Материалы по тегу: облако

|

26.11.2025 [09:50], Руслан Авдеев

У Amazon насчитали более 900 ЦОД в полусотне стран, но компании всё равно этого малоИнфраструктура ЦОД Amazon, вероятно, гораздо масштабнее, чем принято считать. Выяснилось, что более 50 стран стали прибежищем для свыше 900 дата-центров компании, включая совсем небольшие объекты для периферийных сервисов, сообщает Bloomberg со ссылкой на данные SourceMaterial. Крупнейшие кампусы AWS находятся в США, в Вирджинии и Орегоне. Однако у компании есть множество как собственных ЦОД, так и арендованных на долгий срок объектов. Компания размещает стойки в сотнях колокейшн-ЦОД, при этом на них приходится лишь приблизительно 20 % всех вычислительных мощностей AWS. Где-то AWS размещает всего несколько стоек, а где-то, как во Франкфурте и Токио, арендует крупные ЦОД целиком. Согласно документам об энергопотреблении, крупнейшие арендуемые AWS ЦОД, вероятно, расположены во Франкфурте, Монреале, Мумбаи, Сеуле, Сингапуре и Токио или окрестностях этих мегаполисов. Точное местоположение дата-центров не раскрывается, но документы дают некоторое представление о возможностях компании. Они же свидетельствуют о том, что AWS является одним из крупнейших в мире арендаторов колокейшн-площадей. По словам New Relic, помогающей бизнесам управлять технологической инфраструктурой, помимо крупных ЦОД у гиперскейлеров обычно есть и более мелкие облачные объекты, но провайдеры не любят раскрывать их локации. Всего на начало 2024 года AWS пользовалась услугами более 440 колокейшн-ЦОД. Ещё более 220 дополнительных объектов относятся к периферийным, так что полноценными дата-центрами их назвать сложно. Они часто размещаются рядом с мегаполисами и на территории телеком-хабов. Как сообщают в AWS, хотя компания владеет и управляет большинством своих ЦОД, используются и возможности сторонних организаций, чтобы быстро реагировать на меняющиеся требования клиентов. При выходе на новые рынки или изменении спроса AWS опирается на сторонние компании, наращивая мощности для новых клиентов и ИИ-проектов. А, к примеру, в Китае, компания и вовсе обязана работать через местных партнёров. В конце 2023 года Amazon заявила, что имеет втрое больше дата-центров, чем ближайший конкурент. Речь шла о Microsoft, которая в то время имела портфолио из 300 объектов. Baxtel говорит о присутствии Amazon в 449 ЦОД на 49 рынках. DC Byte оценивает парк AWS в 364 объекта в 33 странах. Впрочем, точно установить количество невозможно, поскольку соглашения об аренде обычно носят конфиденциальный характер. В целом, судя по документам, Amazon имеет соглашения, как минимум, со 180 организациями в рамках колокейшн-договоров. По имеющимся данным, компания владеет зданиями общей площадью более 2,4 млн м2 и ещё примерно столько же арендует. Несмотря на огромный парк ЦОД, дела у компании не всегда идут гладко. Не всегда она успевает за спросом и не всегда может обеспечить необходимое качество услуг. Так, согласно Business Insider, нехватка ИИ-мощностей AWS и проблемы с производительностью заставили многих клиентов обратиться к соперникам. Тем не менее, в III квартале облако Amazon принесло $33 млрд и остаётся самым прибыльным в компании, т.ч. только в этом году объём капитальных затрат составит $125 млрд. Масштабы бизнеса стали очевидны в октябре, когда сбой AWS вывел из строя онлайн-сервисы по всему миру.

25.11.2025 [16:24], Руслан Авдеев

Нехватка ИИ-мощностей и проблемы с производительностью вынудили многих клиентов AWS обратиться к конкурентамЛетом 2025 года облачный бизнес Amazon (AWS) с трудом справлялся с растущим спросом на ИИ и упустил часть доходов. Сервис Bedrock занимает ключевое место в развитии ИИ-проектов компании. Однако летом Bedrock столкнулся с нехваткой мощностей, из-за чего некоторые клиенты ушли к конкурентам, в том числе к Google, сообщает Business Insider. Это привело к потерям десятков миллионов долларов и отложенной выручки. Например, проект Fortnite стоимостью $10 млн достался Google Cloud после того, как AWS не смогла выделить ей необходимые квоты (лимит на токены или вызовы API). Согласно внутреннему документу AWS, попавшему в распоряжение журналистов, нефтетрейдер Vitol также перенёс проекты из AWS, а некоторые крупные клиенты, включая Atlassian и GovTech Singapore, летом были вынуждены ожидать увеличения квот, что привело к «отсроченным продажам» минимум на $52,6 млн. Более того, задержки с одобрением выделения мощностей и отказ в обработке нерегулярных, вынудили Stripe, Robinhood и Vanguard отказаться от переноса нагрузок в Bedrock. Подчёркивается, что проблемы Bedrock потенциально ведут к потерям выручки и проблемам с клиентами. Это объясняет, почему облачные компании стремятся построить как можно больше ИИ ЦОД. Высокий спрос хорош только тогда, когда можно его удовлетворить и удержать клиентов от перехода к конкурентам. Бывшие и действующие сотрудники AWS отмечают, что проблемы с вычислительными мощностями были одними из наиболее значимых для компании в сентябре. AWS и раньше испытывала проблемы с нехваткой мощностей даже для собственных нужд, но сейчас ситуация обострилась. Тем временем в Amazon утверждают, что Bedrock быстро растёт, а AWS стремительно наращивает мощности для удовлетворения спроса, за 12 месяцев добавив 3,8 ГВт. Это больше, чем смогу получить любой другой облачный провайдер. AWS удвоила мощность с 2022 года и намерена сделать то же самое к 2027 году. Компания и далее намерена быть «очень агрессивной» в деле масштабирования вычислительных мощностей, причём AWS может монетизировать новые мощности «практически незамедлительно», а Bedrock имеет не меньший потенциал роста, чем EC2. Частично проблемы с Bedrock могут быть связаны с тем, что компания отдаёт предпочтение крупным клиентам. В октябре заявлялось, что большинство задач Bedrock выполняется с помощью «доморощенных» ИИ-чипов Trainium, но в основном нагрузки приходятся на нескольких очень крупных клиентов, которые, по-видимому, готовы вкладываться в развитие инструментов на не самой популярной платформе. Ожидается, что компании среднего размера в ближайшие месяцы тоже начнут использовать Trainium нового поколения. Впрочем, последние иногда всё ещё не могут конкурировать с чипами NVIDIA. Впрочем, помешала Bedrock не только нехватка мощностей. Так, Figma, Intercom и Wealthsimple предпочли использовать LLM Claude в Google Cloud или на платформе самой Anthropic из-за недостатка функций и высокой задержки в Bedrock. Британская госслужба Government Digital Service рассматривала переход в Microsoft Azure только потому, что Claude 3.7 Sonnet работала медленнее на платформе Bedrock. Thomson Reuters также выбрала Google Cloud для своего ИИ-продукта CoCounsel, поскольку сервис AWS оказался на 15–30 % медленнее и не имел ключевых правительственных сертификатов. В документе AWS отмечается, что платформа Bedrock уступает Google. Для моделей Gemini квоты в пять-шесть раз выше, а Gemini Pro побеждает Claude в Bedrock во многих бенчмарках. Хуже того, Gemini Flash обеспечивает сравнимое качество при кратно меньших затратах. Некоторые стартапы буквально «сбежали» по этой причине. TainAI перенесла 40 % задач на Gemini Flash, отказавшись от Claude в Bedrock и экономя тем самым $85 тыс./день, а Hotel Planner намеревалась перейти в Google Cloud или к OpenAI. Всё это было ещё до запуска Gemini 3. Ещё более важная проблема, согласно документу, заключается в том, что у AWS нет целостного видения ИИ-инференса, хотя это ключевой сервис Bedrock. Это сыграло на руку не только гиперскейлерам, но и компаниями поменьше. Без чёткой стратегии AWS рискует упустить одну из самых привлекательных возможностей на рынке ИИ. Но этим проблемы не ограничиваются. Октябрьский сбой AWS продемонстрировал зависимость мировой Сети от лидера облачного рынка, так что многие задумались о переносе хотя бы части нагрузок на другие платформы, а Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантов. В последние недели инвесторы обеспокоены расходами на ИИ, опасаясь возникновения очередного пузыря на рынке IT. В этом контексте дефицит мощностей для Amazon играет двоякую роль. Это свидетельствует, что спрос со стороны клиентов до сих пор высок. С другой стороны, дефицит — ещё одна причина тратить больше денег в развитие инфраструктуры, что повышает риск возникновения пузыря. Amazon утверждает, что намерена выделить $125 млрд на капитальные затраты в текущем году, и ещё больше — в 2026-м.

25.11.2025 [14:05], Владимир Мироненко

AWS потратит $50 млрд на расширение облачных мощностей для правительства США: +1,3 ГВт на ИИ и HPCAmazon объявила о планах инвестировать до $50 млрд в расширение инфраструктуры ИИ и HPC для правительства США. Компания начнёт реализацию проектов в 2026 году и планирует добавить почти 1,3 ГВт вычислительной мощности в регионах AWS Top Secret, AWS Secret и AWS GovCloud (US) на всех уровнях секретности путём строительства новых ЦОД. Федеральные агентства получат расширенный доступ к комплексным ИИ-сервисам AWS, включая SageMaker, Bedrock, Nova и Anthropic Claude. Также в их распоряжение будут предоставлены ведущие модели класса open-weight foundation, ИИ-ускорители Trainium и ИИ-инфраструктура NVIDIA, что позволит им разрабатывать индивидуальные решения в области ИИ, оптимизировать большие наборы данных и повышать производительность труда, сообщила Amazon. Ранее AWS, Google, Oracle, Microsoft, xAI и др. IT-гиганты предоставили госслужбам США существенные скидки на облачные услуги в рамках программы OneGov. Это позволит государственным агентствам ускорить обработку информации и принятие решений. Интеграция ИИ с моделированием и имитацией позволит им решать за считанные часы самые сложные задачи, на которые раньше уходили недели или месяцы, а также «автоматически обнаруживать угрозы и разрабатывать планы реагирования», обрабатывая спутниковые снимки, данные датчиков и исторические закономерности в «беспрецедентном масштабе». «Наши инвестиции в специализированную правительственную инфраструктуру ИИ и облачные технологии коренным образом изменят подход федеральных агентств к использованию суперкомпьютинга, — заявил генеральный директор AWS Мэтт Гарман. — Мы предоставляем агентствам расширенный доступ к передовым возможностям ИИ, которые позволят им ускорить выполнение критически важных задач — от кибербезопасности до разработки лекарств. Эти инвестиции устраняют технологические барьеры, сдерживавшие развитие правительства, и укрепляют лидирующие позиции Америки в эпоху ИИ». Компания отметила, что этот шаг подчёркивает позицию AWS как лидера в области государственных облачных вычислений, поддерживающего более 11 тыс. государственных учреждений. AWS уже давно предоставляет правительству США выделенные облачные регионы. В 2011 году она запустила AWS GovCloud (US-West), AWS Top Secret-East — изолированное облако для секретных рабочих нагрузок — в 2014 году, AWS Secret Region — в 2017 году, с 2018 года добавила второй регион GovCloud (US-East), AWS Top Secret-West, а в октябре 2025 года — AWS Secret-West. Компания не раскрывает точное местоположение ЦОД и регионов. Как пишет Data Center Dynamics, другие страны также доверяют AWS свою самую секретную информацию. В Великобритании в 2021 году сообщили, что три британских разведывательных агентства использовали AWS для хранения совершенно секретных данных. В 2024 году AWS получила контракт стоимостью $1,3 млрд правительства Австралии на строительство ЦОД для совершенно секретной информации — спецслужбы получат возможность работы без использования открытого интернета.

25.11.2025 [13:42], Андрей Крупин

Yandex B2B Tech открыла доступ к Alice AI LLM — самому мощному семейству нейросетей «Яндекса»Yandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о доступности пользователям облачной платформы Yandex Cloud нового семейства генеративных моделей — Alice AI LLM. Alice AI LLM является флагманской ИИ-разработкой компании «Яндекс». Модель построена на архитектуре MoE (Mixture of Experts) с технологией тренировки на основе обучения с подкреплением (Online RL). Нейросеть понимает около 20 языков (в том числе японский) и может быть использована для решения сложных задач: поиска по базам знаний и генерации результатов на основе найденной информации (RAG-сценарий), анализа документов, построения отчётов и аналитики, извлечения информации и автоматизации заполнения полей, форм и баз CRM, а также для создания «человеко-ориентированных» ИИ-ассистентов.

Источник изображения: пресс-служба «Яндекса» / company.yandex.ru Alice AI LLM доступна через OpenAI-совместимые Completions API и Responses API, а также собственный API генерации текста в форматах REST и gRPC. Модель поддерживает интеграцию с популярными open source-библиотеками LangChain, AutoGPT и LlamaIndex. В Yandex B2B Tech подчёркивают, что стоимость использования Alice AI значительно ниже, чем у опенсорсных нейросетей, благодаря оптимизированному под русский язык разделению текста на токены. В один токен в Alice AI помещаются примерно 4–5 символов на кириллице, а в опенсорсных моделях — примерно 2–3 символа. Таким образом, конечная стоимость использования Alice AI в 1,5–2 раза ниже открытых моделей с той же тарификацией. Кроме того, запросы пользователя к нейросети и ответы модели тарифицируются по-разному: токены «на вход» нейросети стоят в четыре раза дешевле, чем «на выход», что позволяет использовать модель более экономно.

24.11.2025 [22:25], Владимир Мироненко

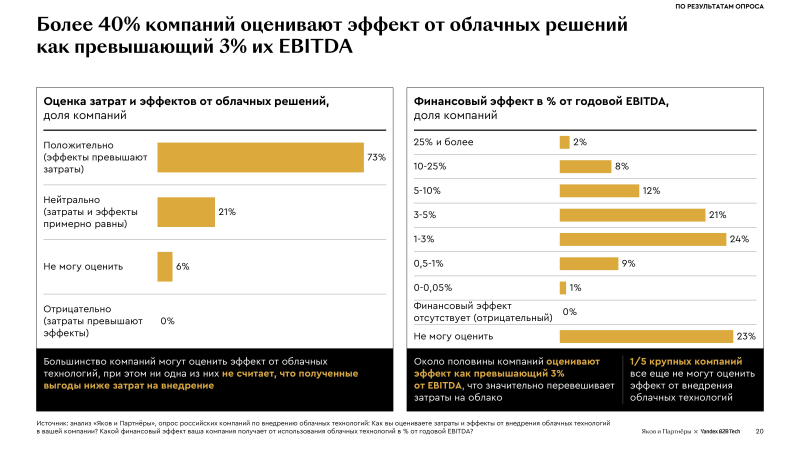

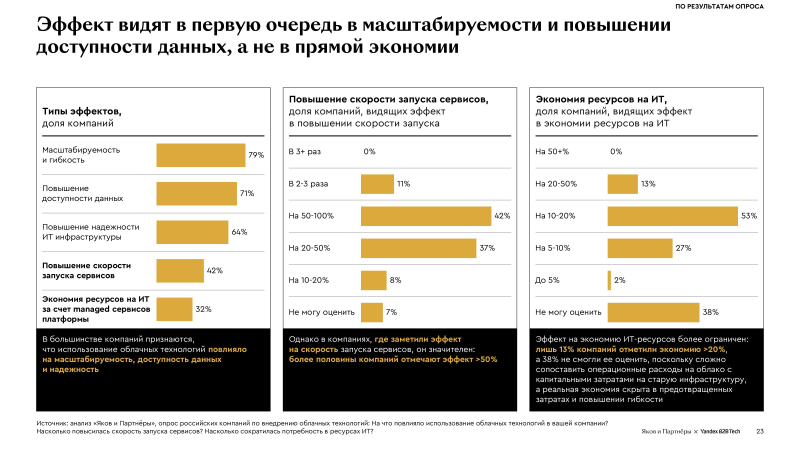

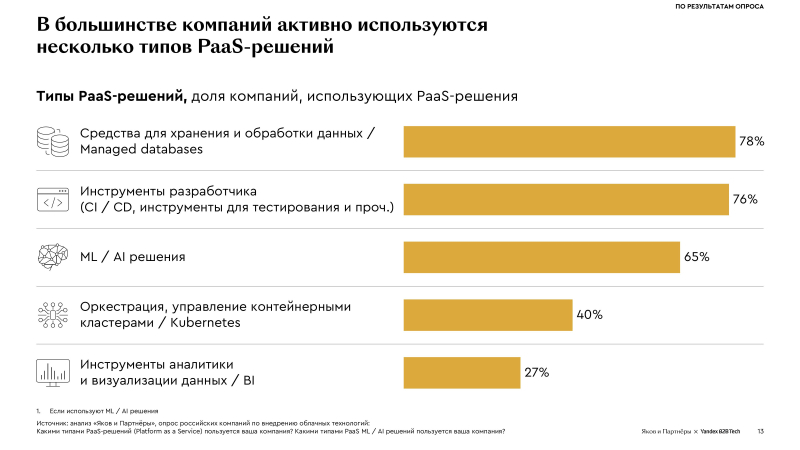

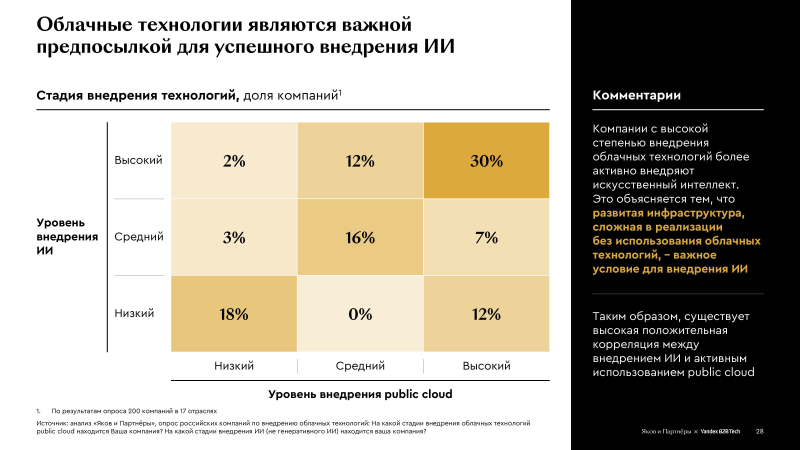

Внедрение облачных технологий увеличивает прибыль компаний, показало исследование Yandex B2B Tech и «Яков и Партнёры»Согласно совместному исследованию консалтинговой компании «Яков и Партнёры» и Yandex B2B Tech «Облачные технологии: тренды и перспективы развития», российские компании продолжают наращивать масштабы использования облачных сервисов, получая от внедрения облачных решений заметный финансовый эффект. В основу исследования легли результаты опроса руководителей 200 крупных российских компаний из 17 отраслей. По оценкам экспертов, большей частью высоким уровнем внедрения ИИ могут похвастать компании с высоким уровнем использования облаков — таких 30 %. При низком уровне использования облаков уровень внедрения ИИ составляет не более 2 %. Около половины компаний оценивают эффект от внедрения облачных решений как превышающий 3 % их EBITDA, что значительно больше затрат на облако. В цифровых отраслях финансовый эффект ещё выше: более 5 % EBITDA у компаний в сфере ИТ и технологий электронной коммерции, а также телекоме и медиа. У 73 % респондентов эффект превысил затраты, у 2 % — он оказался выше 25 %, но 23 % опрошенных всё ещё не могут его оценить. При этом главный результат внедрения компании видят не в прямой экономии, а в улучшение масштабируемости, повышении доступности данных и надёжности инфраструктуры. В этих условиях около половины компаний тратят на облачные решения более 5 % от годового ИТ-бюджета, а свыше 30 % планируют увеличить расходы в будущем. Большинство участников опроса (94 %) планируют и дальше использовать облачные технологии, причем 44 % намерены масштабировать существующие решения, 28 % — применять технологии в новых сценариях, 26 % — использовать облачные технологии в тех же объёмах. Половина компаний планирует увеличить количество провайдеров облачных услуг. При этом ключевым критерием при выборе компании называют качество платформы и сопутствующих сервисов, превышающим по значимости цену и модель ценообразования. Согласно опросу, компании быстро переходят к гибридной модели: более 70 % используют одновременно публичное облако и on-premise инфраструктуру. Проникновение решений PaaS и SaaS составляет 65–66 %, при этом свыше половины компаний (52 %) комбинируют IaaS-, PaaS- и SaaS. Компании активно используют PaaS для ускорения разработки, анализа данных и внедрения AI-технологий, в большинстве случаев — несколько типов. Наиболее востребованы решения для хранения и обработки данных (78 % респондентов), инструменты для разработчиков (76 %), сервисы в области ML и ИИ (65 %), оркестрация, управление контейнерными кластерами (40 %) и инструменты аналитики и визуализации данных (27 %). Отмечено, что аналитические платформы ускоряют подготовку отчётов более чем в два раза, автоматизация консультаций снижает нагрузку на клиентскую поддержку на 20 %, а генеративные сервисы для создания карточек товаров увеличивают скорость публикации в десятки раз. В исследовании отмечено, что глобальный рынок публичных облаков увеличился с 2020 по 2024 гг. почти втрое, до почти $600 млрд, и, согласно прогнозу, достигнет $1,26 трлн в 2028 году. По словам «Яков и Партнёры», на публичные облака приходится больше 60 % мирового рынка ПО, и при позитивном сценарии к 2030 году доля может составить порядка 80 %. При этом в России этот рынок всё ещё является недостаточно зрелым, занимая около 35 % рынка ПО. Вместе с тем прогнозируемые темпы его роста будут превышать мировые, и в течение следующих пяти лет рынок вырастет приблизительно в три раза, практически сравнявшись с on-premise. Согласно прогнозу экспертов, в 2030 году российский рынок облаков по основным типам решений достигнет рекордных 1,24 трлн руб. Основными драйверами его роста являются цифровизация отраслей и спрос на гибкие решения. Рынок включает в себя все облачные решения ПО, а также потребление частных облаков и внутригрупповое потребление решений облачных провайдеров. На внешнее потребление приходится около 70 %.

22.11.2025 [12:23], Сергей Карасёв

В Microsoft Azure появились инстансы с Intel Xeon 6 и CXL-памятьюКорпорация Microsoft в партнёрстве с SAP и Intel запустила в облаке Azure новые виртуальные машины семейства M-Series с технологией Compute Express Link (CXL). В настоящее время эти инстансы работают в режиме закрытого тестирования. Интерконнект CXL основан на интерфейсе PCIe: он обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и буферами памяти, акселераторами, устройствами ввода/вывода и пр. На днях была обнародована спецификация CXL 4.0, которая предусматривает поддержку линий с пропускной способности до 128 ГТ/с. Новые инстансы Azure базируются на процессорах Intel Xeon 6500P и 6700P поколения Granite Rapids-SP. В этих чипах реализована технология CXL Flat Memory Mode, которая позволяет оптимизировать соотношение вычислительных мощностей и ресурсов памяти. Это обеспечивает улучшенную масштабируемость без ущерба для производительности, что важно при работе с приложениями, требовательными к объёму памяти. В случае представленных виртуальных машин Azure поддержка CXL способствует более эффективной работе SAP S/4HANA. В частности, достигается большая гибкость в плане конфигурирования платформы, что помогает удовлетворять потребности конкретных бизнес-пользователей при одновременном снижении совокупной стоимости владения. «Инновационная архитектура инстансов с поддержкой CXL Flat Memory Mode ориентирована на повышение экономической эффективности и оптимизацию производительности программных решений SAP», — отмечает Intel.

21.11.2025 [14:56], Руслан Авдеев

Google и Turkcell объединились для создания в Турции облачного региона и постройки первого ЦОД гиперскейл-классаGoogle Cloud и Turkcell займутся совместным созданием облачного региона в Турции с тремя или более зонами доступности. В заявлении Google говорится, что инициатива будет реализована как часть 10-летнего плана компании, предусматривающего инвестиции в объёме $2 млрд в местную инфраструктуру. Turkcell поможет Google Cloud с инфраструктурой в стране, а сама будет перепродавать облачные сервисы. Представитель компании заявил Bloomberg, что речь идёт о первом в Турции дата-центре гиперскейл-класса. В Turkcell рассчитывают, что мощности её ЦОД вырастут более чем вдвое к концу 2032 года, а выручка от дата-центров и облачных сервисов в долларовом эквиваленте за тот же период вырастет в шесть раз. К 2032 году инвестиции компании в дата-центры и облачные технологии составят около $1 млрд. Это поможет укрепить роль Турции в качестве регионального центра цифровых и ИИ-инноваций.

Источник изображения: Youssef Mohamed/unsplash.com Ранее в 2025 году Turkcell получила финансирование на €100 млн ($112,5 млн) для расширения сети дата-центров. На своём сайте компания сообщает, что управляет восьмёркой основных ЦОД на четырёх рынках — в Текирдаге (Tekirdağ), Гебзе (Gebze), Анкаре (Ankara) и Измире (Izmir), общая площадь объектов составляет 122 тыс. м2, включая 32 тыс. м2 свободной площади, совокупная мощность составляет 41,5 МВт. На момент получения средств компания намеревалась увеличить сеть ЦОД ещё на 8,4 МВт к концу 2025 года. Большинство ЦОД в Турции расположены неподалёку от Стамбула, в Анкаре есть небольшой второстепенный рынок. В стране действуют операторы Equinix, Sparkle, TurkNet и ComNet, а также другие компании. Активность проявляют не только компании американского и турецкого происхождения. Например, в июне 2025 года появилась информация, что принадлежащая китайской Alibaba турецкая Trendyol Group построит дата-центр на 48 МВт в Анкаре.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

19.11.2025 [23:59], Владимир Мироненко

Скандал в NetApp: бывший техдиректор продал разработки конкуренту и скрылся в ИсландииNetApp подала в суд на своего бывшего старшего вице-президента и технического директора Йона Торгримура Стефанссона (Jón Thorgrímur Stefánsson), обвинив его в том, что он, работая в компании и продолжая получать зарплату, тайно развивал конкурирующий бизнес, который продал прямому конкуренту за неназванную сумму всего через несколько недель после того, как покинул NetAPP. Об этом сообщил The Register. В иске, поданном NetApp 6 ноября в Окружной суд США по Среднему округу Флориды, утверждается, что Стефанссон в последние месяцы работы в компании занимался кражей интеллектуальной собственности, пытался вербовать своих коллег, а в конечном итоге обманул NetApp, присвоив её разработки, чтобы продать VAST Data свой стартап в сентябре 2025 года. Благодаря своей позиции он имел «широкий доступ» к конфиденциальным материалам компании, от фирменных инноваций до стратегических деловых отношений. Стефанссон проработал в NetApp восемь лет. Согласно иску, он «принимал непосредственное участие в разработке и интеграции облачных продуктов хранения NetApp с основными гиперскейлерами», такими как AWS, Google Cloud и Microsoft Azure, и отвечал за весь облачный портфель продуктов компании. Как и все сотрудники, имеющие доступ к конфиденциальной информации, Стефанссон подписал с NetApp «Соглашение о конфиденциальной информации, изобретениях и неразглашении» (PIIA), которое запрещает раскрытие или ненадлежащее использование конфиденциальной и служебной информации NetApp во время и после окончания трудовых отношений. В рамках соглашения Стефанссон обязался не участвовать в конфликтующих коммерческих проектах, не переманивать сотрудников или партнёров NetApp в течение как минимум года после увольнения, не рекламировать свои изобретения сотрудникам и деловым партнерам NetApp, а также передать NetApp все изобретения, разработанные им во время работы на компанию. Соглашение также обязывает подписавшего уведомлять о любых изобретениях, созданных в течение шести месяцев после окончания трудовых отношений. В иске утверждается, что каждое из этих обязательств было нарушено. Стефанссон покинул NetApp 27 июня и в течение недели создал новую компанию Red Stapler, которая была официально зарегистрирована 3 июля 2025 года. Компания работала в скрытом режиме. Стефанссон занял пост гендиректора, к нему присоединились пять бывших сотрудников и один действующий сотрудник NetApp — Эйрикур Свейнн Храфнссон (Eiríkur Sveinn Hrafnsson), который покинул NetApp лишь 31 августа 2025 года и стал вторым по величине акционером Red Stapler. А уже 9 сентября, VAST Data, один из прямых конкурентов NetApp, приобрела стартап и назначила Стефанссона генеральным директором по облачным решениям. По словам VAST Data, решения Red Stapler позволят её продуктам «легко интегрироваться в публичные облачные среды». NetApp «не верит, что Red Stapler разработала собственную облачную платформу управления и доставки данных менее чем за десять недель» с момента основания, и утверждает, что приобретённые VAST продукты фактически были её собственными технологиями. Компания сообщила, что потратила годы и десятки миллионов долларов на разработку своего Service Delivery Engine — слоя оркестрации, связывающего облака гиперскейлеров и хранилища NetApp. SDE позволяет конечным пользователям управлять всеми элементами своего хранилища данных из отдельного интерфейса, интегрируясь с любой публичной облачной платформой, пишет Forbes. Ровно это, по мнению NetApp, и предоставляет решение Red Stapler. Даже если предположить, что Стефанссон и его команда каким-то образом самостоятельно разработали технологию Red Stapler в кратчайшие сроки, соглашение PIIA всё равно требовало от него уведомить NetApp об изобретении, но он этого не сделал. В судебных документах NetApp приведены доказательства её обвинений. Во-первых, приводится текстовое сообщение бывшего сотрудника NetApp, ныне входящего в совет директоров VAST, указывающее на то, что Стефанссон согласился присоединиться к VAST в январе 2025 года, за несколько месяцев до своего ухода. Во-вторых, компания обнаружила переписку в Slack, где Стефанссон обсуждал переманивание сотрудников NetApp перед своим уходом. В частности, Стефанссон якобы спрашивал Храфнссона, есть ли у него «данные о зарплатах всех», кого они хотели бы нанять в Red Stapler. В-третьих, компания указывает на учётную запись redstapler-is на GitHub, которая, была создана не позднее 16 июня 2025 года, т.е. за 11 дней до официального ухода Стефанссона из NetApp. Это, как утверждает NetApp, свидетельствует о том, что проектирование и разработка велись, когда Стефанссон всё ещё работал в NetApp. По словам NetApp, в совокупности эти документы показывают, что Стефанссон «разрабатывал технологии и/или исходный код, а также занимался инновациями от имени другой организации», работая в компании. Когда NetApp узнала о сделке VAST в конце октября, она направила Стефанссону письменное предупреждение о нарушении прав интеллектуальной собственности (cease-and-desist letter), в котором подчёркивалось прямое дублирование его работы в NetApp и позиции гендиректора по облачным решениям VAST. В письме также подчёркивалась невозможность разработки платформы Red Stapler без использования конфиденциальной информации NetApp в столь короткие сроки. Стефанссон не ответил на письмо, после чего NetApp отправила ему второе послание, которое тоже осталось без ответа. Более того, через несколько дней после первого письма Стефанссон выставил свой дом в Орландо (Orlando) на продажу и затем покинул США, переехав, по всей видимости, в Исландию. После этого NetApp обратилась в суд, который вынес временный судебный запрет Стефанссону использовать материалы, являющиеся собственностью NetApp, участвовать в любой работе, связанной с продуктами или ПО, разработанными им в период работы в Исландии, привлекать деловых партнёров NetApp, а также уничтожать или распоряжаться документами, имеющими отношение к делу. Срок действия временного запрета истекает 26 ноября. NetApp заявила, что намерена добиваться бессрочного судебного запрета, остающегося в силе до конца судебного разбирательства. Следует также отметить, что VAST не упоминается в иске и не обвиняется NetApp в каких-либо правонарушениях. Пока речь идёт лишь о предполагаемых действиях покинувшего компанию ключевого руководителя, который случайно оказался в VAST Data, чтобы помочь в разработке конкурирующего продукта.

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно. |

|