Материалы по тегу: cxl

|

20.09.2025 [01:40], Владимир Мироненко

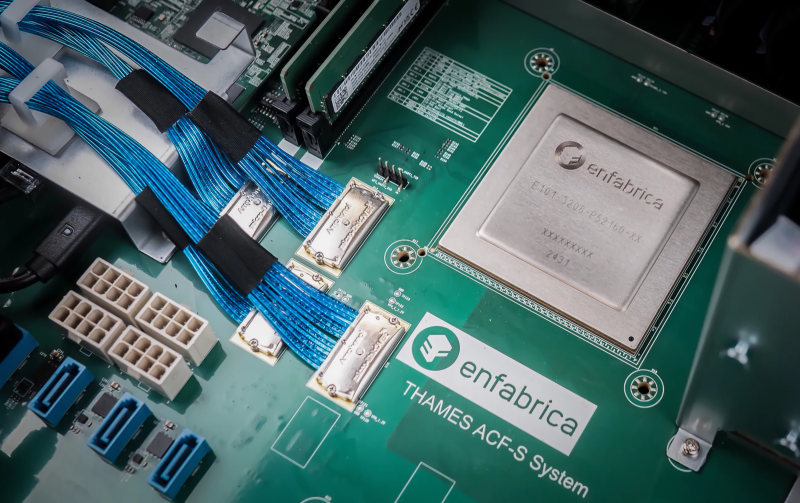

NVIDIA купила за $900 млн разработчика интерконнекта для ИИ-платформ EnfabricaСогласно публикациям CNBC и The Information, NVIDIA заключила сделку с разработчиком интерконнекта для ИИ-систем Enfabrica стоимостью $900 млн, чтобы лицензировать ряд его технологий, а также переманить его гендиректора и ключевых сотрудников. Оплата сделки, завершённой на прошлой неделе, производилась собственными средствами NVIDIA и её акциями. Глава Enfabrica Рочан Санкар (Rochan Sankar) уже присоединился к команде NVIDIA. Спрос на вычислительные мощности для поддержки генеративного ИИ со стороны таких компаний, как OpenAI, Anthropic, Mistral, AWS, Microsoft и Google, ставит перед NVIDIA сложную задачу: как создать унифицированный, отказоустойчивый GPU-кластер, способный справиться с такими огромными нагрузками. Решения Enfabrica, основанной в 2019 году, призваны решить эту задачу. Как пишет Network World со ссылкой на аналитиков, NVIDIA считает интеграцию технологий Enfabrica критически важной для повышения эффективности своих кластеров в обучении новейших ИИ-моделей. Во всяком случае, Enfabrica утверждает, что её технология позволяет бесшовно объединить более 100 тыс. ускорителей в единый кластер. Кроме того, к ускорителям можно добавить CXL-пулы DRAM/SSD. «Используя SuperNIC и фабрику Enfabrica, NVIDIA может ускорить передачу данных в кластерах, обойти текущие ограничения масштабирования сетевых фабрик и снизить зависимость от дорогостоящей памяти HBM», — отметила Рачита Рао (Rachita Rao), старший аналитик Everest Group, имея в виду чип ACF-S, разработанный для обеспечения более высокой пропускной способности, большей отказоустойчивости, меньшей задержки и лучшего программного управления для операторов ЦОД, работающих с ресурсоёмкими ИИ-системами и HPC. Enfabrica утверждает, что ACF-S более отказоустойчив в сравнении с традиционным интерконнектом, поскольку заменяет двухточечные соединения GPU многопутевой архитектурой, которая снижает перегрузку, улучшает распределение данных и гарантирует, что сбои в работе GPU не приведут к остановке процесса вычислений. По мнению Чарли Дая (Charlie Dai), главного аналитика Forrester, для NVIDIA также представляет интерес технология EMFASYS, позволяющая дать ИИ-серверам доступ к внешним пулам памяти. По словам Дая, сочетание ACF-S и EMFASYS может помочь NVIDIA добиться более высокой загрузки GPU и снижения совокупной стоимости владения (TCO) — ключевых показателей для гиперскейлеров и разработчиков LLM. Как сообщает Blocks & Files, Enfabrica привлекла в общей сложности $290 млн венчурного финансирования: $50 млн в раунде A в размере $50 млн в 2022 году при оценке в $50 млн; $125 млн в раунде B в 2023 году с оценкой в размере $250 млн; $115 млн в раунде C в 2024 году. По данным Pitchbook, оценочная стоимость компании сейчас составляет около $600 млн. NVIDIA инвестировала в компанию в раунде B. На этой неделе NVIDIA также объявила об инвестициях в Intel в размере $5 млрд в рамках совместной разработки специализированных чипов для ЦОД и ПК. Квазислияния получили широкое распространение в Кремниевой долине, поскольку позволяют обойти препоны регуляторов. В начале этого года Meta✴ приобрела за $14,3 млрд 49 % акций Scale AI, переманив его основателя Александра Ванга (Alexandr Wang) вместе с ключевыми сотрудниками. Месяц спустя Google объявила о похожем соглашении с ИИ-стартапом Windsurf, в рамках которого его соучредитель и гендиректор Варун Мохан (Varun Mohan) перешёл вместе с рядом сотрудников в подразделение Google DeepMind. Аналогичные сделки были в прошлом году у Google с Character.AI, Microsoft с Inflection AI и у Amazon с Adept.

12.09.2025 [11:29], Сергей Карасёв

PCIe по оптике: Macom представила чипсет, увеличивающий длину соединений PCIe 6.0 до 100 мКомпания Macom Technology Solutions анонсировала новый чипсет, который, как утверждается, позволяет преодолеть существующие ограничения по длине соединений PCIe 6.0 и CXL (Compute Express Link). Изделие обеспечивает возможность высокоскоростной передачи данных с малой задержкой на большие расстояния по паре оптических волокон. Чипсет объединяет трансимпедансный усилитель (TIA) MATA-38794 и драйвер VCSEL MALD-38795. Достигается скорость передачи данных в 64 Гбит/с (PAM4) по восьми линиям PCIe. Протяженность соединений PCIe 6.0 при использовании многомодового оптоволоконного кабеля составляет до 100 м. Подчёркивается, что компоненты MATA-38794 и MALD-38795 обеспечивают масштабируемое и прозрачное подключение посредством PCIe, отвечающее требованиям современных вычислительных сред. Кроме того, новое изделие поддерживает передачу по дополнительному оптоволокну критически важных сигналов, включая сигналы синхронизации, сброса и пробуждения, а также USB и Ethernet. Это, как подчёркивается, «обеспечивает полную прозрачность шины PCIe на больших расстояниях». Чипсет предназначен для формирования платформ дезагрегированных вычислений для задач ИИ и НРС. В отличие от традиционных серверных архитектур, основанных на интегрированном оборудовании и многоуровневых сетевых протоколах, дезагрегированные системы используют оптический интерконнект для прямого подключения ресурсов. Благодаря этому снижается задержка, уменьшается энергопотребление и достигается гибкое масштабирование. Интерфейс PCIe позволяет формировать высокоскоростные соединения типа GPU–GPU и CPU–память.

08.08.2025 [10:44], Сергей Карасёв

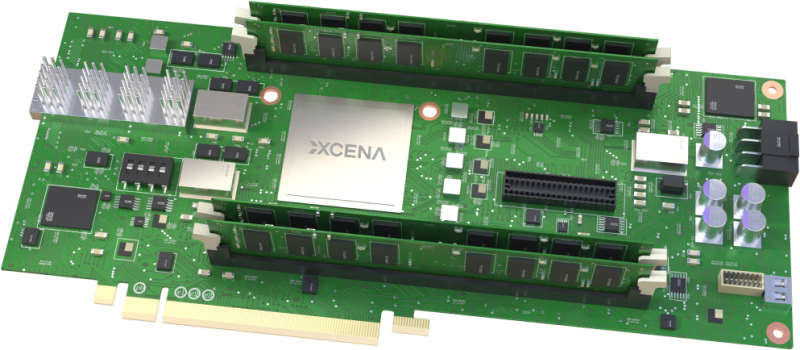

Стартап Xcena представил вычислительную память MX1 с поддержкой PCIe 6.0 и CXL 3.2Южнокорейский стартап Xcena анонсировал свой первый продукт — вычислительную память MX1. Избранные партнёры начнут получать образцы изделий с октября, тогда как массовое производство запланировано на 2026 год. Решение MX1 обладает поддержкой PCIe 6.0 и CXL 3.2. Новинка позволяет расширить основную память системы, добавив до 1 Тбайт в виде четырёх модулей DDR5 DIMM ёмкостью 256 Гбайт каждый. Реализована технология NDP (Near Data Processing), которая сводит к минимуму задержку при перемещении данных между интерфейсами и значительно снижает совокупную стоимость владения для приложений, требующих обработки больших объемов информации. Для выполнения вычислений в оперативной памяти используются «тысячи ядер» на открытой архитектуре RISC-V. Изделия MX1 позволяют существенно ускорить выполнение таких задач, как операции с векторными и графовыми базами данных, анализ информации и пр. При этом снижается нагрузка на CPU. Прототип на базе FPGA продемонстрировал сокращение времени обработки запросов при работе с базами данных на 46 % по сравнению с серверными CPU. Теоретически выигрыш может достигать 95 % при реализации в виде ASIC. Чип задействует 4-нм техпроцесс Samsung Foundry. Упомянута поддержка ECC. Компания Xcena предоставляет полностью интегрированный комплект для разработчиков (SDK), состоящий из низкоуровневых драйверов, библиотек среды выполнения и вспомогательных инструментов, которые помогают создавать прототипы и развертывать MX1 с минимальными усилиями по интеграции.

03.08.2025 [12:14], Сергей Карасёв

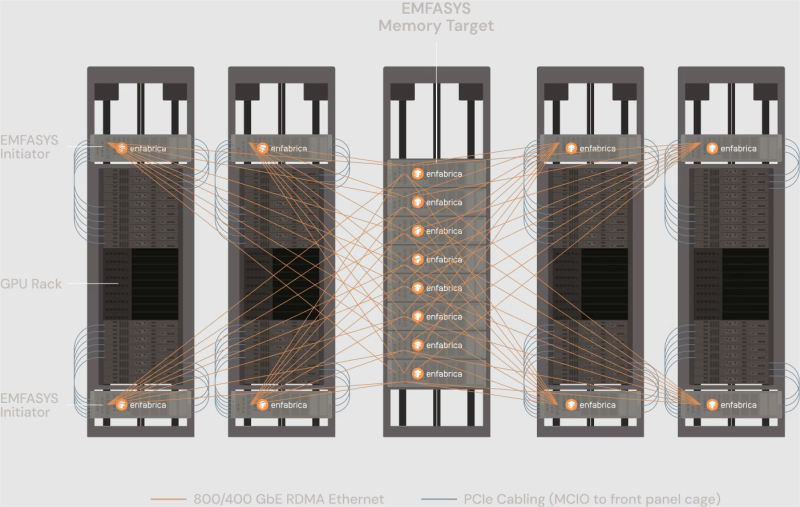

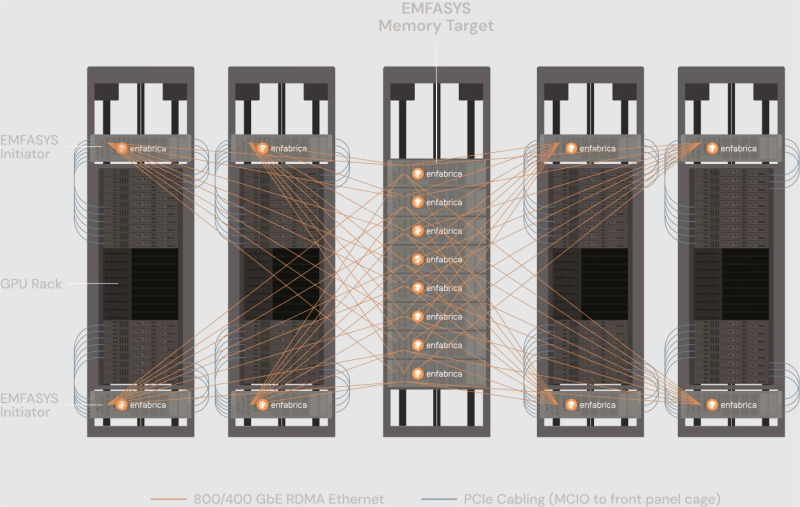

Enfabrica представила технологию EMFASYS для расширения памяти ИИ-системКомпания Enfabrica анонсировала технологию EMFASYS, которая объединяет Ethernet RDMA и CXL для создания пулов памяти, предназначенных для работы с серверными ИИ-стойками на базе GPU. Решение позволяет снизить нагрузку на HBM-память ИИ-ускорителей и тем самым повысить эффективность работы всей системы в целом. Enfabrica основана в 2019 году. Стартап предлагает CXL-платформу ACF на базе ASIC собственной разработки, которая позволяет напрямую подключать друг к другу любую комбинацию GPU, CPU, DDR5 CXL и SSD, а также предоставляет 800GbE-интерконнект. Компания создала чип ACF SuperNIC (ACF-S) для построения высокоскоростного интерконнекта в составе кластеров ИИ на основе GPU. В рамках платформы EMFASYS специализированный пул памяти подключается к GPU-серверам через чип-коммутатор ACF-S с пропускной способностью 3,2 Тбит/с, который объединяет PCIe/CXL и Ethernet. Поддерживаются интерфейсы 100/400/800GbE, 32 сетевых порта и 160 линий PCIe. Могут быть задействованы до 144 линий CXL 2.0, что позволяет использовать до 18 Тбайт памяти DDR5 (в перспективе — до 28 Тбайт). Вместо копирования и перемещения данных между несколькими чипами на плате Enfabrica использует один SuperNIC, который позволяет представлять память в качестве целевого RDMA-устройства для приложений ИИ. Высокая пропускная способность памяти достигается за счёт распределения операций более чем по 18 каналам на систему. Время доступа при чтении измеряется в микросекундах. Программный стек на базе InfiniBand Verbs обеспечивает массовую параллельную передачу данных с агрегированной полосой пропускания между GPU-серверами и памятью DRAM через группы сетевых портов 400/800GbE. Enfabrica отмечает, что рабочие нагрузки генеративного, агентного и рассуждающего ИИ растут экспоненциально. Во многих случаях таким приложениям требуется в 10–100 раз больше вычислительной мощности на запрос, чем большим языковым моделям (LLM) предыдущего поколения. Если память HBM постоянно загружена, дорогостоящие ускорители простаивают. Технология EMFASYS позволяет решить проблему посредством расширения памяти: в этом случае ресурсы GPU используются более полно, а заявленная экономия достигает 50 % в расчёте на токен на одного пользователя.

05.07.2025 [15:16], Алексей Разин

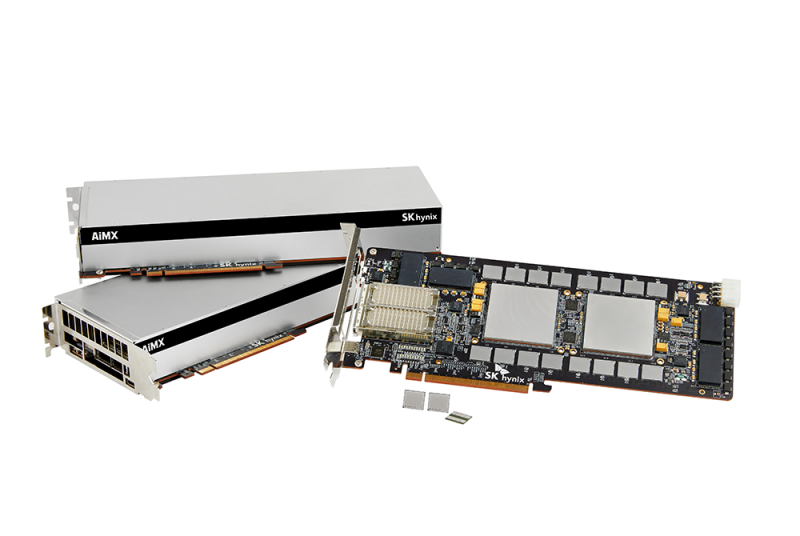

Повальный спрос на HBM тормозит внедрение CXL- и PIM-памятиОтраслевые аналитики уже не раз отмечали, что бурное развитие отрасли искусственного интеллекта, сопряжённое с ростом спроса на память типа HBM, ограничивает ресурсы производителей памяти на других направлениях. Помимо DDR, от этого страдают и перспективные виды памяти, которые производители хотели бы вывести на рынок. Об этом сообщило издание Business Korea, приведя в пример задержки с внедрением памяти типа CXL компанией Samsung Electronics и памяти типа PIM (Processing-in-Memory) компанией SK hynix. В последнем случае речь идёт о микросхемах памяти, способных самостоятельно выполнять специфические вычисления. Оба типа памяти могли бы в известной мере дополнить HBM в сегменте систем искусственного интеллекта.

Источник изображения: SK hynix Samsung рассчитывала приступить к продвижению CXL-памяти ещё во II половине 2024 года, но её сертификация ключевыми клиентами до сих пор не завершена. SK hynix разрабатывает GDDR6-AiM с 2022 года, но до её фактического выпуска дело так и не дошло из-за неготовности рыночной экосистемы. Кроме того, сами производители памяти ограничены в свободных ресурсах, поскольку все силы бросили на выполнение заказов по производству HBM. Всё доступное оборудование задействовано для выпуска именно HBM, не давая производителям шанса заняться подготовкой к выпуску других перспективных типов памяти. На этом фоне у южнокорейских игроков рынка даже возникают опасения, что китайские конкуренты быстрее справятся с выводом на рынок модулей CXL и PIM. В этой ситуации корейские производители начали всё сильнее рассчитывать на поддержку государства, причём не столько финансовую, сколько регуляторную. С технической точки зрения к выводу на рынок CXL и PIM всё уже почти готово, но по факту на память этих типов пока нет достаточного спроса.

16.05.2025 [17:20], Алексей Степин

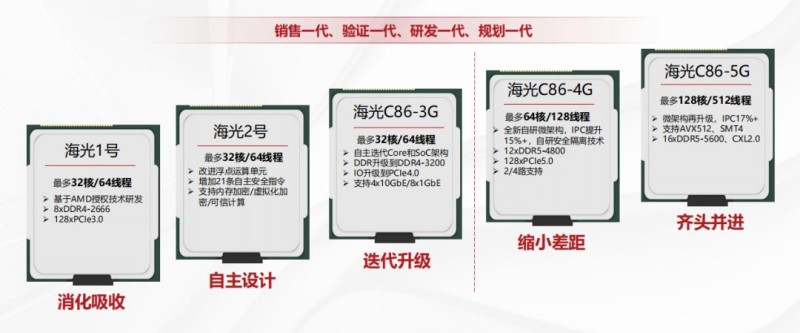

Hygon якобы готова к выпуску 128-ядерного конкурента AMD EPYC с SMT4 и AVX-512Имя Hygon вряд ли легко найти в списке лучших серверных процессоров, однако в своё время этот китайский разработчик смог выпустить в рамках соглашения с AMD серверные чипы Hygon Dhyana, совместимые с платформой Socket SP3. В 2024 году компания похвасталась уже 64-ядерными Hygon C86-7490 для платформы Socket SP5, которые, впрочем, всё равно базировались на архитектуре Zen 1. Но амбиции китайских разработчиков отнюдь не ограничиваются устаревшими архитектурами AMD, передаёт Tom's Hardware. Недавно в социальной сети Twitter (X) был замечен слайд, на котором якобы расписаны планы Hygon в области разработки новых процессоров, и они выглядят впечатляюще. В них фигурирует новый флагман под условным именем C86-5G, способный составить конкуренцию современным многоядерным серверным процессорам Intel и AMD. Этот процессор получит до 128 ядер, причём с поддержкой SMT4, а не привычного для x86-мира SMT2, что даст ему возможность исполнять одновременно до 512 потоков. Некогда аналогичная технология уже применялась Intel в процессорах Xeon Phi Knights Landing. Какая микроархитектура будет стоять за новыми ядрами, пока не разглашается. Заявляется лишь, что это новая фирменная разработка Hygon, а не очередное ответвление AMD EPYC. Заявлено о как минимум 17% прироста производительности в пересчете на такт (IPC). Известно также, что C86-5G получат поддержку AVX-512. 512 потоков нуждаются в быстрой памяти — новые процессоры получат 16-канальный контроллер DDR5-5600, что является серьезным шагом вперёд от 12 каналов DDR5-4800 в предыдущем поколении. Что касается IO-подсистемы, то уже в предыдущем поколении появилась поддержка 128 линий PCI Express 5.0. Вероятнее всего, это станет минимумом для C86-5G и, хотя точных цифр компания нет, отмечается, что в новых процессорах дебютирует полноценная поддержка CXL 2.0.

Hygon C86-7490. Источник: Twitter@YuuKi_AnS Четвёртое поколение серверных чипов Hygon доступно с прошлого года, так что можно предположить, что проектирование C86-5G находится в самом разгаре. Это один из проектов, критически важных для КНР в рамках «тарифной войны» с США и нацеленных на достижение статуса самодостаточности в сфере IT.

26.03.2025 [10:39], Сергей Карасёв

SMART Modular представила энергонезависимые CXL-модули памяти NV-CMM-E3SКомпания SMART Modular Technologies объявила о начале пробных поставок улучшенных энергонезависимых модулей памяти CXL (Non-Volatile CXL Memory Module, NV-CMM), соответствующих стандарту CXL 2.0. Изделия ориентированы на применение в дата-центрах, которые поддерживают такие нагрузки, как резидентные базы данных, аналитика в реальном времени и приложения НРС. Новинка (NV-CMM-E3S) объединяет память DDR4-3200 DRAM, флеш-память NAND и источник резервного питания в форм-факторе E3.S 2T (EDSFF). Задействован интерфейс PCIe 5.0 x8. Применяются контроллеры на базе ASIC и FPGA. Устройство NV-CMM имеет ёмкость 32 Гбайт, а максимальная пропускная способность заявлена на уровне 32 Гбайт/с. Поддерживается шифрование информации по алгоритму AES-256. Интегрированный источник аварийного питания обеспечивает сохранность критически важных данных при непредвиденных отключениях электроэнергии, что повышает надёжность и доступность системы в целом. В случае сбоя в центральной сети энергоснабжения производится копирование данных из DRAM в NAND, а после восстановления подачи энергии выполняется обратный процесс. Изделие обеспечивает более быструю перезагрузку виртуальных машин и сокращает время простоя в облачных инфраструктурах.

Источник изображения: SMART Modular Technologies Устройство имеет размеры 112,75 × 15 × 76 мм. Эксплуатироваться модуль может при температурах окружающей среды до +40 °C. Отмечается, что внедрение NV-CMM на основе стандарта CXL знаменует собой важную веху в удовлетворении растущих потребностей платформ ИИ, машинного обучения и аналитики больших данных.

08.03.2025 [21:26], Сергей Карасёв

Team Group представила самоуничтожающиеся SSD P250Q, а также DDR5-модули памяти CU-DIMM, CSO-DIMM, (LP)CAMM и CXLКомпания Team Group 2025 анонсировала большое количество новинок для индустриального и коммерческого применения. Дебютировали SSD в различных форм-факторах, модули оперативной памяти, а также флеш-карты micro SD. В частности, представлен накопитель P250Q One-Click Data Destruction SSD, особенность которого заключается в поддержке физического уничтожения флеш-памяти с целью недопустимости извлечения информации. Эта функция дополняет традиционное программное стирание, исключая возможность восстановления конфиденциальных данных. Кроме того, анонсированы накопители RF40 E1.S Enterprise SSD в форм-факторе E1.S для дата-центров. Эти устройства допускают горячую замену, а за отвод тепла отвечает запатентованный медно-графеновый радиатор толщиной всего 0,17 мм. На промышленный сектор ориентированы изделия серий R840 и R250 типоразмера М.2, оснащённые интерфейсом PCIe 5.0 x4. В этих SSD применён контроллер, при производстве которого используется 6-нм технология TSMC. Информация о вместимости и скоростных характеристиках всех перечисленных изделий пока не раскрывается. В список новинок вошли модули оперативной памяти промышленного класса DDR5 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Они функционируют на частоте 6400 МГц при напряжении питания 1,1 В. Эти модули могут применяться в серверах, индустриальных ноутбуках повышенной прочности и пр.

Источник изображения: Team Group Анонсированы также модули памяти CAMM2 и LPCAMM2 (Compression Attached Memory Module 2), рассчитанные на промышленные системы, edge-устройства и пр. Такие решения монтируются параллельно материнской плате, благодаря чему занимают меньше места в высоту. Для установки применяются резьбовые стойки. Память соответствует стандарту DDR5-6400.

В число прочих новинок вошли серверные модули памяти CXL 2.0 Server Memory Module. Плюс к этому представлены карты памяти D500R WORM Memory Card и D500N Hidden Memory Card. Первые ориентированы WORM-нагрузки (Write Once, Read Many), что предотвращает стирание или изменение данных. Карты второго типа получили встроенную функцию скрытия разделов.

03.03.2025 [08:13], Сергей Карасёв

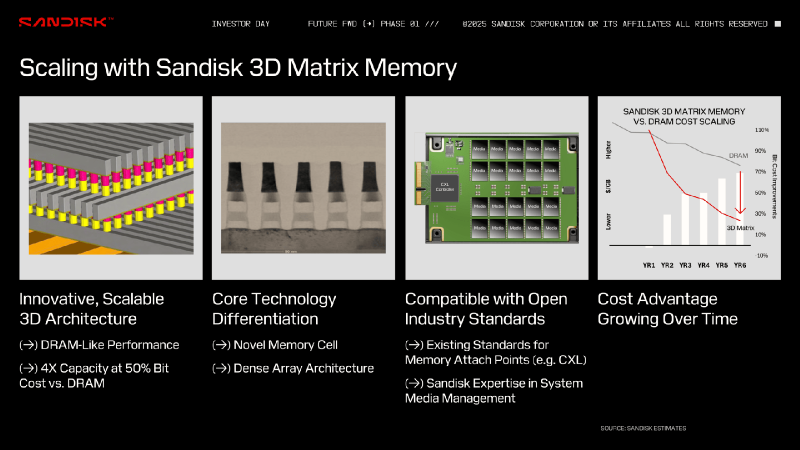

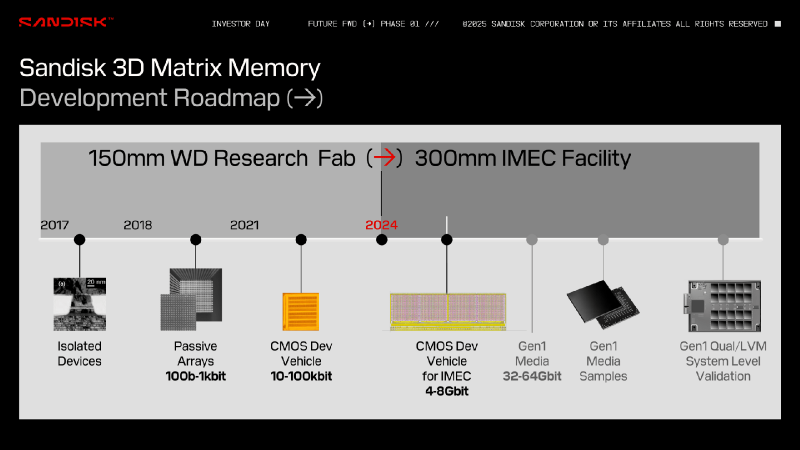

Больше бит за те же деньги: память Sandisk 3D Matrix Memory обещает производительность на уровне DRAM при снижении цены и увеличении ёмкостиКомпания Sandisk, по сообщению TechRadar, обнародовала информацию о памяти нового типа 3D Matrix Memory, которая, как ожидается, в перспективе станет более доступной альтернативой DRAM. Работы над 3D Matrix Memory ведутся с 2017 года в сотрудничестве со специалистами международного микро- и наноэлектронного научно-исследовательского центра IMEC в Лёвене (Бельгия). 3D Matrix Memory использует архитектуру плотного массива с ячейками памяти нового типа. Говорится о совместимости с открытыми отраслевыми стандартами, такими как CXL. По утверждениям Sandisk, разрабатываемая технология позволит преодолеть ограничения в плане ёмкости и пропускной способности, с которыми столкнулись другие типы памяти на фоне стремительного развития ИИ. Для 3D Matrix Memory заявлен высокий уровень масштабируемости. Предполагается, что в перспективе такая память обеспечит в четыре раза большую ёмкость по сравнению с DRAM при сопоставимой производительности и двукратном снижении стоимости. Sandisk утверждает, что характеристики памяти 3D Matrix Memory с течением времени будут улучшаться, повышая её экономическую эффективность. Изделия 3D Matrix Memory первого поколения будут обладать ёмкостью 32–64 Гбит. Одним из первых покупателей памяти станет Министерство обороны США, которое намерено использовать её в аэрокосмическом секторе. О сроках начала массового производства пока ничего не сообщается. Нужно отметить, что ранее Sandisk предложила технологию флеш-памяти с высокой пропускной способностью HBF (High Bandwidth Flash), которая может стать альтернативой HBM (High Bandwidth Memory) в ИИ-ускорителях при решении определённых задач, таких как инференс. По сравнению с HBM использование HBF позволит увеличить объём памяти ИИ-карт в 8 или даже 16 раз при сопоставимой цене. Кроме того, Sandisk проектирует SSD сверхвысокой вместимости для дата-центров: накопители на фирменной платформе UltraQLC смогут вмещать до 1 Пбайт информации.

28.02.2025 [12:35], Сергей Карасёв

Broadcom представила новые решения PCIe 6.0 — чип-коммутатор и ретаймерыВ марте прошлого года Astera Labs анонсировала чипы Aries 6 для PCIe 6.0. Теперь компания Broadcom объявила о доступности собственных решений PCIe 6.0: дебютировали чип-коммутатор PEX 90144, а также ретаймеры BCM85668 и BCM85667. Отмечается, что изделия с поддержкой PCIe 6.0 являются «критически важными высокопроизводительными строительными блоками», необходимыми для развёртывания передовой инфраструктуры ИИ. В тестировании продуктов приняли участие такие компании, как Micron и Teledyne LeCroy.

Источник изображений: Broadcom Ретаймеры BCM85668 и BCM85667 поддерживают соответственно 8 и 16 линий PCIe 6. При производстве применяется 5-нм технология. Говорится об обратной совместимости с PCIe поколений 5/4/3/2/1, а также о совместимости с Compute Express Link (CXL 3.1). Возможна работа в режимах 64, 32, 16, 8, 5 и 2,5 GT/s (млрд пересылок в секунду). Изделие BCM85668 поддерживает бифуркацию x8, 2 x4 и 4 x2. В случае BCM85667 возможны конфигурации 1 x16, 4 x4 и 8 x2. Заявлена поддержка режимов с низким энергопотреблением и проприетарных режимов с малой задержкой (LL).  Чип-коммутатор PEX 90144, в свою очередь, имеет 144 линии. Изделие предназначено для координации потоков трафика. Полностью технические характеристики на данный момент не раскрываются. Год назад также упоминались чипы PEX 90104 и говорилось о разработке коммутаторов PCI Express 7.0 с поддержкой AMD AFL (Accelerated Fabric Link), коммутируемого варианта Infinity Fabric. |

|