Материалы по тегу: cxl

|

16.01.2025 [08:04], Алексей Степин

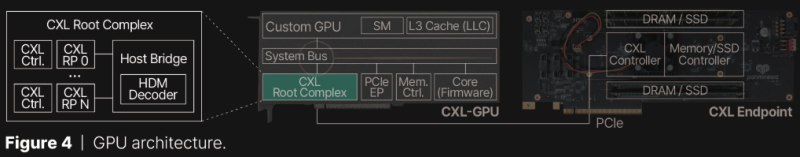

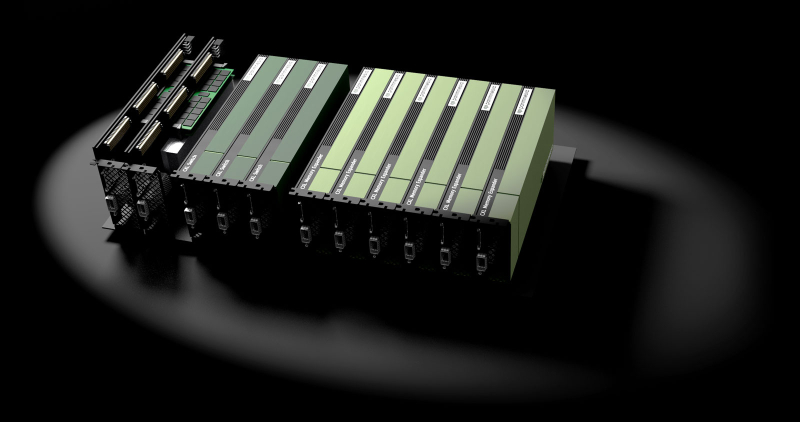

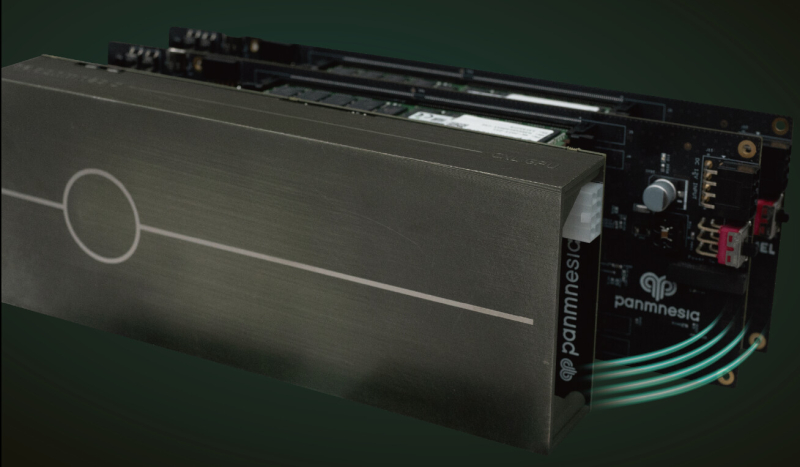

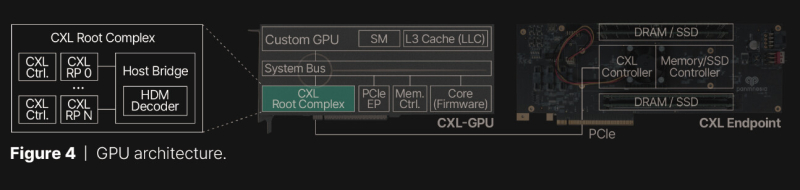

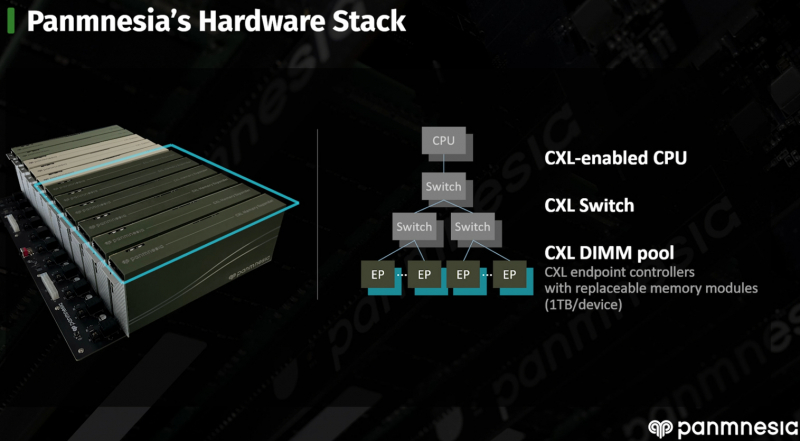

Терабайтные GPU: Panmnesia продемонстрировала CXL-память для ИИ-ускорителейКомпания Panmnesia работает в области проектирования CXL-пулов DRAM довольно давно: в 2023 году она демонстрировала систему, оставляющую позади все решения на базе RDMA и обеспечивающую доступ к 6 Тбайт оперативной памяти. Но большие объёмы памяти сегодня, в эпоху всё более усложняющихся ИИ-моделей, нужны не только и не столько процессорам, сколько ускорителям, априори лишённым возможности апгрейда набортной RAM. На выставке CES 2025 компания продемонстрировала решение данной проблемы. По мнению разработчиков Panmnesia, производительность при обучении масштабных ИИ-моделей упирается именно в объёмы набортной памяти ускорителей: вместо десятков гигабайт требуются уже терабайты, а установка дополнительных ускорителей может обходиться слишком дорого при том, что вычислительные мощности окажутся избыточными. Продемонстрированная на выставке CXL-система построена на базе новейшего контроллера Panmnesia с поддержкой CXL 3.1. В двунаправленном режиме латентность доступа составила менее 100 нс и находится примерно на уровне 80 нс. Ключ к успеху здесь кроется в фирменной реализации CXL 3.1, включая программную часть, благодаря которой GPU могут обращаться к общему пулу памяти, используя те же инструкции типа load/store, что при доступе к набортной HBM или GDDR. Однако технология требует наличия на борту GPU фирменного контроллера CXL Root Complex, одной из важнейших частей которого является декодер HDM, отвечающий за управление адресным пространством памяти (host physical address, HPA), так что уже выпущенные ускорители напрямую работать с системой Panmnesia не смогут. Тем не менее, технология выглядит многообещающей. Она уже привлекла внимание со стороны компаний, занимающихся ИИ, как потенциально позволяющая снизить стоимость инфраструктуры ЦОД.

04.01.2025 [15:21], Руслан Авдеев

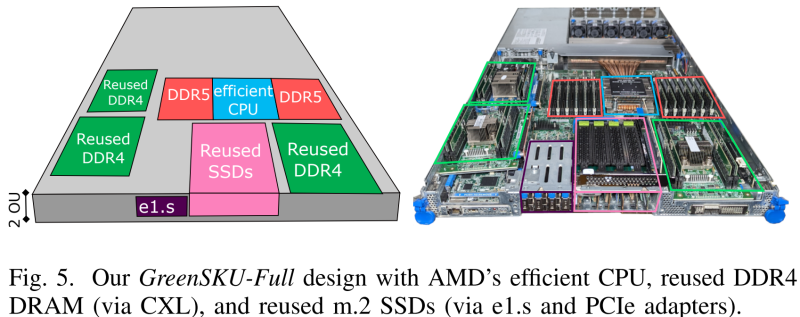

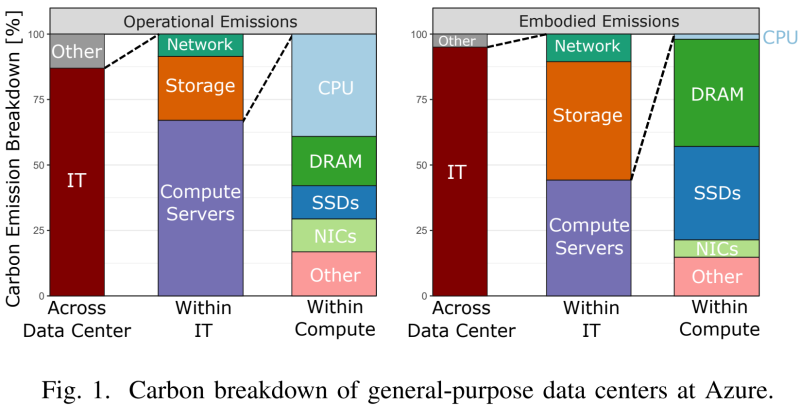

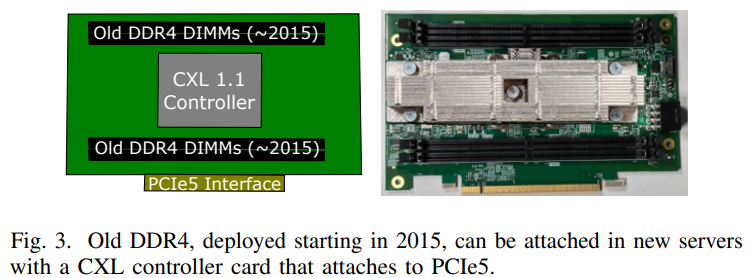

Microsoft совместно с учёными США разработала экологичные облачные серверы GreenSKU, которые используют RAM и SSD из старых системУчёные из Microsoft, Университета Карнеги-Меллона и Вашингтонского университета разработали новый стандарт экологичных серверов GreenSKU, которые позволят снизят углеродные выбросы ЦОД, сообщает IEEE Spectrum. Кроме того, была представлена модель GreenSKU Framework для расчёта целесообразности использования подобных систем в дата-центрах гиперскейлеров и подбора оптимальных конфигураций. Созданные в рамках концепции GreenSKU прототипы серверов были протестированы в ЦОД Azure.

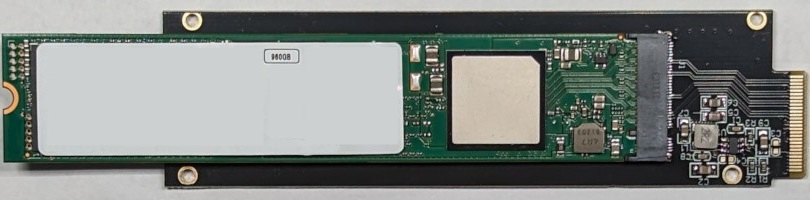

Источник изображений: Microsoft Исследование, вышедшее минувшим летом, изучает возможность использования компонентов из списанных серверов. Это важно, поскольку сегодня во многих случаях при сбое одного компонента из эксплуатации выводится сервер целиком. Кроме того, Microsoft меняет серверы Azure каждые 3–5 лет для оптимизации производительности. И в этом случае работоспособные компоненты всё равно обычно не используются в других серверах. Согласно выкладкам исследователей, уровень сбоев оперативной памяти (AFR) после кратковременного всплеска вскоре после развёртывания остаётся примерно одинаковым на протяжении не менее семи лет. А износ SSD составляет около половины. Впрочем, в данном случае речь идёт об M.2-накопителях. Их надёжность и скорость работы можно повысить простым объединением в RAID-массив. А для их использования в современных платформах с E1.S-корзинами есть готовые пассивные адаптеры, благо стандарт PCIe обладает обратной совместимостью.  С памятью дело обстоит не так просто. Предыдущие поколения серверов использовали DDR4, тогда как актуальные платформы работают только с DDR5. Однако выход есть — в современных CPU появилась поддержка CXL. Точнее, CXL Type 3 (CXL.mem), что позволяет подключать по PCIe пулы DRAM. Они представлены в виде NUMA-узлов без CPU. Такое подключение памяти даёт большую задержку, но современные гипервизоры умеют работать с такими пулами, отправляя в них редко используемые массивы данных.  Старые процессоры переиспользовать не выйдет. Они гораздо менее энергоэффективны и производительны, при этом на CPU приходится основная часть энергопотребления и, соответственно, углеродных выбросов. Исследователи изучили актуальные предложения вендоров и пришли к выводу, что среди доступных на рынке процессоров наилучшим образом для GreenSKU подходят AMD EPYC Bergamo, которые предлагает большое количество ядер и потоков при сравнимом уровне TDP, пусть и при пониженной производительности каждого ядра, а также поддерживают необходимые протоколы CXL. Для распределения нагрузок используется отдельный программный слой, определяющий, какие задачи можно выполнять на серверах GreenSKU, а какие — на стандартных серверах Azure в зависимости от требований к производительности. Как отмечают исследователи, три четверти развёрнутых в Azure инстансов в среднем используют лишь 25 % выделенных ресурсов CPU и около 15 % от доступной пропускной способности памяти. Точно так же далеко не в полной мере используются и SSD. Вместе с тем есть клиенты, которые выживают максимум из каждого инстанcа. Снижение углеродных выбросов имеет большое значение для облачных вычислений, поскольку они могут составить 20 % всех выбросов к 2030 году — об этом свидетельствуют данные НКО Ассоциация вычислительной техники. В пересчёте на ядро выбросы серверов GreenSKU на 28 % ниже, чем выбросы обычных серверов Azure. А на уровне ЦОД с учётом всех накладных расходов снижение выбросов составляет 8 %.

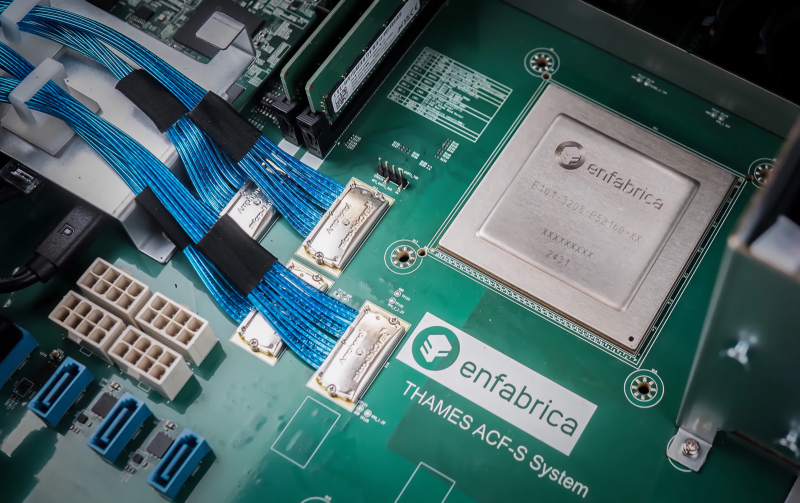

23.11.2024 [12:38], Сергей Карасёв

Стартап Enfabrica выпустил чип ACF SuperNIC для ИИ-кластеров на базе GPUКомпания Enfabrica, занимающаяся разработкой инфраструктурных решений в сфере ИИ, объявила о доступности чипа Accelerated Compute Fabric (ACF) SuperNIC, предназначенного для построения высокоскоростных сетей в рамках кластеров ИИ на основе GPU. Кроме того, стартап провёл очередной раунд финансирования. Напомним, Enfabrica предлагает CXL-платформу ACF на базе ASIC собственной разработки, которая позволяет напрямую подключать друг к другу любую комбинацию GPU, CPU, DDR5 CXL и SSD, а также предоставляет 800GbE-интерконнект. Утверждается, что ACF SuperNIC может обеспечить улучшенную масштабируемость и производительность с более низкой совокупной стоимостью владения для распределённых рабочих нагрузок ИИ по сравнению с другими решениями, доступными на рынке. Изделие ACF SuperNIC (ACF-S) позволяет использовать от четырёх до восьми самых современных ускорителей в расчёте на серверную систему. Чип обеспечивает поддержку 800GbE, 400GbE и 100GbE, 32 сетевых портов и 160 линий PCIe. Благодаря этому становится возможным формирование ИИ-кластеров, насчитывающих более 500 тыс. GPU. Программный стек ACF-S поддерживает стандартные коммуникационные и сетевые операции RDMA через набор библиотек, совместимых с существующими интерфейсами. Фирменная технология Resilient Message Multipathing (RMM) повышает отказоустойчивость кластера ИИ и удобство обслуживания. RMM устраняет простои из-за сбоев и отказов сетевых соединений, повышая эффективность. Функция Collective Memory Zoning обеспечивает снижение задержек. Поставки чипов ACF SuperNIC начнутся в I квартале 2025 года. Что касается нового раунда финансирования, то по программе Series C привлечено $115 млн. Раунд возглавила фирма Spark Capital с участием новых инвесторов — Maverick Silicon и VentureTech Alliance. Кроме того, средства предоставили существующие инвесторы в лице Atreides Management, Sutter Hill Ventures, Alumni Ventures, IAG Capital и Liberty Global Ventures.

05.09.2024 [11:21], Сергей Карасёв

Innodisk представила CXL-модули памяти объёмом 64 Гбайт для ИИ-серверовКомпания Innodisk анонсировала модуль памяти CXL (Compute Express Link), разработанный с прицелом на системы ИИ и облачные дата-центры. Массовые поставки изделия планируется организовать в I квартале 2025 года. Спрос на ИИ-серверы быстро растет. Согласно прогнозам Trendforce, в 2024 году такие системы займут примерно 65 % глобального рынка серверов (в деньгах). По словам Innodisk, сейчас ИИ-системам требуется не менее 1,2 Тбайт оперативной памяти для эффективной работы. Традиционные изделия DDR не всегда способны удовлетворить предъявляемые требования, что приводит к таким проблемам, как недоиспользование ресурсов CPU и увеличение задержек, говорит компания. Модули CXL призваны устранить подобные ограничения. Напомним, CXL — это высокоскоростной интерконнект, обеспечивающий взаимодействие хост-процессора с акселераторами, буферами памяти, устройствами ввода/вывода и пр. Решение Innodisk использует интерфейс PCIe 5.0 x8 и имеет ёмкость 64 Гбайт. Модуль обеспечивает пропускную способность до 32 Гбайт/с. Говорится о совместимости с CXL 1.1/2.0. Устройство выполнено в форм-факторе E3.S 2T и оснащено коннектором EDSFF 2C. Диапазон рабочих температур простирается от 0 до +70 °C. Отмечается, что в случае установки четырёх модулей Innodisk CXL на 64 Гбайт каждый в сервер, который несёт на борту восемь DIMM по 128 Гбайт, общий объём памяти может быть увеличен на четверть, а общая пропускная способность — на 40 %. При этом CXL обеспечивает пулинг памяти, что позволяет оптимизировать совместное использование ресурсов и повысить общую эффективность системы.

13.08.2024 [11:19], Сергей Карасёв

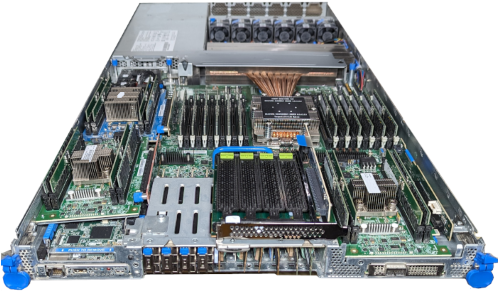

MSI представила сервер S2301 с поддержкой CXL на базе AMD EPYC TurinКомпания MSI в ходе выставки Future of Memory and Storage 2024 (FMS) анонсировала сервер S2301, предназначенный для работы с резидентными базами данных, НРС-приложениями, платформами для автоматизации проектирования электроники (EDA) и пр. Сервер поддерживает стандарт CXL 2.0 на основе интерфейса PCIe. Технология обеспечивает высокоскоростную передачу данных с малой задержкой между хост-процессором и такими устройствами, как серверные ускорители, буферы памяти и интеллектуальные IO-блоки. На основе CXL 2.0 функционирует высокопроизводительный механизм доступа к памяти, который позволяет модулям расширения напрямую взаимодействовать с иерархией памяти CPU. При этом дополнительные блоки памяти работают так, как если бы они были частью собственной памяти системы. Подключив к серверу модули расширения CXL, можно с высокой эффективностью масштабировать ресурсы для обработки сложных задач. Сервер MSI S2301 поддерживает установку двух процессоров AMD EPYC поколения Turin. Доступны 24 слота для модулей ОЗУ. Возможно применение CXL-модулей в форм-факторе E3.S 2T (PCIe 5.0 x8). Такие решения, в частности, в августе 2023 года представила компания Micron Technology. Устройства имеют вместимость 128 и 256 Гбайт. Кроме того, память DRAM с поддержкой CXL 2.0 предлагает Samsung. Во фронтальной части нового сервера располагаются отсеки для SFF-модулей. Говорится об использовании софта Memory Machine X разработки MemVerge, который оптимизирует затраты и помогает улучшить производительность ИИ-приложений и других ресурсоёмких рабочих нагрузок путём интеллектуального управления памятью.

03.07.2024 [23:49], Сергей Карасёв

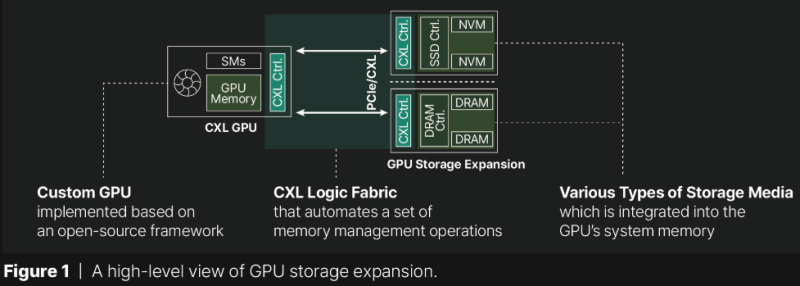

Panmnesia расширит память GPU с помощью DRAM или даже SSDЮжнокорейский стартап Panmnesia сообщил о разработке специализированного CXL-решения, которое позволяет расширять встроенную память ускорителей на базе GPU путём подключения внешних блоков DRAM или даже SSD. Отмечается, что современным приложениям ИИ и НРС требуется значительный объём быстрой памяти, но возможности ускорителей в этом плане ограничены. Сложность расширения памяти актуальных ускорителей заключается в том, что в таких изделиях отсутствуют логическая структура CXL и компоненты, поддерживающие DRAM и/или SSD. Кроме того, подсистемы кеша и памяти GPU не распознают никаких расширений. В лучшем случае предлагается механизм унифицированной виртуальной памяти (UVM) для совместного доступа к содержимому памяти и CPU, и GPU. Однако этот механизм довольно медленный. Panmnesia обошла существующие ограничения путём создания собственного root-комплекса, совместимого со стандартом CXL 3.1 и предоставляющего несколько root-портов. Он и обеспечивает поддержку внешней памяти через PCIe. При этом задействован особый декодер HDM (Host-managed Device Memory), отвечающий за работу с адресными пространствами. Это сложное решение в каком-то смысле «обманывает» подсистему памяти ускорителя, заставляя ее рассматривать внешнюю PCIe-память как доступную напрямую. Прототип, основанный на кастомизированном GPU, в ходе тестов продемонстрировало задержки менее 100 нс при передаче данных в обоих направлениях. При этом решение Panmnesia предоставляет более гранулярный доступ к памяти в сравнении с UVM. Быстродействие CXL-системы Panmnesia оказалось в 3,22 раза выше в пересчёте на IPC по сравнению с UVM.

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

14.03.2024 [23:45], Алексей Степин

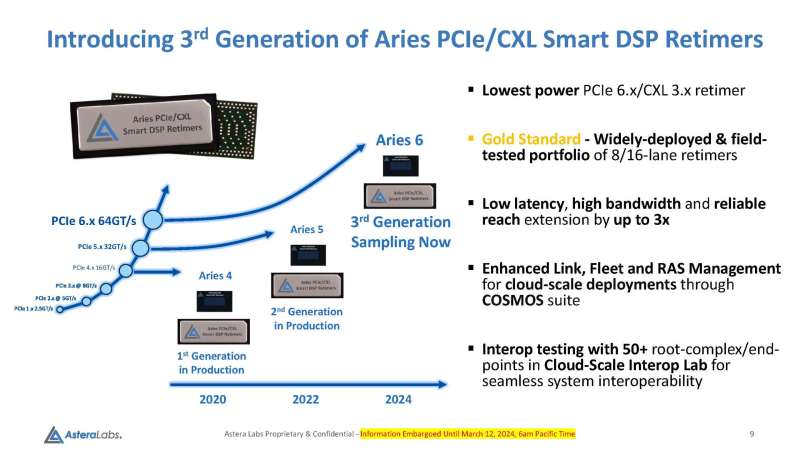

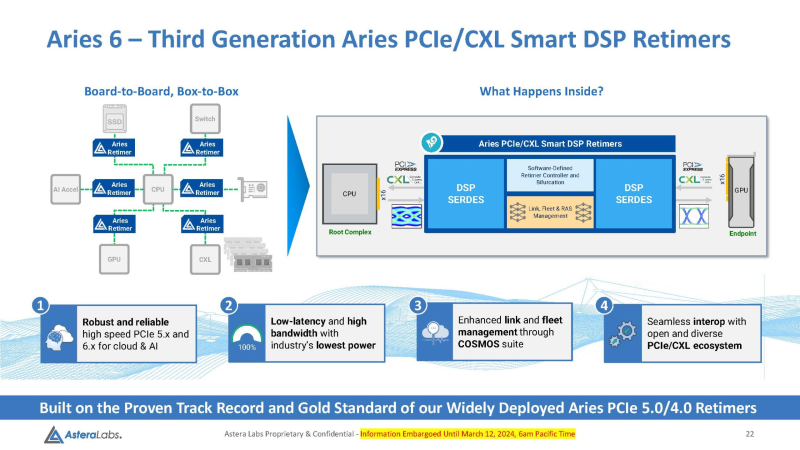

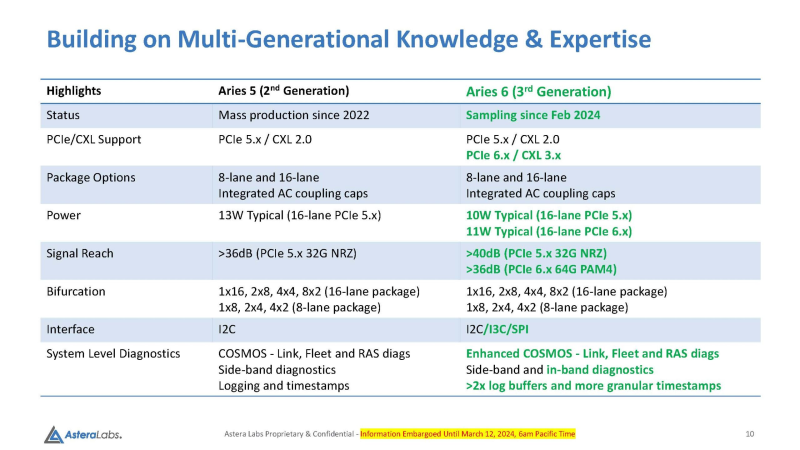

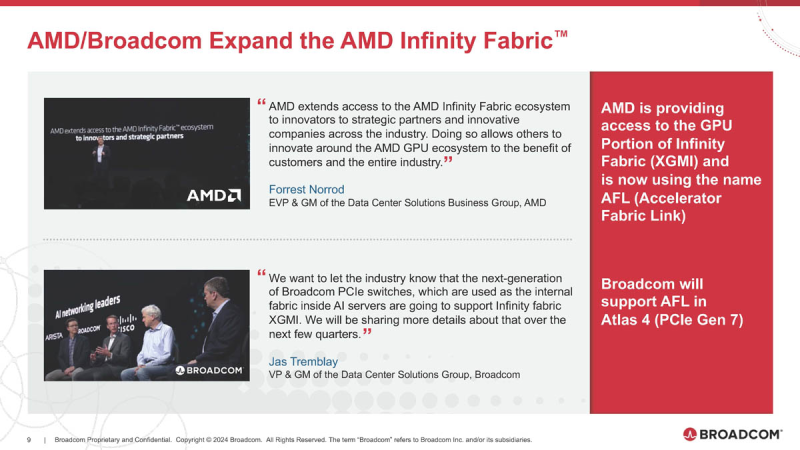

Войны ретаймеров: Astera Labs анонсировала чипы Aries 6 для PCIe 6.0Практически сразу после анонса чипов Broadcom Vantage 5 и 6 Astera представила свой вариант ретаймеров для инфраструктуры PCIe следующего поколения — серию чипов Aries 6, передаёт ServeTheHome. Высокий интерес к ретаймерам вызван теми возможностями, что открывает PCI Express 6.0 как в плане скоростей, так и в плане функциональности (CXL). А переход на новое поколение шины необходим для дальнейшего развития набирающего популярность генеративного ИИ. По мере роста скоростей PCI Express обострялась и проблема длины проводников на печатной плате, при которой сигнал достаточно устойчив и вписывается в окно требуемых характеристик. Если при переходе от PCIe 3.0 к 4.0 удалось обойтись сравнительно малой кровью, то для PCIe 5.0 уже потребовались более сложная схемотехника и более продвинутые ретаймеры. PCIe 6.0 же накладывает ещё более жёсткие требования к целостности сигнала. Платформы GPU-кластеров и СХД компактнее не становятся, так что требуемая длина проводников на печатных платах растёт, а вместе с ней растёт и важность ретаймеров, поскольку без них согласовать высокоскоростной сигнал PCIe 6.0 становится невозможно. Таким системам требуется сразу несколько подобных чипов, причём стоимость каждого из них достигает $20, так что суммарная стоимость этих компонентов на уровне целого ЦОД весьма внушительна. Новые чипы Aries 6 относятся к третьему поколению «умных» DSP-ретаймеров. Они представлены в вариантах с 8 и 16 линиями PCIe 6.0 и позволяют в три раза увеличить длину соответствующего соединения на плате, говорит Astera Labs. При этом новинки поддерживают CXL 3.x и предоставляют расширенные средства диагностики и управления COSMOS. Энергопотребление в режиме PCIe 6.0 при этом заявлено меньше, чем у Broadcom Vantage 6 — 11 Вт против 13 Вт у конкурента. Aries 6 уже протестированы на совместимость с полсотней разнообразных PCIe-соединений, включая root-комплексы и конечные устройства. И если Broadcom пока только говорит о ретаймерах для PCIe 6.0, а появление первого «кремния» Vantage 6 запланировано лишь на следующий год, то Astera Labs начала поставки образцов Aries 6 ещё в феврале. Похоже, Broadcom будет нелегко развернуться на этом рынке.

08.03.2024 [00:03], Алексей Степин

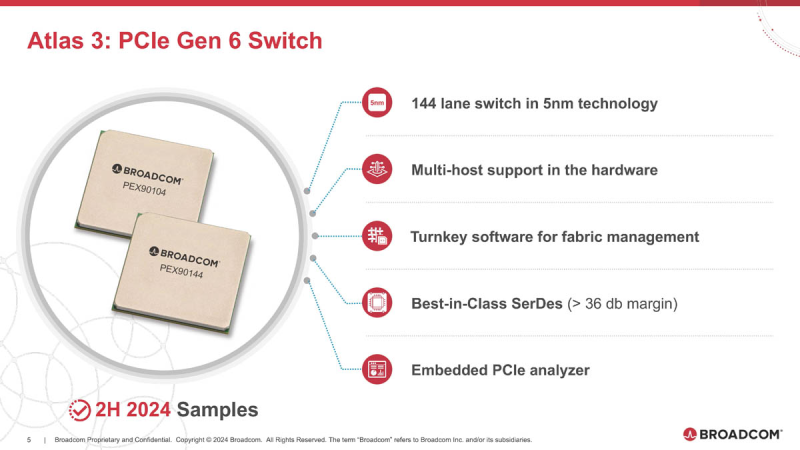

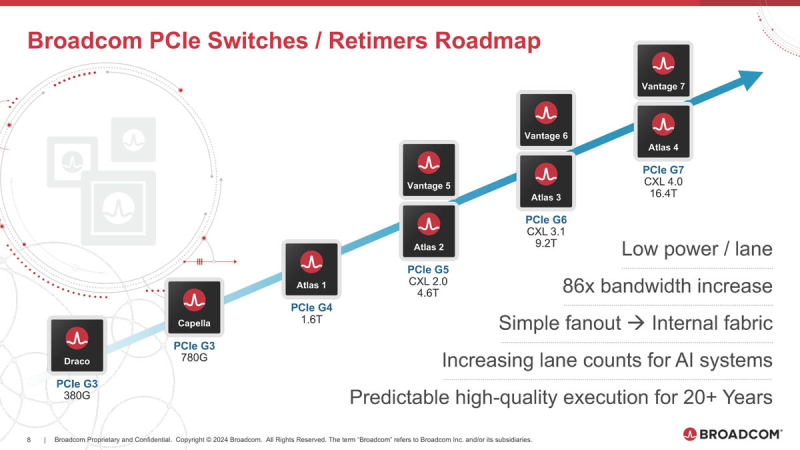

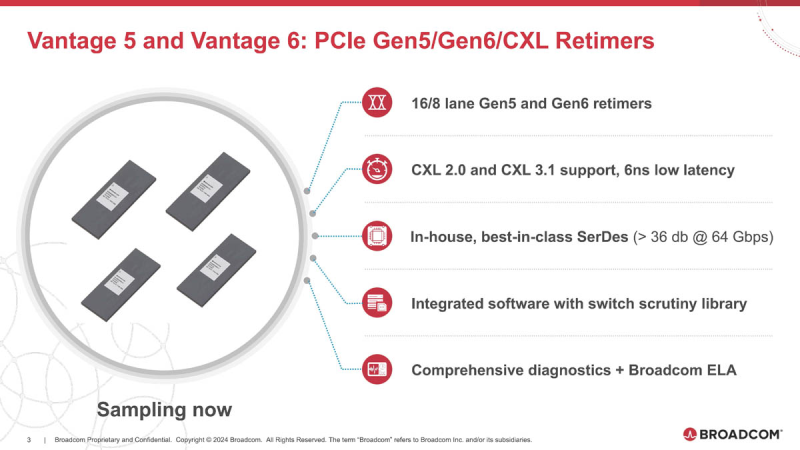

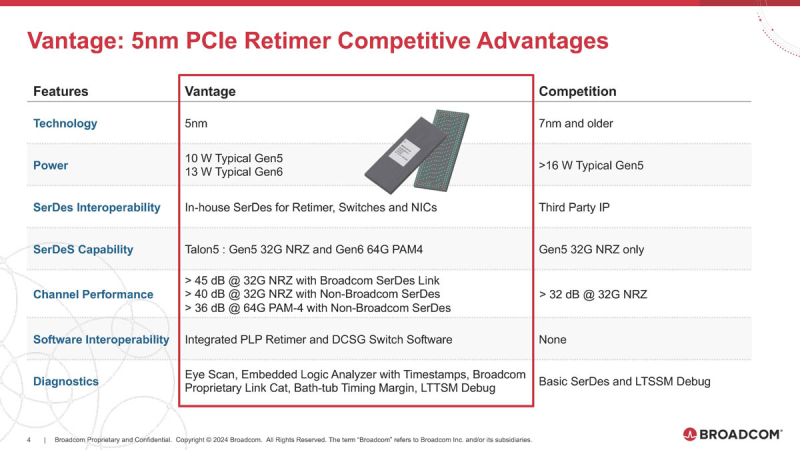

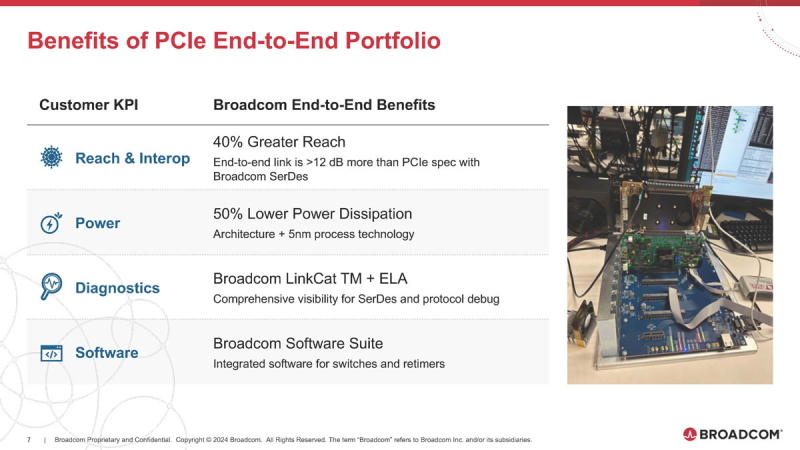

Broadcom готовит чипы для PCIe 6.0/7.0 с поддержкой AMD Infinity FabricОдним из столпов, на которых зиждется господство NVIDIA в мире ускорителей, является NVLink — высокоскоростной интерконнект, позволяющий чипам общаться напрямую не только в составе одного узла, но и за его пределами. AMD пытается ответить на это продвижением XGMI/Infinity Fabric, и в предварительном обзоре Instinct MI300 были затронуты вопросы топологии серверов в исполнении «красных». Ещё тогда, в момент анонса MI300, компания Broadcom объявила о поддержке данного интерконнекта в будущих поколениях своих PCIe-коммутаторов, а сейчас ресурс ServeTheHome поделился новыми подробностями. XGMI действительно станет коммутируемым, что упростит масштабирование систем на базе ускорителей AMD Instinct. Интерконнект получил официально название AFL (Accelerated Fabric Link). В основе AFL по-прежнему будет лежать PCI Express, в данном случае речь идёт уже о PCI Express 7.0. Поддержка данной технологии дебютирует в PCIe-коммутаторах Broadcom Atlas 4. В дополнение к ним будут выпущены и новые ретаймеры Vantage 7, которые также получат поддержку CXL 4.0. Но перед этим Broadcom начнёт поставки образцов чипов-коммутаторов Atlas 3 со 144 линиями PCIe 6.0 во II половине 2024 года, а серверы с такими коммутаторами появятся в 2025 году. Поддержка CXL здесь будет расширена до версии 3.1. Что касается ретаймеров, то здесь Broadcom уже нанесла ответный удар Astera Labs, анонсировав чипы серий Vantage 5 и Vantage 6 для экосистем PCI Express 5.0 и PCI Express 6.0 соответственно. Они будут выпускаться в вариантах с 8 и 16 линиями с опцией бифуркации и поддержкой CXL 2.0 и 3.1. Broadcom заявляет о более низком энергопотреблении, достигнутом за счёт применения 5-нм техпроцесса, лучших в индустрии блоках SerDes и расширенных средствах диагностики, интегрированных в новые ретаймеры. Экономичность здесь играет важную роль: хотя даже 7-нм ретаймер потребляет немного, таких микросхем в составе каждого GPU-сервера несколько, что при дальнейшем масштабировании выливается весьма серьёзные цифры. К тому же меньшая нагрузка ляжет и на систему охлаждения, ведь если CPU и ускорители могут обслуживаться СЖО, то остальные компоненты в таких серверах по-прежнему охлаждаются обычными вентиляторами. Что касается SerDes-блоков, то они позволят на 40 % удлинить соединения при сохранении стабильной работы. Ну а наличие продвинутого диагностического программного обеспечения с расширенными возможностями упростит разработку, отладку и ремонт систем нового поколения. Ретаймеры Vantage 5 будут использоваться в комплекте с коммутаторами Atlas 2 в решениях Broadcom уже сегодня, они обеспечат поддержку CXL 2.0, ну а системы с Vantage 6 и поддержкой CXL 3.1, как уже упоминалось, должны увидеть свет в следующем году. Astera Labs есть о чём беспокоиться: если на данный момент её ретаймерам почти нет альтернативы, то уже в ближайшем будущем ситуация может коренным образом измениться, поскольку Broadcom явно осознала всю важность этого компонента в экосистеме PCI Express и оценила солидный объём потенциальной клиентской базы.

14.08.2023 [17:37], Алексей Степин

CXL-пул Panmnesia втрое быстрее RDMA-систем и может предложить 6 Тбайт RAMНа конференции Flash Memory Summit южнокорейская компания Panmnesia продемонстрировала свою версию CXL-пула DRAM объёмом 6 Тбайт на базе программно-аппаратного стека собственной разработки. Новинка продемонстрировала более чем троекратное превосходство над системой, построенной на базе технологии RDMA, в нагрузках, связанной с работой рекомендательной ИИ-системы Meta✴. Panmnesia разработана в сотрудничестве с Корейским инститом передовых технологий (KAIST). О более раннем варианте разработок KAIST в этой области мы рассказывали в 2022 году. Коммерческий вариант комплекса поддерживает CXL 3.0 и состоит из CXL-процессора, коммутатора и модулей расширения памяти. Все модули выполнены в форм-факторе, чрезвычайно напоминающем FHFL-карты. Модули устанавливаются в универсальное шасси, при этом их можно произвольно комбинировать. Демо-платформа содержала два процессорных модуля, три модуля коммутации и шесть 1-Тбайт модулей памяти. Модули памяти построены на базе обыкновенных DIMM-планок и поддерживают их замену и расширение. Реализован не только режима CXL.mem, но и CXL.cache и CXL.io. При этом компания предлагает не только готовые IP-решения, но и их кастомизацию под конкретного заказчика, что поможет оптимизировать цикл создания продукта и снизить общую стоимость разработки и валидации. Фирменное ПО базируется на Linux и содержит необходимые драйверы, а также специализированную виртуальную машину, с помощью которой пространство памяти представляется в виде безпроцессорного NUMA-узла. Поверх этих компонентов функционирует пользовательская часть, отвечающая за эффективное размещение и предвыборку (prefetching) данных. По ряду параметров Panmnesia можно назвать лидером в области CXL-решений. В частности, по объёму DRAM она уже обгоняет совместное решение Samsung, MemVerge, H3 и XConn, а использование DIMM-модулей только придаёт ей гибкости. Развитая программная часть, как утверждается, упрощает и удешевляет интеграцию в существующую инфраструктуру ЦОД. Спектр применения, как и у всех систем CXL-пулинга, крайне широкий и включает в себя не только ИИ-сценарии, но и любые задачи, требующие большого объёма оперативной памяти. |

|