Материалы по тегу: ram

|

29.09.2025 [17:53], Владимир Мироненко

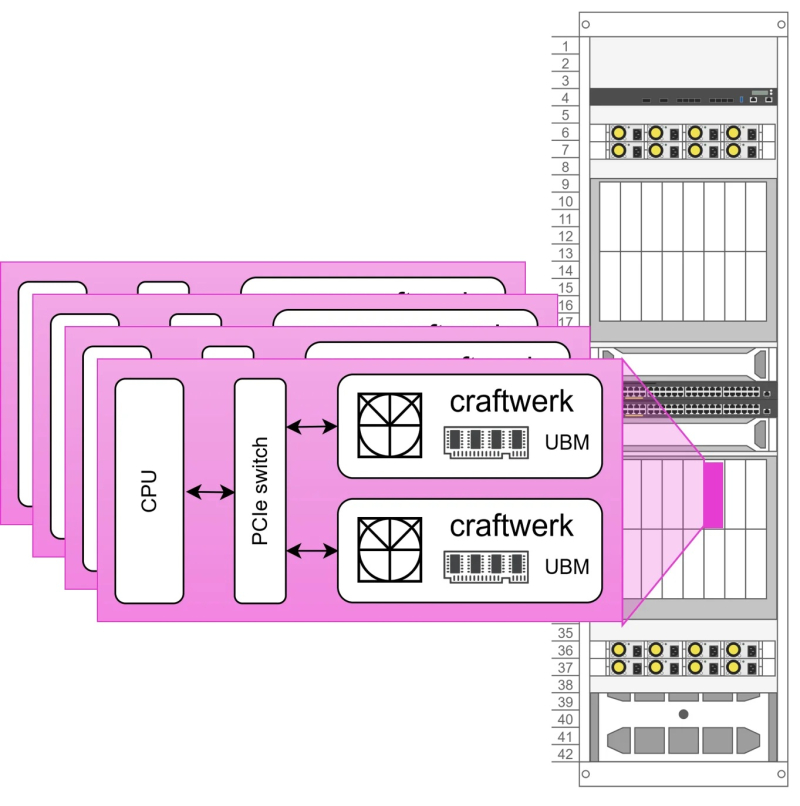

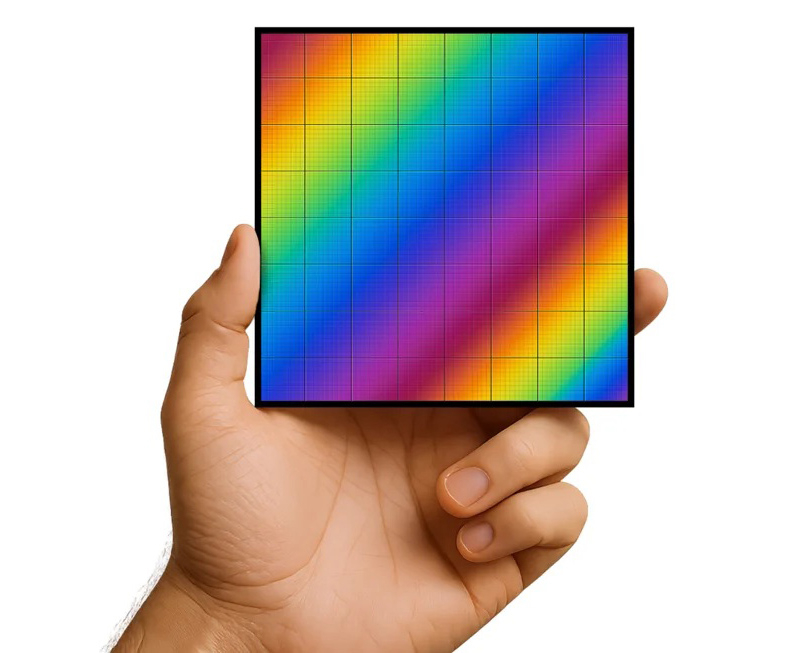

Euclyd разрабатывает ИИ-ускоритель Craftwerk с фирменной памятью UBM: 1 Тбайт и 8 Пбайт/сСтартап Euclyd, вышедший из скрытого режима (stealth mode), рассказал на саммите AI Infra Summit некоторые подробности о разрабатываемом чипе, который обеспечит более низкое энергопотребление и более низкую стоимость в расчёте на токен по сравнению с существующими решениями, пишет ресурс EE Times. Сама компания называет его первым в мире «кремнием» для агентного ИИ. Ингольф Хелд (Ingolf Held), соучредитель и вице-президент по продуктам Euclyd, сообщил ресурсу EE Times, что чип представляет собой огромную конструкцию из множества чиплетов, объединённых в модуль SiP (System-in-Package) под названием Craftwerk. Он будет включать 16 384 SIMD-блоков и обеспечивать производительность до 8 Пфлопс (FP16) или 32 Пфлопс (FP4). Эти вычислительные элементы разработаны Euclyd с нуля. В устройстве будет использоваться кремниевый интерпозер с максимально крупными размерами (примерно 100 × 100 мм) с 2,5D- и 3D-компонентами.

Источник изображений: Euclyd «Мы разработаем его сами — мы не будем наследовать ничего от Arm или RISC-V, и он будет полностью программируемым с помощью наших собственных инструментов», — сказал он. По словам Хелда, дизайн будет поддерживать программируемость, чтобы гарантировать возможность ускорения будущих нагрузок, будь то мультимодальный инференс, логические рассуждения, рекуррентные модели, модели пространства состояний или диффузионные модели. Euclyd объединит вычислительные чиплеты с кастомной памятью Ultra Bandwidth Memory (UBM) — 1 Тбайт DRAM с пропускной способностью 8000 Тбайт/с в той же упаковке Craftwerk. По словам Хелда, ИИ-ускорители со SRAM работают быстро, но при их использовании приходится разделять обработку ИИ-нагрузки между множеством чипов из-за малого объёма такой памяти. HBM имеет достаточную ёмкость, но её пропускная способность мала для решения задач, поставленных Euclyd. И хотя UBM от Euclyd отличается кастомным дизайном, для её изготовления не потребуется какой-то экзотический технологический процесс. Craftwerk позволит реализовать многоагентные рабочие процессы на одном кристалле кремния с TDP в пределах 3 кВт, отметил Хелд. По словам компании, NVIDIA DGX-B200 может обрабатывать 1038 токенов/с для одного пользователя Llama4-Maverick (400B), Cerebras предлагает 2554 токена/с для одного пользователя, а один SiP Craftwerk будет обрабатывать 20 тыс. токенов/с для одного пользователя. Стойка Euclyd будет включать 16 хост-процессоров и 32 модуля Craftwerk в шасси с жидкостным охлаждением с общим TDP 125 кВт. По оценкам Euclyd, в типичном многопользовательском сценарии эта система будет предлагать 7,68 млн токенов/с для Llama4-Maverick. На данный момент у Euclyd три частных инвестора: Питер Веннинк (Peter Wennink, бывший генеральный директор ASML), Федерико Фаггин (Federico Faggin, один из изобретателей микропроцессора и основатель Zilog и Synaptics) и Стивен Шурман (Steven Schuurman, основатель Elastic). В ближайшее время компания планирует привлечь венчурный капитал для запуска производства и масштабирования, но, по словам Хелда, посевного финансирования должно быть достаточно для демонстрации работоспособности кремниевых чипов. Сооснователь и консультант Euclyd Атул Синха (Atul Sinha) заявил EE Times, что Европа лучшее место для талантливых дизайнеров, чем Кремниевая долина. Он подтвердил, что Euclyd планирует оставаться в юрисдикции Нидерландов со штаб-квартирой ИТ-кампусе Эйндховена, где также находится штаб-квартира NXP. «Чего люди не понимают, так это то, что в Европе есть места, где действительно есть значительный набор технологий и кадровая база, — сказал Синха. — Для полупроводников Эйндховен, безусловно, на первом месте. Я бы сказал, что лучше места нет».

15.09.2025 [11:44], Сергей Карасёв

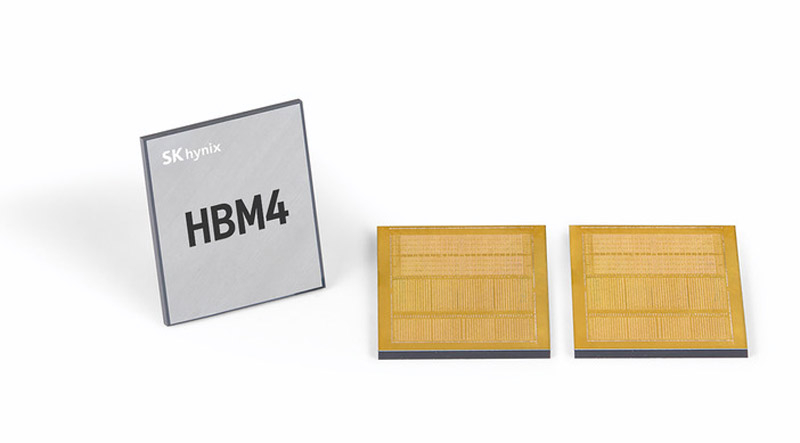

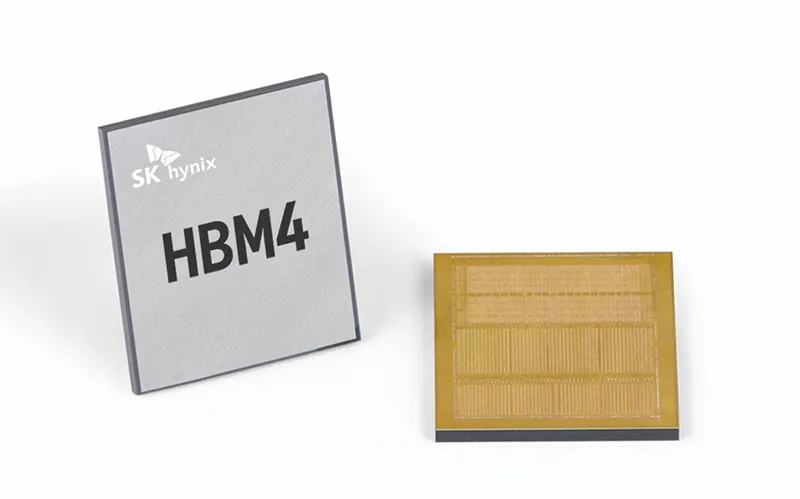

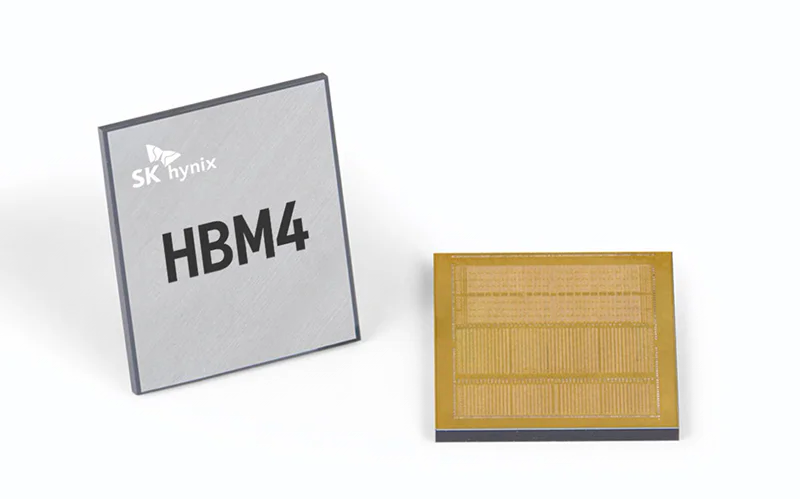

SK hynix завершила разработку памяти HBM4 для ИИ-системКомпания SK hynix объявила о том, что она первой среди участников отрасли завершила разработку памяти с высокой пропускной способностью HBM4 для ИИ-систем. В настоящее время готовится организация массового производства таких изделий. HBM4 — это шестое поколение памяти данного типа после оригинальных решений HBM, а также HBM2, HBM2E, HBM3 и HBM3E. Ожидается, что чипы HBM4 будут применяться в продуктах следующего поколения AMD, Broadcom, NVIDIA и др. Стеки памяти HBM4 от SK hynix оснащены 2048-бит IO-интерфейсом: таким образом, разрядность интерфейса HBM удвоилась впервые с 2015 года. Заявленная скорость передачи данных превышает 10 Гбит/с, что на 25 % превосходит значение в 8 Гбит/с, определённое официальным стандартом JEDEC. Пропускная способность HBM4 увеличилась вдвое по сравнению с предыдущим поколением НВМ, тогда как энергоэффективность повысилась на 40 %.

Источник изображения: SK hynix При изготовлении чипов HBM4 компания SK hynix будет применять 10-нм технологию пятого поколения (1bnm) и методику Advanced Mass Reflow Molded Underfill (MR-MUF). Последняя представляет собой способ объединения нескольких чипов памяти на одной подложке посредством спайки: сразу после этого пространство между слоями DRAM, базовым кристаллом и подложкой заполняется формовочным материалом для фиксации и защиты структуры. Технология Advanced MR-MUF позволяет выдерживать высоту HBM-стеков в пределах спецификации и улучшать теплоотвод энергоёмких модулей памяти. SK hynix не раскрывает ни количество слоёв DRAM в своих изделиях HBM4, ни их ёмкость. Как отмечает ресурс Tom's Hardware, по всей видимости, речь идёт об 12-Hi объёмом 36 Гбайт, которые будут использоваться в ускорителях NVIDIA Rubin. По заявлениям SK hynix, внедрение HBM4 позволит увеличить производительность ИИ-ускорителей на 69 % по сравнению с нынешними решениями. Это поможет устранить узкие места в обработке информации в ИИ ЦОД.

25.08.2025 [11:20], Сергей Карасёв

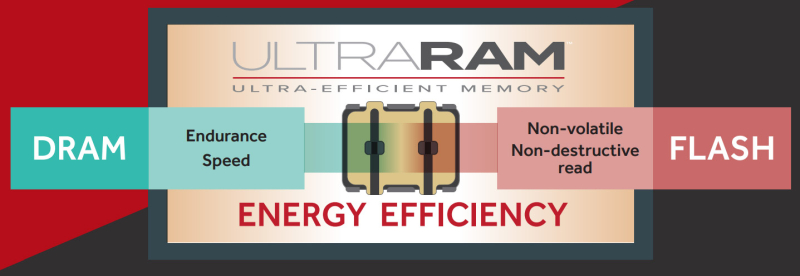

Энергонезависимая память UltraRAM стала на шаг ближе к реальностиБританская компания QuInAs Technology, по сообщению ресурса Blocks & Files, ещё на шаг приблизилась к серийному производству своей универсальной памяти UltraRAM, сочетающей такие характеристики, как высокая скорость DRAM, энергонезависимость NAND и низкое энергопотребление. В разработке технологий, лежащих в основе UltraRAM, приняли участие исследователи из Университета Ланкастера (Lancaster University) и Университета Уорика (University of Warwick). Утверждается, что UltraRAM потребляет в 100 раз меньше энергии, чем DRAM, и в 1000 раз меньше, чем NAND-флеш. Данные в новой памяти могут храниться на протяжении 1000 лет. Кроме того, UltraRAM обладает высокой надёжностью: она может быть перезаписана не менее 10 млн раз. Принцип работы UltraRAM основан на эффекте квантового туннелирования электронов через энергетический барьер в ячейку. Этот барьер формируется путём чередования тонкоплёночных слоёв антимонида галлия (GaSb) и антимонида алюминия (AlSb). В обычной памяти 3D NAND оксидный плавающий затвор в ячейке постепенно разрушается, тогда как у UltraRAM затвор практически не подвержен внешним воздействиям, говорят создатели. Благодаря этому обеспечивается большое количество циклов записи/стирания. Партнёром QuInAs в рамках проекта по организации массового производства UltraRAM выступает компания IQE, тогда как грантовое финансирование предоставляет Innovate UK. Специалисты IQE разработали производственный процесс получения структур для UltraRAM с использованием эпитаксии (нарастание одного кристаллического материала на другом). В настоящее время QuInAs и IQE обсуждают возможности коммерциализации памяти нового типа с производственными предприятиями и стратегическими партнёрами. Ожидается, что UltraRAM сможет найти применение в самых разных устройствах — от автономных изделий интернета вещей (IoT) и смартфонов до ноутбуков и оборудования для дата-центров.

07.08.2025 [12:18], Андрей Крупин

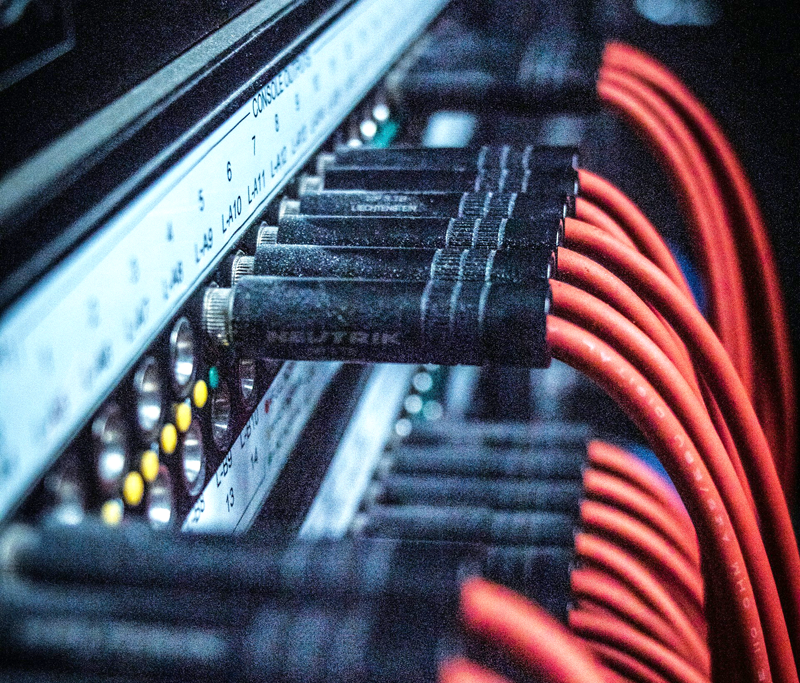

«Вымпелком» запустил новый узел связи в ФинляндииТелекоммуникационный оператор «Вымпелком», предоставляющий услуги под брендом «Билайн», объявил о запуске нового узла связи в Хельсинки, столице Финляндии. Сообщается, что развёртывание нового узла связи позволило компании нарастить зарубежные ёмкости и ускорить доступ частных и корпоративных клиентов к сетевым площадкам за пределами Рунета. В частности, пропускная способность соединения с коммуникационным сервисом Telegram выросла до 2 Тбит/с. Подчёркивается, что расширение пропускной способности стыка (то есть прямого соединения между сетью «Билайна» и оборудованием интернет-сервиса) с Telegram стало одним из первых включений на новом узле связи. Суммарно в 2025 году она выросла на 43 % — с 1,4 до 2 Тбит/с. Расширение стыков с другими сервисами находится в работе и завершится в ближайшее время, говорится в заявлении пресс-службы «Вымпелкома».

Источник изображения: Justin Bautista / unsplash.com «Вымпелком» ведёт деятельность на телекоммуникационном рынке с 1992 года и входит в четвёрку крупнейших мобильных операторов России. Помимо мобильной связи компания предоставляет услуги фиксированной телефонии и интернета, IP-телевидения, облачных сервисов и решений для бизнеса (B2B).

05.07.2025 [15:16], Алексей Разин

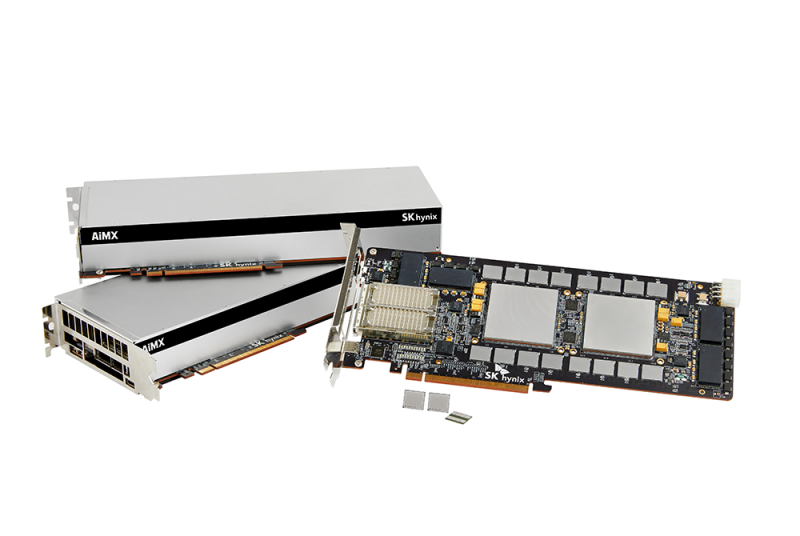

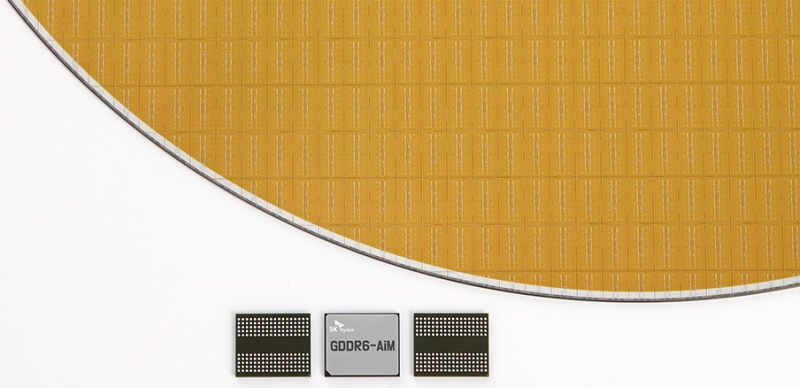

Повальный спрос на HBM тормозит внедрение CXL- и PIM-памятиОтраслевые аналитики уже не раз отмечали, что бурное развитие отрасли искусственного интеллекта, сопряжённое с ростом спроса на память типа HBM, ограничивает ресурсы производителей памяти на других направлениях. Помимо DDR, от этого страдают и перспективные виды памяти, которые производители хотели бы вывести на рынок. Об этом сообщило издание Business Korea, приведя в пример задержки с внедрением памяти типа CXL компанией Samsung Electronics и памяти типа PIM (Processing-in-Memory) компанией SK hynix. В последнем случае речь идёт о микросхемах памяти, способных самостоятельно выполнять специфические вычисления. Оба типа памяти могли бы в известной мере дополнить HBM в сегменте систем искусственного интеллекта.

Источник изображения: SK hynix Samsung рассчитывала приступить к продвижению CXL-памяти ещё во II половине 2024 года, но её сертификация ключевыми клиентами до сих пор не завершена. SK hynix разрабатывает GDDR6-AiM с 2022 года, но до её фактического выпуска дело так и не дошло из-за неготовности рыночной экосистемы. Кроме того, сами производители памяти ограничены в свободных ресурсах, поскольку все силы бросили на выполнение заказов по производству HBM. Всё доступное оборудование задействовано для выпуска именно HBM, не давая производителям шанса заняться подготовкой к выпуску других перспективных типов памяти. На этом фоне у южнокорейских игроков рынка даже возникают опасения, что китайские конкуренты быстрее справятся с выводом на рынок модулей CXL и PIM. В этой ситуации корейские производители начали всё сильнее рассчитывать на поддержку государства, причём не столько финансовую, сколько регуляторную. С технической точки зрения к выводу на рынок CXL и PIM всё уже почти готово, но по факту на память этих типов пока нет достаточного спроса.

23.06.2025 [16:53], Владимир Мироненко

SK hynix выпустит кастомную HBM4E-память для NVIDIA, Microsoft и BroadcomСогласно данным The Korea Economic Daily, южнокорейская компания SK hynix заключила контракты на поставку кастомной памяти HBM с NVIDIA, Microsoft и Broadcom, опередив конкурента Samsung Electronics на рынке кастомной HBM, который, по прогнозам TrendForce и Bloomberg Intelligence к 2033 году вырастет до $130 млрд с $18,2 млрд в 2024 году. Ожидается, что поставки SK hynix кастомных чипов начнутся во второй половине 2025 года. По данным отраслевых источников, Samsung также ведёт переговоры с Broadcom и AMD о поставках кастомной HBM4. Ранее, в ходе квартального отчёта в апреле компания сообщила, что начнёт поставки памяти HBM4 в I половине 2026 года. Для наращивания производства HBM и передовой памяти DRAM компания SK hynix переоборудовала свой завод M15X в Чхонджу (Cheongju), изначально предназначенный для производства флеш-памяти NAND. Объём запланированных инвестиций составляет ₩20 трлн ($14,5 млрд). Кастомные HBM, предназначенные для удовлетворения конкретных потребностей клиентов, пользуются всё большим спросом, поскольку крупные технологические компании, стремясь оптимизировать производительность своих ИИ-решений, отказываются от использования универсальной памяти. О заключении контрактов стало известно примерно через 10 месяцев после того, как SK hynix объявила о получении запросов на поставку кастомной HBM от «Великолепной семёрки»: Apple, Microsoft, Google, Amazon, NVIDIA, Meta✴ и Tesla.

Источник изображения: SK hynix По словам источника The KED в полупроводниковой отрасли, «учитывая производственные мощности SK hynix и сроки запуска ИИ-сервисов крупными технологическими компаниями, удовлетворить все запросы “Великолепной семёрки” не представляется возможным». Тем не мене, он допустил, что SK hynix с учётом условий рынка может заключить контракты ещё с несколькими клиентами. Ранее SK hynix сообщила, что с поколением HBM4E она полностью перейдет на модель индивидуального производства. Текущее массовое внедрение сосредоточено вокруг HBM3E, а отрасль готовится в ближайшем будущем к переходу на шестое поколение памяти HBM — HBM4. По словам источников, выпуск кастомной памяти седьмого поколения HBM4E компания освоит во II половине 2026 года, а массовое производство HBM4 начнёт во второй II 2025 года. Начиная с HBM4, логические кристаллы для памяти SK hynix выпускает TSMC, поскольку усовершенствованный чип требует более продвинутых техпроцессов. До этого компания обходилась собственными мощностями. По данным TrendForce, SK hynix контролирует половину мирового рынка HBM, за ней следуют Samsung и Micron с долями рынка в размере 30 % и 20 % соответственно.

17.04.2025 [12:08], Сергей Карасёв

JEDEC обнародовала стандарт памяти HBM4 для ИИ-ускорителей следующего поколенияАссоциация JEDEC Solid State Technology объявила о публикации стандарта памяти с высокой пропускной способностью HBM4. Он предполагает дальнейшее повышение пропускной способности, эффективности и ёмкости памяти для ускорителей следующего поколения, ориентированных на задачи ИИ и НРС. Стандарт JESD270-4 HBM4, как утверждается, привносит многочисленные улучшения по сравнению с предыдущей версией. В частности, благодаря переходу от 1024-бит интерфейса у HBM3E к 2048-бит общая пропускная способность возросла до 2 Тбайт/с. Таким образом, HBM4 подходит для наиболее ресурсоёмких приложений, требующих эффективной обработки огромных массивов данных и сложных вычислений, включая генеративный ИИ. Стандарт HBM4 удваивает количество независимых каналов на стек с 16 (HBM3) до 32: это предоставляет разработчикам большую гибкость. Говорится о поддержке уровней напряжения VDDQ 0,7 В, 0,75 В, 0,8 В или 0,9 В и VDDC 1,0 В или 1,05 В, что обеспечивает возможность снижения энергопотребления и повышения энергоэффективности. Допускается формирование 4-, 8-, 12- и 16-ярусных стеков ёмкостью 24 и 32 Гбайт. Упомянута поддержка Directed Refresh Management (DRFM) для снижения риска сбоев и повышения надёжности, доступности и удобства обслуживания.

Источник изображения: SK hynix Для стандарта HBM4 заявлена обратная совместимость с существующими контроллерами HBM3, что обеспечивает бесшовную интеграцию и гибкость при разработке систем нового поколения. При этом один и тот же контроллер может работать как с HBM3, так и с HBM4. «Внедрение HBM4 знаменует собой важный шаг в области создания памяти с высокой пропускной способностью, обеспечивая производительность, эффективность и масштабируемость, которые необходимы для поддержки ИИ и высокопроизводительных вычислений следующего поколения», — говорит старший вице-президент, корпоративный научный сотрудник и технический директор по вычислениям и графике AMD.

10.04.2025 [09:14], Владимир Мироненко

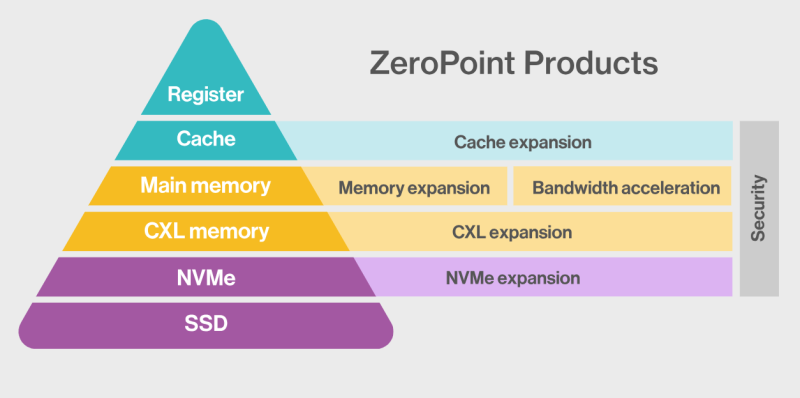

ZeroPoint Technologies и Rebellions займутся разработкой ИИ-ускорителей со «сжимаемой» памятьюШведская компания ZeroPoint Technologies, специализирующаяся на создании решений для оптимизации памяти, объявила о стратегическом альянсе с южнокорейским разработчиком ИИ-чипов Rebellions с целью разработки ИИ-ускорителей для инференс. Компании планируют представить новые продукты в 2026 году, обещая «беспрецедентную производительность в пересчёте на токены в секунду на Вт (TPS/W)», пишет EE Times. Компании планируют увеличить эффективную пропускную способность и ёмкость памяти для нагрузок инференса, используя технологии сжатия, уплотнения и управления памятью от ZeroPoint Technologies. По словам генерального директора ZeroPoint Technologies Класа Моро (Klas Moreau), аппаратная оптимизация работы с памятью на уровне ЦОД позволит увеличить адресуемую ёмкость с ускорением работы почти в 1000 раз по сравнению с использованием программного сжатия. Компании планируют улучшить показатели токенов в секунду на Вт без ущерба для точности, используя сжатие модели без потерь для уменьшения её размера и сокращения использования энергии, необходимой для перемещения компонентов модели. Гендиректор Rebellions Сонхён Пак (Sunghyun Park) указал, что партнёрство позволит компаниям переопределить возможности инференса, предоставляя более умную, экономичную и устойчивую ИИ-инфраструктуру. Моро ранее заявил, что более 70 % данных, хранящихся в памяти, являются избыточными, что позволяет полностью избавиться от них, добившись сжатия без потерь полезной информации. Такая технология сжатия должна выполнять ряд специфических действий в пределах наносекунды, т.е. всего нескольких тактов: «Во-первых, она должна отрабатывать сжатие и распаковку. Во-вторых, она должна уплотнять полученные данные, собирая небольшие фрагменты в единичную линию кеша, чтобы значительно улучшить видимую пропускную способность памяти, и, наконец, она должна бесперебойно управлять данными, отслеживая все фрагменты. Чтобы минимизировать задержку, такой подход должен работать с гранулярностью линий кеша — сжимая, уплотняя и управляя данными в 64-байт фрагментах — в отличие от гораздо больших блоков 4–128 Кбайт, используемых традиционными методами сжатия вроде ZSTD и LZ4». По словам Моро, благодаря этой технологии, для базовых рабочих нагрузок в ЦОД гиперскейлера адресуемая ёмкость памяти и пропускная способность могут быть увеличены в два-четыре раза, производительность на Вт может увеличиться на 50 %, а совокупная стоимость владения (TCO) может быть значительно снижена. А для специализированных нагрузок, таких как большие языковые модели (LLM), интеграция программного сжатия в сочетании с встроенной аппаратной декомпрессией (что минимизирует любую дополнительную задержку) уже продемонстрировала прирост примерно на 50 % в адресуемой ёмкости памяти, пропускной способности и токенах в секунду. Моро утверждает, что грядущая интеграция аппаратной (де-)компрессии обещает ещё более существенные улучшения. Например, для базовых ИИ-нагрузок кластер со 100 Гбайт физической памяти благодаря использованию этой технологии будет функционировать так, как если бы у него было 150 Гбайт памяти. «Это не только представляет собой миллиарды долларов потенциальной экономии, но и может повысить производительность сложных ИИ-моделей», — заявил Моро. «Эти достижения обеспечивают надёжную основу для компаний, производящих чипы ИИ, позволяя бросить вызов доминированию таких гигантов отрасли, как NVIDIA», — добавил он.

08.04.2025 [08:30], Владимир Мироненко

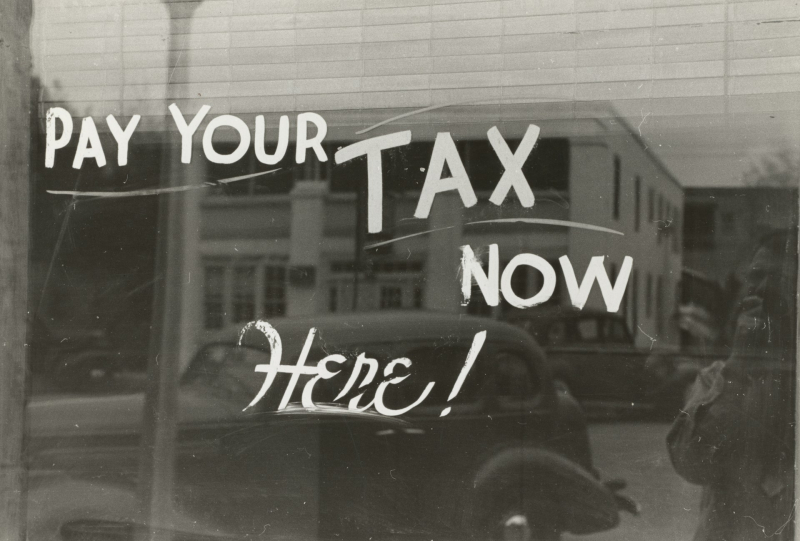

Поставщики памяти, накопителей и СХД в основном проиграют от торговой войны СШАВведение президентом США пошлин отразится на американских компаниях, у которых компоненты многонациональной цепочки поставок и готовая продукция импортируются в Америку, а также на цене продукции иностранных поставщиков, импортируемой в США, пишет ресурс Blocks & Files. Торговая война также затронет американских поставщиков систем хранения, экспортирующих в те страны, которые в ответ тоже повышают пошлины. Таким образом, можно говорить о трёх группах компаний, которые столкнутся с различными проблемами после роста пошлин. США назначили Китаю самую высокую пошлину в 54 %. И это не предел, поскольку в связи с решением Китая повысить в ответ пошлины на 34 % США, в свою очередь, могут повысить ставку до 104 %, пишет The Register. За Китаем следует Камбоджа с пошлиной в 49 %, Лаос — 48 %, Вьетнам — 46 %, Таиланд — 37 %, Индонезия и Тайвань — по 32 %, Индия — 27 %, Южная Корея — 26 %, Япония — 24 %, Евросоюз — 18,5 %, Филиппины — 18 %. Среди компаний, поставляющих товары в США, введение пошлин может затронуть поставщиков DRAM, NAND, SSD, лент и ленточных приводов, а также тех, кто производит контроллеры СХД и серверные процессоры. Следует учесть, что согласно приложению II Гармонизированного тарифного графика США (HTSUS), полупроводниковые чипы освобождены от пошлин, но не товары, которые содержат их в качестве компонентов. Так, Micron производит DRAM, NAND и SSD. DRAM выпускается в Бойсе (штат Айдахо), а также в Японии, Сингапуре и на Тайване. Освобождение от пошлин может применяться к чипам DRAM и NAND, но не обязательно к SSD, содержащим NAND, поскольку для них нет специального освобождения. На товары будут действовать пошлины для страны происхождения, установленные администрацией США. Samsung, производит DRAM и NAND в основном в Южной Корее, но часть NAND выпускается в Китае. Сборка SSD сосредоточена в Южной Корее, поэтому они, скорее всего, подпадают под 26-% пошлину. SK hynix, производит чипы DRAM, NAND и SSD в Южной Корее, в то время как её дочерняя компания Solidigm производит SSD в Китае. То есть на её ценах отразится 54-% пошлина на SSD из Китая и 26-% — на продукцию из Южной Кореи. Kioxia, производит NAND и SSD в Японии, при ввозе в США её продукты будут облагаться 24-% пошлиной. NAND-память SanDisk производится в Японии (совместно с Kioxia), но часть SSD выпускается на заводах в Китае, что подразумевает применение 54-% пошлины. Это означает, что SSD Kioxia, Samsung и SK hynix, могут оказаться дешевле, чем SSD Sandisk, а вот SSD Solidigm — нет.

Источник изображения: The New York Public Library / Unsplash У HDD Seagate довольно сложная и интегрированная международная цепочка поставок, включающая Китай, Таиланд, Сингапур и Малайзию. Компания производит пластины для дисков и часть самих HDD (например, Exos) в Китае, а двигатели, узлы привода головок и жёсткие диски других серий — в Таиланде. Кроме того, пластины и некоторые другие диски собираются в Сингапуре и Малайзии. Новые пошлины будут применяться при импорте дисков в США и будут зависесть от страны происхождения. Столь резкое увеличение цен из-за пошлин может вызвать шок у клиентов, отметил ресурс Blocks & Files. Western Digital собирает свои диски в Малайзии и Таиланде, и поэтому столкнётся с пошлинами в размере 24 % и 36 % соответственно. Жёсткие диски Toshiba производятся в Китае, на Филиппинах и в Японии, что подразумевает импортные пошлины США в размере 54, 18 и 24 % соответственно. Записываемые диски Blu-ray и DVD производятся в Китае, Индии, Японии и на Тайване — они точно так же будут облагаться пошлинами в зависимости от страны выпуска. IBM производит ленточные накопители, проприетарные и LTO, в Тусоне (штат Аризона), поэтому её коснутся только пошлины на любые компоненты иностранного производства, которые она будет импортировать. Fujifilm производит LTO-накопители в Бедфорде (штат Массачусетс), а Sony — в Японии, что означает 24-процентную пошлину на ввоз в США. Fujifilm — в выигрыше от ввода пошлин, а Sony — наоборот. Контроллеры хранения данных и серверные процессоры в основном производятся Intel, некоторые — компанией AMD. У Intel есть фабрики в Орегоне (Хиллсборо), Аризоне (Чандлер) и Нью-Мексико (Рио-Ранчо). Сборочные, испытательные и упаковочные мощности для CPU имеются в Израиле, Малайзии, Вьетнаме, Китае и Коста-Рике. Часть продукции выпускается завод в графстве Килдэр (Ирландия). AMD во много зависит от тайваньских фабрик TSMC. Однако обе компании, а заодно и производители Arm-чипов, пошлины не затронут. Зато экспорт в Китай подпадёт под ответные 34-% пошлины. Массивы хранения данных в основном производятся в США, где находятся все производства Dell, HPE и NetApp. А вот Hitachi Vantara производит свои хранилища в Японии, поэтому на них будет действовать 24-%. СХД Lenovo фактически являются OEM-массивами NetApp, поэтому она может избежать пошлин. СХД Infinidat выпускаются на производственных мощностях Arrow Electronics, которая имеет глобальную цепочку поставок с США в роли главного хаба. Где именно по факту производятся массивы, Infinidat не говорит. Поставщики неамериканских СХД в США столкнутся с пошлинами в зависимости от страны их базирования. Чтобы избежать этого, компании могут инвестировать в американские подразделения, хотя для многих в нынешней ситуации это может быть не очень целесообразно. Третья группа поставщиков СХД — это американские компании, экспортирующие продукцию, например, в Китай, который в ответ повышает собственные пошлины на ввоз товаров из США — с 10 апреля она составит 34 %. Одним из победителей в этой торговой войне Blocks & Files назвал Huawei, которая не поставляет товары в США.

29.03.2025 [10:57], Владимир Мироненко

SK hynix распродала почти всю память HBM, которую выпустит в 2026 годуНа этой неделе состоялось ежегодное собрание акционеров компании SK hynix, на котором Квак Но-чжун (Kwak Noh-jung) заявил, что переговоры компании с клиентами о продажах памяти HBM в 2026 году близки к завершению. Как пишет The Register, заявление гендиректора было воспринято как знак того, что, как и в прошлом году, SK hynix распродаст весь объём выпуска HBM на год вперёд. На мероприятии было объявлено, что в последние недели наблюдается всплеск заказов на поставки HBM, поскольку компании стремятся заключить контракты до ожидаемого увеличения США пошлин на импортируемые полупроводники. Напомним, что в феврале президент США Дональд Трамп (Donald Trump) заявил о намерении ввести тарифы на импорт полупроводников на уровне 25 % и выше, добавив, что в течение года они могут вырасти до 50 % и даже 100 %.

Источник изображений: SK hynix Квак также сообщил акционерам, что SK hynix ожидает «взрывного» роста продаж HBM. На вопрос о том, представляет ли угрозу планам компании то, что DeepSeek использует для обучения своих ИИ-моделей сравнительно небольшие вычислительные мощности, глава SK hynix заявил, что достижения китайского стартапа станут стимулом для более широкого внедрения ИИ, что повлечёт за собой ещё больший спрос на продукцию SK hynix со стороны большего количества покупателей. Такой ответ стал почти стандартным для руководителей компаний, предоставляющих оборудование для обработки рабочих ИИ-нагрузок, на вопрос о том, формируется ли на ИИ-рынке «ценовой пузырь» и что может произойти, если он лопнет, отметил The Register. На прошлой неделе компания заявила, что отправила клиентам первые образцы 12-слойной памяти HBM4, отметив, что «образцы были доставлены с опережением графика» и что «она намерена завершить подготовку к массовому производству 12-слойной продукции HBM4 во второй половине года». |

|