Материалы по тегу: сжо

|

27.01.2026 [12:53], Сергей Карасёв

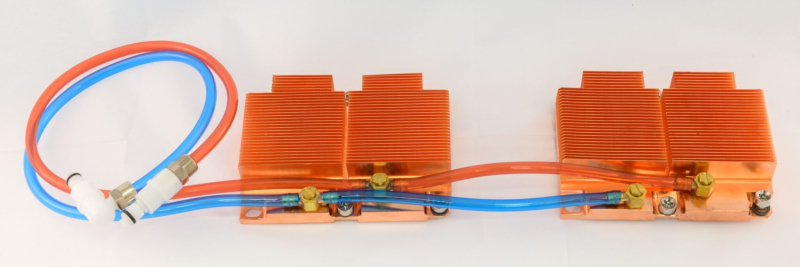

Giga Computing представила ИИ-сервер на базе NVIDIA GB200 NVL4 с СЖОКомпания Giga Computing, подразделение Gigabyte Group, пополнила ассортимент серверов моделью XN24-VC0-LA61, ориентированной на ИИ-задачи и другие ресурсоёмкие нагрузки. Устройство выполнено в форм-факторе 2U на аппаратной платформе NVIDIA GB200 NVL4. В общей сложности задействованы четыре GPU поколения Blackwell со 186 Гбайт памяти HBM3E каждый (пропускная способность до 8 Тбайт/с) и два CPU Grace с 480 Гбайт памяти LPDDR5X (пропускная способность до 512 Гбайт/с). Применяется GPU — GPU интерконнект NVIDIA NVLink и CPU — GPU интерконнект NVIDIA NVLink-C2C. Реализована система прямого жидкостного охлаждения. Доступны четыре сетевых порта OSFP InfiniBand XDR на 800 Гбит/с или два порта Ethernet на 400 Гбит/с на базе NVIDIA ConnectX-8 SuperNIC. Кроме того, имеется порт 1GbE на основе Intel I210-AT и выделенный сетевой порт управления 1GbE. В оснащение входит контроллер ASPEED AST2600. Во фронтальной части расположены восемь посадочных мест для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe) с жидкостным охлаждением. Опционально может быть установлен DPU NVIDIA BlueField-3. Есть внутренний разъём для SSD типоразмера M.2 2242/2260/2280/22110 с интерфейсом PCIe 5.0 x4, слот PCIe 5.0 х16 для карты FHHL с СЖО и ещё один разъём PCIe 5.0 х16 FHHL. Предусмотерны коннекторы USB 3.2 Gen1 Type-A, Micro-USB, Mini-DP и RJ45. Сервер имеет габариты 438 × 87 × 900 мм и массу 42,8 кг. За питание отвечают четыре блока мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Диапазон рабочих температур простирается от +10 до +35 °C.

19.01.2026 [14:16], Руслан Авдеев

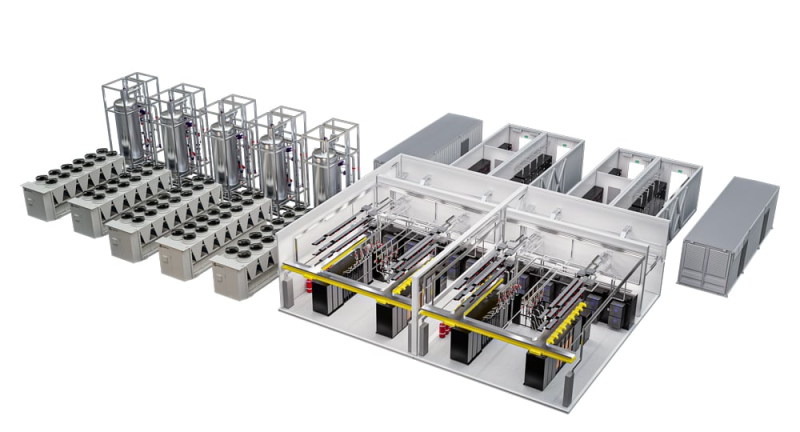

100+ кВт на стойку с СЖО: Vertiv обновила модульную инфраструктуру MegaMod HDX для ИИ и HPCVertiv анонсировала новые конфигурации MegaMod HDX. Это модульное силовое и охлаждающее решение, разработанное для вычислительных сред высокой плотности. Новые конфигурации обеспечивают гибкую адаптацию к растущим требованиям к питанию и охлаждению, занимают меньше места, требуют меньше времени на развёртывание и обеспечивают воспроизводимость благодаря заранее собранным на заводе конструкциям, прошедшим интеграцию и тестирование компонентов. Vertiv MegaMod HDX сочетает прямое жидкостное охлаждение чипов и воздушное охлаждение — это помогает справиться с интенсивными ИИ-нагрузками, поддерживая модульные среды для ИИ и передовые кластеры ускорителей. Базовый модуль стандартной высоты поддерживает до 13 стоек и мощность до 1,25 МВт. Комбинированное решение отличается большей высотой и поддерживает уже до 144 стоек и мощность до 10 МВт. Оба варианта обеспечивают плотность от 50 кВт до 100+ кВт на стойку с возможностью оптимизации системы охлаждения под актуальные запросы и с возможностью масштабирования.

Источник изображения: Vertiv Новые решения используют распределённую силовую архитектуру с резервированием. Для СЖО предусмотрен буфер, который обеспечит поддержку стабильной работы кластеров ускорителей во время техобслуживания. Обе конфигурации основаны на этом обширном портфолио, включающем, например, ИБП Vertiv Liebert APM2, блок распределения жидкости Vertiv CoolChip CDU, а также шинопровод Vertiv PowerBar и систему мониторинга инфраструктуры Vertiv Unify. Также Vertiv предлагает инфраструктуру IT-стоек, разработанную для беспрепятственной интеграции и поддержки IT-систем. В том числе речь идёт о стойках Vertiv и OCP-совместимых стойках, теплообменниках задней двери Vertiv CoolLoop RDHx, PDU и DC-системах Vertiv PowerDirect и т.п. Летом 2025 года сообщалось, что выручка Vertiv выросла на 35 % на фоне «беспрецедентного роста ЦОД», но новые тарифы, введённые США, не дают бизнесу развиваться активнее.

12.01.2026 [13:16], Сергей Карасёв

Supermicro представила SuperBlade-сервер на базе Intel Xeon 6900 с СЖОКомпания Supermicro анонсировала сервер SBI-622BA-1NE12-LCC семейства SuperBlade, предназначенный для построения вычислительных платформ высокой плотности. Устройство будет предлагаться в вариантах с воздушным и прямым жидкостным охлаждением: в первом случае в шасси типоразмера 6U могут быть размещены пять узлов, во втором — десять. Каждый узел SuperBlade поддерживает установку двух процессоров Intel Xeon 6900 поколения Granite Rapids, насчитывающих до 128 производительных P-ядер. Показатель TDP может достигать 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400/8800 суммарным объёмом до 3 Тбайт. Предусмотрены два посадочных места для накопителей E1.S. Опционально могут быть также установлены два NVMe SSD формата M.2 2280 или M.2 22110. Реализованы три слота PCIe 5.0 x16 для карт формата FHHL, HHHL/LP и OCP 3.0. В оснащение входят контроллер Aspeed AST2600 и адаптер Intel E810-XXVAM2, на базе которого реализованы два сетевых порта 25GbE. Шасси, в которое монтируются серверные узлы SBI-622BA-1NE12-LCC, оснащено модулями управления и Ethernet-коммутаторами с резервированием. Питание обеспечивают восемь блоков с сертификатом 80 Plus Titanium. Диапазон рабочих температур — от +10 до +35 °C. По заявлениям Supermicro, передовой дизайн шасси 6U обеспечивает сокращение количества кабелей на 93 % и экономию пространства на 50 % по сравнению с серверами в форм-факторе 1U с сопоставимой конфигурацией. Новинка ориентирована на решение НРС-задач в таких областях, как производство, финансы, научные исследования, энергетика, моделирование климата и пр.

31.12.2025 [12:02], Сергей Карасёв

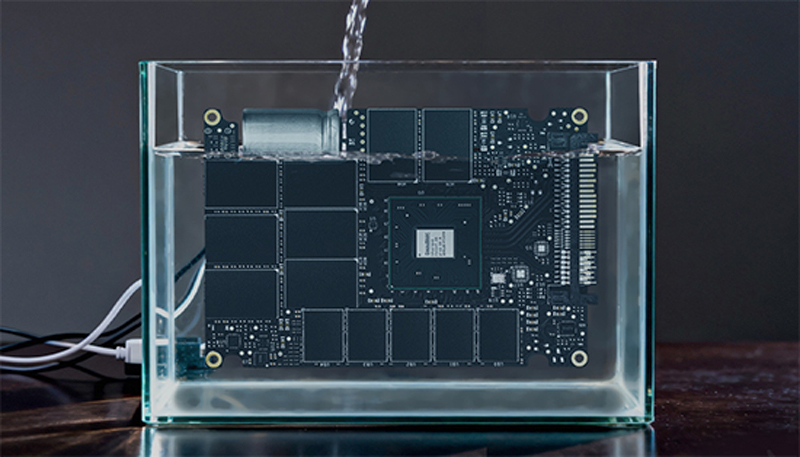

DapuStor и ZTE внедряют в дата-центрах SSD с иммерсионным охлаждениемКомпания DapuStor объявила об успешном внедрении в серверной инфраструктуре ZTE систем хранения данных на основе SSD с иммерсионным (погружным) жидкостным охлаждением. Применённые накопители семейства DapuStor J5, как утверждается, продемонстрировали исключительную стабильность и надёжность при непрерывных нагрузках чтения/записи. Отмечается, что на фоне стремительного развития ИИ быстро растёт нагрузка на ЦОД — это приводит к увеличению энергопотребления. В результате, возможностей традиционного воздушного охлаждения становится недостаточно, в связи с чем гиперскейлеры и облачные провайдеры внедряют передовые жидкостные решения, в том числе иммерсионные системы. Однако существуют риски: хотя погружное охлаждение обеспечивает эффективный отвод тепла, оно предъявляет дополнительные требования к оборудованию. Длительное нахождение в диэлектрической жидкости может провоцировать химическую эрозию и ускорение старения из-за проникновения состава в микроскопические структурные зазоры электронных компонентов. В случае SSD это чревато системными сбоями. Поэтому для достижения долгосрочной надёжности необходима комплексная адаптация устройств хранения с точки зрения базовых материалов, конструкции и производственных процессов.

Источник изображения: DapuStor Накопители DapuStor J5, оптимизированные для иммерсионного охлаждения, разработаны специально с прицелом на эксплуатацию в экстремальных условиях. Все используемые материалы прошли тщательную проверку, исключающую ухудшение характеристик после длительного контакта с охлаждающей жидкостью. Гарантированы целостность сигнала и долговременная стабильность, говорят компании. Заявленная скорость последовательного чтения и записи данных достигает соответственно 7,4 и 7,0 Гбайт/с. Показатель IOPS при произвольном чтении составляет до 1,75 млн, при произвольной записи — до 340 тыс. Задержка — 67/9 мкс. Отмечается, что при использовании иммерсионного охлаждения средний годовой показатель PUE составляет менее 1,15 против 1,4–1,6 при традиционном воздушном охлаждении, что соответствует снижению на 15–28 %. Плотность мощности в расчёте на стойку возрастает на порядок — с 3–5 кВт до 48 кВт.

01.12.2025 [09:15], Руслан Авдеев

Японская Daikin намерена утроить продажи систем охлаждения ЦОД в Северной Америке, надеясь на гиперскейлеров и ИИ-бумЯпонская Daikin Industries рассчитывает утроить продажи охлаждающего оборудования для ЦОД в Северной Америке на фоне бума ИИ-технологий — до более чем ¥300 млрд ($1,92 млрд) к 2030 финансовому году, сообщает Nikkei Asian Review. Сейчас Daikin скупает технологии охлаждения американских компаний и намерена учредить отдельную штаб-квартиру для североамериканского рынка в 2026 финансовом году. Основная цель — работа со всеми гиперскейлерами. По оценкам Daikin, на Северную Америку приходится 40 % мирового рынка решений для охлаждения ЦОД, и её доля, вероятно, продолжит расти. Ключевыми заказчиками являются гиперскейлеры, и Daikin уже работает с Google и Amazon. Крупные HVAC-системы нередко приобретаются для нескольких зданий одновременно, так что объёмы единовременных продаж обычно составляют десятки миллионов долларов. Доля Daikin на североамериканском рынке, по её собственным оценкам, составляет около 12 %. Она занимает третье место в своём сегменте. К 2030 году компания намерена довести долю до 30 %. Конкуренцию ей составит как минимум LG, которая будет поставлять свои системы охлаждения для ИИ ЦОД Microsoft. В 2007 году Daikin купила малайзийскую OYL Industries, которая владела американским производителем кондиционеров McQuay International (бренд Applied). В 2023 году за ¥30 млрд ($192 млн) она купила американскую Alliance Air Products, специалиста по оборудованию для обработки воздуха. В августе того же года она приобрела американскую же Dynamic Data Centers Solutions, разрабатывавшую технологию индивидуального охлаждения стоек. Наконец, в ноябре компания купила американский стартап Chilldyne, специализирующийся на СЖО. Массовое производство систем воздушного и жидкостного охлаждения для серверов начнётся весной следующего года. По прогнозам Daikin, приблизительно 70 % рынка к 2030 году будет приходиться на системы воздушного охлаждения и около 30 % — на СЖО. Daikin намерена предлагать оптимальные комбинации этих методов для операторов ЦОД и отраслевых подрядчиков. Дополнительно она предлагает и системы контроля охлаждения. Также компания сообщает, что намерена создать в США хаб по выпуску решений для ЦОД в 2026 фискальном году для контроля над североамериканским рынком. По данным индийской Fortune Business Insights, мировой рынок систем охлаждения для ЦОД должен вырасти более чем вдвое с 2024 по 2032 гг. до $42,4 млрд. Впрочем, гиперскейлеры работают над собственными решениями, которые позволят обрести им «суверенитет» от независимых вендоров. Например, собственную СЖО всего за 11 месяцев разработала и запустила в производство AWS. А Meta✴ пришлось пойти на ухищрения, чтобы обойтись воздушным охлаждением ИИ-стоек.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

17.11.2025 [10:14], Руслан Авдеев

Vertiv представила иммерсионные СЖО CoolCenter Immersion на 25–240 кВтVertiv объявила о выпуске системы погружного охлаждения CoolCenter Immersion. Иммерсионная СЖО обеспечивает поддерживает отвод от 25 кВт до 240 кВт на модуль ёмкостью 24U до 52U, обеспечивая при этом PUE на уровне 1,08. По словам компания, иммерсионное охлаждение играет всё более важную роль из-за повсеместного внедрения HPC- и ИИ-платформ. В Vertiv CoolCenter Immersion применяется многолетний опыт, полученный Vertiv в сфере СЖО для создания спроектированных «под ключ» систем, безопасно и эффективно справляющихся с высокоплотными системами. Операторы ЦОД смогут практично масштабировать ИИ-инфраструктуру без ущерба надёжности и удобству обслуживания. Каждая система включает внутренний или внешний резервуар для теплоносителя, блок распределения жидкости (CDU), датчики температуры, а также насосы с регулируемой скоростью работы и трубки. Модуль включает два источника питания и резервные насосы, а также встроенные датчики мониторинга состояния и 9″ сенсорный дисплей. Предусмотрена возможность подключения к системе управления зданием (BMS). Тепло отводится через пластинчатый теплообменник во внешний водяной контур. Vertiv уже заключила контракт с Digital Realty в Италии на поставку электроэнергии и систем охлаждения для римского объекта Digital ROM1 мощностью 3 МВт. Запуск ЦОД запланирован на 2027 год. На объекте будет использоваться фрикулинг и система охлаждения, готовая к ИИ-нагрузкам, передаёт DataCenter Dynamics. Сделка стала ещё одной в череде европейских проектов Digital Realty в Париже, Мадриде, Амстердаме и др.

Источник изображения: Vertiv В Digital Realty подчеркнули, что Рим становится важнейшим шлюзом для цифровой инфраструктуры между Европой и Средиземноморским регионом. Передовые технологии для ROM1 помогут стать дата-центру стратегическим ИИ-хабом, задающим новые стандарты энергоэффективности и производительности в сфере HPC. Также Vertiv работает с Nextra в Африке и намерена сотрудничать с Ezditek для создания ЦОД в Саудовской Аравии. Ранее сообщалось, что нежелание NVIDIA сертифицировать иммерсионные СЖО во многом тормозит их развитие. Прямое жидкостное охлаждение (DLC) менее эффективно, чем иммерсионные системы, но NVIDIA всё ещё считает, что пока достаточно этого. Впрочем, эксперты прогнозируют, что настоящий расцвет технологии придётся на 2027–2028 гг. Ожидается, что она будут активно распространяться после выхода ускорителей NVIDIA Rubin Ultra.

07.11.2025 [13:51], Сергей Карасёв

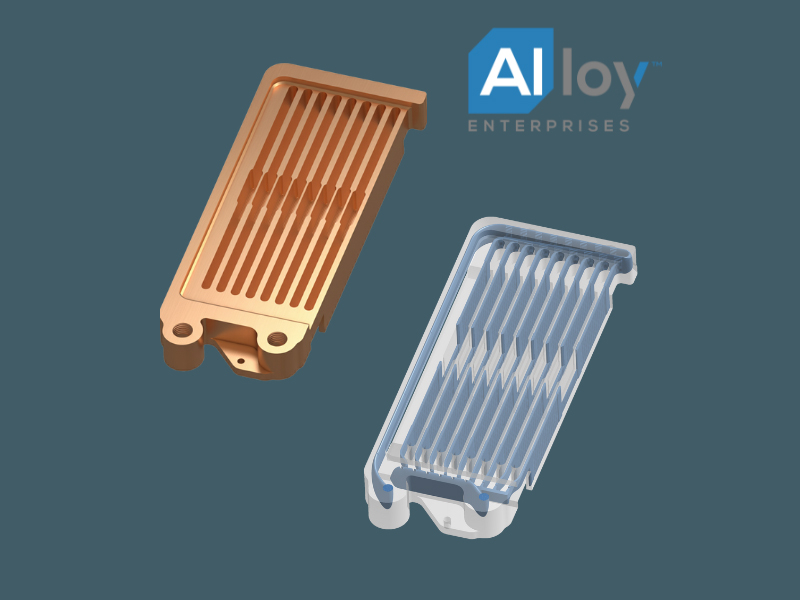

Alloy Enterprises представила водоблоки СЖО для всех компонентов blade-серверовКомпания Alloy Enterprises анонсировала цельные охлаждающие модули с защитой от протечек, обеспечивающие возможность прямого жидкостного охлаждения (DLC) всех компонентов в составе blade-серверов, включая оперативную память, сетевые адаптеры и оптические элементы QSFP. Alloy Enterprises отмечает, что на фоне стремительного развития ИИ и НРС меняется архитектура серверов, а следовательно, и тепловой баланс высокопроизводительных систем. Исторически на GPU-ускорители приходилось около 80 % от всего энергопотребления blade-узлов, тогда как оставшиеся 20 % сообща расходовали модули DIMM, сетевые карты, QSFP-корзины и другие компоненты, которые могли довольствоваться воздушным охлаждением. При этом в традиционных HPC-платформах 100-% жидкостное охлаждение компонентов уже давно не редкость.

Источник изображения: Alloy Enterprises Энергопотребление современной стойки NVIDIA GB200 NVL72 составляет 120–140 кВт в номинальном режиме. При этом на периферийные устройства приходится 24–28 кВт, что пока укладывается в возможности воздушного охлаждения. Однако в будущих системах класса 600 кВт, таких как платформа NVIDIA Kyber, только периферийным компонентам потребуется до 100 кВт энергии, а поэтому воздушного охлаждения окажется недостаточно. В результате, потребуются качественно новые решения, в том числе на основе DLC. Новые охлаждающие модули Alloy Enterprises выполнены с использованием запатентованной технологии Stack Forging. Они сочетают особую внутреннюю микрогеометрию с монолитной конструкцией, благодаря чему обеспечивается эффективное охлаждение под высоким давлением без утечек. Изделия рассчитаны на давление до 138 бар без деформации, что позволяет сохранять структурную целостность в экстремальных условиях. Alloy Enterprises говорит о возможности оптимизации отвода тепла для каждого периферийного устройства. Изделия для оперативной памяти поддерживают двустороннее охлаждение модулей DIMM мощностью свыше 40 Вт, что соответствует спецификациям JEDEC следующего поколения. Возможна замена без слива жидкости из охлаждающего контура. Для оптических модулей 800G и 1,6T допускается отвод до 50 Вт/порт. В случае сетевых адаптеров низкопрофильные монолитные пластины обеспечивают равномерное охлаждение и механическую стабильность, говорит компания.

07.11.2025 [12:17], Сергей Карасёв

Sugon ScaleX640 — первая в мире стоечная система с 640 ИИ-ускорителямиКитайская компания Sugon (Dawning Information Industry), специализирующаяся на разработке суперкомпьютеров, серверов и СХД, представила ИИ-систему ScaleX640. Это, как утверждается, первое в мире решение в виде одной стойки, допускающее использование до 640 ускорителей. Суперускоритель выполнен на «сверхскоростной ортогональной архитектуре». Используются вычислительные узлы высокой плотности, которые допускают установку ИИ-карт различных производителей. Говорится о совместимости с существующей экосистемой ПО для задач ИИ. Платформа ScaleX640 предусматривает применение иммерсионного жидкостного охлаждения с фазовым переходом и высоковольтных источников питания постоянного тока (DC). СЖО способна отвести до 1,72 МВт. По заявлениям Sugon, по плотности вычислений новинка до 20 раз превосходит другие суперузлы, доступные на рынке. При этом обеспечивается высокий показатель эффективности использования электроэнергии (PUE) — 1,04. Два суперузла ScaleX640 могут формировать вычислительный блок с поддержкой 1280 ускорителей ИИ. Стойки соединяются между собой посредством высокоскоростной сети. В целом, возможно развёртывание кластеров, насчитывающих до 100 тыс. ИИ-карт. Sugon утверждает, что по сравнению с традиционными платформами новая система обеспечивает повышение производительности на 30–40 % в сценариях обучения больших языковых моделей (LLM) с триллионами параметров и инференса. Проведённое всестороннее тестирование ScaleX640 говорит о высокой надёжности и стабильности работы комплекса.

06.11.2025 [17:12], Руслан Авдеев

Daikin Applied купила разработчика необычных СЖО с отрицательным давлением ChilldyneDaikin Applied Americas сообщила о покупке компании Chilldyne — лидера в сфере СЖО с отрицательным давлением, применяемых в HCP/ИИ-платформах. Покупка поможет пополнить существующее портфолио Applied для дата-центров, поддерживая миссию компании по предоставлению комплексных решений для охлаждения, отвечающих требованиям гиперскейлеров для дата-центров следующего поколения. Сделка позволит Chilldyne быстро расширить присутствие на рынке. Как заявляют в Daikin Applied Materials, покупая Chilldyne, компания стремится удовлетворить меняющиеся потребности клиентов и задать новый стандарт при обеспечении производительности и работы без сбоев. Утверждается, что системы компании с отрицательным давлением в контуре выгоднее экономически и надёжнее в сравнении с традиционными системами для ЦОД с положительным давлением. Проще говоря, в случае повреждения контура СЖО Chilldyne Cool-Flo охлаждающая жидкость будет из него высосана, что снизит риск повреждения оборудования, вероятность незапланированных простоев и стомость обслуживания. Покупка Chilldyne стала поворотным моментом в реализации более широкой стратегии Daikin Applied по созданию всеобъемлющей экосистемы решений для охлаждения для ЦОД гиперскейл-уровня. Chilldyne и DDC Solutions, купленная Daikin Applied в августе 2025 года, позволяет интегрировать СЖО Chilldyne с модульными охлаждающими шкафами DDC. Вместе они обеспечат высокоэффективные и надёжные решения для стоек высокой плотности. Это уже третья по счёту сделка в области СЖО для ЦОД за последние недели. Так, на днях появилась новость, что Vertiv купит за $1 млрд поставщика сервисов для СЖО и HVAC PurgeRite, а Eaton поглотит Boyd Thermal, чтобы пополнить портфолио решений для ИИ ЦОД передовыми СЖО. |

|