Материалы по тегу: switch

|

28.01.2026 [13:45], Владимир Мироненко

SoftBank отказалась от поглощения оператора ЦОД Switch за $50 млрдSoftBank Group приостановила переговоры о приобретении американского оператора ЦОД Switch за $50 млрд, сообщил ресурс Bloomberg со ссылкой на информированные источники. Глава и основатель SoftBank Масаёси Сон (Masayoshi Son), считавший, что прямой контроль над сетью ЦОД Switch станет действенным инструментом в реализации проекта Stargate стоимостью $500 млрд, и в течение нескольких месяцев добивавшийся поглощения компании, признал, что её полное приобретение исключено, и отменил запланированное на январь объявление, сообщили источники. Эта сделка стала бы одной из крупнейших для японской компании на сегодняшний день и дала бы столь необходимый импульс проекту Stargate по созданию ИИ ЦОД в США. Сон рассматривал её как ключевой шаг к более значимой роли в гонке в сфере ИИ и обещал инвестировать $100 млрд «немедленно» вместе с OpenAI, Oracle и MGX из Абу-Даби, пишет Bloomberg. «Завершение переговоров SoftBank со Switch оставляет планы компании по созданию дата-центров в подвешенном состоянии, поскольку объявления о проекте Stargate по-прежнему редки», — отметили аналитики Bloomberg Intelligence. По словам источников, стратегические инвестиции или партнёрство не смогут обеспечить тот оперативный охват, который SoftBank стремилась получить в таких областях, как полупроводники и физический ИИ. Как сообщают источники, у некоторые представителей руководства SoftBank были опасения по поводу масштаба сделки, а также возможных трудностей, с которыми компания столкнулась бы при управлении обширной сетью кампусов ЦОД в США. К тому же Switch готовится к IPO в этом году с оценкой примерно в $60 млрд, включая долг, посредством листинга на фондовой бирже. И любая сделка с ней, вероятно, также будет подвергнута проверке со стороны Комитета по иностранным инвестициям в США (CFIUS). Аналитики считают маловероятным сценарием то, что SoftBank и Switch возобновят переговоры о полном поглощении. Не исключено, что SoftBank выберет более простой путь для получения доступа к инфраструктуре ЦОД. Например, SoftBank владеет производственным предприятием в Огайо, которым управляет тайваньская компания Foxconn. Таой способ взаимодействия может стать прообразом для её партнёрства со Switch. Отметим, что в начале этого месяца SoftBank заключила сделку на $3 млрд по приобретению зарегистрированной на Нью-Йоркской бирже инвестиционной компании DigitalBridge Group, которая владеет контрольным пакетом акций Switch, а также Vantage Data Centers. Последняя уже принимает участие в строительстве двух ЦОД Stargate в Техасе и Висконсине (Lighthouse). В последнее время SoftBank увеличила свои ставки на ИИ. За последний год компания накопила 11 % акций OpenAI, вложив $22,5 млрд только в прошлом месяце. Она приобрела американского разработчика Arm-процессоров Ampere Computing за $6,5 млрд, а также подразделение робототехники ABB за $5,4 млрд. Для финансирования этих сделок SoftBank продала акции T-Mobile US, избавилась от всей своей доли в NVIDIA и расширила маржинальный кредит, используя свои акции Arm. В 2024 году Softbank приобрела разработчика ИИ-ускорителей Graphcore. Инвестиции SoftBank в ИИ, наряду с резким падением стоимости акций Arm в конце прошлого года, оказывают давление на её кредитоспособность, сообщило в этом месяце рейтинговое агентство S&P Global Ratings. Аналитики предупредили, что если SoftBank не предпримет незамедлительных мер по смягчению ситуации, таких как ликвидация активов, давление на кредитные рейтинги усилится. Компания Switch, основанная Робом Роем (Rob Roy) в 2000 году, управляет крупными кампусами ЦОД Prime в Остине (штат Техас), Рено и Лас-Вегасе (штат Невада), Гранд-Рапидсе (штат Мичиган) и Атланте (штат Джорджия). За последний год компания подала заявки на дальнейшее расширение сети ЦОД в Остине и Атланте. Её основной кампус, расположенный в Лас-Вегасе (штат Невада), после завершения строительства будет обладать мощностью до 495 МВт, сообщил ресурс Data Center Dynamics.

27.01.2026 [13:37], Руслан Авдеев

В аккумуляторной лондонского дата-центра Global Switch случился пожарЛондонский дата-центр Global Switch пострадал от небольшого пожара. В минувшие выходные местная пожарная бригада (London Fire Brigade, LFB) прислала на место событий в район Блэкуолл восемь пожарных машин и около 60 пожарных, сообщает Datacenter Dynamics. Информация об инциденте поступила в 04:52 субботнего утра, но к 06:43 пожар был уже потушен. По данным местных СМИ, пожар произошёл в цокольном этаже здания ЦОД Global Switch. LFB объявила, что, вероятнее всего, возгорание произошло случайно и было вызвано некорректной работы одного из свинцово-кислотных аккумуляторов. Огонь распространился лишь на группу АКБ, дальнейших повреждений здание не получило. Судя по всему, аккумуляторы находились в помещении, за управление которым отвечал субподрядчик. Там находились 200 элементов питания. По слухам, с огнём справился всего один пожарный с ручным огнетушителем. Информации о пострадавших нет, на предоставление сервисов клиентам происшествие не повлияло. Другими словами, масштаб реагирования пожарных был не вполне пропорционален реальному масштабу происшествия, но проще было перестраховаться, поскольку события имели место в многоэтажном здании. Для тушения привлекли команды сразу с нескольких пожарных станций. В 2023 году протечка воды на объекте Global Switch в Париже уже привела к возгоранию аккумуляторов, что вызвало сбой работы всех европейских сервисов Google.

Источник изображения: London Fire Brigade Дата-центру компании Global Switch Доклендс доступно 224 МВА — в нём находится крупнейший, по словам компании, в Европе кластер ИИ-ускорителей H100 и H200, принадлежащий CoreWeave. Компания управляет двумя площадками в районе Доклендс (Docklands), куда входит и Блэкуолл: London East и London North. Также был анонсирован третий объект, London South, мощностью 40 МВт и площадью 27 тыс. м2. В июне 2025 года на одной из площадок в Доклендс были продемонстрированы технологии жидкостного охлаждения. Также от пожара в субботу пострадал телефонный узел BT/Openreach в Великобритании. Причина инцидента до сизх пор неизвестна, расследование продолжается. В сентябре 2025 сообщалось, что Openreach предписала клиентам и партнёрам за 48 часов заменить литиевые батареи в своих телефонных станциях в связи с риском возгорания на более безопасные из-за «значительного риска неуправляемого нагрева, возгорания и взрыва» — ирония в том, что в качестве замены рекомендовались именно свинцово-кислотные элементы.

16.01.2026 [09:16], Руслан Авдеев

ЦОД Switch получат энергию от геотермальной электростанции OrmatОператор дата-центров Switch подписал 20-летнее соглашение с энергокомпанией Ormat Technologies на поставку 13 МВт «чистой» энергии с геотермальной электростанции Salt Wells близ Фэллона (Невада). Это первая сделка Ormat со оператором ЦОД. Сделка допускает расширение соглашения за счёт использования солнечной электростанции на 7 МВт. Непосредственные поставки энергии должны начаться в I квартале 2030 года, после обновления электростанции Salt Wells. Ormat заявила, что гордится расширением разностороннего портфолио возобновляемых источников энергии в Неваде и углублением сотрудничества со Switch. В Ormat подчёркивают, что по мере роста спроса на ИИ- и HPC-инфраструктуру надёжные поставки безуглеродной являются ключевой потребностью клиентов компании, обеспечивающей её рост. Геотермальная энергия надёжна и экобезопасна — именно такая нужна для следующего поколения ИИ и облачных нагрузок, говорит Ormat. Электростанция Salt Wells — геотермальный проект, работающий по традиционной бинарной схеме. ГеоЭС, построенная Enel Green Power, была введена в эксплуатацию в 2009 году. В 2023 году она была продана Ormat. Сейчас Ormat занимается модернизацией и расширением станции для повышения её эффективности и мощности, завершить работы планируется во II квартале 2026 года.

Источник изображения: Switch Ormat Technologies — вертикально интегрированная энергетическая компания с портфолио мирового масштаба общей мощностью более 1,6 ГВт, куда входят геотермальные и солнечные электростанции в Гваделупе, Гватемале, Гондурасе, Индонезии, Кении и США совокупной мощностью почти 1,3 ГВт, а также энергохранилища на 350 МВт в США. Switch — не первый игрок рынка ЦОД, заинтересовавшийся геотермальной энергетикой. Meta✴ договорилась с двумя геотермальными компаниями, подписав соглашения с Sage Geosystems на поставку до 150 МВт энергии, а также с XGS Energy — на ту же мощность. Google заключила соглашение на 10 МВт с Baseload Capital на Тайване и сделку с NV Energy на поставку 115 МВт от геотермальной электростанции Fervo Energy в Неваде.

09.12.2025 [15:33], Руслан Авдеев

SoftBank ведёт переговоры о покупке DigitalBridge, крупного инвестора в ЦОДЯпонская SoftBank Group ведёт переговоры о покупке частной инвестиционной компании, вкладывающей средства в цифровую инфраструктуры, в том числе в ЦОД — DigitalBridge Group. Потенциальный покупатель стремится воспользоваться всеми преимуществами, которые даёт бум на рынке цифровой инфраструктуры на фоне развития ИИ-проектов, сообщает Bloomberg. По данным источников, SoftBank предполагает приобретение котирующейся на нью-йоркской бирже компании для последующего преобразования её в частный бизнес. На фоне новостей, акции DigitalBridge, упавшие на 13 % с начала года до прошедшей пятницы, выросли на 45 %, продемонстрировав самый высокий дневной прирост в истории компании. Сделка может состояться в ближайшие недели. Сами компании от комментариев отказываются. Согласно данным на сайте DigitalBridge, на конец сентября компания управляла активами на сумму порядка $108 млрд. В портфолио инвестора входят операторы ЦОД AIMS, AtlasEdge, DataBank, Scala Data Centers, Switch, Vantage Data Centers и Yondr. По мнению экспертов, DigitalBridge рассматривает возможность продажи, но только по «правильной» цене и на «правильных» условиях.

Источник изображения: Kanchanara/unsplash.com Ранее SoftBank уже пыталась освоить рынок инвестиций в инфраструктуру и недвижимость, приобретя в 2017 году Fortress Investment Group более чем за $3 млрд. В итоге в 2024 году она активы группе, включающей суверенный фонд благосостояния Абу-Даби Mubadala Investment Co. и руководство Fortress. В январе SoftBank сообщила об участии совместно с OpenAI, Oracle и MGX в проекте Stargate стоимостью $500 млрд, предполагавшему строительство ИИ ЦОД в США. Хотя SoftBank обещала выделить $100 млрд «немедленно», реализация проекта идёт не так быстро, как планировалось, во многом из-за разногласий по поводу мест размещения дата-центров. В мае сообщалось, что SoftBank пыталась привлечь финансирование от внешних инвесторов, включая страховые компании, пенсионные и инвестиционные фонды. Тем не менее некоторые переговоры замедлились из-за волатильности рынка, неопределённости в торговой политике США и вопросов к финансовым оценкам ИИ-оборудования. В сентябре OpenAI, Oracle и SoftBank объявили о намерении построить пять новых площадок в Техасе, Нью-Мексико и Огайо с общей мощностью 7 ГВт, это сопоставимо с мощностью некоторых городов. Для высвобождения капитала SoftBank потребовалось перераспределение части средств. При этом руководство очень переживало из-за необходимости продать долю в NVIDIA за $5,8 млрд чтобы получить деньги для других ИИ-проектов. По данным Datacenter Dynamics, компания Vantage из портфолио DigitalBridge стоит за ЦОД для Stargate. Инвестор в альтернативные активы — компания 26North вела переговоры о покупке DigitalBridge в мае 2025 года. В ноябре текущего года DigitalBridge завершила формирование инвестиционного фонда DigitalBridge Partners III (DBP III) стоимостью $11,7 млрд для инвестиций в ЦОД, ВОЛС и инфраструктуру мобильной связи. UPD 12.12.2025: по данным Bloomberg, SoftBank также интересуется покупкой оператора ЦОД Switch. Владельцы оператора рассчитывают оценивают компанию приблизительно в $50 млрд с учётом долговых обязательств. Попутно они также рассматривают возможность IPO в начале 2026 года, рассчитывая на оценку в районе $60 млрд. Switch был приобретён DigitalBridge Group и IFM Investors за $11 млрд в конце 2022 года и покинул NYSE (тикер SWCH). Это одна из крупнейших сделок на рынке ЦОД.

05.07.2025 [02:13], Владимир Мироненко

CoreWeave первой в отрасли развернула кластер на базе NVIDIA GB300 NVL72Облачный провайдер CoreWeave объявил о первом в отрасли развёртывании кластера на базе передовой платформы NVIDIA GB300 NVL72, размещённой в интегрированной стоечной системе, поставленной Dell. Развёртыванием кластера занимался оператор ЦОД Switch. Dell заявила, что стоечные системы поставляются собранными и протестированными. Они изначально разработаны для быстрой установки и развёртывания. GB300 NVL72 в исполнении Dell представляет собой интегрированное стоечное решение на базе серверов PowerEdge XE9712 с жидкостным охлаждением, которое объединяет 72 ускорителя NVIDIA Blackwell Ultra, 36 Arm-процессоров NVIDIA Grace на базе Arm-архитектуры, интерконнект NVLink и 18 или 36 DPU NVIDIA BlueField-3 в одну мощную платформу, использующую в работе широкий спектр передовых решений NVIDIA. Каждая стойка GB300 NVL72 оснащена 21 Тбайт HBM3E и 40 Тбайт RAM. В решении используются 800G-сеть с коммутаторами Quantum-X800 InfiniBand и адаптерами ConnectX-8 SuperNIC. Каждая стойка GB300 NVL72 обеспечивает производительность 1,1 Эфлопс в FP4-вычислениях для инференса и 0,36 Эфлопс в FP8 (без разреженности) для обучения, что на 50 % выше по сравнению с GB200 NVL72. Программная инфраструктура NVIDIA DOCA, работающая на NVIDIA BlueField-3, ускоряет рабочие нагрузки ИИ, обеспечивая пользователям скорость сети до 200 Гбит/с и высокопроизводительный доступ к данным ускорителей. Как отметила CoreWeave, новое оборудование означает для клиентов значительный рост производительности при обработке рабочих нагрузок рассуждающих ИИ-моделей.

19.12.2024 [13:59], Руслан Авдеев

SMR-стартап Oklo подписал сделку о поставке 12 ГВт оператору ЦОД SwitchРазработчик малых атомных реакторов Oklo, поддерживаемый главой OpenAI Сэмом Альтманом (Sam Altman), подписал соглашение о поставке 12 ГВт мощностей оператору дата-центров Switch. Ожидается, что это поможет удовлетворить растущий спрос оператора на электроэнергию, сообщает Bloomberg. Компании подписали не обязывающее соглашение, действующее до 2044 года, которое поддержит планы Oklo по строительству и управлению малыми модульными реакторами (SMR) Aurora. В Oklo рассчитывают начать поставки электричества от своих микро-АЭС к концу десятилетия по цене около $100 за МВт∙ч. Многочисленные IT-гиганты, включая AWS и Meta✴ подписали в последние месяцы соглашения для питания своей инфраструктуры с помощью атомной энергии, но сделка Oklo и Switch является одной из крупнейших. Утверждается, что ЦОД являются идеальными клиентами новых атомных проектов, поскольку их потребности в стабильных поставках энергии только растут. Правда, пока атомные сделки зависят от разработчиков SMR, которые всё ещё не создали ни один работающий коммерческий реактор.

Источник изображения: Oklo Oklo является одной из десятков компаний, разрабатывающих малые модульные реакторы — они будут выпускаться на заводах и собираться на местах использования. Предполагается, что мини-АЭС будут быстрее и дешевле строить, но пока испытаний в реальных условиях они не прошли. Oklo, председателем которой является Сэм Альтман, может стать одной из первых — первый SMR компании, возможно, заработает уже в 2027 году. Ранее сообщалось о получении запросов Oklo на поставку 750 МВт для ЦОД в США. Потенциальные клиенты не называются, но известно, что общая мощность планируемых к строительству реакторов Oklo в результате должна вырасти до 2,1 ГВт. В апреле появилась информация о том, что Equinix заплатила $25 млн за право получить до 500 МВт от малых модульных реакторов Oklo.

05.10.2024 [13:39], Руслан Авдеев

HMC Capital ведёт переговоры о покупке активов Global Switch Australia и других ЦОДHMC Capital ведёт переговоры о покупке ряда дата-центров, включая австралийский бизнес компании Global Switch. По данным Datacenter Dynamics, в пятницу инвестор сообщил, что проводит аудит перед несколькими потенциальными покупками. Заявляется, что стороны ведут переговоры, но условия возможных приобретений пока остаются конфиденциальными и ещё не носят юридически обязывающего характера. HMC Capital представила информацию после того, как некоторые данные обнародовали австралийские СМИ. По их информации, Global Switch Australia оценена в AU$2 млрд ($1,33 млрд). В июле, по слухам, Global Switch уже отклонила несколько предложений о покупке её австралийского подразделения, поскольку предложенные суммы не устроили компанию. Среди потенциальных покупателей были Stonepeak, Queensland Investment Corporation и Canada Pension Plan Investment Board (CPP Investments).

Источник изображения: Global Switch Global Switch управляет 13 объектами в Европе, Австралии и Азии. Также компания строит объект в Лондоне (Великобритании) и завершила строительство во Франкфурте (Германия). В Сиднее компания управляет двумя примыкающими друг к другу дата-центрами Sydney West (20,5 МВт) и Sydney East (22 МВт) с общей площадью зданиями на территории площадью 11 тыс. м2. Недавно компания подала заявку на надстройку дополнительных этажей на уже существующих зданиях. Продажа Global Switch целиком или по частям обсуждалась в течение нескольких лет после того, как китайский металлургический гигант Jiangsu Shagang Group взял компанию под контроль. Речь шла о $10–11 млрд. В числе потенциальных покупателей назывались больше дюжины компаний и инвестиционных фондов. Переговоры, судя по всему, прекратились в январе 2023 года — покупатели предлагали слишком мало. Впрочем, сообщалось, что EQT всё ещё интересовалась сделкой, оценивая всю Global Switch в $6–7 млрд. Несколько австралийских правительственных учреждений отказались от использования объектов в Сиднее после того, как китайский бизнес получил контроль над компанией. В том числе речь идёт о Министерстве внутренних дел, а также других крупных ведомствах, тесно связанных с вопросами национальной безопасности.

11.09.2024 [20:13], Руслан Авдеев

DigitalBridge намерена снова вывести Switch на IPOВладельцы оператора дата-центров Switch рассматривают IPO компании в 2025 году, которое, вероятно, поднимет оценку компании до $40 млрд. По данным Reuters, пока обсуждение вопроса находится на ранней стадии и решение ещё не принято. Switch управляет крупными кампусами в Остине (Техас), Рино (Лас-Вегас), Гранд-Рапидс (Мичиган) и Атланте (Джорджия). В прошлом году поданы заявления о расширении бизнеса в Остине и Атланте. Основанная в 2000 году компания вышла на IPO в 2017 году, сумев привлечь $513 млн при рыночной капитализации $4,2 млрд. В 2022 году Switch была выкуплена DigitalBridge и IFM Investors за $11 млрд и стала частной. В 2023 году миноритарную долю приобрёл австралийский пенсионный фонд Aware Super. По имеющимся данным, в последние недели Switch провела предварительные переговоры с инвестиционными банкирами. На такой шаг компании намерены пойти на фоне стремительного роста интереса инвесторов к генеративному ИИ, который вызвал взлёт спроса на инфраструктуру, в том числе на дата-центры и высокопроизводительные серверы.

Источник изображения: Jason Briscoe/unsplash.com В последнее время отмечается и значительное увеличение числа сделок на рынке серверов и ЦОД. Например, в сентябре текущего года Blackstone заключила сделку, купив австралийского оператора ЦОД AirTrunk за сумму, превышающую AU$24 млрд ($16 млрд), в августе AMD согласилась купить производителя серверов ZT Systems за $4,9 млрд — компания намерена расширить свои продуктовые линейки в попытке угнаться за чрезвычайно успешной NVIDIA. С последней сотрудничает и Switch. Также компания работает с Dell и FedEx. С января 2016 года дата-центры компании питаются за счёт возобновляемой энергии — это привлекает технологические компании, имеющие природоохранные обязательства и соответствующие заявленные цели. Согласно докладу Morgan Stanley, до конца десятилетия мировой бум индустрии ЦОД, вероятно, обеспечит выбросы, эквивалентные 2,5 млрд тонн углекислого газа.

08.12.2022 [14:24], Сергей Карасёв

Закрыта $11-млрд сделка по продаже одного из крупнейших операторов ЦОД Switch — компания станет частнойDigitalBridge Group и IFM Investors сообщили о завершении сделки по поглощению одного из крупнейших операторов дата-центров — компании Switch. Соответствующее соглашение было заключено в мае 2022 года. Продажа осуществлена из расчёта $34,25 за одну ценную бумагу Switch. Общая сумма сделки с учётом долговых обязательств составила $11 млрд денежными средствами — это одна из крупнейших сделок на рынке ЦОД в этом году. После завершения слияния Switch превратится в частную компанию, а продажи её акций на Нью-Йоркской фондовой бирже прекратятся. Ранее этот оператор ЦОД торговался под тикером SWCH. Switch управляет крупными американскими площадками Prime в Рино, Лас-Вегасе, Гранд-Рапидсе и Атланте. В 2021 году компания открыла пятый кампус ЦОД в Техасе и сообщила, что планирует до 2030 года построить более 1,02 млн м2 дополнительных площадей.

Источник изображения: Switch «Мы рады приступить к следующему этапу развития Switch в партнёрстве с DigitalBridge и IFM Investors, двумя ведущими инвестиционными компаниями в области цифровой инфраструктуры. Благодаря своему стратегическому опыту и ресурсам Switch имеет отличные возможности для удовлетворения растущего спроса клиентов на наиболее передовую и экологически устойчивую инфраструктуру дата-центров в мире», — отмечает Switch. В настоящее время активы DigitialBridge на рынке ЦОД, помимо компании Switch, включают DataBank, Scala Data Centers, Landmark Dividend LLC, Vantage Data Centers и AtlasEdge. При этом Switch также сотрудничает с FedEx в рамках проекта по созданию периферийных ЦОД в США. Ожидалось, что в этом году состоится ещё одна крупная сделка по продаже другого оператора ЦОД со схожим названием, Global Switch, который оценён в $10 млрд.

22.03.2022 [18:40], Игорь Осколков

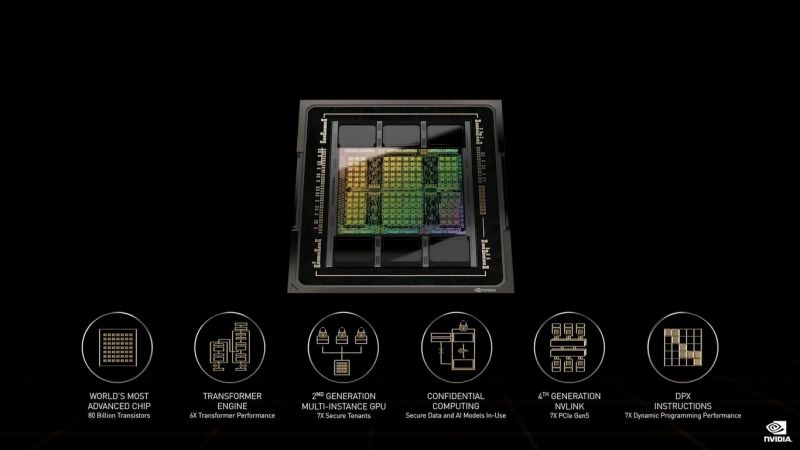

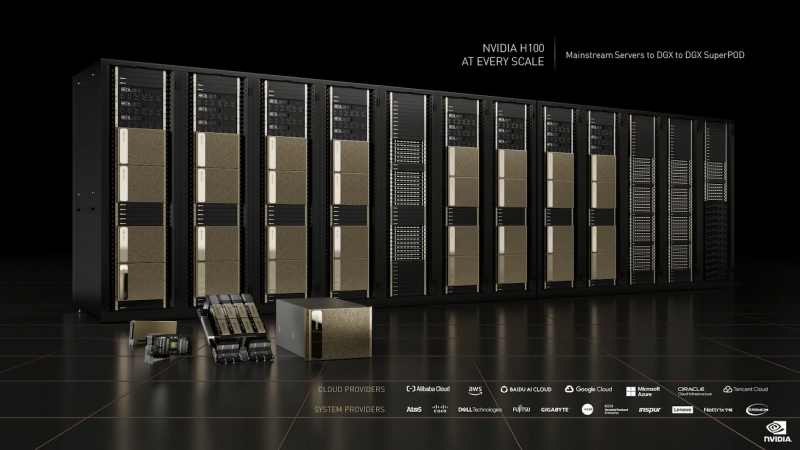

NVIDIA анонсировала 4-нм ускорители Hopper H100 и самый быстрый в мире ИИ-суперкомпьютер EOS на базе DGX H100На GTC 2022 компания NVIDIA анонсировала ускорители H100 на базе новой архитектуры Hopper. Однако NVIDIA уже давно говорит о себе как создателе платформ, а не отдельных устройств, так что вместе с H100 были представлены серверные Arm-процессоры Grace, в том числе гибридные, а также сетевые решения и обновления наборов ПО.

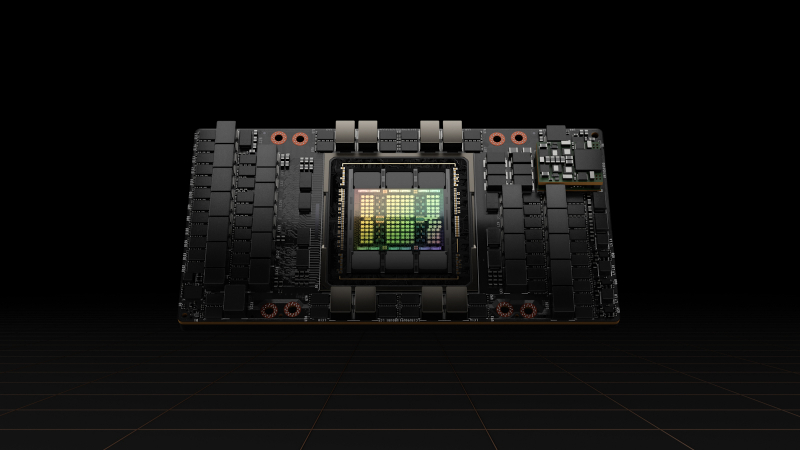

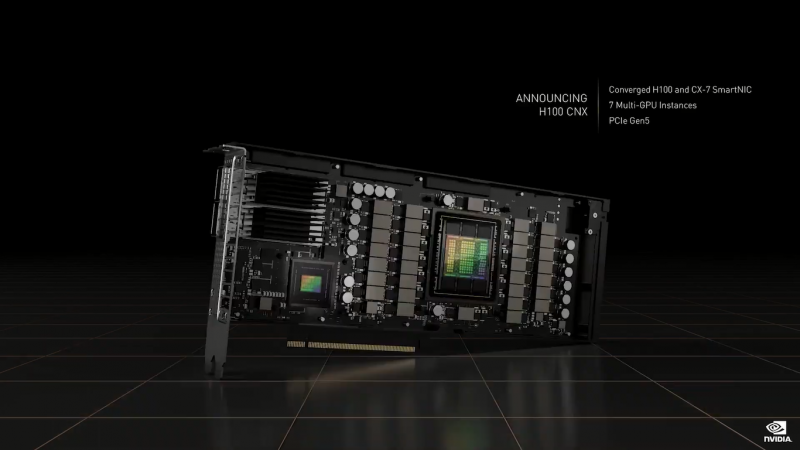

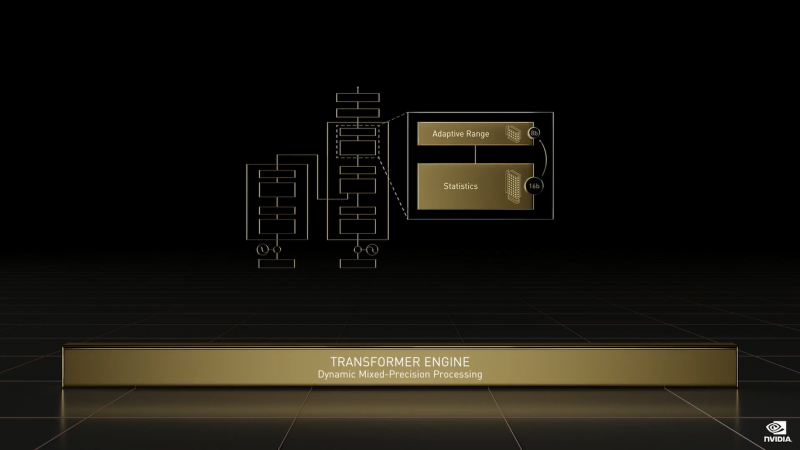

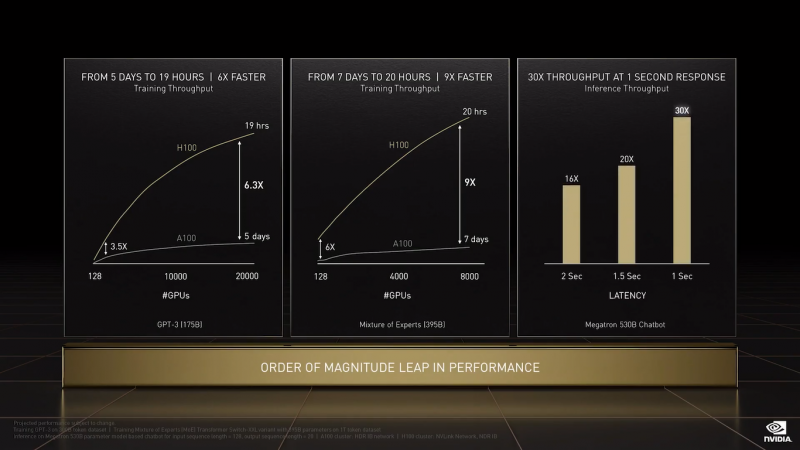

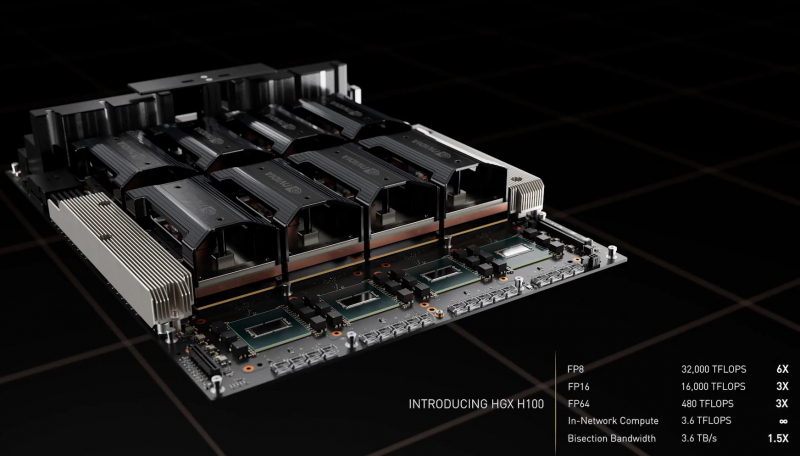

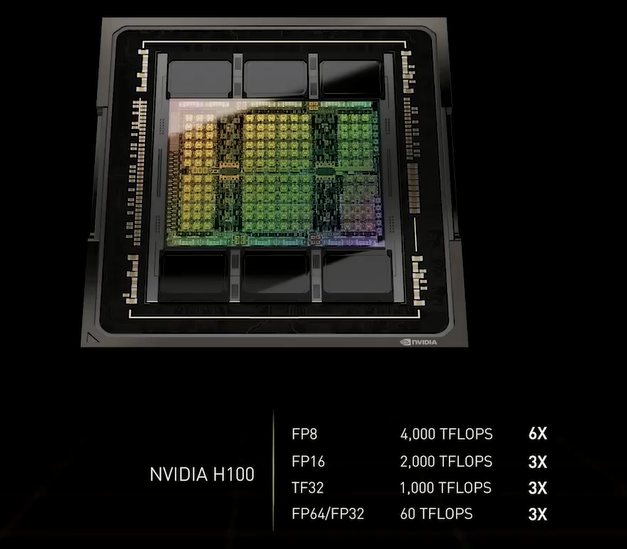

NVIDIA H100 (Изображения: NVIDIA) NVIDIA H100 использует мультичиповую 2.5D-компоновку CoWoS и содержит порядка 80 млрд транзисторов. Но нет, это не самый крупный чип компании на сегодняшний день. Кристаллы новинки изготавливаются по техпроцессу TSMC N4, а сопровождают их — впервые в мире, по словам NVIDIA — сборки памяти HBM3 суммарным объёмом 80 Гбайт. Объём памяти по сравнению с A100 не вырос, зато в полтора раза увеличилась её скорость — до рекордных 3 Тбайт/с. Подробности об архитектуре Hopper будут представлены чуть позже. Пока что NVIDIA поделилась некоторыми сведениями об особенностях новых чипов. Помимо прироста производительности от трёх (для FP64/FP16/TF32) до шести (FP8) раз в сравнении с A100 в Hopper появилась поддержка формата FP8 и движок Transformer Engine. Именно они важны для достижения высокой производительности, поскольку само по себе четвёртое поколение ядер Tensor Core стало втрое быстрее предыдущего (на всех форматах). TF32 останется форматом по умолчанию при работе с TensorFlow и PyTorch, но для ускорения тренировки ИИ-моделей NVIDIA предлагает использовать смешанные FP8/FP16-вычисления, с которыми Tensor-ядра справляются эффективно. Хитрость в том, что Transformer Engine на основе эвристик позволяет динамически переключаться между ними при работе, например, с каждым отдельным слоем сети, позволяя таким образом добиться повышения скорости обучения без ущерба для итогового качества модели. На больших моделях, а именно для таких H100 и создавалась, сочетание Transformer Engine с другими особенностями ускорителей (память и интерконнект) позволяет получить девятикратный прирост в скорости обучения по сравнению с A100. Но Transformer Engine может быть полезен и для инференса — готовые FP8-модели не придётся самостоятельно конвертировать в INT8, движок это сделает на лету, что позволяет повысить пропускную способность от 16 до 30 раз (в зависимости от желаемого уровня задержки). Другое любопытное нововведение — специальные DPX-инструкции для динамического программирования, которые позволят ускорить выполнение некоторых алгоритмов до 40 раз в задачах, связанных с поиском пути, геномикой, квантовыми системами и при работе с большими объёмами данных. Кроме того, H100 получили дальнейшее развитие виртуализации. В новых ускорителях всё так же поддерживается MIG на 7 инстансов, но уже второго поколения, которое привнесло больший уровень изоляции благодаря IO-виртуализации, выделенным видеоблокам и т.д. Так что MIG становится ещё более предпочтительным вариантом для облачных развёртываний. Непосредственно к MIG примыкает и технология конфиденциальных вычислений, которая по словам компании впервые стала доступна не только на CPU. Программно-аппаратное решение позволяет создавать изолированные ВМ, к которым нет доступа у ОС, гипервизора и других ВМ. Поддерживается сквозное шифрование при передаче данных от CPU к ускорителю и обратно, а также между ускорителями. Память внутри GPU также может быть изолирована, а сам ускоритель оснащается неким аппаратным брандмауэром, который отслеживает трафик на шинах и блокирует несанкционированный доступ даже при наличии у злоумышленника физического доступа к машине. Это опять-таки позволит без опаски использовать H100 в облаке или в рамках колокейшн-размещения для обработки чувствительных данных, в том числе для задач федеративного обучения. Но главная инновация — это существенное развитие интерконнекта по всем фронтам. Суммарная пропускная способность внешних интерфейсов чипа H100 составляет 4,9 Тбайт/с. Да, у H100 появилась поддержка PCIe 5.0, тоже впервые в мире, как утверждает NVIDIA. Однако ускорители получили не только новую шину NVLink 4.0, которая стала в полтора раза быстрее (900 Гбайт/с), но и совершенно новый коммутатор NVSwitch, который позволяет напрямую объединить между собой до 256 ускорителей! Пропускная способность «умной» фабрики составляет до 70,4 Тбайт/с. Сама NVIDIA предлагает как новые системы DGX H100 (8 × H100, 2 × BlueField-3, 8 × ConnectX-7), так и SuperPOD-сборку из 32-х DGX, как раз с использованием NVLink и NVSwitch. Партнёры предложат HGX-платформы на 4 или 8 ускорителей. Для дальнейшего масштабирования SuperPOD и связи с внешним миром используются 400G-коммутаторы Quantum-2 (InfiniBand NDR). Сейчас NVIDIA занимается созданием своего следующего суперкомпьютера EOS, который будет состоять из 576 DGX H100 и получит FP64-производительность на уровне 275 Пфлопс, а FP16 — 9 Эфлопс. Компания надеется, что EOS станет самой быстрой ИИ-машиной в мире. Появится она чуть позже, как и сами ускорители, выход которых запланирован на III квартал 2022 года. NVIDIA представит сразу три версии. Две из них стандартные, в форм-факторах SXM4 (700 Вт) и PCIe-карты (350 Вт). А вот третья — это конвергентный ускоритель H100 CNX со встроенными DPU Connect-X7 класса 400G (подключение PCIe 5.0 к самому ускорителю) и интерфейсом PCIe 4.0 для хоста. Компанию ей составят 400G/800G-коммутаторы Spectrum-4. |

|