Материалы по тегу: 100gbe

|

05.02.2026 [11:35], Сергей Карасёв

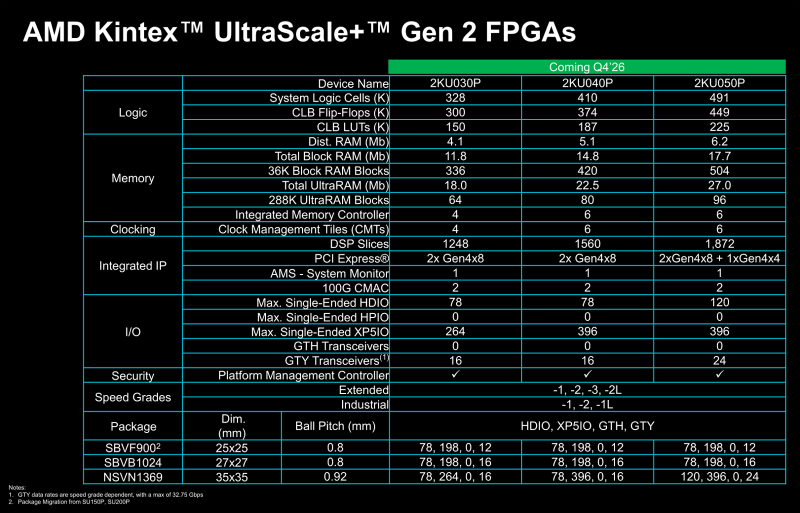

AMD представила FPGA серии Kintex UltraScale+ Gen 2 с поддержкой PCIe 4.0 и LPDDR5XКомпания AMD анонсировала FPGA серии Kintex UltraScale+ Gen 2, относящиеся к среднему классу. Эти изделия могут использоваться в разных сферах, включая здравоохранение (эндоскопия, машинное зрение, роботизированная хирургия), промышленный сектор (системы автоматизации и инспекции, периферийные платформы), вещание (видеозахват, производство материалов), среды тестирования и пр. Решения выполнены по 16-нм технологии FinFET. Реализована поддержка памяти LPDDR4X, LPDDR5 и LPDDR5X, интерфейса PCIe 4.0, а также двух блоков 100G CMAC. Упомянуты средства постквантовой криптографии в соответствии с алгоритмами, одобренными Национальным институтом стандартов и технологий США (NIST). В семейство Kintex UltraScale+ Gen 2 вошли три модели — 2KU030P, 2KU040P и 2KU050P. Первый из перечисленных чипов содержит 328 тыс. логических элементов, 150 тыс. CLB LUT (Configurable Logic Block Look-Up Table), четыре контроллера LPDDR4X/5/5X, а также в общей сложности 33,9 Мбайт памяти. Конфигурация включает два интерфейса PCIe 4.0 x8. В свою очередь, решение 2KU040P насчитывает 410 тыс. логических элементов и 187 тыс. CLB LUT, имеет шесть контроллеров LPDDR4X/5/5X, 42,4 Мбайт памяти и два интерфейса PCIe 4.0 x8. Старший вариант, 2KU050P, получил 491 тыс. логических элементов, 225 тыс. CLB LUT, шесть контроллеров LPDDR4X/5/5X, 50,9 Мбайт памяти, два интерфейса PCIe 4.0 x8 и один интерфейс PCIe 4.0 x4. Первые инженерные образцы решений Kintex UltraScale+ Gen 2 начнут поступить заказчикам в IV квартале текущего года, тогда как серийное производство чипов должно начаться в I половине 2027-го. Компания AMD гарантирует доступность изделий как минимум до 2045 года, что должно сделать новые FPGA особенно привлекательными для отраслей с длительным жизненным циклом продукции, таких как аэрокосмическая и оборонная промышленность.

26.12.2025 [13:27], Сергей Карасёв

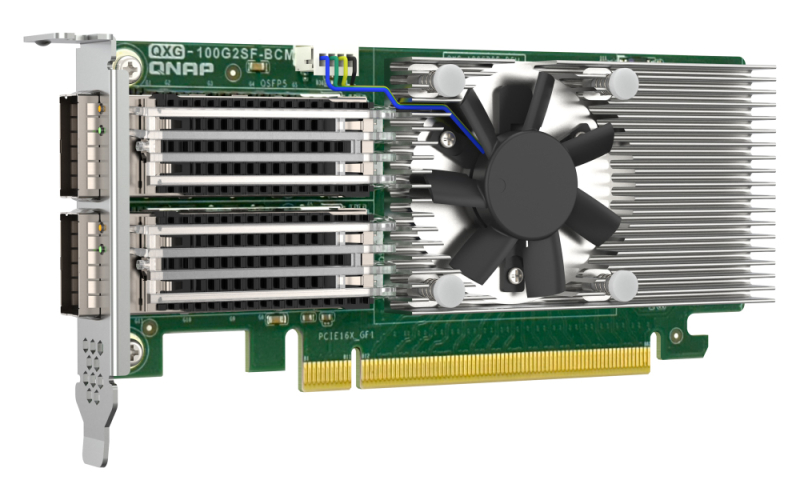

QNAP выпустила 100GbE-адаптер с интерфейсом PCIe 4.0 x16Компания QNAP Systems анонсировала сетевой адаптер QXG-100G2SF-BCM стандарта 100GbE, рассчитанный на использование в дата-центрах. Изделие, как утверждается, призвано устранить узкие места при передаче данных в средах с интенсивным вводом-выводом, в частности, в системах виртуализации. Новинка выполнена в виде карты расширения с интерфейсом PCIe 4.0 x16. Применён контроллер Broadcom 57508. Реализованы два порта QSFP28 со скоростью передачи данных 100 Гбит/с каждый. Устройство имеет однослотовый низкопрофильный дизайн, а в комплект поставки входят монтажные планки стандартной и уменьшенной высоты. Применено активное охлаждение с радиатором и вентилятором с центральным расположением. Благодаря поддержке RDMA (RoCE и iSER) уменьшается задержка, снижается нагрузка на CPU и повышается общая эффективность, говорит QNAP, а технология SR-IOV (Single Root Input/Output Virtualization) позволяет сетевой карте выглядеть как несколько независимых устройств. Сетевой адаптер QXG-100G2SF-BCM может применяться в СХД QNAP под управлением QTS и QuTS hero. Гарантирована совместимость с Windows 11. На изделие предоставляется трёхлетняя гарантия.

21.12.2025 [12:22], Руслан Авдеев

Китай развернул обширную экспериментальную телеком-сеть CENI, сравнив её с американской ARPANETКитайские власти на днях сертифицировали исследовательскую телеком-сеть China Environment for Network Innovation (CENI). Пекин рассчитывает, что она поможет КНР оставаться на переднем крае исследований сетевых технологий, сообщает The Register. По данным государственных СМИ, тесты сети показали, что она способна передать 72 Тбайт за 1,6 часа на расстояние 1 тыс. км — между радиотелескопом в провинции Гуйджоу (Guizhou) и университетом в провинции Хубэй (Hubei). Фактически скорость составляет почти 100 Гбит/с, это хороший результат для передачи данных на большие расстояния — даже если речь шла об эксперименте в контролируемой среде. У CENI ушло более десяти лет на строительство сети, теперь она связывает 40 китайских городов с использованием 55 тыс. км оптоволокна. Государственные СМИ КНР сообщают, что платформа может поддерживать 128 гетерогенных сетей (разных по архитектуре и протоколам) и проводить 4 096 параллельных тестов гетерогенных сервисов.

Источник изображения: Fernand De Canne/unsplash.com Китай нередко разрешает учёным докладывать о своих технологических достижениях на международных конференциях. Так, в ноябре о CENI сообщалось на конференции HEPiX Forum, в основном посвящённой физике высоких энергий. При этом в презентации CENI сравнивается со старой американской сетью ARPANET, за которой, помимо исследователей, стояли военные, и сетью Global Environment for Network Innovations (GENI) — считается, что именно они легли в основу современного интернета. ARPANET и GENI уже не функционируют, хотя многие государства и организации имеют более современные исследовательские сети. В ходе презентации на площадке HEPiX отмечалось, что одна из целей CENI — разработка сетевых инноваций «на 5-10 лет с опережением индустрии». Также сообщалось, что китайские техногиганты Huawei и Baidu использовали сеть для тестирования своих технологий. Последняя применила CENI для перемещения корпуса данных при решении задач по обучению ИИ и инференсу. Поскольку Китай стремится создать собственную, независимую ИИ-экосистему, CENI может послужить весьма полезным инструментом для поддержки этих усилий. При этом ещё пять лет назад Huawei предложила Международному союзу электросвязи (ITU) план по отказу от TCP/IP и переходу разработанное её решение New IP.

10.12.2025 [13:18], Сергей Карасёв

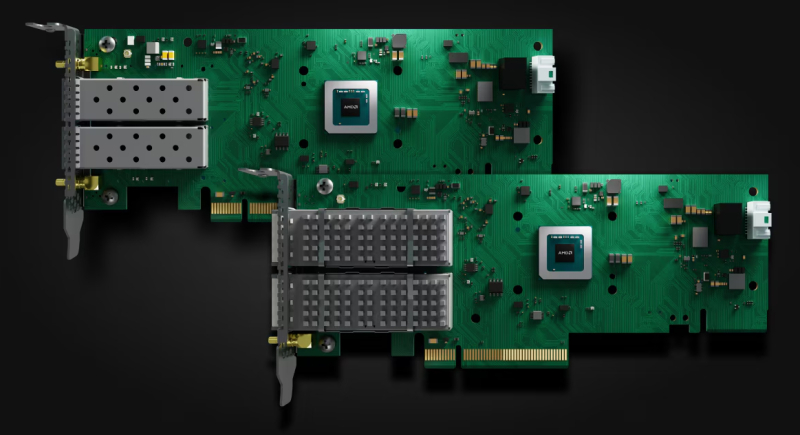

«Гравитон» представил SmartNIC SNC-QSFP2-SH01 с FPGA, 100GbE-портами и слотом SO-DIMMКомпания «Гравитон», российский производитель вычислительной техники, анонсировала сетевой адаптер SNC-QSFP2-SH01 класса SmartNIC, предназначенный для использования в дата-центрах. Устройство обеспечивает аппаратное ускорение различных сетевых функций. В основу решения положена неназванная ПЛИС, которая насчитывает свыше 1 млн логических ячеек и содержит более 50 Мбит встроенной блочной памяти. Адаптер может нести на борту до 32 Гбайт оперативной памяти DDR4. Также упоминается отечественный центральный микроконтроллер первого уровня. Карта оснащена двумя 100GbE-портами QSFP28, что, впрочем, видится избыточным, поскольку используемое подключение PCIe 3.0 x8 не способно «прокачать» столько трафика. За охлаждение отвечают радиатор и вентилятор тангенциального типа. Заявлена поддержка библиотек DPDK и совместимость с платформами Linux и Windows Благодаря возможности реконфигурирования FPGA адаптер может использоваться для решения широкого спектра задач. Среди них названы ускорение работы облачных сервисов, виртуализация, проверка сетевых пакетов по их содержимому (DPI) для регулирования и фильтрации трафика, межсетевые экраны нового поколения (NGFW). Изделие также может применяться в комплексных решениях в сфере кибербезопасности для поиска и устранения угроз в сетевом трафике.

Источник изображения: «Гравитон» «Использование архитектуры на базе ПЛИС позволило нам создать устройство, которое не просто передаёт пакеты, а берёт на себя ресурсоёмкие вычисления: от балансировки нагрузки до глубокой инспекции пакетов. Мы предлагаем рынку мощный инструмент, который поможет оптимизировать работу облачных сервисов и систем информационной безопасности, высвобождая ресурсы CPU для прикладных задач», — говорит «Гравитон».

10.10.2025 [12:00], Сергей Карасёв

AMD представила Ethernet-адаптеры Solarflare X4 со сверхнизкой задержкойКомпания AMD анонсировала Ethernet-адаптеры Solarflare X4 для систем, в которых критическое значение имеет минимальная задержка. Это могут быть платформы для трейдинга, анализа финансовых данных в реальном времени и других задач, где, как подчеркивается, важна каждая наносекунда. В семейство Solarflare X4 вошли две модели — X4542 и X4522. По сравнению с изделиями Solarflare предыдущего поколения новинки, по заявлениям AMD, обеспечивают уменьшение задержки до 40 %. Производительность на системном уровне увеличилась на 200 % по отношению к адаптерам Solarflare X2. Обе новинки выполнены в виде низкопрофильных карт расширения половинной длины с интерфейсом PCIe 5.0 x8. В основу положена кастомизированная ASIC, обеспечивающая сверхнизкие задержки. AMD уверяет, что при использовании адаптеров в связке с процессорами EPYC 4005 Grado достигается снижение задержки до 12 % по сравнению с аналогичными по классу решениями конкурентов. Версия Solarflare X4542 оснащена двумя разъёмами QSFP с поддержкой двух портов 40/50/100GbE или четырёх портов 1/10/25GbE. Модификация Solarflare X4522, в свою очередь, получила два разъёма SFP с поддержкой пары портов 1/10/25/50GbE. Карты оснащены пассивным охлаждением. Энергопотребление составляет менее 25 Вт. Для адаптеров доступно фирменное ПО AMD Solarflare Onload, которое отвечает за повышение производительности при работе с ресурсоёмкими сетевыми приложениями, такими как резидентные базы данных, программные балансировщики нагрузки и веб-серверы. Solarflare Onload помогает поднять эффективность обработки огромных объёмов небольших пакетов данных — даже в периоды пиковой нагрузки. AMD отмечает, что 9 из 10 крупнейших мировых фондовых бирж используют решения Solarflare для обеспечения работы своих торговых платформ.

12.07.2025 [15:13], Сергей Карасёв

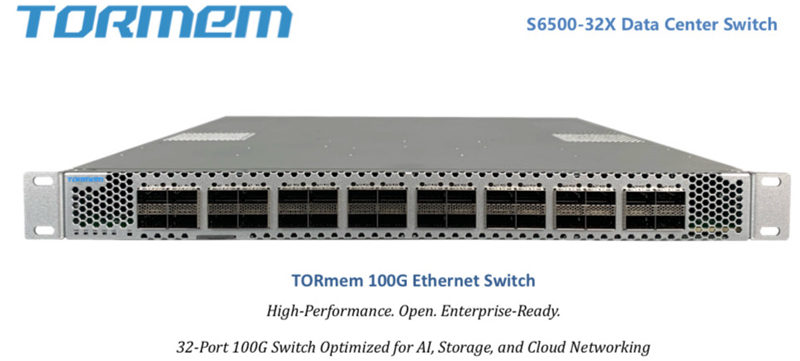

От 100GbE до 800GbE, недорого: стартап TORmem обещает трансформировать рынок ЦОД-коммутаторовСтартап TORmem, специализирующийся на решениях для дезагрегации памяти в дата-центрах, обнародовал планы по выпуску коммутаторов для сетей с высокой пропускной способностью. В семейство войдут модели с поддержкой стандартов от 100GbE до 800GbE. По утверждениям TORmem, она потратила четыре года на разработку «революционной технологии дезагрегации», которая позволяет реализовывать концепцию вычислений в оперативной памяти (IMC) в масштабах ЦОД. Полученный опыт стартап намерен использовать для решения другой проблемы современных дата-центров — высокой стоимости корпоративной сетевой инфраструктуры. TORmem обещает трансформировать сегмент коммутаторов корпоративного класса, выпустив высокопроизводительные устройства по цене в два раза меньше по сравнению с аналогичными решениями, уже представленными на рынке. В частности, TORmem предлагает для заказа модель стандарта 100GbE (S6500-32X) с 32 портами на основе ASIC Marvell: устройство стоит $7 тыс. против $14 тыс. или более у «стандартных продуктов», говорит компания.

Источник изображений: TORmem В конце текущего года стартап намерен подготовиться к началу производства коммутаторов 200GbE/400GbE, которые, как ожидается, также окажутся на 50 % дешевле конкурирующих изделий: их цена составит от $12 тыс. до $20 тыс. против $25–$40 тыс., которые, как утверждается, будут просить конкуренты. Кроме того, в разработке находятся модели класса 800GbE.  На сайте Unipoe.net удалось обнаружить описание коммутатора RZ-S6500-32X. Он располагает 32 портами 40/100GbE QSFP28, а коммутируемая ёмкость достигает 6,4 Тбит/с. Устройство выполнено в форм-факторе 1U с габаритами 440 × 470 × 43 мм. Предусмотрены сетевой порт управления, консольный порт и разъём USB 2.0. В оснащение входят два блока питания и пять модульных вентиляторов с возможностью горячей замены. Максимальное энергопотребление составляет менее 650 Вт. Диапазон рабочих температур — от 0 до +40 °C. Упомянута поддержка протоколов RIP, IS-IS, RIPng, OSPFv3, BGP4+ и пр. Отраслевые аналитики прогнозируют, что объём глобального рынка высокоскоростных коммутаторов увеличится с примерно $8 млрд в 2025 году до более чем $15 млрд в 2027-м. Основным драйвером отрасли называется внедрение решений стандарта 200GbE и выше.

16.06.2025 [09:20], Владимир Мироненко

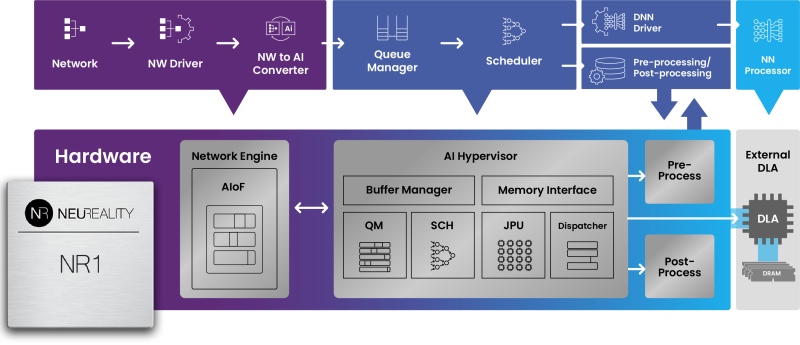

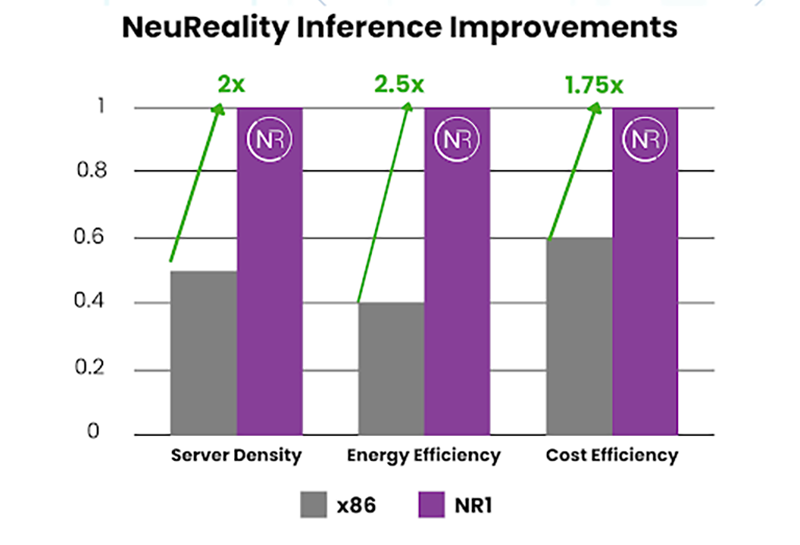

x86 не нужен: «недопроцессор» NeuReality NR1 кратно ускоряет инференс на любых GPUNeuReality объявила о выходе чипа NR1, специально созданного для оркестрации инференса, передаёт HPCwire. Он сочетается с любым GPU или ИИ-ускорителем, позволяя повысить эффективность использование GPU почти до 100 % по сравнению со средним показателем в 30–50 % при традиционном сочетании классического процессора и сетевого адаптера в современных серверах. Чип NR1 призван заменить традиционные CPU и NIC, которые являются узким местом для ИИ-нагрузок, предлагая вместе с тем шестикратное увеличение вычислительной мощности для обеспечения максимальной пропускной способности ускорителей и масштабного ИИ-инференса, утверждает разработчик. Как отметила компания, в течение многих лет разработчики развивали GPU, чтобы соответствовать требованиям ИИ, делая их быстрее и мощнее. Но традиционные CPU, разработанные для эпохи интернета, а не эпохи ИИ, в основном не менялись, становясь узким местом, поскольку ИИ-модели становятся всё более сложными, а запросы ИИ-нагрузок растут в объёме. NR1 включает все базовые функции CPU, необходимые для работы с ИИ-задачами, выделенные обработчики мультимедиа и данных, аппаратный гипервизор и комплексные сетевые IP-блоки, что обеспечивает значительно более высокую производительность, более низкое энергопотребление и окупаемость инвестиций. В тестах самой компании исполнение одной и той же модели на базе генеративного ИИ на одном и том же ИИ-ускорителе её чип NR1 позволяет получить в 6,5 раза больше токенов, чем x86-сервер при той же стоимости и энергопотреблении.  В соответствии с текущей тенденцией на разделение ресурсов хранения и вычислений, дезагрегация ИИ-ресурсов обеспечивает оптимизированную изоляцию ИИ-вычислений, отметила NeuReality. Такое разделение особенно важно в ЦОД и облаках. Традиционные программно-управляемые платформы, ориентированные на CPU, сталкиваются с такими проблемами, как высокая стоимость, энергопотребление и узкие места в системе при обработке задач ИИ-инференса. Сложность современной инфраструктуры и высокая стоимость часто ограничивают использование всех возможностей инференса, утверждает NeuReality. NR1 ориентирован на комплексную разгрузку ИИ-конвейера. Аппаратный ИИ-гипервизор отвечает за обработку путей данных и планирование заданий, охватывая механизмы пред- и постобработки данных, а также сетевой движок AI-over-Fabric. Благодаря этому достигнуто оптимальное соотношение цены и производительности и самые низкие эксплуатационные расходы, характеризующиеся низким энергопотреблением, минимальной задержкой и линейной масштабируемостью, говорит компания. Для DevOps и MLOps компания предоставляет полный SDK и сервисный слой на основе Kubernetes. Новый чип предлагается использовать для решения задач в сфере финансов и страхования, здравоохранении и фармацевтике, госуслугах и образовании, телекоммуникации, ретейле и электронной коммерции, для нагрузок генеративного и агентного ИИ, компьютерного зрения и т.д. NeuReality NR1 включает:

14.04.2025 [08:10], Владимир Мироненко

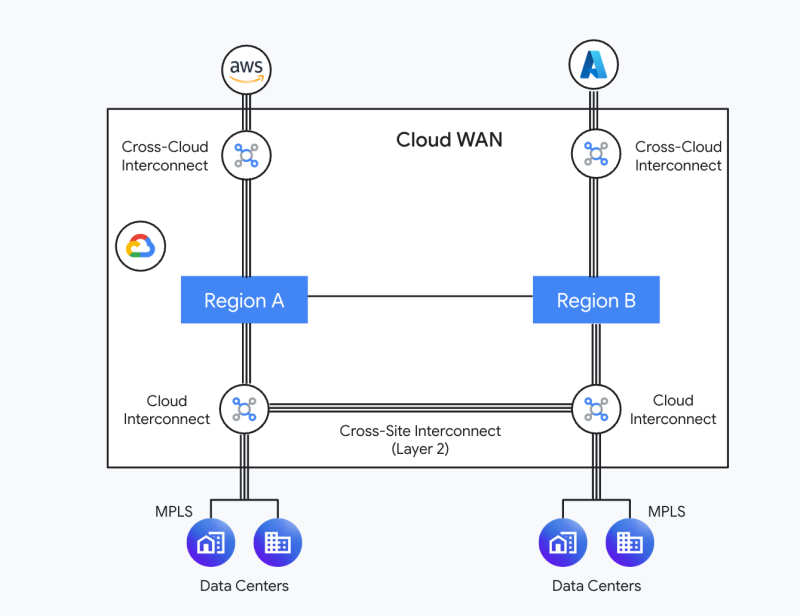

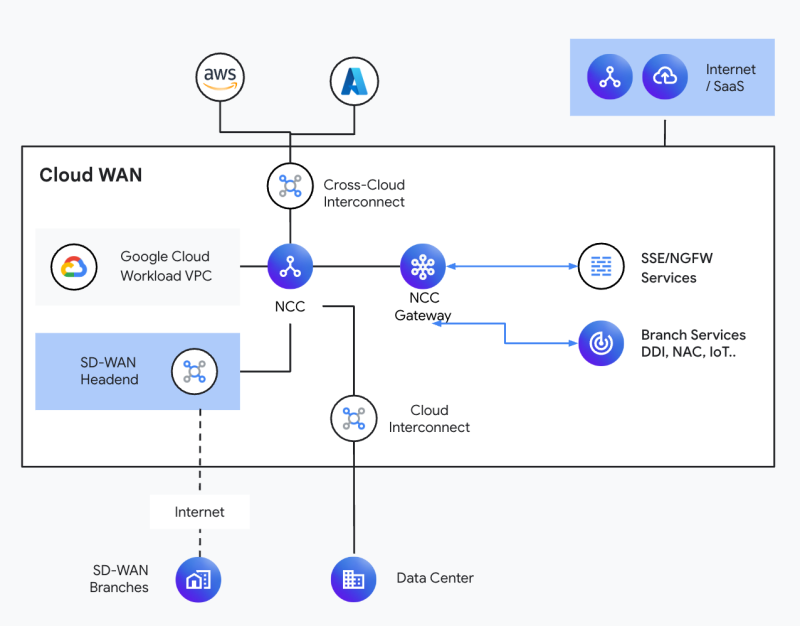

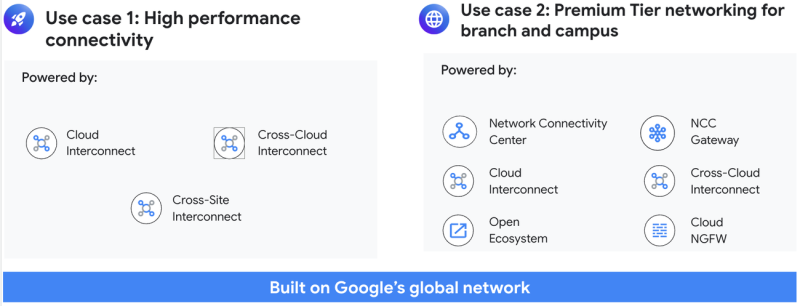

На 40 % быстрее и дешевле обычного интернета: Google предложила компаниям доступ к своей сетевой инфраструктуре планетарного масштабаGoogle объявила о запуске Cloud WAN, полностью управляемой корпоративной WAN-платформы, которая делает доступной для всех компаний и организаций всемирную сетевую инфраструктуру Google, поддерживающую собственные сервисы компании, включая поисковик, Google Cloud Platform, Gmail, YouTube и т.п. Как отмечалось в исследовании ASPI, в настоящее время гиперскейлеры владеют около 71 % международных подводных линий связи. В то же время они стремительно наращивают ёмкость и количество дата-центров, отмечает Synergy Research. Всё это обеспечивает им практически полный контроль над всей цепочкой предоставления интернет-услуг, от создания до хранения, обработки и передачи данных. Однако Google, представив Cloud WAN, намекнула, что готова «отобрать хлеб» у традиционных телеком-операторов. Компания также запустила программу Verified Peering Provider (VPP), которая ранжирует операторов по качеству и глубине связи с сетями Google, и поменяла подход к работе с IX. Сейчас у Google более 5700 прямых пиринговых подключений и доступ к более чем 60 тыс. ASN. Сеть Google занимает первое место среди провайдеров облачных услуг и шестое место в мировом пиринге. Благодаря 202 точкам присутствия (PoP), более 3,2 млн км оптоволокна и 33 подводным кабелям сеть Google предлагает надёжную отказоустойчивую (заявленный SLA 99,99 %) глобальную WAN-платформу для критически важных для бизнеса приложений, сообщает компания.

Источник изображений: Google Google Cloud WAN была специально разработана для замены традиционных корпоративных архитектур WAN. Сеть Google подключена ко всем основным игрокам облачных вычислений в мире и всем известным провайдерам крупных ЦОД, что позволяет ей доставлять трафик с высокой скоростью близко к конечному пункту назначения. По словам компании, Cloud WAN обеспечивает до 40 % более низкую задержку по сравнению с общедоступным интернетом и до 40 % экономии общей стоимости владения (TCO) по сравнению с решением WAN, управляемым клиентом (с учётом брандмауэров). Компания отметила, что быстрое развитие ИИ-технологий предъявило дополнительные требования к корпоративным сетям. ИИ-приложения требуют высокораспределённой инфраструктуры. Cloud WAN предлагает унифицированное корпоративное сетевое решение для безопасного и надёжного подключения между любыми корпоративными локациями, приложениями и пользователями, помогая при этом обеспечивать оптимальную производительность и сокращать расходы, говорит Google. Cloud WAN обеспечивает два основных варианта использования: предоставление высокопроизводительного подключения между географически распределёнными ЦОД организаций, которым необходимо надёжно и экономически эффективно передавать значительные объёмы данных, и подключение филиалов и кампусов через сеть Premium Tier. В первом случае Cloud WAN предлагает несколько сервисов. В рамках Cloud Interconnect предлагаются прямые соединения с низкой задержкой между облачными регионами и собственными ЦОД заказчика в 159 точках по всему миру. Cross-Cloud Interconnect обеспечивает связь облачных регионов Google Cloud Platform с регионами AWS, Microsoft Azure и Oracle Cloud Infrastructure в 21 точке по всему миру. Новая функция Cross-Site Interconnect, которая пока доступна только в некоторых странах в режиме превью, предлагает L2-соединения «точка-точка» между ЦОД заказчика на скорсти 10 Гбит/с или 100 Гбит/с. Така функциональность, по словам Google, нужна для государственных учреждений, операторов связи и предприятий, которым требуется прозрачное L2-подключение. Трафик идёт по каналам с резервированием, так что в случае сбоя какого-либо участка ВОЛС он будет автоматически направлен по другому физическому маршруту. Кроме того, в рамках NCC (Network Connectivity Center) доступна и L3-маршрутизация. Второй вариант использования Cloud WAN — сеть Premium Tier. Она ориентирована на защищённое подлючение филиалов к публичным облакам, ЦОД заказчика и публичному интернету с низкой задержкой. NCC действует как централизованный концентратор, работающий с Cloud VPN и решениями SD-WAN от сторонних поставщиков. NCC доступен в 20 странах мира. В данном случае присоединение к Cloud WAN происходит в географически ближайшей точке доступа. В 2025 году в некоторых регионах Lumen предложит выделенное оптическое подключение («последнюю милю») к Cloud WAN. Lumen также строит выделенные ВОЛС для AWS, Meta✴ и Microsoft.

19.03.2025 [11:25], Руслан Авдеев

Nokia обновит сети в дата-центрах HetznerФинская Nokia заключила соглашение с европейским хостинг-провайдером Hetzner для обновления сетей в ЦОД компании и её ключевой сетевой инфраструктуры в целом. Это последнее из партнёрств, анонсированных Nokia в последние месяцы и связанных с дата-центрами, сообщает пресс-служба Nokia. По данным Nokia, апгрейд обеспечит Hetzner возможность эффективно масштабировать проекты, совершенствовать автоматизацию и поддерживать наиболее передовое в индустрии время безотказной работы. Как сообщает Datacenter Dynamics, основанная в 1997 году немецкая Hetzner управляет ЦОД в Нюрнберге (Nuremberg) и Фалькенштайне (Falkenstein) в Германии, а также Хельсинки (Helsinki) в Финляндии. Также у неё есть площадки в Сингапуре и США. Внедрение новых решений Nokia уже началось в Германии и Финляндии, на очереди — расширение на другие европейские рынки для удовлетворения растущего спроса на цифровую инфраструктуру. Nokia поставит Hetzner энергоэффективные маршрутизаторы, решения для автоматизации и сбора телеметрии. В частности, будут развёрнуты маршрутизаторы 7750 SR-1x. В Nokia отмечают, что Hetzner сможет 100G-трансиверы, работающие на одной длине волны, но в целом новая архитектура рассчитана на апгрейд до 400G и 800G. Ещё в прошлом году Nokia начала активно заниматься проектами для дата-центров, а в прошлом месяце назначила бывшего топ-менеджера Intel Джастина Хоттарда (Justin Hottard), занимавшегося ЦОД-направлением, своим генеральным директором — он сменил на этом посту Пекку Лундмарка (Pekka Lundmark). До этого Лундмарк заявлял, что Nokia видит «значительную возможность» расширения своего присутствия на рынке дата-центров. После его комментариев Nokia расширила существующее соглашение о снабжении облака Microsoft Azure маршрутизаторами и коммутаторами. В сентябре Nokia также анонсировала запуск платформы автоматизации работы ЦОД, которую в компании называют «событийно-ориентированной автоматизацией» ( Event-Driven Automation, EDA). В ходе MWC 2025 представитель Nokia заявил, что ИИ стал «единственным за поколение» катализатором бума дата-центров.

17.03.2025 [10:00], Алексей Степин

YADRO представила российский 100GbE-коммутатор Kornfeld D2132Сетевая инфраструктура — важнейшая, неотъемлемая часть современного IT-ландшафта, одним из ключевых компонентов которой являются коммутаторы. Вместе с ростом скоростей и объёмов передаваемых данных растут и требования к этим устройствам, поэтому компания YADRO, российский разработчик и производитель ИКТ-решений, представила новый 100GbE-коммутатор Kornfeld D2132, который вместе с анонсированным ранее Kornfeld D1156 позволяет эффективно реализовать двухуровневые сети Spine-Leaf на отечественном оборудовании. В основе 1U-коммутатора Kornfeld D2132 лежит ASIC с пропускной способностью 6,4 Тбит/с, обслуживающий 32 QSFP28-порта 25/40/100GbE. Это позволяет использовать новинку как для организации уровня агрегации, так и для подключения конечных устройств. Объём буфера составляет 32 Мбайт. Коммутатор поддерживает ключевые сетевые протоколы, включая OSPF, BGP, ECMP, VRRP и MCLAG, а также интерфейсы управления SSH, SNMP и REST API. Kornfeld D2132 имеет надёжную систему охлаждения с резервированием по схеме 5+1 с горячей заменой вентиляторов и возможностью выбора направления воздушного потока. Это позволяет использовать Kornfeld D2132 практически в любых ЦОД с различной конфигурацией стоек и организацией «холодного» и «горячего» рядов.  Оба устройства серии Kornfeld, D1156 и D2132, ориентированы на высоконагруженную сетевую инфраструктуру дата-центров, вычислительных кластеров и корпоративных. Полностью разработанная YADRO аппаратная и программная архитектура гарантирует высокий уровень контроля, безопасности и гибкости. Модель Kornfeld D2132 уже прошла успешное тестирование в сетевой инфраструктуре заказчиков. В январе текущего года новинка была включена в реестр телекоммуникационного оборудования с российским происхождением (ТОРП). |

|