Материалы по тегу: jbof

|

23.07.2025 [09:37], Владимир Мироненко

SSD не нужны: OFP обещает на порядок повысить плотность All-Flash СХД и наполовину снизить расходы на инфраструктуруИнициатива Open Flash Platform (OFP) призвана полностью пересмотреть работу с флеш-памятью в ИИ ЦОД. Участники OFP — Hammerspace, Linux Foundation, Лос-Аламосская национальная лаборатория (LANL), ScaleFlux, SK hynix и Xsight Systems — намерены отказаться от традиционных All-Flash хранилищ и контроллеров. Вместо них предложено использовать флеш-картриджи с минимумом аппаратной начинки, а доступ к таким массивам предоставлять посредством DPU и pNFS. Как отмечено в пресс-релизе, OFP отвечает многим фундаментальным требованиям, возникающим в связи со следующим этапом развития СХД для ИИ. Для ИИ требуются поистине огромные массивы данных, но вместе с тем ЦОД сталкиваются с дефицитом энергии, повышением температуры и недостатком свободного места. Именно поэтому в OFP решили, что инфраструктуры хранения для ИИ лучше разработать с чистого листа. Если 10 лет назад технология NVMe вывела флеш-память на новый уровень производительности благодаря отказу от устаревших шин данных и контроллеров, то теперь OFP обещает раскрыть возможности флеш-памяти, исключив посредников в виде серверов хранения и проприетарных программных стеков. OFP же опирается на открытые стандарты и open source решения, в частности, Parallel NFS (pNFS) и стандартный Linux, для размещения флеш-памяти непосредственно в SAN. А отказ от традиционных СХД обеспечит на порядок большую плотность размещения данных, существенную экономию энергии и значительно более низкую совокупную стоимость владения. OFP отметила, что существующие решения изначально привязаны к модели сервера хранения, которая требует чрезмерных ресурсов для повышения производительности и возможностей. Конструкции всех современных поставщиков AFA не оптимизированы для достижения максимальной плотности размещения флеш-памяти и привязаны к сроку службы CPU (обычно пять лет), тогда как срок службы флеш-памяти в среднем составляет восемь лет. Эти серверы хранения также предлагают проприетарные структуры и уровни хранения данных, что приводит к увеличению количества копий данных и добавлению расходов на лицензирование для каждого узла. Комментируя инициативу, ресурс Blocks & Files отметил, что Pure Storage и другие поставщики AFA уже предлагают оптимизированные схемы лицензирования и подписки, в том числе с обновлением контроллеров и дисковых полок. Та же Pure Storage предлагает более высокую плотность хранения, чем многие другие поставщики, хотя и использует проприетарные решения. Поддержкой DPU тоже удивить нельзя. Например, VAST Data уже поддерживает работу своего ПО на NVIDIA BlueField-3. А большинство поставщиков флеш-массивов и так поддерживают RDMA и GPUDirect. OFP выступает за открытый, основанный на стандартах подход, включающий несколько основных элементов:

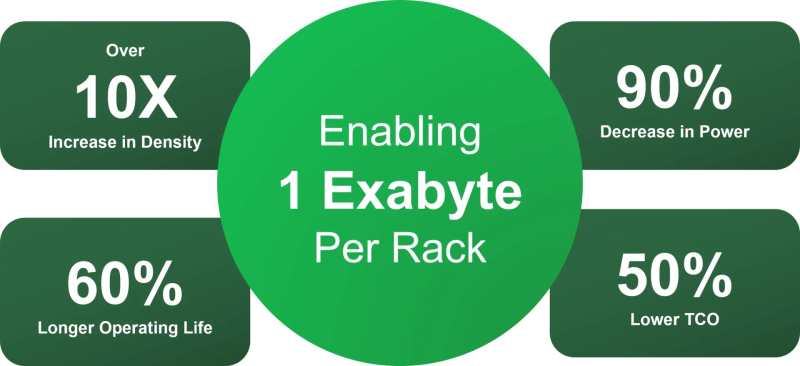

Благодаря использованию открытых архитектур и компонентов, соответствующих отраслевым стандартам, реализация OFP приведёт к значительному повышению эффективности хранения данных, утверждают основатели инициативы. Так, обещано десятикратное увеличение плотности размещения данных, что позволит «упаковать» в одну стойку 1 Эбайт, попутно снизив энергопотребление на 90 %, увеличив срок службы флеш-памяти на 60 % и уменьшив совокупную стоимость владения (TCO) на 60 % по сравнению со стандартными массивами хранения. По мнению Blocks & Files, в текущем виде OFP выглядит скорее как маркетинговая инициатива, от которой в первую очеред выиграют её участники. Концепция же «сетевых» SSD сама по себе не нова. Весной Kioxia показала SSD с «оптикой». Да, тут речь идёт скорее о блочном доступе и NVMe-oF, но, например, Nimbus Data в прошлом году представила ExaDrive EN с поддержкой NFS.

24.11.2024 [09:54], Сергей Карасёв

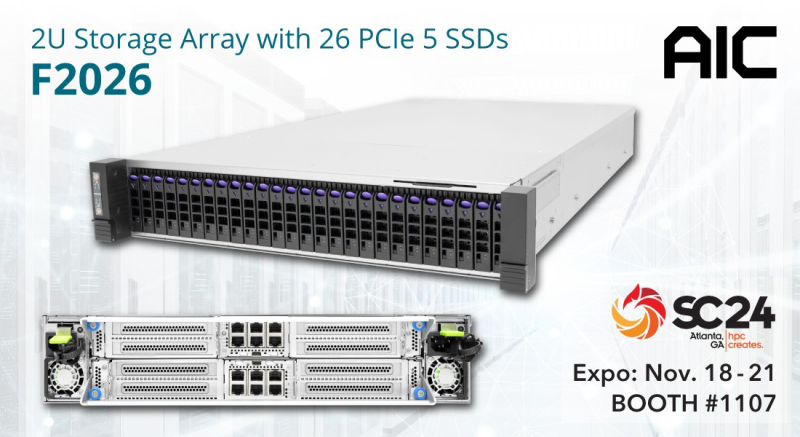

AIC и ScaleFlux представили JBOF-массив на основе NVIDIA BlueField-3Компании AIC и ScaleFlux анонсировали систему F2026 Inference AI для ресурсоёмких приложений ИИ с интенсивным использованием данных. Решение выполнено в форм-факторе 2U. В оснащение входят два DPU NVIDIA BlueField-3, которые могут работать на скорости до 400 Гбит/с. Эти изделия способны ускорять различные сетевые функции, а также операции, связанные с передачей и обработкой больших массивов информации. Во фронтальной части F2026 Inference AI расположены 26 отсеков для высокопроизводительных вычислительных SSD семейства ScaleFlux CSD5000 (U.2). Накопители с интерфейсом PCIe 5.0 (NVMe 2.0b) имеют вместимость 3,84, 7,68, 15,36, 30,72, 61,44 и 122,88 Тбайт, а с учётом компрессии эффективная ёмкость может достигать приблизительно 256 Тбайт. Реализована поддержка TCG Opal 2.02 и шифрования AES-256, NVMe Thin Provisioned Namespaces Virtualization (48PF/32VF), ZNS, FDP. Платформа F2026 Inference AI представляет собой JBOF-массив, способный на сегодняшний день хранить 1,6 Пбайт информации (эффективный объём). В следующем году показатель будет доведён до 6,6 Пбайт. Утверждается, что сочетание BlueField-3 и энергоэффективной технологии хранения ScaleFlux помогает минимизировать энергопотребление, а также повысить долговечность и надёжность. Результаты проведённого тестирования F2026 Inference AI демонстрируют пропускную способность при чтении до 59,49 Гбайт/с, при записи — более 74,52 Гбайт/с. Благодаря объединению средств хранения, сетевых функций и инструментов безопасности в одну систему достигается снижение эксплуатационных расходов, что позволяет оптимизировать совокупную стоимость владения (TCO). Новинка является лишь одной из вариаций решений на базе F2026. Платформа, в частности, поддерживает работу других DPU, включая Kalray 200 и Chelsio T7. Также упоминается вариант шасси на 32 накопителя EDSFF E3.S/E3.L.

22.10.2024 [11:01], Сергей Карасёв

Supermicro представила All-Flash JBOF-массивы на базе NVIDIA BlueField-3 DPUКомпания Supermicro анонсировала высокопроизводительные системы хранения Storage SuperServer типа JBOF All-Flash, оптимизированные для HPC-задач, обучения ИИ-моделей и инференса. Устройства, рассчитанные на монтаж в стойку, выполнены в форм-факторе 2U. Новинки построены на основе DPU NVIDIA BlueField-3. Эти изделия содержат 16 ядер Cortex-A78, поддерживают интерфейс PCIe 5.0 и обеспечивают скорость в 400 Гбит/с. Системы Supermicro JBOF могут использовать до четырёх ускорителей BlueField-3. В число представленных устройств вошли модели SSG-229J-5BU24JBF и SSG-229J-5BE36JBF. Первая рассчитана на 24 накопителя SFF U.2 NVMe, вторая — на 36 накопителей E3.S. Отсеки для SSD расположены во фронтальной части; допускается горячая замена. В обоих случаях имеются два коннектора M.2 для SSD формата 2280/22110 с интерфейсом PCIe 5.0 x4. Предусмотрены три слота для карт PCIe 5.0 x16 FHFL.

Источник изображения: Supermicro Системы оснащены двумя портами 1GbE и дополнительным портом 1GbE на основе контроллера Realtek. Габариты составляют 762 × 449,4 × 88 мм. Питание обеспечивают два блока с сертификатом 80 Plus Titanium мощностью 1600 Вт у SSG-229J-5BU24JBF и 2000 Вт у SSG-229J-5BE36JBF. Установлены шесть вентиляторов охлаждения диаметром 60 мм. Диапазон рабочих температур — от +10 до +35 °C. Supermicro отмечает, что при использовании SSD вместимостью 30,71 Тбайт можно сформировать хранилище суммарной ёмкостью 1,1 Пбайт. Архитектура контроллеров «активный — активный» гарантирует высокую доступность.

11.08.2024 [22:03], Сергей Карасёв

Western Digital представила NVMe-oF-платформу OpenFlex Data24 4000 вместимостью до 368 ТбайтКомпания Western Digital анонсировала платформу хранения данных OpenFlex Data24 4000 класса NVMe-oF JBOF с возможностью установки 24 NVMe SSD стандарта U.2. Например, могут применяться накопители Ultrastar DC SN655 вместимостью 15,36 Тбайт, что в сумме даст около 368 Тбайт ёмкости. Система выполнена в форм-факторе 2U с размерами 85,5 × 491,1 × 628,65 мм. Задействованы хост-адаптеры RapidFlex на основе фирменных ASIC A2000 с возможностью использования в общей сложности до 12 портов 100GbE. Говорится о поддержке TCP и RoCEv2. Производительность RoCEv2 достигает 27 млн операций ввода/вывода в секунду (IOPS) при произвольном чтении данных блоками по 4 Кбайт и 3 млн операций при произвольной записи. Скорость последовательного чтения и записи — до 135 и 92 Гбайт/с соответственно. В случае TCP показатель IOPS составляет до 21 млн при произвольном чтении и до 3 млн при произвольной записи. Скорость последовательного чтения и записи — до 113 и 86 Гбайт/с.

Источник изображения: Western Digital Устройство OpenFlex Data24 4000 несёт на борту чип BMC с ядром Arm; имеется выделенный порт 1GbE для удалённого мониторинга и управления. Диапазон рабочих температур — от +10 до +35 °C. Питание обеспечивают два блока мощностью 800 Вт с сертификатом Titanium. Производитель предоставляет пятилетнюю гарантию. |

|