Материалы по тегу: amd

|

22.02.2026 [00:24], Владимир Мироненко

AMD подстрахует Crusoe, продаст ей свои чипы и сама же арендует их, если что-то пойдёт не такСогласно данным ресурса The Information, AMD предоставит гарантию по кредиту в размере $300 млн неооблаку Crusoe для покупки и развёртывания своих ИИ-чипов. Благодаря этому стартап получит кредит под 6 %, что гораздо ниже, чем было бы без поддержки AMD. Кредит для Crusoe, организованный Goldman Sachs, будет обеспечен чипами AMD и соответствующим оборудованием. Сделка позволит Crusoe приобрести ИИ-чипы AMD, чтобы развернуть их в новом ЦОД в Огайо, строящемся канадским девелопером 5C, поддерживаемым Brookfield. По данным источников, AMD обязуется арендовать собственные чипы у Crusoe, если ей не удастся привлечь достаточное количество клиентов, особенно среди разработчиков ИИ. Генеральный директор Crusoe Чейз Лохмиллер (Chase Lochmiller) в прошлом году сообщил Reuters, что компания планирует приобрести чипы AMD на сумму $400 млн. Эта сделка подчеркивает усиление конкуренции среди производителей полупроводников за поддержку развития инфраструктуры, ориентированной на ИИ, отметил ресурс MarketScreener. В данном случае AMD придерживается стратегии лидера ИИ-рынка компании NVIDIA, готовой предоставить заимствования для покупки своей продукции, арендовать собственные чипы, выступить в качестве гаранта партнёра в сделках аренды ЦОД, а также гарантировать выкуп вычислительных мощностей партнёра в случае, если те останутся невостребованными. NVIDIA также является ключевым инвестором Crusoe. Компания участвовала в раунде финансирования серии D компании Crusoe на сумму $600 млн в конце 2024 года, а затем в раунде серии E на сумму $1,375 млрд в октябре 2025 года, что увеличило оценку Crusoe до более чем $10 млрд. Несмотря на циклический характер заключаемых NVIDIA сделок, что вызывает опасения экспертов в растущем пузыре на ИИ-рынке, инвесторы пока сохраняют оптимизм. Акции NVIDIA выросли за 2025 год более чем на 34 %, а акции AMD за тот же период — на 76 %, пишет MSN.

20.02.2026 [09:10], Руслан Авдеев

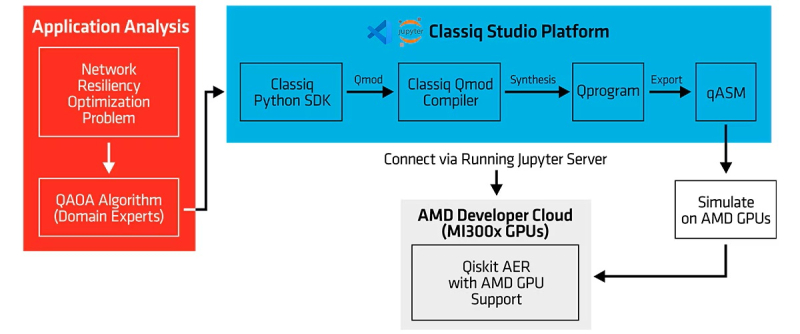

AMD, Classiq и Comcast «квантово» улучшили интернетРазработчик программного обеспечения для квантовых вычислений Classiq совместно с Comcast и AMD объявили о завершении испытаний, направленных на совершенствование доставки интернет-трафика путём использования квантовых алгоритмов для повышения надёжности маршрутизации в Сети, сообщает HPC Wire. Comcast заявила, что клиентам нужно быстрое, безопасное и надёжное подключение, но при управлении большой и динамичной сетью достижение этой цели становится сложной задачей, особенно в условиях растущего спроса. Поэтому в прошлом году были начаты эксперименты по выяснению того, как квантовое ПО и технологии могут решать реальные сетевые задачи. Результаты показали, что квантовые вычисления для оптимизации сети — не теория, а вполне практическое, масштабируемое решение. В ходе тестов решалась фундаментальная задача проектирования сети — определение независимых резервных маршрутов для сетевых узлов в общей конкурентной среде при проведении технического обслуживания и изменении топологии сети, причём с сохранением минимально возможной задержки, высокой устойчивостью к одновременным сбоям и высокой же пропускной способностью. Такая задача регулярно возникает на реальных сетях, где и без планового обслуживания не обойтись, и от одновременных сбоев никто застрахован.

Источник изображения: Dynamic Wang/unsplash.com В ходе эксперимента с использованием квантовых технологий и HPC-платформ AMD на базе ускорителей Instinct MI300X проверялась возможность квантовых алгоритмов успешно определять резервные пути для трафика в режиме реального времени в различных сценариях. Использовались как моделирование с использованием Instinct для достижения значимых вычислительных мощностей (кубитного уровня), что позволило быстро перебирать различные алгоритмы, так и реальный квантовый компьютер IonQ Forte с 29 алгоритмическими кубитами для проверки успешности реализации алгоритмов. Задача оптимизации глобальных телекоммуникационных сетей — крайне ресурсоёмкая комбинаторная задача, экспоненциально усложняющаяся по мере роста размера сети. Такая задача является идеальным вызовом для систем квантовых вычислений. По словам представителя Classiq, исследования и разработки в сфере квантовых технологий требуют быстрых итераций с внесением улучшений на каждом цикле и воспроизводимых рабочих процессов. AMD заявила, что будущее HPC — в конвергенции классических и квантовых вычислений.

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

16.02.2026 [16:15], Сергей Карасёв

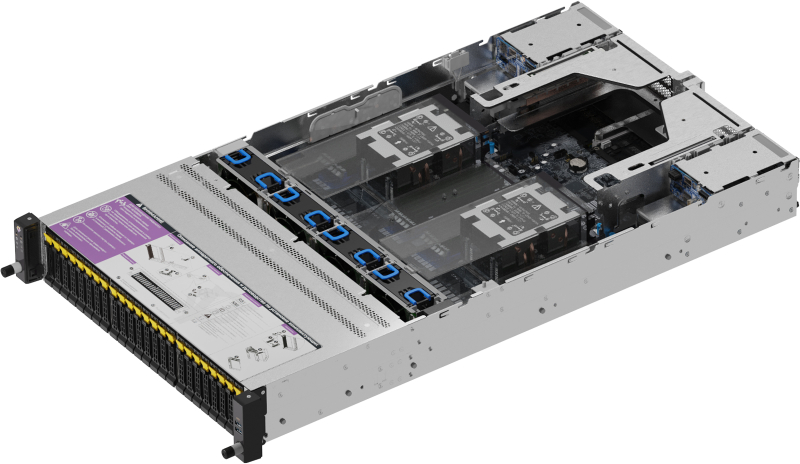

Oxide Computer готовит блейд-платформу на базе AMD EPYC TurinКомпания Oxide Computer, по сообщению The Register, провела раунд финансирования Series C, в ходе которого на дальнейшее развитие привлечено $200 млн. Стартап планирует направить средства в том числе на создание новой стоечной платформы на аппаратной платформе AMD EPYC 9005 Turin. Oxide Computer основана в 2019 году группой бывших инженеров Joyent и Sun Microsystems. Стартап занимается разработкой оборудования для дата-центров. При этом в качестве новой вычислительной единицы компания рассматривает целую стойку, а не отдельный сервер. Система Oxide Computer первого поколения несёт на борту 32 вычислительных модуля, оснащённых чипами AMD EPYC 7713P (Milan). Каждый модуль содержит 64 ядра CPU, до 1 Тбайт DDR4-3200 и 10 NMVe-накопителей U.2 суммарной вместимостью 32 Тбайт. Применённая объединительная плата обеспечивает питание и коммутационную способность до 12,8 Тбит/с. Общее энергопотребление стойки находится на уровне 15 кВт.

Источник изображения: Oxide Computer По словам генерального директора Oxide Computer Стива Така (Steve Tuck), компания проектирует обновлённую версию своей стоечной системы, в которую будут устанавливаться процессоры EPYC поколения Turin. Такие чипы насчитывают до 192 вычислительных ядер. Говорится об использовании памяти DDR5-6400. Вкупе это даст значительный прирост производительности по сравнению с оригинальной машиной. Важным преимуществом Turin является поддержка инструкций AVX-512, предназначенных для ускорения ресурсоёмких вычислений, таких как обработка больших массивов данных, задачи ИИ и пр. Какие именно модели процессоров будут задействованы в новых серверных модулях, Так уточнять не стал. Кроме того, Oxide Computer рассматривает возможность перехода на новые коммутационные решения, которые в перспективе придут на смену ныне применяющимся изделиям Intel Tofino 2. Одним из вариантов является чип-коммутатор Xsight Labs X2, обеспечивающий пропускную способность до 12,8 Тбит/с. При этом изучаются и другие альтернативы. Oxide Computer также не исключает, что в будущем начнёт оснащать свои системы ИИ-ускорителями на базе GPU.

09.02.2026 [14:20], Сергей Карасёв

OpenYard выпустила российский двухсокетный сервер RS202A на базе AMD EPYC TurinРоссийский разработчик и производитель корпоративного оборудования OpenYard объявил о начале серийного выпуска серверов RS202A на аппаратной платформе AMD. Устройства предназначены для построения масштабируемых и отказоустойчивых IT-инфраструктур, включая виртуальные среды, аналитические системы и хранилища данных. Серверы выполнены в форм-факторе 2U. Допускается установка двух процессоров AMD EPYC 9005 поколения Turin в исполнении LGA 6096 (SP5) с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 1GbE (Intel I350-AM2) и выделенный сетевой порт управления 1GbE. Во фронтальной части корпуса в зависимости от модификации располагаются 24 отсека для SFF-накопителей (SATA/SAS-4/NVMe PCIe 5.0) или 12 отсеков для LFF-изделий. В тыльной секции находятся четыре посадочных места для SFF-изделий с интерфейсом SATA/SAS-4. Во всех случаях допускается горячая замена. Кроме того, сеть два внутренних слота для SSD типоразмера M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и один слот M.2 2280/22110 PCIe 3.0 x2. Доступны до пяти разъёмов PCIe 5.0 x16 для карт расширения FHHL и до двух разъёмов OCP 3.0 PCIe 5.0 x16 с поддержкой NCSI. Габариты составляют 438 × 87,5 × 815 мм. Установлены два блока питания мощностью 2000 Вт с сертификатом 80 PLUS Platinum. Упомянуты два порта USB 3.2, коннектор Mini-DP и три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур — от +10 до +35 °C. Производство серверов RS202A осуществляется на собственной площадке OpenYard в Рязани. В настоящее время системы проходят пилотные внедрения в корпоративных IT-средах, а объёмы выпуска планируется масштабировать в зависимости от рыночного спроса, говорит компания.

09.02.2026 [13:17], Сергей Карасёв

«Ядерный» суперкомпьютер Teton производительностью 20,8 Пфлопс полагается только на AMD EPYC TurinНациональная лаборатория Айдахо (INL) в составе Министерства энергетики США (DOE) сообщила о запуске суперкомпьютера Teton. Система присоединилась к четырём другим НРС-комплексам лаборатории — Bitterroot, Hoodoo, Wind River и Sawtooth, увеличив доступные вычислительные ресурсы вчетверо. В основу Teton положена платформа HPE Cray EX 4000. Объединены 1024 вычислительных узла, каждый из которых содержит 384 ядра CPU и 768 Гбайт памяти. Задействованы процессоры AMD EPYC 9005 поколения Turin. Таким образом, в общей сложности используются около 393 тыс. CPU-ядер и 768 Тбайт памяти. Как отмечает INL, на сегодняшний день Teton — это один из самых мощных суперкомпьютеров в мире, архитектура которого базируется исключительно на CPU (без применения GPU и других специализированных компонентов). Такая конфигурация обусловлена спецификой использования системы: комплекс предназначен для сложных физических моделирований в рамках проектов по разработке передовых реакторов на быстрых нейтронах, малых модульных реакторов и микрореакторов. Утверждается, что традиционные CPU лучше подходят для подобных расчётов, нежели GPU.

Источник изображений: INL «Teton позволит исследователям моделировать ядерные технологии следующего поколения с беспрецедентной точностью, что значительно сократит время работ от создания концепции до внедрения критически важных проектов в области ядерной энергетики», — отмечает Бренден Хайдрих (Brenden Heidrich), руководитель научной программы Nuclear Science User Facilities (NSUF), реализуемой DOE.  В рамках NSUF исследователям в области ядерной энергетики предоставляется доступ к широкому спектру ресурсов INL и других учреждений. Новый суперкомпьютер поможет учёным моделировать сложную физику реакторов, поведение перспективных материалов и процессы топливного цикла.

05.02.2026 [11:35], Сергей Карасёв

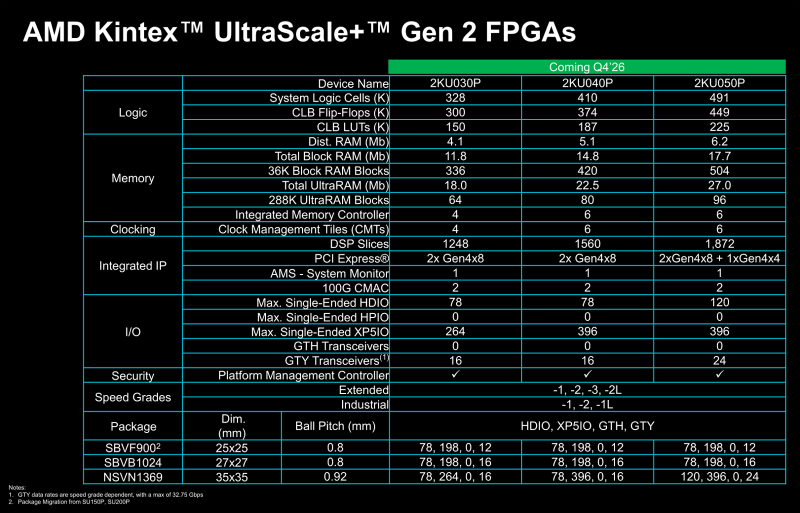

AMD представила FPGA серии Kintex UltraScale+ Gen 2 с поддержкой PCIe 4.0 и LPDDR5XКомпания AMD анонсировала FPGA серии Kintex UltraScale+ Gen 2, относящиеся к среднему классу. Эти изделия могут использоваться в разных сферах, включая здравоохранение (эндоскопия, машинное зрение, роботизированная хирургия), промышленный сектор (системы автоматизации и инспекции, периферийные платформы), вещание (видеозахват, производство материалов), среды тестирования и пр. Решения выполнены по 16-нм технологии FinFET. Реализована поддержка памяти LPDDR4X, LPDDR5 и LPDDR5X, интерфейса PCIe 4.0, а также двух блоков 100G CMAC. Упомянуты средства постквантовой криптографии в соответствии с алгоритмами, одобренными Национальным институтом стандартов и технологий США (NIST). В семейство Kintex UltraScale+ Gen 2 вошли три модели — 2KU030P, 2KU040P и 2KU050P. Первый из перечисленных чипов содержит 328 тыс. логических элементов, 150 тыс. CLB LUT (Configurable Logic Block Look-Up Table), четыре контроллера LPDDR4X/5/5X, а также в общей сложности 33,9 Мбайт памяти. Конфигурация включает два интерфейса PCIe 4.0 x8. В свою очередь, решение 2KU040P насчитывает 410 тыс. логических элементов и 187 тыс. CLB LUT, имеет шесть контроллеров LPDDR4X/5/5X, 42,4 Мбайт памяти и два интерфейса PCIe 4.0 x8. Старший вариант, 2KU050P, получил 491 тыс. логических элементов, 225 тыс. CLB LUT, шесть контроллеров LPDDR4X/5/5X, 50,9 Мбайт памяти, два интерфейса PCIe 4.0 x8 и один интерфейс PCIe 4.0 x4. Первые инженерные образцы решений Kintex UltraScale+ Gen 2 начнут поступить заказчикам в IV квартале текущего года, тогда как серийное производство чипов должно начаться в I половине 2027-го. Компания AMD гарантирует доступность изделий как минимум до 2045 года, что должно сделать новые FPGA особенно привлекательными для отраслей с длительным жизненным циклом продукции, таких как аэрокосмическая и оборонная промышленность.

04.02.2026 [14:11], Владимир Мироненко

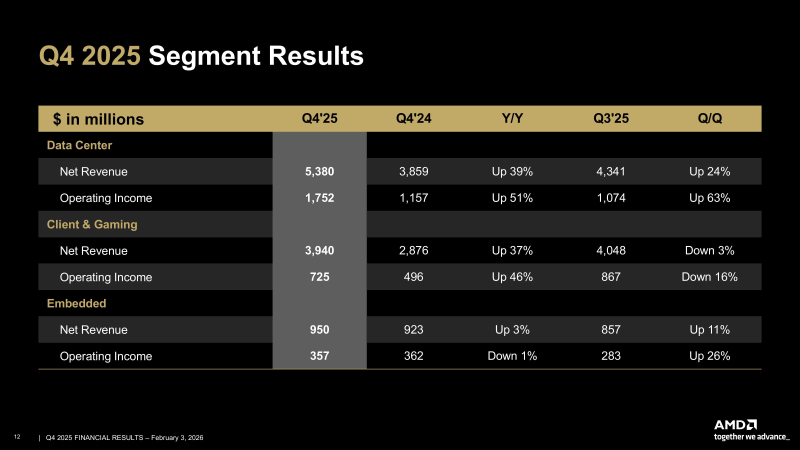

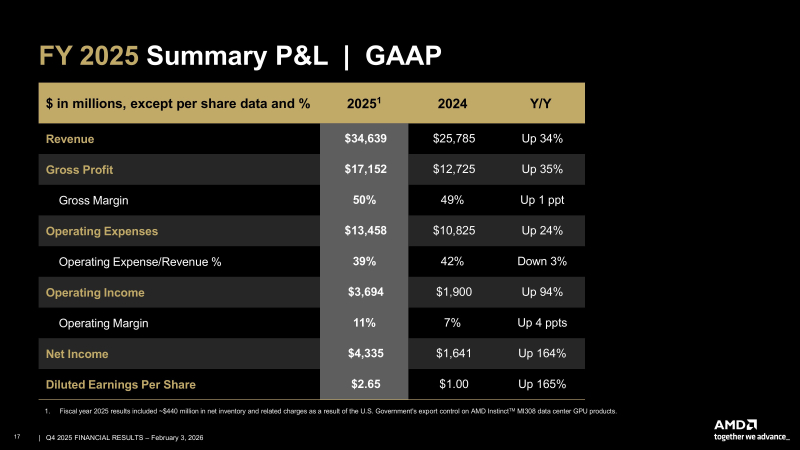

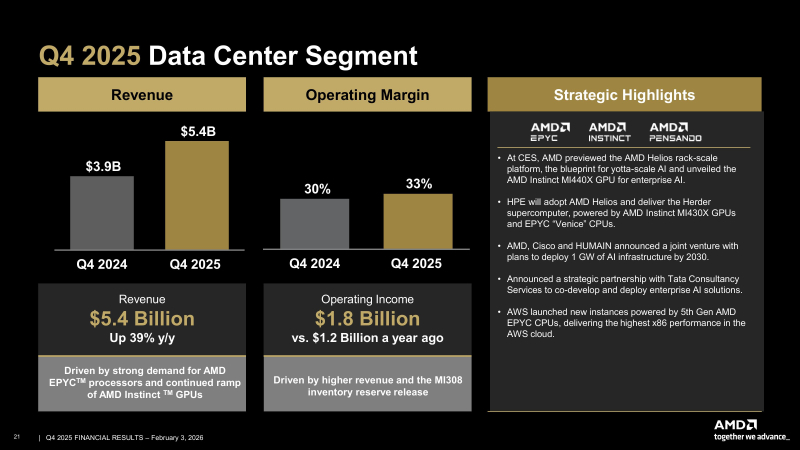

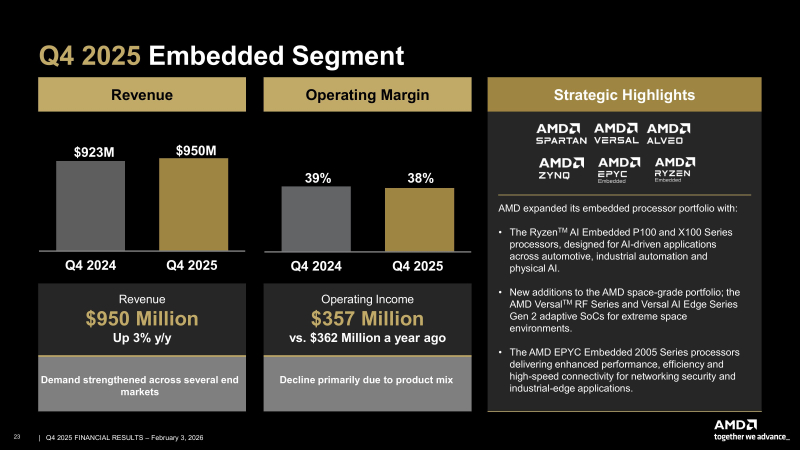

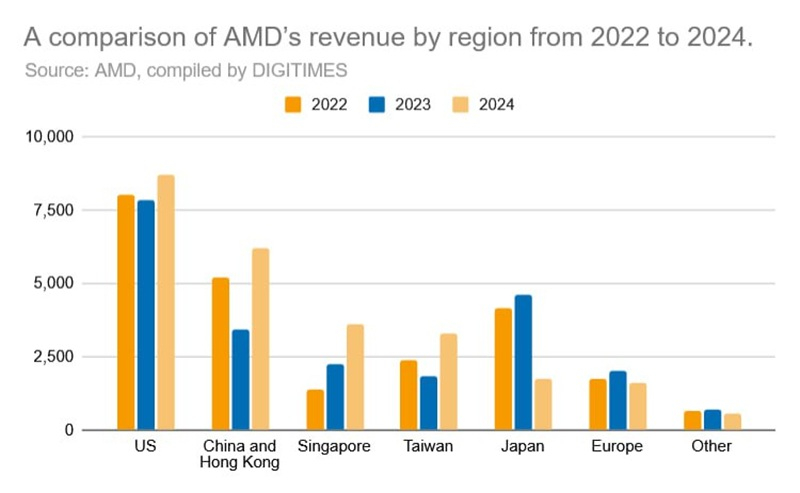

Акции AMD упали из-за слабого прогноза, даже несмотря на рекордные квартальные результатыAMD сообщила финансовые результаты IV квартала и всего 2025 финансового года, завершившегося 27 декабря 2025 года. Объявленные показатели превысили ожидания Уолл-стрит, но прогноз компании на I квартал 2026 финансового года не оправдал ожиданий некоторых аналитиков на фоне бума расходов на ИИ, что вызвало опасения по поводу её способности эффективно конкурировать с NVIDIA, в связи с чем акции упали во вторник на 8 % на внебиржевых торгах, отметил Reuters. Выручка AMD за IV квартал достигла рекордных $10,27 млрд, что больше результата аналогичного квартала годом ранее на 34 %, а также выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $9,67 млрд (по данным CNBC). Скорректированная прибыль (Non-GAAP) на разводнённую акцию составила $1,53, превысив на 40 % прошлогодний показатель и прогноз от LSEG в $1,32. Чистая прибыль (GAAP) AMD увеличилась за квартал в годовом исчислении на 213 % до $1,51 млрд, или $0,92 на разводнённую акцию, с $482 млн, или $0,29 на разводнённую акцию годом ранее. В I квартале AMD прогнозирует получить выручку в размере $9,8 млрд ± $300 млн, против ожиданий в $9,38 млрд. Прогноз включает $100 млн выручки от продаж в Китай ускорителей AMD Instinct MI308. Однако некоторые аналитики ожидали, что AMD представит более оптимистичный прогноз, а не снижение выручки, поскольку клиенты продолжают наращивать расходы на чипы, необходимые для работы ИИ-моделей. Тем более, что администрация Трампа одобрила лицензию на заказы, которые AMD получила в начале 2025 года от китайских компаний. Выручка от продаж MI308 в Китай в IV квартале составила около $390 млн. AMD сообщила о рекордной выручке за весь 2025 год в размере $34,64 млрд (рост 34 %), валовой марже в 50 % (рост 1 п.п.), операционной прибыли в $3,69 млрд (рост 94 %), чистой прибыли в $4,34 млрд (рост — 164 %) и прибыли на разводнённую акцию в $2,65 (рост — 165 %). «2025 год стал определяющим для AMD, с рекордными показателями выручки и прибыли, обусловленными эффективной реализацией проектов и широким спросом на наши высокопроизводительные платформы и платформы искусственного интеллекта», — отметила Лиза Су (Lisa Su), председатель совета директоров и генеральный директор AMD. Подразделение ЦОД AMD, которое поставляет CPU и ИИ-ускорители, принесло рекордную выручку в $5,38 млрд (рост — 39 %), что выше прогноза аналитиков в $4,97 млрд (по данным finance.yahoo.com) благодаря высокому спросу на процессоры AMD EPYC и продолжающемуся наращиванию поставок ускорителей AMD Instinct. Операционная прибыль подразделения составила $1,75 млрд, что значительно выше показателя годом ранее в размере $1,07 млрд. За весь 2025 год выручка сегмента ЦОД достигла рекордных $16,6 млрд, что на 32 % больше, чем годом ранее. Су отметила, что бум ИИ стимулирует также продажи CPU компании, а не только GPU. «Спрос на серверные процессоры остается очень высоким, — сказала Су. — Крупные компании расширяют свою инфраструктуру, чтобы удовлетворить растущий спрос на облачные сервисы в области ИИ, в то время как крупные предприятия модернизируют свои ЦОД, чтобы обеспечить наличие необходимых вычислительных мощностей для реализации новых рабочих ИИ-процессов». Сегмент клиентских и игровых решений AMD вырос на 37 % в годовом исчислении до $3,94 млрд с $2,88 млрд годом ранее. За весь 2025 год выручка сегмента достигла рекордных $14,6 млрд, увеличившись на 51 %. Сегмент встраиваемых систем увеличился на 3 % в годовом исчислении до $950 млн. Операционная прибыль осталась почти на том же уровне — $357 млн против $362 млн годом ранее. За весь 2025 год выручка сегмента встраиваемых систем составила $3,5 млрд (падение на 3 %), что, как утверждает компания, отражает влияние корректировок уровня запасов у клиентов, произведенных ранее в этом году. AMD ускорила запуск своих продуктов и переходит к продаже полноценных ИИ-систем Helios, чтобы лучше конкурировать с NVIDIA, которая предлагает стоечные системы, объединяющие GPU, CPU и сетевое оборудование. Компания ожидает, что к 2027 году ежегодный рост продаж подразделения ЦОД превысит 60 %. Это принесёт компании десятки миллиардов долларов. Су сообщила, что компания ожидает быстрого роста продаж нового флагманского ИИ-сервера компании OpenAI и другим компаниям во II половине этого года, отметив, что глобальный дефицит микросхем памяти не замедлит её планы. «Я не думаю, что мы столкнёмся с ограничениями поставок в плане наращивания объёмов производства», — заявила гендиректор AMD.

02.02.2026 [11:02], Сергей Карасёв

Giga Computing выпустила вычислительные узлы TO25-ZU4 и TO25-ZU5 на базе AMD EPYC TurinКомпания Giga Computing, подразделение Gigabyte, анонсировала серверные узлы TO25-ZU4 и TO25-ZU5 стандарта OCP ORV3, ориентированные на гиперскейлеров и облачных провайдеров. Решения формата 2OU (двухузловая конфигурация) выполнены на аппаратной платформе AMD. Устройства получили системную плату MZU3-MG0. Допускается установка одного процессора EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт (до 192 вычислительных ядер). Доступны 12 слотов для модулей оперативной памяти DDR5-6400/4800. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 10GbE (Intel X710-AT2) и выделенный сетевой порт управления 1GbE. Модель TO25-ZU4 поддерживает два накопителя типоразмера E1.S (PCIe 5.0; NVMe) толщиной 9,5 мм и четыре SFF-накопителя (NVMe/SATA/SAS-4). Кроме того, есть по два слота для карт FHFL (PCIe 5.0 x16) и OCP NIC 3.0 (PCIe 5.0 x16). В свою очередь, модификация TO25-ZU5 оборудована посадочными местами для двух накопителей E1.S (PCIe 5.0; NVMe) и восьми изделий SFF (NVMe/SATA/SAS-4). При этом доступны два разъёма PCIe 5.0 x16 для низкопрофильных карт расширения.

Источник изображений: Giga Computing Во фронтальной части обоих узлов расположены интерфейсы USB 3.0 Type-C, Micro-USB и Mini-DP, а также три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур простирается от +10 до +30 °C. За безопасность отвечает опциональный модуль TPM 2.0. При необходимости может быть также добавлен RAID-адаптер. Габариты решений составляют 258 × 86 × 771 мм.

27.01.2026 [17:10], Владимир Мироненко

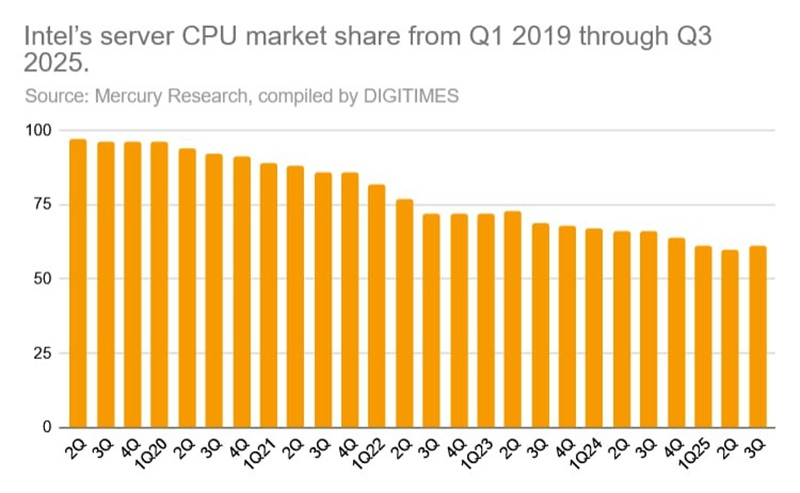

Дисциплина и чиплеты: Лиза Су раскрыла секрет успеха AMD на рынке серверных процессоровС момента внедрения архитектуры Zen в 2017 году компания AMD совершила впечатляющий рывок на рынке CPU, бросив вызов своему давнему конкуренту Intel, сообщила генеральный директор AMD Лиза Су (Lisa Su) в интервью в подкасте A Bit Personal, передаёт DigiTimes. Су подчеркнула трансформацию компании, отметив, что бизнес AMD в сфере решений для ЦОД, находившийся «на грани краха», теперь оказывает конкуренцию Intel на рынке серверных процессоров. Доля рынка AMD EPYC неуклонно растёт, увеличившись с 1 % до примерно 40 % на текущий момент. Слова Су подтверждаются данными Mercury Research, согласно которым за последние семь лет доля Intel на рынках процессоров для клиентских и серверных компьютеров снизилась, достигнув исторически низких показателей, в то время как рыночная доля AMD стабильно росла каждый квартал. Это значительно затруднило Intel поддержание общего доминирования, даже несмотря на сохранение лидерства в абсолютном выражении. По состоянию на III квартал 2025 года, по поставкам серверных процессоров Intel занимала 72 % рынка, но по выручке — всего 61 %, что значительно меньше по сравнению с долей рынка в 97 % в 2019 году. Когда Лиза Су возглавила AMD в 2014 году, отраслевые наблюдатели сомневались в том, что бывшему руководителю подразделения полупроводников IBM удастся вывести компанию из кризиса в условиях острой конкуренции. Однако Су рассматривала эту должность как личную и профессиональную веху — возможность для полной самореализации в полупроводниковой индустрии. Под руководством Су компания AMD совершила практически безупречный разворот, стратегически позиционируя себя для эры генеративного ИИ, отметил ресурс DigiTimes.

Источник изображения: DigiTimes В то время как NVIDIA остаётся главным игроком в сфере ИИ, AMD извлекла выгоду из экспоненциального роста на мировом ИИ-рынке, подкреплённого тесным сотрудничеством с TSMC. Сама Су была избрана в конце 2025 года председателем совета директоров Ассоциации полупроводниковой промышленности (SIA), что отражает признание её авторитета и растущее влияние в отрасли. Су объяснила успех AMD тремя ключевыми стратегическими решениями, поддержанными техническим директором Марком Пейпермастером (Mark Papermaster), который присоединился к компании тремя месяцами ранее. Первое касалось демонтажа существующей линейки продуктов для ЦОД. По словам Су, одним из самых сложных моментов в начале её работы было признать то, что планы AMD по развитию серверного сегмента больше не конкурентоспособны. Продолжение движения по этому пути только ускорило бы потерю компанией доли рынка. В конечном итоге было решено начать всё с «чистого листа». Вторым поворотным моментом стал смелый технологический сдвиг, отметила Су. Её команда отказалась от традиционного подхода к созданию всё более крупных монолитных процессоров в пользу чиплетной архитектуры в сочетании с передовой упаковкой. Это новаторское на тот момент решение несло значительный риск, когда парадигма проектирования Intel доминировала на рынке. Оглядываясь назад, можно сказать, что эта ставка AMD оправдалась. Intel в конечном итоге последовала её примеру, внедрив чиплетную архитектуру и передав часть производства на аутсорсинг TSMC, что позволило ей решить проблемы с выходом годных изделий.

Источник изображения: DigiTimes Третье стратегически важное решение касалось выбора партнёра по производству микросхем. Вместо GlobalFoundries, которая в конечном итоге отказалась от планов по использованию техпроцессов тоньше 7 нм, AMD обратилась к TSMC, хотя у неё в 2017–2019 гг. был ограниченный опыт работы с высокопроизводительными x86-процессорами, несмотря на лидерство в передовых технологических процессах. Тем не менее, использование передовых техпроцессов TSMC сыграло решающую роль, и AMD стала одним из ведущих клиентов компании. По мере роста спроса на чипы для ИИ-технологий ожидается дальнейшее увеличение объёмов производства AMD. Как отметила Су, эти решения демонстрируют сочетание стратегического видения, технической смелости и дисциплины в реализации выбранного пути, которые позволили AMD выйти из почти полной безвестности и стать одним из ключевых игроков на мировом рынке полупроводников и ИИ. |

|