Материалы по тегу: hardware

|

03.03.2026 [16:05], Руслан Авдеев

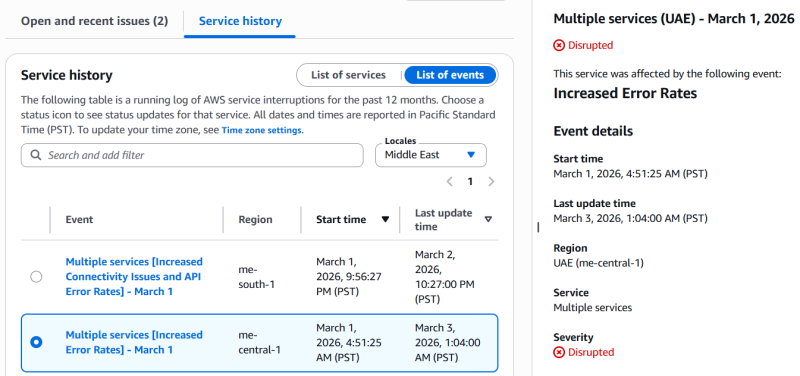

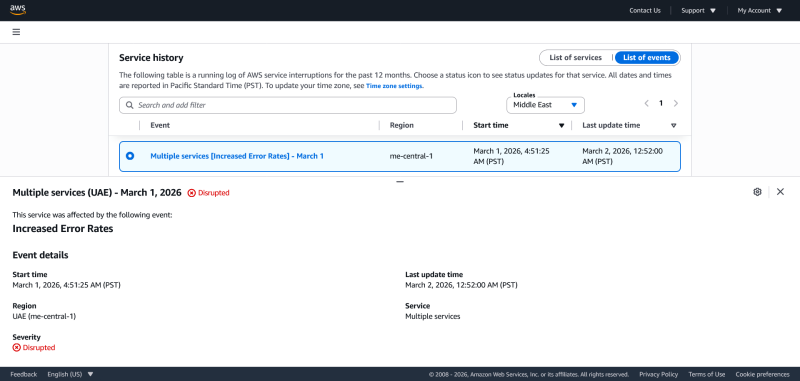

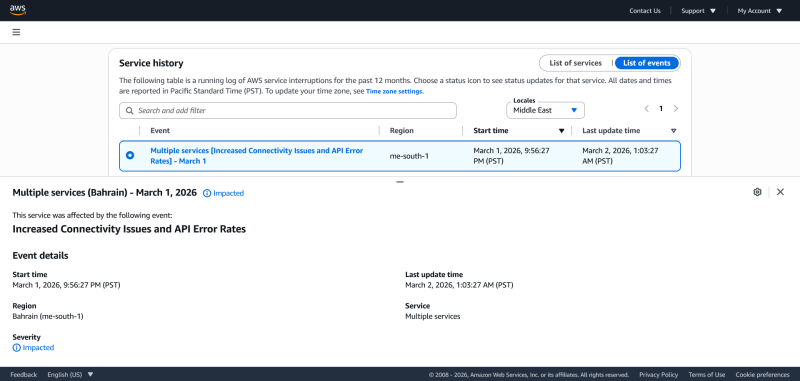

Иранские дроны повредили два дата-центра Amazon в ОАЭ и «зацепили» ещё один в БахрейнеВ результате ударов беспилотников на Ближнем Востоке пострадали три дата-центра Amazon. Компания отказалась от корпоративных эвфемизмов о попадании неких «объектов», которые вызвали «искрение и возгорание», и прямо заявила, что дроны попали в два ЦОД в ОАЭ, обслуживающие зоны доступности mec1-az2 и mec1-az3 региона ME-CENTRAL-1. Третий ЦОД в Бахрейне (mes1-az2 в ME-SOUTH-1) пострадал от удара в «непосредственной близости» от него. Хотя прямо Amazon об этом не говорит, очевидно, что беспилотники были иранские. Как заявила AWS, удары нанесли «структурный урон», нарушили подачу электроэнергии объектам компании, а в некоторых случаях потребовалось тушение пожаров, что причинило дополнительный ущерб, на этот раз от воды. По словам компании, организовано тесное сотрудничество с местными властями, а первостепенное внимание уделяется безопасности персонала. Зоны mec1-az2 и mec1-az3 региона ME-CENTRAL-1 по-прежнему работают с перебоями, третья зона — mec1-az1 продолжает функционировать в обычном режиме, хотя затронуты некоторые сервисы az1, зависевшие и от работы других зон. В регионе ME-SOUTH-1, расположенном в Бахрейне, пострадал один объект. Впрочем, как в Бахрейне, так и в ОАЭ клиенты продолжают сталкиваться ошибками и проблемами доступности ряда сервисов. В компании предполагают, что инфраструктуру ожидает длительный процесс восстановления с учётом «характера причинённого физического ущерба». С учётом ситуации на Ближнем Востоке AWS рекомендует клиентам создавать резервные копии информации и оценить, насколько возможен перенос рабочих нагрузок в другие облачные регионы Amazon.

03.03.2026 [14:27], Руслан Авдеев

Сделано в США: Flex начала выпуск американских ИИ-серверов с AMD InstinctАмериканская производственная компания Flex, поставляющая решения для дата-центров, анонсировала расширение стратегического сотрудничества с AMD для выпуска решений на платформе Instinct. По словам Flex, это важная веха на пути укрепления локального производства на территории США, в том числе передовых ИИ- и HPC-продуктов. В рамках партнёрства выпуск платформы AMD Instinct MI355X организован на территории головного подразделения Flex в Остине (Техас). В следующем квартале объёмы выпуска должны увеличиться. Речь идёт не только о платформе текущего поколения, компания намерена поддержать выпуск и новых платформ Instinct для удовлетворения спроса со стороны крупномасштабных ИИ-проектов. Сейчас Flex выпускает высокоплотные системы с восемью ускорителями и сопутствующей обвязкой. Каждая платформа, как утверждают в компании, проходит строгие заводские испытания и оценку. Системы оснащаются СЖО JetCool, принадлежащей Flex. По данным производителя, комбинация передовых индустриальных мощностей Flex, надёжной цепочки поставок и производственных мощностей в США с передовыми позициями AMD в HPC-сегменте позволяет клиентам масштабировать свои ИИ-проекты быстрее и с повышенной надёжностью. Головная структура Flex в Техасе занимает площадь более 130 тыс. м2 и создана для поддержки комплексного производства в больших объёмах. Всего у Flex в США есть более 650 тыс. м2 площадей на 17 объектах.

Источник изображения: Flex Планы AMD по локализации производства включают и выпуск чипов на американских фабриках TSMC. NVIDIA идёт по тому же пути, но в части выпуска или хотя бы сборки серверов на территории США, в том числе для обслуживания гиперскейлеров, у неё гораздо больше возможностей. Но и AMD укрепила свои позиции в этой области в результате сделки с ZT Systems и Sanmina. США всеми силами стремятся локализовать производство и разработки на своей территории. В декабре 2025 года было объявлено о заключении партнёрских отношений с 24 ведущими IT-компаниями в рамках «Миссии Генезис», призванной стимулировать ИИ-разработки и производство на американской территории. Например, в конце января 2026 года сообщалось, что Corning построит крупнейшее в мире производство оптоволоконного кабеля для ЦОД в рамках сделки с Meta✴ на $6 млрд.

03.03.2026 [14:10], Сергей Карасёв

Gigabyte представила ИИ-сервер G893-ZX1-AAX4 на базе AMD Instinct MI355XGigabyte Technology анонсировала сервер G893-ZX1-AAX4, предназначенный для выполнения ресурсоёмких задач, таких как ИИ-инференс, сложное моделирование и пр. Новинка построена на аппаратной платформе AMD. Устройство типоразмера 8U рассчитано на два процессора EPYC 9005 Turin или EPYC 9004 Genoa в исполнении Socket SP5 (LGA 6096) с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-4800/6400. Во фронтальной части расположены восемь отсеков для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe). Кроме того, есть два внутренних коннектора для SSD формата M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и PCIe 3.0 x1. Реализованы восемь разъёмов PCIe 5.0 x16 для однослотовых карт расширения FHHL и четыре разъёма PCIe 5.0 x16 для двухслотовых карт FHHL. В оснащение входят восемь ускорителей AMD Instinct MI355X OAM. Применяется полностью воздушное охлаждение с 15 вентиляторами диаметром 80 мм в области GPU-лотка, шестью кулерами на 60 мм в зоне материнской платы и четырьмя вентиляторами диаметром 80 мм в секции PCIe. Питание обеспечивают 12 блоков мощностью 3000 Вт каждый с сертификатом 80 PLUS Titanium.

Источник изображения: Gigabyte Technology Сервер оборудован контроллером ASPEED AST2600, двумя сетевыми портами 10GbE на базе Intel X710-AT2 (RJ45), выделенным сетевым портом управления 1GbE (RJ45), двумя портами USB 3.2 Gen1 (5 Гбит/с), аналоговым разъёмом D-Sub. Диапазон рабочих температур — от +10 до +30 °C. Габариты составляют 447 × 351 × 923 мм.

03.03.2026 [11:00], Руслан Авдеев

Саудовский «город будущего» Неом заключил сделку с DataVolt о строительстве ЦОД гиперскейл-уровня за $5 млрдСтроящийся на северо-западе Саудовской Аравии «город будущего» Неом (Neom) заключил соглашение с саудовской DataVolt в рамках общей стратегии развития плавучего района Oxagon по созданию ИИ-экосистемы с питанием от исключительно возобновляемых источников энергии. Стоимость проекта составляет $5 млрд, сообщает Computer Weekly. Как сообщает Forbes, национальные средства направляются на реализацию инициативы Project Transcendence стоимостью $100 млрд, предусматривающей строительство суверенной ИИ-инфраструктуры. DataVolt обязалась потратить $5 млрд на строительство кампуса ЦОД мощностью 1,5 ГВт. Как заявил представитель Oxagon, соглашение с DataVolt закладывает основу для использования первых в Саудовской Аравии «зелёных» мощностей для ИИ-систем. Кроме того, эта договорённость обеспечит стране необходимые вычислительные мощности для укрепления позиций королевства в регионе и мире. В рамках соглашения Oxagon будет сдавать DataVolt землю в аренду и обеспечит поддержку ключевой инфраструктуры. Как ожидается, объект будет работать с нулевым выбросом. Передовые технологии охлаждения будут применяться для повышения эффективности оборудования и снижения потребления воды и электричества.

Источник изображения: NEOM Расположение Oxagon на побережье Красного моря расширяет возможности подключения проекта к другим информационным хабам. Доступ к подводным оптоволоконным кабелям гарантирует низкую задержку, а близость к источникам возобновляемой энергии, «зелёным» водородным проектам и расширяющаяся промышленная база района усиливает его позиции в стремлении превратиться в инфраструктурный хаб глобального масштаба. Соглашение с DataVolt укладывается в более широкую национальную стратегию. Саудовская Аравия активно инвестирует в ИИ, цифровую инфраструктуру и «умные» города в рамках долгосрочного плана экономической трансформации. Ключевая роль отводится Неому, включая «флагманские» проекты вроде The Line и Oxagon, оптимизированные для создания цифровых экосистем. Планы могут оказаться под угрозой, поскольку ситуация в регионе оказалась непредсказуемой на фоне событий последних дней, от которых уже пострадали зоны доступности AWS в ОАЭ и Бахрейне.

03.03.2026 [10:50], Сергей Карасёв

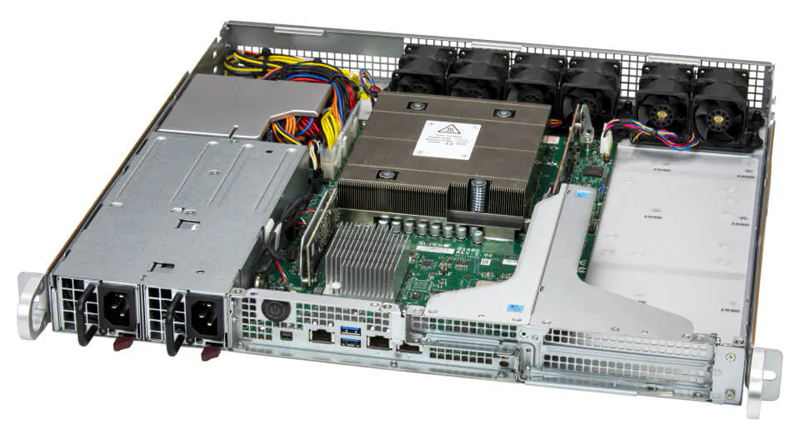

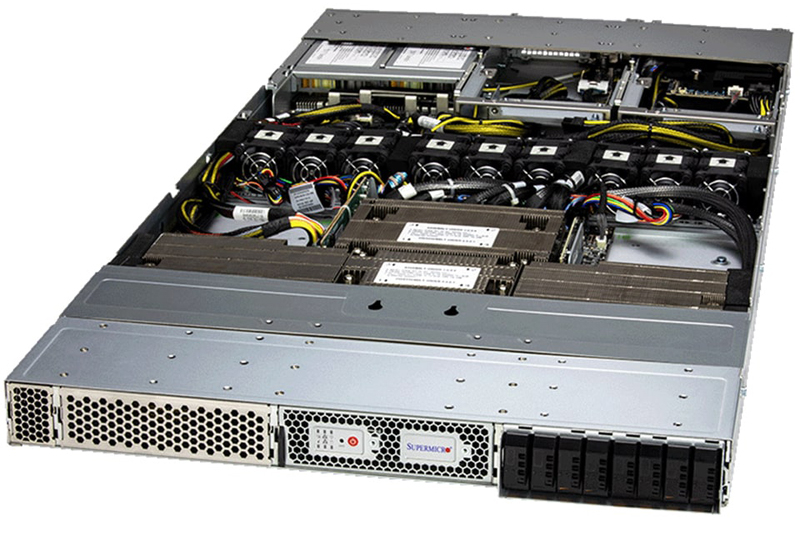

Supermicro представила серверы на базе NVIDIA Grace для инфраструктур AI-RANSupermicro анонсировала серверы на платформе NVIDIA Grace, ориентированные на применение в составе систем AI-RAN. Дебютировали устройства ARS-111L-FR, ARS-221GL-NR и ARS-111GL-NHR, использующие дизайн NVIDIA Aerial RAN Computer (ARC). Модель ARS-111L-FR выполнена в форм-факторе 1U. Задействован один чип NVIDIA Grace, объединяющий 72 вычислительных ядра Arm Neoverse V2 (Armv9). Говорится об использовании 240 Гбайт памяти LPDDR5X. Возможна установка двух ускорителей NVIDIA L4. Сервер оборудован двумя коннекторами M.2 для NVMe SSD с интерфейсом PCIe 5.0 x4, двумя посадочными местами для SFF-накопителей NVMe, двумя слотами для карт PCIe 5.0 x16 FHFL, одним разъёмом PCIe 5.0 x16 HHHL, портами 1GbE (RJ45), USB 3.2 Gen1 (5 Гбит/с) и mini-DP. Могут устанавливаться два блока питания мощностью до 800 Вт с сертификатом 80 Plus Titanium.

Источник изображений: Supermicro Устройство ARS-221GL-NR, в свою очередь, заключено в корпус 2U. Используется сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Во фронтальной части располагаются отсеки для NVMe-накопителей E1.S с возможностью горячей замены. Есть два разъёма M.2 M-key 22110 для SSD с интерфейсом PCIe 5.0 x4 (NVMe), три слота для карт PCIe 5.0 x16 FHFL и два слота для карт PCIe 5.0 x16 FHFL двойной ширины. Реализованы порты 1GbE (RJ45), USB 3.0 Type-A (×2) и mini-DP. Питание обеспечивают три блока на 2000 Вт с сертификатом 80 Plus Titanium.  Сервер ARS-111GL-NHR типоразмера 1U несёт на борту NVIDIA GH200. Могут быть установлены до восьми NVMe-накопителей E1.S и два NVMe SSD формата M.2. Доступны два слота для карт PCIe 5.0 x16 FHFL, порты 1GbE (RJ45), USB 3.0 и mini-DP. За питание отвечают два блока мощностью 2000 Вт с сертификатом 80 Plus Titanium. Все новинки оснащены воздушным охлаждением.

02.03.2026 [14:52], Сергей Карасёв

В США появился Институт дата-центров следующего поколения для решения проблем питания и охлаждения ИИ ЦОД будущегоОкриджская национальная лаборатория (ORNL) Министерства энергетики США (DOE) объявила о создании Института дата-центров следующего поколения (NGDCI). Это подразделение объединит опыт и ресурсы лаборатории в области энергетических технологий, HPC и кибербезопасности для решения проблем, с которыми сталкиваются современные ИИ ЦОД. Речь идёт прежде всего о дефиците электроэнергии и стремительном увеличении нагрузки на энергосистему. На дата-центры, по оценкам, приходится более 4 % потребления электроэнергии в США. Согласно прогнозам Научно-исследовательского института электроэнергетики (EPRI), к 2030-му этот показатель может увеличиться до 17 %. Значительная часть роста обусловлена рабочими нагрузками ИИ: например, для обучения одной большой языковой модели (LLM) с огромным количеством параметров требуются сотни МВт·ч. Быстро повышающийся спрос со стороны ИИ и промышленных потребителей создаёт всё большие риски для надёжности энергосистемы. Кроме того, растут инвестиции в области ЦОД. По оценкам McKinsey, к 2030 году глобальные расходы на соответствующую инфраструктуру достигнут $7 трлн, причём более 40 % из них придётся на США. Директор ORNL Стивен Стрейффер (Stephen Streiffer) отмечает, что на фоне быстрого развития дата-центров всё более остро встают вопросы надёжного энергоснабжения и эффективного охлаждения. Специалистам NGDCI предстоит помочь в решении назревших проблем. Новый институт будет развивать интегрированный подход, предполагающий объединение технологий электропитания, охлаждения, терморегулирования, планирования рабочих нагрузок и прогнозирования с использованием ИИ. При этом планируется использовать наработки другого проекта ORNL — MEGA-DC (Modeling Energy Growth Associated with Data Centers): это платформа поддержки принятия решений с учётом множества критериев, которая моделирует и прогнозирует затраты и экономические выгоды от модернизации инфраструктуры. В целом, NGDCI сосредоточит работу на шести ключевых направлениях:

02.03.2026 [13:00], Руслан Авдеев

Облако AWS пострадало от «удара объектов по ЦОД» в ОАЭ, приведшего к пожаруЗоны доступности mec1-az2 и mec1-az3 в регионе AWS ME-CENTRAL-1 в ОАЭ прекратили работу после того, как по дата-центру ударили «объекты». По данным AWS, объекты вызвали «искры и возгорание». Пожарные отключили сетевое электропитание и генераторы объекта для того, чтобы без помех погасить огонь. Сервисы EC2 и S3 отключены полностью, ещё 84 сервиса подвержены различным проблемам. Зона mec1-az1 не пострадала. Тем, кто не использовал резервирование в нескольких зонах, компания рекомендует развернуть нагрузки из последних бэкапов в незатронутых зонах или регионах. Сообщается, что компания всё ещё ждёт разрешения для того, чтобы вновь подать питание, и как только получит его, будет обеспечено безопасное восстановление работы и связи. Одновременно пострадала и зона доступности mes1-az2 региона ME-SOUTH-1 в Бахрейне. Компания сообщает о проблемах с питанием и сетевым подключением, но не уточняет причины сбоя. Всего проблемы затронули 66 сервисов. Остальные зоны региона не пострадали.

02.03.2026 [12:35], Сергей Карасёв

Team Group анонсировала новые индустриальные NVMe SSD и модули памятиTeam Group готовит новые SSD в различных форм-факторах, а также модули оперативной памяти для индустриальных и встраиваемых систем. В частности, готовятся накопители Team Group Industrial R252 стандарта U.2 (NVMe), предназначенные для серверов. Эти устройства оснащены интерфейсом PCIe 5.0 x4. Они обеспечивают скорость последовательного чтения информации до 14 000 Мбайт/с, скорость последовательной записи — до 10 000 Мбайт/с. Кроме того, выйдут SSD серии Team Group Industrial R253, ориентированные на решение разнообразных задач в современных дата-центрах и на периферии. Такие устройства, получившие формат EDSFF E3.S, позиционируются в качестве накопителей большой ёмкости с улучшенной защитой данных. Они подходят для обработки ИИ-нагрузок, аналитики в реальном времени и пр. Дебютируют также SSD семейства Team Group Industrial R251 стандарта EDSFF E1.S, оптимизированные для серверов форм-фактора 1U. Эти накопители имеют сертификацию по стандартам виброустойчивости MIL-STD, что означает надёжность при эксплуатации в системах с высокой плотностью размещения оборудования.

Источник изображений: Team Group В сегменте оперативной памяти Team Group представит новые модули Industrial DDR4 U-DIMM и SO-DIMM, специально разработанные для промышленного применения и IoT-устройств. Помимо этого, готовятся изделия Industrial DDR5 CU-DIMM и CSO-DIMM с частотой до 7200 МГц, рассчитанные на ИИ-платформы. На системы со значительной интенсивностью вычислений ориентированы решения Team Group Industrial LPDDR5X CAMM2: они обеспечивают высокую пропускную способность и низкую задержку.

02.03.2026 [08:59], Владимир Мироненко

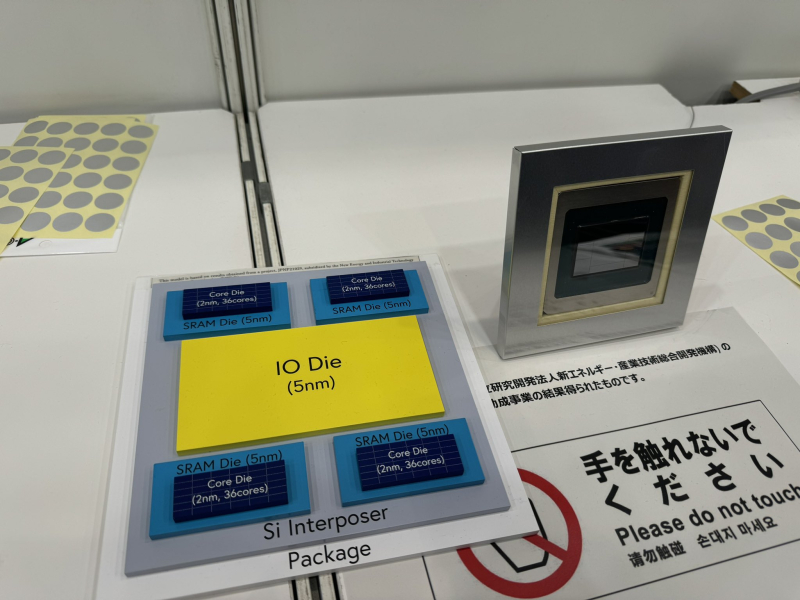

Fujitsu похвасталась, что её 2-нм процессоры MONAKA получат продвинутую упаковку Broadcom 3.5D XDSiPBroadcom объявила о начале поставок первой в отрасли 2-нм специализированной SoC, построенной на платформе 3.5D eXtreme Dimension System in Package (XDSiP). Модульная многомерная платформа с многослойной компоновкой чиплетов, 3.5D XDSiP, которая используется в чипе Fujitsu MONAKA, сочетает в себе 2.5D-упаковку и 3D-интеграцию с использованием технологии гибридного соединения между чиплетами (Face-to-Face, F2F), значительно повышающего пропускную способность. Сообщается, что технология 3.5D XDSiP станет основой XPU следующего поколения. С её помощью компании в сфере ИИ могут создавать самые передовые XPU с «беспрецедентной плотностью сигнала, превосходной энергоэффективностью и низкой задержкой», позволяющие удовлетворить вычислительные потребности ИИ-кластеров гигаваттного масштаба. Платформа Broadcom XDSiP позволяет масштабировать вычислительные ресурсы, память и сетевые интерфейсы независимо друг от друга в компактном форм-факторе, обеспечивая энергоэффективные вычисления с высокой производительностью, говорит компания. «Мы гордимся тем, что представили первый специализированный SoC на базе 3.5D-упаковки для Fujitsu», — сказал Фрэнк Остоич (Frank Ostojic), старший вице-президент и генеральный директор подразделения ASIC-продуктов Broadcom. Он отметил, что с момента внедрения технологии 3.5D XDSiP в 2024 году компания Broadcom расширила возможности своей 3.5D-платформы, чтобы поддерживать XPU для более широкой клиентской базы, поставки которых начнутся во II половине 2026 года. Как отметил ресурс The Register, Fujitsu стала одной из первых компаний-разработчиков чипов, публично признавших использование этой технологии Broadcom. Обычно клиенты Broadcom не стремятся предать огласке, какие IP-блоки они лицензируют, а какие создают сами. Например, всем известно, что Google тесно сотрудничает с Broadcom в разработке TPU, но не всегда ясно, где заканчивается вклад Google и начинается работа Broadcom. «Мы работаем над этой технологией почти пять лет, — рассказал The Register Хариш Бхарадвадж (Harish Bharadwaj), вице-президент подразделения ASIC-продуктов Broadcom. — Мы отгрузили образцы на этой неделе для Fujitsu, и в своё время многие другие наши клиенты внедрили эту технологию для своих [решений] следующих поколений». Разрабатываемый Fujitsu чип MONAKA включает четыре 2-нм вычислительных чиплета, каждый — с 36 ядрами Armv9-A, расположенные поверх четырёх SRAM-чиплетов, изготовленных по 5-нм техпроцессу TSMC. Эти стеки объединяются с центральным I/O-чиплетом, который обслуживает 12 каналов DDR5 и линии PCIe 6.0/CXL 3.0, через кремниевую подложку-интерпозер. Кроме того, новинки получат поддержку NVIDIA NVLink. По словам Бхарадваджа, Fujitsu стала одной из первых компаний из числа внедривших технологию 3.5D XDSiP, но MONAKA является лишь одним из примерно полудюжины разрабатываемых проектов. Хотя MONAKA — это платформа для процессоров, примерно 80 % успешных проектов Broadcom с использованием XDSiP приходится на XPU с HBM, отметил он. В 2024 году сообщалось о поддержке платформой решений с 12 стеками HBM. В компании рассказали The Register, что сейчас разрабатываются проекты с более чем 12 стеками.

01.03.2026 [18:15], Руслан Авдеев

CPP Investments и Equinix купили за $4 млрд оператора экологичных ИИ ЦОД atNorthКанадский пенсионный фонд Canada Pension Plan Investment Board (CPP Investments) и Equinix анонсировали соглашение о покупке у Partners Group компании atNorth за $4 млрд, специализирующейся на предоставлении колокейшн-площадок для HPC/ИИ-нагрузок и провайдере ЦОД «под ключ», сообщает HPC Wire. Digital Realty, тоже пытавшаяся купить atNorth, осталась не у дел. CPP и Equinix предварительно согласовали финансирование в объёме $4,2 млрд (€3,6 млрд) как для закрытия самой сделки, так и для расширения бизнеса atNorth. CPP Investments намерена вложить около $1,6 млрд, получив долю в 60 % компании, а Equinix — около 40 %. Сообщается, что сразу после закрытия сделка, которая ещё ожидает одобрение регуляторов, окажет положительное действие на скорректированный денежный поток от операционной деятельности (AFFO) Equinix. Сделка укрепляет долговременное сотрудничество между Equinix и CPP Investments — в 2024 году было создано совместное предприятие с сингапурской GIC для расширения портфоли ЦОД xScale. У atNorth есть восемь действующих дата-центров, ещё несколько строятся в Дании, Финляндии, Исландии, Норвегии и Швеции — общий объём портфолио составляет 800 МВт. Кроме того, компания уже зарезервировала поставки 1 ГВт энергии. Некоторые объекты, разработанные для ИИ и HPC, поддерживают жидкостное охлаждение. Также компания активно внедряет возобновляемую энергетику, инициативы по использованию избыточного тепла от оборудования, в том числе для выращивания овощей, и модульный дизайн для минимизации ущерба окружающей среде и продвижению экономики замкнутого цикла. atNorth заявляет, что компания по-прежнему будет придерживаться работы в северном регионе и продолжит независимую работу под собственным брендом, сохраняя приверженность культуре и ценностям, которые она продвигает. В CPP Investments подчеркнули, что сделка основана на уже имеющемся долгосрочном сотрудничестве с Equinix. Фонд намерен и далее наращивать бизнес в быстрорастущем секторе ЦОД. Equinix подчеркнула, что для клиентов, нуждающихся в надёжном масштабировании, компания предлагает готовую к будущим задачам инфраструктуру с сохранением юридического и информационного суверенитета. Северная Европа укрепляет статус критически важного хаба для следующего этапа цифрового роста. Он имеет сильную и надёжную экономику, активно внедряет инновации, делает ставку на исследования и техническую экспертизу, а также экоустойчивые проекты. Здесь есть много источников возобновляемой энергии и оптимальный для ЦОД климат. Equinix располагает восемью ЦОД на севере Европы: пять в Хельсинки и три в Стокгольме. Всего же в ведении компании есть более 100 объектов в 20 странах. В Европе компания на 100 % компенсирует энергопотребление своих дата-центров за счёт покупок возобновляемой энергии. Это вполне соответствует «зелёному» курсу atNorth и, как ожидается, Equinix добьётся нулевых выбросов к 2040 году. |

|