Материалы по тегу: hardware

|

28.02.2026 [23:59], Владимир Мироненко

Hyundai инвестирует более $6 млрд в ИИ ЦОД, роботов, водородную и солнечную энергетику

hardware

hyundai

nvidia

водород

ии

инвестиции

робототехника

солнечная энергия

финансы

цод

энергетика

южная корея

Hyundai Motor Group и правительство Южной Кореи подписали соглашение об инвестировании около ₩9 трлн ($6,26 млрд) с целью строительства объединённого инновационного центра в районе Сэмангым (Saemangeum) города Кунсан (Gunsan), который будет включать в себя ИИ ЦОД, завод по производству робототехники и производство водородной/солнечной энергии, сообщило агентство Reuters со ссылкой на министерство земельных ресурсов страны. По данным ведомства, около ₩5,8 трлн (около $4,04 млрд) Hyundai инвестирует в строительство ИИ ЦОД, в котором будет развёрнуто 50 тыс. NVIDIA Blackwell. ЦОД будет оснащён «массивным» хранилищем для хранения огромных массивов данных для обучения, разработки программно-определяемых транспортных средств (SDV) и внедрения «умных заводов», заявили в Hyundai. Ожидается, что интегрированная платформа позволит ускорить исследования и разработку продукции по всей цепочке создания стоимости. Ещё ₩400 млрд (около $278,8 млн) будет выделено на строительство завода по производству роботов, в том числе носимых (экзоскелетов). Также компания инвестирует ₩1 трлн (около $697,2 млн) в строительство электролизерной установки с протонообменной мембраной (Proton Exchange Membrane, PEM) мощностью 200 МВт для производства экологически чистого водорода с использованием возобновляемых источников энергии на месте. Hyundai планирует со временем достичь общей мощности электролизеров в 1 ГВт на внутреннем рынке. Hyundai утверждает, что её технология PEM достигла более чем 90 % локализации, что способствует технологической независимости Южной Кореи и расширению экспортных возможностей экологически чистого водорода, сообщил ресурс Data Center Knowledge. Оставшуюся часть суммы в размере ₩1,3 трлн (около $906,6 млн) компания направит в солнечную энергетику — строительство солнечных электростанций гигаваттного масштаба к 2035 году на основе действующей с 2021 года 99-МВт электростанции. Hyundai рассматривает ЦОД как «мозг» своей ИИ-экосистемы, объединяющий данные производства, логистики и эксплуатации транспортных средств для развития ИИ внутри страны. В центре также будет создан «умный город» с водородными технологиями на основе ИИ, который интегрирует технологии в единую экосистему. Строительство ЦОД, солнечной инфраструктуры и объекта по производству водорода планируется начать в 2027 году и завершить в 2029 году. По прогнозам Hyundai, эти инвестиции принесут экономический эффект в размере около ₩16 трлн (примерно $11 млрд) и позволят создать около 71 тыс. рабочих мест.

28.02.2026 [12:23], Владимир Мироненко

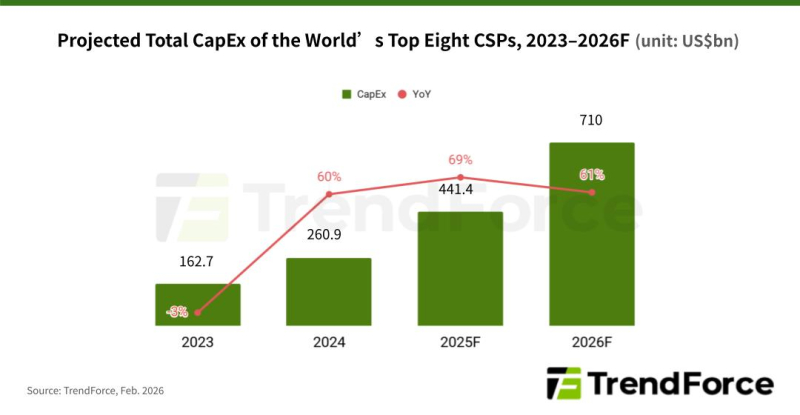

TrendForce: капзатраты восьми гиперскейлеров в 2026 году превысят ВВП ИрландииВ этом году, по оценкам TrendForce, восемь крупнейших мировых облачных провайдеров — Google, Amazon, Meta✴, Microsoft, Oracle, Tencent, Alibaba и Baidu — направят более $710 млрд на капитальные затраты, что примерно на 61 % больше, чем в прошлом году и превышает валовой внутренний продукт (ВВП) Ирландии за прошлый год. Около $650 млрд из этой суммы приходится на первых четверых гиперскейлеров из этого списка, пишет The Register. Эти средства будут потрачены на строительство и расширение ЦОД, а также оборудование для них, включая высокопроизводительные серверы, обычно оснащённые ускорителями AMD или NVIDIA. Также набирают популярность ASIC других брендов, которые в отличие от универсальных ускорителей разрабатываются для конкретных видов нагрузки. По данным TrendForce, Google остаётся единственной облачной компанией, которая добавляет больше серверов на базе ASIC, чем на базе GPU. По оценкам аналитиков консалтинговй компании, процессоры Tensor Processing Units (TPU) будут использоваться примерно в 78 % ИИ-серверов для дата-центров Google в этом году. Ожидается, что у Amazon 60 % серверов будут оснащены GPU, и компания начнёт наращивать системы на базе Trainium3 позже в этом году. Компания Meta✴ также будет в основном полагаться на ускорители NVIDIA и AMD, которыми будут оснащены более 80 % серверов, установленных в этом году. Microsoft продолжит закупать стоечные системы NVIDIA, а Oracle расширяет развёртывание стоечных серверов с GPU. Из китайских операторов Tencent также продолжит развёртывать серверы с ускорителями NVIDIA, пусть и опосредованно. The Register отметил, что высокий спрос на ИИ-серверы привёл к росту цен на память и её дефициту, поскольку производители переводят производственные линии на выпуск высокорентабельных решений, таких как память HBM. Производители микросхем памяти SK Hynix и Sandisk объявили о работе над процессом стандартизации HBF-памяти для ИИ-инференса. SK hynix описывает HBF как новый уровень памяти между сверхбыстрой HBM и высокоёмкими SSD, утверждая, что она снизит совокупную стоимость владения (TCO), одновременно повышая масштабируемость ИИ-систем. Согласно прогнозу компании, спрос на такие решения, как HBF, возрастёт примерно к 2030 году.

28.02.2026 [11:43], Сергей Карасёв

Supermicro представила высокоплотную платформу MicroBlade на базе AMD EPYC 4005Компания Supermicro анонсировала новую серверную платформу MicroBlade для облачных и периферийных развёртываний. Система, как утверждается, на сегодняшний день обладает самой высокой плотностью компоновки из всех доступных решений, использующих процессоры AMD EPYC 4005 Grado. Основой MicroBlade служат узлы MBA-315R-1DE12, рассчитанные на чипы в исполнении AM5 (LGA-1718). Могут применяться процессоры с TDP до 110 Вт, насчитывающие до 16 вычислительных ядер (32 потока инструкций). В расчёте на процессор доступны два слота для модулей оперативной памяти DDR5-5600 суммарным объёмом до 128 Гбайт. Каждый узел оснащается контроллером Aspeed AST2600 BMC, двумя сетевыми портами 25GbE на базе Broadcom BCM57414, а также модулем TPM 2.0, отвечающим за безопасность. Возможна установка одного SSD формата M.2 (NVMe) и двух накопителей EDSFF E1.S. Диапазон рабочих температур — от +10 до +35 °C. Габариты составляют 589,28 × 125,48 × 30,48 мм, масса — около 1,5 кг. Новая платформа поддерживает до 40 узлов в одном корпусе форм-фактора 6U. Таким образом, в серверной стойке 48U могут разместиться до 320 узлов. Supermicro подчёркивает, что это обеспечивает «беспрецедентную вычислительную плотность, энергоэффективность и экономичность для масштабируемых и многопользовательских сред». Решение MicroBlade подходит для широкого спектра нагрузок, среди которых названы виртуальные частные серверы, периферийные системы, микросервисы, службы обработки данных, приложения в области кибербезопасности, площадки электронной коммерции и пр.

28.02.2026 [11:37], Сергей Карасёв

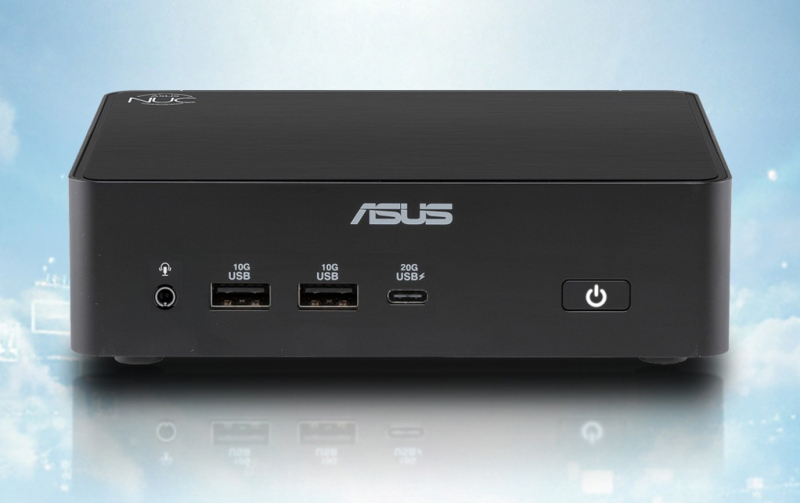

ASUS готовит «беспамятные» облачные мини-ПК NUC 16 для Windows 365Компания ASUS сообщила о скором выходе компьютеров небольшого форм-фактора NUC 16, оптимизированных для использования облачного ПО Windows 365. Устройства, заключенные в корпус объёмом всего 0,7 л, построены на аппаратной платформе Intel. Полностью технические характеристики NUC 16 for Windows 365 не раскрываются. При этом ASUS говорит о применении «новейшего процессора Intel», работающего в тандеме с памятью DDR5. Сетевые источники считают, что с учётом специфики компьютеров могут быть задействованы чипы поколения Twin Lake или Wildcat Lake. В оснащение устройств входят адаптеры Wi-Fi 6E и Bluetooth 5.3, сетевой контроллер 2.5GbE, интерфейс HDMI, порты USB Type-C (20 Гбит/с) и USB Type-A (10 Гбит/с), стандартное аудиогнездо на 3,5 мм. Внешне изделия напоминают мини-компьютер ASUS NUC 16 Pro, который использует платформу Intel Panther Lake. В максимальной конфигурации устанавливается процессор Core Ultra X9 388H с 16 ядрами (4Р+8Е+4LPE), а объём ОЗУ достигает 128 Гбайт. Возможна установка SSD типоразмера М.2 с интерфейсом PCIe 5.0 x4 (NVMe) вместимостью до 8 Тбайт. Этот компьютер рассчитан на работу с Windows 11 Pro или Home. Габариты составляют 144 × 117 × 42 мм, масса — 685 г. Допускается монтаж посредством крепления VESA. Однако в случае нового NUC 16 локальное хранение данных и приложений не предполагается — всё находится в Microsoft Azure, что как минимум позволит сэкономить на дефицитных SSD и RAM. Кроме того, сообщается, что компактные компьютеры для работы с Windows 365 готовит Dell. Речь идёт об устройствах Pro Desktop, которые получат процессор Intel N-Series с пассивным охлаждением. Это означает, что может быть использован чип Twin Lake или Alder Lake-N. Упомянуты порты USB Type-C и USB Type-A, а также 3,5-мм аудиогнездо.

28.02.2026 [09:48], Сергей Карасёв

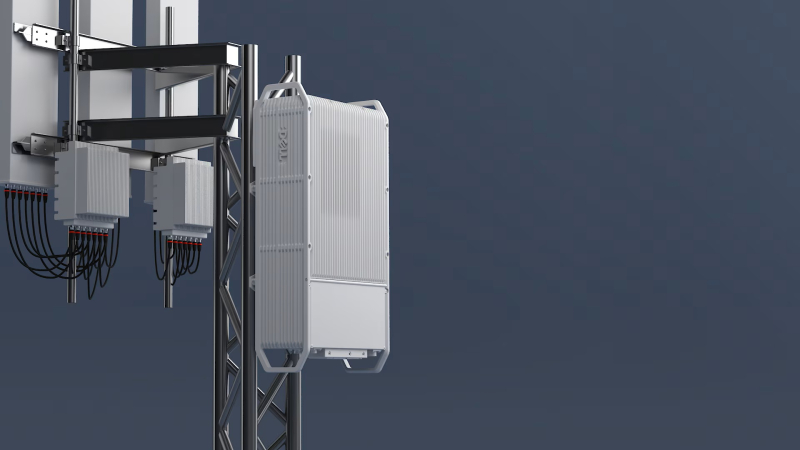

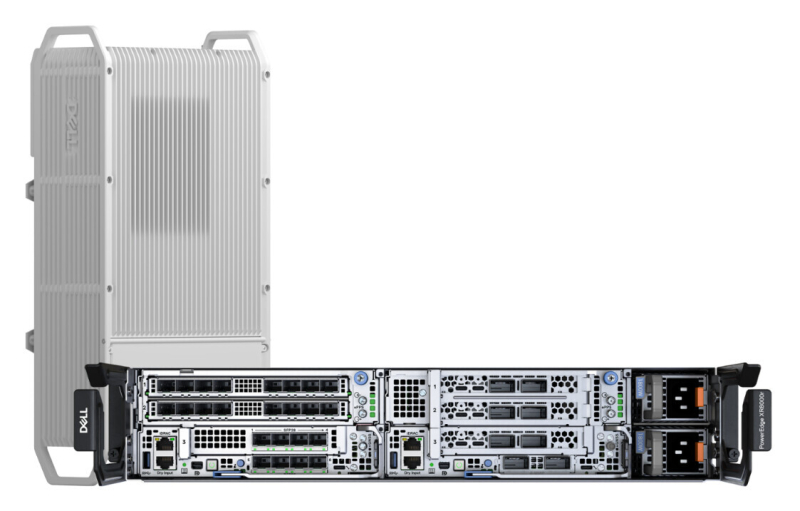

Dell представила подвесной уличный сервер PowerEdge XR9700 с замкнутой СЖОDell анонсировала сервер PowerEdge XR9700, предназначенный для инфраструктур Cloud RAN и ИИ-приложений на периферии. Устройство рассчитано на эксплуатацию в неблагоприятных условиях, в том числе на открытом воздухе: оно может монтироваться на опорах линий электропередач, крышах и фасадах зданий. Новинка заключена в корпус объёмом около 15 л. Говорится о сертификации IP66 и GR-3108 Class 4: серверу не страшны пыль, влага и воздействие прямого солнечного излучения. Диапазон рабочих температур простирается от -40 до +46 °C. В основу PowerEdge XR9700 положена аппаратная платформа Intel Xeon 6 SoC — Granite Rapids-D (до 72 P-ядер, TDP до 325 Вт). Также возможна установка ИИ-ускорителей и различных сетевых карт, в том числе для обработки L1-трафика. Задействована система жидкостного охлаждения с замкнутым контуром, а ребристая внешняя поверхность работает в качестве радиатора. Без СЖО с таким уровнем тепловыделения CPU/GPU и в таком компактном корпусе уже вряд ли можно обойтись. Отмечается, что с технической точки зрения устройство идентично модели PowerEdge XR8720t, которая дебютировала в октябре прошлого года. В зависимости от конфигурации это решения располагает четырьмя или восемью слотами для модулей DDR5. Возможна установка до трёх SSD формата M.2 (NVMe). В оснащение могут входить два порта 100GbE QSFP и восемь портов 10/25GbE SFP. Реализованы интерфейсы USB 3.0 Type-A, UCB Type-C, Mini-DisplayPort и пр. Заявлена поддержка Wind River SUSE Linux Enterprise Server/RT, Ubuntu Server LTS и Red Hat Enterprise Linux/RT. Интегрированный контроллер удалённого доступа Dell (iDRAC) обеспечивает мониторинг и управление. Говорится о совместимости с существующим набором решений для периферийных вычислений в области телекоммуникаций. В продажу PowerEdge XR9700 поступит во II половине текущего года.

27.02.2026 [22:55], Владимир Мироненко

Amazon вложит в OpenAI $50 млрд, OpenAI в ответ потратит $100 млрд на 2 ГВт мощностей TrainiumOpenAI и Amazon объявили о заключении соглашения о стратегическом партнёрстве с целью ускорения инноваций в области ИИ для предприятий, стартапов и конечных потребителей по всему миру. В рамках многолетнего соглашения Amazon инвестирует в OpenAI $50 млрд — $15 млрд первым траншем, а затем еще $35 млрд в ближайшие месяцы при выполнении определённых условий. AWS и OpenAI совместно создадут среду выполнения с сохранением состояния (Stateful Runtime Environment) на базе моделей OpenAI, которая будет доступна в Amazon Bedrock для создания приложений и агентов генеративного ИИ. Подобное окружение позволяет разработчикам сохранять контекст, запоминать предыдущую работу, работать с различными программными инструментами и источниками данных, а также получать доступ к вычислительным ресурсам. Новинка будет интегрирована с Amazon Bedrock AgentCore и инфраструктурными сервисами, чтобы приложения и ИИ-агенты клиентов работали согласованно с остальными приложениями инфраструктуры, работающими в AWS. AWS также станет эксклюзивным сторонним поставщиком облачных услуг для платформы OpenAI Frontier, позволяющей компаниям создавать, развёртывать и управлять командами ИИ-агентов, работающих в реальных бизнес-системах с общим контекстом. По мере перехода компаний от экспериментов к внедрению ИИ в производство, Frontier упрощает быструю, безопасную и глобальную интеграцию ИИ-технологий в существующие рабочие процессы. Кроме того, OpenAI и Amazon будут сотрудничать в разработке пользовательских моделей для работы с приложениями Amazon, ориентированными на клиентов. AWS и OpenAI также сообщили о расширении ещё на $100 млрд более раннего соглашения о многолетнем стратегическом партнёрстве стоимостью $38 млрд, в рамках которого AWS обязалась предоставлять OpenAI в течение семи лет доступ к ускорителям NVIDIA. Расширенное соглашение со сроком действия 8 лет включает в себя обязательство OpenAI использовать около 2 ГВт мощностей на базе ускорителей Trainium, чтобы поддерживать спрос на Stateful Runtime, Frontier и другие рабочие нагрузки. Это обязательство распространяется как на чипы Trainium3, так и на чипы следующего поколения Trainium4, которые появятся в 2027 году и получат технологию NVIDIA NVLink. Сегодняшний день оказался богатым на события для OpenAI. Компания объявила о привлечении $110 млрд инвестиций в рамках раунда финансирования с предварительной оценкой её рыночной стоимости в $730 млрд, что значительно больше оценки в $500 млрд в октябре 2025 года. Лидером раунда стала Amazon с инвестициями в $50 млрд, за ней следуют NVIDIA и SoftBank, инвестировавшие по $30 млрд. Компания заявила, что ожидает, что к раунду присоединятся и другие инвесторы. Ранее Anthropic, ключевой конкурент OpenAI, закрыл раунд финансирования на $30 млрд, подняв капитализацию до $380 млрд. У компании долгие и тесные отношения с AWS, которая развернула для стартапа один из крупнейших в мире ИИ-кластеров Project Rainier. Впрочем, Anthropic тоже старается диверсифицировать поставки вычислительных мощностей — она заключила контракты с Microsoft (на чипы NVIDIA), а также с Google (на TPU).

27.02.2026 [20:06], Руслан Авдеев

Meta✴ получит миллионы ИИ-ускорителей Google TPUMeta✴ заключила многомиллиардную сделку по аренде ИИ-ускорителей TPU у Google для обучения и инференса LLM, сообщили анонимные источники The Information. Пока в индустрии ИИ-чипов доминируют решения NVIDIA, но TPU во многих случаях представляют собой более дешёвую и привлекательную альтернативу. В последние годы они стали одним из ключевых драйверов роста облачной платформы Google. Новая сделка важна для Meta✴, поскольку компания намерена диверсифицировать вычислительные мощности, снизив зависимость от NVIDIA. Meta✴ — один из крупнейших клиентов компании. Ранее она уже объявила о покупке миллионов новейших ускорителей Vera Rubin и закупках процессоров Grace. Кроме того, Meta✴ заключила сделку с AMD на поставку 6 ГВт GPU Instinct и CPU EPYC нового поколения. Каждый из ускорителей имеет собственные преимущества и недостатки, поэтому Meta✴ может экспериментировать, подбирая оптимальные типы чипов под отдельные задачи. Кроме того, вендоры обеспечат ей оптимальные цены и условия, если будут конкурировать друг с другом. Тем временем Google намерена лишить NVIDIA монополии на рынке ИИ-ускорителей. Компания готова предложить потенциальным клиентам привлекательные альтернативы чипам конкурента. Ранее TPU были доступны только в Google Cloud, но теперь компания намерена продавать их напрямую клиентам для сторонних ЦОД. Одной из первых компаний, которая активно займётся пряой закупкой и размещением TPU, стала Anthropic. Сделка на сумму в «десятки миллиардов» долларов охватывает 1 млн TPU и 1 ГВт мощностей. В Google рассчитывают ближайшие годы получить до 10 % выручки NVIDIA от ЦОД. В отчёте The Information сообщается, что Meta✴ ведёт переговоры с Google о покупке миллионов TPU для своих собственных ЦОД, причём речь идёт об отдельной сделке, напрямую не связанной с нынешним «облачным» соглашением. Наконец, у Meta✴ есть и ускорители MTIA собственной разработки. По имеющимся данным, все чипы MTIA нового поколения оптимизированы для обучения ИИ-моделей, в этой сфере ускорители первого поколения сталкивались с определёнными трудностями. Впрочем, считается, что при разработке новинок компания тоже столкнулась с «техническими проблемами», из-за которых задержался их выпуск.

27.02.2026 [15:30], Руслан Авдеев

Шутки в сторону: 1 апреля провайдер Hetzner резко поднимет цены — до +50 %Один из крупнейших европейских хостинг-провайдеров и операторов ЦОД — компания Hetzner предупредила клиентов, что рост цен на её услуги составит до 50 %. Это касается как имеющихся пользователей, так и будущих — в Германии, Финляндии, США и Сингапуре, сообщает The Register. Hetzner известна (пока) недорогими сервисами, в первую очередь IaaS, для разработчиков и корпоративных клиентов. Компания сообщила, что причиной изменений стоимости её продуктов стал рост цен в разных сферах рынка IT. Компания пожаловалась, что выросла стоимость эксплуатации инфраструктуры и нового оборудования, а попытка оптимизации расходов не принесла желаемого эффекта. Список ценовых изменений свидетельствует, что многие услуги действительно значительно подорожают, многие на 30 %, а некоторые даже на 50 %, что может серьёзно сказаться на небогатых клиентах. Стремительное развитие ИИ-индустрии стало одним из факторов, определивших движение рынка инфраструктуры в непредсказуемых направлениях на фоне спроса на всё большие вычислительные мощности. Гиперскейлеры не могут приобрести достаточно HBM, RAM и флеш-памяти, а также ИИ-ускорителей, особенно производства NVIDIA. Ожидается, что цены на DRAM- и NAND-модули в текущем квартале удвоятся, а некоторые серверные CPU уже в дефиците и скоро подорожают. Производители HDD жалуются, что распродали столько жёстких дисков, сколько собирались выпустить за весь год.

Источник изображения: Jon Del Rivero/unspalsh.com В Omdia отметили, что Hetzner фактически является провайдером облачной инфраструктуры, поэтому в подорожании сервисов даже на 50 % нет ничего удивительного — это всего лишь отражение текущей реальности. В Omdia считают, что пользователи могут ожидать повышения цен и со стороны других провайдеров. Наибольшему давлению подверглись компании-операторы второго эшелона, они в более невыгодном положении в сравнении с гиперскейлерами. Эксперты Omdia отмечают, что рынок облачных сервисов ожидает некоторый раскол — гиперскейлеры уровня AWS, Microsoft и Google имеют долгосрочные прямые соглашения напрямую с поставщиками «железа», защищающие их от немедленного ценового шока. Тем временем средние и малые компании, не обладающие гигантской покупательной способности, в том числеHetzner и OVHcloud (тоже анонсировавшей рост цен), не имеют выбора, перекладывая издержки на пользователей. К несчастью для компаний, рассчитывающих на бюджетный облачный хостинг, инфраструктурные издержки взлетят. Рынку необходимо, чтобы компании уровня Hetzner продолжали работать и сохраняли прибыльность. Реакция онлайн-сообщества оказалась смешанной. Одни пользователи говорят, что рост цен непосильный, поэтому им придётся искать возможные альтернативы. У некоторых небольших провайдеров действительно пока что более привлекательные цены в сравнении с Hetzner. Среди плюсов называется относительно недорогая стоимость ухода от к конкурентам. Другие же пользователи пишут, что реакция компании предсказуема. В противном случае пришлось бы вообще отказаться от облачных серверов. Отмечается, что у Hetzner всё ещё лучшее соотношение цены/производительности в сравнении с конкурентами. Стоит отметить, что некоторые компании довольно спорно обосновывают ценообразование. Например, не так давно сообщалось, что Cisco нашла оправдание повышению цен на свои продукты, несмотря на рекордную выручку во II четверти текущего финансового года.

27.02.2026 [14:03], Руслан Авдеев

NK Group построит кампус из 11 ЦОД в Домодедово — «Сбер» может стать ключевым покупателемВ Подмосковье строится кампус из 11 дата-центров. Исполнителем проекта выступает девелопер NK Group (ранее PNK Group). Мощность каждого из новых ЦОД в Домодедове составит порядка 10 МВт: для пяти уже возведены несущие конструкции, ещё шесть находятся на этапе подготовки к строительству, сообщает РБК. Регион уже выделил кампусу 30 МВт. Пристанищем для кампуса станет технопарк «NK Парк Домодедово 3» — один из трёх объектов, входящих в специализированный кластер NK Group. Общая площадь застройки составляет 105,5 тыс. м², из них дата-центры займут 25,3 тыс. м². Остальная площадь отводится под парковки, дороги, трансформаторную подстанцию, жильё для сотрудников, заправку для резервных генераторов и др. Дата-центры предназначены для продажи, и якорным покупателем может стать «Сбер», который, по неподтверждённым данным, претендует на приобретение 6 из 11 дата-центров. NK Group специализируется на строительстве промышленных объектов и уже имеет в портфолио 47 технопарков в Московском регионе, Санкт-Петербурге, Самаре, Казани, Екатеринбурге, Новосибирске и др. Ежегодно компания строит 1,5 млн м² объектов. При этом она имеет опыт строительства дата-центров — например, в 2024 году достигнуто соглашение о продаже ЦОД на более 4 тыс. стойко-мест в Медведково «Ростелекому» за 26,2 млрд руб. NK Group называют одной из первых в России бизнес-структур, начавших строить дата-центры под заказ. Стоимость нового проекта оценивается в «десятки миллиардов рублей». В сентябре 2025 года сообщалось, что рынок коммерческих ЦОД поставил антирекорд по приросту стойко-мест, а в Москве закончилась электроэнергия для новых объектов. Летом 2025 года сообщалось, что Московский регион страдает от нехватки стойко-мест, но операторы могут уйти в провинцию, где некоторых ресурсов значительно больше. На фоне дефицита новых мощностей в столице операторы ищут новые дата-центры в Московской области, а потребители мощностей стремятся строить ЦОД для собственных нужд. По мнению представителя Профессиональной ассоциации в сфере облачных технологий, к тому времени, когда новые ЦОД будут введены в эксплуатацию, дефицит должен снизиться, в том числе за счёт программы Московского региона, предусматривающей запуск новых дата-центров до 2031 года. Эксперты подчёркивают, что в Москве сосредоточены крупные потребители, заинтересованные в размещении ЦОД в зоне быстрой доступности — от IT-бизнеса и штаб-квартир крупных компаний до государственных ведомств. На фоне вероятного запрета на подключение новых дата-центров в Москве многие из них рассматривают возможность подключения объектов в её окрестностях. По словам представителя Ricci, стоимость строительства проекта может составить 600–800 млн руб. за 1 МВт IT-мощностей. Хотя сейчас объект считается расположенным довольно далеко от МКАД, по мере истощения резервов мощностей в пределах кольцевой автодороги в течение трёх–пяти лет востребованность таких ЦОД может вырасти, поскольку в самой столице получить мощности становится всё сложнее. По некоторым оценкам, шесть дата-центров для «Сбера» могут обойтись в 40–60 млрд руб., а весь кампус — в 73–110 млрд руб., исходя из оценочной стоимости $7–$12 млн на 1 МВт полезной мощности.

27.02.2026 [09:59], Сергей Карасёв

Nimbus Data представила универсальную All-Flash СХД FlashMaxКомпания Nimbus Data анонсировала платформу хранения FlashMax класса All-Flash, разработанную для современных дата-центров с высокими нагрузками. Решение позволяет одновременно использовать блочные, файловые и объектные хранилища данных в одной системе, что упрощает построение разнородной инфраструктуры и повышает эффективность. В семейство FlashMax вошли модели F500, F700 и F900. Все они оснащены двумя контроллерами с возможностью горячей замены. Реализована поддержка протоколов NVMe-oF (TCP и RoCEv2), iSCSI, Fibre Channel, NFS, SMB, AFP, FTP, TFTP и S3. Упомянуты такие функции, как дедупликация, сжатие, контрольные суммы и аппаратное шифрование. В составе устройств применяются стандартные накопители NVMe SSD в SFF-формате. Модель FlashMax F500 стандарта 2U рассчитана на 24 накопителя суммарной вместимостью до 3 Пбайт. Возможно подключение одного модуля расширения E240 (также 2U), который также может комплектоваться 24 SSD. Таким образом, суммарная «сырая» ёмкость достигает 6 Пбайт, эффективная — 30 Пбайт. Показатель IOPS составляет до 2,2 млн, пропускная способность — до 30 Гбайт/с. Доступны следующие сетевые интерфейсы: 2 × 10GbE SFP+ и 3 × 100GbE или 6 × 25GbE или 4 × FC32.

Источник изображения: Nimbus Data Вариант FlashMax F700 типоразмера 2U в базовом исполнении рассчитан на 24 накопителя, но может использовать до четырёх полок E240 (в сумме до 120 SSD). «Сырая» вместимость — до 15 Пбайт, эффективная — до 75 Пбайт. Значение IOPS достигает 6,8 млн, пропускная способность — 100 Гбайт/с. Предусмотрены два порта 10GbE, а также 4 × 400GbE или 8 × 200GbE или 16 × FC64. Старшая версия, FlashMax F900, содержит базовый узел 2U и два дополнительных 2U-модуля, а максимальная конфигурация включает до шести модулей E240. В сумме это даёт до 168 SSD с общей «сырой» ёмкостью до 21 Пбайт и эффективной вместимостью до 100 Пбайт. Прочие характеристики аналогичны модели FlashMax F700. В устройствах применяется технология DirectLink — интерконнект на базе PCIe, который напрямую соединяет модули расширения с контроллерами ввода-вывода. Это обеспечивает высокую производительность и минимизирует задержки. Диапазон рабочих температур простирается от +5 до +40 °C. Клиентам предоставляется круглосуточная поддержка в режиме 24/7/365, а срок гарантии достигает 10 лет. |

|