Материалы по тегу: ии

|

13.02.2026 [10:50], Сергей Карасёв

Xinnor представила All-Flash платформу хранения xiNAS для задач ИИ и НРСКомпания Xinnor анонсировала платформу xiNAS — это высокопроизводительное решение для хранения данных, ориентированное на задачи ИИ, НРС и другие ресурсоёмкие рабочие нагрузки. Изделие, относящееся к классу All-Flash, поддерживает линейное масштабирование пропускной способности по мере добавления узлов. xiNAS объединяет программный RAID-движок Xinnor xiRAID с оптимизированной файловой системой XFS и высокопроизводительным транспортным протоколом NFS over RDMA. По заявлениям разработчика, такая комбинация позволяет максимизировать быстродействие базового оборудования. В качестве последнего могут использоваться серверы Supermicro. Тестирование осуществлялось на машине Supermicro AS-1116CS-TN типоразмера 1U, оборудованной одним процессором AMD EPYC 9004 Genoa, DPU NVIDIA BlueField-3 и 12 накопителями NVMe с интерфейсом PCIe 5.0. Пропускная способность на операциях чтения составила до 74,5 Гбайт/с, на операциях записи — до 39,5 Гбайт/с. При использовании двухузловой конфигурации показатели повысились до 117 и 79,6 Гбайт/с соответственно.

Источник изображений: Xinnor Среди преимуществ платформы xiNAS компания Xinnor выделяет отсутствие проприетарного клиентского ПО, что обеспечивает простоту развёртывания и интеграции. Благодаря xiRAID достигаются высокий уровень защиты данных и стабильность работы при сбоях.  В качестве возможных конфигураций xiNAS приводятся серверы формата 1U и 2U, оснащённые соответственно процессором AMD EPYC 9384X с 32 ядрами и EPYC 9474F с 48 ядрами. Оба устройства располагают 128 Гбайт оперативной памяти и адаптерами ConnectX-7 на 400 Гбит/с (одна и две штуки). Младшая версия несёт на борту 10 накопителей Kioxia CM7-R стандарта E3.S (PCIe 5.0) на 15 Тбайт каждый и два таких же SSD на 2 Тбайт. Пропускная способность системы при последовательном чтении достигает 45 Гбайт/с, при последовательной записи — 20 Гбайт/с. Сервер в 2U-корпусе оборудован 18 накопителями Micron 7450 стандарта U3 (PCIe 5.0) на 15 Тбайт и двумя SSD Micron 7450 E3.S вместимостью 3 Тбайт. Заявленная пропускная способность при последовательном чтении — до 90 Гбайт/с, при последовательной записи — до 45 Гбайт/с.

12.02.2026 [23:38], Владимир Мироненко

Наскоро построенные ИИ ЦОД могут оказаться не нужны, предупредила китайская SMICСо-генеральный директор Semiconductor Manufacturing International Corp. (SMIC) Чжао Хайцзюнь (Zhao Haijun) предупредил что резкий рост инвестиций в микросхемы для ИИ формирует предложение на годы вперёд, что может привести к простою некоторых ЦОД, пишет Bloomberg. Хайцзюнь заявил, что компании хотели бы за год-другой создать мощности ЦОД на 10 лет вперёд, хотя вопрос по поводу того, для каких задач будут использоваться эти ЦОД ещё не до конца продуман. По прогнозам рейтингового агентства Moody’s, инвестиции в ИИ-инфраструктуру в течение следующих пяти лет превысят $3 трлн. Только в 2026 году на фоне гонки в ИИ-сфере совокупные капитальные затраты в расширение ИИ-инфраструктуры Alphabet (Google), Amazon (AWS), Meta✴ и Microsoft превысят $650 млрд. Ведущие китайские компании в сфере ИИ, включая Alibaba, Tencent и ByteDance, также активно инвестируют в ИИ-инфраструктуру, для которой используются как чипы американских производителей (иногда опосредованно), так и отечественные аналоги, в том числе собственной разработки. Компания SMIC является крупнейшим производителем микросхем Китая. Из-за экспортных ограничений США она может производить лишь менее продвинутые чипы для ИИ-нагрузок по сравнению с выпускаемыми NVIDIA на мощностях TSMC. Местные клиенты SMIC, включая Huawei и Cambricon Technologies, стремятся к быстрому наращиванию производства микросхем для удовлетворения потребностей Китая в ИИ-технологиях. «Это как строительство высокоскоростных железнодорожных станций и автомагистралей — даже если сегодня не так много автомобилей, вы всё равно хотите завершить инфраструктуру, рассчитанную на 10 лет, всего за два года», — сказал Чжао. Хотя речь идёт о будущих рисках для ИИ-индустрии, уже сейчас звучат призывы к осмотрительности в подходах к инвестированию в ИИ, поскольку есть опасения по поводу растущего пузыря. Ещё весной прошлого года председатель Alibaba Group Джо Цай (Joe Tsai) предупредил о том, что текущие темпы строительства ЦОД могут опередить рост спроса на ИИ-сервисы и может сложиться ситуация, когда дата-центров построят больше, чем требует рынок. До этого, в 2024 году появились сообщения о том, что из-за спешки и переоценки спроса некоторые ИИ ЦОД в Китае оказались невостребованными. Для продажи простаивающих вычислительных мощностей Пекин сейчас создаёт специальных сервис. В свою очередь, власти Монголии, где всего два ЦОД на всю страну, рассчитывают привлечь инвестиции в развёртывание ИИ-инфраструктуры, хотя буквально «через дорогу» как раз и простаивают китайские дата-центры.

12.02.2026 [16:47], Руслан Авдеев

Anthropic пообещала, что её ИИ ЦОД не повлияют на счета за электричество обычных граждан, но есть один нюансИИ-стартап Anthropic обязался компенсировать любые повышения цен на электричество для обычных потребителей, связанные с высокой энергоёмкостью её дата-центров, сообщает The Register. Как заявляет компания, ответственное развитие ИИ не должно ограничиваться только совершенствованием технологий, оно должно касаться и инфраструктуры, лежащей в основе новых решений. Расходы на обеспечение работы ИИ-моделей Anthropic должны лечь на саму компанию, хотя США остро нуждается в инфраструктуре ИИ ЦОД. По словам главы стартапа Дарио Амодеи (Dario Amodei), это не должно сказываться на рядовых американцах. Anthropic обещает полностью компенсировать расходы на модернизацию электросетей, обязательную для подключения её дата-центров — она будет осуществляться за счёт повышения платы за потребляемое электричество. Строительство и обслуживание электростанций, подстанций, ЛЭП и другой инфраструктуры обходится весьма дорого, а активы коммунальных предприятий со временем подвержены износу. Это не может не влиять на цену электроэнергии, на счета влияет и система гибкого ценообразования в зависимости от спроса в конкретные день или время. Дополнительно Anthropic рассматривает возможное внедрение «систем ограничения потребления электроэнергии» для снижения нагрузки на электросети в периоды пиковых нагрузок, а также внедряет СЖО для уменьшения энергозатрат.

Источник изображения: Jon Moore/unsplash.com Впрочем, такие меры вряд ли повлияют на сложившуюся ситуацию существенно, поскольку Anthropic готова нести ответственность только за принадлежащие ей самой ЦОД, которых в масштабах США очень мало. В аренде у Anthropic находятся значительные мощности и ИИ-ускорители, принадлежащие, в частности, Amazon, Google и Microsoft. Одна только сделка с Microsoft предполагает развёртывание дополнительного гигаватта мощностей. В ноябре 2025 года компания объявила об инвестициях $50 млрд в американскую инфраструктуру вычислений совместно с занимающейся строительством дата-центров FluidStack. В частности, речь идёт о ЦОД в Техасе, Нью-Йорке и др., уже имеется дата-центр на юго-востоке Луизианы. На арендованные мощности обязательства стартапа не распространяются, хотя в таких случаях тот исследует возможности решить проблему влияния нагрузки на цены. Anthropic попросила помощи у Вашингтона, заявив, что действий на уровне отдельных компаний недостаточно и для обеспечения доступности электричества нужны системные изменения. Компания подчеркнула, что поддерживает федеральную политику, в т.ч. реформу системы выдачи разрешений и меры, принимаемые для ускорения развития передающих сетей и межсетевых подключений. Это позволяет быстрее и дешевле вводить в эксплуатацию новые источники энергии. На фоне растущего противодействия массовому строительству дата-центров администрация президента США Дональда Трампа (Donald Trump) оказывает системное давление на гиперскейлеров, предлагая добровольно принять меры, предотвращающие резкое увеличение счетов за электричество и воду для жителей, если это связано с деятельностью самих IT-компаний. Например, Microsoft уже обязалась обеспечить формат работы, при котором работа её ЦОД не приведёт к увеличению коммунальных платежей для обычных потребителей, а Трамп заявил, что американцы не должны оплачивать модернизацию инфраструктуры для ИИ ЦОД.

12.02.2026 [15:29], Руслан Авдеев

MGX из ОАЭ готова вложить сотни миллионов долларов в Anthropic, которой потребовались ещё $20 млрд инвестицийГосударственный группа MGX Fund Management Limited (MGX) из ОАЭ ведёт переговоры о том, чтобы присоединиться к новейшему раунду инвестиций в американскую ИИ-компанию Anthropic, сообщает Bloomberg. Компания рассматривает возможность вложить сотни миллионов долларов в Anthropic в рамках раунда финансирования, в ходе которого планируется привлечь $20 млрд, об этом сообщили изданию источники, знакомые с вопросом на условиях сохранения анонимности. Информация о предложении инвестиций, вероятно, официально появится в ближайшие дни. Впрочем, окончательное решение пока не принято, а масштаб и структура инвестиций ещё могут измениться. Представители MGX и Anthropic слухи пока не комментируют. Anthropic, в меру сил конкурирующая с OpenAI, изначально рассчитывала привлечь $10 млрд, но теперь намерена получить больше средств и довести оценку капитализации до $350 млрд, отчасти благодаря «избыточному» интересу инвесторов. В ходе последнего раунда финансирования компания получила по $1 млрд от Coatue Management, сингапурской GIC Pte и Iconiq Capital. С тех пор компания считается весьма успешным бизнесом, более чем удвоив темпы роста годовой выручки. Недавно она представила новую версию своей наиболее мощной модели, предназначенной для проведения финансовых исследований, вскоре после её экспансии в сферу юридических услуг произошёл обвал акций традиционных разработчиков профильного ПО.

Источник изображения: Centre for Ageing Better/unsplash.com MGX преуспела в качестве активного инвестора в ИИ и смежные технологии. MGX является одной из компанией, поддерживающих проект Stargate компании OpenAI, а также планы строительства ЦОД французской Mistral AI. В прошлом году MGX и BlackRock приобрели Aligned Data Centers за $40 млрд, это крупнейшая сделка подобного рода на рынке ИИ в 2025 году. В январе 2026 года BlackRock сообщила, что привлекла $12,5 млрд для инвестиционного ИИ-партнёрства, поддерживаемого MGX, Microsoft, NVIDIA и xAI. В том же месяце MGX приобрела 15 % в американской, недавно сформированной части TikTok. Также компания тесно связана с ещё одним инвестором из ОАЭ — ИИ-компанией G42, участвующей в проекте строительства кампуса Stargate в стране и заключившей крупную сделку с Cerebras. Последний раунд финансирования даст возможность почти удвоить капитализацию Anthropic. Он пройдёт всего через пять месяцев после того, как компания уже привлекла $13 млрд при значительном участии катарского фонда Qatar Investment Authority. Этот раунд стал поворотным моментом для Anthropic. Глава компании Дарио Амодеи (Dario Amodei) попытался объяснить, почему компания оправдывает привлечение ближневосточных денег несмотря на риск обвинения в лицемерии, назвав это необходимым компромиссом. В ходе тура по ближневосточным странам в октябре 2025 года, Амодеи встретился с представителями MGX, чтобы обсудить привлечение дополнительных средств.

12.02.2026 [15:16], Андрей Крупин

Система визуализации «Графиня» получила модульную архитектуру и средства трансформации данныхКомпания «Лаборатория числитель» выпустила крупное обновление платформы «Графиня», предназначенной для визуализации, мониторинга и анализа данных и выступающей в качестве альтернативы Open Source-инструменту Grafana. Представленный отечественным разработчиком программный продукт создан с нуля и не использует код Grafana, сохраняя знакомую пользователям логику работы при расширенных возможностях и повышенной стабильности. «Графиня» позволяет в реальном времени отслеживать состояние корпоративных IT-сервисов, быстро выявлять и локализовывать проблемы, предоставлять наглядные аналитические панели для оперативного принятия бизнес-решений.

Источник изображения: chislitellab.ru Ключевое изменение релиза — новая архитектура, позволяющая всем желающим создавать и разрабатывать свои модули для системы, с возможностью сбора данных из любых источников и собственной визуализацией. Так, в системе появился первый компонент «Ресурсно-сервисная модель» для взаимодействия с платформами мониторинга. В дополнение к этому «Графиня» получила средства трансформации данных, позволяющие преобразовать «сырые» данные перед тем, как они будут визуализированы, улучшенные виджеты, поддержку новых переменных, расширенные возможности конструктора и редактора, а также прочие доработки. Система «Графиня» зарегистрирована в реестре Минцифры России и может использоваться для реализации проектов импортозамещения программного обеспечения.

12.02.2026 [14:30], Руслан Авдеев

Meta✴ анонсировала строительство очередного гигаваттного кампуса ЦОД стоимостью $10 млрдIT-гигант Meta✴ занялся строительством кампуса ЦОД гигаваттного масштаба в Индиане. Компания анонсировала начало работ в городке Лебаноне (Lebanon), расположенном приблизительно в 47 км от Индианаполиса (Indianapolis). Общий объём инвестиций превысит $10 млрд, которые пойдут на инфраструктуру ЦОД и поддержку местных жителей. По словам компании, это одна из крупнейших инфраструктурных инвестиций компании на сегодняшний день. Судя по рендерам, на площадке планируется строительство около дюжины зданий различных размеров. На пике строительства потребуется 4 тыс. рабочих и прочих сотрудников, на постоянной основе для обслуживания ЦОД потребуется около 300 человек. С этой целью в близлежащем округе будет реализована программа подготовки новых кадров. Сообщается, что кампус будет использовать эффективную систему жидкостного охлаждения замкнутого цикла, так что потребление питьевой воды в течение года будет минимально. Электропитание будет осуществляться за счёт «чистой» энергии. В 2024 году компания получила у местных властей разрешение на строительство, а также налоговые льготы.

Источник изображения: Meta✴ Meta✴ отмечает, что будет полностью оплачивать затраты на электропитание своих дата-центров, и намерена тесно сотрудничать с коммунальными компаниями, чтобы планировать энергорасходы на годы вперёд таким образом, что присутствие компании в штате не оказало негативного влияния на местных жителей. Компания не только планирует полностью компенсировать потребление энергии кампусом, но и намерена «восстанавливать» 100 % потребляемой ей в Лебаноне воды. Всего на водоснабжение и прочую инфраструктуру в городе будет потрачено $120 млн. Новый кампус — уже вторая площадка, планируемая Meta✴ в Индиане. Компания уже строит кампус в Джефферсонвилле (Jeffersonville), на границе с Кентукки — на другом берегу реки расположен крупнейший в Кентукки город Луисвилл (Louisville). Анонсированный в 2024 году кампус в Джефферсонвилле площадью 250 га предусматривает затраты в размере $800 млн на строительства около 65 тыс. м2 площадей ЦОД в технопарке River Ridge Commerce Center. Первые объекты уже готовы, компания устанавливает в них серверные стойки. По всему миру Meta✴ имеет 30 действующих и строящихся кампусов, несколько площадок гигаваттного масштаба строится в США. Главная — Hyperion в Луизиане, после завершения строительства её совокупная мощность может составить более 5 ГВт. Недавно компания купила для расширения кампуса ещё один участок земли площадью 567 га в дополнение к уже имеющимся 911 га. Также до гигаваттного масштаба увеличивается действующий кампус в Огайо. В январе 2026 года глава компании Марк Цукерберг (Mark Zuckerberg) объявил о старте работы подразделения Meta✴ Compute, в рамках которой планируется сконцентрировать усилия на строительстве десятков гигаватт новых мощностей ЦОД до конца текущего десятилетия, а со временем — «сотен гигаватт» или даже больше. По оценкам Meta✴, капитальные затраты в 2026 году должны составить $115–$135 млрд, ранее сообщалось, что компания потратит $600 млрд на дата-центры в США к 2028 году.

12.02.2026 [12:59], Руслан Авдеев

Французская Mistral AI вложит €1,2 млрд в строительство шведского ИИ ЦОДФранцузский стартап Mistral AI инвестирует €1,2 млрд ($1,4 млрд) в строительство ИИ-инфраструктуры в Швеции. Компания намерена стать незаменимым поставщиком ИИ-решений для правительственных структур и крупных компаний в Евросоюзе, сообщает Bloomberg. По данным Mistral, ИИ ЦОД разместится в Бурлэнге (Borlänge) при содействии инфраструктурного провайдера EcoDataCenter AB. Объект вместит мощности, достаточные для обучения ИИ-моделей компании. Сообщается, что он должен начать работу в 2027 году. Это первая инвестиция Mistral в дата-центры за пределами Франции. Компания позиционирует создание ЦОД как меру по укреплению европейского технологического суверенитета. Поскольку политические связи с Вашингтоном ослабевают, правительства стран — участниц Евросоюза всё с большей опаской относятся к использованию облачных сервисов Amazon (AWS), Microsoft и Alphabet, пока доминирующих в сфере ИИ-инфраструктуры, хранения данных и облачных вычислений. Mistral, разрабатывающая ИИ-модели, по данным Bloomberg рассчитывает стать ответом Европы на деятельность OpenAI. С июня 2025 года компания управляет собственным облаком Mistral Compute, предоставляя полный ИИ-стек, включающий ИИ-ускорители, API и разнообразные сервисы, в том числе в формате PaaS. Утверждается, что клиентам предлагается «полностью европейский ИИ-стек» с обрабьоткой и хранением данных на месте.

Источник изображения: Mistral AI По словам главы Mistral Артура Меньша (Arthur Mensch), инвестиция — конкретный шаг на пути к строительству независимых мощностей в Европе, связанных с искусственным интеллектом. В 2025 году Mistral заявила, что намерена инвестировать в строительство дата-центра во Франции для того, чтобы отказаться от использования действующей в США инфраструктуры. После раунда финансирования сентября 2025 года, в ходе которого компания привлекла €1,7 млрд, её капитализация составила €11,7 млрд. Раунд возглавил нидерландский производитель литографического оборудования ASML Holding NV. В январе 2026 года Меньш заявил, что к концу 2026 года выручка компании долждна превысить $1 млрд. EcoDataCenter известна своими проектами высокоэкологичных ЦОД. Отношения Франции и США действительно переживают не лучшие времена. Например, в декабре 2025 года сообщалось, что Airbus перенесёт критически важные нагрузки в суверенное европейское облако. В январе 2026 года появилась информация, что французские власти пересадят госслужащих с с Zoom и Teams на суверенный видеочат Visio, а в феврале сообщили о том, что французская Capgemini продаст подразделение CGS, обслуживающее власти США.

12.02.2026 [10:27], Сергей Карасёв

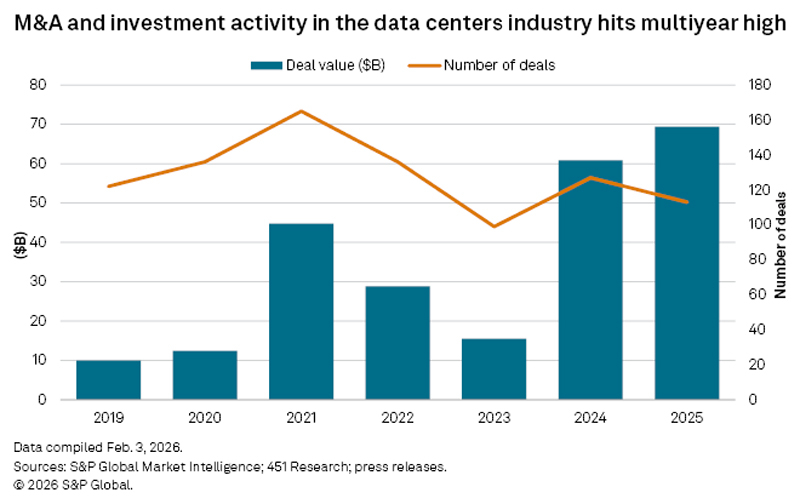

Объём сделок по слияниям и поглощениям на мировом рынке ЦОД бьёт рекордыВ 2025 году объём сделок по слияниям и поглощениям (M&A) на глобальном рынке дата-центров, согласно подсчётам S&P Global Market Intelligence, достиг $69 млрд, что является новым рекордом. Для сравнения, годом ранее общая сумма таких транзакций оценивалась в $60,8 млрд. Таким образом, зафиксирован рост на 13,5 %. Аналитики отмечают, что на фоне бума ИИ инвестиционная активность в сегменте ЦОД за последние годы резко увеличилась. Так, в 2023 году объём M&A-сделок на этом рынке находился на уровне $15 млрд. То есть, за два года расходы на слияния и поглощения подскочили более чем в четыре раза. Вместе с тем, как отмечается в исследовании, количество сделок сокращается. В 2025 году были проведены 113 транзакций M&A на рынке ЦОД, что несколько меньше по сравнению с 2024-м. Наблюдающаяся тенденция свидетельствует об увеличении средней стоимости сделок, которая в прошлом году достигла $0,61 млрд. Большинство транзакций пришлось на США и Азиатско-Тихоокеанский регион.

Источник изображения: S&P Global Market Intelligence S&P Global Market Intelligence подчеркивает, что инвестиции в сегменте ЦОД в основном сосредоточены на проектах с гарантированным электроснабжением. Дефицит энергоресурсов является одним из ключевых факторов, сдерживающих развитие глобальной инфраструктуры дата-центров. В некоторых регионах очередь на подключение ЦОД к электросетям может растягиваться на пять–семь лет. Аналитики также отмечают, что в 2025 году объем финансирования неооблачных компаний утроился по сравнению с рекордными показателями 2024-го, превысив $35 млрд. Речь идет о высокопроизводительных вычислительных платформах, ориентированных на задачи ИИ. Такие компании специализируются на сервисах GPUaaS (GPU как услуга), системах для разработки и запуска генеративного ИИ и пр.

11.02.2026 [15:53], Руслан Авдеев

Власти США «по-хорошему» призывают гиперскейлеров самим финансировать расширение ИИ-проектов, а не перекладывать затраты на жителейАдминистрация президента США продолжает продвигать развитие ИИ-проектов, в то же время стремясь ослабить недовольство граждан непомерными аппетитами ЦОД в отношении электричества и воды, а также обещая освободить крупных игроков рынка от пошлин на ИИ-ускорители. Чтобы успокоить общественность, Вашингтон предложил IT-гигантам гарантировать, что расширение их сети ЦОД в США не приведёт к резкому увеличению счетов за электричество или истощению локальных водных ресурсов, сообщает The Register. По информации Politico, предложено добровольное соглашение между президентом США Дональдом Трампом (Donald Trump) и индустрией ЦОД в лице Microsoft, Google, Amazon, Meta✴ и OpenAI, которое устанавливает принципы ответственного потребления электроэнергии, воды и отношений с жителями в местах размещения дата-центров. Новый шаг соответствует вектору предыдущих событий. Ранее президент заявил, что технологический бизнес должен сам финансировать увеличение мощности ЦОД и адаптацию для этого энергетической инфраструктуры, а не перекладывать расходы на обычных потребителей энергии. Компания Microsoft уже пошла навстречу в этом вопросе, представив проект Community-First AI Infrastructure. Кроме того, Министерство энергетики (DOE) оказало давление на оператора электросетей PJM Interconnection, чтобы та провела экстренный аукцион для компенсации роста спроса на электричество со стороны ЦОД.

Источник изображения: Gabriela/unsplash.com Это направлено на сдерживание растущего общественного недовольства появлением дата-центров по всей территории США. По данным НКО, только во II квартале были заблокированы или отложены 20 проектов строительства ЦОД в стране из-за противодействия местных сообществ. В январе 2026 года Белый дом объявил о ввозных пошлинах в размере 25 % на ИИ-ускорители, включая NVIDIA H200 и AMD MI325X, но их закупки для объектов гиперскейлеров в США пошлиной облагаться не будут. По некоторым данным, освобождение от тарифов может зависеть от политики непосредственных производителей вроде тайваньской TSMC, от которых ожидают переноса до половины своего производства в США в рамках программы «реиндустриализации» Соединённых Штатов. Недавно премьер-министр Тайваня назвал такой перенос «невозможным». Впрочем, TSMC уже выделила $165 млрд на строительство производств в Аризоне для выпуска 2-нм чипов, но пока неизвестно, устроит ли это Трампа.

11.02.2026 [13:38], Руслан Авдеев

Армения получит ещё 41 тыс. NVIDIA GB300 для ИИ ЦОД Firebird за $4 млрдАмериканская компания Firebird, специализирующаяся на облачных и инфраструктурных решениях для ИИ, объявила о реализации второго этапа суперкомпьютерного мегапроекта в Армении. Она получила экспортные лицензии США и разрешения регуляторов на поставку в страну ещё 41 тыс. ускорителей NVIDIA GB300, сообщает HPC Wire. Расширение вычислительного кластера в Армении знаменует собой важную веху. Предполагается, что страна войдёт в пятёрку мест размещения крупнейших кластеров ИИ-ускорителей. Проект стоимостью $4 млрд — одно из крупнейших капиталовложений в технологическую сферу в истории страны. Подробности в ходе визита в Ереван раскрыл вице-президент США Джей Ди Вэнс (JD Vance) при участии вице-президента NVIDIA. По словам Вэнса, США «с гордостью» одобрили замечательное техническое соглашение с NVIDIA. Речь идёт об открытии новых рынков и новых рабочих мест как для американских работников, так и для армянских. 8 августа прошлого года Армения и США подписали меморандум в сфере ИИ и полупроводников. Выданная США экспортная лицензия свидетельствует о том, что проект полностью соответствует американским требованиям. Второй этап — продолжение реализации плана Firebird, выделившей $500 млн на создание в Армении первого ИИ-кластера. Реализация двух этапов обеспечит качественный скачок в технологической инфраструктуре страны. Он позволит проводить исследования в биологии, робототехнике, космической сфере и в сфере ИИ нового поколения. По словам представителей Firebird, новый кластер превращает Армению в глобальный центр суперкомпьютерных вычислений. |

|