Материалы по тегу: ии

|

15.02.2026 [15:46], Владимир Мироненко

Legrand приобрела Kratos и инвестировала в Accelsius для расширения предложений для ИИ ЦОДLegrand, французский поставщик решений для электротехнической и цифровой инфраструктуры зданий, обслуживающей жилой, коммерческий, промышленный рынки и ЦОД, объявил о приобретении Kratos Industries из Арвады (Arvada, штат Колорадо), производителя низковольтного (НВ) и средневольтного (СВ) силового оборудования. Также Legrand сообщила об участии в раунде финансирования серии B компании Accelsius, специализирующейся на двухфазном прямом жидкостном охлаждении. «В совокупности эти шаги значительно расширяют возможности Legrand в области распределения электроэнергии и передового управления тепловыми процессами, позволяя ЦОД удовлетворять растущие потребности в ИИ и высокоплотных вычислительных средах», — отметила Legrand в пресс-релизе. «Принимая Kratos в состав Legrand, мы расширяем наши возможности по обслуживанию всей системы электропитания ЦОД, гарантируя нашим клиентам наличие единого, надёжного партнёра для всей их экосистемы электропитания», — заявила компания. Kratos использует вертикально интегрированную модель с подходом «проектирование под заказ». Благодаря её приобретению Legrand может предложить более надёжный портфель решений для критически важных систем электропитания на рынке ЦОД, охватывая весь спектр решений от кабельных лотков с нагрузочными стендами до шинопроводов и блоков распределения питания (PDU) для стоек. Что касается инвестиций Legrand в Accelsius, то в рамках партнёрства компании планируют совместные инициативы по разработке СЖО для интеграции в инфраструктуру на уровне стоек, ориентированные в ИИ-фабрики и другие высокопроизводительные вычислительные среды. Хотя большая часть бизнеса Legrand приходится на электротехнические решения для жилых и коммерческих зданий, ИИ оказал преобразующее воздействие на компанию, заявил генеральный директор Legrand Бенуа Кокар (Benoit Coquart) агентству Reuters. По его словам, на решения для ЦОД приходится 26 % выручки компании в 2025 году, и этот показатель может достичь 40 %. Выручка Legrand в 2025 году составила €9,48 млрд ($11,26 млрд, рост год к году на 9,6 %), что немного выше прогноза аналитиков, равного €9,46 млрд. Скорректированная операционная прибыль компании выросла год к году на 10,5 % до $1,96 млрд, что соответствует ожиданиям аналитиков. Legrand ожидает рост продаж в 2026 году на 10–15 %, скорректированную операционную маржу на уровне 20,5–21 %.

15.02.2026 [15:10], Сергей Карасёв

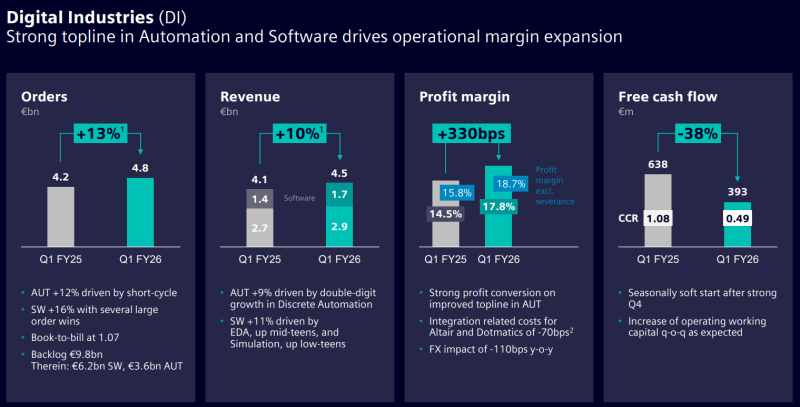

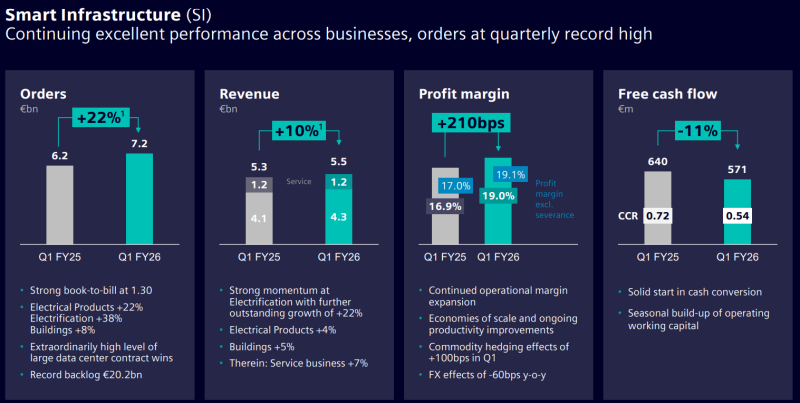

Siemens наращивает выручку и объём заказов на фоне бума ИИНемецкий конгломерат Siemens отрапортовал о работе в I четверти 2026 финансового года, которая была закрыта 31 декабря 2025-го. Выручка за трёхмесячный период достигла €19,14 млрд, что на 4 % больше по сравнению с результатом за аналогичный период предыдущего финансового года, когда было получено €18,35 млрд. Общий объём заказов в годовом исчислении увеличился на 7 % — с €20,07 млрд до €21,37 млрд. При этом чистая прибыль сократилась на 43 %, составив €2,22 млрд против €3,87 млрд годом ранее. Однако в результаты I квартала 2025 финансового года включена прибыль в размере €2,1 млрд евро (после уплаты налогов) от продажи Innomotics — подразделения по производству двигателей и приводов. Увеличение выручки Siemens связывает с бумом ИИ, который спровоцировал расширение глобальной инфраструктуры дата-центров. В подразделении промышленных решений Siemens Digital Industries квартальная выручка поднялась на 12 % — с €4,05 млрд до €4,53 млрд, тогда как объём заказов увеличился с €4,21 млрд до €4,85 млрд, то есть, на 15 %. В сегменте умных инфраструктур Siemens Smart Infrastructure продажи выросли на 5 % — с €5,29 млрд до €5,53 млрд, а объём заказов прибавил 16 %, достигнув €7,17 млрд против €6,20 млрд годом ранее. В целом, индустриальный бизнес Siemens в I квартале 2026 финансового года обеспечил прибыль в размере €2,90 млрд против €2,52 млрд годом ранее. Siemens ожидает, что стремительное развитие ИИ в промышленном секторе и высокий спрос на соответствующие продукты для дата-центров и платформ автоматизации продолжат оказывать положительное влияние на финансовые показатели компании. Siemens, в частности, говорит о значительной динамике в США и Китае. Кроме того, Siemens наряду наряду с Caterpillar, GE Vernova и Mitsubishi Heavy Industries выиграла от резко возросшего спроса на газовые турбины для питания ИИ ЦОД.

14.02.2026 [12:45], Владимир Мироненко

NVIDIA арендует «подсудный» ЦОД, строящийся на средства от продажи «мусорных» облигацийNVIDIA собирается арендовать дата-центр, который будут строить на средства, полученные от продажи «мусорных» облигаций (junk bond — высокодоходные ценные бумаги компании с кредитным рейтингом ниже инвестиционного уровня или без рейтинга), сообщил Bloomberg со ссылкой на информированные источники. NVIDIA не смущает даже то, что этот проект был предметом судебных разбирательств на протяжении всего 2025 года. Согласно документам, с которыми ознакомилось агентство Bloomberg, договор аренды NVIDIA рассчитан на 16 лет с возможностью продления ещё на два периода по 10 лет каждый. Речь идёт о кампусе мощностью 200 Вт, строящемся компанией Fleet Data Centers, входящей в состав Tract Capital, в округе Стори (штат Невада). Fleet Data Centers продаст облигации на сумму $3,8 млрд для финансирования части строительства ЦОД. Сообщается, что в четверг объём сделки по облигациям был увеличен на $150 млн, что свидетельствует о высоком спросе. По словам источников, обсуждается возможность получения доходности около 6%. Из-за низкого рейтинга, обуславливающего высокий риск, связанный с покупкой таких ценных бумаг, продавец вынужден повышать доходность, чтобы привлечь покупателей. Fleet Data Centers была основана в январе 2026 года с целью создания крупномасштабных кампусов с приоритетом на проекты с одним заказчиком мощностью 500 МВт и более, сообщил Data Center Dynamics. Fleet 1 — это первый фонд компании, созданный в рамках SV RNO Property Owner 1. Ожидалось, что Fleet 1 внесет в проект около $620 млн, а средства от продажи облигаций в размере $3,8 млрд будут использованы для финансирования строительства. Как сообщает Bloomberg, средства от дополнительного заёмного капитала по облигационной сделке будут использованы для уменьшения суммы собственного капитала Fleet 1. В сделке также участвуют JPMorgan Chase & Co., возглавляющая сделку, совместно с Morgan Stanley и другими банками. В состав Tract Capital входит компания Tract, базирующаяся в Колорадо и основанная бывшим генеральным директором Cologix Грантом ван Ройеном (Grant van Rooyen). Tract приобретает, зонирует, получает разрешения и развивает «комплексно спланированные» кампусы ЦОД. Компания объявила о планах по развитию территории в округе Стори в октябре 2023 года, а в июне 2024 года приобрела дополнительные участки земли, в результате чего общая площадь её земельных владений в этом регионе превысила 4,45 га. Проект стал предметом судебного спора со Switch из-за его близости к её кампусу. Согласно соглашению Switch с властями, в этом районе запрещается строительство колокейшн-ЦОД. Tract утверждает, что строящийся ЦОД представляет собой объект для одного арендатора, облачного клиента или оптовой продажи мощностей, и, следовательно, не нарушает условий соглашения. NVIDIA управляет собственными ЦОД, а также арендует вычислительные мощности у облачных провайдеров, таких как AWS и Microsoft Azure. Компания также заключила соглашения аренды с неооблаками, включая CoreWeave и Lambda.

14.02.2026 [12:12], Сергей Карасёв

Сделано в Японии: Fujitsu организует производство суверенных ИИ-серверовКорпорация Fujitsu с марта текущего года начнёт выпускать в Японии суверенные серверы, ориентированные на задачи ИИ и другие ресурсоёмкие нагрузки. Такие системы с маркировкой «Made in Japan» будут выпускаться на предприятии Fujitsu Group в Касасиме (Kasashima) по полному циклу. Fujitsu отмечает, что геополитическая напряжённость, усиливающиеся киберугрозы и более жёсткие требования регулирующих органов приводят к необходимости усиления защиты критически важной информации. В Японии, в частности, в рамках Закона о содействии экономической безопасности управление системными рисками и цифровой суверенитет имеют первостепенное значение для клиентов, работающих с критической информационной инфраструктурой (КИИ). С целью удовлетворения растущего спроса на суверенные решения Fujitsu организует в Японии выпуск серверов, оборудованных ускорителями NVIDIA HGX B300 и NVIDIA RTX Pro 6000 Blackwell Server Edition. Кроме того, до конца 2026 финансового года (заканчивается 31 марта 2027-го) корпорация освоит производство систем на основе фирменных чипов Fujitsu Monaka, которые насчитывают до 144 вычислительных ядер с архитектурой Arm.

Источник изображения: Fujitsu Подчёркивается, что при изготовлении суверенных серверов завод Fujitsu Group будет использовать опыт, полученный при создании суперкомпьютера Fugaku и других высоконадёжных систем. Интегрированный процесс производства охватывает все этапы — от получения печатных плат до сборки устройств, что обеспечит полную отслеживаемость и прозрачность. Продукцию «Made in Japan» планируется поставлять на местный рынок, а также европейским заказчикам. Кром того, Fujitsu расширит сотрудничество с Supermicro для обеспечения непрерывного планирования, разработки, производства, продаж и технического обслуживания ИИ-серверов. В конце 2020 года «белую сборку» серверов наладила в США HPE. Эти машины тоже ориентированы в первую очередь на заказчиков из госсектор, а не обычных потребителей.

13.02.2026 [23:25], Андрей Крупин

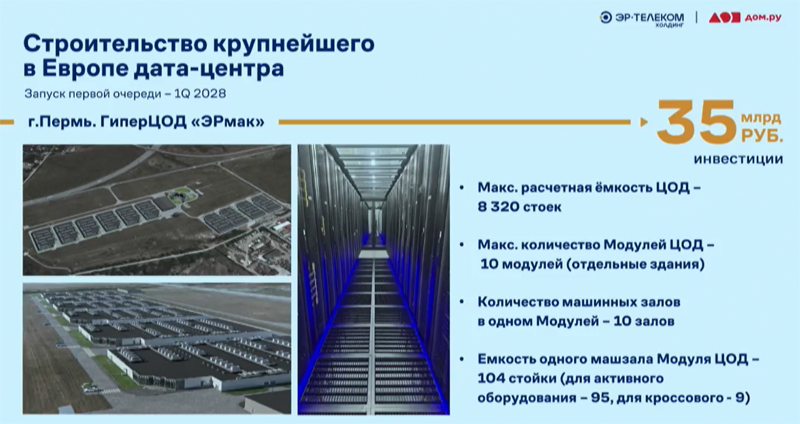

«ЭР-Телеком Холдинг» инвестирует более 100 млрд рублей в строительство дата-центров и не толькоТелекоммуникационный оператор «ЭР-Телеком Холдинг» намерен до 2030 года инвестировать 100 млрд руб. в развёртывание сети дата-центров. Об этом заявил глава компании Андрей Кузяев в ходе своего выступления на Пермском экономическом конгрессе. Согласно озвученной президентом «ЭР-Телеком Холдинга» стратегии, компания планирует строительство двух крупных ЦОД в Москве и Перми мощностью 50 МВт каждый. Также предполагается ввод в эксплуатацию восьми региональных вычислительных комплексов мощностью от 3 до 10 МВт. По словам г-на Кузяева, наиболее крупным объектом станет модульный ЦОД «ЭРмак» в Перми с максимально расчётной ёмкостью 8320 стоек. Инвестиции в реализацию этого проекта, предполагающего строительство 10 модулей (отдельных задний), составят 35 млрд руб. Запуск первой очереди дата-центра запланирован на 1 квартал 2028 года.

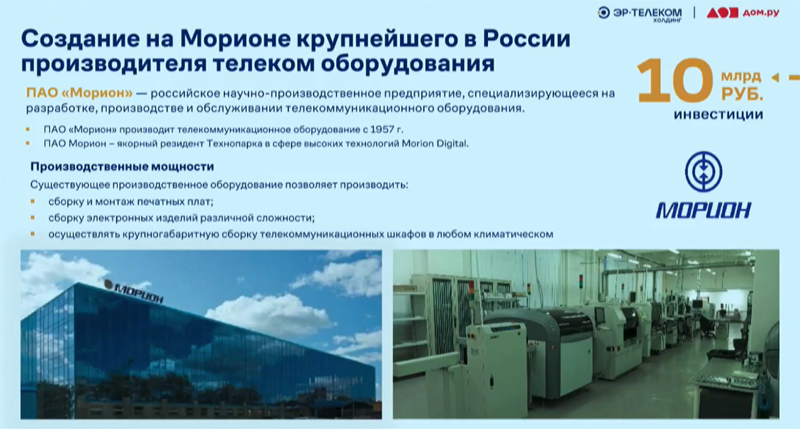

Компания Linx входит в состав «ЭР-Телеком Холдинга» (здесь и далее источник изображений — economcongress.ru) В числе прочего «ЭР-Телеком Холдинг» намерен вложить 10 млрд руб. в создание крупнейшего в России производителя телекоммуникационного оборудования. Новое предприятие будет развёрнуто на базе ПАО «Морион», расположенного в Перми и занимающегося разработкой, производством, монтажом и обслуживанием телекоммуникационного оборудования.

Характеристики будущего ЦОД «ЭРмак» в Перми Также главой компании было озвучено о планах «ЭР-Телеком Холдинга» инвестировать 50 млрд руб. в развитие гигабитной сетевой инфраструктуры на территории РФ. Столь значительные финансовые вложения в строительство дата-центров и коммуникаций Андрей Кузяев объяснил активным развитием технологий искусственного интеллекта, требующих значительных вычислительных мощностей и высоких скоростей передачи данных.

Стратегия «Эр-Телеком Холдинга» предполагает значительные инвестиции в производителя телеком-оборудования «Морион» «ЭР-Телеком Холдинг» работает в телекоммуникационной сфере 25 лет. Компания была основана в столице Пермского края в 2001 году и занимается предоставлением услуг связи частным лицам (бренд «Дом.ру») и корпоративным заказчикам. Также холдинг известен как разработчик комплексных IT-решений, связанных с технологиями промышленного интернета вещей, интеллектуального видеонаблюдения, умного города, обработки данных и прочими направлениями. В активе компании значатся 18 млн клиентов, а численность персонала насчитывает 11,8 тыс. сотрудников.

13.02.2026 [16:08], Владимир Мироненко

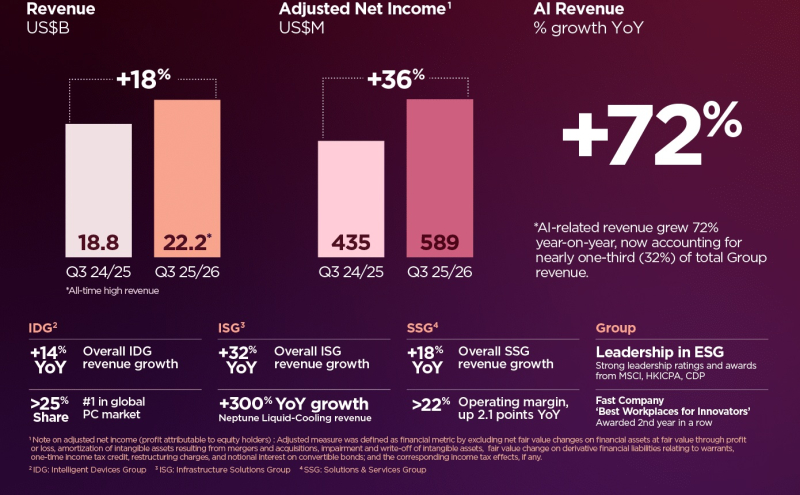

Lenovo нарастила выручку от СЖО на 300 % — здесь снова замешан ИИLenovo сообщила о проведённой реструктуризации подразделения инфраструктурных решений (Infrastructure Solutions Group, ISG), которое специализируется на поставках оборудования для ЦОД, периферийных систем и облачных вычислениях, с целью «ускорения возвращение к прибыльности» на фоне роста спроса на ИИ-продукты во всем её портфеле, благодаря которому был достигнут двузначный рост с рекордной выручкой в III квартале. Выручка Lenovo в отчётном квартале, закончившемся 31 декабря 2025 года, достигла рекордного уровня в $22,2 млрд США, что на 18 % больше, чем годом ранее, и выше прогноза Уолл-стрит в размере $20,6 млрд (по данным Reuters). При этом выручка всех бизнес-групп выросла на двузначное число в процентах в годовом исчислении. Чистая прибыль компании снизилась на 21 % в годовом исчислении до $546 млн, что выше средней оценки аналитиков в $451,29 млн, согласно данным LSEG. Вместе с тем скорректированная чистая прибыль (Non-HKFRS) выросла на 36 % до $589 млн. Lenovo отметила, что ИИ является её ведущим двигателем роста на протяжении многих лет: выручка от ИИ за квартал выросла на 72 % в годовом исчислении и составила почти треть (32 %) от общей выручки компании, чему способствовал высокий спрос на устройства, инфраструктуру, услуги и решения на основе ИИ. Компания сообщила, что реструктуризация ISG, которая обошлась в $285 млн, была проведена с целью «перестройки структуры затрат» бизнес-подразделения. Сообщается, это было достигнуто путём «оптимизации продуктового портфеля, повышения квалификации персонала и обеспечения устойчивого повышения производительности». Как ожидается, эти меры обеспечат ежегодную экономию более $200 млн в течение следующих трёх лет и ускорят трансформацию ISG в сторону прибыльного и устойчивого роста. Подразделение ISG отчиталось о рекордной выручке в $5,2 млрд, выросшей в годовом исчислении на 31 %. Значительный рост был достигнут благодаря увеличению рынка поставщиков облачных услуг (CSP), расширяющейся клиентской базе, трансформации предприятий и малого и среднего бизнеса, а также ускоренному росту продаж ИИ-серверов, достигнувшему «высоких двузначных показателей» в процентах. Выручка от СЖО Neptune увеличилась на 300 % в годовом исчислении благодаря более широкому внедрению решений клиентами в сегментах операторов связи, предприятий и малого и среднего бизнеса. В то же время операционный убыток подразделения составил $11 млн, что, по словам Lenovo, представляет собой «последовательное улучшение на $21 млн», поскольку ISG приближается к своей цели — достижению точки безубыточности к концу финансового года, который заканчивается в конце марта. Компания заявила, что ISG «имеет хорошие возможности для использования долгосрочного потенциала роста, особенно по мере того, как спрос на ИИ смещается от обучения к инференсу». При этом Lenovo ожидает, что рынок ИИ-инфраструктуры утроится к 2028 году. С момента приобретения у IBM бизнеса по выпуску x86-серверов, который стал основой ISG, прошло уже 11 лет, но Lenovo так и не удалось «стабилизировать» прибыльность подразделения. Подразделение решений и услуг Lenovo SSG увеличило по итогам III финансового квартала выручку на 18 % в годовом исчислении до $2,7 млрд — это 19-й квартал подряд роста выручки в годовом исчислении — при этом операционная маржа выросла на 2,1 п.п. год к году до более чем 22 %. Рост ускорился в целевых вертикальных отраслях, включая производство, розничную торговлю, спорт, транспорт и умные города благодаря более широкому использованию ИИ.  В отчётном квартале структура доходов подразделения продолжала смещаться в сторону областей с высоким темпом роста. Управляемые услуги и решения вместе принесли почти до 60 % от общей выручки SSG, что отражает подход, ориентированный на услуги, в гибридных ИИ-средах. В таких областях, как услуги цифрового рабочего места, гибридное облако, ИИ и устойчивое развитие, SSG растёт вдвое быстрее, чем рынок, сообщила Lenovo. Также наблюдался рост выручки от предложений Lenovo TruScale по предоставлению устройств как услуги и инфраструктуры как услуги (DaaS и IaaS), что, по словам компании, «обусловлено рабочими нагрузками на основе GPU и ИИ, поскольку клиенты отдают приоритет гибкости, масштабируемости и более быстрой окупаемости инвестиций». Подразделение Intelligent Devices Group (IDG) увеличило выручку на 14 % в годовом исчислении до $15,8 млрд, несмотря на рост стоимости компонентов, включая память, и увеличения затрат на производство компьютеров. После публикации отчёта Lenovo её акции упали на 6,3 %, что говорит о том, что рынок меньше сосредоточен на динамике выручки и больше обеспокоен ростом стоимости памяти, который оказывает давление на прибыльность по всей цепочке поставок электроники, пишет ресурс GuruFocus.

13.02.2026 [14:00], Андрей Крупин

От «можем заменить» к «инженерной трезвости»: российские разработчики пересматривают подходы к импортозамещениюОтечественный IT-сегмент перешёл от лозунга «можем всё заменить» к «инженерной трезвости». Об этом свидетельствует проведённый OCS Distribution опрос игроков рынка, результаты которого были озвучены в рамках прошедшего в Москве технологического форума «IT-Ось 2026». Исследование проводилось осенью 2025 года и охватило более 100 российских вендоров — производителей оборудования и разработчиков программного обеспечения. Согласно представленным OCS Distribution данным, доля российских компонентов в продуктах отечественных вендоров в среднем составляет 55–60 %. При этом степень локализации во многом зависит от типа решения: у ПО она составляет 77 %, у «железа» — 40 %. В перспективе разработчики софта намерены либо сохранить текущий уровень, либо увеличить его незначительно — на 10–20 %. Среди производителей IT-оборудования практически каждая вторая компания (43 %) собирается наращивать долю отечественных компонентов.

Источник изображения: OCS Distribution / ocs.ru «Разработчики софта имеют высокие показатели локализации, поэтому большинство намерено сохранить текущий уровень или немного увеличить его. У производителей оборудования несколько иная ситуация. Им есть куда расти. Однако возможностей для импортозамещения компонентов становится всё меньше — об этом прямо говорит практически каждый третий вендор "железа"», — говорит OCS Distribution. В производстве вычислительного, телекоммуникационного и прочего высокотехнологичного оборудования для дальнейшей локализации уже требуются значительные инвестиции в R&D. В настоящий момент темпы локализации определяет не стратегия компании, а объективные технологические и индустриальные ограничения. «Следующий рывок требует объединения усилий разных участников IT-рынка. Нужны не просто партнёрства, а большие технологические альянсы, которые позволят создавать спрос на российские базовые технологии и поддерживать его на необходимом для окупаемости уровне. Дистрибьюторы, например, как держатели инженерной экспертизы и глубокой продуктовой аналитики могут координировать этот процесс», — говорит OCS.

13.02.2026 [13:18], Руслан Авдеев

ECL представила всеядную энергетическую архитектуру для периферийных ИИ ЦОДКомпанией ECL (EdgeCloudLink) анонсирована платформа FlexGrid. Речь идёт об энергетической архитектуре, позволяющей развёртывать ИИ ЦОД высокой плотности в локациях с ограниченными возможностями питания. Решение предлагается как способ масштабирования инфраструктуры инференса за пределы крупных кампусов, в которых осуществляется обучение ИИ-моделей — в городские агломерации, периферийные локации и промзоны, где зачастую доступно не более 50–100 МВт, сообщает Converge Digest. FlexGrid обеспечивает модульное развёртывание на площадках мощностью от 2–10 МВт с возможностью масштабировать подключение до 20–25 МВт на объект с помощью интеграции дополнительных, локальных источников энергии различного происхождения. Основа платформы — патентованная система управления питанием ECL, позволяющая объединять несколько источников энергии, включая классические электросети, водородные топливные элементы, генераторы на природном газе, возобновляемые источники и дизельные генераторы. В результате обеспечивается унифицированная подача постоянного или переменного тока. В отличие от традиционных дата-центров, в норме использующих один тип источников энергии, FlexGrid позволяет менять источники энергии или добавлять к ним новые без изменения базовой энергетической инфраструктуры объектов.

Источник изображения: ECL ECL утверждает, что это позволяет оперативно реагировать на региональные энергетические ограничения, изменения политики энергоснабжения на местах и дефицит топлива, при этом сохраняя стабильное качество электропитания ИИ-инфраструктуры. ECL подчёркивает, что FlexGrid разработана для «нормализации» подачи энергии из любых локальных источников и надёжного энергоснабжения ИИ-объектов в условиях ограничений сетевой энергоинфраструктуры. Пока конкуренты стремятся обеспечить себе мощности от 50 МВт для обучения, ECL работает на обозримую перспективу, делая ставку на периферийные объекты, где жизненно важным становится возможность агрегации и управления питанием таким образом, чтобы обеспечить гибкий выбор площадок и быстрый ввод объектов в эксплуатацию. Летом 2026 года сообщалось, что ECL напечатала свой первый модульный дата-центр, работающий от водородных элементов питания. В сентябре того же года появилась информация, что компаняи построит гигантский «зелёный» ЦОД TerraSite-TX1, а первым арендатором станет ИИ-облако Lambda. Годом позже вышла новость о том, что Lambda и ECL впервые запитали NVIDIA GB300 NVL72 от водорода, но теперь стартап перешёл к более универсальным решениям.

13.02.2026 [11:44], Руслан Авдеев

Anthropic закрыла раунд финансирования на $30 млрд, подняв капитализацию до $380 млрдВсего через полгода после закрытия раунда инвестиций на $13 млрд, Anthropic PBC анонсировала привлечение ещё $30 млрд. В общей сложности оценка капитализации компании составила $380 млрд, сообщает Silicon Angle. Новый раунд возглавили сингапурский суверенный фонд Government of Singapore Investment Corporation (GIC) и Coatue. К ним присоединились более 30 других структур, включая NVIDIA и Microsoft. В ноябре 2025 года эти два техногиганта обязались совместно инвестировать до $15 млрд в Anthropic, и отчасти выполнили своё обещание в ходе нового раунда привлечения средств. Помимо прочих, по данным CNBC, приняла участие и государственная компания MGX из ОАЭ, хотя в целом Anthropic относится к партнёрству с Ближним Востоком скорее негативно. Anthropic заявляет, что годовая регулярная выручка компании (ARR) достигла $14 млрд в результате того, что продажи в течение трёх последних лет каждый год росли на порядок. Драйвером этого роста отчасти выступил спрос со стороны крупных компаний. По данным Anthropic, более 500 клиентов платят не менее $1 млн ежегодно за её продукты. ИИ-ассистент Claude Code, представленный Anthropic в прошлом году и призванный помогать разработчикам ПО, также стал важным драйвером роста бизнеса компании. ARR для него удвоился с начала года, составив $2,5 млрд. На корпоративных клиентов приходится более половины этой суммы. На прошлой неделе Anthropic обновила ассистента, добавив функцию «агентных команд» (agent teams), распределяющую сложные задачи по программированию между многочисленными инстансами Claude Code, работающими параллельно, что позволяет решать вопросы намного быстрее, чем при последовательном выполнении. Это — часть более обширного обновления, основным событием которого стала премьера Claude Opus 4.6. Новейшая версия флагманской ИИ-модели Anthropic может обрабатывать до миллиона токенов за раз. Это означает, что Claude Code, имеющий «под капотом» Claude Opus 4.6, может анализировать до 75 тыс. строк разом. Claude Opus 4.6 также лучше предшествующей модели при выполнении других задач. Модель поставила новый рекорд в бенчмарке GDPval-AA, затрагивающем сферы применения вроде финансов, производства и юриспруденции. Дополнительно модель опередила соперниц в отдельном бенчмарке, который оценивает возможность ИИ-агентов проводить исследования. В компании заявляют, что новые средства потратят на финансирование проектов разработки новых моделей. Часть капитала пойдёт на «расширение инфраструктуры», вероятно — на проект строительства ЦОД за $50 млрд, анонсированный в 2025 году. Первые объекты должны заработать в Техасе и Нью-Йорке в 2026 году. Компания строит дата-центры при сотрудничестве с Fluistack. Разработчик также взаимодействует с AWS в расширении инфраструктуры. В прошлом году AWS открыла кампус ЦОД за $11 млрд, специально построенный для выполнения задач Anthropic. Стартап также намерен инвестировать в энергетическую инфраструктуру для поддержки строительства ЦОД. Ранее на этой неделе Anthropic обязалась компенсировать расходы, необходимые для модернизации сетей, выделяемых для её ЦОД и не допускать повышения тарифов из-за их строительства. Впрочем, всё это не касается мощностей, арендуемых компанией, а таковых большинство. Последний раунд позволил привлечь только часть из $50 млрд, которые компания намерена потратить на инфраструктурные проекты. Так что Anthropic потребуется ещё больше денег в обозримом будущем. Быстрый рост компании, вероятно, станет важным элементом при обращении к инвесторам — по слухам, она рассчитывает, что ежегодная регулярная выручка более чем удвоится до $30 млрд к концу года.

13.02.2026 [10:50], Сергей Карасёв

Xinnor представила All-Flash платформу хранения xiNAS для задач ИИ и НРСКомпания Xinnor анонсировала платформу xiNAS — это высокопроизводительное решение для хранения данных, ориентированное на задачи ИИ, НРС и другие ресурсоёмкие рабочие нагрузки. Изделие, относящееся к классу All-Flash, поддерживает линейное масштабирование пропускной способности по мере добавления узлов. xiNAS объединяет программный RAID-движок Xinnor xiRAID с оптимизированной файловой системой XFS и высокопроизводительным транспортным протоколом NFS over RDMA. По заявлениям разработчика, такая комбинация позволяет максимизировать быстродействие базового оборудования. В качестве последнего могут использоваться серверы Supermicro. Тестирование осуществлялось на машине Supermicro AS-1116CS-TN типоразмера 1U, оборудованной одним процессором AMD EPYC 9004 Genoa, DPU NVIDIA BlueField-3 и 12 накопителями NVMe с интерфейсом PCIe 5.0. Пропускная способность на операциях чтения составила до 74,5 Гбайт/с, на операциях записи — до 39,5 Гбайт/с. При использовании двухузловой конфигурации показатели повысились до 117 и 79,6 Гбайт/с соответственно.

Источник изображений: Xinnor Среди преимуществ платформы xiNAS компания Xinnor выделяет отсутствие проприетарного клиентского ПО, что обеспечивает простоту развёртывания и интеграции. Благодаря xiRAID достигаются высокий уровень защиты данных и стабильность работы при сбоях.  В качестве возможных конфигураций xiNAS приводятся серверы формата 1U и 2U, оснащённые соответственно процессором AMD EPYC 9384X с 32 ядрами и EPYC 9474F с 48 ядрами. Оба устройства располагают 128 Гбайт оперативной памяти и адаптерами ConnectX-7 на 400 Гбит/с (одна и две штуки). Младшая версия несёт на борту 10 накопителей Kioxia CM7-R стандарта E3.S (PCIe 5.0) на 15 Тбайт каждый и два таких же SSD на 2 Тбайт. Пропускная способность системы при последовательном чтении достигает 45 Гбайт/с, при последовательной записи — 20 Гбайт/с. Сервер в 2U-корпусе оборудован 18 накопителями Micron 7450 стандарта U3 (PCIe 5.0) на 15 Тбайт и двумя SSD Micron 7450 E3.S вместимостью 3 Тбайт. Заявленная пропускная способность при последовательном чтении — до 90 Гбайт/с, при последовательной записи — до 45 Гбайт/с. |

|