Материалы по тегу: hardware

|

20.02.2026 [15:23], Владимир Мироненко

Anthropic планирует увеличить к 2029 году расходы на облака до $80 млрдК 2029 году затраты на облачные сервисы ИИ-стартапа Anthropic, согласно его собственным прогнозам, достигнут $80 млрд, сообщил ресурс The Information со ссылкой на свои источники. Расходы будут распределены между Google, Microsoft и Amazon. Помимо оплаты аренды серверов для моделей Claude, Anthropic также делится с облачными провайдерами частью прибыли от продаж своих ИИ-сервисов на их платформах. The Information сообщил со ссылкой на данные стартапа, что в 2024 году эта сумма составила $1,3 млн, и, согласно «самым оптимистичным прогнозам» ресурса, в 2025 году она составила $360 млн, в 2026 году вырастет до $1,9 млрд, а в 2027 году — до $6,4 млрд. Также, по словам источника, Anthropic отчисляет клиентам до 50 % своей валовой прибыли от продаж ИИ-решений на AWS, рассчитываемой на основе выручки за вычетом расходов на облачные ресурсы. Для сравнения, Google обычно получает от 20 % до 30 % чистой выручки после вычета затрат на инфраструктуру от перепродажи ПО своих партнёров. Как утверждает генеральный директор Anthropic Дарио Амодеи (Dario Amodei), компания тратит меньше средств на вычислительные мощности ЦОД по сравнению с другими компаниями в сфере ИИ. Он отметил, что чрезмерные расходы могут быть «разорительными» в случае, когда выручка не гарантирована. Anthropic давно пользуется услугами Google Cloud, и в октябре прошлого года заключила сделку, обеспечивающую ей доступ к облачным ресурсам провайдера мощностью более 1 ГВт с возможностью использования до 1 млн TPU от Google. С этим проектом может быть связана сделка Anthropic по поводу $50 млрд инвестиций в вычислительную инфраструктуру в США в сотрудничестве с Fluidstack. Кроме того, у Anthropic очень тесные отношения с AWS, которая много инвестировала в стартап и развернула для него один из крупнейших в мире ИИ-кластеров Project Rainier. Наконец, в прошлом году компания подписала крупное соглашение с Microsoft Azure.

20.02.2026 [12:10], Сергей Карасёв

StorONE обещает повысить экономическую эффективность использования SSD в девять разКомпания StorONE анонсировала программу 9x ROI on Flash (девятикратная окупаемость инвестиций во флеш-память), которая призвана повысить экономическую эффективность использования SSD в рамках платформ хранения данных. Данная инициатива является ответом на сформировавшийся дефицит чипов NAND, который приводит к росту стоимости твердотельных накопителей. Идея 9x ROI on Flash заключается в применении специального ПО для интеллектуального перераспределения файлов между различными уровнями. В частности, важные «горячие» данные хранятся на дорогих SSD, которые обеспечивают быстрый доступ и высокие скорости чтения/записи. Вместе с тем «холодные» данные, которые используются нечасто или вообще архивируются, переносятся на менее производительные, но в то же время более доступные HDD. В результате, обеспечивается оптимальный баланс между быстродействием и стоимостью СХД. В отличие от подходов, основанных на дедупликации или сжатии, решение StorONE повышает эффективность благодаря автоматическому перераспределению информации между уровнями в реальном времени в зависимости от выполняемых задач и характера доступа. Таким образом, не создаётся дополнительная нагрузка на ресурсы CPU и памяти, связанная с компрессией. Генеральный директор StorOne Гал Наор (Gal Naor) отмечает, что предложенная система направлена на устранение узкого места, связанного с использованием флеш-памяти, и предоставление организациям возможности эффективно наращивать ресурсы хранения без чрезмерных затрат на закупку SSD. Технология доступна в рамках программной платформы StorONE v3.9. Нужно отметить, что схожие решения предлагают и другие компании. Так, VDURA недавно анонсировала инициативу Flash Relief Program, которая призвана снизить общую стоимость владения (ТСО) платформами хранения благодаря использованию гибридной архитектуры на основе SSD/HDD. Утверждается, что по ёмкости и быстродействию такие хранилища не уступают массивам VAST Data и WEKA при значительно меньших финансовых затратах.

20.02.2026 [00:40], Владимир Мироненко

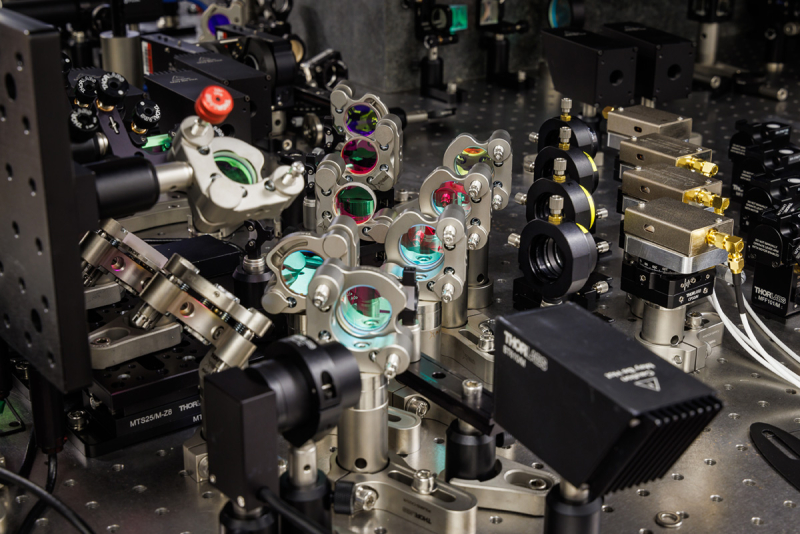

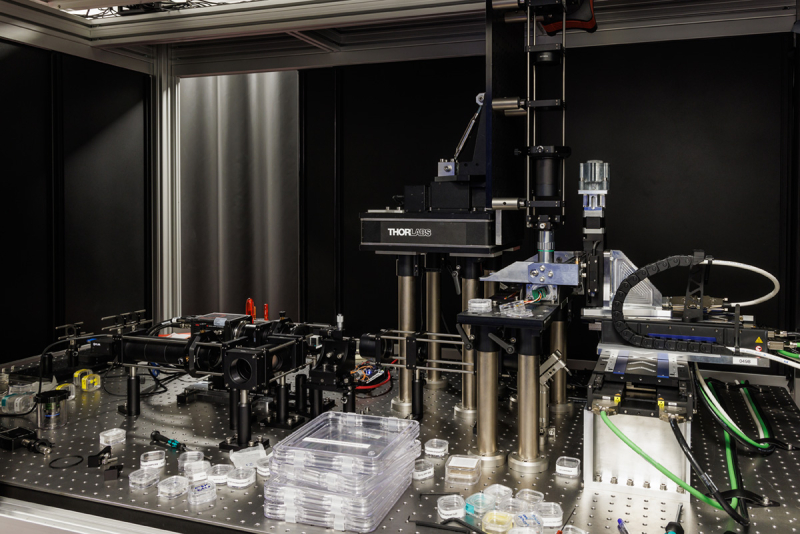

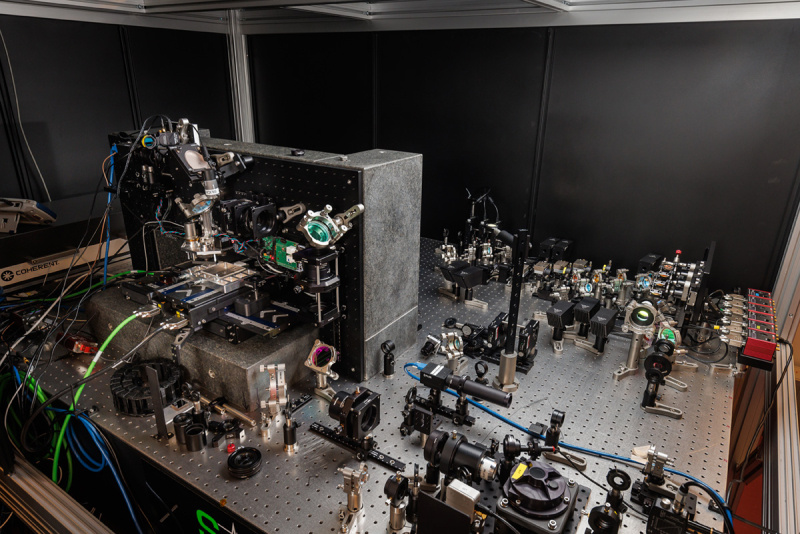

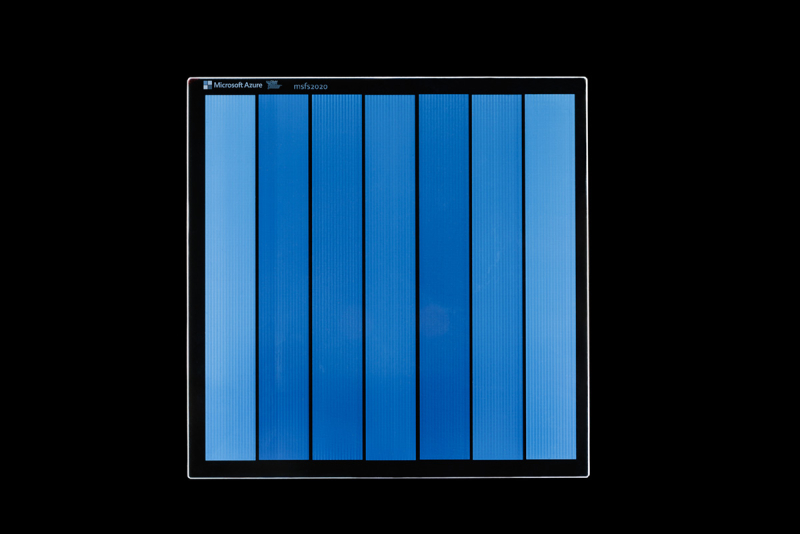

Microsoft ускорила и удешевила стеклянные хранилища Project Silica, но о практическом внедрении речи пока нетMicrosoft сообщила о важном прорыве, достигнутом в рамках проекта Project Silica, нацеленного на объёмную запись данных в стеклянных пластинах с применением фемтосекундных лазеров для длительного хранения информации. Специалисты компании работают над реализацией этой концепции с 2019 года. Согласно опубликованной в журнале Nature статье, новая технология позволяет применять для записи данных вместо дорогостоящего кварцевого стекла обычное боросиликатное. Это стекло используется для изготовления кухонной посуды и в дверцах духовок. В ходе испытаний специалистам Microsoft удалось записать 258 слоев данных общим объёмом примерно 2,02 Тбайт на пластину из боросиликатного стекла площадью 120 мм2 толщиной 2 мм со скоростью 18,4–65,9 Мбит/с, в зависимости от количества используемых лазерных лучей. Максимальная скорость значительно выше, чем 25,6 Мбит/с, достигнутые с использованием кварцевого стекла, но при этом плотность записи значительно меньше — 2,02 Тбайт против 4,84 Тбайт на пластину. Также учёным удалось сократить количество камер, необходимых для считывания данных с пластин, с трёх–четырёх до всего одной. Кроме того, записывающие устройства требуют меньшего количества деталей, что упрощает их изготовление и калибровку, а также позволяет быстрее кодировать данные. Скорость записи 65,9 Мбит/с была достигнута при использовании четырёх лазерных лучей. Сообщается, что возможна запись с использованием 16 лучей (и даже более), что подразумевает скорость от 263,6 Мбит/с. Это составляет 33 Мбайт/с, что значительно медленнее, чем предельная скорость записи несжатых данных на ленту LTO-10, равная 400 Мбайт/с (1000 Мбайт/с в сжатом виде), отметил Blocks & Files. Менеджер по работе с партнёрами Ричард Блэк (Richard Black) рассказал в блоге о том, что компания совершила ряд ключевых научных открытий. В частности, для используемого ранее типа хранения данных в кварцевом стекле с применением двулучепреломляющих (т.е. поляризационных) вокселей был разработан метод, позволяющий уменьшить количество импульсов, используемых для формирования вокселя, с многих до всего двух. Также специалисты изобрели новый тип хранения данных в стекле, называемый фазовыми вокселями, при котором модифицируется фаза, а не поляризация. При этом для создания фазового вокселя достаточно всего одного импульса. И хотя фазовые воксели показали большую склонность к межсимвольной интерференции, это можно эффективно компенсировать с помощью моделей классификации на основе машинного обучения. «Ключевым системным решением для будущей системы Silica является выбор между двулучепреломляющими и фазовыми вокселями… Эффективное формирование двулучепреломляющих вокселей может быть достигнуто только в высокочистых кварцевых стеклах, тогда как фазовые воксели могут быть записаны потенциально в любой прочной прозрачной среде, например, в боросиликатном стекле», — сообщила компания. Помимо сокращения количества лазерных импульсов, необходимых для записи данных на пластины, Microsoft также удалось увеличить количество параллельно записываемых вокселей, объединив математическую модель предварительного и последующего нагрева внутри стекла с многолучевой системой доставки, что значительно повысило скорость передачи данных. Специалисты также создали новый неразрушающий оптический метод для определения старения вокселей. Microsoft провела ускоренный тест на старение, чтобы экстраполировать срок службы носителя. В случае использования боросиликатного стекла он составляет порядка 10 тыс. лет. «Мы демонстрируем, что Silica — это жизнеспособная система хранения данных, полностью восстанавливая пользовательские данные с помощью FEC (прямой коррекции ошибок), и показываем с помощью экспериментов по ускоренному старению, что наши модификации сохраняют свои свойства более 10 000 лет при комнатной температуре. Короче говоря, наши результаты показывают, что Silica может стать решением для архивного хранения данных в цифровую эпоху», — подытожила компания. Вместе с тем заявления о подготовке к коммерциализации технологии не последовало. Блэк лишь сообщил в блоге: «Этап исследований завершён, и мы продолжаем учитывать опыт проекта Silica, изучая сохраняющуюся потребность в устойчивом, долгосрочном сохранении цифровой информации».

19.02.2026 [17:44], Руслан Авдеев

Глубоко копают: Google заказала ещё 150 МВт геотермальной энергии для своих ЦОДПотребление электроэнрегии дата-центрами стремительно выросло на фоне бума ИИ. Это вынуждает технологические компании проявлять изобретательность при добыче нового электричества. Иногда — буквально под землёй, как это сделала Google, сообщает The Register. На днях Ormat Technologies — специалист по геотермальной энергетике, объявила о договоре с NV Energy из Невады о поставке в сеть дополнительных 150 МВт для поддержки расширения кампусов ЦОД Google в регионе. Google была одной из первых гиперскейлеров, начавших использовать геотермальную энергию для компенсации углеродных выбросов от своих дата-центров. Соответствующие проекты она поддерживала с 2008 года. В 2023 году Fervo Energy, имевшая партнёрское соглашение с Google, ввела в эксплуатацию первую «усовершенствованную геотермальную электростанцию». Установка в Неваде использует жар земных недр для превращения воды в пар, подаваемый к турбинам генераторов. Основная задача — закачать воду достаточно глубоко, чтобы эффективно генерировать пар. Fervo пришлось обратиться к технологиям, применяемым в нефтегазовой отрасли, для бурения двух скважин на глубину более 2,4 км. Потом породу раскалывали, чтобы вода смогла проходить между параллельными скважинами, где она нагревалась до температуры выше 190°C.

Источник изображения: Joey Clover/unsplash.com Изначально вырабаотка составила всего 3,5 МВт, но год спустя Fervo и Google подписали дополнительное соглашение о поставке ещё 115 МВт в сеть. Этого было бы достаточно для кампуса ЦОД несколько лет назад, но для современных ИИ-объектов требуется намного больше энергии. Договор Ormat с NV Energy позволит более чем вдвое нарастить объёмы поставок «чистой» энергии в сеть, если компания получит одобрение государственных регуляторов до конца года. Ormat рассчитывает, что новые геотермальные электростанции заработают в 2028–2030 гг. и будут работать ещё минимум 15 лет. В такую энергетику инвестирует не только Google — Meta✴ уже изучала соответствующую технологию и заключила соглашения с Sage Geosystems и XGS Energy о поставке до 300 МВт геотермальной энергии. А та же Ormat недавно подписала договор с оператором ЦОД Switch. Хотя технология не лишена недостатков, по мнению экспертов, в будущем она может удовлетворить значительную часть потребностей ЦОД. В отчёте Rhodium Group утверждается, что ГеоЭС способны удовлетворить до 64 % вероятного роста энергопотребления дата-центров к началу 2030-х гг. Тем не менее, её экономическая целесообразность под вопросом. Чтобы такие проекты были выгодными, операторам ЦОД придётся платить на 20 % больше, чем за классические региональные источники энергии и надеяться, что налоговые льготы на такие виды энергии не отменят, как это уже произошло с солнечной и ветроэнергетикой. Впрочем, ЦОД такая недружелюбность пока не отпугнула.

19.02.2026 [17:07], Владимир Мироненко

Humain из Саудовской Аравии инвестировала $3 млрд в стартап xAI Илона МаскаКомпания Humain из Саудовской Аравии объявила об инвестициях в размере $3 млрд в стартап xAI Илона Маска (Elon Musk) в рамках раунда финансирования серии E на общую сумму в $20 млрд, который завершился незадолго до приобретения стартапа компанией SpaceX. Humain заявила, что в результате сделки стала «значительным миноритарным акционером» xAI. Её активы будут конвертированы в акции SpaceX — примерно 0,24 % в новой объединённой компании стоимостью $1,25 трлн, согласно оценкам Bloomberg. Humain отметила, что участие в раунде серии E укрепляет её роль как масштабного, долгосрочного стратегического инвестора, способного поддерживать компании на разных этапах роста, предоставляя при этом комплексные возможности ИИ в четырёх основных областях: дата-центры следующего поколения; высокопроизводительная инфраструктура и облачные платформы; передовые ИИ-модели; трансформационные решения в области ИИ. Инвестиции являются продолжением партнёрства, объявленного Humain и xAI в ноябре 2025 года, в рамках которого компании договорились о строительстве инфраструктуры ИИ-ЦОД мощностью 500 МВт. Ранее Humain создала совместное предприятие с AMD и Cisco для наращивания мощностей дата-центров в Саудовской Аравии. Также Humain заявила о партнёрстве с AWS с целью развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей для предоставления в дальнейшем вычислительных мощностей и ИИ-сервисов из Саудовской Аравии клиентам со всего мира. Как отметил Bloomberg, суверенные фонды Кувейта, Катара, Саудовской Аравии и ОАЭ, контролирующие более $4 трлн, сделали ИИ центральным элементом диверсификации экономики своих стран, ставших ключевыми игроками в ИИ-отрасли, готовой изменить многие аспекты повседневной жизни.

19.02.2026 [16:58], Руслан Авдеев

«Прогоревший» криптомайнер: NFN8 не пережила пожар в ЦОД, падение биткоина и переметнувшегося к OpenAI партнёраКриптомайнинговая компания NFN8 Group подала заявление о банкротстве в Техасе, все её активы выставлены на продажу. Компания ссылается на многочисленные вызовы, негативно сказавшиеся на выручке, сообщает Datacenter Dynamics, основной проблемой банкротства назван пожар в ЦОД, случившийся в 2025 году. NFN8 управляет собственными майнинговыми системами, а также продаёт оборудование сторонним компаниям с последующей обратной арендой, оплачиваемой за счёт майнинга на нём биткоинов. Компания обратилась к оператору Core Scientific для размещения таких систем в 2020 году. К концу 2022 года оператор управлял большей частью её инфраструктуры, но ровно в этот момент заявил о банкротстве. Хотя Core Scintific продолжал обслуживать некоторых майнеров, контракт с NFN8 был разорван в середине 2023 года, оставив компанию с «тысячами» активных майнинговых установок, которые нельзя было немедленно развернуть в другом месте. В случае с покупателями и арендодателями оборудования, чьи системы продолжали работать на площадках, не связанных с Core Scientific, NFN8 продолжила как его использование, так и выплаты. Арендодателей, чьё майнинговое оборудование «застряло», NFN8 уведомила о ситуации и временно приостановила платежи. Компания планировала возобновить майнинг уже на новых объектах к весне 2024 года, но в апреле произошёл халвинг биткоина. К лету 2024 года стало понятно, что выручки от майнинга не хватает для покрытия арендных платежей, операционных расходов и капитальных издержек одновременно, поэтому NFN8 приостановила некоторые выплаты до зимы 2024 года. Однако некоторые арендодатели подали иск, обвинив компанию в нарушении договоров, мошенничестве и вероятных нарушениях законодательства о ценных бумагах. NFN8 отвергла обвинения, но арбитражное разбирательство всё ещё не закончено. Не исключается, что судебные издержки и возможное неблагоприятное решение может привести к ещё более разрушительным для бизнеса последствиям. Core Scientific более не обслуживает компанию, теперь она арендует мощности на трёх площадках, включая одну в Кристал-Сити (Crystal City) в Техасе, где в конце 2025 года произошёл пожар. В результате майнинговые мощности и выручка NFN8 уменьшились наполовину. Теперь компания желает получить компенсации от страховой компании, но о времени начала выплат ничего не известно. Из-за пожара и надвигающегося судебного разбирательства компания была вынуждена объявить о «защите» в соответствии с главой 11 Кодекса о банкротстве США, позволяющей не продать компанию с молотка полностью, а провести её реорганизацию. Core Scientific смогла оправиться от проблем, переключившись с майнинга на ИИ и фактически обслуживая OpenAI при посредничестве CoreWeave.

19.02.2026 [15:57], Руслан Авдеев

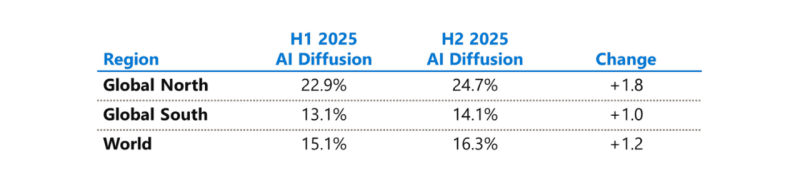

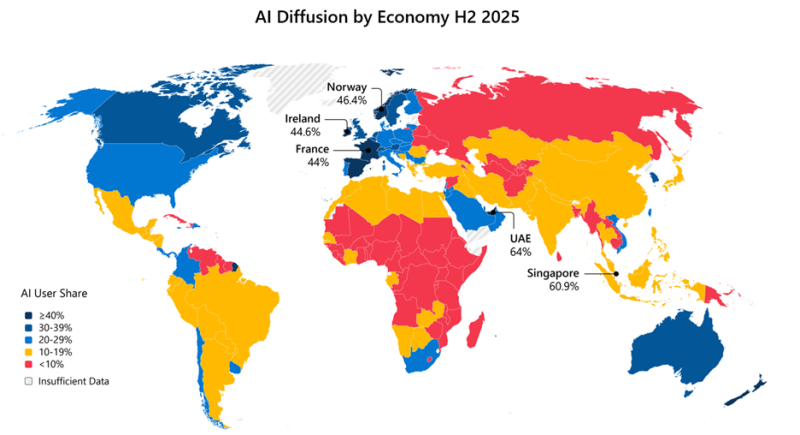

Microsoft бросилась исправлять ИИ-неравенство в мире и выделила на это $50 млрдНа недавнем мероприятии India AI Impact Summit представители Microsoft объявили, что компания готовится инвестировать к концу десятилетия $50 млрд для того, чтобы обеспечить доступ к ИИ странам Глобального Юга. Технологии искусственного интеллекта стремительно распространяются, но чрезвычайно неравномерно в мировом масштабе. В докладе Microsoft AI Diffusion Report утверждается, что в странах Глобального Севера ИИ используется вдвое активнее, чем на юге, и неравенство продолжает увеличиваться. Это сказывается не только на национальном и региональном экономическом росте, но и перспективах развития. Более века неравный доступ к электроэнергии увеличивал экономический разрыв между Глобальным Севером и Югом. С ИИ может произойти аналогичная история. Потребности в новых технологиях требуют существенных инвестиций и больших усилий правительств, частного сектора и НКО. Выделенные Microsoft $50 млрд призваны поддержать новые возможности в странах Глобального Юга. Программа развития ИИ состоит из пяти элементов:

Инфраструктура жизненно необходима для распространения ИИ, говорит компания. ИИ требует энергии, каналов связи, вычислительных мощностей. Только в последнем финансовом году Microsoft инвестировала более $8 млрд в инфраструктуру ЦОД, обслуживающую Глобальный Юг, включая Индию, Мексику, страны Африки, Южной Америки, Юго-Восточной Азии и Ближнего Востока. В первую очередь компания стремится расширить доступ в интернет 250 млн человек в макрорегионе. Microsoft заявила, что уже помогла получить доступ в интернет 117 млн человек в Африке. Инвестиции в ИИ-инфраструктуру осуществляются с учётом необходимости обеспечения местного суверенитета, хотя не так давно компания объявила, что не может обеспечить суверенитет данных в Европе из-за особенностей американского законодательства. Microsoft заявила о создании суверенного управления в публичных облаках, частных суверенных предложениях и тесном сотрудничестве с национальными партнёрами на местах. Утверждается, что в эру ИИ вся информация остаётся в руках клиентов под их полным контролем, без передачи сторонним провайдерам. При этом Глобальный Юг требует огромных инвестиций в инфраструктуру ЦОД, энергетику и связь, что крайне затруднительно без зарубежных инвестиций, в том числе со стороны техногигантов. В числе прочего для удовлетворения этих потребностей было сформировано партнёрство Trusted Tech Alliance, объединяющее 16 ведущих технологических компаний из 11 стран с четырёх континентов.

Источник изображения: Microsoft Однако ЦОД и интернет-каналы — лишь часть необходимой инфраструктуры. Не меньшее значение имеет доступ к технологиям для школ, университетов и НКО и цифровым компетенциям. В предыдущем финансовом году Microsoft инвестировала в программы для государств Глобального Юга $2 млрд, включая гранты, пожертвования, льготы и обучающие программы. В 2025 году компания запустила инициативу Microsoft Elevate, призванную к 2028 году подготовить 20 млн дипломированных специалистов с востребованными ИИ-компетенциями. В Индии компания обучила уже 5,6 млн человек, а к 2030 году намерена довести это число до 20 млн. Компания подготовит 2 млн учителей из более 200 тыс. школ и вузов, а также оснастит 25 тыс. учебных учреждений ИИ-инфраструктурой. Ещё одно направление — создание и доработка ИИ-моделей на местных языках, поскольку локальные решения пока что хуже, чем решения на английском языке. Microsoft поддержала инвестиции в инициативу LINGUA Africa (выделено $5,5 млн) по сбору языковых данных и развитие моделей для африканских языков. Дополнительно совершенствуется бенчмарк MLCommons AILuminate для индийских и азиатских языков для оценки безопасности ИИ вне англоязычной среды. Совместно с образовательными и коммерческими структурами из Индии, Японии, Кореи и Сингапура при участии Microsoft создаётся мультиязычная и мультимодальная подборка из 7 тыс. высококачественных промптов для хинди, тамильского, малайского, японского и корейского языков. Также Microsoft развивает метод Samiksha для учёта локальных языковых и культурных контекстов. Samiksha позволяет выявлять сбои, которые часто упускаются «англоцентричными» методами оценки. В Африке компания совместно с NASA, властями и др. организациями будет применять ИИ к спутниковым данным для анализа продовольственной ситуации. Технология уже отработана в Индии. В рамках Project Gecko компания развивает ИИ-технологии совместно с сообществами в Восточной Африке и Южной Азии для поддержки с/х. В том числе речь идёт о семействе моделей для распознавания речи Paza, способных работать на мобильных устройствах с шестью кенийскими языками. Ведутся работы над многоязыковыми инструментами Copilot, Multimodal Critical Thinking (MMCT) Agent для анализа видео с учётом голоса и текста, адаптацией LLM к низкоресурсным языкам (в т.ч. чичева, инуктитут, маори) и т.д.

Источник изображения: Microsoft Для ускоренного внедрения ИИ нужно понимать, где и как применяется ИИ, с каким недостатками приходится сталкиваться разработчикам, говорит Microsoft. На основе статистики публичных репозиториев GitHub и метрик Azure Foundry компания участвует в создании «рейтинга» Global AI Adoption Index Всемирного Банка. Например, индийское сообщество из 24 млн разработчиков — второе по величине на GitHub и самое быстрорастущее среди 30 ведущих экономик. С 2020 года ежегодный прирост составляет более 26 %, в 2025 году он составил более 36 %. Индийские специалисты занимают второе место в мире по вкладу в open source, использованию GitHub Education, по вкладу в публичные ИИ-проекты и др. Такие данные помогают точнее направлять инвестиции в инфраструктурные проекты, языковые технологии и на обучение. Поддержка подобных метрик помогает измерять достигнутый прогресс. Microsoft подчёркивает, что компания акцентирует внимание в вопросах внедрения ИИ на необходимости создания доступной инфраструктуры, надёжно работающих в реальном мире системах, а также технологиях, которые могут применяться с учётом местных условий. Для этого компания намерена работать с партнёрами, включая обмен данными для оценки прогресса.

19.02.2026 [12:50], Сергей Карасёв

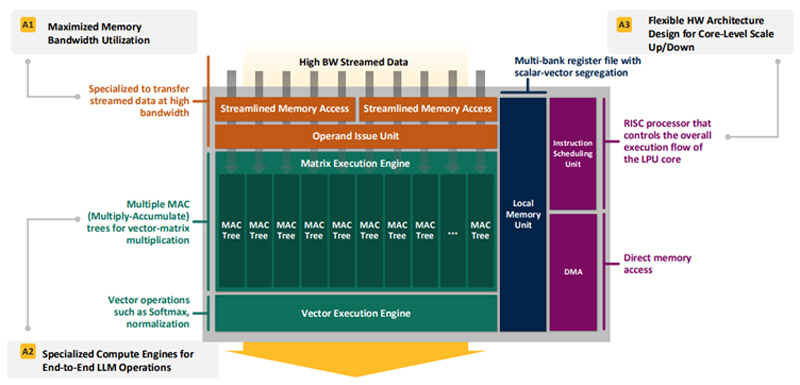

Впятеро энергоэффективнее H100: HyperAccel разработала экономичный чип Bertha 500 для ИИ-инференсаЮжнокорейский стартап HyperAccel, по сообщению EETimes, готовится вывести на рынок специализированный чип Bertha 500, предназначенный для ИИ-инференса. Утверждается, что благодаря особой архитектуре изделие способно генерировать в пять раз больше токенов в секунду по сравнению с решениями на основе GPU при том же уровне TOPS. В Bertha 500 упор сделан на экономическую эффективность. С этой целью используется память LPDDR вместо дорогостоящей HBM. При этом благодаря отказу от традиционной иерархии памяти достигается утилизация пропускной способности LPDDR на 90 %. Дальнейшее повышение эффективности обеспечивается путём оптимизации архитектуры именно для задач инференса. Для сравнения, как утверждает HyperAccel, в случае GPU при инференсе используется только около 45 % пропускной способности памяти и 30 % вычислительных ресурсов. Иными словами, немного жертвуя производительностью, чип Bertha 500 позволяет достичь значительного снижения стоимости. Изделие Bertha 500 будет производиться по 4-нм техпроцессу Samsung. В состав чипа входят 32 ядра LPU (LLM Processing Unit), четыре ядра Arm Cortex-A53 и 256 Мбайт SRAM. Подсистема памяти LPDDR5x использует восемь каналов; пропускная способность достигает 560 Гбайт/с. Заявленная ИИ-производительность на операциях INT8 составляет 768 TOPS. Кроме того, поддерживаются другие 16-, 8- и 4-бит форматы, включая FP16. В целом, по заявлениям HyperAccel, пропускная способность Bertha 500 в расчёте на доллар примерно в 20 раз выше по сравнению с NVIDIA H100, тогда как энергоэффективность больше в пять раз. Чип Bertha 500 будет потреблять около 250 Вт.

Источник изображения: EETimes Программный стек HyperAccel поддерживает все модели из репозитория HuggingFace. Кроме того, компания работает над предметно-ориентированным языком (DSL) под названием Legato, который предоставит разработчикам низкоуровневый доступ к системе. Образцы Bertha 500 появятся к концу I квартала 2026 года, а серийное производство планируется организовать в начале 2027 года. Отмечается также, что совместно с LG стартап разрабатывает «урезанную» версию Bertha 500 для периферийных устройств — Bertha 100. Эта SoC получит ядра Arm Cortex-A55 и отдельные компоненты LG, а также два канала памяти LPDDR5x. Среди возможных сфер применения названы автомобильная промышленность, бытовая электроника и робототехника. Bertha 100 планируется выпускать в виде модулей M.2: первые изделия выйдут в IV квартале текущего года. Решение сможет, например, осуществлять преобразование текста в речь или речи в текст. Стартап HyperAccel основан профессором Корейского института передовых технологий (KAIST) Джуёном Кимом (Jooyoung Kim) вместе с группой его студентов в начале 2023 года. На сегодняшний день компания привлекла $45 млн инвестиций, а её рыночная стоимость оценивается в $200 млн. Штат насчитывает около 80 человек. Первым продуктом HyperAccel стал специализированный сервер Orion на базе FPGA, предназначенный для решения ИИ-задач.

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

19.02.2026 [09:52], Владимир Мироненко

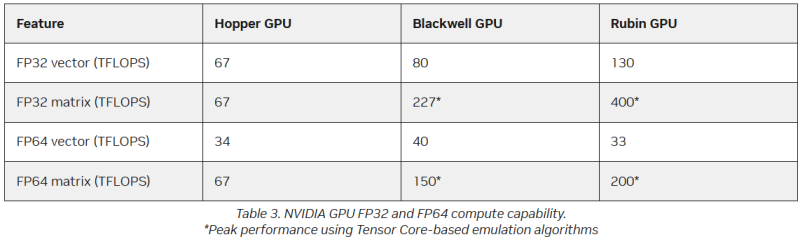

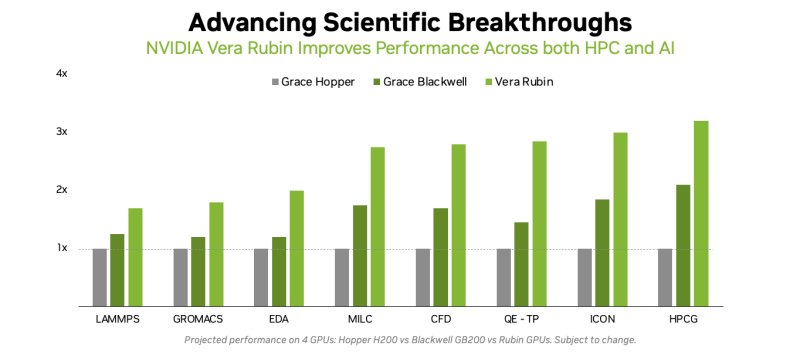

Американская «Миссия Генезис» будет во многом полагаться на «ненастоящие» FP64-вычисленияХотя последнее поколение GPU ориентировано на вычисления с более низкой точностью, которые предпочтительны для ИИ-задач, FP64-вычисления с более высокой точностью по-прежнему «очень важны» для «Миссии Генезис» (Genesis Mission) и её цели — ускорения научных открытий с помощью ИИ, заявил заместитель министра энергетики США по науке и инновациям Дарио Гил (Darío Gil) в интервью HPCwire. «В ходе обсуждений, которые я провел как с [генеральным директором AMD] Лизой Су (Lisa Su), так и с [генеральным директором NVIDIA] Дженсеном [Хуангом] (Jensen Huang), они выразили твёрдую приверженность FP64, подтвердив, что поддержка формата будет продолжаться, — сказал Гил. — Для нас это очень важно, потому что мы не рассматриваем это как замену. Это взаимодополняющие технологии». Он отметил, что для обеспечения вычислительных задач моделирования и симуляции, которые традиционно составляют основу научных вычислений, а также для новых методов ИИ, важно иметь высокопроизводительное оборудование. Гил добавил, что эти два типа вычислений будут работать вместе, чтобы поддержать цель миссии Genesis — расширение границ науки и техники на основе ИИ-технологий. «У вас есть высокоточные симуляционные коды, работающие с FP64. После проверки вы используете их в качестве основы для генерации примеров, на которых вы обучаете суррогатную модель, которую затем запускаете на ИИ-суперкомпьютере, — рассказал Гил. — В итоге вы получаете преимущества с точки зрения производительности и времени решения, часто в 10, 20, 100 раз». Он отметил, что благодаря использованию ИИ-моделей можно получить громадное повышение производительности, но оно зависит от сохранения всего цикла работ, состоящего из экспериментов, моделирования и обучения. «Если вы разорвёте этот цикл и скажете, что у вас больше нет кодов моделирования, то возникнет проблема», — сказал Гил. «Для нас это имеет фундаментальное значение, не только для устаревших кодов, которые мы должны сопровождать и которые так важны для миссии, но и для обеспечения рабочего ИИ-процесса. Поэтому для нас очень важно поддерживать различные архитектурные подходы», — добавил он. В HPC-сообществе возникла обеспокоенность по поводу отсутствия прироста производительности для FP64 в новейших GPU. Напомним, что чип NVIDIA H100, выпущенный в 2022 году, обеспечивает 67 Тфлопс в формате FP64 на тензорных ядрах (34 Тфлопс в векторных вычислениях), в то время как B200 предлагает лишь 37 Тфлопс, а B300 — всего лишь 1,3 Тфлопс. Программная эмуляция FP64-вычислений на тензорных ядрах Blackwell позволяет получить «нечестные» 150 Тфлопс, а из новейших Rubin она позволяет «выжать» 200 Тфлопс. При этом пиковая заявленная производительность векторных FP64-вычислений у Rubin составляет лишь 33 Тфлопс, т.е. нет никакого прироста в сравнении с Hopper. Отметим, что в AMD раскритиковали такой подход, заявив, что он эффективен не для всех сценариев и поэтому такое решение ещё не готово к широкому применению. В свою очередь, эксперты предупреждают, что смещение фокуса производителей на выпуск чипов для ИИ-нагрузок, которые отлично работают с вычислениями с низкой точностью, может привести к дефициту чипов с поддержкой FP64 для HPC, а это грозит потерей лидерства США в этом сегменте рынка. По мере того, как NVIDIA наращивает мощность для выполнения ИИ-задач с низкой точностью вычислений Rubin, компания будет всё больше полагаться на cuBLAS, библиотеку стандартных математических операций CUDA-X, которая эмулирует вычисления с двойной точностью на тензорных ядрах, чтобы постоянно наращивать показатели FP64-производительности. «Мы пытаемся предоставить эти возможности среде разработчиков, чтобы они могли… получить необходимую точность FP64», — заявил в декабре HPCwire Дион Харрис (Dion Harris), старший директор NVIDIA по ИИ/HPC-решениям для гиперскейлеров. Методы эмуляции NVIDIA основаны на схеме Озаки (Ozaki), позволяющей выполнять умножение матриц с высокой точностью, используя многократные вычисления с низкой точностью на тензорных ядрах. NVIDIA утверждает, что использование алгоритма Озаки оправдано, поскольку увеличение производительности FP64 путём добавления большего количества ядер CUDA фактически не повысит общую производительность HPC-приложений, но сделает чипы менее гибкими. По словам компании, анализ реальных нагрузок показывает, что «наивысшая устойчивая производительность FP64 часто достигается на умножении матриц». В Hopper для этого были отдельные аппаратные блоки, но в Blackwell и в Rubin NVIDIA больше опирается на эмуляцию. В то же время, производительность векторных FP64-вычислений остаётся критически важной для научных приложений, в которых не доминируют матричные ядра, признаёт NVIDIA, однако тут же утверждает, что в этих случаях производительность ограничивается перемещением данных через регистры, кеши и HBM, а не непосредственно вычислительными ресурсами. Поэтому сбалансированная конструкция GPU «обеспечивает достаточное количество ресурсов FP64 для насыщения доступной пропускной способности памяти, избегая избыточного выделения вычислительной мощности, которая не может быть эффективно использована». Иными словам, компания ничего менять не собирается. Проект Genesis Mission, вероятно, будет создавать разнообразные ИИ-приложения для научных и инженерных задач, и каждое из них, скорее всего, будет иметь несколько иные вычислительные потребности. Достигли ли NVIDIA и AMD оптимального баланса, используя вычислительные ядра для матричных вычислений и опираясь на эмуляцию Озаки для FP64, ещё предстоит выяснить, пишет HPCwire. |

|