Материалы по тегу: hardware

|

19.02.2026 [09:05], Руслан Авдеев

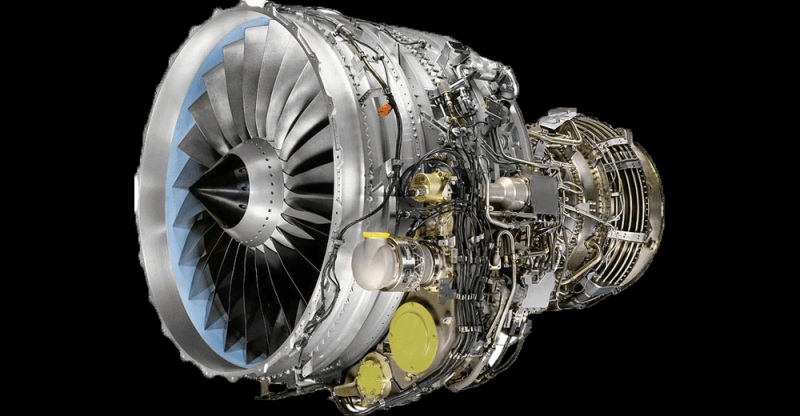

«Грязный» ИИ: ЦОД используют всё больше экологически небезопасных газовых турбинПоскольку дата-центрам нужно всё больше дефицитной энергии, они наращивают использование относительно доступных газовых турбин для компенсации этого дефицита. По некоторым оценкам, такие источники электричества могут добавить 44 млн тонн к выбросам углекислого газа к 2030 году, сообщает The Register. Это приблизительно эквивалентно выбросам 10 млн частных автомобилей. Соответствующие данные предоставила организация Truthout. Проблема в том, что обучение ИИ создало практически неисчерпаемый спрос на вычислительные мощности, что, в свою очередь, вызвало бум строительства дата-центров, требующих подключения к электросетям. В 2025 году Deloitte Insights предупреждала, что в течение десяти лет потребности ИИ ЦОД в электроэнергии только в США могут увеличиться на порядок. Простейший способ решить проблему с дефицитом — использование газотурбинных генераторов, если рядом с ЦОД протянут газопровод, причём инвесторы в ЦОД готовы вкладываться и в строительство газопроводов. Спрос так высок, что газовые турбины оказались в дефиците, в результате некоторые компании занялись переделкой авиационных двигателей коммерческих лайнеров. Отдельные ведомства предлагают переделывать в генераторы списанные двигатели военных самолётов. Boom Supersonic, создающая сверхзвуковые пассажирские самолёты, занялась строительством энергетических турбин на основе двигателя Symphony. Электричеством от собственных газовых генераторов обеспечивает объекты компания Meta✴, мощность кампуса Hyperion в Луизиане должна увеличиться до 5 ГВт, поскольку компания разместила заказ на три крупные газовые электростанции Entergy общей мощностью 2,26 ГВт. Активно пользуется газовыми генераторами компания xAI, не раз оказывавшаяся из-за этого в центре скандалов. Наконец, Microsoft заявляет, что в её структуре энергоснабжения важную роль играет возобновляемая энергетика (особенно в штатах, где много ветра и солнца), но компания вполне допускает использование природного газа в качестве временного решения. Эксперты Gartner предполагают, что операторы ЦОД и вовсе не смогут обеспечить бесперебойное электроснабжение без собственных генерирующих мощностей. Фактически самым вероятным решением станут именно газовые турбины, в полном соответствии с прогнозами Schneider Electric. Всё это соответствует нынешней политике США, готовых использовать для достижения цифрового превосходства даже угольные электростанции. Стремительный рост спроса со стороны ИИ ЦОД стимулирует возобновление выработки электричества на угольных электростанциях. Только в 2025 году эта сфера выросла почти на 20 %. В феврале 2026 года Трамп подписал указ, предписывающий военным и оборонным предприятиям заключать долгосрочные соглашения о закупке электричества с подобными генерирующими компаниями. Ранее представитель Министерства внутренних дел страны заявил, что экзистенциальная угроза для всего мира заключается в проигрыше США в «гонке вооружений» в сфере ИИ, а не в изменении климата. По данным Truthout, наращивают мощности энергетики на природном газе не только в США, хотя Америка на этом рынке является безусловным лидером. По информации издания, в мире реализуются проекты газовой энергетики общей мощностью более 1 ТВт, только за последний год рост составил 31 %. При этом АЭС, включая SMR, которые США тоже продвигают, вряд ли смогут в короткие сроки покрыть весь дефицит в энергии, и даже ослаблений требований ядерной безопасности этому, вероятно, не очень поможет.

18.02.2026 [18:50], Владимир Мироненко

Власти Индии закупят ещё 20 тыс. ускорителей NVIDIA для ускорения развития ИИ в странеНа проходящем в Нью-Дели саммите India AI Impact Summit министр электроники и информационных технологий Индии Ашвини Вайшнау (Ashwini Vaishnaw) заявил, что Индия расширит свои вычислительные мощности для ИИ-нагрузок свыше имеющихся 38 тыс. ускорители, добавив еще 20 тыс. еди. в ближайшее время в рамках программы «Миссия ИИ 2.0». Вайшнау сообщил ресурсу EE Times, что заказы на новые GPU будут размещены в течение недели, и ожидается, что они будут развёрнуты в течение следующих шести месяцев. Расширение вычислительных мощностей происходит в ходе реализации рамочного соглашения между Индией и США на 2026 год, в соответствии с которым две страны договорились значительно увеличить торговлю технологическими продуктами, включая ускорители и другие компоненты для ЦОД. Соглашение предусматривает намерение Индии закупить в течение пяти лет американские энергоносители, самолёты, технологические товары и критически важные материалы на сумму $500 млрд, расширяя при этом совместное технологическое сотрудничество. Заявление Вайшнау говорит о дальнейшем развитии программы IndiaAI Mission, утверждённой в марте 2024 года с бюджетом около $1,14 млрд на пять лет. Первоначально программой планировалось развёртывание 10 тыс. GPU, но их количество уже достигло 38 тыс. Ускорители предоставляются местным компаниям по субсидированной ставке ₹65/час (около $0,72/час). С момента запуска в рамках программы IndiaAI Mission разрабатывались семь основных направлений, включая субсидированные вычислительные ресурсы, разработку базовых моделей, финансирование стартапов и безопасное управление ИИ. Двенадцать стартапов уже были отобраны для разработки отечественных многомодальных базовых моделей с использованием специфических для Индии наборов данных. NVIDIA сообщила о поддержке приоритетов IndiaAI Mission, включая, расширение вычислительных мощностей благодаря поставке ускорителей NVIDIA, разработку передовых ИИ-моделей и исследования и инновации в области ИИ. В рамках программы IndiaAI Mission компания сотрудничает с поставщиками облачных услуг Yotta, L&T и E2E Networks для создания передовых ИИ-фабрик. Yotta — поставщик облачных услуг, создающий крупномасштабную суверенную ИИ-инфраструктуру для Индии под брендом Shakti Cloud, работающую на базе более чем 20 тыс. ускорителей NVIDIA Blackwell Ultra. Его кампусы в Нави Мумбаи (Navi Mumbai) и Большой Нойде (Greater Noida) предоставляют индийским предприятиям и госсектору услуги облачных ИИ-сервисов с высокой пропускной способностью и большим количеством GPU с оплатой по мере использования. В свою очередь, компания E2E Networks создаёт кластер ускорителей NVIDIA Blackwell на своей платформе TIR, размещённый в ЦОД L&T Vyoma в Ченнаи (Chennai). Облачная платформа TIR будет включать системы NVIDIA HGX B200 и корпоративное ПО NVIDIA, а также открытые модели NVIDIA Nemotron для ускорения развития ИИ в таких областях, как агентный ИИ, здравоохранение, финансы, производство и сельское хозяйство. Третий индийский партнёр NVIDIA на ИИ-рынке — компания Netweb Technologies, которая запускает суперкомпьютерные системы Tyrone Camarero AI, построенные на узлах NVIDIA GB200 NVL4, произведённых в рамках государственной программы «Сделано в Индии». Сообщается, что облачная ИИ-инфраструктура в Индии будет размещать рабочие нагрузки, а также обеспечивать интеллектуальные возможности для обучения моделей, тонкой настройки и масштабного инференса. Мощности в этих ЦОД будут зарезервированы для разработчиков моделей, стартапов, исследователей и предприятий для создания, тонкой настройки и развёртывания ИИ в Индии. Ранее глава OpenAI Сэм Альтман (Sam Altman) заявил, что Индия способна стать одним из мировых ИИ-лидеров, особенно в создании малых рассуждающих моделей (SLM).

18.02.2026 [15:00], Андрей Крупин

Новый дата‑центр «Мегафона» начал работу в Хабаровском крае«Мегафон» сообщил о вводе в эксплуатацию нового ЦОД в Хабаровске. Вычислительный комплекс построен по модульному принципу, предусматривающему дальнейшее масштабирование объекта и размещение 110 стоек общей мощностью до 1 МВт. Дата‑центр соответствует отраслевым стандартам и призван обеспечить надёжную работу сетевой инфраструктуры оператора на Дальнем Востоке, говорит компания. ЦОД оснащён системой резервирования, которая позволяет проводить необходимые технические мероприятия без остановки работы оборудования и гарантирует непрерывность предоставления услуг. Мониторинг всех систем объекта ведётся в круглосуточном режиме. Комплексная система безопасности с автоматическим пожаротушением обеспечивает защиту машинных залов и служебных помещений.

Источник изображения: Lightsaber Collection / unsplash.com Сеть «Мегафона» насчитывает более 115 ЦОД по всей стране. В 2025 году новые вычислительные площадки с возможностью дальнейшего расширения построены в Твери, Екатеринбурге и Санкт‑Петербурге. Решение оператора о развитии сети собственных дата‑центров обусловлено ростом объёма пользовательских данных, необходимостью обеспечить качественную обработку высоконагруженных потоковых данных под будущие задачи бизнеса и усиление надёжности сервисов. Ранее, напомним, оператор «Мегафон» запустил на Дальнем Востоке магистральную линию связи с использованием DWDM-систем российского производителя «Т8». Новая линия, обеспечивающая скорость передачи данных в 100 Гбит/с, организована между Хабаровском и Комсомольском-на-Амуре, что составляет более 400 км.

18.02.2026 [14:30], Руслан Авдеев

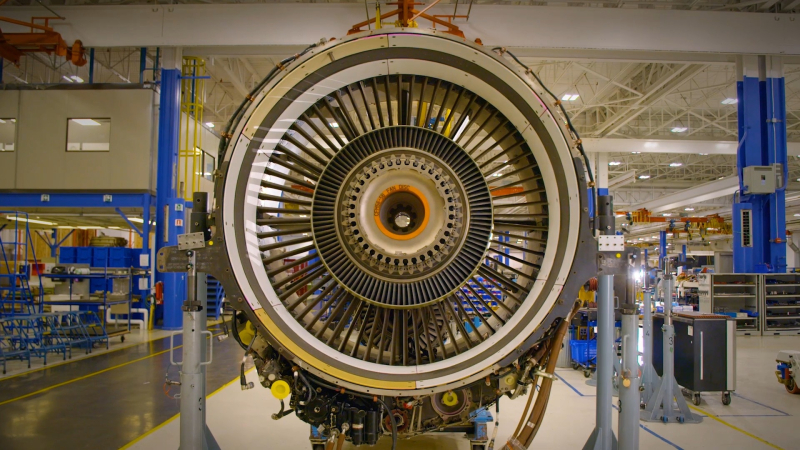

Авиадвигатели сработали: ЦОД получили реактивный импульс благодаря переделке б/у турбинРеактивные авиадвигатели всё чаще рассматриваются в качестве замены классических генераторов. Занимающаяся арендой и ремонтом реактивных турбин компания FTAI Aviation планирует начать продажи модернизированных двигателей, используемых в самолётах Boeing 737, для энергоснабжения дата-центров, сообщает The Wall Street Journal. Акции компании выросли приблизительно на 42 % с момента объявления о том, что та начнёт выпускать «энергетические» варианты двигателей. По оценкам Jefferies, этот бизнес может принести $750 млн в год — до вычета процентов, налогов, амортизации и износа (EBITDA). ProEnergy, поддерживаемая частными инвестициями, тоже продаёт газовые турбины на основе двигателей, применяемых в Boeing 747. Авиастартап Boom Supersonic в декабре 2025 года объявил, что станет продавать модифицированный вариант своего двигателя с доработками, а первым клиентом будет Crusoe, строящая ИИ ЦОД Stargate — компания должна получить новые генераторы уже в 2027 году.

Источник изображения: FTAI Aviation Реактивные двигатели идеально подходят для производства электричества. Техногиганты, занимающиеся энергетическим оборудованием — GE Vernova, Siemens Energy и Mitsubishi Heavy Industries уже продают силовые турбины, называемые «аэродеривативами» (aeroderivatives), созданными на основе авиационных технологий. Выпускающие авиационные двигатели компании GE Aerospace и Woodward тоже продают турбины или компоненты для наземных решений. Пока производители тяжёлого энергетического оборудования не боятся появления новых игроков вроде FTAI, а GE Vernova прямо заявила, что не рассматривает их в качестве конкурентов, отметив, что при разработке бизнес-планов на 20 лет «эффективность имеет большое значение». При этом у многих компаний — длинные очереди на поставку подобных силовых турбин, что открывает возможности для новых участников рынка. FTAI Aviation сообщила, что на переоборудования реактивного двигателя в турбину для выработки электричества требуется 30–45 дней, а на разработку турбины, сохранившей большинство решений исходного двигателя, ушло приблизительно 18 мес. У компании хорошие позиции — она владеет правами на двигатель CFM56, самый продаваемый в коммерческой авиации. По данным Axford Turbine Consultants, есть два основных способа переоборудовать авиадвигатель в наземный генератор — заменить топливные форсунки для использования природного газа и заменить большой вентилятор в передней части двигателя на меньший, оптимально подходящий для электрогенерации на земле. FTAI заявляет, что способна дорабатывать детали реактивных двигателей с остаточным ресурсом в несколько лет для электрогенерации. В этом случае они прослужат ещё многие годы. Если двигатели самолётов испытывают большие нагрузки во время взлёта и посадки, то на земле турбины меньше изнашиваются — работают ли они в качестве базового источника энергии или включаются только периодически. По данным Thunder Said Energy, турбины высокой мощности — самые эффективные из газовых генераторов. При этом они значительно подорожали, а очередь на них растёт. FTAI и Boom Supersonic заявили, что некоторые клиенты с рынка ЦОД в долгосрочной перспективе рассматривают возможность использования именно их решений в качестве основных источников питания. Компании способны предложить и варианты с возможностью улавливать избыточное тепло для ещё большего повышения эффективности. Пока FTAI намерена поставлять около 100 турбин на 2,5 ГВт ежегодно. Boom Supersonic рассчитывает добиться выпуска не менее 4,5 ГВт/год к 2030 году. Компаниям ещё предстоит доказать целесообразность производства таких моделей, но, по данным Morgan Stanley, в 2023–2025 гг. глобальная мощность газовых турбин составляла приблизительно 47 ГВт. По расчётам Jefferies, технический потенциал для наращивания мощностей имеется. Ежегодно из эксплуатации выводятся около 1,6 тыс. «коммерческих» реактивных двигателей. Даже если треть из них превратить в генераторы по схеме FTAI, это добавит рынку 13 ГВт, т.е. более четверти от существующих мощностей газовых турбин по статистике Morgan Stanley. Управление энергетической информации США (EIA) уже предложило использовать списанные двигатели военных самолётов, которые в теории могут дать до 40 ГВт.

Источник изображения: Miguel Ángel Sanz/unspalsh.com Смена профиля производства некоторых бизнесов может нести и негативные последствия. Если на выпуск силовых турбин направят ещё больше двигателей, это может усугубить дефицит на рынке реактивных двигателей для авиации, он и без того довольно силён. Кроме того, это может негативно сказаться и на позициях трёх крупнейших производителей силового оборудования. По информации Morgan Stanley, компании GE Vernova, Mitsubishi Heavy Industries и Siemens Energy контролируют приблизительно 80 % рынка газовых турбин. По данным Thunder Said Energy, они, вероятно, даже сдерживают наращивание производственных мощностей, чтобы избежать кризисов перепроизводства, какие уже были в истории — поскольку масштабирование выпуска газовых турбин «на удивление недорого». Прочие производители двигателей высокой мощности, в том числе морских и иных, могут тоже изменить профиль работы для производства с «минимальными инвестициями».

18.02.2026 [11:46], Руслан Авдеев

Adani вложит $100 млрд в создание 5 ГВт «зелёных» ИИ ЦОД в ИндииИндийский конгломерат Adani увеличил планы строительства дата-центров в Индии более чем вдвое. На днях компания анонсировала планы вложить $100 млрд в возведение готовых к ИИ-нагрузкам ЦОД гиперскейл-уровня, снабжаемых возобновляемой энергией — к 2035 году, сообщает Datacenter Dynamics. Подробности пока почти неизвестны, но компания отметила, что расширенный план основан на существующих портфолио и плане совместного предприятия AdaniConneX совокупной мощностью 2 ГВт. Теперь общая запланированная мощность составляет 5 ГВт, энергетическая составляющая будет реализована за счёт комбинации возобновляемой энергии и питания от магистральных линий электропередачи. Adani объявила, что дальнейшая экспансия опирается на знаковые партнёрские соглашения с Google о строительстве кампуса ИИ ЦОД в Вишакхапатнаме (Visakhapatnam) гигаваттного уровня, а также дополнительных кампусов в Нойде (Noida). Также заключён договор с Microsoft — речь идёт о строительстве кампусов в Хайдарабаде (Hyderabad) и Пуне (Pune). Дополнительно компания сообщила, что намерена углублять партнёрство в сфере ЦОД с индийским гигантом электронной коммерции — компанией Flipkart, с планами построить второй ИИ ЦОД. Ведётся обсуждение с прочими крупными игроками IT-рынка, стремящимися обзавестись крупными кампусами в Индии. По словам Adani Group, мир вступает в эру «интеллектуальной революции», более глубокой, чем любая научно-техническая революция прежде. Страны, сумевшие обеспечить баланс энергетики и вычислений, будут формировать облик следующего десятилетия, а Индия находится в уникальной позиции, позволяющей занять одну из ведущих ролей в этом.

Источник изображения: Rohit Dey/unsplash.com Adani сообщает, что компания, опираясь на опыт в сфере ЦОД и «зелёной» энергетики, расширяет деятельность в стремлении «охватить» полный пятиуровневый ИИ-стек с акцентом на обеспечение индийского технологического суверенитета. В компании рассчитывают, что страна будет не только обычным потребителем в эпоху ИИ, но и создателем, строителем и экспортёром «интеллектуальных» технологий. Утверждается, что группа также инвестирует $55 млрд в расширение портфолио возобновляемой энергетики, включая строительство крупнейшего в мире аккумуляторного энергохранилища (BESS) и создание солнечного/ветряного проекта в Хавде (Khavda) — 10 ГВт мощностей уже функционируют. Дополнительно индийский конгломерат намерен участвовать в инвестициях в местные партнёрства, предполагающие строительство компонентов критической инфраструктуры, включая трансформаторы высокой мощности, передовую электронику для силовых систем, электросетевые системы, инверторы и промышленные системы терморегулирования. AdaniConneX представляет собой совместное предприятие Adani Enterprises и EdgeConneX. Впервые его создание анонсировали в феврале 2021 года, ранее компании рассчитывали построить в Индии ЦОД гиперскейл-уровня мощностью 1 ГВт. На сегодня предприятие реализует проекты в Ченнаи, Нойде, Визаге, Хайдарабаде, Пуне и Мумбаи. Стоит отметить, что в начале февраля 2026 года Индия объявила налоговые каникулы на 20 лет для гиперскейлеров, готовых использовать местные ЦОД для обслуживания зарубежных облачных клиентов.

18.02.2026 [09:19], Сергей Карасёв

Meta✴ развернёт ИИ-инфраструктуру на «миллионах ускорителей NVIDIA Blackwell и Rubin», а также Arm-чипах GraceКомпании NVIDIA и Meta✴ объявили о многолетнем стратегическом партнёрстве, охватывающем локальную, облачную и ИИ-инфраструктуры. В частности, Meta✴ будет использовать в своих дата-центрах решения NVIDIA как для обучения больших языковых моделей (LLM), так и для инференса. Сообщается, что Meta✴ возьмёт на вооружение чипы NVIDIA Grace, которые будут использоваться в серверах, основанных исключительно на CPU-архитектуре (без ускорителей на основе GPU). Изделия Grace, напомним, объединяют 72 вычислительных ядра Armv9 Neoverse V2 (Demeter) с тактовой частотой до 3,35 ГГц и до 480 Гбайт памяти LPDDR5x. Доступна также сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Meta✴ намерена применять изделия Grace для решения общих задач, а также поддержания работы ИИ-агентов, которым не требуются ИИ-ускорители. Вице-президент NVIDIA Иэн Бак (Ian Buck) отмечает, что решения Grace способны обеспечить вдвое большую производительность на 1 Вт при выполнении операций общего назначения по сравнению с альтернативными платформами. В дальнейшем Meta✴ планирует использовать Arm-процессоры NVIDIA следующего поколения — решения Vera. Крупномасштабные развёртывания систем на базе Vera намечены на 2027 год, что поможет Meta✴ в развитии энергоэффективных вычислений и формировании широкой экосистемы Arm.

Источник изображения: Meta✴ Кроме того, в рамках партнёрства Meta✴ будет использовать «миллионы ускорителей NVIDIA Blackwell и Rubin». Так, на основе изделий NVIDIA GB300 компании создадут единую среду, охватывающую локальные дата-центры и облачные ресурсы, что позволит упростить операции при одновременном улучшении производительности и масштабируемости. Среди прочего Meta✴ будет применять сетевую платформу NVIDIA Spectrum-X Ethernet и технологию NVIDIA Confidential Computing для защиты данных. «Мы рады расширить партнёрство с NVIDIA с целью создания передовых кластеров на основе платформы Vera Rubin — это позволит предоставить персональный суперинтеллект каждому человеку в мире», — говорит Марк Цукерберг (Mark Zuckerberg), основатель и генеральный директор Meta✴. Нужно отметить, что среди гиперскейлеров только Meta✴ и Oracle используют в своих инфраструктурах сторонние чипы с архитектурой Arm. В то же время AWS, Google и Microsoft развивают собственные Arm-проекты — изделия Graviton, Axion и Cobalt соответственно.

17.02.2026 [15:33], Руслан Авдеев

Индийская Neysa привлечёт $1,2 млрд для расширения ИИ-облакаИндийский облачный стартап Neysa Networks Pvt. Ltd. Объявил о намерении привлечь до $1,2 млрд для расширения своей инфраструктуры дата-центров, сообщает Silicon Angle. Возглавляемый Blackstone консорциум обеспечит до половины суммы в виде акционерного финансирования, что обеспечит группе инвесторов мажоритарную долю в Neysa. Ещё $600 млн придётся на долговое финансирование. Компания рассчитывает, что привлечённые средства помогут утроить выручку в следующие несколько лет. Как заявляет Blackstone, инвестиции позволят Neysa сыграть важную роль в развитии ИИ-инфраструктуры в Индии и дают возможность компаниям и государственным структурам эффективнее и быстрее внедрять ИИ-технологии. Сейчас Neysa управляет публичной облачной платформой, оптимизированной для ИИ-задач, которая, по слухам, основана на около 2 тыс. ИИ-ускорителей, наиболее передовыми из которых являются NVIDIA H200. Также платформа оснащена чипами более общего назначения NVIDIA L40S. Предлагаются и классические CPU-инстансы. Neysa планирует увеличить количество используемых ИИ-ускорителей приблизительно в десять раз, до 20 тыс. По оценкам Blackstone, это примерно треть от всех ИИ-ускорителей, развёрнутых сейчас в индийских ЦОД. Впрочем, Neysa, вероятно захочет приобрести более современные решения, включая Vera Rubin. По-видимому, как минимум часть из них будет развёрнута в дата-центре в Хайдарабаде, о котором сообщалось в апреле 2025 года. Объект стоит как раз $1,2 млрд и вместит до 25 тыс. ИИ-ускорителей.

Источник изображения: Prashanth Pinha/unsplash.com Помимо набора программных инструментов, компания предлагает и инфраструктурные сервисы. Платформа Neysa позволяет клиентам дообучать открытые ИИ-модели под конкретные задачи. Кроме того, разработчики могут создать несколько вариантов той или иной модели, чтобы выбрать наилучший при помощи инструментов Nesya, которые также помогают отслеживать эффективность использования таких кастомных моделей и обеспечивают средства безопасности и контроля доступа. Также компания намерена улучшить наблюдаемость и управляемость нагрузок.

17.02.2026 [14:22], Руслан Авдеев

Индийские NeevCloud и Agnikul Cosmos тоже готовы развернуть в космосе сотни дата-центровИндийская аэрокосмическая компания Agnikul Cosmos совместно с облачным ИИ-провайдером NeevCloud планируют развернуть в космосе сотни небольших дата-центров, сообщает Datacenter Dynamics. Первый дата-центр должен заработать на орбите к концу 2026 года. NeevCloud развернёт облачный дата-центр и запустит приложения для ИИ-инференса в режиме реального времени на патентованной платформе, разработанной и построенной Agnikul. Последняя известна напечатанными на 3D-принтере ракетами для запуска малых спутников. Если пилотный запуск окажется удачным, компании намерены вывести на орбиту более 600 дата-центров Orbital Edge в следующие три года. NeevCloud заявляет, что речь идёт не только о простом строительстве дата-центров в космосе, но и полностью новом уровне инфраструктуры для орбитального инференса. По словам представителя Agnikul, технология ступени-трансформера позволяет сохранять её функциональность. Фактически речь идёт о превращении ступени в «полезные активы», в которых может размещаться оборудование и программное обеспечение, включая данные и вычислительные мощности. Это новый этап для аэрокосмической компании, позволяющий снизить цены эксплуатации и капитальные издержки, используя размещённое в многоразовых ступенях оборудование.

Источник изображения: Agnikul Помимо SpaceX, попросившей разрешение на запуск сразу миллиона спутников, с проектами космических ЦОД выступают и другие компании, например, масштабная инициатива исходит от Google и др., хотя реальная практика внедрения, вероятно, будет довольно сложной. На днях Starcloud также подала заявку на запуск 88 тыс. спутников. Это меньше, чем мегапроект SpaceX, но тоже вполне крупный проект. Помимо этих компаний, над собственными космическими проектами работают Amazon, Blue Origin, Axiom Space, NTT, Ramon.Space, Sophia Space и др.

17.02.2026 [13:57], Владимир Мироненко

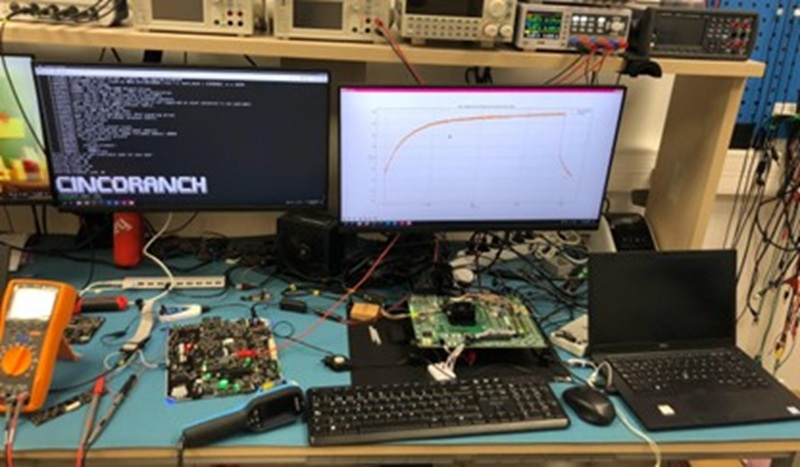

Первый европейский суверенный RISC-V-процессор Cinco Ranch изготовлен по техпроцессу Intel 3Лаборатория суперкомпьютерных вычислений (BZL) Национального центра суперкомпьютерных вычислений Барселоны (BSC-CNS) сообщила об успешном запуске тестового чипа Cinco Ranch TC1 на архитектуре RISC-V, изготовленного по передовому техпроцессу Intel 3. В заявлении отмечено, что результаты подтверждают надёжность конструкции и жизнеспособность вычислительной архитектуры на базе открытой платформы RISC-V. «Это достижение является ключевым этапом в процессе разработки чипа и качественным скачком на пути к суверенным суперкомпьютерным технологиям в Европе», — подчеркнула BZL, отметив, что готовый чип предлагает открытую, гибкую альтернативу, свободную от зависимости от проприетарных архитектур крупных транснациональных корпораций. Проект связан с Европейской инициативой по процессорам (EPI), целью которой является разработка отечественных процессоров для будущих европейских суперкомпьютеров и промышленных систем. «Успешная стабильная загрузка Linux и проверка достижения чипом ожидаемых частот подтверждают зрелость конструкции и качество работы, проделанной командами BZL», — говорит исследователь BSC и координатор аппаратной части лаборатории Zettascale в Барселоне. Cinco Ranch TC1 — это первый чип, произведенный в академической среде с использованием 3-нм техпроцесса Intel 3. На этапе проектирования, из-за невозможности прямого доступа к этой технологии, BZL провела внутренние оценки на сопоставимом техпроцессе TSMC N7, что позволило оценить конструкцию перед окончательной реализацией. Сообщается, что структура Cinco Ranch TC1 основана на трёх взаимодополняющих процессорных блоках, предназначенных для совместной работы и охвата различных вычислительных профилей. В чипе используются три блока RISC-V на одном кристалле, каждый из которых ориентировано на специализированные рабочие нагрузки. Три ядра используют микроархитектуры Sargantana, Lagarto Ka и Lagarto Ox, с основным упором на эффективность, векторные нагрузки и скалярную обработку соответственно. Подсистема CPU занимает всего 3,2 мм² на крошечном кристалле площадью 15,2 мм², который также включает высокоскоростные интерфейсы, такие как PCIe 5.0 и DDR5. Для сравнения, площадь CCD восьмиядерного процессора AMD Zen 5 составляет около 71 мм², и для этого чиплета также требуется отдельный кристалл I/O, отметил ресурс HotHardware.com.  Cinco Ranch TC1 был протестирован на оценочной плате Hawk Canyon V2, разработанной Intel для первоначальной проверки чипа после его производства. Следующим этапом станет функциональное тестирование и тестирование производительности, оптимизация ПО и полная проверка системы. В мае 2025 года на Cinco Ranch TC1 (Test Chip 1) была успешно загружена ОС Linux, а в июле 2025 года, после получения партии из 500 чипов, начались работы по характеризации и проверке. Вся партия продемонстрировала высокую функциональную производительность, при этом большинство устройств успешно запустили все три интегрированных процессора чипа. Также результаты тестов подтверждают, что Cinco Ranch TC1 работает на частоте до 1,25 ГГц, что превышает консервативные оценки, сделанные на этапе проектирования. Для BZL и её партнёров это достижение является важной вехой и доказательством того, что разработанные в Европе процессоры с открытой ISA могут быть реализованы на передовых технологиях производства и воплощены в реальных кремниевых решениях. Для Европы — это значимый шаг к технологической автономии в HPC. А для Intel это демонстрация того, что её бизнес может оказывать всестороннюю поддержку передовым внешним клиентам в сложных гетерогенных проектах.

17.02.2026 [12:04], Руслан Авдеев

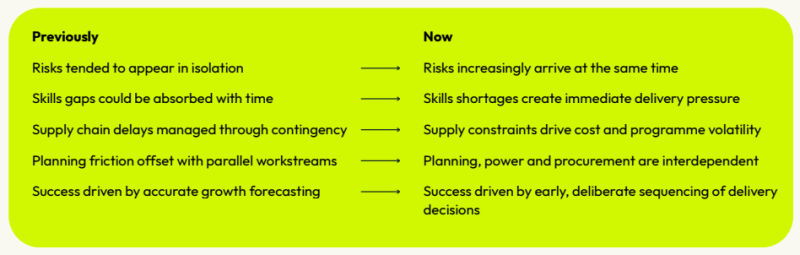

BCS: только каждый пятый дата-центр в Европе готов к ИИ, а строить новые оказалось непростоПо данным экспертов консалтинговой компании BCS, несмотря на рост спроса на ИИ-инфраструктуру, только 20 % дата-центров в Европе и на Ближнем Востоке сегодня считаются готовыми к работе с ИИ, сообщает The Register. Как утверждается в докладе BCS, мощности, уже готовые к внедрению ИИ в регионе, ограничены. Одной из главных проблем застройщиков является нехватка подходящих компетенций. Отчёт получен путём опроса более 3 тыс. представителей отрасли в 41 стране для выявления проблем, с которыми сталкивается строительство новых объектов в Европе. Хотя эксперты прогнозируют, что к 2030 году доля объектов, готовых к внедрению ИИ, увеличится приблизительно до 70 %, не исключено, что спрос всё ещё будет выше, чем возможности инфраструктуры. Суть проблемы в том, что большинство площадок для ЦОД проектировались для обычных корпоративных или облачных нагрузок, а стойки с энергоёмкими ускорителями требуют повышенной плотности, более надёжного охлаждения и усиленной отказоустойчивости в сравнении с теми показателями, что могут обеспечить традиционные объекты. Другими словами, некоторые площадки могут иметь достаточную мощность «на бумаге», но у них нет возможности обеспечивать необходимое электропитание на уровне отдельных стоек или компенсировать повышенные тепловые нагрузки. По мнению экспертов, 20 % готовности — не показатель ошибок отрасли. Это свидетельство того, как высоки сегодня требования к ИИ-инфраструктуре, а также того, что большая часть имеющейся инфраструктуры строилась для удовлетворения потребностей оборудования предыдущего поколения. Важно, что строители ЦОД часто сталкиваются с комплексом известных проблем на одних и тех же проектах. Например, на большей части территории Европы есть дефицит свободной земли для размещения дата-центров, не хватает материалов и тяжёлой техники, имеются проблемы с подключением к электросетям и нехватка квалифицированного персонала. В BCS подчёркивают, что чаще всего речь идёт не об отдельных проблемах, а об их совокупном влиянии. В результате отрасль вступает в новую фазу, когда ожидается рост рынка, но возможностей для его обеспечения становится всё меньше. По данным экспертов, 93 % опрошенных ожидают роста спроса на мощности ЦОД в ближайшие 12 мес., но доступных предложений, вероятно, будет всё меньше. Более того, 95 % опрошенных ожидают, что в тот же период усугубится дефицит квалифицированных специалистов, а 86 % уверены, что нестабильность цепочек поставок стала не временной проблемой, а «структурной особенность» отрасли. Половина строителей, по данным BCS, не уложилась в установленные сроки или не выполнила в полном объёме задач, поставленных клиентами из-за нехватки кадров. 53 % подчёркивают, что проблемы в цепочках поставок влияют на выбор площадки в будущем. Как считают в BCS, самые сильные позиции займут компании, лучше организованные и способные управлять сотрудничеством команд, специалистов и партнёров, для которызх в норме не характерно тесное взаимодействие. Также помогут навыки находить компромиссы даже под давлением. Впрочем, BCS полагает, что на британском рынке всё ещё имеется потенциал для ввода более 10 ГВт новых мощностей в ближайшие 10 лет, а в Германии, Австрии и Швейцарии произойдёт более активная экспансия уже в 2026 году. Согласно отдельному отчёту European Data Centre Association (EUDCA), уже к 2031 году Лондон, возможно, уступит Франкфурту место ключевого европейского хаба ЦОД. |

|