Материалы по тегу: hardware

|

17.02.2026 [11:48], Руслан Авдеев

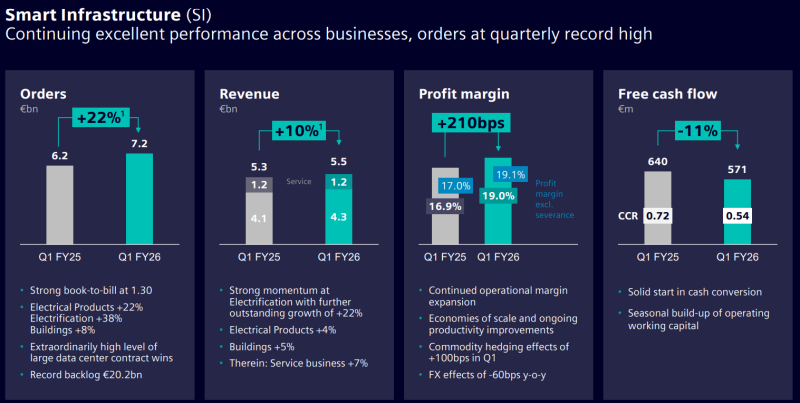

Прогноз — мультиоблачно: Policliud развернёт тысячу суверенных микро-ЦОД за пять летОблачный стартап Policliud из Франции поделился планом развернуть сотни периферийных суверенных дата-центров в следующие пять лет, сообщает Datacenter Dynamics. В ходе мероприятия World AI Cannes Festival 2026 компания объявила о намерении построить около 1 тыс. микро-ЦОД к концу 2030 года с использованием более 250 тыс. ИИ-ускорителей. Компания специализируется на малых «суверенных» проектах дата-центров, но на текущий момент ввела в эксплуатацию лишь восемь из них — во Франции, в странах, входящих в Совет сотрудничества арабских государств Персидского залива (GCC) и США. По данным компании, фактически речь идёт о контрактах на сумму около €10,5 млн ($12,44 млн) и использовании 1,2 тыс. ИИ-ускорителей. В 2026 году Policloud намерена ввести в эксплуатацию 100 ЦОД в 2026 году с суммарно более чем 25 тыс. ИИ-ускорителей. Компания применяет модульные микро-ЦОД без водяного охлаждения, расположенные как можно ближе к источнику данных. Это контейнерные дата-центры, вмещающие до 400 ускорителей на каждый модуль, площадью до 100 м2 и мощностью до 500 кВт. ЦОД используют распределённую облачную платформу Hivenet. Детали об используемых ИИ-ускорителях и вспомогательном оборудовании пока не раскрываются.

Источник изображения: Policloud Компания основана Дэвидом Гурле (David Gurlé), бывшим топ-менеджером Microsoft и основателем коммуникационной платформу Symphony для бизнеса со сквозным шифрованием трафика. В июне 2025 года Policloud привлекла €7,5 млн ($8,8 млн) в ходе начального раунда финансирования, возглавленного Global Ventures. В нём также приняли участие MI8 Limited, OneRagtime и Национальный институт исследований в области цифровых наук и технологий Франции (INRIA), а также частные инвесторы.

17.02.2026 [11:08], Сергей Карасёв

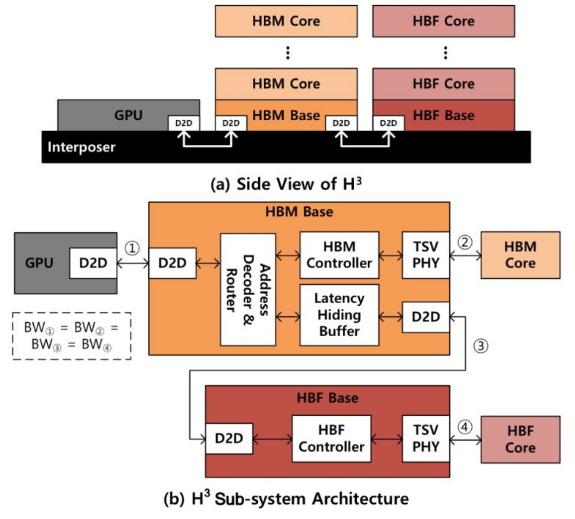

SK hynix предлагает гибридную память HBM/HBF для ускорения ИИ-инференсаКомпания SK hynix, по сообщению ресурса Blocks & Files, разработала концепцию гибридной памяти, объединяющей на одном интерпозере HBM (High Bandwidth Memory) и флеш-чипы с высокой пропускной способностью HBF (High Bandwidth Flash). Предполагается, что такое решение будет подключаться к GPU для повышения скорости ИИ-инференса. Современные ИИ-ускорители на основе GPU оснащаются высокопроизводительной памятью HBM. Однако существуют ограничения по её ёмкости, из-за чего операции инференса замедляются, поскольку доступ к данным приходится осуществлять с использованием более медленных SSD. Решить проблему SK hynix предлагает путём применения гибридной конструкции HBM/HBF под названием H3. Архитектура HBF предусматривает монтаж кристаллов NAND друг над другом поверх логического кристалла. Вся эта связка располагается на интерпозере рядом с контроллером памяти, а также GPU, CPU, TPU или SoC — в зависимости от предназначения конечного изделия. В случае H3 на интерпозере будет дополнительно размещён стек HBM. Отмечается, что время доступа к HBF больше, чем к HBM, но вместе с тем значительно меньше, нежели к традиционным SSD. Таким образом, HBF может служить в качестве быстрого кеша большого объёма.

Источник изображения: SK hynix По заявлениям SK hynix, стеки HBF могут иметь до 16 раз более высокую ёмкость по сравнению с HBM, обеспечивая при этом сопоставимую пропускную способность. С другой стороны, HBF обладает меньшей износостойкостью при записи, до 4 раз более высоким энергопотреблением и большим временем доступа. HBF выдерживает около 100 тыс. циклов записи, а поэтому лучше всего подходит для рабочих нагрузок с интенсивным чтением. В результате, как утверждается, гибридная конструкция сможет эффективно решать задачи инференса при использовании больших языковых моделей (LLM) с огромным количеством параметров. В ходе моделирования работы H3, проведенного специалистами SK hynix, рассматривался ускоритель NVIDIA Blackwell B200 с восемью стеками HBM3E и таким же количеством стеков HBF. В пересчете на токены в секунду производительность системы с памятью H3 оказалась в 1,25 раза выше при использовании 1 млн токенов и в 6,14 раза больше при использовании 10 млн токенов по сравнению с решениями, оборудованными только чипами HBM. Более того отмечено 2,69-кратное повышение производительности в расчёте на 1 Вт затрачиваемой энергии по сравнению с конфигурациями без HBF. К тому же связка HBM и HBF может обрабатывать в 18,8 раз больше одновременных запросов, чем только HBM.

16.02.2026 [17:37], Руслан Авдеев

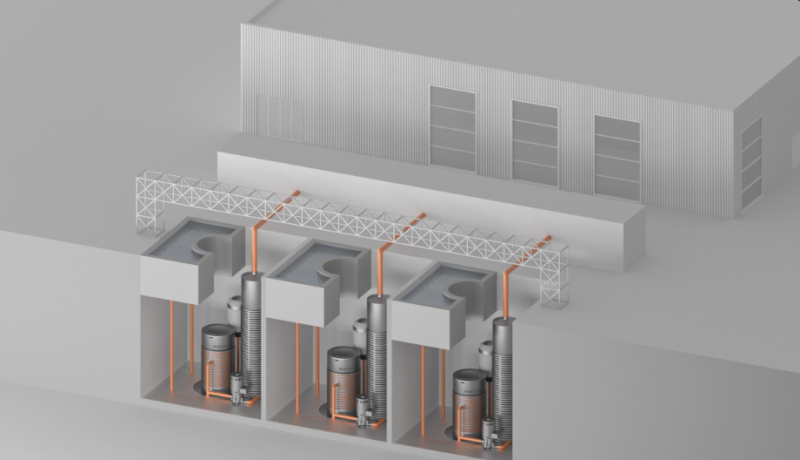

«Атомный ИИ»: Deep Atomic предлагает строить сразу и ЦОД, и АЭС для негоХотя в США уже имеются дата-центры рядом с атомными электростанциями, включая кампус Cumulus в Пенсильвании, с некоторых пор купленный Amazon (AWS), Deep Atomic предложила Министерства энергетики (DOE) страны другую тактику — строительство АЭС специально для «первого в стране кампуса ЦОД для ИИ и HPC» рядом с Национальной лабораторией Айдахо (INL), «колыбели» коммерческой атомной энергетики в США, сообщает The Register. Не так давно Министерство энергетики начало продвигать размещение дата-центров рядом с электростанциями на федеральных землях в рамках программы AI Action Plan. Инициатива поддержана указами президента США Дональда Трампа (Donald Trump), предусматривающими ослабление барьеров для развития ИИ и обеспечения потребностей ИИ ЦОД в энергетике. В консорциум, формируемый Deep Atomic, также входят ещё один разработчик атомных решений, Paragon Energy Solutions, а также связанная с бизнесом ЦОД инжиниринговая компания Future-tech и Moonlite, специализирующаяся на ИИ-инфраструктуре. А специалист по недвижимости Clayco заявляет, что занят планированием реализации инициативы в части того, как именно проектировать, организовать и построить инженерную составляющую. Компания поможет проработать и обосновать заявку для DOE и предоставит консорциуму консультации относительно согласования проектных и строительных решений с эксплуатационными требованиями к высоконагруженным ИИ-проектам.

Источник изображения: Deep Atomic Если проект одобрят, его ожидает поэтапная реализация. В первую очередь участники намерены построить ЦОД, Deep Atomic намерена запустить его за 24–36 мес., используя уже доступные на территории INL подключения к энергосети, геотермальные и солнечные мощности. Параллельно будет проходить сертификация, изготовление и ввод в эксплуатацию малого модульного реактора (SMR) MK60. Вполне вероятно, что благодаря дополнительным источникам энергии ЦОД сможет работать даже без SMR, если проект его строительства столкнётся с непреодолимыми препятствиями. Но Deep Atomic рассчитывает, что MK60 сможет обеспечить 60 МВт мощностей для электропитания и ещё 60 МВт для охлаждения, что важно для HPC/ИИ ЦОД. Сроки запуска как ЦОД, так и АЭС пока не называются. По оценкам Omdia, на реализацию подобных инициатив в атомной энергетике могут уйти годы из-за получения одобрения SMR на соответствие нормативам, масштабирование производства и коммерческое внедрение. Завершение вероятно ближе к 2035 году, хотя эксперты допускают, что результаты будут получены раньше. Ранее министр энергетики США выражал уверенность, что, как минимум, один SMR могут ввести в эксплуатацию к июлю 2026 года. По мнению экспертного сообщества, модель автономной мини-АЭС для отдельного ЦОД без подключения к магистральной электросети — вполне реалистичный сценарий для будущих проектов. Тем не менее, рынок энергоснабжения развивается крайне динамично, а спрос на ИИ-вычисления меняется буквально ежеквартально, что может повлиять на точность прогнозов. В конце января сообщалось, что Министерство энергетики США продвигают «атомные кампусы» с ослабленными требованиями к ядерной безопасности, чтобы снабжать электричеством ИИ ЦОД. В сентябре 2025 года сообщалось, что бум ИИ ЦОД в США обойдётся в $350 млрд.

16.02.2026 [16:15], Сергей Карасёв

Oxide Computer готовит блейд-платформу на базе AMD EPYC TurinКомпания Oxide Computer, по сообщению The Register, провела раунд финансирования Series C, в ходе которого на дальнейшее развитие привлечено $200 млн. Стартап планирует направить средства в том числе на создание новой стоечной платформы на аппаратной платформе AMD EPYC 9005 Turin. Oxide Computer основана в 2019 году группой бывших инженеров Joyent и Sun Microsystems. Стартап занимается разработкой оборудования для дата-центров. При этом в качестве новой вычислительной единицы компания рассматривает целую стойку, а не отдельный сервер. Система Oxide Computer первого поколения несёт на борту 32 вычислительных модуля, оснащённых чипами AMD EPYC 7713P (Milan). Каждый модуль содержит 64 ядра CPU, до 1 Тбайт DDR4-3200 и 10 NMVe-накопителей U.2 суммарной вместимостью 32 Тбайт. Применённая объединительная плата обеспечивает питание и коммутационную способность до 12,8 Тбит/с. Общее энергопотребление стойки находится на уровне 15 кВт.

Источник изображения: Oxide Computer По словам генерального директора Oxide Computer Стива Така (Steve Tuck), компания проектирует обновлённую версию своей стоечной системы, в которую будут устанавливаться процессоры EPYC поколения Turin. Такие чипы насчитывают до 192 вычислительных ядер. Говорится об использовании памяти DDR5-6400. Вкупе это даст значительный прирост производительности по сравнению с оригинальной машиной. Важным преимуществом Turin является поддержка инструкций AVX-512, предназначенных для ускорения ресурсоёмких вычислений, таких как обработка больших массивов данных, задачи ИИ и пр. Какие именно модели процессоров будут задействованы в новых серверных модулях, Так уточнять не стал. Кроме того, Oxide Computer рассматривает возможность перехода на новые коммутационные решения, которые в перспективе придут на смену ныне применяющимся изделиям Intel Tofino 2. Одним из вариантов является чип-коммутатор Xsight Labs X2, обеспечивающий пропускную способность до 12,8 Тбит/с. При этом изучаются и другие альтернативы. Oxide Computer также не исключает, что в будущем начнёт оснащать свои системы ИИ-ускорителями на базе GPU.

16.02.2026 [11:16], Руслан Авдеев

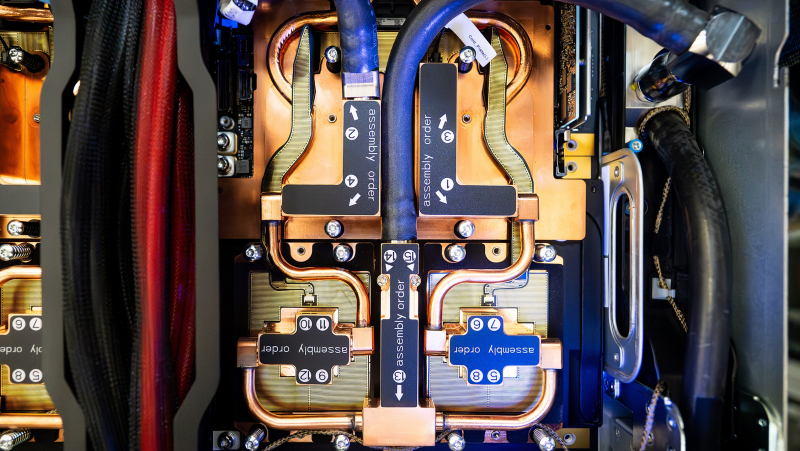

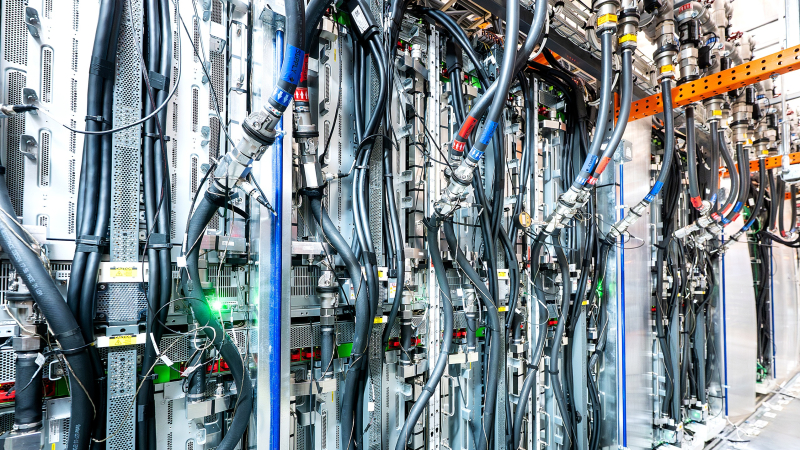

Попутного ветра: AWS резко сократила развёртывание СЖО для Trainium3, решив обойтись преимущественно воздушным охлаждениемAmazon Web Services (AWS) резко увеличит долю воздушного охлаждения в серверах на базе ускорителей Trainium3. Производство серверов намерены нарастить во II квартале 2026 года, но жидкостное охлаждение в них будут применять далеко не так активно, как ожидалось, сообщает DigiTimes. Если ранее планировалось применять системы жидкостного и воздушного охлаждения с соотношением 1:1, то теперь на первые будет приходиться лишь 10 % от общего числа, что способно замедлить внедрение СЖО в ЦОД. При этом ранее отраслевые эксперты прогнозировали, что проникновение СЖО на рынок ИИ-серверов вырастет с менее 20 % в 2025 году до более 50 % в 2026-м. Это должно было случиться за счёт расширения поставок GPU- и ASIC. AWS даже смогла разработать в рекордно короткие сроки собственную платформу СЖО, что привело к падению акций Vertiv, одного из бенефициаров ИИ-бума. Новый подход к оборудованию Trainium3 ставит под вопрос будущее и динамику перехода к жидкостному охлаждению. Тем не менее, рост производства Tranium 3 в любом случае поддержит спрос на продукцию ключевых партнёров AWS: Wiwynn, Accton, Auras, Taiwan Microloops и Nan Juen International (Repon). Вероятно, спрос позволит загрузить производственные мощности до конца 2026 года. По мнению аналитиков, решение AWS во многом связано с TDP ускорителей на уровне 800 Вт (хотя раньше говорили об 1000 Вт) — для них, вероятно, достаточно и для современного воздушного охлаждения, что снижает необходимость перехода на более дорогие и сложные СЖО. По данным AWS, Trainium3 приблизительно на 40 % производительнее в сравнении с ускорителями предыдущего поколения. Также компания объявила о капитальных затратах до $200 млрд на расширение ИИ-инфраструктуры, в т.ч. производство собственно ускорителей — на 2027 год запланированы поставки уже Trainium4. Так или иначе, даже после снижения доли СЖО спрос на компоненты у партнёров должен увеличиться за счёт роста производства в целом. Рост популярности жидкостного охлаждения в ИИ ЦОД в последние годы во многом обусловлен ростом TDP ускорителей NVIDIA. Если у H200 показатель был на уровне около 700 Вт, то у B200 — порядка 1000 Вт, а у B300 — уже 1400 Вт. Для будущих архитектур с двумя чипами значения будут ещё выше. В результате операторам ЦОД требуется эффективный отвод тепла, что могут обеспечить СЖО. Кроме того, это позволяет повысить плотность размещения оборудования. В сегменте ASIC рост TDP заметно ниже. Так, для Trainium2 речь шла об около 500 Вт, у Trainium3 — всего 800 Вт, поэтому воздушное охлаждение — вполне рабочий вариант, за исключением некоторых сценариев, например, с высокой плотностью размещения оборудования. Также источники в цепочке поставок подчёркивают, что жидкостные системы дороже устанавливать и обслуживать в сравнении с современными воздушными вариантами. При этом экосистема производства и обслуживания СЖО часто оценивается как «менее зрелая». Благодаря этому организовать поставки серверов с воздушным охлаждением можно быстрее, и они будут более стабильными. Беспокойство операторов ЦОД может вызывать и репутация жидкостных систем. Например, в конце января Wave Power объявила о том, что некоторые проданные компоненты СЖО для ИИ-систем привели к повреждению оборудования, поэтому компании пришлось выложить $4,5 млн, чтобы заключить мировое соглашение. По мнению экспертов, утечки в СЖО — довольно распространённое явление, не привязанное к конкретному вендору, но каждый подобный инцидент свидетельствует о потенциальных проблемах, которые заказчикам приходится принимать в расчёт. Хотя системы жидкостного охлаждения технически предпочтительнее для самых энергоёмких нагрузок благодаря высокой эффективности теплоотвода, потенциалу снижения показателя PUE и способности обеспечить экономию пространства, на примере Trainium3 можно оценить, как совокупность факторов, включая совокупную стоимость владения (TCO) и операционные риски влияют на сроки внедрения СЖО. Изменение планов AWS может повлиять на всю индустрию ИИ ЦОД, которая может замедлить повсеместный переход на жидкостное охлаждение, по крайней мере, в краткосрочной перспективе. Вместе с тем даже для ИИ-платформ нынешнего поколения гиперскейлеры разработали гибридные варианты охлаждения, позволяющие использовать современные системы в старых ЦОД, не рассчитанных изначально на крупномасштабные СЖО. Так, Meta✴ «растянула» суперускорители NVIDIA GB200 на шесть стоек вместо одной, чтобы разместить там теплообменники, а Microsoft с той же целью «пристроила» к стойке с оборудованием модуль шириной в ещё пару стоек. Google же предпочитает для своих TPU именно СЖО.

16.02.2026 [10:11], Сергей Карасёв

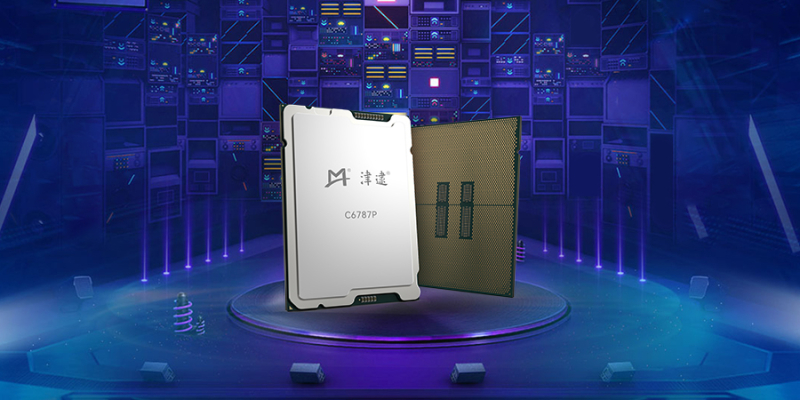

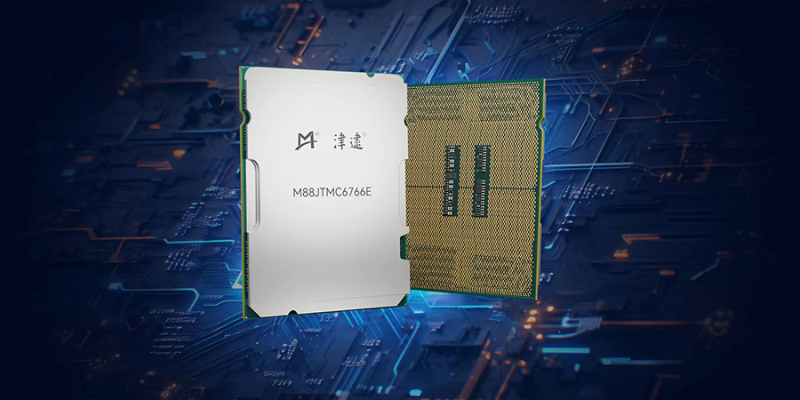

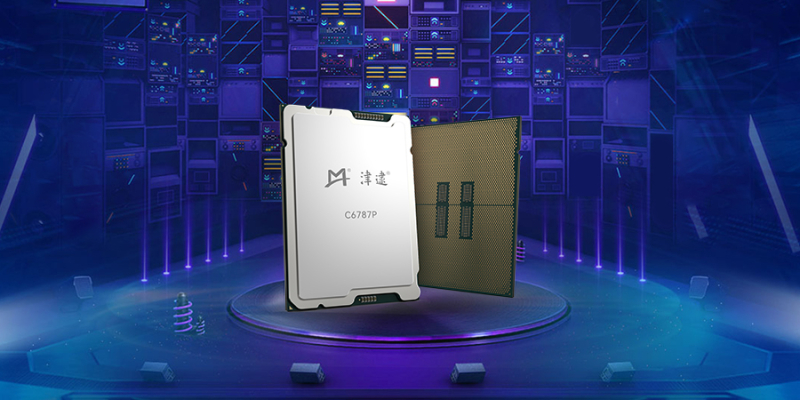

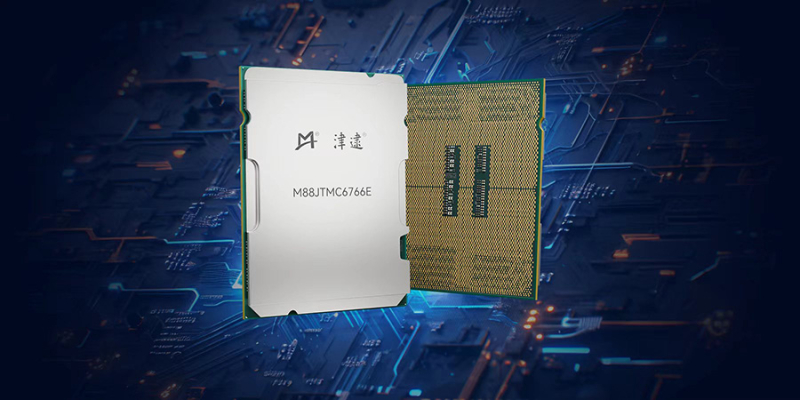

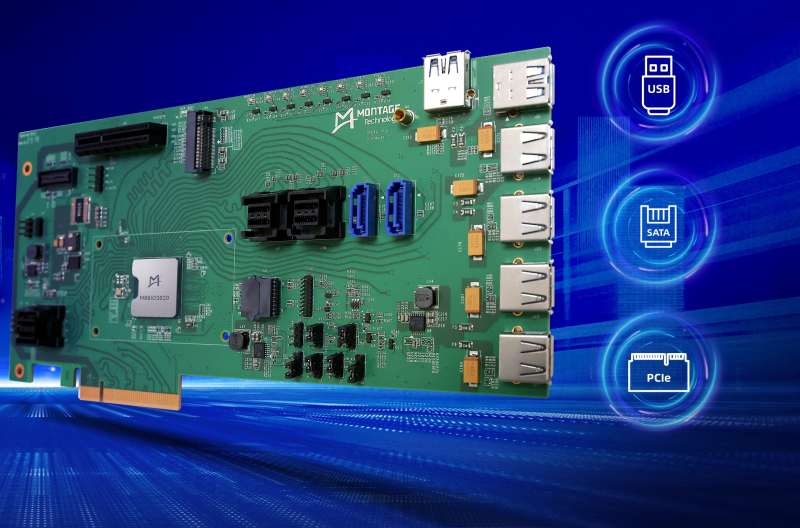

Китайская Montage Technology выпустила серверные процессоры Jintide на базе Intel Xeon 6Китайская компания Montage Technology, на днях осуществившая первичное публичное размещение акций (IPO) на Гонконгской фондовой бирже, выпустила серверные процессоры Jintide следующего поколения, в основу которых положена архитектура Intel Xeon 6, доработанная под требования заказчиков в КНР. В частности, вышли изделия Jintide C6P, которые фактически представляют собой процессоры Intel Xeon 6 семейства Granite Rapids-SP на базе производительных ядер P-core. Их количество в китайских чипах достигает 86 с возможностью одновременной обработки до 172 потоков инструкций, а максимальный объем кеша L3 составляет 336 Мбайт. Реализована 8-канальная подсистема памяти DDR5 с поддержкой модулей RDIMM-6400 и MRDIMM-8000. Процессоры Jintide C6P могут применяться в одно- и двухсокетных конфигурациях. Говорится о поддержке 88 линий PCIe 5.0 и протокола CXL 2.0. Пропускная способность шины UPI достигает 24 ГТ/с. Обеспечивается полная совместимость с набором инструкций x86. Чипы ориентированы на дата-центры и облачные инфраструктуры с высокой вычислительной нагрузкой. Кроме того, дебютировали решения Jintide C6E — это модифицированные изделия Intel Xeon 6 Sierra Forest-SP с энергоэффективными ядрами E-core: их количество достигает 144. Размер кеша L3 составляет до 108 Мбайт. Процессоры имеют восемь каналов памяти DDR5-6400 и до 88 линий PCIe 5.0. Упомянута поддержка CXL 2.0 и шины UPI с пропускной способностью до 24 ГТ/с. Решения Jintide C6E могут устанавливаться в одно-и двухсокетные системы. Компания также анонсировала чип Jintide M88STAR5(N), на основе которого реализуются различные функции безопасности. Изделие, использующее технологию Mont-TSSE (Trust & Security System Extension), отвечает за аппаратное шифрование/дешифрование данных в соответствии с местными стандартами и доверенные вычисления. На кристалле присутствуют нескольких генераторов случайных чисел, а общая пропускная способность достигает 160 Гбит/с через PCIe 5.0 х8. Упомянута поддержка стандартов TPM, TCM и TPCM, а также интерфейсов SMBus, I3C, UART, SPI и GPIO. Наконец, Montage Technology представила чип Jintide M88IO3032 IOH (I/O Hub), предназначенный для использования с CPU нового поколения. Изделие обеспечивает поддержку PCIe 3.0, SATA 3.2 (до 20 портов; RAID 0/1/5/10), USB 3.2/2.0 и пр.

16.02.2026 [00:20], Владимир Мироненко

Разработчик китайских Xeon провёл IPO в Гонконге — Montage Technology привлекла почти $1 млрдАкции китайской компании Montage Technology, специализирующейся на разработке чипов для ЦОД и ИИ-приложений, подскочили на 64 % в ходе первичного размещения (IPO) на Гонконгской фондовой бирже 12 февраля 2026 года после того, как она привлекла HK$7,04 млрд ($900 млн), сообщило агентство Reuters. После размещения по цене HK$106,89 акции разработчика микросхем торговались по цене HK$168, что соответствует верхней границе предложенного диапазона. Всего было предложено 65,9 млн акций. Стоимость предложения Montage Technology в Гонконге было на 44 % ниже цены её акций на Шанхайской бирже накануне, составившей ¥170,90, пишет Bloomberg. Montage Technology также котируется на материковой части Китая, её рыночная стоимость, по данным LSEG, оценивается в около $27 млрд. Согласно результатам первичного размещения акций, опубликованным компанией, книга заявок инвесторов в рамках IPO в Гонконге была переподписана более чем в 700 раз, а при международном размещении — почти в 38 раз, что свидетельствует о высоком интересе инвесторов к китайским компаниям в сфере ИИ и полупроводников, отметил ресурс CNBC. Совместными спонсорами размещения акций Montage выступили China International Capital Corp., Morgan Stanley и UBS Group AG. В размещении приняли участие 17 ключевых инвесторов, которые вложили $450 млн, включая JPMorgan Asset Management, UBS Asset Management и Yunfeng Capital. «Сильный состав глобальных ключевых покупателей свидетельствует о том, что китайские IPO, связанные с ИИ, снова привлекают институциональных инвесторов на рынок HKEX», — отметил Уинстон Ма (Winston Ma), адъюнкт-профессор юридической школы Нью-Йоркского университета и бывший глава североамериканского подразделения CIC, китайского суверенного фонда, имея в виду Гонконгскую фондовую биржу. «Дебют Montage в Гонконге подчеркивает, как китайская экосистема чипов для ИИ движется “вверх по стеку” от базовых компонентов к специализированным чипам, которые соединяют процессоры и память внутри ЦОД», — добавил он. IPO Montage также совпало с самым сильным стартом года Гонконгской фондовой биржи с 2021 года: в январе в ходе IPO и вторых размещений было привлечено около $5,5 млрд, что является самым высоким показателем с января 2021 года, когда было привлечено $7,6 млрд (согласно данным LSEG). Как сообщила Montage Technology, вырученные от продажи акций средства будут направлены на разработку новых технологий, а также использованы для финансирования коммерциализации проектов, стратегических инвестиций или приобретений, и в качестве оборотного капитала. Montage Technology производит, в том числе, CXL-интерконнекты для ЦОД. Согласно документам, поданным ею на Гонконгскую фондовую биржу со ссылкой на американскую консалтинговую компанию Frost & Sullivan, в 2024 году компания была крупнейшим в мире поставщиком таких микросхем, занимая более трети рынка (36,8 %) по выручке. Выручка компании выросла за девять месяцев, закончившихся 30 сентября 2025 года, на 58 % год к году до ¥4,1 млрд ($591 млн), а чистая прибыль — на 64 % до ¥1,6 млрд. Компания также известна адаптацией серверных процессоров Intel Xeon под требования китайских заказчиков. В частности, в 2023 году она представила защищённые процессоры Jintide четвёртого поколения, фактически представляющие собой доработанные чипы Sapphire Rapids. Чуть позже она выпустила CPU Jintide пятого поколения, уже на базе Emeral Rapids. А в прошлом году были представлены варианты на базе Xeon 6 — и Sierra Forrest-SP (6700E), и Granite Rapids-SP (6700P).

15.02.2026 [16:00], Руслан Авдеев

Серверы вместо виски: тайваньский импортёр алкоголя Agencia Comercial Spirits решил вложиться в ИИ и ЦОДБазирующийся на Тайване импортёр и дистрибутор виски и иного алкоголя намерен попробовать силы на рынке дата-центров. Компания Agencia Comercial Spirits Ltd объявила о подписании двух писем о намерениях, касающихся потенциального участия в строительстве ЦОД, сообщает Datacenter Dynamics. Компания подписала письмо с провайдером облачной инфраструктуры Ricloud AI Inc. Потенциальные партнёры определили предварительные условия взаимодействия, в рамках которого Agencia будет арендовать NVIDIA B300. В частности, говорится о потенциале аренды 300 ИИ-ускорителей на сумму около $120 млн. Ricloud, облачный партнёр NVIDIA, имеет портфоло из 10 строящихся и действующих дата-центров на пяти континентах с более 3 ГВт вычислительной мощности. Также компания подписала отдельное не обязывающее письмо о намерениях с неназванным индонезийским контрагентом относительно земельного участка площадью 50 тыс. м2 для строительства ИИ ЦОД в Индонезии.

Источник изображения: Obi/unsplash.com Agencia Comercial Spirits Ltd занимается импортом и дистрибуцией виски (как бутылочного, так и бочкового), а также японского сакэ. Компания вышла на биржу Nasdaq в октябре 2025 года. В своём пресс-релизе она отмечает, что предложенный ИИ-проект является потенциальным отходом от её «исторической линии бизнеса» и связан со «значительными рисками и неопределённостью». Также отмечается, что оба письма носят необязывающий характер и что соглашения могут не принести вообще никаких плодов. В последние годы компании, особенно в Юго-Восточной Азии, пытаются резко сменить профиль деятельности в попытке заработать на волне бума ИИ. Есть даже примеры перехода от сфер авиации и общепита к созданию дата-центров.

15.02.2026 [15:46], Владимир Мироненко

Legrand приобрела Kratos и инвестировала в Accelsius для расширения предложений для ИИ ЦОДLegrand, французский поставщик решений для электротехнической и цифровой инфраструктуры зданий, обслуживающей жилой, коммерческий, промышленный рынки и ЦОД, объявил о приобретении Kratos Industries из Арвады (Arvada, штат Колорадо), производителя низковольтного (НВ) и средневольтного (СВ) силового оборудования. Также Legrand сообщила об участии в раунде финансирования серии B компании Accelsius, специализирующейся на двухфазном прямом жидкостном охлаждении. «В совокупности эти шаги значительно расширяют возможности Legrand в области распределения электроэнергии и передового управления тепловыми процессами, позволяя ЦОД удовлетворять растущие потребности в ИИ и высокоплотных вычислительных средах», — отметила Legrand в пресс-релизе. «Принимая Kratos в состав Legrand, мы расширяем наши возможности по обслуживанию всей системы электропитания ЦОД, гарантируя нашим клиентам наличие единого, надёжного партнёра для всей их экосистемы электропитания», — заявила компания. Kratos использует вертикально интегрированную модель с подходом «проектирование под заказ». Благодаря её приобретению Legrand может предложить более надёжный портфель решений для критически важных систем электропитания на рынке ЦОД, охватывая весь спектр решений от кабельных лотков с нагрузочными стендами до шинопроводов и блоков распределения питания (PDU) для стоек. Что касается инвестиций Legrand в Accelsius, то в рамках партнёрства компании планируют совместные инициативы по разработке СЖО для интеграции в инфраструктуру на уровне стоек, ориентированные в ИИ-фабрики и другие высокопроизводительные вычислительные среды. Хотя большая часть бизнеса Legrand приходится на электротехнические решения для жилых и коммерческих зданий, ИИ оказал преобразующее воздействие на компанию, заявил генеральный директор Legrand Бенуа Кокар (Benoit Coquart) агентству Reuters. По его словам, на решения для ЦОД приходится 26 % выручки компании в 2025 году, и этот показатель может достичь 40 %. Выручка Legrand в 2025 году составила €9,48 млрд ($11,26 млрд, рост год к году на 9,6 %), что немного выше прогноза аналитиков, равного €9,46 млрд. Скорректированная операционная прибыль компании выросла год к году на 10,5 % до $1,96 млрд, что соответствует ожиданиям аналитиков. Legrand ожидает рост продаж в 2026 году на 10–15 %, скорректированную операционную маржу на уровне 20,5–21 %.

15.02.2026 [15:10], Сергей Карасёв

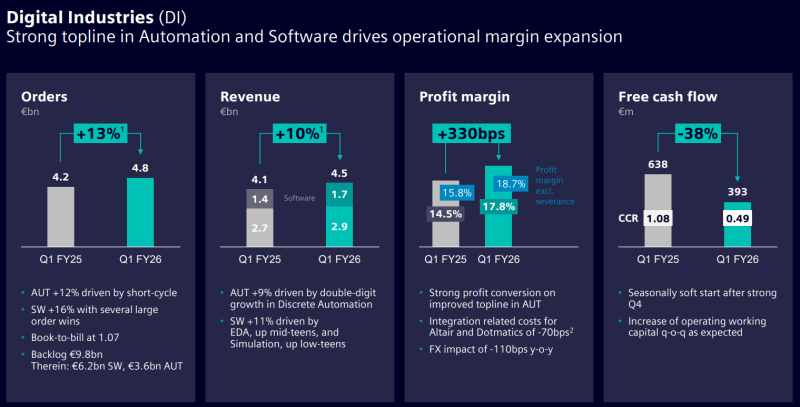

Siemens наращивает выручку и объём заказов на фоне бума ИИНемецкий конгломерат Siemens отрапортовал о работе в I четверти 2026 финансового года, которая была закрыта 31 декабря 2025-го. Выручка за трёхмесячный период достигла €19,14 млрд, что на 4 % больше по сравнению с результатом за аналогичный период предыдущего финансового года, когда было получено €18,35 млрд. Общий объём заказов в годовом исчислении увеличился на 7 % — с €20,07 млрд до €21,37 млрд. При этом чистая прибыль сократилась на 43 %, составив €2,22 млрд против €3,87 млрд годом ранее. Однако в результаты I квартала 2025 финансового года включена прибыль в размере €2,1 млрд евро (после уплаты налогов) от продажи Innomotics — подразделения по производству двигателей и приводов. Увеличение выручки Siemens связывает с бумом ИИ, который спровоцировал расширение глобальной инфраструктуры дата-центров. В подразделении промышленных решений Siemens Digital Industries квартальная выручка поднялась на 12 % — с €4,05 млрд до €4,53 млрд, тогда как объём заказов увеличился с €4,21 млрд до €4,85 млрд, то есть, на 15 %. В сегменте умных инфраструктур Siemens Smart Infrastructure продажи выросли на 5 % — с €5,29 млрд до €5,53 млрд, а объём заказов прибавил 16 %, достигнув €7,17 млрд против €6,20 млрд годом ранее. В целом, индустриальный бизнес Siemens в I квартале 2026 финансового года обеспечил прибыль в размере €2,90 млрд против €2,52 млрд годом ранее. Siemens ожидает, что стремительное развитие ИИ в промышленном секторе и высокий спрос на соответствующие продукты для дата-центров и платформ автоматизации продолжат оказывать положительное влияние на финансовые показатели компании. Siemens, в частности, говорит о значительной динамике в США и Китае. Кроме того, Siemens наряду наряду с Caterpillar, GE Vernova и Mitsubishi Heavy Industries выиграла от резко возросшего спроса на газовые турбины для питания ИИ ЦОД. |

|