Материалы по тегу: ии

|

25.12.2025 [09:40], Руслан Авдеев

«Парадоксальную» Fermi America подозревают в манипуляциях с ценными бумагамиЮридическая фирма Robbins Geller Rudman & Dowd начала расследование в отношении Fermi America — уникального стартапа, обещающего построить гигантский ИИ ЦОД HyperGrid (Project Matador) площадью 167 га и мощностью 11 ГВт в техасском Амарилло (Amarillo), а также комплекс АЭС, турбин и иных энергетических мощностей, сообщает Datacenter Dynamics. Проект неоднократно вызывал обоснованные сомнения у экспертов. Компания, основанная бывшим министром энергетики США и губернатором Техаса Риком Перри (Rick Perry), фактически не имеет опыта строительства столь масштабных объектов, что не помешало ей провести IPO и привлечь $682 млн при оценке капитализации в районе $15 млрд. Сейчас компанию подозревают в нарушении федеральных законов о ценных бумагах — его инициировали после того, как сорвалось соглашение с ключевым арендатором, намеревавшимся участвовать в проекте, что привело к стремительному падению стоимости акций Fermi America. По слухам, арендатором хотела стать Amazon, но Fermi отрицает это.

Источник изображения: Kaleidico/unsplash.com Так, в сентябре 2025 года Fermi заявила о подписании необязывающего письма о намерениях (LOI) с арендатором, имеющим «инвестиционный рейтинг». Предполагалось, что он станет первым клиентом гигантского кампуса. По данным источников, сделку оценивали в $150 млн. Тем не менее ранее в декабре компания опубликовала официальное заявление, в котором сообщалось что срок «эксклюзивности», указанный в письме, истёк, а потенциальный арендатор расторг соглашение, хотя не прекращает переговоров об аренде объектов на территории кампуса. Robbins Geller Rudman & Dowd заявила, что расследование уделит пристальное внимание тому, делали ли представители Fermi вводящие в заблуждения заявления и не раскрывали ли инвесторам информацию, связанную с договором аренды и привязанным к нему финансированием. У инвесторов, понёсших убытки, запрашивается соответствующая информация.

25.12.2025 [02:15], Игорь Осколков

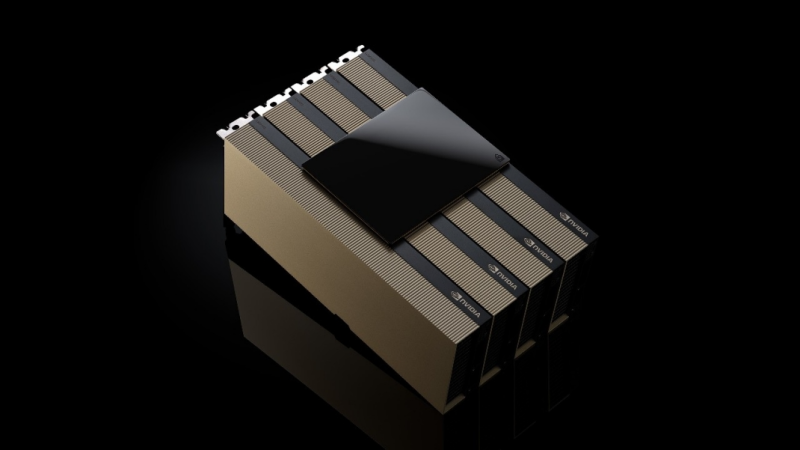

NVIDIA купит за $20 млрд активы разработчика ИИ-ускорителей Groq — это самая дорогая покупка в истории компанииNVIDIA приобретёт активы Groq, своего конкурента в области ИИ-ускорителей, за $20 млрд, передаёт CNBC. Сама Groq заявила, что «заключила неисключительное лицензионное соглашение с NVIDIA на технологии инференса» и что основатель и генеральный директор Groq Джонатан Росс (Jonathan Ross), а также президент компании Санни Мадра (Sunny Madra) и другие высокопоставленные сотрудники «присоединятся к NVIDIA, чтобы помочь продвижению и масштабированию лицензированной технологии». При этом Groq продолжит свою деятельность как независимая компания под руководством Саймона Эдвардса (Simon Edwards). Финансовый директор Nvidia Колетт Кресс (Colette Kress) отказалась комментировать сделку. По-видимому, речь фактически идёт о поглощении Groq, а столь необычная форма сделки выбрана, по примеру других, в попытке снизить внимание к ней регулирующих органов. Стоимость сделки официально не называется, однако Алекс Дэвис (Alex Davis), глава Disruptive, которая инвестировала в Groq более $500 млн, называет сумму в $20 млрд, причём «живыми» деньгами. Дэвис сообщил CNBC, что NVIDIA получит все активы Groq, за исключением её облачного бизнеса. Groq заявила, что «GroqCloud продолжит работать без перебоев». В электронном письме сотрудникам, полученном CNBC, глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил, что сделка расширит возможности NVIDIA: «Мы планируем интегрировать ускорители Groq в архитектуру NVIDIA AI Factory, расширив платформу для обслуживания ещё более широкого спектра задач инференса и рабочих нагрузок в реальном времени». Хуанг добавил: «Хотя мы пополняем наши ряды талантливыми сотрудниками и лицензируем интеллектуальную собственность Groq, мы не приобретаем Groq как компанию». Эта сделка является крупнейшей покупкой NVIDIA за всю историю. До этого самой крупной сделкой была покупка Mellanox почти за $7 млрд в 2019 году. В конце октября у NVIDIA было $60,6 млрд наличных средств и краткосрочных инвестиций, что на $13,3 млрд больше, чем в начале 2023 года. По схожей с Groq схеме была организована и сделка c Enfabrica, в рамках которой NVIDIA заплатила $900 млн деньгами и акциями за лицензирование технологий и переход главы Enfabrica Рочана Санкара (Rochan Sankar) и других ключевых в NVIDIA. Всего три месяца назад Groq, основанная в 2016 году разработчиками ИИ-ускорителей Google TPU, привлекла $750 млн при оценке примерно в $6,9 млрд. Раунд возглавила Disruptive, к которой присоединились Blackrock, Neuberger Berman, Deutsche Telekom Capital Partners, Samsung, Cisco, D1, Altimeter, 1789 Capital и Infinitum. Повлияло ли на решение NVIDIA слухи о намерении Intel купить разработчика ИИ-ускорителей для инференса SambaNova, который наряду с Cerebras является одним из немногих стартапов, способных составить хоть какую-то серьёзную конкуренцию NVIDIA, не уточняется. Сама Groq планировала достичь выручки в $500 млн в этом году. По словам Дэвиса, компания не планировала продажу, когда к ней обратилась NVIDIA. В сентябре NVIDIA объявила о намерении вложить $5 млрд в Intel, а также инвестировать до $100 млрд в OpenAI. Впрочем, последняя сделка носит циклический характер и пока далеко не продвинулась.

25.12.2025 [00:50], Владимир Мироненко

С глаз — долой, с баланса — вон: гиперскейлеры переложили на плечи инвесторов $120 млрд займовВ последнее время сформировался тренд на вывод технологическими компаниями за пределы своих балансов кредитования проектов по развитию ИИ-инфраструктуры. По данным The Financial Times, ряд IT-гигантов обошелся без учёта в своих балансах более $120 млрд, связанных с расходами на ЦОД, благодаря созданию компаний специального назначения — SPV (special-purpose vehicle), финансируемых большей частью инвесторами с Уолл-стрит, что усиливает опасения по поводу финансовых рисков их огромной ставки на ИИ. Речь идёт о Meta✴, xAI, Oracle и CoreWeave, которые лидируют по суммам заключённых сложных финансовых сделок, к которым они прибегли с целью защиты от рисков крупных заимствований, необходимых для строительства ИИ ЦОД. Указанную сумму им предоставили финансовые институты, включая Pimco, BlackRock, Apollo, Blue Owl Capital и американские банки, такие как JPMorgan, в виде заёмных и собственных средств. В октябре компания Meta✴ заключила крупнейшую сделку по привлечению частного кредита для строительства ЦОД Hyperion в Луизиане (США), в рамках которой была создана специализированная компания Beignet Investor совместно с нью-йоркской финансовой фирмой Blue Owl Capital. Beignet Investor привлекла $30 млрд, включая около $27 млрд кредитов от Pimco, BlackRock, Apollo и других, а также $3 млрд акционерного капитала от Blue Owl. Эта сделка не была отражена на балансе Meta✴, что упростило ей привлечение ещё $30 млрд на рынке корпоративных облигаций спустя несколько недель. Привлечение частного капитала через внебалансовые структуры защищает кредитные рейтинги компаний и улучшает их финансовые показатели, отметил The Financial Times. В данном случае Meta✴ получила во владение 20 % SPV и предоставила «гарантию остаточной стоимости» другим инвесторам. Это означает, что она должна будет вернуть средства инвесторам SPV, если стоимость ЦОД упадет ниже определённого уровня к концу срока аренды, а Meta✴ не станет продлевать договор аренды. Oracle стала лидером в структурировании крупных долгов через третьих лиц для оплаты своих огромных обязательств по сдаче в аренду вычислительных мощностей компании OpenAI. Она заключила партнёрские соглашения с застройщиками и финансистами, такими как Crusoe, Blue Owl Capital, Vantage и Related Digital, для строительства целого ряда ЦОД, каждый из которых будет принадлежать SPV. В частности, Blue Owl и JPMorgan инвестировали $13 млрд, включая $10 млрд заёмных средств, в SPV, владеющую ЦОД OpenAI в Абилине (штат Техас). Также упоминается пакет долговых обязательств на сумму $38 млрд для оплаты строительства двух ЦОД в Техасе и Висконсине, и кредит на сумму $18 млрд на строительство ЦОД в Нью-Мексико. При этом Oracle будет арендовать эти объекты у SPV. В случае дефолта кредиторы будут иметь право на активы — ЦОД, земельный участок, на котором он расположен, и оборудование, но не на компании, управляющие объектами. При этом Blue Owl стала более осторожно подходить к сделкам с Oracle. xAI использовала аналогичную стратегию для привлечения $20 млрд, включая до $12,5 млрд заёмных средств. Созданное SPV будет использовать эти деньги для покупки ускорителей NVIDIA с последующей сдачей их в аренду xAI. В марте CoreWeave заявила о создании SPV для выполнения контрактов на сумму $22,4 млрд на поставку вычислительных мощностей компании OpenAI, что «потребует привлечения заемных средств для финансирования своих обязательств». В июле компания заняла ещё $2,6 млрд для финансирования реализации контрактов с OpenAI. Традиционно технологические компании обладали значительными средствами и имели небольшую задолженность, что обеспечивало им отличные кредитные рейтинги и высокую уверенность со стороны инвесторов. Поскольку объём капитала, необходимого для финансирования роста ИИ-инфраструктуры, резко возрос, это истощило денежные резервы технологических компаний. По оценкам Morgan Stanley, для финансирования планов технологических компаний в области ИИ требуется $1,5 трлн внешнего финансирования. При этом частные инвесторы тоже стремятся заработать на буме ИИ, что повышает спрос на подобные сделки. По данным UBS, к началу 2025 года технологические компании привлекли у частных фондов около $450 млрд, что на $100 млрд больше, чем за предыдущие 12 месяцев. В этом году, по данным UBS, около $125 млрд было направлено на сделки по «проектному финансированию» — долгосрочному финансированию инфраструктурных проектов, таких как сделки Meta✴ и Blue Owl. Следует отметить, что не все гиперскейлеры следуют этому тренду. Google, Microsoft и Amazon — у которых до бума ИИ были крупные, хорошо зарекомендовавшие себя дата-центры — продолжают финансировать строительство за счёт собственных средств. Хотя Google и Amazon недавно привлекли инвесторов в облигации для прямого увеличения заёмных средств, эти три компании пока не сообщали о каком-либо значительном финансировании через SPV. Уолл-стрит также использует другие виды сделок на рынке ЦОД. По словам банкиров, в последние месяцы наблюдались сделки по секьюритизации долга в сфере ИИ, когда кредиторы объединяют непогашенные кредиты и продают инвесторам их доли в виде обеспеченных активами ценных бумаг. Два банкира оценили эти сделки в несколько миллиардов долларов. Такого рода сделки позволяют распределить риск кредитования провайдеров ЦОД между гораздо более широким кругом инвесторов, включая управляющих активами и пенсионные фонды. При этом множество сделок так или иначе связано с NVIDIA.

24.12.2025 [17:13], Руслан Авдеев

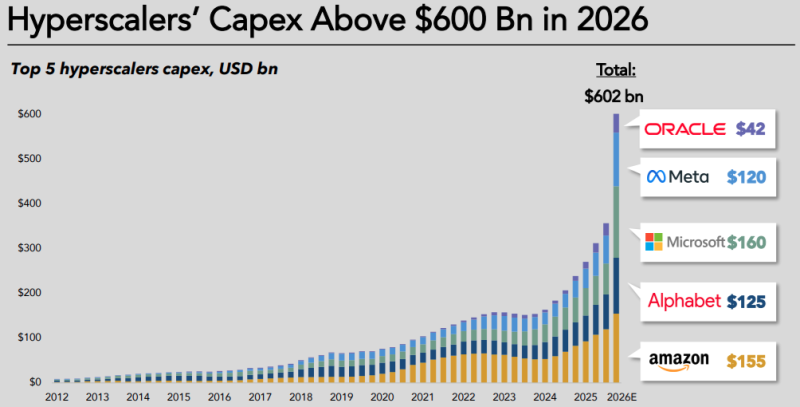

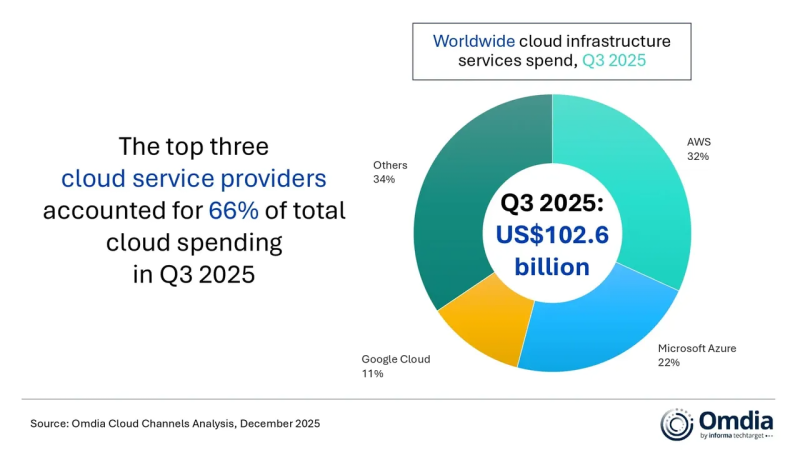

Капитальные затраты гиперскейлеров в 2026 году вырастут на треть и превысят $600 млрдКапитальные затраты «большой пятёрки» гиперскейлеров, включающей Amazon, Google, Microsoft, Meta✴ и Oracle, по прогнозам экспертов, превысят $600 млрд — это на 36 % больше, чем в 2025 году, сообщается в техноблоге IEEE ComSoc. Из них около 75 % или $450 млрд будет напрямую связано с ИИ-инфраструктурой (ЦОД, серверами, ускорителями и иным оборудованием). Поскольку собственных денежных средств после выкупа акций и выплаты дивидендов уже не хватает, компании, традиционно финансировавшие свои проекты в основном за счёт внутренних ресурсов, активно осваивают рынки долговых обязательств. Хотя финансовое положение гиперскейлеров по-прежнему остаётся стабильным, трансформируется сама модель финансирования. По данным Omdia, в III квартале 2025 года общемировые затраты на облачную инфраструктуру достигли $102,6 млрд, т.е. на четверть боьлше год к году. Уже пятый квартал подряд рост облачных расходов превышал 20 %. AWS, Microsoft Azure и Google Cloud в целом сохранили свои рыночные позиции, которые они занимали кварталом ранее, всего на их долю приходилось 66 % мировых расходов на облачную инфраструктуру. На трёх облачных провайдеров совокупный рост год к году составил 29 %. Omdia сообщает, что ситуация на рынке в целом отражает изменения технологического ландшафта по мере того, как корпоративный спрос на ИИ меняется с переходом от ранних экспериментов к масштабному внедрению. Акцент в бизнес-стратегиях гиперскейлеров сместился с предложения максимально производительных отдельных «моделей-рекордсменов» на создание комплексных, готовых к масштабированию ИИ-платформ. Они обеспечивают выбор и комбинированное использование различных моделей и ИИ-агентов. AWS, Microsoft Azure и Amazon превращают облака в единые экосистемы с интеграцией собственных и сторонних ИИ-моделей. Как утверждают эксперты Omdia, коллаборации в рамках общей ИИ-экосистемы остаются критически важными. Поддержка пакетов моделей разных разработчиков становится скорее необходимым требованием, чем необычной функцией. Корпоративные клиенты ищут надёжности, возможности контроля цен и гибкости при внедрении для выполнения ИИ-задач. Гиперскейлеры, наращивают ресурсы для управления жизненным циклом ИИ-агентов, включая их создание и развёртывание на уровне корпоративных клиентов, поскольку практическое внедрение оказалось несколько сложнее, чем ожидалось.

Источник изображения: Omdia Как заявляют в Omdia, массовому внедрению ИИ-агентов мешает отсутствие у компаний готовых, стандартизированных решений, которые одновременно обеспечивали бы бесперебойную работу бизнеса, качественный клиентский опыт и соответствие таких агентов регуляторным требованиям. Недавно Omdia сообщала, что капитальные затраты на ЦОД в целом вырастут к 2030 году до $1,6 трлн — если раньше не лопнет ИИ-пузырь. В августе она же объявила, что расходы гиперскейлеров на дата-центры превысили ВВП целых стран.

24.12.2025 [14:29], Руслан Авдеев

Goodman Group и CPP Investments построят в Европе дата-центры на €8 млрдАвстралийская Goodman Group совместно с канадским фондом Canada Pension Plan Investment Board (CPP Investments) достигли соглашения о партнёрстве в сфере ЦОД в Европе общей стоимостью €8 млрд ($9,4 млрд), сообщает Datacenter Dynamics. Предприятие с равным участием сторон предполагает на первом этапе инвестирование обеими компаниями €2,2 млрд ($2,59 млрд) на строительство дата-центров во Франкфурте, Амстердаме и Париже. Goodman European Data Centre Development Partnership займётся четырьмя проектаами общей мощностью 435 МВт (IT-мощность 282 МВт): два дата-центра в Париже (PAR01 и PAR02), один во Франкфурте (FRA02) и один в Амстердаме (AMS01). По словам партнёров, все проекты обеспечены возможностью подключения электроэнергии, получили разрешения на строительство, а на площадках уже ведутся активные работы, что позволит начать строительство в I полугодии 2026 года. В CPP Investments выразили удовлетворение новым партнёрством с Goodman Group в Европе, позволяющем организовать присутствие на рынках ЦОД уровня Tier I. Предполагается, что строительные возможности Goodman и обширный «земельный банк» компании, а также глобальный опыт CPP Investments в инвестициях в ИИ-инфраструктуру позволяет извлечь выгоду из возможностей роста в сфере ИИ. Сделка будет реализована поэтапно, её закрытие запланировано на март 2026 года. Компании уже работают вместе с 2009 года, инвестируя в проекты в Австралии, Азии, на американских континентах и в Европе.

Источник изображения: Kai Pilger/unsplash.com В Goodman Group отметили, что создание портфолио такого масштаба и качества в регионе FLAPD (Франкфурт, Лондон, Амстердам, Париж и Дублин) — весьма редкий проект. Подобные локации высоко востребованы для удовлетворения растущего спроса на облачные вычисления и внедрение ИИ. Качество и масштаб партнёрства обеспечивает «идеальное взаимовыгодное» взаимодействие с CPP Investments при выходе на европейский рынок. CPP уже имеет в портфолио несколько значимых инвестиций в сфере цифровой инфраструктуры. CPP Investments осуществили первые прямые инвестиции в ЦОД в 2017 году. В ноябре 2024 года компания инвестировала ₩1 трлн ($711 млн) в совместное предприятие с Pacific Asset Management Company для строительства ЦОД гиперскейл-уровня в Южной Корее, пополнив портфолио, состоящее из проектов в Австралии, Гонконге, Японии, Малайзии, Сингапуре, США и Канаде. В августе она выделила CA$225 млн ($160 млн) на расширение кампуса ЦОД в Кембридже (Онтарио, Канада). Goodman Group представляет собой австралийский бизнес, занимающийся проектами в сфере недвижимости. За последние годы компания последовательно расширяла присутствие на рынке ЦОД. Сегодня она имеет действующие или строящиеся объекты в Гонконге, Австралии, Германии, США, Франции и Японии.

24.12.2025 [12:14], Сергей Карасёв

Google Cloud и Palo Alto Networks заключили партнёрское соглашение на $10 млрдОблачная платформа Google Cloud и калифорнийская компания Palo Alto Networks, специализирующаяся на услугах в области информационной безопасности, по информации Reuters, заключили многолетнее соглашение о сотрудничестве. Как сообщили осведомлённые лица, в договоре прописано обязательство Palo Alto Networks выплатить Google Cloud сумму, «приближающуюся к $10 млрд». На сегодняшний день это крупнейшая сделка в истории облачной площадки. Сами компании отказались комментировать финансовые условия контракта. По словам президента Palo Alto Networks Би Джей Дженкинса (BJ Jenkins), часть средств в рамках соглашения пойдёт на перенос существующих сервисов компании в облако Google Cloud. Кроме того, значительная сумма выделяется на развёртывание новых сервисов в сфере кибербезопасности, использующих технологии ИИ. Отмечается, что ИИ оказывает двоякое влияние на сектор ИБ. С одной стороны, нейросетевые технологии помогают в выявлении уязвимостей и новых атак, а также в автоматизации рутинных задач по защите IT-инфраструктуры. Но, с другой стороны, злоумышленники также берут на вооружение ИИ для написания вредоносного кода, поиска дыр в ПО и пр. Кибератаки всё чаще совершаются с использованием тех же инструментов генеративного ИИ, которые поставщики ИБ-услуг применяют для усиления защиты. На фоне стремительного расширения ИИ-рынка и Google, и Palo Alto Networks инвестируют значительные средства в решения нового поколения для обеспечения безопасности. В частности, Google в марте уходящего года объявила о покупке стартапа Wiz, работающего в области информационной безопасности: сумма сделки составляет $32 млрд. В свою очередь, Palo Alto Networks внедрила решения на основе ИИ в октябре, после чего сообщила о планах по покупке разработчика средств мониторинга для ИИ-платформ Chronosphere за $3,35 млрд.

24.12.2025 [08:42], Владимир Мироненко

Western Digital: HDD сохранят актуальность для ИИ ЦОД в ИндииОвайс Мохаммед (Owais Mohammed), директор по продажам Western Digital в Индии, на Ближнем Востоке и Африке заявил в интервью ETTelecom, что согласно исследованиям рынка, порядка 80 % данных ЦОД по-прежнему хранится на жестких дисках. HDD отличаются более низкой по сравнению с SSD совокупной стоимостью владения (TCO), что позволяет наращивать их использование. «Поэтому я не ожидаю увидеть существенных изменений в ближайшем будущем», — сказал он. Мохаммед отметил, что реализация инициатив по цифровизации и концепции «умных городов», строительство ЦОД и потребности в системах видеонаблюдения в потребительском и корпоративном секторах стимулируют спрос на устройства хранения данных в Индии. В связи с планами Индии удвоить мощности ЦОД в течение следующих пяти лет следует ждать удвоения объёмов хранения данных, что свидетельствует о большом потенциале роста в сегменте жёстких дисков, утверждает Овайс Мохаммед. В настоящее время установленная мощность ЦОД в стране составляет более 1 ГВт, и, по прогнозам исследовательских агентств, в 2026 году этот показатель достигнет 2 ГВт, а к 2030 году — более 8 ГВт, для чего потребуется более $30 млрд капитальных затрат. Топ-менеджер Western Digital сообщил, что операционные команды компании в Индии и по всему миру работают в тесной координации, поэтому партнёры по каналам продаж получают стабильные потоки товаров, поддержку и взаимодействие без сбоев в текущих программах. Western Digital не публикует финансовые показатели по регионам, но отметила, что её бизнес в Индии показывает хорошие результаты, и страна является важным центром разработки ПО. «У нас много инженеров на предприятии в Бангалоре. Они вносят свой вклад в наши инициативы в области интеллектуальной собственности, включая работу над новейшими технологиями и тестирование встроенного ПО, что способствует развитию продуктов Western Digital», — сообщил Мохаммед.

24.12.2025 [00:42], Владимир Мироненко

Biren, один из «четырёх маленьких драконов», планирует привлечь $624 млн благодаря IPO в ГонконгеШанхайский разработчик ИИ-ускорителей Biren Technology начал формирование книги заявок для своего первичного публичного размещения акций (IPO) в Гонконге, которое пройдёт 2 января, сообщил ресурс South China Morning Post. Компания выставит на продажу 247,7 млн акций по цене от HK$17 до HK$19,60 за акцию, планируя привлечь до HK$4,85 млрд ($624 млн). Biren входит в число китайских «четырёх маленьких драконов» в сегменте GPU — наряду с материковыми Moore Threads Technology, MetaX Integrated Circuits и Enflame Technology. Для участия в IPO компания привлекла 23 ключевых инвестора, включая крупные компании по управлению активами, отечественные паевые инвестиционные фонды и страховые компании, международные долгосрочные фонды и хедж-фонды, которые согласились инвестировать $372,5 млн в акции и держать их в течение шести месяцев. Qiming Venture Partners, Ping An Group, Lion Global Investors, азиатский хедж-фонд York Capital Management, MY.Alpha Management HK Advisors, подразделение по управлению активами Prudential Eastspring, UBS, Digital China и China Southern Asset Management. Biren станет первым разработчиком GPU из материкового Китая, вышедшим на биржу в Гонконге. Он присоединится к растущему числу китайских технологических компаний с материка, стремящихся к листингу в Гонконге, в числе которых ИИ-стартап MiniMax, который успешно прошёл слушания по IPO на Гонконгской фондовой бирже в воскресенье, и ИИ-стартап Knowledge Atlas Technology (Zhipu AI), прошедший эту процедуру в минувшую пятницу. IPO Biren проходит на фоне стремительного дебюта её конкурентов Moore Threads Technology и MetaX Integrated Circuits в этом месяце на фондовой бирже в Шанхае, где их акции подскочили на 425 и 693 % соответственно. Biren начала получать доход от своих ИИ-решений в 2023 году. По данным South China Morning Post, в прошлом году её выручка составила ¥336,8 млн ($47,9 млн), а в I полугодии 2025 года — ¥58,9 млн ($8,4 млн). Несмотря на рост доходов, Biren остается убыточной, поскольку активно инвестирует в исследования и разработки. Компания сообщила, что большую часть средств, полученных от IPO, направит на R&D, а также на коммерциализацию своих решений. Развитие компании притормозили санкции США — Biren лишили доступа к мощностям TSMC. Аналитики рассматривают проведение IPO Biren как ключевую проверку международного доверия к китайским компаниям, занимающимся выпуском аппаратным обеспечением для ИИ-нагрузок. Агентство Bloomberg привело слова руководителя Barclays Мэтта Томса (Matt Toms): «Китай очень быстро догоняет в войне за чипы. Меня бы не удивило, если бы в 2026 или 2027 году мы стали свидетелями “момента DeepSeek” для чипов, когда Китай начнёт производить недорогие конкурентоспособные чипы».

23.12.2025 [15:03], Руслан Авдеев

Google купит Intersect Power за $4,75 млрд, получив несколько гигаватт энергии для своих ИИ ЦОДGoogle объявила о покупке за $4,75 млрд американского девелопера энергетической инфраструктуры Intersect Power, сообщает Datacenter Dynamics. Google также возьмёт на себя долги приобретаемой компании. Сделка будет закрыта в I половине 2026 года. В рамках сделки «материнская» Google структура — Alphabet получит портфолио как строящихся, так и находящихся в разработке активов Intersect на несколько гигаватт. Google уже является миноритарным акционером Intersect. Google сообщает, что Intersect не только позволит расширить мощности и более гибко строить генерирующие мощности с учётом потребностей новых дата-центров, но и переосмыслить энергетические проекты, чтобы стимулировать инновации и обеспечить лидерство США в связанных сферах. При этом Intersect останется отдельным юридическим лицом, а некоторые активы в Техасе и Калифорнии будут функционировать как независимый бизнес, поддерживаемый TPG Rise Climate, Climate Adaptive Infrastructure и Greenbelt Capital Partners. После сделки Intersect получит новые технологии для наращивания и диверсификации поставок энергии. Компанией продолжит управлять действующий глава Шелдон Кимбер (Sheldon Kimber). В то же время предусмотрено сотрудничество с командой Google, занимающейся технической инфраструктурой. В числе прочего речь идёт о ранее анонсированной инициативе по созданию дата-центра и энергоплощадки в техасском округе Хаскелл (Haskell, Техас).

Источник изображения: Intersect Power Intersect Power специализируется на экологически чистой энергетике. Её портфолио включает солнечные энергетические установки и аккумуляторные энергохранилища на 2,4 ГВт∙ч, в первую очередь в Техасе и Калифорнии. В 2024 году компания впервые начала взаимодействовать с Google для разработки технологий размещения источников возобновляемой энергии и энергохранилищ при новых ЦОД по всей территории США. В рамках первоначального соглашения Intersect согласилась построить объекты «зелёной» энергетики для Google, которая намеревалась закупать энергию для кампусов ЦОД и стать якорным арендатором в новых технопарках. Также Intersect тесно взаимодействует с другими участниками технологической экосистемы, наиболее значимым из которых является Tesla. По данным Intersect, компания заключила соглашение о покупке аккумуляторных энергохранилищ Tesla Megapack на 17,7 ГВт∙ч, что делает её одним из крупнейших заказчиков такого рода в США.

23.12.2025 [13:40], Руслан Авдеев

NVIDIA намерена начать поставки в Китай ИИ-чипов H200 к середине февраляКомпания NVIDIA заявила китайским клиентам о намерении начать поставки ИИ-ускорителей NVIDIA H200 в середине февраля 2026 года, сообщает Reuters со ссылкой на источники, знакомые с ситуацией. Утверждается, что первые заказы из КНР выполнят из уже имеющихся запасов. По данным источников, объём поставок составит 5–10 тыс. ИИ-модулей, т.е. приблизительно 40–80 тыс. ИИ-ускорителей H200. Также китайским покупателям якобы объявили о планах нарастить производственные мощности для выпуска таких чипов, заказы на них начнут принимать во II квартале 2026 года. Источники свидетельствуют, что пока Пекин не одобрил ни одной закупки, а расписание поставок может зависеть от решений китайского правительства. В заявлении для Reuters NVIDIA сообщила, что постоянно контролирует цепочку поставок и лицензионные продажи ускорителей H200 в КНР никак не повлияют на продажи клиентам в США. Это первые официальные партии поставок чипов H200 в Китай после того, как Вашингтон разрешил подобные продажи с пошлиной 25 %. На днях сообщалось, что администрацией США начата межведомственная проверка заявок на получение разрешений на продажу H200 в КНР. H200 не относится к самым передовым моделям. При этом чип входит в линейку Hopper, которая до сих пор широко востребована на рынке ИИ, хотя на смену ей пришли Blackwell и уже готовятся Rubin. Это затрудняет организацию поставок H200, поскольку ресурсы выделены уже на другие решения. Решение США во многом принято из опасений, вызванных активными действиями Китая по развитию собственного производства ИИ-полупроводников. Поскольку китайские ИИ-ускорители пока значительно слабее американских вариантов, разрешение на продажи H200 может замедлить развитие ИИ-технологий КНР. Недавно появилась информация, что китайские власти провели ряд экстренных совещаний в начале декабря для обсуждения политики в отношении закупок и производства полупроводников в новых условиях. Рассматривается возможность разрешения поставок в Китай, но при этом не исключается обязательная покупка китайскими клиентами нескольких чипов «домашнего» производства на каждый купленный H200. Для китайских IT-гигантов вроде Alibaba Group и ByteDance, выразивших заинтересованность в покупке H200, вариант будет значительно более привлекательным, чем поставки «ослабленных» для Китая ускорителей H20, продававшихся ранее. Модель H200 приблизительно в шесть раз более производительна и искусственному ухудшению не подвергалась. |

|