Материалы по тегу: ии

|

29.12.2025 [10:03], Руслан Авдеев

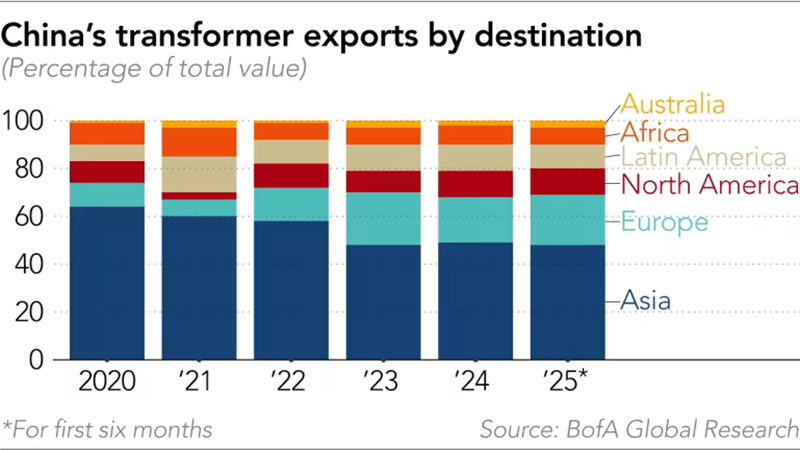

Китайские поставщики заработают на буме ИИ несмотря на напряжённость в отношениях с ЗападомНесмотря на геополитическую напряжённость между Китаем и Западом, китайские поставщики оборудования для ИИ-проектов, от энергетических решений до систем охлаждения, переживают настоящий бум экспорта, сообщает Nikkei Asian Review. ИИ ЦОД потребляют намного больше энергии по сравнению с традиционными дата-центрами и требуют иных технологических решений, например, в области охлаждения. Для обслуживания таких ЦОД нередко нужна модернизация электросетей, поэтому инвестиции в эту сферу стали расти в США, Европе и на Ближнем Востоке с 2022 года. Однако энергооборудование остаётся дефицитным во всём мире. В модернизации электросетей ключевую роль играют трансформаторы. При этом, как сообщает Wood Mackenzie, в США 80 % силовых трансформаторов и 50 % распределительных трансформаторов импортируются в страну из-за рубежа. В 2025 году ожидается дефицит поставок в объёме 30 % и 10 % соответственно. На этом стремится заработать, например, китайская Sieyuan Electric, выпускающая электрооборудование. В прошлом году она создала в США дочернюю компанию для компенсации дефицита в стране трансформаторов. С начала 2025 года акции Sieyuan Electric выросли более чем вдвое, планируется SPO в Гонконге. Производство трансформаторов требует специального оборудования, приобретаемого буквально годами. Кроме того, организация нового производства потребует строительства нового завода и обучения рабочих, поэтому быстрое наращивание производства затруднительно. По данным китайской таможни, за первые 11 месяцев 2025 года экспорт трансформаторов из КНР достиг почти ¥58 млрд ($8,2 млрд), на 36,3 % больше, чем в тот же период 2024 года. На фоне бурного роста спроса за рубежом темпы роста экспорта производителей из КНР превысили рост на внутреннем рынке. Например, крупнейший в мире производитель трансформаторов (по совокупной мощности) Tebian Electric Apparatus нарастил стоимость международных контрактов в годовом исчислении на 65,91 %, на внутреннем рынке рост составил 14,08 %. По мнению экспертов, одним из главных преимуществ китайского бизнеса является скорость организации работ. Как сообщил Bank of America Securities, с момента получения заказа китайским поставщиком до получения готовой продукции проходит менее года, тогда как в США, Европе или Южной Корее речь может идти о двух-трёх годах. По словам экспертов, производство трансформаторов в КНР отличается высокой конкурентоспособностью, поскольку электротехническая листовая сталь раньше импортировалась, а теперь её производство полностью локализовано. Сообщается, что китайские экспортёры постоянно прилагают усилия по расширению бизнеса за рубежом, посколкьу в самой стране жёсткая конкуренция и относительно слабый внутренний рынок. Впрочем, мелкие игроки уровня Dishin с её 150 сотрудниками, вероятно, столкнутся с серьёзными проблемами — стандарты от страны к стране отличаются, что требует технических корректировок и местной сертификации. Кроме того, нужны налаженные каналы сбыта, поскольку трансформаторы обычно продают энергетическим компаниям и одного качества продукции для успеха бизнеса недостаточно. По оценкам UBS, капитальные затраты на ИИ в 2025 году достигнут $423 млрд и $571 млрд — в 2026 году. Ряд инвестиционных банков прогнозирует, что к 2030 году расходы на ИИ превысят $1 трлн. Ожидается, что американские гиперскейлеры, включая Google, Meta✴, Microsoft, Amazon и Oracle в этом году потратят от $350 млрд до $400 млрд, что будет способствовать росту строительства ЦОД и создаст дополнительную нагрузку на электросети. Для сравнения, в Китае, по прогнозам Bank of America, аналогичные капиталовложения в 2025 году составят ¥600–700 млрд ($85–$100 млрд), в основном благодаря правительству и местным крупным компаниям, а к 2030 году достигнут ¥2–¥2,5 трлн ($285–$356 млрд). Около трети этих средств направят на ИИ-инфраструктуру.

Источник изображения: BofA Global Research Системы хранения энергии (ESS) — ещё одна область, где Китай опережает конкурентов. Недавно JP Morgan сообщала, что глобальное развёртывание ИИ ЦОД увеличит спрос на подобные системы. Пока связанный с ИИ спрос на такие системы составляет лишь 2 % от мировых поставок, перспективы очень хорошие. За первые 10 месяцев текущего года поставки аккумуляторных ESS (BESS) выросли на 70 % год к году, во многом благодаря росту китайского экспорта на ключевые рынки на 61 %. JP Morgan прогнозирует рост поставок на 80 % в 2025 году и на 30 % в 2026 году. Дефицит предложения может привести к росту цен. В Bank of America заявляют, что LG также наращивает производственные мощности для энергохранилищ, но темпы роста отстают от реального роста спроса, поэтому заинтересованным сторонам в основном приходится импортировать продукцию из Китая. На мировом рынке аккумуляторов доминируют китайские CATL, EVE Energy и BYD и др. Также, по словам экспертов из Nomura, хотя дефицит сетевых компонентов ожидается до 2026 года из-за высокого спроса и роста технических барьеров, сетевое оборудование для ИИ, включая коммутаторы, маршрутизаторы, оптические и медные кабели и др. станут всё более важными для развёртывания ЦОД. Это может сыграть на руку ведущим поставщикам — вырастет цена и увеличится маржа на мировом рынке. В Bank of America также ожидают роста экспорта из Китая оборудования для охлаждения ИИ-инфраструктуры. В Юго-Восточной Азии, где бурный рост строительства ЦОД стимулирует спрос на компоненты, включая CDU и быстроразъёмные соединения (UQD), по-прежнему доминируют некитайские бренды. Тем не менее, китайские поставщики играют важную роль в обеспечении трубопроводов и коллекторов. По мнению экспертов, поскольку китайские IT-компании всё чаще строят ИИ ЦОД в Юго-Восточной Азии из-за ограничений на экспорт передовых чипов в КНР и высоких цен на электричество в китайских мегаполисах, ожидается, что у китайских производителей охлаждающего оборудования появится больше экспортных возможностей.

28.12.2025 [14:14], Руслан Авдеев

AMD готовится стать крупным поставщиком ИИ-ускорителей для китайской AlibabaПока NVIDIA готовится начать масштабные поставки в Китай ускорителей H200, на рынок Поднебесной спешит выйти и AMD, которая готова поставить Alibaba 40–50 тыс. ослабленных ускорителей Instinct MI308, сообщает Times of AI. Это одна из крупнейших сделок по покупке американских ускорителей бизнесом из КНР после введения жёстких антикитайских ограничений. Впрочем, по данным СМИ, в США, вероятно, рассчитывают на ограниченные партии, а выдачу разрешений будут жёстко контролировать. Хотя китайский бизнес активно интересуется возможными поставками американских чипов, он может столкнуться с ограничениями не только со стороны США, но и китайских властей, желающих наращивать продажи собственных ускорителей вроде Huawei Ascend. При этом китайские ускорители пока значительно уступают американским как по производительности, так и по соотношению цены и вычислительных мощностей. По данным TechNode, для экспорта AMD придётся платить американским властям пошлину в 15 % от стоимости чипов, т.е. пошлина, в отличие от NVIDIDA H200, не выросла. Ускорители стоят приблизительно $12 тыс., на 15 % меньше, чем NVIDIA H20. Успех сделки будет означать значительный прогресс для AMD на китайском рынке, а у китайских покупателей будет больше выбора. Ещё в июле AMD заявляла о вероятном возобновлении поставок MI308 в Китай, но конкретные результаты, похоже, будут достигнуты только теперь, после длительных перебоев.

Источник изображения: AMD Ранее американские власти, наконец, дали разрешение на продажи в Поднебесную ускорителей NVIDIA H200 с 25 % пошлиной, и уже в середине февраля планируются масштабные поставки. Модель H200 значительно уступает по производительности передовым чипам поколений Blackwell и, тем более, Rubin, но в разы эффективнее модели H20, которую можно было продавать в Китай раньше.

27.12.2025 [00:45], Владимир Мироненко

Google избавляется в России от устаревших серверов GGCGoogle разослала российским интернет-провайдерам уведомления о том, что планирует забрать устаревшие кеширующие серверы Dell R720, срок службы которых давно закончился, сообщил ресурс РБК со ссылкой на источники среди провайдеров. Эти серверы используются в системе Google Global Cache (GGC) для кеширования наиболее востребованного контента с целью более быстрой его загрузки местными пользователями. После ухода с российского рынка в 2022 году Google больше не модернизировала систему GGC. В марте 2025 года из-за того, что её российская «дочка» находится в состоянии банкротства, Google отключила пиринговые соединения с некоторыми российскими точками обмена трафиком (IX) и ЦОД. В письмах, направленных интернет-провайдерам, являющимся партнёрами GGC, компания отметила, что будет выводить из эксплуатации серверы, которые сняты с производства и не имеют гарантийного обслуживания, с 26 января 2026 года. В связи с этим Google попросила операторов отключить и извлечь из стойки серверы, а также предоставить адрес, где их можно забрать. Источник РБК также сообщил, что вопросами передачи оборудования для Google занимается европейская компания MPK Asset Solutions. По его словам, часть серверов компания уже вывезла. При этом конкурсный управляющий по делу о банкротстве ООО «Гугл» заявил РБК, что не имеет информации о вывозе оборудования Google из России. Комментируя планы Google вывезти серверы из России, эксперты отметили, что речь идёт о старом оборудовании, официальная поддержка которого была прекращена ещё в 2018 году. Также они считают, что могут возникнуть сложности с его вывозом из-за отсутствия правовых оснований и продолжающейся процедуры банкротства юрлица Google в России. Ранее Google предложила операторам, причём не только российским, вместо GGC использовать прямое присоединение к своей сети. Google, равно как и другие гиперскейлеры, уже давно занимается строительством собственной глобальной сети. В апреле Google объявила о запуске Cloud WAN, полностью управляемой корпоративной WAN-платформы, обеспечившей доступ к её всемирной сетевой инфраструктуре всем организациям и компаниям.

26.12.2025 [15:30], Руслан Авдеев

Ватты-Биты: Токийский университет и Fujitsu проведут пилотные тесты переноса рабочих нагрузок между ЦОД в ЯпонииС 5 января по 21 марта 2026 года Токийский университет и Fujitsu проведут пилотное тестирование перераспределения рабочих нагрузок между дата-центрами, расположенными в разных регионах, сообщает Datecenter Dynamics. Инициатива — часть проекта Watt-Bit Collaboration по оптимизации спроса и предложения электроэнергии. Партнёры заявляют, что проект вызван необходимостью децентрализации дата-центров на японском рынке. Кроме того, он поддержит усилия страны по декарбонизации. Тест является частью процесса технических испытаний в рамках проекта Watt-Bit (Ватт-Бит) по «зелёной» трансформации при сотрудничестве с Tokyo Electric Power Company (TEPCO). Предполагается создание «углеродно-нейтральной», экоустойчивой инфраструктуры и помощь в «зелёной» трансформации за счёт активного использования возобновляемых источников энергии для удовлетворения растущего спроса на электричество. Партнёры намерены взаимодействовать с национальными и профильными структурами для расширения сети вовлечённых локаций и планирования дополнительных испытаний, в т.ч. с применением концепции All Photonics Network (APN). Кроме того, партнёры намерены разработать технологии, способствующие реализации концепции суверенного распределённого дата-центра, обеспечивающего суверенитет данных и операций, прежде всего, в регионах вблизи возобновляемых источников энергии. В ходе испытаний проверят возможность вычислений вне зависимости от местоположения с применением контейнерных технологий. Кроме того, протестируют эффективность межрегионального перераспределения рабочих нагрузок, связанного с состоянием электросетей в зависимости от уровня нагрузки и локальных цен на электроэнергию. Токийский университет намерен предоставить суперкомпьютеры для кластера Information Technology Center и подготовить сценарии использования рабочих нагрузок, связанные с исследованиями в сфере ИИ. При этом Fujitsu обеспечит перенос рабочих нагрузок с помощью контейнерных технологий и предоставит собственный облачный сервис, действующий на платформе Oracle Alloy. Умные системы управления энергией и вычислениями готовятся применять и другие структуры. Так, Google объявила о соглашениях с американскими энергокомпаниями Indiana Michigan Power (I&M) и Tennessee Valley Authority (TVA), направленных на сокращение потребления ИИ ЦОД в периоды высокого спроса. Впрочем, ещё в 2023 году сообщалось, что Google тестирует систему перераспределения нагрузок между ЦОД. Похожую систему создала и Microsoft.

26.12.2025 [14:23], Руслан Авдеев

ИИ ЦОД предложили запитать от списанных реакторов кораблей и подлодок ВМС СШАТехасская компания HGP Intelligent Energy LLC предложила переоборудовать списанные ядерные реакторы с авианосцев и подводных лодок в источники энергии для ИИ ЦОД, сообщает Silicon Angle. HGP подала Министерству энергетики США (DoE) заявку на получение государственной гарантии по кредиту для финансирования инициативы CoreHeld Project в рамках федеральных программ поддержки энергетики. В HGP предполагают размещение и эксплуатацию на территории специализированного ЦОД поблизости от Национальной лаборатории Ок-Ридж (в штате Теннесси) списанных реакторов ВМС США. Речь идёт о водно-водяных реакторах Westinghouse Electric и General Electric, рассчитанных на длительную службу. Есть большой опыт их безопасной эксплуатации в ВМС. Предполагается, что они будут вырабатывать 450–520 МВт. По оценкам компании, на проект потребуется $1,8–$2,1 млрд, приблизительно $1–$4 млн/МВт. Такой проект обойдётся значительно дешевле, чем стоимость строительства новой АЭС или даже малого модульного реактора (SMR). Теоретически смена профиля реакторов не составит большого труда, но главная проблема не в этом — нормативно-правовые акты не учитывают возможность повторного использования реакторов ВМС. В таких реакторах обычно применяется высокообогащённое топливо, а сами они спроектированы как герметичные системы, что не вполне соответствуют существующим нормативным актам Комиссии по ядерному регулированию (Nuclear Regulatory Commission) коммерческих АЭС.

Источник изображения: MD Amadul Haque/unsplash.com Впрочем, HGP уверена, что проект вполне можно реализовать безопасно и в больших масштабах. Компания утверждает, что ей повезло получить «прочную» базу инвесторов и партнёров, разделяющих подобное видение. Предложение появилось в условиях возрастающего давления на энергосистему США — ИИ требует расширения ЦОД гиперскейлеров, облачные провайдеры и операторы ЦОД всё чаще рассматривают ядерную энергетику как стабильный источник безуглеродного электроснабжения своих объектов. В последнее время интерес распространяется на обычные реакторы, малые модульные реакторы и долгосрочные соглашения о покупке энергии (PPA), связанные с атомной энергетикой. Изучающие и разрабатывающие ядерную энергетику для ИИ ЦОД структуры привлекают всё более внимания венчурных инвесторов. В ноябре стартап X-energy Reactor, занимающийся разработкой SMR, привлёк $700 млн. 18 декабря Radiant Industries, разрабатывающая «массовые» портативные реакторы, привлекла более $300 млн. В некоторых случаях предлагается «перезапустить» старые АЭС, например — остановленной АЭС DAEC в Айове при участии Google. В конце сентября 2025 года сообщалось, что бум атомной энергетики из-за ИИ ЦОД в США обойдётся в $350 млрд.

26.12.2025 [13:22], Руслан Авдеев

Китайская iFlytek основал новую структуру для разработки чипов и связанных ИИ-решенийВнесённая в американский чёрный список компания iFlytek, считающаяся в Китае одним из столпов местной ИИ-индустрии наряду с Baidu, Alibaba, Tencent и др., основала новую компанию, которая займётся как разработкой полупроводников, так и прочими, связанными с ИИ решениями в рамках попыток Китая развивать технологическую самодостаточность, сообщает гонконгская SCMP. По данным китайской платформы коммерческой бизнес-разведки Qichacha, новая структура Shandong Yixun Information Technology зарегистрирована на прошлой неделе с уставным капиталом ¥50 млн ($7,1 млн). В числе заявленных сфер деятельности — разработка собственно чипов, а также программного обеспечения для ИИ и технический консалтинг ИИ-сервисов для государственных услуг. iFlytek отказалась от комментариев, связанных с новым бизнесом.

Источник изображения: Tran Mau Tri Tam/unsplash.com Последняя инициатива iFlytek, в своё время сделавшей имя на ПО для распознавания звука, а позже осуществившей развитие бизнеса и в других сфераъ, включая ИИ, свидетельствует о растущей важности разработки собственных ИИ-чипов для КНР. Всё больше бизнесов в стране занимаются проектами в этой сфере. Ожидается, что они потенциально смогут соперничать с западными «тяжеловесами» индустрии вроде NVIDIA и AMD. Это происходит на фоне того, что управление Торгового представительства США (USTR) заявило, что стремление Пекина к доминированию в области полупроводников «необоснованное и дискриминационное» и представляет прямую угрозу для торговли Соединённых Штатов. Ведомство заявляет, что США вводят тарифные ограничения в отношении импорта с страну широкого спектра китайских полупроводников. Китайский бизнес действительно прилагает все усилия для развития собственных ИИ-технологий. Так, на днях сообщалось, что ByteDance намерена нарастить свои инвестиции в ИИ-проекты, чтобы не отстать от американских конкурентов — компания готовится увеличить капитальные затраты до ¥160 млрд ($23 млрд) в 2026 году.

26.12.2025 [09:07], Владимир Мироненко

Wistron потратит $0,9 млрд на расширение производства сетевого и ИИ-оборудования и инвестции в облако GMIТайваньский контрактный производитель Wistron инвестирует в течение ближайших нескольких лет NT$27,9 млрд ($0,9 млрд) в развитие бизнеса в области ИИ, облаков и сетей. Решение об этом было принято на недавнем заседании директоров компании, сообщил ресурс money.udn.com. Wistron объявила, что в связи с запланированным расширением бизнеса будет приобретено оборудование и проведена реконструкция завода в Синьчжу (Hsinchu) на сумму до $0,7 млрд. Также предполагается направить $30,8 млн на продление аренды производственных площадей в Мексике до 2031 года. В заявлении Wistron отмечено, что в связи с высоким спросом со стороны клиентов она продолжает реализацию плана расширения завода в Мексике, завершение которого ожидается уже в следующем году. Wistron была названа в числе контрактных производителей-партнёров NVIDIA по сборке серверной платформы новейшего поколения Vera Rubin наряду с Foxconn и Quanta. Дочерняя компания Wistron InfoComm построит во Вьетнаме новый завод, а также проведёт реконструкцию и приобретёт оборудование и технику на общую сумму до $134,8 млн в рамках программы по развитию бизнеса в сфере сетевых технологий. Кроме того, Wistron намерена инвестировать до $37 млн в компанию GMI Computing Holding посредством простого соглашения о долевом участии (SAFE, Simple Agreement for Future Equity) и подписки на привилегированные акции, чтобы укрепить позиции на рынке облачных сервисов следующего поколения. В связи с ростом спроса на ИИ-решения Wistron стремится оперативно наращивать производственные мощности. По словам президента и гендиректора Wistron Джеффа Лина (Jeff Lin), большинство клиентов размещают долгосрочные 12-месячные заказы, т.ч. уже в 2026 году мощностей недавно введённого в эксплуатацию производственного комплекса AI Smart Campus Wistron в Чжубэе (Zhubei) может оказаться недостаточно для удовлетворения растущего спроса на ИИ-серверы. В августе сообщалось о планах Wistron построить два завода по производству компонентов для суперкомпьютеров в Форт-Уэрт (Fort Worth, Техас), инвестировав в строительство и реконструкцию объектов $761 млн. Ожидается, что их запустят в эксплуатацию в 2026 году. До этого СМИ писали, что Wistron намерена открыть дочернее предприятие в США и вложить в производство на территории страны до $50 млн. Ещё одна тайваньская компания, Foxconn, планирует инвестировать в развитие ИИ-инфраструктуры в США в штате Висконсин в течение следующих четырёх лет $569 млн. Ещё $200 млн она потратила на развитие производства в Мексике.

25.12.2025 [15:56], Владимир Мироненко

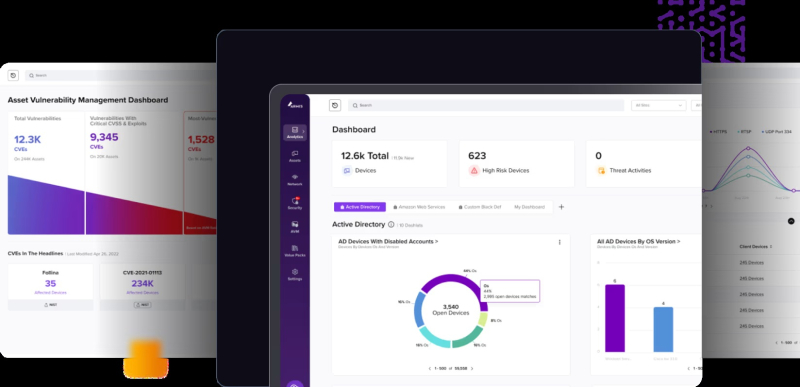

ServiceNow купила за $7,75 млрд стартап Armis для расширения своих услуг кибербезопасностиКомпания ServiceNow объявила о приобретении за $7,75 млрд стартапа Armis, разработчика платформы кибербезопасности для защиты подключённых устройств. Это более чем на $1,5 млрд больше оценки, полученной Armis после последнего раунда финансирования в ноябре, когда она привлекла $435 млн, уточнил ресурс SiliconANGLE. По словам ServiceNow, приобретение будет обеспечено за счёт комбинации имеющихся денежных средств и заёмных средств. Это крупнейшая покупка ServiceNow на сегодняшний день и четвёртое приобретение в сфере кибербезопасности за последний год, отметил ресурс DarkReading. Ожидается, что сделка будет завершена во II половине 2026 года. У ServiceNow и Armis есть много общих клиентов, включая Colgate-Palmolive, JPMorgan Chase, Merck, Mondelēz и United Airlines. Armis, основанная десять лет назад Евгением Дибеовым (Yevgeny Dibeov) и Надиром Израэлем (Nadir Izrael), специализируется на защите и управлении подключёнными устройствами и активами, к которым, например, относятся системы Интернета вещей, промышленные роботы, медицинское оборудование, офисные принтеры и т.д., по всем поверхностям атак. Её облачная платформа управления активами и безопасностью Centrix обеспечивает прозрачность для всего спектра устройств, обнаруживая вредоносную активность, такую как попытки установки несанкционированных программ в систему, используя ИИ. Платформа также выявляет уязвимости устройств, которые могут привести к кибератакам в будущем. «Armis обладает способностью обеспечивать полную прозрачность активов, которые не управляются в традиционных ИТ-системах», — заявил Билл Макдермотт (Bill McDermott), председатель и генеральный директор ServiceNow. При этом Centrix обнаруживает нарушения безопасности с помощью безагентного механизма и создаёт ловушки (honeypot) — механизмы обнаружения вредоносного ПО, замаскированные под технологические активы. По словам ServiceNow, решение Armis позволит клиентам постоянно отслеживать каждый актив, расставлять приоритеты для каждого риска и реагировать на него в рамках единой системы ещё до возникновения инцидента. Он отметил, что приобретение Armis укрепляет стратегию компании по углублению контекста безопасности на платформе ServiceNow AI за счёт охвата киберфизической безопасности. «Клиенты могут заблаговременно снижать риски по мере ускорения внедрения ИИ», — сообщила компания. ServiceNow планирует интегрировать возможности Armis и её набор данных с недавно запущенным инструментом ServiceNow AI Control Tower — централизованным командным центром для внедрения, управления и контроля ИИ и его жизненного цикла. Объединение приведёт к созданию «единого, комплексного стека управления рисками и операциями в области безопасности, который сможет видеть, принимать решения и действовать по всей технологической инфраструктуре», говорит компания. Платформа также обеспечит автоматизацию процесса пересылки данных о нарушении безопасности наиболее подходящему для его устранения администратору. Кроме того, сделка расширит возможности CMDB-платформы ServiceNow. В объявлении о сделке ServiceNow раскрыла информацию о том, что ежегодный регулярный доход (ARR) её подразделение кибербезопасности и управления рисками в прошлом квартале превысил отметку в $1 млрд. Приобретение Armis более чем втрое увеличит рыночные возможности подразделения, надеется ServiceNow. У самой Armis показатель ARR составляет более $340 млн, при этом темпы роста превышают 50 % в годовом исчислении. Armis — второй поставщик решений в области кибербезопасности, приобретённый ServiceNow в этом месяце. Ранее компания объявила о покупке поставщика решений для идентификации личности Veza примерно за $1 млрд. Также в начале декабря компания завершила приобретение поставщика решений на основе ИИ Moveworks за $2,85 млрд, чей ИИ-помощник сыграет ключевую роль в планах ServiceNow по обеспечению безопасности автономных рабочих процессов и быстрому реагированию на инциденты безопасности. А на прошлой неделе она завершила сделку по покупке поставщика решений в области безопасности Mission Secure, о которой было объявлено в ноябре 2024 года.

25.12.2025 [14:48], Руслан Авдеев

В 2026 году ByteDance увеличит инвестиции в ИИ-инфраструктуру до $23 млрдВладеющая TikTok китайская ByteDance рассчитывает нарастить свои инвестиции в ИИ-проекты, чтобы не отстать от американских конкурентов — компания намерена увеличить капитальные затраты до ¥160 млрд ($23 млрд) в 2026 году, сообщает The Financial Times. Для сравнения, в 2025 году инвестиции компании в ИИ-инфраструктуру составили порядка ¥150 млрд. ¥85 млрд планируется потратить на закупку передовых ИИ-ускорителей, хотя вопрос с доступом к чипам NVIDIA пока не решён окончательно. Сама NVIDIA рассчитывает начать поставки H200 уже в феврале следующего года. ByteDance — один из крупнейших китайских строителей ИИ-инфраструктуры, компания стремится стать одним из мировых лидеров в этой сфере. Впрочем, в сравнении с инвестициями в ИИ ЦОД, на которые ушли уже сотни миллиардов долларов, расходы ByteDance относительно невелики. Пока китайские компании не могут приобретать передовые чипы NVIDIA из-за ограничений со стороны американских властей. В результате они стремятся к программным оптимизациям и к обучению ИИ-моделей за рубежом. При этом аренда обычно учитывается не как капитальные затраты, а как операционные расходы.

Источник изображения: ByteDance В декабре 2025 года США отменили запрет на продажу ускорителей NVIDIA H200 некоторым клиентам в Китай. Такие чипы менее производительны, чем самые современные модели. Кроме того, определённые круги в Пекине и Вашингтоне выступают против продаж по разным причинам. Так или иначе, источники свидетельствуют, что в случае разрешения поставок ByteDance и другие китайские технологические группы будут охотно покупать H200 в больших масштабах. Так, ByteDance якобы намерена закупить 20 тыс. H200 в рамках «пробного» заказа, стоимость каждого ускорителя может составить порядка $20 тыс. Если гигант получит неограниченные квоты для закупки, он может значительно нарастить капитальные затраты на 2026 год. По словам экспертов, в сравнении с другими китайскими техногигантами ByteDance выигрывает потому, что её акции не торгуются публично, т.ч. она лучше защищена от инвестиционных манипуляций и способна играть «вдолгую» на рынке ИИ. Хотя, по данным The Financial Times, производительность открытых ИИ-моделей ByteDance Doubao отстаёт от Alibaba Qwen и DeepSeek, компания доминирует в сфере ИИ-приложений, рассчитанных на потребителей. Так, по статистике QuestMobile, чат-бот Doubao обогнал DeepSeek и уже стал самым популярным в КНР по количеству ежемесячных активных пользователей. Компания активно конкурирует и с Alibaba, продвигая облачный сервис Volcano Engine для бизнеса. По информации Goldman Sachs, предложенные ByteDance ИИ-продукты обеспечили себе статус самых востребованных в Китае. По статистике, в октябре ByteDance отметила существенный рост спроса — более 30 трлн токенов в день. Для сравнения, у Google тот же показатель составил 43 трлн.

25.12.2025 [13:17], Руслан Авдеев

Британская Nscale потратит $865 млн на размещение ИИ-оборудования в СШАБританский стартап Nscale, специализирующийся на ИИ-инфраструктуре, намерен потратить $865 млн на размещение оборудование на территории США. В рамках соглашения сроком на 10 лет Nscale станут доступны 40 МВт в ещё не построенном дата-центре NC-1 компании WhiteFiber в Мэдисоне (Северная Каролина), сообщает Datacenter Knowledge. Речь идёт об очередных усилиях Nscale по развитию ИИ-инфраструктуры в Европе и США. Ранее в этом году было заявлено о намерении Nscale расширить присутствие в Северной Америке и построить новые дата-центры на «сотни мегаватт». WhiteFiber инвестировала $150 млн в объект площадью около 93 тыс. м2 на участке площадью около 39 га. Он расположен к северу от Шарлотта (Charlotte, Северная Каролина). В сделке с Nscale объект NC-1 позиционируется, как ключевой центр ИИ-вычислений, поддерживающий рост инфраструктуры британской компании в США. В октябре 2025 года Nscale уже заключила контракт с Microsoft на поставку 104 тыс. ИИ-ускорителей NVIDIA для дата-центра мощностью 240 МВт в Барстоу (Barstow, Техас).

Источник изображения: Daniel Weiss/unsplash.com Соглашение с WhiteFiber предусматривает, что Nscale начнёт оплачивать 20 МВт мощности уже в апреле 2026 года, ещё 20 МВт — в мае. Также WhiteFiber согласилась предоставить Nscale в приоритетном порядке данные о любых доступных дополнительных мощностях. По словам представителя HyperFrame Research, в 2026 году будет всё больше сделок подобного рода. WhiteFiber является дочерним предприятием канадской Enovum Data Centers. Компания заявила, что ведёт активные переговоры с несколькими ведущими кредитными организациями, связанные с неотложными работами по развёртыванию инфраструктуры в рамках сделки с Nscale. В сентябре 2025 года Nscale привлекла $1,1 млрд в рамках раунда финансирования серии B для поддержки экспансии в Европе, Северной Америке и на Ближнем Востоке. По словам представителя стартапа, создаётся «инфраструктурная платформа будущего», ориентированная на искусственный интеллект. Одним из крупных партнёров Nscale является OpenAI с её проектом Stargate. Британский стартап, например, участвует в реализации Stargate UK и Stargate Norway. |

|