Материалы по тегу: s

|

21.11.2025 [23:59], Сергей Карасёв

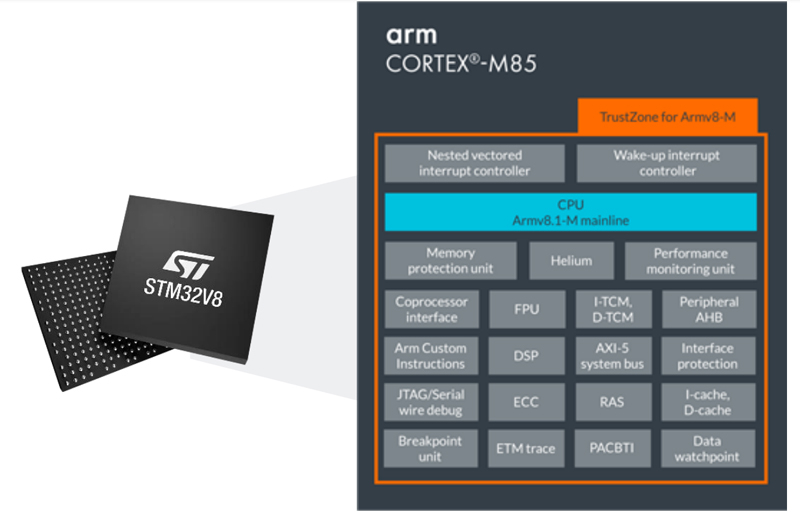

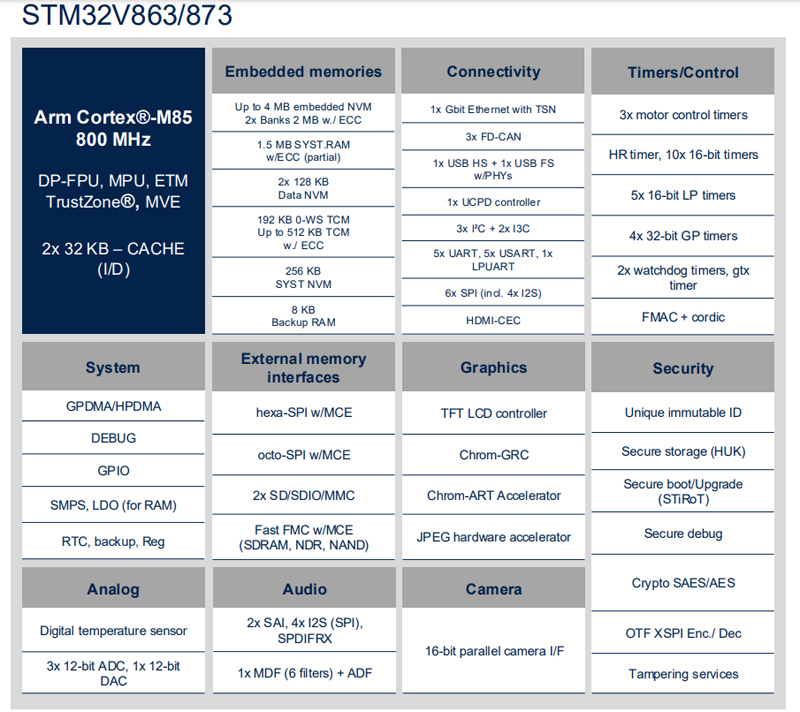

По-настоящему космический микроконтроллер STMicroelectronics STM32V8 пропишется в спутниках Starlink: 800 Мгц, защита от радиации и работа при +140 °CКомпания STMicroelectronics анонсировала микроконтроллер STM32V8 для индустриальной сферы. Среди возможных областей применения названы системы промышленной автоматизации, робототехника, оборудование для аэрокосмической отрасли и здравоохранения, устройства для умных городов и пр. Изделие изготавливается по 18-нм техпроцессу FD-SOI в партнёрстве с Samsung Foundry. Основой служит 32-бит ядро Arm Cortex-M85 (до 800 МГц) с поддержкой Arm Helium, Arm MVE и TrustZone. По заявлениям STMicroelectronics, на сегодняшний день новинка является самым производительным микроконтроллером серии STM32. Одной из особенностей STM32V8 является наличие 4 Мбайт (два блока по 2 Мбайт) энергонезависимой памяти на основе фазового перехода (РСМ). Она устойчива к воздействию радиации, что позволяет использовать микроконтроллер в том числе в космическом пространстве. Отмечается, что компания SpaceX будет применять изделие в своих спутниках системы Starlink. Еще одна особенность решения — широчайший диапазон рабочих температур, который простирается от -40 до +140 °C.

Источник изображений: STMicroelectronics В состав чипа входят графический блок Chrom-ART 2D GPU и аппаратный JPEG-ускоритель. Есть 1,5 Мбайт памяти System SRAM с поддержкой ECC и 8 Кбайт памяти Backup RAM. Реализованы интерфейсы внешней памяти Hexa-SPI, Octo-SPI, 2 × SD/SDIO/MMC, SDRAM, NAND. Упомянута поддержка 1GbE, 2 × SAI, 4 × I2S, S/PDIF Rx, 1 × USB HD, 1 × USB FS, UCPD (USB-C PD), 3 × I2C, 2 × I3C, 5 × USART, 5 × UART, 1 × LPUART, 3 × FD-CAN, 6 × SPI, 3 × ADC (12 бит), 1 × DAC (12 бит).  Для микроконтроллера доступны различные варианты исполнения, включая 68-pin VQFN (8 × 8 мм), 100-pin LQFP/TFBGA (14 × 14 или 8 × 8 мм), 144-pin LQFP (20 × 20 мм), 176-pin LQFP (24 × 24 мм), 176+25-pin UFBGA (10 × 10 мм) и 273-pin TFBGA (14 × 14 мм). Пробные поставки изделия избранным клиентам уже начались. Массовые отгрузки запланированы на следующий год.

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

19.11.2025 [11:49], Сергей Карасёв

Второй европейский экзафлопсный суперкомпьютер Alice Recoque получит чипы AMD EPYC Venice и ускорители Instinct MI430XЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) и французско-нидерландский Консорциум Жюля Верна объявили о том, что в создании суперкомпьютера Alice Recoque примут участие компании Eviden (входит в состав Atos Group), AMD и SiPearl. О проекте Alice Recoque впервые стало известно в июне прошлого года. Это будет второй европейский суперкомпьютер экзафлопсного класса после системы JUPITER, смонтированной в Юлихском исследовательском центре (FZJ) в Германии. Соглашение о создании Alice Recoque подписано между EuroHPC JU и французским национальным агентством высокопроизводительных вычислений (GENCI). Комплекс будет смонтирован в дата-центре на территории Брюйер-ле-Шатель (Bruyères-le-Châtel), к юго-западу от Парижа. Как сообщается, в состав Alice Recoque войдут унифицированный вычислительный раздел и скалярный раздел. Основой первого послужит новая платформа Eviden BullSequana XH3500, содержащая серверы с 256-ядерными процессорами AMD EPYC Venice и ускорителями Instinct MI430X, оснащёнными 432 Гбайт памяти HBM4 с пропускной способностью 19,6 Тбайт/с. Кроме того, говорится о применении AMD FPGA и высокопроизводительной подсистемы хранения данных DDN. Суперкомпьютер объединит 94 стойки с суммарным энергопотреблением «менее 15 МВт». В свою очередь, скалярный раздел будет использовать 128-ядерные Arm-процессоры SiPearl Rhea2. Общее количество таких ядер превысит 100 тыс. В качестве интерконнекта в составе Alice Recoque планируется использовать технологию BullSequana eXascale Interconnect (BXI v3), обеспечивающую скорость передачи данных до 400 и 800 Гбит/с для CPU- и GPU-узлов соответственно. Машина получит систему прямого жидкостного охлаждения (DLC) пятого поколения (с тёплой водой) разработки Eviden для унифицированных стоек и технологию охлаждаемых дверей для скалярных стоек. Интеллектуальное программное обеспечение Eviden Argos обеспечит мониторинг в режиме реального времени и оптимизацию энергопотребления. Говорится о широком применении компонентов с открытым исходным кодом, таких как SLURM, Kubernetes, LUSTRE, Grafana и Prometheus. Монтаж суперкомпьютера Alice Recoque начнётся в 2026 году. Затраты на приобретение, доставку, установку и обслуживание системы составят €354,8 млн. EuroHPC JU предоставит половину этой суммы, ещё столько же обеспечат Франция, Нидерланды и Греция в рамках Консорциума Жюля Верна. Общие инвестиции в проект на протяжении пяти лет оцениваются в €554 млн. Использовать новый вычислительный комплекс планируется для решения сложных задач в сферах моделирования климата, разработки передовых материалов, энергетики и пр. Система также поможет в развитии европейских моделей ИИ следующего поколения и цифровых двойников для персонализированной медицины.

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно.

18.11.2025 [16:55], Владимир Мироненко

d-Matrix привлекла ещё $275 млн и объявила о разработке первого ИИ-ускорителя с 3D-памятью Raptord-Matrix сообщила о завершении раунда финансирования серии C, в ходе которого было привлечено $275 млн инвестиций с оценкой рыночной стоимости компании в $2 млрд. Общий объём привлечённых компанией средств достиг $450 млн. Полученные средства будут направлены на расширение международного присутствия компании и помощь клиентам в развёртывании ИИ-кластеров на основе её технологий. Раунд C возглавил глобальный консорциум, включающий BullhoundCapital, Triatomic Capital и суверенный фонд благосостояния Сингапура Temasek. В раунде приняли участие Qatar Investment Authority (QIA) и EDBI, M12, венчурный фонд Microsoft, а также Nautilus Venture Partners, Industry Ventures и Mirae Asset. Сид Шет (Sid Sheth), генеральный директор и соучредитель d-Matrix, отметил, с самого начала компания была сосредоточена исключительно на инференсе. «Мы предсказывали, что когда обученным моделям потребуется непрерывная масштабная работа, инфраструктура не будет готова. Последние шесть лет мы потратили на разработку решения: принципиально новой архитектуры, которая позволяет ИИ работать везде и всегда. Это финансирование подтверждает нашу концепцию, поскольку отрасль вступает в эпоху ИИ-инференса», — добавил он. d-Matrix разработала ускоритель инференса Corsair на базе архитектуры с вычислениями в памяти DIMC (digital in-memory computing) — процессорные компоненты в нём встроены в память. Ускоритель предлагается вместе с сетевой картой JetStream. Также предлагается референсная архитектура SquadRack, которая упрощает создание ИИ-кластеров на базе Corsair. Она поддерживает до восьми серверов в стойке, каждая из которых содержит восемь ускорителей Corsair. Шасси SquadRack позволяет запускать ИИ-модели размером до 100 млрд параметров, хранящиеся полностью в SRAM. По данным d-Matrix, такая конфигурация обеспечивает на порядок большую производительность по сравнению с чипами с HBM. Вместе с оборудованием компания предлагает программный стек Aviator, который автоматизирует часть работы, связанной с развертыванием ИИ-моделей на ускорителе. Aviator также включает набор инструментов для отладки моделей и мониторинга производительности. В следующем году d-Matrix планирует выпустить более производительный ускоритель инференса Raptor. Это первый в мире ускоритель на базе 3D DRAM. Решение разрабатывается в партнёрстве с Alchip, известной разработками в области ASIC. Благодаря сотрудничеству уже реализована ключевая технология d-Matrix 3DIMC, представленная в тестовом кристалле d-Matrix Pavehawk. По словам компаний, новинка обеспечит до 10 раз более быстрый инференс по сравнению с решениями на базе HBM4, что позволит повысить эффективность генеративных и агентных рабочих ИИ-нагрузок. Также в Raptor будет использоваться процессор AndesCore AX46MPV от Andes Technology. Компании заявили, что их сотрудничество представляет собой конвергенцию вычислений, ориентированных на память, и инноваций в области процессоров на основе открытых стандартов для рабочих ИИ-нагрузок в масштабах ЦОД. Andes AX46MPV будет отвечать за оркестрацию наргрузок, распределение памяти, векторные вычисления и функции активации. AX46MPV — 64-бит многоядерный RISC-V-процессор с поддержкой Linux. Он включает 2048-бит блок векторной обработки (RVV 1.0), высокоскоростную векторную память (HVM) и ряд других аппаратных блоков для работы с массивными вычислениями. В совокупности эти функции обеспечивают запас производительности и гибкость ПО, необходимые для систем инференса уровня ЦОД. Референсные ядра, являющиеся ключевыми для рабочих нагрузок ИИ-трансформеров и LLM, демонстрируют прирост производительности до 2,3 раза по сравнению с предшественником AX45MPV.

18.11.2025 [13:36], Сергей Карасёв

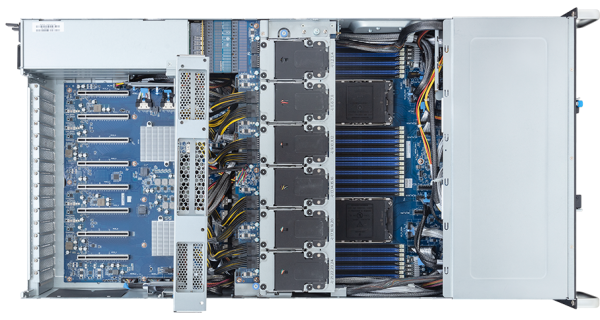

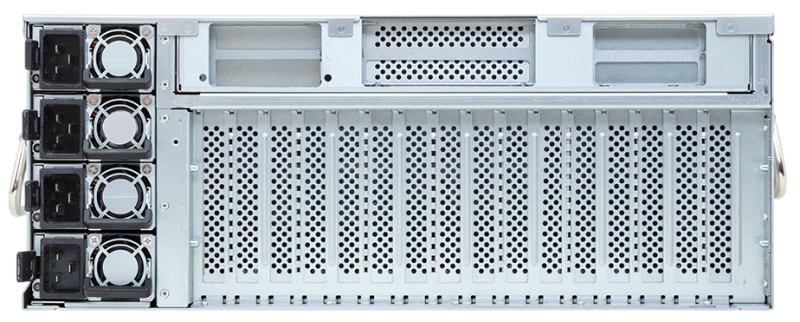

ИИ-сервер с турбонаддувом: Giga Computing G494-SB4 вмещает восемь двухслотовых ускорителей и предлагает дополнительный модуль охлажденияКомпания Giga Computing, подразделение Gigabyte, пополнила ассортимент ИИ-серверов моделью G494-SB4-AAP2, построенной на аппаратной платформе Intel. Система может нести на борту до восьми PCIe-ускорителей — например, NVIDIA RTX Pro 6000 Blackwell Server Edition, Intel Gaudi3 или NVIDIA H200 NVL. Сервер выполнен в форм-факторе 4U. Допускается установка двух процессоров Intel Xeon 6500P и 6700P поколения Granite Rapids-SP с показателем TDP до 350 Вт. Доступны 32 слота для модулей DDR5 (RDIMM-6400 или MRDIMM-8000). Во фронтальной части расположены 12 отсеков для SFF-накопителей с интерфейсом PCIe 5.0 (NVMe), SATA-3 или SAS-4; допускается горячая замена. Сервер располагает восемью слотами для ИИ-ускорителей FHFL PCIe 5.0 x16, четырьмя разъёмами для карт расширения типоразмера FHHL с интерфейсом PCIe 5.0 x16 (по два спереди и сзади) и тремя слотами для низкопрофильных (LP) карт, также оснащённых интерфейсом PCIe 5.0 x16. Присутствуют сетевой адаптер Intel X710-AT2 с двумя портами 10GbE (разъёмы RJ45 на лицевой панели), выделенный сетевой порт управления 1GbE (RJ45) и контроллер ASPEED AST2600. Предусмотрены два порта USB 3.2 Gen1 Type-A и аналоговый коннектор D-Sub. За питание отвечают четыре блока мощностью 3000 Вт с сертификатом 80 PLUS Titanium. Реализовано воздушное охлаждение с двумя системными вентиляторами диаметром 40 мм и 12 вентиляторами диаметром 60 мм. Дополнительно доступен блок из четырёх 80-мм вентиляторов. Он добавляет около 120 мм к глубине сервера, но зато позволяет использовать восемь 600-Вт ускорителей. Диапазон рабочих температур — от +10 до +35 °C (до +25 °C при использовании H200 NVL). Габариты составляют 448 × 176 × 880 мм, масса — 66,8 кг. Гарантирована совместимость с Red Hat Enterprise Linux 10.0 и выше, а также с Windows Server 2025.

16.11.2025 [23:30], Игорь Осколков

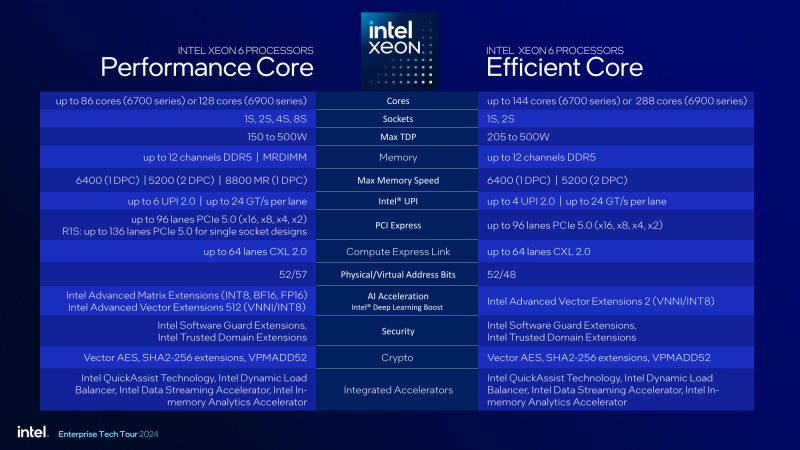

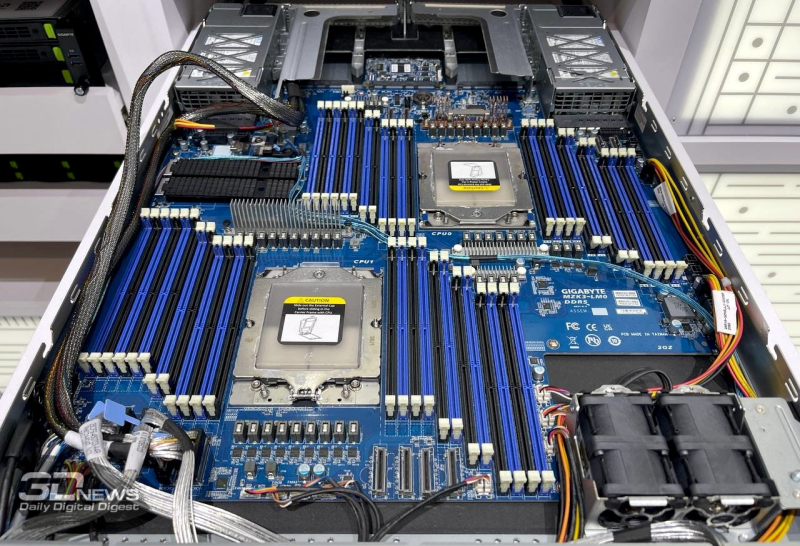

Intel отказалась от массовых Xeon Diamond Rapids с восемью каналами памяти — останутся только 16-канальные процессорыIntel, по сообщению ServeTheHome, решила отказаться в следующем поколении серверных процессоров Xeon Diamond Rapids на платформе Oak Stream от чипов с поддержкой восьми каналов памяти, оставив только модели с 16 каналами DRAM и поддержкой MRDIMM. Иными словами, в новом поколении компания, по-видимому, будет ориентироваться на топовый сегмент, оставив недорогие массовые платформы за бортом. Компания дала официальный комментарий ServeTheHome: «Мы исключили 8-канальные Diamond Rapids из наших планов. Мы упрощаем платформу Diamond Rapids, уделяя особое внимание 16-канальным процессорам и расширяя её преимущества для всех остальных, чтобы удовлетворить потребности различных клиентов». Грядущие AMD EPYC Venice также получат 16-канальный контроллер памяти. Пока что и у AMD, и у Intel максимальное количество поддерживаемых каналов памяти составляет 12. Однако в случае Intel реально доступными являются только Xeon Granite Rapids-AP (6900P), тогда как Sierra Forest-AP (6900E) так и остались нишевым продуктом. Грядущие Xeon 6+ Clearwater Forest также останутся при 12 каналах. При этом у EPYC поколения Turin (9005) во всех вариантах доступны 12 каналов. Наиболее массовые Granite Rapids-SP (6500P/6700P) и Sierra Forest-SP (6700E) на платформе Birch Stream ограничены восемью каналами памяти, но… это может быть не так уж и плохо. Платформы для них дешевле, чем для AP-версий, а относительно небольшое количество каналов памяти даёт определённую гибкость в выборе компонентов. Речь в том числе про физические характеристики серверных платформ — платы с 32 или 48 слотами DIMM вынужденно переходят к «двухярусной» компоновке, когда один процессор сдвинут вглубь шасси из-за невозможности комфортно разместить все слоты и оба сокета в один ряд в рамках стандартного 19” корпуса. При этом типовые восьмиканальные решения позволяют легко набрать нужный объём RAM в 2DPC-режиме более дешёвыми модулями памяти (пусть и с потерей производительности), чем в случае 12-канальных платформ с 1DPC. Поэтому 2S-системы с восьмиканальными CPU всё ещё остаются крайне популярными. Однако Intel в Diamond Rapids решила отказаться от массовых платформ.

16.11.2025 [12:35], Сергей Карасёв

Qualcomm представила чипы Dragonwing IQ-X для индустриальных Windows-компьютеровКомпания Qualcomm анонсировала новые SoC семейства Dragonwing IQ-X — изделия IQ-X5181 и IQ-X7181, ориентированные на индустриальный сектор. Чипы предназначены для построения промышленных Windows-компьютеров, систем автоматизации, робототехнических платформ, медицинского оборудования и пр. Решение IQ-X5181 объединяет восемь кастомизированных ядер Qualcomm Oryon (Armv8) с тактовой частотой до 3,4 ГГц, модификация IQ-X7181 — двенадцать. В состав SoC входит графический ускоритель Qualcomm Adreno с частотой соответственно 1,1 и 1,25 ГГц. Младшая версия способна справляться с декодированием видеоматериалов 4Kp60 VP9/AV1 и кодированием 4Kp30 AV1, старшая — 4K120 VP9/AV1 и 4Kp60 AV1. Чипы обеспечивают ИИ-производительность до 45 TOPS с учётом блоков CPU, GPU и Hexagon NPU.

Источник изображения: Qualcomm Возможно использование до 64 Гбайт оперативной памяти LPDDR5X-4200, флеш-накопителей UFS 4.0 и карт SD/MMC (SD 3.0). Реализованы интерфейсы eDP (eDP1.4b) с поддержкой разрешения до 4096 × 2160 пикселей при 60 Гц и DisplayPort v1.4a (через USB) с поддержкой разрешения до 5120 × 2880 точек при 60 Гц. Изделие IQ-X5121 располагает двумя интерфейсами камер CSI на четыре линии каждый, IQ-X7181 — четырьмя. Для обеих новинок заявлена поддержка 2 × USB 3.1, 3 × USB 4.0 Type-C (DisplayPort v1.4a Alt Mode), 6 × eUSB 2.0 и 221 × GPIO (UART, SPI, I3C, I2C via QUP). В случае IQ-X5181 реализованы интерфейсы 2 × PCIe 4.0 х4 и 2 × PCIe 3.0 х2, в случае IQ-X7181 — PCIe 4.0 х8, PCIe 4.0 х4 и 2 × PCIe 3.0 х2. Кроме того, говорится о поддержке Ethernet (чип-компаньон QPS615), Wi-Fi и Bluetooth (посредством модуля M.2 PCIe), Wi-Fi 7 / Wi-Fi 6E (через WCN785/WCN6856), а также 5G (модем Snapdragon X65). Изделия выполнены в корпусе 1747-ball BGM с размерами 58 × 58 мм с максимальной толщиной 3 мм. Диапазон рабочих температур простирается от -40 до +105 °C. Говорится о совместимости с Windows 10/11 IoT Enterprise LTSC, Qt, CODESYS, EtherCAT и пр. Гарантирована доступность чипов в течение более чем 10 лет.

15.11.2025 [16:14], Владимир Мироненко

Broadcom упростила сертификацию оборудования для VCF для ускорения внедрения современных частных облаковBroadcom объявила о значительном обновлении VMware Cloud Foundation (VCF) 9.0 с целью предоставления компаниям более широкого выбора в области оборудования, сетевых решений и open source ПО с открытым исходным кодом. По словам компании, VCF представляет собой частную облачную платформу, открытую и адаптируемую ко всем уровням инфраструктуры. Изменения формируют открытую, гибкую экосистему, которая позволяет клиентам создавать, подключать, защищать и развивать современные частные облака в предпочитаемых ЦОД, периферийных локациях и хостинговых средах. VCF 9.0 теперь сочетает в себе эффективность облачной операционной модели с локальным управлением, расширяя совместимость с решениями разных провайдеров, возможности использования ИИ и преимущества в совокупной стоимости владения, отметил ресурс StorageReview.com. «Создавая открытую экосистему VCF, мы даём компаниям возможность создавать современные частные облака, соответствующие их стратегическим потребностям, гарантируя, что они смогут использовать технологии, необходимые для их уникальных сред», — заявил Пол Тернер (Paul Turner), директор по продуктам подразделения VMware Cloud Foundation компании Broadcom. Обновление включает расширение компанией программы открытой сертификации оборудования, чтобы расширить возможности OEM- и ODM-партнёров. В частности, программа VCF AI ReadyNodes (готовые к работе с VCF ИИ-узлы) призвана упростить процесс сертификации ИИ-узлов, позволяя заказчикам внедрять CPU, GPU и ускорители следующего поколения по мере их появления. VCF AI ReadyNodes будет использоваться для сертификации серверов, прошедших предварительную квалификацию для обучения ИИ-моделей и инференса. Сертифицированные согласно VCF AI ReadyNodes узлы представляют собой предварительно настроенное оборудование с ПО VMware с предсказуемой производительностью, простым управлением и гибкой виртуализацией со сквозным доступом к GPU, а также включают сетевые функции для минимизации задержки и масштабирования пропускной способности. Такие узлы снижают риски проблем при интеграции и сокращают время выхода продукта на рынок, предлагая предварительно проверенные ПАК для обучения и инференса. Они поддерживают плавное обновление через SDDC Manager, обеспечивая синхронизацию обновлений драйверов GPU, прошивок сетевых карт и VMware ESXi для поддержания стабильности в производственных ИИ-средах. Supermicro станет одним из первых OEM-партнёров, сертифицировавших свои серверы в рамках AI ReadyNode. Broadcom также расширила программу VCF ReadyNode, предоставив ODM-партнёрам возможность самостоятельно сертифицировать готовые узлы в рамках программы Broadcom Technology Alliance (TAP). Все сертифицированные системы будут проверены на полную совместимость с VMware Cloud Foundation с последовательным управлением жизненным циклом VCF. Это расширяет возможности поиска поставщиков и сокращает время выполнения заказов. Для узлов для периферийных вычислений компания предлагает вариант VCF Edge, ориентированный на надёжные и компактные серверы для промышленных, оборонных, розничных и др. нужд. Broadcom также сообщила о новой стратегии, направленной на унификацию сетевых инфраструктур и упрощение сетевых операций в современном частном облаке с помощью стандартизированных сетей с EVPN и BGP. Клиенты получат преимущества от защиты на уровне VPC, согласованных сетевых операций, маршрутизации и видимости во всех доменах VCF Networking (NSX) и сетевых решениях сторонних производителей, обеспечивающих унифицированные операции с помощью комплексной автоматизации. Этот подход согласует VCF со стратегией Cisco Nexus One Fabric, обеспечивая более согласованные и надёжные результаты работы для совместных клиентов Cisco и VMware. Cisco Nexus One Fabric расширяет возможности VCF, предоставляя современную, масштабируемую и автоматизированную сетевую архитектуру на основе VXLAN EVPN. VCF Networking (NSX) также теперь поддерживает популярную открытую NOS SONiC. SONiC обеспечивает клиентам снижение затрат за счёт использования стандартного коммутационного оборудования разных производителей, снижая как капитальные, так и эксплуатационные расходы. Кроме того, Broadcom продолжает участвовать в сообществе Kubernetes, являясь одним из пяти крупнейших участников CNCF (Cloud Native Computing Foundation) и работая над проектами Antrea, Cluster API, ContainerD, Contour, etcd, Harbor и т.д. Broadcom объявила, что VMware vSphere Kubernetes Service (VKS) был сертифицирован CNCF как платформа, соответствующая требованиям Kubernetes AI Conformant Platform. Как сообщает The Register, эта недавно запущенная программа соответствия призвана дать клиентам уверенность в том, что контейнерная платформа может надёжно выполнять реальные рабочие нагрузки ИИ. Программа определяет минимальный набор возможностей и конфигураций, необходимых для запуска широко распространенных фреймворков ИИ и машинного обучения в инфраструктуре Kubernetes.

15.11.2025 [15:38], Сергей Карасёв

До 3,2 Пбайт в 4U: Seagate представила JBOD-системы высокой плотности Exos 4U100 и 4U74Компания Seagate Technology анонсировала JBOD-системы Exos 4U100 и Exos 4U74, разработанные для современных дата-центров. Новинки позволяют формировать массивы хранения данных высокой плотности, необходимые для поддержания рабочих нагрузок в области ИИ и машинного обучения. Обе системы выполнены в форм-факторе 4U. Модель Exos 4U100 рассчитана на 100 накопителей LFF, модификация Exos 4U74 — на 74. Могут применяться изделия с интерфейсом SATA и SAS. Габариты устройств составляют соответственно 175,5 × 448,5 × 1146,0 мм и 175,5 × 448,5 × 932,0 мм, масса — 59,9 и 49,9 кг (без установленных HDD). Изделия оборудованы двумя модулями ввода/вывода (I/O Module, IOM) с резервированием: каждый из них содержит четыре порта Mini-SAS HD, сетевой порт 1GbE (RJ45) и последовательный порт (USB). Питание обеспечивают два блока мощностью 1800 Вт с сертификатом 80 Plus Titanium. Диапазон рабочих температур простирается от +10 до +35 °C. За охлаждение отвечают четыре корпусных вентилятора с двумя крыльчатками.

Источник изображения: Seagate Seagate подчеркивает, что системы совместимы с технологией Mozaic HAMR, благодаря чему обеспечиваются высокие показатели плотности хранения данных, пропускной способности и экономичности. В частности, в случае Exos 4U100 вместимость в максимальной конфигурации может достигать 3,2 Пбайт (при использовании HDD ёмкостью 32 Тбайт). При этом по сравнению с JBOD-массивами предыдущего поколения заявлено снижение энергопотребления до 30 % и повышение эффективности охлаждения до 70 %. Новинки спроектированы с прицелом на сокращение операционных расходов и минимизацию совокупной стоимости владения (TCO). В продажу Exos 4U100 и Exos 4U74 поступят в I квартале следующего года. Seagate также отмечает, что в перспективе вместимость накопителей, выполненных по технологии Mozaic HAMR, достигнет 50 Тбайт и более. |

|