Материалы по тегу: s

|

14.11.2025 [09:38], Сергей Карасёв

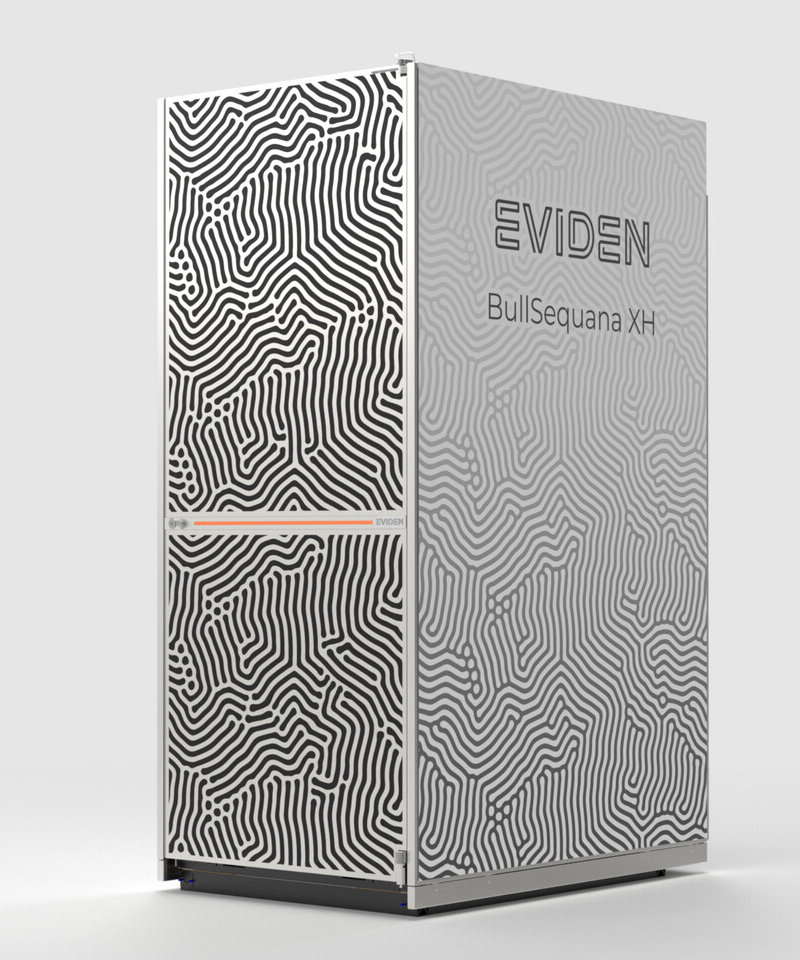

«За пределы экзафлопсного уровня»: Eviden представила суперкомпьютерную платформу BullSequana XH3500Компания Eviden, входящая в Atos Group, анонсировала конвергентную суперкомпьютерную платформу BullSequana XH3500 для ресурсоёмких нагрузок ИИ и HPC. Новинка сочетает передовые аппаратные решения с комплексной экосистемой ПО, обеспечивая возможность масштабирования «за пределы экзафлопсного уровня». BullSequana XH3500 использует открытую модульную конструкцию. Такой подход позволяет свободно комбинировать блоки CPU, GPU и сетевые компоненты от различных производителей, адаптируя конфигурации под определённые потребности. При этом устраняется зависимость от какого-либо конкретного поставщика оборудования, что обеспечивает полную технологическую свободу. По заявлениям Eviden, платформа BullSequana XH3500 по сравнению с системой предыдущего поколения позволяет добиться повышения электрической мощности более чем на 80 % в расчёте на 1 м2 и увеличения эффективности охлаждения на 30 % в расчёт на 1 кВт. Это даёт возможность удовлетворить растущие потребности в вычислительных ресурсах без необходимости расширения площадей в дата-центрах. Габариты стойки BullSequana XH3500 без модуля ультраконденсатора составляют 2270 × 900 × 1457 мм. Мощность AC достигает 284 кВт (с одной помпой). Задействовано на 100 % безвентиляторное прямое жидкостное охлаждение (DLC) пятого поколения с возможностью использования горячей воды с температурой до 40 °C. Подсистемы питания и охлаждения выполнены по схеме с резервированием N+1. Доступны 38 универсальных слотов 1U.

Источник изображения: Eviden Для платформы BullSequana XH3500 разработаны узлы BullSequana XH3515B и BullSequana AI1242. Первый соответствует типоразмеру 1U: это одноузловое изделие оборудовано двумя чипами NVIDIA Grace CPU и четырьмя ускорителями NVIDIA Blackwell B200. Возможна установка до девяти NVMe SSD в форм-факторе E1.S. Говорится о поддержке четырёх сетевых устройств Eviden BXI V3 или InfiniBand NDR/XDR. В свою очередь, сервер BullSequana AI1242 имеет исполнение 2U. Данное решение несёт на борту два процессора AMD EPYC Turin и GPU-ускоритель AMD Instinct MI355X. Реализована поддержка восьми устройств Eviden BXI V3 или InfiniBand NDR/XDR, а также четырёх накопителей E1.S NVMe SSD.

12.11.2025 [23:23], Владимир Мироненко

От ИИ ЦОД до роботов: AMD анонсировала долгосрочную стратегию роста

amd

cpu

dpu

epyc

hardware

instinct

mi400

mi500

ocp

pensando systems

ualink

ultra ethernet

venice

verano

xilinx

ии

ускоритель

финансы

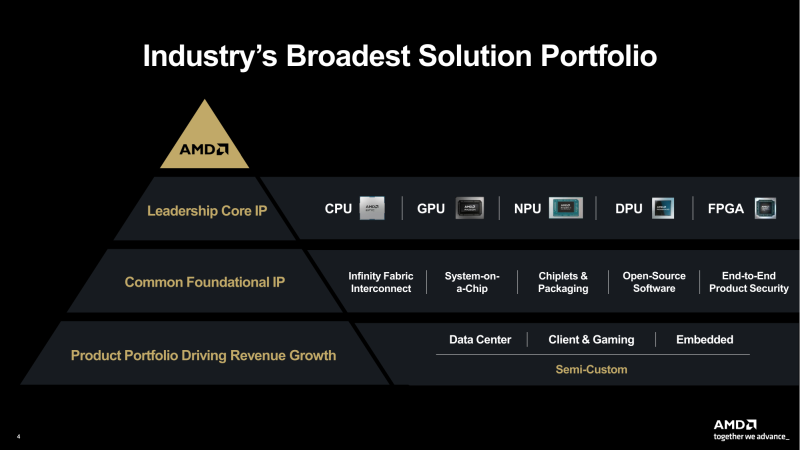

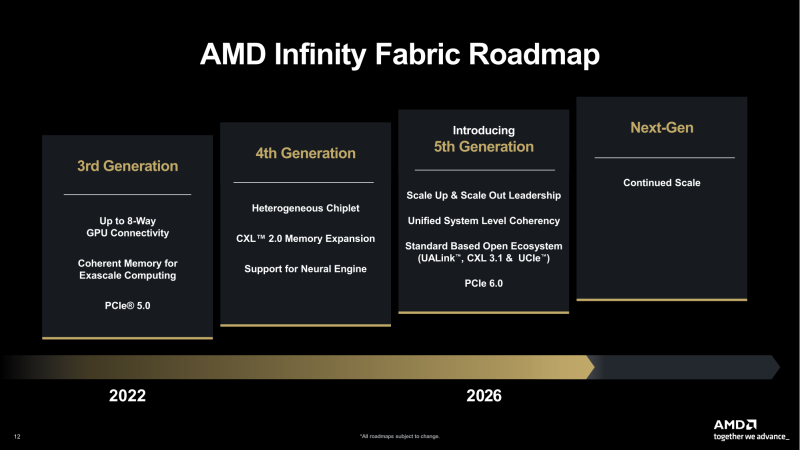

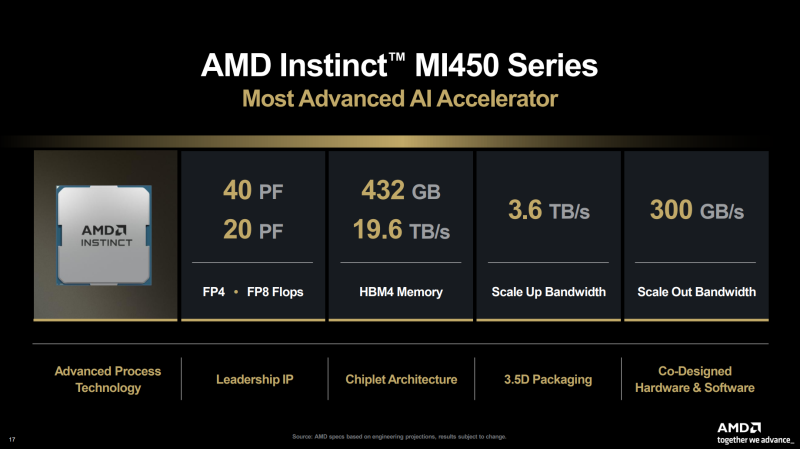

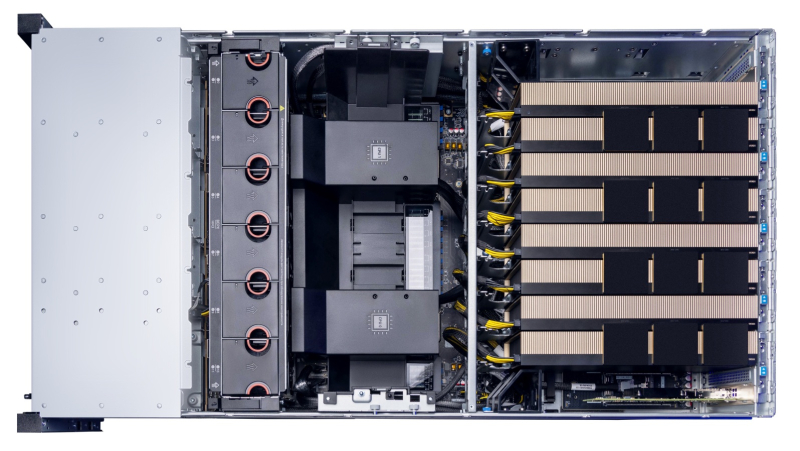

AMD представила на мероприятии Financial Analyst Day 2025 план по достижению лидерства на рынке вычислительных технологий объёмом $1 трлн. Долгосрочная стратегия роста AMD построена на четырех столпах: лидерство в сфере ЦОД, повышение производительности ИИ, открытое ПО и расширение присутствия на рынках встраиваемых и полукастомных кремниевых решений. AMD ожидает, что только её бизнес в сфере ЦОД будет приносить более $100 млрд годовой выручки, с увеличением совокупного среднегодового темпа роста (CAGR) до более чем 60 %, при этом CAGR дохода от ИИ-решений увеличится до более чем 80 %. Генеральный директор AMD Лиза Су (Lisa Su) заявила, что следующий этап будет основан на унифицированной вычислительной платформе AMD, объединяющей процессоры EPYC, ускорители Instinct, сетевые решения Pensando и ПО ROCm. Новый план развития AMD призван обеспечить ей конкуренцию с NVIDIA и Intel на корпоративных рынках и в борьбе за заказы гиперскейлеров. Ускорители серии Instinct MI350, уже развёрнутые Oracle (ещё 50 тыс. MI450 будут развёрнуты во II половине 2026 г.), являются самыми популярными ускорителями AMD на сегодняшний день. Следующей платформой станет серия MI450, которая будет запущена вместе со стоечной платформой Helios в III квартале 2026 года. Helios обеспечит пропускную способность интерконнекта 3,6 Тбайт/с на каждый ускоритель и до 72 ускорителей на стойку с совокупной пропускной способностью 260 Тбайт/с, соединённых между собой посредством UALink и Ultra Ethernet (UEC). Система поддерживает разделяемую память между ускорителями, что обеспечивает обучение крупномасштабных моделей с бесперебойным доступом к памяти и отказоустойчивой сетью с шестью плоскостями. AMD характеризует Helios как свою первую ИИ-платформу стоечного масштаба — полностью интегрированную систему с открытой архитектурой, которая объединяет вычислительные мощности, ускорение, сетевые технологии и ПО в единую структуру. В отличие от традиционных серверных кластеров, Helios реализует всю стойку как единый высокопроизводительный вычислительный домен. Каждая стойка объединяет процессоры AMD EPYC Venice, CDNA5-ускорители Instinct MI450X (будет и вариант MI430X с полноценными FP64-блоками) и 400G/800G-карты Pensando Vulcano, связанные Infinity Fabric пятого поколения (PCIe 6.0, CXL 3.1, UCIe) и UALink. Эта архитектура минимизирует накладные расходы на перемещение данных, увеличивает пропускную способность между ускорителями и обеспечивает эффективность класса экзафлопсных вычислений в компактном корпусе. Helios фактически представляет собой проект AMD для ИИ-фабрики будущего с возможностью модульного расширения, позволяя объединять сотни стоек в одну систему в ЦОД. В 2027 году AMD планирует выпустить ускорители серии MI500 и процессоры EPYC Verano, продолжая тем самым ежегодный цикл совместной разработки процессоров, ускорителей и сетей. AMD заявила, что EPYC Venice, намеченные к выпуску в 2026 году, будут обладать лучшими в отрасли показателями плотности (1,3x по количеству потоков в сравнении с текущими решениями) и энергоэффективности (1,7x). Они пополнятся оптимизированными для ИИ наборами инструкций для обработки инференса и выполнения вычислений общего назначения. Указанные компоненты станут основой ИИ-фабрики, способной масштабироваться от одной стойки до глобально распределённых кластеров. Исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) подчеркнул в своём выступлении, что производительность ИИ всё больше зависит от сети. Сетевые карты AMD Pensando Pollara и Vulcano для ИИ образуют связующую ткань архитектуры Helios. Сетевая карта Pollara 400 обеспечивает пропускную способность 400 Гбит/с, а готовящаяся к выходу сетевая карта Vulcano удвоит её до 800 Гбит/с, обеспечивая связь Ultra Ethernet между крупными кластерами ускорителей. AMD представила четырёхуровневую архитектуру сети для масштабных ИИ-инфраструктур. Front-End часть обслуживает пользователей, хранилище и приложения. Она опирается на DPU Pensando и P4-движки, отвечающие за разгрузку сетевых функций, функции безопасности и шифрования, и работу с СХД. Вертикальное масштабирование в пределах стойки обеспечивает 3,6-Тбайт/с подключение на каждый GPU. Горизонтальное масштабирование реализуется благодаря UEC — внутренние тесты показали снижение затрат на коммутацию до 58 % по сравнению с традиционными сетями типа Fat-Tree. Наконец, Scale-Across (пространственное масштабирование) позволит объединить географически распределённые ЦОД в кластеры с интеллектуальным управлением трафиком и адаптивной балансировкой нагрузки. AMD отметила, что открытый программный стек ROCm (Radeon open compute) по-прежнему лежит в основе её стратегии в области ИИ-платформ. По сравнению с прошлым годом число его загрузок выросло в десять раз и теперь на HuggingFace поддерживается более 2 млн моделей. ROCm интегрируется с ведущими фреймворками, включая PyTorch, TensorFlow, JAX, Triton, vLLM, ComfyUI и Ollama, и поддерживает проекты с открытым исходным кодом, такие как Unsloth. AMD также расширила своё видение «физического ИИ», когда вычисления выходят за рамки облака и охватывают роботов, транспортные средства и промышленные системы. Подразделение встраиваемых систем, усиленное приобретением Xilinx в 2022 году, превратилось из бизнеса, ориентированного на FPGA, в многоплатформенный двигатель роста, охватывающий адаптивные системы на кристалле (SoC), встраиваемые x86-процессоры и заказные кремниевые решения. По словам компании, с 2022 года решения в этой области принесли более $50 млрд. AMD рассчитывает превысить 70 % доли рынка адаптивных вычислений. Говоря о перспективах, компания отметила, что ЦОД остаются основным драйвером роста, но наряду с этим она будет диверсифицировать свою деятельность по всем сегментам. Финансовые цели AMD включают:

12.11.2025 [17:12], Руслан Авдеев

Конкуренция на рынке аккумуляторных энергохранилищ США скажется на ЦОД — у КНР более дешёвые и качественные АКБ

catl

hardware

jefferies

tesla

дефицит

ибп

ии

китай

прогноз

санкции

сша

цод

электропитание

энергетика

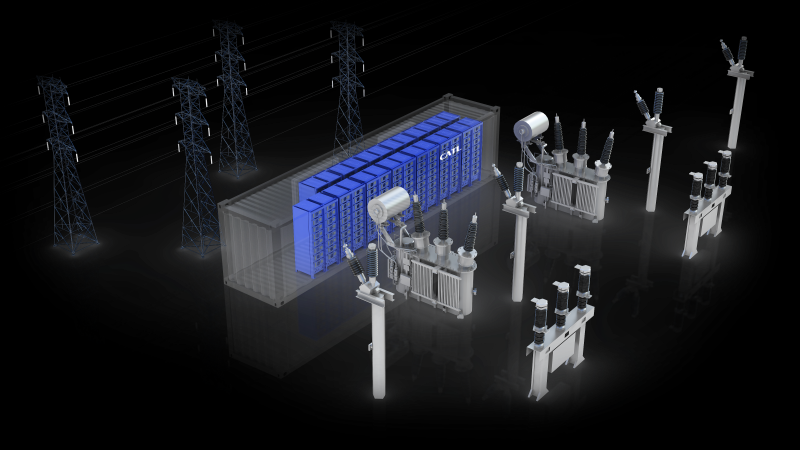

Аккумуляторные энергохранилища (BESS) в скором будущем могут стать стандартом для дата-центров по мере расширения инфраструктуры ИИ ЦОД. Тем не менее американских экспертов настораживает существующая на рынке тенденция — аккумуляторные решения из США во многом уступают китайским аналогам, сообщает The Register. В распоряжение издания попали материалы аналитической компании Jefferies. В отчёте подчёркивается, что гиперскейлеры, строящие ИИ ЦОД, всё больше рассматривают BESS в качестве неотъемлемой части энергетической инфраструктуры. Они всё чаще обращаются к проектам локальной генерации или испытывают проблемы с присоединением к энергосетям, поэтому BESS рассматривается как дополнительный ресурс, позволяющий управлять нагрузками, ускорить подключение и получить избыточные резервы энергии. Аккумуляторные системы используют в качестве резервных наряду с генераторами и другими вариантами получения энергии вроде твёрдооксидных топливных элементов. В Jefferies ожидают, что применение BESS будет расти в связи с трудностями коммунальных служб, которым трудно справиться с ростом спроса на электричество со стороны владельце электромобилей и расширением рынка дата-центров. В отчёте отмечается, что аккумуляторные решения — одна из немногих безуглеродных технологий, которым пророчат процветание при новой администрации США, даже за пределами рынка ЦОД. В следующее десятилетие будут развёрнуты минимум 20 ГВт аккумуляторных энергохранилищ. Наиболее вероятным будет применение литий-железо-фосфатных (LFP или LiFePO4) решений с 2–4-часовым циклом. При этом операторы ЦОД, вероятно, найдут китайские решения более привлекательными как по качеству, так и по цене, но это достаточно рискованный выбор в политической плоскости.

Источник изображения: CATL Наиболее перспективными в Jefferies называют китайских поставщиков CATL и Sungrow. Китайские системы значительно дешевле и совершеннее с точки зрения плотности хранения энергии и эффективности в целом, а последние данные свидетельствуют о росте китайского экспорта. Аналитики полагают, что Китай сохранит преимущество на рынке США и останется весьма конкурентоспособным. Так, в отчёте подчёркивается, что даже налоговая льгота в 40–50 % для произведённых в США систем всё равно не способна сделать китайские альтернативы неконкурентоспособными. Некоторые штаты и коммунальные службы в США, возможно, избегают китайских BESS из-за угроз кибербезопасности. Jefferies называет решения Tesla и Fluence Energy приемлемыми альтернативами. Наилучшие позиции из американских поставщиков для ИИ ЦОД занимает Tesla с решениями Megapack и Megablock. Ожидаемо, что одним из немногих кампусов ЦОД, объявивших о партнёрстве с Tesla, стала xAI (Colossus 1 и Colossus 2), рассчитывающая на ёмкость Megapack в 655 МВт∙ч. В отчёте прогнозируется рост рынка энергохранилищ в 2026 году на уровне менее 10 % из-за вступления в силу ограничений, касающихся иностранных юридических лиц, «вызывающих озабоченность» (FEOC). Кроме того, ситуация не улучшают и тарифные войны, которые на некоторое время привели к увеличению пошлин на импорт в США китайских аккумуляторов более чем на 150 %. Прогнозируется, что спрос на ЦОД на окажет значительного влияния на рынок BESS в 2026 году, поскольку развитие ИИ-технологий всё ещё находится на начальной стадии, но в 2027 году Jefferies ожидает существенного роста.

12.11.2025 [10:28], Владимир Мироненко

YADRO выводит на рынок высокопроизводительный ИИ-сервер для компаний, внедряющих искусственный интеллектYADRO (входит в «ИКС Холдинг») объявляет о коммерческом запуске ИИ-сервера YADRO G4208P G3 — решения для компаний, которые рассматривают искусственный интеллект как стратегический драйвер роста. В условиях перехода рынка от отдельных пилотных проектов к широкому внедрению прикладных сценариев использования искусственного интеллекта новый сервер призван удовлетворить растущий спрос бизнеса на масштабируемую инфраструктуру с предсказуемой эффективностью. Многолетний опыт YADRO в построении ИИ-систем для российских заказчиков лёг в основу архитектуры нового сервера G4208P G3. Платформа спроектирована под реальные задачи бизнеса: дообучение корпоративных моделей и обучение компактных моделей, высокопроизводительный инференс в промышленной среде, а также задачи, где требуется GPU-ускорители, включая видеоаналитику и обработку изображений. YADRO G4208P G3 поддерживает установку до восьми GPU-ускорителей и конфигурации на основе двух процессоров Intel Xeon Scalable 4-го/5-го поколений с интерфейсами PCIe 5.0 и памятью DDR5-5600. Сочетание производительности и масштабируемости такого уровня выводит сервер в число самых сильных предложений на российском рынке. Сервер прошел серию испытаний и сравнений с публичными бенчмарками, включая MLCommons и прикладные тесты для генеративных моделей (LLM). Результаты подтвердили уровень производительности и эффективности, сопоставимый с решениями ведущих мировых вендоров. Для российских компаний это означает, что инфраструктура на базе YADRO G4208P G3 позволит запускать крупные современные ИИ- модели, включая DeepSeek-R1 685B, и обеспечить их стабильную работу в продуктивной среде с соблюдением целевых SLO/SLA, снижением времени отклика сервисов и контролируемыми затратами на развитие инфраструктуры. Параллельно идёт широкая программа испытаний совместно с технологическими партнёрами — разработчиками отечественных программных решений. Ряд сценариев уже успешно протестирован, подтверждены совместимость и ключевые показатели производительности. ИИ-стеки, валидированные на базе серверов YADRO, формируют инфраструктурную основу для развития отечественных технологий искусственного интеллекта. YADRO сопровождает заказчиков на всем пути внедрения своих продуктов. Команда помогает определить оптимальную конфигурацию под конкретные задачи — от картирования рабочих нагрузок и выбора архитектуры до пилотирования и настройки производительности. Полный цикл сервиса включает консультирование, инсталляцию, сопровождение и поддержку на всём жизненном цикле решения. В результате заказчики получают устойчивую ИИ-инфраструктуру, которая работает надёжно и развивается вместе с бизнесом. «Компании переходят к практической интеграции ИИ в ключевые процессы, и мы уверены, что сейчас самый подходящий момент для выхода сервера YADRO G4208P G3. Платформа создана на основе нашего опыта реальных внедрений и ориентирована на быстрый путь от идеи к промышленной эксплуатации. Мы предлагаем оборудование и экспертную поддержку — от выбора конфигурации и внедрения до последующего обслуживания — чтобы заказчики могли эффективно управлять развитием своих ИИ- инициатив», — резюмирует Павел Егоров, директор по продуктам YADRO. Сервер YADRO G4208P G3 внесён в Единый реестр российской радиоэлектронной продукции Минпромторга, что подтверждает его соответствие требованиям импортозамещения и открывает возможность применения в государственных и корпоративных проектах с требованиями по локализации. Подробнее ознакомиться с конфигурациями, результатами тестов и сценариями применения, а также получить рекомендации экспертов и оставить заявку на пилотное тестирование сервера можно на сайте.

12.11.2025 [00:28], Владимир Мироненко

Nebius заключила сделку с Meta✴ на $3 млрд, распродав все свои вычислительные мощности и нарастив выручку на 355 %Поставщик облачных ИИ-решений Nebius Group N.V. (бывшая материнская структура «Яндекса» Yandex N.V.) заключил сделку с Meta✴ на $3 млрд на предоставление гиперскейлеру доступа к ИИ-инфраструктуре в течение пяти лет. Об этом сообщил основатель и генеральный директор Nebius Аркадий Волож в письме акционерам, посвящённом итогам III квартала 2025 финансового года, завершившегося 30 сентября 2025 года. Не раскрывая подробностей, Волож сообщил, что размер контракта был ограничен объёмом имеющихся мощностей. По его словам, компания в течение трёх месяцев развернёт все необходимые для его обслуживания мощности. Волож добавил, что, как и в случае со сделкой с Microsoft, экономические условия этого соглашения привлекательны и помогут ускорить рост облачного ИИ-бизнеса Nebius. По словам Воложа, выручка от сделки с Microsoft на сумму до $19,4 млрд, тоже заключённой на пять лет, начнёт расти в 2026 году. Nebius также опубликовала неаудированные результаты за III квартал 2025 финансового года. Выручка компании составила $146,1 млн, что на 355 % больше год к году и на 39 % больше, чем в предыдущем квартале. Nebius завершила квартал с чистым убытком в размере $119,6 млн, что больше убытка годом ранее, составившего $43,6 млн. Скорректированный чистый убыток вырос с $39,7 млн в прошлом году до $100,4 млн. Капитальные затраты компании взлетели на 455 % — до $955,5 млн со $172,1 млн годом ранее. Скорректированная EBITDA составила −$5,2 млн против −$45,9 млн годом ранее. В 2026 году компания планирует достичь годовой доходности (Annualized Run Rate, ARR) в пределах $7–$9 млрд. Также было объявлено, что в настоящее время все доступные мощности Nebius распроданы. Волож заявил, что 2025 год стал годом развития, поскольку компания создала инфраструктуру и основу для будущего быстрого роста. В следующем году Nebius должна прочно занять место в числе ведущих мировых компаний в сфере облачных ИИ-технологий, считает глава компании. «И в то же время 2026 год — это только начало», — добавил он. Волож сообщил, что для поддержки амбициозных планов роста в 2026 году и сохранения этих темпов роста в 2027 году компания будет использовать как минимум три источника финансирования: корпоративный долг, финансирование под залог активов и акционерный капитал. «В прошлом квартале мы прогнозировали 1 ГВт законтрактованной мощности к концу 2026 года. В настоящее время мы занимаемся поиском дополнительных площадок, которые доведут нашу общую законтрактованную мощность (т.е. закреплённую за электроэнергией землю) примерно до 2,5 ГВт к концу 2026 года, — рассказал Волож. — Из этого контрактного объёма мы ожидаем, что к концу 2026 года будет подключено от 800 МВт до 1 ГВт электроэнергии (т.е. электроэнергии, подключенной к построенным ЦОД)».

11.11.2025 [17:14], Андрей Крупин

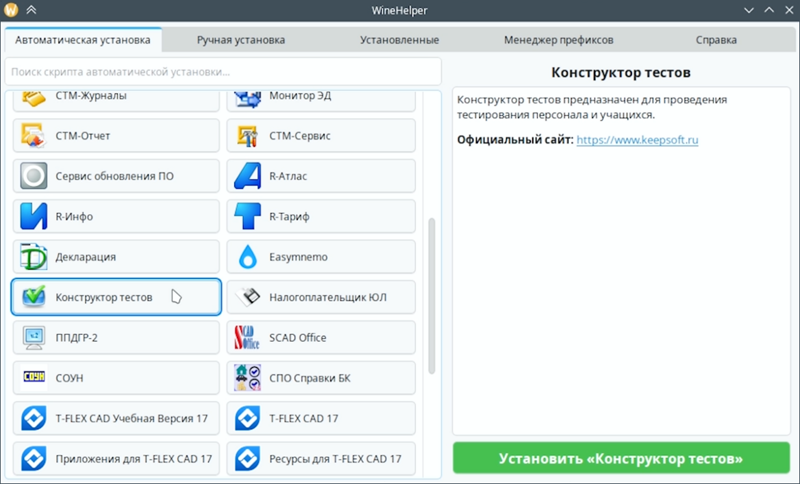

Вышла новая версия WineHelper — программы для запуска Windows-приложений в ОС «Альт» LinuxКомпания «Базальт СПО» представила новую версию WineHelper — программного решения для установки и запуска Windows-приложений в операционных системах семейства «Альт». Инструмент WineHelper построен на базе портативной сборки Wine, дополненной набором скриптов, автоматизирующих развёртывание ПО Windows в среде Linux. Обновлённая редакция WineHelper получила графический пользовательский интерфейс и возможность запуска программы непосредственно из меню приложений ОС «Альт». В дополнение к этому появились два режима установки Windows-программ — автоматический и ручной, новая вкладка «Менеджер префиксов» с расширенными настройками Wine, а также инструменты резервного копирования созданных префиксов.

Источник изображения: basealt.ru WineHelper поддерживает автоматическое развёртывание более 40 программных продуктов Windows, в числе которых T-Flex CAD, «Декларация», «СТМ-Финансы», «R-Инфо», SCAD Offce, «Налогоплательщик ЮЛ», «Монитор ЭД» и многие другие востребованные в корпоративной среде решения. Программы добавляются в WineHelper по запросам заказчиков.

10.11.2025 [15:00], Владимир Мироненко

Фирменные ИИ-ускорители Amazon всё ещё не могут конкурировать с чипами NVIDIA, считают некоторые стартапыНекоторые стартапы считают, что ИИ-чипы Trainium и Inferenetia собственной разработки Amazon менее конкурентоспособны, чем ускорители NVIDIA, сообщил ресурс Business Insider со ссылкой на внутреннюю документацию AWS. Согласно июльскому «конфиденциальному» внутреннему документу Amazon, ИИ-стартап Cohere обнаружил, что чипы Amazon Trainium 1 и 2 «уступают по производительности» ускорителям NVIDIA H100. Стартап отметил, что доступ к Trainium2 был «крайне ограничен», а в работе наблюдались частые перебои. Amazon и её подразделение Annapurna Labs всё еще изучают возникшие у Cohere «проблемы с производительностью», но прогресс в решении этих проблем был «ограниченным», отмечено в официальном документе. Также в нём упоминается стартап Stability AI, разработавший, в том числе, ИИ-генератор изображений Stable Diffusion, который высказывал схожие претензии. В частности, говорится, что чипы Amazon Trainium2 уступают NVIDIA H100 по задержке, что делает их «менее конкурентоспособными» с точки зрения скорости и стоимости. Ставка Amazon на чипы собственной разработки является частью её усилий по обеспечению конкурентоспособности в ИИ-гонке. Её прибыльность основана в том числе на использовании собственных процессоров Graviton вместо дорогостоящих чипов Intel. И сейчас Amazon тоже стремится задействовать собственные чипы для обработки ИИ-нагрузок. Если некоторые клиенты AWS не захотят использовать Trainium и будут настаивать на том, чтобы AWS запускала свои облачные ИИ-системы с использованием чипов NVIDIA, которые гораздо дороже её собственных решений, это отразится на её прибыли от облачных вычислений, отметил Business Insider. Рынок стартапов давно является важным для AWS, поэтому их претензии имеют большое значение для компании. Представитель Amazon заявил, что компания «благодарна» клиентам за отзывы, которые помогают сделать её чипы «еще лучше и более широко используемыми». Он добавил, что кейс с Cohere «не является актуальным», отметив, что её чипы Trainium и Inferentia «достигли отличных результатов» с такими клиентами, как Ricoh, Datadog и Metagenomi. «Мы очень довольны ростом и внедрением Trainium2, который на данном этапе в основном используется небольшим числом очень крупных клиентов, таких как Anthropic», — написал представитель в электронном письме ресурсу Business Insider. AWS утверждает, что ее собственные ИИ-ускорители предлагают на 30-40 % лучшие ценовые характеристики, чем нынешнее поколение GPU. Компания обладает «невероятными талантами» в области проектирования чипов и работает над новыми поколениями ускорителей. «Мы рассчитываем привлечь больше клиентов, начиная с Trainium 3, превью которого ожидается позже в этом году», — сказал представитель Amazon. Генеральный директор Amazon Энди Джасси (Andy Jassy) заявил во время отчёта о доходах компании, что чипы Trainium2 «полностью распределены по подписке» и теперь являются «многомиллиардным» бизнесом, который последовательно увеличивается на 150 % от квартала к кварталу. Жалобы клиентов Amazon на её чипы поступали и раньше. Согласно июльскому документу, стартап Typhoon обнаружил, что устаревшие ускорители NVIDIA A100 в три раза экономичнее для определённых рабочих нагрузок, чем чипы Inferentia2 от AWS, ориентированные на инференс. В свою очередь, исследовательская группа AI Singapore установила, что серверы AWS G6, оснащённые ускорителями NVIDIA, более экономичны по сравнению с Inferentia2 при различных вариантах использования. В прошлом году клиенты облака Amazon также отмечали «проблемы при внедрении» её пользовательских ИИ-чипов, которые создают «проблемные области», что ведёт к снижению их использования. Эти проблемы нашли отражение в доле рынка Amazon. По данным исследовательской компании Omdia, NVIDIA доминирует на рынке ИИ-чипов с долей более 78 %. За ней следуют Google и AMD, владеющие по чуть более 4 %. AWS занимает лишь шестое место с 2 % рынка. Наглядно иллюстрирует проблемы Amazon в этом отношении соглашение AWS и OpenAI стоимостью $38 млрд. Сделка предполагает использование облачных ИИ-серверов на базе ускорителей NVIDIA, без упоминания чипов Trainium. Ускорители NVIDIA не только обеспечивают высокую производительность, но подкрепляются широко распространённой платформой CUDA. Это качество особенно ценно при разработке крупных проектов в области ИИ с высоким уровнем риска, когда надёжность и имеющийся опыт могут сыграть решающую роль. В июльском документе сотрудники Amazon отметили, что технические ограничения и другие проблемы, связанные со сравнением пользовательских ИИ-чипов компании и ускорителей NVIDIA, стали «критическим препятствием» для клиентов, задумывающихся о переходе на чипы AWS. До публикации отчёта о доходах Amazon на прошлой неделе аналитики Bank of America соблюдали осторожность в оценке прогресса Tranium. В аналитической заметке, опубликованной в конце октября, они предупредили, что инвесторы «скептически» относятся к возможностям Trainium, и что «неясно», проявится ли высокий спрос на них «за пределами Anthropic». Недавно AWS запустила проект Project Rainier — ИИ-кластер из полумиллиона чипов Trainium2, которые будут использоваться для обучения LLM следующего поколения Anthropic. Ожидается, что к концу года Anthropic получит более 1 млн чипов Trainium2, но решение по этому вопросу ещё не принято. Если реализация проекта будет успешной, это станет огромным подспорьем для Amazon. Вместе с тем в прошлом месяце Anthropic подписала многомиллиардный контракт на использование Google TPU, отметив, что продолжит использовать Trainium. Хотя Anthropic публично признала сложность использования архитектур с разными чипами, представитель Amazon сообщил Business Insider, что Anthropic продолжает расширять использование Trainium и подчеркнул стремление компании предлагать клиентам широкий спектр аппаратных опций в рамках своих облачных сервисов. В ходе общения с аналитиками на прошлой неделе Джасси подчеркнул, что AWS сосредоточена на предоставлении «нескольких вариантов чипов». Он отметил, что цель состоит не в том, чтобы заменить чипы NVIDIA, а в том, чтобы предоставить клиентам больше выбора. Этой стратегии AWS придерживается и в других областях облачных вычислений, сказал он. «В истории AWS никогда не было случая, чтобы какой-то один игрок в течение длительного периода времени владел всем сегментом рынка, а затем мог удовлетворить потребности всех во всех аспектах», — сказал Джасси. В долгосрочной перспективе не слишком удачные продажи собственных ускорителей не лучшим образом скажутся на AWS. Компания понимает, что её решения могут быть менее производительны и удобны, поэтому и предлагает их по меньшей цене, чем ускорители NVIDIA. Однако стоимость их производства сравнима со стоимостью производства чипов такого же класса, и со временем она будет только расти. Проще говоря, Amazon меньше зарабатывает на своих чипах, а в худшем случае может терять на них деньги.

10.11.2025 [12:05], Сергей Карасёв

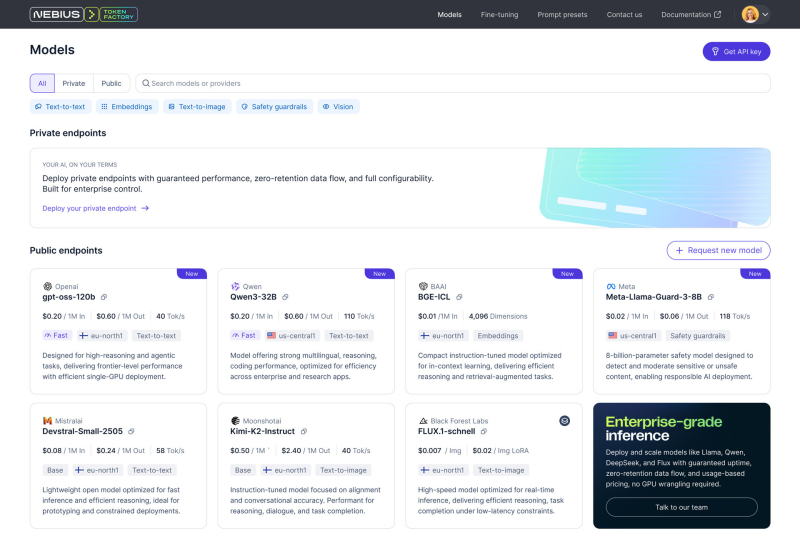

Фабрика токенов: Nebius, бывшая Yandex NV, запустила платформу Token Factory для инференса на базе открытых ИИ-моделейКомпания Nebius (бывшая материнская структура «Яндекса») представила платформу Nebius Token Factory для инференса: она позволяет разворачивать и оптимизировать открытые и кастомизированные ИИ-модели в больших масштабах с высоким уровнем надёжности и необходимым контролем. Nebius отмечает, что применение закрытых ИИ-моделей может создавать трудности при масштабировании. С другой стороны, открытые и кастомизированные модели позволяют устранить эти ограничения, но управление ими и обеспечение безопасности остаются технически сложными и ресурсоёмкими задачами для большинства команд. Платформа Nebius Token Factory призвана решить существующие проблемы: она сочетает гибкость открытых моделей с управляемостью, производительностью и экономичностью, которые необходимы организациям для реализации масштабных проектов в сфере ИИ. Nebius Token Factory базируется на комплексной ИИ-инфраструктуре Nebius. Новая платформа объединяет высокопроизводительный инференс, пост-обучение и управление доступом. Обеспечивается поддержка более 40 open source моделей, включая новейшие версии Deep Seek, Llama, OpenAI и Qwen. Среди ключевых преимуществ Nebius Token Factory заявлены соответствие требованиям корпоративной безопасности (HIPAA, ISO 27001 и ISO 27799), предсказуемая задержка (менее 1 с), автоматическое масштабирование пропускной способности и доступность на уровне 99,9 %. Инференс выполняется в дата-центрах на территории Европы и США без сохранения данных на серверах Nebius. Задействована облачная экосистема Nebius AI Cloud 3.0 Aether, что, как утверждается, обеспечивает безопасность корпоративного уровня, проактивный мониторинг и стабильную производительность. Отмечается, что Nebius Token Factory может применяться для решения широкого спектра ИИ-задач: от интеллектуальных чат-ботов, помощников по написанию программного кода и генерации с дополненной выборкой (RAG) до высокопроизводительного поиска, анализа документов и автоматизированной поддержки клиентов. Интегрированные инструменты тонкой настройки и дистилляции позволяют компаниям адаптировать большие открытые модели к собственным данным. При этом достигается сокращение затрат на инференс до 70 %. Оптимизированные модели затем можно быстро разворачивать без ручной настройки инфраструктуры.

10.11.2025 [09:24], Сергей Карасёв

QNAP выпустила стоечное хранилище TS-h2477AXU-RP на платформе AMDКомпания QNAP Systems анонсировала сетевое хранилище (NAS) корпоративного класса TS-h2477AXU-RP, которое использует аппаратную платформу AMD, ОС QTS 5.2.6 и файловую систему ZFS. Новинка выполнена в форм-факторе 4U для монтажа в серверную стойку. Применён процессор серии Ryzen 7 Pro 7000 с восемью ядрами (16 потоков) с максимальной тактовой частотой до 5,3 ГГц. В состав чипа входит ускоритель AMD Radeon Graphics. Объём оперативной памяти DDR5 в стандартной конфигурации составляет 32 Гбайт (расширяется до 192 Гбайт в виде четырёх модулей на 48 Гбайт). Есть 5 Гбайт интегрированной флеш-памяти. Во фронтальной части располагаются 24 отсека для LFF/SFF-накопителей с интерфейсом SATA-3: могут применяться HDD или SSD с горячей заменой. Кроме того, предусмотрены два внутренних коннектора M.2 2280 для SSD с интерфейсом PCIe 5.0 x2. При использовании HDD на 30 Тбайт суммарная полезная ёмкость, как отмечает QNAP, достигает 600 Тбайт. При этом могут быть добавлены модули расширения: например, при использовании восьми дополнительных массивов TL-R2400PES-RP на 24 накопителя каждый можно получить ещё 192 отсека для HDD/SSD. Есть по два сетевых порта 2.5GbE и 10GbE. Хранилище получило три слота PCIe 4.0 х4, в которые могут устанавливаться карты расширения, включая сетевые адаптеры 25GbE. Имеются также два порта USB 3.2 Gen2 Type-A. Питание обеспечивают два блока мощностью 800 Вт с резервированием. За охлаждение отвечают три системных вентилятора диаметром 60 мм. Диапазон рабочих температур — от 0 до +40 °C. Габариты устройства составляют 177,35 × 432,4 × 511,7 мм, масса — 18,62 кг без установленных накопителей. Производитель предоставляет на модель TS-h2477AXU-RP пятилетнюю гарантию.

09.11.2025 [13:38], Сергей Карасёв

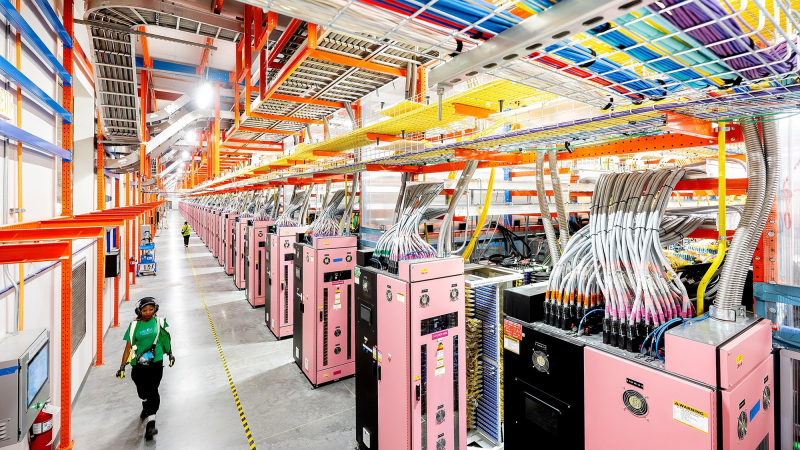

Nebius Аркадия Воложа развернула в Великобритании платформу AI Cloud на базе NVIDIA HGX B300Компания Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) объявила о своём первом развёртывании ИИ-инфраструктуры в Великобритании. Кластер Nebius AI Cloud расположен в кампусе Longcross Park на площадке Ark Data Centres недалеко от Лондона. Как отмечает основатель и генеральный директор Nebius Аркадий Волож, Великобритания является одним из ведущих ИИ-центров в мире. Поэтому для компании создание кластера на территории этой страны имеет большое значение. Кластер состоит из 126 стоек с оборудованием, размещённых в трёх машинных залах. В рамках первой фазы проекта установлены 4 тыс. ускорителей NVIDIA HGX B300 (Blackwell Ultra) в составе серверов пятого поколения (Gen5) собственной разработки Nebius. Вторая фаза предполагает монтаж ещё 3 тыс. ускорителей B300. Общая мощность системы — 16 МВт. По заявлениям Nebius, британский кластер AI Cloud использует передовые энергоэффективные технологии охлаждения, сетевое подключение NVIDIA Quantum-X800 InfiniBand с низкой задержкой и надёжную локальную систему генерации электроэнергии. Говорится о полной интеграции с программной платформой NVIDIA AI Enterprise, предназначенной для разработки и развёртывания ИИ-приложений. Объединяя нашу облачную инфраструктуру с новейшими технологиями NVIDIA, мы предоставляем организациям по всей Великобритании возможность обучать, развёртывать и масштабировать модели и приложения ИИ быстрее, безопаснее и эффективнее, чем когда-либо», — говорит Волож. Британский кластер использует облачную платформу Nebius AI Cloud 3.0 Aether, которая разработана специально для создания и использования ИИ в таких областях, как здравоохранение, финансы, науки о жизни, корпоративный сектор и государственная сфера. Говорится о поддержке сквозного шифрования и о полном соответствии стандартам защиты данных GDPR и CCPA. Ранее Nebius сообщила о запуске своего первого кластера AI Cloud в Израиле, который расположился на площадке в Модиине (Modiin). У Nebius также имеются дата-центры в Финляндии, Франции и США. |

|