Материалы по тегу: s

|

28.11.2025 [08:44], Сергей Карасёв

MSI выпустила многоузловые серверы на базе Intel Xeon 6 для общих задачКомпания MSI анонсировала серверы общего назначения CD270-S3061-X4 и CD270-S3071-X2 в форм-факторе 2U. Новинки, получившие многоузловую конфигурацию, построены на аппаратной платформе Intel с процессорами Xeon 6. Модель CD270-S3061-X4 насчитывает четыре узла (2U4N). Каждый из них может нести на борту один чип Xeon 6700E семейства Sierra Forest-SP или Xeon 6500P/6700P поколения Granite Rapids-SP с показателем TDP до 350 Вт. В расчёте на узел доступны 16 слотов для модулей DDR5 (RDIMM-6400 или MRDIMM-8000), три фронтальных отсека для накопителей U.2 NVMe SSD с интерфейсом PCIe 5.0 x4, два внутренних коннектора М.2 2280/22110 (PCIe 5.0 x2) и слот OCP 3.0 (PCIe 5.0 x16). В оснащение также входят контроллер ASPEED AST2600, выделенный сетевой порт управления 1GbE, последовательный порт (разъём USB Type-A), порт USB 2.0 Type-A и коннектор Mini-DisplayPort. В свою очередь, CD270-S3071-X2 — это двухузловая система (2U2N). Каждый узел может быть оборудован процессором Xeon 6900 серии Granite Rapids-AP с TDP до 500 Вт, 12 модулями DDR5 (RDIMM-6400 или MRDIMM-8800), шестью фронтальными U.2 NVMe SSD с интерфейсом PCIe 5.0 x4 и двумя внутренними SSD типоразмера М.2 2280/22110 с интерфейсом PCIe 5.0 x2 (NVMe). Реализованы по одному слоту PCIe 5.0 x16 с поддержкой карт FHHL и OCP 3.0 (PCIe 5.0 x16). Прочие характеристики аналогичны четырёхузловой модели. Габариты серверов составляют 448 × 87 × 747 мм. Установлены два блока питания с резервированием и сертификацией 80 PLUS Titanium (мощностью 2700 Вт у варианта с четырьмя узлами и 2400 Вт у версии с двумя узлами). Применено воздушное охлаждение. Диапазон рабочих температур — от 0 до +35 °C.

27.11.2025 [21:00], Руслан Авдеев

Airbus уже семь лет переезжает с Microsoft Office на Google Workspace, но полностью отказаться от Excel и Word всё не получаетсяОсвободиться от офисных программ Microsoft сложнее, чем может показаться. Французская Airbus начала перевод 130 тыс. своих сотрудников с пакета Microsoft Office на облачную платформу Google Workspace более семи лет тому назад, но так его и не закончила, хотя изначально планировалось завершить миграцию в течение 18 мес., сообщает The Register. В 2018 году авиагигант объявил о миграции на облачные инструменты Google. И хотя сегодня более ⅔ из 150 тыс. сотрудников Airbus полностью перешли на новое ПО, значительная часть из них всё равно параллельно пользуется программами Microsoft. Так, сотрудники финансового отдела традиционно используют Excel, поскольку Google Таблицы не поддерживают требуемые размеры файлов — некоторые документы содержат по 20 млн ячеек. Коммерческий, закупочный и юридический отделы требуют надёжного отслеживания изменений в документах, но в Google Документах такая функция всё ещё не полностью совместима с режимом правок в Word. В результате ПО Google не может справиться со сложным форматированием документов и комментариями в Word-документах. В Google обещали, что 100-% совместимость появится в 2026 году, т.е. через 20 лет после запуска Google Docs. Некоторые источники в Airbus на условиях анонимности подтвердили, что проблемы с совместимостью сохраняются, поэтому многие вынуждены продолжить пользоваться Excel. При этом компания по-прежнему платит Microsoft за лицензии, но масштаб проблемы и объём расходов не называются. Существуют и другие препятствия, не имеющие отношения к Google. Так, секретные документы нельзя размещать в облаке, поэтому работа над военными проектами ведётся в локально развёрнутом ПО Microsoft.

Источник изображения: Jeremy/unsplash.com Впрочем, руководство Airbus хвалит Google за готовность работать над своим программным обеспечением для улучшения совместимости и повышения функциональности Workspace. Airbus — важный клиент Google, поэтому руководство последней считает жизненно важным сохранить партнёра с огромным числом пользователей с учётом того, что Google претендует на соперничество с Microsoft, обладающей огромной пользовательской базой. Впрочем, у Microsoft есть собственные значимые недостатки. Так, в сентябре 2025 года сообщалось, что компания намерена запретить перепродажу корпоративных лицензий Office и Windows компаниям, уже не испытывающим в них нужды — в Великобритании дело дошло до суда. А обвинения Microsoft в неконкурентном поведении уже стали привычными.

27.11.2025 [12:16], Сергей Карасёв

Celestica выпустила JBOD-массив SD6300 на 108 накопителей для ИИ-платформКомпания Celestica анонсировала JBOD-массив SD6300 высокой плотности, ориентированный на инфраструктуры гиперскейлеров, платформы ИИ и пр. Новинка может применяться для формирования озер данных, объектных хранилищ, долгосрочного (холодного) хранения и архивирования информации. Устройство выполнено в форм-факторе 4U. Допускается установка до 108 двухпортовых накопителей стандартов LFF/SFF в конфигурации 104 × SAS-3 и 4 × SAS-4. Таким образом, могут монтировать как традиционные HDD, так и высокопроизводительные SSD. Это обеспечивает более высокую общую производительность на операциях чтения и записи, что важно при решении задач, которым требуется интенсивный обмен данными.

Источник изображения: Celestica JBOD-массив SD6300 имеет глубину 1125 мм (включая систему управления кабелями), что, как утверждает Celestica, позволяет максимально эффективно использовать имеющееся пространство в дата-центрах. Отмечается, что на сегодняшний день новинка является наиболее компактным решением в своём классе с поддержкой до 108 накопителей. Устройство располагает четырьмя интерфейсами mini-SAS HD. За охлаждение отвечают двухроторные вентиляторные блоки с резервированием. Установлены два блока питания неназванной мощности. Среди ключевых преимуществ продукта названы высокая плотность хранения в расчёте на стойку, сокращение капитальных и эксплуатационных расходов благодаря максимально эффективному использованию площади ЦОД, гибкость применения (подходит для широкого спектра задач) и удобство интеграции в IT-инфраструктуру.

26.11.2025 [17:49], Руслан Авдеев

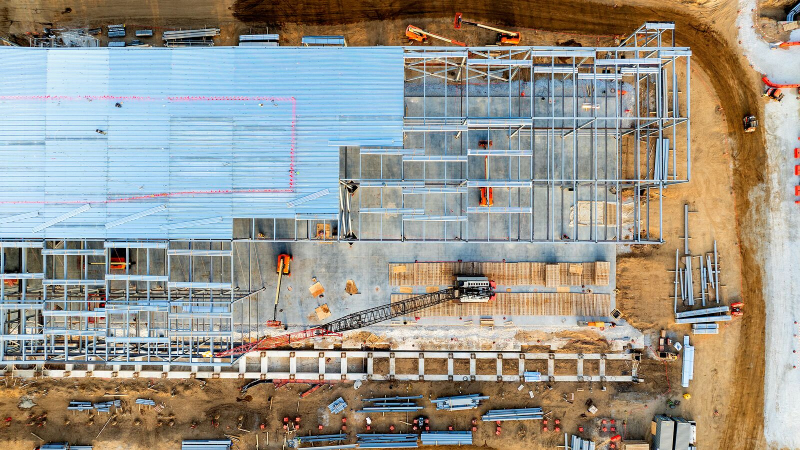

AWS вложит $26 млрд в ИИ-инфраструктуру в Индиане, покрыв расходы на новые ЛЭП и электростанции для своих ЦОДКомпания Amazon (AWS) намерена вложить $15 млрд в ИИ-инфраструктуру в Индиане в дополнение к $11 млрд, выделенным на ЦОД в округе Сен-Жозеф (St. Joseph County). Компания намерена нарастить мощности ЦОД в регионе на 2,4 ГВт, открыв в штате новые кампусы. Подробности не разглашаются, но известно, что в 2023 году компания хотела построить новый кампус в Портидже (Portage, округ Портер), и даже получила небольшие налоговые льготы. Строительство кампуса стоимостью $11 млрд в Нью-Карлайле (New Carlisle, округ Сен-Жозеф) началось в октябре. Кампус, вероятно, будет состоять из 22 зданий, причём минимум треть достанется ИИ-суперкластеру Project Rainier. В Amazon подчёркивают, что все новые объекты в штате изначально проектировались с учётом возможного масштабирования и оптимизированы для ИИ, ML и облачных приложений нового поколения с поддержкой отраслевых стандартов устойчивого развития. В данном случае интересно и то, что AWS договорилась с местной коммунальной компанией NIPSCO о защите жителей и малого бизнеса от повышения тарифов на электричество. Они, как утверждается, смогут сэкономить около $1 млрд за 15 лет. AWS будет платить за использование ЛЭП и покрывать расходы на любые новые электростанции, новые линии и оборудование, необходимые для питания очередных ЦОД компании. Общий объём введённых мощностей может достигнуть 3 ГВт, из которых 2,4 ГВт достанутся дата-центрам Amazon. С 2010 года Amazon инвестировала в Индиану более $31,3 млрд, увеличив местный ВВП на более чем $29,9 млрд и поддержав создание 24,5 тыс. рабочих мест разного характера, а также 27,5 тыс. «косвенных» рабочих мест на разных объектах. Собственные ЦОД в штате строят Meta✴, Microsoft и Google.

26.11.2025 [09:50], Руслан Авдеев

У Amazon насчитали более 900 ЦОД в полусотне стран, но компании всё равно этого малоИнфраструктура ЦОД Amazon, вероятно, гораздо масштабнее, чем принято считать. Выяснилось, что более 50 стран стали прибежищем для свыше 900 дата-центров компании, включая совсем небольшие объекты для периферийных сервисов, сообщает Bloomberg со ссылкой на данные SourceMaterial. Крупнейшие кампусы AWS находятся в США, в Вирджинии и Орегоне. Однако у компании есть множество как собственных ЦОД, так и арендованных на долгий срок объектов. Компания размещает стойки в сотнях колокейшн-ЦОД, при этом на них приходится лишь приблизительно 20 % всех вычислительных мощностей AWS. Где-то AWS размещает всего несколько стоек, а где-то, как во Франкфурте и Токио, арендует крупные ЦОД целиком. Согласно документам об энергопотреблении, крупнейшие арендуемые AWS ЦОД, вероятно, расположены во Франкфурте, Монреале, Мумбаи, Сеуле, Сингапуре и Токио или окрестностях этих мегаполисов. Точное местоположение дата-центров не раскрывается, но документы дают некоторое представление о возможностях компании. Они же свидетельствуют о том, что AWS является одним из крупнейших в мире арендаторов колокейшн-площадей. По словам New Relic, помогающей бизнесам управлять технологической инфраструктурой, помимо крупных ЦОД у гиперскейлеров обычно есть и более мелкие облачные объекты, но провайдеры не любят раскрывать их локации. Всего на начало 2024 года AWS пользовалась услугами более 440 колокейшн-ЦОД. Ещё более 220 дополнительных объектов относятся к периферийным, так что полноценными дата-центрами их назвать сложно. Они часто размещаются рядом с мегаполисами и на территории телеком-хабов. Как сообщают в AWS, хотя компания владеет и управляет большинством своих ЦОД, используются и возможности сторонних организаций, чтобы быстро реагировать на меняющиеся требования клиентов. При выходе на новые рынки или изменении спроса AWS опирается на сторонние компании, наращивая мощности для новых клиентов и ИИ-проектов. А, к примеру, в Китае, компания и вовсе обязана работать через местных партнёров. В конце 2023 года Amazon заявила, что имеет втрое больше дата-центров, чем ближайший конкурент. Речь шла о Microsoft, которая в то время имела портфолио из 300 объектов. Baxtel говорит о присутствии Amazon в 449 ЦОД на 49 рынках. DC Byte оценивает парк AWS в 364 объекта в 33 странах. Впрочем, точно установить количество невозможно, поскольку соглашения об аренде обычно носят конфиденциальный характер. В целом, судя по документам, Amazon имеет соглашения, как минимум, со 180 организациями в рамках колокейшн-договоров. По имеющимся данным, компания владеет зданиями общей площадью более 2,4 млн м2 и ещё примерно столько же арендует. Несмотря на огромный парк ЦОД, дела у компании не всегда идут гладко. Не всегда она успевает за спросом и не всегда может обеспечить необходимое качество услуг. Так, согласно Business Insider, нехватка ИИ-мощностей AWS и проблемы с производительностью заставили многих клиентов обратиться к соперникам. Тем не менее, в III квартале облако Amazon принесло $33 млрд и остаётся самым прибыльным в компании, т.ч. только в этом году объём капитальных затрат составит $125 млрд. Масштабы бизнеса стали очевидны в октябре, когда сбой AWS вывел из строя онлайн-сервисы по всему миру.

25.11.2025 [16:24], Руслан Авдеев

Нехватка ИИ-мощностей и проблемы с производительностью вынудили многих клиентов AWS обратиться к конкурентамЛетом 2025 года облачный бизнес Amazon (AWS) с трудом справлялся с растущим спросом на ИИ и упустил часть доходов. Сервис Bedrock занимает ключевое место в развитии ИИ-проектов компании. Однако летом Bedrock столкнулся с нехваткой мощностей, из-за чего некоторые клиенты ушли к конкурентам, в том числе к Google, сообщает Business Insider. Это привело к потерям десятков миллионов долларов и отложенной выручки. Например, проект Fortnite стоимостью $10 млн достался Google Cloud после того, как AWS не смогла выделить ей необходимые квоты (лимит на токены или вызовы API). Согласно внутреннему документу AWS, попавшему в распоряжение журналистов, нефтетрейдер Vitol также перенёс проекты из AWS, а некоторые крупные клиенты, включая Atlassian и GovTech Singapore, летом были вынуждены ожидать увеличения квот, что привело к «отсроченным продажам» минимум на $52,6 млн. Более того, задержки с одобрением выделения мощностей и отказ в обработке нерегулярных, вынудили Stripe, Robinhood и Vanguard отказаться от переноса нагрузок в Bedrock. Подчёркивается, что проблемы Bedrock потенциально ведут к потерям выручки и проблемам с клиентами. Это объясняет, почему облачные компании стремятся построить как можно больше ИИ ЦОД. Высокий спрос хорош только тогда, когда можно его удовлетворить и удержать клиентов от перехода к конкурентам. Бывшие и действующие сотрудники AWS отмечают, что проблемы с вычислительными мощностями были одними из наиболее значимых для компании в сентябре. AWS и раньше испытывала проблемы с нехваткой мощностей даже для собственных нужд, но сейчас ситуация обострилась. Тем временем в Amazon утверждают, что Bedrock быстро растёт, а AWS стремительно наращивает мощности для удовлетворения спроса, за 12 месяцев добавив 3,8 ГВт. Это больше, чем смогу получить любой другой облачный провайдер. AWS удвоила мощность с 2022 года и намерена сделать то же самое к 2027 году. Компания и далее намерена быть «очень агрессивной» в деле масштабирования вычислительных мощностей, причём AWS может монетизировать новые мощности «практически незамедлительно», а Bedrock имеет не меньший потенциал роста, чем EC2. Частично проблемы с Bedrock могут быть связаны с тем, что компания отдаёт предпочтение крупным клиентам. В октябре заявлялось, что большинство задач Bedrock выполняется с помощью «доморощенных» ИИ-чипов Trainium, но в основном нагрузки приходятся на нескольких очень крупных клиентов, которые, по-видимому, готовы вкладываться в развитие инструментов на не самой популярной платформе. Ожидается, что компании среднего размера в ближайшие месяцы тоже начнут использовать Trainium нового поколения. Впрочем, последние иногда всё ещё не могут конкурировать с чипами NVIDIA. Впрочем, помешала Bedrock не только нехватка мощностей. Так, Figma, Intercom и Wealthsimple предпочли использовать LLM Claude в Google Cloud или на платформе самой Anthropic из-за недостатка функций и высокой задержки в Bedrock. Британская госслужба Government Digital Service рассматривала переход в Microsoft Azure только потому, что Claude 3.7 Sonnet работала медленнее на платформе Bedrock. Thomson Reuters также выбрала Google Cloud для своего ИИ-продукта CoCounsel, поскольку сервис AWS оказался на 15–30 % медленнее и не имел ключевых правительственных сертификатов. В документе AWS отмечается, что платформа Bedrock уступает Google. Для моделей Gemini квоты в пять-шесть раз выше, а Gemini Pro побеждает Claude в Bedrock во многих бенчмарках. Хуже того, Gemini Flash обеспечивает сравнимое качество при кратно меньших затратах. Некоторые стартапы буквально «сбежали» по этой причине. TainAI перенесла 40 % задач на Gemini Flash, отказавшись от Claude в Bedrock и экономя тем самым $85 тыс./день, а Hotel Planner намеревалась перейти в Google Cloud или к OpenAI. Всё это было ещё до запуска Gemini 3. Ещё более важная проблема, согласно документу, заключается в том, что у AWS нет целостного видения ИИ-инференса, хотя это ключевой сервис Bedrock. Это сыграло на руку не только гиперскейлерам, но и компаниями поменьше. Без чёткой стратегии AWS рискует упустить одну из самых привлекательных возможностей на рынке ИИ. Но этим проблемы не ограничиваются. Октябрьский сбой AWS продемонстрировал зависимость мировой Сети от лидера облачного рынка, так что многие задумались о переносе хотя бы части нагрузок на другие платформы, а Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантов. В последние недели инвесторы обеспокоены расходами на ИИ, опасаясь возникновения очередного пузыря на рынке IT. В этом контексте дефицит мощностей для Amazon играет двоякую роль. Это свидетельствует, что спрос со стороны клиентов до сих пор высок. С другой стороны, дефицит — ещё одна причина тратить больше денег в развитие инфраструктуры, что повышает риск возникновения пузыря. Amazon утверждает, что намерена выделить $125 млрд на капитальные затраты в текущем году, и ещё больше — в 2026-м.

25.11.2025 [14:05], Владимир Мироненко

AWS потратит $50 млрд на расширение облачных мощностей для правительства США: +1,3 ГВт на ИИ и HPCAmazon объявила о планах инвестировать до $50 млрд в расширение инфраструктуры ИИ и HPC для правительства США. Компания начнёт реализацию проектов в 2026 году и планирует добавить почти 1,3 ГВт вычислительной мощности в регионах AWS Top Secret, AWS Secret и AWS GovCloud (US) на всех уровнях секретности путём строительства новых ЦОД. Федеральные агентства получат расширенный доступ к комплексным ИИ-сервисам AWS, включая SageMaker, Bedrock, Nova и Anthropic Claude. Также в их распоряжение будут предоставлены ведущие модели класса open-weight foundation, ИИ-ускорители Trainium и ИИ-инфраструктура NVIDIA, что позволит им разрабатывать индивидуальные решения в области ИИ, оптимизировать большие наборы данных и повышать производительность труда, сообщила Amazon. Ранее AWS, Google, Oracle, Microsoft, xAI и др. IT-гиганты предоставили госслужбам США существенные скидки на облачные услуги в рамках программы OneGov. Это позволит государственным агентствам ускорить обработку информации и принятие решений. Интеграция ИИ с моделированием и имитацией позволит им решать за считанные часы самые сложные задачи, на которые раньше уходили недели или месяцы, а также «автоматически обнаруживать угрозы и разрабатывать планы реагирования», обрабатывая спутниковые снимки, данные датчиков и исторические закономерности в «беспрецедентном масштабе». «Наши инвестиции в специализированную правительственную инфраструктуру ИИ и облачные технологии коренным образом изменят подход федеральных агентств к использованию суперкомпьютинга, — заявил генеральный директор AWS Мэтт Гарман. — Мы предоставляем агентствам расширенный доступ к передовым возможностям ИИ, которые позволят им ускорить выполнение критически важных задач — от кибербезопасности до разработки лекарств. Эти инвестиции устраняют технологические барьеры, сдерживавшие развитие правительства, и укрепляют лидирующие позиции Америки в эпоху ИИ». Компания отметила, что этот шаг подчёркивает позицию AWS как лидера в области государственных облачных вычислений, поддерживающего более 11 тыс. государственных учреждений. AWS уже давно предоставляет правительству США выделенные облачные регионы. В 2011 году она запустила AWS GovCloud (US-West), AWS Top Secret-East — изолированное облако для секретных рабочих нагрузок — в 2014 году, AWS Secret Region — в 2017 году, с 2018 года добавила второй регион GovCloud (US-East), AWS Top Secret-West, а в октябре 2025 года — AWS Secret-West. Компания не раскрывает точное местоположение ЦОД и регионов. Как пишет Data Center Dynamics, другие страны также доверяют AWS свою самую секретную информацию. В Великобритании в 2021 году сообщили, что три британских разведывательных агентства использовали AWS для хранения совершенно секретных данных. В 2024 году AWS получила контракт стоимостью $1,3 млрд правительства Австралии на строительство ЦОД для совершенно секретной информации — спецслужбы получат возможность работы без использования открытого интернета.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

24.11.2025 [08:45], Сергей Карасёв

Cornelis анонсировала 800G-адаптер CN6000 SuperNIC с поддержкой Omni-Path, RoCEv2 и Ultra Ethernet для ИИ и НРСКомпания Cornelis Networks анонсировала сетевой адаптер CN6000 SuperNIC со скоростью передачи данных до 800 Гбит/с, разработанный для систем ИИ и НРС. О намерении использовать решение объявили многие отраслевые игроки, включая Lenovo, Synopsys и Atipa Technologies. В устройстве реализована архитектура Omni-Path. Говорится о полной совместимости со стандартами Ultra Ethernet и RoCEv2. Таким образом, адаптер может применяться в высоконагруженных средах, где требуются максимальная пропускная способность при низких задержках. Адаптер CN6000 SuperNIC обеспечивает быстродействие до 1,6 млрд сообщений в секунду. Утверждается, что новинка поможет организациям ускорить обучение крупных ИИ-моделей при одновременном снижении расходов на электроэнергию и эксплуатацию дата-центров. Cornelis заявляет, что традиционные архитектуры RoCEv2 испытывают трудности при масштабировании в рамках масштабных GPU-кластеров из-за требований к ресурсам памяти при управлении парами связанных очередей (Queue Pair, QP) для отправки и приёма данных. CN6000 SuperNIC позволяет решить проблему благодаря принципиально иной конструкции: задействованы «облегчённые» алгоритмы QP и аппаратно-ускоренные таблицы RoCEv2 In-Flight (RiF), что даёт возможность отслеживать миллионы одновременных операций с минимальными требованиями к ресурсам. Это гарантирует предсказуемую задержку при максимальной пропускной способности в системах любого масштаба. Пробные поставки CN6000 SuperNIC планируется начать к середине 2026 года, после чего будет организовано массовое производство.

22.11.2025 [12:26], Сергей Карасёв

ASUS представила модульную ИИ-систему PE3000N на платформе NVIDIA Jetson Thor T5000Компания ASUS IoT, подразделение ASUS по выпуску умных устройств для интернета вещей, анонсировала компьютер PE3000N — модульную систему для периферийных ИИ-задач. Устройство выполнено в корпусе повышенной прочности в соответствии со стандартом MIL-STD-810H, а диапазон рабочих температур простирается от -20 до +60 °C. В основу новинки положен модуль NVIDIA Jetson Thor T5000. Изделие содержит CPU с 14 ядрами Arm Neoverse-V3AE (до 2,6 ГГц) и 2560-ядерный GPU на архитектуре Blackwell (до 1,57 ГГц). Имеется 128 Гбайт памяти LPDDR5X с пропускной способностью 273 Гбайт/с. ИИ-производительность достигает 2070 Тфлопс (FP4 Sparse). Встроенный VPU-блок способен осуществлять многопоточное декодирование видеоматериалов: 4 × 8Kp30 (H.265), 10 × 4Kp60 (H.265), 22 × 4Kp30 (H.265), 46 × 1080p60 (H.265), 92 × 1080p30 (H.265), 82 × 1080p30 (H.264) и 4 × 4Kp60 (H.264). Кодирование возможно в режимах 6 × 4Kp60 (H.265), 12 × 4Kp30 (H.265), 24 × 1080p60 (H.265), 50 × 1080p30 (H.265), 48 × 1080p30 (H.264) и 6 × 4Kp60 (H.264). Компьютер располагает коннектором M.2 M-key 2242/2260/2280 для SSD, разъёмом M.2 E-key 2230 для адаптера Wi-Fi/Bluetooth, коннектором M.2 B-key 3042/3052 для сотового модема 4G/5G (плюс слот для карты nano-SIM), а также разъёмом PCIe x4/x8. Есть сетевые порты 1GbE RJ45 и 10GbE RJ45, интерфейс HDMI 2.0, четыре порта USB 3.1 Type-A, по одному порту USB 3.1 Type-C и USB 3.1 Type-C OTG (OS Flash), два порт USB 2.0, аудиогнёзда на 3,5 мм. Могут быть также задействованы два последовательных порта RS-232/422/485 и четыре порта 25GbE. Реализован интерфейс MIPI CSI (16 линий; через коннектор AGX CSI) с возможностью подключения до 16 камер GMSL. Дополнительные интерфейсные модули закрепляются в нижней части компьютера. Один из таких блоков содержит шесть портов 1GbE с поддержкой PoE, другой — четыре разъёма 10GbE M12 и два коннектора Fakra для GSML-камер. Габариты системы составляют 165 × 165 × 68 мм (165 × 165 × 97 мм с модулем расширения). Возможна подача питания в диапазоне 12–60 В. В качестве программной платформы применяется Ubuntu. |

|