Материалы по тегу: s

|

03.12.2025 [20:51], Владимир Мироненко

HPE одной из первых начнёт выпускать интегрированные стоечные ИИ-платформы AMD Helios AI

amd

broadcom

epyc

hardware

hpc

hpe

instinct

juniper networks

mi400

ocp

ualink

venice

германия

ии

суперкомпьютер

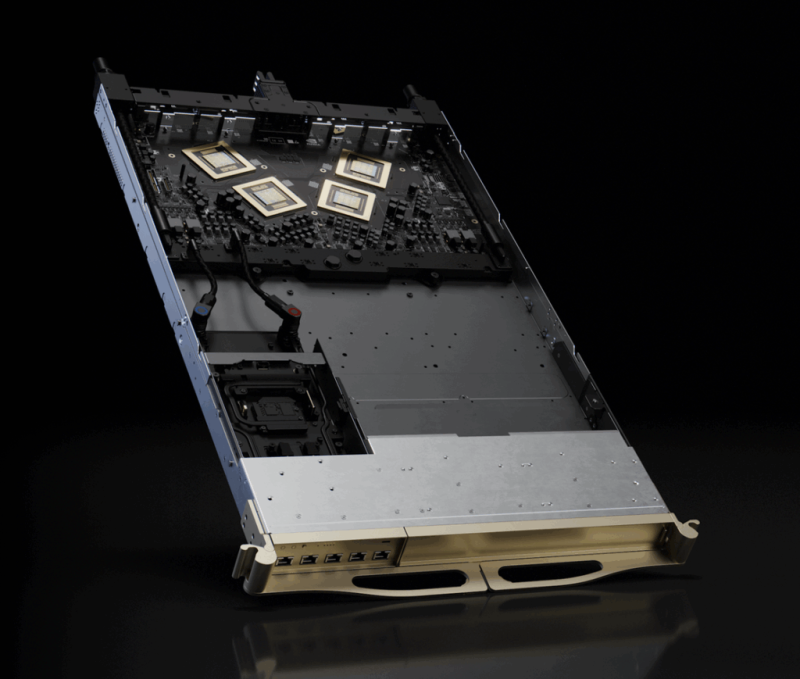

AMD объявила о расширении сотрудничества с HPE, в рамках которого HPE станет одним из первых поставщиков стоечных систем AMD Helios AI, которые получат коммутаторы Juniper Networking (компания с недавних пор принадлежит HPE), разработанные совместно с Broadcom, и ПО для бесперебойного высокоскоростного подключения по Ethernet. AMD Helios AI — открытая полнофункциональная ИИ-платформа на базе архитектуры OCP Open Rack Wide (ORW), разработанная для крупномасштабных рабочих нагрузок и обеспечивающая FP4-производительность до 2,9 Эфлопс на стойку благодаря ускорителям AMD Instinct MI455X, процессорам EPYC Venice шестого поколения и DPU Pensando Vulcano, работающими под управлением открытой программной экосистемы ROCm для нагрузок ИИ и HPC. Как отметил The Register, сетевая архитектура этой системы будет представлять собой масштабируемую реализацию UALink over Ethernet (UALoE) и специализированным коммутатором Juniper Networks на базе сетевого чипа Broadcom Tomahawk 6 (102,4 Тбит/с). Система разработана для упрощения развёртывания крупномасштабных ИИ-кластеров, что позволяет сократить время разработки решений и повысить гибкость инфраструктуры. В отличие от NVIDIA, AMD не выпускает коммутаторы, предлагая открытую экосистему, так что HPE и другие компании могут интегрировать собственные сетевые решения. The Register полагает, что HPE и Broadcom решили не гнаться за отдельной аппаратной реализацией UALink, если данные можно передавать поверх Ethernet. «Это первое в отрасли масштабируемое решение, использующее Ethernet, стандартный Ethernet. Это означает, что оно полностью соответствует открытому стандарту и позволяет избежать привязки к проприетарному поставщику, использует проверенную сетевую технологию HPE Juniper для обеспечения масштабируемости и оптимальной производительности для рабочих нагрузок ИИ», — заявила HPE. HPE заявила, что это позволит её стоечной системе поддерживать трафик, необходимый для обучения модели с триллионами параметров, а также обеспечить высокую пропускную способность инференса. Стоечная система HPE будет включать 72 ускорителя AMD Instinct MI455X с 31 Тбайт HBM4 с агрегиированной пропускной способностью 1,4 Пбайт/с. Агрегированная скорость интерконнекта составит 260 Тбайт/с. Новинка будет доступна в 2026 году. AMD также сообщила, что Herder, новый суперкомпьютер для Центра высокопроизводительных вычислений в Штутгарте (HLRS) (Германия), получит Instinct MI430X и EPYC Venice. Он будет построена на платформе HPE Cray Supercomputing GX5000. Поставка Herder запланирована на II половину 2027 года, а ввод в эксплуатацию — к концу 2027 года. Herder заменит используемый центром суперкомпьютер Hunter.

03.12.2025 [13:25], Сергей Карасёв

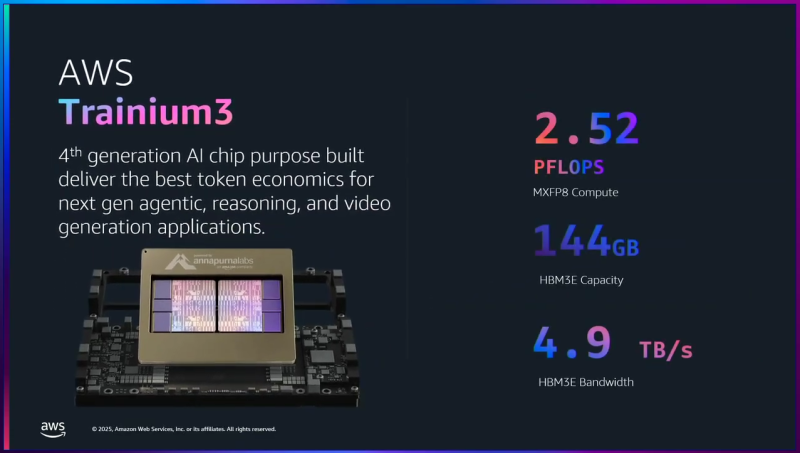

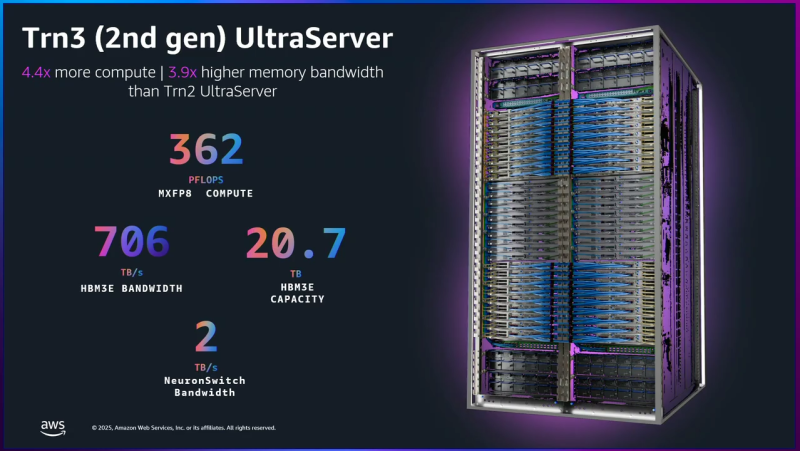

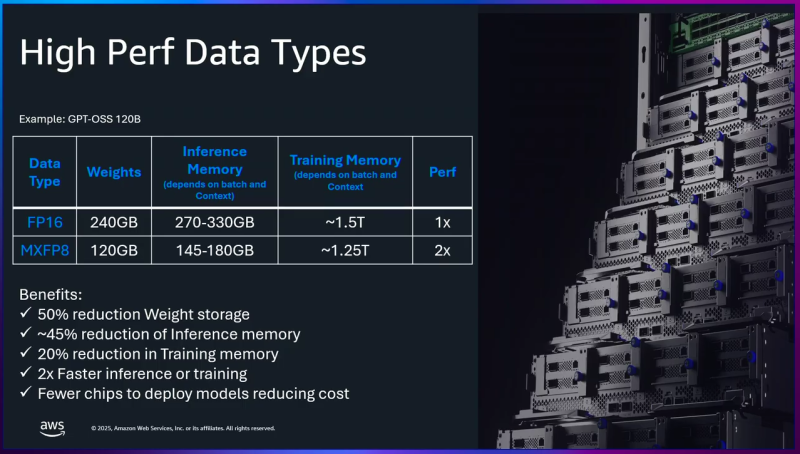

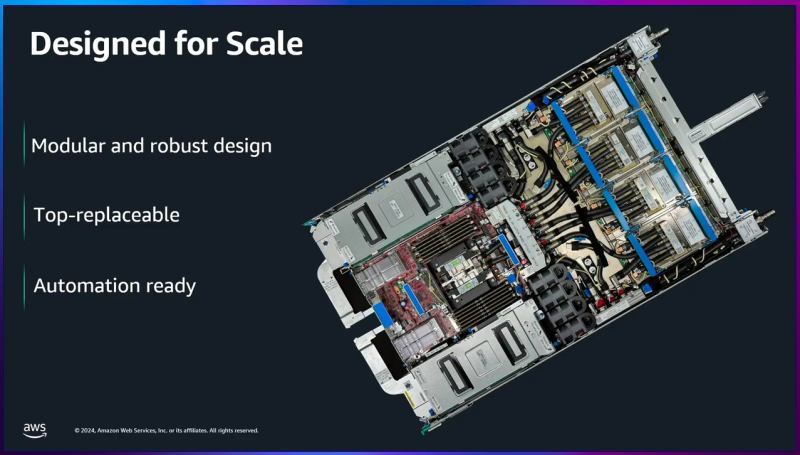

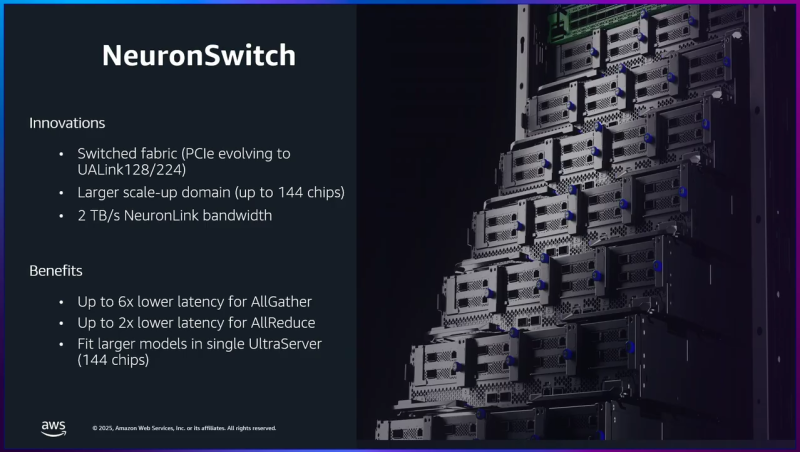

AWS представила ИИ-ускорители Trainium3: 144 Гбайт памяти HBM3E и 2,52 Пфлопс в режиме FP8Облачная платформа Amazon Web Services (AWS) анонсировала ускорители Trainium3 для задач ИИ, а также серверы Trainium3 UltraServer (Trn3 UltraServer). Эти машины, как утверждается, превосходят решения предыдущего поколения — Trainium2 UltraServer — в 4,4 раза по производительности, в 4 раза по энергоэффективности и почти в 4 раза по пропускной способности памяти. Чипы Trainium3 изготавливаются по 3-нм технологии TSMC. Они оснащены 144 Гбайт памяти HBM3E с пропускной способностью до 4,9 Тбайт/с. По сравнению с Trainium2 объём памяти увеличился в 1,5 раза, её пропускная способность — в 1,7 раза. Ранее сообщалось, что энергопотребление новых ускорителей может достигать 1 кВт. Изделие Trainium3 предназначено для высокоплотных и сложных параллельных рабочих нагрузок с использованием расширенных типов данных (MXFP8 и MXFP4). По утверждениям AWS, на операциях FP8 быстродействие достигает 2,52 Пфлопс. Для сравнения, AMD Instinct MI355X показывает результат в 10,1 Пфлопс, а чип поколения NVIDIA Blackwell — 9 Пфлопс. Как уточняет The Register, ускорители Trainium3 используют структурированную разрежённость (structured sparsity) формата 16:4, что фактически поднимает производительность в четыре раза — до 10 Пфлопс — на таких задачах, как обучение ИИ-моделей. Системы Trainium3 UltraServer объединяют 144 ускорителя Trainium3, которые соединены посредством интерконнекта NeuronSwitch-v1: эта технология, по оценкам AWS, увеличивает пропускную способность в два раза по сравнению с машинами UltraServer предыдущего поколения. Усовершенствованная сетевая архитектура Neuron Fabric сокращает задержки при передаче данных между чипами до менее чем 10 мкс. Каждая система Trainium3 UltraServer оперирует 20,7 Тбайт памяти HBM3E с общей пропускной способностью 706 Тбайт/с. Заявленная производительность достигает 362 Пфлопс в режиме FP8. Применённые в Trainium3 технологии, как заявляет AWS, дают возможность создавать приложения ИИ с практически мгновенным откликом. Платформа EC2 UltraClusters 3.0 позволяет объединять тысячи систем UltraServer, содержащих до 1 млн ускорителей Trainium, что в 10 раз больше, чем в случае изделий предыдущего поколения. При этом следующее поколение ускорителей Trainium4 получит интерконнект NVLink Fusion шестого поколения.

03.12.2025 [01:28], Владимир Мироненко

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

02.12.2025 [18:20], Сергей Карасёв

Российская ИИ-система Delta Sprut XL поддерживает до 25 GPU

delta computers

gpu

granite rapids

h200

hardware

intel

nvidia

ocp

rtx

sierra forest

xeon

ии

сделано в россии

сервер

Российская компания Delta Computers представила OCP-систему Delta Sprut XL, предназначенную для ресурсоёмких нагрузок, таких как обучение ИИ-моделей, инференс, научное моделирование и задачи HPC. В основу новинки положена аппаратная платформа Intel Xeon 6. CPU-секция допускает установку двух процессоров Sierra Forest-SP или Granite Rapids-SP с показателем TDP до 330 и 350 Вт соответственно: в первом случае могут быть задействованы в общей сложности до 288 E-ядер, во втором — до 172 P-ядер. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM или DDR5-8000 MRDIMM суммарным объёмом до 8 Тбайт. Могут быть установлены четыре SFF-накопителя U.2 толщиной 15 мм с интерфейсом PCIe 5.0 (NVMe) или восемь таких SSD толщиной 7 мм. Кроме того, есть два коннектора M2.2280 (PCIe). Реализованы четыре слота PCIe 5.0 x16 для карт типоразмера HHHL и слот OCP 3.0 (PCIe 5.0). Присутствуют разъёмы USB 3.0 Type-A и miniDP, а также выделенный сетевой порт управления 1GbE. В системе Delta Sprut XL ускорители на базе GPU устанавливаются в отдельные модули. В общей сложности могут использоваться до 20 карт NVIDIA H200 или до 25 экземпляров NVIDIA RTX Pro 6000 Blackwell Server Edition. Каждый квартет NVIDIA H200 объединён при помощи NVLink. «Delta Computers представляет GPGPU-платформу, способную консолидировать до 20 ускорителей NVIDIA H200 в одном кластере. При этом необходимость использования InfiniBand или 400GbE появляется лишь в случае потребности у заказчика в ещё большем количестве ускорителей — при таком сценарии предусмотрены отдельные слоты расширения для объединения нескольких платформ Delta Sprut XL в единый кластер», — отмечает компания. Питание обеспечивается посредством централизованного шинопровода OCP на 12 или 48 В. Применено встроенное ПО Delta BMC, предназначенное для мониторинга (сбор телеметрии, отслеживание состояния платформы, её модулей и компонентов) и удалённого администрирования серверного оборудования. Эта прошивка включена в реестр Минцифры РФ и сертифицирована ФСТЭК.

02.12.2025 [18:18], Руслан Авдеев

Утечка бюджетного отчёта Великобритании произошла из-за ошибок в настройках плагина для WordPress и хостингаУправление бюджетной ответственности Великобритании (Office for Budget Responsibility, OBR) обвинило в утечке государственного бюджетного отчёта Economic and Fiscal Outlook (EFO) ошибки в конфигурации сайта на движке WordPress, сообщает The Register. В докладе отмечается, что WordPress может быть сложен в настройке, а при работе с ним легко допустить ошибки. Фактически данные были раскрыты из-за непонимания работы плагина Download Monitor для WordPress и неверной настройки сервера, что вкупе позволило получить прямой доступ к файлу путём подбора URL. Плагин формирует простые и предсказуемые ссылки на файлы, что само по себе не является большой проблемой. Однако отсутствие на хостинге WP Engine блокировки прямого доступа к файлам стало второй ошибкой, приведшей к утечке. В результате документ до официальной публикации получили не только госслужащие, но и посторонние. 26 ноября, чуть позже 06:00 некие пользователи начали предпринимать десятки попыток найти отчёт по прямым URL с семи уникальных IP-адресов. Вскоре после загрузки отчёта в 11:30–11:35 по местному времени один из этих IP, наконец, подобрал нужный URL и скачал файл. Менее чем за час файл пытались получить с 32 различных IP-адресов. Удаление файла не помогло, поскольку он уже оказался в Internet Archive. Канцлер Казначейства начал доклад по EFO в 12:34 того же дня, признав, что информация уже утекла в Сеть. Обычно сотрудники OBR сами поддерживают свой сайт, но примерно на три дня в году, в том числе во время публикации отчёта, из-за пиковых нагрузок к ресурсам допускаются сторонние разработчики. Примечательно, что нечто подобное уже случилось в марте 2025 года. Тогда один из IP-адресов получил доступ к документу приблизительно за полчаса до официальной публикации. В результате расследования рекомендовано провести детальный цифровой аудит публикаций EFO за два последних года, а также пересмотреть решение от 2013 года, давшее право OBR вести собственный сайт вне доменной зоны .gov.uk. Британия известна довольно радикально настроениями в вопросе защиты данных. Так, в британском правительстве всерьёз обсуждали план физического уничтожения лондонского ЦОД, где хранились секретные сведения и который по недосмотру был продан китайской компании, до того, как хранившуюся там информацию можно будет защитить иным способом.

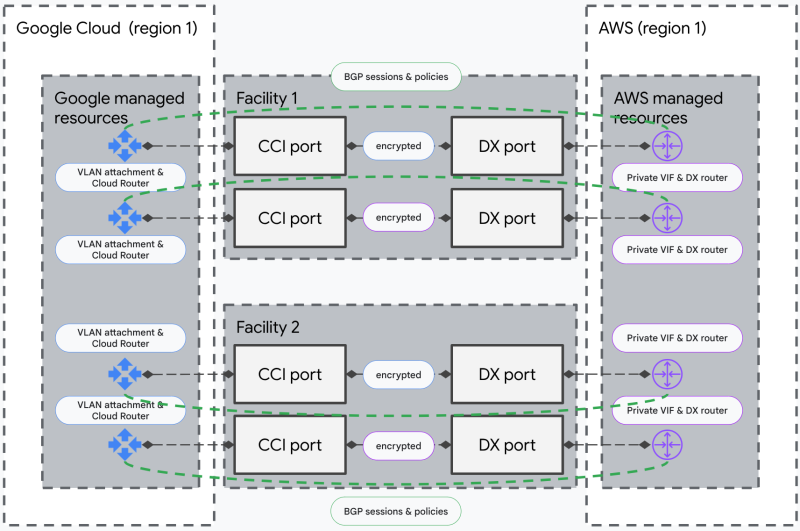

02.12.2025 [09:15], Владимир Мироненко

AWS и Google Cloud подружили свои облачные сети, чтобы интернет падал пореже и не у всех сразуAmazon и Google представили мультиоблачный сетевой сервис, разработанный совместными усилиями и призванный удовлетворить растущий спрос на надёжное подключение, в то время как даже кратковременные перебои в работе интернета могут привести к серьезным сбоям в работе сервисов. Новый сервис объединяет AWS Interconnect – multicloud и Google Cross-Cloud Interconnect, предлагая организациям возможность установления защищённых частных высокоскоростных сетевых соединений между Google Cloud и AWS, что обеспечивает онлайн-бизнесу подстраховку в случае сбоя в работе одного из провайдеров. Кроме того, сервис упрощает одновременное использование облачных услуг обоих провайдеров в рамках одного приложения. Теперь компании смогут за считанные минуты установить соединение между вычислительными платформами через выбранную облачную консоль или API. Как отметила Google Cloud, ранее для подключения провайдеров облачных услуг клиентам приходилось вручную настраивать сложные сетевые компоненты, включая физические соединения и оборудование. Это требовало длительного времени на подготовку и координации с несколькими внутренними и внешними командами, и могло занять недели или даже месяцы. Сервис предлагает подключение выбранной ёмкости между двумя облачными регионами обоих провайдеров с четырёхкратным резервированием на уровне ЦОД, пограничных маршрутизаторов и т.д. Оба поставщика осуществляют непрерывный мониторинг для проактивного выявления и устранения проблем, а также совместно управляют резервированием и занимаются эксплуатационной поддержкой. Шифрование MACsec защищает соединения между периферийными маршрутизаторами AWS и Google Cloud. Партнёры также выпустили унифицированный API и открытую спецификацию, предложив другим поставщикам облачных и сетевых услуг фреймворк для интеграции аналогичных мультиоблачных подключений. Благодаря новому сервису клиенты, использующие в работе несколько облаков, получают стандартизированный подход к гибридному перемещению данных, рабочих ИИ-нагрузок и кросс-облачной аналитике.  Salesforce в числе первых внедрила эту технологию. В компании отметили, что интеграция Salesforce Data 360 с более широким ИТ-ландшафтом требует надёжного частного подключения. AWS Interconnect – multicloud позволяет наводить критически важные мосты с Google Cloud с той же лёгкостью, что и развёртывание внутренних ресурсов AWS. В октябре в AWS произошел крупный сбой, который вывел из строя ряд сервисов, включая Fortnite, Alexa и Snapchat. В последующие недели сбои наблюдались и в Microsoft Azure, и в Cloudflare, что вызвало опасения по поводу рисков, связанных с использованием лишь нескольких крупных поставщиков интернет-инфраструктуры. AWS планирует развернуть аналогичный сервис с Microsoft Azure в следующем году. Ранее AWS, Google Cloud и Microsoft Azure уже сделали шаг навстречу другу другу, отказавшись от платы за выгрузку данных при переезде в другое облако.

01.12.2025 [12:43], Сергей Карасёв

Databricks рассчитывает привлечь $5 млрд при оценке $134 млрдКомпания Databricks, занимающаяся разработкой решений в сфере аналитики данных и ИИ, по информации ресурса SiliconANGLE, ведёт переговоры о привлечении нового финансирования в размере $5 млрд. В случае проведения соответствующего инвестиционного раунда оценка фирмы может достичь $134 млрд, что примерно в 32 раза превысит ожидаемую выручку в объёме $4,1 млрд в 2026 году (по данным Reuters). Databricks была основана в 2013 году. Компания создала единую платформу для обработки данных, аналитики и машинного обучения. Кроме того, Databricks предлагает специализированные инструменты корпоративного класса, обеспечивающие полный цикл разработки ИИ — от проектирования функций и обучения моделей до оценки и развёртывания. У Databricks более 20 тыс. клиентов по всему миру: в их число входят OpenAI Group PBC, Block, Shell, Siemens AG, Toyota Motor, AT&T, Walgreens Boots Alliance и Rivian Automotive. На сегодняшний день Databricks провела 15 раундов финансирования, в ходе которых было получено в общей сложности около $15,7 млрд. В частности, в январе нынешнего года компания закрыла инвестиционную программу Series J, в ходе которой на развитие привлечено $10 млрд (плюс дополнительное долговое финансирование на сумму $5,25 млрд). При этом рыночная стоимость Databricks достигла $62 млрд. В августе этот показатель увеличился до $100 млрд: тогда компания сообщила о выполнении условий привлечения венчурного капитала в рамках раунда Series K. В число инвесторов Databricks входят Andreessen Horowitz, Insight Partners LP, MGX Capital, Thrive Capital Management, WCM Investment Management, The Blackstone Group, Apollo Global Management, Blue Owl Capital, JPMorgan Chase & Co., Barclays, Citigroup, Goldman Sachs Group и Morgan Stanley.

30.11.2025 [17:37], Сергей Карасёв

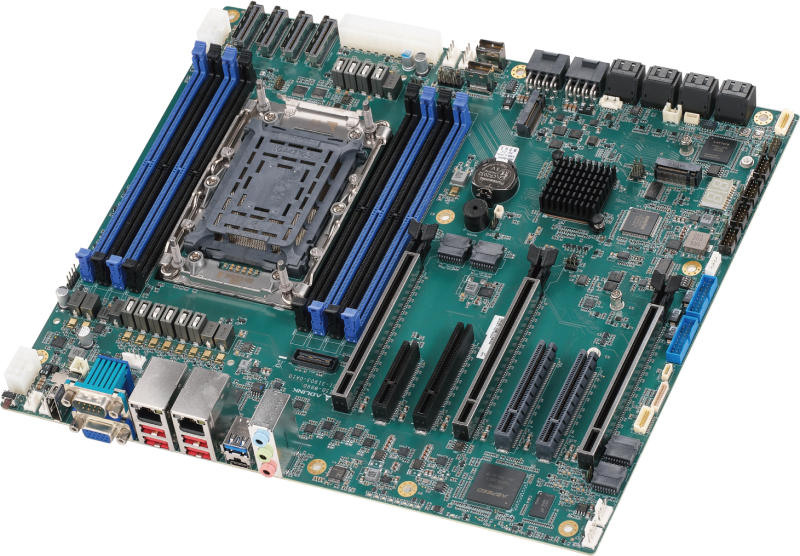

Для невышедших Intel Xeon Granite Rapids-WS уже представлена материнская плата Adlink ISB-W890 формата CEBAdlink подготовила к выпуску материнскую плату ISB-W890, предназначенную для создания рабочих станций и небольших серверов. Новинка, построенная на наборе логики Intel W890, допускает установку процессоров Intel Xeon Granite Rapids-WS (официальный анонс ожидается в I половине 2026 года) в исполнении Socket E2. Плата выполнена в форм-факторе CEB с размерами 305 × 267 мм. Предусмотрены восемь слотов для модулей оперативной памяти DDR5-6400 RDIMM ECC суммарным объёмом до 1 Тбайт. Доступны два коннектора M.2 M-Key 2280/22110/25110 для SSD (NVMe), два интерфейса SlimSAS и восемь портов SATA-3 с возможностью формирования массивов RAID 0/1/5/10. Возможны конфигурации Expert (128 линий PCIe) и Mainstream (80 линий PCIe). В первом случае слоты расширения выполнены по схеме 2 × PCIe 5.0 x16, 1 × PCIe 4.0 x16, 1 × PCIe 5.0 x8, 1 × PCIe 4.0 x8, 1 × PCIe 5.0 x4 и 1 × PCIe 4.0 x4, во втором — 2 × PCIe 5.0 x16, 1 × PCIe 5.0 x8, 1 × PCIe 4.0 x8, 1 × PCIe 5.0 x4 и 1 × PCIe 4.0 x4. В обоих вариантах доступны четыре коннектора MCIO ×8. Материнская плата располагает контроллером Aspeed AST2600, сетевыми адаптерами 1GbE (Intel I210) и 2.5GbE (Intel I226). Интерфейсный блок содержит коннекторы D-Sub и DP, пять портов USB 3.2 Gen2x1 Type-A, порт USB 3.2 Gen2 Type-С, гнёзда RJ45 для сетевых кабелей, последовательный порт (RS-232/422/485) и набор аудиогнёзд на 3,5 мм. Через внутренние разъёмы могут быть задействованы порты USB 3.2 Gen1 и USB 2.0. Гарантирована совместимость с Windows 11 LTSC и Ubuntu 24.04. Диапазон рабочих температур простирается от 0 до +60 °C.

29.11.2025 [15:09], Сергей Карасёв

Asustor представила десктопные NAS Lockerstor Gen2+ с двумя портами 5GbE и чипом Intel Jasper LakeКомпания Asustor анонсировала сетевые хранилища серии Lockerstor Gen2+, ориентированные на профессиональных пользователей, создателей контента и пр. Устройства выполнены в «настольном» форм-факторе на аппаратной платформе Intel Jasper Lake. В семейство вошли модели Lockerstor 2 Gen2+, Lockerstor 4 Gen2+ и Lockerstor 6 Gen2+, рассчитанные соответственно на два, четыре и шесть накопителей LFF/SFF с интерфейсом SATA-3 (HDD и SSD). Допускается горячая замена. Во всех NAS применён процессор Celeron N5105 с четырьмя вычислительными ядрами, функционирующими на тактовой частоте 2,0–2,9 ГГц. Объём оперативной памяти DDR4 составляет 4 Гбайт у двух младших версий и 8 Гбайт у старшей (у всех вариантов возможно расширение до 16 Гбайт в виде двух модулей SO-DIMM). В оснащение входит флеш-модуль eMMC вместимостью 8 Гбайт. Все новинки располагают четырьмя коннекторами M.2 для SSD с интерфейсом PCIe 3.0 (NVMe). Доступны два сетевых порта 5GbE: их пропускная способность благодаря поддержке функции SMB Multi-Channel может быть объединена для достижения показателя в 10 Гбит/с. Заявленная скорость последовательного чтения и записи данных достигает 1146 и 536 Мбайт/с в режиме RAID 5. Хранилища оборудованы двумя портами USB 3.1 Type-A, портом USB 2.0 Type-A, интерфейсом HDMI 2.0b. Версия Lockerstor 2 Gen2+ комплектуется блоком питания мощностью 65 Вт и вентилятором диаметром 70 мм. Модификация Lockerstor 4 Gen2+ получила блок питания на 90 Вт и вентилятор на 120 мм, вариант Lockerstor 6 Gen2+ — 250 Вт и 120 мм соответственно. Диапазон рабочих температур простирается от 0 до +40 °C. Производитель предоставляет на устройства трёхлетнюю гарантию. Рекомендованная стоимость варьируется от $470 до $820 без установленных накопителей.

28.11.2025 [16:22], Руслан Авдеев

Гора с плеч: SEC отказалась от иска к SolarWinds и её шефу по безопасности из-за нашумевшей атаки SUNBURST пятилетней давностиАмериканская Комиссия по ценным бумагам и биржам (SEC) отказалась от иска против допустившей ряд крупных оплошностей IT-компании SolarWinds и её директора по информационной безопасности Тима Брауна (Tim Brown). Ранее утверждалось, что они ввели в заблуждение инвесторов о действовавших на её платформе механизмах обеспечения безопасности, пропустивших атаку SUNBURST в 2020 году, сообщает The Register. В совместном ходатайстве, поданном в минувший четверг, SEC, SolarWinds и Тим Браун попросили суд о завершении гражданского процесса. SEC отметила, что решение о запросе прекратить дело принято «на основании предоставленных ей полномочий», но это не означает, что Комиссия обязательно будет придерживаться аналогичной политики в любых других случаях в будущем. SolarWinds заявила, что «безусловно в восторге» от исхода дела. Компания подчеркнула, что её команда действовала должным образом, и решение SEC является «долгожданным подтверждением» этого. Более того, такой исход дела заставит меньше переживать многих директоров по информационной безопасности других компаний, поскольку продолжение процесса могло бы сказаться и на их работе. Глава SolarWinds заявил, что решение SEC знаменует начало нового этапа для SolarWinds. В ходе SUNBURST хакеры внедрили бэкдор в инструмент сетевого мониторинга SolarWinds Orion после получения доступа к её внутренней инфраструктуре. Около 18 тыс. организаций загрузили содержащее дефект ПО, после чего порядка 100 из них были атакованы командой Cozy Bear, предположительно, российского происхождения. Среди жертв оказались Microsoft, Intel, FireEye, Cisco, а также Министерства финансов, юстиции, обороны и энергетики. Пострадал даже Госдепартамент США. После кибератаки руководство SolarWinds пересмотрело подход к обеспечению безопасности. Утверждается, что инцидент заставил компанию глубже задуматься о новых угрозах и привёл к формированию принципа «Безопасность по умолчанию» (Secure by Design). Новый принцип представляет собой обязательство компании установить новые, более высокие стандарты надёжности и безопасности разработки ПО, задавая планку для всей индустрии. В иске SEC 2023 года SolarWinds и её директор по информационной безопасности обвинялись в том, что ввели в заблуждение инвесторов относительно механизмов обеспечения безопасности в компании в октябре 2018 года, а позже намеренно преуменьшили масштаб и серьёзность кибератаки. Необычным было и то, что SEC обвинила не только компанию, но и лично директора. В июле 2024 года судья отклонил большинство обвинений SEC. В апреле 2025 года акции компании перестали торговаться на бирже, и та перешла в частную собственность Turn/River Capital, а в июле 2025 года сообщалось, что стороны в основном урегулировали спор. |

|