Материалы по тегу: s

|

09.12.2025 [15:45], Андрей Крупин

МТС построила новый модуль на 125 серверных стоек в своём ЦОД в Ленинградской областиМТС ввела в эксплуатацию четвёртый модуль в центре обработки данных в посёлке Фёдоровское Ленинградской области. Новый модуль ЦОД оснащён 125 серверными стойками и позволил довести общую ёмкость вычислительного комплекса до 500 стойко-мест. Модуль, как и весь дата-центр, будет задействован для размещения корпоративных систем МТС, а также облачных мощностей MWS Cloud. Первые два модуля центра обработки данных МТС в посёлке Фёдоровское были введены в эксплуатацию осенью 2020 года. Третий — осенью 2024 года. ЦОД имеет сертификат надёжности Tier III, общая мощность, подведённая к объекту, составляет 16 МВт. Особенностью дата-центра является система адиабатического охлаждения, что позволяет снизить годовой показатель PUE до 1,15.

09.12.2025 [11:17], Сергей Карасёв

«Карманный» NAS Youyeetoo NestDisk для четырёх М.2 SSD оснащён парой портов 2.5GbEКомпания Youyeetoo выпустила компактное сетевое хранилище NestDisk на аппаратной платформе Intel Alder Lake-N. Устройство, заключенное в корпус с размерами 146 × 97,5 × 32 мм, может использоваться для создания частного облака в офисных или домашних условиях. Базовая конфигурация предусматривает использование чипа Intel Processor N150 (4C/4T; до 3,6 ГГц; 6 Вт) с графическим ускорителем Intel UHD Graphics. В наиболее мощном варианте применяется процессор Core 3 N355 (8C/8T; до 3,9 ГГц; 15 Вт). Объём оперативной памяти LPDDR5 может составлять 6, 12 или 16 Гбайт. В оснащение входит флеш-модуль eMMC вместимостью 64 Гбайт. Внутри есть место для четырёх NVMe SSD формата M.2 2280 с интерфейсом PCIe 3.0 x2 (один из слотов также поддерживает установку SATA-накопителя) суммарной вместимостью до 16 Тбайт. Скорость передачи данных достигает 1969 Мбайт/с. Допускается формирование массивов RAID 0/1/5/6. Устройство располагает двумя сетевыми портами 2.5GbE RJ45 на базе контроллера Intel I226V, тремя портами USB 3.1 Type-A и аудиогнездом на 3,5 мм. Возможен вывод изображения одновременно на три дисплея через два интерфейса HDMI 2.0 и разъём USB 3.2 Gen2 Type-C (DisplayPort). Присутствуют адаптеры Wi-Fi 6 и Bluetooth 5.2. Питание подаётся через дополнительный коннектор USB Type-C от сетевого блока мощностью 65 Вт. Для охлаждения задействован вентилятор диаметром 30 мм с низким уровнем шума. NAS использует программную платформу OpenMediaVault на ядре Linux. Но при необходимости можно загрузить TrueNAS, Unraid, Ubuntu и даже Windows. Цена начинается со €170 в варианте с чипом Intel Processor N150 и 12 Гбайт ОЗУ.

08.12.2025 [14:20], Владимир Мироненко

$2 млрд инвестиций NVIDIA в Synopsys несут риски для UALinkОбъявление NVIDIA о расширении сотрудничества с Synopsys, разработчиком ПО для проектирования чипов и членом совета директоров UALink, и инвестициях в размере $2 млрд в совместные инициативы, последовавшее после недавнего решения производителя ИИ-ускорителей инвестировать $5 млрд в Intel, вызвали опасения по поводу его возможного влияния на разработку UALink — альтернативы собственному интерконнекту NVLink. Как отметил Network World, Synopsys входит в совет директоров консорциума Ultra Accelerator Link (UALink) — отраслевой коалиции из более чем 80 компаний, включая AMD, Intel, Google, Microsoft и Meta✴, которая работает над созданием открытой альтернативы технологии NVIDIA NVLink для объединения ИИ-ускорителей в один домен. NVIDIA инвестировала $2 млрд в обыкновенные акции Synopsys ($414,79/ед.), получив долю в разработчике ПО и планируя в рамках партнёрства объединить преимущества своих технологий с ведущими на рынке инженерными решениями Synopsys. В сентябре NVIDIA инвестировала $5 млрд в Intel, объявив о сотрудничестве с целью разработки чипов для ЦОД и ПК с использованием NVLink Fusion. За несколько месяцев до этого Intel взяла на себя обязательство совместно разрабатывать конкурирующий стандарт UAlink. Arm тоже присоединилась к консорциуму UAlink, участвуя при этом и в экосистеме NVLink Fusion.

Источник изображения: NVIDIA Moor Insights & Strategy считает, что с помощью инвестиций NVIDIA укрепляет свою экосистему на фоне вызовов AMD, будь то CPU, GPU или сетевые решения. Вместе с тем аналитики признают, что это «действительно усиливает давление на UALink» — финансовая «доля» NVIDIA в консорциуме UALink может повлиять на разработку открытого стандарта, специально созданного для конкуренции с технологиями самой NVIDIA и предоставления предприятиям более широкого выбора компонентов. Компании считают такие открытые стандарты критически важными для предотвращения привязки к одному поставщику и поддержания конкурентоспособных цен. В апреле консорциум ратифицировал спецификацию UALink 200G 1.0, определяющую открытый стандарт для объединения в один кластер до 1024 ИИ-ускорителей со скоростью 200 Гбит/с на линию. Это прямой конкурент NVLink, хотя и не такой производительный. При этом Synopsys играет ключевую роль в работе консорциума. Она не только вошла в совет директоров UALink, но и анонсировала первые в отрасли компоненты для проектирования UALink, позволяющие создавать ускорители, совместимые с UALink. Gartner признаёт наличие напряжённости: «Сделка между NVIDIA и Synopsys действительно вызывает вопросы о будущем UALink, поскольку Synopsys является ключевым партнёром консорциума и владеет критически важными IP на UALink, который конкурирует с проприетарным NVLink». По оценкам Greyhound Research, Synopsys играет ведущую роль в UALink, поэтому вхождение NVIDIA в структуру акционеров Synopsys может повлиять на заинтересованность последней в работе консорциума. UALink действует благодаря коммерческому согласованию, общим приоритетам НИОКР и близости планов развития участников. Даже потенциальная возможность влияния NVIDIA может подорвать доверие среди членов UALink. «Партнёры по консорциуму должны быть готовы к тому, что будущие версии UALink могут быть сформированы таким образом, что это либо замедлит их развитие, либо будет смещено в сторону компромиссов в дизайне для минимизации конкурентного давления на NVLink», — предупреждает Greyhound Research, призывая консорциум «срочно усилить управление, повысить прозрачность в отношении вклада Synopsys и рассмотреть механизмы защиты, если хочет сохранить доверие». Объявляя о партнёрстве, NVIDIA и Synopsys подчеркнули, что сотрудничество будет сосредоточено на инженерных инструментах на базе ИИ, а не на интерконнектах. В частности, библиотеки NVIDIA CUDA-X будут интегрированы в приложения Synopsys для проектирования микросхем, молекулярного моделирования и электромагнитного анализа. В пресс-релизе по поводу сотрудничества не было никакого упоминания NVLink или интерконнектов. «Поэтому это больше похоже на партнёрство в сфере ПО, чем в сфере интеллектуальной собственности», — пишет Moor Insights & Strategy. Генеральный директор Synopsys Сассин Гази (Sassine Ghazi), подчеркнул, что партнёрство никак не связано с циклическим финансированием. «Мы не намерены и не берём на себя обязательство использовать эти $2 млрд на покупку GPU NVIDIA», — сказал он, добавив, что к партнёрству могут присоединиться другие производители микросхем. Это означает, что компании могут продолжать сотрудничество в рамках более широкой экосистемы, то есть Synopsys продолжит работать с другими поставщиками, конкурирующими с NVIDIA, будь то AMD, Broadcom или один из гиперскейлеров. В ответ на просьбу Network World прокомментировать возможное влияние партнёрства на её приоритеты, Synopsys заявила, что это не меняет её стратегию. В свою очередь, NVIDIA не ответила вопрос ресурса о том, как эти инвестиции могут повлиять на деятельность Synopsys в рамках UALink или на независимость консорциума. Впрочем, аналитики сходятся во мнении, что для консорциума это партнёрство вряд ли можно считать чем-то позитивным. UALink важен для будущих ИИ-платформ AMD. HPE, которая одной из первых поддержала решение AMD Helios AI, будет использовать реализацию UALink over Ethernet (UALoE).

08.12.2025 [13:00], Руслан Авдеев

Акции «маленькой NVIDIA» — китайской Moore Threads выросли более чем впятеро после IPOПосле выхода на IPO акции китайской Moore Threads Technology, называемой «маленькой NVIDIA», выросли с ¥114,28 до ¥650 на фоне общего спада рынка в Шанхае. Цена поднялась более чем впятеро, сообщает гонконгская SCMP — инвесторы тем самым выразили доверие пекинскому стартапу, специализирующемуся на ИИ-чипах. Это второй по масштабу выход на IPO в КНР (его материковой части) в 2025 году. На пике рост составил 468 % от изначальной цены, на момент закрытия торгов в пятницу цена снизилась до ¥600,50 (рост 425 %), биржевой индекс CSI300 Index по итогам дня вырос на 0,8 %. В ходе IPO компания привлекла ¥8 млрд ($1,13 млрд). Вырученные средства потратят на реализацию ИИ-проектов нового поколения, создание ИИ-чипов и др. По масштабу IPO стартап уступил только Huadian New Energy Group, выручившей $2,7 млрд в июле. Moore Threads довольно быстро получила разрешение на IPO от китайских регуляторов, спустя всего четыре месяца после подачи заявки. При этом в среднем время обработок таких заявок составляет около 470 дней, во всяком случае, для заявок Shanghai Stock Exchange Science and Technology Innovation Board (STAR Market). Глава и основатель DeepSeek Лян Вэньфэн (Liang Wenfeng) и хедж-фонда HighFlyer инвестировал в Moore ¥7 млн.

Источник изображения: Moore Threads Как сообщает SCMP, компания имеет большие амбиции и намерена стать «ведущим глобальным игроком» на рынке ИИ-технологий. Дело в том, что её платформа MUSA, в отличие от предложений Huawei, совместима с NVIDIA CUDA, что даёт бизнесу большое преимущество не только на китайском, но и на международном рынке. Глава Moore Threads Чжан Цзяньчжун (Zhang Jianzhong) занимал в NVIDIA ключевые посты в Китае с 2006 по 2020 гг. Ранее он сообщал, что компания будет выпускать по чипу нового поколения ежегодно, чтобы обеспечить Китаю ключевые аппаратные решения для развития ИИ-проектов. По его словам, главная цель компании сегодня — стать «ведущим игроком на рынке GPU с международной конкурентоспособностью». По некоторым оценкам, разработки Moore Threads считаются в КНР лучшим «ответом» NVIDIA. По словам Чжана, для китайских властей жизненно важно поддерживать разработку ИИ-ускорителей в стране: если «домашняя» цепочка поставок сможет поддержать ускорители местной разработки, это поможет улучшить продукты и повысить конкурентоспособность китайской полупроводниковой индустрии. Ранее NVIDIA неоднократно жаловалась, что вводимые США ограничения на поставки ИИ-американских ускорителей в Китай лишь ставят под сомнение доминирование Соединённых Штатов в мире ИИ. Не так давно сообщалось, что власти обсуждают разрешение продаж в КНР ускорителей NVIDIA H200.

06.12.2025 [13:15], Владимир Мироненко

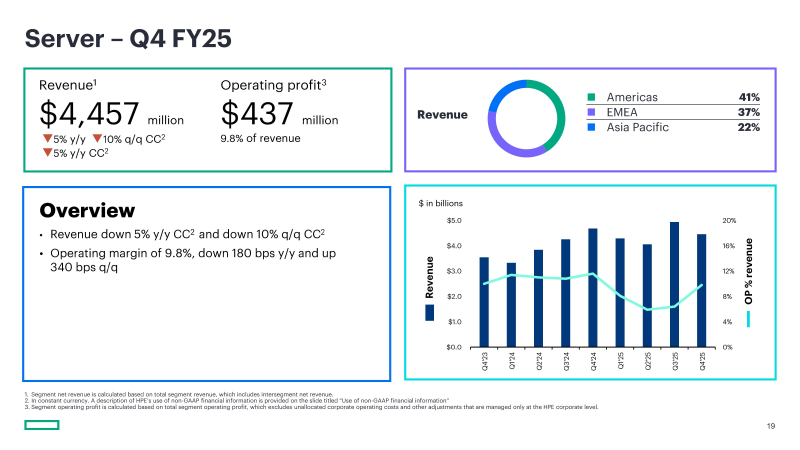

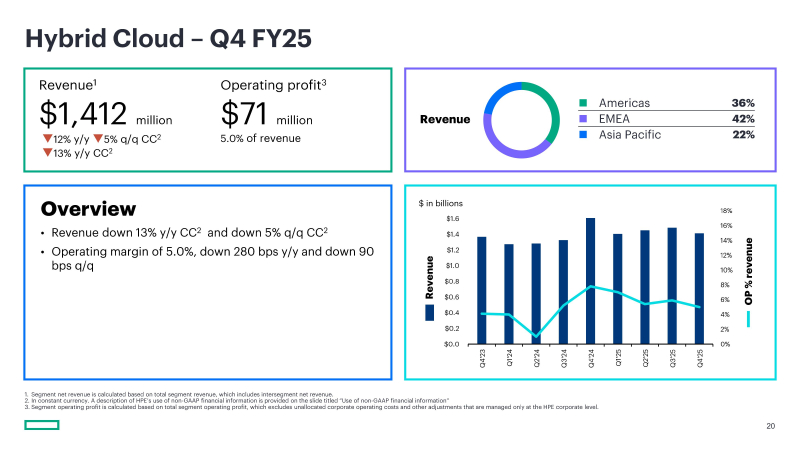

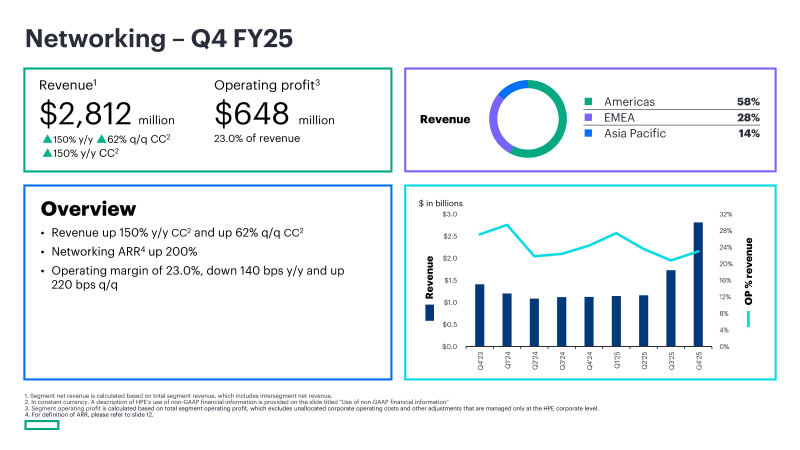

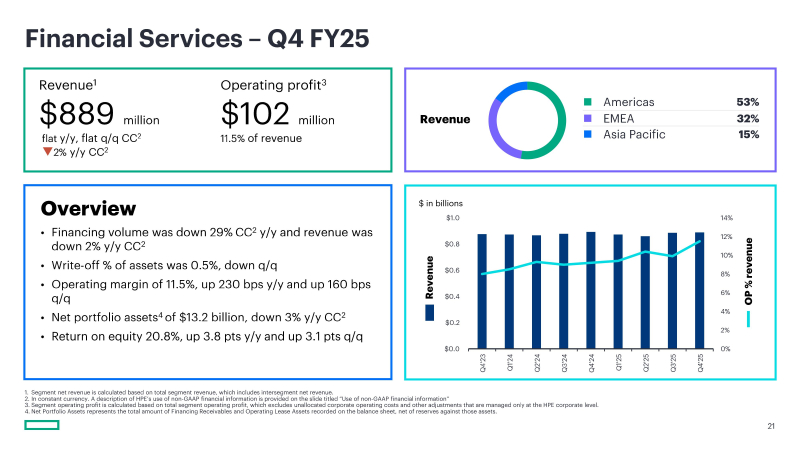

ИИ-серверы HPE стали хуже продаваться, но компания теперь называет себя сетецентрическойКомпания HPE объявила неаудированные финансовые результаты за IV квартал, закончившийся 31 октября 2025 года. Прибыль за квартал превысила ожидания аналитиков, в то время как выручка оказалась ниже их прогноза, хотя и больше год к году благодаря приобретению Juniper Networks. Несмотря на это, гендиректор и президент HPE Антонио Нери (Antonio Neri) заявил в программе Money Movers на канале CNBC в пятницу, что «невероятно доволен» результатами за квартал. Он отметил, что «HPE завершила год преобразований, продемонстрировав уверенный рост прибыли и дисциплинированную реализацию проектов». Нери сообщил, что у компании в минувшем году прибавилось примерно 7 тыс. новых клиентов предложения GreenLake IT-as-a-Service, достигнув на конец года 46 тыс. Он отметил, что HPE стала «сетеориентированной компанией», готовой «предоставлять отличные возможности и возможности для роста как в облачных технологиях, так и в сфере ИИ», сообщил The Register. Компания повысила прогноз роста выручки от сетевого оборудования на весь год до +65–70 % по отчётным данным, что подразумевает выручку примерно в $11 млрд, подсчитал ресурс MSN. Общая выручка за квартал составила $9,68 млрд, что на 14 % больше, чем годом ранее, но ниже консенсус-прогноза аналитиков, опрошенных LSEG, в размере $9,94 млрд. вместе с тем скорректированная прибыль (non-GAAP) на разводнённую акцию составила 62 цента на акцию, что выше ожидаемой аналитиками от LSEG прибыли в 58 центов на акцию. Финансовый директор Мари Майерс (Marie Myers) заявила в ходе телефонной конференции с аналитиками, посвящённой итогам года, что корректировки прибыли были связаны с «амортизацией нематериальных активов, расходами на приобретение, связанными с Juniper, расходами на компенсацию, основанную на акциях, и расходами на план сокращения затрат, частично компенсированными корректировками по налогам и другими корректировками». Она добавила, что слабая выручка в последнем квартале года «соответствует исторической сезонности». HPE сообщила об убытке (GAAP) от операционной деятельности в размере $8 млн за квартал, тогда как годом ранее у неё были прибыль в размере $693 млн за аналогичный квартал. Чистая прибыль компании за IV квартал составила $146 млн или 11 центов на разводнённую акцию, что значительно ниже чистой прибыли в размере $1,34 млрд или 99 центов на акцию годом ранее. Величина ARR (годовой регулярный доход) выросла год к году на 63 % до $3,2 млрд. Выручка от продаж серверов упала на 5 % до $4,46 млрд с $4,68 млрд годом ранее. Показатель оказался ниже ожиданий аналитиков StreetAccount в $4,58 млрд. Операционная маржа снизилась с 11,6 до 9,8 %, а операционная прибыль упала на 1,8 пункта до $437 млн. По словам Майерс, падение объясняется смещением сроков поставок и более низкими, чем ожидалось, расходами федерального бюджета США. «Несмотря на эти трудности, нас обнадёживает устойчивый рост заказов на серверы как традиционных, так и ИИ-решений, при этом спрос значительно опережал выручку в этот период», — сказала финансовый директор. Объём заказов на ИИ-системы в отчётном финансовом квартале достиг $1,9 млрд. Майерс сообщила, что компания ожидает падения доходов от ИИ-серверов в текущем финансовом квартале из-за переноса заказов клиентами на II половину года. «В сфере облачных технологий и ИИ мы продолжаем наблюдать влияние неравномерности продаж и выручки от ИИ-серверов», — заявила Мари Майерс, добавив, что HPE ожидает, что спрос на ИИ-серверы останется неравномерным, поскольку некоторые из её крупных государственных клиентов размещают заказы с увеличенными сроками поставки, что может привести к переносу поставок на будущие периоды, передаёт Reuters. Майерс сообщила, что в настоящее время компания интегрирует свой отдел продаж с отделом продаж Juniper, назвав эту задачу «важнейшей вехой». Выручка HPE в сегменте гибридного облака снизилась на 12 % до $1,41 млрд при операционной марже в размере 5 % по сравнению с 7,8 % за аналогичный период прошлого года. Выручка от продажи сетевого оборудования составила $2,81 млрд, что на 150 % больше, чем за аналогичный период прошлого года. Операционная маржа упала до 23 с 24,4 % за аналогичный период прошлого года. Выручка сегмента финансовых услуг осталась на прежнем уровне — $889 млн. Общая годовая выручка HPE достигла $34,3 млрд, что на 14 % больше, чем годом ранее. Компания прогнозирует выручку за I квартал 2026 финансового года в диапазоне от $9 до $9,4 млрд, что ниже прогнозируемых аналитиками FactSet $9,87 млрд. Скорректированная прибыль (non-GAAP) на разводнённую акцию, как ожидается, составит от $0,57 до $0,61. HPE подтвердила прогноз роста выручки на 2026 финансовый год в диапазоне от 17 % до 22 %, а также повысила прогноз чистой прибыли на разводнённую акцию (non-GAAP) на 2026 финансовый год до $2,25–$2,45 с предыдущего прогноза в диапазоне от $2,20 до $2,40. Антонио Нери предупредил, что рост цен на память повлечёт за собой повышение цен на серверы примерно на 15 %. На прошлой неделе HPE сообщила о продаже свой доли в китайском совместном предприятия H3C. В результате сделки в следующем году компания должна получить $643 млн. Мари Майерс заявила: «Мы создали прочную основу для трансформации нашей структуры затрат благодаря инициативам катализаторов, которые в сочетании с синергетическим эффектом от Juniper позволят достичь годовой структурной экономии примерно в $1 млрд к 2028 финансовому году».

05.12.2025 [13:41], Сергей Карасёв

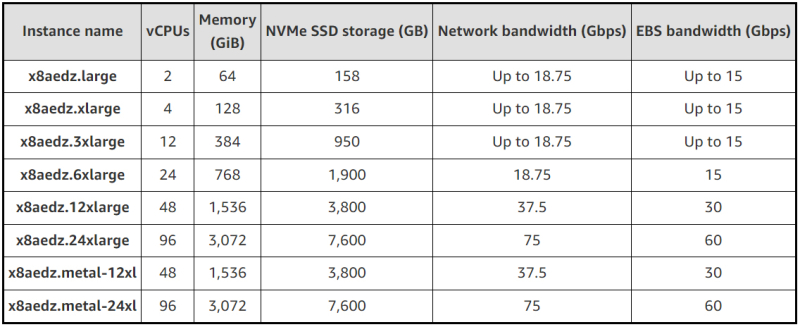

Пять облачных гигагерц: AWS запустила инстансы EC2 X8aedz на базе AMD EPYC Turin для требовательных к памяти нагрузокОблачная платформа AWS анонсировала инстансы EC2 X8aedz, оптимизированные для нагрузок, которым требуется большой объём памяти. Это могут быть задачи, связанные с автоматизацией проектирования электроники (EDA), реляционные базы данных и пр. В основу инстансов положены процессоры AMD EPYC Turin, тактовая частота которых достигает 5 ГГц: утверждается, что это самый высокий показатель в облаке AWS. Новые экземпляры обеспечивают до двух раз более высокую вычислительную производительность по сравнению с инстансами EC2 X2iezn предыдущего поколения. В случае EC2 X8aedz количество vCPU варьируется от 2 до 96, а объём оперативной памяти — от 64 до 3072 ГиБ. Инстансы предлагают локальное NVMe-хранилище ёмкостью от 158 до 7600 Гбайт. Пропускная способность сетевого подключения составляет от 18,75 до 75 Гбит/с, пропускная способность EBS — от 15 до 60 Гбит/с. Задействованы карты AWS Nitro шестого поколения, которые отвечают за виртуализацию, разгрузку сетевых функций и функций хранения. В обозначении X8aedz, как отмечает Amazon, суффикс «a» указывает на аппаратную платформу AMD, «e» — на расширенную память, «d» — на локальные NVMe SSD, физически подключённые к хост-серверу, а «z» — на высокую частоту процессоров. Соотношение памяти к виртуальным CPU у всех новых экземпляров составляет 32:1. Инстансы Amazon EC2 X8aedz уже доступны в регионах US West (Орегон) и Asia Pacific (Токио). В дальнейшем география охвата будет расширяться. Заказчики могут выбирать между различными конфигурациями, включая два варианта Bare Metal.

05.12.2025 [12:15], Сергей Карасёв

HPE представила 102,4-Тбит/с коммутатор Juniper Networking QFX5250 с СЖОКомпания HPE анонсировала производительный коммутатор Juniper Networking QFX5250, ориентированный на ИИ-инфраструктуры следующего поколения. В устройстве применяется технология прямого жидкостного охлаждения Direct-To-Chip (DTC), благодаря чему достигается высокая энергоэффективность. В основу решения положен чип Broadcom Tomahawk 6, который поддерживает коммутационную способность до 102,4 Тбит/с. Возможны следующие конфигурации портов: 64 × 1,6 Тбитс, 128 × 800 Гбит/с, 256 × 400 Гбит/с, 512 × 200 Гбит/с, 512 × 100 Гбит/с и 512 × 50 Гбит/с. Новинка выполнена в форм-факторе 2U с габаритами 92,7 × 537 × 805 мм, а масса составляет 48 кг. Коммутатор может монтироваться в 21″ серверную стойку стандарта ORv3. Применена программная платформа Junos OS, оптимизированная для задач ИИ. Эта ОС, как утверждается, обеспечивает максимальную производительность с улучшенными функциями контроля, управления и предотвращения перегрузок. Кроме того, доступен набор API для автоматизации с помощью Terraform и Ansible. Кроме того, HPE объявила о выходе маршрутизатора Juniper Networking MX301 для ИИ-систем. Это устройство, рассчитанное на использование на периферии, обеспечивает пропускную способность до 1,6 Тбит/с. Решение предлагает 16 портов 1/10/25/50GbE, 10 портов 100GbE и 4 порта 400 GbE. Форм-фактор — 1U с размерами 440 × 450 × 44,5 мм. Применено воздушное охлаждение. Маршрутизатор Juniper Networking MX301 уже доступен для заказа. Коммутатор Juniper Networking QFX5250 поступит в продажу в I квартале наступающего года.

04.12.2025 [22:18], Владимир Мироненко

AWS анонсировала 192-ядерные серверные Arm-процессоры Graviton5AWS анонсировала свой самый мощный на сегодняшний день серверный Arm-процессор — 3-нм 192-ядерный Graviton5. Новые инстансы M9g на базе Graviton5 отличаются более высокой производительностью благодаря впятеро большему общему L3-кешу и в 2,6 раза большему объёму кеша на ядро по сравнению с Graviton4, более высокой скорости памяти и повышенной пропускной способности сетевого подключения. Также компания снизила задержку передачи данных между ядрами на треть. В Graviton5 появилась функция Nitro Isolation Engine с формальной верификацией изоляции исполняемых рабочих нагрузок друг от друга и от самой AWS. Процессоры предлагают полное шифрование памяти, расширенный предсказатель ветвлений, улучшенную подсистему предвыборки выделенные кеши для каждого vCPU и аутентификацию указателей (PAC). Кроме того, Graviton5 получили систему охлаждения на кристалле. Процессор содержит 172 млрд транзисторов. Процессор использует ядра Neoverse V3 (Poseidon) с ISA Armv9.2-A. Хотя сам чип монолитный, он разделён на два NUMA-домена для снижения задержек обращений к памяти. Каждому ядру полагается 2 Мбайт L2-кеша, а общий объём L3-кеша составляет 192 Мбайт — суммарно 576 Мбайт. Процессор имеет 12 каналов DDR5-8800, причём AWS работает с поставщиками памяти для валидации их DIMM. Также отмечено снижение задержки доступа до менее чем 100 нс. Для связи с внешним миром есть восемь контроллеров PCIe 6.0. Как сообщается, клиенты AWS уже провели первые тесты Graviton5, показавшие прирост производительности от 25 до 60 % в зависимости от типа рабочей нагрузки. Помимо инстансов M9g в 2026 году также появятся инстансы C9g для ресурсоёмких вычислений и R9g с оптимизацией по памяти. Новые инстансы имеют в среднем на 15 % более высокую скорость сетевого подключения и на 30 % более высокую скорость доступа к EBS-томам (в том числе с шифрованием). Кроме того, они получили чипы Nitro 6, ответственные за виртуализацию, защиту и разгрузку сетевых функций и функция хранения. Процессоры Graviton теперь обеспечивают более половины всех новых вычислительных мощностей, добавляемых в AWS третий год подряд, причем 98 % из 1000 ведущих клиентов EC2 уже используют эту архитектуру. Постепенно осваивают Arm и прямые конкуренты Amazon — Google активно портирует своё ПО на CPU Axion, у Microsoft недавно представила уже второе поколение процессоров Cobalt.

04.12.2025 [14:36], Владимир Мироненко

Nebius готова к трудным временам, рассчитывая на эффективность выбранной модели работы на ИИ-рынкеПоставщик облачных ИИ-решений Nebius Group N.V., успевший за непродолжительное время после выделения из бывшей материнской структуры «Яндекса» Yandex N.V. заключить крупные контракты с Microsoft и Meta✴, планирует использовать полученные средства для развития своего бизнеса в сфере ИИ как с крупными игроками, так и со стартапами, которые со временем могут стать технологическими гигантами, заявил соучредитель Nebius Роман Чернин (Roman Chernin) в интервью агентству Reuters. Благодаря сделкам с Microsoft и Meta✴ акции Nebius, котирующиеся на Nasdaq, взлетели в этом году на 248 %, что увеличило её рыночную капитализацию до более чем $25 млрд. В настоящее время компания расширяет свою клиентскую базу, особенно учитывая появившиеся опасения, что пузырь ИИ уже набирает обороты, говорит Чернин. Вместе с тем Nebius настроена оптимистично, утверждает он, отметив, что спады — вполне естественное явление во время технологической революции, но рынок услуг по предоставлению компаниям доступа к ИИ-инфраструктуре может вырасти в десять, а то и в сто раз, поскольку компании находятся в самом начале использования ИИ-моделей, которые тоже стремительно развиваются. В то же время компания готовится к трудным временам, развивая высокорентабельные услуги и долгосрочные отношения. «Мы должны быть готовы к “зиме”», — заявил Чернин, добавив, что Nebius выступит в качестве консолидатора. Он отметил, что компании только начинают пользоваться сервисам Nebius. Её клиенты представляют такие секторы, как производство, розничная торговля и банковское дело, при этом сотрудничество с фармацевтическими компаниями и финансовыми учреждениями, такими как хедж-фонды, развивается быстрее. При поддержке NVIDIA, которая является одним из её инвесторов, Nebius предлагает доступ к инфраструктуре на базе её ускорителей, являясь крупнейшим в Европе неооблаком, отметило Reuters. Преимуществом Nebius является то, что вместе с «железом» она предлагает ПО, необходимое для его эффективного использования и запуска специализированных ИИ-приложений, что позволяет ей конкурировать как с традиционными операторами ЦОД, так и с гиперскейлерами. Хотя основным рынком Nebius по выручке и установленной мощности являются США, у неё также есть ЦОД в Европе, в том числе в Великобритании, Исландии, Финляндии и Франции. К концу 2026 года компания планирует увеличить мощность своих объектов до 2,5 ГВт на фоне высокого спроса на свои услуги. По данным компании CBRE, за девять месяцев 2025 года объём мощностей, проданных европейским неооблакам, вырос год к году на 211 % до 414 МВт. Чернин подчеркнул, что заключая сделки с гиперскейлерами, Nebius отдавала приоритет рентабельности, а не выручке. После сделки с Microsoft компания привлекла $4,2 млрд в рамках IPO и от продажи конвертируемых облигаций. Поначалу клиентскую базу Nebius составляли компании, работающие в сфере ИИ, такие как французский разработчик ИИ-моделей Mistral, американский поставщик ПО Cursor и немецкая компания Black Forest, специализирующаяся на визуальном ИИ. По словам Чернина, эти компании имеют все возможности для того, чтобы превратиться в крупных игроков. Он сообщил, что свой рост в 2026 году Nebius планирует обеспечить за счёт существующих цифровых компаний, таких как Shopify, Prosus и ServiceNow, которые всегда полагались на американские облачные сервисы, но видят преимущества в специализированных предложениях Nebius в области ИИ, что подтверждает правильность выбранной компанией модели. Говоря о более далёкой перспективе, Чернин выразил надежду, что после 2027 года Nebius будет предоставлять услуги крупным компаниям, что принесёт больше пользы европейскому суверенитету, чем привлечение инвестиций в крупные ЦОД со стороны американских компаний. «Куда пойдут Siemens и BMW, когда им потребуется широкомасштабное внедрение ИИ?» — задаётся вопросом Чернин, добавив, что цель Nebius — «быть востребованной на этом рынке».

04.12.2025 [09:48], Владимир Мироненко

Частное ИИ-облако под ключ: Amazon представила AWS AI Factory для развёртывания в собственных ЦОД заказчиковAmazon представила AWS AI Factory — выделенную ИИ-инфраструктуру, включающую ускорители NVIDIA, чипы Trainium, а также сетевые решения, хранилища и базы данных AWS, которую можно развернуть в собственных ЦОД клиентов, обеспечивая их потребность в реализации суверенитета и соблюдении нормативных требований. «Клиенты могут использовать пространство своего существующего ЦОД, сетевое подключение и электроэнергию, в то время как AWS берет на себя все сложности развёртывания и управления интегрированной инфраструктурой», — пояснила компания. AWS отметила, что организации в регулируемых отраслях и государственном секторе при развёртывании своих масштабных проектов в сфере ИИ сталкиваются с проблемой их размещения в соответствующей требованиям инфраструктуре. Создание собственной ИИ-инфраструктуры требует значительных капиталовложений в покупку ускорителей, (до-)оснащение ЦОД и электроэнергию, а также сложных циклов закупок, выбора ИИ-модели для конкретного сценария использования и лицензирования моделей у разных поставщиков ИИ-технологий. Это требует много времени и усложняет эксплуатацию, отвлекая клиентов от основных бизнес-целей. AWS AI Factory позволяет решить эту проблему путём развёртывания готовой к использованию выделенной ИИ-инфраструктуры AWS в собственных дата-центрах клиентов. AWS AI Factory функционирует как частный облачный регион AWS, предоставляя безопасный доступ с низкой задержкой к вычислительным ресурсам, хранилищу данных, базам данных и ИИ-сервисам AWS для обучения и инференса ИИ-моделей. Кроме того, предоставляются управляемые сервисы, обеспечивающие доступ к ведущим базовым моделям без необходимости заключения отдельных контрактов с их поставщиками. Всё это помогает организациям соблюдать требования безопасности, суверенитета данных и нормам обработки и хранения данных, экономя усилия по развёртыванию и управлению инфраструктурой. Компания отметила, что AWS AI Factory разработаны в соответствии со строгими стандартами безопасности AWS, обеспечивая выполнение самых важных рабочих нагрузок на всех уровнях секретности: «Несекретно», «Конфиденциально», «Секретно» и «Совершенно секретно». AWS AI Factory — совместный проект AWS и NVIDIA, благодаря чему клиенты получат доступ к ПО NVIDIA и множеству приложений с ускорением на базе GPU. AWS Nitro и EC2 UltraClasters поддерживают платформы Grace Blackwell и Vera Rubin. AWS и NVIDIA также сотрудничают в рамках стратегического партнёрства с HUMAIN из Саудовской Аравии. AWS создаёт в Саудовской Аравии первую в своём роде «Зону искусственного интеллекта» (AI Zone) в кампусе HUMAIN, включающую до 150 тыс. ИИ-чипов, в том числе ускорители NVIDIA GB300 и Amazon Trainium, выделенную ИИ-инфраструктуру и ИИ-сервисы AWS. |

|