Материалы по тегу: ии

|

24.01.2026 [14:15], Сергей Карасёв

Nokia и Hypertec построили в Канаде 15-Пфлопс суперкомпьютер Nibi с погружным охлаждением

amd

emerald rapids

granite rapids

h100

hardware

hpc

intel

mi300

nokia

nvidia

ии

канада

отопление

погружное охлаждение

суперкомпьютер

Компании Nokia и Hypertec объявили о запуске суперкомпьютера Nibi, смонтированного в Университете Ватерлоо (University of Waterloo) в Канаде. Эта НРС-платформа будет использоваться для решения широкого спектра задач, в том числе в области ИИ. Проект Nibi финансируется канадским Министерством инноваций, науки и экономического развития через Канадский альянс цифровых исследований, а также Министерством колледжей, университетов, научных исследований и безопасности через некоммерческую организацию Compute Ontario. Система насчитывает в общей сложности более 750 вычислительных узлов. Это, в частности, 700 узлов CPU, каждый из которых несёт на борту два процессора Intel Xeon 6972P поколения Granite Rapids-AP (96C/192T, до 3,9 ГГц) и 748 Гбайт оперативной памяти. Кроме того, задействованы 10 узлов с двумя чипами Xeon 6972P и 6 Тбайт памяти каждый. В состав суперкомпьютера также входят 36 узлов GPU, которые содержат по два процессора Intel Xeon Platinum 8570 серии Emerald Rapids (56C/112T, до 4 ГГц), 2 Тбайт оперативной памяти и восемь ускорителей NVIDIA H100 SXM (80 GB), связанных посредством NVLink. Наконец, Nibi оперирует шестью узлами с четырьмя ускорителями AMD Instinct MI300A. Подсистема хранения VAST Data выполнена на основе SSD суммарной вместимостью 25 Пбайт. Пропускная способность каналов передачи данных между CPU- и GPU-узлами составляет 200 Гбит/с. Подключение к хранилищу обеспечивается благодаря 24 линиям на 100 Гбит/с. Заявленная пиковая производительность Nibi достигает 15 Пфлопс. Новая НРС-платформа оборудована высокоэффективной системой погружного жидкостного охлаждения. Сгенерированное тепло используется для обогрева центра квантовых и нанотехнологий имени Майка и Офелии Лазаридис (Mike and Ophelia Lazaridis Quantum-Nano Centre).

24.01.2026 [14:03], Сергей Карасёв

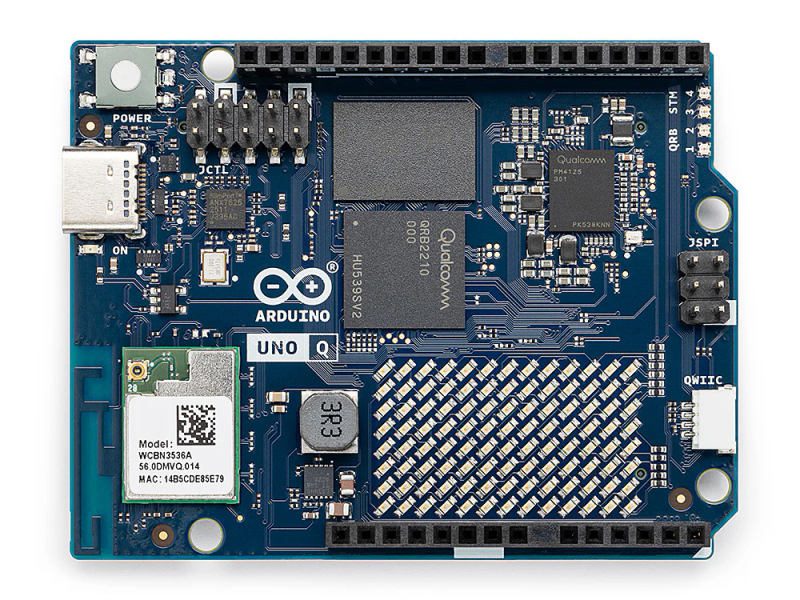

Одноплатный компьютер Arduino UNO Q вышел в версии с 4 Гбайт ОЗУ за $59Участники проекта Arduino, приобретённого компанией Qualcomm в октябре 2025 года, сообщили о доступности одноплатного компьютера UNO Q в модификации с 4 Гбайт оперативной памяти. Это вдвое больше по сравнению с ранее предлагавшейся версией изделия. Устройство Arduino UNO Q, напомним, дебютировало осенью прошлого года. Оно оснащено процессором Qualcomm Dragonwing QRB2210 с четырьмя ядрами Arm Cortex-A53 (2 ГГц), а также микроконтроллером реального времени STMicro STM32U585 с ядром Arm Cortex-M33 (160 МГц). Присутствует графический ускоритель Adreno 702 GPU (845 МГц) с поддержкой OpenGL ES 3.1, Vulkan 1.1, OpenCL 2.0. Есть адаптеры Wi-Fi 5 и Bluetooth 5.1, порт USB Type-C, интерфейсы I2C, I3C, SPI, CAN, UART, PSSI и GPIO. С момента анонса покупателям предлагалась версия Arduino UNO Q с 2 Гбайт ОЗУ и флеш-модулем eMMC вместимостью 16 Гбайт. Новый вариант одноплатного компьютера, помимо 4 Гбайт RAM, получил накопитель на 32 Гбайт. Это позволяет реализовывать проекты, более требовательные к аппаратным ресурсам. В частности, как отмечает Arduino, могут применяться более сложные модели ИИ и алгоритмы машинного обучения для реализации функций компьютерного зрения и обработки аудиоинформации. Изделие имеет размеры 68,58 × 53,34 мм. Питание (5 В) подаётся через коннектор USB Type-C. Модель Arduino UNO Q с 4 Гбайт памяти доступна для заказа по цене $59 против $44 у младшей модификации. Приобрести устройство можно через магазины RS Components, Farnell, DigiKey, Mouser и Robu.in, а также у других авторизованных дистрибьюторов и реселлеров.

23.01.2026 [23:54], Владимир Мироненко

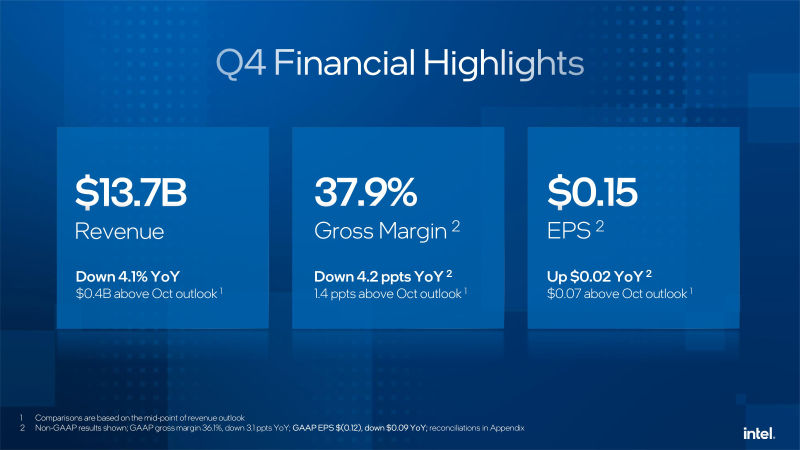

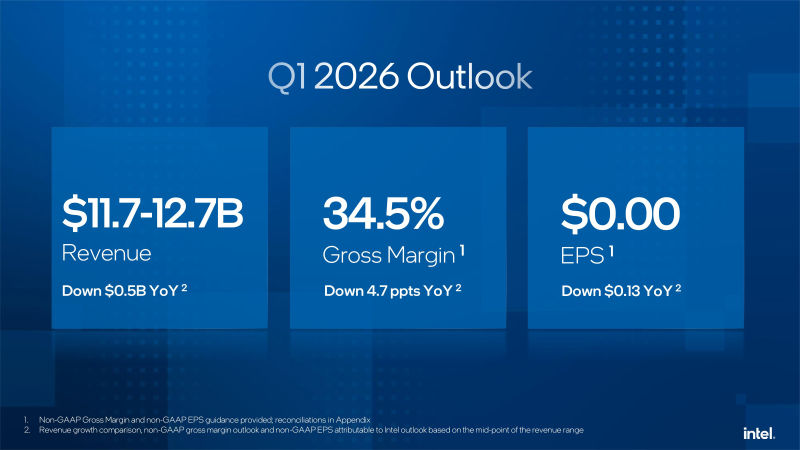

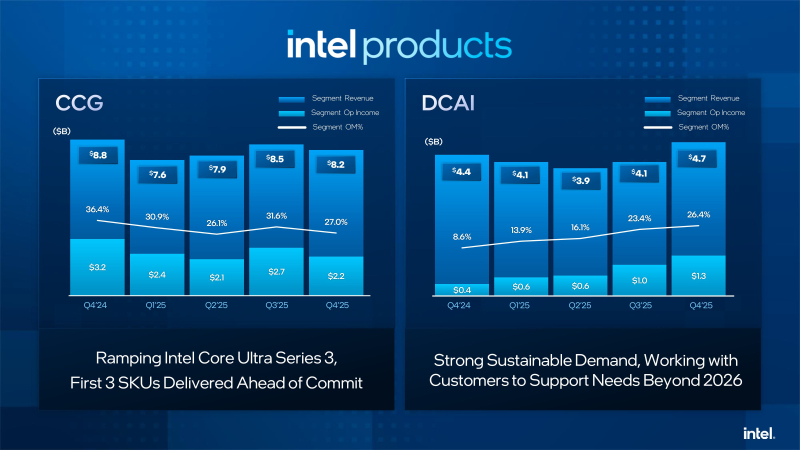

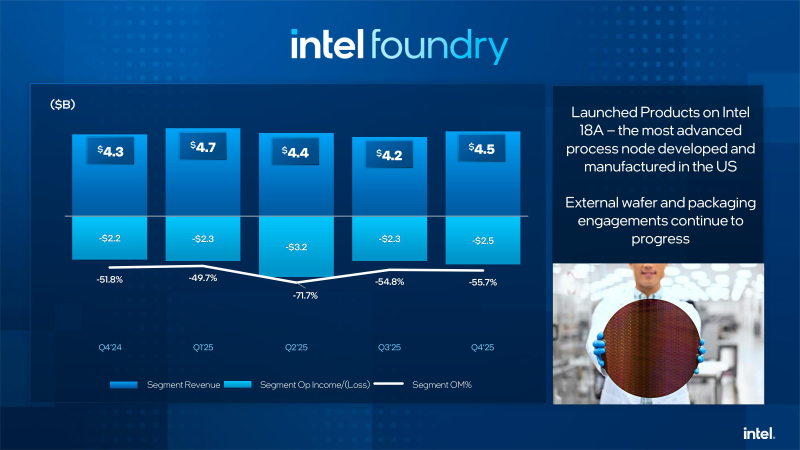

Слабый прогноз из-за дефицита компонентов уронил акции Intel, которая решила сосредоточиться на серверных продуктахКомпания Intel объявила результаты за IV квартал и 2025 финансовый год, завершившийся 27 декабря 2025 года. Хотя результаты за квартал превзошли ожидания Уолл-стрит, из-за слабого прогноза на текущий квартал, а также предупреждения о дефиците поставок, акции компании упали в пятницу на 15 %, сообщил ресурс CNBC. Впрочем, несмотря на падение акций после квартального отчёта, компания по-прежнему демонстрирует уверенный старт в 2026 году и с начала года её ценные бумаги выросли в цене на 47 %. Выручка Intel за IV квартал составила $13,7 млрд, что на 4 % меньше год к году, но выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $13,4 млрд. Скорректированная прибыль на акцию (non-GAAP) равняется 15¢ при прогнозе аналитиков от LSEG в 8¢. Компания сообщила о чистом убытке (GAAP) за отчётный квартал в размере $591 млн, или 12¢ на разводнённую акцию. Годом ранее у неё тоже был чистый убыток, но меньше — $126 млн, или 3¢ на акцию. Intel объявила, что в текущем квартале рассчитывает на безубыточность по скорректированной прибыли на акцию и выручку в диапазоне от $11,7 до $12,7 млрд. Оба показателя оказались ниже прогноза аналитиков, опрошенных LSEG, ожидающих прибыль в размере 5¢ на акцию при выручке в $12,51 млрд. Как сообщает ресурс SiliconANGLE, финансовый директор Intel Дэвид Зинснер (David Zinsner) объяснил снижение прогноза проблемами с поставками компонентов, которых не хватает для удовлетворения сезонного спроса. По его словам, компания пытается решить эту проблему, повышая эффективность производства или выход годной продукции, чтобы увеличить поставки. «Наша производительность соответствует нашим внутренним планам», — сказал генеральный директор Intel Лип-Бу Тан (Lip-Bu Tan), отметив, что она по-прежнему ниже того уровня, которого ему хотелось бы достичь. Выручка подразделения Datacenter and AI Group (DCAI), которое специализируется на продуктах для ЦОД и ИИ, выросла год к году на 9 % до $4,74 млрд. Операционная прибыль подразделения составила $1,25 млрд. Выручка потребительской группы Client Computing Group (CCG) упала на 7 % до $8,19 млрд. Подразделение Intel Foundry, которое занимается производством чипов, получило выручку в размере $4,51 млрд, что выше год к году на 4 %. При этом его операционный убыток составил $2,51 млрд. Годом ранее подразделение тоже сработало с убытком, составившим $2,25 млрд при выручке $4,34 млрд. Как отметил The Register, по сравнению с катастрофой, которой стал для Intel 2024 финансовый год, прошедший год был значительно лучше. В 2025 году компания понесла убытки всего в $267 млн при выручке в $52,9 млрд. Это значительно лучше рекордных убытков в $18,8 млрд годом ранее. В ходе общения с аналитиками Зинснер признал, что компания оказалась в затруднительном положении после того, как неправильно оценила спрос на свою продукцию для ЦОД, что привело к дефициту мощностей в течение квартала. Дело в том, что полгода назад почти все гипескейлеры говорили о планах заказать меньшее количество чипов с большим количеством ядер, но затем их позиция изменились, и спрос на продукты Intel Xeon значительно вырос в III и IV кварталах. Платформа Intel Xeon 6 широко используется в ИИ-системах, таких как NVIDIA DGX B200 и B300, а также во многих системах с AMD Instinct. Чтобы удовлетворить этот спрос, компания «перенаправляет как можно больше ресурсов в ЦОД», отметил Зинснер. При этом он заверил, что компания не откажется от своего клиентского бизнеса «полностью» в погоне за доходами от ИИ в ЦОД. «В клиентском сегменте мы фокусируемся на среднем и высоком сегментах, а на низком — не так сильно. В той мере, в какой у нас есть избыточные мощности, мы направляем их производство для ЦОД», — сказал финансовый директор. Ранее в этом месяце Тан заявил, что технология производства 18A, конкурирующая с 2-нм техпроцессом TSMC, «превзошла ожидания» в 2025 году. Он указал в годовом отчёте, что Intel «активно работает» над увеличением поставок продукции, изготовленной по техпроцессу 18A, для удовлетворения «высокого спроса со стороны клиентов». Зинснер сообщил ресурсу CNBC, что клиенты для следующего техпроцесса 14A от Intel появятся во II половине года. При этом компания не собирается публично об этом объявлять. «Как только мы их получим, нам нужно будет вкладывать значительные средства в развитие 14A, и тогда вы поймёте, что происходит», — сказал он. Вместе с тем аналитики RBC Capital Markets предупредили, что «значительный вклад в выручку» от клиентов продуктов согласно техпроцессу 14A может появиться не раньше конца 2028 года.

23.01.2026 [22:51], Руслан Авдеев

Продано: Oracle и Майкл Делл стали инвесторами американского предприятия TikTok USDS

bytedance

dell

g42

oracle

oracle cloud infrastructure

silver lake

software

tiktok

инвестиции

китай

реструктуризация

сделка

сша

Социальная сеть TikTok китайского происхождения объявила о создании совместного предприятия, которое станет управлять её деятельностью в США. Только на этих условиях компания сохранит возможность работы в Америке. Новая компания TikTok USDS Joint Venture LLC объявила о трёх управляющих инвесторах: Oracle, частной инвестиционной компании Silver Lake и инвесторе MGX из ОАЭ, каждый из них получит по 15 % в совместном предприятии. ByteDance, управляющей TikTok в других странах, принадлежит доля в 19,9 %. Инвестором выступает и компания Майкла Делла (Michael Dell) — Dell Family Office. Об участии Делла в сделке сообщалось ещё в сентябре 2025 года. Oracle будет играть ключевую роль в работе TikTok в США — данные американских пользователей будут размещаться в её облаке, также она выступит «доверенным партнёром» нового консорциума в сфере обеспечения безопасности. В частности, её эксперты займутся проверкой исходного кода. Также планируется переобучить и обновить рекомендательные алгоритмы на основе данных американских пользователей. Технически данные американских пользователей в рамках Project Texas уже перенесли в облако Oracle в 2022 году. В рамках аналогичного Project Clover данные пользователей из Европы переехали в ЦОД в Ирландии и Норвегии. Пока неизвестно, сколько было заплачено ByteDance за новый формат партнёрства, но есть данные, что ByteDance будет по-прежнему управлять электронной коммерцией, рекламой и маркетингом американской платформы, а также глобальной совместимостью продуктов. Последнее важно, поскольку планируется обеспечить «заметность» американских создателей контента и работу американских бизнесов в мировом масштабе.

Источник изображения: SEO Galaxy/unsplash.com Одним из руководителей совместного предприятия назван гражданин Сингапура, генеральный директор TikTok Шоу Чу (Shou Chew). При этом совет директоров состоит «в основном из американцев». В частности, генеральным директором назначен Адам Прессер (Adam Presser), а директором по безопасности — Уилл Фаррелл (Will Farrell). Сделка готовилась очень долго. В своё время Конгресс США принял закон, обязывающий ByteDance найти покупателя американского сегмента компании, иначе социальной сети пришлось бы прекратить деятельность в Соединённых Штатах — предлогом выступила угроза национальной безопасности США от приложений иностранных противников. По имеющимся данным, новое совместное предприятие будет заниматься и делами прочих приложений ByteDance, включая CapCut и Lemon8.

23.01.2026 [16:42], Владимир Мироненко

OpenAI готовит крупнейший в своей истории раунд финансирования на $50 млрд при участии инвесторов Ближнего ВостокаСогласно появившимся в прессе сообщениям, генеральный директор OpenAI Сэм Альтман (Sam Altman) проводит в ОАЭ переговоры о привлечении инвестиций для грядущего раунда финансирования объёмом до $50 млрд, передают источники Bloomberg. Условия ещё не утверждены, но ожидается, что раунд будет завершён в I квартале 2026 года. Всего три месяца назад OpenAI завершила продажу акций на сумму $6,6 млрд с оценкой рыночной стоимости в $500 млрд. До этого, в марте 2025 года компания провела раунд финансирования на $40 млрд, возглавляемый SoftBank при участии Microsoft и других крупных игроков, таких как Coatue, Altimeter и Thrive. Любопытно, что Anthropic тоже намерена привлечь инвестиции с Ближнего Востока, но не очень этому рада. Как пишет ресурс eWeek, суверенные фонды Ближнего Востока стали доминирующей силой в глобальных инвестициях в ИИ, вложив только в 2025 году $66 млрд в ИИ и цифровую инфраструктуру, что является самой большой долей инвестиций в ИИ в мире. Суверенный фонд благосостояния Саудовской Аравии (PIF) в прошлом году выделил $36,2 млрд на инициативы в области ИИ, в то время как Mubadala из ОАЭ инвестировала $12,9 млрд в ИИ и цифровые активы. Вместе семь крупнейших фондов Персидского залива представляли 43 % всего суверенного капитала, инвестированного в мире в 2025 году, вложив рекордную сумму $126 млрд.

Источник изображения: Growtika/unsplash.com Как сообщила ранее Deloitte, суверенные фонды Персидского залива рассматривают ИИ как «стратегический актив», а не как спекулятивную игру. Согласно прогнозам, опубликованным в начале этого месяца, к 2030 году доля ИИ в ВВП ОАЭ составит 14 %, а в ВВП Саудовской Аравии — 12,4 %. Новый раунд нацелен на выполнение масштабных инфраструктурных проектов, уже находящихся в стадии реализации. OpenAI заключила партнёрское соглашение с G42, поддерживаемой инвестиционной компанией Mubadala, для разработки кластера ЦОД мощностью 5 ГВт в Абу-Даби — части более масштабного проекта Stargate. Как отметил eWeek, фонды из Абу-Даби за последний год инвестировали $31 млрд во французские ЦОД и $40 млрд в американские объекты, а консорциум во главе с MGX из Абу-Даби в октябре 2025 года заключил сделку на $40 млрд по приобретению Aligned Data Centers. Согласно анализу EY, за первые девять месяцев 2025 года суверенные фонды благосостояния участвовали в венчурных сделках в сфере ИИ на общую сумму $46 млрд, что составляет почти половину всех венчурных инвестиций в ИИ за год. Геополитические последствия этого подхода не менее значительны. В США приветствуют инвестиции стран Персидского залива в ЦОД и полупроводники как способ противодействия влиянию Китая на цепочки поставок в сфере ИИ. К 2035 году на регион Персидского залива может приходиться 5-10 % новых глобальных развёртываний ИИ-ускорителей, что позиционирует страны Ближнего Востока как критически важных партнёров по инфраструктуре для американских ИИ-компаний.

23.01.2026 [12:23], Сергей Карасёв

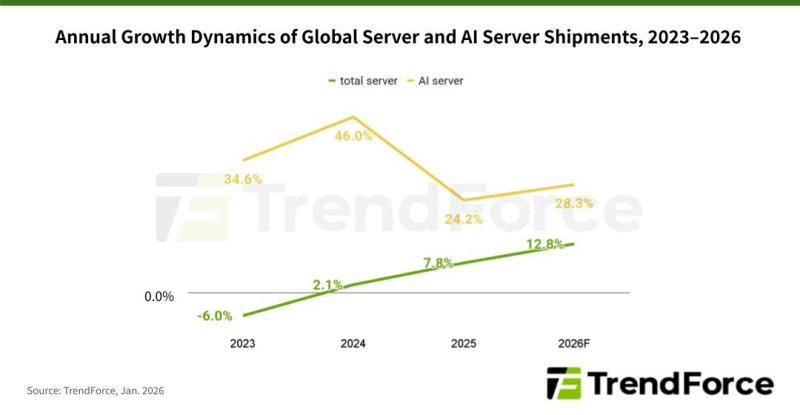

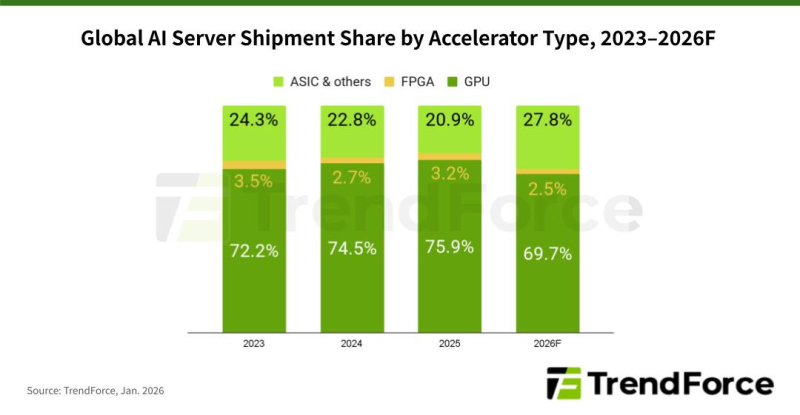

TrendForce: мировые поставки ИИ-серверов в 2026 году поднимутся на 28 %По данным компании TrendForce, глобальные поставки серверов в 2025 году поднялись на 7,8 % по сравнению с предыдущим годом, тогда как в сегменте ИИ-систем зафиксирован рост на 24,2 % (абсолютные цифры не приводятся). Аналитики полагают, что в 2026-м общий объём рынка увеличится на 12,8 %, а отгрузки серверов для ИИ-задач подскочат на 28,3 %. В 2025 году, согласно оценкам TrendForce, в сегменте ИИ-серверов доминировали системы, оснащённые ускорителями на базе GPU: их доля составила 75,9 %. Ещё 20,9 % пришлось на машины с ASIC и ускорителями других типов, 3,2 % — на устройства с FPGA. В 2026 году, как полагают эксперты, расстановка сил изменится. Связано это с тем, что в 2024–2025 гг. нагрузки ИИ были сфокусированы преимущественно на обучении больших языковых моделей (LLM) с огромным количеством параметров. Однако к концу 2025 года наметился сдвиг в сторону инференса и использования ИИ-агентов. Прогнозируется, что по итогам 2026-го доля ИИ-серверов на основе GPU сократится до 69,7 %. Вместе с тем до 27,8 % поднимется доля систем, в состав которых входят ASIC. На машины с FPGA при этом придётся 2,5 %. Прогнозируется также, что темпы роста поставок ИИ-серверов на базе ASIC будут выше, чем темпы роста отгрузок GPU-систем. Отмечается, что такие компании, как Google и Meta✴, ускоряют разработку собственных ASIC. TrendForce полагает, что совокупные капитальные затраты пяти крупнейших североамериканских провайдеров облачных услуг — Google, AWS, Meta✴, Microsoft и Oracle — увеличатся в 2026 году на 40 % по отношению к предыдущему году. Помимо масштабного развития инфраструктуры дата-центров, часть средств пойдёт на обновление серверов общего назначения, приобретённых во время бума облачного рынка в 2019–2021 гг.

23.01.2026 [12:18], Сергей Карасёв

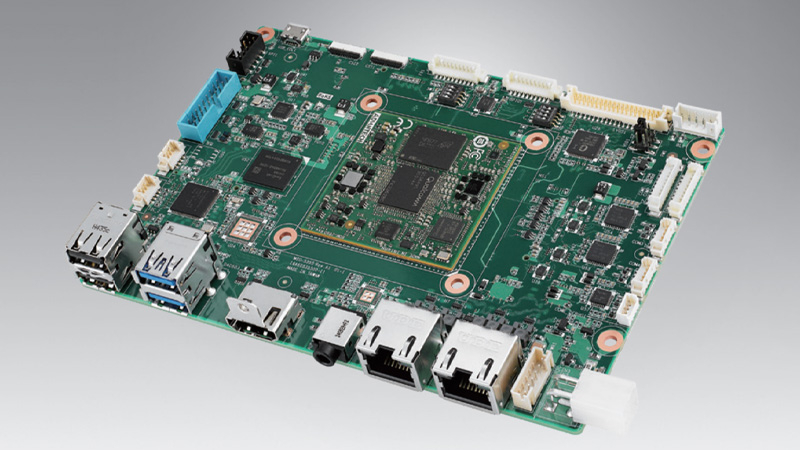

Чип Qualcomm и модуль 5G: одноплатный компьютер Advantech MIO-5355 ориентирован на ИИ-задачи на периферииКомпания Advantech анонсировала индустриальный одноплатный компьютер MIO-5355, выполненный в 3,5″ форм-факторе на аппаратной платформе Qualcomm. Устройство предназначено для решения различных ИИ-задач на периферии, в том числе в суровых условиях эксплуатации — при температурах от -20 до +70 °C. Новинка доступна в двух модификациях. Старшая версия несет на борту процессор Qualcomm DragonWing QCS6490 с восемью ядрами Kryo 670 в конфигурации 1 × Gold Plus (Cortex-A78) с частотой 2,7 ГГц, 3 × Gold (Cortex-A78) с частотой 2,4 ГГц и 4 × Silver (Cortex-A55) с частотой до 1,9 ГГц. В состав чипа входит графический ускоритель Adreno 643 (812 МГц) с поддержкой Open GL ES 3.2, Open CL 2.0, Vulkan 1.x, DX FL 12. Встроенный VPU-блок Adreno 633 обеспечивает возможность декодирования материалов 4K60 H.264/H.265/VP9 и кодирования 4K30 H.264/H.265. Кроме того, имеется ИИ-движок Qualcomm AI Engine шестого поколения с производительностью до 12,3 TOPS.

Источник изображения: Advantech Менее мощная версия получила процессор Qualcomm DragonWing QCS5430 с шестью ядрами Kryo 670 в виде связки 2 × Gold Plus (Cortex-A78) с частотой до 2,1 ГГц и 4 × Silver (Cortex-A55) с частотой до 1,8 ГГц. Графический ускоритель Adreno 642L (812 МГц) обладает поддержкой OpenGL ES 3.2, DirectX FL 12, OpenCL 2.0 и Vulkan. Модуль VPU Adreno 642L способен декодировать материалы 4K60 H.264/H.265/VP9 и кодировать 4K30 H.264/H.265. Быстродействие на операциях ИИ составляет до 3,5 TOPS. Объём оперативной памяти LPDDR5 в обоих вариантах равен 8 Гбайт. Возможна установка флеш-модуля UFS или eMMC вместимостью до 128 Гбайт, NVMe SSD формата M.2 2280 и карты microSD. Есть двухпортовый сетевой контроллер 1GbE на основе Realtek RTL8211FS. Опционально могут быть добавлены комбинированный адаптер Wi-Fi/Bluetooth (модуль M.2 E-Key) и модем 5G/4G (M.2 B-Key плюс слот Nano-SIM). Допускается вывод изображения одновременно на два монитора через интерфейсы HDMI 2.0 (до 4К; 60 Гц) и LVDS (1920 × 1080 пикселей) или eDP 1.4. Предусмотрены по два порта USB 3.0 Type-A и USB 2.0 Type-A, два гнезда RJ45 для сетевых кабелей, аудиогнездо на 3,5 мм (кодек Realtek ALC5682I), два интерфейса камер MIPI-CSI (по 4 линии). Через разъёмы на плате можно задействовать по два последовательных порта RS-232/422/485 и RS-232, а также по два порта USB 3.0 и USB 2.0. Габариты составляют 146 × 102 мм, масса — 128 г (без радиатора охлаждения). Питание подаётся через ATX-коннектор. Заявлена совместимость с Windows 11 IoT Enterprise, Ubuntu 24.04 LTS и Yocto Linux.

22.01.2026 [17:40], Руслан Авдеев

OpenAI представила программу Stargate Community для налаживания добрососедских отношений с местными жителямиКомпания OpenAI, объявившая о намерении создать «общий искусственный интеллект» (AGI) на благо всего человечества, намерена организовать работу таким образом, чтобы в ходе достижения этой цели её кампусы приносили пользу местным жителям. С этой целью компания представила программу Stargate Community, способствующую развитию экономики и созданию рабочих мест в регионах присутствия. В рамках инициативы Stargate компания задалась целью нарастить инфраструктуру ИИ в США до 10 ГВт к 2029 году. Первый объект в Абилине (Abilene, Техас) уже работает, новые объекты строятся по всей стране. С момента запуска в январе 2025 года, партнёры по Stargate анонсировали несколько проектов большой мощности по всему миру. В сентябре были анонсированы планы построить пять кампусов ЦОД в Техасе, Нью-Мексико, Висконсине и Мичигане общей мощностью 5,5 ГВт. ИИ уже приносит ощутимую пользу, помогая сотням людей в вопросах здоровья и обеспечения общего благополучия, говорит OpenAI. В будущем каждая площадка Stargate будет иметь собственный план Stargate Community, подготовленный с учётом местных проблем. По словам компании, добиться результатов можно, только будучи «хорошими соседями». Компания намерена компенсировать свои энергопотребности таким образом, что это не будет приводить к росту тарифов на электричество для местных жителей, строя энергохранилища, оплачивая создание генерирующих мощностей и модернизацию электросетей, разрабатывая режимы гибкого эгнергопотребления и др. Так, в Висконсине Oracle и Vantage совместно с WEC Energy Group развивают генерирующие мощности и полностью берут на себя расходы на энергетическую инфраструктуру нового объекта, чтобы все затраты на энергосети для ИИ ЦОД не перекладывались на обычных потребителей. В Мичигане Oracle и Related Digital взаимодействуют с DTE Energy в вопросе использования существующих энергоресурсов, дополненных новым аккумуляторным хранилищем, оплаченным проектом. Наконец, в Техасе принадлежащая SoftBank компания SB Energy рассчитывает построить новые генерирующие мощности и системы хранения энергии, чтобы обеспечить большую часть потребностей местного кампуса Stargate на 1,2 ГВт. OpenAI также приветствует инициативу Microsoft Community-First AI Infrastructure Plan, распространяющуюся на строящиеся для OpenAI кампусы, в рамках которой компания тоже пообещала сохранить стабильные тарифы на электроэнергию для обычных граждан, стать водноположительной, обучать и создавать рабочие места для местных жителей, а также направлять средства на социальные нужды и поддерживать местные НКО. В OpenAI тоже придерживаются подхода, при котором используются замкнутые или использующие мало питьевой воды системы охлаждения. Власти Абилина утверждают, что местный кампус будет потреблять в год вдвое меньше, чем город использует за день. Такие же решения внедряются в кампусах Stargate в других локациях, а в Висконсине не менее $175 млн направят на местную инфраструктуру и проекты восстановления водных ресурсов. В Абилине же откроется первая OpenAI Academу для подготовки специалистов в области ИИ ЦОД, от строителей до управляющих. Несмотря на все попытки OpenAI и партнёров, а также указы правительства, у экспертов и общественности сохраняются опасения, что крупные ИИ ЦОД приведут к росту цен на электричество. Вызывает обеспокоенность и вероятное использование природного газа для энергоснабжения объектов Stargate. В марте 2025 года сообщалось, что Crusoe, ответственная за строительство ЦОД в Абилине, заказала газовые турбины общей мощностью 4,5 ГВт для питания сети ЦОД.

22.01.2026 [16:04], Владимир Мироненко

Upscale AI привлёк $200 млн для запуска ИИ-интерконнекта и коммутатора SkyHammerСтартап Upscale AI, специализирующий на разработке ИИ-интерконнекта, объявил о привлечении $200 млн в рамках раунда финансирования серии А. С учётом предыдущего раунда общая сумма инвестиций в Upscale AI достигла $300 млн, а оценка его рыночной стоимости превысила $1 млрд, что придало ему статус «единорога». Это большая сумма для любой технологической компании со 150 сотрудниками, большинство из которых инженеры. Раунд серии А возглавили Tiger Global, Premji Invest и Xora Innovation, также в нём приняли участие Maverick Silicon, StepStone Group, Mayfield, Prosperity7 Ventures, Intel Capital и Qualcomm Ventures. Upscale AI отметил, что поддержка инвесторов отражает растущее в отрасли мнение, что сети являются критически узким местом для масштабирования ИИ, а традиционные сетевые архитектуры, предназначенные для соединения вычислительных ресурсов общего назначения и хранилищ, принципиально не подходят для эпохи ИИ. Устаревшие сетевые решения для ЦОД были разработаны до появления ИИ, и слабо подходят для масштабного, синхронизированного масштабирования на уровне стоек. Когда Upscale AI был основан в начале 2024 года, консорциум UALink и стандарт ESUN, предложенный Meta✴ Platforms, ещё не были обнародованы, но идея гетерогенной инфраструктуры, безусловно, уже была, отметил ресурс The Next Platform. Созданная Upscale AI платформа объединяет GPU, ИИ-ускорители, память, хранилище и сетевые возможности в единый синхронизированный ИИ-движок. Для этого стартап разработал ASIC SkyHammer, который поддерживает ESUN, UALink, Ultra Ethernet, SONiC и Switch Abstraction Interface (SAI). Фактически Upscale AI хочет составить конкуренцию NVIDIA NVSwitch, дав возможность выбора интерконнекта при создании ИИ-инфраструктур. Upscale AI сообщил, что благодаря дополнительному финансированию представит первую полнофункциональную, готовую к использованию платформу, охватывающую кремниевые компоненты, системы и ПО. Также полученные средства будут направлены на расширение инженерных, торговых и операционных команд по мере перехода к коммерческому внедрению решения. По словам Арвинда Шрикумара (Arvind Srikumar), старшего вице-президента по продуктам и маркетингу компании, поставки образцов SkyHammer клиентам начнутся в конце 2026 года, а массовые поставки — в 2027 году, когда в это же время выйдут новые поколения GPU, XPU, коммутаторов и стоек. Коммутаторы должны быть у OEM/ODM-производителей за два квартала до того, как вычислительные ядра будут готовы к поставкам, чтобы они могли собрать системы и протестировать их. «Я всегда считал, что гетерогенные вычисления — это правильный путь, и гетерогенные сети — это тоже правильный путь», — сообщил Шрикумар изданию The Next Platform. Он отметил, что Upscale AI фокусируется на демократизации интерконнекта для ИИ. Шрикумар признал, что у NVIDIA отличные технологии, и что это «потрясающая» компания, когда дело касается инноваций. Вместе с тем он считает, что в будущем, с учётом темпов развития ИИ, вряд ли одна компания сможет предоставить все необходимые технологии для ИИ. Шрикумар считает, что PCIe-коммутация хорошо работает, когда несколько СPU взаимодействуют с несколькими GPU, относительная пропускная способность памяти GPU довольно низкая, а СPU и GPU расположены довольно близко друг к другу в серверном узле. В то же время Upscale AI скептически относится к попыткам создания коммутаторов UALink, ESUN или SUE путем использования ASIC-чипов для PCIe или путём извлечения начинки ASIC-чипов Ethernet-коммутаторов. «Те, кто давно занят в сфере ASIC, знают, что можно удалить много блоков, но основные элементы остаются прежними. Базовая ДНК каждого ASIC остается неизменной», — отметил Шрикумар. Поэтому в Upscale AI решили создать ASIC с нуля, а затем обеспечить поддержку протоколов семантики памяти по мере их появления.

22.01.2026 [14:15], Сергей Карасёв

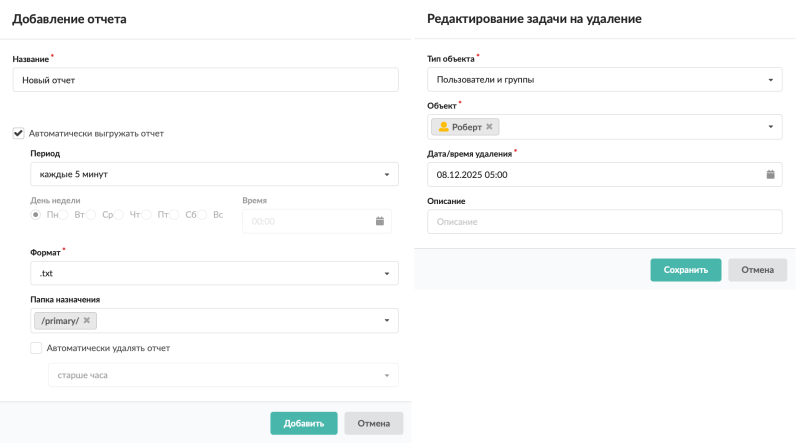

NGFW ИКС 13.0 — состоялся релиз новой версии российского межсетевого экранаКомпания «А-Реал Консалтинг» — разработчик программного обеспечения в области информационной безопасности и сетевых технологий, сообщила о выходе новой версии своей флагманской разработки. NGFW ИКС — это многофункциональное решение для защиты IT-ландшафта предприятия, управления сервисами работы с пользователями и мониторинга трафика сети. В числе ключевых функций ИКС:

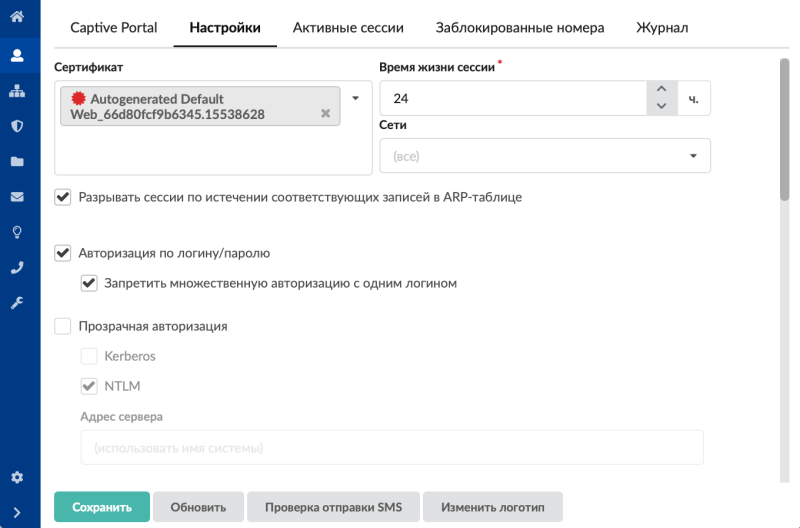

В новой версии ИКС 13.0 произошло обновление системной платформы до FreeBSD 14.3, что гарантирует повышение уровня целостности и безопасности продукта, ряд внутренних служб и сервисов ИКС также был обновлён до актуальных версий. Реализована возможность автоматической выгрузки отчётов за требуемый период в файловое хранилище, а также добавлена новая служба — планировщик, удаляющая объекты системы по расписанию. Данные изменения позволяют оптимизировать повседневную работу системного инженера, избавив его от рутинных задач. В службе синхронизации добавлена возможность импортировать все почтовые ящики пользователя FreeIPA. Для повышения скорости при больших нагрузках, реализована работа прокси-сервера в многопоточном режиме. В Captive portal добавлена возможность прозрачной аутентификации через Kerberos и/или NTLM. Подробнее об особенностях новой версии NGFW ИКС можно узнать на сайте разработчика. NGFW ИКС поставляется как в виде программного решения для самостоятельного развёртывания в среде заказчика, так и в составе ПАК, в том числе на аппаратных платформах из реестра Минпромторга России. В продуктовой линейке «А-Реал Консалтинг» также присутствует межсетевой экран ИКС, сертифицированный ФСТЭК России. Профили защиты: межсетевой экран типа «А» 4-го класса (ИТ.МЭ.А4.ПЗ), межсетевой экран типа «Б» 4-го класса (ИТ.МЭ.Б4.ПЗ); СОВ уровня cети 4-го класса (ИТ.СОВ.С4.ПЗ). Межсетевой экран ИКС ФСТЭК подходит для:

Для тех, кто не располагает достаточным временем для внедрения продукта, разработчик предусмотрел услугу ИКС ПРО, которая включает все этапы развёртывания ИКС в корпоративной сети: от брифа и техзадания, до запуска полностью настроенного продукта. ИКС ПРО позволяет сократить сроки внедрения и избежать ошибок при интеграции в инфраструктуру. Триал-версия ИКС доступна для скачивания и является полнофункциональной. На этапе тестирования предоставляется приоритетная техподдержка, по согласованию может быть организована онлайн-встреча с инженером для демонстрации возможностей продукта. Сделайте свою сеть безопасной и удобной, настройте необходимое с помощью ИКС! |

|