Материалы по тегу: гиперскейлер

|

24.02.2026 [08:59], Руслан Авдеев

К 2030 году Техас может стать крупнейшим рынком ЦОД в мире, а каждый пятый кампус будет уже гигаваттным

bloom energy

hardware

jll

ветроэнергетика

гиперскейлер

ии

полезные ископаемые

прогноз

солнечная энергия

сша

цод

экология

энергетика

Согласно анализу рынка JLL, индустрия ЦОД в Северной Америке перешла к новому этапу роста, обусловленному спросом на объекты гиперскейл-уровня и ИИ-платформы, из-за чего свободные мощности второй год подряд составляют всего 1 %, сообщает Datacenter Knowledge. Крупнейшим бенефициаром этих процессов становится Техас. Всего в Северной Америке насчитывается 39 ГВт мощностей ЦОД, в стадии реализации проекты ещё на 35 ГВт. Почти ⅔ новых мощностей — за пределами традиционных центров, Северной Вирджинии или Кремниевой долины. Тем временем, в Техасе ведётся строительство ЦОД на 6,5 ГВт — к 2030 году этот рынок может обогнать Северную Вирджинию, долгие годы бывшую абсолютным мировым лидером. Набирает обороты строительство и на рынках Теннеси, Висконсина и Огайо благодаря относительной доступности электроэнергии, наличию свободной земли и благоприятные условия ведения бизнеса. Здесь реализуются более десяти проектов мощностью более 1 ГВт. Дефицит предложения приводит к значительному ценовому давлению. Арендная плата у ЦОД выросла на 9 % в 2025 году, в результате чего рост с 2020 года составит 60 %. Отмечается, что большинство новых договоров аренды включает положение о ежегодном повышении арендной платы как минимум на 3 %, а договоры на новые площади заключаются на несколько лет вперёд, хотя зачастую ввод объектов в эксплуатацию состоится не раньше 2027 года или даже позже. Основным драйвером роста выступают крупные облачные провайдеры, капитальные затраты пяти облачных гиперскейлеров составят $710 млрд (От новости к новости цифра растёт и растёт. — Прим. ред.) только в 2026 году. Этого хватит на 35 ГВт глобальных мощностей. ИИ-компании вроде OpenAI и Anthropic анонсировали строительство ещё 10 ГВт мощностей, а неооблачные провайдеры арендовали порядка 1 ГВт.

Источник изображения: Sam LaRussa/unsplash.com При этом критическим препятствием является недостаток электроэнергии, сроки подключения составляют четыре года и выше, что вынуждает операторов осваивать новые рынки, переходить к поэтапному и модульному строительству, вырабатывать стратегии гибридного и временного энергообеспечения объектов, в том числе строить электростанций при ЦОД. И Техас в этом отношении наиболее удобен — здесь есть необходимая передающая инфраструктура, избыточная выработка электроэнергии и возможность ввода новых генерирующих объектов. А в местной энергосистеме ERCOT больше потенциальной энергии от солнечных и ветряных электростанций и природного газа, чем в любом другом регионе США. Как сообщает The Register, по данным доклада Bloom Energy 2026 Datacenter Power Report, общая IT-нагрузка в США может практически удвоиться в ближайшие несколько лет, с приблизительно 80 ГВт в 2025 году до 150 ГВт к 2028 году. По прогнозу, к 2028 году рынок ЦОД Техаса удвоится и превысит 40 ГВт. А основным источником локальной генерации для них станут газовые турбины, хотя их не хватает, да и экологичными их не назвать. Так или иначе, мощности будут наращиваться, как и масштаб новых дата-центров. В компании полагают, что к 2030 году каждый пятый ЦОД будет мощнее 1 ГВт, а к 2035 году — каждый третий.

11.02.2026 [15:53], Руслан Авдеев

Власти США «по-хорошему» призывают гиперскейлеров самим финансировать расширение ИИ-проектов, а не перекладывать затраты на жителейАдминистрация президента США продолжает продвигать развитие ИИ-проектов, в то же время стремясь ослабить недовольство граждан непомерными аппетитами ЦОД в отношении электричества и воды, а также обещая освободить крупных игроков рынка от пошлин на ИИ-ускорители. Чтобы успокоить общественность, Вашингтон предложил IT-гигантам гарантировать, что расширение их сети ЦОД в США не приведёт к резкому увеличению счетов за электричество или истощению локальных водных ресурсов, сообщает The Register. По информации Politico, предложено добровольное соглашение между президентом США Дональдом Трампом (Donald Trump) и индустрией ЦОД в лице Microsoft, Google, Amazon, Meta✴ и OpenAI, которое устанавливает принципы ответственного потребления электроэнергии, воды и отношений с жителями в местах размещения дата-центров. Новый шаг соответствует вектору предыдущих событий. Ранее президент заявил, что технологический бизнес должен сам финансировать увеличение мощности ЦОД и адаптацию для этого энергетической инфраструктуры, а не перекладывать расходы на обычных потребителей энергии. Компания Microsoft уже пошла навстречу в этом вопросе, представив проект Community-First AI Infrastructure. Кроме того, Министерство энергетики (DOE) оказало давление на оператора электросетей PJM Interconnection, чтобы та провела экстренный аукцион для компенсации роста спроса на электричество со стороны ЦОД.

Источник изображения: Gabriela/unsplash.com Это направлено на сдерживание растущего общественного недовольства появлением дата-центров по всей территории США. По данным НКО, только во II квартале были заблокированы или отложены 20 проектов строительства ЦОД в стране из-за противодействия местных сообществ. В январе 2026 года Белый дом объявил о ввозных пошлинах в размере 25 % на ИИ-ускорители, включая NVIDIA H200 и AMD MI325X, но их закупки для объектов гиперскейлеров в США пошлиной облагаться не будут. По некоторым данным, освобождение от тарифов может зависеть от политики непосредственных производителей вроде тайваньской TSMC, от которых ожидают переноса до половины своего производства в США в рамках программы «реиндустриализации» Соединённых Штатов. Недавно премьер-министр Тайваня назвал такой перенос «невозможным». Впрочем, TSMC уже выделила $165 млрд на строительство производств в Аризоне для выпуска 2-нм чипов, но пока неизвестно, устроит ли это Трампа.

06.02.2026 [17:43], Руслан Авдеев

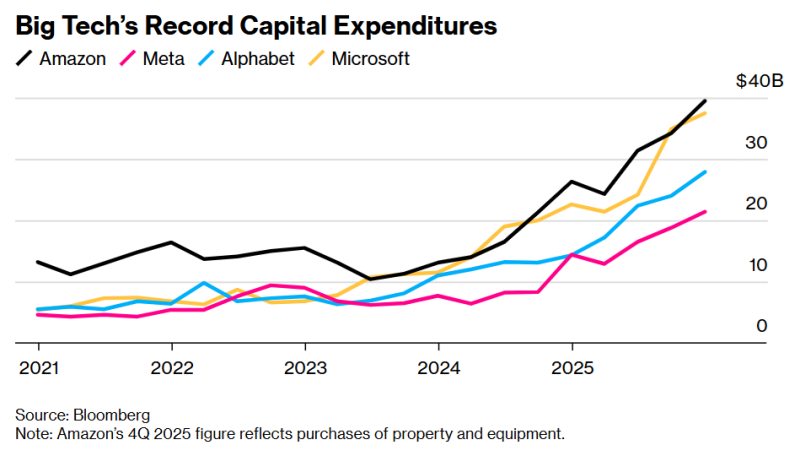

Затраты четырёх американских гиперскейлеров на ИИ ЦОД и оборудование превысят в 2026 году $650 млрдСовокупные капитальные затраты четырёх американских гиперскейлеров в 2026 году составят $650 млрд. Огромную сумму выделили на новые ИИ ЦОД и сопутствующее оборудование, необходимое для их функционирования, в т.ч. ИИ-чипы, сетевые кабели, резервные генераторы и т.п., сообщает Bloomberg. Запланированные Alphabet (Google), Amazon (AWS), Meta✴ и Miсrosoft расходы должны помочь в достижении доминирующего положения на рынке ИИ-инструментов, на котором наблюдается беспрецедентный бум. Как утверждают в Bloomberg, вероятные затраты каждой из этих компаний в 2026 году установят рекорд по капитальным затратам любой корпорации за последние десять лет. Сравнить заоблачные расходы можно, разве что, с «пузырём» на телеком-рынке в 1990-х гг. или даже со стремительным развитием железнодорожных сетей в США в XIX веке. Рост расходов на 60 % в сравнении с предыдущим годом означает новую волну ускоренного строительства дата-центров, ведущих к непрекращающемуся дефициту электроснабжения и росту тарифов для обычных пользователей, конфликтам между застройщиками на почве конкуренции за энергию и чистую воду. Также расходы малой группы состоятельной компании могут исказить общие экономические показатели в стране. При этом, по мнению экспертов, рынок вычислительных ресурсов для ИИ рассматривается как очередное поле битвы, где победитель заберёт всё или большую часть. На днях Meta✴ объявила, что капитальные затраты за год вырастут до $135 млрд, рост может составить порядка 87 %. Тогда же Microsoft объявила об увеличении капитальных затрат во II квартале на 66 %, что превышает предыдущие прогнозы. Аналитики полагают, что годовые капитальные затраты компании вырастут почти вдвое до $145 млрд, как и у Oracle — до $55 млрд. Alphabet обнародовала прогноз капитальных вложений, превосходящий расходы значительной части американской промышленности, на уровне до $185 млрд. Наконец, Amazon даже превзошла этот показатель, запланировав потратить $200 млрд в 2026 году. По прогнозам Bloomberg, крупнейшие американские автопроизводители, компании, выпускающие строительную технику, железнодорожные компании, ВПК, мобильные операторы, службы доставки посылок, а также Exxon Mobil, Intel, Walmart и др. (всего 21 компания) потратят суммарно $180 млрд. При этом расходы гиперскейлеров даже по отдельности уже превысили ВВП целых стран. У каждого из гиперскейлеров разные подходы к обеспечению окупаемости инвестиций. Но все затраты основаны на предпосылке, что инструменты вроде ChatGPT будут играть всё более важную роль в бизнесе и дома. Создание передовых ИИ с помощью тысяч чипов — чрезвычайно дорогой процесс, но затраты оправдываются предполагаемым экспоненциальным ростом доходов в будущем. Всего несколько лет назад даже IT-гиганты имели относительно небольшие вычислительные мощности, обслуживая миллиарды людей, но теперь ситуация изменилась. Например, в 2026 году Meta✴ впервые за шесть лет потратила на капитальные проекты больше, чем на исследования и разработки (в основном, на зарплаты разработчикам). На конец 2025 года она уже владела активами и оборудованием на $176 млрд, это приблизительно впятеро больше, чем на конец 2019 года.

Источник изображения: Bloomberg По мере роста объёмов работ пока неизвестно, способны ли компании реализовать свои амбиции. Идёт конкуренция за ограниченное количество электриков, грузовиков-цементовозов и ИИ-ускорители NVIDIA, выпускаемые TSMC в ограниченных объёмах. Кроме того, прибыль Meta✴ и Google поступает в основном от цифровой рекламы, Amazon является крупнейшим ретейлером и поставщиком облачных сервисов, Microsoft является крупнейшим продавцом ПО для бизнеса — все они лидируют в своих отраслях и имеют значительные денежные резервы. Готовность тратить эти резервы на ИИ-проекты не может не беспокоить инвесторов. По словам представителя Theory Ventures, ранее работавшего в Google, раньше средства вкладывались в настоящие «машины для производства денег», а теперь им сами понадобились эти деньги, и даже кредиты. Более того, инвесторы, в последний год стремившиеся скупить акции техногигантов, теперь весьма осторожны на фоне растущих капитальных затрат. В некоторых случаях акции продаются даже тогда, когда основные направления бизнеса от онлайн-рекламы до электронной коммерции оставались стабильными и выручка даже превышала прогнозы. По словам некоторых экспертов, инвесторов пугают «аналитические обзоры и риторика». Не исключено, что перед их глазами — пример менее успешных компаний. Например, Fermi, очень успешно стартовавшая со сбором средств, теперь подозревается в манипуляциях с ценными бумагами и против неё уже подали коллективный иск от имени инвесторов. А, например, Oracle банки уже не очень хотят давать деньги в долг. На неё, кстати, тоже подали в суд в связи непрозрачностью финансирования ИИ ЦОД в интересах OpenAI, на которую завязано очень многое.

03.02.2026 [12:31], Руслан Авдеев

Индия объявила 20 лет налоговых каникул для гиперскейлеров, использующих местные ЦОД для обслуживания зарубежных облачных клиентовИндия анонсировала 20 лет налоговых льгот для гиперскейлеров, использующих дата-центры, расположенные в стране, для обслуживания клиентов со всего мира, сообщает CNBC. Предполагается, что такое предложение может привлечь связанные с ИИ бизнесы в активно развивающийся регион. Правда, стремление многих стран к цифровому суверенитету может помешать этим планам. По словам экспертов, стоимость инфраструктуры ЦОД в Индии и без того невысока, а в совокупности с налоговыми каникулами использование индийских ЦОД для гиперскейлеров станет ещё привлекательнее в сравнении с хабами в Сингапуре, ОАЭ и Ирландии. По мнению экспертов, это изменит положение Индии — она станет не только «рынком потребления» услуг ЦОД, но и глобальным хабом для облачных и ИИ-вычислений. Пока же гиперскейлеры сталкиваются со значительными рисками, связанными с корпоративными налогами, если имеют в Индии «значительное экономическое присутствие». Сегодня работа ЦОД иностранных гиперскейлеров в Индии рассматриваются как «постоянное представительство», а прибыль от этой деятельности облагается налогом в 35 %, не считая дополнительных сборов. Теперь облачные сервисы, предоставляемые зарубежными гиперскейлерами с использованием дата-центров, принадлежащих местным застройщикам и управляемых ими же, будут пользоваться налоговыми каникулами до 2047 года. Ожидается, что это ускорит инвестиции в ЦОД. Пока роль Индии в мировой гонке ИИ была ограничена, поскольку стране недостаёт ИИ-моделей местного происхождения, производства чипов и больших ЦОД в сравнении с США и Китаем. Предложенные налоговые каникулы и инвестиции, которые они, вероятно, принесут, могут усилить роль Индии в глобальной гонке технологий искусственного интеллекта. Многие техногиганты уровня Microsoft уже анонсировали миллиардные инвестиции в местную ИИ-инфраструктуру. Ещё более крупные инвестиции готовит Amazon. Помимо попыток привлечь гиперскейлеров, Индия имеет большие амбиции в сфере ИИ-полупроводников, поощряя их разработку и производство в стране. Налоговые каникулы должны сыграть на руку местным IT-компаниям и облачным бизнесам вроде Infosys, Wipro, TCS, HCL Tech и Jio, равно как и местным строителям ЦОД. Среди выгодоприобретателей от налоговых каникул, вероятно, будет Google, совместно с местной AdaniConneX намеренная построить дата-центр за $15 млрд на территории нового ИИ-хаба на юге Индии. В последние годы спрос на ЦОД значительно вырос, в основном в связи с масштабированием ИИ-задач, требующих огромных вычислительных мощностей, электроэнергии, охлаждения и сетевой инфраструктуры. В глобальный рынок ЦОД в 2025 году вложили более $61 млрд. Сегодня мощность индийских ЦОД составляет около 1,2 ГВт, но в следующие пять лет рынок должен преодолеть отметку в 3 ГВт. Согласно январскому докладу JLL, мировая мощность ЦОД составила около 100 ГВт и должна удвоиться до 200 ГВт к 2030 году благодаря буму ИИ. В Индии считают, что налоговые каникулы уберут крупнейшее препятствие для выхода зарубежных гиперскейлеров на индийский рынок. По мнению экспертов, поскольку рынки Азиатско-Тихоокеанского региона уровня Японии, Австралии, Китая и Сингапура достигли «зрелости», а Сингапур, ко всему прочему, ещё и страдает от дефицита земли и других ресурсов, Индия может стать новым перспективным местом для развития инфраструктуры ЦОД. В стране много места для крупномасштабных строек ЦОД, а в сравнении с ИИ-хабами в Европе, цены на электричество довольно невысоки. С учётом растущих возможностей развития возобновляемой энергии, критической для питания дата-центров, модель индийского технологического рывка выглядит вполне убедительно. Как заявляют индийские эксперты, налоговые каникулы для зарубежных облачных компаний могут стать катализатором крупных глобальных инвестиций, увеличения экспортной выручки и приведут к созданию долгосрочных рабочих мест и других возможностей.

25.12.2025 [00:50], Владимир Мироненко

С глаз — долой, с баланса — вон: гиперскейлеры переложили на плечи инвесторов $120 млрд займовВ последнее время сформировался тренд на вывод технологическими компаниями за пределы своих балансов кредитования проектов по развитию ИИ-инфраструктуры. По данным The Financial Times, ряд IT-гигантов обошелся без учёта в своих балансах более $120 млрд, связанных с расходами на ЦОД, благодаря созданию компаний специального назначения — SPV (special-purpose vehicle), финансируемых большей частью инвесторами с Уолл-стрит, что усиливает опасения по поводу финансовых рисков их огромной ставки на ИИ. Речь идёт о Meta✴, xAI, Oracle и CoreWeave, которые лидируют по суммам заключённых сложных финансовых сделок, к которым они прибегли с целью защиты от рисков крупных заимствований, необходимых для строительства ИИ ЦОД. Указанную сумму им предоставили финансовые институты, включая Pimco, BlackRock, Apollo, Blue Owl Capital и американские банки, такие как JPMorgan, в виде заёмных и собственных средств. В октябре компания Meta✴ заключила крупнейшую сделку по привлечению частного кредита для строительства ЦОД Hyperion в Луизиане (США), в рамках которой была создана специализированная компания Beignet Investor совместно с нью-йоркской финансовой фирмой Blue Owl Capital. Beignet Investor привлекла $30 млрд, включая около $27 млрд кредитов от Pimco, BlackRock, Apollo и других, а также $3 млрд акционерного капитала от Blue Owl. Эта сделка не была отражена на балансе Meta✴, что упростило ей привлечение ещё $30 млрд на рынке корпоративных облигаций спустя несколько недель. Привлечение частного капитала через внебалансовые структуры защищает кредитные рейтинги компаний и улучшает их финансовые показатели, отметил The Financial Times. В данном случае Meta✴ получила во владение 20 % SPV и предоставила «гарантию остаточной стоимости» другим инвесторам. Это означает, что она должна будет вернуть средства инвесторам SPV, если стоимость ЦОД упадет ниже определённого уровня к концу срока аренды, а Meta✴ не станет продлевать договор аренды. Oracle стала лидером в структурировании крупных долгов через третьих лиц для оплаты своих огромных обязательств по сдаче в аренду вычислительных мощностей компании OpenAI. Она заключила партнёрские соглашения с застройщиками и финансистами, такими как Crusoe, Blue Owl Capital, Vantage и Related Digital, для строительства целого ряда ЦОД, каждый из которых будет принадлежать SPV. В частности, Blue Owl и JPMorgan инвестировали $13 млрд, включая $10 млрд заёмных средств, в SPV, владеющую ЦОД OpenAI в Абилине (штат Техас). Также упоминается пакет долговых обязательств на сумму $38 млрд для оплаты строительства двух ЦОД в Техасе и Висконсине, и кредит на сумму $18 млрд на строительство ЦОД в Нью-Мексико. При этом Oracle будет арендовать эти объекты у SPV. В случае дефолта кредиторы будут иметь право на активы — ЦОД, земельный участок, на котором он расположен, и оборудование, но не на компании, управляющие объектами. При этом Blue Owl стала более осторожно подходить к сделкам с Oracle. xAI использовала аналогичную стратегию для привлечения $20 млрд, включая до $12,5 млрд заёмных средств. Созданное SPV будет использовать эти деньги для покупки ускорителей NVIDIA с последующей сдачей их в аренду xAI. В марте CoreWeave заявила о создании SPV для выполнения контрактов на сумму $22,4 млрд на поставку вычислительных мощностей компании OpenAI, что «потребует привлечения заемных средств для финансирования своих обязательств». В июле компания заняла ещё $2,6 млрд для финансирования реализации контрактов с OpenAI. Традиционно технологические компании обладали значительными средствами и имели небольшую задолженность, что обеспечивало им отличные кредитные рейтинги и высокую уверенность со стороны инвесторов. Поскольку объём капитала, необходимого для финансирования роста ИИ-инфраструктуры, резко возрос, это истощило денежные резервы технологических компаний. По оценкам Morgan Stanley, для финансирования планов технологических компаний в области ИИ требуется $1,5 трлн внешнего финансирования. При этом частные инвесторы тоже стремятся заработать на буме ИИ, что повышает спрос на подобные сделки. По данным UBS, к началу 2025 года технологические компании привлекли у частных фондов около $450 млрд, что на $100 млрд больше, чем за предыдущие 12 месяцев. В этом году, по данным UBS, около $125 млрд было направлено на сделки по «проектному финансированию» — долгосрочному финансированию инфраструктурных проектов, таких как сделки Meta✴ и Blue Owl. Следует отметить, что не все гиперскейлеры следуют этому тренду. Google, Microsoft и Amazon — у которых до бума ИИ были крупные, хорошо зарекомендовавшие себя дата-центры — продолжают финансировать строительство за счёт собственных средств. Хотя Google и Amazon недавно привлекли инвесторов в облигации для прямого увеличения заёмных средств, эти три компании пока не сообщали о каком-либо значительном финансировании через SPV. Уолл-стрит также использует другие виды сделок на рынке ЦОД. По словам банкиров, в последние месяцы наблюдались сделки по секьюритизации долга в сфере ИИ, когда кредиторы объединяют непогашенные кредиты и продают инвесторам их доли в виде обеспеченных активами ценных бумаг. Два банкира оценили эти сделки в несколько миллиардов долларов. Такого рода сделки позволяют распределить риск кредитования провайдеров ЦОД между гораздо более широким кругом инвесторов, включая управляющих активами и пенсионные фонды. При этом множество сделок так или иначе связано с NVIDIA.

24.12.2025 [17:13], Руслан Авдеев

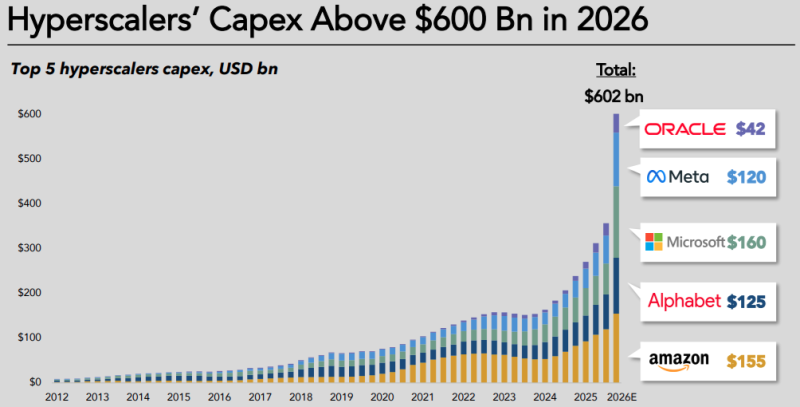

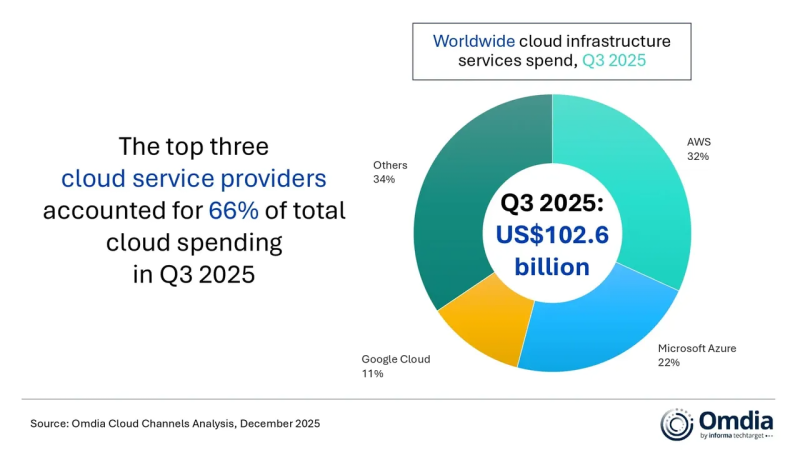

Капитальные затраты гиперскейлеров в 2026 году вырастут на треть и превысят $600 млрдКапитальные затраты «большой пятёрки» гиперскейлеров, включающей Amazon, Google, Microsoft, Meta✴ и Oracle, по прогнозам экспертов, превысят $600 млрд — это на 36 % больше, чем в 2025 году, сообщается в техноблоге IEEE ComSoc. Из них около 75 % или $450 млрд будет напрямую связано с ИИ-инфраструктурой (ЦОД, серверами, ускорителями и иным оборудованием). Поскольку собственных денежных средств после выкупа акций и выплаты дивидендов уже не хватает, компании, традиционно финансировавшие свои проекты в основном за счёт внутренних ресурсов, активно осваивают рынки долговых обязательств. Хотя финансовое положение гиперскейлеров по-прежнему остаётся стабильным, трансформируется сама модель финансирования. По данным Omdia, в III квартале 2025 года общемировые затраты на облачную инфраструктуру достигли $102,6 млрд, т.е. на четверть боьлше год к году. Уже пятый квартал подряд рост облачных расходов превышал 20 %. AWS, Microsoft Azure и Google Cloud в целом сохранили свои рыночные позиции, которые они занимали кварталом ранее, всего на их долю приходилось 66 % мировых расходов на облачную инфраструктуру. На трёх облачных провайдеров совокупный рост год к году составил 29 %. Omdia сообщает, что ситуация на рынке в целом отражает изменения технологического ландшафта по мере того, как корпоративный спрос на ИИ меняется с переходом от ранних экспериментов к масштабному внедрению. Акцент в бизнес-стратегиях гиперскейлеров сместился с предложения максимально производительных отдельных «моделей-рекордсменов» на создание комплексных, готовых к масштабированию ИИ-платформ. Они обеспечивают выбор и комбинированное использование различных моделей и ИИ-агентов. AWS, Microsoft Azure и Amazon превращают облака в единые экосистемы с интеграцией собственных и сторонних ИИ-моделей. Как утверждают эксперты Omdia, коллаборации в рамках общей ИИ-экосистемы остаются критически важными. Поддержка пакетов моделей разных разработчиков становится скорее необходимым требованием, чем необычной функцией. Корпоративные клиенты ищут надёжности, возможности контроля цен и гибкости при внедрении для выполнения ИИ-задач. Гиперскейлеры, наращивают ресурсы для управления жизненным циклом ИИ-агентов, включая их создание и развёртывание на уровне корпоративных клиентов, поскольку практическое внедрение оказалось несколько сложнее, чем ожидалось.

Источник изображения: Omdia Как заявляют в Omdia, массовому внедрению ИИ-агентов мешает отсутствие у компаний готовых, стандартизированных решений, которые одновременно обеспечивали бы бесперебойную работу бизнеса, качественный клиентский опыт и соответствие таких агентов регуляторным требованиям. Недавно Omdia сообщала, что капитальные затраты на ЦОД в целом вырастут к 2030 году до $1,6 трлн — если раньше не лопнет ИИ-пузырь. В августе она же объявила, что расходы гиперскейлеров на дата-центры превысили ВВП целых стран.

22.12.2025 [10:17], Владимир Мироненко

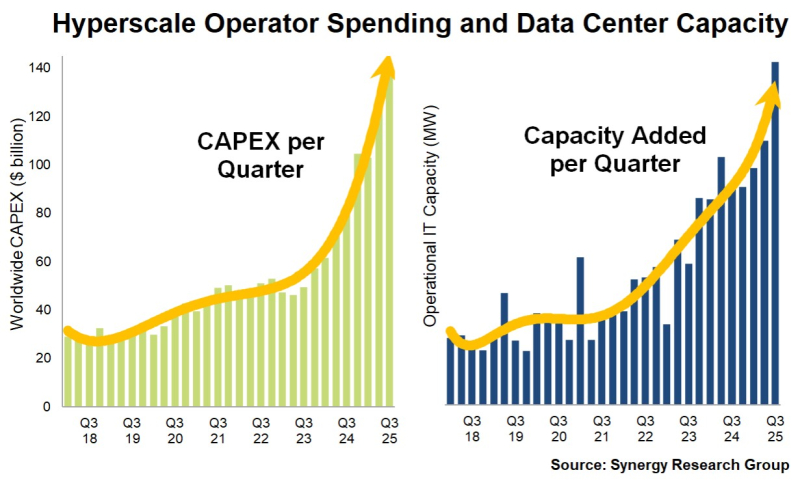

Количество ЦОД гиперскейлеров выросло с 2018 года почти втроеСогласно данным Synergy Research Group за III квартал 2025 года, в мире насчитывается уже 1297 ЦОД гиперскейлеров, что почти втрое больше, чем в начале 2018 года. При этом их общая мощность увеличилась более чем в четыре раза, поскольку средний размер ЦОД продолжает расти. Аналитики отметили, что рост основных показателей рынка резко ускорился после запуска ChatGPT в конце 2022 года благодаря росту инвестиций в области ИИ. За последние три года ежеквартальные капитальные затраты гиперскейлеров выросли почти на 180 %, достигнув в III квартале $142 млрд. Фактические мощности росли почти такими же темпами — на 170 % каждый квартал. Благодаря этому доля США на мировом рынке с точки зрения мощностей выросла за три года с 52 до 55 %, укрепив их доминирующее положение. Исследование Synergy Research Group основано на анализе инфраструктуры ЦОД 21 крупнейших в мире компаний в сфере облачных и интернет-сервисов, включая крупнейших операторов в сфере SaaS, IaaS, PaaS, поисковых систем, социальных сетей, электронной коммерции и игр. Лидируют в рейтинге провайдеры облачных сервисов Amazon, Microsoft и Google, обладающие самой обширной инфраструктурой ЦОД как в США, так и за их пределами. На них приходится 58 % всех мощностей ЦОД гиперскейлеров. За ними следуют Meta✴, Alibaba, Tencent, Oracle, Apple, ByteDance, а затем другие, менее крупные гиперскейлеры. Прогноз Synergy Research Group в значительной степени основан на отслеживании планов гиперскейлеров по строительству ЦОД. В настоящее время в базе данных Synergy насчитывается 770 объектов, находящихся на различных этапах планирования, строительства или оснащения. Аналитики отметили увеличение в минувшем квартале темпов роста по количеству введённых ЦОД, эксплуатационной мощности, связанными с ними капитальным затратам, доходам компаний и доходам от облачных сервисов. Также аналитики отметили увеличение количества будущих объектов. Synergy пересмотрела свой пятилетний прогноз в сторону повышения по нескольким ключевым показателям, ожидая, что общая мощность ЦОД гиперскейлеров удвоится всего за двенадцать кварталов. Это «подчёркивает масштаб и скорость, с которой инвестиции в инфраструктуру, основанные на ИИ, меняют глобальные рынки облачных вычислений», — отметила компания.

18.11.2025 [17:07], Руслан Авдеев

Евросоюз рассматривает необходимость ограничения возможностей американских облачных гигантовЕвросоюз рассматривает возможность ужесточения контроля за деятельностью облачных гигантов AWS, Microsoft Azure и Google Cloud, передаёт Bloomberg. Анитимонополные регуляторы намерены принять решение, следует ли ввести дополнительные ограничения для кого-либо из этих гиперскейлеров в соответствии с действующим в ЕС законом Digital Markets Act (DMA), сообщает издание со ссылкой на источники, «знакомые с ситуацией». План расследования разработан после ряда крупных сбоев в облачном секторе — они привели к хаосу в работе глобальных служб и стали дополнительным свидетельством того, что не стоит опираться лишь на нескольких крупных игроков. Речь о крупных сбоях AWS и Microsoft Azure. Пока облачные гиперскейлеры не подпадали под действие DMA, поскольку большая часть их деятельности связана с корпоративными контрактами, что затрудняет подсчёт индивидуальных пользователей их сервисов. Именно их количество может послужить для ЕС одним из главных оснований для введения дополнительного надзора за облачными сервисами из США.

Источник изображения: Jon Del Rivero/unspalsh.com В рамках расследования регуляторы оценят, стоит ли заставлять ведущих операторов брать на себя новые обязательства, включая повышение уровня совместимости с конкурирующим ПО (что особенно актуально для Microsoft) и упрощение переноса данных пользователей от одного облачного провайдера к другому. Кроме того, не исключены запреты на обязательную продажу пакетов услуг или ПО без возможности купить их по отдельности, а также ограничения на стимулирование подобных «пакетных» продаж. Еврокомиссия и представители гиперскейлеров ситуацию пока не комментируют. Закон DMA, принятый ЕС в 2023 году, призван ограничить деятельность крупнейших IT-гигантов, устанавливая ряд правил и запретов. Пока они не применялись против крупных облачных провайдеров, контролирующих значительную долю рынка. Если облачные сервисы в итоге будут признаны подпадающими под правила DMA, штрафы за их нарушения могут быть весьма чувствительными даже для гиперскейлеров. Например, Apple и Meta✴ уже почувствовали жёсткость закона на себе, заплатив штрафы €500 млн ($579 млн) и €200 млн ($231 млн) соответственно.

11.11.2025 [09:48], Руслан Авдеев

«Никто не хочет ЦОД у себя во дворе» — юрист Microsoft о проблемах строительства дата-центровВ ходе вебинара «Дата-центр: строительство, контракты и долги» (Data centers: Construction, contracts and debt), организованного юридической компанией Norton Rose Fulbright, представитель Microsoft выступила с любопытным заявлением. По словам главного корпоративного юриста компании Линди Стоун (Lyndi Stone), «на самом деле никто не хочет иметь дата-центр у себя на заднем дворе», сообщает Datacenter Dynamics. По словам Стоун, раньше ЦОД строили вдали от населённых пунктов и жилых зон, но по мере экспансии у них появились соседи, находящиеся совсем рядом и не желающие иметь дата-центр на заднем дворе. Более того, сама Стоун заявила, что не хотела бы такого для себя. Хотя она представляет интересы Microsoft, в настоящее время агрессивно расширяющей мощности ЦОД в США и по всему миру, её комментарии буквально повторяют тезисы многих сельских общин, негативно реагирующих на проекты строительства дата-центров.

Источник изображения: AMONWAT DUMKRUT/unsplash.com В основном жители опасаются роста стоимости коммунальных услуг, негативного воздействия на окружающую среду и изменение традиционного облика района в целом. Кроме того, жителей раздражают требования подписать соглашения о неразглашении для получения информации о проекте и высокая скорость утверждения подобных проектов властями. В результате проекты ЦОД зачастую или сразу отклоняются властями, или от них отказываются сами застройщики. Microsoft множество раз сталкивалась с такой ситуацией. Тем временем глава компании Сатья Наделла (Satya Nadella) заявил о намерении Microsoft увеличить мощности ИИ-проектов в течение 2026 финансового года более чем на 80 % и примерно вдвое увеличить площадь дата-центров за пару лет. Сообщается, что только в 2025 году в действие введено около 2 ГВт ЦОД, в последнем квартале капитальные издержки выросли на 50 % квартал к кварталу до $34,9 млрд. Из них $11,1 млрд потрачены на аренду мощностей в сторонних ЦОД. Выступая, Стоун упомянула и тему новых рабочих мест, заявив, что во время строительства у людей действительно появляется довольно много работы, но после ввода ЦОД в эксплуатацию для его обслуживания надо очень мало сотрудников, поэтому польза для местных сообществ невелика. Кроме того, такие места часто требуют высокой квалификации, поэтому операторы ЦОД привлекают специалистов со стороны. Стоун рассказала и о политической проблеме — представителей местных властей выбирают непосредственно люди, поэтому им приходится учитывать мнение избирателей, а застройщикам и операторам ЦОД приходится получать общественный «кредит доверия», поскольку чиновникам приходится учитывать позицию жителей. Сопротивление стало особенно активным на фоне бума ИИ. Операторы ЦОД, стремящиеся быстро получить доступ к электричеству и другим ресурсам, переключили внимание с мегаполисов и их окрестностей на небольшие сельские поселения. Впрочем, жители и местные активисты нередко жалуются на те или иные проблемы, связанные с ЦОД. Так, в конце октября появилась информация, что дата-центры лишают людей воды и света от Мексики до Ирландии. А в Северной Вирджинии, крупнейшем в мире рынке ЦОД гиперскейлеров, дата-центры создают невыносимый шум — местные жители активно судятся с властями и IT-гигантами. Тем не менее, ещё летом сообщалось, что рынок ЦОД стал настолько привлекателен, что даже высокий порог входа не останавливает неквалифицированных инвесторов от попыток заработать.

23.10.2025 [17:05], Руслан Авдеев

OpenAI на проводе: поставщик газовых турбин GE Vernova рассчитывает неплохо заработать на ИИ ЦОД гиперскейлеров

general electric

hardware

openai

гиперскейлер

полезные ископаемые

сша

финансы

электропитание

энергетика

Акции производителя турбин GE Vernova показали рекордное падение после рекордного же роста в этом году из-за опасений компании по поводу будущего рынка. Впрочем, компания надеется на растущий спрос со стороны дата-центров, сообщает Bloomberg. Тем не менее, GE Vernova по-прежнему не уверена в целесообразности расширения производственных мощностей, хотя и полагает, что капитальные расходы предприятий сектора энергетика достигнут пика уже в следующем году. При этом заявление GE Vernova обрушило и акции конкурентов: Vertiv Holdings и Eaton. Спрос на электроэнергию быстро растёт благодаря развитию энергоёмких ИИ ЦОД, новых производств и общей электрификации экономики. Внимание экспертов приковано к тому, как крупные энергокомпании реализуют потенциал роста и избегут ряда рисков. GE Vernova намерена всё активнее поставлять технологическим компаниям, строящим ЦОД, свои газовые турбины. Впрочем, пока около 90 % заказов поступает от обычных клиентов вроде коммунальных компаний и независимых производителей энергии. Примерно 10 % приходятся на гиперскейлеров — $600 млн в 2024 году и $900 млн в этом, с учётом заказов за IV квартал сумма год к году фактически удвоится. Вместе с тем на IT-гигантов также приходится около трети оплаченных предварительных заказов для проектов на ранней стадии реализации. Однако здесь есть важный нюанс — технологические компании нередко финансируют контракты, не будучи конечными операторами турбин. Они лишь принимают участие в проектах, чтобы обеспечить рост отрасли соответствующими их ожиданиям темпами. По словам GE Vernova, турбины практически распроданы уже на весь 2028 год. На 2027 год распределены заказы на значительную часть трансформаторов. Компания также заявила, что намерена купить за $5,3 млрд 50 % акций производителя трансформаторов Prolec GE. В III квартале заказы в энергетическом бизнесе компании выросли на 50 % году к году до $7,8 млрд, заказы в сегменте электрификации выросли на 102 % до $5,1 млрд. Также компания объявила, что портфель её энергетических заказов и запросов вырос с 55 до 62 ГВт, цены на газовые генераторы растут ускоренными темпами, а рентабельность по будущим заказам улучшается. Ожидается, что предварительные запросы превратятся в настоящие заказы в течение 2026 года, что обеспечит компании увеличение и выручки, и прибыли. Глава GE Vernova отметил, что в последние недели часто виделся с руководителем OpenAI Сэмом Альтманом (Sam Altman) и его командой. OpenAI является неотъемлемой частью амбициозного плана по развитию бизнеса GE Vernova. Речь идёт как о партнёрстве в сфере генерации энергии, так и поставках электрического оборудования. Компания уже стала ключевым поставщиком энергетического оборудования почти всем ключевым гиперскейлерам, включая OpenAI и Oracle (Crusoe и не только), Google (NextEra) и xAI. По словам экспертов, сейчас главной проблемой GE Vernova являются ограниченные возможности производства, меняющаяся тарифная политика, которая уже обошлась компании в $300–$400 млн, и регуляторы, из-за которых, в частности, упали заказы на ветряки. У бизнеса может появиться сильный конкурент. Компания ProEnergy предложила запитать ЦОД от своих газовых генераторов на основе старых авиадвигателей. Они будут доступны тысячами после списания с авиалайнеров. |

|