Материалы по тегу: ии

|

22.02.2026 [00:24], Владимир Мироненко

AMD подстрахует Crusoe, продаст ей свои чипы и сама же арендует их, если что-то пойдёт не такСогласно данным ресурса The Information, AMD предоставит гарантию по кредиту в размере $300 млн неооблаку Crusoe для покупки и развёртывания своих ИИ-чипов. Благодаря этому стартап получит кредит под 6 %, что гораздо ниже, чем было бы без поддержки AMD. Кредит для Crusoe, организованный Goldman Sachs, будет обеспечен чипами AMD и соответствующим оборудованием. Сделка позволит Crusoe приобрести ИИ-чипы AMD, чтобы развернуть их в новом ЦОД в Огайо, строящемся канадским девелопером 5C, поддерживаемым Brookfield. По данным источников, AMD обязуется арендовать собственные чипы у Crusoe, если ей не удастся привлечь достаточное количество клиентов, особенно среди разработчиков ИИ. Генеральный директор Crusoe Чейз Лохмиллер (Chase Lochmiller) в прошлом году сообщил Reuters, что компания планирует приобрести чипы AMD на сумму $400 млн. Эта сделка подчеркивает усиление конкуренции среди производителей полупроводников за поддержку развития инфраструктуры, ориентированной на ИИ, отметил ресурс MarketScreener. В данном случае AMD придерживается стратегии лидера ИИ-рынка компании NVIDIA, готовой предоставить заимствования для покупки своей продукции, арендовать собственные чипы, выступить в качестве гаранта партнёра в сделках аренды ЦОД, а также гарантировать выкуп вычислительных мощностей партнёра в случае, если те останутся невостребованными. NVIDIA также является ключевым инвестором Crusoe. Компания участвовала в раунде финансирования серии D компании Crusoe на сумму $600 млн в конце 2024 года, а затем в раунде серии E на сумму $1,375 млрд в октябре 2025 года, что увеличило оценку Crusoe до более чем $10 млрд. Несмотря на циклический характер заключаемых NVIDIA сделок, что вызывает опасения экспертов в растущем пузыре на ИИ-рынке, инвесторы пока сохраняют оптимизм. Акции NVIDIA выросли за 2025 год более чем на 34 %, а акции AMD за тот же период — на 76 %, пишет MSN.

21.02.2026 [15:03], Сергей Карасёв

G42 из ОАЭ и Cerebras построят в Индии национальный ИИ-суперкомпьютер с царь-ускорителями WSE-3Холдинг G42 из Абу-Даби (ОАЭ) и компания Cerebras в партнёрстве с Университетом искусственного интеллекта им. Мохаммеда бин Зайеда (MBZUAI) и Индийским центром развития передовых вычислительных технологий (C-DAC) развернут в Индии национальный ИИ-суперкомпьютер. Технические подробности проекта не раскрываются. Отмечается лишь, что система обеспечит ИИ-производительность на уровне 8 Эфлопс (точность вычислений не указана). Комплекс, размещённый на территории Индии, будет эксплуатироваться в соответствии с местными требованиями к безопасности, а все обрабатываемые данные останутся в национальной юрисдикции. Иными словами, речь идёт о формировании суверенной вычислительной платформы. Как отмечает The Register, в основу суперкомпьютера лягут ускорители Cerebras WSE-3. Эти изделия содержат 4 трлн транзисторов, 900 тыс. ядер и 44 Гбайт SRAM. Суммарная пропускная способность встроенной памяти достигает 21 Пбайт/с. Производительность составляет до 125 Пфлопс на операциях FP16. Таким образом, в составе НРС-системы могут быть задействованы 64 экземпляра Cerebras WSE-3.

Источник изображения: G42 После ввода в эксплуатацию новый суперкомпьютер станет доступен широкому кругу пользователей в Индии — от ведущих научных организаций, институтов и государственных структур до стартапов, малых и средних предприятий. Ожидается, что появление системы позволит ускорить инновации в области ИИ. «Суверенная инфраструктура ИИ становится важнейшим компонентом национальной конкурентоспособности. Новый проект предоставит Индии такую платформу, позволив местным исследователям и предприятиям внедрять ИИ, обеспечивая при этом полную безопасность данных», — заявил Ману Джайн (Manu Jain), генеральный директор G42 India. Нужно отметить, что в Индии активно развивается инфраструктуры для ИИ-вычислений. В частности, индийские Tata Group, Tata Consultancy Services (TCS) и OpenAI намерены развернуть в стране ИИ ЦОД мощностью до 1 ГВт. Вместе с тем индийский конгломерат Adani вложит $100 млрд в создание ЦОД общей мощностью 5 ГВт, снабжаемых возобновляемой энергией.

20.02.2026 [23:37], Руслан Авдеев

«Гонка вооружений» в сфере ИИ бессмысленна — США и Китай преследуют совершенно разные целиВ ИИ уже вложено больше денег, чем потребовалось для высадки людей на Луну, а в 2026 году расходы на технологию могут достигнуть $700 млрд, почти удвоившись год к году. В США политики и бизнес часто стремятся в этой сфере «победить Китай», однако такой подход предполагает общую цель двух стран и относительную «симметрию» при её достижении. На деле цели у стран на рынке ИИ весьма разные, сообщает IEEE Spectrum. По словам Селины Сюй (Selina Xu), руководящей исследованиями и стратегическими инициативами, касающимися Китая и ИИ в офисе Эрика Шмидта (Eric Schmidt), бывшего главы Google, внимательное изучение развития ИИ в двух странах показывает, что они не стремятся в этой сфере к одним и тем же целям. Более того, они движутся совсем в разных направлениях. По мнению Сюй, США делают акцент на масштабирование, стремясь создать «общий искусственный интеллект» (AGI), тогда как для Китая важнее повышение экономических показателей и использование в реальном мире. По словам Сюй, менталитет «гонки на выживание» способен только навредить — правительства и компании будут пренебрегать необходимыми мерами безопасности для достижения мнимого «первенства». Отчасти это уже наблюдается, например, в сфере энергетики, где администрация президента США продвигает «атомные кампусы» с ослабленными требованиями к безопасности АЭС. Сам Шмидт уже предупреждал об опасности стремления США к доминированию в области ИИ. По мере развития систем машинного обучения в 2010-х гг., видные общественные деятели вроде Стивена Хокинга и Илона Маска уже предупреждали, что универсальный потенциал ИИ невозможно будет отделить от военного и экономического — повторяется модель конкуренции времён Холодной войны. По мнению некоторых экспертов, концепция такого «состязания» выгодна передовым лабораториям, инвесторам и СМИ, которым просто удобнее оперировать простыми метриками успеха вроде размера моделей, контрольных показателей и большей вычислительной мощности. В парадигме «гонки вооружений» «общий искусственный интеллект» — и есть «финишная линия», победителем станет тот, кто первый её достигнет. Тем временем, как считают эксперты, нет никакой гарантии, что страна, создавшая AGI, станет именно победителем и её интересы восторжествуют, поскольку такой искусственный интеллект будет умнее людей и, следовательно, неуправляемым и непредсказуемым. Кроме того, Китай и США совсем-по разному подходят к реализации ИИ-проектов и экономические условия этих стран кардинально отличаются. После десятилетий быстрого роста КНР столкнулась с экономическим спадом, поэтому страна стремится найти новый «двигатель экономики». Вместо того, чтобы вкладывать ресурсы в «спекулятивные» модели развития искусственного интеллекта, Поднебесная рассматривает ИИ как инструмент, позволяющий совершенствовать действующие отрасли, от здравоохранения до энергетики и сельского хозяйства, как инструмент, улучшающий жизнь обычных людей. Для этого ИИ внедряется в производство, логистику, энергетику, финансы и госуслуги. Автопроизводители активно внедряют роботов на заводах с минимальным участием людей, по имеющейся статистике на 2024 год в КНР использовалось впятеро больше промышленных роботов, чем в США. Сельскохозяйственные модели помогают фермерам, в здравоохранении ИИ-инструменты помогают врачам ставить диагнозы и лечить пациентов и др. Даже очень маленькие предприятия изучают возможность использовать ИИ для повышения производительности. В США ИИ-модели тоже внедряются в разные отрасли всё чаще, но основной акцент делается на сервис и обработку информации с применением больших языковых моделей (LLM). Они применяются для обработки неструктурированных данных и автоматизации коммуникаций. Например, банками используются помощники на основе LLM для помощи в управлении счетами пользователей и обработки их рутинных запросов, LLM помогают врачам извлекать ключевые данные из медицинских записей и клинической документации. По словам отраслевых экспертов, LLM больше подходят для экономики США, ориентированной на сферу услуг, чем для китайской индустриальной экономики. Конечно, Китай и США конкурируют в некоторых областях, связанных с ИИ, в частности, касающихся разработки и производства полупроводников для обеспечения работы искусственного интеллекта. Также обе страны стремятся обрести контроль над цепочками поставок для обеспечения национальной безопасности. Китай, безусловно, стремится избавиться от зависимости от американских чипов. Важной сферой для конкуренции является ИИ для военного применения, поскольку та или иная сторона может получить преимущества в плоскости отдельных военных технологий. При этом Китай всё ещё не подобрал «фаворита» для военного и промышленного сектора. После триумфального дебюта DeepSeek в 2025 году, главный получатель средств для разработки «общего искусственного интеллекта» так и не выбран, а вкладывать все средства в AGI страна, похоже, не планирует, поскольку это слишком рискованно. На деле американские и китайские компании до сих пор сотрудничают, несмотря на постепенное «разделение» экономик двух стран. Фактически, по мнению Сюй, для создания безопасного и заслуживающего доверия ИИ было бы лучше, чтобы исследователи и политики США и КНР наладили диалог и достигли консенсуса относительно того, что запрещено, а потом конкурировали бы в этих рамках. В концепции «гонки вооружений» упускается из виду реальная ситуация на местах, обмен опытом между компаниями, обмен научными данными, переток талантов с одного рынка на другой и то, насколько тесно переплетены экосистемы двух стран в целом.

20.02.2026 [22:30], Владимир Мироненко

Не $100 млрд, а $30 млрд, и не выиграл, а переиграл — NVIDIA и OpenAI готовят новую инвестиционную сделкуМноголетняя сделка между NVIDIA и OpenAI, в рамках которой производитель ИИ-ускорителей обязался инвестировать в разработчика ИИ-моделей $100 млрд, так и не была подписана. Вместо неё компании готовят более простую схему с инвестициями NVIDIA в акционерный капитал OpenAI в размере $30 млрд в обмен на её акции, сообщил ресурс The Financial Times. По данным источников The Financial Times, переговоры по этому поводу находятся на завершающей стадии, решение может быть принято уже в эти выходные. Инвестиции NVIDIA в акционерный капитал OpenAI в размере $30 млрд являются частью более крупного раунда финансирования, который, как ожидается, позволит OpenAI привлечь более $100 млрд с оценкой её рыночной стоимости в $730 млрд, не считая новых средств, сообщили источники. OpenAI реинвестирует большую часть нового капитала в оборудование NVIDIA, но компании откажутся от прежней сделки на $100 млрд, о которой было объявлено в сентябре, добавили источники. По словам источников, это финансирование поддержит создание новых вычислительных мощностей и, вероятно, со временем приведет к заключению новых сделок. Как отметил ресурс eWeek, на практике ничего не поменяется: OpenAI по-прежнему нуждается в огромных вычислительных мощностях, а NVIDIA по-прежнему находится в центре цепочки поставок оборудования, обеспечивающей работу современной экономики ИИ. Меняется лишь то, как формируются риски, сроки и обязательства. Ранее руководители OpenAI и NVIDIA попытались развеять слухи об охлаждении отношений между их компаниями в связи с замораживанием сделки на $100 млрд. «Нам нравится работать с NVIDIA, и они производят лучшие в мире чипы для ИИ. Мы надеемся оставаться их ключевым клиентом очень долгое время», — заявил генеральный директор OpenAI Сэм Альтман (Sam Altman). Следом глава NVIDIA Дженсен Хуанг (Jensen Huang) заявил CNBC, что любые предположения о «спорах» — это «ерунда». «Нам нравится работать с OpenAI», — сказал он. Тем не менее, OpenAI подписала в начале года крупную сделку с Cerebras и уже начала использовать её царь-чипы. Кроме того, у OpenAI есть и сделка с AMD. По словам источников The Financial Times, OpenAI также находится на заключительном этапе переговоров с SoftBank по поводу инвестиций около $30 млрд, и Amazon, которая может инвестировать до $50 млрд в рамках более широкого партнёрства, предполагающего использование ИИ-моделей GPT. Ожидается, что MGX, государственный инвестиционный фонд Абу-Даби в сфере технологий, и Microsoft также инвестируют крупные суммы, а руководители OpenAI на этой неделе встречаются с венчурными капиталистами и другими инвесторами по поводу дальнейших инвестиционных проектов, добавили источники.

20.02.2026 [16:55], Руслан Авдеев

OpenAI и Tata договорились о строительстве 1 ГВт ИИ ЦОД в ИндииИндийские Tata Group, Tata Consultancy Services (TCS) и OpenAI анонсировали новое стратегическое партнёрство. Подразделение HyperVault компании TCS и OpenAI займутся строительством ИИ-инфраструктуры в Индии, сообщает Datacenter Dynamics. Многолетнее партнёрство предусматривает реализацию совместного проекта в несколько этапов. Для начала TCS построит ИИ-инфраструктуру на 100 МВт, в будущем возможно её масштабирование до 1 ГВт. По словам главы OpenAI Сэма Альтмана (Sam Altman), Индия уже является лидером по внедрению искусственного интеллекта. С её талантами, амбициями и сильной правительственной поддержкой у неё очень хорошие позиции для того, чтобы самой творить своё будущее. OpenAI при сотрудничестве с Tata Group работают над строительством инфраструктуры, подготовкой специалистов и заключением локальных соглашений для создания «ИИ с Индией, для Индии и в Индии» таким образом, что многие люди в стране смогут получить доступ к ИИ-инструментам и получать от этого выгоду. Создание ЦОД HyperVault анонсировали в ходе квартального отчёта в прошлом октябре. В планах значится постройка в стране дата-центров Stargate с жидкостным охлаждением общей мощностью 1 ГВт. В предприятие инвестировала частная инвестиционная компания TPG. Как заявляют в Tata, глубокое сотрудничество между OpenAI и Tata Group знаменует важную веху в планах Индии по превращению в глобального лидера в сфере искусственного интеллекта с подготовкой местной молодёжи для преуспевания в новую эру. Согласно договорённости, сотрудники Tata получат доступ к корпоративной версии бота OpenAI — Enterprise ChatGPT. Кроме того, компании будут совместно разрабатывать специальные ИИ-решения. Ранее HyperVault заявляла, что будет применять ускорители AMD на своих объектах, OpenAI также ранее обязалась внедрить оборудование на основе решений AMD. Помимо аренды больших облачных мощностей у гиперскейлеров, OpenAI строит и собственные дата-центры в разных локациях мира в рамках инициативы Stargate. Компания рассчитывает на объекты в многочисленных городах США, а также на локации в Норвегии, Великобритании, ОАЭ и Южной Корее. Имеются планы строительства ЦОД в Аргентине и Канаде. Слухи о том, что OpenAI рассматривает Индию для реализации своих проектов, появились в сентябре 2025 года.

20.02.2026 [15:59], Сергей Карасёв

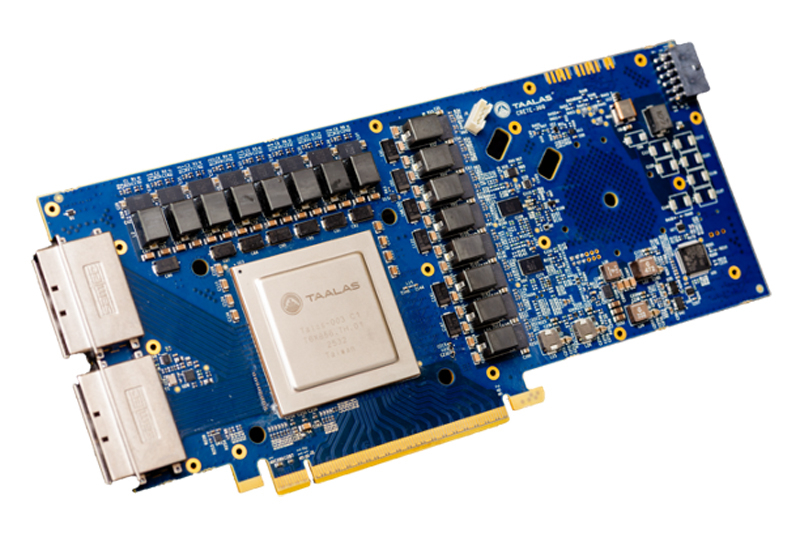

Узкие специалисты: Talaas, разрабатывающая оптимизированные под конкретные ИИ-модели ускорители, получила на развитие $169 млнСтартап Taalas, разрабатывающий чипы, специально оптимизированные для работы с конкретными ИИ-моделями, провел раунд финансирования на сумму в $169 млн. В число инвесторов вошли Quiet Capital и Fidelity, а также венчурный капиталист Пьер Ламонд (Pierre Lamond). Таким образом, на сегодняшний день компания получила на развитие в общей сложности более $200 млн. Фирма Taalas вышла из крытого режима (stealth mode) в марте 2023 года. Стартап занимается созданием чипов, предназначенных для определённых LLM. Первым продуктом компании стало изделие, ориентированное на ИИ-модель Llama 3.1 8B. Утверждается, что этот процессор способен генерировать до 17 тыс. выходных токенов в секунду, что в 73 раза больше по сравнению с NVIDIA H200. При этом решение Taalas потребляет в 10 раз меньше энергии.

Источник изображения: Taalas Оптимизация аппаратных ускорителей под конкретную ИИ-модуль повышает производительность и эффективность благодаря отказу от избыточных компонентов. Однако разработка таких узкоспециализированных изделий представляет собой сложный и дорогостоящий процесс. Компании Taalas удалось решить проблему, создав архитектуру, при которой для «тонкой» настройки требуется кастомизация только двух из более чем 100 слоев, из которых состоят её чипы. Кроме того, Taalas не использует в своих изделиях дорогостоящую память HBM. Это также упрощает конструкцию, позволяя упразднить компоненты, которые необходимы для обеспечения взаимодействия с HBM-модулями. В настоящее время Taalas работает над чипом, предназначенным для запуска ИИ-модели Llama с 20 млрд параметров: выпуск этого решения намечен на лето нынешнего года. Затем появится более мощный чип, ориентированный на LLM высокого уровня.

20.02.2026 [15:23], Владимир Мироненко

Anthropic планирует увеличить к 2029 году расходы на облака до $80 млрдК 2029 году затраты на облачные сервисы ИИ-стартапа Anthropic, согласно его собственным прогнозам, достигнут $80 млрд, сообщил ресурс The Information со ссылкой на свои источники. Расходы будут распределены между Google, Microsoft и Amazon. Помимо оплаты аренды серверов для моделей Claude, Anthropic также делится с облачными провайдерами частью прибыли от продаж своих ИИ-сервисов на их платформах. The Information сообщил со ссылкой на данные стартапа, что в 2024 году эта сумма составила $1,3 млн, и, согласно «самым оптимистичным прогнозам» ресурса, в 2025 году она составила $360 млн, в 2026 году вырастет до $1,9 млрд, а в 2027 году — до $6,4 млрд. Также, по словам источника, Anthropic отчисляет клиентам до 50 % своей валовой прибыли от продаж ИИ-решений на AWS, рассчитываемой на основе выручки за вычетом расходов на облачные ресурсы. Для сравнения, Google обычно получает от 20 % до 30 % чистой выручки после вычета затрат на инфраструктуру от перепродажи ПО своих партнёров. Как утверждает генеральный директор Anthropic Дарио Амодеи (Dario Amodei), компания тратит меньше средств на вычислительные мощности ЦОД по сравнению с другими компаниями в сфере ИИ. Он отметил, что чрезмерные расходы могут быть «разорительными» в случае, когда выручка не гарантирована. Anthropic давно пользуется услугами Google Cloud, и в октябре прошлого года заключила сделку, обеспечивающую ей доступ к облачным ресурсам провайдера мощностью более 1 ГВт с возможностью использования до 1 млн TPU от Google. С этим проектом может быть связана сделка Anthropic по поводу $50 млрд инвестиций в вычислительную инфраструктуру в США в сотрудничестве с Fluidstack. Кроме того, у Anthropic очень тесные отношения с AWS, которая много инвестировала в стартап и развернула для него один из крупнейших в мире ИИ-кластеров Project Rainier. Наконец, в прошлом году компания подписала крупное соглашение с Microsoft Azure.

19.02.2026 [17:07], Владимир Мироненко

Humain из Саудовской Аравии инвестировала $3 млрд в стартап xAI Илона МаскаКомпания Humain из Саудовской Аравии объявила об инвестициях в размере $3 млрд в стартап xAI Илона Маска (Elon Musk) в рамках раунда финансирования серии E на общую сумму в $20 млрд, который завершился незадолго до приобретения стартапа компанией SpaceX. Humain заявила, что в результате сделки стала «значительным миноритарным акционером» xAI. Её активы будут конвертированы в акции SpaceX — примерно 0,24 % в новой объединённой компании стоимостью $1,25 трлн, согласно оценкам Bloomberg. Humain отметила, что участие в раунде серии E укрепляет её роль как масштабного, долгосрочного стратегического инвестора, способного поддерживать компании на разных этапах роста, предоставляя при этом комплексные возможности ИИ в четырёх основных областях: дата-центры следующего поколения; высокопроизводительная инфраструктура и облачные платформы; передовые ИИ-модели; трансформационные решения в области ИИ. Инвестиции являются продолжением партнёрства, объявленного Humain и xAI в ноябре 2025 года, в рамках которого компании договорились о строительстве инфраструктуры ИИ-ЦОД мощностью 500 МВт. Ранее Humain создала совместное предприятие с AMD и Cisco для наращивания мощностей дата-центров в Саудовской Аравии. Также Humain заявила о партнёрстве с AWS с целью развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей для предоставления в дальнейшем вычислительных мощностей и ИИ-сервисов из Саудовской Аравии клиентам со всего мира. Как отметил Bloomberg, суверенные фонды Кувейта, Катара, Саудовской Аравии и ОАЭ, контролирующие более $4 трлн, сделали ИИ центральным элементом диверсификации экономики своих стран, ставших ключевыми игроками в ИИ-отрасли, готовой изменить многие аспекты повседневной жизни.

19.02.2026 [15:57], Руслан Авдеев

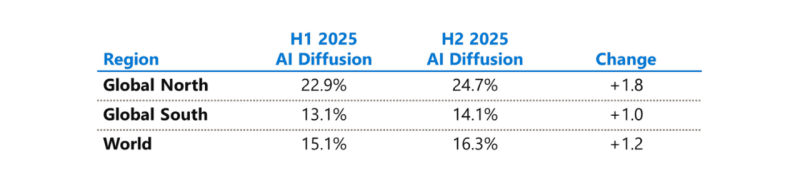

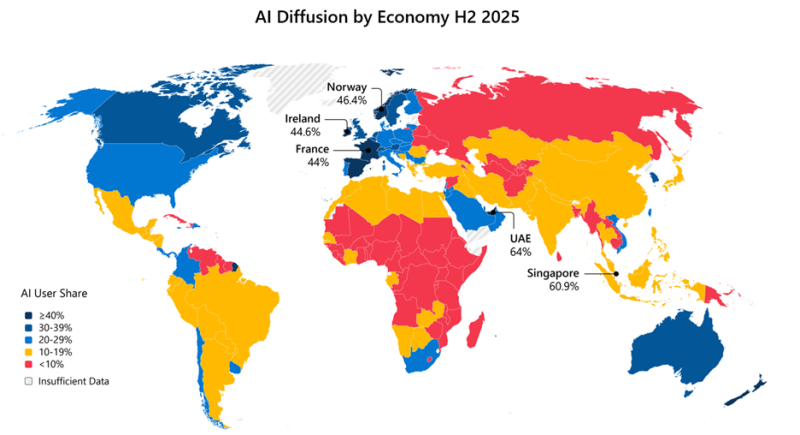

Microsoft бросилась исправлять ИИ-неравенство в мире и выделила на это $50 млрдНа недавнем мероприятии India AI Impact Summit представители Microsoft объявили, что компания готовится инвестировать к концу десятилетия $50 млрд для того, чтобы обеспечить доступ к ИИ странам Глобального Юга. Технологии искусственного интеллекта стремительно распространяются, но чрезвычайно неравномерно в мировом масштабе. В докладе Microsoft AI Diffusion Report утверждается, что в странах Глобального Севера ИИ используется вдвое активнее, чем на юге, и неравенство продолжает увеличиваться. Это сказывается не только на национальном и региональном экономическом росте, но и перспективах развития. Более века неравный доступ к электроэнергии увеличивал экономический разрыв между Глобальным Севером и Югом. С ИИ может произойти аналогичная история. Потребности в новых технологиях требуют существенных инвестиций и больших усилий правительств, частного сектора и НКО. Выделенные Microsoft $50 млрд призваны поддержать новые возможности в странах Глобального Юга. Программа развития ИИ состоит из пяти элементов:

Инфраструктура жизненно необходима для распространения ИИ, говорит компания. ИИ требует энергии, каналов связи, вычислительных мощностей. Только в последнем финансовом году Microsoft инвестировала более $8 млрд в инфраструктуру ЦОД, обслуживающую Глобальный Юг, включая Индию, Мексику, страны Африки, Южной Америки, Юго-Восточной Азии и Ближнего Востока. В первую очередь компания стремится расширить доступ в интернет 250 млн человек в макрорегионе. Microsoft заявила, что уже помогла получить доступ в интернет 117 млн человек в Африке. Инвестиции в ИИ-инфраструктуру осуществляются с учётом необходимости обеспечения местного суверенитета, хотя не так давно компания объявила, что не может обеспечить суверенитет данных в Европе из-за особенностей американского законодательства. Microsoft заявила о создании суверенного управления в публичных облаках, частных суверенных предложениях и тесном сотрудничестве с национальными партнёрами на местах. Утверждается, что в эру ИИ вся информация остаётся в руках клиентов под их полным контролем, без передачи сторонним провайдерам. При этом Глобальный Юг требует огромных инвестиций в инфраструктуру ЦОД, энергетику и связь, что крайне затруднительно без зарубежных инвестиций, в том числе со стороны техногигантов. В числе прочего для удовлетворения этих потребностей было сформировано партнёрство Trusted Tech Alliance, объединяющее 16 ведущих технологических компаний из 11 стран с четырёх континентов.

Источник изображения: Microsoft Однако ЦОД и интернет-каналы — лишь часть необходимой инфраструктуры. Не меньшее значение имеет доступ к технологиям для школ, университетов и НКО и цифровым компетенциям. В предыдущем финансовом году Microsoft инвестировала в программы для государств Глобального Юга $2 млрд, включая гранты, пожертвования, льготы и обучающие программы. В 2025 году компания запустила инициативу Microsoft Elevate, призванную к 2028 году подготовить 20 млн дипломированных специалистов с востребованными ИИ-компетенциями. В Индии компания обучила уже 5,6 млн человек, а к 2030 году намерена довести это число до 20 млн. Компания подготовит 2 млн учителей из более 200 тыс. школ и вузов, а также оснастит 25 тыс. учебных учреждений ИИ-инфраструктурой. Ещё одно направление — создание и доработка ИИ-моделей на местных языках, поскольку локальные решения пока что хуже, чем решения на английском языке. Microsoft поддержала инвестиции в инициативу LINGUA Africa (выделено $5,5 млн) по сбору языковых данных и развитие моделей для африканских языков. Дополнительно совершенствуется бенчмарк MLCommons AILuminate для индийских и азиатских языков для оценки безопасности ИИ вне англоязычной среды. Совместно с образовательными и коммерческими структурами из Индии, Японии, Кореи и Сингапура при участии Microsoft создаётся мультиязычная и мультимодальная подборка из 7 тыс. высококачественных промптов для хинди, тамильского, малайского, японского и корейского языков. Также Microsoft развивает метод Samiksha для учёта локальных языковых и культурных контекстов. Samiksha позволяет выявлять сбои, которые часто упускаются «англоцентричными» методами оценки. В Африке компания совместно с NASA, властями и др. организациями будет применять ИИ к спутниковым данным для анализа продовольственной ситуации. Технология уже отработана в Индии. В рамках Project Gecko компания развивает ИИ-технологии совместно с сообществами в Восточной Африке и Южной Азии для поддержки с/х. В том числе речь идёт о семействе моделей для распознавания речи Paza, способных работать на мобильных устройствах с шестью кенийскими языками. Ведутся работы над многоязыковыми инструментами Copilot, Multimodal Critical Thinking (MMCT) Agent для анализа видео с учётом голоса и текста, адаптацией LLM к низкоресурсным языкам (в т.ч. чичева, инуктитут, маори) и т.д.

Источник изображения: Microsoft Для ускоренного внедрения ИИ нужно понимать, где и как применяется ИИ, с каким недостатками приходится сталкиваться разработчикам, говорит Microsoft. На основе статистики публичных репозиториев GitHub и метрик Azure Foundry компания участвует в создании «рейтинга» Global AI Adoption Index Всемирного Банка. Например, индийское сообщество из 24 млн разработчиков — второе по величине на GitHub и самое быстрорастущее среди 30 ведущих экономик. С 2020 года ежегодный прирост составляет более 26 %, в 2025 году он составил более 36 %. Индийские специалисты занимают второе место в мире по вкладу в open source, использованию GitHub Education, по вкладу в публичные ИИ-проекты и др. Такие данные помогают точнее направлять инвестиции в инфраструктурные проекты, языковые технологии и на обучение. Поддержка подобных метрик помогает измерять достигнутый прогресс. Microsoft подчёркивает, что компания акцентирует внимание в вопросах внедрения ИИ на необходимости создания доступной инфраструктуры, надёжно работающих в реальном мире системах, а также технологиях, которые могут применяться с учётом местных условий. Для этого компания намерена работать с партнёрами, включая обмен данными для оценки прогресса.

19.02.2026 [15:11], Андрей Крупин

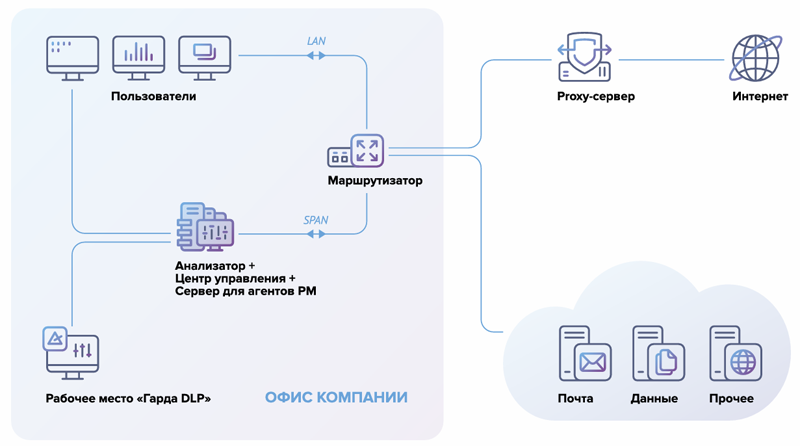

Система «Гарда DLP» получила расширенные средства контроля каналов обмена даннымиКомпания «Гарда» (входит в «ИКС Холдинг») сообщила о выпуске обновлённого решения для защиты данных «Гарда DLP» 6.4. Программный комплекс «Гарда DLP» позволяет видеть полную картину коммуникаций в организации, блокирует передачу конфиденциальных документов, помогает выявлять признаки корпоративного мошенничества и автоматизировать выявление инцидентов. Система поддерживает работу с платформами Windows, macOS, Linux, обеспечивает контроль 20+ каналов коммуникаций и мониторинг шифрованного HTTPS-трафика, предоставляет единую веб-консоль для управления включёнными в состав продукта инструментами, а также помогает привести IT-инфраструктуру в соответствие требованиям 152-ФЗ, 21 и 17 приказов ФСТЭК. Продукт зарегистрирован в реестре отечественного ПО и подходит для задач импортозамещения.

Принцип работы «Гарда DLP» (источник изображения: garda.ai) В новой версии DLP-системы реализован контроль возможных утечек при помощи браузерной версии Telegram через технологию OCR (то есть за счёт распознавания текста и файлов на рабочем компьютере пользователя), усилена аналитика по действиям сотрудников и добавлена функция перехвата паролей в офисных документах и архивах.

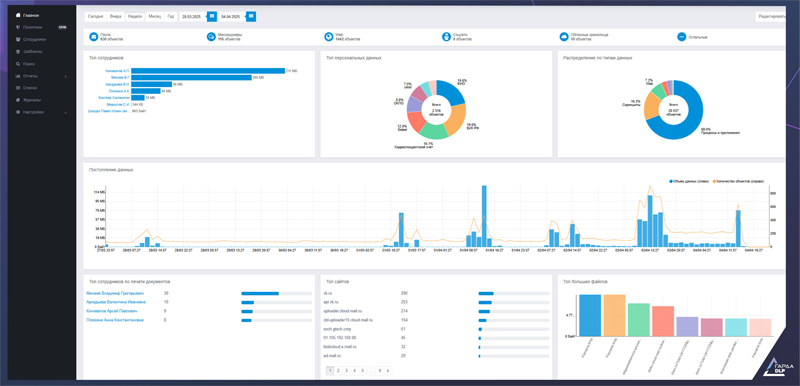

Пользовательский интерфейс «Гарда DLP» (источник изображения: garda.ai) Чтобы облегчить выполнение требований регуляторов для финансовых компаний, в обновлённой редакции «Гарда DLP» добавлены встроенные политики безопасности по отраслевым стандартам. Они позволяют регистрировать угрозы, которые описаны в PCI DSS и ГОСТ Р 57580 сразу после установки и запуска системы. Кроме того, разработчики внедрили в продукт полноценную событийно-инцидентную модель в соответствии с ГОСТ Р ИСО/МЭК ТО 18044-2007 по менеджменту инцидентов, единую для всех продуктов защиты данных «Гарды». В системе появились новые сущности — «Угроза» и «Уровень критичности», которые автоматически присваиваются событиям безопасности. Такая градация упрощает приоритизацию и создаёт более точную картину рисков: за большим количеством зафиксированных нарушений можно увидеть реальное число критичных инцидентов. |

|