Материалы по тегу: ии

|

19.02.2026 [12:50], Сергей Карасёв

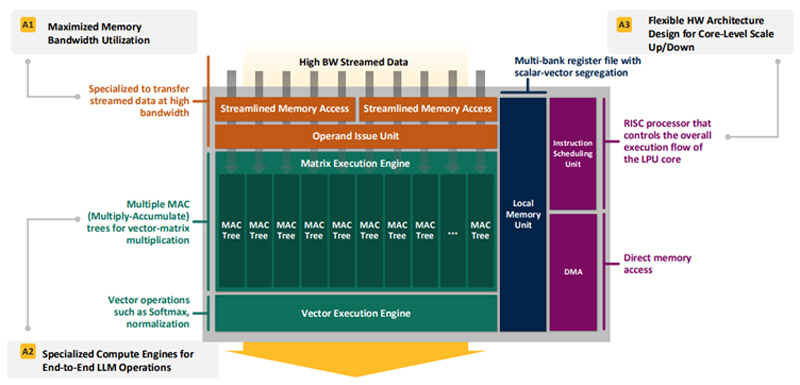

Впятеро энергоэффективнее H100: HyperAccel разработала экономичный чип Bertha 500 для ИИ-инференсаЮжнокорейский стартап HyperAccel, по сообщению EETimes, готовится вывести на рынок специализированный чип Bertha 500, предназначенный для ИИ-инференса. Утверждается, что благодаря особой архитектуре изделие способно генерировать в пять раз больше токенов в секунду по сравнению с решениями на основе GPU при том же уровне TOPS. В Bertha 500 упор сделан на экономическую эффективность. С этой целью используется память LPDDR вместо дорогостоящей HBM. При этом благодаря отказу от традиционной иерархии памяти достигается утилизация пропускной способности LPDDR на 90 %. Дальнейшее повышение эффективности обеспечивается путём оптимизации архитектуры именно для задач инференса. Для сравнения, как утверждает HyperAccel, в случае GPU при инференсе используется только около 45 % пропускной способности памяти и 30 % вычислительных ресурсов. Иными словами, немного жертвуя производительностью, чип Bertha 500 позволяет достичь значительного снижения стоимости. Изделие Bertha 500 будет производиться по 4-нм техпроцессу Samsung. В состав чипа входят 32 ядра LPU (LLM Processing Unit), четыре ядра Arm Cortex-A53 и 256 Мбайт SRAM. Подсистема памяти LPDDR5x использует восемь каналов; пропускная способность достигает 560 Гбайт/с. Заявленная ИИ-производительность на операциях INT8 составляет 768 TOPS. Кроме того, поддерживаются другие 16-, 8- и 4-бит форматы, включая FP16. В целом, по заявлениям HyperAccel, пропускная способность Bertha 500 в расчёте на доллар примерно в 20 раз выше по сравнению с NVIDIA H100, тогда как энергоэффективность больше в пять раз. Чип Bertha 500 будет потреблять около 250 Вт.

Источник изображения: EETimes Программный стек HyperAccel поддерживает все модели из репозитория HuggingFace. Кроме того, компания работает над предметно-ориентированным языком (DSL) под названием Legato, который предоставит разработчикам низкоуровневый доступ к системе. Образцы Bertha 500 появятся к концу I квартала 2026 года, а серийное производство планируется организовать в начале 2027 года. Отмечается также, что совместно с LG стартап разрабатывает «урезанную» версию Bertha 500 для периферийных устройств — Bertha 100. Эта SoC получит ядра Arm Cortex-A55 и отдельные компоненты LG, а также два канала памяти LPDDR5x. Среди возможных сфер применения названы автомобильная промышленность, бытовая электроника и робототехника. Bertha 100 планируется выпускать в виде модулей M.2: первые изделия выйдут в IV квартале текущего года. Решение сможет, например, осуществлять преобразование текста в речь или речи в текст. Стартап HyperAccel основан профессором Корейского института передовых технологий (KAIST) Джуёном Кимом (Jooyoung Kim) вместе с группой его студентов в начале 2023 года. На сегодняшний день компания привлекла $45 млн инвестиций, а её рыночная стоимость оценивается в $200 млн. Штат насчитывает около 80 человек. Первым продуктом HyperAccel стал специализированный сервер Orion на базе FPGA, предназначенный для решения ИИ-задач.

19.02.2026 [12:26], Сергей Карасёв

«НВБС» представила российские серверы «Необайт» на платформах Intel и AMDКомпания «НВБС», российский системный интегратор и производитель технологических решений, анонсировала собственные серверы семейства «Необайт». Дебютировали модели NeoByte NBR220 и NeoByte NBR680 на аппаратной платформе Intel, а также NeoByte NBR685 с процессорами AMD. По словам компании, новинки «сопоставимы с решениями ведущих компаний на рынке, но при этом в среднем стоят на 10–15 % дешевле за счёт широкого пула поставщиков и оптимизированной логистики». Система NeoByte NBR220 типоразмера 2U может нести на борту два чипа Intel Xeon Sapphire Rapids или Emerald Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-4800. В зависимости от конфигурации во фронтальной части возможна установка 12 накопителей LFF/SFF или 24 устройств SFF с интерфейсом SATA/SAS/NVMe. В тыльной зоне корпуса расположены посадочные места ещё для четырёх накопителей LFF/SFF (SATA/SAS/NVMe), тогда как внутри есть два коннектора для SSD формата M.2 (SATA/NVMe). Реализована поддержка до 10 стандартных слотов PCIe и одного слота OCP 3.0. В оснащение входят контроллер AST2600, два сетевых порта 1GbE, выделенный сетевой порт управления 1GbE, четыре порта USB 3.0 (по два спереди и сзади), два интерфейса D-Sub (по одному спереди и сзади) и последовательный порт. Питание обеспечивают два блока с резервированием мощностью 800/1300/1600/2000 Вт. Сервер оптимизирован для ИИ-задач, виртуализации, баз данных и файловых хранилищ. Платформа практически идентична представленным ранее серверам «Аквариус» AQserv T50 D224RS и T50 D212RS. Модель NeoByte NBR680 стандарта 6U имеет аналогичные характеристики подсистем CPU, ОЗУ, хранения данных и интерфейсов ввода/вывода. При этом возможна установка до восьми GPU-ускорителей двойной ширины. Есть пять стандартных слотов PCIe и один слот OCP; передняя панель поддерживает до трёх стандартных слотов PCIe и один слот OCP. Мощность каждого из двух блоков питания — 2700 или 3200 Вт. Машина предназначена для научных исследований и крупных ИИ-проектов. В свою очередь, GPU-сервер NeoByte NBR685 формата 6U рассчитан на два процессора AMD EPYC 9005 Turin или EPYC 9004 Genoa с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-4800. Прочие характеристики идентичны версии NeoByte NBR680, включая поддержку восьми GPU-ускорителей двойной ширины. Система подходит для анализа больших данных в реальном времени, криптографии и блокчейна. Все новинки могут быть опционально укомплектованы контроллером SAS RAID/HBA. Заявлена совместимость с Windows Server 2022 SLES 12.5 и выше, RHEL7.8 и выше, Ubuntu18.04 и выше, CentOS7.6 и выше, Vmware ESXi 7.0 GA и выше. Гарантия производителя достигает пяти лет. Также «НВБС» говорит, что «не зависит от санкций, что снижает риски ограничения поставок».

19.02.2026 [10:22], Андрей Крупин

«Группа Астра» и «Банк ПСБ» создадут центр ИБ-компетенций и разработки доверенных отраслевых решений«Группа Астра» и «Банк ПСБ» заключили соглашение о сотрудничестве в сфере информационной безопасности. Подписанный «Группой Астра» и «Банком ПСБ» документ предполагает создание совместного предприятия, деятельность которого будет сосредоточена на реализации комплекса мер в области защиты информационных активов и цифровых процессов. Приоритетными направлениями станут развёртывание и эксплуатация единой сервисной платформы для централизованного предоставления ИБ-услуг, в том числе для дочерних компаний финансовой организации. Параллельно будут идти разработка и вывод на рынок линейки специализированных решений для наращивания безопасности IT-систем: различных сервисов, платформенных и программно-аппаратных комплексов.

Источник изображения: пресс-служба «Группы Астра» / astra.ru «Мы уверены, что вместе с коллегами достигнем качественного прорыва в обеспечении информационной безопасности, объединив экспертизу в сфере защиты финансовых систем и передовые отечественные технологии. Создание совместного предприятия станет не только инструментом минимизации операционных рисков, но и точкой роста для стратегической перспективы: мы планируем сформировать самодостаточную экосистему, способную задавать отраслевые стандарты киберустойчивости, стать драйвером для развития смежных направлений и укрепить позиции российских решений в высокотехнологичном сегменте», — говорится в заявлении «Группы Астра».

19.02.2026 [09:52], Владимир Мироненко

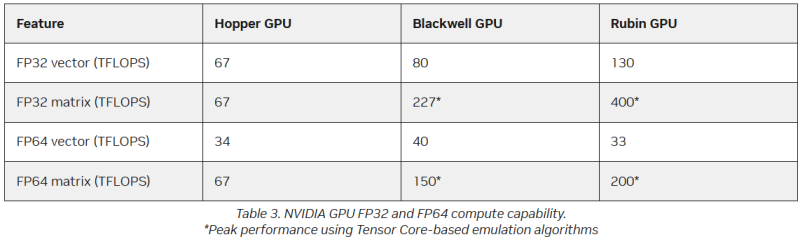

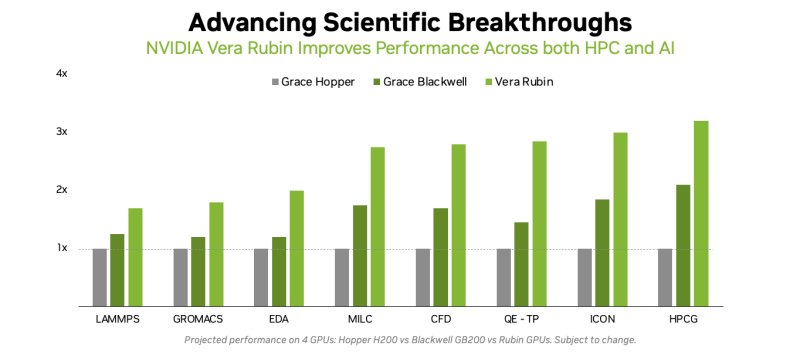

Американская «Миссия Генезис» будет во многом полагаться на «ненастоящие» FP64-вычисленияХотя последнее поколение GPU ориентировано на вычисления с более низкой точностью, которые предпочтительны для ИИ-задач, FP64-вычисления с более высокой точностью по-прежнему «очень важны» для «Миссии Генезис» (Genesis Mission) и её цели — ускорения научных открытий с помощью ИИ, заявил заместитель министра энергетики США по науке и инновациям Дарио Гил (Darío Gil) в интервью HPCwire. «В ходе обсуждений, которые я провел как с [генеральным директором AMD] Лизой Су (Lisa Su), так и с [генеральным директором NVIDIA] Дженсеном [Хуангом] (Jensen Huang), они выразили твёрдую приверженность FP64, подтвердив, что поддержка формата будет продолжаться, — сказал Гил. — Для нас это очень важно, потому что мы не рассматриваем это как замену. Это взаимодополняющие технологии». Он отметил, что для обеспечения вычислительных задач моделирования и симуляции, которые традиционно составляют основу научных вычислений, а также для новых методов ИИ, важно иметь высокопроизводительное оборудование. Гил добавил, что эти два типа вычислений будут работать вместе, чтобы поддержать цель миссии Genesis — расширение границ науки и техники на основе ИИ-технологий. «У вас есть высокоточные симуляционные коды, работающие с FP64. После проверки вы используете их в качестве основы для генерации примеров, на которых вы обучаете суррогатную модель, которую затем запускаете на ИИ-суперкомпьютере, — рассказал Гил. — В итоге вы получаете преимущества с точки зрения производительности и времени решения, часто в 10, 20, 100 раз». Он отметил, что благодаря использованию ИИ-моделей можно получить громадное повышение производительности, но оно зависит от сохранения всего цикла работ, состоящего из экспериментов, моделирования и обучения. «Если вы разорвёте этот цикл и скажете, что у вас больше нет кодов моделирования, то возникнет проблема», — сказал Гил. «Для нас это имеет фундаментальное значение, не только для устаревших кодов, которые мы должны сопровождать и которые так важны для миссии, но и для обеспечения рабочего ИИ-процесса. Поэтому для нас очень важно поддерживать различные архитектурные подходы», — добавил он. В HPC-сообществе возникла обеспокоенность по поводу отсутствия прироста производительности для FP64 в новейших GPU. Напомним, что чип NVIDIA H100, выпущенный в 2022 году, обеспечивает 67 Тфлопс в формате FP64 на тензорных ядрах (34 Тфлопс в векторных вычислениях), в то время как B200 предлагает лишь 37 Тфлопс, а B300 — всего лишь 1,3 Тфлопс. Программная эмуляция FP64-вычислений на тензорных ядрах Blackwell позволяет получить «нечестные» 150 Тфлопс, а из новейших Rubin она позволяет «выжать» 200 Тфлопс. При этом пиковая заявленная производительность векторных FP64-вычислений у Rubin составляет лишь 33 Тфлопс, т.е. нет никакого прироста в сравнении с Hopper. Отметим, что в AMD раскритиковали такой подход, заявив, что он эффективен не для всех сценариев и поэтому такое решение ещё не готово к широкому применению. В свою очередь, эксперты предупреждают, что смещение фокуса производителей на выпуск чипов для ИИ-нагрузок, которые отлично работают с вычислениями с низкой точностью, может привести к дефициту чипов с поддержкой FP64 для HPC, а это грозит потерей лидерства США в этом сегменте рынка. По мере того, как NVIDIA наращивает мощность для выполнения ИИ-задач с низкой точностью вычислений Rubin, компания будет всё больше полагаться на cuBLAS, библиотеку стандартных математических операций CUDA-X, которая эмулирует вычисления с двойной точностью на тензорных ядрах, чтобы постоянно наращивать показатели FP64-производительности. «Мы пытаемся предоставить эти возможности среде разработчиков, чтобы они могли… получить необходимую точность FP64», — заявил в декабре HPCwire Дион Харрис (Dion Harris), старший директор NVIDIA по ИИ/HPC-решениям для гиперскейлеров. Методы эмуляции NVIDIA основаны на схеме Озаки (Ozaki), позволяющей выполнять умножение матриц с высокой точностью, используя многократные вычисления с низкой точностью на тензорных ядрах. NVIDIA утверждает, что использование алгоритма Озаки оправдано, поскольку увеличение производительности FP64 путём добавления большего количества ядер CUDA фактически не повысит общую производительность HPC-приложений, но сделает чипы менее гибкими. По словам компании, анализ реальных нагрузок показывает, что «наивысшая устойчивая производительность FP64 часто достигается на умножении матриц». В Hopper для этого были отдельные аппаратные блоки, но в Blackwell и в Rubin NVIDIA больше опирается на эмуляцию. В то же время, производительность векторных FP64-вычислений остаётся критически важной для научных приложений, в которых не доминируют матричные ядра, признаёт NVIDIA, однако тут же утверждает, что в этих случаях производительность ограничивается перемещением данных через регистры, кеши и HBM, а не непосредственно вычислительными ресурсами. Поэтому сбалансированная конструкция GPU «обеспечивает достаточное количество ресурсов FP64 для насыщения доступной пропускной способности памяти, избегая избыточного выделения вычислительной мощности, которая не может быть эффективно использована». Иными словам, компания ничего менять не собирается. Проект Genesis Mission, вероятно, будет создавать разнообразные ИИ-приложения для научных и инженерных задач, и каждое из них, скорее всего, будет иметь несколько иные вычислительные потребности. Достигли ли NVIDIA и AMD оптимального баланса, используя вычислительные ядра для матричных вычислений и опираясь на эмуляцию Озаки для FP64, ещё предстоит выяснить, пишет HPCwire.

19.02.2026 [09:05], Руслан Авдеев

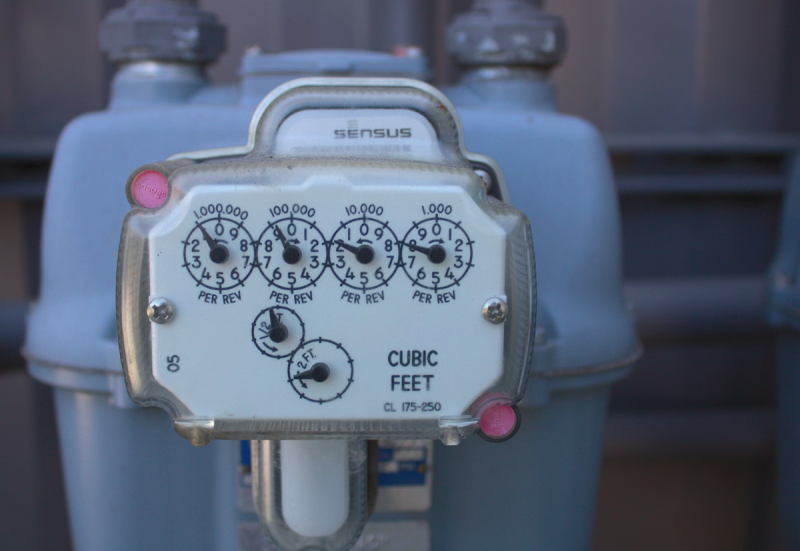

«Грязный» ИИ: ЦОД используют всё больше экологически небезопасных газовых турбинПоскольку дата-центрам нужно всё больше дефицитной энергии, они наращивают использование относительно доступных газовых турбин для компенсации этого дефицита. По некоторым оценкам, такие источники электричества могут добавить 44 млн тонн к выбросам углекислого газа к 2030 году, сообщает The Register. Это приблизительно эквивалентно выбросам 10 млн частных автомобилей. Соответствующие данные предоставила организация Truthout. Проблема в том, что обучение ИИ создало практически неисчерпаемый спрос на вычислительные мощности, что, в свою очередь, вызвало бум строительства дата-центров, требующих подключения к электросетям. В 2025 году Deloitte Insights предупреждала, что в течение десяти лет потребности ИИ ЦОД в электроэнергии только в США могут увеличиться на порядок. Простейший способ решить проблему с дефицитом — использование газотурбинных генераторов, если рядом с ЦОД протянут газопровод, причём инвесторы в ЦОД готовы вкладываться и в строительство газопроводов. Спрос так высок, что газовые турбины оказались в дефиците, в результате некоторые компании занялись переделкой авиационных двигателей коммерческих лайнеров. Отдельные ведомства предлагают переделывать в генераторы списанные двигатели военных самолётов. Boom Supersonic, создающая сверхзвуковые пассажирские самолёты, занялась строительством энергетических турбин на основе двигателя Symphony. Электричеством от собственных газовых генераторов обеспечивает объекты компания Meta✴, мощность кампуса Hyperion в Луизиане должна увеличиться до 5 ГВт, поскольку компания разместила заказ на три крупные газовые электростанции Entergy общей мощностью 2,26 ГВт. Активно пользуется газовыми генераторами компания xAI, не раз оказывавшаяся из-за этого в центре скандалов. Наконец, Microsoft заявляет, что в её структуре энергоснабжения важную роль играет возобновляемая энергетика (особенно в штатах, где много ветра и солнца), но компания вполне допускает использование природного газа в качестве временного решения. Эксперты Gartner предполагают, что операторы ЦОД и вовсе не смогут обеспечить бесперебойное электроснабжение без собственных генерирующих мощностей. Фактически самым вероятным решением станут именно газовые турбины, в полном соответствии с прогнозами Schneider Electric. Всё это соответствует нынешней политике США, готовых использовать для достижения цифрового превосходства даже угольные электростанции. Стремительный рост спроса со стороны ИИ ЦОД стимулирует возобновление выработки электричества на угольных электростанциях. Только в 2025 году эта сфера выросла почти на 20 %. В феврале 2026 года Трамп подписал указ, предписывающий военным и оборонным предприятиям заключать долгосрочные соглашения о закупке электричества с подобными генерирующими компаниями. Ранее представитель Министерства внутренних дел страны заявил, что экзистенциальная угроза для всего мира заключается в проигрыше США в «гонке вооружений» в сфере ИИ, а не в изменении климата. По данным Truthout, наращивают мощности энергетики на природном газе не только в США, хотя Америка на этом рынке является безусловным лидером. По информации издания, в мире реализуются проекты газовой энергетики общей мощностью более 1 ТВт, только за последний год рост составил 31 %. При этом АЭС, включая SMR, которые США тоже продвигают, вряд ли смогут в короткие сроки покрыть весь дефицит в энергии, и даже ослаблений требований ядерной безопасности этому, вероятно, не очень поможет.

18.02.2026 [18:50], Владимир Мироненко

Власти Индии закупят ещё 20 тыс. ускорителей NVIDIA для ускорения развития ИИ в странеНа проходящем в Нью-Дели саммите India AI Impact Summit министр электроники и информационных технологий Индии Ашвини Вайшнау (Ashwini Vaishnaw) заявил, что Индия расширит свои вычислительные мощности для ИИ-нагрузок свыше имеющихся 38 тыс. ускорители, добавив еще 20 тыс. еди. в ближайшее время в рамках программы «Миссия ИИ 2.0». Вайшнау сообщил ресурсу EE Times, что заказы на новые GPU будут размещены в течение недели, и ожидается, что они будут развёрнуты в течение следующих шести месяцев. Расширение вычислительных мощностей происходит в ходе реализации рамочного соглашения между Индией и США на 2026 год, в соответствии с которым две страны договорились значительно увеличить торговлю технологическими продуктами, включая ускорители и другие компоненты для ЦОД. Соглашение предусматривает намерение Индии закупить в течение пяти лет американские энергоносители, самолёты, технологические товары и критически важные материалы на сумму $500 млрд, расширяя при этом совместное технологическое сотрудничество. Заявление Вайшнау говорит о дальнейшем развитии программы IndiaAI Mission, утверждённой в марте 2024 года с бюджетом около $1,14 млрд на пять лет. Первоначально программой планировалось развёртывание 10 тыс. GPU, но их количество уже достигло 38 тыс. Ускорители предоставляются местным компаниям по субсидированной ставке ₹65/час (около $0,72/час). С момента запуска в рамках программы IndiaAI Mission разрабатывались семь основных направлений, включая субсидированные вычислительные ресурсы, разработку базовых моделей, финансирование стартапов и безопасное управление ИИ. Двенадцать стартапов уже были отобраны для разработки отечественных многомодальных базовых моделей с использованием специфических для Индии наборов данных. NVIDIA сообщила о поддержке приоритетов IndiaAI Mission, включая, расширение вычислительных мощностей благодаря поставке ускорителей NVIDIA, разработку передовых ИИ-моделей и исследования и инновации в области ИИ. В рамках программы IndiaAI Mission компания сотрудничает с поставщиками облачных услуг Yotta, L&T и E2E Networks для создания передовых ИИ-фабрик. Yotta — поставщик облачных услуг, создающий крупномасштабную суверенную ИИ-инфраструктуру для Индии под брендом Shakti Cloud, работающую на базе более чем 20 тыс. ускорителей NVIDIA Blackwell Ultra. Его кампусы в Нави Мумбаи (Navi Mumbai) и Большой Нойде (Greater Noida) предоставляют индийским предприятиям и госсектору услуги облачных ИИ-сервисов с высокой пропускной способностью и большим количеством GPU с оплатой по мере использования. В свою очередь, компания E2E Networks создаёт кластер ускорителей NVIDIA Blackwell на своей платформе TIR, размещённый в ЦОД L&T Vyoma в Ченнаи (Chennai). Облачная платформа TIR будет включать системы NVIDIA HGX B200 и корпоративное ПО NVIDIA, а также открытые модели NVIDIA Nemotron для ускорения развития ИИ в таких областях, как агентный ИИ, здравоохранение, финансы, производство и сельское хозяйство. Третий индийский партнёр NVIDIA на ИИ-рынке — компания Netweb Technologies, которая запускает суперкомпьютерные системы Tyrone Camarero AI, построенные на узлах NVIDIA GB200 NVL4, произведённых в рамках государственной программы «Сделано в Индии». Сообщается, что облачная ИИ-инфраструктура в Индии будет размещать рабочие нагрузки, а также обеспечивать интеллектуальные возможности для обучения моделей, тонкой настройки и масштабного инференса. Мощности в этих ЦОД будут зарезервированы для разработчиков моделей, стартапов, исследователей и предприятий для создания, тонкой настройки и развёртывания ИИ в Индии. Ранее глава OpenAI Сэм Альтман (Sam Altman) заявил, что Индия способна стать одним из мировых ИИ-лидеров, особенно в создании малых рассуждающих моделей (SLM).

18.02.2026 [11:46], Руслан Авдеев

Adani вложит $100 млрд в создание 5 ГВт «зелёных» ИИ ЦОД в ИндииИндийский конгломерат Adani увеличил планы строительства дата-центров в Индии более чем вдвое. На днях компания анонсировала планы вложить $100 млрд в возведение готовых к ИИ-нагрузкам ЦОД гиперскейл-уровня, снабжаемых возобновляемой энергией — к 2035 году, сообщает Datacenter Dynamics. Подробности пока почти неизвестны, но компания отметила, что расширенный план основан на существующих портфолио и плане совместного предприятия AdaniConneX совокупной мощностью 2 ГВт. Теперь общая запланированная мощность составляет 5 ГВт, энергетическая составляющая будет реализована за счёт комбинации возобновляемой энергии и питания от магистральных линий электропередачи. Adani объявила, что дальнейшая экспансия опирается на знаковые партнёрские соглашения с Google о строительстве кампуса ИИ ЦОД в Вишакхапатнаме (Visakhapatnam) гигаваттного уровня, а также дополнительных кампусов в Нойде (Noida). Также заключён договор с Microsoft — речь идёт о строительстве кампусов в Хайдарабаде (Hyderabad) и Пуне (Pune). Дополнительно компания сообщила, что намерена углублять партнёрство в сфере ЦОД с индийским гигантом электронной коммерции — компанией Flipkart, с планами построить второй ИИ ЦОД. Ведётся обсуждение с прочими крупными игроками IT-рынка, стремящимися обзавестись крупными кампусами в Индии. По словам Adani Group, мир вступает в эру «интеллектуальной революции», более глубокой, чем любая научно-техническая революция прежде. Страны, сумевшие обеспечить баланс энергетики и вычислений, будут формировать облик следующего десятилетия, а Индия находится в уникальной позиции, позволяющей занять одну из ведущих ролей в этом.

Источник изображения: Rohit Dey/unsplash.com Adani сообщает, что компания, опираясь на опыт в сфере ЦОД и «зелёной» энергетики, расширяет деятельность в стремлении «охватить» полный пятиуровневый ИИ-стек с акцентом на обеспечение индийского технологического суверенитета. В компании рассчитывают, что страна будет не только обычным потребителем в эпоху ИИ, но и создателем, строителем и экспортёром «интеллектуальных» технологий. Утверждается, что группа также инвестирует $55 млрд в расширение портфолио возобновляемой энергетики, включая строительство крупнейшего в мире аккумуляторного энергохранилища (BESS) и создание солнечного/ветряного проекта в Хавде (Khavda) — 10 ГВт мощностей уже функционируют. Дополнительно индийский конгломерат намерен участвовать в инвестициях в местные партнёрства, предполагающие строительство компонентов критической инфраструктуры, включая трансформаторы высокой мощности, передовую электронику для силовых систем, электросетевые системы, инверторы и промышленные системы терморегулирования. AdaniConneX представляет собой совместное предприятие Adani Enterprises и EdgeConneX. Впервые его создание анонсировали в феврале 2021 года, ранее компании рассчитывали построить в Индии ЦОД гиперскейл-уровня мощностью 1 ГВт. На сегодня предприятие реализует проекты в Ченнаи, Нойде, Визаге, Хайдарабаде, Пуне и Мумбаи. Стоит отметить, что в начале февраля 2026 года Индия объявила налоговые каникулы на 20 лет для гиперскейлеров, готовых использовать местные ЦОД для обслуживания зарубежных облачных клиентов.

18.02.2026 [09:19], Сергей Карасёв

Meta✴ развернёт ИИ-инфраструктуру на «миллионах ускорителей NVIDIA Blackwell и Rubin», а также Arm-чипах GraceКомпании NVIDIA и Meta✴ объявили о многолетнем стратегическом партнёрстве, охватывающем локальную, облачную и ИИ-инфраструктуры. В частности, Meta✴ будет использовать в своих дата-центрах решения NVIDIA как для обучения больших языковых моделей (LLM), так и для инференса. Сообщается, что Meta✴ возьмёт на вооружение чипы NVIDIA Grace, которые будут использоваться в серверах, основанных исключительно на CPU-архитектуре (без ускорителей на основе GPU). Изделия Grace, напомним, объединяют 72 вычислительных ядра Armv9 Neoverse V2 (Demeter) с тактовой частотой до 3,35 ГГц и до 480 Гбайт памяти LPDDR5x. Доступна также сборка Grace Superchip, которая состоит из двух кристаллов Grace и чипов памяти LPDDR5x общим объёмом до 960 Гбайт. Meta✴ намерена применять изделия Grace для решения общих задач, а также поддержания работы ИИ-агентов, которым не требуются ИИ-ускорители. Вице-президент NVIDIA Иэн Бак (Ian Buck) отмечает, что решения Grace способны обеспечить вдвое большую производительность на 1 Вт при выполнении операций общего назначения по сравнению с альтернативными платформами. В дальнейшем Meta✴ планирует использовать Arm-процессоры NVIDIA следующего поколения — решения Vera. Крупномасштабные развёртывания систем на базе Vera намечены на 2027 год, что поможет Meta✴ в развитии энергоэффективных вычислений и формировании широкой экосистемы Arm.

Источник изображения: Meta✴ Кроме того, в рамках партнёрства Meta✴ будет использовать «миллионы ускорителей NVIDIA Blackwell и Rubin». Так, на основе изделий NVIDIA GB300 компании создадут единую среду, охватывающую локальные дата-центры и облачные ресурсы, что позволит упростить операции при одновременном улучшении производительности и масштабируемости. Среди прочего Meta✴ будет применять сетевую платформу NVIDIA Spectrum-X Ethernet и технологию NVIDIA Confidential Computing для защиты данных. «Мы рады расширить партнёрство с NVIDIA с целью создания передовых кластеров на основе платформы Vera Rubin — это позволит предоставить персональный суперинтеллект каждому человеку в мире», — говорит Марк Цукерберг (Mark Zuckerberg), основатель и генеральный директор Meta✴. Нужно отметить, что среди гиперскейлеров только Meta✴ и Oracle используют в своих инфраструктурах сторонние чипы с архитектурой Arm. В то же время AWS, Google и Microsoft развивают собственные Arm-проекты — изделия Graviton, Axion и Cobalt соответственно.

17.02.2026 [19:40], Владимир Мироненко

Российский бизнес распробовал ИИ от Яндекса — потребление токенов за год выросло всемеро«Яндекс» сообщила неаудированные финансовые результаты за IV квартал и весь 2025 год, завершившийся 31 декабря 2025 года. Выручка компании выросла за IV квартал год к году на 28 % до 436,0 млрд руб. и на 32 % за весь год до 1441,1 млрд руб. Скорректированная чистая прибыль составила за квартал 53,5 млрд руб., увеличившись на 70 % год к году, и 141,4 млрд руб. за 2025 год (рост — 40 %). Скорректированный показатель EBITDA вырос в IV квартале год к году на 80 % до 87,8 млрд руб., за 2025 год рост составил 49 % — до 280,8 млрд руб. Выручка сегмента «Б2Б Тех» выросла за квартал год к году на 42 % до 13,9 млрд руб., за 2025 год — на 48 % — до 48,2 млрд руб. Скорректированный показатель EBITDA за IV квартал составил 2,9 млрд руб., увеличившись на 95 %, за 2025 год рост показателя составил 141 % — до 9,4 млрд руб. Рентабельность скорректированного показателя EBITDA увеличилась за отчётный квартал на 5,7 п.п. до 20,9 %, за 2025 год — на 7,6 п.п. до 19,6 %. В 2026 году компания ожидает рост выручки порядка 20 % год к году и скорректированный показатель EBITDA около 350 млрд руб. Компания отметила, что по темпам роста «Б2Б Тех» в IV квартале по-прежнему существенно опережал российский рынок корпоративных IT-решений — в 1,9 раза. Основная часть клиентов Yandex Cloud — внешние, на них приходится 93 % выручки направления. Количество клиентов выросло на 17 % год к году до почти 51 тыс. Львиную долю выручки (54 %) приносят крупные компании. Доля выручки от ИИ- и ИБ-сервисов, выросла почти в два раза до около 9 % от общей выручки Yandex Cloud. Сервисами безопасности пользовался каждый четвёртый коммерческий клиент. За 2025 год выручка ИБ-сервисов выросла в 2,3 раза год к году. Решения on-premise, которые помогают привлекать крупный бизнес, принесли в 2025 году 3,4 % от выручки Yandex Cloud. Отдельно отмечается, что темп роста корпоративных ИИ-сервисов значительно опережает рыночный. Так, квартальная выручка Yandex AI Studio выросла почти вдвое, до 2 млрд руб. Потребление токенов посредством API выросло примерно всемеро — 234 млрд токенов за весь 2025 год, из них более 150 млрд пришлось на IV квартал. Сервисами Яндекс 360 пользуются более 170 тыс. компаний, а их ежемесячная аудитория превышает 102 млн пользователей. На конец 2025 года общее количество платных учётных записей Яндекс 360 составило 8,1 млн, при этом свыше 2,2 млн приходится на крупные организации. Ежемесячная аудитория облачного сервиса «Яндекс Диск» составляет 61,5 млн человек. Также сообщается, что запущено тестирование «Яндекс Документов» и «Яндекс Диска» в варианте on-premise. До конца 2026 года в формате on-premise станут доступны в общей сложности 11 сервисов Яндекс 360.

17.02.2026 [15:33], Руслан Авдеев

Индийская Neysa привлечёт $1,2 млрд для расширения ИИ-облакаИндийский облачный стартап Neysa Networks Pvt. Ltd. Объявил о намерении привлечь до $1,2 млрд для расширения своей инфраструктуры дата-центров, сообщает Silicon Angle. Возглавляемый Blackstone консорциум обеспечит до половины суммы в виде акционерного финансирования, что обеспечит группе инвесторов мажоритарную долю в Neysa. Ещё $600 млн придётся на долговое финансирование. Компания рассчитывает, что привлечённые средства помогут утроить выручку в следующие несколько лет. Как заявляет Blackstone, инвестиции позволят Neysa сыграть важную роль в развитии ИИ-инфраструктуры в Индии и дают возможность компаниям и государственным структурам эффективнее и быстрее внедрять ИИ-технологии. Сейчас Neysa управляет публичной облачной платформой, оптимизированной для ИИ-задач, которая, по слухам, основана на около 2 тыс. ИИ-ускорителей, наиболее передовыми из которых являются NVIDIA H200. Также платформа оснащена чипами более общего назначения NVIDIA L40S. Предлагаются и классические CPU-инстансы. Neysa планирует увеличить количество используемых ИИ-ускорителей приблизительно в десять раз, до 20 тыс. По оценкам Blackstone, это примерно треть от всех ИИ-ускорителей, развёрнутых сейчас в индийских ЦОД. Впрочем, Neysa, вероятно захочет приобрести более современные решения, включая Vera Rubin. По-видимому, как минимум часть из них будет развёрнута в дата-центре в Хайдарабаде, о котором сообщалось в апреле 2025 года. Объект стоит как раз $1,2 млрд и вместит до 25 тыс. ИИ-ускорителей.

Источник изображения: Prashanth Pinha/unsplash.com Помимо набора программных инструментов, компания предлагает и инфраструктурные сервисы. Платформа Neysa позволяет клиентам дообучать открытые ИИ-модели под конкретные задачи. Кроме того, разработчики могут создать несколько вариантов той или иной модели, чтобы выбрать наилучший при помощи инструментов Nesya, которые также помогают отслеживать эффективность использования таких кастомных моделей и обеспечивают средства безопасности и контроля доступа. Также компания намерена улучшить наблюдаемость и управляемость нагрузок. |

|