Материалы по тегу: c

|

02.11.2025 [12:06], Сергей Карасёв

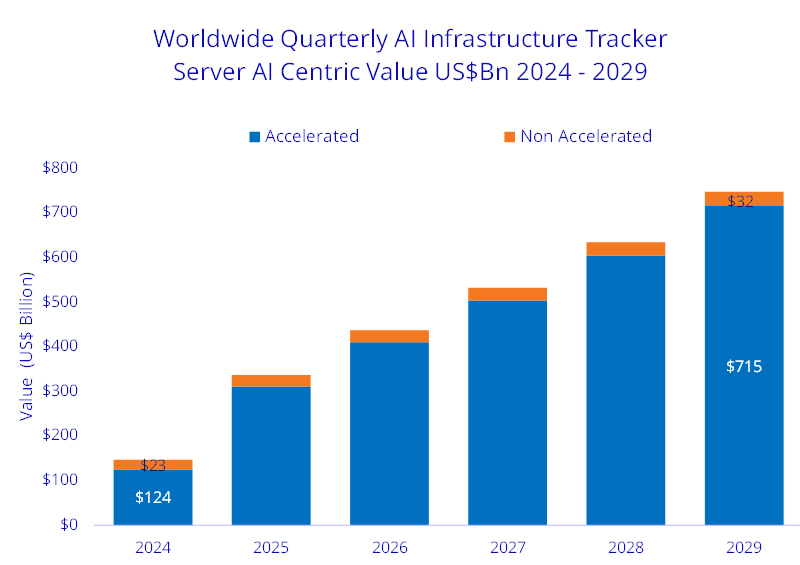

IDC: квартальные расходы на ИИ-инфраструктуру превысили $80 млрд, но закупались в основном гиперскейлеры и облакаКомпания International Data Corporation (IDC) обнародовала результаты исследования глобального рынка инфраструктур для задач ИИ по итогам II квартала 2025 года, а также сделала прогноз до 2029-го. Аналитики полагают, что сектор продолжит демонстрировать стремительный рост. Обнародованные данные учитывают отгрузки серверов и СХД для ИИ-платформ. В период с апреля по июнь включительно продажи такого оборудования в денежном выражении достигли $82 млрд. Это на 166 % больше по сравнению с аналогичным периодом 2024-го, когда отгрузки оценивались приблизительно в $30,8 млрд. На системы для облачных и общедоступных сред пришлось 84,1 % от общих затрат на ИИ-инфраструктуру во II квартале 2025-го. Гиперскейлеры, поставщики облачных и цифровых услуг обеспечили 86,7 % всех расходов за рассматриваемый период.

Источник изображения: IDC Вклад серверов в общие продажи в денежном выражении достигает 98 %, а рост в годовом исчислении зафиксирован на уровне 173,2 %. При этом доминируют системы с ИИ-ускорителями: они обеспечили 91,8 % от суммарной выручки на рынке ИИ-инфраструктур, продемонстрировав рост на 207,3 % по отношению к 2024 году. С географической точки зрения лидируют США, вклад которых в общий объём отрасли во II четверти 2025 года составил 76 %. Далее следуют Китай с 11,6 %, Азиатско-Тихоокеанский регион и Япония с 6,9 %, а также EMEA (Европа, Ближний Восток и Африка) с 4,7 %. IDC прогнозирует, что в течение следующих пяти лет Китай будет показывать самые высокие среднегодовые темпы роста — плюс 41,5 %. В США этот показатель ожидается на уровне 40,5 %, в регионе EMEA — 17,3 %, в Азиатско-Тихоокеанском регионе и Японии — 14,3 %. В целом, по данным IDC, к 2029 году расходы на инфраструктуру ИИ в мировом масштабе достигнут $758 млрд. При этом 94,3 % от общего объёма расходов, или $715 млрд, придётся на серверы, оснащённые различными ИИ-ускорителями.

30.10.2025 [16:18], Руслан Авдеев

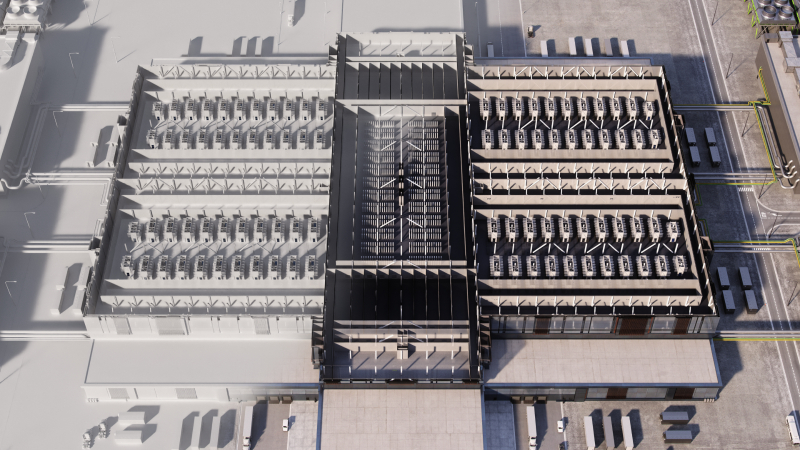

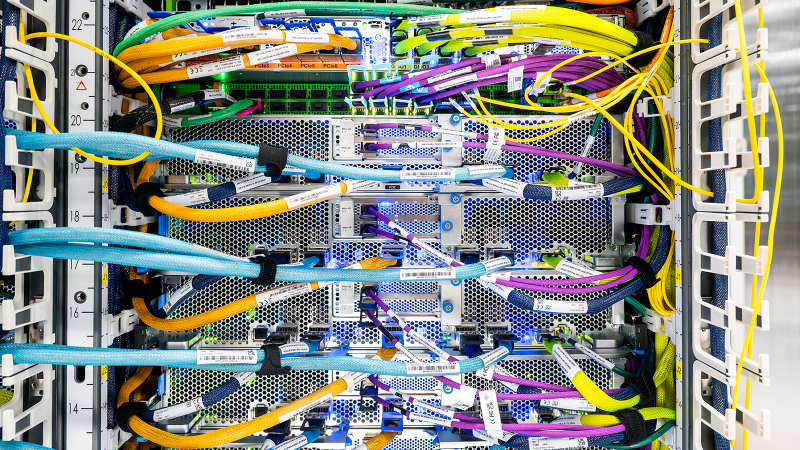

Полмиллиона ускорителей Trainium2: AWS развернула для Anthropic один из крупнейших в мире ИИ-кластеров Project RainierAWS объявила о запуске одного из крупнейших в мире ИИ-кластеров Project Rainier. Фактически амбициозный проект представляет собой распределённый между несколькими ЦОД ИИ-суперкомпьютер — это важная веха в стремлении AWS к развитию ИИ-инфраструктуры, сообщает пресс-служба Amazon. Платформа создавалась под нужды Anthropic, которая буквально на днях подписала многомиллиардный контракт на использование Google TPU. В рамках Project Rainier компания AWS сотрудничала со стартапом Anthropic. В проекте задействовано около 500 тыс. чипов Trainium2, а вычислительная мощность в пять раз выше той, что Anthropic использовала для обучения предыдущих ИИ-моделей. Project Rainier применяется Anthropic для создания и внедрения моделей семейства Claude. К концу 2025 года предполагается использование более миллиона чипов Trainium2 для обучения и инференса. В рамках Project Rainier в AWS уже создали инфраструктуру на основе Tranium2, на 70 % превосходящую любую другую вычислительную ИИ-платформу в истории AWS. Проект охватывает несколько дата-центров в США и не имеет аналогов среди инициатив AWS. Он задуман как гигантский кластер EC2 UltraCluster из серверов Trainium2 UltraServer. UltraServer объединяет четыре физических сервера, каждый из которых имеет 16 чипов Trainium2. Они взаимодействуют через фирменный интерконнект NeuronLink, обеспечивающий быстрые соединения внутри системы, что значительно ускоряет вычисления на всех 64 чипах. Десятки тысяч UltraServer объединяются в UltraCluster посредством фабрики EFA. Эксплуатация такого ЦОД требует повышенной надёжности. В отличие от большинства облачных провайдеров, AWS создаёт собственное оборудование и может контролировать каждый компонент, от чипов до систем охлаждения и архитектуру дата-центров в целом. Управляющие ЦОД команды уделяют повышенное внимание энергоэффективности, от компоновки стоек до распределения энергии и выбора методов охлаждения. Кроме того, в 2023 году вся энергия, потребляемая Amazon, полностью компенсировалась электричеством из возобновляемых источников. В Amazon утверждают, что в последние пять лет компания является крупнейшим покупателем возобновляемой энергии и стремится к достижению нулевых выбросов к 2040 году.

Источник изображения: AWS Миллиарды долларов инвестируются в ядерную энергетику и АКБ, а также крупные проекты в области возобновляемой энергетики для ЦОД. В 2024 году компания объявила о внедрении новых компонентов для ЦОД, сочетающих технологии электропитания, охлаждения и аппаратного обеспечения, причём не только для строящихся, но и уже для имеющихся объектов. Новые компоненты, предположительно, позволят снизить энергопотребление некоторых компонентов до -46 % и сократить углеродный след используемого бетона на 35 %.

Источник изображения: AWS Для новых объектов, строящихся в рамках Project Rainier и за его пределами, предусмотрено использование целого ряда новых технологий для повышения энергоэффективности и экоустойчивости. Некоторые технологии связаны с рациональным использованием водных ресурсов. AWS проектирует объекты так, чтобы использовать минимум воды, или вовсе не использовать её. Один из способов — отказ от её применения в системах охлаждения на многих объектах большую часть года, с переходом на охлаждение наружным воздухом.

Источник изображения: AWS Так, один из объектов Project Rainier в Индиане будет максимально использовать именно уличный воздух, а с октября по март дата-центры вовсе не станут использовать воду для охлаждения, с апреля по сентябрь в среднем вода будет применяться по несколько часов в день. Согласно отчёту Национальной лаборатории им. Лоуренса в Беркли (LBNL), стандартный показатель WUE для ЦОД 0,375 л/кВт·ч. В AWS этот показатель равен 0,15 л/кВт·ч, что на 40 % лучше, чем в 2021 году.

30.10.2025 [13:51], Владимир Мироненко

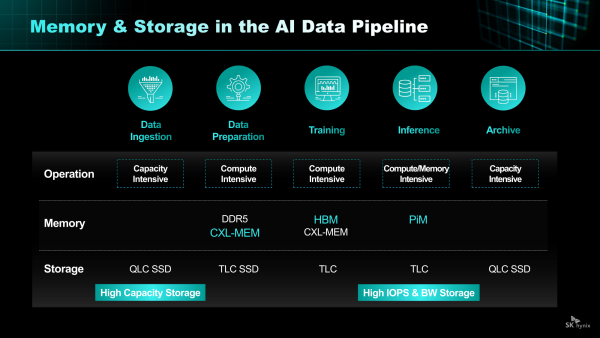

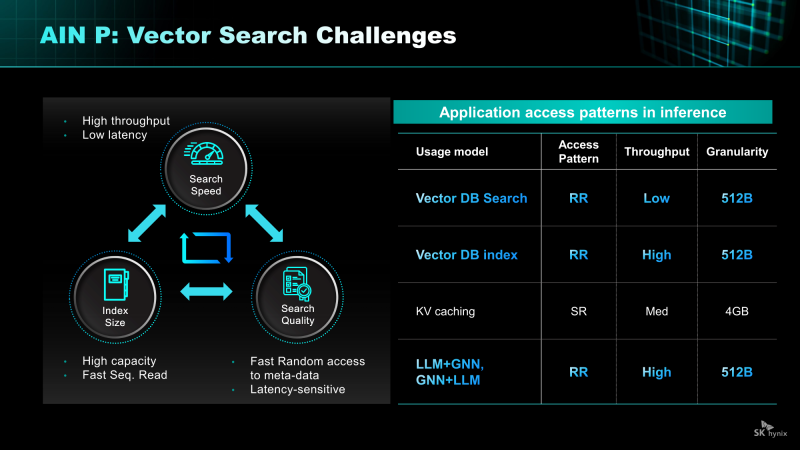

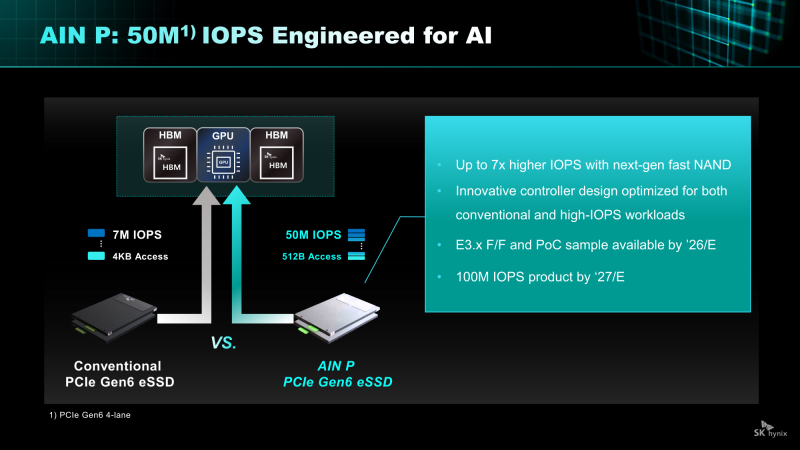

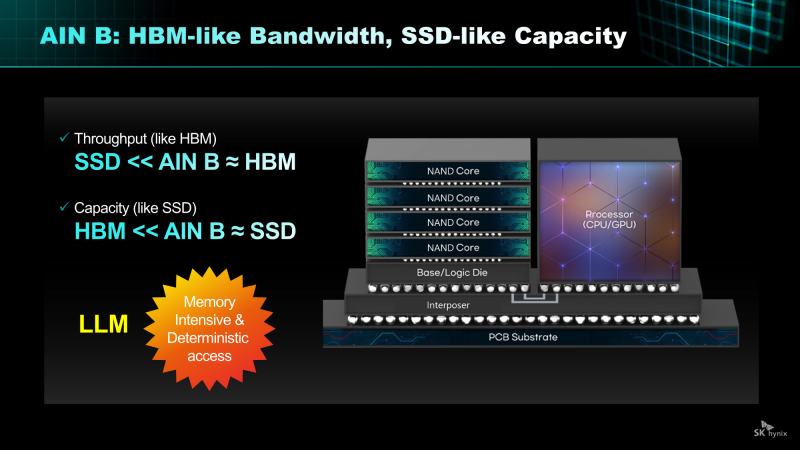

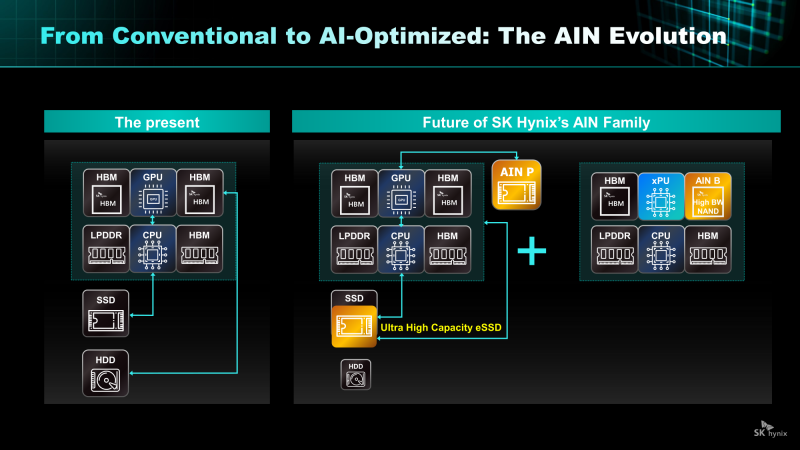

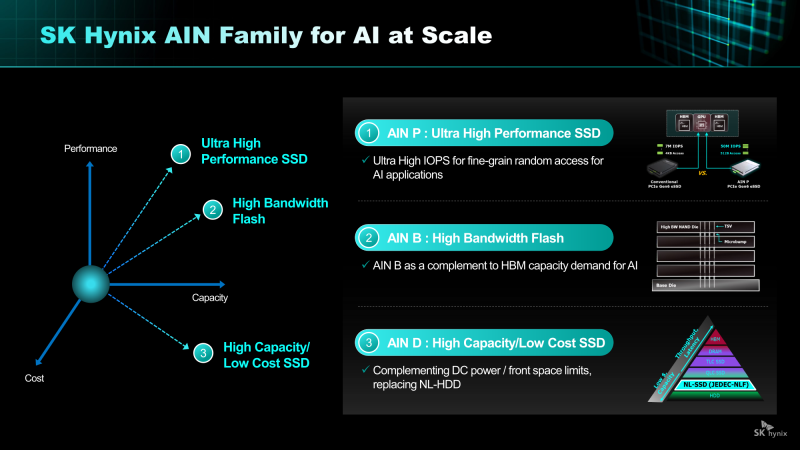

От Nearline SSD до HBF: SK hynix анонсировала NAND-решения AIN для ИИ-платформКомпания SK hynix представила стратегию развития решений хранения на базе NAND нового поколения. SK hynix заявила, что в связи с быстрым ростом рынка ИИ-инференса спрос на хранилища на базе NAND, способных быстро и эффективно обрабатывать большие объёмы данных, стремительно растёт. Для удовлетворения этого спроса компания разрабатывает серию решений AIN (AI-NAND), оптимизированных для ИИ. Семейство будет включать решения AIN P, AIN B и AIN D, оптимизированные по производительности, пропускной способности и плотности соответственно. AIN P (Performance) — это решение для эффективной обработки больших объёмов данных, генерируемых в рамках масштабных рабочих нагрузок ИИ-инференса. Продукт значительно повышает скорость обработки и энергоэффективность, минимизируя узкие места между хранилищем и ИИ-операциями. SK hynix разрабатывает NAND-память и контроллеры с новыми возможностями и планирует выпустить образцы к концу 2026 года. Как пишет Blocks & Files, накопитель AIN P, как ожидается, получит поддержку PCIe 6.0 и обеспечит 50 млн IOPS на 512-байт блоках, тогда как сейчас производительность случайного чтения и записи с 4-Кбайт блоками составляет порядка 7 млн IOPS у накопителей PCIe 6.0. То есть AIN P будет в семь раз быстрее, чем нынешние корпоративные PCIe 6.0 SSD, и, по заявлению SK hynix, достичь 100 млн IOPS можно будет уже в 2027 году. Такой SSD будет выполнен в форм-факторе EDSFF E3.x и оснащён контроллером, предназначенным для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. AIN D (Density) — это высокоплотное решение Nearline (NL) SSD для хранения больших объёмов данных с низкими энергопотреблением и стоимостью, подходящее для хранения ИИ-данных. Компания стремится увеличить плотность QLC SSD с Тбайт до Пбайт, создав решение среднего уровня, сочетающее в себе скорость SSD и экономичность HDD. AIN D от SK hynix как раз предназначен для замены жёстких дисков. Компания также упоминает некий стандарт JEDEC-NLF (Near Line Flash?), который пока не существует. При этом SK hynix пока не упоминает PLC NAND и не приводит данные о ёмкости AIN D. AIN B (Bandwidth) — это HBF-память с увеличенной за счёт вертикального размещения нескольких модулей NAND пропускной способностью. Ключевым в данном случае является сочетание структуры стекирования HBM с высокой плотностью и экономичностью флеш-памяти NAND. AIN B предложит большую ёмкость, чем HBM, примерно на уровне ёмкости SSD. AIN B может увеличить эффективную ёмкость памяти GPU и, таким образом, устранить необходимость покупки/аренды дополнительных GPU для увеличения ёмкости HBM, например, для хранения содержимого KV-кеша. Компания рассматривает различные стратегии развития AIN B, например, совместное использование с HBM для повышения общей ёмкости системы, поскольку стек HBF может быть совмещён со стеком HBM на одном интерпозере. SK hynix и Sandisk работают над продвижением стандарта HBF. Они провели в рамках 2025 OCP Global Summit мероприятие HBF Night, посвящённое этому вопросу. Рании компании подписали меморандум о стандартизации HBF в целях расширения технологической экосистемы. «Благодаря OCP Global Summit и HBF Night мы смогли продемонстрировать настоящее и будущее SK hynix как глобального поставщика решений памяти, процветающего на быстро развивающемся ИИ-рынке», — заявила SK hynix, добавив, что на рынке устройств хранения данных на базе NAND следующего поколения SK hynix будет тесно сотрудничать с клиентами и партнёрами, чтобы стать ключевым игроком.

29.10.2025 [16:53], Владимир Мироненко

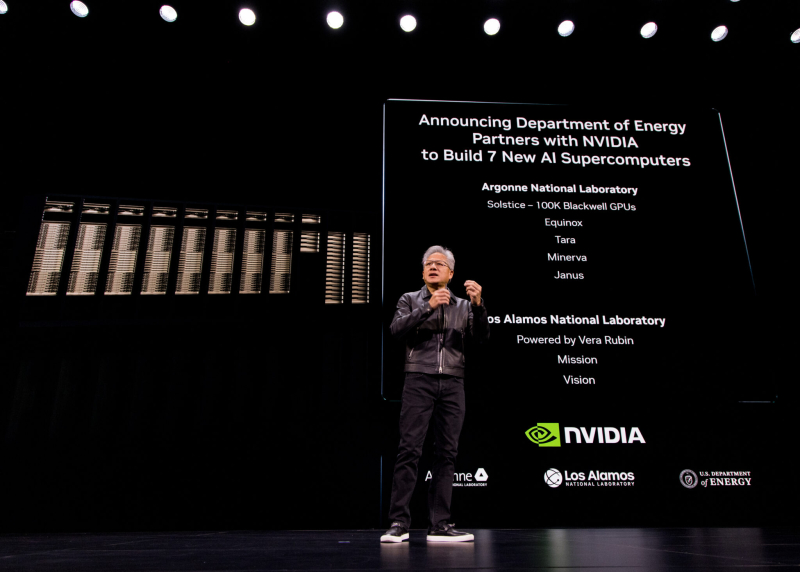

В США построят семь новых ИИ-компьютеров на чипах NVIDIA по заказу Министерства энергетики СШАNVIDIA объявила о сотрудничестве с национальными лабораториями Министерства энергетики США (DoE) и ведущими компаниями с целью развития ИИ-инфраструктуры страны, в рамках которого будет построено семь новых суперкомпьютеров в Аргоннской (ANL) и Лос-Аламосской (LANL) национальных лабораториях. На первом этапе проекта NVIDIA и Oracle совместно построят в Аргоннской национальной лаборатории (ANL) два новых суперкомпьютера Equinox и Solstice с суммарной ИИ-производительность 2,2 Зфлопс. Также ANL планирует запустить ещё три новые ИИ-системы на базе технологий NVIDIA: Tara, Minerva и Janus. Не вдаваясь в подробности по поводу спецификаций систем, руководство лаборатории заявило, что суперкомпьютеры призваны расширить доступ исследователям в сфере ИИ из других центров по всей стране. Лос-Аламосская национальная лаборатория (LANL) получит ИИ-системы Mission и Vision нового поколения, которые будут разработаны и поставлены компанией HPE. Уже известно, что они будут базироваться на платформе NVIDIA Vera Rubin с сетевой фабрикой Quantum‑X800 InfiniBand. Как сообщает NVIDIA, система Vision основана на достижениях суперкомпьютера Venado, созданного для несекретных исследований. Как уточнили в лаборатории, Vision будет использоваться для несекретных задач в области национальной безопасности, материаловедения и ядерной науки, энергетического моделирования и биомедицинских исследований, сообщили в лаборатории, пишет The Register. Mission — пятая система ATS5 (Advanced Technology System) в рамках программы усовершенствованного моделирования и вычислений (Advanced Simulation and Computing) Национального управления ядерной безопасности США (The National Nuclear Security Administration, NNSA), поддерживаемой LANL. Система предназначена для запуска секретных приложений, её ввод в эксплуатацию состоится в конце 2027 года. Vera Rubin в сочетании с Quantum‑X800 позволит учёным проводить сложное моделирование в области материаловедения, моделирования климата и квантовых вычислений. «Использование такого уровня вычислительной производительности критически важно для решения некоторых из самых сложных научных задач и задач национальной безопасности», — заявил Том Мейсон (Thom Mason), директор LANL.

29.10.2025 [11:55], Сергей Карасёв

NVIDIA представила интерконнект NVQLink для гибридных вычислений на базе GPU и QPUКомпания NVIDIA анонсировала NVQLink — открытую системную архитектуру, предназначенную для тесной интеграции графических (GPU) и квантовых (QPU) процессоров с целью создания гибридных вычислительных платформ. В разработке интерконнекта NVQLink приняли участие Брукхейвенская национальная лаборатория (BNL), Национальная ускорительная лаборатория им. Ферми (Fermilab), Национальная лаборатория имени Лоуренса в Беркли (LBNL), Лос-Аламосская национальная лаборатория (LANL), Национальная лаборатория Ок-Ридж (ORNL), Национальные лаборатории Сандия (SNL) и Тихоокеанская северо-западная национальная лаборатория (PNNL), которые принадлежат Министерству энергетики США (DoE). Кроме того, были вовлечены специалисты Линкольнской лаборатории Массачусетского технологического института (MIT Lincoln Laboratory). Отмечается, что NVQLink обеспечивает открытый подход к квантовой интеграции. Максимальная пропускная способность в системах GPU — QPU заявлена в 400 Гбит/с, тогда как минимальная задержка (FPGA-GPU-FPGA) составляет менее 4 мкс. Интерконнект может применяться в составе ИИ-платформ, обладающих производительностью до 40 Пфлопс (FP4). Решение NVQLink оптимизировано для крупномасштабных квантовых вычислений в реальном времени. В целом, NVQLink обеспечивает возможность непосредственного взаимодействия QPU разных типов и систем управления квантовым оборудованием с ИИ-суперкомпьютерами. Технология предоставляет готовое унифицированное решение для преодоления ключевых проблем интеграции, с которыми сталкиваются исследователи в области квантовых вычислений при масштабировании своих систем. Разработчики могут получить доступ к NVQLink благодаря интеграции с программной платформой NVIDIA CUDA-Q. В число партнёров, вносящих вклад в NVQLink, входят разработчики квантового оборудования Alice & Bob, Anyon Computing, Atom Computing, Diraq, Infleqtion, IonQ, IQM Quantum Computers, ORCA Computing, Oxford Quantum Circuits, Pasqal, Quandela, Quantinuum, Quantum Circuits, Quantum Machines, Quantum Motion, QuEra, Rigetti, SEEQC и Silicon Quantum Computing, а также разработчики квантовых систем управления, включая Keysight Technologies, Quantum Machines, Qblox, QubiC и Zurich Instruments.

28.10.2025 [22:35], Владимир Мироненко

Министерство энергетики США получит два суперкомпьютера на чипах AMD общей стоимостью $1 млрд: Discovery и Lux AI

amd

epyc

hardware

hpc

hpe

mi350

mi400

oracle

oracle cloud infrastructure

ornl

venice

ии

облако

суперкомпьютер

сша

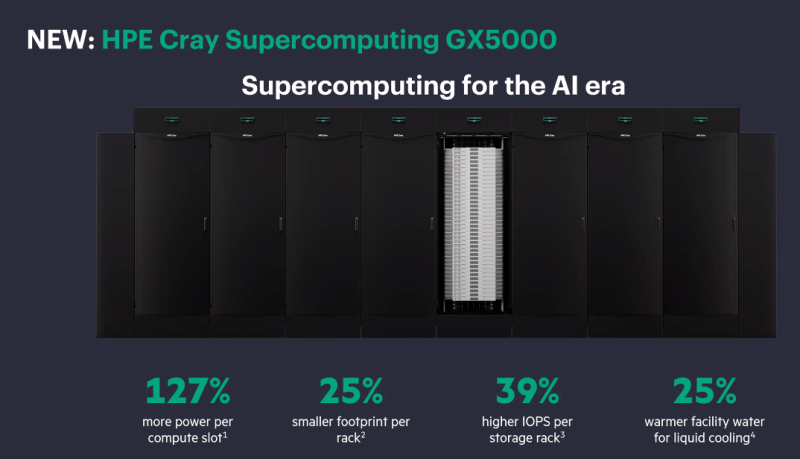

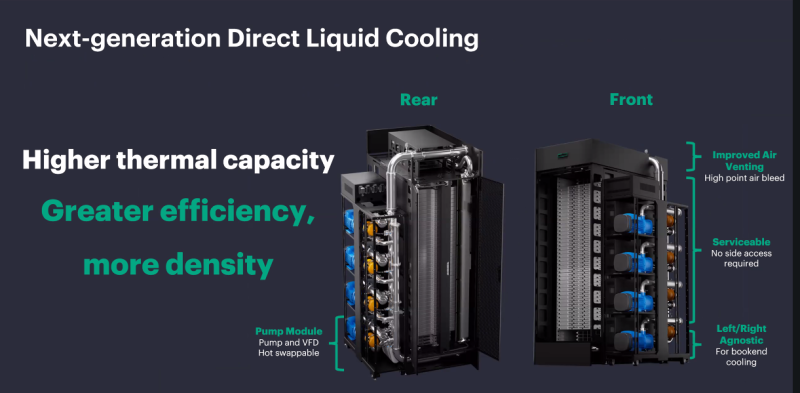

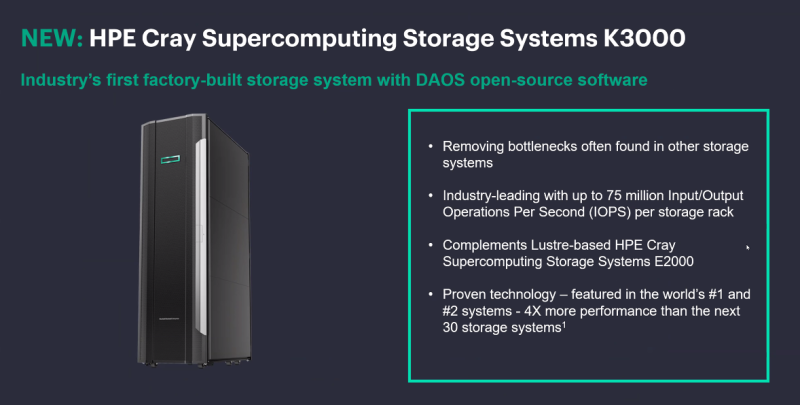

Министерство энергетики США (DOE) заключило с AMD контракт стоимостью $1 млрд с целью строительства двух суперкомпьютеров HPE для решения масштабных научных задач в области ядерной энергетики, здравоохранения и национальной безопасности. Министр энергетики Крис Райт (Chris Wright) сообщил агентству Reuters, что создание HPC-систем даст мощный импульс развитию ядерной и термоядерной энергетики, оборонных технологий и национальной безопасности, а также разработке лекарственных препаратов. Учёные и компании пытаются воспроизвести термоядерный синтез, который, в том числе, подпитывает солнечную энергию. «Мы добились значительного прогресса, но плазма нестабильна, и нам необходимо воссоздать центр Солнца на Земле», — заявил Райт. Он выразил уверенность, что ИИ-системы позволят открыть практические пути для использования энергии термоядерного синтеза в ближайшие два-три года, а также помогут управлять ядерным арсеналом США и ускорить разработку лекарств, моделируя способы лечения рака вплоть до молекулярного уровня. «Я надеюсь, что в ближайшие пять-восемь лет мы превратим большинство видов рака, многие из которых сегодня являются смертным приговором, в контролируемые состояния», — сказал Райт. Первым планируется запустить в эксплуатацию в течение следующих шести месяцев суперкомпьютер Lux с облачным доступом. Он будет основан на узлах HPE ProLiant Compute XD685 с СЖО, которые объединяют ИИ-ускорителях Instinct MI355X, CPU AMD EPYC, а также DPU Pensando. Система разработана AMD совместно с HPE, Oracle (OCI) и Ок-Риджской национальной лабораторией (ORNL). Глава AMD Лизу Су (Lisa Su) сообщила, что запуск Lux будет самым быстрым развёртыванием суперкомпьютера таких размеров в её практике. «Именно такой скорости и гибкости мы хотели бы добиться для программ США в области ИИ искусственного интеллекта», — сказала она. По словам директора ORNL, Lux будет обладать примерно в три раза большей вычислительной мощностью по сравнению с существующими системами. Второй, более продвинутый суперкомпьютер под названием Discovery станет преемником экзафлопсной машины Frontier в ORNL и будет практически на порядок быстрее её. Его разработкой занимаются ORNL, HPE и AMD. Discovery будет основан на платформе HPE Cray Supercomputing GX5000, поддерживающей до 25 кВт на узел и охлаждение водой с температорой +40 °C. Узлы получат процессоры AMD EPYC Venice, которые, как ожидается, появятся во II половине 2026 года, а также специализированные ускорители Instinct MI430X с полноценной поддержкой FP64-вычислений — они также должны появиться в следующем году. Для интерконнекта будет задействован HPE Slingshot следующего поколения, сроки выхода которого не называются. Discovery получит новейшую СХД Cray SC Storage Systems K3000 с объектным хранилищем DAOS, которое дополнит имеющуюся СХД на базе Cray SC Storage Systems E2000 с Lustre. Ранее HPE наняла инженеров, занимавшихся разработкой DAOS в Intel, и включила их в свою команду по работе над СХД. По словам HPE, K3000 предложит до 75 млн IOPS на стойку. HPE не раскрывает, сколько узлов, процессоров и ускорителей будет использоваться в Discovery, а также какой объём памяти будет у системы. Ожидается, что Discovery будет поставлен в 2028 году и готов к эксплуатации в 2029 году. Оценочная стоимость системы — $500 млн. Министерство энергетики США разместит суперкомпьютеры, компании предоставят оборудование и средства на капитальные затраты, а вычислительные мощности будут распределены между обеими сторонами, сообщил представитель министерства. Он отметил, что эти суперкомпьютеры на базе чипов AMD станут первыми в ряду подобных партнёрств министерства с частными компаниями в стране. По аналогичной схеме будет финансироваться создание ИИ-суперкомпьютера Solstice.

28.10.2025 [21:35], Владимир Мироненко

NVIDIA и Oracle построят для США ИИ-суперкомпьютер Solstice: 100 тыс. ускорителей Blackwell и государственно-частное партнёрствоNVIDIA объявила о новом совместном проекте с Oracle по созданию крупнейшей суперкомпьютерной системы с поддержкой ИИ в интересах Министерства энергетики США (DoE) для разработок в сфере науки. В рамках партнёрства NVIDIA и Oracle построят два суперкомпьютера — Solstice и Equinox, оснащённых 100 тыс. и 10 тыс. ускорителей NVIDIA Blackwell соответственно, которые будут объединены интерконнектом NVIDIA и обеспечат суммарную ИИ-производительность в 2,2 Зфлопс. Система Equinox будет введена в эксплуатацию в I половине 2026 года. Стоимость проекта не разглашается. Solstice будет построен с использованием новой модели государственно-частного партнёрства Министерства энергетики США, включающей инвестиции cо стороны промышленности. Сообщается, что суперкомпьютеры будут размещены в Аргоннской национальной лаборатории (ANL) Министерства энергетики США. С их помощью исследователи будут разрабатывать и обучать новые передовые ИИ-модели, включая модели рассуждений, для реализации проектов открытой науки, используя библиотеку NVIDIA Megatron-Core, а также масштабировать их с помощью программного стека для инференса NVIDIA TensorRT. Эти модели станут основой рабочих процессов агентного ИИ для научных исследований. Оба суперкомпьютера будут использоваться в рамках сотрудничества NVIDIA, ANL и DoE, повышая производительность исследований и разработок и ускоряя процесс научных открытий, которые будут осуществляться за счет государственных средств в течение десятилетия. Глава ANL, что новые суперкомпьютеры будут подключены к передовым экспериментальным установкам Министерства энергетики США, таким как усовершенствованный источник фотонов, что позволит решать самые насущные проблемы страны благодаря научным открытиям.

27.10.2025 [16:10], Руслан Авдеев

Aligned Data Centers и Calibrant Energy развернут «первое в своём роде» аккумуляторное энергохранилище для ЦОД ёмкостью 62 МВт∙чКомпания Aligned Data Centers объединила усилия с Calibrant Energy для создания в США «первой в своём роде» системы хранения энергии на основе АКБ (BESS), которая позволит ввести строящийся ЦОД в эксплуатацию на годы раньше, чем планировалось. Такой компромиссный вариант позволяет не дожидаться полноценной модернизации местной энергосети и вместе с тем не требует полностью автономного питания ЦОД. В рамках соглашения Calibrant в 2026 году построит BESS мощностью 31 МВт (62 МВт∙ч) для кампуса ЦОД Aligned Pacific Northwest в Хиллсборо (Hillsboro, Орегон). BESS является многообещающим решением в условиях продолжающегося дефицита электроэнергии для ЦОД. В данным конкретном случае BESS отслеживает состояние региональной энергосети. Энергохранилище предназначено для разрядки в периоды пикового спроса, что повышает стабильность работы и энергосети, и ЦОД. Наличие такой BESS ускоряет одобрение регулятором присоединения к сети. Речь идёт о первом случае в США, когда аккумуляторное энергохранилище специально строится для ускорения подключения к энергосети и обеспечения крупного ЦОД. По словам Aligned, стратегический проект меняет подходы к росту на рынках с ограниченным предложением электроэнергии. BESS позволяет превратить «потенциальную сетевую нагрузку» в «динамический сетевой актив» для ускорения роста бизнеса. Aligned представила планы создания крупного кампуса ЦОД в Хиллсборо ещё в 2023 году. Кампус находится в орегонском регионе Silicon Forest («Кремниевый лес») к западу от Портленда, наряду с объектами Intel, Flexential и QTS. По завершении строительства кампус площадью около 11 га будет обеспечен мощностью более 100 МВт. Сейчас техасская Aligned Data Centers управляет в США 50 объектами общей мощностью 5 ГВт. Партнёры подтвердили, что рассматривают реализацию аналогичных проектов и на других рынках. Новость появилась вскоре после того, как консорциум, включающий NVIDIA, BlackRock, Microsoft и xAI объявил о покупке Aligned Data Centers за $40 млрд.

27.10.2025 [11:16], Сергей Карасёв

Axelera AI представила ИИ-чип Europa с производительностью 629 TOPSНидерландский стартап Axelera AI анонсировал ИИ-ускоритель (AIPU) под названием Europa, предназначенный для таких задач, как генеративные сервисы и приложения компьютерного зрения. По заявлениям разработчиков, чип может использоваться в оборудовании разного класса — от периферийных устройств до корпоративных серверов. В состав Europa AIPU входят восемь «ядер ИИ второго поколения», которые используют векторные движки и технологию цифровых вычислений в оперативной памяти (D-IMC), разработанные специалистами Axelera. Заявленная ИИ-производительность достигает 629 TOPS на операциях INT8. Кроме того, чип содержит 16 специализированных векторных ядер с архитектурой RISC-V, сгруппированных в два кластера: они предназначены для операций пред- и постобработки, не связанных с ИИ. Пиковая производительность блока RISC-V достигает 4915 GOPS (млрд операций в секунду). Интегрированный декодер H.264/H.265 ускоряет выполнение медиазадач. Процессор располагает 256-бит интерфейсом памяти LPDDR5 с пропускной способностью 200 Гбайт/с и 128 Мбайт памяти L2 SRAM. Новинка будет предлагаться в различных форм-факторах, включая компактное исполнение с размерами 35 × 35 мм и карты расширения PCIe 4.0 х4 в различных конфигурациях, в частности, с одним чипом и 16 Гбайт памяти, а также с четырьмя чипами и 256 Гбайт памяти. Разработчикам предоставляет комплект Voyager SDK, который позволяет полностью раскрыть потенциал процессора. В целом, как утверждается, новинка обеспечивает в 3–5 раз более высокую производительность в расчёте на 1 Вт и $1 по сравнению с ведущими отраслевыми решениями в той же категории. Поставки Europa AIPU и PCIe-карт начнутся в I половине 2026 года.

26.10.2025 [23:55], Владимир Мироненко

Amazon проморгала рынок и теперь её клиенты бегут за ИИ в облака конкурентовAmazon, стоящая у истоков облачного бизнеса, уже не первый год отстаёт от конкурентов по темпам его роста. И на ИИ-рынке, по общему мнению, она оказалась в роли догоняющей на фоне стремительного роста конкурентов, пишет агентство Bloomberg. На прошлой неделе стало известно, что Google Cloud предоставит Anthropic до 1 млн своих ИИ-чипов TPU, что свидетельствует об углублении партнёрства Google с быстрорастущим ИИ-стартапом и наносит удар по Amazon, инвестировавшей в Anthropic миллиарды долларов. AWS по-прежнему лидирует на облачном рынке, но Microsoft наращивает объём корпоративных продаж быстрее, чем Amazon. В прошлом году, по оценке Gartner, облачное AWS заняла 38 % корпоративных расходов на услуги облачной инфраструктуры, тогда как ещё в 2018 году, по данным компании, у «дочки» Amazon было почти 50 % этого рынка. Чтобы выяснить причины сложившейся ситуации, агентство Bloomberg провело опрос аналитиков в области облачных вычислений и финансов, а также у компаний, которые используют или перепродают облачные решения Amazon, и среди 23 нынешних и бывших сотрудника AWS, работающих в сфере разработки, управления продуктами, маркетинга, продаж и поддержки. Одной из главных причин, тормозящих работу AWS, а также влияющих на гибкость, они назвали внутреннюю бюрократию. Респонденты отметили слабый старт компании в области ИИ, а также то, что она стала менее привлекательной для стартапов. Вместе с тем AWS верна своей давней стратегии на фоне быстро меняющегося рынка. Участники опроса признают, что AWS сохраняет значительные преимущества и лояльность клиентов, но опасаются, что компания теряет свои позиции в погоне за конкурентами, которых когда-то опережала. На следующей неделе Amazon объявит квартальные финансовые результаты, которые, как ожидается, покажут рост облачного бизнеса на 18 % до $32 млрд, что уступает показателю роста годом ранее (19 %). Сказался и серьёзный рост конкуренции на облачном рынке в последние пару лет. Oracle, которую когда-то считали аутсайдером в облачной индустрии, теперь заключает многомиллиардные контракты в области ИИ, хотя и не все верят в её успех. Также наращивают мощности Google и неооблака. Дэйв Маккарти (Dave McCarthy), консультант IDC, отметил, что выбор облачных предложений, ранее ограничивавшийся сервисами Amazon и Microsoft, стал гораздо больше, и это не сулит ничего хорошего Amazon. «Это создаёт новое конкурентное давление, которого раньше не было», — подчеркнул он. Стремясь вернуть себе инициативу, AWS реорганизовала команды по инжинирингу и продажам, провела кадровые перестановки в руководстве, а также отказалась от некоторых собственных правил разработки ради ускорения вывода продуктов на рынок и попыталась сократить бюрократию, возникшую после масштабного набора сотрудников во время пандемии. Кроме того, в этом месяце AWS выпустила Quick Suite, призванный заменить её предыдущий основной ИИ-инструмент для корпоративных клиентов, и в декабре ожидается запуск ряда новых и обновлённых ИИ-сервисов. Представитель Amazon Селена Шен (Selena Shen) сообщила в электронном письме Bloomberg, что AWS по-прежнему лидирует на рынке облачных технологиях с большим отрывом, а её ИИ-сервисы, такие как Amazon Bedrock, SageMaker и Kiro, пользуются спросом у клиентов, в том числе из-за выгодного соотношении цены и производительности фирменных ИИ-ускорителей Trainium2. Amazon заключила за последнее время крупные сделки с широким кругом клиентов, включая Delta Air Lines, Volkswagen, Управление общих служб США (GSA) и State Farm, отметила Шен. «Если вы посмотрите на любой список самых инновационных или быстрорастущих стартапов мира, вы обнаружите, что подавляющее большинство из них в значительной степени разворачивают рабочие нагрузки в AWS», — добавила она, ссылаясь, среди прочего, на списки Forbes и CNBC. Тем не менее, по общему мнению, оставаясь лидером в области облачной инфраструктуры, AWS отстаёт от своих конкурентов в плане привлечения бизнеса, создающего или использующего ИИ-модели. В частности, AWS не поверила в то, что Anthropic сможет монетизировать свои разработки, поэтому стартап в поисках необходимых вычислительных мощностей обратился к Google Cloud. Когда стартап привлёк инвестиции в начале 2023 года, среди инвесторов была и Google. Лишь в сентябре Amazon спохватилась и инвестировала в Anthropic первый из двух запланированных траншей в размере $4 млрд, обязав Anthropic использовать AWS и собственные чипы Amazon, а также предлагать клиентам Amazon модели Claude. Объём инвестиций шокировал ветеранов Amazon, знавших, что компания крайне не любит платить за что-либо по рыночным ценам. Некоторые посчитали это отчаянием, пишет Bloomberg. Amazon долгое время гордилась тем, что работает в режиме стартапа, предоставляя свободу независимым командам. Но этот принцип оказался неэффективным при разработке ИИ-моделей, поскольку научные и инженерные подразделения AWS, розничный отдел Amazon и группы Alexa и устройств занимались схожей, иногда дублирующей работой по обучению собственных ИИ-моделей. На конференции AWS re:Invent в ноябре 2023 года компания сделала упор на ИИ, а чуть позже развернула собственного ИИ-ассистента Amazon Q, который, по словам аналитиков, не принёс ничего революционного рынку, уже переполненному чат-ботами. Amazon провела реорганизацию и централизовала большинство работ по разработке передовых моделей, однако развитие AWS замедлилось. В том числе из-за усложнения иерархии после всплеска найма в результате пандемии. В условиях растущей бюрократии принятие решений происходило не так быстро, как раньше. Кроме того, поскольку ПО AWS стало критически важным для крупных корпоративных и государственных клиентов, в компании установили процедуры, призванные снизить риск того, что невнимательный или недовольный сотрудник может сломать что-то важное — это тоже замедляет работу. В некоторых случах часть сотрудников даже заставили получать разрешения на отправку писем высшему руководству. Шен сообщила, что с 2024 года AWS наняла множество новых руководителей и продвигает по службе тех, кто «демонстрирует производительность и готовность к следующему уровню», и что культура AWS остаётся сильной. Сменивший Адама Селипски (Adam Selipsky) на посту гендиректора AWS Мэтт Гарман (Matt Garman), пользующийся большим доверием разработчиков, частично вернул культуру прошлого. От руководителей продуктов требуется открытое признание ошибок и извлечённых уроков, идеи сотрудников принимаются в виде коротких питчей, а сами разработчики ПО работают посменно, обрабатывая запросы поддержки и инциденты по своим продуктам, чтобы понять потребности клиентов. Кроме того, Гарман завершил или прекратила разработку около трёх десятков устаревших и непопулярных продуктов, перенаправив силы на разработку ИИ-инструментов. Тем не менее, сотрудники выражают обеспокоенность тем, что Amazon теряет привлекательность для стартапов. AWS, как известно, помогла зарождению Netflix, но в последние годы порой отдавала приоритет корпорациям с большими расходами, не желая тратить силы на стартапы, которые могут и не стать долгосрочными богатыми клиентами. По словам аналитиков и стартап-консультантов, Google, используя свою известность, инженеров и навыки в передовых ИИ-инструментах, смогла привлечь многих ведущих стартапов в этой сфере. «Если вы сегодня не привлекаете местные стартапы в сфере ИИ, которые в ближайшие пару лет вырастут в пять-десять раз, это может стать реальной проблемой для бизнеса», — сказал Джош Бек (Josh Beck), аналитик Raymond James. Шен же назвала AWS «лучшим выбором для стартапов», приведя в пример Perplexity и Cursor. Но, к примеру, Пит Шваб (Pete Schwab), основатель стартапа Stronghold Labs в области ИИ-анализа видео, выбрал для своего детища площадку Google из-за её ориентации на небольших разработчиков и качества внутренних ИИ-моделей, хотя сам до этого 10 лет проработал в Amazon. AWS «раньше гораздо лучше привлекала таких людей, как мы», — сказал Шваб. Существующие клиенты AWS сейчас также обращаются к услугам её конкурентов, особенно в ИИ-сфере. Например, Grammarly, пользуется AWS, но для ИИ-решений использует модели OpenAI, в том числе в Microsoft Azure, а также Meta✴ Llama, поскольку AWS Bedrock не отвечает ценовым и другим потребностям компании, заявил технический директор стартапа. В начале этого месяца компания представила Quick Suite — чат-бот и набор ИИ-агентов, предназначенных для анализа данных, создания отчётов или резюмирования веб-контента, которые ориентированы на офисных сотрудников. В этой области компания не добилась особого успеха. Руководители в частном порядке признают, что, в отличие от Google и Microsoft, которые могут демонстрировать свои ИИ-инструменты миллиардам клиентов поисковой системы или пользователей ПК, естественный охват AWS ограничен гораздо более узким сообществом разработчиков. Для этой аудитории AWS продолжает расширять возможности Bedrock. Bedrock считается самым успешным ИИ-продуктом компании, число пользователей которого исчисляется десятками тысяч. По словам клиентов и партнёров, отделы продаж сделали увеличение их количества приоритетом. Однако Amazon может преуспеть в эпоху ИИ, просто выступая в качестве поставщика инфраструктуры для других компаний и управляя ею экономически эффективно. По мнению аналитиков, большая часть корпоративных проектов в области ИИ носит экспериментальный характер. Если проект получит более широкую поддержку, экономия средств и надёжная инфраструктура (если не учитывать недавний сбой) — два основных преимущества AWS — станут ещё важнее, утверждают руководители компании. |

|