Материалы по тегу: c

|

26.10.2025 [23:55], Владимир Мироненко

Amazon проморгала рынок и теперь её клиенты бегут за ИИ в облака конкурентовAmazon, стоящая у истоков облачного бизнеса, уже не первый год отстаёт от конкурентов по темпам его роста. И на ИИ-рынке, по общему мнению, она оказалась в роли догоняющей на фоне стремительного роста конкурентов, пишет агентство Bloomberg. На прошлой неделе стало известно, что Google Cloud предоставит Anthropic до 1 млн своих ИИ-чипов TPU, что свидетельствует об углублении партнёрства Google с быстрорастущим ИИ-стартапом и наносит удар по Amazon, инвестировавшей в Anthropic миллиарды долларов. AWS по-прежнему лидирует на облачном рынке, но Microsoft наращивает объём корпоративных продаж быстрее, чем Amazon. В прошлом году, по оценке Gartner, облачное AWS заняла 38 % корпоративных расходов на услуги облачной инфраструктуры, тогда как ещё в 2018 году, по данным компании, у «дочки» Amazon было почти 50 % этого рынка. Чтобы выяснить причины сложившейся ситуации, агентство Bloomberg провело опрос аналитиков в области облачных вычислений и финансов, а также у компаний, которые используют или перепродают облачные решения Amazon, и среди 23 нынешних и бывших сотрудника AWS, работающих в сфере разработки, управления продуктами, маркетинга, продаж и поддержки. Одной из главных причин, тормозящих работу AWS, а также влияющих на гибкость, они назвали внутреннюю бюрократию. Респонденты отметили слабый старт компании в области ИИ, а также то, что она стала менее привлекательной для стартапов. Вместе с тем AWS верна своей давней стратегии на фоне быстро меняющегося рынка. Участники опроса признают, что AWS сохраняет значительные преимущества и лояльность клиентов, но опасаются, что компания теряет свои позиции в погоне за конкурентами, которых когда-то опережала. На следующей неделе Amazon объявит квартальные финансовые результаты, которые, как ожидается, покажут рост облачного бизнеса на 18 % до $32 млрд, что уступает показателю роста годом ранее (19 %). Сказался и серьёзный рост конкуренции на облачном рынке в последние пару лет. Oracle, которую когда-то считали аутсайдером в облачной индустрии, теперь заключает многомиллиардные контракты в области ИИ, хотя и не все верят в её успех. Также наращивают мощности Google и неооблака. Дэйв Маккарти (Dave McCarthy), консультант IDC, отметил, что выбор облачных предложений, ранее ограничивавшийся сервисами Amazon и Microsoft, стал гораздо больше, и это не сулит ничего хорошего Amazon. «Это создаёт новое конкурентное давление, которого раньше не было», — подчеркнул он. Стремясь вернуть себе инициативу, AWS реорганизовала команды по инжинирингу и продажам, провела кадровые перестановки в руководстве, а также отказалась от некоторых собственных правил разработки ради ускорения вывода продуктов на рынок и попыталась сократить бюрократию, возникшую после масштабного набора сотрудников во время пандемии. Кроме того, в этом месяце AWS выпустила Quick Suite, призванный заменить её предыдущий основной ИИ-инструмент для корпоративных клиентов, и в декабре ожидается запуск ряда новых и обновлённых ИИ-сервисов. Представитель Amazon Селена Шен (Selena Shen) сообщила в электронном письме Bloomberg, что AWS по-прежнему лидирует на рынке облачных технологиях с большим отрывом, а её ИИ-сервисы, такие как Amazon Bedrock, SageMaker и Kiro, пользуются спросом у клиентов, в том числе из-за выгодного соотношении цены и производительности фирменных ИИ-ускорителей Trainium2. Amazon заключила за последнее время крупные сделки с широким кругом клиентов, включая Delta Air Lines, Volkswagen, Управление общих служб США (GSA) и State Farm, отметила Шен. «Если вы посмотрите на любой список самых инновационных или быстрорастущих стартапов мира, вы обнаружите, что подавляющее большинство из них в значительной степени разворачивают рабочие нагрузки в AWS», — добавила она, ссылаясь, среди прочего, на списки Forbes и CNBC. Тем не менее, по общему мнению, оставаясь лидером в области облачной инфраструктуры, AWS отстаёт от своих конкурентов в плане привлечения бизнеса, создающего или использующего ИИ-модели. В частности, AWS не поверила в то, что Anthropic сможет монетизировать свои разработки, поэтому стартап в поисках необходимых вычислительных мощностей обратился к Google Cloud. Когда стартап привлёк инвестиции в начале 2023 года, среди инвесторов была и Google. Лишь в сентябре Amazon спохватилась и инвестировала в Anthropic первый из двух запланированных траншей в размере $4 млрд, обязав Anthropic использовать AWS и собственные чипы Amazon, а также предлагать клиентам Amazon модели Claude. Объём инвестиций шокировал ветеранов Amazon, знавших, что компания крайне не любит платить за что-либо по рыночным ценам. Некоторые посчитали это отчаянием, пишет Bloomberg. Amazon долгое время гордилась тем, что работает в режиме стартапа, предоставляя свободу независимым командам. Но этот принцип оказался неэффективным при разработке ИИ-моделей, поскольку научные и инженерные подразделения AWS, розничный отдел Amazon и группы Alexa и устройств занимались схожей, иногда дублирующей работой по обучению собственных ИИ-моделей. На конференции AWS re:Invent в ноябре 2023 года компания сделала упор на ИИ, а чуть позже развернула собственного ИИ-ассистента Amazon Q, который, по словам аналитиков, не принёс ничего революционного рынку, уже переполненному чат-ботами. Amazon провела реорганизацию и централизовала большинство работ по разработке передовых моделей, однако развитие AWS замедлилось. В том числе из-за усложнения иерархии после всплеска найма в результате пандемии. В условиях растущей бюрократии принятие решений происходило не так быстро, как раньше. Кроме того, поскольку ПО AWS стало критически важным для крупных корпоративных и государственных клиентов, в компании установили процедуры, призванные снизить риск того, что невнимательный или недовольный сотрудник может сломать что-то важное — это тоже замедляет работу. В некоторых случах часть сотрудников даже заставили получать разрешения на отправку писем высшему руководству. Шен сообщила, что с 2024 года AWS наняла множество новых руководителей и продвигает по службе тех, кто «демонстрирует производительность и готовность к следующему уровню», и что культура AWS остаётся сильной. Сменивший Адама Селипски (Adam Selipsky) на посту гендиректора AWS Мэтт Гарман (Matt Garman), пользующийся большим доверием разработчиков, частично вернул культуру прошлого. От руководителей продуктов требуется открытое признание ошибок и извлечённых уроков, идеи сотрудников принимаются в виде коротких питчей, а сами разработчики ПО работают посменно, обрабатывая запросы поддержки и инциденты по своим продуктам, чтобы понять потребности клиентов. Кроме того, Гарман завершил или прекратила разработку около трёх десятков устаревших и непопулярных продуктов, перенаправив силы на разработку ИИ-инструментов. Тем не менее, сотрудники выражают обеспокоенность тем, что Amazon теряет привлекательность для стартапов. AWS, как известно, помогла зарождению Netflix, но в последние годы порой отдавала приоритет корпорациям с большими расходами, не желая тратить силы на стартапы, которые могут и не стать долгосрочными богатыми клиентами. По словам аналитиков и стартап-консультантов, Google, используя свою известность, инженеров и навыки в передовых ИИ-инструментах, смогла привлечь многих ведущих стартапов в этой сфере. «Если вы сегодня не привлекаете местные стартапы в сфере ИИ, которые в ближайшие пару лет вырастут в пять-десять раз, это может стать реальной проблемой для бизнеса», — сказал Джош Бек (Josh Beck), аналитик Raymond James. Шен же назвала AWS «лучшим выбором для стартапов», приведя в пример Perplexity и Cursor. Но, к примеру, Пит Шваб (Pete Schwab), основатель стартапа Stronghold Labs в области ИИ-анализа видео, выбрал для своего детища площадку Google из-за её ориентации на небольших разработчиков и качества внутренних ИИ-моделей, хотя сам до этого 10 лет проработал в Amazon. AWS «раньше гораздо лучше привлекала таких людей, как мы», — сказал Шваб. Существующие клиенты AWS сейчас также обращаются к услугам её конкурентов, особенно в ИИ-сфере. Например, Grammarly, пользуется AWS, но для ИИ-решений использует модели OpenAI, в том числе в Microsoft Azure, а также Meta✴ Llama, поскольку AWS Bedrock не отвечает ценовым и другим потребностям компании, заявил технический директор стартапа. В начале этого месяца компания представила Quick Suite — чат-бот и набор ИИ-агентов, предназначенных для анализа данных, создания отчётов или резюмирования веб-контента, которые ориентированы на офисных сотрудников. В этой области компания не добилась особого успеха. Руководители в частном порядке признают, что, в отличие от Google и Microsoft, которые могут демонстрировать свои ИИ-инструменты миллиардам клиентов поисковой системы или пользователей ПК, естественный охват AWS ограничен гораздо более узким сообществом разработчиков. Для этой аудитории AWS продолжает расширять возможности Bedrock. Bedrock считается самым успешным ИИ-продуктом компании, число пользователей которого исчисляется десятками тысяч. По словам клиентов и партнёров, отделы продаж сделали увеличение их количества приоритетом. Однако Amazon может преуспеть в эпоху ИИ, просто выступая в качестве поставщика инфраструктуры для других компаний и управляя ею экономически эффективно. По мнению аналитиков, большая часть корпоративных проектов в области ИИ носит экспериментальный характер. Если проект получит более широкую поддержку, экономия средств и надёжная инфраструктура (если не учитывать недавний сбой) — два основных преимущества AWS — станут ещё важнее, утверждают руководители компании.

25.10.2025 [22:49], Сергей Карасёв

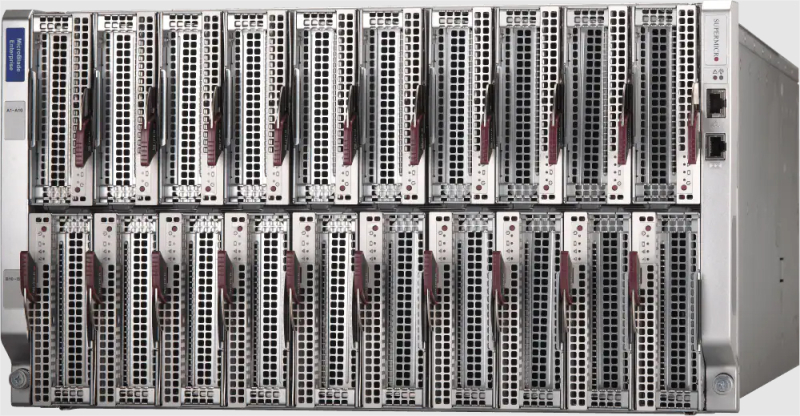

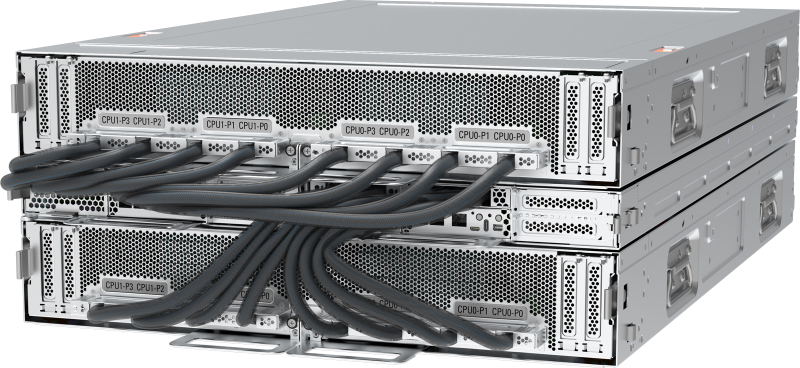

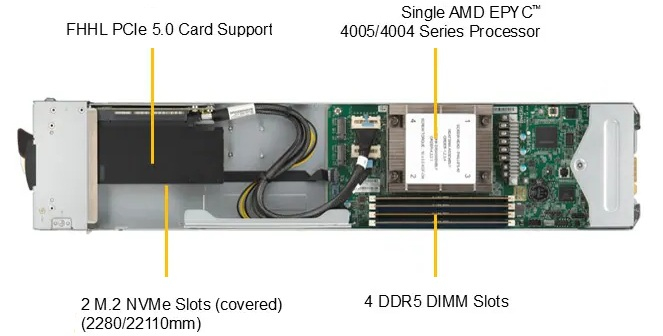

Микрооблако с микро-EPYC: Supermicro представила 20-узловой сервер на базе процессоров AMD GradoКомпания Supermicro анонсировала сервер 6U20N MicroBlade (MBA-315R-1G x20), построенный на аппаратной платформе AMD. Система может применяться для решения таких задач, как облачные вычисления, ИИ-инференс, веб-хостинг, потоковая передача видео и пр.

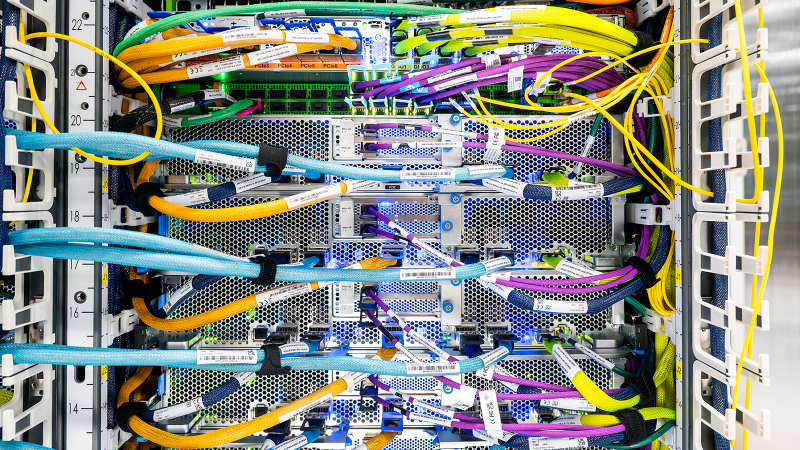

Источник изображений: Supermicro Устройство, выполненное в форм-факторе 6U, имеет 20-узловую конфигурацию. Каждый узел может нести на борту один процессор EPYC 4005 Grado с 16 вычислительными ядрами (32 потока) и показателем TDP до 170 Вт. Применяется воздушное охлаждение. Доступны четыре слота для модулей оперативной памяти DDR5-5600 суммарным объёмом до 192 Гбайт. Каждый узел оснащён двумя сетевыми интерфейсами 25GbE на базе Mellanox ConnectX-4, контроллером Aspeed AST2500 BMC и двумя коннекторами M.2 для SSD (NVMe). Опционально могут устанавливаться два накопителя U.2 (NVMe). Кроме того, возможен монтаж GPU-ускорителя формата FHHL с интерфейсом PCIe 5.0. Сервер 6U20N MicroBlade может нести на борту два Ethernet-коммутатора и два модуля управления. Питание обеспечивают восемь блоков мощностью 2200/3000 Вт с сертификатом 80 Plus Titanium. Диапазон рабочих температур простирается от +10 до +35 °C. В одну серверную стойку стандарта 48U могут быть установлены до восьми таких систем, что в сумме даст 160 вычислительных узлов. В целом, как отмечается, серверы MicroBlade на процессорах EPYC 4005 построены на основе уникальной модульной архитектуры Supermicro, которая обеспечивает сокращение количества кабелей до 95 %, экономию пространства до 70 % и снижение энергопотребления на 30 % по сравнению с традиционными серверами типоразмера 1U.

24.10.2025 [13:15], Руслан Авдеев

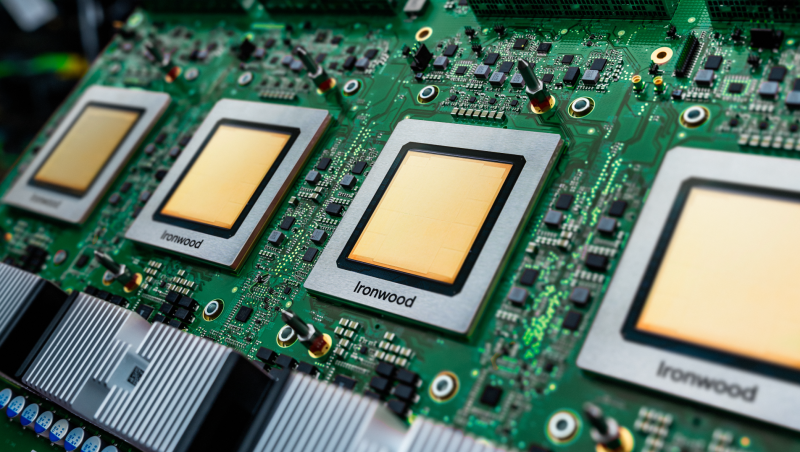

1 млн TPU и 1 ГВт: Anthropic расширит использование ИИ-ускорителей и сервисов Google CloudКомпания Anthropic объявила о знаковом расширении использования чипов TPU Google Cloud. Это обеспечит компании доступ к вычислительным ресурсам, необходимым для обучения и обслуживания ИИ-моделей Claude новых поколений. В 2026 году Anthropic рассчитывает получить доступ к мощностям, превышающим 1 ГВт, сообщает пресс-служба Google Cloud. Речь идёт о крупнейшем увеличении использования TPU компанией Anthropic за всё время использования ей тензорных ускорителей Google. Она получит доступ к 1 млн чипов, а также дополнительным сервисам Google Cloud. По оценкам некоторых экспертов, это примерная пятая часть всех TPU Google, но в 2026 году компания намерена развернуть ещё 2,5 млн TPU. Предполагается, что сделка обеспечит R&D-группы Anthropic передовой инфраструктурой, оптимизированной для ИИ-проектов, на годы вперёд. Как сообщают в Google, Anthropic выбрала TPU из-за привлекательного соотношения цены и производительности, а также благодаря имеющемуся опыту обучения и эксплуатации ИИ-моделей именно с помощью TPU. О стратегическом партнёрстве Anthropic и Google Cloud объявили в 2023 году. На сегодняшний день моделями семейства Claude компании Anthropic в Google Cloud активно пользуются тысячи компаний, включая Figma, Palo Alto Networks, Cursor и др. В Anthropic подчеркнули, что с Google компания давно сотрудничает, а последнее расширение поможет и дальше наращивать вычислительные мощности, необходимые для наращивания возможностей ИИ-систем. В числе клиентов — как компании из списка Fortune 500, так и ИИ-стартапы, которые полагаются на Claude. Расширение вычислительных возможностей гарантирует, что компания сможет удовлетворить стремительно растущий спрос, сохраняя актуальность ИИ-продуктов. В Google Cloud отметили, что Anthropic использует TPU уже несколько лет с оптимальным для неё соотношением цены и производительности, в Google продолжают инновации, опираясь на «зрелое» портфолио ИИ-ускорителей, включая TPU седьмого поколения — Ironwood.

23.10.2025 [17:05], Руслан Авдеев

OpenAI на проводе: поставщик газовых турбин GE Vernova рассчитывает неплохо заработать на ИИ ЦОД гиперскейлеров

general electric

hardware

openai

гиперскейлер

полезные ископаемые

сша

финансы

электропитание

энергетика

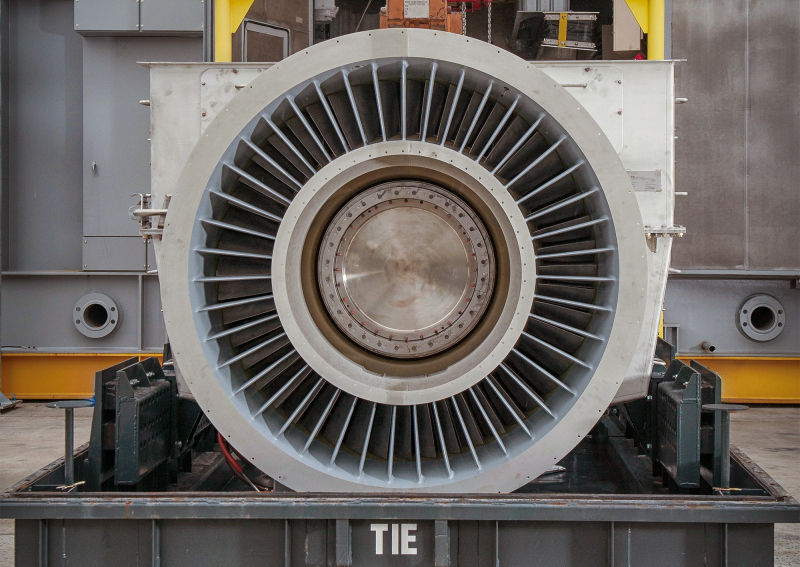

Акции производителя турбин GE Vernova показали рекордное падение после рекордного же роста в этом году из-за опасений компании по поводу будущего рынка. Впрочем, компания надеется на растущий спрос со стороны дата-центров, сообщает Bloomberg. Тем не менее, GE Vernova по-прежнему не уверена в целесообразности расширения производственных мощностей, хотя и полагает, что капитальные расходы предприятий сектора энергетика достигнут пика уже в следующем году. При этом заявление GE Vernova обрушило и акции конкурентов: Vertiv Holdings и Eaton. Спрос на электроэнергию быстро растёт благодаря развитию энергоёмких ИИ ЦОД, новых производств и общей электрификации экономики. Внимание экспертов приковано к тому, как крупные энергокомпании реализуют потенциал роста и избегут ряда рисков. GE Vernova намерена всё активнее поставлять технологическим компаниям, строящим ЦОД, свои газовые турбины. Впрочем, пока около 90 % заказов поступает от обычных клиентов вроде коммунальных компаний и независимых производителей энергии. Примерно 10 % приходятся на гиперскейлеров — $600 млн в 2024 году и $900 млн в этом, с учётом заказов за IV квартал сумма год к году фактически удвоится. Вместе с тем на IT-гигантов также приходится около трети оплаченных предварительных заказов для проектов на ранней стадии реализации. Однако здесь есть важный нюанс — технологические компании нередко финансируют контракты, не будучи конечными операторами турбин. Они лишь принимают участие в проектах, чтобы обеспечить рост отрасли соответствующими их ожиданиям темпами. По словам GE Vernova, турбины практически распроданы уже на весь 2028 год. На 2027 год распределены заказы на значительную часть трансформаторов. Компания также заявила, что намерена купить за $5,3 млрд 50 % акций производителя трансформаторов Prolec GE. В III квартале заказы в энергетическом бизнесе компании выросли на 50 % году к году до $7,8 млрд, заказы в сегменте электрификации выросли на 102 % до $5,1 млрд. Также компания объявила, что портфель её энергетических заказов и запросов вырос с 55 до 62 ГВт, цены на газовые генераторы растут ускоренными темпами, а рентабельность по будущим заказам улучшается. Ожидается, что предварительные запросы превратятся в настоящие заказы в течение 2026 года, что обеспечит компании увеличение и выручки, и прибыли. Глава GE Vernova отметил, что в последние недели часто виделся с руководителем OpenAI Сэмом Альтманом (Sam Altman) и его командой. OpenAI является неотъемлемой частью амбициозного плана по развитию бизнеса GE Vernova. Речь идёт как о партнёрстве в сфере генерации энергии, так и поставках электрического оборудования. Компания уже стала ключевым поставщиком энергетического оборудования почти всем ключевым гиперскейлерам, включая OpenAI и Oracle (Crusoe и не только), Google (NextEra) и xAI. По словам экспертов, сейчас главной проблемой GE Vernova являются ограниченные возможности производства, меняющаяся тарифная политика, которая уже обошлась компании в $300–$400 млн, и регуляторы, из-за которых, в частности, упали заказы на ветряки. У бизнеса может появиться сильный конкурент. Компания ProEnergy предложила запитать ЦОД от своих газовых генераторов на основе старых авиадвигателей. Они будут доступны тысячами после списания с авиалайнеров.

22.10.2025 [21:00], Руслан Авдеев

От винта! ProEnergy предложила запитать ЦОД от старых авиадвигателей

general electric

hardware

авиация

дефицит

полезные ископаемые

сша

утилизация

цод

экология

электропитание

энергетика

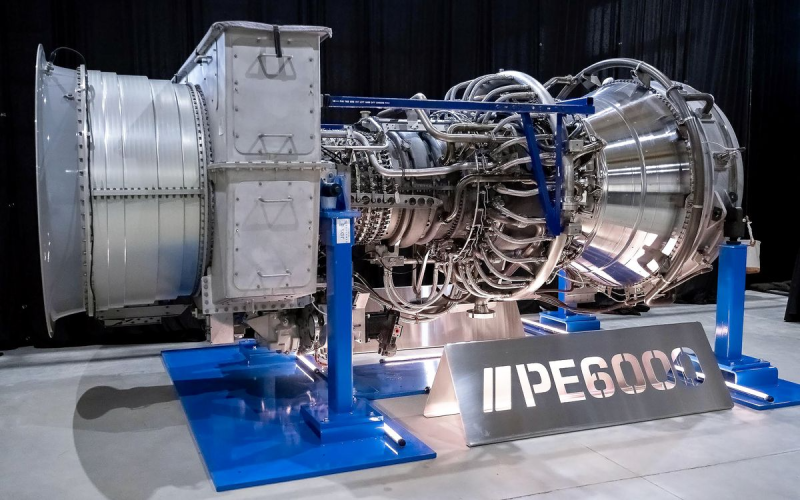

Строители ЦОД столкнулись с серьёзным дефицитом энергии, пытаясь строить всё более крупные объекты для ИИ-инициатив. На помощь готова прийти компания ProEnergy, предложившая альтернативу классическим источникам энергии — бывшие в употреблении авиационные двигатели, сообщает IEEE Spectrum. Некоторые ЦОД уже используют газовые генераторы ProEnergy PE6000 во время строительства и первых лет эксплуатации. После присоединения к энергосети турбины становятся резервными источниками питания, причём иногда не только для ЦОД, но и для местных коммунальных компаний. Впрочем, идея не нова. Производители газотурбинных установок вроде GE Vernova и Siemens Energy давно используют адаптированные авиационные двигатели для создания стационарных генераторов, у которых уже есть своя ниша на рынке — они легче, компактнее и проще в обслуживании, чем обычные газотурбинные установки. Правда, по словам экспертов Axford Turbine Consultants, чтобы заставить авиационный двигатель вырабатывать электроэнергию, приходится приложить немало усилий. Газовая турбина LM6000 компании GE Vernova была создана на основе успешного турбовинтового двигателя GE CF6-80C2, широко применяемого в коммерческих самолётах. Двигатель появился в 1985 году, а LM6000 — пятью годами позже. В конструкцию пришлось внести немало изменений, в том числе позволяющих вместо авиационного топлива работать на природном газе. Кроме того, важен и экологический аспект, поскольку классический двигатель выбрасывает немало оксидов азота в ходе работы.

Источник изображения: ProEnergy Так или иначе, Generative Power Solutions утверждает, что классических газовых турбин просто не хватает, сроки поставок LM6000 составляют 3–5 лет. То же можно сказать и об «авиационной» турбине SGT-A35 компании Siemens Energy. Сроки ожидания некоторых популярных моделей ещё больше. Так, PE6000 обещают поставить в 2027 году. Производители, конечно, видят спрос со стороны дата-центров, но расширять производство пока опасаются из-за возможного краха ИИ-сектора. Переделанный двигатель от ProEnergy может обеспечить до 48 МВт, чего достаточно для небольших и средних ЦОД или 20–40 тыс. домохозяйств. ProEnergy предлагает готовые к развёртыванию установки PE6000 на базе отремонтированных и доработанных б/у двигателей CF6-80C2. ProEnergy продаёт двухтурбинные блоки стандартной конфигурации. Они включают газовые турбины, собственно генераторы и множество других компонентов вроде систем охлаждения воздуха, поступающего в турбины в жаркие дни и т. п. Компания специализируется исключительно на модели CF6-80C2 для оптимизации и упрощения проектирования и обслуживания. Первоначально PE6000 предназначался для коммунальных служб для компенсации нагрузок в часы пик. Из-за бума ЦОД операторы последних хотят сами приобретать генерирующие мощности, работающие на природном газе и готовые к эксплуатации в течение 5 минут после запуска. Замена нуждающегося в обслуживании двигателя осуществляется в течение 72 ч., а уровень выбросов ниже норм Агентства по охране окружающей среды США. С 2020 года ProEnergy выпустила 75 комплектов PE6000, на очереди ещё 52. В компании рассчитывают, что в следующие 10 лет около 1 тыс. авиадвигателей выведут из эксплуатации, поэтому недостатка в них не будет. Популярности модели способствует не только резкий рост количества дата-центров, но и необходимость подолгу ждать подключения к электросети — иногда до 8–10 лет. В этих условиях турбины на основе авиадвигателей выступают как промежуточная технология, которая будет работать, пока коммунальная компания не будет готова обеспечить присоединение. По такому пути, например, пошла xAI, которая смогла в кратчайшие сроки запустить свои ИИ ЦОД, но столкнулась с противодействием экоактивистов.

18.10.2025 [22:25], Владимир Мироненко

К полувековому юбилею суперкомпьютера Cray-1 выпущена памятная однодолларовая монетаМонетный двор США представил дизайн памятных однодолларовых монет для программы 2026 American Innovation $1 Coin Program. На одной из них изображён Cray-1 — один из самых известных суперкомпьютеров всех времён, отличавшийся инновационной для своего времени конструкцией и уникальным дизайном. В рамках этой программы, действующей с 2018 года, ежегодно выпускаются четыре монеты, представляющие «американские инновации, а также значительные инновационные и новаторские достижения отдельных лиц или групп». В этом году дизайн монет для программы был предложен штатами Айова, Висконсин, Калифорния и Миннесота. Дизайн монеты с изображением Cray-1 был предложен штатом Висконсин, где находится исследовательский центр Cray Research, в котором был создан Cray-1 под руководством ныне покойного Сеймура Крея (Seymour Cray) и соучредителя, главного инженера Лестера Дэвиса (Lester Davis). На лицевой стороне монеты размещено изображение вида сверху суперкомпьютера Cray-1 с круговым расположением вычислительных блоков. На С-образном корпусе машины видна надпись Cray-1 Supercomputer, а также подписи художника и скульптора Пола Романо (Paul Romano) и Джона П. Макгроу (John P. McGraw). Также есть надписи «Соединённые штаты Америки» и «Висконсин». Памятные монеты вряд ли поступят в регулярное обращение, и их вряд ли можно будет купить в банке за доллар. Они являются законным платёжным средством, но в первую очередь — предметом коллекционирования. Предыдущие памятные долларовые монеты продавались монетным двором по цене от $13,25. Cray-1 стал первым суперкомпьютером, в котором была успешно реализована концепция векторного процессора, позволяющего повысить скорость математических операций путём оптимальной организации памяти и регистров для быстрого выполнения одной операции с большим набором данных. В предыдущих системах эта концепция была реализована с ограниченной производительностью. Cray-1 работал в несколько раз быстрее любой аналогичной конструкции и лидировал среди суперкомпьютеров с 1976 по 1982 год, достигая впечатляющих 160 Мфлопс благодаря инновационному использованию интегральных схем. За всё время существования системы на рынке было продано более 80 машин, что сделало Cray-1 одним из самых успешных в этой категории за всю историю вычислительных систем. Он известен своей уникальной формой: относительно небольшим С-образным корпусом, окружённым кольцом «тумбочек», закрывающих блоки питания и систему охлаждения. Согласно «Википедии», после анонса Cray-1 с частотой 80 МГц в 1975 году ажиотаж вокруг него был настолько велик, что между Ливерморской национальной лабораторией имени Лоуренса (LLNL) и Лос-Аламосской национальной лабораторией (LANL) разгорелась настоящая война за право покупки первой машины. В итоге последняя выиграла тендер и получила в 1976 году первый экземпляр Cray-1 с серийным номером 001. Национальный центр атмосферных исследований США (NCAR) стал первым официальным клиентом Cray Research в 1977 году, заплатив $8,86 млн (сейчас это более $47 млн с учётом инфляции) за суперкомпьютер с серийным номером 003. Этот суперкомпьютер был выведен из эксплуатации в 1989 году.

16.10.2025 [16:44], Сергей Карасёв

Pegatron представила ИИ-сервер AS501-4A1-16I1 с СЖО и 16 ускорителями AMD Instinct MI355XPegatron анонсировала высокопроизводительный сервер AS501-4A1-16I1 с СЖО для задач НРС, а также ресурсоёмких приложений ИИ, включая инференс и обучение больших языковых моделей. Устройство выполнено в форм-факторе 5OU на аппаратной платформе AMD. До восьми серверов AS501-4A1-16I1 могут быть установлены в стойку RA5100-128I1. Это позволяет сформировать ИИ-систему высокой плотности, насчитывающую до 32 процессоров EPYC 9005 и до 128 ускорителей Instinct MI355X. Конструкция системы включает два CPU-узла и два лотка GPU. Каждая из CPU-секций допускает установку двух процессоров AMD EPYC 9005 Turin с показателем TDP до 500 Вт и 24 модулей оперативной памяти DDR5-6400 RDIMM. Таким образом, в общей сложности могут быть задействованы четыре чипа EPYC и 48 модулей ОЗУ. В свою очередь, каждый из GPU-лотков оснащается восемью ускорителями AMD Instinct MI355X, которые несут на борту 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. В общей сложности реализованы 12 слотов PCIe 5.0 x16 FHHL, в которые установлены десять однопортовых сетевых адаптеров 400GbE и два двухпортовых адаптера 10GbE В оснащение входят контроллер Aspeed AST2600, два сетевых порта 1GbE (RJ45), выделенный сетевой порт управления (RJ45), последовательный порт (разъём Micro-USB), интерфейсы USB 2.0 Type-C и Mini-DP. В дополнение к СЖО имеются десять вентиляторов охлаждения. Применяется шина питания ORv3 на 48 В DC.

16.10.2025 [12:12], Руслан Авдеев

Группа инвесторов, включающая NVIDIA, под руководством Macquarie Asset Management купит Aligned Data Centers за $40 млрд — это одна из крупнейших сделок на рынке ЦОДГруппа AI Infrastructure Partnership (AIP), фонд MGX из ОАЭ и Global Infrastructure Partners (GIP) под руководством Macquarie Asset Management намерены приобрести техасского оператора ЦОД Aligned Data Centers за $40 млрд. Сделка заключена в рамках более широкого проекта по развитию ИИ-инфраструктуры, сообщает пресс-служба Macquaire, и станет одной из крупнейших на рынке ЦОД. Ожидается, что сделка будет закрыта в I полугодии 2026 года. AIP включает NVIDIA, BlackRock, Microsoft, xAI, Global Infrastructure Partners (GIP, принадлежит BlackRock) и государственную инвесткомпанию (создана при участии Mubadala и G42) из ОАЭ. AI Infrastructure Partnership была сформирована в 2024 году с целью ускорения инвестиций в ИИ-инфраструктуру нового поколения. По словам BlackRock, благодаря инвестициям в Aligned будет обеспечено создание инфраструктуры, необходимой для будущих ИИ-проектов. Aligned располагает 50 дата-центрами и 5 ГВт доступной мощности. Помимо США Aligned имеет серьёзный бизнес в Латинской Америке — компания приобрела OData, владеющей объектами в Бразилии, Чили, Колумбии и Мексике в мае 2023 года. Также она является инвестором канадского оператора ЦОД QScale SEC.

Источник изображения: Aligned Data Centers Как сообщает Datacenter Knowledge, в последние месяцы IT-гиганты тратили миллиарды долларов на создание достаточной для удовлетворения спроса инфраструктуры ЦОД на фоне нарастающего интереса бизнеса к ИИ. В UBS утверждают, что мировые инвестиции в искусственный интеллект могут составить в 2025 году $375 млрд, а к 2026 году — $500 млрд. Руководство Aligned Data Centers заявило, что новое партнёрство будет способствовать ускоренному выполнению миссии по созданию инфраструктуры, обеспечивающей будущее цифровой экономики. Компания утверждает, что готова к более активному масштабированию, дальнейшим инновациям и переосмыслению возможностей устойчивой инфраструктуры ЦОД. Руководителем Aligned останется Эндрю Шаап (Andrew Schaap), а компания сохранит штаб-квартиру в Далласе (Техас).

15.10.2025 [12:14], Владимир Мироненко

Oracle запустит в 2026 году ИИ-кластер на базе 50 тыс. AMD Instinct MI450Oracle объявила о расширении сотрудничества с AMD, в рамках которого Oracle Cloud Infrastructure (OCI) запустит первый публично доступный ИИ-суперкластер на базе 50 тыс. ускорителей AMD Instinct MI450. Согласно пресс-релизу, первоначальное развёртывание кластера начнётся в III квартале 2026 года, после чего он будет расширяться в 2027 году, а также в дальнейшем. Будущие ИИ-кластеры OCI будут основаны на стоечной архитектуре AMD Helios с использованием ускорителей AMD Instinct серии MI450, процессоров AMD EPYC следующего поколения с кодовым названием Venice и сетевой системы AMD Pensando следующего поколения с кодовым названием Vulcano. Махеш Тиагараджан (Mahesh Thiagarajan), исполнительный вице-президент OCI отметил, что благодаря десятилетнему сотрудничеству с AMD — от ускорителей EPYC до AMD Instinct — компания продолжает предоставлять «оптимальную по соотношению цены и производительности, открытую, безопасную и масштабируемую облачную платформу в партнерстве с AMD, чтобы удовлетворить потребности клиентов в новой эре ИИ». Ускоритель AMD Instinct MI450 основан на архитектуре CDNA 5 и изготавливается по 2-нм техпроцессу TSMC. Ускоритель будет обладать до 432 Гбайт памяти HBM4 с пропускной способностью 20 Тбайт/с. Стойка AMD Helios с 72 ускорителями AMD Instinct MI450 объединяет возможности масштабирования UALoE и масштабируемую сеть на базе Ethernet, соответствующую стандартам Ultra Ethernet (UEC), для минимизации задержек и максимальной пропускной способности между модулями и стойками.

Источник изображения: Oracle Сообщается, что процессоры EPYC (Venice) будут предлагать возможности конфиденциальных вычислений и встроенные функции безопасности для комплексной защиты конфиденциальных рабочих ИИ-нагрузок. Конвергентные сети с DPU, созданные на основе полностью программируемой технологии AMD Pensando, обеспечат безопасность и производительность, необходимые ЦОД для работы с ИИ следующего поколения, включая обучение, инференс и облачные рабочие нагрузки. Каждый ускоритель может быть оснащён до трёх DPU Vulcano со скоростью передачи данных 800 Гбит/с. Несколько месяцев назад Oracle и AMD объявили, что провайдер облачных вычислений развернёт кластер, включающий до 131 072 ускорителей AMD MI355X, на основе ранее запущенного кластера на базе AMD Instinct MI300X. Ранее в этом месяце стало известно о соглашении AMD с OpenAI на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт на сумму около $60–$80 млрд для обеспечения её ИИ-инфраструктуры.

14.10.2025 [20:58], Владимир Мироненко

Oracle анонсировала крупнейший в мире зеттафлопсный ИИ-кластер OCI Zettascale10: до 800 тыс. ускорителей NVIDIA в нескольких ЦОД

800gbe

ethernet

hardware

hpc

nvidia

oracle

oracle cloud infrastructure

stargate

ии

интерконнект

кластер

сша

цод

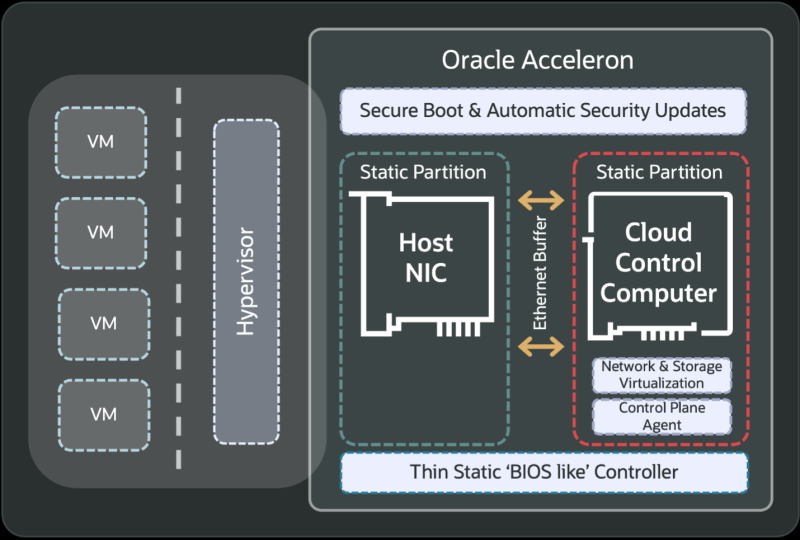

Oracle анонсировала облачный ИИ-кластер OCI Zettascale10 на базе сотен тысяч ускорителей NVIDIA, размещённых в нескольких ЦОД, который имеет пиковую ИИ-производительность 16 Зфлопс (точность вычислений не указана). OCI Zettascale10 — это инфраструктура, на которой базируется флагманский ИИ-суперкластер, созданный совместно с OpenAI в техасском Абилине (Abilene) в рамках проекта Stargate и основанный на сетевой архитектуре Oracle Acceleron RoCE нового поколения. OCI Zettascale10 использует NVIDIA Spectrum-X Ethernet — первую, по словам NVIDIA, Ethernet-платформу, которая обеспечивает высокую масштабируемость, чрезвычайно низкую задержку между ускорителями в кластере, лидирующее в отрасли соотношение цены и производительности, улучшенное использование кластера и надежность, необходимую для крупномасштабных ИИ-задач. Как отметила Oracle, OCI Zettascale10 является «мощным развитием» первого облачного ИИ-кластера Zettascale, который был представлен в сентябре 2024 года. Кластеры OCI Zettascale10 будут располагаться в больших кампусах ЦОД мощностью в гигаватты с высокоплотным размещением в радиусе двух километров, чтобы обеспечить наилучшую задержку между ускорителями для крупномасштабных задач ИИ-обучения. Именно такой подход выбран для кампуса Stargate в Техасе. Oracle отметила, что помимо возможности создавать, обучать и развёртывать крупнейшие ИИ-модели, потребляя меньше энергии на единицу производительности и обеспечивая высокую надёжность, клиенты получат свободу работы в распределённом облаке Oracle со строгим контролем над данными и суверенитетом ИИ. Изначально кластеры OCI Zettascale10 будут рассчитаны на развёртывание до 800 тыс. ускорителей NVIDIA, обеспечивая предсказуемую производительность и высокую экономическую эффективность, а также высокую пропускную способность между ними благодаря RoCEv2-интерконнекту Oracle Acceleron со сверхнизкой задержкой. Acceleron предлагает 400G/800G-подключение со сверхнизкой задержкой, двухуровневую топологию, множественное подключение одного NIC к нескольким коммутатором с физической и логической изоляцией сетевых потоков, поддержку LPO/LRO и гибкость конфигурации. DPU Pensando от AMD в Acceleron место тоже нашлось. OCI уже принимает заказы на OCI Zettascale10, который поступит в продажу во II половине следующего календарного года. В августе NVIDIA анонсировала решение Spectrum-XGS Ethernet для объединения нескольких ЦОД в одну ИИ-суперфабрику, которым, по-видимому, воспользуется не только Oracle, но и Meta✴. |

|