Материалы по тегу: c

|

11.10.2025 [11:45], Сергей Карасёв

Молдова стала участником европейской суперкомпьютерной программы EuroHPC JUЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о том, что Молдова стала 37-м государством, присоединившимся к данному проекту. Решение принято в ходе очередного заседания Совета управляющих EuroHPC JU. Отмечается, что с января 2012 года Молдова активно участвует в инициативах Европейского союза по исследованиям и инновациям. В частности, в рамках программы Horizon 2020 специалистам из академических кругов, исследовательских институтов, органов государственной власти и индустриального сектора Молдовы предоставляется доступ к суперкомпьютерам EuroHPC. Теперь Молдова стала полноправным участником EuroHPC: ожидается, что это позволит укрепить взаимодействие между страной и другими европейскими исследователями. В частности, молдавские ученые смогут подавать заявки на исследовательские и инновационные инициативы EuroHPC JU, финансируемые по программе Horizon Europe. Речь идёт о разработке суперкомпьютерных технологий и сопутствующих программных продуктов. Кроме того, Молдова сможет принять участие в запуске фабрик ИИ (EuroHPC AI Factories), которые формируются по всей Европе. Эти площадки призваны помочь в создании высококонкурентной и инновационной европейской экосистемы ИИ. Молдова присоединилась к другим государствам — участникам программы EuroHPC JU, которые не являются членами Евросоюза. В их число также входят Албания, Исландия, Израиль, Черногория, Северная Македония, Норвегия, Сербия, Турция и Великобритания. Эти страны сотрудничают с ЕС с целью достижения стратегической независимости в области HPC, ИИ, квантовых вычислений и суперкомпьютерных технологий. В настоящее время EuroHPC JU курирует реализацию 13 проектов по созданию фабрик ИИ. Недавно при участии EuroHPC JU был официально введён в эксплуатацию первый в Европе суперкомпьютер экзафлопсного класса — система JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research), которая размещена в Юлихском исследовательском центре (FZJ) в Германии. EuroHPC JU также разворачивает европейскую инфраструктуру квантовых вычислений, интегрируя квантовые технологии с существующими суперкомпьютерами.

08.10.2025 [15:30], Сергей Карасёв

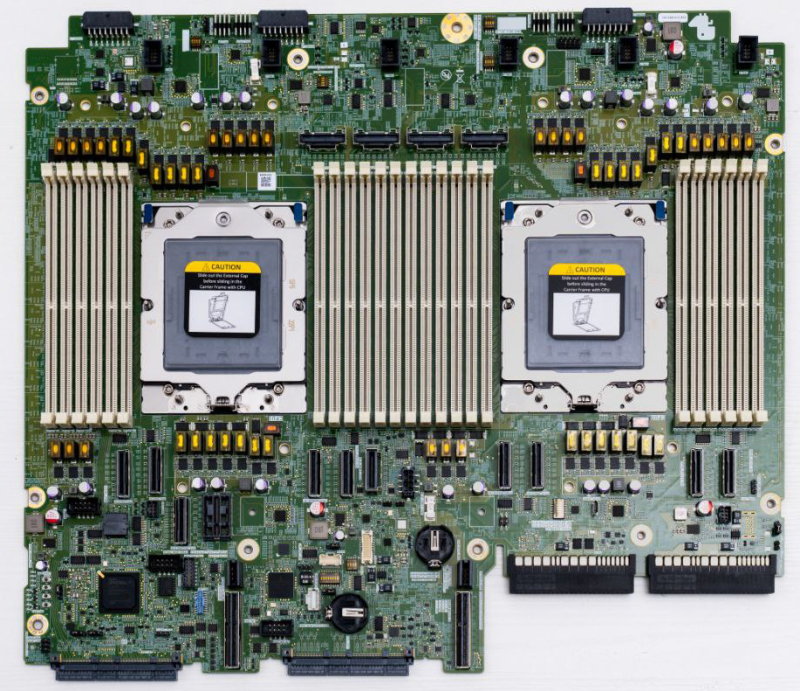

Selectel представила российскую серверную платформу на базе AMD EPYC 9005 TurinКомпания Selectel объявила о разработке собственной материнской платы, предназначенной для построения российских серверов на процессорах AMD EPYC 9005 Turin. Новинка дополнит представленные ранее серверы SSE-I112-G6 и SSE-I224-G6 на базе Intel Xeon 6 (6700). Изделие рассчитано на установку двух чипов в исполнении SP5, которые могут насчитывать до 192 вычислительных ядер. Доступны 24 слота для модулей оперативной памяти DDR5-6400. Платформа допускает подключение до 24 накопителей NVMe (PCIe 5.0) формата SFF и до 12 устройств стандарта LFF, что позволяет создавать высокопроизводительные серверы хранения данных. Прочие технические характеристики платы таковы: два разъёма OCP NIC 3.0 x16, два сетевых порта 1GbE, по два порта USB 3.2 на передней и задней панелях, контроллер ASPEED AST2600 (прошивка собственная). Могут быть использованы два райзера с поддержкой разъёмов FHFL PCIe 5.0: два x16 в первом и один или два x8/x16 во втором. Упомянуто управление питанием FPGA. По заявлениям Selectel, серверы на новой материнской плате могут заинтересовать корпоративных заказчиков из финансового сектора и телеком-операторов. Кроме того, такие устройства могут найти применение в сферах ИИ и НРС. Потенциальными покупателями также названы SaaS-компании, которые стремятся сократить операционные расходы. Заместитель генерального директора по разработке и эксплуатации продуктов Selectel, отмечает, что выпуск решений на базе процессоров AMD в дополнение к Intel-продуктам даёт возможность диверсифицировать технологические платформы. Это важно в условиях сформировавшейся геополитической обстановки, когда поставки зарубежных CPU могут быть нестабильными. Кроме того, заказчики получают дополнительную гибкость при построении IT-инфраструктуры.

07.10.2025 [09:13], Сергей Карасёв

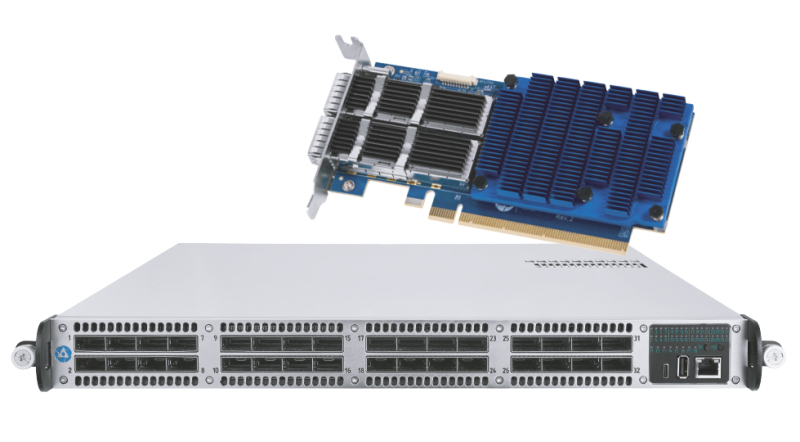

«Росатом» создал российский интерконнет «Альфа»: до 80 Гбит/с на порт и до 4096 узловНаучно-производственное объединение «Критические информационные системы» (НПО КИС), входящее в «Росатом», представило коммуникационную сеть Альфа, предназначенную для передачи данных между узлами вычислительных систем с высокой скоростью и малой задержкой. В качестве сфер применения сети «Альфа» названы СХД, СУБД, суперкомпьютеры и кластеры (в том числе на основе GPU), бортовые вычислительные комплексы и пр. Архитектура «Альфы» предполагает использование чипа на базе ПЛИС и хост-интерфейса PCIe 3.0 x16. Топология — 5D-тор, Fat Tree, Dragonfly+. Реализована поддержка медных и оптических кабелей, прямого доступа в память удалённого узла (RDMA), атомарных операций и вызовов удалённых прерываний, а также счётчиков производительности и исключительных ситуаций. Передача данных происходит без участия ядра ОС (в пространстве пользователя). Заявленная пропускная способность достигает 80 Гбит/с на порт, пропускная способность MPI (Message Passing Interface) — 72,5 Гбит/с. Задержка между соседними узлами составляет 1,7 мкс, задержка узла — 0,5 мкс. Темп выдачи сообщений — 50 МТ/с. Возможно масштабирование до 4096 узлов. Для сети «Альфа» разработаны адаптер и коммутатор. Первый выполнен в виде HHHL-карты с интерфейсом PCIe 3.0 x16. Предусмотрены два порта QSFP-DD. Применяется пассивная система охлаждения, потребляемая мощность — до 29,5 Вт. Изделие имеет размеры 142,25 × 68,9 × 17,25 мм. Возможно объединение в кольцо до восьми адаптеров без использования коммутатора. В свою очередь, коммутатор располагает 32 портами QSFP-DD: устройство представляет собой четыре модуля коммутации, соединённых в кольцо. Решение выполнено в форм-факторе 1U с габаритами 650 × 43,6 × 440 мм. Используется активное воздушное охлаждение, а энергопотребление не превышает 300 Вт. Коммутатор получил блок питания с резервированием.

06.10.2025 [14:27], Сергей Карасёв

GIP близка к поглощению оператора ЦОД Aligned Data Centers за $40 млрдИнвестиционная компания Global Infrastructure Partners (GIP), по сообщению Bloomberg, ведёт переговоры о покупке Aligned Data Centers — техасского оператора ЦОД. Стоимость последнего в рамках готовящейся сделки может составить около $40 млрд. В случае успеха сделка станет одной из крупнейших на рынке. На сегодняшний день Aligned Data Centers оперирует кампусами в Чикаго (штат Иллинойс), Далласе (штат Техас), Солт-Лейк-Сити (штат Юта), Финиксе (штат Аризона) и Северной Вирджинии. Кроме того, компания занимается строительством объектов в Мэриленде, Огайо, Иллинойсе и Вирджинии. В начале текущего года Aligned Data Centers привлекла на развитие $12 млрд в виде долговых обязательств и акционерного капитала из фондов, подконтрольных австралийской Macquarie Asset Management. Деньги помогут в развитии инфраструктуры ИИ ЦОД. В свою очередь, компания GIP, основанная в 2006 году, управляет клиентскими активами на сумму более $100 млрд. Первоочередное внимание уделяется секторам энергетики, транспорта, водоснабжения и утилизации отходов, а также цифровым технологиям, включая направление дата-центров. В январе 2024 года одна из крупнейших в мире инвестиционных компаний BlackRock приобрела GIP за $12,5 млрд. При этом сама BlackRock также владеет европейским оператором Mainova Webhouse. По информации Bloomberg, в сделке между GIP и Aligned Data Centers может принять участие инвестиционный фонд MGX, принадлежащий государственной холдинговой компании из Абу-Даби Mubadala Investment Company. При этом MGX уже владеет долей в Aligned Data Centers. Предполагается, что о продаже оператора ЦОД будет официально объявлено в ближайшее время. Ни одна из сторон комментарии по данному вопросу не даёт.

06.10.2025 [10:54], Владимир Мироненко

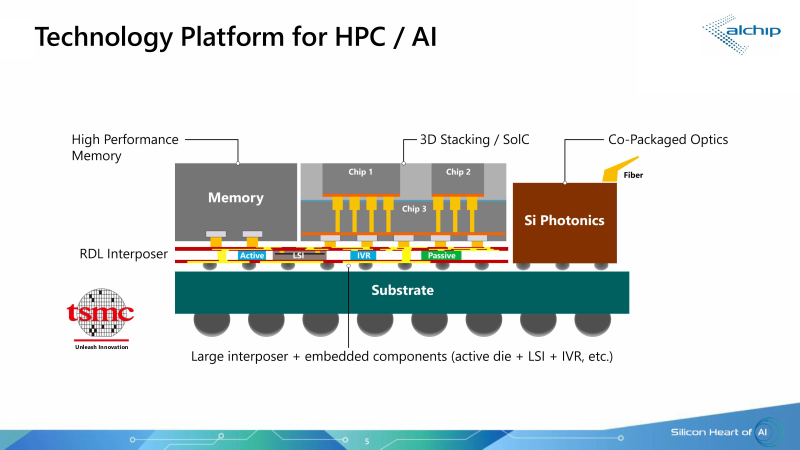

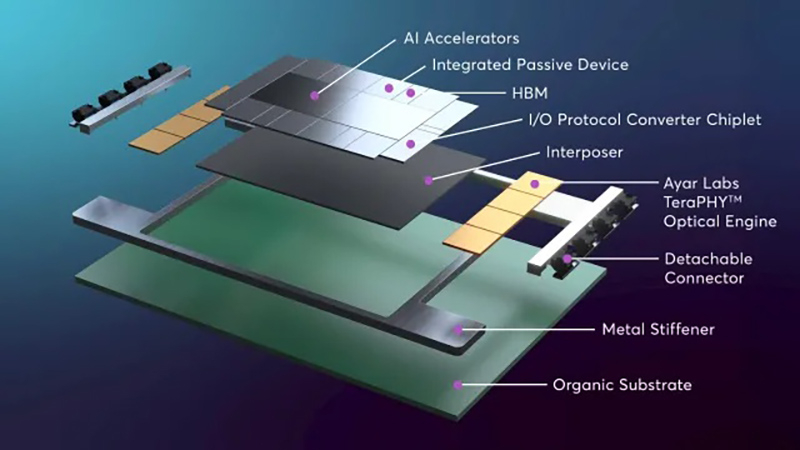

250 Тбит/с на чип: Ayar Labs, Alchip и TSMC предложили референс-дизайн для упаковки ASIC, памяти и оптических модулей в одном чипеКомпания Ayar Labs (США), занимающаяся разработкой интерконнекта на базе кремниевой фотоники, и тайваньский производитель ASIC-решений Alchip Technologies представили референсную платформу проектирования ИИ ASIC с несколькими оптическими IO-модулями на основе технологии кремниевой фотоники TSMC COUPE (Compact Universal Photonic Engine). В начале сентября компании объявили о стратегическом партнёрстве с целью ускорения масштабирования ИИ-инфраструктуры благодаря объединению технологии CPO компании Ayar Labs, экспертизы Alchip в области создания и упаковки кастомных ASIC, а также технологии упаковки и техпроцесса компании TSMC. Как сообщил технический директор Ayar Labs Владимир Стоянович (Vladimir Stojanovic) в интервью EE Times, платформа предназначена для устранения узких мест в передаче данных, замедляющих работу ИИ-инфраструктуры, путём эффективного сокращения времени простоя системы и создания крупных высокопроизводительных ИИ-кластеров нового поколения. Партнёры отметили, что по мере роста ИИ-моделей и размеров кластеров традиционные медные соединения достигают своих физических и энергетических пределов. Путём замены меди на интегрированную оптику (CPO) решение Alchip и Ayar Labs обеспечивает расширенную дальность связи, низкую задержку, энергоэффективность и высокий радикс, необходимые для масштабных развертываний ИИ-ускорителей. «Масштабируемые сети ИИ-кластеров ограничены расстоянием медных соединений. В то же время энергоэффективность сети ограничена плотностью мощности и возможностями систем охлаждения», — пояснил Эрез Шайзаф (Erez Shaizaf), технический директор Alchip, добавив, что CPO снимает эти ограничения. Новое совместное решение включает оптические модули Ayar Labs TeraPHY, размещённые вместе с решениями Alchip на общей подложке, обеспечивая прямой доступ ИИ-ускорителя к оптическому интерфейсу. Такая интеграция обеспечивает пропускную способность 100+ Тбит/с на каждый ускоритель и поддерживает более 256 оптических портов на устройство. TeraPHY не привязан к какому-либо протоколу и обеспечивает гибкую интеграцию с кастомными чиплетами. Референсный дизайн позволяет партнёрам «заложить основу» для быстрого создания подобной системы. Платформа референсного проекта включает два вычислительных кристалла с чиплетами HBM и другими чиплетами, в сочетании с восемью оптическими IO-модулями на базе чиплета TeraPHY. Такая конструкция обеспечит двустороннюю пропускную способность 200–250 Тбит/с для каждой сборки (SiP), что значительно превышает показатели современных крупных GPU, сообщил Стоянович. Это позволит масштабировать систему, а также значительно расширить объём памяти, имеющей пропускную способность, сопоставимую с HBM, добавил он. Оптический модуль Ayar Labs основан на чиплете TeraPHY PIC с двумя дополнительными слоями чиплетов, собранными с помощью TSMC COUPE. Два слоя электронных чиплетов собраны по технологии TSMC SoIC (System on Integrated Chips), которая использует вертикальное размещение нескольких кристаллов друг над другом, чтобы обеспечить более плотное соединение между ними, позволяя снизить энергопотребление, увеличить производительность и уменьшить задержки. По словам Стояновича, такой дизайн будет масштабироваться до уровня UCIe-A и выше как минимум в течение следующего десятилетия.  Совместное решение Alchip и Ayar Labs позволяет масштабировать многостоечную сетевую фабрику без потерь мощности и задержек, характерных для подключаемых оптических кабелей, за счёт минимизации длины электрических трасс и размещения оптических соединений вблизи вычислительного ядра. Благодаря поддержке UCIe для межкомпонентных соединений и гибкому размещению конечных точек на границе чипов, команды разработчиков могут интегрировать масштабируемое решение Alchip и Ayar Labs с существующими вычислительными блоками, стеками памяти и ускорителями, обеспечивая при этом соблюдение требований к производительности, целостности сигнала и температурному режиму на уровне всей сборки. Как сообщается, компании предоставят командам разработчиков дополнительные материалы, референсные архитектуры и варианты сборки. Платформа референсного дизайна включает в себя тестовые программы, позволяющие тестировать сборку и прошивку управления модулем, что облегчает его интеграцию в сборку. «Заказчику нужна поддержка, чтобы он понимал процессы оценки надёжности и испытаний, поэтому мы тесно сотрудничаем с Alchip, чтобы предоставить заказчику доступ ко всему этому пакету», — рассказал Стоянович.

04.10.2025 [12:56], Сергей Карасёв

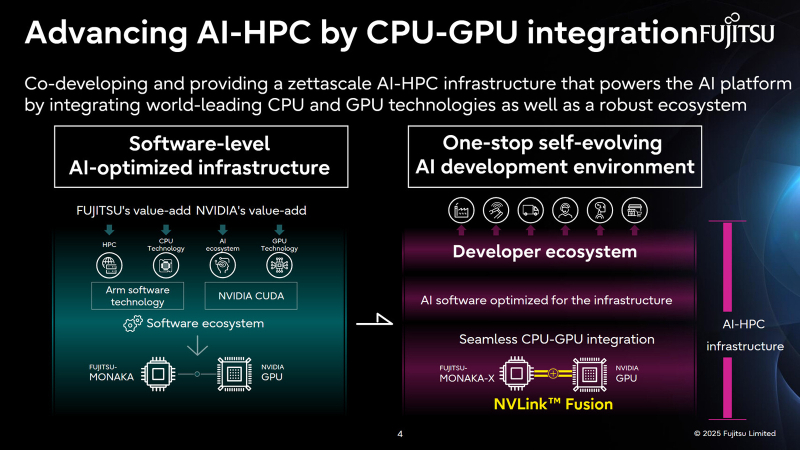

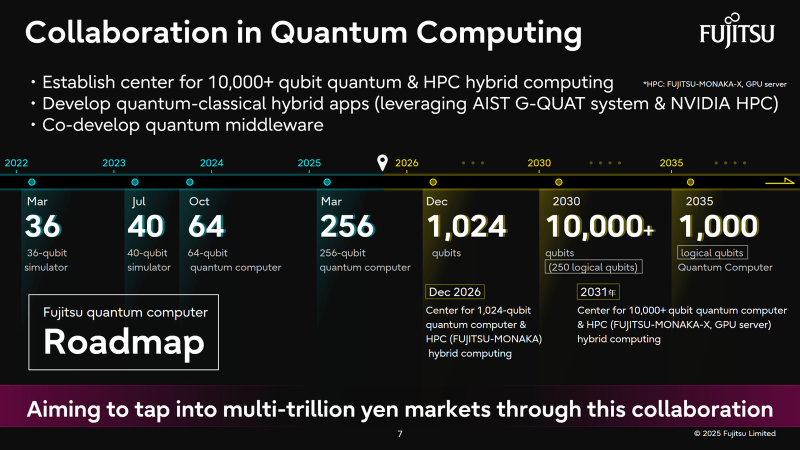

Fujitsu и NVIDIA создадут вычислительную ИИ-инфраструктуру нового поколенияЯпонская корпорация Fujitsu объявила о расширении стратегического сотрудничества с NVIDIA с целью создания полнофункциональной инфраструктуры ИИ следующего поколения, в состав которой войдут ИИ-агенты. Предполагается, что инициатива поможет ускорить развитие таких отраслей, как здравоохранение, производство, робототехника и др. Партнёры намерены работать по ряду направлений. В частности, Fujitsu и NVIDIA займутся созданием передовой вычислительной инфраструктуры для задач ИИ. Речь идёт об объединении серверных процессоров Fujitsu Monaka на архитектуре Arm с высокопроизводительными GPU разработки NVIDIA. Для этого будет задействована технология NVLink Fusion, позволяющая применять скоростные интерконнекты NVLink со сторонними чипами. Конечной целью является предоставление комплексной экосистемы HPC-ИИ с интегрированным софтом Fujitsu для Arm-процессоров и NVIDIA CUDA. Кроме того, сотрудничество предусматривает создание «саморазвивающейся» платформы ИИ-агентов. Она, как ожидается, обеспечит высокую производительность и безопасность. Планируется внедрение механизма, который позволит агентам и моделям ИИ развиваться автономно с возможностью оптимизации под запросы конкретных отраслей. В конечном итоге, такие агенты будут предоставляться заказчикам в виде микросервисов NVIDIA NIM. Ещё одним направлением сотрудничества названо формирование партнёрской экосистемы для расширения использования агентов и моделей ИИ. Планируется также разработка передовых квантовых технологий, включая гибридные квантово-классические вычислительные системы на основе чипов Monaka и НРС-решений NVIDIA. В целом, как отмечается, к 2030 году спрос на вычислительные мощности для ИИ в Японии вырастет в 320 раз по сравнению с 2020-м. На этом фоне местные компании, включая Fujitsu, SoftBank и KDDI, активно реализуют различные проекты, направленные на развитие рынка ИИ.

02.10.2025 [15:28], Руслан Авдеев

Дата-центр радиотелескопа Square Kilometre Array (SKA) «засадили» сразу в две клетки Фарадея для защиты сверхчувствительных антенн от радиопомехРаботы в дата-центре, предназначенным для обслуживания радиообсерватории Square Kilometre Array (SKA) на западе Австралии, практически завершены. В числе прочего установлены две клетки Фарадея, блокирующие радиоволны — это делается, чтобы ЦОД не повлияли на работу сверхчувствительных антенн гигантского радиотелескопа, сообщает The Register. SKA представляет собой международный проект, предусматривающий строительство 131 072 антенн. Это крупнейший радиоинтерферометр в мире, потенциально позволяющий совершенно по-новому взглянуть на Вселенную. Работы начались в 2022 году. По имеющимся данным, уже установлено 12 100 антенн, работы по прокладке силовых кабелей и оптоволокна тоже в основном завершены. Работы над дата-центром в Мерчисоне (Murchison, штат Виктория), отдалённой части SKA, тоже завершены. Мерчисон выбран потому, что там почти нет людей и, следовательно, современной техники, что позволяет соблюдать режим радиомолчания. В дата-центре размещены около 100 стоек с серверами на базе FPGA, которые отвечают за фильтрацию терабайт данных, ежедневно собираемых SKA. Ценная информация будет отправляться по 10-Тбайт/с ВОЛС суперкомпьютеру в городе Перт (Perth).

Источник изображения: SKA Observatory Несмотря на то, что в Мерчисоне в целом мало электронных устройств, компьютеры генерируют немало радиопомех. Хотя в большинстве случаев в ЦОД и офисах это не проблема, в случае с SKA дело обстоит совсем иначе, поскольку тот настроен на поиск даже самых слабых сигналов. Именно поэтому ЦОД поместили сразу в две «клетки Фарадея». Экранированы даже входы в здание, а внутренняя дверь не откроется, пока не закрыта внешняя. Строительство на объекте SKA, вероятно, продолжится до 2029 года. В 2026 году учёным предложат представить собственные предложения по использованию радиотелескопа, некоторые выберут для испытаний SKA в 2027 году — к тому времени SKA уже будет самым большим «физическим низкочастотным радиотелескопом на планете». Руководство SKA уверено, что даже тесты 2027 года уже дадут результаты, достойные включения в научные труды. Одно из препятствий — поиск дополнительных средств. У SKA пока есть лишь 80 % средств для завершения проекта.

02.10.2025 [10:56], Сергей Карасёв

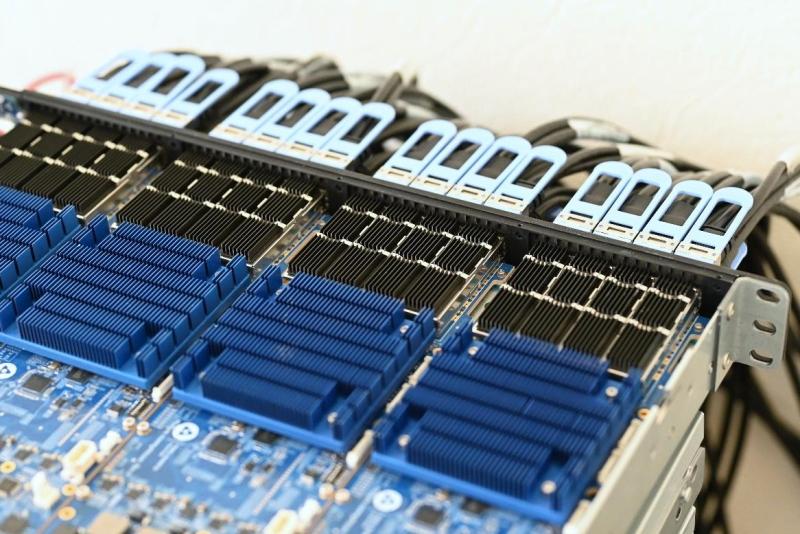

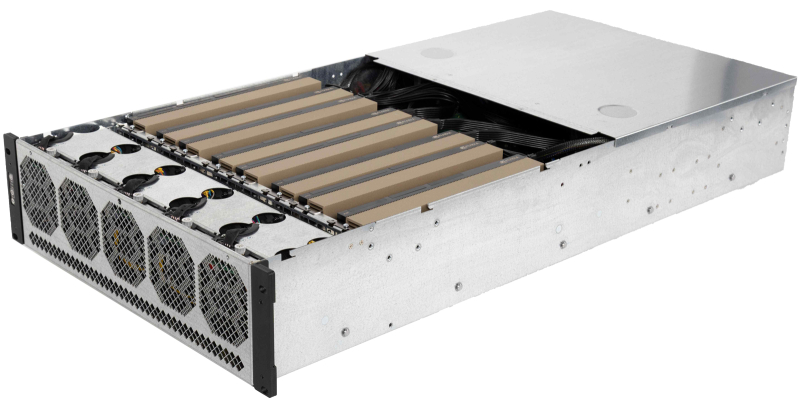

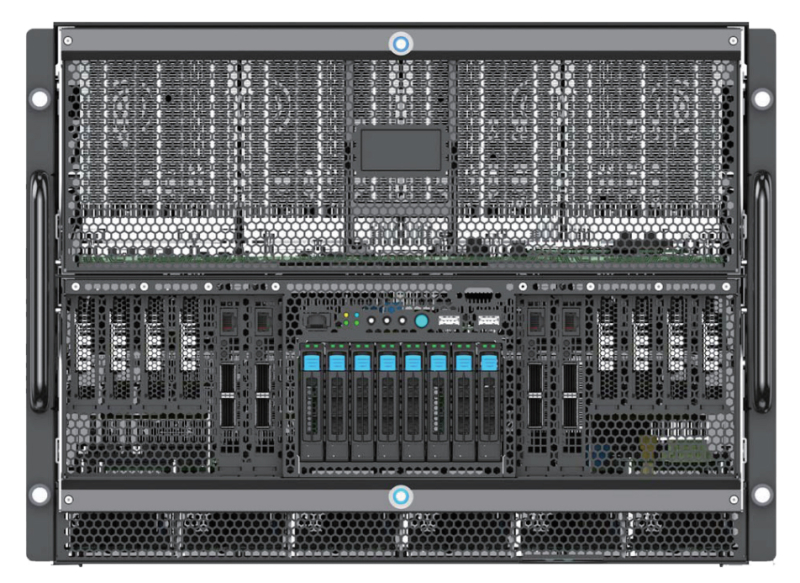

РСК представила внешний JBOG-массив RSC ScaleStream-CГруппа компаний РСК представила на международной конференции «Суперкомпьютерные дни в России», прошедшей в МГУ имени Ломоносова, внешний массив PCIe-коммутации RSC ScaleStream-C (JBOG). Это решение предназначено для установки ускорителей GPU/TPU с целью повышения производительности серверов при работе с различными ресурсоёмкими приложениями, включая задачи ИИ и НРС. Решение RSC ScaleStream-C выполнено в форм-факторе 3U. Допускается установка до десяти карт с интерфейсом PCIe x16 (до 600 Вт), связанных интерконнектом NVLink. При использовании ускорителей на базе GPU применяется гибридное охлаждение, при работе с TPU — воздушное. Питание обеспечивают четыре блока мощностью 2200 Вт каждый. Массив может монтироваться в стандартную 19″ серверную стойку. Задействованы средства управления и мониторинга на базе Redfish, RESTful API, GUI разработки РСК. К системе RSC ScaleStream-C могут быть подсоединены до четырёх серверов посредством внешних кабелей на базе стандарта PCIe 4.0 x16. Ресурсы GPU/TPU могут динамически перераспределяться между подключенными серверами, что, как утверждается, обеспечивает уникальные возможности по созданию оптимальных конфигураций под конкретную нагрузку. Благодаря этому достигается наиболее эффективное использование вычислительных мощностей ИИ-ускорителей, используемых в составе массива. РСК заявляет, что утилизация GPU в некоторых случаях повышается на десятки процентов по сравнению с применением ускорителей в составе традиционных серверных платформах. В целом, RSC ScaleStream-C обеспечивает производительность до 300 ТФлопс (FP64) на массив в случае применения десяти ускорителей NVIDIA H200. При установке карт LinQ HPQ, разработанных российской компании «ХайТэк», быстродействие достигает 960 TOPS на операциях INT8. Среди ключевых сфер применения новинки названы: машинное обучение и ИИ (инференс и работа с большими языковыми моделями), НРС-нагрузки (научные исследования и моделирование), анализ больших данных, виртуализация, криптография и блокчейн (майнинг криптовалют и задачи распределенных реестров).

26.09.2025 [09:53], Сергей Карасёв

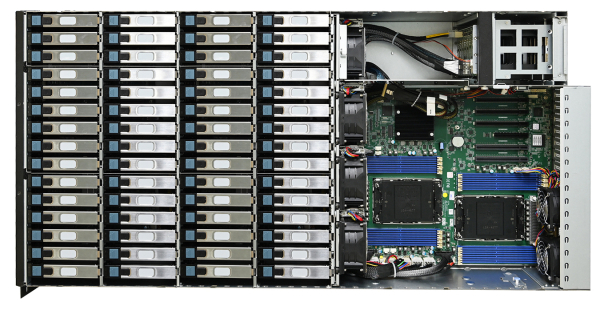

Сервер хранения AIC SB407-VA допускает установку 60 накопителей LFF SATA/SASКомпания AIC представила сервер хранения данных SB407-VA, выполненный в форм-факторе 4U на аппаратной платформе Intel. Новинка допускает установку в общей сложности 70 накопителей разных типов, что позволяет сформировать массив большой ёмкости для таких задач, как аналитика данных, периферийные ИИ-приложения и пр. Сервер может комплектоваться двумя процессорами Xeon Sapphire Rapids или Emerald Rapids. Доступны 16 слотов для модулей DDR5-5600/4800 суммарным объёмом до 4 Тбайт (3DS RDIMM). Предусмотрены четыре слота расширения PCIe x16 и один разъём PCIe x8: во всех случаях могут монтироваться карты формата FHHL. Предусмотрены посадочные места для 60 накопителей LFF с интерфейсом SATA/SAS и возможностью горячей замены. Кроме того, могут быть установлены восемь SFF-устройств в конфигурации 6 × NMVe (PCIe 4.0) и 2 × SATA с поддержкой горячей замены. Плюс к этому есть два коннектора M.2 M Key 2280 для SSD с интерфейсом PCIe 4.0. Модель AIC SB407-VA наделена контроллером Aspeed AST2600. Реализованы два сетевых порта 1GbE на базе Broadcom BCM5720 и выделенный сетевой порт управления 1GbE на основе Realtek RTL8211FS. Во фронтальной части расположен один порт USB3.0 Type-A, в тыльной — три гнезда RJ45 для сетевых кабелей, два разъёма USB 3.1 Gen1 Type-A и коннектор D-Sub. Габариты составляют 434 × 853 × 176 мм. Питание обеспечивают четыре блока мощностью 800 Вт с сертификатом 80 Plus Platinum/Titanium. Задействовано воздушное охлаждение, а диапазон рабочих температур простирается от 0 до +35 °C.

25.09.2025 [11:37], Сергей Карасёв

Edgecore Networks представила ИИ-сервер AGS8600 на базе AMD EPYC Turin и Instinct MI325XКомпания Edgecore Networks анонсировала сервер AGS8600 формата 8U, построенный на аппаратной платформе AMD. Устройство, уже доступное для заказа, предназначено для решения ресурсоёмких задач в сферах ИИ, машинного обучения, НРС, научных исследований и пр. Система несёт на борту два 64-ядерных процессора EPYC 9575F поколения Turin с показателем TDP в 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5. Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 (NVMe): базовая конфигурация включает шесть SSD вместимостью 7,68 Тбайт каждый и два SSD на 1,92 Тбайт. Сервер укомплектован восемью GPU-ускорителями Instinct MI325X с 256 Гбайт памяти HBM3e и производительностью до 2,6 Пфлопс в режиме FP8. Задействованы семь линий Infinity Fabric в расчёте на GPU. В оснащение включены восемь однопортовых сетевых адаптеров BCM957608-P1400GDF00 400G QSFP112-DD PCIe Ethernet NIC. Кроме того, присутствуют два двухпортовых адаптера BCM957608-P2200GQF00 200GbE QSFP112 PCIe Ethernet NIC, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, два порта USB 3.0 и интерфейс D-Sub. За возможности расширения отвечают восемь слотов PCIe 5.0 x16 для карт половинной высоты и четыре разъёма PCIe 5.0 x16 для карт полной высоты. Питание обеспечивают шесть блоков мощностью 3300 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с 15 вентиляторами, допускающими горячую замену. Габариты составляют 448 × 850 × 351 мм. Диапазон рабочих температур — от +10 до +35 °C. На сервере используется ОС с ядром Linux. Среди поддерживаемого ПО упомянуты ROCm 6.2.4, RCCL 2.20.5, PyTorch 2.3/2.2/2.1/2.0/1.13, TensorFlow 2.16.1/2.15.1/2.14.1, JAX 0.4.26 и ONNX Runtime 1.17.3. |

|