Материалы по тегу: c

|

25.09.2025 [11:37], Сергей Карасёв

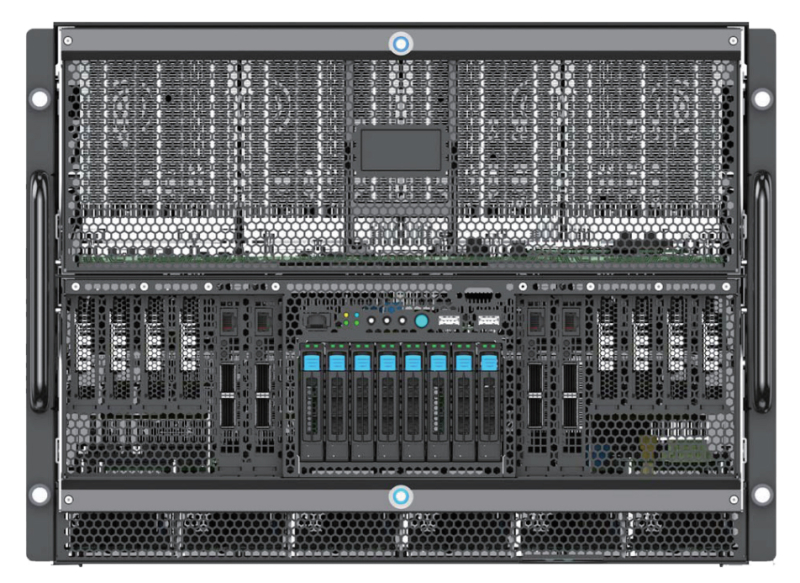

Edgecore Networks представила ИИ-сервер AGS8600 на базе AMD EPYC Turin и Instinct MI325XКомпания Edgecore Networks анонсировала сервер AGS8600 формата 8U, построенный на аппаратной платформе AMD. Устройство, уже доступное для заказа, предназначено для решения ресурсоёмких задач в сферах ИИ, машинного обучения, НРС, научных исследований и пр. Система несёт на борту два 64-ядерных процессора EPYC 9575F поколения Turin с показателем TDP в 400 Вт. Доступны 24 слота для модулей оперативной памяти DDR5. Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 (NVMe): базовая конфигурация включает шесть SSD вместимостью 7,68 Тбайт каждый и два SSD на 1,92 Тбайт. Сервер укомплектован восемью GPU-ускорителями Instinct MI325X с 256 Гбайт памяти HBM3e и производительностью до 2,6 Пфлопс в режиме FP8. Задействованы семь линий Infinity Fabric в расчёте на GPU. В оснащение включены восемь однопортовых сетевых адаптеров BCM957608-P1400GDF00 400G QSFP112-DD PCIe Ethernet NIC. Кроме того, присутствуют два двухпортовых адаптера BCM957608-P2200GQF00 200GbE QSFP112 PCIe Ethernet NIC, выделенный сетевой порт управления 1GbE, контроллер ASPEED AST2600, два порта USB 3.0 и интерфейс D-Sub. За возможности расширения отвечают восемь слотов PCIe 5.0 x16 для карт половинной высоты и четыре разъёма PCIe 5.0 x16 для карт полной высоты. Питание обеспечивают шесть блоков мощностью 3300 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с 15 вентиляторами, допускающими горячую замену. Габариты составляют 448 × 850 × 351 мм. Диапазон рабочих температур — от +10 до +35 °C. На сервере используется ОС с ядром Linux. Среди поддерживаемого ПО упомянуты ROCm 6.2.4, RCCL 2.20.5, PyTorch 2.3/2.2/2.1/2.0/1.13, TensorFlow 2.16.1/2.15.1/2.14.1, JAX 0.4.26 и ONNX Runtime 1.17.3.

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

21.09.2025 [13:23], Сергей Карасёв

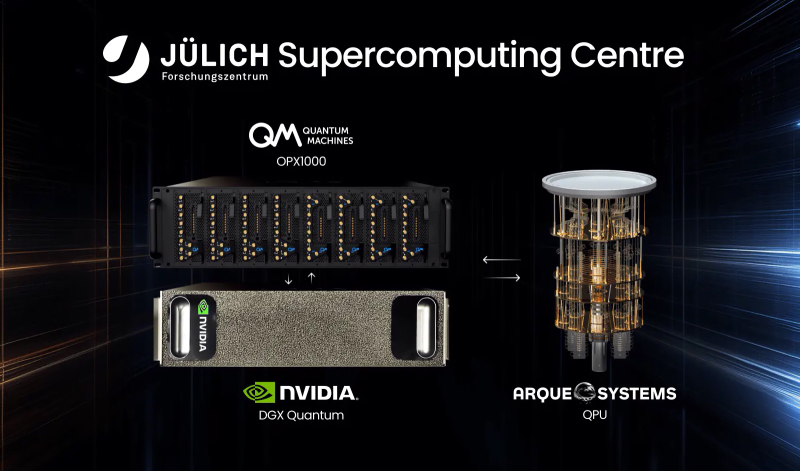

В Германии запущена квантово-классическая система с суперчипами NVIDIA GH200Компании Quantum Machines и Arque Systems развернули в Юлихском суперкомпьютерном центре в Германии (Jülich Supercomputing Centre, JSC) гибридную квантово-классическую вычислительную систему на платформе NVIDIA DGX Quantum. Это первый подобный проект, реализованный на базе крупной НРС-площадки в Европе. Новая система сочетает суперчипы NVIDIA GH200, 5-кубитный квантовый процессор Arque Systems и гибридный квантово-классический контроллер Quantum Machines OPX1000. Использованная архитектура, как утверждается, обеспечивает возможность квантовой коррекции ошибок (QEC), что является критически важным требованием при организации практических квантовых вычислений. Контроллер OPX1000, как отмечается, обеспечивает бесшовное взаимодействие между классическими и квантовыми вычислительными ресурсами. Достигается двусторонняя передача данных с задержкой менее 4 мкс, что в 1000 раз лучше, чем в предыдущих подобных реализациях. Ключевыми задачами проекта названы ускорение процедур калибровки кубитов и тестирование производительности квантовой коррекции ошибок. Кроме того, на базе комплекса планируется осуществлять разработку гибридных квантово-классических вычислительных алгоритмов. Одним из главных преимуществ платформы названа возможность запуска нейронных сетей и моделей машинного обучения на высокопроизводительных GPU с сохранением взаимодействия с квантовой подсистемой с низкой задержкой. Такой уровень интеграции, как подчёркивается, недоступен ни в одной другой современной системе квантовых вычислений. «Объединяя квантовые и классические вычислительные ресурсы на базе ведущего европейского суперкомпьютерного центра, мы открываем новые возможности для исследователей в плане изучения гибридных квантово-классических алгоритмов», — говорит доктор Кристель Михильсен (Kristel Michielsen), директор JSC. Нужно отметить, что JSC является оператором первого в Европе экзафлопсного суперкомпьютера — машины JUPITER, которая была официально запущена в эксплуатацию в сентябре 2025 года. Система использует примерно 6000 вычислительных узлов с гибридными ускорителями NVIDIA Quad GH200 и интерконнектом InfiniBand NDR200 (4×200G на узел, DragonFly+): в общей сложности задействованы почти 24 тыс. NVIDIA GH200.

17.09.2025 [18:34], Сергей Карасёв

OnLogic представила компактные защищённые компьютеры Karbon 520 на базе Intel Meteor LakeКомпания OnLogic анонсировала индустриальные компьютеры небольшого форм-фактора семейства Karbon 520, предназначенные для эксплуатации в неблагоприятных условиях. Устройства могут применяться для решения задач в сфере промышленной автоматизации, робототехники, периферийных ИИ-вычислений и пр. Новинки выполнены в корпусе повышенной прочности в соответствии со стандартом MIL-STD-810H, что означает защиту от вибрации, ударов и пр. Диапазон рабочих температур простирается от -40 до +70 °C. В зависимости от модификации применяется пассивное или активное охлаждение. При этом ребристая верхняя часть выполняет функции радиатора для рассеяния тепла. Задействована аппаратная платформа Intel Meteor Lake. Может быть установлен процессор Core Ultra 5 125H (4P+8E+2LPE; 18 потоков; до 4,5 ГГц), Core Ultra 5 135H (4P+8E+2LPE; 18 потоков; до 4,6 ГГц) или Core Ultra 7 165H (6P+8E+2LPE; 22 потока; до 5,0 ГГц). В состав чипов входят графический ускоритель Intel Arc и нейропроцессорный ИИ-блок Intel AI Boost. Доступны два слота для модулей оперативной памяти DDR5-5600 суммарным объёмом до 96 Гбайт.

Источник изображений: OnLogic В семейство вошли пять моделей: Karbon 521, Karbon 522, Karbon 523, Karbon 524 и Karbon 525. Все они оборудованы шестью портами USB 3.2 Gen2 Type-A, двумя портами Thunderbolt 4 (USB Type-C), четырьмя сетевыми портами 2.5GbE (RJ45), двумя интерфейсами DisplayPort и четырьмя последовательными портами (RS-232/422/485). Допускается вывод изображения одновременно на четыре дисплея. Возможен монтаж посредством крепления VESA.  Karbon 521 располагает разъёмами M.2 2230 E-key (PCIe x1 / USB 2.0), M.2 2280 M-key (PCIe 4.0 x4), M.2 B-Key (PCIe 4.0 x2 / USB 2.0, PCIe 4.0 x1 / USB 3.2 Gen1) и 3FF-SIM. Вариант Karbon 522 имеет аналогичную конфигурацию, но дополнительно предоставляет два посадочных места для SFF-накопителей с интерфейсом SATA. Модификация Karbon 523 получила два слота расширения ModBay, а модель Karbon 524 — слот PCIe 5.0 x16 для карты FHHL. Версия Karbon 525 допускает установку GPU NVIDIA в форм-факторе MXM.

17.09.2025 [17:50], Сергей Карасёв

Мини-ПК MeLE Cyber X1 на базе Intel Twin Lake получил пластиковый корпус-радиаторКомпания MeLE, по сообщению CNX Software, выпустила компьютер небольшого форм-фактора Cyber X1, подходящий для использования в коммерческой и индустриальной сферах. Новинка выполнена на аппаратной платформе Intel Twin Lake с процессором N150 (четыре ядра; до 3,6 ГГц; 6 Вт). Устройство довольствуется пассивным охлаждением. Оно заключено в необычный корпус, верхняя часть которого усеяна шипами из специального пластика с высокой теплопроводностью, которые выполняют функцию радиатора для рассеяния тепла. При этом площадь охлаждающей поверхности, как утверждается, увеличивается в 6,4 раза по сравнению с обычной плоской панелью. Однако при интенсивной нагрузке температура этой зоны может достигать 55–70 °C. Компьютер несёт на борту 16 Гбайт LPDDR5-4800 и NVMe SSD формата M.2 2280 вместимостью 512 Гбайт со скоростью передачи данных до 3940 Мбайт/с. Кроме того, предусмотрен слот для карты microSD. В оснащение входят адаптеры Wi-Fi 5 (802.11ac; частотные диапазоны 2,4/5 ГГц) и Bluetooth 5.1, сетевой контроллер 1GbE. Возможен вывод изображения одновременно на три монитора через два интерфейса HDMI 2.0 и разъём DisplayPort (через USB Type-C): во всех случаях поддерживается разрешение до 4K (60 Гц). Устройство располагает портами USB 3.2 Gen2 Type-A (10 Гбит/с), USB 3.0 Type-A (5 Гбит/с), USB 2.0 Type-A, USB 3.2 Gen2 Type-C (DisplayPort Alt Mode и USB PD 3.0), гнездом RJ45 для сетевого кабеля, 3,5-мм аудиоразъёмом. Питание (12 В / 5 A) подаётся через дополнительный порт USB Type-C. Габариты составляют 131 × 81 × 24 мм, масса — 288 г. Возможен монтаж при помощи крепления VESA. По имеющейся информации MeLE Cyber X1 поставляется с Windows 11. Ориентировочная цена — $230.

17.09.2025 [11:04], Сергей Карасёв

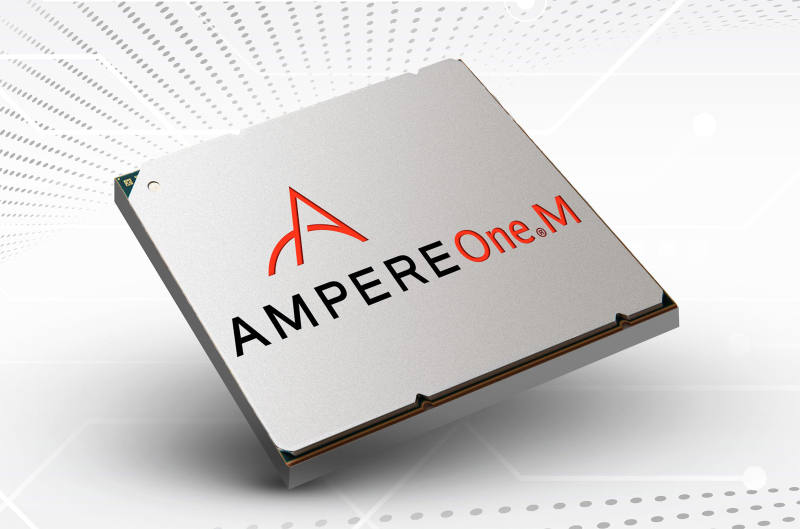

В США появится ИИ-суперкомпьютер с Arm-процессорами AmpereOne M и ускорителями Qualcomm Cloud AIУниверситет штата Нью-Йорк в Стони-Бруке (SBU) объявил о получении гранта в размере $13,77 млн от Национального научного фонда США (NSF) на приобретение и эксплуатацию высокопроизводительного энергоэффективного суперкомпьютера для задач ИИ. Средства получит Институт передовых вычислительных наук (IACS) в составе SBU. В проекте также примет участие Университет штата Нью-Йорк в Буффало (UB). Деньги выделяются в рамках программы Sustainable Cyber-infrastructure for Expanding Participation (Устойчивая киберинфраструктура для расширенной совместной работы). В основу НРС-комплекса, который пока не получил определённого названия, лягут процессоры AmpereOne M, разработанные компанией Ampere Computing специально для ресурсоёмких ИИ-нагрузок в дата-центрах. Эти чипы насчитывают до 192 кастомизированных 64-бит ядер на базе Arm v8.6+ Реализована поддержка 12 каналов DDR5-5600 и 96 линий PCIe 5.0. Кроме того, в состав суперкомпьютера войдут ИИ-ускорители Qualcomm Cloud AI, которые несут на борту до 576 Мбайт SRAM и до 128 Гбайт памяти LPDDR4x с пропускной способностью до 548 Гбайт/с. Расчётные показатели быстродействия машины пока не раскрываются. Ожидается, что комбинация AmpereOne M и Qualcomm Cloud AI обеспечит высокую энергоэффективность, а также значительную производительность, достаточную для работы с крупными ИИ-моделями. Доступ к ресурсам суперкомпьютера планируется предоставлять исследователям, студентам и преподавателям на всей территории США. Новый НРС-комплекс поможет ускорить открытия в области геномики, биоинформатики и в других областях. Кроме того, система будет применяться при реализации проектов в сферах машинного обучения и статистического анализа.

15.09.2025 [14:48], Сергей Карасёв

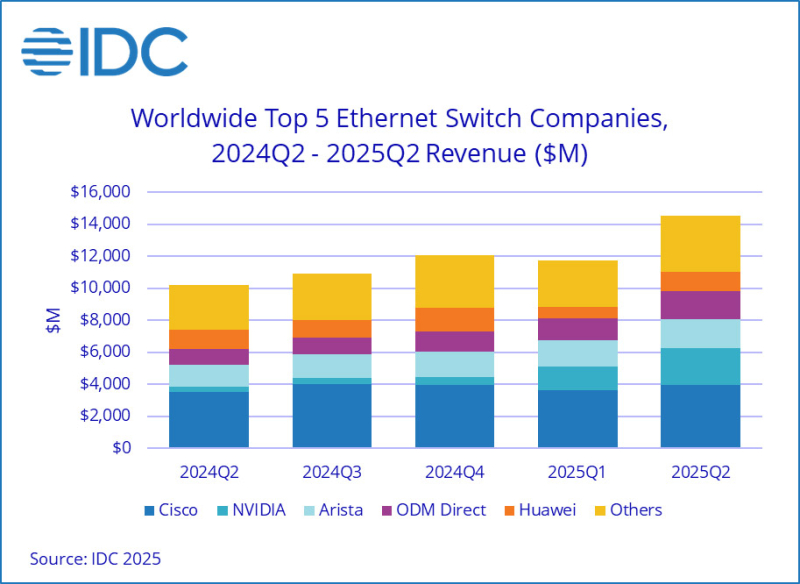

Продажи Ethernet-коммутаторов и маршрутизаторов корпоративного класса растут на фоне бума ИИКомпания International Data Corporation (IDC) обнародовала результаты исследования мирового рынка сетевого оборудования корпоративного класса во II квартале текущего года. Отрасль демонстрирует рост на фоне бума ИИ: гиперскейлеры и поставщики облачных услуг активно расширяют инфраструктуру для удовлетворения растущих потребностей в вычислительных мощностях. По оценкам, продажи Ethernet-коммутаторов в период с апреля по июнь включительно составили $14,5 млрд: это на 42,1 % больше по сравнению со II четвертью 2024 года. В сегменте решений для дата-центров выручка подскочила на 71,6 % в годовом исчислении. В данном секторе быстро укрепляет позиции компания NVIDIA, у которой продажи взлетели на 647 % — до $2,3 млрд, что обеспечило ей наибольшую рыночную долю — 25,9 %. IDC отмечает стремительный рост спроса на коммутаторы стандарта 800GbE, продажи которых поднялись на 222,1 % по сравнению с I четвертью 2025 года, а их доля в общем объёме ЦОД-рынка составила 12,8 %. Поставки коммутаторов стандартов 200/400GbE для дата-центров в годовом исчислении выросли на 175,5 %, тогда как их доля находится на уровне 49,5 %. В сегменте коммутаторов, не связанных с ЦОД, продажи за год поднялись на 12,5 %. Поставки изделий 1GbE, на которые приходится более половины выручки, выросли на 11,3 % в денежном выражении. Спрос на устройства 25/50GbE поднялся на 27,5 % год к году. С географической точки зрения в Северной и Южной Америке рынок Ethernet-коммутаторов корпоративного класса показал рост на 56,8 % в годовом исчислении. В Европе, на Ближнем Востоке и в Африке (EMEA) продажи увеличились на 33,8 %, а в Азиатско-Тихоокеанском регионе — на 24,0 %. В список ведущих мировых поставщиков коммутаторов Ethernet входят Cisco, Arista Networks, NVIDIA, Huawei и HPE Aruba Networking с долями соответственно 27,3 %, 12,6 %, 15,7 %, 8,3 % и 4,7 %. В секторе маршрутизаторов общая выручка во II квартале 2025 года достигла $3,6 млрд, что на 12,5 % больше по сравнению с аналогичным периодом предыдущего года. На поставщиков услуг пришлось 73,2 % от общего объёма данного сегмента с ростом на 13,8 % в годовом исчислении. Корпоративный сектор обеспечил 26,8 % продаж, показав прибавку в 9,1 %. В региональном разрезе объём рынка маршрутизаторов в Северной и Южной Америке вырос на 24,5 % в годовом исчислении, в Азиатско-Тихоокеанском регионе — на 11,4 %. Вместе с тем в регионе EMEA отмечено падение на 1,0 %.

15.09.2025 [11:48], Сергей Карасёв

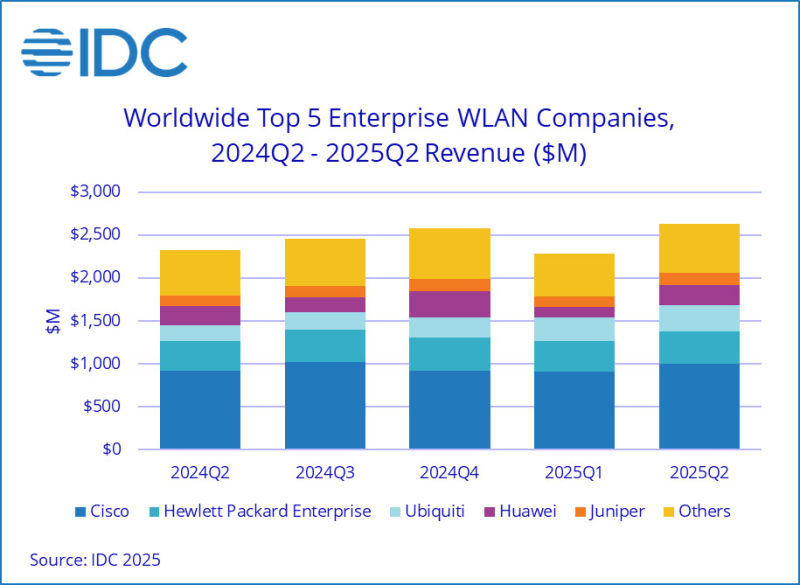

Квартальные продажи корпоративного WLAN-оборудования достигли $2,6 млрдКомпания International Data Corporation (IDC) подвела итоги исследования мирового рынка корпоративного оборудования для беспроводных локальных сетей (WLAN) во II квартале 2025 года. Продажи достигли $2,6 млрд, что на 13,2 % больше по сравнению с аналогичным периодом 2024-го, когда объем отрасли оценивался в $2,3 млрд. Драйвером рынка аналитики называют внедрение новых стандартов Wi-Fi 6E и Wi-Fi 7, которые предусматривают поддержку трёх частотных диапазонов: 2,4, 5 и 6 ГГц. На точки доступа Dependent Access Point стандарта Wi-Fi 7 во II четверти нынешнего года пришлось 21,2 % выручки против 11,8 % кварталом ранее. Ещё около 26,8 % продаж в денежном выражении обеспечили решения Wi-Fi 6E, тогда как оставшуюся часть дохода принесли устройства Wi-Fi 6. В географическом плане в Северной и Южной Америке рынок корпоративного WLAN-оборудования продемонстрировал рост на 17,0 % в годовом исчислении, благодаря увеличению отгрузок в США на 18,4 %. В Европе, на Ближнем Востоке и в Африке (EMEA) отмечена прибавка на уровне 14,7 %, тогда как в Азиатско-Тихоокеанском регионе поставки поднялись на 4,6 % в денежном выражении. В Китае при этом зафиксировано сокращение продаж на 6,6 %. Выручка Cisco увеличилась во II квартале 2025-го на 8,0 % в годовом исчислении, достигнув $996,1 млн: это обеспечило компании долю в 37,8 %. На втором месте в списке ведущих игроков находится HPE Aruba Networking с $376,3 млн и 14,3% рынка: у этой компании продажи год к году поднялись на 9,3 %. Замыкает тройку Ubiquiti с $312,4 млн и долей в 11,9 %: компания нарастила выручку на 66,8 %. Далее идёт Huawei, увеличившая продажи на 5,4 % — до $235,9 млн: компания контролирует 9,0 % рынка. На пятом месте в рейтинге располагается Juniper Networks, которая показала рост на 20,4 % в годовом исчислении — до $141,9 млн: доля компании составила 5,4 %. При этом нужно отметить, что в июле HPE закрыла сделку по покупке Juniper Networks за $14 млрд.

10.09.2025 [12:52], Руслан Авдеев

Microsoft уменьшит зависимость от OpenAI, подключив ИИ Anthropic к Office 365Компания Microsoft намерена снизить зависимость от давнего партнёра в лице OpenAI, прибегнув к помощи стартапа Anthropic. В частности, его технологии будут применяться в приложениях Office 365 для реализации новых функций наряду с решениями OpenAI, сообщает TechCrunch со ссылкой на данные источников The Information. Использование конкурентного ИИ в Word, Excel, Outlook и PowerPoint положит конец монополии OpenAI в этой сфере. Ранее Microsoft фактически зависела от разработчика ChatGPT для обеспечения ИИ-функций в своём офисном пакете. Попытки Microsoft диверсифицировать партнёрство в сфере ИИ происходят на фоне растущих разногласий с OpenAI, реализующей собственные инфраструктурные проекты. Кроме того, компания является потенциальным конкурентом LinkedIn, социальная сеть почти десять лет принадлежит Microsoft. Сделка с Anthropic состоялась на фоне переговоров с OpenAI об обновлении соглашения, которое, вероятно, позволит IT-гиганту получать доступ к новейшим технологиям OpenAI и в будущем, даже после реструктуризации последней в коммерческую компанию. Впрочем, по данным The Information, в Microsoft считают, что новейшие модели Anthropic, включая Claude Sonnet 4, фактически лучше решений OpenAI по ряду параметров, например — при создании презентаций PowerPoint.

Источник изображения: BoliviaInteligente/unsplash.com Это не первый эпизод расширения ИИ-сотрудничества Microsoft. Хотя модели OpenAI предлагаются «по умолчанию», через GitHub Copilot можно получить доступ и к моделям Grok (xAI) и Claude (Anthropic). Также компания не так давно представила и собственные модели — MAI-Voice-1 и MAI-1-preview. OpenAI може стремится выйти из сферы влияния Microsoft. На прошлой неделе компания запустила платформу для поиска работы, способную конкурировать с LinkedIn, а СМИ сообщают, что OpenAI намерена наладить выпуск собственных ИИ-чипов совместно с Broadcom в 2026 году. Другими словами, компания сможет обучать и запускать ИИ-модели на собственном оборудовании, не полагаясь на ресурсы Microsoft Azure. Впрочем, по словам представителя Microsoft, OpenAI продолжит быть партнёром компании в области передовых ИИ-моделей, и техногигант по-прежнему привержен долгосрочному сотрудничеству.

09.09.2025 [15:46], Сергей Карасёв

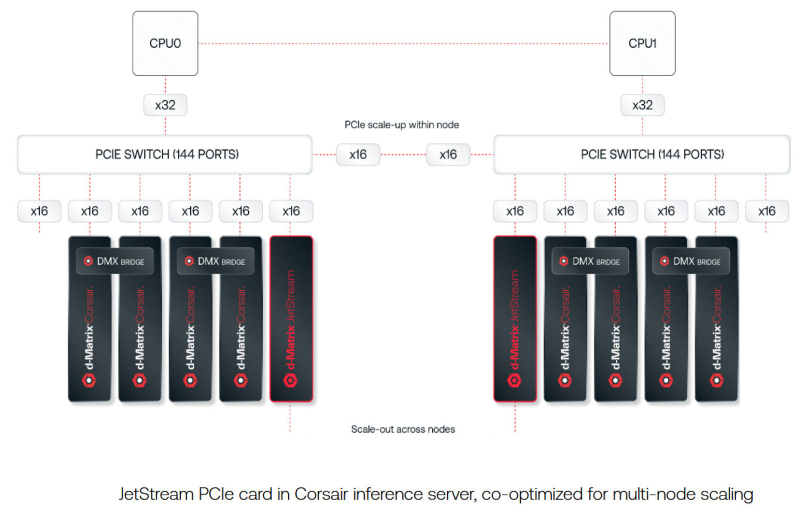

d-Matrix представила 400GbE-адаптер JetStream для объединения своих ИИ-ускорителейСтартап d-Matrix анонсировал специализированную IO-карту JetStream, предназначенную для распределения нагрузок ИИ-инференса между серверами в дата-центре. Устройство ориентировано на использование в связке с ускорителями d-Matrix Corsair, архитектура которых основана на модифицированных ячейках SRAM для вычислений в памяти (DIMC). JetStream использует стандарт Ethernet, благодаря чему обладает совместимостью с уже существующими коммутаторами. Новинка выполнена в виде платы расширения с интерфейсом PCIe 5.0 х16. Используются корзины QSFP-DD. Могут быть задействованы два 200GbE-порта со скоростью 200 Гбит/с или один 400GbE-порт. Архитектура серверов d-Matrix для ИИ-инференса предполагает установку ускорителей Corsair с DMX-мостом между каждыми двумя такими картами для обеспечения высокой пропускной способности без использования PCIe. Затем пары ускорителей объединяются посредством коммутатора PCIe. В эталонном дизайне один NIC JetStream обслуживает до четырёх экземпляров Corsair. d-Matrix утверждает, что сетевую задержку в такой конфигурации удалось сократить до 2 мкс. По заявлениям d-Matrix, карты JetStream могут применяться в существующих ЦОД без необходимости замены дорогостоящих инфраструктурных компонентов. В связке с ИИ-ускорителями Corsair и ПО d-Matrix Aviator решения JetStream способны справляться с ИИ-моделями, насчитывающими более 100 млрд параметров. При этом, как утверждает разработчик, обеспечивается в 10 раз более высокая производительность, в три раза лучшая экономическая эффективность и втрое большая энергоэффективность по сравнению с решениями на базе GPU. Энергопотребление JetStream составляет около 150 Вт. Адаптер оснащён системой охлаждения с радиатором и тепловыми трубками, которые охватывают зону QSFP-DD. Пробные поставки новинки уже начались, а массовое производство запланировано на конец текущего года. |

|