Материалы по тегу: ornl

|

28.10.2025 [22:35], Владимир Мироненко

Министерство энергетики США получит два суперкомпьютера на чипах AMD общей стоимостью $1 млрд: Discovery и Lux AI

amd

epyc

hardware

hpc

hpe

mi350

mi400

oracle

oracle cloud infrastructure

ornl

venice

ии

облако

суперкомпьютер

сша

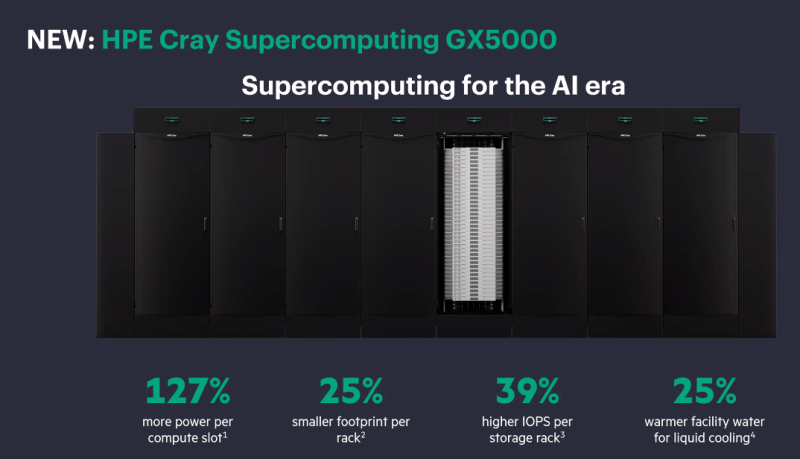

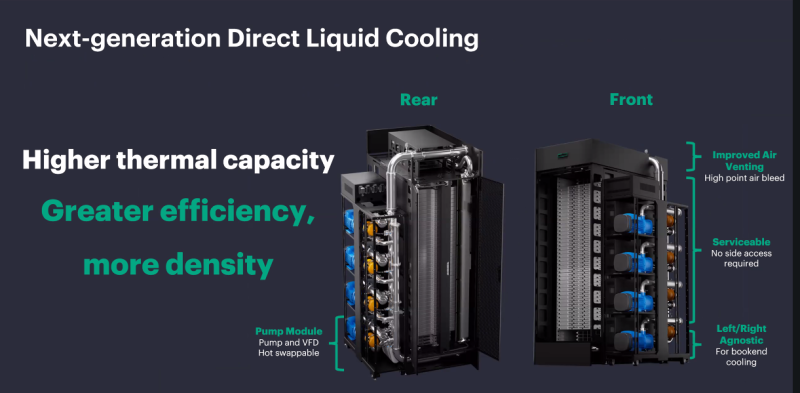

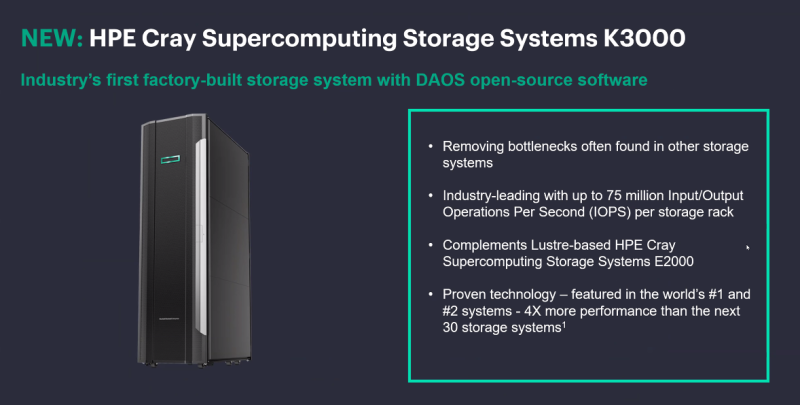

Министерство энергетики США (DOE) заключило с AMD контракт стоимостью $1 млрд с целью строительства двух суперкомпьютеров HPE для решения масштабных научных задач в области ядерной энергетики, здравоохранения и национальной безопасности. Министр энергетики Крис Райт (Chris Wright) сообщил агентству Reuters, что создание HPC-систем даст мощный импульс развитию ядерной и термоядерной энергетики, оборонных технологий и национальной безопасности, а также разработке лекарственных препаратов. Учёные и компании пытаются воспроизвести термоядерный синтез, который, в том числе, подпитывает солнечную энергию. «Мы добились значительного прогресса, но плазма нестабильна, и нам необходимо воссоздать центр Солнца на Земле», — заявил Райт. Он выразил уверенность, что ИИ-системы позволят открыть практические пути для использования энергии термоядерного синтеза в ближайшие два-три года, а также помогут управлять ядерным арсеналом США и ускорить разработку лекарств, моделируя способы лечения рака вплоть до молекулярного уровня. «Я надеюсь, что в ближайшие пять-восемь лет мы превратим большинство видов рака, многие из которых сегодня являются смертным приговором, в контролируемые состояния», — сказал Райт. Первым планируется запустить в эксплуатацию в течение следующих шести месяцев суперкомпьютер Lux с облачным доступом. Он будет основан на узлах HPE ProLiant Compute XD685 с СЖО, которые объединяют ИИ-ускорителях Instinct MI355X, CPU AMD EPYC, а также DPU Pensando. Система разработана AMD совместно с HPE, Oracle (OCI) и Ок-Риджской национальной лабораторией (ORNL). Глава AMD Лизу Су (Lisa Su) сообщила, что запуск Lux будет самым быстрым развёртыванием суперкомпьютера таких размеров в её практике. «Именно такой скорости и гибкости мы хотели бы добиться для программ США в области ИИ искусственного интеллекта», — сказала она. По словам директора ORNL, Lux будет обладать примерно в три раза большей вычислительной мощностью по сравнению с существующими системами. Второй, более продвинутый суперкомпьютер под названием Discovery станет преемником экзафлопсной машины Frontier в ORNL и будет практически на порядок быстрее её. Его разработкой занимаются ORNL, HPE и AMD. Discovery будет основан на платформе HPE Cray Supercomputing GX5000, поддерживающей до 25 кВт на узел и охлаждение водой с температорой +40 °C. Узлы получат процессоры AMD EPYC Venice, которые, как ожидается, появятся во II половине 2026 года, а также специализированные ускорители Instinct MI430X с полноценной поддержкой FP64-вычислений — они также должны появиться в следующем году. Для интерконнекта будет задействован HPE Slingshot следующего поколения, сроки выхода которого не называются. Discovery получит новейшую СХД Cray SC Storage Systems K3000 с объектным хранилищем DAOS, которое дополнит имеющуюся СХД на базе Cray SC Storage Systems E2000 с Lustre. Ранее HPE наняла инженеров, занимавшихся разработкой DAOS в Intel, и включила их в свою команду по работе над СХД. По словам HPE, K3000 предложит до 75 млн IOPS на стойку. HPE не раскрывает, сколько узлов, процессоров и ускорителей будет использоваться в Discovery, а также какой объём памяти будет у системы. Ожидается, что Discovery будет поставлен в 2028 году и готов к эксплуатации в 2029 году. Оценочная стоимость системы — $500 млн. Министерство энергетики США разместит суперкомпьютеры, компании предоставят оборудование и средства на капитальные затраты, а вычислительные мощности будут распределены между обеими сторонами, сообщил представитель министерства. Он отметил, что эти суперкомпьютеры на базе чипов AMD станут первыми в ряду подобных партнёрств министерства с частными компаниями в стране. По аналогичной схеме будет финансироваться создание ИИ-суперкомпьютера Solstice.

20.09.2024 [20:25], Руслан Авдеев

20 тонн HDD в труху — накопители хранилища Alpine уходящего на покой суперкомпьютера Summit отправили в измельчительПо словам специалистов Национальной лаборатории Ок-Ридж (ORNL) Министерства энергетики США, суперкомпьютеры и их компоненты утилизируются точно так же, как и ненужная бумага — буквально отправляются в измельчитель. И совсем скоро сотрудникам лаборатории предстоит разобрать суперкомпьютер Summit, который морально устарел, хотя всё ещё входит в десятку самых производительных систем мирового рейтинга TOP500. Summit хотели вывести из эксплуатации ещё в 2023 году, но из-за довольно высокой производительности пока решено оставить его в строю почти до ноября 2024 года в рамках программы SummitPLUS. Впрочем, часть комплекса уже модернизируется. Так, на смену хранилищу Alpine придёт Alpine 2. Данные из Alpine были переданы в другие СХД суперкомпьютерного центра Oak Ridge Leadership Computing Facility (OLCF). 19 ноября Alpine2 переключат в режим «только для чтения», а потом изменят конфигурацию хранилища для использования в других проектах. Alpine, основанная на параллельной файловой системе IBM Spectrum Scale, создавалась для временного хранения данных Summit и других систем. По словам учёных, Summit строили для симуляции процессов в сверхновых и термоядерных реакторах и вряд ли где-либо ещё есть такая же концентрация жёстких дисков в одном месте, как в системах ORNL, за исключением, возможно, гиперскейлеров. Другими словами, даже разборка Alpine, которая началась ещё летом — чрезвычайно трудоёмкий процесс, поскольку накопители приходится извлекать вручную и по одному. Alpine состояло из 40 стоек на площади около 130 м2. Хранилище суммарной ёмкостью 250 Пбайт включало 32 494 HDD. Речь идёт о почти 20 т оборудования. Чтобы обеспечить по-настоящему безопасное удаление данных, HDD отвозят для физического уничтожения. За этот процесс отвечает компания ShredPro Secure. HDD буквально крошатся металлическими зубьями до небольших фрагментов. На переработку одного диска уходит приблизительно 10 с, а за день можно уничтожить до 3,5 тыс. накопителей. Полученные остатки окончательно утилизируются в рамках программы по переработке металла ORNL, так что лаборатория ещё и получает деньги за сдачу вторичного сырья. Вывод из эксплуатации крупных вычислительных систем — постоянно совершенствуемый процесс, который с годами становится всё эффективнее. В последний раз крупное хранилище (Atlas) утилизировали в 2019 году, оно включало около 20 тыс. HDD. Утилизация своими силами заняла около 9 месяцев и оказалась очень дорогой. ShredPro Secure справилась гораздо быстрее, а сам процесс оказался гораздо дешевле. Поэтому компании в итоге отдали на уничтожение ещё около 10 тыс. HDD из других систем. Правда, теперь ORNL раздумывает над покупкой собственного измельчителя, чтобы дополнительно повысить безопасность и сэкономить ещё больше в долгосрочной перспективе.

17.04.2024 [13:53], Сергей Карасёв

Разработчик квантовых компьютеров IonQ поможет в модернизации энергосистемы СШАКомпания IonQ, специализирующаяся на разработках в области квантовых вычислений, объявила о заключении соглашения о сотрудничестве с Окриджской национальной лабораторией (ORNL) Министерства энергетики США. Речь идёт об исследованиях, нацеленных на модернизацию американской энергосистемы. Отмечается, что нагрузка на энергетическую инфраструктуру США постоянно растёт, что порождает необходимость её совершенствования. При этом требуются инновационные решения, которые помогут не только в оптимизации энергосети, но и в повышении безопасности и стабильности. Предполагается, что квантовые вычисления будут способствовать устранению существующих проблем. В рамках сотрудничества ORNL инвестирует в квантовые системы IonQ. Квантовые системы быть значительно производительнее традиционных суперкомпьютеров при решении определённых задач. К ним, в частности, относятся исследования в сфере энергетики. «Модернизация энергосистемы США является приоритетом. Мы уверены, что квантовые технологии в конечном итоге повысят устойчивость, надёжность и безопасность соответствующей инфраструктуры», — говорит IonQ. Работа IonQ поддерживается проектом GRID-Q, который является частью Инициативы по модернизации энергосистем США (Grid Modernization Initiative), а также проектом ORNL Quantum Computing User Program, предусматривающим предоставление доступа к самым современным квантовым компьютерам для тестирования реальных приложений, таких как управление энергосистемами. Исследования IonQ и ORNL финансируются Министерством энергетики США. |

|