Материалы по тегу: финансы

|

04.03.2026 [00:15], Владимир Мироненко

Ayar Labs привлекла $500 млн инвестиций от AMD, NVIDIA, MediaTek и др.Компания Ayar Labs, занимающаяся разработкой интерконнекта на базе кремниевой фотоники, объявила о завершении раунда финансирования серии E на сумму $500 млн, в результате чего её рыночная капитализация составила $3,75 млрд. Компания сообщила, что использует привлечённые средства для масштабирования производства и тестирования мощностей, чтобы ускорить внедрение своего решения на основе интегрированной оптики (Co-Packaged Optics, CPO), анонсированного осенью 2025 года. Всего с начала деятельности Ayar Labs привлекла $870 млн инвестиций. Раунд возглавила компания Neuberger Berman, к которой присоединились ведущие институциональные инвесторы, включая ARK Invest, Insight Partners, Qatar Investment Authority (QIA), Sequoia Global Equities и 1789 Capital, а также ключевые коммерческие стратегические инвесторы AMD, Alchip, MediaTek и NVIDIA. Neuberger Berman займёт должность наблюдателя в совете директоров. Как отметила Ayar Labs, участие в раунде MediaTek и Alchip Technologies ещё больше укрепляет её связи с ключевыми партнерами в экосистеме проектирования кастомных ASIC. «Инфраструктура ИИ сталкивается с проблемой энергопотребления, вызванной неэффективностью межсоединений. По мере роста спроса на пропускную способность медные кабели становятся узким местом — они потребляют слишком много энергии и ограничивают пропускную способность ИИ на ватт и доллар, — заявил Марк Уэйд (Mark Wade), генеральный директор и соучредитель Ayar Labs. — Интегрированная оптика преодолевает эти барьеры, позволяя тысячам GPU работать как единая система. Это финансирование расширяет наши возможности по удовлетворению потребностей гиперскейлеров». Ayar Labs представила в апреле 2025 года первый в мире чиплет оптического межсоединения UCIe (Universal Chiplet Interconnect Express). Спустя пять месяцев она объявила о партнёрстве с тайваньской компанией Alchip, специализирующейся на производстве ASIC-чипов, для разработки масштабируемой ИИ-инфраструктуры на основе технологии CPO.

03.03.2026 [17:18], Руслан Авдеев

NVIDIA инвестировала $4 млрд в поставщиков лазеров и фотоники для ИИ ЦОД Lumentum и CoherentNVIDIA инвестирует по $2 млрд в Lumentum Holdings и Coherent Corp., выпускающие оптическое сетевое оборудование. Сделки также включает «многомиллиардные» обязательства по закупке определённых лазерных компонентов и доступ к ним в будущем, сообщает Silicon Angle. В случае Coherent речь идёт и о других оптоэлектронных комплектующих. В марте 2025 года NVIDIA представила серию коммутаторов Spectrum-X и Quantum-X для дата-центров, использующих интегрированную фотонику (CPO), что позволило отказаться от использования трансиверов, упростить инфраструктуру и снизить энергопотребление сетевых интерконнектов. Lumentum и Coherent выпускают компоненты для таких систем, причём первая ещё осенью прошлого года начала наращивать производственные мощности по их выпуску. Lumentum входит в число ключевых поставщиков лазерных модулей, оптимально подходящих для CPO — с механизмом терморегулирования и оптимизацией сетевой производительности. Выручка Lumentum в 2025 году составила $655,5 млн. Компания производит и иное сетевое оборудование, в том числе классические трансиверы и оптические коммутаторы (OCS), а также поставляет индустриальные лазеры, например, для сварки металлов. Coherent также выпускает и промышленные лазеры, и оптические решения для дата-центров. Так, недавно компания представила оптимизированный CPO-модуль. Кроме того, Coherent предлагает инструменты для разработки оптических сетевых решений. Coherent и Lumentum используют средства NVIDIA для поддержки исследований и конструкторских разработок. Также компании работают над тем, чтобы нарастить производство в США. После объявления о новых инвестициях акции компаний поднялись в цене более чем на 10 %. Доля NVIDIA на рынке Ethernet-коммутаторов стремительно растёт, во многом благодаря спросу на её же ИИ-платформы. Этот сегмент становится всё более прибыльным для компании. При этом агрессивная политика NVIDIA уже привела к дефициту лазеров.

03.03.2026 [17:09], Владимир Мироненко

SAP выплатит почти полмиллиарда доларров за то, что «заманила» Teradata в невыгодное совместное предприятие почти 20 лет назадНемецкий разработчик ПО для управления бизнесом SAP урегулировал спор с американской компанией-разработчиком ПО Teradata всего за несколько недель до начала судебного разбирательства. Соглашение было достигнуто после того, как немецкий поставщик ERP-систем согласился выплатить Teradata $480 млн во внесудебном порядке, пишет ресурс The Register. Согласно заявлению Teradata, поданному в прошлом месяце в Комиссию по ценным бумагам и биржам США (SEC), обе стороны заключили мировое соглашение для «урегулирования всех прошлых и текущих судебных споров» между ними, включая обвинение компании SAP в нарушении антимонопольного законодательства. «В результате Teradata получит общую выплату в размере $480 млн… После получения Teradata подтверждения оплаты стороны обратятся в суд с просьбой отклонить все иски, возражения и встречные иски с лишением права на повторное обращение», — говорится в заявлении. Согласно подсчётам Teradata, после всех издержек она получит от $355 до $362 млн до уплаты налогов. Конфликт компаний берёт начало в 2018 году, когда Teradata подала в суд на SAP, утверждая, что в течение десяти лет она вела «кампанию по незаконному присвоению коммерческой тайны, нарушению авторских прав и антимонопольного законодательства». Teradata утверждала, что SAP воспользовалась свой сильной позицией на рынке ERP-решений, чтобы «заманить» её в совместное предприятие в 2008 году, а затем «быстро захватить долю рынка» в сфере хранилищ данных. В сентябре того же года SAP обратилась в суд с ходатайством об отклонении иска ввиду его необоснованности, которое калифорнийский суд отказался удовлетворить. Судебная тяжба сопровождалась взаимными обвинениями. Согласно документам, представленным Teradata в регулирующие органы, SAP подала встречные иски о нарушении патентов в июле 2019 года. В августе 2020 года Teradata подала второй иск против SAP, обвиняя компанию в нарушении четырёх своих патентов США. В феврале 2021 года SAP подала дополнительные встречные иски о нарушении патентов и инициировала судебный процесс в Германии по поводу нарушения одного немецкого патента. В ноябре 2021 года антимонопольные иски Teradata, утверждавшей, что немецкая компания якобы объединила продажу своего корпоративного ПО с программой анализа данных HANA, которая конкурирует с аналогичным продуктом от Teradata, а также большинство её обвинений в нарушении коммерческой тайны в первом иске были отклонены. Компания обжаловала это решение. В результате коллегия из трёх судей заслушала устные аргументы в феврале 2024 года, после чего Teradata и SAP заключили частичное соглашение. В декабре 2024 года суд отменил постановление о вынесении решения в порядке упрощённого производства против Teradata. В январе 2025 года SAP безуспешно пыталась добиться пересмотра дела, подав затем ходатайство в Верховный суд США, который отказался принять это дело к рассмотрению, фактически одобрив дальнейшее разбирательство в суде низшей инстанции. Начало судебного разбирательства с отбором присяжных было запланировано на конец марта 2026 года. Сообщается, что соглашение об урегулировании включает положения о будущем сотрудничестве между двумя фирмами. При этом SAP сохраняет свою позицию о независимой разработке HANA. Как утверждает ресурс Tech Edu Byte, урегулирование этого громкого дела позитивно отразится на рынке ПО и клиентах SAP, которые могут ожидать более предсказуемых обновлений и улучшений линейки её продуктов. Корпоративные клиенты SAP и Teradata теперь могут быть более уверены в своих технологических инвестициях, не опасаясь неопределённости, связанной с продолжающимися судебными разбирательствами, влияющими на планы развития продуктов и поддержку. Для Teradata, помимо денежной компенсации, позитив заключается в том, что соглашение признаёт ценность её портфеля интеллектуальной собственности.

01.03.2026 [18:15], Руслан Авдеев

CPP Investments и Equinix купили за $4 млрд оператора экологичных ИИ ЦОД atNorthКанадский пенсионный фонд Canada Pension Plan Investment Board (CPP Investments) и Equinix анонсировали соглашение о покупке у Partners Group компании atNorth за $4 млрд, специализирующейся на предоставлении колокейшн-площадок для HPC/ИИ-нагрузок и провайдере ЦОД «под ключ», сообщает HPC Wire. Digital Realty, тоже пытавшаяся купить atNorth, осталась не у дел. CPP и Equinix предварительно согласовали финансирование в объёме $4,2 млрд (€3,6 млрд) как для закрытия самой сделки, так и для расширения бизнеса atNorth. CPP Investments намерена вложить около $1,6 млрд, получив долю в 60 % компании, а Equinix — около 40 %. Сообщается, что сразу после закрытия сделка, которая ещё ожидает одобрение регуляторов, окажет положительное действие на скорректированный денежный поток от операционной деятельности (AFFO) Equinix. Сделка укрепляет долговременное сотрудничество между Equinix и CPP Investments — в 2024 году было создано совместное предприятие с сингапурской GIC для расширения портфоли ЦОД xScale. У atNorth есть восемь действующих дата-центров, ещё несколько строятся в Дании, Финляндии, Исландии, Норвегии и Швеции — общий объём портфолио составляет 800 МВт. Кроме того, компания уже зарезервировала поставки 1 ГВт энергии. Некоторые объекты, разработанные для ИИ и HPC, поддерживают жидкостное охлаждение. Также компания активно внедряет возобновляемую энергетику, инициативы по использованию избыточного тепла от оборудования, в том числе для выращивания овощей, и модульный дизайн для минимизации ущерба окружающей среде и продвижению экономики замкнутого цикла. atNorth заявляет, что компания по-прежнему будет придерживаться работы в северном регионе и продолжит независимую работу под собственным брендом, сохраняя приверженность культуре и ценностям, которые она продвигает. В CPP Investments подчеркнули, что сделка основана на уже имеющемся долгосрочном сотрудничестве с Equinix. Фонд намерен и далее наращивать бизнес в быстрорастущем секторе ЦОД. Equinix подчеркнула, что для клиентов, нуждающихся в надёжном масштабировании, компания предлагает готовую к будущим задачам инфраструктуру с сохранением юридического и информационного суверенитета. Северная Европа укрепляет статус критически важного хаба для следующего этапа цифрового роста. Он имеет сильную и надёжную экономику, активно внедряет инновации, делает ставку на исследования и техническую экспертизу, а также экоустойчивые проекты. Здесь есть много источников возобновляемой энергии и оптимальный для ЦОД климат. Equinix располагает восемью ЦОД на севере Европы: пять в Хельсинки и три в Стокгольме. Всего же в ведении компании есть более 100 объектов в 20 странах. В Европе компания на 100 % компенсирует энергопотребление своих дата-центров за счёт покупок возобновляемой энергии. Это вполне соответствует «зелёному» курсу atNorth и, как ожидается, Equinix добьётся нулевых выбросов к 2040 году.

28.02.2026 [23:59], Владимир Мироненко

Hyundai инвестирует более $6 млрд в ИИ ЦОД, роботов, водородную и солнечную энергетику

hardware

hyundai

nvidia

водород

ии

инвестиции

робототехника

солнечная энергия

финансы

цод

энергетика

южная корея

Hyundai Motor Group и правительство Южной Кореи подписали соглашение об инвестировании около ₩9 трлн ($6,26 млрд) с целью строительства объединённого инновационного центра в районе Сэмангым (Saemangeum) города Кунсан (Gunsan), который будет включать в себя ИИ ЦОД, завод по производству робототехники и производство водородной/солнечной энергии, сообщило агентство Reuters со ссылкой на министерство земельных ресурсов страны. По данным ведомства, около ₩5,8 трлн (около $4,04 млрд) Hyundai инвестирует в строительство ИИ ЦОД, в котором будет развёрнуто 50 тыс. NVIDIA Blackwell. ЦОД будет оснащён «массивным» хранилищем для хранения огромных массивов данных для обучения, разработки программно-определяемых транспортных средств (SDV) и внедрения «умных заводов», заявили в Hyundai. Ожидается, что интегрированная платформа позволит ускорить исследования и разработку продукции по всей цепочке создания стоимости. Ещё ₩400 млрд (около $278,8 млн) будет выделено на строительство завода по производству роботов, в том числе носимых (экзоскелетов). Также компания инвестирует ₩1 трлн (около $697,2 млн) в строительство электролизерной установки с протонообменной мембраной (Proton Exchange Membrane, PEM) мощностью 200 МВт для производства экологически чистого водорода с использованием возобновляемых источников энергии на месте. Hyundai планирует со временем достичь общей мощности электролизеров в 1 ГВт на внутреннем рынке. Hyundai утверждает, что её технология PEM достигла более чем 90 % локализации, что способствует технологической независимости Южной Кореи и расширению экспортных возможностей экологически чистого водорода, сообщил ресурс Data Center Knowledge. Оставшуюся часть суммы в размере ₩1,3 трлн (около $906,6 млн) компания направит в солнечную энергетику — строительство солнечных электростанций гигаваттного масштаба к 2035 году на основе действующей с 2021 года 99-МВт электростанции. Hyundai рассматривает ЦОД как «мозг» своей ИИ-экосистемы, объединяющий данные производства, логистики и эксплуатации транспортных средств для развития ИИ внутри страны. В центре также будет создан «умный город» с водородными технологиями на основе ИИ, который интегрирует технологии в единую экосистему. Строительство ЦОД, солнечной инфраструктуры и объекта по производству водорода планируется начать в 2027 году и завершить в 2029 году. По прогнозам Hyundai, эти инвестиции принесут экономический эффект в размере около ₩16 трлн (примерно $11 млрд) и позволят создать около 71 тыс. рабочих мест.

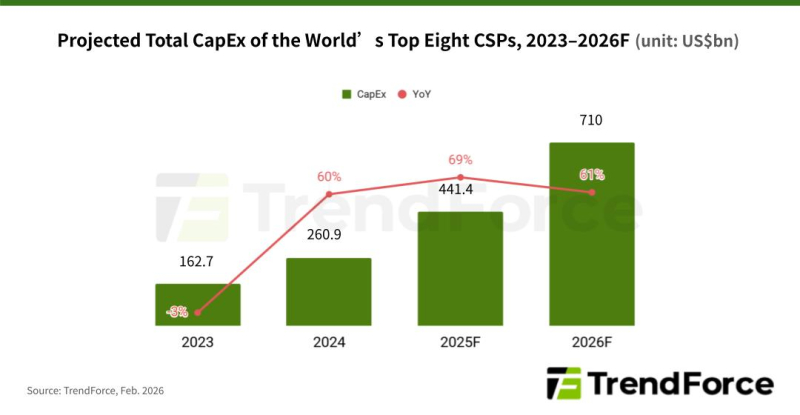

28.02.2026 [12:23], Владимир Мироненко

TrendForce: капзатраты восьми гиперскейлеров в 2026 году превысят ВВП ИрландииВ этом году, по оценкам TrendForce, восемь крупнейших мировых облачных провайдеров — Google, Amazon, Meta✴, Microsoft, Oracle, Tencent, Alibaba и Baidu — направят более $710 млрд на капитальные затраты, что примерно на 61 % больше, чем в прошлом году и превышает валовой внутренний продукт (ВВП) Ирландии за прошлый год. Около $650 млрд из этой суммы приходится на первых четверых гиперскейлеров из этого списка, пишет The Register. Эти средства будут потрачены на строительство и расширение ЦОД, а также оборудование для них, включая высокопроизводительные серверы, обычно оснащённые ускорителями AMD или NVIDIA. Также набирают популярность ASIC других брендов, которые в отличие от универсальных ускорителей разрабатываются для конкретных видов нагрузки. По данным TrendForce, Google остаётся единственной облачной компанией, которая добавляет больше серверов на базе ASIC, чем на базе GPU. По оценкам аналитиков консалтинговй компании, процессоры Tensor Processing Units (TPU) будут использоваться примерно в 78 % ИИ-серверов для дата-центров Google в этом году. Ожидается, что у Amazon 60 % серверов будут оснащены GPU, и компания начнёт наращивать системы на базе Trainium3 позже в этом году. Компания Meta✴ также будет в основном полагаться на ускорители NVIDIA и AMD, которыми будут оснащены более 80 % серверов, установленных в этом году. Microsoft продолжит закупать стоечные системы NVIDIA, а Oracle расширяет развёртывание стоечных серверов с GPU. Из китайских операторов Tencent также продолжит развёртывать серверы с ускорителями NVIDIA, пусть и опосредованно. The Register отметил, что высокий спрос на ИИ-серверы привёл к росту цен на память и её дефициту, поскольку производители переводят производственные линии на выпуск высокорентабельных решений, таких как память HBM. Производители микросхем памяти SK Hynix и Sandisk объявили о работе над процессом стандартизации HBF-памяти для ИИ-инференса. SK hynix описывает HBF как новый уровень памяти между сверхбыстрой HBM и высокоёмкими SSD, утверждая, что она снизит совокупную стоимость владения (TCO), одновременно повышая масштабируемость ИИ-систем. Согласно прогнозу компании, спрос на такие решения, как HBF, возрастёт примерно к 2030 году.

27.02.2026 [22:55], Владимир Мироненко

Amazon вложит в OpenAI $50 млрд, OpenAI в ответ потратит $100 млрд на 2 ГВт мощностей TrainiumOpenAI и Amazon объявили о заключении соглашения о стратегическом партнёрстве с целью ускорения инноваций в области ИИ для предприятий, стартапов и конечных потребителей по всему миру. В рамках многолетнего соглашения Amazon инвестирует в OpenAI $50 млрд — $15 млрд первым траншем, а затем еще $35 млрд в ближайшие месяцы при выполнении определённых условий. AWS и OpenAI совместно создадут среду выполнения с сохранением состояния (Stateful Runtime Environment) на базе моделей OpenAI, которая будет доступна в Amazon Bedrock для создания приложений и агентов генеративного ИИ. Подобное окружение позволяет разработчикам сохранять контекст, запоминать предыдущую работу, работать с различными программными инструментами и источниками данных, а также получать доступ к вычислительным ресурсам. Новинка будет интегрирована с Amazon Bedrock AgentCore и инфраструктурными сервисами, чтобы приложения и ИИ-агенты клиентов работали согласованно с остальными приложениями инфраструктуры, работающими в AWS. AWS также станет эксклюзивным сторонним поставщиком облачных услуг для платформы OpenAI Frontier, позволяющей компаниям создавать, развёртывать и управлять командами ИИ-агентов, работающих в реальных бизнес-системах с общим контекстом. По мере перехода компаний от экспериментов к внедрению ИИ в производство, Frontier упрощает быструю, безопасную и глобальную интеграцию ИИ-технологий в существующие рабочие процессы. Кроме того, OpenAI и Amazon будут сотрудничать в разработке пользовательских моделей для работы с приложениями Amazon, ориентированными на клиентов. AWS и OpenAI также сообщили о расширении ещё на $100 млрд более раннего соглашения о многолетнем стратегическом партнёрстве стоимостью $38 млрд, в рамках которого AWS обязалась предоставлять OpenAI в течение семи лет доступ к ускорителям NVIDIA. Расширенное соглашение со сроком действия 8 лет включает в себя обязательство OpenAI использовать около 2 ГВт мощностей на базе ускорителей Trainium, чтобы поддерживать спрос на Stateful Runtime, Frontier и другие рабочие нагрузки. Это обязательство распространяется как на чипы Trainium3, так и на чипы следующего поколения Trainium4, которые появятся в 2027 году и получат технологию NVIDIA NVLink. Сегодняшний день оказался богатым на события для OpenAI. Компания объявила о привлечении $110 млрд инвестиций в рамках раунда финансирования с предварительной оценкой её рыночной стоимости в $730 млрд, что значительно больше оценки в $500 млрд в октябре 2025 года. Лидером раунда стала Amazon с инвестициями в $50 млрд, за ней следуют NVIDIA и SoftBank, инвестировавшие по $30 млрд. Компания заявила, что ожидает, что к раунду присоединятся и другие инвесторы. Ранее Anthropic, ключевой конкурент OpenAI, закрыл раунд финансирования на $30 млрд, подняв капитализацию до $380 млрд. У компании долгие и тесные отношения с AWS, которая развернула для стартапа один из крупнейших в мире ИИ-кластеров Project Rainier. Впрочем, Anthropic тоже старается диверсифицировать поставки вычислительных мощностей — она заключила контракты с Microsoft (на чипы NVIDIA), а также с Google (на TPU).

27.02.2026 [15:30], Руслан Авдеев

Шутки в сторону: 1 апреля провайдер Hetzner резко поднимет цены — до +50 %Один из крупнейших европейских хостинг-провайдеров и операторов ЦОД — компания Hetzner предупредила клиентов, что рост цен на её услуги составит до 50 %. Это касается как имеющихся пользователей, так и будущих — в Германии, Финляндии, США и Сингапуре, сообщает The Register. Hetzner известна (пока) недорогими сервисами, в первую очередь IaaS, для разработчиков и корпоративных клиентов. Компания сообщила, что причиной изменений стоимости её продуктов стал рост цен в разных сферах рынка IT. Компания пожаловалась, что выросла стоимость эксплуатации инфраструктуры и нового оборудования, а попытка оптимизации расходов не принесла желаемого эффекта. Список ценовых изменений свидетельствует, что многие услуги действительно значительно подорожают, многие на 30 %, а некоторые даже на 50 %, что может серьёзно сказаться на небогатых клиентах. Стремительное развитие ИИ-индустрии стало одним из факторов, определивших движение рынка инфраструктуры в непредсказуемых направлениях на фоне спроса на всё большие вычислительные мощности. Гиперскейлеры не могут приобрести достаточно HBM, RAM и флеш-памяти, а также ИИ-ускорителей, особенно производства NVIDIA. Ожидается, что цены на DRAM- и NAND-модули в текущем квартале удвоятся, а некоторые серверные CPU уже в дефиците и скоро подорожают. Производители HDD жалуются, что распродали столько жёстких дисков, сколько собирались выпустить за весь год.

Источник изображения: Jon Del Rivero/unspalsh.com В Omdia отметили, что Hetzner фактически является провайдером облачной инфраструктуры, поэтому в подорожании сервисов даже на 50 % нет ничего удивительного — это всего лишь отражение текущей реальности. В Omdia считают, что пользователи могут ожидать повышения цен и со стороны других провайдеров. Наибольшему давлению подверглись компании-операторы второго эшелона, они в более невыгодном положении в сравнении с гиперскейлерами. Эксперты Omdia отмечают, что рынок облачных сервисов ожидает некоторый раскол — гиперскейлеры уровня AWS, Microsoft и Google имеют долгосрочные прямые соглашения напрямую с поставщиками «железа», защищающие их от немедленного ценового шока. Тем временем средние и малые компании, не обладающие гигантской покупательной способности, в том числеHetzner и OVHcloud (тоже анонсировавшей рост цен), не имеют выбора, перекладывая издержки на пользователей. К несчастью для компаний, рассчитывающих на бюджетный облачный хостинг, инфраструктурные издержки взлетят. Рынку необходимо, чтобы компании уровня Hetzner продолжали работать и сохраняли прибыльность. Реакция онлайн-сообщества оказалась смешанной. Одни пользователи говорят, что рост цен непосильный, поэтому им придётся искать возможные альтернативы. У некоторых небольших провайдеров действительно пока что более привлекательные цены в сравнении с Hetzner. Среди плюсов называется относительно недорогая стоимость ухода от к конкурентам. Другие же пользователи пишут, что реакция компании предсказуема. В противном случае пришлось бы вообще отказаться от облачных серверов. Отмечается, что у Hetzner всё ещё лучшее соотношение цены/производительности в сравнении с конкурентами. Стоит отметить, что некоторые компании довольно спорно обосновывают ценообразование. Например, не так давно сообщалось, что Cisco нашла оправдание повышению цен на свои продукты, несмотря на рекордную выручку во II четверти текущего финансового года.

27.02.2026 [14:11], Руслан Авдеев

Китайские поставщики подняли цену на оптоволокно для России в 2,5-4 разаРоссийские покупатели оптоволокна столкнулись с серьёзной проблемой. Цена на поставляемое из КНР оптоволокно выросла в 2,5–4 раза, российское производство временно не работает, а поставки из других стран ограничены, сообщает Forbes. Получать волокно из Японии и США нельзя из-за санкций, а единственный российский завод по выпуску оптоволокна в Саранске не работает с 2025 года. Информация о росте цен подтверждается российскими экспертами, а также непосредственными участниками российского рынка ВОЛС — производителями кабеля на основе оптоволокна, включая представителей компаний «Еврокабель-1» и «Инкаб», и крупнейшего магистрального оператора — компании «Транстелеком». По данным ComNews, российские заказчики приобретают китайское оптоволокно по ценам внутреннего рынка Поднебесной. Так, востребованное операторами связи волокно G.652D в прошлом году стоило ¥16/км, но к концу года цена выросла до ¥25/км юаней. А в январе она составляла уже ¥40/км.

Источник изображения: Shoaib Asif/unsplash.com При этом на Китай приходится более 60 % общемирового производства оптоволокна, и эксперты считают, что рост цен вполне закономерен на фоне дефицита, связанного с развитием ИИ-инфраструктуры по всему миру. Россия же не является приоритетным рынком для поставщиков. По словам представителя «Инкаба», сохранение «напряжённости» ожидается минимум до 2027 года. В октябре ассоциация «Электрокабель» сообщала, что производство кабелей на основе оптоволокна в I полугодии в России упало на четверть год к году. В последнее время, по словам экспертов, использование оптоволокна значительно выросло, а значительная часть его применяется не для традиционных ВОЛС. В 2025 году на Россию пришлось около 10,5 % мирового потребления оптоволокна, тогда как ранее речь шла не более, чем об 1 %. По прогнозам экспертов, повышение цен китайскими производителями приведёт и к росту стоимости аренды «тёмного волокна», увеличение стоимости строительства и обновления магистральных сетей связи.

27.02.2026 [09:30], Владимир Мироненко

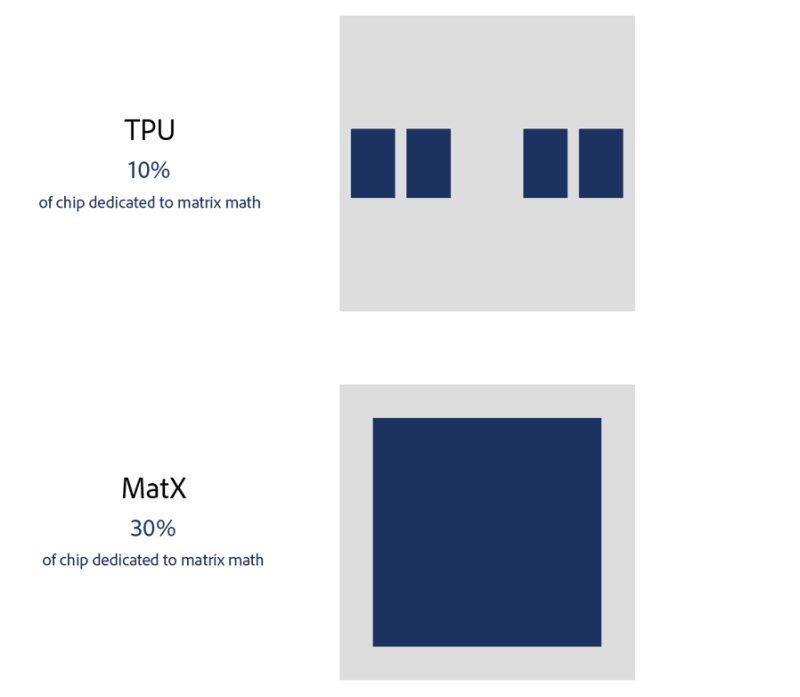

Стартап MatX, намеренный конкурировать с NVIDIA, привлёк $500 млн инвестицийСтартап MatX в сфере разработки ИИ-чипов, основанный бывшими сотрудниками Google, сообщил, что привлёк $500 млн в рамках раунда финансирования серии B для завершения разработки и быстрого масштабирования производства чипа для обучения больших языковых моделей (LLM), с выпуском готовой продукции менее чем за год. Раунд возглавили Jane Street и Situational Awareness, инвестиционная фирма, основанная бывшим исследователем OpenAI Леопольдом Ашенбреннером (Leopold Aschenbrenner). Среди других инвесторов — Marvell Technology, венчурные фирмы NFDG и Spark Capital, а также соучредители Stripe Патрик и Джон Коллисон (Patrick, John Collison), Triatomic Capital, Harpoon Ventures, Андрей Карпати (Andrej Karpathy), Дваркеш Патель (Dwarkesh Patel) и т.д. Компания отказалась раскрыть точную оценку, но заявила, как сообщает Bloomberg, что теперь её стоимость оценивается в несколько миллиардов долларов. Нынешний раунд финансирования состоялся более чем через год после раунда серии А, в котором было привлечено около $100 млн и который возглавила компания Spark Capital, сообщил TechCrunch. Тогда, в 2024 году, компания была оценена более чем в $300 млн.

Источник изображения: MatX «Мы разрабатываем LLM-чип, который обеспечивает гораздо более высокую пропускную способность, чем любой другой чип, и при этом достигает минимальной задержки. Мы называем его MatX One», — сообщила компания. MatX One основан на разделяемом систолическом массиве, сочетая низкую задержку, характерную для SRAM-ориентированных разработок, с поддержкой длительных контекстов HBM. Компания отметила, что конструкция чипа, а также новый подход к численным вычислениям, обеспечивают более высокую пропускную способность при работе с LLM, чем любая ИИ-система на рынке. «Более высокая пропускная способность и меньшая задержка позволяют создавать более интеллектуальные и быстрые модели за ваши деньги, потраченные на подписку», — сообщила MatX. Компания рассчитывает завершить разработку чипа в этом году и начать поставки в следующем. MatX планирует выпускать чип на мощностях TSMC. Новое финансирование призвано помочь компании зарезервировать производственные мощности и комплектующие, чтобы обеспечить быструю отгрузку после завершения разработки, сообщил соучредитель Майк Гюнтер (Mike Gunter). «Это позволяет нам конкурировать на равных с крупнейшими компаниями, поскольку они могут очень быстро масштабироваться, — сказал он. — Этот раунд ставит нас практически на один уровень с игроками, обладающими огромными финансовыми ресурсами». |

|