Материалы по тегу: ии

|

11.02.2026 [15:53], Руслан Авдеев

Власти США «по-хорошему» призывают гиперскейлеров самим финансировать расширение ИИ-проектов, а не перекладывать затраты на жителейАдминистрация президента США продолжает продвигать развитие ИИ-проектов, в то же время стремясь ослабить недовольство граждан непомерными аппетитами ЦОД в отношении электричества и воды, а также обещая освободить крупных игроков рынка от пошлин на ИИ-ускорители. Чтобы успокоить общественность, Вашингтон предложил IT-гигантам гарантировать, что расширение их сети ЦОД в США не приведёт к резкому увеличению счетов за электричество или истощению локальных водных ресурсов, сообщает The Register. По информации Politico, предложено добровольное соглашение между президентом США Дональдом Трампом (Donald Trump) и индустрией ЦОД в лице Microsoft, Google, Amazon, Meta✴ и OpenAI, которое устанавливает принципы ответственного потребления электроэнергии, воды и отношений с жителями в местах размещения дата-центров. Новый шаг соответствует вектору предыдущих событий. Ранее президент заявил, что технологический бизнес должен сам финансировать увеличение мощности ЦОД и адаптацию для этого энергетической инфраструктуры, а не перекладывать расходы на обычных потребителей энергии. Компания Microsoft уже пошла навстречу в этом вопросе, представив проект Community-First AI Infrastructure. Кроме того, Министерство энергетики (DOE) оказало давление на оператора электросетей PJM Interconnection, чтобы та провела экстренный аукцион для компенсации роста спроса на электричество со стороны ЦОД.

Источник изображения: Gabriela/unsplash.com Это направлено на сдерживание растущего общественного недовольства появлением дата-центров по всей территории США. По данным НКО, только во II квартале были заблокированы или отложены 20 проектов строительства ЦОД в стране из-за противодействия местных сообществ. В январе 2026 года Белый дом объявил о ввозных пошлинах в размере 25 % на ИИ-ускорители, включая NVIDIA H200 и AMD MI325X, но их закупки для объектов гиперскейлеров в США пошлиной облагаться не будут. По некоторым данным, освобождение от тарифов может зависеть от политики непосредственных производителей вроде тайваньской TSMC, от которых ожидают переноса до половины своего производства в США в рамках программы «реиндустриализации» Соединённых Штатов. Недавно премьер-министр Тайваня назвал такой перенос «невозможным». Впрочем, TSMC уже выделила $165 млрд на строительство производств в Аризоне для выпуска 2-нм чипов, но пока неизвестно, устроит ли это Трампа.

11.02.2026 [13:38], Руслан Авдеев

Армения получит ещё 41 тыс. NVIDIA GB300 для ИИ ЦОД Firebird за $4 млрдАмериканская компания Firebird, специализирующаяся на облачных и инфраструктурных решениях для ИИ, объявила о реализации второго этапа суперкомпьютерного мегапроекта в Армении. Она получила экспортные лицензии США и разрешения регуляторов на поставку в страну ещё 41 тыс. ускорителей NVIDIA GB300, сообщает HPC Wire. Расширение вычислительного кластера в Армении знаменует собой важную веху. Предполагается, что страна войдёт в пятёрку мест размещения крупнейших кластеров ИИ-ускорителей. Проект стоимостью $4 млрд — одно из крупнейших капиталовложений в технологическую сферу в истории страны. Подробности в ходе визита в Ереван раскрыл вице-президент США Джей Ди Вэнс (JD Vance) при участии вице-президента NVIDIA. По словам Вэнса, США «с гордостью» одобрили замечательное техническое соглашение с NVIDIA. Речь идёт об открытии новых рынков и новых рабочих мест как для американских работников, так и для армянских. 8 августа прошлого года Армения и США подписали меморандум в сфере ИИ и полупроводников. Выданная США экспортная лицензия свидетельствует о том, что проект полностью соответствует американским требованиям. Второй этап — продолжение реализации плана Firebird, выделившей $500 млн на создание в Армении первого ИИ-кластера. Реализация двух этапов обеспечит качественный скачок в технологической инфраструктуре страны. Он позволит проводить исследования в биологии, робототехнике, космической сфере и в сфере ИИ нового поколения. По словам представителей Firebird, новый кластер превращает Армению в глобальный центр суперкомпьютерных вычислений.

11.02.2026 [08:42], Руслан Авдеев

Австралийское неооблако Firmus привлекло $10 млрд в кредит для строительства ИИ-фабрик Project SouthgateАвстралийский неооблачный провайдер Firmus привлёк в кредит $10 млрд. Главными участниками кредитного соглашения стали инвестиционные компании Blackstone и Coatue, сообщает Datacenter Dynamics. По словам Firmus, финансирование позволит развернуть ИИ-фабрики на основе эталонной архитектуры NVIDIA по всей Австралии. Новый план — часть проекта Southgate, реализуемого Firmus в рамках стратегического партнёрства с CDC Data Centres и NVIDIA. Firmus была основана в 2019 году и поначалу специализировалась на криптовалютах и HPC, а также системах иммерсионного охлаждения. Неооблачная компания заявила, что речь идёт об одной из «крупнейших частных сделок по привлечению заёмных средств» за всю историю Австралии. Представитель Blackstone сообщил, что инструменты, стоящие за революцией в сфере ИИ — одно из наиболее перспективных инвестиционных направлений, и Австралия сможет сыграть центральную роль в развитии ИИ-инфраструктуры. Firmus подчеркнула, что благодаря Blackstone и Coatue она поможет удовлетворить растущий спрос на вычислительные мощности для ИИ в мире и создать долгосрочные выгоды как для клиентов, так и для местной экономики в целом. Стоит отметить, что Blackstone владеет крупным региональным оператором ЦОД AirTrunk.

Источник изображения: Firmus Firmus впервые упомянула Project Southgate в сентябре 2025 года в описании ИИ-кампуса в городе Лонсестон (Launceston, Тасмания). На тот момент компания заявляла, что совместный с правительством Тасмании проект к 2026 году обеспечит создание ИИ-инфраструктуры мощностью 90 МВт. Месяцем позже Firmus сообщила, что проекта расширят и на материковую Австралию при содействии CDC Data Centres. Предполагается развёртывание дополнительных объектов в Сиднее, Канберре, Мельбурне и Перте. В ноябре 2025 года сообщалось о привлечении для Project Southgate AU$500 млн ($351 млн). В последнем заявлении Firmus объявила о строительстве нескольких ИИ-фабрик в Австралии, где планируется развернуть тысячи ИИ-ускорителей — общая мощность к 2028 году должна достигнуть 1,6 ГВт. Каждая ИИ-фабрика будет учитывать современные требования к энергоэффективности и параметрам генерации токенов, чтобы удовлетворять потребности самых требовательных клиентов со всего мира. Подчёркивается, что Австралия имеет конкурентоспособный «энергетический профиль» и квалифицированные кадры.

10.02.2026 [14:41], Андрей Крупин

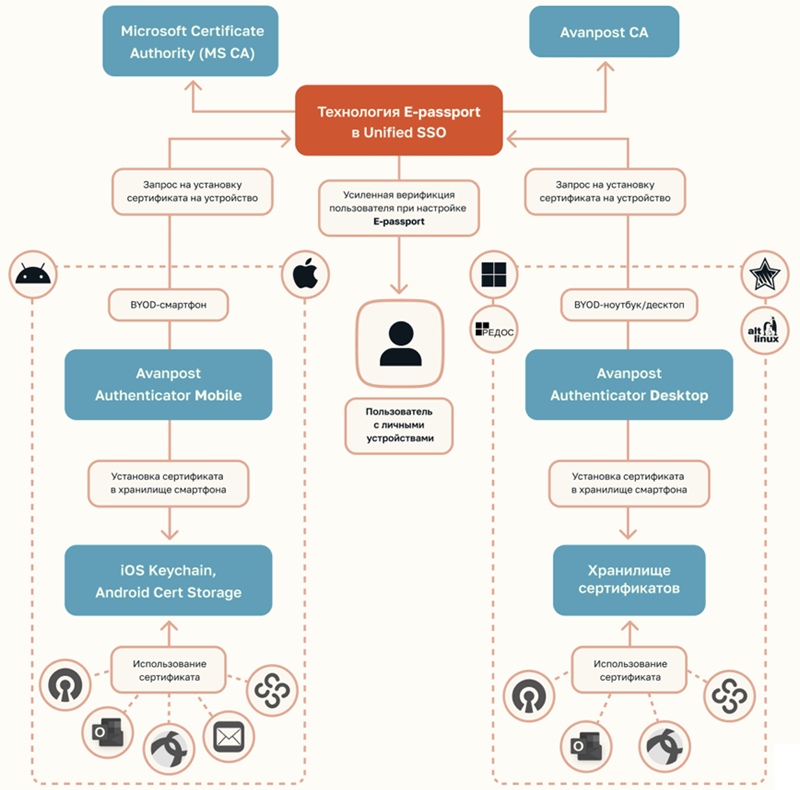

Avanpost представила технологию защищённой аутентификации E-Passport для корпоративного рынкаКомпания Avanpost разработала технологию защищённой аутентификации E-Passport. Решение включено в состав программного комплекса Unified SSO. E-Passport представляет собой цифровой идентификатор сотрудника на личном или корпоративном устройстве, реализованный в виде криптографической пары ключей. Технология обеспечивает защищённый доступ к корпоративной IT-инфраструктуре, безопасную передачу данных и исключает риск перехвата злоумышленниками сетевых сессий и чувствительной информации. Ключевая пара генерируется и неизвлекаемо сохраняется в защищённом аппаратном хранилище устройства (TPM, Secure Enclave, Keystore) под управлением операционных систем iOS, Android, Windows или Linux.

Архитектура решения E-Passport в составе программного комплекса Avanpost Unified SSO (источник изображения: avanpost.ru) E-Passport выступает основой бесшовной аутентификации во всех корпоративных системах любых вариантов исполнения — от веб-сервисов до традиционных десктопных приложений — с единой сессией. Решение позволяет сотрудникам выполнять однократный вход и автоматически получать доступ к комплекту внутренних корпоративных сервисов без многократного ввода паролей, при этом обеспечивая соблюдение принципов Zero Trust в контексте сессии. Одним из сценариев применения E-Passport является ситуация, когда сотрудник, пройдя единовременную аутентификацию на рабочей станции, получает доступ ко всем необходимым корпоративным приложениям и сервисам без необходимости повторной авторизации. Автоматизация такого уровня снижает нагрузку на IT-поддержку и ускоряет рабочие процессы, одновременно усиливая безопасность инфраструктуры.

10.02.2026 [09:57], Руслан Авдеев

Евросоюз потратит €347 млн на защиту и ремонт подводных кабелей — начнут с БалтикиЕврокомиссия объявила, что растущие риски для критически важной подводной кабельной инфраструктуры заставляют Евросоюз активизировать усилия по её защите. На днях представлен комплекс мер Cable Security Toolbox по снижению рисков безопасности кабелей и список кабельных проектов, представляющих интерес для Европы (Cable Projects of European Interest, CPEI). Также пересмотрен план Connecting Europe Facility (CEF) — Digital Work Programme по распределению €347 млн на стратегические кабельные проекты, в т.ч. на расширение европейских возможностей по ремонту кабелей. Новая инициатива — часть плана ЕС по обеспечению безопасности кабелей (EU Action Plan on Cable Security), направленного на укрепление безопасности подводной кабельной инфраструктуры Европы, в т.ч. на противодействие преднамеренным повреждениям и саботажу. Инструментарий для обеспечения безопасности включает шесть стратегических мер и четыре технические и вспомогательные. Комплекс разработали с учётом оценки рисков, уязвимостей и угроз, проведённой в октябре 2025 года. Государственному финансированию подлежат 13 направлений CPEI. Реализация проекта рассчитана на три пятилетки, до 2040 года. Проекты CPEI будут иметь приоритет при выборе в ходе предстоящих конкурсах предложений в рамках программы CEF. Им же будет уделяться особое внимание при планировании следующей многолетней программы финансирования. Оценка рисков, инструменты и CPEI определены Еврокомиссией и представителями государств в рамках специальной экспертной группы, посвящённой кабелям (Cables Expert Group). Еврокомиссия внесла поправки в план CEF Digital Work Programme, выделив €347 млн на финансирование кабельных проектов, имеющих стратегическое значение.

Источник изображения: Teo D/unsplash.com В 2026 году €60 млн выделят на два проекта по развитию возможностей ремонта кабелей, отдельно проведут конкурс на €20 млн для оборудования кабельных SMART-систем. Речь идёт о датчиках и элементах систем мониторинга, интегрированных в подводную кабельную инфраструктуру для сбора сейсмических и иных данных в режиме реального времени. Также в 2026–2027 гг. объявят два конкурса для финансирования CPEI на €267 млн. В рамках CEF Digital объявлен конкурс на €20 млн для развития «адаптируемых» модулей для ремонта подводной кабельной инфраструктуры. Предполагается, что такие модули будут размещать в портах и на верфях, что ускорит восстановление подводной инфраструктуры. Речь идёт о первом этапе более масштабной инициативы, предназначенной для всех морских бассейнов с присутствием Евросоюза (Балтийского, Средиземного и Атлантического). В ходе реализации пилотного проекта будет уделяться первоочередное внимание Балтийскому морю в связи с участившимися в последние годы случаями обрывов подводных кабелей. Предполагается, что объекты критически важной инфраструктуры могут стать целями для неких враждебных действий. Заявки на финансирование будут приниматься только от государственных организаций, имеющих полномочия реагировать на чрезвычайные ситуации, включая силы гражданской обороны, береговой охраны и ВМС. В рамках действующей многолетней рабочей программы CEF Digital multiannual Work Programme (2024–2027 гг.) на связанные с подводными кабелями проекты в общей сложности распределено €533 млн, из них €186 млн уже выделены на 25 проектов. В 2021–2024 гг. Евросоюз уже выделил €186 млн на 51 проект подключения к магистральным кабелям. Стоит отметить, что защита кабелей продвигается также по линии НАТО (Baltic Sentry) и отдельных стран. Так, срочно озаботиться вопросами ремонта и защиты подводных кабелей призывали британские власти.

09.02.2026 [23:25], Владимир Мироненко

Alphabet возьмёт в долг $20 млрд на 100 лет, чтобы вложиться в ИИХолдинг Alphabet (включает Google), объявивший на прошлой неделе о планах удвоить капзатраты в 2026 году до ≈$180 млрд, планирует привлечь $20 млрд за счёт выпуска долларовых облигаций, сообщил Bloomberg со ссылкой на информированные источники. Поначалу источники сообщали о планах Alphabet привлечь таким образом $15 млрд. По словам источников, помимо США холдинг предлагает инвесторам свои первые в истории размещения облигации в Швейцарии и Великобритании. Последнее будет включать редкую продажу 100-летних облигаций — первый случай, когда технологическая компания пытается осуществить подобное размещение со времён бума доткомов в конце 1990-х годов, отметил Bloomberg. В последний раз такой возможностью воспользовалась Motorola в 1997 году. Источники утверждают, что объявление Alphabet о выпуске долларовых облигаций в понедельник привлекло заявки на более чем $100 млрд. Собеседники Bloomberg сообщили, что холдинг разместит семь выпусков, самый «длинный» из которых со сроком погашения в 2066 году и доходностью на 0,95 п.п. выше, чем у казначейских облигаций США (ранее сообщалось о 1,2 п.п.). Согласно прогнозу Morgan Stanley, в 2026 году крупные инвестиционные компании займут $400 млрд, что намного больше $165 млрд в 2025 году. Массовое размещение облигаций, вероятно, приведёт к рекордному объему выпуска высококачественных долговых обязательств в этом году в размере $2,25 трлн, указал в своей аналитической записке Вишвас Паткар (Vishwas Patkar), глава отдела кредитной стратегии в США Morgan Stanley. Некоторые кредитные стратеги ожидают, что масштабный выпуск облигаций приведёт к расширению спредов (увеличению разницы между ценами покупки и продажи) по корпоративным облигациям, что означает увеличение рисков при операциях с такими активами. «Мы считаем, что сценарий похож на 1997/98 или 2005 год: кредиты показывают худшие результаты, но не “конец цикла”», — написал Паткар, имея в виду период, когда растёт число дефолтов и сокращается доступность кредитов. Последний раз Alphabet выходил на американский рынок облигаций в ноябре 2025 года, когда привлёк $17,5 млрд в рамках сделки с продажей 50-летних облигаций. Это было самое долгосрочное предложение корпоративных технологических облигаций в долларах США в прошлом году, согласно данным Bloomberg. Alphabet также продал в то время облигации на €6,5 млрд в Европе. Другие технологические компании тоже наращивают капзатраты в борьбе за доминирование на ИИ-рынке. Amazon объявила о планах направить на капзатраты в 2026 году $200 млрд, а Meta✴ Platforms планирует потратить от $115 до $135 млрд. Ожидаемые затраты Microsoft составят $145 млрд, а Oracle — $55 млрд.

09.02.2026 [14:20], Сергей Карасёв

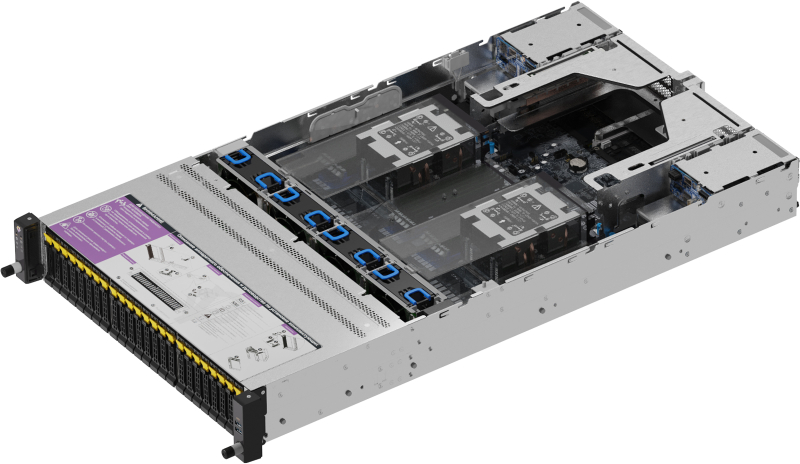

OpenYard выпустила российский двухсокетный сервер RS202A на базе AMD EPYC TurinРоссийский разработчик и производитель корпоративного оборудования OpenYard объявил о начале серийного выпуска серверов RS202A на аппаратной платформе AMD. Устройства предназначены для построения масштабируемых и отказоустойчивых IT-инфраструктур, включая виртуальные среды, аналитические системы и хранилища данных. Серверы выполнены в форм-факторе 2U. Допускается установка двух процессоров AMD EPYC 9005 поколения Turin в исполнении LGA 6096 (SP5) с показателем TDP до 500 Вт. Предусмотрены 24 слота для модулей оперативной памяти DDR5-6400 суммарным объёмом до 6 Тбайт. В оснащение входят контроллер ASPEED AST2600, двухпортовый сетевой адаптер 1GbE (Intel I350-AM2) и выделенный сетевой порт управления 1GbE. Во фронтальной части корпуса в зависимости от модификации располагаются 24 отсека для SFF-накопителей (SATA/SAS-4/NVMe PCIe 5.0) или 12 отсеков для LFF-изделий. В тыльной секции находятся четыре посадочных места для SFF-изделий с интерфейсом SATA/SAS-4. Во всех случаях допускается горячая замена. Кроме того, сеть два внутренних слота для SSD типоразмера M.2 2280/22110 с интерфейсом PCIe 3.0 x4 и один слот M.2 2280/22110 PCIe 3.0 x2. Доступны до пяти разъёмов PCIe 5.0 x16 для карт расширения FHHL и до двух разъёмов OCP 3.0 PCIe 5.0 x16 с поддержкой NCSI. Габариты составляют 438 × 87,5 × 815 мм. Установлены два блока питания мощностью 2000 Вт с сертификатом 80 PLUS Platinum. Упомянуты два порта USB 3.2, коннектор Mini-DP и три гнезда RJ45 для сетевых кабелей. Диапазон рабочих температур — от +10 до +35 °C. Производство серверов RS202A осуществляется на собственной площадке OpenYard в Рязани. В настоящее время системы проходят пилотные внедрения в корпоративных IT-средах, а объёмы выпуска планируется масштабировать в зависимости от рыночного спроса, говорит компания.

09.02.2026 [09:10], Владимир Мироненко

Хоть инвестиций клок: SambaNova проведёт раунд на $350 млн при поддержке IntelСтартап в сфере разработки ИИ-чипов SambaNova Systems ведёт переговоры о привлечении более $350 млн в рамках раунда финансировании серии E, сообщило агентство Reuters. Раунд возглавляет частная инвестиционная компания Vista Equity Partners, которая до этого инвестировала исключительно в компании, занимающиеся корпоративным ПО. Компания, известная крупными сделками в сфере ПО, приобрела в 2022 году компанию облачных вычислений Citrix Systems и компанию-разработчика ПО Nexthink в 2025 году. Сообщается, что это изменение может быть вызвано масштабной распродажей акций компаний-разработчиков ПО на этой неделе. По данным источников Reuters, в раунде также примут участие венчурная компания Cambium Capital и Intel. В частности, Intel, как сообщается, планирует инвестировать около $100 млн с потенциальным обязательством направить $150 млн. Оценка рыночной стоимости, которую SambaNova может получить по итогам раунда, не уточняется. Источники предупредили, что привлечение средств продолжается, и окончательные условия раунда могут измениться. Источники сообщили, что SambaNova начала искать новое финансирование в прошлом месяце после того, как переговоры о её приобретении компанией Intel зашли в тупик. В декабре появилась информация о том, что Intel предложила за SambaNova $1,6 млрд, включая долг. Это примерно треть от суммы в $5 млрд, в которую оценивалась рыночная стоимость SambaNova после последнего раунда финансирования в 2021 году, возглавляемого фондом SoftBank Vision Fund 2. С момента основания в 2017 году SambaNova привлекла более $1 млрд инвестиций и переориентировалась на разработку решений в области ИИ и облачных сервисов. С тех пор компания столкнулась с трудностями и провела сокращения персонала в 2024 году. В прошлом месяце компания сообщила сотрудникам, что превысила целевой показатель продаж за 2025 финансовый год. Рост числа клиентов SambaNova может быть одной из причин, по которой компания привлекла интерес институциональных инвесторов и Intel, допускает ресурс SiliconANGLE. В июле прошлого года SambaNova представила услугу SambaManaged, которая сокращает время развёртывания ИИ-оборудования в типовом ЦОД до 90 дней. В течение следующих шести месяцев компания заключила контракты на поставку оборудования с четырьмя различными операторами ЦОД. В рамках одного из контрактов SambaNova будет поставлять чипы для суверенного облачного кампуса в Шотландии с запланированной мощностью более 2 ГВт. Флагманский продукт SambaNova — ИИ-ускоритель для инференса SN40L, содержащий 1040 ядер, изготовленных с использованием 5-нм техпроцесса TSMC, имеет производительность 638 Тфлопс в режиме BF16. Компания поставляет чипы в составе системы SambaStack с воздушным охлаждением, которая содержит 16 ускорителей SN40L, а также включает в себя сетевое оборудование и компоненты управления питанием. SambaStack позволяет запускать ИИ-модели с до 5 трлн параметров.

08.02.2026 [17:00], Владимир Мироненко

Из-за ИИ и так дефицитная SLC NAND подорожает на 400–500 %В связи с продолжающимся усовершенствованием ИИ-серверов и коммутаторов объём NOR-памяти на одну единицу такой продукции, как ожидают аналитики DigiTimes, вырастет в несколько раз на фоне прогнозируемого дефицита высокопроизводительных компонентов. Согласно прогнозу DigiTimes, во II квартале 2026 года цены на NOR Flash вырастут последовательно на 40–50 %, причем по некоторым позициям клиенты будут готовы платить надбавки, чтобы гарантировать поставки в рамках контрактов. Что касается памяти SLC NAND и MLC NAND, то здесь ожидается ещё более значительный рост цен — на 400–500 % во II квартале в годовом исчислении, что побудит тайваньского производителя Winbond Electronics ускорить расширение мощностей по производству SLC NAND. Winbond выпускает NOR-память для ИИ-серверов и сетевых приложений с использованием 58-нм техпроцесса, в то время как память для носимых устройств, таких как Bluetooth-гарнитуры, производится по 45-нм техпроцессу. DigiTimes отметил, что более сложный дизайн NVIDIA GB300 по сравнению с GB200 с большим объёмом памяти и более высокими требованиями к её спецификациям обусловил рост спроса на модули NOR ёмкостью 512 Мбайт и 1 Гбайт. Но запасы модули NOR-памяти большой ёмкости остаются относительно ограниченными. По данным источников, цены на NOR-флеш выросли в I квартале 2026 года примерно на 30 %, а на некоторые позиции — на 50 %. Хотя масштабы повышения цен менее значительны, чем в категории DDR4, предложение NOR остаётся ограниченным, и ожидается, что контрактные цены неё во II квартале вырастут ещё на 40–50 %, а сроки поставки специальных вариантов увеличатся до 12–14 недель.

Источник изображения: Winbond Тайваньский производитель Macronix тоже утверждает, что продолжающийся рост выпуска серверов для ИИ-нагрузок создаёт структурную напряжённость на рынке NOR, которую будет сложно преодолеть в краткосрочной перспективе. Уход крупных производителей NAND-памяти с рынков SLC NAND и MLC NAND ещё больше подстегнул дефицит и позволил Winbond и Macronix выступать на рынке в качестве основных поставщиков. Цены Macronix на MLC eMMC недавно выросли вдвое по сравнению с декабрём 2025 года. Несмотря на авансовые платежи, внесённые ранее в этом году, клиентам не обеспечили поставки до китайского Нового года, что сделало эту продукцию крайне дефицитной на нишевых рынках, пишет DigiTimes. Доля в выручке Macronix от памяти NAND (включая eMMC) выросла до 21 %, более чем вдвое превысив уровень прошлого года. Контрактные цены Winbond на память SLC NAND во II квартале 2026 года, как ожидается, резко вырастут по сравнению с аналогичным периодом 2025 года — до 400–500 %. Цены Winbond на SLC NAND в I квартале выросли больше всего в её портфолио, превысив рост цен на DDR4. Компания планирует расширение своих мощностей по производству памяти. В частности, будут запущены производственные линии по выпуску DRAM на заводе в Гаосюне (Gāoxióng). Сообщается, что мощность завода компании в Тайчжуне (Táizhōng) составляет примерно 58 тыс. пластин в месяц, включая приблизительно 25 тыс. пластин для NOR, 15 тыс. пластин для NAND и 10 тыс. пластин для DRAM. Ожидается значительное увеличение общего объёма производства до примерно 50 тыс. пластин памяти NOR и SLC NAND с более высокой рентабельностью. Согласно данным Winbond, на SLC NAND, производимую по 46-нм и 32-нм техпроцессам, приходится около 15–25 % выручки. Её доля в выручке компании будет расти по мере роста цен, что приведет к сокращению мощностей, выделенных на производство DRAM по устаревшим техпроцессам. Цены на флеш-память, изготовленную по традиционным технологиям, стремительно растут, а спрос на NOR-память большой ёмкости увеличился в несколько раз. По данным источников DigiTimes, Winbond, увеличившая объёмы поставок, недавно завершила согласование цен по контрактам на I квартал 2026 года. Ожидается, что рост цен на DRAM, начавшийся в IV квартале 2025 года, продолжится и во II квартале 2026 года, что ознаменует собой третий подряд квартал роста и фактически удвоение контрактных цен в годовом исчислении. Также сообщается, что новые производственные мощности Winbond, запланированные к вводу в эксплуатацию в 2027 году, уже полностью забронированы. Глава Winbond сообщил о резко увеличившемся количестве запросов от клиентов, что создало дефицит предложения и затрудняет удовлетворение всех их потребностей. Помимо прямых клиентов первого уровня, владельцы брендов второго уровня и операторы третьего уровня всё чаще обходят посредников и ведут переговоры напрямую с Winbond, что отражает высокий рыночный спрос, отметил DigiTimes.

08.02.2026 [15:14], Руслан Авдеев

Iren привлекла $3,6 млрд на закупку ИИ-ускорителей для нужд Microsoft — отказ от майнинга продолжаетсяНеооблачная компания Iren опубликовала результаты II квартала 2026 финансового года, закончившиеся в декабре 2025-го. Ключевым событием стало привлечение $3,6 млрд для закупки ИИ-ускорителей, которые нужны для обеспечения долгосрочной сделки с Microsoft, сообщает Converge! Digest. С учётом предоплаты от клиента в размере $1,9 млрд покрывается около 95 % капитальных затрат, связанных с инфраструктурой ИИ-ускорителей. Компания объявила, что закупка 140 тыс. чипов будет идти по плану. К концу календарного 2026 года, как ожидается, годовая повторяющаяся выручка (ARR — Annual Recurring Revenue) достигнет $3,4 млрд. Iren продолжает переход от майнинга биткоинов к созданию облачной ИИ-инфраструктуры. Развитие осуществляется по нескольким векторам. Так, в Британской Колумбии (Канада) расширяется ИИ-платформа AI Cloud. На площадке Prince George уже законтрактованы сервисы на $400 млн, в результате текущих переговоров общий потенциал может превысить $500 млн ARR. В Оклахоме анонсировано строительство нового кампуса мощностью 1,6 ГВт, что увеличивает портфолио компании до более чем 4,5 ГВт. Начало подключений к энергосети на новой площадке начнётся уже в 2028 году. Выручка компании во II квартале 2026 финансового года последовательно снизилась до $184,7 млн. Скорректированная EBITDA — $75,3 млн. Чистый убыток и нескорректированная EBITDA оказались хуже ожидаемых из-за «неденежных» и разовых факторов. Например, отмечены нереализованные убытки из-за переоценки хеджей по конвертируемым облигациям, разовое списание ASIC из-за перехода от майнинга к ИИ-инфраструктуре, а также повышенные расходы на вознаграждение акциям. Часть негативного эффекта компенсирована налоговой выгодой от пересмотра отложенных налоговых обязательств.

Источник изображения: Jakub Żerdzicki/unsplash.com На 31 января 2026 года компания располагала $2,8 млрд денежных средств и их эквивалентов. Всего с начала года привлечено $9,2 млрд с помощью различных финансовых инструментов. В I квартале благодаря быстрому расширению сегмента AI Cloud и заключению серии многолетних контрактов общая выручка Iren выросла на 355 % год к году до $240,3 млн. Показатель скорректированной EBITDA увеличился сразу на 3568 % до $91,7 млн. По данным руководства компании, в прошедшем квартале отмечен значительный прогресс в расширении ИИ-мощностей, работе с клиентами и привлечении капитала. Это отражает её становление как облачной ИИ-платформы. Имея более 4,5 ГВт обеспеченной мощности, можно планировать и реализовать широкий набор проектов и поддерживать следующий этап роста. По мнению Converge! Digest, последняя сделка Iren демонстрирует то, как соглашения с гиперскейлерами преобразуют финансовые модели крупных развёртываний ИИ-инфраструктуры. Предоплаты и финансирование, обеспеченное доступными активами, существенно снижают нагрузку на баланс операторов инфраструктуры, а проект в Оклахоме в целом соответствует общей тенденции создания гигаваттных ИИ ЦОД в Северной Америке, рассчитанных на доступность энергии после 2027 года и устойчивый спрос со стороны облачных провайдеров и разработчиков ИИ-моделей. |

|