Лента новостей

|

13.11.2025 [15:49], Андрей Крупин

«Ростелеком» приобретает долю в одном из старейших разработчиков российского Linux — «Базальт СПО»«Ростелеком» объявил о приобретении доли в размере 5 % в компании «Базальт СПО», занимающейся разработкой системного программного обеспечения на базе Linux, в том числе по требованиям российского законодательства в области защиты информации. Владельцем доли стал фонд поддержки национальных IT-решений «Консоль», созданный при участии «Ростелекома» и Минцифры России. В сообщении телекоммуникационного оператора подчёркивается, что до конца 2025 года доля фонда «Консоль» в «Базальт СПО» будет поэтапно доведена до 25 %, в том числе за счёт внесения денежного вклада в уставной капитал софтверного разработчика. Фактически «Базальт СПО» станет частью коммерческого IT-кластера «Ростелекома», включающего компанию «Базис», экосистему «Лукоморье» и облачного провайдера «Турбо Облако». По словам «Ростелекома», сделка с «Базальт СПО» является важным шагом в стратегии компании, который формирует конкурентоспособный национальный стек цифровых технологий. Приобретение доли отечественного разработчика позволит телекоммуникационному гиганту усилить экосистему программных продуктов IT-кластера и обеспечит более активное участие в процессах замещения иностранного ПО на российском рынке.

Источник изображения: пресс-служба компании «Ростелеком» / company.rt.ru «Объединение технологий «Базальт СПО» с коммерческим IT-кластером «Ростелекома» позволит создавать IT-инфраструктуры нового поколения. Эти комплексные и масштабируемые решения смогут удовлетворить потребности самых разных клиентов: от государственных ведомств до частных компаний. Таким образом, мы не просто расширяем продуктовую линейку, а формируем целостные решения, что кардинально повысит конкурентоспособность «Ростелекома» и ускорит вывод на рынок готовых, безопасных IT-платформ», — говорится в сообщении телекоммуникационного оператора.

13.11.2025 [12:12], Руслан Авдеев

Anthropic инвестирует $50 млрд в американскую ИИ-инфраструктуруИИ-стартап Anthropic объявил о намерении инвестировать $50 млрд в вычислительную инфраструктуру в США. Компания создаст ЦОД совместно с Fluidstack в Техасе, Нью-Йорке и других. местах. Объекты проектируются с учётом запросов Anthropic для обеспечения максимальной эффективности рабочих нагрузок. Fluidstack выбрана в качестве партнёра стартапа за «исключительную гибкость», позволяющую быстро получить гигаватты мощностей. Первые объекты должны ввести в эксплуатацию в 2026 году. ЦОД позволят создать 800 постоянных рабочих мест. План поможет выполнению инициативы администрации Дональда Трампа в области ИИ (AI Action Plan) — она направлена на сохранение лидерства США в сфере искусственного интеллекта. В компании заявляют, что приближаются к созданию ИИ, способного ускорить научные открытия и решать сложные задачи невозможными ранее способами. Для этого необходима инфраструктура, способная поддерживать непрерывное развитие — новые площадки помогут создавать более эффективные ИИ-системы, способные обеспечить новые исследовательские прорывы и создавать рабочие места для американцев. Anthropic с её ИИ-моделями Claude обслуживает более 300 тыс. корпоративных клиентов, а число клиентов, приносящих более $100 тыс. ежегодно, за последний год выросло почти в семь раз. Огромный масштаб инвестиций необходим для удовлетворения растущего спроса на Claude среди сотен тысяч компаний с сохранением передовых позиций в сфере исследований ИИ-технологий. В компании обещают отдавать приоритет «экономически эффективным» и «капиталоэффективным» подходам для достижения своих целей. По данным Datacenter Dynamics, в случае с техасским ЦОД, возможно, речь идёт о ранее анонсированном объекте Fluidstack и TeraWulf на 168 МВт в Абернати (Abernathy) или о совместном c Cipher Mining проекте на 244 МВт. В случае с Нью-Йоркским ЦОД, речь, возможно, идёт о кампусе Lake Mariner — совместном проекте Fluidstack и TeraWulf. Google, имеющая долю 14 % в Anthropic, поддержала оба проекта с участием TeraWulf. Ранее в этом году компания обеспечила гарантии по её кредитам, а также предоставила гарантии по арендным обязательствам Fluidstack на сумму $1,4 млрд для сделки с Cipher, получив в TeraWulf долю 5,4 %, а в бизнесе Fluidstack — 14 %. В октябре Anthropic анонсировала сделку с Google Cloud объёмом более 1 ГВт, которая даст ей доступ к миллиону ускорителей Google TPU. Предстоит уточнить, идёт ли в новом анонсе Anthropic речь о том же самом контракте с участием Fluidstack в качестве посредника — или речь идёт о новой сделке. AWS тоже владеет долей в Anthropic. В октябре она запустила для Anthropic кластер Project Rainier на основе собственных ИИ-ускорителей Tranium2. На площадку потратят $11 млрд (при полной загрузке). Стоимость вычислений Anthropic растёт, но The Information располагает информацией, что ИИ-стартап надеется использовать более эффективные модели, требующие меньших вычислительных мощностей в пересчёте на каждого пользователя. Это снизит затраты и позволит скорее добиться прибыльности бизнеса. По оценкам, $50 млрд инвестиций дадут компании доступ к примерно 5 ГВт ЦОД.

13.11.2025 [11:00], Сергей Карасёв

«Группа Астра» представила семейство ПАК XPlatform для построения ИТ-инфраструктуры «под ключ»

astra linux

hardware

ии

облако

резервное копирование

сделано в россии

сервер

субд

схд

частное облако

«Группа Астра» анонсировала серию отечественных программно-аппаратных комплексов (ПАК) XPlatform, которые, как утверждается, предназначены для быстрого развертывания устойчивой, высокопроизводительной и безопасной ИТ-инфраструктуры «под ключ». В семейство вошли устройства разного класса — XTime, XCloud, XConnect, XGenAI и XData для решения определённых задач. Все компоненты систем XPlatform спроектированы для бесшовной интеграции, имеют необходимые сертификаты регуляторов, внесены в реестры Минцифры и Минпромторга. Каждый продукт поставляется как полностью подготовленный комплекс, прошедший заводское тестирование и проверку совместимости. Использование ПАК позволяет сократить издержки на интеграцию и отладку, а также ускорить развёртывание: на ввод в эксплуатацию требуются считаные дни или даже часы вместо недель или месяцев как в случае разрозненных решений. Система XTime предназначена для резервного копирования и централизованного хранения бэкапов виртуальных машин, баз данных и файловых хранилищ. Возможно архивирование регламентированных данных с длительным сроком хранения (соблюдение политики аудита). Поддерживаются распределённые филиальные контуры. В состав XTime входят сервер с RAID-контроллерами и дисковые полки. Программная составляющая включает софт Termidesk Connect и BRO Software. В свою очередь, XCloud служит для построения частного, гибридного или публичного облака, в котором можно гибко объединять IT-ресурсы, управлять доступом большого числа пользователей и масштабировать инфраструктуру под растущие нагрузки. Обеспечиваются быстрое развёртывание сложных информационных и геоинформационных систем, контроль и учёт потребления вычислительных ресурсов. Платформа объединяет серверы, СХД (SDS-архитектура) и коммутаторы, а также стек различного ПО. ПАК XConnect обеспечивает доставку приложений. Этот аппаратно-программный контроллер балансирует трафик, распределяет запросы между серверами и гарантирует устойчивость пользовательских сервисов. Обеспечивается возможность построения распределённой инфраструктуры для организаций с разветвлённой филиальной сетью. Разработчик говорит о высокой доступности системы даже при значительном росте количества пользователей. Аппаратная часть включает высокопроизводительные системы карт, SSL-ускорение и резервирование критичных компонентов. Применяется ПО Termidesk Connect. Решение XGenAI предназначено для создания и развёртывания классических и генеративных ИИ-моделей, включая обработку естественного языка, предиктивную аналитику и компьютерное зрение в локальных контурах. Используются сервер с ускорителями на основе GPU и софт «Тессеракт». Наконец, XData — это машина баз данных, которая, по заявлениям производителя, обеспечивает высокую доступность, масштабируемость и балансировку нагрузки для критически важных корпоративных СУБД. Задействована программная платформа Tantor. В числе потенциальных заказчиков ПАК XPlatform названы государственные и регулируемые организации, банки и прочие финансовые учреждения, промышленные предприятия и корпорации с филиальной структурой, а также любые другие компании, работающие с высоконагруженными приложениями и «чувствительными» данными. «С XPlatform мы предлагаем клиентам не просто набор технологий, а законченные программно-аппаратные комплексы, которые сокращают путь от идеи до промышленной эксплуатации. Единый стек, предсказуемая производительность, соответствие регуляторным требованиям и единое окно поддержки — это та комбинация, что позволяет бизнесу быстро и безопасно решать самые разнообразные задачи», — говорит Антон Шмаков, технический директор «Группы Астра».

12.11.2025 [23:23], Владимир Мироненко

От ИИ ЦОД до роботов: AMD анонсировала долгосрочную стратегию роста

amd

cpu

dpu

epyc

hardware

instinct

mi400

mi500

ocp

pensando systems

ualink

ultra ethernet

venice

verano

xilinx

ии

ускоритель

финансы

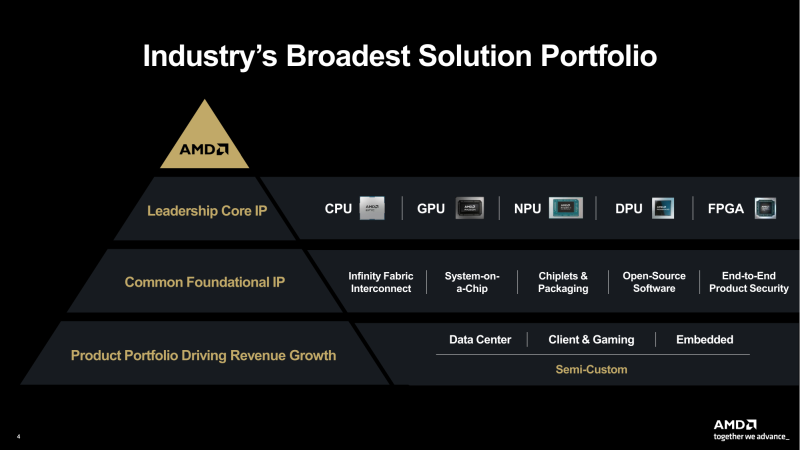

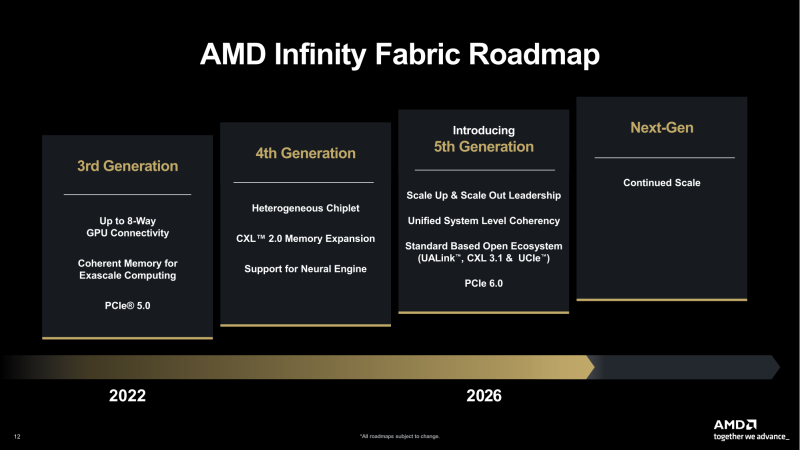

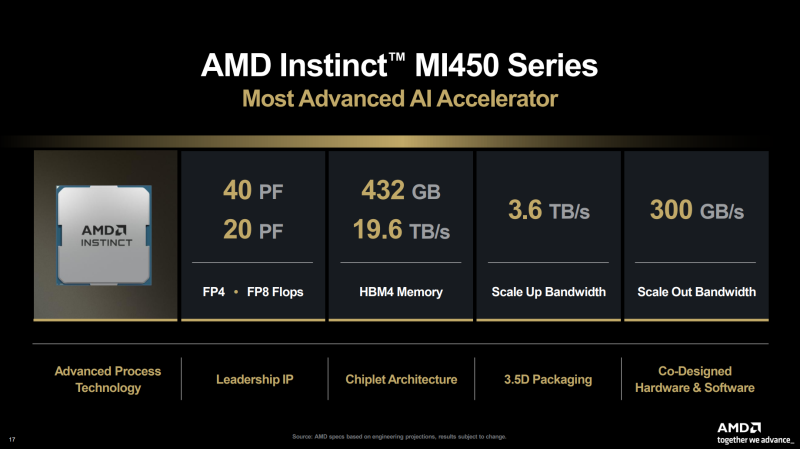

AMD представила на мероприятии Financial Analyst Day 2025 план по достижению лидерства на рынке вычислительных технологий объёмом $1 трлн. Долгосрочная стратегия роста AMD построена на четырех столпах: лидерство в сфере ЦОД, повышение производительности ИИ, открытое ПО и расширение присутствия на рынках встраиваемых и полукастомных кремниевых решений. AMD ожидает, что только её бизнес в сфере ЦОД будет приносить более $100 млрд годовой выручки, с увеличением совокупного среднегодового темпа роста (CAGR) до более чем 60 %, при этом CAGR дохода от ИИ-решений увеличится до более чем 80 %. Генеральный директор AMD Лиза Су (Lisa Su) заявила, что следующий этап будет основан на унифицированной вычислительной платформе AMD, объединяющей процессоры EPYC, ускорители Instinct, сетевые решения Pensando и ПО ROCm. Новый план развития AMD призван обеспечить ей конкуренцию с NVIDIA и Intel на корпоративных рынках и в борьбе за заказы гиперскейлеров. Ускорители серии Instinct MI350, уже развёрнутые Oracle (ещё 50 тыс. MI450 будут развёрнуты во II половине 2026 г.), являются самыми популярными ускорителями AMD на сегодняшний день. Следующей платформой станет серия MI450, которая будет запущена вместе со стоечной платформой Helios в III квартале 2026 года. Helios обеспечит пропускную способность интерконнекта 3,6 Тбайт/с на каждый ускоритель и до 72 ускорителей на стойку с совокупной пропускной способностью 260 Тбайт/с, соединённых между собой посредством UALink и Ultra Ethernet (UEC). Система поддерживает разделяемую память между ускорителями, что обеспечивает обучение крупномасштабных моделей с бесперебойным доступом к памяти и отказоустойчивой сетью с шестью плоскостями. AMD характеризует Helios как свою первую ИИ-платформу стоечного масштаба — полностью интегрированную систему с открытой архитектурой, которая объединяет вычислительные мощности, ускорение, сетевые технологии и ПО в единую структуру. В отличие от традиционных серверных кластеров, Helios реализует всю стойку как единый высокопроизводительный вычислительный домен. Каждая стойка объединяет процессоры AMD EPYC Venice, CDNA5-ускорители Instinct MI450X (будет и вариант MI430X с полноценными FP64-блоками) и 400G/800G-карты Pensando Vulcano, связанные Infinity Fabric пятого поколения (PCIe 6.0, CXL 3.1, UCIe) и UALink. Эта архитектура минимизирует накладные расходы на перемещение данных, увеличивает пропускную способность между ускорителями и обеспечивает эффективность класса экзафлопсных вычислений в компактном корпусе. Helios фактически представляет собой проект AMD для ИИ-фабрики будущего с возможностью модульного расширения, позволяя объединять сотни стоек в одну систему в ЦОД. В 2027 году AMD планирует выпустить ускорители серии MI500 и процессоры EPYC Verano, продолжая тем самым ежегодный цикл совместной разработки процессоров, ускорителей и сетей. AMD заявила, что EPYC Venice, намеченные к выпуску в 2026 году, будут обладать лучшими в отрасли показателями плотности (1,3x по количеству потоков в сравнении с текущими решениями) и энергоэффективности (1,7x). Они пополнятся оптимизированными для ИИ наборами инструкций для обработки инференса и выполнения вычислений общего назначения. Указанные компоненты станут основой ИИ-фабрики, способной масштабироваться от одной стойки до глобально распределённых кластеров. Исполнительный вице-президент AMD Форрест Норрод (Forrest Norrod) подчеркнул в своём выступлении, что производительность ИИ всё больше зависит от сети. Сетевые карты AMD Pensando Pollara и Vulcano для ИИ образуют связующую ткань архитектуры Helios. Сетевая карта Pollara 400 обеспечивает пропускную способность 400 Гбит/с, а готовящаяся к выходу сетевая карта Vulcano удвоит её до 800 Гбит/с, обеспечивая связь Ultra Ethernet между крупными кластерами ускорителей. AMD представила четырёхуровневую архитектуру сети для масштабных ИИ-инфраструктур. Front-End часть обслуживает пользователей, хранилище и приложения. Она опирается на DPU Pensando и P4-движки, отвечающие за разгрузку сетевых функций, функции безопасности и шифрования, и работу с СХД. Вертикальное масштабирование в пределах стойки обеспечивает 3,6-Тбайт/с подключение на каждый GPU. Горизонтальное масштабирование реализуется благодаря UEC — внутренние тесты показали снижение затрат на коммутацию до 58 % по сравнению с традиционными сетями типа Fat-Tree. Наконец, Scale-Across (пространственное масштабирование) позволит объединить географически распределённые ЦОД в кластеры с интеллектуальным управлением трафиком и адаптивной балансировкой нагрузки. AMD отметила, что открытый программный стек ROCm (Radeon open compute) по-прежнему лежит в основе её стратегии в области ИИ-платформ. По сравнению с прошлым годом число его загрузок выросло в десять раз и теперь на HuggingFace поддерживается более 2 млн моделей. ROCm интегрируется с ведущими фреймворками, включая PyTorch, TensorFlow, JAX, Triton, vLLM, ComfyUI и Ollama, и поддерживает проекты с открытым исходным кодом, такие как Unsloth. AMD также расширила своё видение «физического ИИ», когда вычисления выходят за рамки облака и охватывают роботов, транспортные средства и промышленные системы. Подразделение встраиваемых систем, усиленное приобретением Xilinx в 2022 году, превратилось из бизнеса, ориентированного на FPGA, в многоплатформенный двигатель роста, охватывающий адаптивные системы на кристалле (SoC), встраиваемые x86-процессоры и заказные кремниевые решения. По словам компании, с 2022 года решения в этой области принесли более $50 млрд. AMD рассчитывает превысить 70 % доли рынка адаптивных вычислений. Говоря о перспективах, компания отметила, что ЦОД остаются основным драйвером роста, но наряду с этим она будет диверсифицировать свою деятельность по всем сегментам. Финансовые цели AMD включают:

12.11.2025 [21:06], Андрей Крупин

Российский корпоративный центр сертификации SafeTech CA получил масштабное обновление

software

защита предприятия

импортозамещение

информационная безопасность

криптография

сделано в россии

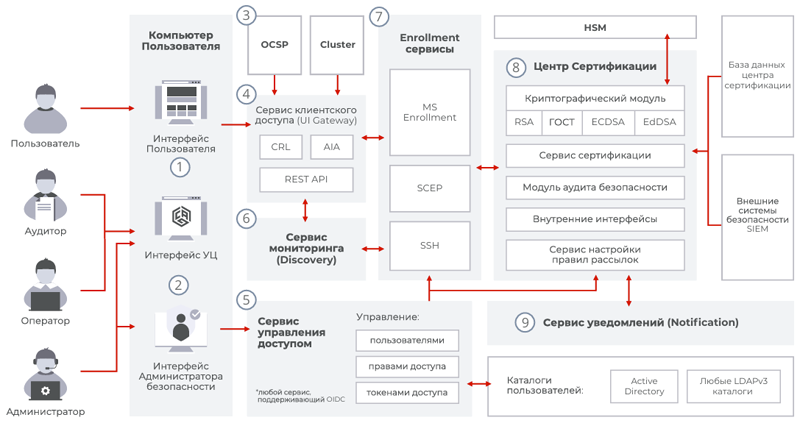

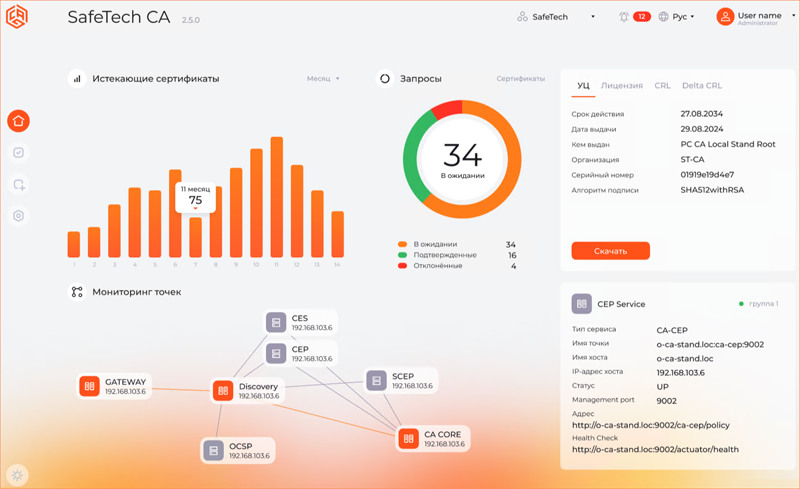

Работающая в сфере кибербезопасности российская компания SafeTech Lab представила крупнейшее с момента создания продукта обновление корпоративного центра сертификации SafeTech CA. Программный комплекс SafeTech CA в полной мере отвечает задачам импортозамещения ПО в отечественных организациях и способен полностью заменить Microsoft Certificate Authority для Windows-инфраструктур. Решение также позволяет управлять процессами выпуска и администрирования технологических сертификатов для Linux-систем, мобильных устройств на базе Android/iOS, сетевого оборудования и других компонентов IT-ландшафта. Ключевой инновацией в SafeTech CA стала реализация полноценного Autoenrollment’a технологических сертификатов для Linux-систем. Совместно с экспертами «Группы Астра» разработаны механизмы и многочисленные сценарии автоматического выпуска, обновления и отслеживания статуса сертификатов пользователей и компонентов инфраструктуры в рамках домена ALD Pro. В дополнение к этому были расширены возможности интеграции комплекса и с другими службами каталогов. Так, для Microsoft Active Directory внедрён ряд улучшений и дополнений, позволяющих IT-администраторам детальнее настраивать политики выпуска сертификатов. Для «Ред АДМ» (Samba DC) подготовлены специализированные сценарии и инструменты для интеграции компонентов PKI-инфраструктуры на базе SafeTech CA.

Архитектура SafeTech CA (источник изображения: safetechlab.ru) Для более тонкой настройки прав доступа в рамках домена в SafeTech CA добавлена возможность назначения шаблонов сертификатов на подразделения (Organization Unit), что позволяет разграничить использование различных сервисов в инфраструктуре организации средствами PKI. В партнёрстве с компанией «Актив» был разработан механизм выпуска цифровых сертификатов на аппаратные носители «Рутокен» напрямую через интерфейс SafeTech CA. Для аутентификации пользователей по смарт-картам в SafeTech CA разработаны сценарии и добавлены инструменты реализации Smart Card Logon на базе доменов ALD Pro, Microsoft AD, «Ред АДМ», FreeIPA, Samba DC. Важным шагом в оптимизации работы с интернет-сервисами стала поддержка протокола ACME, который позволяет в автоматическом режиме выпускать и обновлять SSL/TLS-сертификаты для веб-серверов.

Пользовательский интерфейс SafeTech CA (источник изображения: safetechlab.ru) «Новый релиз SafeTech CA знаменует собой превращение продукта в универсальную многофункциональную платформу для управления цифровыми сертификатами в сложных гибридных инфраструктурах. Реализация Linux Autoenrollment с отслеживанием статуса и обновлением сертификатов внутри домена — это долгожданная возможность, обеспечивающая заказчикам совершенно новый уровень автоматизации для отечественных Linux-сред, который раньше был доступен только в Windows-инфраструктурах», — говорится в заявлении SafeTech Lab. Дальнейшая дорожная карта SafeTech CA предполагает углублённую проработку сервисных процессов PKI, включая централизованное конфигурирование компонентов и ротацию сертификатов, повышение производительности решения для работы в высоконагруженных архитектурах, а также расширение интеграционных возможностей.

12.11.2025 [17:12], Руслан Авдеев

Конкуренция на рынке аккумуляторных энергохранилищ США скажется на ЦОД — у КНР более дешёвые и качественные АКБ

catl

hardware

jefferies

tesla

дефицит

ибп

ии

китай

прогноз

санкции

сша

цод

электропитание

энергетика

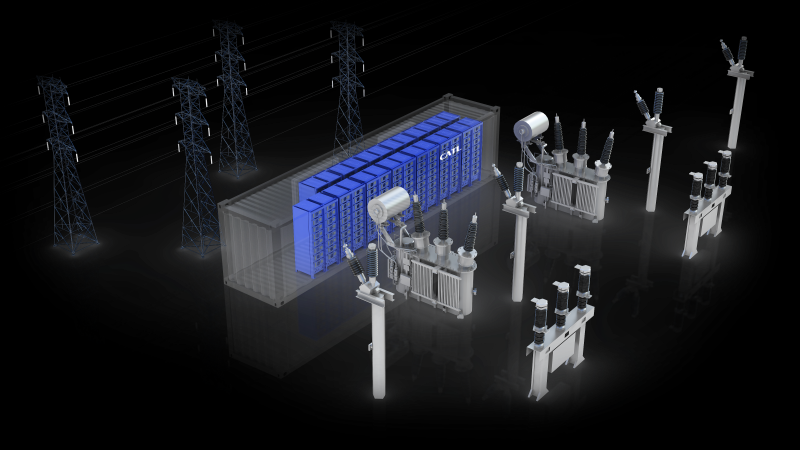

Аккумуляторные энергохранилища (BESS) в скором будущем могут стать стандартом для дата-центров по мере расширения инфраструктуры ИИ ЦОД. Тем не менее американских экспертов настораживает существующая на рынке тенденция — аккумуляторные решения из США во многом уступают китайским аналогам, сообщает The Register. В распоряжение издания попали материалы аналитической компании Jefferies. В отчёте подчёркивается, что гиперскейлеры, строящие ИИ ЦОД, всё больше рассматривают BESS в качестве неотъемлемой части энергетической инфраструктуры. Они всё чаще обращаются к проектам локальной генерации или испытывают проблемы с присоединением к энергосетям, поэтому BESS рассматривается как дополнительный ресурс, позволяющий управлять нагрузками, ускорить подключение и получить избыточные резервы энергии. Аккумуляторные системы используют в качестве резервных наряду с генераторами и другими вариантами получения энергии вроде твёрдооксидных топливных элементов. В Jefferies ожидают, что применение BESS будет расти в связи с трудностями коммунальных служб, которым трудно справиться с ростом спроса на электричество со стороны владельце электромобилей и расширением рынка дата-центров. В отчёте отмечается, что аккумуляторные решения — одна из немногих безуглеродных технологий, которым пророчат процветание при новой администрации США, даже за пределами рынка ЦОД. В следующее десятилетие будут развёрнуты минимум 20 ГВт аккумуляторных энергохранилищ. Наиболее вероятным будет применение литий-железо-фосфатных (LFP или LiFePO4) решений с 2–4-часовым циклом. При этом операторы ЦОД, вероятно, найдут китайские решения более привлекательными как по качеству, так и по цене, но это достаточно рискованный выбор в политической плоскости.

Источник изображения: CATL Наиболее перспективными в Jefferies называют китайских поставщиков CATL и Sungrow. Китайские системы значительно дешевле и совершеннее с точки зрения плотности хранения энергии и эффективности в целом, а последние данные свидетельствуют о росте китайского экспорта. Аналитики полагают, что Китай сохранит преимущество на рынке США и останется весьма конкурентоспособным. Так, в отчёте подчёркивается, что даже налоговая льгота в 40–50 % для произведённых в США систем всё равно не способна сделать китайские альтернативы неконкурентоспособными. Некоторые штаты и коммунальные службы в США, возможно, избегают китайских BESS из-за угроз кибербезопасности. Jefferies называет решения Tesla и Fluence Energy приемлемыми альтернативами. Наилучшие позиции из американских поставщиков для ИИ ЦОД занимает Tesla с решениями Megapack и Megablock. Ожидаемо, что одним из немногих кампусов ЦОД, объявивших о партнёрстве с Tesla, стала xAI (Colossus 1 и Colossus 2), рассчитывающая на ёмкость Megapack в 655 МВт∙ч. В отчёте прогнозируется рост рынка энергохранилищ в 2026 году на уровне менее 10 % из-за вступления в силу ограничений, касающихся иностранных юридических лиц, «вызывающих озабоченность» (FEOC). Кроме того, ситуация не улучшают и тарифные войны, которые на некоторое время привели к увеличению пошлин на импорт в США китайских аккумуляторов более чем на 150 %. Прогнозируется, что спрос на ЦОД на окажет значительного влияния на рынок BESS в 2026 году, поскольку развитие ИИ-технологий всё ещё находится на начальной стадии, но в 2027 году Jefferies ожидает существенного роста.

12.11.2025 [15:52], Руслан Авдеев

ГК Key Point построит коммерческие дата-центры в Санкт-Петербурге и ДагестанеРоссийская ГК Key Point объявила о начале строительства нового коммерческого дата-центра в Санкт-Петербурге. Объект будет возведён на ул. Прокофьева, 10 — он станет крупнейшей колокейшн-площадкой в Санкт-Петербурге и Северо-Западном федеральном округе, сообщает компания. Проект на 20 МВт рассчитан на 1626 IT-стоек. Начало эксплуатации первой очереди совокупной мощностью 5 МВт и ёмкостью 330 стоек по 8 кВт планируется в I квартале 2027 года. Первая очередь проекта получит сертификаты надёжности Tier III. Вторую и третью очереди на 1296 стоек мощностью 15 МВт, введут в эксплуатацию в III квартале того же года и II квартале 2028 года соответственно. II и III очереди сертифицируют в соответствии с уровнем Tier IV. Площадка в Санкт-Петербурге станет первым ЦОД такого уровня на Северо-Западе. Ответственным за полный комплекс работ EPC-подрядчиком проекта является компания «Свободные Технологии Инжиниринг». В ГК Key Point отмечают, что сегодня потребность в современной цифровой инфраструктуре в Санкт-Петербурге растёт год от года, и новый ЦОД повышенной надёжности станет опорой для цифровой экономики всего Северо-Запада. Ранее Key Point объявила, что в IV квартале 2026 года заработает первая очередь Tier III ЦОД компании в Хасавюртовском районе Дагестана. Проект будет построен в два этапа, по 220 стоек на каждом. Общая подведённая мощность составит 5,5 МВт, IT-мощность — 3 МВт. Генеральным подрядчиком и генеральным проектировщиком объекта также выбрана компания «Свободные Технологии Инжиниринг». Партнёром проекта выступает компания «Электросвязь» — ведущий оператор связи в регионе. В сентябре 2024 года сообщалось, что Softline и Key Point развернут сеть модульных дата-центров в Сибири и на Дальнем Востоке. В феврале 2025 года появилась информация, что ВТБ выделит 3,2 млрд рублей на ЦОД Key Point в Свердловской области. В 2026 году должен заработать ЦОД в Ростовской области.

12.11.2025 [15:30], Руслан Авдеев

Kyocera показала технологию подводной оптической передачи данных UWOC: до 5,2 Гбит/с в пресной водеKyocera рассказала об успешных лабораторных испытаниях технологии подводной беспроводной оптической связи (UWOC). Утверждается, что она обеспечивает скорость передачи данных 5,2 Гбит/с на короткие дистанции в пресной воде. Это одна из наиболее передовых подводных безволоконных оптических систем на сегодня, сообщает компания. Новый вариант UWOC предназначен для передачи данных с большой пропускной способностью в режиме реального времени. Технология может применяться для исследования океана и обеспечения работы робототехники. Она обеспечит мгновенный доступ к видео, изображениям и данным подводных датчиков. Традиционная подводная связь обычно строится на акустических технологиях и ограничена всего несколькими мегабитами в секунду, этого для современных роботизированных миссий и исследований этого слишком мало. Собственный PHY-блок, разработанный Kyocera, преобразует цифровые данные в модулированный лазерный свет. Расширенная оптическая схема с полосой пропускания более 1 ГГц обеспечивает скорость передачи данных приблизительно в 2,5 раза выше, чем у существующих UWOC-систем. В будущем Kyocera намерена расширить возможности технологии, передавая данные на большие расстояния. В теории этом позволит превратить технологию в основу морской телекоммуникационной инфраструктуры.

Источник изображения: Kyocera Компания прогнозирует её применение в автономных подводных аппаратах-беспилотниках, морской энергетике, морской биологии и даже подводном строительстве, где незамедлительный доступ к большим массивам визуальных и аналитических данных может изменить базовые принципы морских подводных операций. Как сообщает Converge Digest, конкуренты вроде SONARDYNE, Teledyne и Hydromea тоже разработали гибридные оптико-акустические платформы, но именно Kyocera выделяется за счёт ключевых преимуществ: проприетарного дизайна PHY-модуля и рекордной полосы пропускания. Кроме того, компания рассчитывает стать ключевым игроком на рынке не только морской, но и наземной связи, развивая технологии фазированных антенных решёток и датчиков миллиметрового диапазона. В конце апреля сообщалось, что стартап CSignum из Эдинбурга, разработавший систему подземной и подводной коммуникации, привлёк £6 млн в раунде финансирования серии A. Компания предложила беспроводную систему связи, которая использует низкочастотные электромагнитные поля для передачи данных на поверхность через воду, лёд, почву, горные породы и бетон. Технология позволяет передавать данные с морского или речного дна на берег, с корпуса судна и двигательных установок на палубу и т.п., хотя скорость передачи в разы ниже, чем у технологий Kyocera.

12.11.2025 [15:17], Руслан Авдеев

Microsoft инвестирует $10 млрд в ИИ ЦОД в ПортугалииMicrosoft потратит $10 млрд на ИИ ЦОД на побережье Португалии. Это станет одной из крупнейших инвестиций компании в Европе в 2025 году, сообщает Bloomberg. Речь о проекте кампуса в Синише (Sines) в 150 км от Лиссабона. Строительством парка занимается Microsoft совместно с португальской Start Campus и британским стартапом Nscale. Информацию о проекте и сумме подтвердил президент Microsoft Брэд Смит (Brad Smith). Как отмечает Datacenter Dynamics, в начале года в кампусе введён в эксплуатацию первый из шести планируемых объектов — ЦОД SIN01. $10 млрд покроют расходы на развитие второй фазы проекта. Второй ЦОД SIN02 обеспечит 180 МВт и уже строится. Общая мощность кампуса должна составить 1,2 ГВт. Пока неизвестно, в скольких проектах ЦОД на площадке Microsoft и Nscale будут участвовать совместно. Партнёрство Microsoft, Nscale и Start Campus было анонсировано в октябре 2025 года. Nscale развернёт для Microsoft в Синише 12,6 тыс. ускорителей NVIDIA GB300. Столкнувшись с нехваткой мощностей, компания подписала соглашения с несколькими неооблаками на $60 млрд, в том числе с CoreWeave, Nebius, IREN и Lambda. Только за последний квартал на аренду потрачено $11,1 млрд. Мощности Nscale компания намерена арендовать в Великобритании, США и Норвегии. Всего Microsoft намерена арендовать у Nscale 116 тыс. ускорителей GB300. Хотя большинство ЦОД расположены в районе Лиссабона (присутствуют объекты AtlasEdge, Claranet, Edged, Tata Communications и Equinix), прибрежный город Синиш с населением порядка 15 тыс. человек становится ключевым инвестиционным хабом Португалии. Отсюда проложены и подводные кабели, ещё больше появится в будущем — Medusa, New CAM Ring, Nuvem и Olisipo. В мае китайская CALB Group начала строить в городе фабрику по производству аккумуляторов за €2 млрд ($2,3 млрд). Также Синиш, возможно, станет домом для «ИИ-гигафабрики», поддерживаемой Евросоюзом.

12.11.2025 [14:38], Сергей Карасёв

Квартальная выручка CoreWeave подскочила более чем в два раза, а объём законтрактованных мощностей вырос до 2,9 ГВтПровайдер облачных услуг для ИИ-задач CoreWeave отчитался о работе в III квартале 2025 года. Выручка компании за трёхмесячный период достигла $1,36 млрд: это на 134 % больше по сравнению с показателем годичной давности, когда было получено $583,94 млн. Отмечается, что CoreWeave стремительно наращивает продажи. Так, в I четверти 2025-го выручка подскочила на 420 % в годовом исчислении — до $971,63 млн. Во II квартале зафиксирован рост на 207 % с итоговым результатом в $1,2 млрд. Операционный доход за отчётный период составил $51,85 млн против $117,12 млн годом ранее. В III квартале 2025-го CoreWeave понесла чистые убытки в размере $110,12 млн, или $0,22 в пересчёте на одну ценную бумагу. Для сравнения: годом ранее компания потеряла $359,81 млн, или $1,82 на акцию. Скорректированный показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) составил $838,12 млн против $378,76 млн в III четверти 2024 года.

Источник изображения: CoreWeave CoreWeave заявляет о диверсификации своей клиентской базы. Финансовый директор компании Нитин Агравал (Nitin Agrawal) сообщил, что на сегодняшний день вклад крупнейшего заказчика в общую выручку не превышает 35 %. Это существенно меньше по сравнению со II кварталом 2025 года, когда показатель находился на уровне 50 %. А в 2024-м около 62 % от суммарной выручки CoreWeave обеспечила Microsoft. Вторым по величине заказчиком оказалась NVIDIA (15 %), которая к тому же обязалась выкупить у CoreWeave все нераспроданные ИИ-мощности. Ранее Microsoft скупала мощности в интересах OpenAI. Теперь OpenAI напрямую закупает мощности у CoreWeave, хотя Microsoft тоже от них отказываться не будет. Кроме того, среди новых крупных заказчиков CoreWeave есть IBM и Meta✴. По словам Агравала, более 60 % портфеля заказов компании приходится на «клиентов инвестиционного уровня». CoreWeave также продолжает расширять инфраструктуру дата-центров. В течение III квартала добавлены 120 МВт мощностей, благодаря чему общий показатель достиг 590 МВт. Компания завершила квартал с законтрактованными мощностями в 2,9 ГВт. На территории США в течение июля–сентября введены в эксплуатацию восемь дополнительных ЦОД. Однако один из крупных проектов по созданию дата-центров был отложен из-за отставания от графика неназванного стороннего застройщика. В результате капитальные затраты за отчётный период составили $1,9 млрд, а не $2,9–$3,4 млрд, как предполагалось ранее. |

|