Лента новостей

|

14.11.2025 [10:03], Руслан Авдеев

NVIDIA ужесточит контроль над выпуском ИИ-платформ, задвинув Foxconn и других партнёров на второй планКомпания NVIDIA готовится изменить текущую бизнес-модель в контексте ИИ-серверов. Она намерена получить под свой контроль производство ИИ-платформ целиком, а не отдельные элементы цепочек поставок, сообщает Wccftech. Если обычно экосистема поставок NVIDIA опирается на партнёров, выпускающих компоненты конечных продуктов — Foxconn, Quanta (QCT) и Wistron (Wiwynn) — со своими собственными разработками, то в будущем компания фактически возьмёт под контроль всё производство вплоть до уровня стоек. До сих пор NVIDIA поставляла в основном ключевые компоненты, такие как ИИ-ускорители и системные платы вроде Bianca Port UPB. Тем не менее, в ходе отчёта Wistron за III квартал 2025 года представитель JPMorgan заявил, что компания, похоже, переходит к «прямым поставкам» полноценных систем. Если раньше NVIDIA отвечала за ключевые элементы стоек — ИИ-ускорители и платы, — то за остальную архитектуру отвечали подрядчики вроде Foxconn, Quanta и других компаний. Теперь, как полагают в JPMorgan, NVIDIA станет напрямую поставлять системы Level-10 (почти полный блок серверной стойки). Компания унифицирует конструкцию систем, заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна и запретит использование проприетарных архитектур, созданных самими подрядчиками. Фактически — это развитие философии MGX-архитектуры, предполагающей единые стандарты от серверного узла до полнофункциональной ИИ-фабрики. При этом время развёртывания таких комплексных систем сократится с 9–12 мес. до 90 дней, т.е. 3 мес. Поскольку 80 % наполнения систем будет предварительно определяться NVIDIA, новые платформы вроде Rubin/Rubin CPX можно будет внедрять ускоренными темпами. NVIDIA выиграет от быстрого вывода систем на рынок, роста маржинальности и расширения так называемого «общего адресуемого рынка» (TAM). В Wistron утверждают, что новая модель выгодна и заказчикам, поскольку ключевые работы по созданию ИИ-оборудования всё равно выполняет компания-подрядчик. В целом NVIDIA стремится перейти от роли обычного поставщика ИИ-чипов к модели, при которой IT-гигант контролирует развёртывание инфраструктуры целиком. Это как ускорит выпуск ИИ-систем, так и укрепит позиции компании. Впрочем, пока информация об изменениях поступает из сторонних источников — в самой NVIDIA её не подтверждали. При этом для гиперскейлеров, которые самостоятельно занимаются разработкой ИИ-платформ, пока, по-видимому, ничего не поменяется.

14.11.2025 [09:38], Сергей Карасёв

«За пределы экзафлопсного уровня»: Eviden представила суперкомпьютерную платформу BullSequana XH3500Компания Eviden, входящая в Atos Group, анонсировала конвергентную суперкомпьютерную платформу BullSequana XH3500 для ресурсоёмких нагрузок ИИ и HPC. Новинка сочетает передовые аппаратные решения с комплексной экосистемой ПО, обеспечивая возможность масштабирования «за пределы экзафлопсного уровня». BullSequana XH3500 использует открытую модульную конструкцию. Такой подход позволяет свободно комбинировать блоки CPU, GPU и сетевые компоненты от различных производителей, адаптируя конфигурации под определённые потребности. При этом устраняется зависимость от какого-либо конкретного поставщика оборудования, что обеспечивает полную технологическую свободу. По заявлениям Eviden, платформа BullSequana XH3500 по сравнению с системой предыдущего поколения позволяет добиться повышения электрической мощности более чем на 80 % в расчёте на 1 м2 и увеличения эффективности охлаждения на 30 % в расчёт на 1 кВт. Это даёт возможность удовлетворить растущие потребности в вычислительных ресурсах без необходимости расширения площадей в дата-центрах. Габариты стойки BullSequana XH3500 без модуля ультраконденсатора составляют 2270 × 900 × 1457 мм. Мощность AC достигает 284 кВт (с одной помпой). Задействовано на 100 % безвентиляторное прямое жидкостное охлаждение (DLC) пятого поколения с возможностью использования горячей воды с температурой до 40 °C. Подсистемы питания и охлаждения выполнены по схеме с резервированием N+1. Доступны 38 универсальных слотов 1U.

Источник изображения: Eviden Для платформы BullSequana XH3500 разработаны узлы BullSequana XH3515B и BullSequana AI1242. Первый соответствует типоразмеру 1U: это одноузловое изделие оборудовано двумя чипами NVIDIA Grace CPU и четырьмя ускорителями NVIDIA Blackwell B200. Возможна установка до девяти NVMe SSD в форм-факторе E1.S. Говорится о поддержке четырёх сетевых устройств Eviden BXI V3 или InfiniBand NDR/XDR. В свою очередь, сервер BullSequana AI1242 имеет исполнение 2U. Данное решение несёт на борту два процессора AMD EPYC Turin и GPU-ускоритель AMD Instinct MI355X. Реализована поддержка восьми устройств Eviden BXI V3 или InfiniBand NDR/XDR, а также четырёх накопителей E1.S NVMe SSD.

14.11.2025 [09:38], Сергей Карасёв

ИТ-холдинг Т1 представил первый ПАК для работы с ИИ-платформой «Сайбокс»Многопрофильный ИТ-холдинг Т1 анонсировал первый отечественный программно-аппаратный комплекс (ПАК), предназначенный для работы с ИИ-платформой «Сайбокс». Решение под названием «ИИ-Фабрика Сайбокс» представляет собой готовую серверную стойку, оснащённую всеми необходимыми компонентами для решения различных ресурсоёмких задач — от подготовки данных до обучения моделей и запуска ИИ-агентов. В основу новинки положен сервер МЛТ-С пятого поколения, созданный российской IT-компании «Мультиллект» (совместное предприятие компании «Азимут» госкорпорации «Ростех» и ИТ-холдинга Т1). Это двухпроцессорная система в форм-факторе 2U, обладающая поддержкой DDR5, PCIe 5.0 и CXL. Сервер совместим с основными системами виртуализации и широким спектром ПО. Он включён в Единый реестр российской радиоэлектронной продукции (Реестр РЭП), утверждённый Минпромторгом России. Машина сертифицирована для обработки и хранения данных, управления ИИ-приложениями и поддержки критической инфраструктуры.

Источник изображения: «Ростех» В состав ПАК входит отечественная MLOps-платформа «Сайбокс» для полного цикла работы с моделями машинного обучения. Она позволяет внедрять в текущие бизнес-процессы компании различные ИИ-сервисы (документооборот, видеоаналитика, промышленная диагностика, планирование ремонтов). Через встроенный маркетплейс можно выбрать готовое решение либо быстро создать ИИ-агента с помощью инструментария no-code/low-code. Упомянуты такие возможности, как запуск, дообучение и объединение больших языковых моделей, реализация RAG-сценариев, интеграция с Hugging Face без внешних зависимостей. «Наше решение — это не набор разрозненных компонентов, а протестированный и готовый к работе комплекс, который позволяет бизнесу получать современный функционал искусственного интеллекта "из коробки". Серверная часть уже хорошо зарекомендовала себя в пилотных проектах в компаниях различных отраслей. Формат полностью российского решения повышает устойчивость бизнеса к внешним и внутренним рискам и ускоряет внедрение инновационных сервисов», — говорит глава Т1. Отмечается, что «ИИ-Фабрика Сайбокс» может применяться в том числе на объектах критической информационной инфраструктуры. Среди потенциальных заказчиков названы предприятия энергетического сектора, транспортной отрасли и пр.

14.11.2025 [09:36], Сергей Карасёв

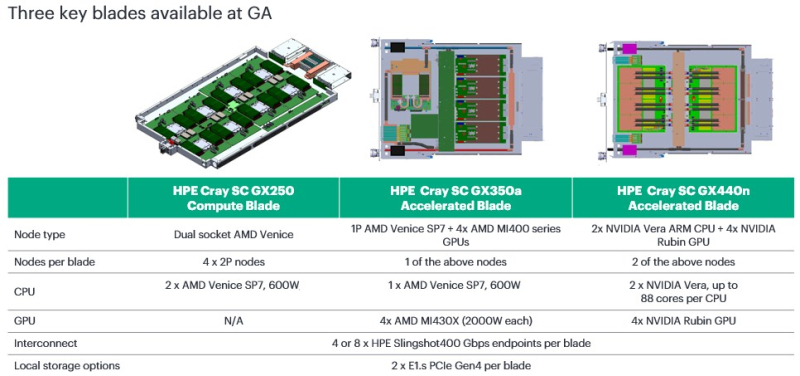

HPE представила CPU- и GPU-узлы суперкомпьютерной платформы Cray Supercomputing GX5000Компания HPE анонсировала новые решения для НРС-задач, являющиеся частью суперкомпьютерной платформы Cray Supercomputing GX5000. В частности, дебютировали узлы GX250 Compute Blade, GX350a Accelerated Blade и GX440n Accelerated Blade, а также высокопроизводительная СХД Storage Systems K3000. Устройство HPE Cray Supercomputing GX250 Compute Blade представляет собой CPU-сервер, оснащённый восемью процессорами AMD EPYC Venice (появятся во II половине 2026 года). В одной стойке могут быть размещены до 40 таких серверов, что обеспечивает самую высокую в отрасли плотность компоновки x86-ядер следующего поколения, говорит компания. В паре с CPU-узлами могут функционировать новые GPU-модули. Так, изделие HPE Cray Supercomputing GX350a Accelerated Blade несёт на борту один чип AMD EPYC Venice и четыре ускорителя AMD Instinct MI430X. В стойку могут устанавливаться до 28 таких серверов, что даёт в сумме 112 ускорителей MI430X. В свою очередь, HPE Cray Supercomputing GX440n Accelerated Blade содержит четыре NVIDIA Vera CPU и восемь NVIDIA Rubin GPU. Допускается монтаж до 24 подобных серверов на стойку, что обеспечивает 192 ускорителя Rubin. Все новинки оборудованы жидкостным охлаждением. СХД HPE Cray Supercomputing Storage Systems K3000 выполнена на сервере HPE ProLiant Compute DL360 Gen12. Могут устанавливаться 8, 12, 16 или 20 накопителей NVMe вместимостью 3,84, 7,68 или 15,36 Тбайт каждый. Объём памяти DRAM — 512 Гбайт, 1 или 2 Тбайт. Применяется платформа DAOS, разработанная для требовательных рабочих нагрузок, таких как анализ данных и машинное обучение. Поддерживаются технологии HPE Slingshot 200, HPE Slingshot 400, InfiniBand NDR и 400GbE. Кроме того, HPE сообщила о том, что для платформы HPE Cray Supercomputing GX5000 доступен интерконнект HPE Slingshot 400. Соответствующие коммутаторы с прямым жидкостным охлаждением наделены 64 портами на 400 Гбит/с. Возможны конфигурации с 8, 16 и 32 коммутаторами, что в сумме позволяет использовать до 512, 1024 и 2048 портов соответственно. О выборе платформы HPE Cray Supercomputing GX5000 для НРС-комплексов нового поколения уже объявили Центр высокопроизводительных вычислений Штутгартского университета (HLRS) и Центр суперкомпьютеров имени Лейбница (LRZ) Баварской академии естественных и гуманитарных наук (BADW). Кроме того, новая платформа является основой суперкомпьютера Discovery Министерства энергетики США (DOE).

14.11.2025 [08:56], Руслан Авдеев

Microsoft запустила второй «самый передовой» ИИ ЦОД в мире по проекту Fairwater в рамках создания ИИ-суперфабрикиMicrosoft запустила в Атланте (Джорджия) второй ИИ ЦОД по проекту Fairwater, подключенный к первому ИИ ЦОД такого типа в Висконсине для создания вычислительного суперкластера. Связь ЦОД осуществляется с помощью выделенной оптоволоконной сети AI Wide Area Network (AI WAN), специально предназначенной для выполнения ИИ-задач. Размеры и мощность нового ЦОД пока не раскрываются, но дата-центры этой серии станут крупнейшими объектами за всю историю Microsoft, а, возможно, и в мире. В дата-центре используется замкнутая система жидкостного охлаждения, которую обслуживает одна из крупнейших в мире система чиллеров. Объект поддерживает стойки мощностью порядка 140 кВт (1360 кВт на ряд). В целом он использует сотни тысяч новейших ИИ-ускорителей NVIDIA GB200/GB300 NVL72, объединённых двухуровневой 800GbE-сетью с коммутаторами под управлением SONiC. Дата-центр в Атланте имеет два этажа, чтобы сократить расстояние между стойками во всех трёх измерениях. Для AI WAN компания совместно с OpenAI, NVIDIA и другими партнёрами создала и внедрила протокол Multi-Path Reliable Connected (MRC) для оптимальной связи между несколькими дата-центрами класса Fairwater во время обучения сверхкрупных моделей, которые «не помещаются» в один ЦОД. Общая протяжённость каналов AI WAN составляет более 193 тыс. км. В Microsoft отметили, что благодаря надёжной электросети Атланты удалось отказаться от проектов локальной генерации электроэнергии, специальных ИБП и двух линий питания, что сократило время запуска ЦОД и стоимость его эксплуатации. По словам компании, им удалось добиться доступности 99,99 % по цене 99,9 %. Дополнительно разработаны уникальные программные и аппаратные решения для управления энергопотреблением, сглаживающие колебания нагрузок на сеть, вызванные работой ИИ, в том числе за счёт введения вспомогательных заданий во время простоя, самоограничения мощности GPU и использования накопителей энергии на площадке. Microsoft вводит в эксплуатацию всё больше дата-центров проекта Fairwater и намерена объединить их в целую сеть, превратив дата-центры в распределённый виртуальный суперкомпьютер, способный решать проблемы способами, недоступные отдельны объектам. Как считают в компании, если традиционный дата-центр предназначен для запуска миллионов приложений для многочисленных клиентов, то «ИИ-суперфабрика» выполняет одну сложную задачу в миллионах ускорителей. У Microsoft стремительно растут капитальные затраты на ЦОД и ускорители. При этом топ-менеджеры Microsoft признают, что «на самом деле никто не хочет иметь дата-центр у себя на заднем дворе». Жители большинства регионов опасаются роста стоимость коммунальных услуг, ущерба экологии и др.

14.11.2025 [01:55], Владимир Мироненко

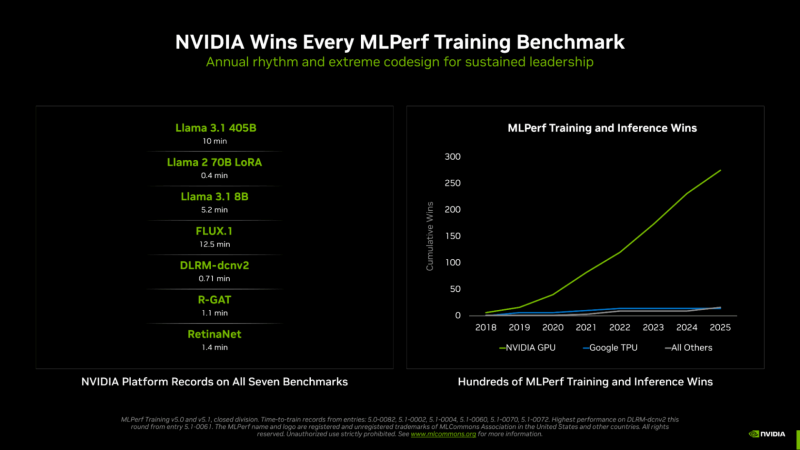

NVIDIA вновь впереди всех в новом раунде MLPerf Training v5.1Консорциум MLCommons опубликовал результаты тестирования различных аппаратных решений в бенчмарке MLPerf Training v5.1. На этот раз был установлен новый рекорд по разнообразию представленных систем. Участники этого раунда тестирования представили 65 уникальных систем, оснащённых 12 различными аппаратными ускорителями и различными программными платформами. Почти половина заявок была для многоузловых систем, что на 86 % больше, чем в раунде MLPerf Training 4.1 год назад, причём они так же отличались разнообразием сетевых архитектур. Раунд MLPerf Training v5.1 включает в себя результаты 20 компаний, подавших заявки: AMD, ASUS, Cisco, Dell, Giga Computing, HPE, Krai, Lambda, Lenovo, MangoBoost, MiTAC, Nebius, NVIDIA, Oracle, Quanta Cloud Technology (QCT), Supermicro, Supermicro + MangoBoost, Университет Флориды, Verda (DataCrunch), Wiwynn. Также сообщается, что структура заявок свидетельствует о растущем внимании к тестам, ориентированным на задачи генеративного ИИ: количество заявок на тест Llama 2 70B LoRa увеличилось на 24 %, а на новый тест Llama 3.1 8B — на 15 % по сравнению с тестом, который он заменил (BERT). NVIDIA объявила, что её чипы на архитектуре NVIDIA Blackwell заняли первые позиции во всех семи тестах MLPerf Training v5.1, обеспечив максимально быстрое обучение в работе с большими языковыми моделями (LLM), генерацией изображений, рекомендательными системами, компьютерным зрением и графическими нейронными сетями. NVIDIA подчеркнула, что была единственной платформой, которая предоставила результаты по всем тестам — это, по словам компании, «подчёркивает широкие возможности программирования ускорителей NVIDIA, а также зрелость и универсальность программного стека CUDA». Компания сообщила, что в этом раунде MLPerf Training дебютировала стоечная система GB300 NVL72, работающая на базе ускорителя NVIDIA Blackwell Ultra, показав рекордные результаты и доказав, что является наилучшим выбором для интенсивных рабочих ИИ-нагрузок. При предварительном обучении Llama 3.1 40B ускорители GB300 обеспечивают более чем вчетверо большую производительность по сравнению с H100 и почти вдвое — по сравнению с GB200. Аналогичным образом, при точной настройке Llama 2 70B восемь ускорителей GB300 обеспечили в пять раз большую производительность по сравнению с H100. NVIDIA отметила, что этого удалось достичь благодаря архитектурным усовершенствованиям Blackwell Ultra, включая новые тензорные ядра, которые обеспечивают ИИ-производительность в формате NVFP4 в размере 15 Пфлопс, вдвое большую производительность в работе механизма внимания (attention-layer compute) и 279 Гбайт HBM3e, а также новые методы обучения, которые позволили повысить вычислительную производительность архитектуры NVFP4. В MLPerf также дебютировала 800G-платформа Quantum-X800 InfiniBand, объединяющая несколько систем GB300 NVL72, которая удвоила пропускную способность сети по сравнению с предыдущим поколением. Но по словам компании, «ключом к выдающимся результатам в этом раунде было выполнение вычислений с использованием NVFP4 — впервые в истории MLPerf Training». NVIDIA обеспечила поддержку FP4 для обучения LLM на каждом уровне, что позволило удвоить скорость вычислений по сравнению с FP8. Ускоритель NVIDIA Blackwell может выполнять вычисления в формате FP4 (в т.ч. NVFP4 и др.) с удвоенной скоростью по сравнению с FP8, а Blackwell Ultra — с утроенной. На сегодняшний день NVIDIA является единственной платформой, которая представила результаты MLPerf Training с вычислениями, выполненными с использованием FP4 при соблюдении строгих требований к точности в тесте. Эти результаты были получены с использованием 5120 ускорителей Blackwell GB200, которым потребовалось всего 10 мин. на бенчмарк Llama 3.1 405B, что является новым рекордом. Это в 2,7 раза быстрее, чем лучший результат с использованием архитектуры Blackwell, показанный в предыдущем раунде бенчмарка. NVIDIA также установила рекорды производительности в двух новых тестах: Llama 3.1 8B и FLUX.1. Llama 3.1 8B — компактная, но обладающая высокой производительностью LLM — заменила модель BERT-large, добавив в линейку базовых моделей современную LLM малого размера. NVIDIA представила результаты с использованием до 512 ускорителей Blackwell Ultra, потратив 5,2 мин. на прохождение теста. FLUX.1 — современная модель генерации изображений — заменила Stable Diffusion v2, и только платформа NVIDIA представила результаты этого теста. NVIDIA представила результаты с использованием 1152 ускорителей Blackwell, установив рекорд — 12,5 мин. обучения.

13.11.2025 [21:25], Владимир Мироненко

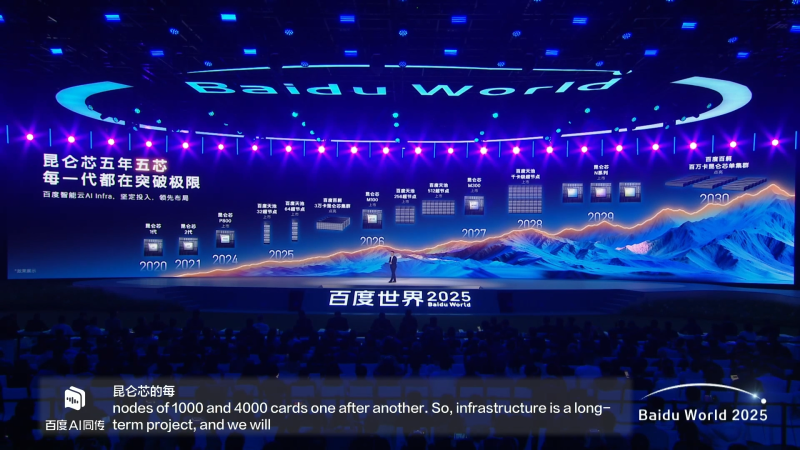

Baidu анонсировала суверенные ИИ-ускорители Kunlun M100 и M300 для инференса и обученияКомпания Baidu представила на технологической конференции Baidu World 2025 в Пекине два новых ИИ-ускорителя, разработанных её подразделением Kunlunxin Technology, — Kunlun M100 и Kunlun M300, пишет ресурс TrendForce. Также было объявлено о предстоящем выходе суперузлов Tianchi256 и Tianchi512. Компания сообщила о планах выпускать новые продукты ежегодно в течение следующих пяти лет, чтобы поддержать развитие ИИ-технологий в Китае и сохранить их независимость от зарубежных поставщиков. Кроме того, компания намерена активно развивать не только «железо», но и постоянно оптимизировать ПО для него. Baidu сообщила, что ИИ-ускоритель Kunlun M100 оптимизирован для крупномасштабных сценариев инференса с упором на «максимальную экономичность», используя преимущества архитектуры собственной разработки, что значительно повышает производительность инференса MoE-моделей. Он выйдет в начале 2026 года. ИИ-ускоритель Kunlun M300 предназначен не только для инференса, но и обучения сверхбольших мультимодальных моделей с триллионами параметров с упором на «максимальную производительность». Старт поставок Kunlun M300 намечен на начало 2027 года. Также сообщается, что выпуск чипов Kunlun серии N запланирован на 2029 год. Что касается суперускорителей для обработки массивных ИИ-нагрузок, то выход Baidu Tianchi 256 и 512 запланирован на следующий год. Tianchi256, включающий до 256 чипов Kunlun P800, как ожидается, выйдет в I половине 2026 года, а Tianchi512 — во II полугодии. Сообщается, что один Baidu Tianchi512 может завершить обучение модели с триллионом параметров. В дальнейшем компания намерена выпустить узлы Tianchi сначала с 1 тыс. ускорителей, а затем и с 4 тыс. В целом, компания планирует к 2030 году увеличить максимальный размер кластера с 30 тыс. ускорителей до 1 млн. Облачное подразделение Baidu Intelligent Cloud Group, используя чипы Kunlun и вычислительную платформу ИИ Baige, предоставляет предприятиям высокопроизводительные масштабируемые вычислительные мощности для обработки ИИ-нагрузок и шесть лет подряд занимает первое место на китайском рынке облачных ИИ-решений.

13.11.2025 [18:17], Руслан Авдеев

Google инвестирует €5,5 млрд в дата-центры в ГерманииGoogle намерена вложить €5,5 млрд ($6,4 млрд) в вычислительные ресурсы и расширение работы на территории Германии. Средства будут потрачены в следующие четыре года, сообщает Bloomberg. IT-гигант сделал соответствующее заявление во вторник в Берлине в ходе встречи представителей компании с местными федеральными министрами. В числе целей для инвестиций — два дата-центра в районе Франкфурта, их мощность не уточняется. Страны Европы стремятся в приоритетном порядке развивать отрасль ЦОД, поскольку опасаются дальнейшего технологического отставания в сфере ИИ от США и Китая. Еврокомиссия уже призвала создавать «гигафабрики» — дата-центры, способные обучать и обслуживать сложнейшие ИИ-модели. На прошлой неделе NVIDIA и Deutsche Telekom объявили о намерении строительства ИИ ЦОД стоимостью €1 млрд в Мюнхене, его открытие запланировано на начало 2026 года. Google подчеркнула, что будущие расходы в Германии — часть «постоянной верности Европе». Годами её приходилось отвечать на вызовы, создаваемые регуляторами региона, связанными с вопросами конфиденциальности, антимонопольного законодательства и авторских прав. Кроме того, компания боролась на этом рынке с Microsoft, безуспешно пытаясь привлечь к борьбе ассоциацию облачных провайдеров. В итоге она создала собственную организацию Open Cloud Coalition (OCC), которую Microsoft, в свою очередь, незамедлительно раскритиковала. В сентябре Google объявила о готовности потратить £5 млрд ($6,8 млрд) в Великобритании в следующие два года. Планы в отношении Германии предполагают расширение трёх офисов Google. Alphabet — материнская структура, стоящая за Google, рассчитывает, что в 2025 году капитальные затраты компании в мировом масштабе составят $93 млрд.

13.11.2025 [17:39], Руслан Авдеев

Меж болот и прерий: Meta✴ начала строительство юбилейного 30-го дата-центра за $1 млрдMeta✴ анонсировала строительство очередного ИИ ЦОД. Объект возведут в городе Бивер Дам (Beaver Dam, Висконсин). Это уже 30-й дата-центр компании по всему миру. Место выбрано благодаря лёгкому доступу к надёжной инфраструктуре и квалифицированной рабочей силе, сообщает Meta✴. Инвестиции в ЦОД в Бивер Дам площадью около 65 тыс. м2 превысят $1 млрд, будет поддерживаться работа более 100 штатных сотрудников. Также Meta✴ вложит около $200 млн в энергетическую инфраструктуру для покрытия расходов, связанных с дата-центром, включая обновление энергосетей, подстанций и ЛЭП. Дополнительно Meta✴ выделит $15 млн для принадлежащего Alliant Energy фонда Hometown Care Energy Fund, который поможет покрыть расходы на электроэнергию нуждающимся семьям. Питание дата-центра будет осуществляться за счёт 100 % «чистой» и возобновляемой энергии, сам объект получит сертификат LEED Gold Certification. Осенью 2026 года в рамках корпоративной программы Data Center Community Action Grants начнётся приём заявок на финансирование школ и местных организаций для внедрения технологий на пользу «общественного блага». Средства выделят на проекты, использующие технологии для развития сообщества, его устойчивости и на образование в сфере STEAM (наука, технология, инженерия, искусство и математика). Также местные малые бизнесы получат доступ к бесплатным программам обучения цифровым навыкам, помогающим использовать ИИ-инструменты, включая Meta✴ AI.

Источник изображений: Meta✴ Отдельное внимание уделено управлению водными и прочими ресурсами. Кампус Beaver Dam будет использовать технологии драйкулинга — это означает, что вода для охлаждения практически не потребуется. Также компания обещает восстановить 100 % воды в местных водных бассейнах, которые потребит ЦОД. Среди прочих мер называются сбор дождевой воды для дальнейшего использования, интеграция водосберегающих технологий на объектах ЦОД, а также благоустройство с использованием местной растительности для снижения потребностей в орошении. Наконец, в партнёрстве с Ducks Unlimited и прочими организациями будут восстановлены 230 га болотных угодий и прерий, окружающих дата-центр, из них 70 га будут переданы Ducks Unlimited для развития экосистем. Это позволит превратить «деградировавшие» болотные угодья в полные жизни, экологически богатые места обитания с тысячами птиц, животных и растений. Как сообщает Bloomberg, глава компании Марк Цукерберг (Mark Zuckerberg) неоднократно поддерживал агрессивные инвестиции в ИИ-инфраструктуру и постоянно говорит инвесторам о том, что лучше вложить в ИИ избыточные средства, чем недостаточные. До 2028 года компания инвестирует $600 млрд в США, значительная часть этих средств будет потрачена на чипы, дата-центры и оборудование. Meta✴ строит гигаваттные ЦОД в некоторых других штатах, включая Огайо, Техас и Луизиану.

13.11.2025 [16:32], Сергей Карасёв

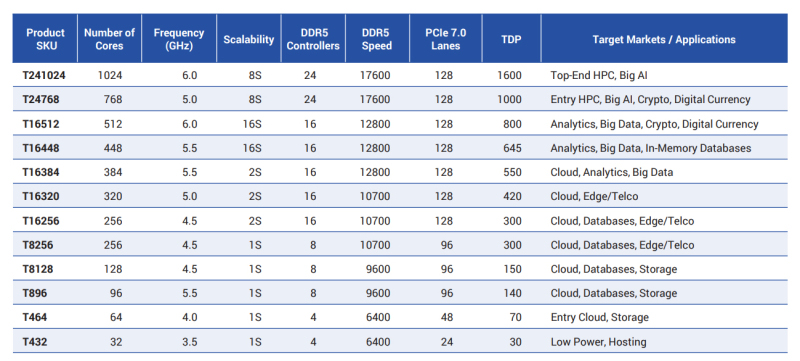

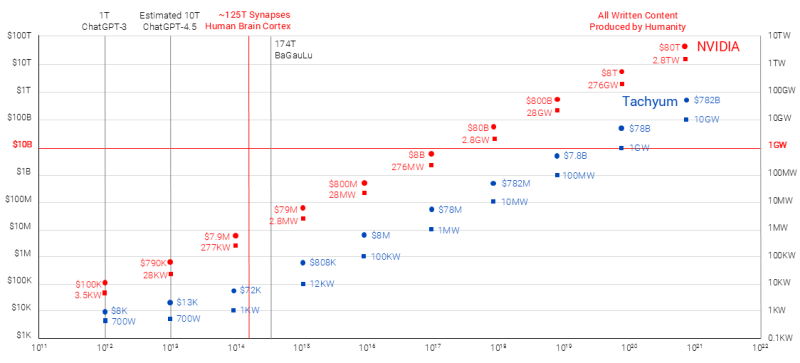

1024 ядра, 6 ГГц и 48 Тбайт DDR5-17600: Tachyum обновила характеристики несуществующего процессора ProdigyСловацкая компания Tachyum в очередной раз поделилась информацией о процессорах Prodigy с уникальной архитектурой, которые объединят возможности CPU, GPU и TPU. Эти изделия, как утверждается, позволят работать с ИИ-моделями, которые по количеству параметров будут на много порядков превосходить современные решения, но за несколько лет компания так и не представила ни одного работающего чипа. Tachyum работает над Prodigy с 2019 года. При этом фактический выпуск процессоров многократно переносился: последовательно назывались 2021, 2022, 2023, 2024 и 2025 годы, но пока эти чипы существуют только на бумаге. Между тем компания заявляет о внесении улучшений в архитектуру Prodigy в соответствии с постоянно меняющимися требованиями в отношении аппаратных платформ для ИИ и НРС.

Источник изображений: Tachyum Изначально предполагалось, что в состав Prodigy войдут до 192 ядер с тактовой частотой до 5 ГГц и выше. Говорилось о поддержке 16 каналов памяти DDR5-7200 с возможностью использования до 32 Тбайт ОЗУ в расчёте на процессорный разъём, а также 96 линий PCIe 5.0. Выпускать изделия компания намеревалась по 5-нм технологии. Теперь Tachyum заявляет, что Prodigy будут производиться по 2-нм технологии. Каждый чиплет в составе процессоров объединит до 256 высокопроизводительных кастомизированных 64-бит ядер с частотой до 6 ГГц, что в сумме даст до 1024 ядер в конфигурации с четырьмя чиплетами. Упомянуты 24 контроллера памяти с поддержкой DDR5-17600 и 128 линий PCIe 7.0. Максимальный объём памяти достигает 48 Тбайт в расчёте на сокет. Показатель TDP — до 1600 Вт. Возможно формирование 8S-систем. Такими характеристиками будут обладать флагманские изделия серии Prodigy Ultimate. Кроме того, готовятся чипы Prodigy Premium, имеющие до 512 ядер и до 16 каналов памяти DDR5-12800, а также «обычные» чипы Prodigy, содержащие до 128 ядер и до 8 каналов DDR5-9600. Первые могут применяться в 16S-системах, вторые — в односокетных. Кроме того, заявлена возможность запуска немодифицированных x86-приложений, а также Arm и RISC-V ПО. В целом, утверждает Tachyum, решения Prodigy Ultimate обеспечат до 21,3 раза более высокую ИИ-производительность на уровне стойки по сравнению с NVIDIA Rubin Ultra NVL576. В свою очередь, Prodigy Premium якобы превзойдут по ИИ-быстродействию систему NVIDIA Vera Rubin NVL144 в 25,8 раза. Разработчик также заявляет, что Prodigy станет первым чипом с производительностью более 1000 Пфлопс на задачах инференса против 50 Пфлопс у NVIDIA Rubin на аналогичных операциях. Впрочем, в спецификациях Prodigy пока говорится от 400 Тфлопс в FP64-вычислениях и о 400 Пфлопс в ИИ-вычислениях неназванной точности. |

|