Материалы по тегу: ускоритель

|

24.02.2026 [23:00], Владимир Мироненко

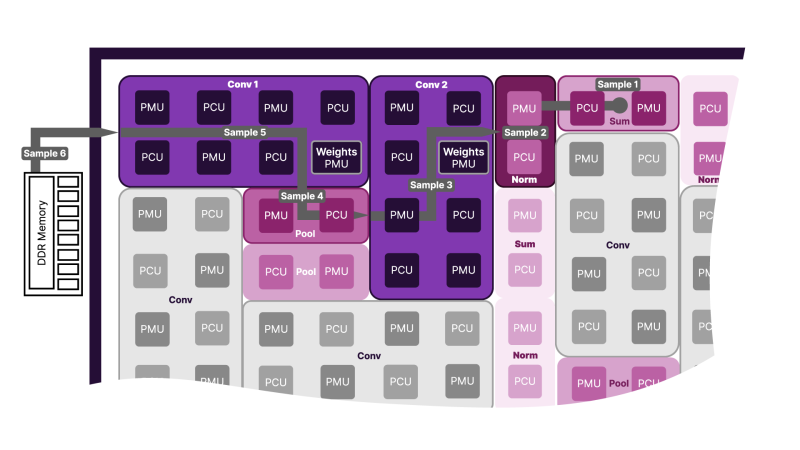

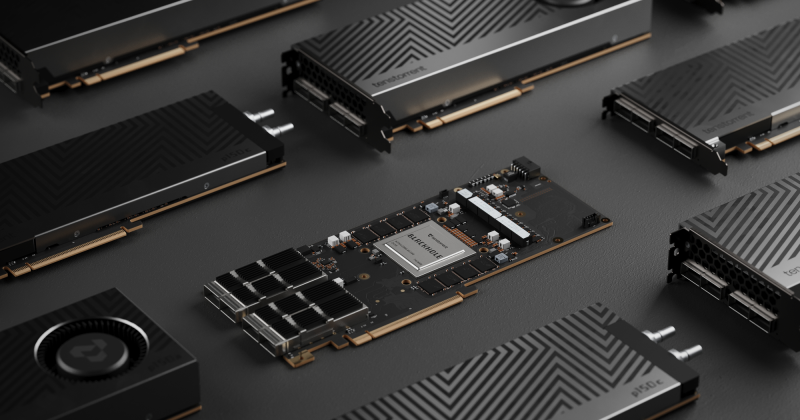

SambaNova представила ИИ-ускоритель SN50 и объявила о расширении партнёрства с IntelSambaNova представила ИИ-ускорители пятого поколения SN50 на основе фирменных RDU (Reconfigurable Dataflow Unit), которые, по словам компании, «обеспечивает непревзойденное сочетание сверхнизкой задержки, высокой пропускной способности и энергоэффективной производительности для рабочих нагрузок ИИ-инференса, коренным образом меняя экономику генерации токенов». Кроме того, объявлено об инвестициях и сотрудничестве с Intel, которая передумала покупать SambaNova целиком. Как отметил The Register, новый чип представляет собой значительное улучшение по сравнению с SN40L 2023 года. По данным компании, SN50 обеспечивает в 2,5 раза более высокую производительность при 16-бит вычислениях (1,6 Пфлопс) и в 5 раз более высокую производительность в режиме FP8 (3,2 Пфлопс). В основе SN50 лежит архитектура потоковой обработки данных (SambaNova DataFlow). Как и в предшественнике, в SN50 используется трёхуровневая иерархия памяти, которая сочетает в себе DDR5, HBM и SRAM, что позволяет платформам на основе новинки поддерживать ИИ-модели с 10 трлн параметров и длиной контекста до 10 млн токенов. Каждый RDU оснащен 432 Мбайт SRAM, 64 Гбайт HBM2E с пропускной способностью 1,8 Тбайт/с и от 256 Гбайт до 2 Тбайт памяти DDR5. Доступность HBM2E и конфигурируемый объём DDR5 позволят повысить привлекательность и доступность SN50 на фоне дефицита памяти. Каждый ускоритель получил интерконнект со скоростью 2,2 Тбайт/с (в каждую сторону) для связи с другими чипами через коммутируемую фабрику. Как утверждает SambaNova, по сравнению с ускорителем NVIDIA B200, SN50 обеспечивает в 5 раз большую максимальную скорость генерации токенов на пользователя и более чем в 3 раза большую пропускную способность для агентного инференса, что было продемонстрировано на примере ряда моделей, таких как Meta✴ Llama 3.3 70B. Архитектура позволяет эффективно разгружать KV-кеш и переключаться между моделям в HBM и SRAM в режиме «горячей замены» за миллисекунды, что крайне важно для агентных рабочих нагрузок, часто переключающихся между несколькими ИИ-моделями. Также в SN50 входные токены могут кешироваться в памяти, сокращая время предварительной обработки и время ожидания первого токена (TTFT) для запросов. Такое сочетание производительности, эффективности и масштабируемости обеспечивает преимущество в совокупной стоимости владения (TCO), по словам компании, не имеющее аналогов на рынке, для поставщиков сервисов инференса, использующих такие модели, как OpenAI GPT-OSS, с восьмикратной экономией по сравнению с NVIDIA B200. SN50 ориентирован и на такие приложения, как голосовые помощники на основе ИИ, требующие сверхнизкой задержки для работы в режиме реального времени. По заявлению компании, он сможет обеспечить работу тысяч одновременных сессий. Также была представлена 20-кВт система SambaRack SN50, которая объединяет 16 чипов SN50. SambaRack могут масштабироваться до кластера из 256 ускорителей с пропускной способностью интерконнекта в несколько Тбайт/с, что сокращает время обработки запросов и поддерживает большие размеры пакетов. В результате можно развёртывать модели с более высокой пропускной способностью и быстродействием. Поставки SN50 клиентам начнутся во II половине 2026 года. Раннее SambaNova сообщила о привлечении более $350 млн в рамках переподписанного раунда финансирования серии E, возглавляемого частной инвестиционной компанией Vista Equity Partners при партнёрстве с Cambium Capital. В нём также приняло «активное участие» инвестиционное подразделение Intel — Intel Capital, сообщил SiliconANGLE. Также SambaNova заявила о сотрудничестве с Intel в разработке новых высокопроизводительных и экономически эффективных систем для выполнения ИИ-задач. Цель — предоставить предприятиям альтернативу GPU, которые сегодня используются в большинстве рабочих нагрузок. Intel инвестирует в стартап, чтобы ускорить развёртывание нового «облачного решения для ИИ» на базе существующей платформы SambaNova Cloud. Обновлённая платформа, оптимизированная для многомодальных LLM, получит процессоры Xeon, а также GPU, сетевые и иные решения Intel, в том числе в области СХД. Идёт ли речь о создании специализированных моделей Xeon, как это было в случае NVIDIA, не уточняется. В дальнейшем Intel и SambaNova планируют совместно продвигать и продавать новую платформу, используя существующие связи Intel с предприятиями и партнёрские каналы. Партнёрство несёт выгоду обеим компаниям. SambaNova сможет воспользоваться глобальным охватом и производственной базой Intel для масштабирования своих ИИ-ускорителей, а Intel получит шанс наконец-то заявить о себе на ИИ-рынке. До сих пор Intel не могла конкурировать с NVIDIA и другими производителями чипов, такими как AMD, в ИИ-сфере. Чипы SN50 от SambaNova в сочетании с процессорами Intel Xeon потенциально могут изменить эту ситуацию. Стоит отметить, что у Intel, которая сама чувствует себя не лучшим образом, есть довольно крупная сделка с NVIDIA. Компания также предлагает собственные GPU для инференса, пусть и значительно более простые в сравнении с SN50, и даже странные гибриды из ускорителей Habana Gaudi 3 и NVIDIA B200. Наконец, имеется и сделка с AWS по выпуску кастомных Xeon 6 и неких ИИ-ускорителей. Что касается старых «коллег» SambaNova в деле борьбы с NVIDIA, то Groq в итоге была поглощена последней, а Cerebras, наконец, подписала заметную сделку с действительно крупным игроком на рынке ИИ — OpenAI.

23.02.2026 [22:57], Владимир Мироненко

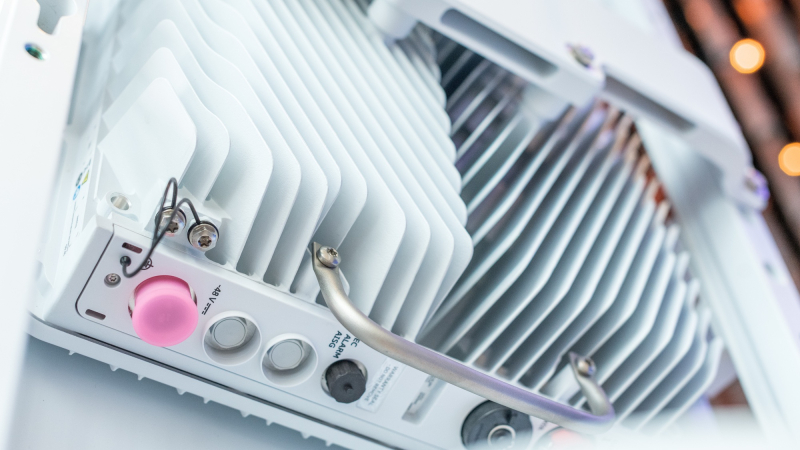

Чипы AMD прожорливы, NVIDIA — дороги, а Intel — ненадёжны: Ericsson остаётся верна кастомным ASICEricsson представила свой первый набор продуктов AI-RAN, подчеркнув приверженность стратегии, основанной на собственных ASIC для повышения производительности сетей радиодоступа (RAN). В то время как беспроводная индустрия всё чаще обращается к виртуализированным/облачным RAN с использованием универсальных процессоров (GPP) Intel, Ericsson защищает свои продолжающиеся инвестиции в кастомные чипы для высокопроизводительных задач, отметил ресурс IEEE ComSoc Technology Blog. Впрочем, Intel остаётся ключевым партнёром Ericsson, а вот с AMD и NVIDIA у компании не заладилось. Портфель решений Ericsson для RAN базируется на двух основных архитектурах. Большая часть основана на ASIC, разработанных как собственными силами, так и в партнёрстве с Intel. Также портфель включает Cloud RAN, которая объединяет программный стек Ericsson с процессорами Intel Xeon EE. Несмотря на надежды отрасли, что виртуализация позволит отделить аппаратное обеспечение от программного, Intel остаётся единственным партнером Ericsson по поставке микросхем для массового развёртывания, что создаёт некоторые риски. Фактически Ericsson подтвердила «коммерческую поддержку» исключительно решений Intel, в то время как в случае AMD, Arm и NVIDIA всё по-прежнему ограничивается «поддержкой прототипов». Несмотря на многолетние заявления отрасли о необходимости разнообразия микросхем в экосистеме vRAN, прогресс, похоже, застопорился. Кроме того, интеграция ИИ в ПО RAN добавляет новые уровни сложности, которые могут ещё больше укрепить зависимость компании от «железа» одного вендора. Отраслевые наблюдатели по-прежнему скептически относятся к стремлению Ericsson к «единому программному стеку» для гетерогенных аппаратных платформ. Хотя аппаратная и программная дезагрегация достижима на более высоких уровнях (L2/L3), PHY-уровень L1 — наиболее ресурсоёмкая часть стека — остаётся сильно оптимизированным для конкретного «кремния». Первоначально Ericsson рассчитывала на переносимость L1-кода между x86 (в т.ч. AMD) и Arm SVE2 (NVIDIA Grace) для соответствия возможностям Intel AVX-512. Однако достижение высокой производительности на этих платформах без существенного рефакторинга остается серьёзной инженерной проблемой. Критическим узким местом в обработке L1-трафика является коррекция ошибок (Forward Error Correction), которая традиционно требует выделенного аппаратного ускорения. Ericsson первоначально полагалась на разгрузку с переносом задач FEC на дискретные PCIe-ускорители Intel. Затем Intel внедрила ускорение FEC в Xeon EE в рамках vRAN Boost. Попытки использовать FPGA AMD показали их невысокую энергоэффективность, а GPU NVIDIA оказались слишком дороги для такой задачи. Однако развитие AI-RAN изменило экономику, поскольку теперь ускорители можно использовать как для RAN, так и для ИИ-задач. Так, Ericsson заинтересовали тензорные процессоры Google (TPU). Тем не менее, несмотря на стремление к созданию «единого ПО», планы Ericsson подтверждают существование проблем в реализации этой идеи. В то время как уровни L2 и выше используют универсальную кодовую базу для всех аппаратных платформ, уровень L1 требует адаптации под конкретные чипы. Чтобы избежать зависимости от одного поставщика чипов, компания уделяет приоритетное внимание развитию HAL (Hardware Abstraction Layers), что позволит портировать ПО на разные аппаратные платформы с минимальными изменениями. Основные инициативы включают внедрение интерфейса BBDev (Baseband Device) для отделения ПО RAN от базового аппаратного обеспечения. Рассматривается даже возможность интеграции с NVIDIA CUDA, но здесь многое зависит от более широкой отраслевой стандартизации. Что касается радиосвязи, менее подверженной полной виртуализации, Ericsson встраивает процессоры Neural Network Accelerators (NNA) непосредственно в радиомодули. Эти программируемые матричные ядра оптимизированы для обработки данных в системах Massive MIMO, обеспечивая формирование луча и оценку канала за доли миллисекунды при соблюдении строгих ограничений по мощности. Новые AI-радиомодули оснащены ASIC Ericsson с NNA. Утверждается, что они расширяют возможности локального инференса в радиосистемах Massive MIMO, обеспечивая оптимизацию в реальном времени.

20.02.2026 [15:59], Сергей Карасёв

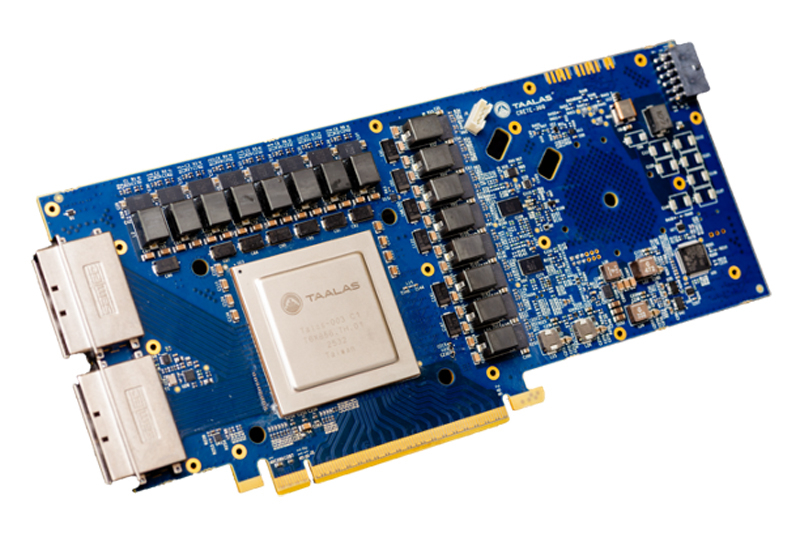

Узкие специалисты: Talaas, разрабатывающая оптимизированные под конкретные ИИ-модели ускорители, получила на развитие $169 млнСтартап Taalas, разрабатывающий чипы, специально оптимизированные для работы с конкретными ИИ-моделями, провел раунд финансирования на сумму в $169 млн. В число инвесторов вошли Quiet Capital и Fidelity, а также венчурный капиталист Пьер Ламонд (Pierre Lamond). Таким образом, на сегодняшний день компания получила на развитие в общей сложности более $200 млн. Фирма Taalas вышла из крытого режима (stealth mode) в марте 2023 года. Стартап занимается созданием чипов, предназначенных для определённых LLM. Первым продуктом компании стало изделие, ориентированное на ИИ-модель Llama 3.1 8B. Утверждается, что этот процессор способен генерировать до 17 тыс. выходных токенов в секунду, что в 73 раза больше по сравнению с NVIDIA H200. При этом решение Taalas потребляет в 10 раз меньше энергии.

Источник изображения: Taalas Оптимизация аппаратных ускорителей под конкретную ИИ-модуль повышает производительность и эффективность благодаря отказу от избыточных компонентов. Однако разработка таких узкоспециализированных изделий представляет собой сложный и дорогостоящий процесс. Компании Taalas удалось решить проблему, создав архитектуру, при которой для «тонкой» настройки требуется кастомизация только двух из более чем 100 слоев, из которых состоят её чипы. Кроме того, Taalas не использует в своих изделиях дорогостоящую память HBM. Это также упрощает конструкцию, позволяя упразднить компоненты, которые необходимы для обеспечения взаимодействия с HBM-модулями. В настоящее время Taalas работает над чипом, предназначенным для запуска ИИ-модели Llama с 20 млрд параметров: выпуск этого решения намечен на лето нынешнего года. Затем появится более мощный чип, ориентированный на LLM высокого уровня.

19.02.2026 [12:50], Сергей Карасёв

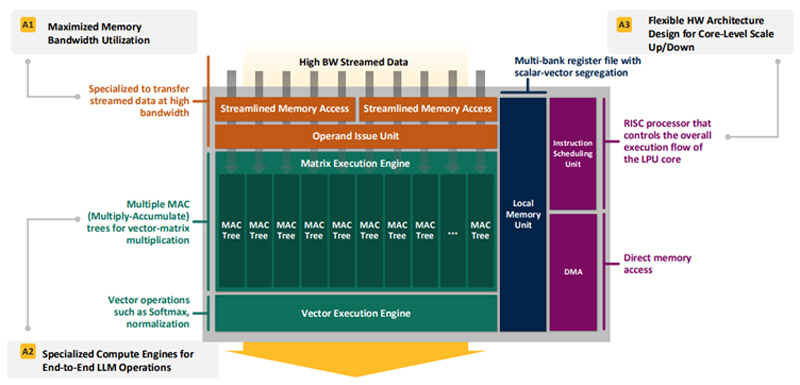

Впятеро энергоэффективнее H100: HyperAccel разработала экономичный чип Bertha 500 для ИИ-инференсаЮжнокорейский стартап HyperAccel, по сообщению EETimes, готовится вывести на рынок специализированный чип Bertha 500, предназначенный для ИИ-инференса. Утверждается, что благодаря особой архитектуре изделие способно генерировать в пять раз больше токенов в секунду по сравнению с решениями на основе GPU при том же уровне TOPS. В Bertha 500 упор сделан на экономическую эффективность. С этой целью используется память LPDDR вместо дорогостоящей HBM. При этом благодаря отказу от традиционной иерархии памяти достигается утилизация пропускной способности LPDDR на 90 %. Дальнейшее повышение эффективности обеспечивается путём оптимизации архитектуры именно для задач инференса. Для сравнения, как утверждает HyperAccel, в случае GPU при инференсе используется только около 45 % пропускной способности памяти и 30 % вычислительных ресурсов. Иными словами, немного жертвуя производительностью, чип Bertha 500 позволяет достичь значительного снижения стоимости. Изделие Bertha 500 будет производиться по 4-нм техпроцессу Samsung. В состав чипа входят 32 ядра LPU (LLM Processing Unit), четыре ядра Arm Cortex-A53 и 256 Мбайт SRAM. Подсистема памяти LPDDR5x использует восемь каналов; пропускная способность достигает 560 Гбайт/с. Заявленная ИИ-производительность на операциях INT8 составляет 768 TOPS. Кроме того, поддерживаются другие 16-, 8- и 4-бит форматы, включая FP16. В целом, по заявлениям HyperAccel, пропускная способность Bertha 500 в расчёте на доллар примерно в 20 раз выше по сравнению с NVIDIA H100, тогда как энергоэффективность больше в пять раз. Чип Bertha 500 будет потреблять около 250 Вт.

Источник изображения: EETimes Программный стек HyperAccel поддерживает все модели из репозитория HuggingFace. Кроме того, компания работает над предметно-ориентированным языком (DSL) под названием Legato, который предоставит разработчикам низкоуровневый доступ к системе. Образцы Bertha 500 появятся к концу I квартала 2026 года, а серийное производство планируется организовать в начале 2027 года. Отмечается также, что совместно с LG стартап разрабатывает «урезанную» версию Bertha 500 для периферийных устройств — Bertha 100. Эта SoC получит ядра Arm Cortex-A55 и отдельные компоненты LG, а также два канала памяти LPDDR5x. Среди возможных сфер применения названы автомобильная промышленность, бытовая электроника и робототехника. Bertha 100 планируется выпускать в виде модулей M.2: первые изделия выйдут в IV квартале текущего года. Решение сможет, например, осуществлять преобразование текста в речь или речи в текст. Стартап HyperAccel основан профессором Корейского института передовых технологий (KAIST) Джуёном Кимом (Jooyoung Kim) вместе с группой его студентов в начале 2023 года. На сегодняшний день компания привлекла $45 млн инвестиций, а её рыночная стоимость оценивается в $200 млн. Штат насчитывает около 80 человек. Первым продуктом HyperAccel стал специализированный сервер Orion на базе FPGA, предназначенный для решения ИИ-задач.

07.02.2026 [23:53], Игорь Осколков

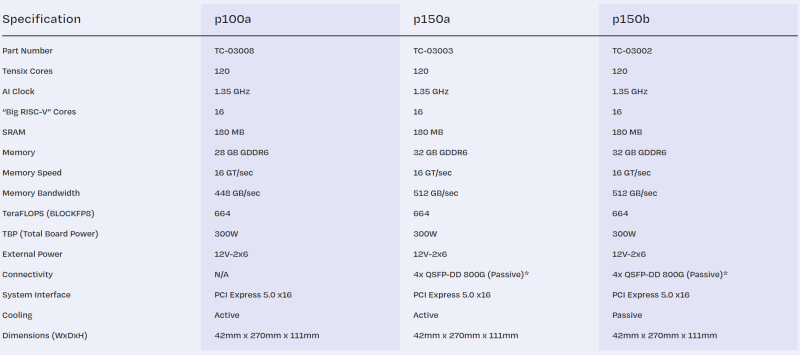

Tenstorrent принудительно «отрезала» ИИ-ядра у ускорителей Blackhole, даже у уже проданныхРазработчик ИИ-ускорителей Tenstorrent, возглавляемый Джимом Келлером, неожиданно изменил конфигурацию своих чипов Blackhole. Последнее обновление прошивки для карт p150a/p150b принудительно снижает количество активных ИИ-ядер Tensix со 140 до 120, причём это касается уже выпущенных и проданных карт. Описание p150a/p150b на сайте тоже обновилось. Хотя количество ядер уменьшится более чем на 14 %, компания обещает, что в типичных рабочих нагрузках разница в производительности составит лишь 1–2 %. Однако если ранее пиковая заявленная производительность составляла 774 Тфлопс (BLOCKFP8), то теперь она равна 664 Тфлопс. Таким образом, формально вычислительные блоки у младшей p100a и старших p150a/p150b теперь одинаковые. Вся разница в технических характеристиках между ними, помимо сетевого интерфейса, теперь заключается в объёме и скорости набортной памяти — 28 Гбайт GDDR6 (448 Гбайт/с) у младшей модели против 32 Гбайт (512 Гбайт/с) у старших. Причину такого внезапного изменения характеристик компания не назвала. В Сети есть предположения, что Tenstorrent таким образом пытается, к примеру, увеличить выход годных чипов. Или же она столкнулась с какими-то другими ограничениями, к примеру, по питанию и/или охлаждению. В частности, в том же самом апдейте снижен TDP у решения Galaxy на базе ускорителей Wormhole, чтобы, как сказано в описании, оставаться в рамках лимита по питанию. Наконец, изменение может быть связано и с подготовкой двухчиповой версии ускорителей Blackhole p300, которые получат 64 Гбайт памяти (1 Тбайт/с).

06.02.2026 [10:53], Владимир Мироненко

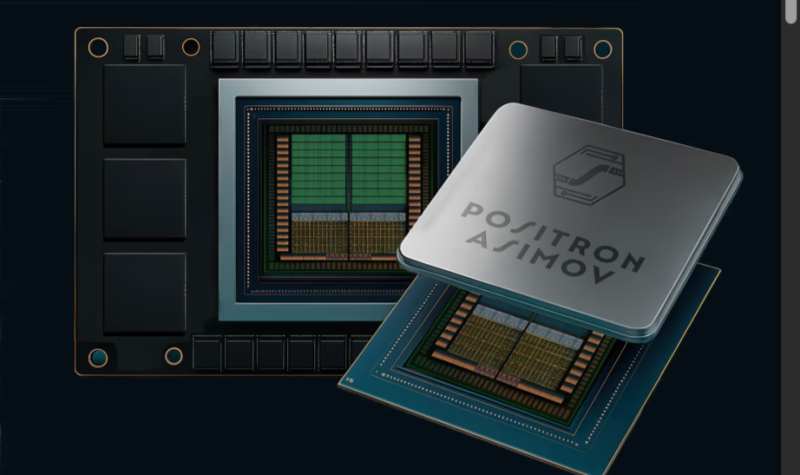

Без дефицитной HBM: Positron AI готовит ИИ-ускоритель Asimov с терабайтами LPDDR5xКомпания Positron AI сообщила о привлечении $230 млн инвестиций в рамках переподписанного раунда финансирования серии B, в результате которого оценка её рыночной стоимости превысила $1 млрд. Раунд возглавили ARENA Private Wealth, Jump Trading и Unless при участии новых инвесторов Qatar Investment Authority (QIA), Arm и Helena, а также существующих инвесторов Valor Equity Partners, Atreides Management, DFJ Growth, Resilience Reserve, Flume Ventures и 1517. Объявление было сделано на мероприятии Web Summit Qatar, что подчеркивает растущий международный авторитет компании, отметил ресурс eWeek. На то, чтобы перейти в категорию единорогов, Positron AI потребовалось 34 месяца. Positron AI отметила решение Jump Trading стать одним из лидеров раунда после того, как эта компания стала её клиентом. «Для рабочих нагрузок, которые нас интересуют, узкими местами всё чаще становятся память и энергопотребление, а не теоретические вычисления», — сказал технический директор Jump Trading. — В ходе наших тестов Positron Atlas показал примерно в три раза меньшую сквозную задержку, чем сопоставимая система на базе NVIDIA H100, при оценке рабочих нагрузок инференса, в готовом к производству корпусе с воздушным охлаждением и цепочкой поставок, которую мы можем спланировать». Полученные инвестиции позволят ускорить выход платформы следующего поколения Asimov, разработанной на заказ. Компания планирует завершить тестирование Asimov к концу III квартала, а пробные версии появятся в конце I квартала 2027 года. В Asimov будет использоваться память LPDDR (без HBM), но возможность приблизиться к теоретической пиковой пропускной способности памяти означает, что компании и не нужно полагаться на HBM для быстрой генерации токенов, сообщил ресурсу EE Times технический директор Positron. Вычислительные элементы Asimov — это эволюция блоков Atlas с добавлением ядер Arm и улучшенным интерконнектом. Расширить память LPDDR5x в Asimov можно с помощью CXL — с 864 Гбайт до 2,3 Тбайт на чип. Чип позволяет создать два независимых домена памяти, чтобы лучше утилизировать её. Хосит-интерфейс чипа — PCI 6.0 x32. Хотя LPDDR5x дешевле и ёмче HBM, она значительно уступает ей по пропускной способности. Если ускорители Rubin от NVIDIA оснащены 288 Гбайт памяти HBM4 с пиковой пропускной способностью 22 Тбайт/с, то для Asimov, по-видимому, потолок составляет около 3 Тбайт/с, пишет The Register (в спецификациях указано 2,76 Тбайт/с). По словам Positron, разница в том, что её чипы действительно могут использовать 90 % этой пропускной способности, в то время как GPU на базе HBM в реальных условиях едва достигают 30 % пиковой пропускной способности, хотя память Rubin даже в этом случае примерно в 2,4 раза быстрее, чем у Asimov. Компания сообщила, что 400-Вт чип оснащён систолической матрицей 512×512, работающей на частоте 2 ГГц и поддерживающей типы данных TF32, FP16/BF16, FP8, NVFP4 и INT4. Эта матрица управляется рядом ядер Armv9 и может быть переконфигурирована, например, в 128×512 (GEMV) или 512×128 (GEMM), в зависимости от того, какой вариант более выгоден для решения конкретной задачи. Четыре чипа Asimov образуют 4U-платформу Titan с воздушным охлаждением и пропускной способностью между чипами 16 Тбит/с. Компания отметила, что Asimov рассчитан на поддержку 2 Тбайт памяти на ускоритель и 8 Тбайт памяти на систему Titan с аналогичной пропускной способностью памяти, как у ускорителя NVIDIA Rubin. В масштабе стойки это означает объём памяти более 100 Тбайт. До 4096 систем Titan (16384 ускорителя) могут быть объединены в единый масштабируемый домен с более чем 32 Пбайт памяти. Это достигается с помощью чистого межчипового интерконнекта, а не коммутируемых масштабируемых сетей, как в стоечных архитектурах NVIDIA или AMD. Positron подчеркнула, что её архитектура, ориентированная на память, открывает доступ к высокоэффективным задачам инференса, включая большие языковые модели с длинным контекстом, агентные рабочие процессы и модели медиа и видео следующего поколения.

03.02.2026 [17:15], Руслан Авдеев

OpenAI не устроили чипы NVIDIA для инференса, теперь она ищет альтернативыПо данным многочисленных отраслевых источников, компания OpenAI недовольна некоторыми ИИ-чипами NVIDIA и с прошлого года ищет им альтернативы. Потенциально это усложнит отношения между крупнейшими игроками рынка на фоне бума ИИ, сообщает Reuters. Изменения стратегии OpenAI связаны с усилением акцента на инференсе. NVIDIA доминирует в нише ускорителей для обучения ИИ-моделей, но теперь инференс стал отдельным рынком с сильной конкуренцией. Решение OpenAI — вызов доминированию NVIDIA в сфере ИИ и препятствие $100-млрд сделки между компаниями, обеспечивающей разработчику чипов долю в ИИ-стартапе в обмен на доступ к передовым ускорителям. Предполагалось, что сделка будет закрыта за недели, но вместо этого переговоры ведутся месяцами. В то же время OpenAI заключила соглашение с AMD и Cerebras (её в своё время даже хотели купить) для получения «альтернативных» чипов, а также разрабатывает собственный ИИ-ускоритель при участии Broadcom. Amazon тоже не прочь предоставить OpenAI собственные ускорители, равно как и Google. Изменение планов OpenAI изменило и потребности в вычислительных мощностях и замедлило переговоры с NVIDIA. В минувшую субботу глава NVIDIA Дженсен Хуанг (Jensen Huang) опроверг слухи о проблемах с OpenAI, назвав их «чепухой» и подчеркнув, что клиенты продолжают выбирать NVIDIA для инференса, поскольку компания обеспечивает наилучшее соотношение производительности и совокупной стоимости владения, причём в больших масштабах. Отдельно представитель OpenAI заявлял, что компания полагается на NVIDIA для поставок большинства чипов для инференса, причём именно NVIDIA обеспечивает наилучшую производительность на каждый вложенный доллар. Глава OpenAI Сэм Альтман (Sam Altman) отметил, что NVIDIA выпускает «лучшие чипы в мире» и есть надежда, что OpenAI останется её «гигантским» клиентом очень долгое время. При этом, как сообщает Reuters со ссылкой на семь источников, OpenAI не удовлетворена производительностью инференса, на которую способны чипы NVIDIA. В частности, речь идёт о специализированных задачах вроде разработки ПО с помощью ИИ и коммуникаций ИИ с другим ПО. По данным одного из источников, компании понадобится новое аппаратное обеспечение, которое в конечном счёте обеспечит в будущем порядка 10 % вычислительных мощностей для инференса. OpenAI обсуждала возможности работы с ИИ-стартапами, включая Cerebras и Groq для обеспечения чипов с более быстрым инференсом, но NVIDIA фактически поглотила Groq на $20 млрд, что привело к прекращению переговоров с компанией. Хотя формально речь идёт неэксклюзивном лицензировании технологий Groq, что в теории позволяет сторонним компаниям получить доступ к решениям Groq, фактически все разработчики перешли в NVIDIA, а оставшаяся небольшая команда отвечает за выполнение облачных контрактов с имеющимися заказчиками. Чипы NVIDIA хорошо подходят для обработки больших объёмов данных при обучении больших ИИ-моделей вроде тех, что стоят за ChatGPT. Тем не менее прогресс требует массового использования уже обученных моделей для дальнейшего инференса и ИИ-рассуждений. Как сообщается, OpenAI с 2025 года ищет альтернативы ускорителям NVIDIA с упором на компании, создающие чипы с большими объёмами интегрированной SRAM. Maia 200 от Microsoft, по-видимому, компании не очень подходит. Инференс моделей более требователен к памяти, чем обучение, а вычислительная нагрузка, наоборот, не так велика. В тоге нередко на доступ к данным уходит больше времени, чем на расчёты. NVIDIA и AMD полагаются на внешнюю память, что замедляет соответствующие процессы общения с чат-ботами. В OpenAI проблемы отметили при эксплуатации системы Codex, активно продвигаемой компанией для создания кода. В компании считают, что некоторые слабости системы связаны именно с оборудованием NVIDIA. Конкуренты OpenAI полагаются на альтернативное оборудование. Anthropic активно использует AWS Trainium и Google TPU, а Google уже много лет использует свои TPU, которые с недавних пор готова отдавать на сторону. TPU оптимизированы в том числе для инференса и в некоторых отношениях более производительны, чем GPU общего назначения AMD и NVIDIA. Когда OpenAI недвусмысленно выразила отношение к технологиям NVIDIA, та предложила компаниям, создающим ускорители с упором на SRAM, включая Cerebras и Groq, купить их бизнес. Cerebras отказалась и заключила прямую сделку с OpenAI. Groq вела переговоры с OpenAI о предоставлении вычислительных мощностей, что вызвало интерес у инвесторов, оценивших капитализацию компании на уровне $14 млрд.

02.02.2026 [09:19], Сергей Карасёв

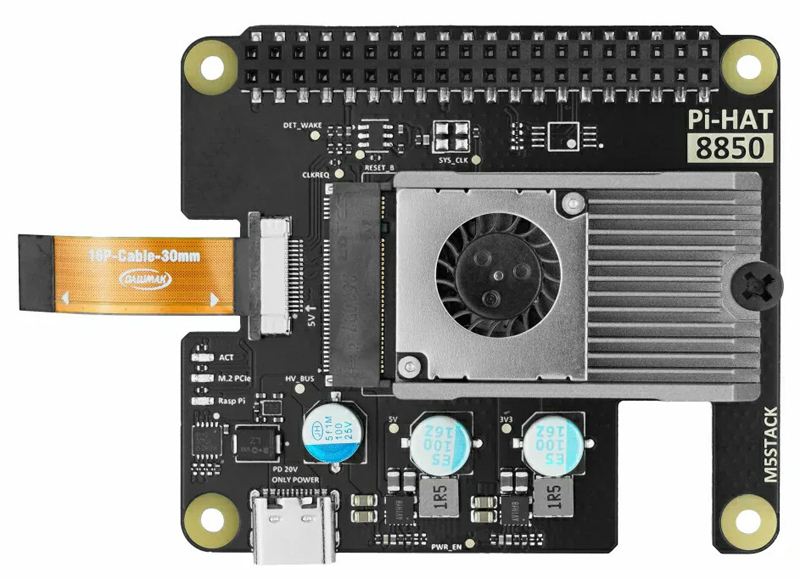

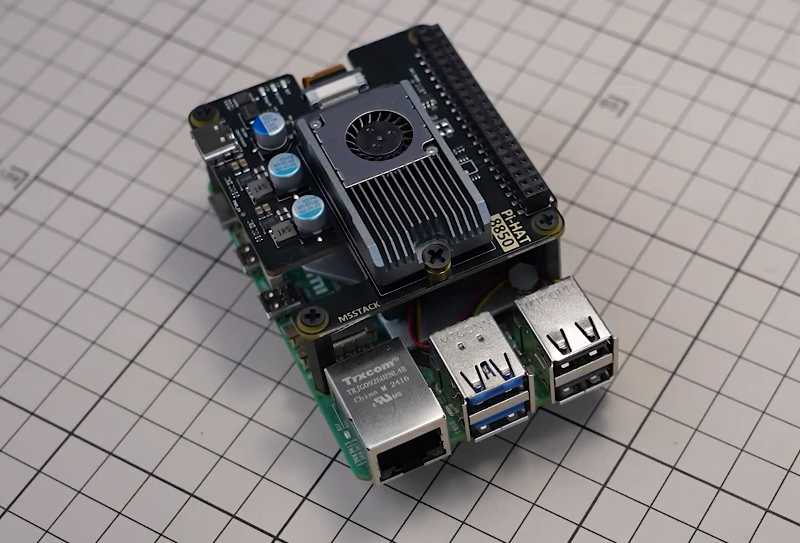

Карта на прибавление «ума»: M5Stack выпустила для Raspberry Pi 5 ИИ-ускоритель с 8 Гбайт RAMКомпания M5Stack, по сообщению CNX Software, выпустила комплект AI-88502 LLM Accelerator M.2 Kit — это ИИ-ускоритель для одноплатного компьютера Raspberry Pi 5, предназначенный для работы с большими языковыми моделями (LLM) и приложениями машинного зрения. Новинка представляет собой альтернативу изделию Raspberry Pi AI HAT+ 2. Основой анонсированного решения служит модуль M5Stack LLM-8850 формата M.2 M-Key 2242 с интерфейсом PCIe 2.0 x2. Он оснащён чипом Axera AX8850 с восемью ядрами Cortex-A55 с частотой 1,7 ГГц и нейропроцессорным узлом (NPU), обеспечивающим ИИ-производительность до 24 TOPS на операциях INT8. Встроенный VPU-блок предоставляет возможность кодирования и декодирования видеоматериалов H.264/H.265 в формате 8К со скоростью соответственно 30 и 60 к/с. В оснащение входят 8 Гбайт LPDDR4x-4266. Модуль имеет размеры 42,6 × 24,0 × 9,7 мм и весит 14,7 г. Максимальное энергопотребление — 7 Вт.

Источник изображений: CNX Software Изделие M5Stack LLM-8850 устанавливается на плату-адаптер Pi HAT 8850. Она оснащена 16-контактным коннектором FFC PCIe 2.0/3.0 x1 и 40-контактной колодкой GPIO. Питание 9/12/20 В подаётся через разъём USB Type-C PD 3.0. Габариты платы составляют 65,0 × 58,0 × 12,7 мм, масса — 31,9 г. Диапазон рабочих температур простирается от 0 до +60 °C. В комплект также входят кулер с вентилятором и радиатором для охлаждения модуля М.2 и крепёж для монтажа на одноплатный компьютер Raspberry Pi 5.  Набор M5Stack AI-88502 LLM Accelerator M.2 Kit предлагается по цене $215. Заявлена возможность использования следующих ИИ-моделей:

01.02.2026 [11:55], Сергей Карасёв

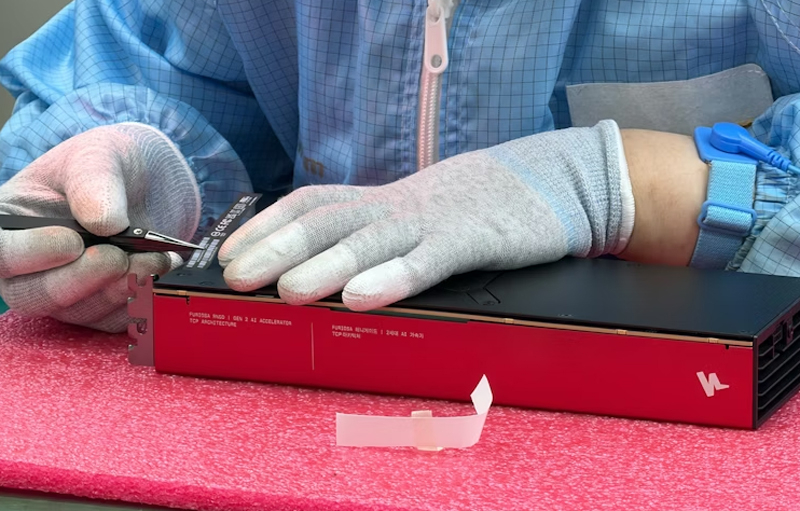

Южнокорейский стартап FuriosaAI начал массовое производство ИИ-ускорителей RNGDЮжнокорейский стартап FuriosaAI объявил о начале серийного выпуска ИИ-ускорителей RNGD и серверов NXT RNGD на их основе. Отмечается, что благодаря тесному партнёрству с TSMC, SK hynix и другими отраслевыми игроками, включая ASUS, сформирована стабильная производственная и логистическая цепочка, а новые продукты доступны корпоративным заказчикам по всему миру. ИИ-ускоритель RNGD выполнен в виде карты расширения PCIe 5.0 x16: он оснащён 48 Гбайт HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт SRAM с пропускной способностью 384 Тбайт/с. Показатель TDP не превышает 180 Вт. Заявленная производительность достигает 512 Тфлопс на операциях INT8. В свою очередь, система NXT RNGD формата 4U несёт на борту восемь карт RNGD. Энергопотребление находится на уровне 3 кВт. Утверждается, что в стандартную серверную стойку с воздушным охлаждением можно установить пять экземпляров NXT RNGD, что обеспечит ИИ-быстродействие до 20 Пфлопс (INT8).

Источник изображений: FuriosaAI Как подчёркивает FuriosaAI, современные ИИ-модели требуют колоссальных вычислительных мощностей, но подавляющее большинство корпоративных дата-центров имеют воздушное охлаждение, а их мощность ограничена 15 кВт на стойку. Поэтому для использования огромного количества GPU-ускорителей с показателем TDP до 600 Вт и более требуется дорогостоящая и трудоёмкая модернизация инфраструктуры. Применение изделий RNGD позволяет решить проблему. По заявлениям FuriosaAI, её решения обеспечивает в 3,5 раза большую вычислительную плотность, чем системы на базе NVIDIA H100 в стандартных средах.  Для ускорителей RNGD доступен полнофункциональный комплект разработки SDK. Говорится о поддержке популярных ИИ-моделей, таких как Qwen 2 и Qwen 2.5. Объём первой изготовленной партии изделий составил 4000 единиц.

31.01.2026 [21:37], Сергей Карасёв

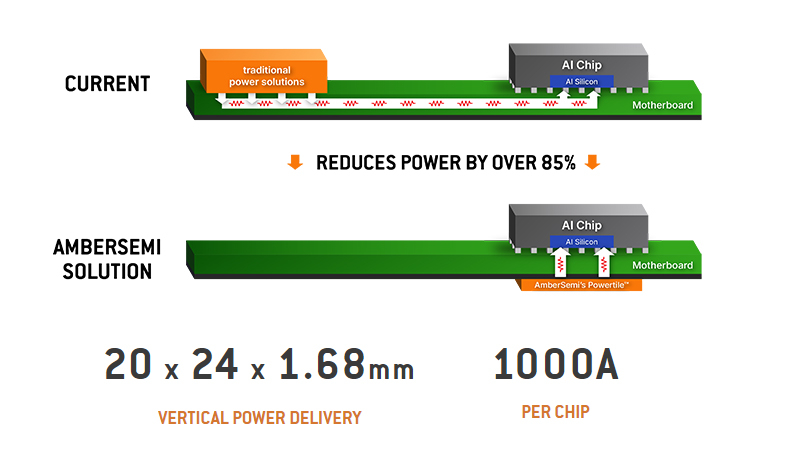

10 тыс. ампер на ускоритель: AmberSemi представила чип питания PowerTile для повышения энергоэффективности ИИ ЦОДКалифорнийская компания AmberSemi, специализирующаяся на разработке полупроводниковых изделий, сообщила о создании нового чипа управления питанием под названием PowerTile для дата-центров, ориентированных на ресурсоёмкие задачи ИИ. Решение PowerTile представляет собой конвертер DC-DC, предназначенный для использования с мощными современными процессорами. Новинка монтируется на обратной стороне системной платы непосредственно под компонентом, на который подаётся питание. AmberSemi заявляет, что благодаря такой вертикальной схеме потери мощности сокращаются более чем на 85 % по сравнению с традиционным боковым распределением питания. В результате, значительно повышается эффективность и улучшается масштабируемость ИИ-систем. Изделие PowerTile имеет размеры 20 × 24 × 1,68 мм. Чип способен подавать до 1000 А на CPU, GPU, FPGA или другие компоненты с высоким энергопотреблением. В системе могут быть задействованы несколько экземпляров PowerTile, что обеспечивает возможность наращивания тока до 10 000 А и более. Благодаря небольшой толщине может быть использовано жидкостное охлаждение.

Источник изображений: AmberSemi По оценкам AmberSemi, для ИИ ЦОД мощностью 500 МВт решение PowerTile может сэкономить до 225 МВт, что эквивалентно $160 млн/год. Компания сравнивает это с приблизительной годовой выработкой энергии малым модульным ядерным реактором. AmberSemi подчёркивает, что чип PowerTile разработан с учётом будущих архитектур дата-центров для ИИ, поскольку мощность таких объектов постоянно увеличивается.  Тар Кейси (Thar Casey), генеральный директор AmberSemi, отмечает, что существующие архитектуры питания с трудом справляются с быстро растущими потребностями ИИ-платформ. Это создаёт узкое место, ограничивающее дальнейшее наращивание производительности систем. PowerTile открывает путь для решения проблемы. AmberSemi планирует организовать тестирование изделия совместно с ключевыми партнёрами в конце текущего года. Поставки первых серийных образцов PowerTile начнутся в 2027-м. |

|