Материалы по тегу: ускоритель

|

29.01.2026 [16:57], Сергей Карасёв

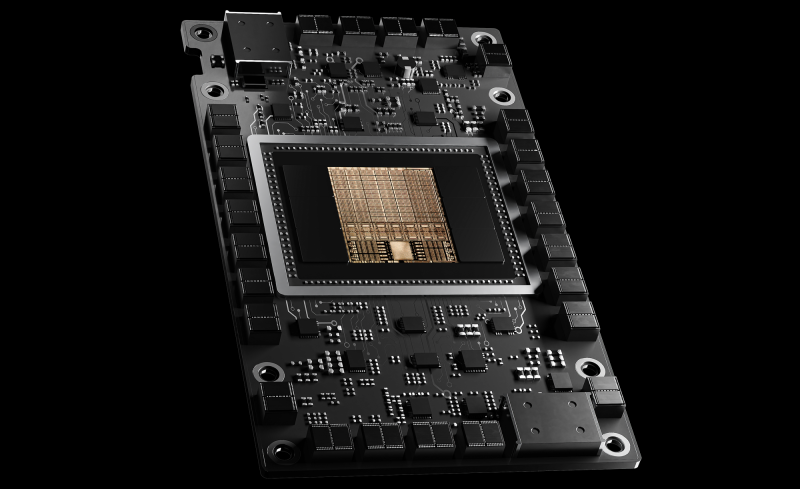

Китайский конкурент NVIDIA H20 — Alibaba представила ИИ-ускоритель Zhenwu 810E с 96 Гбайт HBM2eКомпания T-Head Semiconductor, подразделение китайского интернет-гиганта Alibaba Group Holding, представила ИИ-ускоритель собственной разработки Zhenwu 810E. Изделие, как утверждается, может использоваться для обучения ИИ-моделей и инференса, а также для решения других ресурсоёмких задач, например, в области автономного вождения. В основу новинки положены аппаратная и программная архитектуры, полностью разработанные специалистами T-Head. Решение оснащено 96 Гбайт памяти HBM2e. Применен проприетарный интерконнект ICN (Inter-Chip Network), обеспечивающий пропускную способность до 700 Гбайт/с — у каждого чипа есть семь таких интерфейсов для прямого объединения с другими чипами. Для подключения к хосту используется шина PCIe 5.0 x16. В плане производительности Zhenwu 810E, по имеющейся информации, превосходит ускоритель NVIDIA A800, а также некоторые GPU китайского производства. Подчеркивается, что новое решение T-Head способно составить конкуренцию NVIDIA H20. Напомним, что и A800, и H20 разработаны специально для китайского рынка в соответствии с американскими требованиями по контролю над экспортом высокопроизводительных процессоров. Некоторые источники также предполагают, что модернизированная версия чипа Zhenwu сможет обеспечить производительность, превосходящую показатели NVIDIA A100.

Источник изображения: T-Head Alibaba уже использует Zhenwu 810E для обучения своих больших языковых моделей Qianwen, а также для ИИ-инференса. Кроме того, на базе новых чипов в сочетании с облачными сервисами Alibaba предоставляются услуги более чем 400 клиентам, включая Государственную электросетевую компанию (SGCC), Китайскую академию наук (CAS) и стартап по производству электромобилей Xpeng. Собственные ИИ-чипы проектируют и многие другие китайские компании. В частности, местный стартап Iluvatar CoreX недавно поделился планами по выпуску GPU-ускорителей, превосходящих по возможностям NVIDIA Rubin. Соответствующие разработки также ведут Kunlunxin (Baidu), Zixiao (Tencent), MetaX, Moore Threads и Biren. Но ведущими игроками рынка ИИ-чипов КНР остаются NVIDIA и Huawei.

28.01.2026 [13:43], Сергей Карасёв

Китайский стартап Iluvatar CoreX обещает GPU-ускорители, превосходящие по возможностям NVIDIA RubinСтартап Iluvatar CoreX из Китая, по сообщению DigiTimes, раскрыл планы по выпуску ускорителей на основе GPU для ИИ-задач. Речь идёт об изделиях четырёх поколений, которые, как предполагается, смогут составить конкуренцию продукции NVIDIA. В частности, Iluvatar CoreX создаёт решения на архитектуре с кодовым названием Tianshu. Такие устройства, по утверждениям разработчика, по производительности превзойдут ускорители NVIDIA поколения Hopper, включая H200. На 2026 год компания Iluvatar CoreX запланировала анонс ускорителей на архитектуре Tianxuan, которым предстоит конкурировать с решениями семейства NVIDIA Blackwell, в том числе с B200. Кроме того, позднее в текущем году Iluvatar CoreX намерена представить изделия на архитектуре следующего поколения Tianji: по быстродействию такие чипы, предположительно, будут опережать Blackwell. Наконец, на 2027-й китайский стартап запланировал выпуск GPU с архитектурой Tianquan, которая по производительности призвана превзойти платформу NVIDIA Rubin. После этого Iluvatar CoreX рассчитывает сфокусировать внимание на разработке «прорывных вычислительных архитектур». По состоянию на 30 июня 2025 года Iluvatar CoreX отгрузила более 52 тыс. GPU примерно 290 корпоративным клиентам, в том числе из финансовой сферы и сектора здравоохранения. Компания позиционирует себя в качестве поставщика высокопроизводительных GPU общего назначения и крупномасштабных вычислительных систем. Вместе с тем, как и другие китайские разработчики ИИ-чипов, Iluvatar CoreX сталкивается с проблемами, связанными со сбоями в цепочках поставок и доступом к передовым производственным мощностям. Дальнейшее развитие продуктового семейства компании будет зависеть от внедрения современных технологических процессов и методов корпусировки. Помимо GPU-продуктов, Iluvatar CoreX также разрабатывает изделия Tongyang для периферийных вычислений. По заявлениям стартапа, один из подобных чипов — TY1000 — продемонстрировал превосходство над NVIDIA Jetson AGX Orin в реальных задачах, включая компьютерное зрение, обработку естественного языка и ИИ-инференс с использованием таких больших языковых моделей, как DeepSeek 32B.

27.01.2026 [01:23], Владимир Мироненко

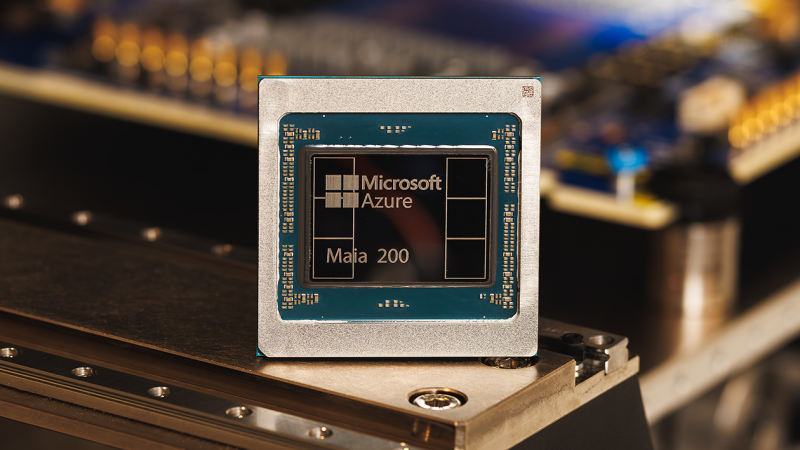

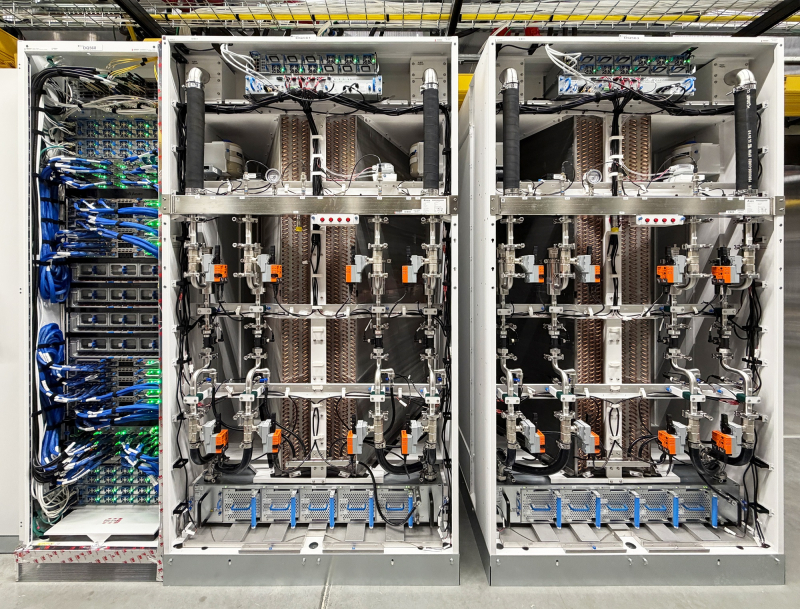

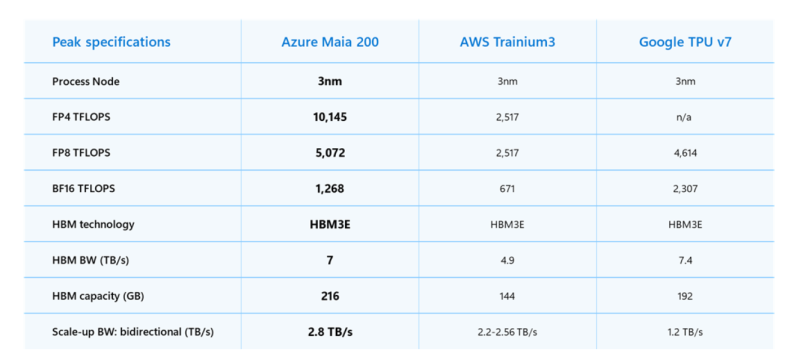

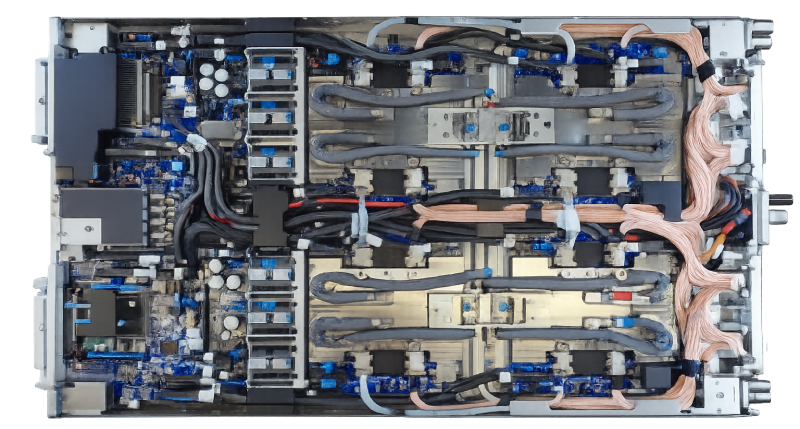

Microsoft представила ИИ-ускоритель Maia 200 с 216 Гбайт HBM3eMicrosoft представила 3-нм ИИ-ускоритель Maia 200 для инференса с собственными тензорными ядрами с поддержкой форматов FP8/FP4, переработанной подсистемой памяти с 216 Гбайт HBM3e (7 Тбайт/с), 272 Мбайт SRAM, DMA-движком, оптимизированной NOC, а также «механизмами перемещения данных, обеспечивающими быструю и эффективную работу масштабных моделей». Maia 200 содержит более 140 млрд транзисторов. FP4-производительность составляет более 10 Пфлопс что в три раза выше, чем у Amazon Trainium3, но почти вдвое меньше, чем у NVIDIA Blackwell, и более 5 Пфлопс в FP8-вычислениях, чуть превосходя по производительности Google TPU v7 Ironwood и опять-таки примерно вдвое уступая Blackwell. При этом TDP составляет 750 Вт, а для охлаждения используются СЖО и фирменные теплообменники второго поколения. На системном уровне Maia 200 использует всего лишь двухуровневую унифицированную сетевую фабрику, построенную на стандартном Ethernet. Специальный транспортный уровень Maia AI, который используется и для вертикального, и для горизонтального масштабирования, и тесно интегрированный сетевой адаптер обеспечивают производительность, высокую надёжность и преимущества по стоимости без использования проприетарных интерконнектов. Каждый акселератор получил выделенный интерфейс с пропускной способностью 2,8-Тбайт/с (в дуплексе). Обещаны предсказуемые, высокопроизводительные коллективные операции в кластерах, объединяющих до 6144 ускорителей. Внутри каждого узла есть четыре ускорителя Maia 200, которые общаются друг с другом напрямую, т.е. без использования коммутатора. «Maia 200 также является самой эффективной системой для выполнения задач ИИ, когда-либо развёрнутой Microsoft, обеспечивая на 30 % лучшую производительность на доллар, чем новейшее оборудование в нашем парке», — сообщила компания. Maia 200 уже используется в регионе US Central недалеко от Де-Мойна (Des Moines, шт. Айова), а в дальнейшем планируется развёртывание новых ускорителей в регионе US West 3, недалеко от Финикса (Phoenix, шт. Аризона). Компания также представила предварительную версию SDK Maia с полным набором инструментов для создания и оптимизации LLM для Maia 200. Он включает в себя полный набор возможностей, в том числе интеграцию с PyTorch, компилятор Triton и оптимизированную kernel-библиотеку, а также доступ к низкоуровневому программированию Maia. Microsoft сообщила, что Maia 200 будет использоваться в рамках её гетерогенной ИИ-инфраструктуры для работы с различными моделями, включая GPT-5.2 от OpenAI, обеспечивая преимущества в соотношении производительности и затрат для Microsoft Foundry и Microsoft 365 Copilot. Команда Microsoft Superintelligence будет использовать Maia 200 для генерации синтетических данных и обучения с подкреплением для улучшения собственных моделей следующего поколения. В сценариях использования конвейера синтетических данных использование Maia 200 позволит ускорить процесс генерации и фильтрации высококачественных данных, специфичных для конкретной предметной области.

26.01.2026 [09:39], Владимир Мироненко

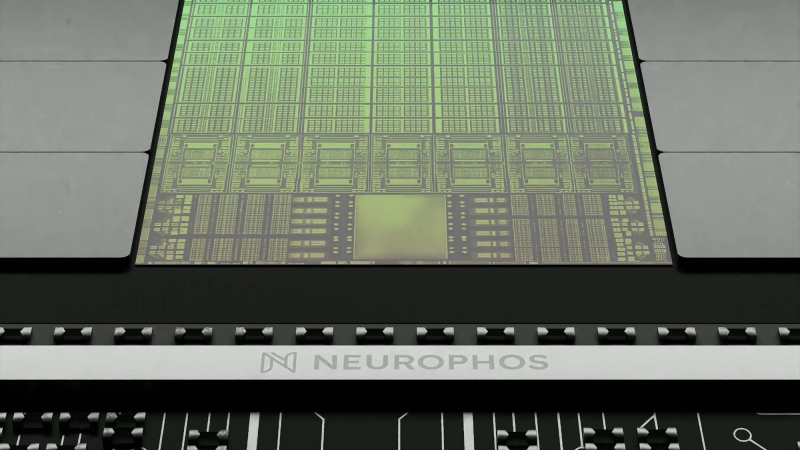

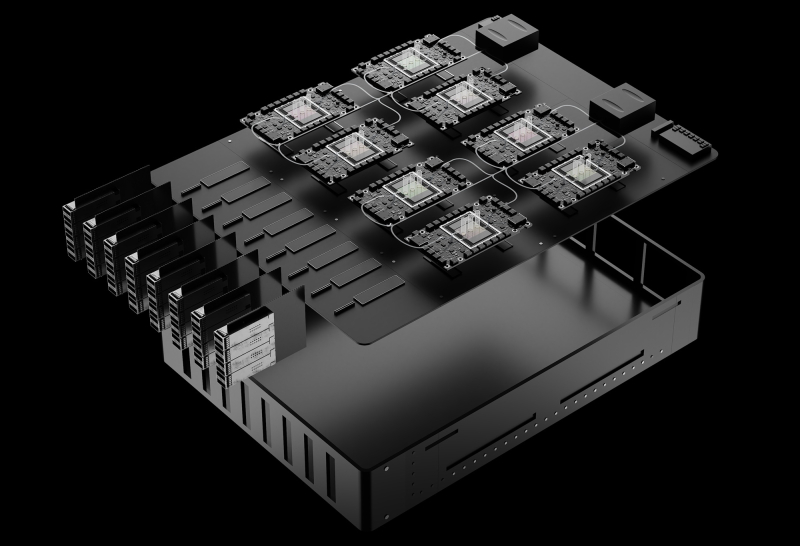

ИИ-расчёты — в OPU: Neurophos готовит 56-ГГц фотонный ускоритель Tulkas T100Стартап Neurophos, специализирующийся на разработках в области фотонных чипов для ИИ-нагрузок, сообщил о привлечении $110 млн в рамках переподписанного раунда финансирования серии А, в результате чего общий объём полученных им инвестиций вырос до $118 млн. Раунд возглавила Gates Frontier Билла Гейтса (Bill Gates) при участии M12 (венчурный фонд Microsoft), Carbon Direct Capital, Aramco Ventures, Bosch Ventures, Tectonic Ventures, Space Capital и др. В число инвесторов также вошли DNX Ventures, Geometry, Alumni Ventures, Wonderstone Ventures, MetaVC Partners, Morgan Creek Capital, Silicon Catalyst Ventures, Mana Ventures, Gaingels и другие. Юридическим консультантом выступает Cooley LLP. Полученные средства компания планирует использовать для ускорения разработки своей первой интегрированной фотонной вычислительной системы. Она включает в себя готовые к использованию в ЦОД модули OPU, полный программный стек и аппаратное обеспечение с ранним доступом для разработчиков. Кроме того, компания расширяет свою штаб-квартиру в Остине и открывает новый инженерный центр в Сан-Франциско для удовлетворения первоначального спроса клиентов. Стартап разработал «метаповерхностный модулятор» с оптическими свойствами, позволяющими его использовать в качестве тензорного процессора для выполнения матрично-векторного умножения. Разработанные стартапом оптические модуляторы на основе метаматериалов микронного масштаба в 10 тыс. раз меньше существующих фотонных элементов, что впервые делает фотонные вычисления реальностью. Эти модуляторы интегрируются с технологией вычислений в памяти для сокращения перемещения данных. «Современные задачи инференса с использованием ИИ требуют колоссальных вычислительных мощностей и ресурсов, — сообщил доктор Марк Трембле (Marc Tremblay), корпоративный вице-президент и технический эксперт по базовой ИИ-инфраструктуре ИИ. — Нам необходим прорыв в вычислительной мощности, сопоставимый с теми скачками, которые мы наблюдаем в самих ИИ-моделях, и именно этим занимается технология Neurophos и ее высококвалифицированная команда». Компания, основанная Патриком Боуэном (Patrick Bowen) и Эндрю Траверсо (Andrew Traverso), включает в себя ветеранов отрасли из NVIDIA, Apple, Samsung, Intel, AMD, Meta✴, ARM, Micron, Mellanox, Lightmatter и др. Neurophos разрабатывает оптический процессор (OPU), который объединяет более миллиона микронных оптических элементов обработки на одном чипе. Он обеспечивает до 100 раз большую производительность и энергоэффективность по сравнению с ведущими современными чипами, утверждает компания. «Закон Мура замедляется, но ИИ не может позволить себе ждать. Наш прорыв в фотонике открывает совершенно новый уровень масштабирования благодаря массивному оптическому параллелизму на одном чипе. Этот сдвиг на уровне физики означает, что как эффективность, так и скорость улучшаются по мере масштабирования, освобождаясь от энергетических барьеров, которые ограничивают традиционные GPU», — говорит Боуэн. «Эквивалент оптического транзистора, который вы получаете сегодня на заводах, огромен. Он имеет длину около 2 мм. Вы просто не можете разместить достаточное количество таких транзисторов на чипе, чтобы получить вычислительную плотность, хотя бы отдалённо конкурирующую с современными CMOS-технологиями», — сообщил ресурсу The Register Боуэн. «В мае мы получили первый кремниевый кристалл, продемонстрировав, что можем сделать это с помощью стандартного CMOS-процесса, что означает совместимость с существующими технологиями производства. На кристалле находится одно фотонное тензорное ядро размером 1000 × 1000 [обрабатывающих элементов]», — сказал он. Это значительно больше, чем обычно встречается в большинстве GPU, которые обычно используют механизмы матричного умножения размером 256 × 256 обрабатывающих элементов. Однако для чипа Neurophos достаточно одного тензорного ядра вместо десятков или даже сотен таких, как в ускорителях NVIDIA. Боуэн говорит, что тензорное ядро в ускорителе Neurophos первого поколения будет занимать примерно 25 мм². Оснащение остальной части микросхемы размером с фотошаблон — это «главная проблема, связанная с поддержкой этого невероятно мощного тензорного ядра», сказал Боуэн. В частности, Neurophos требуется огромное количество векторных процессоров и SRAM, чтобы тензорное ядро не испытывало нехватки данных. Это связано с тем, что само тензорное ядро — которое в чипе будет всего лишь одно — работает на частоте около 56 ГГц. Но поскольку матричное умножение выполняется оптическим методом, единственная потребляемая тензорным ядром энергия уходит на преобразование электрических сигналов в оптические и обратно, сообщил Боуэн. Как сообщает Neurophos, её первый OPU Tulkas T100 получит 768 Гбайт памяти HBM (20 Тбайт/с) и 200 Мбайт L2-кеша. Производительность системы составит 470 POPS (FP4/INT4) или 400 TOPS (FP16/INT16) при потреблении от 1 до 2 КВт под нагрузкой, демонстрируя энергоэффективность до 235 TOPS/Вт. Следует учитывать, что эти цифры пока лишь ориентиры. Чип всё ещё находится в активной разработке, и полномасштабное производство, как ожидается, начнётся не раньше середины 2028 года. Как утверждают в Neurophos, проблем с массовым производством оптических чипов не предвидится, поскольку они могут быть изготовлены с использованием стандартных материалов, инструментов и процессов полупроводниковых фабрик. Боуэн предполагает, что Tulkas T100 будет выполнять аналогичную роль, что и соускоритель NVIDIA Rubin CPX для работы с контекстом и создания KV-кеша. «Текущая концепция, которая может измениться, заключается в том, что мы разместим одну нашу стойку, состоящую из 256 наших чипов, и она будет сопряжена с чем-то вроде стойки NVL576», — сказал он. В долгосрочной перспективе возможен и переход к генерации токенов, но для этого потребуется разработка множества технологий, включая интегрированную оптику. Боуэн сообщил ресурсу TechCrunch, что Neurophos уже заключил контракты с несколькими клиентами (хотя он отказался назвать их имена), и такие компании, как Microsoft, «очень внимательно изучают» продукцию стартапа. Хотя на рынке ИИ-ускорителей и так большая конкуренция, Боуэн уверен, что повышение производительности и эффективности, обеспечиваемое оптическими вычислениями, станет достаточным конкурентным преимуществом чипов стартапа. «Все остальные, включая NVIDIA, в плане фундаментальной физики кремния, скорее эволюционны, чем революционны, и это связано с прогрессом TSMC. Если посмотреть на улучшение техпроцессов TSMC, то в среднем они повышают энергоэффективность примерно на 15 %, и на это уходит пара лет», — сказал он.

20.01.2026 [21:58], Владимир Мироненко

Tesla возобновит строительство ИИ-суперкомпьютеров DojoГендиректор Tesla (Elon Musk) Илон Маск объявил в соцсети Х о решении компании возобновить работу над Dojo3, третьим поколением суперкомпьютерных систем, о чём сообщает Data Center Dynamics. Команда, занимавшаяся проектом Dojo, была расформирована в прошлом году в связи с тем, что компания отдала предпочтение ИИ-чипам, используемых в бортовых системах электромобилей. Также ранее было объявлено, что компания будет полагаться на чипы внешних партнёров. Вместе с тем компания возвращается к проекту Dojo, поскольку, по словам Маска, достигнуты успехи в разработке чипа AI5, что создало определённый запас прочности. Маск объявил, что однокристальный чип AI5 обеспечит производительность на уровне NVIDIA Hopper, при этом двухкристальный AI5 будет равен по мощности чипу с Blackwell. Он предложил всем заинтересованным в участии в проекте и «работе над созданием самых массово производимых в мире микросхем» отправить сообщение Tesla, указав в трёх пунктах самые сложные технические проблемы, которые они решили. Илон Маск также сообщил, что разработка чипа Tesla AI5 почти завершена, а чип AI6 находится на «ранней стадии» разработки, добавив, что компания также планирует создать чипы AI7, AI8 и AI9. По его словам, нынешний чип Tesla AI4 позволит достичь «уровня безопасности при автономном вождении, намного превышающего человеческий», а AI5 сделает электромобили Tesla «почти идеальными», также значительно улучшив функционирование человекоподобного робота Optimus. «AI6 для Optimus и ЦОД. AI7/Dojo3 будут использовать ИИ для космических вычислений», — написал Маск. В ноябре 2025 года он заявил, что существует «чёткий путь к удвоению производительности по всем показателям для AI6 в течение 10–12 мес. после выпуска AI5», а теперь он намерен сократить срок создания каждого нового поколения ИИ-чипов до 9 мес. Хотя сам миллиардер не стал называть сроки производства чипа AI5, ИИ-чат-бот Grok сообщил пользователям в ответ на запросы, что ограниченное производство AI5 ожидается в 2026 году, а массовое производство запланировано на 2027 год. В конце прошлого года Маск заявил акционерам Tesla, что компании, вероятно, потребуется построить «гигантскую фабрику» для производства своих ИИ-чипов, чтобы хотя бы частично удовлетворить в них потребности компании. Tesla уже сотрудничает с TSMC и Samsung, которые производят чипы AI5 и AI6 на заводах в Аризоне и Тайване, а также в Южной Корее и Техасе соответственно. На том же собрании акционеров Маск сказал, что, вероятно, стоит обсудить вопрос производства и с Intel. Как отметил Techpowerup, в августе прошлого года появились сообщения о присоединении к компании Маска Intel в качестве ключевого партнёра по упаковке чипов, что ознаменовало отход Tesla от прежней зависимости от TSMC в вопросах производства. Сообщается, что Intel будет управлять сборкой и тестированием, используя свою технологию EMIB. Это лучше подходит для больших блоков Tesla Dojo, объединяющих несколько чипов площадью 654 мм² в одном корпусе. В свою очередь, Samsung будет производить обучающие чипы D3 на своем заводе в Техасе с помощью 2-нм техпроцесса, оставив Intel контроль над процессами упаковки. Такое разделение труда решает проблему ограничений производственных мощностей и предоставляет Tesla большую гибкость в настройке схем межсоединений. Для автомобильных чипов AI5 компании Samsung и TSMC создадут разные версии, хотя Tesla стремится обеспечить одинаковую производительность в обоих случаях. Предполагается, что AI5 будет потреблять 150 Вт, при этом соответствуя по производительности NVIDIA H100, у которого TDP составляет до 700 Вт. Это было достигнуто путём удаления графических подсистем общего назначения и оптимизации архитектуры специально для ИИ-алгоритмов Tesla.

19.01.2026 [10:09], Сергей Карасёв

DeepX представила ИИ-ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2Южнокорейский стартап Deepx, специализирующийся на разработке чипов для задач ИИ, анонсировал ускорители DX-H1 V-NPU, DX-H1 Quattro и DX-M1 М.2. В основу решений, которые демонстрировались на недавней выставке CES 2026 в Лас-Вегасе (Невада, США), положен нейропроцессорный узел Genesis NPU. Устройство DX-H1 V-NPU предназначено для выполнения операций, связанных с обработкой видеоматериалов: это может быть декодирование, кодирование, перекодирование и пр. Утверждается, что новинка обеспечивает снижение стоимости оборудования примерно на 80 % и сокращение энергопотребления на 85 % по сравнению с решениями на базе GPU при той же плотности каналов. Ускоритель выполнен в виде низкопрофильной карты расширения PCIe 3.0 x16 (x8 на уровне сигналов). Он оснащён двумя аппаратными видеокодеками и двумя NPU с общей производительностью до 50 TOPS (INT8) при инференсе в реальном времени. Возможно декодирование 64 каналов H.264/265 (1080р; 30 к/с) и кодирование 32 каналов H.264/265 (1080р; 30 к/с). Секция кодирования имеет доступ к 16 Гбайт памяти LPDDR5, секция NPU — к 8 Гбайт. Упомянуты интерфейс HDMI 2.0 и флеш-модуль eMMC вместимостью 32 Гбайт. Максимальное энергопотребление составляет 40 Вт. Решение DX-H1 Quattro, в свою очередь, оснащено четырьмя NPU с суммарной производительностью до 100 TOPS (INT8). В оснащение входят 16 Гбайт памяти LPDDR5. Ускоритель, выполненный в виде карты PCIe 3.0 x16, предназначены для выполнения ИИ-задач в дата-центрах и на периферии. Энергопотребление равно 20 Вт, диапазон рабочих температур простирается от -25 до +85 °C. Говорится о совместимости с Windows и различными вариантами Linux, включая Ubuntu. Изделие DX-M1 М.2 представляет собой ИИ-ускоритель в виде модуля М.2 2280, выполненный на чипе DX-M1. ИИ-производительность — до 25 TOPS, а энергопотребление не превышает 5 Вт. Используется интерфейс PCIe 3.0 x4. Говорится о возможности применения устройства в системах с архитектурой х86 и Arm. Диапазон рабочих температур — от -25 до +85 °C. Упомянута совместимость с Windows 11 и Ubuntu 22.04.

15.01.2026 [18:19], Сергей Карасёв

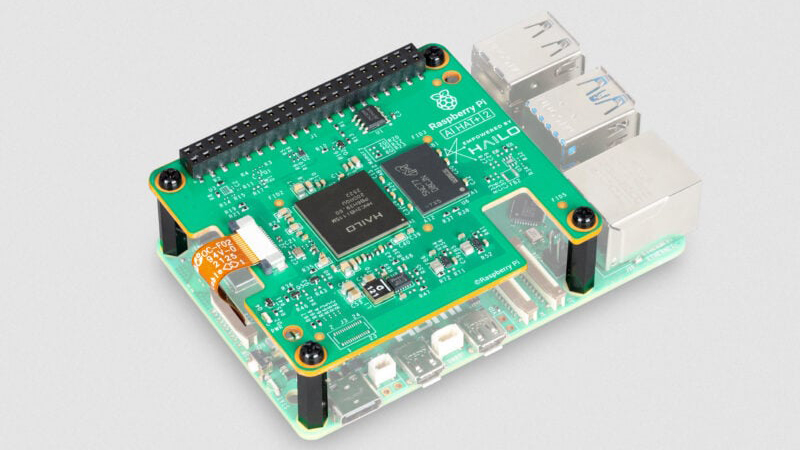

Модуль AI HAT+ 2 добавляет к Raspberry Pi 5 ИИ-ускоритель Hailo-10HКомпания Raspberry Pi анонсировала специализированный модуль расширения AI HAT+ 2, позволяющий использовать одноплатный компьютер Raspberry Pi 5 для ИИ-инференса. Новинка уже доступна для заказа по ориентировочной цене $130. Ранее Raspberry Pi выпустила ИИ-модуль AI HAT+, который в зависимости от модификации оснащается ускорителем Hailo-8 (26 TOPS) или Hailo-8L (13 TOPS). Такие изделия предназначены прежде всего для инференса. Решение Raspberry Pi AI HAT+ 2, в свою очередь, спроектировано под генеративный ИИ. В основу новинки положен ускоритель Hailo-10H, который позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально. Чип функционирует в тандеме с 8 Гбайт LPDDR4/4X. Заявленная ИИ-производительность достигает 40 TOPS на операциях INT4. Для задач, основанных на машинном зрении, таких как распознавание объектов, оценка позы и сегментация сцены, производительность AI HAT+ 2 приблизительно эквивалентна быстродействию ранее выпущенного ИИ-модуля на базе Hailo-8.

Источник изображения: Raspberry Pi При подключении модуля операционная система Raspberry Pi OS автоматически обнаруживает ускоритель и переносит на него поддерживаемые задачи ИИ. Поначалу для изделия будут доступны следующие LLM: DeepSeek-R1-Distill, Qwen2.5-Coder, Qwen2.5-Instruct и Qwen2 (все с 1,5 млрд параметров), а также Llama3.2 (с 1 млрд параметров). В дальнейшем будут предложены более крупные модели.

28.12.2025 [15:42], Владимир Мироненко

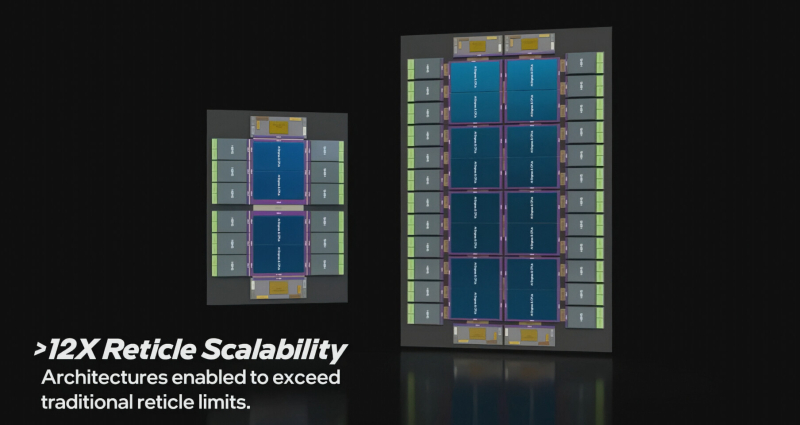

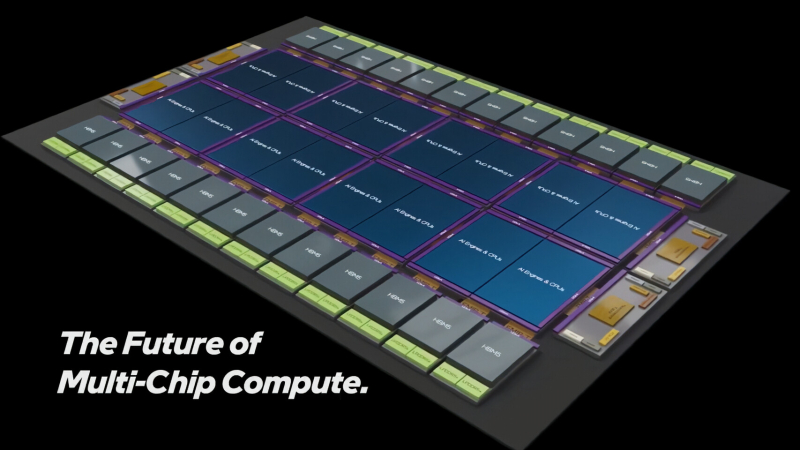

16 вычислительных тайлов и 24 стека HBM: Intel продемонстрировала свои возможности для создания будущих чиповIntel Foundry опубликовала видео с демонстрацией своих передовых решений в области упаковки микросхем с использованием технологических процессов 18A/14A, технологий Foveros 3D и EMIB-T. В видео представлены концептуальные и масштабируемые конструкции с возможностью размещения до 16 вычислительных блоков, 24 стеков HBM и многое другое. Как отметил ресурс WCCFTech, видеоролик демонстрирует, что ждёт клиентов Intel, стремящихся использовать её технологии при создании будущих чипов. Эти технологии будут устанавливать стандарты для чипов следующего поколения для HPC, ИИ, ЦОД и многого другого. Передовые решения в области упаковки также усилят позиции Intel в конкуренции с TSMC, которая представили решение CoWoS, обеспечивающее 9,5-кратное превышение размеров стандартного фотошаблона (830 мм²), использующее технологический процесс A16 и более 12 стеков HBM4E (CoWoS-L). Согласно видео, технологии Intel Foveros 3D и межкристального соединения EMIB-T позволяют объединить до 16 вычислительных кристаллов в паре с 24 стеками HBM5 в одном корпусе. При этом используются 18A-процессы Intel, включая 18A-P и 18A-PT, и 14A-процессы, которые компания готовит к массовому производству, в том числе для внешних заказчиков. В опубликованном видеоролике Intel демонстрирует два передовых решения для корпусирования микросхем. Одна микросхема включает четыре вычислительных блока и 12 модулей HBM, а вторая — 16 вычислительных блоков и 24 модуля HBM. Также у более крупной размещено в одном корпусе вдвое больше контроллеров LPDDR5X, до 48, что значительно увеличивает плотность памяти для ИИ-нагрузок и ЦОД. Для создания микросхем используется технология послойного объединения кристаллов, при которой базовые кристаллы, изготовленные с использованием процесса 18A-PT, используют подачу питания с обратной стороны (PowerVia) и включают SRAM-банки. На базовый тайл затем устанавливается основной вычислительный тайл, который может включать в себя ИИ-движки, CPU или другие IP-блоки. Они изготавливаются по технологическим процессам Intel 14A или 14A-E, используют транзисторы RibbonFET второго поколения и технологию PowerDirect, и соединяются с базовым тайлом с помощью технологии Foveros Direct 3D, обеспечивающей вертикальное размещение компонентов, образуя 3D-стек. Затем несколько чиплетов соединяются и дополнительно взаимодействуют с памятью с помощью технологии упаковки EMIB-T. Верхний тайл использует 24 модуля HBM, которые могут поддерживать как существующие стандарты HBM, такие как HBM3/HBM3E, так и будущие, такие как HBM4/HBM4E или HBM5. При этом активно используется UCIe. Теперь дело за практической реализацией замыслов. Компания возвращается на рынок с ИИ-ускорителем Jaguar Shores и GPU Crescent Island для ИИ-инференса, но всё зависит от сделок со сторонними поставщиками.

26.12.2025 [13:22], Руслан Авдеев

Китайская iFlytek основал новую структуру для разработки чипов и связанных ИИ-решенийВнесённая в американский чёрный список компания iFlytek, считающаяся в Китае одним из столпов местной ИИ-индустрии наряду с Baidu, Alibaba, Tencent и др., основала новую компанию, которая займётся как разработкой полупроводников, так и прочими, связанными с ИИ решениями в рамках попыток Китая развивать технологическую самодостаточность, сообщает гонконгская SCMP. По данным китайской платформы коммерческой бизнес-разведки Qichacha, новая структура Shandong Yixun Information Technology зарегистрирована на прошлой неделе с уставным капиталом ¥50 млн ($7,1 млн). В числе заявленных сфер деятельности — разработка собственно чипов, а также программного обеспечения для ИИ и технический консалтинг ИИ-сервисов для государственных услуг. iFlytek отказалась от комментариев, связанных с новым бизнесом.

Источник изображения: Tran Mau Tri Tam/unsplash.com Последняя инициатива iFlytek, в своё время сделавшей имя на ПО для распознавания звука, а позже осуществившей развитие бизнеса и в других сфераъ, включая ИИ, свидетельствует о растущей важности разработки собственных ИИ-чипов для КНР. Всё больше бизнесов в стране занимаются проектами в этой сфере. Ожидается, что они потенциально смогут соперничать с западными «тяжеловесами» индустрии вроде NVIDIA и AMD. Это происходит на фоне того, что управление Торгового представительства США (USTR) заявило, что стремление Пекина к доминированию в области полупроводников «необоснованное и дискриминационное» и представляет прямую угрозу для торговли Соединённых Штатов. Ведомство заявляет, что США вводят тарифные ограничения в отношении импорта с страну широкого спектра китайских полупроводников. Китайский бизнес действительно прилагает все усилия для развития собственных ИИ-технологий. Так, на днях сообщалось, что ByteDance намерена нарастить свои инвестиции в ИИ-проекты, чтобы не отстать от американских конкурентов — компания готовится увеличить капитальные затраты до ¥160 млрд ($23 млрд) в 2026 году.

19.12.2025 [18:35], Сергей Карасёв

NVIDIA выпустила ускоритель RTX Pro 5000 Blackwell с 72 Гбайт памяти для рабочих станцийКомпания NVIDIA сообщила о доступности ускорителя RTX Pro 5000 Blackwell с 72 Гбайт памяти GDDR7 (ECC) для мощных рабочих станций, ориентированных на ИИ-задачи, включая «тонкую» настройку больших языковых моделей (LLM). Новинка является собратом ранее выпущенной версии RTX Pro 5000 Blackwell с 48 Гбайт GDDR7, по сравнению с которой объём памяти увеличился в полтора раза. Оба ускорителя построены на чипе Blackwell с 14 080 ядрами CUDA. Задействованы тензорные ядра пятого поколения и RT-ядра четвёртого поколения. Говорится об использовании 512-бит шины памяти; пропускная способность — 1344 Гбайт/с. Новинка выполнена в виде двухслотовой карты расширения полной высоты с интерфейсом PCIe 5.0 x16.

Источник изображения: NVIDIA Выпущенный ускоритель располагает четырьмя разъёмами DisplayPort 2.1b. Возможен одновременный вывод изображения на несколько мониторов в следующих конфигурациях: четыре с разрешением до 4096 × 2160 пикселей и частотой обновления 120 Гц, четыре с разрешением 5120 × 2880 точек и частотой 60 Гц или два с разрешением 7680 × 4320 пикселей и частотой 60 Гц. Заявлена поддержка DirectX 12, Shader Model 6.6, OpenGL 4.63, Vulkan 1.33, а также CUDA 12.8, OpenCL 3.0 и DirectCompute. Заявленная ИИ-производительность достигает 2142 TOPS. Карта оборудована 16-контактным разъёмом дополнительного питания. Энергопотребление находится на уровне 300 Вт. Применено активное охлаждение с вентилятором. Ускоритель RTX Pro 5000 Blackwell с 72 Гбайт памяти предлагается через партнёрские каналы, включая Ingram Micro, Leadtek, Unisplendour и xFusion. |

|