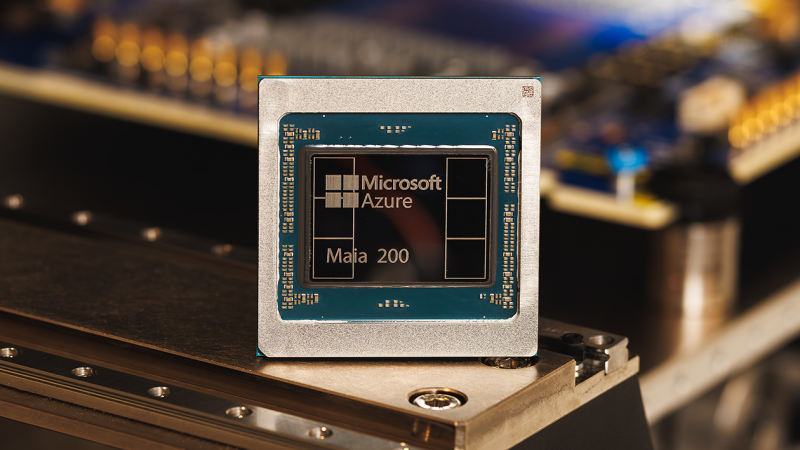

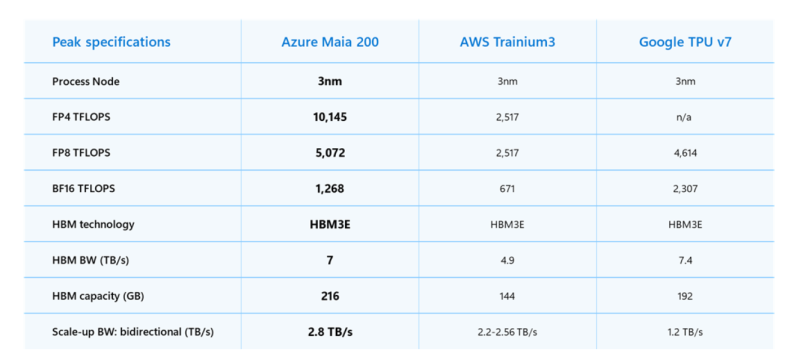

Microsoft представила 3-нм ИИ-ускоритель Maia 200 для инференса с собственными тензорными ядрами с поддержкой форматов FP8/FP4, переработанной подсистемой памяти с 216 Гбайт HBM3e (7 Тбайт/с), 272 Мбайт SRAM, DMA-движком, оптимизированной NOC, а также «механизмами перемещения данных, обеспечивающими быструю и эффективную работу масштабных моделей». Maia 200 содержит более 140 млрд транзисторов.

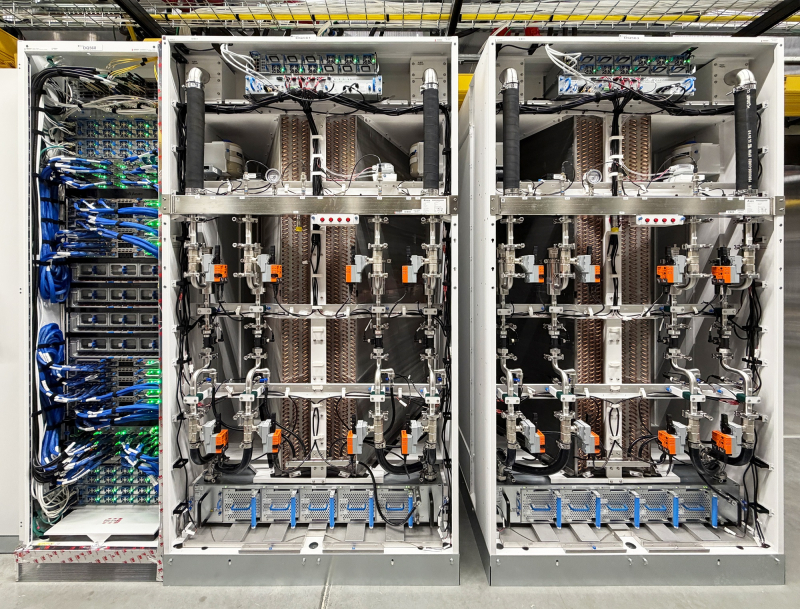

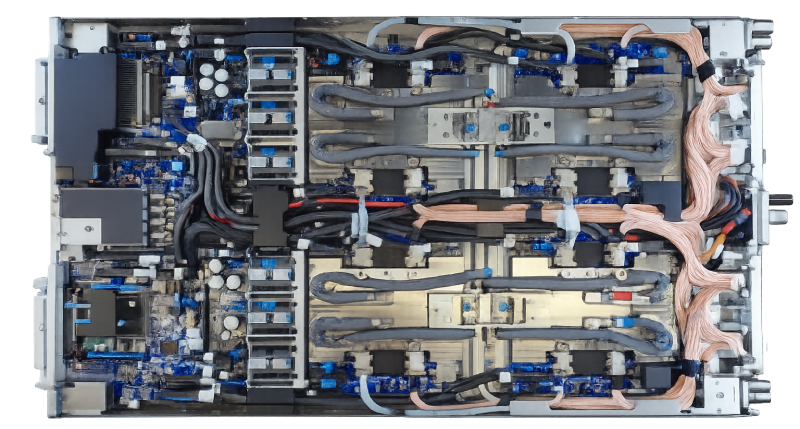

FP4-производительность составляет более 10 Пфлопс что в три раза выше, чем у Amazon Trainium3, но почти вдвое меньше, чем у NVIDIA Blackwell, и более 5 Пфлопс в FP8-вычислениях, чуть превосходя по производительности Google TPU v7 Ironwood и опять-таки примерно вдвое уступая Blackwell. При этом TDP составляет 750 Вт, а для охлаждения используются СЖО и фирменные теплообменники второго поколения.

На системном уровне Maia 200 использует всего лишь двухуровневую унифицированную сетевую фабрику, построенную на стандартном Ethernet. Специальный транспортный уровень Maia AI, который используется и для вертикального, и для горизонтального масштабирования, и тесно интегрированный сетевой адаптер обеспечивают производительность, высокую надёжность и преимущества по стоимости без использования проприетарных интерконнектов. Каждый акселератор получил выделенный интерфейс с пропускной способностью 2,8-Тбайт/с (в дуплексе). Обещаны предсказуемые, высокопроизводительные коллективные операции в кластерах, объединяющих до 6144 ускорителей. Внутри каждого узла есть четыре ускорителя Maia 200, которые общаются друг с другом напрямую, т.е. без использования коммутатора.

«Maia 200 также является самой эффективной системой для выполнения задач ИИ, когда-либо развёрнутой Microsoft, обеспечивая на 30 % лучшую производительность на доллар, чем новейшее оборудование в нашем парке», — сообщила компания. Maia 200 уже используется в регионе US Central недалеко от Де-Мойна (Des Moines, шт. Айова), а в дальнейшем планируется развёртывание новых ускорителей в регионе US West 3, недалеко от Финикса (Phoenix, шт. Аризона).

Компания также представила предварительную версию SDK Maia с полным набором инструментов для создания и оптимизации LLM для Maia 200. Он включает в себя полный набор возможностей, в том числе интеграцию с PyTorch, компилятор Triton и оптимизированную kernel-библиотеку, а также доступ к низкоуровневому программированию Maia.

Microsoft сообщила, что Maia 200 будет использоваться в рамках её гетерогенной ИИ-инфраструктуры для работы с различными моделями, включая GPT-5.2 от OpenAI, обеспечивая преимущества в соотношении производительности и затрат для Microsoft Foundry и Microsoft 365 Copilot. Команда Microsoft Superintelligence будет использовать Maia 200 для генерации синтетических данных и обучения с подкреплением для улучшения собственных моделей следующего поколения. В сценариях использования конвейера синтетических данных использование Maia 200 позволит ускорить процесс генерации и фильтрации высококачественных данных, специфичных для конкретной предметной области.

Источник: