Материалы по тегу: nvidia

|

20.11.2025 [14:09], Руслан Авдеев

xAI, Humain и NVIDIA построят крупный ИИ ЦОД в Саудовской АравииГлава компании xAI Илон Маск (Elon Musk) объявил о новом совместном проекте xAI, NVIDIA и Humain в Саудовской Аравии. Новость появилась на фоне официального визита саудовского наследного принца Мухаммеда бин Салмана (Mohammed bin Salman) в США, сообщает NBC News. Проект был анонсирован практически одновременно с аналогичным проектом AMD, Cisco и Humain. По словам Маска, с использованием чипов NVIDIA и при участии Humain, созданной при поддержке суверенного фонда благосостояния Саудовской Аравии, компанией xAI будет построен дата-центр мощностью 500 МВт. Для сравнения, кампус ЦОД Colossus 1 компании xAI в Мемфисе является одним из крупнейших в мире действующих вычислительных кластеров и его мощность пока составляет около 300 МВт. Как заявляют в Белом доме, заявления о партнёрстве последовали после заключения меморандума о взаимопонимании в сфере ИИ между США и Саудовской Аравией. В соответствии с новым соглашением, Соединённые Штаты предоставляют ближневосточному королевству доступ к ведущим американским системам и одновременно американские технологии будут защищены от «иностранного влияния».

Источник изображения: NEOM/unspalsh.com По словам Маска, будущее буквально наполнено роботами и космическими ИИ ЦОД. В частности, он заявил, что «гуманоидные роботы станут крупнешим продуктом в истории», что сделает работу «необязательной». Прогнозируя будущее отрасли ИИ, Маск предположил, что через четыре-пять лет спутники с ИИ-модулями на солнечных батареях могут стать самым дешёвым способом обеспечить вычисления.

20.11.2025 [11:37], Сергей Карасёв

Представлен самый мощный суперкомпьютер на Ближнем Востоке — 122,8-Пфлопс система Shaheen IIIУниверситет науки и технологий имени короля Абдаллы (KAUST) в Саудовской Аравии объявил о запуске вычислительного комплекса Shaheen III. На сегодняшний день, как утверждается, это самый мощный суперкомпьютер на Ближнем Востоке: его FP64-производительность достигает 122,8 Пфлопс. Применять Shaheen III планируется для решения широкого спектра ресурсоёмких задач. Среди них названа разработка нового поколения малых и больших языковых моделей (LLM), ориентированных на арабский регион. Кроме того, суперкомпьютер поможет в создании цифрового двойника всего Аравийского полуострова — интегрированной среды моделирования, объединяющей атмосферные, океанические и земные процессы. Эта виртуальная модель будет способствовать решению комплексных проблем, таких как управление разливами нефти и оптимизация морских перевозок. В числе других задач названы оптимизация сельскохозяйственной деятельности и управления водными ресурсами, поиск передовых материалов, диагностика редких заболеваний, улучшение качества медицинской визуализации, разработка перспективных лекарственных препаратов и пр. Система создана компанией HPE на платформе Cray EX с прямым жидкостным охлаждением (DLC). В общей сложности задействованы 2800 гибридных суперчипов NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Общее количество используемых ядер составляет 574 464. Применён интерконнект Slingshot-11. В качестве программной платформы используется HPE Cray OS. В ноябрьском рейтинге самых мощных суперкомпьютеров мира TOP500 система Shaheen III занимает 18-ю позицию. Её теоретическое пиковое быстродействие заявлено на уровне 155,21 Пфлопс. Энергопотребление — 1,98 МВт.

19.11.2025 [01:11], Владимир Мироненко

$30 млрд и 1 ГВт: Microsoft, NVIDIA и Anthropic договорились о сотрудничествеMicrosoft, NVIDIA и Anthropic объявили о стратегическом партнёрстве, которое включает ряд новых инициатив. Как сообщается, Anthropic взяла на себя обязательство приобрести вычислительные мощности Azure стоимостью $30 млрд и заключить контракт на поставку дополнительных вычислительных мощностей объёмом до 1 ГВт для обеспечения будущих потребностей в масштабировании. В рамках партнёрства NVIDIA и Microsoft также обязуются инвестировать в Anthropic до $10 и $5 млрд соответственно. Компании также расширят существующее партнёрство, чтобы обеспечить предприятиям более широкий доступ к ИИ-модели Claude. Клиенты Microsoft Azure AI Foundry смогут получить доступ к продвинутым (frontier) версиям модели Claude, включая Claude Sonnet 4.5, Claude Opus 4.1 и Claude Haiku 4.5. Это партнёрство делает Claude единственной frontier-моделью LLM, доступной во всех трёх самых известных облачных сервисах мира. Также Claude будет интегрирована в пакет Copilot, включающий GitHub Copilot, Microsoft 365 Copilot и Copilot Studio. Генеральный директор Anthropic Дарио Амодеи (Dario Amodei) отметил, что акцент Microsoft на корпоративные платформы естественным образом подходит Claude, которая часто используется в бизнес-приложениях, пишет The Wall Street Journal. В рамках стратегического партнёрства Anthropic и NVIDIA будут сотрудничать в области проектирования и инжиниринга с целью обеспечения наилучшей производительности, экономичности и общей стоимости владения для моделей Anthropic, а также оптимизации будущих архитектур NVIDIA для рабочих нагрузок Anthropic. Первоначально Anthropic будет использовать вычислительные системы NVIDIA Grace Blackwell и Vera Rubin мощностью до 1 ГВт. Аналитики Bank of America утверждают, что эти, на первый взгляд, цикличные сделки являются для лидеров отрасли способом расширить свой потенциальный целевой рынок, что «может многократно увеличить будущие выгоды». Как отметил ресурс Converge! Network Digest, с учётом нынешнего объявления портфель обязательств Microsoft в области ИИ теперь превышает $100 млрд, включая контракты с OpenAI, Inflection и Anthropic. Эти долгосрочные соглашения помогают Microsoft обосновать ускоренное строительство ИИ ЦОД, закупки электроэнергии и развёртывание ИИ-систем. Сделка также укрепляет позиции Azure по сравнению с AWS, запустившей для Anthropic ИИ-кластер Project Rainier, и Google Cloud, TPU которой также пользуется Anthropic.

18.11.2025 [23:59], Владимир Мироненко

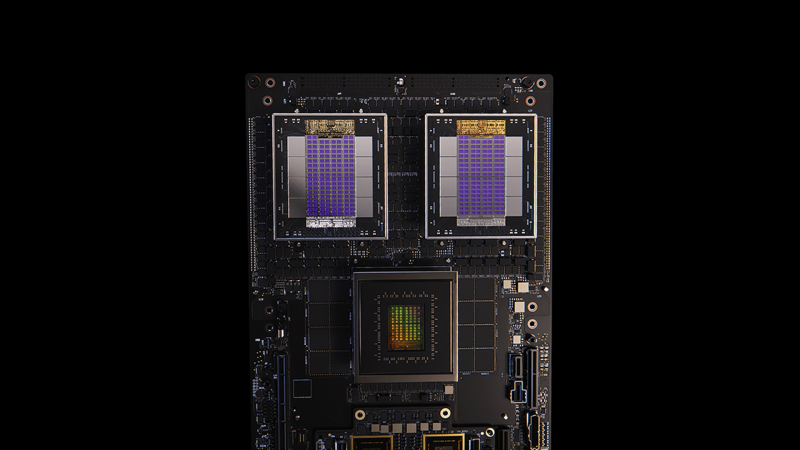

Arm добавила Neoverse поддержку NVIDIA NVLink FusionArm объявила о расширении возможностей платформы Neoverse с помощью NVIDIA NVLink Fusion в рамках партнёрства с NVIDIA, обеспечивая всей экосистеме ту же производительность, пропускную способность и эффективность, которые впервые были реализованы на платформах Grace Hopper и Grace Blackwell. «NVLink Fusion — это связующее звено эпохи ИИ, объединяющее все CPU, GPU и ускорители в единую архитектуру стоечного масштаба», — заявил Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA. Как сообщается в пресс-релизе, два года назад Arm и NVIDIA представили платформу Grace Hopper, в которой технология NVLink обеспечила согласованную интеграцию CPU и GPU. NVLink Fusion обеспечивает компаниям возможность подключать вычислительные системы на базе Arm к предпочитаемым ими ускорителям через согласованный интерфейс с высокой пропускной способностью. Устойчивый спрос на Grace Blackwell способствует распространению NVLink Fusion во всей экосистеме Neoverse, позволяя партнёрам создавать дифференцированные, энергоэффективные ИИ-системы на базе Arm, отвечающие современным требованиям к производительности и масштабируемости. Arm отметила, что на текущий момент развёрнуто более чем 1 млрд ядер Neoverse и уверенно движется к достижению 50 % доли рынка среди ведущих гиперскейлеров к 2025 году. Все крупные провайдеры — AWS, Google, Microsoft, Oracle и Meta✴ — используют Neoverse, а ИИ ЦОД следующего поколения, такие как проект Stargate, используют Arm как основную вычислительную платформу. NVLink Fusion совместим с технологией AMBA CHI C2C (Coherent Hub Interface Chip-to-Chip) компании Arm, которая обеспечивает когерентное высокоскоростное соединения между CPU и ускорителями. Arm внедряет в платформу Neoverse последнюю версию протокола AMBA CHI C2C, чтобы SoC Neoverse могли беспрепятственно передавать данные между CPU Arm и ускорителями. Благодаря этому обеспечивается более быстрая интеграция, более быстрый вывод на рынок и большая гибкость для разработчиков ИИ-систем нового поколения. В свою очередь, NVIDIA работает над стандартизацией многих компонентов в этих системах для повышения надёжности и времени безотказной работы. С этой целью в CPU NVIDIA Vera следующего поколения будут использоваться кастомные ядра Arm вместо ядер Neoverse. Fujitsu также разрабатывает собственные Arm-процессоры MONAKA-X, которые тоже получат NVLink Fusion. NVLink Fusion получат и x86-процессоры Intel.

18.11.2025 [10:54], Сергей Карасёв

Начался монтаж крупнейшего в США академического суперкомпьютера Horizon с ИИ-быстродействием до 80 ЭфлопсНациональный научный фонд США (NSF) объявил о начале монтажа вычислительно комплекса Horizon — крупнейшего в стране академического суперкомпьютера. Система расположится в Техасском центре передовых вычислений (TACC) при Техасском университете в Остине (UT Austin). Проект реализуется в сотрудничестве с Dell, NVIDIA, VAST Data, Spectra Logic, Versity и Sabey Data Centers. Суперкомпьютер будет развёрнут в новом дата-центре мощностью 15–20 МВт с передовым жидкостным охлаждением в Раунд-Роке (штат Техас). В основу системы лягут серверы Dell PowerEdge. Говорится об использовании процессоров NVIDIA Vera и суперчипов NVIDIA Grace Blackwell. В общей сложности будут задействованы около 1 млн CPU-ядер и примерно 4 тыс. GPU. Архитектура предусматривает использование интерконнекта NVIDIA Quantum-2 InfiniBand. Вместимость локального хранилища данных, выполненного исключительно на основе SSD, составит 400 Пбайт. Оно обеспечит пропускную способность при чтении/записи более 10 Тбайт/с. Заявленная производительность Horizon — 300 Пфлопс: это примерно в 10 раз больше по сравнению с системой Frontera, которая в настоящее время является самым мощным академическим суперкомпьютером в США. При выполнении ИИ-задач новый вычислительный комплекс обеспечит быстродействие до 20 Эфлопс на операциях BF16/FP16 и до 80 Эфлопс в режиме FP4 — более чем 100-кратный прирост по сравнению с нынешними машинами, которые эксплуатируются в американских академических кругах. При этом говорится о повышении энергетической эффективности до шести раз. Запуск Horizon запланирован на весну 2026 года. Суперкомпьютер будет использоваться для решения сложных и ресурсоёмких задач в таких областях, как биомедицина, физика, энергетика, экология и пр. В частности, система будет применяться для моделирования климата.

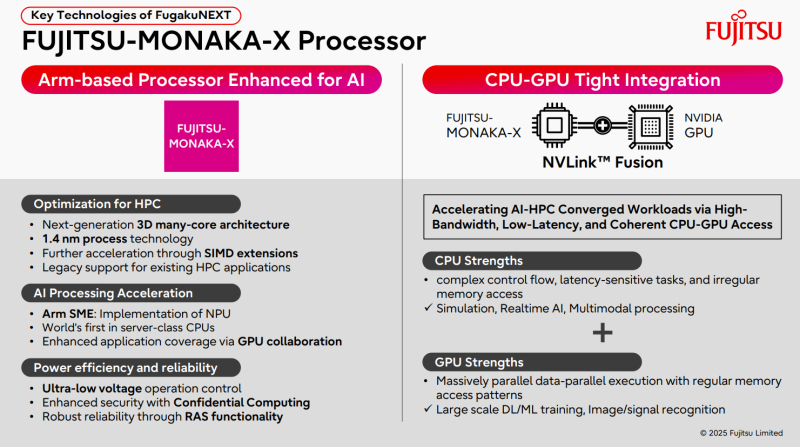

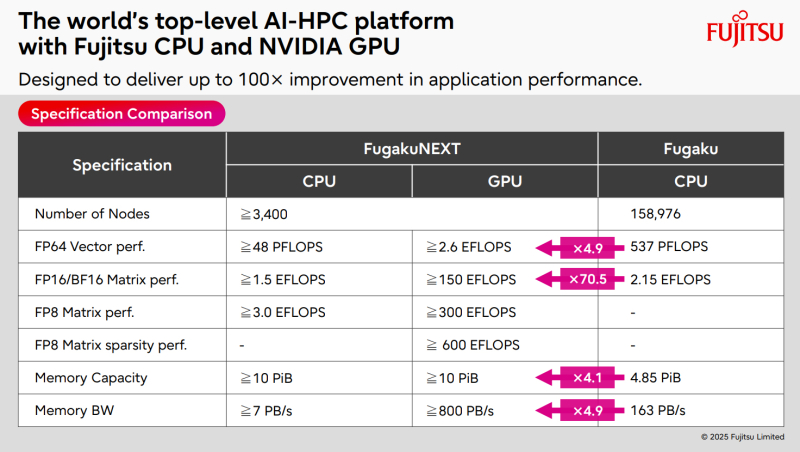

17.11.2025 [10:02], Сергей Карасёв

ИИ-производительность японского суперкомпьютера FugakuNEXT превысит 600 ЭфлопсКомпания Fujitsu поделилась информацией о суперкомпьютере следующего поколения FugakuNEXT (Fugaku Next), который создаётся совместно с японским Институтом физико-химических исследований (RIKEN). Проект реализуется при поддержке Министерства образования, культуры, спорта, науки и технологий Японии (MEXT). FugakuNEXT придёт на смену вычислительному комплексу Fugaku, который в 2020 году стал самым высокопроизводительным суперкомпьютером в мире. В рейтинге ТОР500 от июня 2025 года эта НРС-система занимает седьмое место с FP64-быстродействием приблизительно 442 Пфлопс (теоретическая пиковая производительность достигает 537,21 Пфлопс). Разработку архитектуры FugakuNEXT планируется полностью завершить к середине 2028 года, после чего начнутся производство и монтаж суперкомпьютера. В эксплуатацию система будет введена не ранее середины 2030 года. Известно, что в основу FugakuNEXT лягут Arm-процессоры Fujitsu MONAKA-X, при производстве которых предполагается использовать 1,4-нм технологию. Чипы получат до 144 вычислительных ядер. Кроме того, в состав машины войдут ИИ-ускорители NVIDIA, для связи которых с CPU планируется задействовать шину NVLink Fusion. Платформа также получит новые интерконнекты для горизонтального и вертикального масштабирования. В материалах Fujitsu говорится, что FugakuNEXT получит в общей сложности свыше 3400 узлов CPU и GPU. Их объём памяти превысит 10 ПиБ (Пебибайт). Агрегированная пропускная способность памяти в случае CPU-блоков составит более 7 Пбайт/с, GPU-модулей — свыше 800 Пбайт/с против 163 Пбайт/с у нынешней системы Fugaku. Кроме того, раскрываются ожидаемые показатели ИИ-быстродействия FugakuNEXT. У CPU-секции производительность превысит 48 Пфлопс в режиме FP64, 1,5 Эфлопс на операциях FP16/BF16 и 3 Эфлопс в режиме FP8. В случае GPU-раздела быстродействие FP64, FP16/BF16, FP8 и FP8 Sparse составит более 2,6 Эфлопс, 150 Эфлопс, 300 Эфлопс и 600 Эфлопс соответственно.

14.11.2025 [12:56], Руслан Авдеев

Китайская INF Tech обошла санкции США на доступ к ИИ-чипам NVIDIA Blackwell через индонезийское облакоКитайской ИИ-компании INF Tech удалось получить доступ к 2,3 тыс. ускорителей NVIDIA Blackwell благодаря соглашению с индонезийским бизнесом. Несмотря на запрет США на поставки передовых ИИ-чипов в Китай, доступ к вычислительным ресурсам всё же удалось получить, причём с соблюдением буквы американских законов, сообщает The Wall Street Journal. В целом «операция» проводится через партнёров в разных странах и с использованием всевозможных лазеек, но технически американские экспортные законы не нарушаются. Сами чипы находятся в ЦОД, спрятавшемся между частной школой и жилым комплексом в Джакарте — они легально куплены индонезийским телеком-провайдером Indosat Ooredoo Hutchison, которая потратила около $100 млн на 32 стоечных суперускорителя с NVIDIA GB200 NVL72 у компании Aivres из Кремниевой долины, занимающейся выпуском серверов. Все они теперь будут использоваться шанхайской INF Tech. История началась с продажи NVIDIA чипов компании Aivres, которая не является обычным спекулянтом-перепродавцом, а на треть принадлежит китайской Inspur, в 2023 году попавшей в чёрные списки Минторга США, якобы за причастность к суперкомпьютерным проектам китайских военных. Inspur является одним из крупнейших в мире поставщиков серверов. Чёрный список американских властей запрещает NVIDIA напрямую иметь дела с Inspur или подразделений компании, тоже занесённых в чёрные списки, но Aivres, будучи компанией американской, под ограничения не попадает. При этом особого секрета в том, что она наряду с Betapex и KAYTUS Singapore Pte прямо связана с Inspur, нет. Об этом, в частности, прямо говорится в иске HPE.

Источник изображения: David Kristianto/unsplash.com Другими словами, NVIDIA с чистой совестью продала ускорители в полном соответствии с законами, а Aivres закрыла сделку с Indosat в середине 2024 года. Сделка состоялась только после того, как Indosat нашла под чипы конкретного покупателя — INF Tech. ИИ-стартап основан в Китае в 2021 году, а его основатель Ци Юань (Qi Yuan) — профессор Фуданьского университета, бывший высокопоставленный учёный в структуре Alibaba, получивший докторскую степень в MIT и к тому же являющийся гражданином США. По некоторым данным, в обсуждении облачного контракта принимали участие и другие сотрудники Фуданьского университета. Серверы уже доставлены в ЦОД в Индонезии. Они будут использоваться для обучения ИИ-моделей в области финансов и здравоохранения, в частности, фармацевтики. Законов, запрещающих китайским компаниям арендовать доступ к облачным вычислениям за рубежом, не существует. По словам знакомых с тематикой юристов, оборудование запрещено использовать только для военной разведки или создания вооружений. Впрочем, многие американские чиновники всё равно недовольны. Утверждается, что «коммерческие» китайские проекты легко перепрофилировать для военных задач с учётом тесного сотрудничества гражданских и военных структур в КНР. Именно поэтому прошлая администрация США готовила закон, ограничивавший экспорт ИИ-технологий в страны вроде Индонезии, не относящиеся к числу верных сторонников США. В случае принятия этого закона американские компании стали бы обязаны раскрывать информацию о том, кто и почему покупает чипы и не распространяются ли на конечного пользователя ограничения. Новая администрация показала, что не желает иметь с этим законом ничего общего. В результате проверки рисков фактически возложили на NVIDIA. В INF Tech заявляют, что не связаны с военными исследованиями и действуют в соответствии с американскими законами. Теперь компания намерена развивать бизнес за пределами Китая, заключая соглашения с операторами ЦОД в Сингапуре, Малайзии и Таиланде для создания собственной ИИ-инфраструктуры. В Indosat подтвердили, что работают с многонациональными компаниями и каждый клиент, как американский, так и китайский, проходит одинаковый процесс одобрения. Также Indosat подчеркнула, что INF Tech не имеет физического доступа к оборудованию в Джакарте и только использует инфраструктуру для эксплуатации ИИ-продуктов, оптимизированных для Индонезии и Юго-Восточной Азии. По словам главы NVIDIA Дженсена Хуанга (Jensen Huang), доля компании на китайском рынке ИИ-решений упала с 95 % до нуля из-за экспортных ограничений и давно критикует власти США за недальновидность. Впрочем, китайский бизнес и ранее прибегал к использованию американских облаков или контрабандным ускорителям. Представитель NVIDIA не так давно заявлял, что ограничения на поставки уже стоили налогоплательщикам десятков миллиардов долларов, помешали инновациям и заставили уступить долю рынка зарубежным конкурентам.

14.11.2025 [10:03], Руслан Авдеев

NVIDIA ужесточит контроль над выпуском ИИ-платформ, задвинув Foxconn и других партнёров на второй планКомпания NVIDIA готовится изменить текущую бизнес-модель в контексте ИИ-серверов. Она намерена получить под свой контроль производство ИИ-платформ целиком, а не отдельные элементы цепочек поставок, сообщает Wccftech. Если обычно экосистема поставок NVIDIA опирается на партнёров, выпускающих компоненты конечных продуктов — Foxconn, Quanta (QCT) и Wistron (Wiwynn) — со своими собственными разработками, то в будущем компания фактически возьмёт под контроль всё производство вплоть до уровня стоек. До сих пор NVIDIA поставляла в основном ключевые компоненты, такие как ИИ-ускорители и системные платы вроде Bianca Port UPB. Тем не менее, в ходе отчёта Wistron за III квартал 2025 года представитель JPMorgan заявил, что компания, похоже, переходит к «прямым поставкам» полноценных систем. Если раньше NVIDIA отвечала за ключевые элементы стоек — ИИ-ускорители и платы, — то за остальную архитектуру отвечали подрядчики вроде Foxconn, Quanta и других компаний. Теперь, как полагают в JPMorgan, NVIDIA станет напрямую поставлять системы Level-10 (почти полный блок серверной стойки). Компания унифицирует конструкцию систем, заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна и запретит использование проприетарных архитектур, созданных самими подрядчиками. Фактически — это развитие философии MGX-архитектуры, предполагающей единые стандарты от серверного узла до полнофункциональной ИИ-фабрики. При этом время развёртывания таких комплексных систем сократится с 9–12 мес. до 90 дней, т.е. 3 мес. Поскольку 80 % наполнения систем будет предварительно определяться NVIDIA, новые платформы вроде Rubin/Rubin CPX можно будет внедрять ускоренными темпами. NVIDIA выиграет от быстрого вывода систем на рынок, роста маржинальности и расширения так называемого «общего адресуемого рынка» (TAM). В Wistron утверждают, что новая модель выгодна и заказчикам, поскольку ключевые работы по созданию ИИ-оборудования всё равно выполняет компания-подрядчик. В целом NVIDIA стремится перейти от роли обычного поставщика ИИ-чипов к модели, при которой IT-гигант контролирует развёртывание инфраструктуры целиком. Это как ускорит выпуск ИИ-систем, так и укрепит позиции компании. Впрочем, пока информация об изменениях поступает из сторонних источников — в самой NVIDIA её не подтверждали. При этом для гиперскейлеров, которые самостоятельно занимаются разработкой ИИ-платформ, пока, по-видимому, ничего не поменяется.

14.11.2025 [09:38], Сергей Карасёв

«За пределы экзафлопсного уровня»: Eviden представила суперкомпьютерную платформу BullSequana XH3500Компания Eviden, входящая в Atos Group, анонсировала конвергентную суперкомпьютерную платформу BullSequana XH3500 для ресурсоёмких нагрузок ИИ и HPC. Новинка сочетает передовые аппаратные решения с комплексной экосистемой ПО, обеспечивая возможность масштабирования «за пределы экзафлопсного уровня». BullSequana XH3500 использует открытую модульную конструкцию. Такой подход позволяет свободно комбинировать блоки CPU, GPU и сетевые компоненты от различных производителей, адаптируя конфигурации под определённые потребности. При этом устраняется зависимость от какого-либо конкретного поставщика оборудования, что обеспечивает полную технологическую свободу. По заявлениям Eviden, платформа BullSequana XH3500 по сравнению с системой предыдущего поколения позволяет добиться повышения электрической мощности более чем на 80 % в расчёте на 1 м2 и увеличения эффективности охлаждения на 30 % в расчёт на 1 кВт. Это даёт возможность удовлетворить растущие потребности в вычислительных ресурсах без необходимости расширения площадей в дата-центрах. Габариты стойки BullSequana XH3500 без модуля ультраконденсатора составляют 2270 × 900 × 1457 мм. Мощность AC достигает 284 кВт (с одной помпой). Задействовано на 100 % безвентиляторное прямое жидкостное охлаждение (DLC) пятого поколения с возможностью использования горячей воды с температурой до 40 °C. Подсистемы питания и охлаждения выполнены по схеме с резервированием N+1. Доступны 38 универсальных слотов 1U.

Источник изображения: Eviden Для платформы BullSequana XH3500 разработаны узлы BullSequana XH3515B и BullSequana AI1242. Первый соответствует типоразмеру 1U: это одноузловое изделие оборудовано двумя чипами NVIDIA Grace CPU и четырьмя ускорителями NVIDIA Blackwell B200. Возможна установка до девяти NVMe SSD в форм-факторе E1.S. Говорится о поддержке четырёх сетевых устройств Eviden BXI V3 или InfiniBand NDR/XDR. В свою очередь, сервер BullSequana AI1242 имеет исполнение 2U. Данное решение несёт на борту два процессора AMD EPYC Turin и GPU-ускоритель AMD Instinct MI355X. Реализована поддержка восьми устройств Eviden BXI V3 или InfiniBand NDR/XDR, а также четырёх накопителей E1.S NVMe SSD.

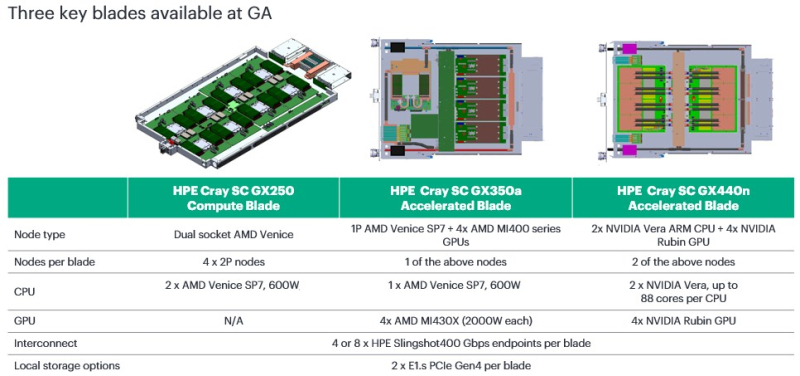

14.11.2025 [09:36], Сергей Карасёв

HPE представила CPU- и GPU-узлы суперкомпьютерной платформы Cray Supercomputing GX5000Компания HPE анонсировала новые решения для НРС-задач, являющиеся частью суперкомпьютерной платформы Cray Supercomputing GX5000. В частности, дебютировали узлы GX250 Compute Blade, GX350a Accelerated Blade и GX440n Accelerated Blade, а также высокопроизводительная СХД Storage Systems K3000. Устройство HPE Cray Supercomputing GX250 Compute Blade представляет собой CPU-сервер, оснащённый восемью процессорами AMD EPYC Venice (появятся во II половине 2026 года). В одной стойке могут быть размещены до 40 таких серверов, что обеспечивает самую высокую в отрасли плотность компоновки x86-ядер следующего поколения, говорит компания. В паре с CPU-узлами могут функционировать новые GPU-модули. Так, изделие HPE Cray Supercomputing GX350a Accelerated Blade несёт на борту один чип AMD EPYC Venice и четыре ускорителя AMD Instinct MI430X. В стойку могут устанавливаться до 28 таких серверов, что даёт в сумме 112 ускорителей MI430X. В свою очередь, HPE Cray Supercomputing GX440n Accelerated Blade содержит четыре NVIDIA Vera CPU и восемь NVIDIA Rubin GPU. Допускается монтаж до 24 подобных серверов на стойку, что обеспечивает 192 ускорителя Rubin. Все новинки оборудованы жидкостным охлаждением. СХД HPE Cray Supercomputing Storage Systems K3000 выполнена на сервере HPE ProLiant Compute DL360 Gen12. Могут устанавливаться 8, 12, 16 или 20 накопителей NVMe вместимостью 3,84, 7,68 или 15,36 Тбайт каждый. Объём памяти DRAM — 512 Гбайт, 1 или 2 Тбайт. Применяется платформа DAOS, разработанная для требовательных рабочих нагрузок, таких как анализ данных и машинное обучение. Поддерживаются технологии HPE Slingshot 200, HPE Slingshot 400, InfiniBand NDR и 400GbE. Кроме того, HPE сообщила о том, что для платформы HPE Cray Supercomputing GX5000 доступен интерконнект HPE Slingshot 400. Соответствующие коммутаторы с прямым жидкостным охлаждением наделены 64 портами на 400 Гбит/с. Возможны конфигурации с 8, 16 и 32 коммутаторами, что в сумме позволяет использовать до 512, 1024 и 2048 портов соответственно. О выборе платформы HPE Cray Supercomputing GX5000 для НРС-комплексов нового поколения уже объявили Центр высокопроизводительных вычислений Штутгартского университета (HLRS) и Центр суперкомпьютеров имени Лейбница (LRZ) Баварской академии естественных и гуманитарных наук (BADW). Кроме того, новая платформа является основой суперкомпьютера Discovery Министерства энергетики США (DOE). |

|