Материалы по тегу: nvidia

|

28.11.2025 [17:29], Владимир Мироненко

Alibaba и ByteDance натренировались тренировать передовые ИИ-модели в ЦОД Юго-Восточной АзииВедущие китайские компании, включая Alibaba и ByteDance, используют для обучения своих самых передовых больших языковых моделей (LLM) дата-центры за пределами страны по всей Юго-Восточной Азии, поскольку в Китае у них нет доступа к продвинутым ускорителям NVIDIA из-за экспортных ограничений США, пишет The Financial Times со ссылкой на информированные источники. По их словам, после введением администрацией США в апреле ограничений на продажи NVIDIA H20, предназначенных только для Китая, наблюдается устойчивая тенденция роста обучения ИИ-моделей китайских технологических компаний за рубежом. Один из операторов сингапурских ЦОД назвал такой выбор вполне очевидным: «Для обучения самых современных моделей нужны лучшие чипы, и всё это соответствует законодательству». В настоящее время в Сингапуре и Малайзии идёт бурное развитие бизнеса ЦОД, чему способствует и спрос со стороны Китая. Многие из них оснащены высокопроизводительными ускорителями NVIDIA. По словам источников, используется довольно простая схема. Китайские компании заключают договор аренды на использование зарубежных ЦОД, принадлежащих и управляемых некитайскими компаниями. Это соответствует требованиям экспортного контроля США, поскольку правило AI Diffusion rule («Правило распространения ИИ»), принятое в начале года при Джо Байдене (Joe Biden) для регулирования режима экспортного контроля ИИ-технологий и призванное закрыть эту лазейку, было отменено президентом США Дональдом Трампом в мае. Китайские компании не раз ловили на использовании зарубежных площадок — что в этом году, что в прошлом. Но есть и исключения. Например, DeepSeek обучает свои ИИ-модели, по словам осведомленных источников, внутри страны. Как сообщают источники, знакомые с ситуацией, DeepSeek удалось создать запас чипов NVIDIA до вступления в силу запретов на экспорт в США. Компания также тесно сотрудничает с китайскими производителями чипов, включая лидера отрасли Huawei, чтобы оптимизировать и разработать следующее поколение ИИ-ускорителей, сообщают источники. При этом Huawei рассматривает партнёрство с DeepSeek как стратегическую возможность для продвижения своих продуктов в КНР. За последний год ИИ-модели Qwen от Alibaba и Doubao от ByteDance получили признание в мире как одни из эффективных LLM. Qwen также получила широкое распространение среди разработчиков за пределами Китая, поскольку является open source-моделью. При этом большинство китайских компаний предпочитают использовать для обучения передовые ускорители NVIDIA, но вот для инференса, который становится всё более важным, они всё чаще обращаются к чипам местного производства. Китайские технологические компании также используют ЦОД в Юго-Восточной Азии для обслуживания своих зарубежных клиентов, поскольку те же Alibaba и ByteDance стремятся увеличить свою долю на мировом рынке облачных вычислений. Китайские компании также расширяют использование ЦОД в других регионах, например, на Ближнем Востоке. Вместе с тем, в связи с действующим в Китае запретом на вывод личных данных за пределы страны, тюнинг моделей для местных клиентов необходимо проводить в Китае, сообщили представители отрасли.

26.11.2025 [13:48], Сергей Карасёв

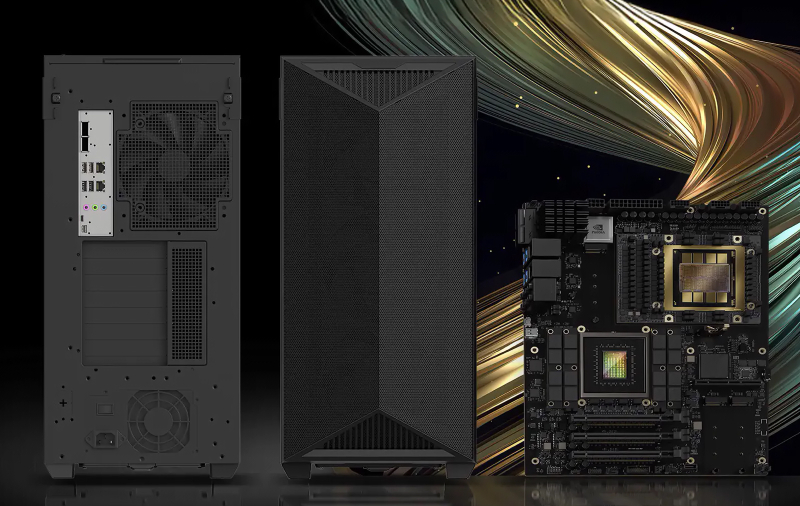

MSI представила рабочую станцию CT60-S8060 на базе NVIDIA GB300Компания MSI анонсировала мощную рабочую станцию CT60-S8060, ориентированную на ресурсоёмкие задачи в сфере ИИ, такие как обучение больших языковых моделей и инференс, а также на анализ крупных массивов данных и пр. Новинка построена на аппаратной платформе NVIDIA. В основу системы положен «персональный ИИ-суперкомпьютер» DGX Station. Используется суперчип GB300: объединены ускоритель B300 с 288 Гбайт памяти HBM3E (до 8 Тбайт/с) и процессор Grace с 72 Arm-ядрами. Присутствуют 496 Гбайт памяти LPDDR5X с пропускной способностью до 396 Гбайт/с. Блоки CPU и GPU связаны интерконнектом NVLink-C2C, который обеспечивает скорость передачи данных до 900 Гбайт/с. Рабочая станция заключена в корпус с габаритами 245 × 528,4 × 595 мм. Доступны два слота PCIe 5.0 x16 (на уровне сигналов x8 каждый) для карт расширения одинарной ширины и слот PCIe 5.0 x16 для карты двойной ширины. Кроме того, есть по два разъёма М.2 2280 с интерфейсом PCIe 5.0 x2 (NVMe) и M.2 2280 с интерфейсом PCIe 6.0 x4 (NVMe) для SSD, а также коннектор М.2 2232 (PCIe x1) для комбинированного адаптера Wi-Fi/Bluetooth. Система располагает контроллером Aspeed AST2600 BMC, сетевым адаптером NVIDIA ConnectX-8 с двумя портами 400GbE QSFP и контроллером Marvel AQC113, на основе которого реализован порт 10GbE RJ45. В тыльной части сосредоточены аудиогнёзда, порты USB Type-A и USB Type-C. Питание обеспечивает блок формата ATX мощностью 1600 Вт с сертификатом 80 PLUS Titanium.

26.11.2025 [00:54], Владимир Мироненко

Планы Meta✴ использовать ИИ-ускорители Google TPU ударили по акциям NVIDIAВо вторник рынок ценных бумаг компаний в сфере ИИ пришёл в движение после появления в понедельник публикации ресурса The Information о том, что Meta✴ ведёт переговоры с Google об использовании ИИ-ускорителей TPU в её ЦОД в 2027 году. По данным источника ресурса, стороны также обсуждают возможность аренды этих чипов в Google Cloud уже в следующем году, что являются частью более масштабной стратегии Google по привлечению клиентов к использованию TPU в её облаке. Этот шаг ознаменует собой отход от текущей стратегии Google, нацеленной на использование TPU только в собственных ЦОД, что приведёт к обострению конкуренции на многомиллиардном рынке ИИ-ускорителей, отметило агентство Reuters. В Google Cloud предположили, что эта стратегия может помочь компании получить до 10 % годовой выручки NVIDIA, т.е. миллиарды долларов, говорится в публикации The Information. Заключение сделки станет сигналом о растущем спросе на чипы Google и потенциальной возможности бросить в будущем вызов доминированию NVIDIA на рынке, тем более что Google ранее договорилась о поставке Anthropic до 1 млн чипов TPU, пишет Bloomberg. О таком развитии событий аналитики говорили ещё в прошлом году, а уже в этом году появились слухи, что Google готова предложить свои чипы другим провайдерам. Впрочем, Anthropic получила и полмиллиона фирменных ускорителей AWS Trainium. Новость о переговорах вызвала падение во вторник акций NVIDIA на 4,3 %. Акции Alphabet, материнской компании Google, выросли на 4,2 % после более чем 6 % роста в понедельник. Акции Broadcom, участвующей в разработке TPU, выросли более чем на 2 % на премаркете во вторник после роста на 11 % накануне, сообщил CNBC. «Google Cloud испытывает растущий спрос как на наши собственные TPU, так и на GPU NVIDIA; мы намерены поддерживать обе платформы, как и делали это много лет», — заявил представитель Google телеканалу CNBC. Акции AMD, ранее считавшейся наиболее реальным конкурентом NVIDIA на рынке GPU, во вторник упали на 7,5 %. Акции разработчика чипов Arm упали на 4,2 %. Акции компаний в Азии, связанных с Alphabet, выросли в начале торгов во вторник. В Южной Корее акции IsuPetasys Co., которая поставляет многослойные платы для Alphabet, подскочили на 18 %, установив новый рекорд роста в течение дня. На Тайване акции MediaTek выросли почти на 5 %. В последние месяцы Google набрала обороты, сумев привлечь Berkshire Hathaway, принадлежащую Уоррену Баффету (Warren Buffett), в качестве инвестора, превратив облачное подразделение в двигатель роста и получив высокие первые отзывы о своей новейшей модели Gemini 3. Предоставление чипов NVIDIA в аренду клиентам является крупным источником дохода для ее облачного подразделения, пишет Reuters. Чтобы справиться с доминированием NVIDIA, компании потребуется преодолеть почти двадцатилетнюю историю NVIDIA CUDA, которая затрудняет вытеснение её экосистемы. Более 4 млн разработчиков по всему миру используют CUDA для создания ИИ-приложений и других программ. Кроме того, Google должно хватать TPU на всех клиентов. Следует учесть и то, что Meta✴ разрабатывает собственные ИИ-ускорители MTIA. UPD 01.12.2025: Сайнин Се (Saining Xie), бывший сотрудник ИИ-лаборатории Meta✴ FAIR (Fundamental AI Research), сообщил, что Meta✴ использовала Google TPU как минимум с 2020 года, однако из-за малого интереса среди других разработчиков внутри компании в начале 2023 года она отказалась от контракта с Google Cloud. Примерно за год до этого Meta✴ анонсировала создание самого мощного на тот ИИ-суперкомпьютера в мире — RSC (Research SuperCluster).

24.11.2025 [12:23], Руслан Авдеев

США рассматривают продажу в Китай ИИ-ускорителей NVIDIA H200Администрация США рассматривает возможность дать «зелёный свет» продажам ИИ-чипов NVIDIA H200 в КНР — по данным источников, некоторая двухсторонняя «разрядка» способствует обсуждению продаж передовых американских технологий в Китай, сообщает Reuters. Впрочем, H200 вряд ли можно назвать «новейшими» — в ходу уже совсем другие решения. В Белом Доме отказались комментировать ситуацию, но заявили, что американская администрация стремится «обеспечению американского технологического лидерства и защите национальной безопасности». Ранее глава NVIDIA Дженсен Хуанг (Jensen Huang) предупреждал, что именно запреты на продажу передовых решений могут угрожать технологическому лидерству США в мире. Теперь в NVIDIA не прокомментировали ситуацию прямо, но заявили, что текущие правила не позволяют продавать в Китае конкурентоспособные чипы, оставляя этот рынок на откуп быстро развивающимся иностранным конкурентам. Данные источников косвенно свидетельствуют о смягчении подхода США к отношениям с Китаем после того, как китайский Лидер Си Цзиньпин (Xi Jinping) в прошлом месяце заключил «перемирие» в технологической и торговой войнах. Антикитайские политики в Вашингтоне обеспокоены тем, что поставки более передовых чипов в Китай могут помочь Пекину «перезагрузить» военную машину, именно поэтому прошлая администрация в своё время ужесточила экспортный контроль в отношении Поднебесной.

Источник изображения: NVIDIA Столкнувшись с ограничениями Пекина на экспорт редкоземельных металлов, критически важных для производства многих высокотехнологичных продуктов, в этом году США пригрозили ввести новые технологические ограничения, но в итоге отказались от них в большинстве случаев. Чипы H200 представили два года назад, они получили более быструю и ёмкую память в сравнении с оригинальными H100, что позволяет быстрее обрабатывать данные ИИ-серверами. По имеющимся оценкам, модели H200 вдвое производительнее, чем варианты H20, разрешённые для экспорта в Китай Трампом после короткого тотального запрета. В отношении ближневосточных стран, которым тоже долго не разрешали закупать ускоритли из-за опасений, что они в итоге достанутся Китаю, послабления были объявлены на днях. В частности, Министерство торговли США уже одобрило поставку в страну эквивалент до 70 тыс. чипов NVIDIA Blackwell компаниям Humain и G42 из Саудовской Аравии и ОАЭ соответственно.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

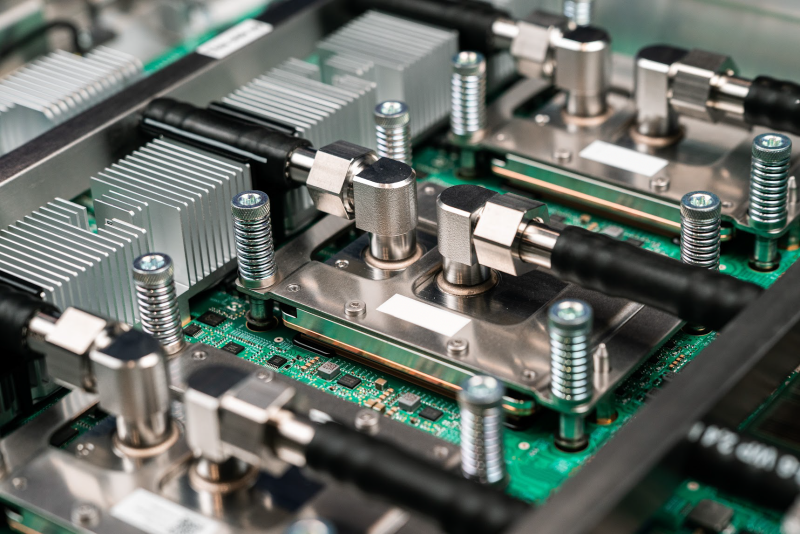

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

22.11.2025 [12:26], Сергей Карасёв

ASUS представила модульную ИИ-систему PE3000N на платформе NVIDIA Jetson Thor T5000Компания ASUS IoT, подразделение ASUS по выпуску умных устройств для интернета вещей, анонсировала компьютер PE3000N — модульную систему для периферийных ИИ-задач. Устройство выполнено в корпусе повышенной прочности в соответствии со стандартом MIL-STD-810H, а диапазон рабочих температур простирается от -20 до +60 °C. В основу новинки положен модуль NVIDIA Jetson Thor T5000. Изделие содержит CPU с 14 ядрами Arm Neoverse-V3AE (до 2,6 ГГц) и 2560-ядерный GPU на архитектуре Blackwell (до 1,57 ГГц). Имеется 128 Гбайт памяти LPDDR5X с пропускной способностью 273 Гбайт/с. ИИ-производительность достигает 2070 Тфлопс (FP4 Sparse). Встроенный VPU-блок способен осуществлять многопоточное декодирование видеоматериалов: 4 × 8Kp30 (H.265), 10 × 4Kp60 (H.265), 22 × 4Kp30 (H.265), 46 × 1080p60 (H.265), 92 × 1080p30 (H.265), 82 × 1080p30 (H.264) и 4 × 4Kp60 (H.264). Кодирование возможно в режимах 6 × 4Kp60 (H.265), 12 × 4Kp30 (H.265), 24 × 1080p60 (H.265), 50 × 1080p30 (H.265), 48 × 1080p30 (H.264) и 6 × 4Kp60 (H.264). Компьютер располагает коннектором M.2 M-key 2242/2260/2280 для SSD, разъёмом M.2 E-key 2230 для адаптера Wi-Fi/Bluetooth, коннектором M.2 B-key 3042/3052 для сотового модема 4G/5G (плюс слот для карты nano-SIM), а также разъёмом PCIe x4/x8. Есть сетевые порты 1GbE RJ45 и 10GbE RJ45, интерфейс HDMI 2.0, четыре порта USB 3.1 Type-A, по одному порту USB 3.1 Type-C и USB 3.1 Type-C OTG (OS Flash), два порт USB 2.0, аудиогнёзда на 3,5 мм. Могут быть также задействованы два последовательных порта RS-232/422/485 и четыре порта 25GbE. Реализован интерфейс MIPI CSI (16 линий; через коннектор AGX CSI) с возможностью подключения до 16 камер GMSL. Дополнительные интерфейсные модули закрепляются в нижней части компьютера. Один из таких блоков содержит шесть портов 1GbE с поддержкой PoE, другой — четыре разъёма 10GbE M12 и два коннектора Fakra для GSML-камер. Габариты системы составляют 165 × 165 × 68 мм (165 × 165 × 97 мм с модулем расширения). Возможна подача питания в диапазоне 12–60 В. В качестве программной платформы применяется Ubuntu.

21.11.2025 [17:33], Владимир Мироненко

Рекордная выручка и оптимистичный прогноз NVIDIA снизили опасения по поводу растущего ИИ-пузыряNVIDIA сообщила финансовые результаты за III квартал 2026 финансового года, завершившийся 26 октября 2025 года. Рекордная выручка и прибыль превзошли ожидания Уолл-стрит, а прогноз на IV квартал оказался выше ожиданий аналитиков. Как отметил ресурс The Guardian, внимание экспертов было приковано к отчёту NVIDIA, лидера ИИ-индустрии и самой дорогой публичной компании в мире. Аналитики и инвесторы надеялись, что прибыль производителя чипов за III квартал развеет опасения по поводу формирования пузыря в ИИ-секторе. Дженсен Хуанг (Jensen Huang), основатель и генеральный директор NVIDIA, заявил, что в сфере ИИ происходят серьёзные перемены, и NVIDIA играет в этом ключевую роль. «Много говорят о пузыре ИИ, — сказал Хуанг. — С нашей точки зрения, мы видим нечто совершенно иное. Напомним, что NVIDIA не похожа ни на одну другую компанию-акселератор. Мы превосходим всех на каждом этапе развития ИИ — от подготовки и постобучения до инференса». NVIDIA сообщила о прибыли на разводнённую акцию в размере $1,30 при общей выручке в $57,01 млрд, превысившей прошлогодний результат на 62 %, также превзойдя прогнозы аналитиков, опрошенных LSEG, ожидавших $1,25 прибыли на акцию при выручке в $54,9 млрд (по данным CNBC). В сегменте продуктов для ЦОД выручка составила $51,22 млрд, что на 66 % больше год к году и выше ожиданий аналитиков в размере $49,09 млрд. При этом выручка от поставки решений для вычислений выросла до $43,03 млрд с $28,64 млрд годом ранее. Компания заявила, что рост во многом был обусловлен продажами ускорителей GB300, а финансовый директор NVIDIA Колетт Кресс (Colette Kress) сообщила, что самым продаваемым семейством чипов компании теперь является Blackwell Ultra. Выручка от продаж сетевого оборудования выросла за квартал на 262 % до $8,19 млрд. «Продажи Blackwell зашкаливают, а облачные GPU распроданы, — сообщил Хуанг в квартальном отчёте. — Спрос на вычислительные мощности продолжает расти и усложняться, как в сфере обучения, так и в сфере инференса, причём каждый растёт экспоненциально. Мы вступили в благотворный цикл развития ИИ. Экосистема ИИ быстро масштабируется — появляются новые разработчики базовых моделей, стартапы в сфере ИИ, присоединяются всё больше отраслей и стран. ИИ проникает повсюду, делает всё и сразу». Хуанг отметил три крупных изменения в платформе: переход от вычислений общего назначения к ускоренным вычислениям; переход к генеративному ИИ и переход к агентному и физическому ИИ, например, роботам или автономным транспортным средствам. По его словам, это следует учитывать при рассмотрении инвестиций. Каждая из этих фундаментальных тенденций будет способствовать развитию инфраструктуры. И NVIDIA обеспечивает все три перехода, причем для любой формы или модальности ИИ, говорит Хуанг. Кресс заявила, что компании не удалось реализовать значительные заказы на закупку в этом квартале из-за геополитических проблем и растущей конкуренции на китайском рынке. «Хотя мы разочарованы текущей ситуацией, которая не позволяет нам поставлять в Китай более конкурентоспособные вычислительные решения для ЦОД, мы стремимся к дальнейшему взаимодействию с правительствами США и Китая и будем продолжать отстаивать способность Америки конкурировать по всему миру», — отметила она. В числе других направлений деятельности NVIDIA, выручка от игрового бизнеса за квартал выросла год к году на 30 % до $4,27 млрд. Автомобильное и робототехническое подразделение компании увеличило продажи год к году на 32 % до $592 млн. В сегменте профессиональной визуализации продажи выросли на 26 % до $760 млн. Комментируя финансовые результаты NVIDIA, Томас Монтейро (Thomas Monteiro), старший аналитик Investing.com, выразил мнение, что ИИ-революция далека от своего пика. «В то время как инвесторы опасаются, что рост капитальных затрат вынудит компании замедлить циклы внедрения ИИ, NVIDIA продолжает доказывать, что масштабирование ЦОД — это не опциоя, а скорее основная потребность для любого технологического бизнеса в мире». NVIDIA прогнозирует выручку в IV финансовом квартале в размере $65 млрд ± 2 %. Согласно прогнозу аналитиков, опрошенных LSEG, выручка за текущий квартал составит $61,66 млрд. Стивен Иннес (Stephen Innes) из SPI Asset Management заявил, что оптимистичный прогноз NVIDIA приглушил опасения по поводу ИИ-пузыря. «Но не заблуждайтесь: рынок всё ещё балансирует на грани между эйфорией от ИИ и реальностью, полной долгов», — предупредил он. «Я не верю в то, что рост NVIDIA будет устойчивым в долгосрочной перспективе», — говорит старший аналитик Forrester Элвин Нгуен (Alvin Nguyen). «Спрос на ИИ беспрецедентен, но если произойдет коррекция рынка из-за удовлетворения спроса предложением или замедления темпов инноваций/привыкания бизнеса к этим темпам, я ожидаю, что дальнейший рост стоимости акций Nvidia замедлится», — прогнозирует он. Согласно отчёту 10-Q для Комиссии по ценным бумагам и биржам США (SEC), к концу октября NVIDIA заключила многолетние соглашения на предоставление облачных услуг на общую сумму $26 млрд. Указанная сумма будет выплачена в течение ближайших шести лет. При этом многие провайдеры облачных услуг, с которыми заключены эти контракты, являются крупными клиентами самой NVIDIA, например, Lambda ($1,5 млрд на лизинг ускорителей) и CoreWeave ($6,3 млрд за нераспроданные мощности). Компания отметила, что некоторые из соглашений могут быть «сокращены, расторгнуты или проданы другим поставщикам услуг», что уменьшит её обязательства. Ожидается, что эти соглашения помогут в «исследовательской и опытно-конструкторской деятельности и предложениях DGX Cloud».

21.11.2025 [14:14], Руслан Авдеев

AWS и Humain построят в Эр-Рияде кампус AI Zone, где развернут до 150 тыс. ИИ-ускорителей NVIDIA GB300 и Amazon TrainiumAWS и инвестиционная компания Humain из Саудовской Аравии объявили о планах развёртывания в кампусе AI Zone в Эр-Рияде до 150 тыс. ИИ-ускорителей. В рамках расширенного партнёрства компании намерены предоставлять вычислительные мощности и ИИ-сервисы из Саудовской Аравии клиентам со всего мира. Первый в своём роде в Саудовской Аравии кампус AI Zone будет применяться для обучения ИИ и инференса, с доступом к новейшей ИИ-инфраструктуре на основе ускорителей NVIDIA GB300 и Amazon Trainium. Клиенты смогут быстро переходить от стадии концепции к непосредственно работам, а «железо» и ПО NVIDIA будут бесшовно интегрированы с инфраструктурой и сервисами AWS. Поддержка Amazon Bedrock, AgentCore и SageMaker обеспечит клиентам немедленный доступ к базовым моделям в рамках единой платформы без необходимости управления базовой инфраструктурой. Для расширения возможностей AI Zone компания Humain присоединится к программе AWS Solution Provider Program. Это поможет реализации совместного плана, анонсированного в мае 2025 года и предусматривающего инвестиции более $5 млрд в ИИ-инфраструктуру, сервисы AWS, обучение и развитие ИИ-специалистов в Саудовской Аравии. Представитель AWS в регионе EMEA заявил, что объединяя локальный опыт и инвестиции Humain с решениями AWS в сфере ИИ, а также аппаратные решения NVIDIA, инновационную платформу Amazon Bedrock и решения для бизнес-пользователей, включая Amazon Quick Suite, партнёры создают инновационный центр мирового уровня, способный обслуживать клиентов по всему миру. AWS и Humain также ускорят внедрение ИИ в государственном и частном секторах, в том числе развитие LLM с поддержкой арабского языка, включая ALLAM, и создание единого маркетплейса ИИ-агентов для правительственных сервисов.

Истчоник изображения: backer Sha/unsplash.com Для подготовки квалифицированных кадров AWS обучит 100 тыс. граждан Саудовской Аравии работе с облачными технологиями и специфике генеративного ИИ в рамках программы Amazon Academy, отдельно планируется поддержать программу повышения квалификации для 10 тыс. женщин. Усилия направлены на подготовку кадров для «ИИ-центричной» экономики, которая, по прогнозам, к 2030 году внесёт в ВВП страны вклад в объёме $130 млрд. Подобные проекты стали возможны во многом благодаря визиту в США наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman). Визит способствовал ряду соглашений американских компаний с саудовским бизнесом и Humain в частности — с участием AMD, xAI, NVIDIA и др., а также открыл дорогу для поставок в королевство передовых ИИ-чипов.

21.11.2025 [12:54], Руслан Авдеев

США одобрили экспорт передовых ИИ-чипов в Саудовскую Аравию, ОАЭ и АрмениюСоединённые Штаты одобрили поставки передовых чипов NVIDIA компании Humain из Саудовской Аравии, а также компании G42 из ОАЭ. Поддерживаемые на государственном уровне компании приобретут до 35 тыс. чипов общей стоимостью $1 млрд, сообщает CNBC. Новое соглашение свидетельствует о крупных изменениях политики США, ранее не желавших прямых поставок ИИ-ускорителей компаниям стран Залива, за которыми стоят государственные структуры. Экспортный контроль вводили, чтобы передовые американские технологии не утекли в Китай. Прошлая администрация последовательно вводила всё новые ограничения поставок, тогда как новая стремится шире распространять американские технологии, для продвижения дальнейшего доминирования США и сохранения глобального технологического лидерства. Министерство торговли подтвердило, что экспорт чипов будет осуществляться с учётом принципов безопасности и строгой отчётности, контролем займётся Бюро промышленности и безопасности министерства. Разрешение на экспорт дали после визита в Вашингтон наследного принца Саудовской Аравии Мохаммеда бин Салмана (Mohammed bin Salman), королевство пообещало инвестировать в США $1 трлн. Ранее, в ходе майского визита Трампа в страны Залива, речь шла лишь о 600 млрд.

Источник изображения: NEOM/unspalsh.com Саудовская ИИ-компания Humain поддерживается королевским Фондом государственных инвестиций (Public Investment Fund), она подписала соглашения с Adobe, Qualcomm, AMD, Cisco, GlobalAI, Groq, Luma и xAI в ходе инвестиционного форума в Вашингтоне. Humain построит совместно с xAI дата-центр на 500 МВт в Саудовской Аравии. В Humain утверждают, что в 2026 году намерены сделать в королевстве столько, сколько было сделано за предыдущие 20 лет, и рассчитывают, что Саудовская Аравия станет третьим по величине ИИ-хабом в мире после США и Китая. По словам экспертов, у Humain и G42 имеется капитал для инвестиций, связи с NVIDIA и американским правительством. Компании могут воспользоваться этими преимуществами для строительства региональной ИИ-инфраструктуры и хотят использовать её для превращения Персидского Залива в вычислительный хаб. Стоит отметить, что всего пару недель назад Microsoft получила лицензию на экспорт передовых чипов в ОАЭ. Ключевым партнёром компании в стране является G42, но до сегодняшнего дня о поставках чипов именно ей Microsoft не сообщала.

Источник изображения: Gevorg Avetisyan/unsplash.com Тем временем, некоторые преференции от США получила и ещё одна страна — Армения, сообщает Bloomberg. В частности, ИИ-стартапу Firebird разрешили импортировать ускорители NVIDIA в рамках суперкомпьютерного проекта. Речь идёт о 100-МВт объекте, для строительства которого в регион привлекут $500 млн. Он будет использовать серверы Dell и ускорители NVIDIA Blackwell, первая очередь проекта должна заработать во II квартале 2026 года. Во времена последних нормативов Байдена, касавшихся ИИ-чипов, страна относилась ко «второму эшелону» государств по уровню ограничений, наряду с Израилем, Саудовской Аравией и Польшей. Впрочем, при Трампе эту градацию отменили. Приблизительно 20 % мощностей Firebird будет выделено армянским компаниям, остальные 80 % — бизнесам американского происхождения. Компания Firebird из Сан-Франциско была основана в 2025 году и сейчас насчитывает 25 сотрудников. Она ориентируется на строительство ЦОД на «чистой» энергии для развивающихся рынков, и уже ведёт переговоры в некоторых других странах, включая государства Латинской Америки. Экспансия на другие рынки запланирована не ранее 2027 года, пока компания намерена убедиться в успехе начинания в Армении. Впрочем, она уже ведёт переговоры с представителями Министерства торговли США о получении разрешений для прочих развивающихся рынков.

20.11.2025 [16:26], Руслан Авдеев

Brookfield, NVIDIA и партнёры направят $100 млрд на развитие ИИ-инфраструктуры и энергетикиУправляющая альтернативными активами компания Brookfield Asset Management совместно с NVIDIA запустила проект развития ИИ-инфраструктуры стоимостью $100 млрд. В число партнёров вошла Kuwait Investment Authority (KIA), сообщает Reuters. В основе программы — новый фонд Brookfield Artificial Intelligence Infrastructure Fund (BAIIF), целевой объём инвестиций в акционерный капитал составляет $10 млрд. Фонд уже сумел привлечь $5 от инвесторов, включая саму Brookfield, NVIDIA и KIA. По данным Brookfield, фонд купит связанные с ИИ-инфраструктурой активы на сумму до $100 млрд, включая энергетические мощности, землю, дата-центры и вычислительные мощности при поддержке дополнительных источников финансирования. Brookfield является одним из крупнейших в мире инвесторов в цепочку создания стоимости, связанную с ИИ. Компания потратила по всему миру более €100 млрд ($115,83 млрд) на цифровую инфраструктуру, возобновляемую энергетику и выпуск полупроводников. Активное внедрение ИИ стимулирует и спрос на инвестиции в соответствующую инфраструктуру, в т.ч. дата-центры, HPC и генерацию электроэнергии. Компании стремятся обеспечить мощности для ресурсоёмких ИИ-проектов. По словам Brookfield, ИИ потребует от мира реализации одного из самых масштабных инфраструктурных проектов в истории и в ближайшие годы соответствующие работы обойдутся в $7 трлн.

Источник изображения: Sean Pollock/unsplash.com Изначальные инвестиции фонда включают финансирование рамочного соглашения с Bloom Energy на сумму $5 млрд для установки источников электропитания мощностью до 1 ГВт для дата-центров и ИИ-фабрик. Инвестиция в энергетическую инфраструктуру обеспечит стабильное энергоснабжение энергоёмких объектов ИИ, минуя общественные сети. Ранее в 2025 году Brookfield объявила о намерении инвестировать до kr95 млрд ($10,01 млрд) в ИИ ЦОД в Швеции и выделила €20 млрд на ИИ-проекты во Франции. Конкурирующая BlackRock сформировала аналогичный фонд AI Infrastructure Partnership (AIP), ранее известный как Global AI Infrastructure Investment Partnership (GAIIP), который также вложит до $100 млрд ($30 млрд на первом этапе) в ИИ-инфраструктуру и смежные области. В AIP входят Microsoft, Global Infrastructure Partners (GIP, принадлежит BlackRock), дубайская государственная инвесткомпания MGX (создана Mubadala и G42), NVIDIA, xAI и всё тот же фонд Kuwait Investment Authority (KIA). |

|