Материалы по тегу: nvidia

|

08.12.2025 [09:48], Сергей Карасёв

Вышел мини-компьютер AAEON Boxer-8651AI-Plus на платформе NVIDIA Jetson Orin NXКомпания AAEON представила компьютер небольшого форм-фактора Boxer-8651AI-Plus, спроектированный для выполнения ИИ-задач на периферии (Edge AI). Устройство может эксплуатироваться в неблагоприятных условиях, включая повышенные вибрации и температуры от -25 до +55 °C. В основу положена платформа NVIDIA Jetson Orin NX: доступны модификации с 8 и 16 Гбайт памяти LPDDR5. В первом случае в состав решения входят шесть CPU-ядер Arm Cortex-A78AE, во втором — восемь. Обе версии несут на борту графический блок на архитектуре NVIDIA Ampere с 1024 ядрами. Благодаря поддержке Jetpack 6.2 реализован режим Super Mode, повышающий ИИ-производительность на операциях INT8 (Sparse) со стандартных 100 до 157 TOPS. Компьютер оснащён разъёмами M.2 3042/3052 B+M Key для SSD или модема 4G/5G (плюс слот для SIM-карты) и M.2 2230 E Key для адаптера Wi-Fi/Bluetooth. Доступны четыре порта USB 3.2 Gen2 Type-A, последовательный порт RS-232 (Rx/Tx/CTS/RTS), коннектор Micro-USB, интерфейс HDMI 1.2 с поддержкой разрешения до 1920 × 1080 точек, сетевой порт 1GbE RJ45, а также гнёзда для подключения антенн беспроводной связи. Новинка заключена в корпус с размерами 125 × 90 × 56 мм. Применено пассивное охлаждение; ребристая поверхность способствует более эффективному рассеянию тепла. Масса составляет 0,84 кг. Питание в диапазоне 12–24 В подаётся через 2-контактный разъём. Возможен монтаж компьютера на стену. За безопасность отвечает модуль TPM 2.0.

05.12.2025 [17:29], Руслан Авдеев

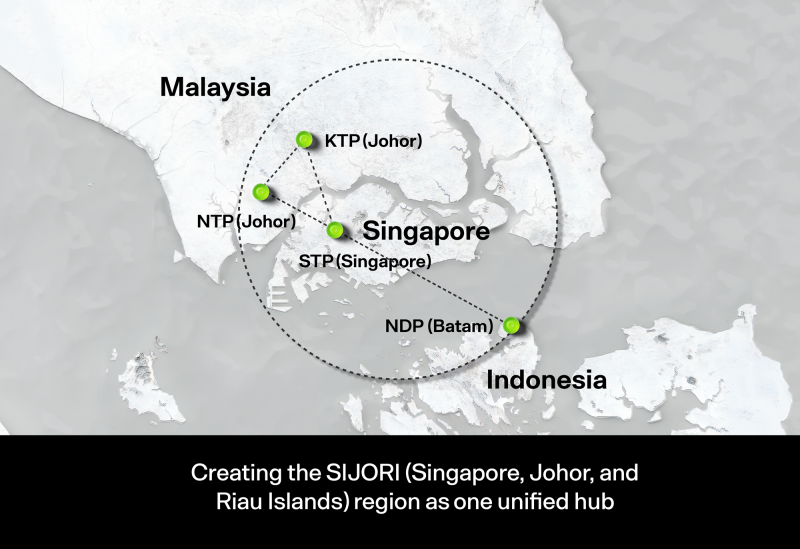

Малайзия стала на шаг ближе к ИИ-суверенитету — запущен 600-МВт дата-центр с суперускорителями NVIDIAМалайзия сделала очередной важный шаг на пути достижения суверенитета в области технологий искусственного интеллекта. В Кулае (Kulai, штат Джохор) введена в эксплуатацию первая очередь дата-центра на основе технологий NVIDIA мощностью 600 МВт, сообщает Converge! Digest. Это позволит существенно снизить зависимость от иностранной ИИ-инфраструктуры. Построенный совместно с NVIDIA и YTL Power International (YTLP) центр находится на территории принадлежащего последней технопарка Green Data Center Park. Объект оснастили ИИ-системами NVIDIA GB200 NVL72 для обучения крупных ИИ-моделей и корпоративного инференса. Запуск последовал за дебютом малайзийской ИИ-модели ILMU — первого национального варианта LLM, разработанного в самой стране. Это свидетельствует о желании малайзийского правительства развивать собственные ИИ-компетенции, а не полагаться исключительно на сторонних поставщиков облачных услуг. При этом под давлением США выбор был сделан в пользу американских, а не китайских технологий.

Источник изображения: Ven Jiun (Greg) Chee/unsplash.com Дата-центр укрепляет долгосрочные амбиции страны по превращению в ведущий ИИ-хаб АСЕАН к 2030 году. Власти подчёркивали стратегическую важность суверенных вычислений в ходе недавних переговоров с главой NVIDIA Дженсеном Хуангом (Jensen Huang). В бюджете на 2026 год выделено RM5,9 млрд (более $1,4 млрд) на расширение ИИ-инфраструктуры, масштабирование внедрения ИИ в промышленности и повышение цифровой конкурентоспособности в производстве, телеком-секторе и сфере услуг. Развитие инфраструктуры соответствует общей динамике развития региона, в т.ч. речь про крупные инвестиции в Джохоре и его окрестностях. В настоящее время регион является одним из самых быстрорастущих хабов ЦОД в Юго-Восточной Азии. Всё новые и новые проекты ЦОД указывают на устойчивый спрос на мощности, близость к IT-экосистеме Сингапура и выгодные условия в области энергетики. Конкуренцию Малайзии пытается составить Индонезия. Малайзия определяет создание суверенных вычислительных мощностей и государственно-частное партнёрство как основные принципы стратегии развития цифровой индустрии. Как считают в Converge! Digest, действия Малайзии отражает аналогичные инвестиции в ИИ-вычисления, основанные на принципах суверенитета, осуществляющиеся в Сингапуре, Индонезии, Южной Корее, Японии и на Ближнем Востоке. Повсеместно страны создают специальные кластеры ускорителей для поддержки ИИ-индустрии. Укрепление партнёрства NVIDIA с поддерживаемыми государствами игроками в области ИИ от Сингапура до Саудовской Аравии отражает и растущий спрос на локализованные мощности и специализированные стоечные архитектуры. По мере развития ИИ-проектов в Джохоре Малайзия становится крупным ИИ-хабом с конкурентоспособными ценами в региональной гонке за развитие инфраструктуры. В августе сообщалось, что во II квартале 2025 года штат Джохор (Малайзия) одобрил 42 проекта строительства ЦОД.

04.12.2025 [23:59], Владимир Мироненко

$100-млрд мегасделка NVIDIA и OpenAI дальше громких заявлений пока так и не продвинуласьСпустя два месяца с момента подписания NVIDIA и OpenAI соглашения о намерениях, согласно которому NVIDIA инвестирует в OpenAI до $100 млрд, предоставив ей в аренду ускорители для развёртывания ИИ-инфраструктуры мощностью не менее 10 ГВт, выяснилось, что окончательная сделка до сих пор не подписана, сообщил ресурс Fortune. Исполнительный вице-президент и финансовый директор NVIDIA Колетт Кресс (Colette Kress) на конференции UBS Global Technology and AI Conference в Скоттсдейле (Scottsdale), сообщила инвесторам, что партнёрство с OpenAI по-прежнему находится на стадии согласования. «Мы до сих пор не заключили окончательное соглашение», — заявила Кресс в ответ на вопрос о том, какая часть обязательств NVIDIA фактически зафиксирована договором. С учётом того, что генеральный директор NVIDIA Дженсен Хуанг (Jensen Huang) однажды назвал сделку «крупнейшим проектом инфраструктуры ИИ в истории», такой ответ вызывает новые вопросы. По оценкам аналитиков, сделка может принести NVIDIA до $500 млрд выручки. Вместе с объявлением в сентябре о партнёрстве, компании представили план по развёртыванию миллионов ускорителей NVIDIA в течение нескольких лет, подкрепленный мощностями ЦОД до 10 ГВт и обещанием NVIDIA инвестировать в OpenAI до $100 млрд по мере реализации проекта. Эта новость способствовала росту рынка ИИ-инфраструктуры, подняв акции NVIDIA на 4 % и укрепив общее мнение о тесном сотрудничестве двух компаний. Как отметил Fortune, неясно, почему сделка не была заключена, но последний отчёт NVIDIA по 10-Q дает некоторые подсказки. В документе прямо указано, что «нет никаких гарантий, что какие-либо инвестиции будут осуществлены на ожидаемых условиях, если вообще будут», подразумевая не только соглашение по OpenAI, но и запланированные инвестиции NVIDIA в размере $10 млрд в Anthropic, $5 млрд в Intel и $2 млрд в Synopsys. Следует отметить, что фраза об отсутствии гарантий по будущей сделке является стандартной формулировкой, которую добавляют в 10-Q, говоря о планируемых сделках и не только. В разделе «Факторы риска» NVIDIA подробно описывает сложность реализации подобных мегасделок. NVIDIA вынуждена заказывать ускорители, память, сетевое оборудование и другие компоненты более чем за год вперёд, часто по неотменяемым предоплаченным контрактам. NVIDIA предупреждает, что в случае сокращения объёмов, задержки финансирования или изменения направления развития, у неё могут возникнуть «избыточные запасы», «штрафы за отмену заказа» или т.п. В документе отмечается, что прошлые несоответствия между спросом и предложением «значительно навредили её финансовым результатам». NVIDIA сообщила, что наличие «мощностей ЦОД, энергии и капитала» критически важно для клиентов, чтобы развернуть ИИ-системы, которые они устно обязались использовать. Наращивание мощности описывается как «многолетний процесс», который сталкивается с «нормативными и техническими проблемами, а также проблемами строительства». Компания предупреждает, что если клиенты не смогут получить достаточное количество электроэнергии или финансирования, это может «задержать внедрение технологий или сократить масштабы» развёртывания. NVIDIA также признала, что её собственные темпы инноваций затрудняют планирование. Компания перешла на ежегодный цикл выпуска новых архитектур — Hopper, Blackwell, Vera Rubin, — продолжая при этом поддерживать предыдущие поколения. Она отметила, что более высокие темпы развития архитектуры «могут усугубить трудности» с прогнозированием спроса и привести к «снижению спроса на продукты текущего поколения». Эти разъяснения NVIDIA подкрепляют предостережения «медведей» на ИИ-рынке, таких как известный мастер «игры на понижение» Майкл Берри (Michael Burry), который утверждает, что NVIDIA и другие производители чипов чрезмерно продлевают срок службы своих чипов и что их последующее обесценивание приведёт к сбоям в инвестиционном цикле. В ответ на такие обвинения Хуанг заявил, чипы шестилетней давности всё ещё работают на полную мощность. Кроме того, NVIDIA по аналогии с прошлыми циклами подъёмов и спадов рынка, связанными с «модными» вариантами использования, такими как майнинг криптовалют, предупредила, что новые рабочие нагрузки могут спровоцировать аналогичные всплески и спады, которые трудно предугадать, и могут наводнить серый рынок подержанными GPU. Хотя сделку пока не заключили, и теперь неясно, будет ли она подписана, Кресс подчеркнула, что отношения NVIDIA с OpenAI остаются «очень прочным партнёрством», длящимся уже более десяти лет. По её словам, OpenAI считает NVIDIA своим «предпочтительным партнёром» в сфере вычислений. Кресс также добавила, что сделка по OpenAI не входит в прогноз NVIDIA по поставкам GPU для ЦОД на 2025–2026 гг. на сумму $500 млрд. На данный момент закупки ускорителей для OpenAI осуществляются опосредованно, через облачных партнёров, а не по новому прямому соглашению с NVIDIA, указанному в протоколе о намерениях. OpenAI «хочет выйти на прямой контракт», отметила Кресс. «Но, опять же, мы всё ещё работаем над окончательным соглашением», — добавила она. В ответ на вопрос, влияет ли рост популярности Google TPU как потенциального конкурента ускорителям NVIDIA на лидерство компании на рынке, Кресс заявила: «Абсолютно нет». «Сейчас мы сосредоточены на том, чтобы помочь не только разработчикам моделей, но и множеству предприятий, предлагая полный пакет решений», — сказала она. По её словам, конкурентным преимуществом NVIDIA является не какой-то отдельный чип, а вся платформа в целом: аппаратное обеспечение, CUDA и постоянно расширяющаяся библиотека ПО. Именно благодаря этому стеку старые архитектуры по-прежнему широко используются, даже с переходом на Blackwell в качестве нового стандарта. «Все работают на нашей платформе, — сказала Кресс. — Все модели работают на нашей платформе, как в облаке, так и локально». Представитель OpenAI не стал комментировать ситуацию с подписанием сделки, но указал на слова Хуанга во время телефонной конференции, который говорил об OpenAI как о «компании, появляющейся раз в поколение», и его ожидание того, что инвестиции в OpenAI «приведут к необычайной доходности», пишет CNBC.

04.12.2025 [09:48], Владимир Мироненко

Частное ИИ-облако под ключ: Amazon представила AWS AI Factory для развёртывания в собственных ЦОД заказчиковAmazon представила AWS AI Factory — выделенную ИИ-инфраструктуру, включающую ускорители NVIDIA, чипы Trainium, а также сетевые решения, хранилища и базы данных AWS, которую можно развернуть в собственных ЦОД клиентов, обеспечивая их потребность в реализации суверенитета и соблюдении нормативных требований. «Клиенты могут использовать пространство своего существующего ЦОД, сетевое подключение и электроэнергию, в то время как AWS берет на себя все сложности развёртывания и управления интегрированной инфраструктурой», — пояснила компания. AWS отметила, что организации в регулируемых отраслях и государственном секторе при развёртывании своих масштабных проектов в сфере ИИ сталкиваются с проблемой их размещения в соответствующей требованиям инфраструктуре. Создание собственной ИИ-инфраструктуры требует значительных капиталовложений в покупку ускорителей, (до-)оснащение ЦОД и электроэнергию, а также сложных циклов закупок, выбора ИИ-модели для конкретного сценария использования и лицензирования моделей у разных поставщиков ИИ-технологий. Это требует много времени и усложняет эксплуатацию, отвлекая клиентов от основных бизнес-целей. AWS AI Factory позволяет решить эту проблему путём развёртывания готовой к использованию выделенной ИИ-инфраструктуры AWS в собственных дата-центрах клиентов. AWS AI Factory функционирует как частный облачный регион AWS, предоставляя безопасный доступ с низкой задержкой к вычислительным ресурсам, хранилищу данных, базам данных и ИИ-сервисам AWS для обучения и инференса ИИ-моделей. Кроме того, предоставляются управляемые сервисы, обеспечивающие доступ к ведущим базовым моделям без необходимости заключения отдельных контрактов с их поставщиками. Всё это помогает организациям соблюдать требования безопасности, суверенитета данных и нормам обработки и хранения данных, экономя усилия по развёртыванию и управлению инфраструктурой. Компания отметила, что AWS AI Factory разработаны в соответствии со строгими стандартами безопасности AWS, обеспечивая выполнение самых важных рабочих нагрузок на всех уровнях секретности: «Несекретно», «Конфиденциально», «Секретно» и «Совершенно секретно». AWS AI Factory — совместный проект AWS и NVIDIA, благодаря чему клиенты получат доступ к ПО NVIDIA и множеству приложений с ускорением на базе GPU. AWS Nitro и EC2 UltraClasters поддерживают платформы Grace Blackwell и Vera Rubin. AWS и NVIDIA также сотрудничают в рамках стратегического партнёрства с HUMAIN из Саудовской Аравии. AWS создаёт в Саудовской Аравии первую в своём роде «Зону искусственного интеллекта» (AI Zone) в кампусе HUMAIN, включающую до 150 тыс. ИИ-чипов, в том числе ускорители NVIDIA GB300 и Amazon Trainium, выделенную ИИ-инфраструктуру и ИИ-сервисы AWS.

03.12.2025 [13:40], Руслан Авдеев

ИИ-столбы: британский стартап Conflow Power разместит NVIDIA Jetson в уличных фонаряхБританский стартап Conflow Power Group намерен разместить ИИ-оборудование в уличных фонарях. Речь идёт об «умных» фонарях компании iLamp, которые дооснастят вычислительными модулями NVIDIA Jetson, сообщает Datacenter Dynamics. Базовый вариант модели сегодня обойдётся в £7,5 тыс. ($9,9 тыс.). Компания заявляет, что покупатели могли бы зарабатывать сами, требуя плату с ИИ-провайдеров за использование ИИ-оборудования. Ранее в 2025 году Conflow Power анонсировала проект iLamp — обычный фонарный столб, дополненный солнечными панелями и аккумуляторами. Кроме того, конструкция предусматривала поддержку 5G и Wi-Fi, модули управления дорожным движением, видеонаблюдение, датчики контроля окружающей среды и прочие компоненты. Для работы собственно iLamp требуется 80 Вт, но внешнее оборудование вроде Jetson сможет получать до 200–260 Вт.

Источник изображения: Conflow Power Group Conflow Power даже заявляет, что классические ЦОД можно заменить на iLamps, оснащённые модулями NVIDIA Jetson. Фактически речь идёт о создании распределённого дата-центра — экологически безопасного, не требующего водных ресурсов и с низкой задержкой, поскольку серверы находятся рядом с пользователями, говорит компания. По имеющимся данным, Conflow уже ведёт переговоры с несколькими компаниями и даже правительствами о внедрении новой технологии. Ранее в этом году бельгийский стартап Tonomia объявил о сотрудничестве с британским поставщиком ИИ-оборудования Panchaea для формирования eCloud — распределённой ИИ-платформы, размещаемой в системах солнечных панелей на автопарковках. Правда, eCloud предполагает использование более традиционных edge-серверов, а не Jetson AGX Thor или IGX Thor.

03.12.2025 [01:28], Владимир Мироненко

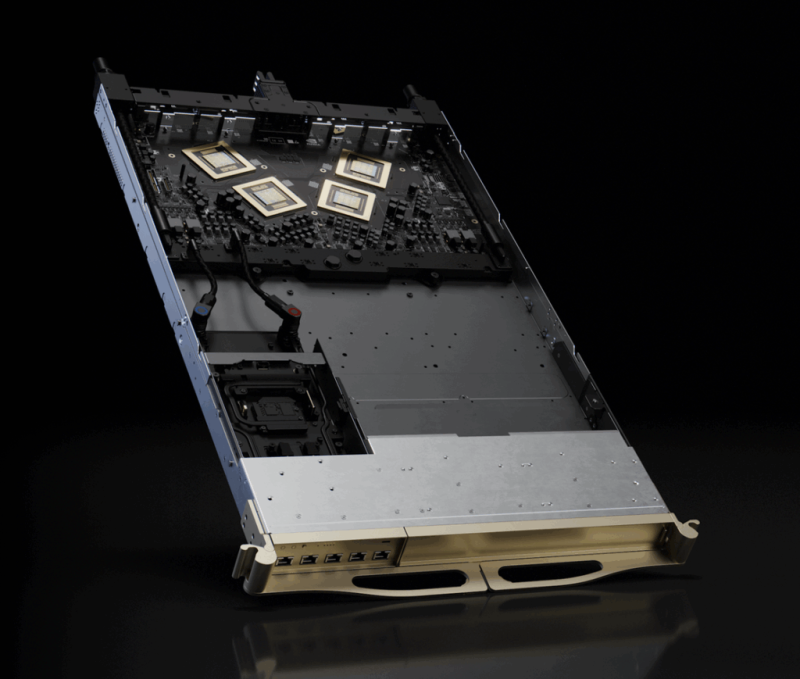

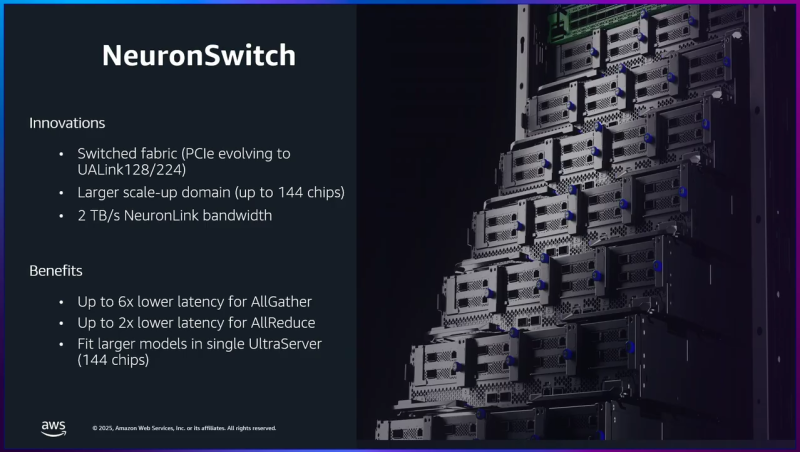

AWS «сдалась на милость» NVIDIA: анонсированы ИИ-ускорители Trainium4 с шиной NVLink FusionAWS готовит Arm-процессоры Graviton5, которые составят компанию ИИ-ускорителям Trainium4 с интерконнектом NVLink Fusion, фирменными EFA-адаптерам и DPU Nitro 6 с движком Nitro Isolation Engine. Но что более важно, все они будут «упакованы» в стойки стандарта NVIDIA MGX. Amazon и NVIDIA объявили о долгосрочном партнёрстве, в рамках которого ИИ-ускорители Trainium4 получит шину NVIDIA NVLink Fusion шестого поколения (по-видимому, 3,6 Тбайт/с в дуплексе), которая позволит создать стоечную платформу нового поколения, причём, что интересно, на базе архитектуры NVIDIA MGX, которая передана в OCP. Пикантность ситуации в том, что AWS годами практически игнорировала OCP, самостоятельно создавая стойки, их компоненты, включая СЖО, и архитектуру ИИ ЦОД в целом. Даже в нынешнем поколении стоек с GB300 NVL72 отказалась от референсного дизайна NVIDIA. NVIDIA же напирает на то, что для гиперскейлерам крайне трудно заниматься кастомными решениями — циклы разработки стоечной архитектуры занимают много времени, поскольку помимо проектирования специализированного ИИ-чипа, гиперскейлеры должны озаботиться вертикальным и горизонтальным масштабированием, интерконнектами, хранилищем, а также самой конструкцией стойки, включая лотки, охлаждение, питание и ПО.

Источник изображения: NVIDIA Вместе с тем управление цепочкой поставок отличается высокой сложностью, так как требуется обеспечить согласованную работу десятков поставщиков, ответственных за десятки тысяч компонентов. И даже одна задержка поставки или замена одного компонента может поставить под угрозу весь проект. Платформа NVIDIA если не устраняет целиком, то хотя бы смягчает эти проблемы, предлагая готовые стандартизированные решения, которые могут поставлять множество игроков рынка. По словам NVIDIA, в отличие от других подходов к масштабированию сетей, NVLink — проверенная и широко распространённая технология. В сочетании с фирменным ПО NVLink Switch обеспечивает увеличение производительности и дохода от ИИ-инференса до трёх раз, объединяя 72 ускорителя в одном домене. Пользователи, внедрившие NVLink Fusion, могут использовать любую часть платформы — каждый компонент может помочь им быстро масштабироваться для удовлетворения требований интенсивного инференса и обучения моделей агентного ИИ, говорит NVIDIA. Что касается самих ускорителей Trainium4, то в сравнении с Trainium3 они будут вшестеро быстрее в FP4-расчётах, втрое быстрее в FP8-вычислениях, а пропускная способность памяти будет увеличена вчетверо. Впрочем, пока собственные ускорители Amazon не всегда могут составить конкуренцию чипам NVIDIA. Любопытно и то, что в рассказе о Trainium3 компания отметила о переходе от PCIe к UALink в коммутаторах NeuronSwitch для фирменного интерконнекта NeuronLink, объединяющего до 144 чипов Trainium. Однако после крупных инвестиций NVIDIA в Synopsys развитие UALink как открытой альтернативы NVLink теперь под вопросом.

02.12.2025 [18:20], Сергей Карасёв

Российская ИИ-система Delta Sprut XL поддерживает до 25 GPU

delta computers

gpu

granite rapids

h200

hardware

intel

nvidia

ocp

rtx

sierra forest

xeon

ии

сделано в россии

сервер

Российская компания Delta Computers представила OCP-систему Delta Sprut XL, предназначенную для ресурсоёмких нагрузок, таких как обучение ИИ-моделей, инференс, научное моделирование и задачи HPC. В основу новинки положена аппаратная платформа Intel Xeon 6. CPU-секция допускает установку двух процессоров Sierra Forest-SP или Granite Rapids-SP с показателем TDP до 330 и 350 Вт соответственно: в первом случае могут быть задействованы в общей сложности до 288 E-ядер, во втором — до 172 P-ядер. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM или DDR5-8000 MRDIMM суммарным объёмом до 8 Тбайт. Могут быть установлены четыре SFF-накопителя U.2 толщиной 15 мм с интерфейсом PCIe 5.0 (NVMe) или восемь таких SSD толщиной 7 мм. Кроме того, есть два коннектора M2.2280 (PCIe). Реализованы четыре слота PCIe 5.0 x16 для карт типоразмера HHHL и слот OCP 3.0 (PCIe 5.0). Присутствуют разъёмы USB 3.0 Type-A и miniDP, а также выделенный сетевой порт управления 1GbE. В системе Delta Sprut XL ускорители на базе GPU устанавливаются в отдельные модули. В общей сложности могут использоваться до 20 карт NVIDIA H200 или до 25 экземпляров NVIDIA RTX Pro 6000 Blackwell Server Edition. Каждый квартет NVIDIA H200 объединён при помощи NVLink. «Delta Computers представляет GPGPU-платформу, способную консолидировать до 20 ускорителей NVIDIA H200 в одном кластере. При этом необходимость использования InfiniBand или 400GbE появляется лишь в случае потребности у заказчика в ещё большем количестве ускорителей — при таком сценарии предусмотрены отдельные слоты расширения для объединения нескольких платформ Delta Sprut XL в единый кластер», — отмечает компания. Питание обеспечивается посредством централизованного шинопровода OCP на 12 или 48 В. Применено встроенное ПО Delta BMC, предназначенное для мониторинга (сбор телеметрии, отслеживание состояния платформы, её модулей и компонентов) и удалённого администрирования серверного оборудования. Эта прошивка включена в реестр Минцифры РФ и сертифицирована ФСТЭК.

02.12.2025 [12:41], Руслан Авдеев

Американский ИИ-стартап ищет деньги, чтобы снабдить китайцев чипами NVIDIA через ЯпониюБазирующийся в США стартап PaleBlueDot AI ищет, у кого бы занять $300 млн, чтобы купить ускорители NVIDIA и разместить их в токийском ЦОД — и всё это в интересах китайской медиакомпании RedNote (Xiaohongshu), сообщает Bloomberg. В своё время RedNote получила известность за пределами КНР благодаря временному запрету TikTok в Соединённых Штатах — тогда американцы начали массово регистрироваться в китайской соцсети. PaleBlueDot AI из Кремниевой долины обратилась к банкам и частным кредитным компаниям для получения финансирования. Сообщается, что JPMorgan Chase & Co. причастен к подготовке маркетинговых материалов для потенциальных заёмщиков, но от участия в самой сделке, вероятно, откажется. Источники утверждают, что сделка обсуждается, как минимум, в последние три месяца, хотя неизвестно, каков прогресс. По словам PaleBlueDot AI, «упомянутая информация не соответствует действительности», в JPMorgan от комментариев отказались, а NVIDIA и Xiaohongshu просто не ответили на запросы. PaleBlueDot AI позиционирует себя как посредника, предлагающего безопасные и экономически эффективные вычислительные решения. Примечательно, что у истоков компании и в её руководстве числятся бизнесмены китайского происхождения.

Источник изображения: zhang kaiyv/unsplash.com Планируемый заём наглядно демонстрирует, как именно намерены технологические компании обходить ограничения на продажу в Китай передовых ИИ-чипов, неоднократно ужесточавшиеся с 2022 года. Хотя китайские компании теперь не могут покупать оборудование напрямую, они могут вполне легально получать доступ к ЦОД в странах за пределами Китая. Буквально на днях сообщалось, что Alibaba и ByteDance стали обучать передовые ИИ-модели в дата-центрах Юго-Восточной Азии. Финансирование подобных проектов всегда воспринимается с осторожностью. Это связано с озабоченностью тем, что американские власти могут наложить дополнительные санкции. Хотя сама NVIDIA давно критикует политику полных запретов поставок ИИ-чипов в Китай, компания постоянно обещает, что будет строго придерживаться политики, предотвращающей попадание чипов «не в те руки». Впрочем, подход американских властей может измениться. По слухам, уже рассматривается возможность поставок в КНР относительно устаревших вариантов — NVIDIA H200.

02.12.2025 [09:39], Владимир Мироненко

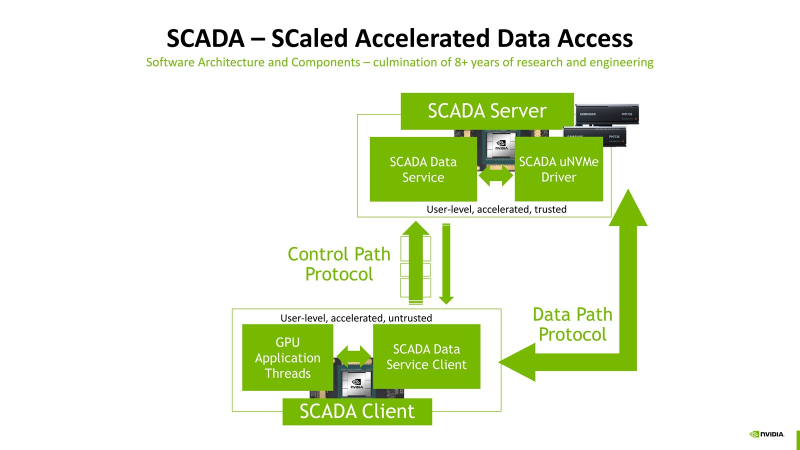

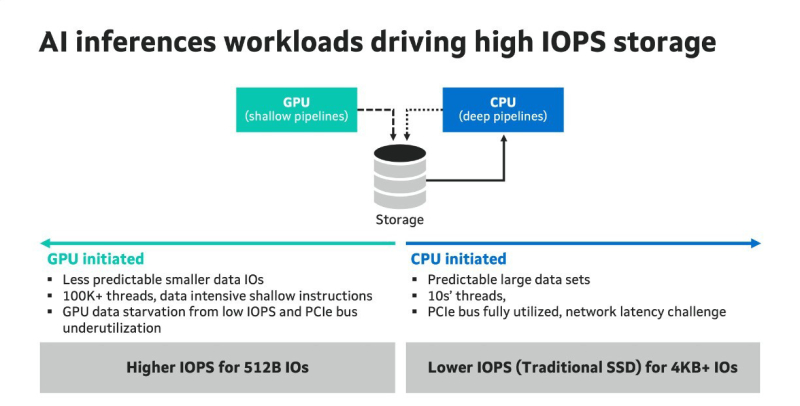

Миллионы IOPS, без посредников: NVIDIA SCADA позволит GPU напрямую брать данные у SSDNVIDIA разрабатывает SCADA (Scaled Accelerated Data Access, масштабируемый ускоренный доступ к данным) — новую IO-архитектуру, где GPU инициируют и управляют процессом работы с хранилищами, сообщил Blocks & Files. SCADA отличается от существующего протокола NVIDIA GPUDirect, который, упрощённо говоря, позволяет ускорить обмен данными с накопителями, напрямую связывая посредством RDMA память ускорителей и NVMe SSD. В этой схеме CPU хоть и не отвечает за саму передачу данных, но оркестрация процесса всё равно ложится на его плечи. SCADA же предлагает перенести на GPU и её. Обучение ИИ-моделей обычно требует передачи больших объёмов данных за сравнительно небольшой промежуток времени. При ИИ-инференсе осуществляется передача небольших IO-блоков (менее 4 Кбайт) во множестве потоков, а время на управление каждой передачей относительно велико. Исследование NVIDIA показало, что инициирование таких передач самим GPU сокращает время и ускоряет инференс. В результате была разработана схема SCADA. NVIDIA уже сотрудничает с партнёрами по экосистеме хранения данных с целью внедрения SCADA. Так, Marvell отмечает: «Потребность в ИИ-инфраструктуре побуждает компании, занимающиеся СХД, разрабатывать SSD, контроллеры, NAND-накопители и др. технологии, оптимизированные для поддержки GPU, с акцентом на более высокий показатель IOPS для ИИ-инференса. Это будет принципиально отличаться от технологий для накопителей, подключенных к CPU, где главными приоритетами являются задержка и ёмкость». По словам Marvell, в рамках SCADA ускорители используют семантику памяти при работе с накопителями. Однако сами SSD мало подходят для таких задач, поскольку не могут обеспечить необходимый уровень IOPS, когда во время инференса тысячи параллельных потоков запрашивают наборы данных размером менее 4 Кбайт. Это приводит к недоиспользованию шины PCIe, «голоданию» GPU и пустой трате циклов. В CPU-центричной архитектуре, которая подходит для обучения моделей, параллельных потоков данных десятки, а не тысячи, а блоки данных крупные — от SSD требуется высокие ёмкость и пропускная способность, а также малая задержка, поскольку свою задержку в рамках СХД также внесут PCIe и Ethernet. Внедрение PCIe 6.0 и PCIe 7.0, конечно, само по себе ускорит обмен данными, но контроллеры SSD также нуждаются в обновлении. Они должны уметь использовать возможности SCADA, иметь оптимальные схемы коррекции ошибок для малых блоков данных и быть мультипротокольными (PCIe, CXL, Ethernet). Компания Micron также участвует в разработке SCADA. В рамках SC25 Micron показала прототип SCADA-хранилища на базе платформы H3 Platform Falcon 6048 с PCIe 6.0 (44 × E1.S NVMe SSD + 6 × GPU/DPU/NIC), оснащённой 44 накопителями Micron 9650 (7,68 Тбайт, до 5,4 млн на случайном чтении 4K-блоками с глубиной очереди 512, PCIe 6.0), тремя коммутаторами Broadcom PEX90000 (144 линии PCIe 6.0 в каждом), одним процессором Intel Xeon (PCIe 5.0) и тремя ускорителями NVIDIA H100 (PCIe 5.0). Micron заявила, что система «демонстрирует линейное масштабирование производительности от 1 до 44 SSD», доходя до 230 млн IOPS, что довольно близко к теоретическому максимуму в 237,6 млн IOPS. «В сочетании с PCIe 6.0 и высокопроизводительными SSD архитектура [SCADA] обеспечивает доступ к данным в режиме реального времени для таких рабочих нагрузок, как векторные базы данных, графовые нейронные сети и крупномасштабные конвейеры инференса», — подытожила Micron.

29.11.2025 [14:58], Сергей Карасёв

MGX-сервер MSI CG480-S6053 получил чипы AMD EPYC Turin и восемь слотов PCIe 5.0 x16 для FHFL-карт двойной шириныКомпания MSI анонсировала сервер CG480-S6053, предназначенный для ресурсоёмких задач ИИ и НРС. Устройство выполнено в форм-факторе 4U на архитектуре NVIDIA MGX. Возможна установка двух процессоров AMD EPYC 9005 Turin в исполнении Socket SP5 с показателем TDP до 500 Вт. Доступны 24 слота для модулей оперативной памяти DDR5-6400 RDIMM/RIMM-3DS суммарным объёмом до 6 Тбайт (в конфигурации 24 × 256 Гбайт). Во фронтальной части расположены восемь отсеков для SFF-накопителей U.2 с интерфейсом PCIe 5.0 x4 (NVMe); допускается горячая замена. Есть два внутренних коннектор М.2 для SSD типоразмера 2280/22110 с интерфейсом PCIe 3.0 x2 (NVMe). Сервер оснащён восемью слотами PCIe 5.0 x16 для карт FHFL двойной ширины. Могут устанавливаться, в частности, ИИ-ускорители NVIDIA H200 NVL и RTX Pro 6000 Blackwell Server Edition. Кроме того, есть пять слотов PCIe 5.0 x16 для карт FHFL одинарной ширины. Сервер располагает контроллером ASPEED AST2600, двумя сетевыми портами 10GbE (RJ45) на основе Intel X710-AT2, выделенным сетевым портом управления 1GbE, разъёмами USB 3.0/2.0 Type-A и Mini-DisplayPort. Модификация системы с обозначением CG481-S6053 получила восемь портом 400GbE на базе NVIDIA ConnectX-8 SuperNIC. Предусмотрен модуль TPM 2.0. Новинка имеет размеры 438,5 × 175 × 800 мм. Питание обеспечивают четыре блока с резервированием мощностью 3200 Вт (80 PLUS Titanium). Применено воздушное охлаждение с десятью системными вентиляторами диаметром 80 мм с возможностью горячей замены. Диапазон рабочих температур — от +10 до +35 °C. |

|