Материалы по тегу: nvidia

|

17.12.2025 [10:11], Сергей Карасёв

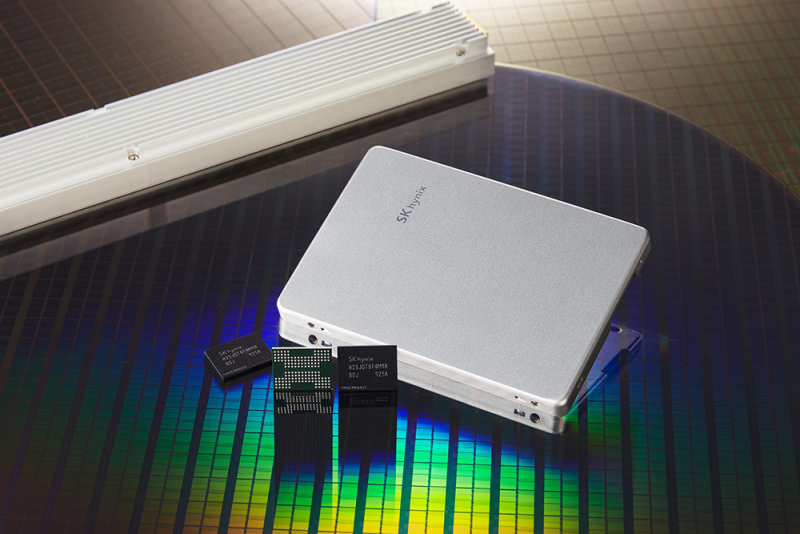

SK hynix и NVIDIA объединили усилия для создания сверхбыстрых SSD для ИИ-системКомпании SK hynix и NVIDIA, по сообщениям сетевых источников, занимаются совместной разработкой сверхбыстрых SSD, которые, как ожидается, помогут устранить узкие места современных ИИ-платформ. Проект получил название Storage Next: он предполагает создание чипов флеш-памяти NAND и сопутствующих контроллеров следующего поколения. По информации ресурса ZDNet, первые прототипы изделий партнёры намерены представить к концу следующего года. Речь идёт о накопителях с интерфейсом PCIe 6.0, которые смогут демонстрировать показатель IOPS (операций ввода/вывода в секунду) на уровне 25 млн. Более того, в 2027-м, как ожидается, будет выпущено устройство с величиной IOPS до 100 млн. Для сравнения, современные высокопроизводительные SSD корпоративного класса имеют значение IOPS на уровне 2–3 млн. В основу накопителей Storage Next лягут наработки SK hynix в области памяти AI-N (AI-NAND), оптимизированной для ИИ. В частности, упоминаются решения AI-N P: предполагается, что такие устройства будут выполнены в форм-факторе EDSFF E3.x. Они получат контроллер, предназначенный для выполнения как обычных рабочих нагрузок, так и с высоким показателем IOPS. По мере того, как ИИ-платформы переходят от обучения к инференсу, возможностей памяти HBM с высокой пропускной способностью оказывается недостаточно: наблюдается разрыв между объёмом и производительностью HBM и вычислительными возможностями ИИ-ускорителей на базе GPU. Цель проекта Storage Next состоит в том, чтобы решить эту проблему путём использования инноваций в области NAND. По сравнению с современными SSD накопители Storage Next смогут демонстрировать увеличение показателя IOPS в 30–50 раз. Кроме того, SK hynix разрабатывает память AI DRAM (AI-D) для ИИ-платформ: эти изделия, как предполагается, помогут справиться с нехваткой памяти.

16.12.2025 [01:05], Владимир Мироненко

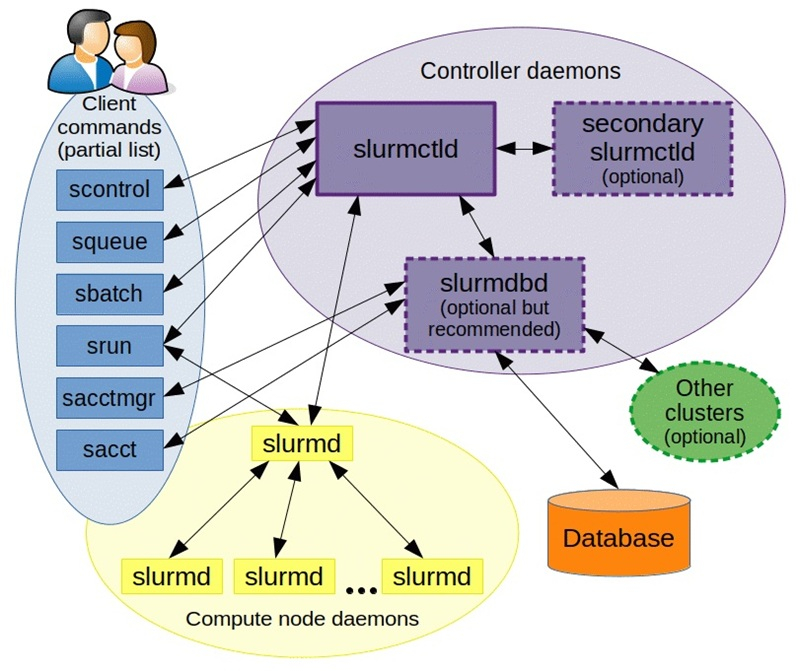

NVIDIA купила разработчика Slurm, пообещав не забрасывать open source решениеNVIDIA объявила о приобретении SchedMD — ведущего разработчика открытой системы оркестрации Slurm для высокопроизводительных вычислений (HPC) и ИИ. Финансовые условия сделки не разглашаются. Созданная SchedMD система Slurm обеспечивает планирование и управление большими вычислительными задачами в ЦОД, позволяя уменьшить количество ошибок, ускорить вывод продукции на рынок и снизить затраты. Как сообщает NVIDIA, сделка поможет укрепить экосистему ПО с открытым исходным кодом и стимулировать инновации в области ИИ для исследователей, разработчиков и предприятий. Компания отметила, что рабочие нагрузки HPC и ИИ включают сложные вычисления с выполнением параллельных задач на кластерах, для чего требуется организация очередей, планирование и распределение вычислительных ресурсов. По мере увеличения размеров и мощности кластеров HPC и ИИ задача эффективного использования ресурсов становится критически важной.

Источник изображения: SchedMD SchedMD была основана в 2010 году разработчиками ПО Slurm Моррисом «Мо» Джеттом (Morris «Moe» Jette) и Дэнни Оублом (Danny Auble) в Ливерморе (Livermore, штат Калифорния). В настоящее время персонал компании насчитывает 40 человек. Сейчас Slurm — ведущий менеджер рабочих нагрузок и планировщик заданий по масштабируемости, пропускной способности и управлению сложными политиками, который используется более чем в половине из десяти и ста лучших систем в списке TOP500 суперкомпьютеров. NVIDIA сообщила, что сотрудничает с SchedMD более десяти лет и продолжит инвестировать в разработку Slurm, чтобы сохранить его поизиции как ведущего планировщика с открытым исходным кодом для HPC и ИИ. NVIDIA обеспечит доступ SchedMD к новым системам, чтобы клиенты могли запускать гетерогенные кластеры с использованием последних инноваций Slurm. Также NVIDIA пообещала и далее поддерживать open source ПО, вкладываться в разработку Slurm и обучение. NVIDIA делает ставку на технологии с открытым исходным кодом и наращивает инвестиции в ИИ-экосистему, чтобы противостоять растущей конкуренции, отметил ресурс Reuters. В конце прошлого года NVIDIA завершила приобретение стартапа Run:ai, разрабатывающего ПО для управления рабочими нагрузками ИИ и оркестрации на базе Kubernetes. А в 2022 году она купила фирму Bright Computing, ещё одного известного разработчика инструментов оркестрации и управления кластерами.

14.12.2025 [14:40], Руслан Авдеев

NVIDIA рассматривает увеличение выпуска ускорителей H200 из-за большого спроса на них в КитаеПо данным отраслевых источников, NVIDIA сообщила клиентам в Китае, что уже рассматрвиает возможность нарастить производство ИИ-ускорителей H200. По данным Reuters, объёмы заказов уже превышают доступный сегодня уровень производства. Ранее сообщалось, что руководство США рассматривает разрешение поставок H200 в КНР, а в минувший вторник президент страны объявил о том, что этот вопрос решён положительно. При этом власти будут получать комиссию в 25 % с продаж ускорителей в Китай. Спрос на современные ИИ-чипы в Китае столь высок, что NVIDIA допускает расширение их производства. В самой NVIDIA прокомментировали слух, заявив, что управляют цепочкой поставок таким образом, чтобы продажи авторизованным клиентам в Китае не повлияли на способность поставлять продукцию покупателям из США. Пока чипов H200 производится очень немного, поскольку NVIDIA сосредоточилась на выпуске передовых ускорителей Blackwell, а также будущего семейства — Rubin. Крупные китайские компании, включая Alibaba и ByteDance уже связались с NVIDIA на днях по поводу закупок H200 и, как утверждается, заинтересованы в размещении крупных заказов. Впрочем, пока неопределённость сохраняется, поскольку закупки H200 не одобрили в самом Китае. По словам источников, в прошлую среду китайские чиновники провели ряд экстренных совещаний для обсуждения вопроса и принятия решения о том, стоит ли в принципе разрешать поставки H200.

Источник изображения: bruce mars/unsplash.com H200 поступили в массовое производство в 2024 году и являются самыми быстрыми ускорителями NVIDIA поколения Hopper. Высокий спрос на H200 в Китае обусловлен тем, что это самый производительный чип, который будет доступен китайскому бизнесу на данный момент. Он приблизительно вшестеро производительнее «урезанной» модели H20. Решение США принято на фоне стремления Китая активно развивать собственную полупроводниковую индустрию для ИИ-проектов. Поскольку продукция, сопоставимая с H200 в продаже пока отсутствует, в Китае уже возникли опасения, что выход американских чипов на локальный рынок может затормозить развитие местной отрасли. По мнению некоторых китайских экспертов, вычислительная мощность H200 в два-три раза выше, чем у самых передовых чипов из КНР — многие поставщики облачных услуг и корпоративные клиенты активно размещают заказы и лоббируют ослабление ограничений. При этом отмечается, что спрос в Китае в любом случае превышает возможности местного производства. По сведениям источников, в ходе экстренных совещаний предлагалось разрешить покупать каждый ускоритель H200 только при условии покупки определённого количества чипов китайского производства. При этом у китайских IT-гигантов теоретически остаётся запасной вариант — размещение H200 в собственных ЦОД за пределами Китая. Они и так обучают модели в дата-центрах вне КНР, пусть и не своих. Для NVIDIA же наращивать производственные мощности тоже непросто, поскольку она занята наладкой массового производства Rubin и конкурирует за мощности TSMC с компаниями уровня Google.

12.12.2025 [17:21], Руслан Авдеев

Никаких закладок: NVIDIA анонсировала новое ПО для мониторинга и продления жизни ИИ-ускорителей в ЦОД

dcim

nvidia

open source

software

амортизация

ии

мониторинг

охлаждение

цод

электропитание

энергоэффективность

NVIDIA разрабатывает новое открытое ПО, благодаря которому операторы ЦОД смогут получать более подробные данные о тепловом состоянии и иных параметрах работы ИИ-ускорителей. Предполагается, что это поможет решать проблемы, связанные с перегревом оборудования и его надёжностью, увеличив его срок службы и производительность. NVIDIA отдельно подчёркивает, что телеметрия собирается только в режиме чтения без слежки за оборудованием, а в ПО нет «аварийных выключателей» и бэкдоров. Да и в целом использование новинки опционально. ПО обеспечивает операторам ЦОД доступ к мониторингу потребления энергии, загрузки, пропускной способности памяти и других ключевых параметров в масштабах всего парка ускорителей. Это помогает выявлять на ранних стадиях риски и проблемные компоненты и условия работы, отслеживать использование ИИ-ускорителей, их конфигурации и ошибки. Детализированная телеметрия становится всё важнее для планирования и управления масштабными инфраструктурами, говорит компания. ПО позволит:

Такой мониторинг особенно важен на фоне недавнего отчёта учёных Принстонского университета, в котором сообщается, что интенсивные тепловые и электрические нагрузки способны сократить срок службы ИИ-чипов до года-двух, хотя обычно предполагается, что они способны стабильно проработать до трёх лет. Современные ускорители потребляют 700 Вт и более, а высокоплотные системы — от 6 кВт. Из-за этого формируются зоны перегрева, происходят колебания энергопотребления и растёт риск деградации интерконнектов в высокоплотных стойках. Телеметрия, позволяющая оценить потребление энергии в реальном времени, состояние интерконнектов, систем воздушного охлаждения и др. позволяет перейти от реактивного мониторинга к проактивному проектированию. Рабочие нагрузки можно размещать с учётом теплового режима, быстрее внедрять СЖО или гибридные системы охлаждения, оптимизировать работу сетей с уменьшением тепловыделения. Также ПО может помочь операторам ЦОД выявлять скрытые ошибки, вызванные несоответствием версий прошивки или драйверов. Благодаря этому можно повысить общую стабильность парка ускорителей. Кроме того, без задержек передаваемые данные об ошибках и состоянии компонентов могут значительно сократить среднее время восстановления работы и упростить анализ причин сбоев. Соответствующие данные могут влиять на решения о тратах на инфраструктуру и стратегию её развития на уровне предприятия.

Источник изображения: NVIDIA Как заявляют в Gartner, современный ИИ представляет собой «энергоёмкого и сильно нагревающегося монстра», разрушающего экономику и принципы работы ЦОД. В результате, предприятиям нужны специальные инструменты мониторинга и управления для того, чтобы ситуация не вышла из-под контроля. В ближайшие годы использование подобных решений, вероятно, станет обязательным. Кроме того, прозрачность на уровне всего парка оборудования становится необходимой для обоснования роста бюджетов на ИИ-инфраструктуру. По словам экспертов, такие программные инструменты позволяют оптимизировать капитальные и операционные затраты на ЦОД и инфраструктуру, запланированные на ближайшие годы. «Каждый доллар и каждый ватт» должны быть учтены при эффективном использовании ресурсов.

12.12.2025 [15:43], Владимир Мироненко

В МФТИ изучили альтернативы ИИ-ускорителям NVIDIA — китайские Moore Threads и MetaX оказались неплохиВ связи с прекращением поставок в Россию ускорителей NVIDIA, ограничениями на загрузку драйверов и отсутствием их техподдержки Институт искусственного интеллекта МФТИ провёл исследование рынка альтернативных ускорителей, включая продукты китайских производителей Moore Threads и MetaX с целью оценки их способности обеспечить полный цикл работы современных ИИ-моделей. Исследование включало анализ архитектурных особенностей ускорителей, драйверов, совместимости с фреймворками и тестирование под нагрузкой при работе с LLM, инференсом, задачами компьютерного зрения и распределённых вычислений. Проведена оценка скорости и воспроизводимости вычислений, устойчивости при росте нагрузки и стабильности поведения моделей на разных типах ускорителей. Исследователи пришли к выводу, что ускорители Moore Threads s4000 и MetaX C500 могут применяться в широком спектре сценариев, обеспечивая стабильный запуск популярных LLM, корректную работу современных фреймворков, предсказуемую производительность и устойчивость работы при длительных нагрузках. В отдельных типах вычислений альтернативные ускорители не уступали или даже обгоняли NVIDIA A100. Особое внимание было уделено возможности работы альтернативных ускорителей в составе вычислительных узлов и кластеров. Разработанный стек ПО позволяет эффективно распределять ресурсы, объединять мощности для работы с крупными моделями и создавать кластерные конфигурации, сообщили в МФТИ. В МФТИ планируют и дальше тестировать новые поколения ускорителей, расширив перечень поддерживаемых моделей, а также намерены подготовить отраслевые рекомендации для создания автономной ИИ-инфраструктуры. На основе исследования в МФТИ был создан Центр компетенций по решениям, не зависящим от NVIDIA, который объединяет лучшие инженерные практики, методики тестирования, оптимизированные конфигурации и опыт взаимодействия с поставщиками. Он будет оказывать помощь компаниям в подборе оборудования, проведении нагрузочного тестирования под конкретные задачи, настройке вычислительных цепочек, а также может сопровождать платформы в процессе эксплуатации.

10.12.2025 [18:14], Руслан Авдеев

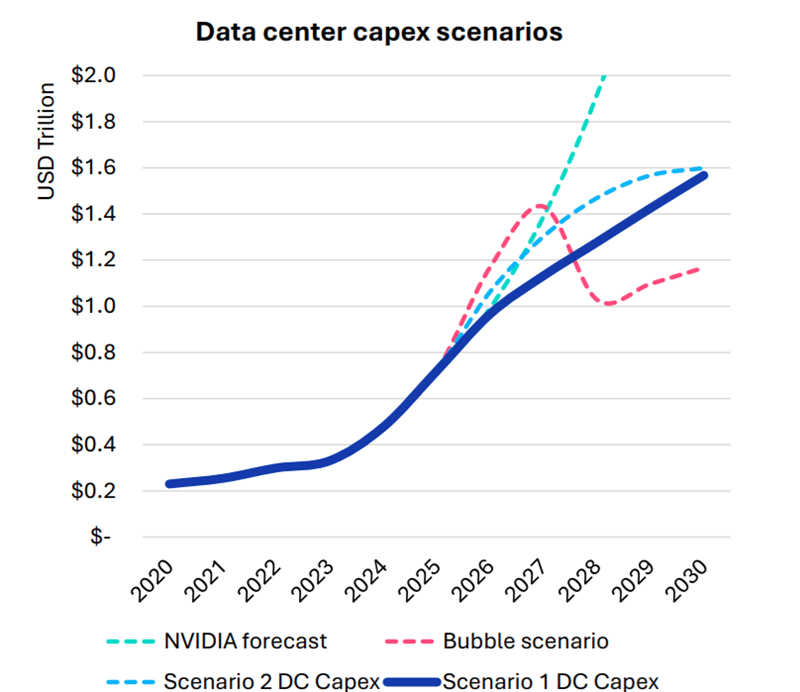

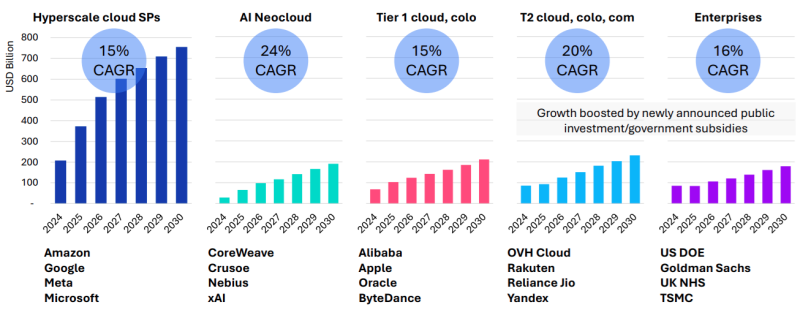

Omdia: капитальные затраты на ЦОД вырастут до $1,6 трлн к 2030 году — если раньше не лопнет ИИ-пузырьСогласно прогнозам аналитиков Omdia, капитальные затраты на дата-центры будут расти на 17 % ежегодно до 2030 года. В итоге они достигнут $1,6 трлн, а ограничения в цепочках поставок вызовут рост цен на компоненты вычислительной инфраструктуры. В своём последнем обзоре рынка облаков и дата-центров (Cloud and Data Center Market Snapshot) компания сообщила, что инвестиции в ИИ-инфраструктуру продолжают расти быстрыми темпами, хотя разговоры о том, что на рынке формируется готовый лопнуть пузырь, не утихают. Впрочем, уровень внедрения ИИ пока остаётся относительно низким, в будущем ожидается, что вырастет как количество пользователей, так и средняя интенсивность использования ими ИИ-инструментов. В то же время ИИ-модели становятся всё более громоздкими и используют больше вычислительных ресурсов для инференса. В результате операторы наращивают производительность инфраструктуры. Вместе с этим растёт потребление электроэнергии, увеличивается энергетическая плотность серверов, стоек и самих дата-центров. Окупятся ли все эти гигантские инвестиции, никто пока точно сказать не может. Bain & Company полагает, что к 2030 году доходы отрасли должны вырасти до $2 трлн/год, чтоб окупить прогнозируемый уровень инвестиций. Окупаемость затрат под вопросом как для поставщиков услуг, так и для пользователей. Как сообщает The Register, на днях представители ряда технологических компаний заявили, что ИИ — не пузырь, не находя аналогий с крахом «доткомов».

Источник изображения: Omdia Omdia рассмотрела четыре сценария развития рынка:

Рост расходов на ЦОД обусловлен и увеличением поставок серверов, цикл обновления которых начался в 2025 году и продолжится 6–8 кварталов. Ранее Omdia сообщала, что крупные операторы ЦОД, в основном гиперскейлеры, откладывали замену серверов разных типов. Новые серверы способны заменить оборудование сразу нескольких поколений. При этом ожидается, что к 2030 году серверы с Blackwell будут ещё в ходу. Рост инвестиций ожидается во всех сегментах, включая ниши неооблаков (CoreWeave, Nebius, xAI и др.), колокейшн-провайдеров первого и второго уровней, гиперскейлеров и корпоративных пользователей.

Источник изображения: Omdia Ограничения в цепочках поставок ведут к росту стоимости некоторых компонентов, например, памяти. По данным источников The Register, это, вероятно, приведёт к росту цен на серверы на 15 %. Omdia утверждает, что новые ЦОД, вероятно, будут проектироваться не так, как сегодня — спрос на ИИ приводит к быстрой смене внутренней инфраструктуры. Это касается всех компонентов, от микросхем до серверов и стоек, систем терморегуляции, распределения энергии, резервного питания и др. В докладе имеются рекомендации на будущее как для вендоров, так и для пользователей. Кроме того, Omdia прогнозирует, что, несмотря на спекуляции относительно ИИ-пузыря, быстрое внедрение ИИ-технологий и инвестиции продолжатся, а мощности по-прежнему будут в дефиците.

09.12.2025 [22:15], Владимир Мироненко

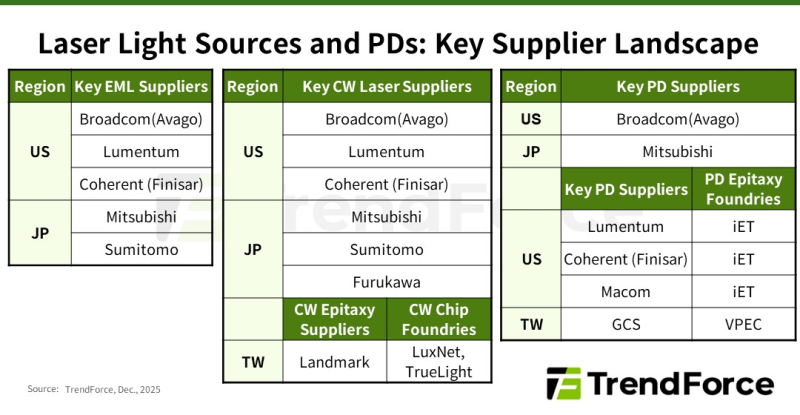

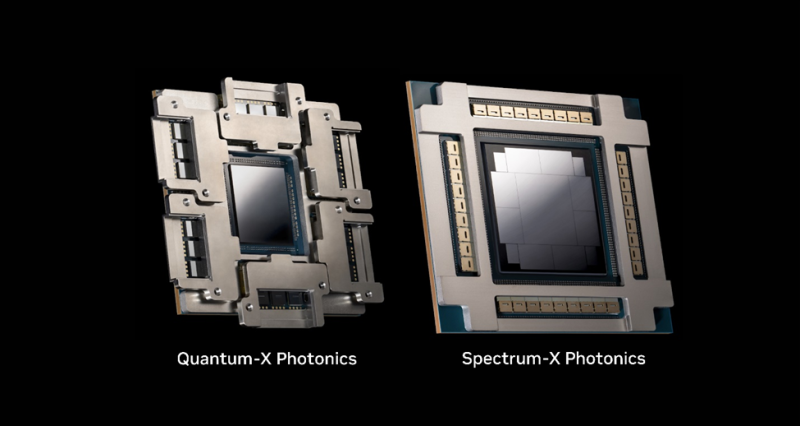

Дефицит добрался и до лазеров: NVIDIA зарезервировала чуть ли не всю продукцию ключевых поставщиковВ настоящее время высокоскоростные оптические соединения играют ключевую роль в обеспечении производительности и масштабируемости ИИ ЦОД, особенно по мере того, как они превращаются в крупные кластеры, сообщается в исследовании TrendForce. Согласно её прогнозу, в 2025 году мировые поставки оптических трансиверов с поддержкой скорости 800 Гбит/с и выше составят 24 млн шт. с последующим ростом в 2,6 раза почти до 63 млн шт. в 2026 году. Аналитики отметили, что резкий рост спроса на оптические трансиверы привёл к значительному дефициту в сфере производства источников лазерного излучения на глобальном рынке. NVIDIA в рамках стратегии развития зарезервировала крупные объёмы продукции у ключевых поставщиков EML-лазеров, что привело к увеличению сроков поставки — не ранее 2027 года. В связи с этим производители оптических модулей и провайдеры облачных услуг (CSP) вынуждены заниматься поиском вторичных поставщиков и альтернативных решений, что ведёт к изменениям в отрасли, отметили в TrendForce. Помимо лазеров VCSEL, используемых в линиях связи малой и средней дальности, оптические модули для линий средней и большой дальности в основном включают два типа лазеров: EML, отличающиеся большой дальностью действия и целостностью сигнала, и лазеры непрерывного излучения (CW). В EML-лазерах все ключевые функции объединены на одном кристалле, что делает их чрезвычайно сложными и трудоёмкими в изготовлении. Их производством занимается всего лишь несколько поставщиков, таких как Lumentum, Coherent (Finisar), Mitsubishi, Sumitomo и Broadcom. Впрочем, о дефиците Mitsubishi предупреждала более года назад. А Broadcom, вероятно, будет отдавать приоритет собственным продуктам. EML-лазеры играют важную роль в масштабировании вычислительных кластеров с увеличением расстояния между ЦОД. Планы NVIDIA по развитию кремниевой фотоники и интегрированной оптики (CPO) реализуются медленнее, чем предполагалось, что приводит к постоянной зависимости от подключаемых модулей для расширения кластеров. Чтобы обеспечить стабильную работу в этом направлении, NVIDIA заранее зарезервировала значительную часть мощностей по производству EML-лазеров, что отразилось на доступности компонента для остальных компаний. CW-лазеры, используемые в паре с кремниевыми фотонными чипами, отличаются более простой конструкцией, обусловленной отсутствием встроенной возможности модуляции, что упрощает производство и расширяет круг поставщиков. В результате CW-лазеры в сочетании с кремниевой фотоникой стали основным альтернативным решением для провайдеров облачных услуг в связи с дефицитом EML-лазеров. Впрочем, здесь тоже наблюдаются проблемы. Производство CW-лазеров сталкивается с растущими ограничениями, обусловленными рядом факторов: длительные сроки поставки оборудования ограничивают расширение производства, а строгие стандарты надёжности требуют трудоемких тестов. В результате многие поставщики передают эти этапы на аутсорсинг, что создает дополнительные узкие места в производственной цепочке. Ввиду того, что экосистема производства CW-лазеров приближается к дефициту мощностей, поставщики вынуждены форсировать усилия по расширению производства. Помимо лазерных передатчиков, для изготовления оптических модулей требуются высокоскоростные фотодиоды (PD) для приёма сигналов. Ведущие поставщики, такие как Coherent, MACOM, Broadcom и Lumentum, выпускают фотодиоды PD 200G с поддержкой скорости передачи данных 200 Гбит/с на канал. Фотодиоды производятся на эпитаксиальных пластинах из фосфида индия (InP), аналогично EML- и CW-лазерам. Поскольку производители лазеров стремятся расширить мощности для эпитаксии, многие из них передают заказы на InP-эпитаксию (процесс выращивания эпитаксиальных листов из фосфида индия на подложке) специализированным заводам, таким как IntelliEPI и VPEC, сообщили в TrendForce. TrendForce прогнозирует, что спрос, обусловленный ИИ, приведёт не только к сокращению предложения модулей памяти, но и отразится на экосистеме производства лазеров в целом. Стремление NVIDIA обеспечить необходимые объёмы поставок EML-лазеров привело к ускорению перехода к CW-решениям и кремниевой фотоники среди других производителей. В то же время общеотраслевая гонка за производственными мощностями меняет роли в цепочке поставок и стимулирует рост производства у поставщиков технологий эпитаксии и обработки полупроводниковых соединений, говорят аналитики.

09.12.2025 [11:48], Руслан Авдеев

США разрешили продавать ИИ-ускорители NVIDIA H200 в Китай, но с пошлиной 25 %Президент США Дональд Трамп (Donald Trump) разрешил NVIDIA поставлять ИИ-ускорители H200 в Китай, но в обмен на дополнительный сбор в пользу США в размере 25 % от их стоимости. Это потенциально позволит NVIDIA вернуть многомиллиардный бизнес в КНР — одном из ключевых рынков для продукции компании в мире, сообщает Bloomberg. Трамп сообщил, что уже уведомил руководство КНР об изменениях и что новость была воспринята положительно. Поставки будут осуществляться только «одобренным клиентам», право на экспорт некоторых своих продуктов также получат AMD и Intel. После заявления Трампа акции NVIDIA и AMD выросли приблизительно на 2 % в конце торгов. Intel, вероятно, не особенно выиграет от изменений в обозримом будущем, поэтому её ценные бумаги подорожали менее чем на 1 %. При этом акции китайских SMIC и Hua Hong Semiconductor упали на торгах в Гонконге более чем на 2 %. Речь идёт о победе NVIDIA в стремлении компании убедить правительство США в необходимости ослабить экспортный контроль, мешавший компании продавать в Китай её продукцию. Глава компании Дженсен Хуанг (Jensen Huang) неоднократно говорил, что ограничения только способствуют развитию китайского производства ИИ-полупроводников. По мнению некоторых экспертов, решение рискует подорвать лидерство США в сфере ИИ. Впрочем, NVIDIA пока не уверена, готовы ли в КНР покупать H200. В августе NVIDIA получила разрешение на продажу чипов H20, а AMD — MI308, разработанных с учётом экспортных ограничений, в обмен на выплату США 15 % от продаж в Китае. Впрочем, эта схема так и не заработала. Решение Трампа вызвало критику со стороны части сенаторов, обвинивших президента в предоставлении Пекину инструментов для создания ИИ нового поколения. Формально H200 минимум на поколение опережает все китайские ИИ-чипы Huawei, Cambricon Technologies, Moore Threads и пр. Последняя после успешного IPO на днях объявила о своих глобальных амбициях. Так или иначе, Пекин, желая снизить зависимость от американских технологий, ранее решительно препятствовал внедрению в ЦОД чипов NVIDIA, особенно государственными структурами. Сам Трамп подчёркивает, что защищает национальную безопасность, создаст рабочие места в Америке и сохранит лидерство в сфере ИИ. В октябре Трамп допускал поставки в Китай «урезанных» вариантов Blackwell, но идея так и не получила развития. При этом Хуанг отмечал, что потенциальный рынок для его компании в Китае оценивается в $50 млрд. Нынешние послабления Blackwell и Rubin не касаются. По данным источников, ранее NVIDIA пыталась продавить продажи в Китай чипов B30 или B40, т.ч. экспорт H200 является компромиссным вариантом. В Министерстве торговли сообщают, что оплата американскому правительству будет осуществляться в виде пошлины в размере 25 %, которую будут взимать при поставке чипов с Тайваня в США, только после этого их будут отправлять в Китай. H20 и H200 принадлежат к одному поколению устаревающих ускорителей Hopper. Тем не менее, H200 значительно производительнее H20 и, по некоторым данным, их производительность почти на порядок выше ранее разрешённого для экспорта в КНР максимума производительности чипов. Так или иначе, ранее власти КНР фактически заблокировали импорт H20 в страну, порекомендовав китайским структурам полагаться на ускорители местных компаний и фактически остановив выход на огромный рынок продукции NVIDIA и AMD. На прошлой неделе в Конгрессе заблокировали инициативу, которая ограничила бы продажу в Китай и некоторые другие страны передовых ИИ-чипов. Закон GAIN AI Act обязал бы производителей, включая NVIDIA и AMD, предоставлять преимущественное право на покупку чипов покупателям из США. Американские законодатели уже работают над т.н. SAFE Act, новый закон должен систематизировать действующие в США ограничения на экспорт полупроводников на китайский рынок.

08.12.2025 [16:35], Владимир Мироненко

Помимо циклических сделок NVIDIA теперь раздаёт партнёрам и «кредиты доверия»Несмотря на растущую критику стратегии NVIDIA по финансированию своих клиентов, компания продолжает поддерживать своих партнёров и заказчиков всё новыми способами. Как пишет Data Center Dynamics, в своём недавнем отчёте по форме 10-Q NVIDIA сообщила, что выступила в качестве гаранта своего партнёра, что позволило последнему «обеспечить аренду объекта с ограниченной доступностью, подкреплённую кредитной историей» NVIDIA. Партнёр, имя которого не раскрывается, разместил на эскроу-счете около $470 млн, и у него уже есть соглашение о продаже облачных мощностей, что, по словам NVIDIA, снижает риск. Если компания не выполнит свои обязательства, NVIDIA имеет право взять объект в аренду для внутреннего использования или сдать его в субаренду, но ей придётся выплатить в течение пяти лет $860 млн. За последнее время NVIDIA заключила с покупателями своих ускорителей ряд сделок, отличающихся циклическим характером, что увеличило и без того высказываемые опасения экспертов в растущем пузыре на ИИ-рынке. Компания поддержала, в том числе, такие необлака, как CoreWeave, Nebius, Nscale, Lambda и Crusoe. В некоторых случаях компания выступает в качестве гаранта продаж. В сентябре этого года NVIDIA пообещала выкупить нераспроданные вычислительные мощности у CoreWeave за $6,3 млрд, а также заключила сделку с Lambda на $1,5 млрд на аренду серверов с собственными чипами. NVIDIA также готова инвестировать крупные суммы в разработчиков ИИ-моделей. Она заключила мегасделку на $100 млрд с OpenAI, а также сделку на $10 млрд с Anthropic. Обе сделки пока не завершены, и также привязаны к гарантиям продажи ускорителей. Также сообщается, что NVIDIA обсуждала возможность поддержки кредитов OpenAI на ЦОД, чтобы ускорить реализацию планов по расширению комплекса Stargate. Компания также инвестирует в разработчиков ИИ-моделей Mistral AI, xAI и Cohere, планирует инвестировать $5 млрд в Intel и $2 млрд в разработчика ПО Synopsys, а также поддерживает фонд ЦОД под руководством BlackRock. Уровень инвестиций в поддержание собственных продаж вызвал критику известного инвестора Майкла Берри (Michael Burry), ставшего прообразом одного из героев фильма «Игра на понижение», вынудив NVIDIA оправдываться, заявив, что она отличается от Enron, обанкротившейся из-за бухгалтерского мошенничества, а также от WorldCom или Lucent, оказавшихся в центре скандалов из-за манипуляций с учётом финансов и отчётностью.

08.12.2025 [14:20], Владимир Мироненко

$2 млрд инвестиций NVIDIA в Synopsys несут риски для UALinkОбъявление NVIDIA о расширении сотрудничества с Synopsys, разработчиком ПО для проектирования чипов и членом совета директоров UALink, и инвестициях в размере $2 млрд в совместные инициативы, последовавшее после недавнего решения производителя ИИ-ускорителей инвестировать $5 млрд в Intel, вызвали опасения по поводу его возможного влияния на разработку UALink — альтернативы собственному интерконнекту NVLink. Как отметил Network World, Synopsys входит в совет директоров консорциума Ultra Accelerator Link (UALink) — отраслевой коалиции из более чем 80 компаний, включая AMD, Intel, Google, Microsoft и Meta✴, которая работает над созданием открытой альтернативы технологии NVIDIA NVLink для объединения ИИ-ускорителей в один домен. NVIDIA инвестировала $2 млрд в обыкновенные акции Synopsys ($414,79/ед.), получив долю в разработчике ПО и планируя в рамках партнёрства объединить преимущества своих технологий с ведущими на рынке инженерными решениями Synopsys. В сентябре NVIDIA инвестировала $5 млрд в Intel, объявив о сотрудничестве с целью разработки чипов для ЦОД и ПК с использованием NVLink Fusion. За несколько месяцев до этого Intel взяла на себя обязательство совместно разрабатывать конкурирующий стандарт UAlink. Arm тоже присоединилась к консорциуму UAlink, участвуя при этом и в экосистеме NVLink Fusion.

Источник изображения: NVIDIA Moor Insights & Strategy считает, что с помощью инвестиций NVIDIA укрепляет свою экосистему на фоне вызовов AMD, будь то CPU, GPU или сетевые решения. Вместе с тем аналитики признают, что это «действительно усиливает давление на UALink» — финансовая «доля» NVIDIA в консорциуме UALink может повлиять на разработку открытого стандарта, специально созданного для конкуренции с технологиями самой NVIDIA и предоставления предприятиям более широкого выбора компонентов. Компании считают такие открытые стандарты критически важными для предотвращения привязки к одному поставщику и поддержания конкурентоспособных цен. В апреле консорциум ратифицировал спецификацию UALink 200G 1.0, определяющую открытый стандарт для объединения в один кластер до 1024 ИИ-ускорителей со скоростью 200 Гбит/с на линию. Это прямой конкурент NVLink, хотя и не такой производительный. При этом Synopsys играет ключевую роль в работе консорциума. Она не только вошла в совет директоров UALink, но и анонсировала первые в отрасли компоненты для проектирования UALink, позволяющие создавать ускорители, совместимые с UALink. Gartner признаёт наличие напряжённости: «Сделка между NVIDIA и Synopsys действительно вызывает вопросы о будущем UALink, поскольку Synopsys является ключевым партнёром консорциума и владеет критически важными IP на UALink, который конкурирует с проприетарным NVLink». По оценкам Greyhound Research, Synopsys играет ведущую роль в UALink, поэтому вхождение NVIDIA в структуру акционеров Synopsys может повлиять на заинтересованность последней в работе консорциума. UALink действует благодаря коммерческому согласованию, общим приоритетам НИОКР и близости планов развития участников. Даже потенциальная возможность влияния NVIDIA может подорвать доверие среди членов UALink. «Партнёры по консорциуму должны быть готовы к тому, что будущие версии UALink могут быть сформированы таким образом, что это либо замедлит их развитие, либо будет смещено в сторону компромиссов в дизайне для минимизации конкурентного давления на NVLink», — предупреждает Greyhound Research, призывая консорциум «срочно усилить управление, повысить прозрачность в отношении вклада Synopsys и рассмотреть механизмы защиты, если хочет сохранить доверие». Объявляя о партнёрстве, NVIDIA и Synopsys подчеркнули, что сотрудничество будет сосредоточено на инженерных инструментах на базе ИИ, а не на интерконнектах. В частности, библиотеки NVIDIA CUDA-X будут интегрированы в приложения Synopsys для проектирования микросхем, молекулярного моделирования и электромагнитного анализа. В пресс-релизе по поводу сотрудничества не было никакого упоминания NVLink или интерконнектов. «Поэтому это больше похоже на партнёрство в сфере ПО, чем в сфере интеллектуальной собственности», — пишет Moor Insights & Strategy. Генеральный директор Synopsys Сассин Гази (Sassine Ghazi), подчеркнул, что партнёрство никак не связано с циклическим финансированием. «Мы не намерены и не берём на себя обязательство использовать эти $2 млрд на покупку GPU NVIDIA», — сказал он, добавив, что к партнёрству могут присоединиться другие производители микросхем. Это означает, что компании могут продолжать сотрудничество в рамках более широкой экосистемы, то есть Synopsys продолжит работать с другими поставщиками, конкурирующими с NVIDIA, будь то AMD, Broadcom или один из гиперскейлеров. В ответ на просьбу Network World прокомментировать возможное влияние партнёрства на её приоритеты, Synopsys заявила, что это не меняет её стратегию. В свою очередь, NVIDIA не ответила вопрос ресурса о том, как эти инвестиции могут повлиять на деятельность Synopsys в рамках UALink или на независимость консорциума. Впрочем, аналитики сходятся во мнении, что для консорциума это партнёрство вряд ли можно считать чем-то позитивным. UALink важен для будущих ИИ-платформ AMD. HPE, которая одной из первых поддержала решение AMD Helios AI, будет использовать реализацию UALink over Ethernet (UALoE). |

|