Материалы по тегу: ии

|

09.11.2025 [00:35], Владимир Мироненко

Создание Microsoft массивной ИИ-инфраструктуры в ОАЭ повышает риск утечки технологий и ресурсов в КитайПоддержка Microsoft масштабного развёртывания ИИ-инфраструктуры в ОАЭ, объём инвестиций которой в 2023–2029 гг. в различные проекты в стране составит $15,2 млрд, вызывает опасения у экспертов по поводу обеспечения безопасности, пишет ресурс Dark Reading. В партнёрстве с местной ИИ-компанией G42, поддерживаемой суверенным фондом благосостояния ОАЭ, Microsoft строит первую очередь ИИ-кампуса с новейшими ускорителями NVIDIA. За время президентства Джо Байдена (Joe Biden) Microsoft поставила в ОАЭ эквивалент 21,5 тыс. ускорителей NVIDIA A100. А при администрации Дональда Трампа (Donald Trump) компания получила экспортные лицензии, которые позволяют поставить в ОАЭ эквивалент ещё 60,4 тыс. A100. В прошлом году Microsoft инвестировала в G42 $1,5 млрд. В мае этого года пять компаний — Cisco, NVIDIA, OpenAI, Oracle и SoftBank Group — объединили усилия с G42 для создания Stargate UAE — вычислительного кластера мощностью 1 ГВт в рамках проекта по строительству 5-ГВт ИИ-кампуса. Что касается безопасности, то при заключении Microsoft соглашения об инвестициях в G42 обеим сторонам пришлось согласовать обязательный рамочный документ — Межправительственное соглашение о гарантиях (IGAA) — для соблюдения передовых требований в области кибербезопасности, физической безопасности, экспортного контроля и политики «Знай своего клиента» (KYC). Однако, по неофициальным данным, одним из условий сделки Microsoft с G42 также был отказ ОАЭ от сотрудничества с Китаем и вывод ряда китайских решений из инфраструктуры страны. Безопасность — ключевой элемент уравнения, особенно учитывая, что ОАЭ считаются «сложным» партнёром для США, говорит Джанет Иган (Janet Egan), старший научный сотрудник и заместитель директора программы технологий и национальной безопасности Центра новой американской безопасности (CNAS), указав на то, что в ОАЭ не демократический режим и поддерживаются тесные партнёрские отношения с Китаем, в том числе по вопросам безопасности. «США стремятся приблизить [ОАЭ] к своей орбите и геостратегическому партнёрству, но в то же время должны быть очень осторожны, чтобы не вооружить другую страну, которая может затем сместить или отделить свои интересы от интересов США», — отметила Иган. Опасения понятны — контролировать дата-центры с новейшими технологиями за пределами США гораздо сложнее. Это касается и возможных утечек, и готовности к атакам любого рода. Кроме того, КНР уже не раз ловили на использовании облачной инфраструктуры с передовыми чипами через посредников. Этот вопрос снова был поднят в связи со сделками между G42 и Cerebras. Последняя не только является разработчиком ИИ-ускорителей, но и поставщиком облачных ИИ-решений. ОАЭ — важный союзник США в регионе и самый активный в мире разработчик ИИ-технологий — согласно отчёту Microsoft «AI Diffusion Report» страна занимает первое место по уровню использования ИИ. Страна всерьёз собирается стать ИИ-сверхдержавой. Впрочем, это не мешает, к примеру, китайской Alibaba Cloud развиваться в стране, а Huawei — пытаться продать ОАЭ собственные ускорители Ascend, пока США тянули с разрешением на поставки чипов NVIDIA. По словам вице-председателя и президента Microsoft Брэда Смита (Brad Smith), при администрации Байдена компания проделала «значительную работу… для соответствия строгим требованиям кибербезопасности, национальной безопасности и другим технологическим требованиям, предъявляемым лицензиями на экспорт чипов». Последние разрешения на экспорт чипов, выданные нынешней администрацией Белого дома, потребовали ещё более строгих технологических гарантий, отметил Dark Reading.

08.11.2025 [12:53], Сергей Карасёв

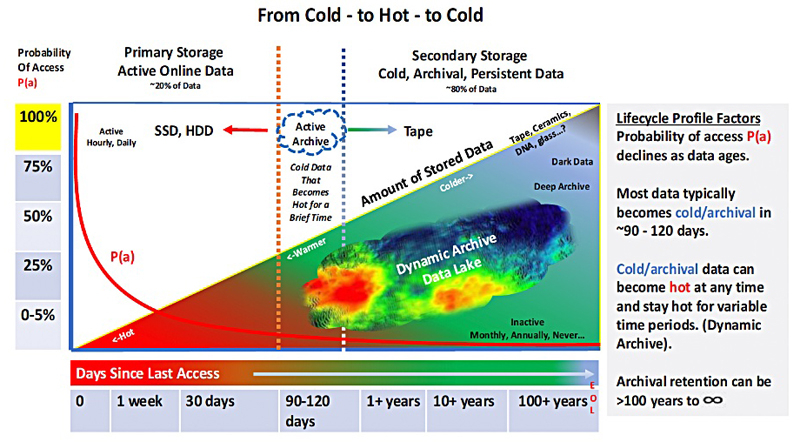

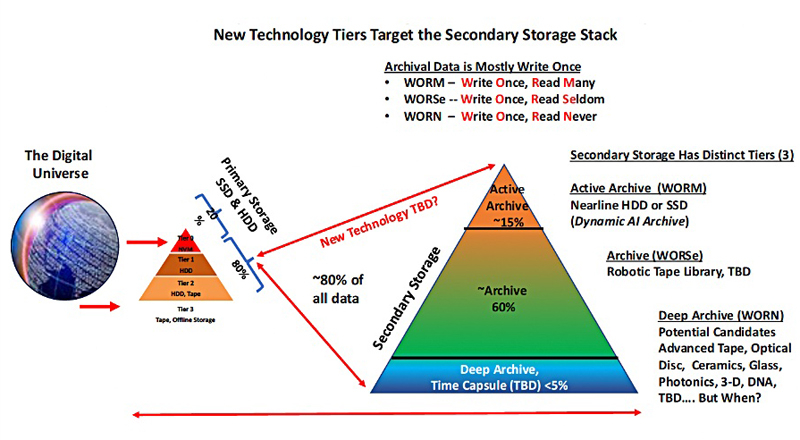

WORM, WORSe и WORN — определены три уровня архивного хранения данных для ИИ-системОрганизация Active Archive Alliance, по сообщению ресурса Blocks & Files, определила три основных уровня архивного хранения данных в эпоху ИИ. Предложенная концепция поможет преобразовать архивы из пассивных хранилищ в активные механизмы с возможностью быстрого извлечения нужных сведений. Active Archive Alliance — это отраслевая группа, сформированная в 2010 году для продвижения концепции «активных архивов». Такие системы обеспечивают упрощённый и быстрый доступ к любым данным в любое время. В состав альянса входят Arcitecta, BDT Media Automation GmbH, Cerebyte, FujiFilm, IBM, Iron Mountain, MagStor, Point, Savartus, Spectra Logic, Wasabi, Western Digital и XenData.

Источник изображений: Horison Information Strategies / Blocks & Files Отмечается, что на фоне стремительного развития ИИ организациям в различных отраслях всё чаще требуется быстрый доступ к огромным объёмам исторической информации. Помочь в удовлетворении таких потребностей призван «активный архив». Архитектура таких платформ предполагает применение накопителей разных типов — SSD, HDD, оптических дисков и ленточных устройств. Распределение данных между ними управляется при помощи специального интеллектуального ПО. Сами накопители могут размещаться локально или в облаках. Предусмотрены различные слои архивирования: «горячие» (SSD, HDD), «тёплые» (HDD, оптические диски) и «холодные» (LTO). Данные по мере старения перемещаются от горячего до холодного слоя, но могут вернуться обратно в случае необходимости.  При этом Active Archive Alliance предлагает три уровня доступа к информации — WORM (Write Once, Read Many), WORSe (Write Once, Read Seldom) и WORN (Write Once, Read Never.) Первый предполагает однократную запись и многократное чтение, второй — однократную запись и редкое чтение, третий — однократную запись при практически полном отсутствии операций чтения. Эти уровни соответствуют трём типам хранилищ — активному, архивному и глубокому. Все они относятся к вторичным массивам, на которые, по оценкам, приходится около 80 % данных (ещё 20 % располагаются в первичных высокопроизводительных системах). Причём активный ярус хранения обеспечивает около 15 % ёмкости, архивный — 60 %, глубокий — только 5 %.

07.11.2025 [22:12], Владимир Мироненко

VAST Data и CoreWeave заключили сделку на $1,17 млрдИИ-стартап VAST Data объявил о заключении сделки с облачным провайдером CoreWeave стоимостью $1,17 млрд, в рамках которой CoreWeave будет использовать VAST AI OS в качестве основной платформы управления данными для своей облачной ИИ-инфраструктуры. Финансовые подробности сделки, включая сроки действия не раскрываются. VAST лишь сообщил, что такие контракты обычно заключаются на три-пять лет. «Объединяя инфраструктуру CoreWeave и VAST AI, компании создают новый класс интеллектуальной архитектуры данных, предназначенной для поддержки непрерывного обучения, инференса в реальном времени и обработки больших объёмов данных для критически важных отраслей», — сообщается в пресс-релизе. Говорится, что расширенное партнёрство подтверждает давнюю приверженность CoreWeave использованию VAST AI OS в качестве основной платформы данных, укрепляя позиции VAST в качестве ключевого компонента ИИ-облака CoreWeave. VAST также сообщил, что его программно-определяемое хранилище построено на базе бесконечно масштабируемой архитектуры, которую можно развернуть в крупных ЦОД, где требуется надёжность и масштабируемость. Платформа управления данными VAST AI OS объединяет сервисы данных — DataSpace, DataBase, DataStore, DataEngine, AgentEngine, InsightEngine — поверх архитектуры DASE (Distributed and Shared Everything). Стек хранения CoreWeave включает локальные, объектные и распределённые файловые сервисы хранения. Локальное хранилище поддерживает эфемерные тома до 60 Тбайт, в то время как выделенные кластеры используют технологии VAST, WEKA, DDN, IBM Spectrum Scale и Pure Storage. Уровень объектного хранилища S3 использует локальный ускоритель передачи объектов (LOTA) для кеширования данных непосредственно на узлах GPU. Соглашение позволяет CoreWeave «управлять и защищать сотни петабайт данных одновременно. Кроме того, мы совместимы с POSIX и подходим для совместного доступа между несколькими экземплярами», заявили в Coreweave ресурсу Blocks & Files. VAST Data и CoreWeave планируют согласовать планы развития своих продуктов, чтобы улучшить хранение и доступ к данным для рабочих ИИ-нагрузок и повысить эффективность работы. Разрабатываемое VAST Data ПО позволяет компаниям эффективно хранить и обрабатывать большие объёмы информации, используемой для обучения и эксплуатации ИИ-систем, и получать доступ к неструктурированным данным, таким как электронные письма, сообщения клиентов, видео и PDF-файлы. Компания взимает с клиентов плату в зависимости от ёмкости и используемых функций. В числе партнёров VAST Data компания NVIDIA, заключившая с ней соглашение по созданию собственной инфраструктуры обработки данных. В прошлом году на встрече с главой VAST Data Ренен Халлак (Renen Hallak) генеральный директор и основатель NVIDIA Дженсен Хуанг (Jensen Huang) высоко оценил решения компании и заявил, что рассчитывает на сотрудничество с ней в течение следующих 80 лет, пишет CRN. Также среди партнёров стартапа ведущие провайдеры облачных услуг (AWS и др.), неооблака (Nebius и др.), лаборатории ИИ (xAI и др.), сообщил соучредитель VAST Джефф Денворт (Jeff Denworth) в интервью агентству Reuters. Сделка может помочь компании в привлечении финансирования. В августе сообщалось, что VAST ведёт переговоры о привлечении нескольких миллиардов долларов нового капитала при оценке до $30 млрд. Среди потенциальных инвесторов — фонд Alphabet CapitalG и NVIDIA. VAST Data оценивалась в $9,1 млрд после раунда финансирования в 2023 году. Инвесторы рассматривают компанию как потенциального кандидата на IPO.

07.11.2025 [17:07], Руслан Авдеев

Iren резко улучшила финансовые показатели и занялась строительством 3-ГВт ИИ-платформы AI CloudIren Ltd. отчиталась о результатах работы в I квартале 2026 финансового года, который закончился 30 сентября 2025 года (). Благодаря быстрому расширению сегмента AI Cloud и заключению серии многолетних контрактов общая выручка компании выросла на 355 % год к году до $240,3 млн. Показатель скорректированной EBITDA увеличился на 3568 % до $91,7 млн. Чистая прибыль (правда, с учётом нереализованной прибыли) составила $384,6 млн против убытка годом ранее. Такие рекордные показатели связаны со стремительным ростом спроса на ИИ-вычисления со стороны гиперскейлеров и корпоративных клиентов. Мощность инфраструктуры IREN вскоре вырастет до 3 ГВт. К концу 2026 года компания намерена иметь парк из 140 тыс. ИИ-ускорителей, на которые придётся лишь лишь 16 % энергетического портфолио. Компания заключила многолетние соглашения с Together AI, Fluidstack и Fireworks AI, в результате чего плановая выручка AI Cloud в годовом исчислении составит более $500 млн к концу I квартала 2026 года. Iren также упомянула ранее анонсированный контракт с Microsoft на сумму $9,7 млрд, который и внесёт основной вклад в годовую регулярную выручку (ARR, Annual Recurring Revenue) сегмента AI Cloud, запланированную на уровне $3,4 млрд.

Источник изображения: Iren Iren сообщила не только о росте клиентской базы, но и о наличии $1,8 млрд денежных средств или их эквивалентов, выпуске бескупонных конвертируемых облигаций на $1 млрд и привлечении целевых $400 млн на приобретение ускорителей для поддержки роста. 160-МВт площадка в Британской Колумбии до конца года будет переведена с ASIC-чипов для майнинга на ИИ-ускорители. В техасском Чилдрессе (Childress) Iren намерена ускорить строительство 750-МВт кампуса уровня Tier III с поддержкой СЖО и плотностью стоек 130–200 кВт для обучения высокопроизводительных ИИ-моделей. Площадка Sweetwater Hub мощностью 2 ГВт будет развёрнута в две фазы: 1,4 ГВт — в апреле 2026 года, 600 МВт — в конце 2027 года. Это часть портфолио объектов IREN, общая мощность которого составит 3 ГВт. По мнению экспертов Converge Digest, переход с ASIC-майнеров на ИИ-решения аналогичен мерам, принятым компаниям вроде CoreWeave и Crusoe Energy, в своё время перешедших с майнинговых проектов на работу с искусственным интеллектом. Это знаменует более широкий поворот в индустрии на создание ИИ ЦОД с высокой энергетической плотностью с заключением долговременных контрактов с гиперскейлерами.

07.11.2025 [15:10], Руслан Авдеев

IT-гиганты вливают миллиарды долларов в солнечную энергетику, чтобы поддержать работу ИИ ЦОДБум дата-центров в США столкнулся с изменением федеральной энергетической политики и растущими проблемами для проектов «чистой» энергетики, противодействием местных жителей и техническими ограничениями. Поскольку обычные энергосети не могут удовлетворить спрос дата-центров, операторы вкладывают миллиарды долларов в развитие солнечной энергетики, сообщает Datacenter Knowledge. Примечательно, что в октябре администрация президента США Дональда Трампа (Donald Trump) отменила реализацию проекта Esmeralda 7 — крупнейшей инициативы в области возобновляемой энергетики, получившей разрешение федеральных властей ещё при администрации Джо Байдена. Теперь на веб-странице проекта указано, что экологическая экспертиза «отменена». Решение принято на фоне того, что быстрое расширение дата-центров создаёт дополнительную нагрузку на электросети всей страны. Особенно остро проблема проявляется в Вирджинии, где сосредоточено большинство ЦОД США. В мае коммунальная PJM Interconnection, управляющая электросетью штата, выпустила беспрецедентное предупреждение о том, что энергии летом может не хватить для удовлетворения спроса. Вирджиния импортирует больше электричества, чем любой из прочих штатов, более 50 ТВт∙ч только в 2023 году, но спрос быстро растёт, подпитываемый растущим парком ЦОД, развитием ИИ и майнинга. Динамика не может не беспокоить чиновников, не исключается, что к 2040 году энергопотребление может утроиться.

Источник изображения: Markus Spiske/unsplash.com На фоне энергокризиса солнечная энергетика всё же становится всё более привлекательной для операторов ЦОД. В Вирджинии проектам мощностью менее 150 МВт разрешено получать разрешения в ускоренном режиме — менее двух лет от подачи заявки до начала эксплуатации. Установку солнечных панелей можно реализовать и за несколько месяцев без подключения к общей сети. Впрочем, по данным Университета штата Вирджиния, в 2024 году власти округов штата отклонили больше мегаватт «солнечных» проектов, чем одобрили — в сельской местности такие проекты часто рассматривают, как «индустриальное вторжение», а не «чистую» энергетическую инфраструктуру. Перевести ЦОД на солнечную энергию сложно из-за двух ключевых проблем: огромной территории, которую требуют солнечные панели (например, более 400 га для ЦОД мощностью 200 МВт), и их низкой эффективности (коэффициент использования установленной мощности около 22 %). Другими словами, они не могут постоянно обеспечивать высокое энергопотребление дата-центров, работающих без перерыва — одной только солнечной энергии для этого недостаточно. Пока, по мнению экспертов, ценность солнечной энергии не в прямом питании дата-центров, а в том вкладе, который она вносит в общие электросети. Несмотря на многочисленные ограничения, техногиганты стремятся внести вклад в строительство солнечных мощностей. Только в 2024 году Microsoft ввела в эксплуатацию более 860 МВт солнечных мощностей, в т.ч. в Иллинойсе, Техасе, Мичигане и Миссури. Всего портфолио объектов компании в области чистой энергетики превысило 34 ГВт. Meta✴ тоже расширила своё присутствие в солнечной энергетике в Техасе, реализовав три крупных проекта общей мощностью более 900 МВт.

Источник изображения: American Public Power Association/unsplash.com AWS лидирует в области солнечной энергетики среди американских компаний, строя 13,6 ГВт солнечных мощностей, это больше установленной мощности большинства штатов. В том числе речь идёт о более 20 проектов в Техасе, в т.ч. солнечной электростанции на 500 МВт в округе Уэбб (Webb). У Google гибридный подход, сочетающий использование солнечных мощностей и аккумуляторных батарей. Компания управляет АКБ на 312 МВт и заключила соглашение с Intersect Power на $20 млрд для создания центров, совмещающих мощности «чистой» энергетики и собственно ЦОД. Поскольку определённость относительно федеральной поддержки проектов возобновляемой энергетики отсутствует, в компании Janta Power уверены, что «рыночные силы» продолжат выступать драйверами внедрения солнечных инициатив. Главными приоритетами для отрасли должны стать не только субсидии, но и эффективность, надёжность и масштабируемость проектов — спрос на чистую энергию не снижается, особенно в секторе ЦОД. Кроме того, утверждается, что рост корпоративных инвестиций может превратить ЦОД из потребителей энергии в основных потребителей именно передовых солнечных технологий, что потенциально способно изменить всю отрасль. Впрочем, в первую очередь всё же субсидии. Amazon, Google и Microsoft призвали США сохранить субсидии на возобновляемые источники энергии ради борьбы с КНР за первенство в сфере ИИ.

07.11.2025 [14:16], Владимир Мироненко

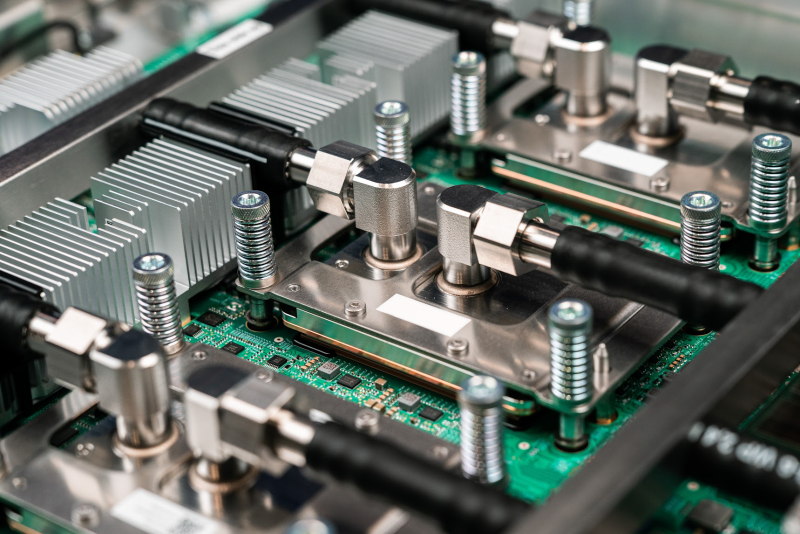

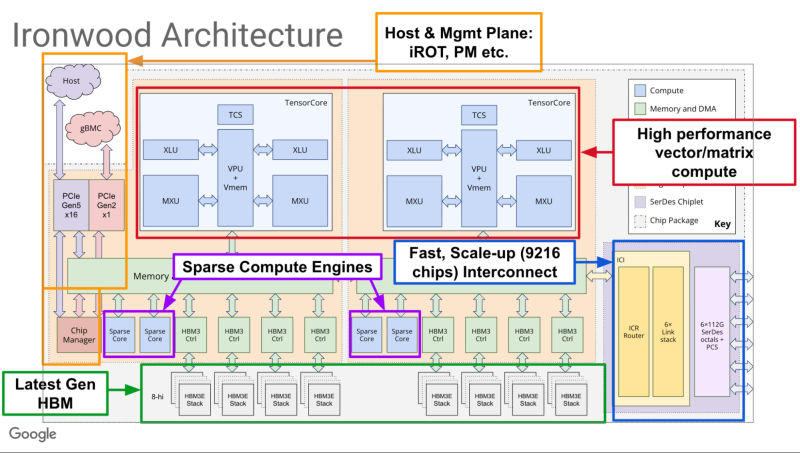

Google объявила о доступности фирменных ИИ-ускорителей TPU Ironwood и кластеров на их основеGoogle объявила о доступности в ближайшие недели ИИ-ускорителя седьмого поколения TPU v7 Ironwood, специально разработанного для самых требовательных рабочих нагрузок: от обучения крупномасштабных моделей и сложного обучения с подкреплением (RL) до высокопроизводительного ИИ-инференса и обслуживания моделей с малой задержкой. Google отметила, что современные передовые ИИ-модели, включая Gemini, Veo, Imagen от Google и Claude от Anthropic, обучаются и работают на TPU. Многие компании смещают акцент с обучения этих моделей на обеспечение эффективного и отзывчивого взаимодействия с ними. Постоянно меняющаяся архитектура моделей, рост агентных рабочих процессов и практически экспоненциальный рост спроса на вычисления определяют новую эру инференса. В частности, ИИ-агенты, требующие оркестрации и тесной координации между универсальными вычислениями и ускорением машинного обучения, создают новые возможности для разработки специализированных кремниевых процессоров и вертикально оптимизированных системных архитектур. TPU Ironwood призван обеспечить новые возможности для инференса и агентных рабочих нагрузок. TPU Ironwood был представлен в апреле этого года. По данным Google, он обеспечивает десятикратное увеличение пиковой производительности по сравнению с TPU v5p и более чем четырёхкратное увеличение производительности на чип как для обучения, так и для инференса по сравнению с TPU v6e (Trillium), что делает Ironwood самым мощным и энергоэффективным специализированным кристаллом компании на сегодняшний день. Ускорители объединяются в «кубы» — 64 шт. TPU в 3D-торе, объединённых интерконнектом Inter-Chip Interconnect (ICI) со скоростью 9,6 Тбит/с на подключение. Google сообщила, что на базе Ironwood можно создавать кластеры, включающие до 9216 чипов (42,5 Эфлопс в FP8), объединённых ICI с агрегированной скоростью 88,5 Пбит/с с доступом к 1,77 Пбайт общей памяти HBM, преодолевая узкие места для данных даже самых требовательных моделей. Компания отметила, что в таком масштабе сервисы требуют бесперебойной доступности. Её гарантирует технология оптической коммутации (OCS), которая реализуется как динамическая реконфигурируемая инфраструктура. А если клиенту требуется больше мощности, Ironwood масштабируется в кластеры из сотен тысяч TPU. Своим клиентам, пользующимся решениями на TPU, компания предлагает возможности Cluster Director в Google Kubernetes Engine. Это включает в себя расширенные возможности обслуживания и понимания топологии для интеллектуального планирования и создания высокоустойчивых кластеров. Для предобучения и постобучения компания предлагает новые улучшения MaxText, высокопроизводительного фреймворка LLM с открытым исходным кодом, которые упрощают внедрение новейших методов оптимизации обучения и обучения с подкреплением, таких как контролируемая тонкая настройка (SFT) и оптимизация политики генеративного подкрепления (GRPO) — алгоритм обучения с подкреплением (RL). Также улучшена поддержка vLLM, что позволит с минимальными усилиями перенести инференс с GPU на TPU. А GKE Inference Gateway позволит снизить задержку выдачи первого токена (TTFT). Никуда не делась и поддержка JAX с PyTorch.

07.11.2025 [12:17], Сергей Карасёв

Sugon ScaleX640 — первая в мире стоечная система с 640 ИИ-ускорителямиКитайская компания Sugon (Dawning Information Industry), специализирующаяся на разработке суперкомпьютеров, серверов и СХД, представила ИИ-систему ScaleX640. Это, как утверждается, первое в мире решение в виде одной стойки, допускающее использование до 640 ускорителей. Суперускоритель выполнен на «сверхскоростной ортогональной архитектуре». Используются вычислительные узлы высокой плотности, которые допускают установку ИИ-карт различных производителей. Говорится о совместимости с существующей экосистемой ПО для задач ИИ. Платформа ScaleX640 предусматривает применение иммерсионного жидкостного охлаждения с фазовым переходом и высоковольтных источников питания постоянного тока (DC). СЖО способна отвести до 1,72 МВт. По заявлениям Sugon, по плотности вычислений новинка до 20 раз превосходит другие суперузлы, доступные на рынке. При этом обеспечивается высокий показатель эффективности использования электроэнергии (PUE) — 1,04. Два суперузла ScaleX640 могут формировать вычислительный блок с поддержкой 1280 ускорителей ИИ. Стойки соединяются между собой посредством высокоскоростной сети. В целом, возможно развёртывание кластеров, насчитывающих до 100 тыс. ИИ-карт. Sugon утверждает, что по сравнению с традиционными платформами новая система обеспечивает повышение производительности на 30–40 % в сценариях обучения больших языковых моделей (LLM) с триллионами параметров и инференса. Проведённое всестороннее тестирование ScaleX640 говорит о высокой надёжности и стабильности работы комплекса.

06.11.2025 [22:34], Владимир Мироненко

Qualcomm и Arm разошлись во мнениях по поводу развития ИИ-вычисленийQualcomm и Arm опубликовали в среду квартальные отчёты, дав разные прогнозы относительно рынка процессоров для инференса, пишет The Register. Генеральный директор Qualcomm Криштиану Амон (Cristiano Amon) сообщил аналитикам в ходе телефонной конференции, посвященной квартальным финансовым результатам о том, что его компания выйдет на рынок ЦОД с чипами, предназначенными для выполнения задач инференса и потребляющими меньше энергии, чем «железо» конкурентов. Амон рассказал, что Qualcomm разрабатывает SoC и плату для неё, поскольку «рост ИИ-ЦОД смещается от обучения к специализированным рабочим нагрузкам инференса, и ожидается, что эта тенденция усилится в ближайшие годы». Вместе с тем он отметил, что Qualcomm не сможет отчитаться о «существенной» выручке в сегменте ЦОД до 2027 года. Генеральный директор Arm Рене Хаас (Rene Haas) тоже придерживается мнения, что энергопотребление является «узким местом» в ЦОД, и что спрос сместится с обучения на инференс, вместе с тем считая, что такого рода задачи будут выполняться и за пределами дата-центров. Он отметил растущий спрос на различные архитектуры и вычислительные решения, позволяющие выполнять инференс не в облаке. «Очевидно, что вы не будете полностью полагаться на что-то, что находится на периферии. Но сегодня всё наоборот. Всё на 100 % зависит от облака. И мы думаем, что это изменится», — заявил Хаас во время телефонной конференции с аналитиками, посвящённой финансовому отчёту Arm. Qualcomm анонсировала новую серию чипов для ИИ ЦОД AI200/AI250, заявив, что ИИ-стартап Humain, основанный суверенным фондом Саудовской Аравии, станет одним из их заказчиков. В ходе телефонной конференции Амон сообщил, что Qualcomm ведёт переговоры с другим крупным заказчиком-гиперскейлером, отметив, что они проходят успешно, пишет Reuters. Выручка Qualcomm в IV квартале 2025 финансового года, завершившемся 28 сентября 2025 года, составила $11,27 млрд, что на 10 % больше, чем годом ранее, и выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $10,79 млрд. В полупроводниковом сегменте (QCT) выручка компании составила $9,82 млрд, превысив результат годичной давности на 13 %. При этом выручка в автомобильном сегменте выросла на 17 % до $1,05 млрд, в сегменте Интернета вещей — на 7 % до $1,81 млрд. Скорректированная прибыль на акцию составила $3,00 при прогнозе от LSEG в размере $2,88. Из-за единовременной налоговой выплаты в размере $5,7 млрд компания завершила квартал с чистым убытком в $3,12 млрд, или $2,89 на акцию, тогда как годом ранее у неё была чистая прибыль в размере $2,92 млрд, или $2,59 на акцию. Выручка Qualcomm за 2025 финансовый год составила $44,3 млрд, что на 14 % больше показателя предыдущего финансового года. Чистая годовая прибыль снизилась на 45 % до $5,5 млрд. В I квартале 2026 финансового года Qualcomm прогнозирует выручку в размере $11,8–$12,6 млрд, что соответствует среднему значению в $12,2 млрд. По данным LSEG, это превышает консенсус-прогноз аналитиков в $11,62 млрд. Скорректированная прибыль на акцию, согласно ожиданиям компании, составит $3,30–$3,50 при прогнозе Уолл-стрит в размере $3,31 на акцию. Arm объявила о выручке во II квартале 2026 финансового года в размере $1,14 млрд, что на 34 % больше, чем годом ранее, а также больше прогноза аналитиков в размере $1,06 млрд, пишет Reuters. Третий квартал подряд выручка компании превышает $1 млрд. Выручка компании от роялти выросла год к году на 21 % до рекордных $620 млн, а от лицензирования — на 56 % до $515 млн благодаря новым крупным соглашениям в сфере вычислительных технологий нового поколения. Скорректированная операционная прибыль (Non-GAAP), достигла $467 млн, а скорректированная прибыль на акцию (Non-GAAP), составила $0,39, что в обоих случаях превышает прогноз, отметил ресурс Converge! Network Digest. Финансовый директор Джейсон Чайлд (Jason Child) сообщил инвесторам, что наибольший вклад в рост выручки внесли смартфоны, но «более высокие ставки роялти за чип в ЦОД, где мы по-прежнему наблюдаем рост доли кастомных чипов для гиперскейлеров», безусловно, не были помехой. Arm отметила, что набирает обороты вклад своей архитектуры в развитие облачного ИИ: более 1 млн ядер Arm Neoverse уже развёрнуто в инфраструктуре гиперскейлеров. Ожидается, что доля процессоров Arm в установленных ведущими гиперскейлерами чипах в этом году достигнет почти 50 %. Среди новых игроков на этом рынке компания отметила Google, которая уже перенесла более 30 тыс. облачных приложений на Arm-чипы Axion, включая Gmail и YouTube, и намерена перенести большую часть из более чем 100 тыс. своих приложений. Также в минувшем квартале Microsoft расширила использование процессоров Cobalt 100 на базе Arm до 29 регионов по всему миру. «Открытие пяти новых ЦОД Stargate AI, все из которых основаны на Arm как стратегической вычислительной платформе, подчёркивает роль Arm в обеспечении масштабируемого ИИ», — отметила компания. Доля Arm на рынке серверных процессоров действительно достигла 25 %, но во многом благодаря внедрению интегированных в суперчипы NVIDIA процессорам Grace.

06.11.2025 [14:09], Сергей Карасёв

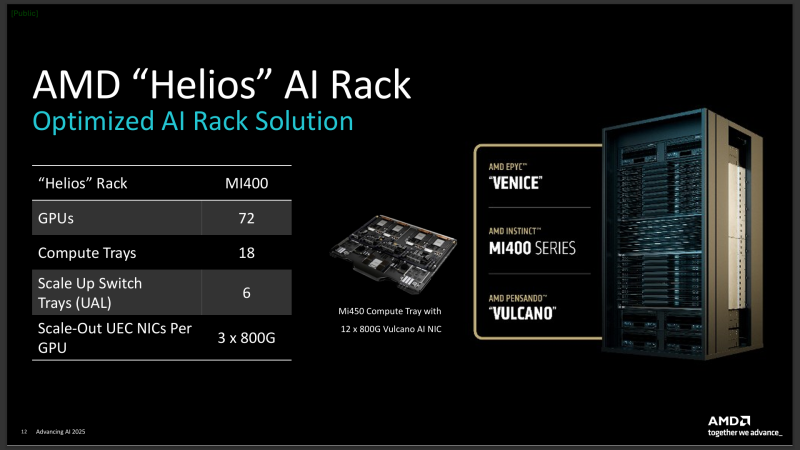

Новая фаза роста: глава AMD Лиза Су рассказала о прогрессе в разработке ИИ-систем следующего поколенияПрезидент и генеральный директор AMD Лиза Су (Lisa Su), по сообщению The Register, рассказала о прогрессе компании в сфере разработки продуктов следующего поколения для дата-центров, ориентированных на ИИ-нагрузки. Речь идёт, в частности, об ускорителях на базе GPU и мощных серверных стойках Helios. О разработке Helios (на изображении) было впервые объявлено в июне нынешнего года. Это стойка двойной ширины, которая будет оснащаться серверными модулями с процессорами AMD EPYC Venice с ядрами Zen 6 и ускорителями Instinct MI400. Кроме того, упомянуты сетевые адаптеры Pensando. Чипы Venice (EPYC шестого поколения) будут производиться с использованием 2-нм техпроцесса TSMC.

Источник изображения: AMD «Разработка наших GPU серии MI400 и стоечного решения Helios идёт быстрыми темпами, чему способствует тесное сотрудничество с гиперскейлерами, ИИ-компаниями, а также OEM- и ODM-партнёрами. Это позволит начать широкомасштабное развёртывание систем в следующем году», — сообщила Су. По её словам, решающую роль в разработке Helios играют специалисты компании ZT Systems, которую AMD купила весной нынешнего года за $4,9 млрд. Производственное подразделение этой фирмы недавно было продано поставщику услуг по выпуску электроники Sanmina за $3 млрд. Процессоры EPYC Venice, ускорители Instinct MI400 и стоечные решения Helios дебютируют в 2026 году. Лиза Су подчёркивает, что бизнес AMD в области ИИ-решений для ЦОД вступает в «следующую фазу роста». При этом наблюдается повышение интереса к будущим продуктам со стороны потенциальных заказчиков. Глава AMD отмечает, что для изделий Instinct MI450 готовятся различные варианты исполнения. При этом фиксируется значительный интерес именно «к полноценному стоечному решению».

06.11.2025 [14:05], Руслан Авдеев

Нас не купишь: акционеры Core Scientific неожиданно отказались продавать компанию своему ключевому заказчику — CoreWeaveCore Scientific анонсировала итоги специального собрания акционеров. По результатам собрания не удалось набрать количества голосов, необходимого для того, чтобы окончательно продать компанию CoreWeave, сообщает пресс-служба Core Scientific. Ещё в июне 2024 года CoreWeave намеревалась приобрести Core Scientific за $1 млрд, видимо, устав арендовать у компании ЦОД, но на тот момент потенциальные продавцы сочли сумму слишком маленькой. В июле 2025 года появилась информация, что CoreWeave всё-таки заключила «окончательную сделку» по покупке Core Scientific, но уже в девять раз дороже, чем годом ранее. Впрочем, похоже, оказалось мало и этого. Как сообщают в Core Scientific, 30 октября «согласно и в соответствии» с соглашением о слиянии, компания разорвала договор о покупке, решение вступило в силу немедленно. Core Scientific сохранит статус участвующей в публичных торгах компании и её обычные акции продолжат продавать на биржах Nasdaq под тикером CORZ. В пресс-релизе Core Scientific утверждается, что компания намерена перепрофилировать оставшиеся объекты, пока используемые для майнинга цифровых активов, на предоставление колокейшн-сервисов высокой плотности. В CoreWeave заявили, что уважают мнение акционеров и партнёрство продолжится, хотя сама CoreWeave намерена продолжить покупать интересные ей бизнесы. Окончательные результаты голосования будут переданы в форме 8K в Комиссию по ценным бумагам и биржам США (SEC). |

|