Материалы по тегу: ии

|

11.11.2025 [15:39], Руслан Авдеев

Tapestry, «ИИ-управляющий» энергосетями от Google X, поможет обеспечить надёжное питание кампуса Rio AI City мощностью 1,8 ГВтОдин из инновационных проектов Google X — компания Tapestry заключила соглашение с властями Рио-де-Жанейро. Компания поможет в создании и поддержке энергетической инфраструктуры 1,8-ГВт кампуса ЦОД Rio AI City, создаваемого при участии NVIDIA и Oracle, сообщает Datacenter Dynamics. Tapestry подключилась к проекту по приглашению мэра Рио Эдуардо Паэса (Eduardo Paes). В рамках сделки Tapestry поможет в оценке и планировании энергетической инфраструктуры AI City. Для управления сетями в проекте будет применяться инструмент GridAware, предлагаемый Tapestry — он обеспечит проверку состояния физической электросети в AI City. Позже инструмент Grid Planning Tool будет применяться для расчёта сценариев, позволяющих нарастить генерирующие мощности и пропускную способность сетей с сохранением почти 100 % надёжности. Также в проекте принимает участие Axia Energia (Electrobras), крупнейшая в Латинской Америке компания по генерации и передаче электроэнергии, оператор и застройщик ЦОД Elea Data Centers, и местная энергокомпания Light SA. Tapestry — инновационный проект под «зонтиком» Google X, который с помощью ИИ создаёт «первую унифицированную модель энергосети». Компания надеется помочь всем, планирующим и строящим электросети, а также управляющим ими. Пользователи ПО смогут оптимизировать энергопотоки и подключать к сети энергию из различных источников. Развитие Rio AI City уже началось. Ожидается, что второй объект кампуса RJO2 получит 80 МВт в 2026 году. Позже в эксплуатацию введут площадки RJO3 и RJO4, ещё на 120 МВт. В дальнейшем на первом этапе мощность можно будет увеличить до 1,5 ГВт (включая существующий объект RJO1), а в будущем — до 3,2 ГВт и 27 объектов.

11.11.2025 [15:14], Руслан Авдеев

Облака и ЦОД Northern Data будут проданы Rumble для создания экосистемы Freedom-First с упором на свободу слова и приватность, а майнинговые мощности достанутся Elektron EnergyНемецкая IT-компания Northern Data Group будет продана видеоплатформе и облачному провайдеру Rumble Inc. Последняя купит 100 % акций Northern Data. Сделка предусматривает покупку всего бизнеса, включая облачные и ИИ-подразделения, и будет закрыта во II половине 2026 года, сообщает Datacenter Dynamics. В Rumble сообщают, что намерены расширить облачный бизнес за счёт активов Northern Data, получив одни из крупнейших массивов ИИ-ускорителей в Европе наряду с ЦОД. Это поможет компании построить собственную экосистему Freedom-First. Экосистема Freedom-First, в отличие от классических гиперскейлеров, якобы предполагает поддержку свободы слова, приватности, независимости и надёжности. В будущем планируется расширить портфолио сервисов, предложив Rumble Wallet, ИИ-ботов и агентов и др. Основанная в 2022 году Rumble включает видеоплатформу, а также облачный сервис Rumble Cloud. Последний распоряжается ЦОД в несколкьих американских штатах. В рамках сделки каждый совладелец Northern Data получит по 2,0281 акций Rumble класса A в обмен на каждую акцию Northern Data. Также среди акционеров распределят $200 млн. На сегодня крупным акционером Northern и Rumble является криптомайнинговая компания Tether. Она, наряду с другими инвесторами, и приняла решение о продаже. В минувшие выходные Northern Data объявила о продаже доли в Lancium, задействованной в проекте Stargate, за $30 млн. Кроме того, упомянуто соглашение с Tether об аренде ИИ-ускорителей на сумму до $150 млн в течение двух лет. Параллельно Northern Data избавится от подразделения, ответственное за майнинг криптовалют, чтобы полностью сосредоточиться на облачных сервисах и ЦОД, сообщает Datacenter Dynamics. Первоначальный платёж за майнинговый бизнес Peak Mining должен был составить $50 млн. Имя покупателя не называлось, но в августе появилась информация, что майнинговое подразделение продадут Elektron Energy за $350 млн. Ещё $150 млн будет выплачено, если прибыль подразделения после сделки достигнет заданных показателей. Вырученные средства пойдёт на расширение облачных и ИИ-сервисов.

Источник изображения: Kanchanara/unsplash.com Northern Data была основана в Германии в 2009 году под именем Northern Bitcoin AG. Бизнес позиционировал себя как «зелёного» майнера биткоинов. В 2020 году компанию переименовали в Northern Data Group и переориентировали на HPC-проекты в целом. Летом 2023 года компания запустила три бернда: Taiga Cloud, Ardent Data Centers и Peak Mining. Облаку Taiga Cloud досталось более 22 тыс. ИИ-ускорителей. Что касается Ardent Data Centers, то восемь ЦОД по всему миру к 2027 году совокупно достигнут мощности порядка 250 МВт. Ardent управляет дата-центрами в Будене (Boden) в Швеция, а также в Норвегии — в Лефдале (Lefdal) на мощностях Lefdal Mine и Кристиансанне (Kristiansand) на мощностях Bulk. В США летом 2025 года компания открыла дата-центр в Питтсбурге (Пенсильвания). Также планируется масштабное строительство в Мейсвилле (Maysville, Джорджия). Также упоминаются мощности для размещения оборудования в Великобритании и Португалии. Дополнительно упомянуто о площадке мощностью 6 МВт в Амстердаме (Нидерланды). В мае Northern Data сообщала о получении от компаний, «зарегистрированных на бирже в США», заявлений о заинтересованности в обсуждении о слиянии с подразделениями Taiga Cloud и Ardent или их приобретении. В августе компания Rumble Inc. объявила, что заинтересована в рассмотрении покупке, в качестве средства оплаты предлагая свои акции взамен активов. Положение Northern Data на рынке не вполне стабильно. Если в июле 2024 года сообщалось, что компания рассматривает вывод на IPO подразделений ЦОД и ИИ, то в сентябре 2025 года появилась информация о том, что европейских офисах компании прошли обыски и аресты. Сообщалось, что компанию подозревают в неуплате €100 млн налогов от деятельности, связанной с криптомайнингом.

11.11.2025 [13:00], Сергей Карасёв

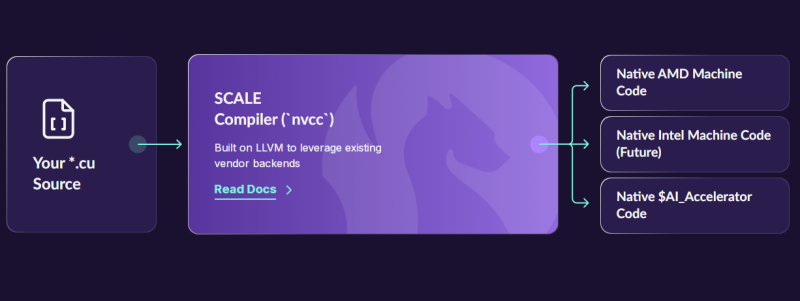

Стартап Spectral Compute по переносу CUDA-приложений на сторонние платформы получил на развитие $6 млнКомпания Spectral Compute, занимающаяся разработкой программной платформы SCALE для запуска CUDA-приложений на любых GPU-ускорителях, сообщила о проведении посевного раунда финансирования на сумму в $6 млн. Инвестиционная программа проведена при участии Costanoa, Crucible и ряда бизнес-ангелов. Стартап Spectral основан в 2018 году инженерами Майклом Сёндергаардом (Michael Søndergaard), Крисом Китчингом (Chris Kitching), Николасом Томлинсоном (Nicholas Tomlinson) и Франсуа Суше (Francois Souchay). Они обладают богатым опытом работы в сферах НРС, программирования GPU и пр. Штат компании на сегодняшний день насчитывает около 20 человек. Spectral развивает решение SCALE, которое обеспечивает компиляцию исходного кода CUDA напрямую в машинные инструкции для ускорителей на базе GPU, отличных от NVIDIA. На начальном этапе реализована возможность использования CUDA-приложений с изделиями AMD, а в дальнейшем планируется добавить поддержку ускорителей других производителей, включая Intel. Таким образом, компании смогут использовать одну и ту же кодовую базу для оборудования разных поставщиков, формируя кластеры ИИ и НРС на основе любых GPU, а не только решений NVIDIA. «Цель проекта SCALE заключается в том, чтобы предоставить организациям возможность использовать существующий код CUDA на любом графическом процессоре, будь то NVIDIA, AMD, Intel или другие изделия — без потери производительности или дорогостоящего переписывания кода», — говорит Сёндергаард. Привлечённые средства стартап намерен направить на дальнейшее развитие платформы SCALE, а также на увеличение численности персонала.

11.11.2025 [12:03], Сергей Карасёв

Стартап Majestic Labs обещает ИИ-серверы со 128 Тбайт RAMКомпания Majestic Labs, занимающаяся разработкой серверов нового поколения для наиболее ресурсоёмких задач ИИ, объявила о выходе из скрытого режима (Stealth) и проведении раунда финансирования Series A. В общей сложности стартап на сегодняшний день получил на развитие $100 млн. Majestic Labs основана бывшими сотрудниками Google и Meta✴. Компания разрабатывает серверы высокой плотности, способные справляться с самыми масштабными и сложными задачами ИИ, для которых в настоящее время требуются несколько стоек с вычислительным оборудованием и коммутаторами. По оценкам Стэнфордского университета (Stanford University), размер кластеров для обучения ИИ-моделей удваивается каждые пять месяцев, объём наборов данных — каждые восемь, а энергопотребление — ежегодно. При этом узким местом, по заявлениям Majestic Labs, является память ИИ-систем: наблюдается разрыв между её объемом и производительностью и собственно вычислительными возможностями ускорителей. В результате, компании вынуждены приобретать избыточные дорогостоящие ИИ-карты только для того, чтобы получить доступ к большему объёму памяти. Majestic Labs рассчитывает решить проблему путём использования принципиально новой архитектуры ИИ-серверов, меняющей баланс памяти и вычислительных мощностей. Стартап заявляет, что каждый сервер нового типа сможет нести на борту столько же памяти, сколько 10 или более современных стоек. Разрабатываемая архитектура позволит радикально сократить затраты на охлаждение, сетевое оборудование и другие компоненты, которые используются в традиционных системах. «Серверы Majestic будут обладать всеми вычислительными возможностями современных устройств на базе GPU и TPU в сочетании с 1000-кратным увеличением объёма памяти», — говорит соучредитель и генеральный директор стартапа Офер Шахам (Ofer Shacham). Архитектура Majestic Labs предусматривает разделение памяти и вычислительных ресурсов. В серверах будут применяться специализированные ИИ-ускорители и блоки «чрезвычайно быстрой и энергоэффективной памяти с высокой пропускной способностью» (тип не уточняется). Каждый сервер сможет нести на борту до 128 Тбайт RAM, что позволит работать с самыми крупными моделями LLM с огромными контекстными окнами. При этом будет обеспечиваться значительное снижение энергопотребления по сравнению с традиционными системами сопоставимого уровня, объединяющими несколько стоек с оборудованием. Программу финансирования Series A на сумму в $71 млн возглавляет Bow Wave Capital. Предыдущим посевным раундом руководила инвестиционная компания Lux Capital. Кроме того, поддержку стартапу оказывают SBI, Upfront, Grove Ventures, Hetz Ventures, QP Ventures, Aidenlair Global и TAL Ventures. Majestic Labs планирует продавать своё оборудование гиперскейлерам, операторам крупных дата-центров, финансовым учреждениям и фармацевтическим компаниям. Стартап рассчитывает выпустить первые коммерческие серверы в 2027 году. Привлечённые средства будут также использованы для расширения команды инженеров и улучшения программного стека, обеспечивающего работу систем нового типа.

11.11.2025 [09:20], Андрей Крупин

Postgres Professional представила ProGate — инструмент для миграции данных из Oracle Database и PostgreSQL в Postgres ProКомпания Postgres Professional объявила о выпуске нового продукта ProGate, предназначенного для упрощения переноса корпоративных систем с Oracle Database и PostgreSQL на СУБД Postgres Pro отечественной разработки. ProGate закрывает полный цикл задач по переносу и синхронизации данных. В составе программного решения представлены три компонента:

ProGate поддерживает репликацию в аналитические хранилища и parquet-файлы, а также упрощает мажорные апгрейды между версиями Postgres Pro и PostgreSQL.

Источник изображения: postgrespro.ru По словам команды разработчиков Postgres Professional, инструмент ProGate может быть востребован при реализации проектов импортозамещения ПО и работе с крупными корпоративными системами, где важны минимальный простой и высокая точность передачи данных. «Миграция из Oracle Database — это один из самых рискованных этапов цифрового перехода. На кону — данные организаций, от которых напрямую зависит работа банков, госсектора и промышленности. Ошибки в процессе переноса несут риски повреждения или потери данных, а также прямые финансовые убытки. ProGate снимает эту проблему, позволяя выполнять перенос данных быстро, контролируемо и без потерь», — отмечает Postgres Professional.

11.11.2025 [09:09], Владимир Мироненко

Meta✴ потратит $600 млрд на ИИ ЦОД, инфраструктуру и кадры, чтобы создать сверхинтеллект и сохранить технологическое лидерство СШАMeta✴ планирует потратить $600 млрд на цифровую инфраструктуру и рабочие места в США, включая ЦОД, в течение следующих трёх лет. Об этом компания сообщила в конце прошлой недели в своём блоге и на промо-странице Building America. Meta✴ отметила, что ЦОД «имеют решающее значение» для достижения её цели — «создать сверхинтеллект для всех» и «помочь Америке сохранить своё технологическое превосходство». «Именно поэтому мы инвестируем в строительство ведущих в отрасли ИИ ЦОД прямо здесь, в США. Мы планируем выделить более $600 млрд к 2028 году на поддержку технологий ИИ, инфраструктуры и расширение штата», — сообщается в публикации. Из каких источников будет обеспечиваться реализация этих планов, компания не сообщила. С учётом того, что её выручка за прошлый год составила $62,3 млрд, можно предположить, что Meta✴ рассчитывает на внешнюю поддержку. Сейчас компания создаёт гигаваттные ИИ ЦОД Hyperion, Prometheus и недавно анонсированный кампус в Техасе. Всего у компании есть порядка 30 действующих и строящихся кампусов ЦОД по всему миру.

Источник изображения: Meta✴ Первоначально эта сумма была названа гендиректором Meta✴ Марком Цукербергом (Mark Zuckerberg) во время ужина с президентом США Дональдом Трампом (Donald Trump) и другими лидерами в сфере ИИ. Цукерберг сказал, что Meta✴ инвестирует «что-то около, я не знаю, как минимум $600 млрд до 2028 года в США», напомнил ресурс Business Insider. Тогда Цукерберг, по-видимому, был не совсем уверен в точной сумме. В разговоре с Дональдом Трампом, который был слышен присутствующим на ужине, поскольку те находились возле микрофона, Цукерберг сказал: «Я не был уверен, какую сумму вы бы выбрали». На конференции Goldman Sachs в Сан-Франциско, состоявшейся позже в том же месяце, финансовый директор Meta✴ Сьюзан Ли (Susan Li) пояснила, что названная Цукербергом сумма включает все планируемые Meta✴ затраты на развитие инфраструктуры ЦОД в США, а также «все инвестиции, направленные на поддержку деятельности нашего бизнеса в США», включая найм персонала Meta✴. Теперь Meta✴ заявила, что направит средства на разработку проектов ИИ ЦОД, которые позволят сократить потребление воды, стремясь к 2030 году стать «водосберегающей» компанией, то есть возвращать в окружающую среду больше воды, чем потреблять.

Источник изображения: Meta✴ «Строя ЦОД в США, мы не только развиваем технологии и ИИ-инфраструктуру, но и создаем рабочие места, поддерживаем местную экономику и укрепляем технологическое лидерство Америки», — отметила компания. Meta✴ заявила, что благодаря её инициативам в сфере ЦОД с 2010 года было создано 30 тыс. рабочих мест для квалифицированных специалистов и 5 тыс. рабочих мест в связанных областях. Компания добавила, что в настоящее время обеспечивает субподрядчиков по всей территории США более чем $20 млрд выручки, поддерживая сталелитейщиков, монтажников трубопроводов, электриков, специалистов по ВОЛС и других специалистов, которые строят новое поколение оптимизированных для ИИ дата-центров. Ожидается, что в этом году капитальные затраты Meta✴ составят $72 млрд. Сьюзан Ли в прошлом месяце сообщила инвесторам, что в 2026 году капзатраты «значительно» вырастут в связи с планами «активно инвестировать» в дата-центры. Цукерберг заявил, что риск чрезмерного развития ИИ-инфраструктуры оправдан, если это позволит не отстать в гонке за право первым создать сверхинтеллект. При худшем сценарии развития событий у компании будет готова инфраструктура на несколько лет вперед, и она, понеся некоторые затраты на амортизацию, в конечном итоге нарастит дополнительные мощности.

10.11.2025 [15:46], Руслан Авдеев

Большой дата-центр для маленького острова: Google хочет построить ИИ ЦОД для военных на Острове Рождества в Индийском океанеGoogle намерена построить большой ИИ ЦОД на маленьком австралийском Острове Рождества (Кристмас) в Индийском океане после подписания соглашения с Министерством обороны Австралии, сообщает Reuters. ЦОД на острове, расположенном в 350 км к югу от Индонезии, станет ценным активом — остров всё чаще рассматривается западными военными как важнейший пункт мониторинга движения китайских подводных лодок и прочей военно-морской активности в Индийском океане. По данным представителей властей острова и согласно протоколам заседания местного совета, Google активно ведёт переговоры об аренде земли неподалёку от местного аэропорта для строительства дата-центра и о поставках энергии. Google заявила, что проект является частью работы по созданию подводной кабельной инфраструктуры для обеспечения повышенной цифровой устойчивости в Австралии и Индо-Тихоокеанском регионе. Впрочем, в компании утверждают, что речь идёт о небольшом ЦОД. По словам пожелавшего остаться анонимным источника, Google запрашивает запросила поставку 7 МВт с использованием дизельной генерации и возобновляемых источников. Местные власти желают, чтобы это никак не сказалось на доступности энергии для местных жителей и компаний. В доступной документации указано, что Google предлагает построить дополнительную кабельную систему, которая свяжет остров с материками. Власти Австралии подтвердили планы Google по постройке ЦОД и прокладке кабеля до города Дарвин (Darwin). В Министерстве обороны страны информацию не комментируют. В ходе недавних учений с участием США, Австралии и Японии Острову Рождества отводилась роль передовой линии обороны Австралии в любом региональном конфликте. Его преимуществом называют возможность запуска безэкипажных оружейных систем и дронов. Бывший представитель ВМС США, руководивший учениями, заявлял, что наличие на Острове Рождества узла командования и управления будет играть решающую роль в случае противостояния с Китаем или другим противником. По его словам, ЦОД отчасти позволит осуществлять командование и управление с помощью ИИ в будущем, особенно в случае применения беспилотных систем для наблюдения, целеуказания и даже боевых действий. Министерство обороны Австралии уже заключило трёхлетнюю облачную сделку с Google, аналогичный договор имеется и у британских военных — это укрепит обмен разведданными с США. В октябре Google подала заявку австралийским регуляторам на прокладку подводного кабеля, соединяющего Остров Рождества с Дарвином (север Австралии) — именно там шесть месяцев в году базируется морская пехота Соединённых Штатов, не считая австралийских подразделений. Руководство острова изучает предполагаемое воздействие ЦОД на местное сообщество, лишь после этого оно согласится дать окончательное разрешение на строительство. Остров площадью 135 км2 до недавнего времени не имел качественных телекоммуникационных каналов, а 1,6 тыс. его жителей не имели возможности найти хорошую работу. Утверждается, что идея пользуется поддержкой, поскольку ЦОД действительно принесёт пользу местным — для него построят инфраструктуру, создадут рабочие места и в целом экономическая ценность острова повысится.

Источник изображения: Raphael Bick/unsplashc.com Правда, жители обеспокоены влиянием дата-центра на энергетику острова, находящегося в 1,5 тыс. км от Австралии. Сегодня там применяются дизельные генераторы, а также ограниченное число источников возобновляемой энергии. В «материковой» Австралии считают, что проект Google поможет диверсифицировать экономику острова, хотя для реализации проекта необходимо будет соблюдать все экологические требования. По словам источников Reuters, дата-центр коммерчески привлекателен для Google, поскольку расположен в Индийском океане между Африкой, Азией и Австралией. Военным же они интересен потому, что позволяет контролировать несколько ближайших проливов. Развитие оборонного сектора, как ожидается, улучшит экономику острова, однако местные жители опасаются, что это же отпугнёт туристов. Сейчас на острове активно развивается направление экотуризма. По данным Datacenter Dynamics, Минобороны Австралии заключило крупные контракты с американскими гиперскейлерами. В июле 2025 года с Microsoft подписана сделка на AU$495 млн ($324,71 млн) об использовании облачных вычислительных сервисов компании. В 2024 году появились данные, что AWS строит кампус для австралийского правительства для хранения совершенно секретной информации. Дата-центр и облачная система будет строиться в партнёрстве с AWS и австралийским правительством, последнее намерено вложить AU$2 млрд ($1,3 млрд) в новую систему в следующие десять лет. В 2023 году стало известно, что Пентагон оплатил треть стоимости подводного интернет-кабеля SubCo OAC от Омана до Австралии в обмен на секретное подключение военной базы на острове Диего-Гарсия.

10.11.2025 [15:00], Владимир Мироненко

Фирменные ИИ-ускорители Amazon всё ещё не могут конкурировать с чипами NVIDIA, считают некоторые стартапыНекоторые стартапы считают, что ИИ-чипы Trainium и Inferenetia собственной разработки Amazon менее конкурентоспособны, чем ускорители NVIDIA, сообщил ресурс Business Insider со ссылкой на внутреннюю документацию AWS. Согласно июльскому «конфиденциальному» внутреннему документу Amazon, ИИ-стартап Cohere обнаружил, что чипы Amazon Trainium 1 и 2 «уступают по производительности» ускорителям NVIDIA H100. Стартап отметил, что доступ к Trainium2 был «крайне ограничен», а в работе наблюдались частые перебои. Amazon и её подразделение Annapurna Labs всё еще изучают возникшие у Cohere «проблемы с производительностью», но прогресс в решении этих проблем был «ограниченным», отмечено в официальном документе. Также в нём упоминается стартап Stability AI, разработавший, в том числе, ИИ-генератор изображений Stable Diffusion, который высказывал схожие претензии. В частности, говорится, что чипы Amazon Trainium2 уступают NVIDIA H100 по задержке, что делает их «менее конкурентоспособными» с точки зрения скорости и стоимости. Ставка Amazon на чипы собственной разработки является частью её усилий по обеспечению конкурентоспособности в ИИ-гонке. Её прибыльность основана в том числе на использовании собственных процессоров Graviton вместо дорогостоящих чипов Intel. И сейчас Amazon тоже стремится задействовать собственные чипы для обработки ИИ-нагрузок. Если некоторые клиенты AWS не захотят использовать Trainium и будут настаивать на том, чтобы AWS запускала свои облачные ИИ-системы с использованием чипов NVIDIA, которые гораздо дороже её собственных решений, это отразится на её прибыли от облачных вычислений, отметил Business Insider. Рынок стартапов давно является важным для AWS, поэтому их претензии имеют большое значение для компании. Представитель Amazon заявил, что компания «благодарна» клиентам за отзывы, которые помогают сделать её чипы «еще лучше и более широко используемыми». Он добавил, что кейс с Cohere «не является актуальным», отметив, что её чипы Trainium и Inferentia «достигли отличных результатов» с такими клиентами, как Ricoh, Datadog и Metagenomi. «Мы очень довольны ростом и внедрением Trainium2, который на данном этапе в основном используется небольшим числом очень крупных клиентов, таких как Anthropic», — написал представитель в электронном письме ресурсу Business Insider. AWS утверждает, что ее собственные ИИ-ускорители предлагают на 30-40 % лучшие ценовые характеристики, чем нынешнее поколение GPU. Компания обладает «невероятными талантами» в области проектирования чипов и работает над новыми поколениями ускорителей. «Мы рассчитываем привлечь больше клиентов, начиная с Trainium 3, превью которого ожидается позже в этом году», — сказал представитель Amazon. Генеральный директор Amazon Энди Джасси (Andy Jassy) заявил во время отчёта о доходах компании, что чипы Trainium2 «полностью распределены по подписке» и теперь являются «многомиллиардным» бизнесом, который последовательно увеличивается на 150 % от квартала к кварталу. Жалобы клиентов Amazon на её чипы поступали и раньше. Согласно июльскому документу, стартап Typhoon обнаружил, что устаревшие ускорители NVIDIA A100 в три раза экономичнее для определённых рабочих нагрузок, чем чипы Inferentia2 от AWS, ориентированные на инференс. В свою очередь, исследовательская группа AI Singapore установила, что серверы AWS G6, оснащённые ускорителями NVIDIA, более экономичны по сравнению с Inferentia2 при различных вариантах использования. В прошлом году клиенты облака Amazon также отмечали «проблемы при внедрении» её пользовательских ИИ-чипов, которые создают «проблемные области», что ведёт к снижению их использования. Эти проблемы нашли отражение в доле рынка Amazon. По данным исследовательской компании Omdia, NVIDIA доминирует на рынке ИИ-чипов с долей более 78 %. За ней следуют Google и AMD, владеющие по чуть более 4 %. AWS занимает лишь шестое место с 2 % рынка. Наглядно иллюстрирует проблемы Amazon в этом отношении соглашение AWS и OpenAI стоимостью $38 млрд. Сделка предполагает использование облачных ИИ-серверов на базе ускорителей NVIDIA, без упоминания чипов Trainium. Ускорители NVIDIA не только обеспечивают высокую производительность, но подкрепляются широко распространённой платформой CUDA. Это качество особенно ценно при разработке крупных проектов в области ИИ с высоким уровнем риска, когда надёжность и имеющийся опыт могут сыграть решающую роль. В июльском документе сотрудники Amazon отметили, что технические ограничения и другие проблемы, связанные со сравнением пользовательских ИИ-чипов компании и ускорителей NVIDIA, стали «критическим препятствием» для клиентов, задумывающихся о переходе на чипы AWS. До публикации отчёта о доходах Amazon на прошлой неделе аналитики Bank of America соблюдали осторожность в оценке прогресса Tranium. В аналитической заметке, опубликованной в конце октября, они предупредили, что инвесторы «скептически» относятся к возможностям Trainium, и что «неясно», проявится ли высокий спрос на них «за пределами Anthropic». Недавно AWS запустила проект Project Rainier — ИИ-кластер из полумиллиона чипов Trainium2, которые будут использоваться для обучения LLM следующего поколения Anthropic. Ожидается, что к концу года Anthropic получит более 1 млн чипов Trainium2, но решение по этому вопросу ещё не принято. Если реализация проекта будет успешной, это станет огромным подспорьем для Amazon. Вместе с тем в прошлом месяце Anthropic подписала многомиллиардный контракт на использование Google TPU, отметив, что продолжит использовать Trainium. Хотя Anthropic публично признала сложность использования архитектур с разными чипами, представитель Amazon сообщил Business Insider, что Anthropic продолжает расширять использование Trainium и подчеркнул стремление компании предлагать клиентам широкий спектр аппаратных опций в рамках своих облачных сервисов. В ходе общения с аналитиками на прошлой неделе Джасси подчеркнул, что AWS сосредоточена на предоставлении «нескольких вариантов чипов». Он отметил, что цель состоит не в том, чтобы заменить чипы NVIDIA, а в том, чтобы предоставить клиентам больше выбора. Этой стратегии AWS придерживается и в других областях облачных вычислений, сказал он. «В истории AWS никогда не было случая, чтобы какой-то один игрок в течение длительного периода времени владел всем сегментом рынка, а затем мог удовлетворить потребности всех во всех аспектах», — сказал Джасси. В долгосрочной перспективе не слишком удачные продажи собственных ускорителей не лучшим образом скажутся на AWS. Компания понимает, что её решения могут быть менее производительны и удобны, поэтому и предлагает их по меньшей цене, чем ускорители NVIDIA. Однако стоимость их производства сравнима со стоимостью производства чипов такого же класса, и со временем она будет только расти. Проще говоря, Amazon меньше зарабатывает на своих чипах, а в худшем случае может терять на них деньги.

10.11.2025 [12:05], Сергей Карасёв

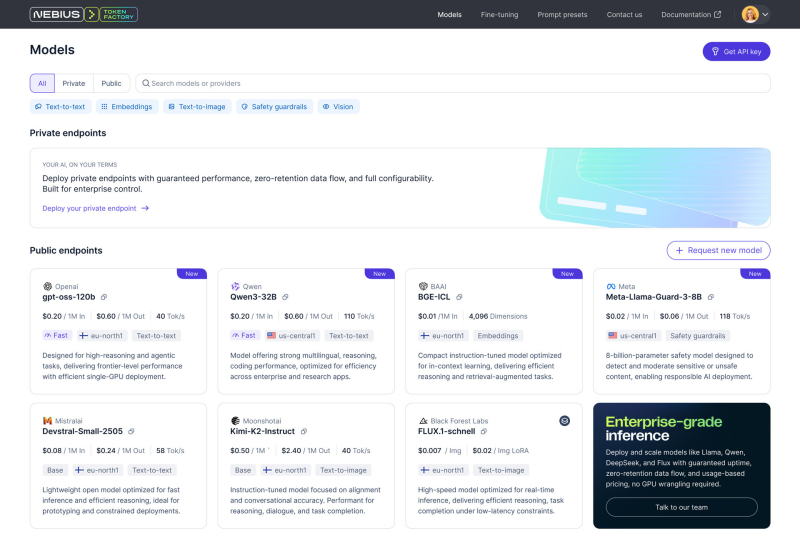

Фабрика токенов: Nebius, бывшая Yandex NV, запустила платформу Token Factory для инференса на базе открытых ИИ-моделейКомпания Nebius (бывшая материнская структура «Яндекса») представила платформу Nebius Token Factory для инференса: она позволяет разворачивать и оптимизировать открытые и кастомизированные ИИ-модели в больших масштабах с высоким уровнем надёжности и необходимым контролем. Nebius отмечает, что применение закрытых ИИ-моделей может создавать трудности при масштабировании. С другой стороны, открытые и кастомизированные модели позволяют устранить эти ограничения, но управление ими и обеспечение безопасности остаются технически сложными и ресурсоёмкими задачами для большинства команд. Платформа Nebius Token Factory призвана решить существующие проблемы: она сочетает гибкость открытых моделей с управляемостью, производительностью и экономичностью, которые необходимы организациям для реализации масштабных проектов в сфере ИИ. Nebius Token Factory базируется на комплексной ИИ-инфраструктуре Nebius. Новая платформа объединяет высокопроизводительный инференс, пост-обучение и управление доступом. Обеспечивается поддержка более 40 open source моделей, включая новейшие версии Deep Seek, Llama, OpenAI и Qwen. Среди ключевых преимуществ Nebius Token Factory заявлены соответствие требованиям корпоративной безопасности (HIPAA, ISO 27001 и ISO 27799), предсказуемая задержка (менее 1 с), автоматическое масштабирование пропускной способности и доступность на уровне 99,9 %. Инференс выполняется в дата-центрах на территории Европы и США без сохранения данных на серверах Nebius. Задействована облачная экосистема Nebius AI Cloud 3.0 Aether, что, как утверждается, обеспечивает безопасность корпоративного уровня, проактивный мониторинг и стабильную производительность. Отмечается, что Nebius Token Factory может применяться для решения широкого спектра ИИ-задач: от интеллектуальных чат-ботов, помощников по написанию программного кода и генерации с дополненной выборкой (RAG) до высокопроизводительного поиска, анализа документов и автоматизированной поддержки клиентов. Интегрированные инструменты тонкой настройки и дистилляции позволяют компаниям адаптировать большие открытые модели к собственным данным. При этом достигается сокращение затрат на инференс до 70 %. Оптимизированные модели затем можно быстро разворачивать без ручной настройки инфраструктуры.

09.11.2025 [13:38], Сергей Карасёв

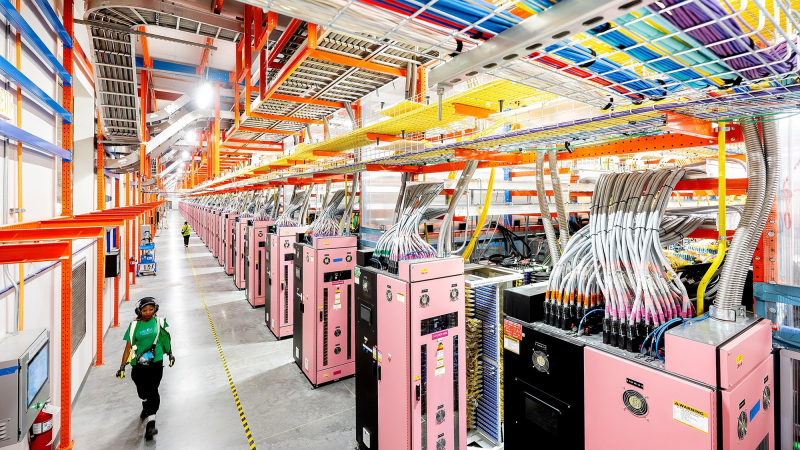

Nebius Аркадия Воложа развернула в Великобритании платформу AI Cloud на базе NVIDIA HGX B300Компания Nebius (бывшая материнская структура «Яндекса» Yandex N.V.) объявила о своём первом развёртывании ИИ-инфраструктуры в Великобритании. Кластер Nebius AI Cloud расположен в кампусе Longcross Park на площадке Ark Data Centres недалеко от Лондона. Как отмечает основатель и генеральный директор Nebius Аркадий Волож, Великобритания является одним из ведущих ИИ-центров в мире. Поэтому для компании создание кластера на территории этой страны имеет большое значение. Кластер состоит из 126 стоек с оборудованием, размещённых в трёх машинных залах. В рамках первой фазы проекта установлены 4 тыс. ускорителей NVIDIA HGX B300 (Blackwell Ultra) в составе серверов пятого поколения (Gen5) собственной разработки Nebius. Вторая фаза предполагает монтаж ещё 3 тыс. ускорителей B300. Общая мощность системы — 16 МВт. По заявлениям Nebius, британский кластер AI Cloud использует передовые энергоэффективные технологии охлаждения, сетевое подключение NVIDIA Quantum-X800 InfiniBand с низкой задержкой и надёжную локальную систему генерации электроэнергии. Говорится о полной интеграции с программной платформой NVIDIA AI Enterprise, предназначенной для разработки и развёртывания ИИ-приложений. Объединяя нашу облачную инфраструктуру с новейшими технологиями NVIDIA, мы предоставляем организациям по всей Великобритании возможность обучать, развёртывать и масштабировать модели и приложения ИИ быстрее, безопаснее и эффективнее, чем когда-либо», — говорит Волож. Британский кластер использует облачную платформу Nebius AI Cloud 3.0 Aether, которая разработана специально для создания и использования ИИ в таких областях, как здравоохранение, финансы, науки о жизни, корпоративный сектор и государственная сфера. Говорится о поддержке сквозного шифрования и о полном соответствии стандартам защиты данных GDPR и CCPA. Ранее Nebius сообщила о запуске своего первого кластера AI Cloud в Израиле, который расположился на площадке в Модиине (Modiin). У Nebius также имеются дата-центры в Финляндии, Франции и США. |

|