Материалы по тегу: s

|

20.10.2025 [14:16], Владимир Мироненко

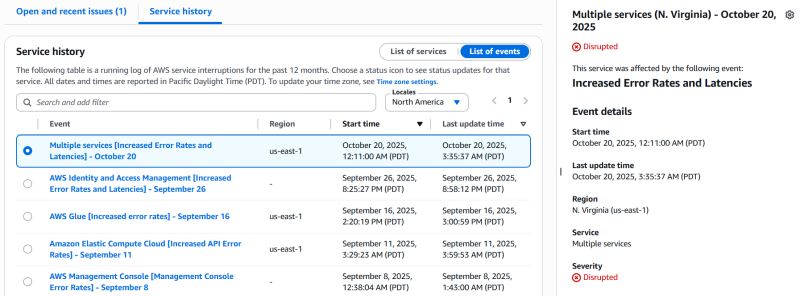

AWS столкнулась с серьёзным сбоем из-за ошибки DNS — падение одного сервиса потянуло за собой ещё 110 служб [Обновлено]Облако Amazon Web Services (AWS) столкнулось со серьёзным сбоем, из-за которого сейчас могут быть недоступны такие онлайн-сервисы, как Perplexity, Snapchat, Fortnite, Airtable, Canva, Amazon, Slack, Signal, PlayStation, Clash Royale, Brawl Stars, Epic Games Store и Ring Cameras, пишет Data Center Dynamics. Согласно отчёту Amazon, наблюдается «значительный уровень ошибок в запросах к DynamoDB в регионе US-EAST-1», который находится в Северной Вирджинии. Компания отметила, что эта проблема также затрагивает другие сервисы AWS в регионе US-EAST-1, а у клиентов может не быть возможности создавать или обновлять запросы в службу поддержки. Первопричиной проблем стала ошибка DNS. AWS её исправила и теперь занимается восстановлением доступности других сервисов. Проблема DynamoDB затронула другие сервисы AWS, включая AWS Global Accelerator, AWS VPCE PrivateLink, AWS Security Token Service, AWS Step Functions, AWS Systems Manager, Amazon CloudFront, Amazon DynamoDB, Amazon Elastic Compute Cloud, Amazon EventBridge, Amazon EventBridge Scheduler, Amazon GameLift Servers, Amazon Kinesis Data Streams, Amazon SageMaker и Amazon VPC Lattice — всего 82 службы. Сбои в работе сервисов AWS наблюдаются в других регионах по всему миру. Проблемы в работе AWS в регионе US-East-1 привели к масштабным сбоям в 2023, 2021 и 2020 годах, в результате чего было отключено множество веб-сайтов и платформ. Лишь спустя несколько часов было восстановлено нормальное обслуживание, сообщил The Verge. UPD: по состоянию на 21:45 МСК AWS продолжает работать над устранением проблем. По уточнённым данным, проблемы наблюдаются в 110 сервисах облака. Работа ещё 25 сервисов восстановлена. В качестве причины названы проблемы с сетью в US-EAST-1.

18.10.2025 [21:46], Владимир Мироненко

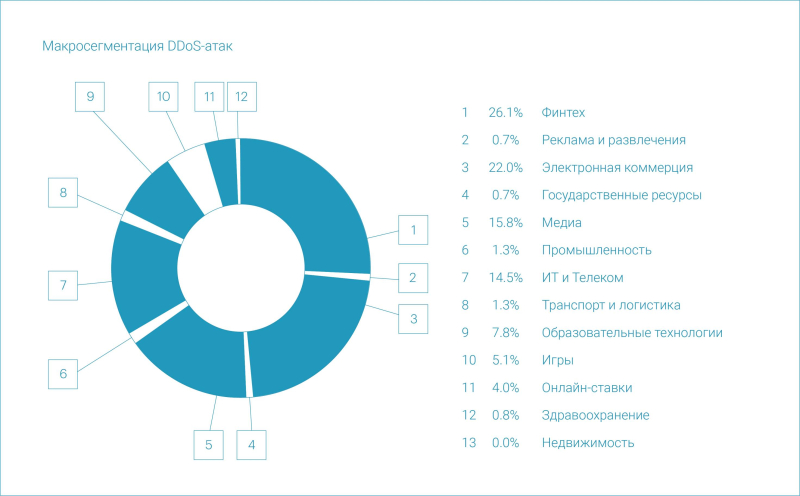

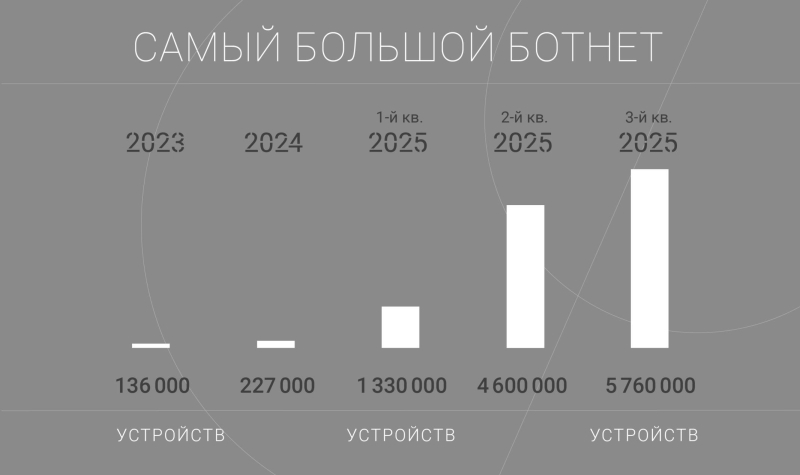

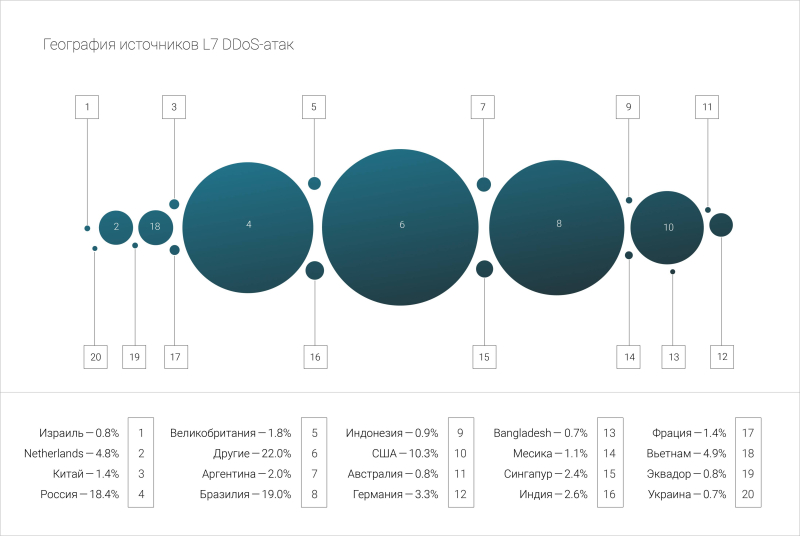

Curator: рекордный ботнет за полгода вырос вчетверо — до 5,8 млн устройствКомпания Curator (ранее Qrator Labs) опубликовала отчёт «DDoS, боты и BGP-инциденты в III квартале 2025 года: статистика и тренды», согласно которому в отчётном периоде больше всего DDoS-атак пришлось на сегменты «Финтех» (26,1 %), «Электронная коммерция» (22,0 %), «Медиа» (15,8 %) и «ИТ и Телеком» (14,5 %) — суммарно почти 78,3 % всех атак. Самая длительная DDoS-атака квартала продолжалась более девяти суток (225,9 ч). В среднем атака длилась 3370 с (около 56 мин.). Самая интенсивная L3–L4 DDoS-атака произошла 27 августа 2025 года, достигнув в пике 1,15 Тбит/с, что выше прошлогоднего рекорда в 1,14 Тбит/с. Она была направлена на организацию из сегмента «Онлайн-ритейл» и продолжалась всего несколько минут. Эта атака также была наиболее масштабной по максимальной скорости передачи пакетов: в пике — 174,7 Mpps. 1 сентября 2025 года была зафиксирована новая масштабная атака громадного DDoS-ботнета, впервые обнаруженного 26 марта 2025 года. В ходе ее отражения было заблокировано 5,76 млн IP-адресов. Для сравнения, в I квартале бот насчитывал 1,33 млн устройств, во II квартале — порядка 4,6 млн IP-адресов. То есть за неполные полгода бот вырос более чем в четыре раза. Атака была направлена на организацию из сегмента «Государственные ресурсы» и продолжалась около двух часов. В III квартале в рейтинге стран, которые чаще всего были источникам DDoS-атак на уровне приложений на первое место вышла Бразилия (19 %), на втором месте — Россия (18,4 %), третье место у США (10,3 %). После резкого роста «плохих» ботов во II квартале 2025 года (+31 %) в III квартале был отмечен резкий спад (–37 %), несмотря на заметный прирост количества защищаемых ресурсов. В основном затишье наблюдалось в летний период, а к сентябрю объём трафика «плохих» ботов снова вырос. Главным образом их атаки были нацелены на сегменты «Электронная коммерция» (42,79 %), «Онлайн-ставки» (21,71 %) и сегмент «Здравоохранение» (17,52 %), занявший третье место за счёт значительного объёма трафика на единственный ресурс.

17.10.2025 [14:49], Андрей Крупин

VK Cloud, Yandex Cloud и «Флант» создадут первую в России некоммерческую ассоциацию по облачным технологиямКомпании VK Cloud, Yandex Cloud и «Флант» объявили о планах по созданию некоммерческой Ассоциации облачно-ориентированных технологий (АОТ) — первой в РФ организации, которая займётся развитием новых подходов, стандартов и архитектуры нативных облачных технологий без привязки к конкретному вендору. АОТ призвана объединить игроков отечественного облачного рынка для популяризации облачных технологий, таких как Kubernetes и Cloud-native. Ключевыми задачами ассоциации станут продвижение и внедрение Cloud-native-решений через стандартизацию подходов и компетенций в разработке ПО, поддержка и развитие Open Source-продуктов, а также их внедрение в бизнес-среде, популяризация облачных технологий и Kubernetes, а также развитие и объединение профессионального сообщества.

Источник изображения: Monisha Selvakumar / unsplash.com Стать партнёром АОТ сможет любая компания, использующая в работе облачные технологии, а участником — любой IT-специалист. Статус партнёра предполагает ежегодные взносы, которые идут на проекты ассоциации, и открывает доступ к проектам и ресурсам АОТ. «Мы считаем, что базовые облачные технологии должны быть доступны всем, и у каждого должна быть возможность вносить в них свой вклад. Наша совместная задача с партнёрами из Ассоциации облачно-ориентированных технологий — объединить усилия крупнейших организаций и всех инженеров, которым не безразличен Open Source, чтобы ускорить развитие индустрии в целом», — прокомментировали инициативу в компании «Флант».

15.10.2025 [12:14], Владимир Мироненко

Oracle запустит в 2026 году ИИ-кластер на базе 50 тыс. AMD Instinct MI450Oracle объявила о расширении сотрудничества с AMD, в рамках которого Oracle Cloud Infrastructure (OCI) запустит первый публично доступный ИИ-суперкластер на базе 50 тыс. ускорителей AMD Instinct MI450. Согласно пресс-релизу, первоначальное развёртывание кластера начнётся в III квартале 2026 года, после чего он будет расширяться в 2027 году, а также в дальнейшем. Будущие ИИ-кластеры OCI будут основаны на стоечной архитектуре AMD Helios с использованием ускорителей AMD Instinct серии MI450, процессоров AMD EPYC следующего поколения с кодовым названием Venice и сетевой системы AMD Pensando следующего поколения с кодовым названием Vulcano. Махеш Тиагараджан (Mahesh Thiagarajan), исполнительный вице-президент OCI отметил, что благодаря десятилетнему сотрудничеству с AMD — от ускорителей EPYC до AMD Instinct — компания продолжает предоставлять «оптимальную по соотношению цены и производительности, открытую, безопасную и масштабируемую облачную платформу в партнерстве с AMD, чтобы удовлетворить потребности клиентов в новой эре ИИ». Ускоритель AMD Instinct MI450 основан на архитектуре CDNA 5 и изготавливается по 2-нм техпроцессу TSMC. Ускоритель будет обладать до 432 Гбайт памяти HBM4 с пропускной способностью 20 Тбайт/с. Стойка AMD Helios с 72 ускорителями AMD Instinct MI450 объединяет возможности масштабирования UALoE и масштабируемую сеть на базе Ethernet, соответствующую стандартам Ultra Ethernet (UEC), для минимизации задержек и максимальной пропускной способности между модулями и стойками.

Источник изображения: Oracle Сообщается, что процессоры EPYC (Venice) будут предлагать возможности конфиденциальных вычислений и встроенные функции безопасности для комплексной защиты конфиденциальных рабочих ИИ-нагрузок. Конвергентные сети с DPU, созданные на основе полностью программируемой технологии AMD Pensando, обеспечат безопасность и производительность, необходимые ЦОД для работы с ИИ следующего поколения, включая обучение, инференс и облачные рабочие нагрузки. Каждый ускоритель может быть оснащён до трёх DPU Vulcano со скоростью передачи данных 800 Гбит/с. Несколько месяцев назад Oracle и AMD объявили, что провайдер облачных вычислений развернёт кластер, включающий до 131 072 ускорителей AMD MI355X, на основе ранее запущенного кластера на базе AMD Instinct MI300X. Ранее в этом месяце стало известно о соглашении AMD с OpenAI на поставку ИИ-ускорителей AMD нескольких поколений общей мощностью 6 ГВт на сумму около $60–$80 млрд для обеспечения её ИИ-инфраструктуры.

14.10.2025 [15:49], Андрей Крупин

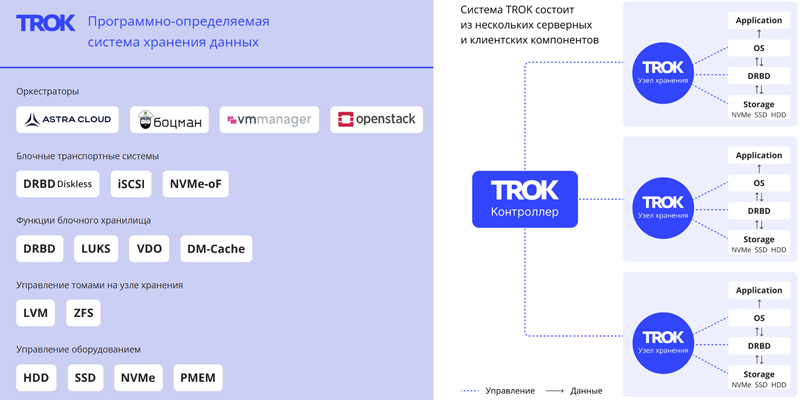

«Группа Астра» представила программно-определяемую систему хранения данных TROK«Группа Астра» объявила о выпуске TROK — российского программно-определяемого хранилища данных (Software-defined storage, SDS), предназначенного для построения отказоустойчивых облачных инфраструктур и корпоративных систем хранения. Система TROK может быть развёрнута на любом типовом сервере с архитектурой x86-64, amd64 или Arm. Решение позволяет управлять виртуальными устройствами, поддерживает разные протоколы доступа (блочный, файловый, объектный), параллельную синхронную репликацию данных между узлами хранения, возможность подключения по iSCSI, NVMEoF Target, NFS и различные механизмы восстановления данных. Доступен API управления хранилищем с поддержкой аутентификации. Продукт интегрирован в экосистему «Группы Астра» и совместим с отечественными платформами, включая ОС Astra Linux и СУБД Tantor.

Источник изображения: trok-sds.ru По заверениям разработчика, TROK подходит для построения частных, гибридных, публичных облаков и обеспечивает снижение совокупной стоимости владения (TCO) до 50 % по сравнению с проприетарными СХД. Стоимость TROK зависит от количества поддерживаемых виртуальных блочных устройств (доступны варианты на 10 Тбайт и 1 Пбайт), типа лицензии (бессрочная или подписка) и срока технической поддержки. Платформа зарегистрирована в реестре отечественного программного обеспечения и полностью подходит для задач импортозамещения.

14.10.2025 [09:54], Сергей Карасёв

Giga Computing представила ИИ-сервер TO86-SD1 на платформе NVIDIA HGX B200Компания Giga Computing, подразделение Gigabyte, анонсировала высокопроизводительный сервер TO86-SD1 для обучения ИИ-моделей, инференса и ресурсоёмких HPC-задач. Новинка выполнена в форм-факторе 8OU в соответствии со стандартом OCP ORv3. Возможна установка двух процессоров Intel Xeon 6500P/6700P (Granite Rapids-SP) с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5 (RDIMM 6400 или MRDIMM 8000). Во фронтальной части предусмотрены отсеки для восьми SFF-накопителей с интерфейсом PCIe 5.0 (NVMe); поддерживается горячая замена. Есть коннектор M.2 2280/22110 для SSD (PCIe 5.0 x4). Упомянута поддержка CXL 2.0. Сервер несёт на борту ИИ-ускорители NVIDIA HGX B200 поколения Blackwell в конфигурации 8 × SXM. Суммарный объём памяти HBM3E составляет 1,4 Тбайт. Доступны 12 слотов PCIe 5.0 x16 для карт расширения FHHL с доступом через лицевую панель корпуса. Говорится о совместимости с NVIDIA BlueField-3 DPU и NVIDIA ConnectX-7 NIC.

Источник изображения: Giga Computing В оснащение входят контроллер ASPEED AST2600, два сетевых порта 10GbE на базе Intel X710-AT2, выделенный сетевой порт управления 1GbE, разъёмы USB 3.2 Gen1 Type-C, Micro-USB и Mini-DP. Применяется система воздушного охлаждения с четырьмя 92-мм вентиляторами в области материнской платы и двенадцатью 92-мм кулерами в GPU-секции. Диапазон рабочих температур — от +10 до +35 °C. Заявлена совместимость с Windows Server, RHEL, Ubuntu, Citrix, VMware ESXi.

13.10.2025 [13:20], Сергей Карасёв

«Инферит» представил российские 2U-серверы для ИИ на базе Intel Xeon Emerald RapidsРоссийский поставщик IT-решений «Инферит» (ГК Softline) анонсировал серверы на аппаратной платформе Intel. Дебютировали модели UR2X2G4V1-D24, GR2X2G4V1-D24, UR2X2G4V1-D12 и GR2X2G4V1-D12 для решения различных задач. Все новинки выполнены в форм-факторе 2U. Они могут нести на борту два процессора Intel Xeon Sapphire Rapids или Xeon Emerald Rapids с TDP до 350 Вт. Поддерживается до 8 Тбайт оперативной памяти DDR5-4400/4800 в виде 32 модулей. Модель Inferit UR2X2G4V1-D24 предназначена для комплексных вычислений, виртуализации, облачных сервисов и работы с большими данными. Во фронтальной части расположены 24 отсека для SFF-накопителей SAS/SATA/NVME с поддержкой горячей замены. Доступны два слота PCIe 5.0 x16 и четыре слота PCIe 5.0 x8 для карт полной высоты, а также два разъёма OCP 3.0 (PCIe 5.0 x8). Предусмотрены выделенный сетевой порт управления 1GbE (RJ45), последовательный порт, разъёмы USB 3.0 и D-Sub. Установлены два блока питания мощностью 1300 Вт с сертификатом 80 Plus Platinum. Вариант Inferit GR2X2G4V1-D24 имеет аналогичные технические характеристики, но оснащается двумя ИИ-ускорителями на базе GPU суммарной мощностью до 600 Вт. Система ориентирована на развёртывание языковых моделей, обучение ИИ, 3D-визуализацию и 3D-рендеринг, работу с большими данными, комплексные научные вычисления, виртуализацию и облачные сервисы. Задействованы два блока питания на 2000 Вт с сертификатом 80 Plus Platinum. Сервер Inferit UR2X2G4V1-D12, в свою очередь, подходит для комплексных вычислений, виртуализации и облачных сервисов. Он оборудован 12 лицевыми отсеками для LFF/SFF-накопителей SAS/SATA/NVMe с поддержкой горячей замены. Прочие характеристики аналогичны версии Inferit UR2X2G4V1-D24. Наконец, модификация Inferit GR2X2G4V1-D12 схожа с версией GR2X2G4V1-D24, но при этом оснащена 12 посадочными местами для накопителей LFF/SFF. На все серверы опционально предустанавливается фирменная ОС «МСВСфера». Базовая гарантия составляет три года с возможностью продления до пяти лет. «Мы укрепляем свои позиции на рынке ИТ, развивая линейки собственных продуктов для бизнеса и госсектора. Новая серия серверов — это топовое решение в нашей продуктовой линейке для крупного бизнеса, науки и госучреждений. Конструируя их, мы ориентировались не только на производительность — надёжность, масштабируемость и минимум отказов были не меньшими приоритетами», — говорит «Инферит Техника».

13.10.2025 [00:30], Владимир Мироненко

Вложи $5 млн — получи $75 млн: NVIDIA похвасталась новыми рекордами в комплексном бенчмарке InferenceMAX v1

b200

gb200

hardware

nvidia

open source

semianalysis

бенчмарк

ии

инференс

рекорд

финансы

энергоэффективность

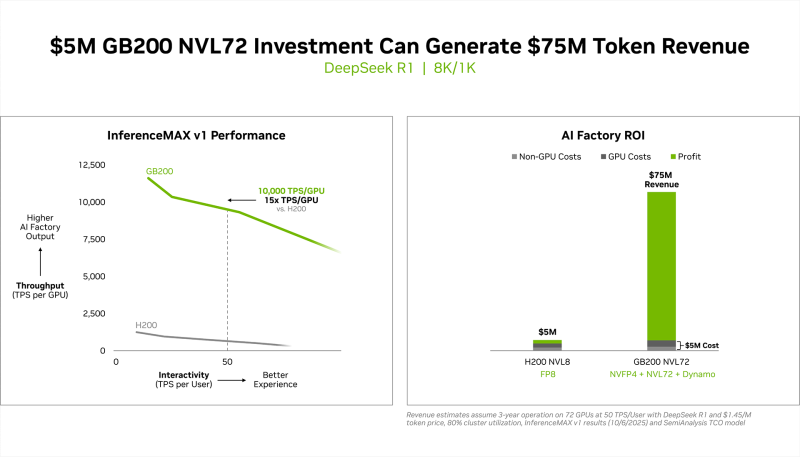

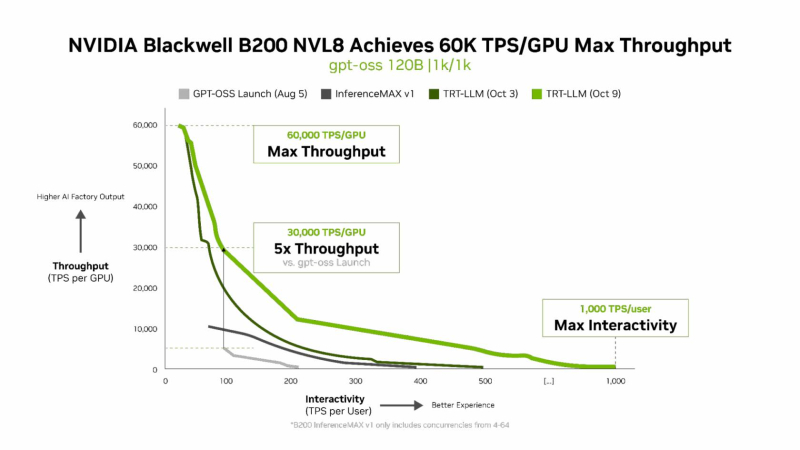

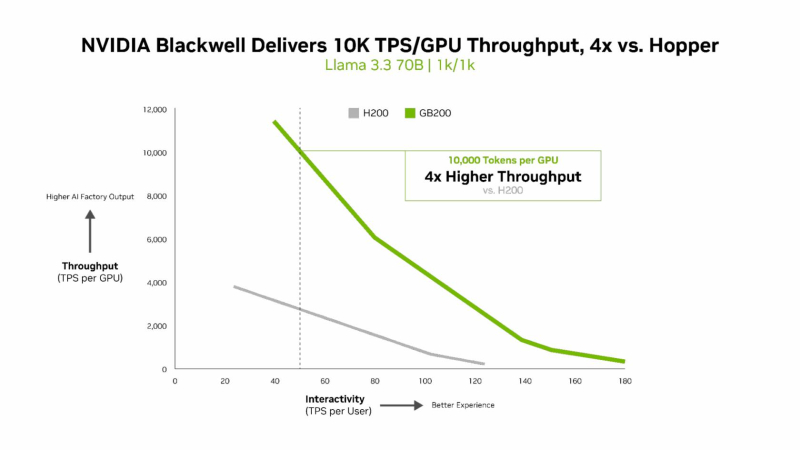

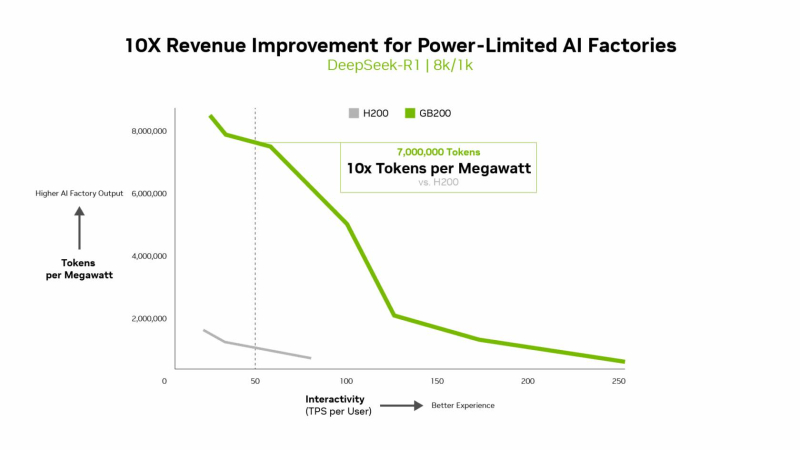

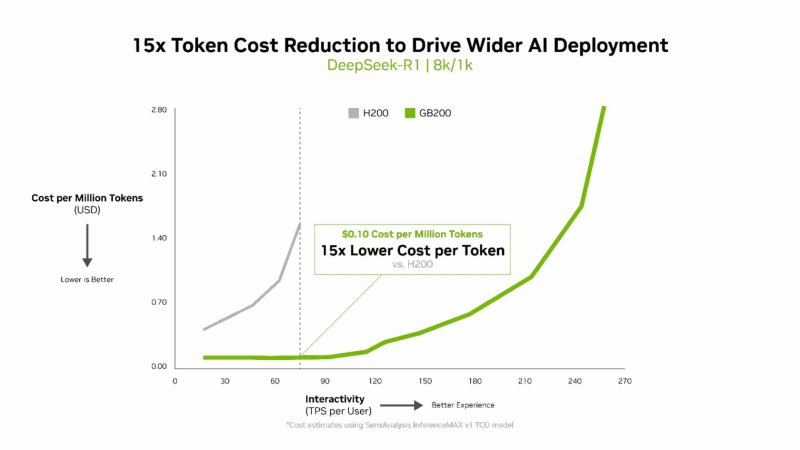

NVIDIA сообщила о результатах, показанных суперускорителем GB200 NVL72, в новом независимом ИИ-бенчмарке InferenceMAX v1 от SemiAnalysis. InferenceMAX оценивает реальные затраты на ИИ-вычисления, определяя совокупную стоимость владения (TCO) в долларах на миллион токенов для различных сценариев, включая покупку и владение GPU в сравнении с их арендой. InferenceMAX опирается на инференс популярных моделей на ведущих платформах, измеряя его производительность для широкого спектра вариантов использования, а результаты может перепроверить любой желающий, говорят авторы бенчмарка. Суперускоритель GB200 NVL72 победил во всех категориях бенчмарка InferenceMAX v1. Чипы NVIDIA Blackwell показали наилучшую окупаемость инвестиций — вложение в размере $5 млн приносят $75 млн дохода от токенов DeepSeek R1, обеспечивая 15-кратную окупаемость (год назад NVIDIA обещала ROI на уровне 700 %). Также ускорители поколения Blackwell отличаются самой низкой совокупной стоимостью владения. например, оптимизация ПО NVIDIA B200 позволила добиться стоимости всего в два цента на миллион токенов на OpenAI gpt-oss-120b, обеспечив пятикратное снижение стоимости одного токена всего за два месяца. NVIDIA B200 первенствовал и по пропускной способности и интерактивности, обеспечив 60 тыс. токенов в секунду на ускоритель и 1 тыс. токенов в секунду на пользователя в gpt-oss с новейшим стеком NVIDIA TensorRT-LLM. NVIDIA сообщила, что постоянно повышает производительность путём оптимизации аппаратного и программного стека. Первоначальная производительность gpt-oss-120b на системе NVIDIA DGX Blackwell B200 с библиотекой NVIDIA TensorRT LLM уже была лидирующей на рынке, но команды NVIDIA и сообщество разработчиков значительно оптимизировали TensorRT LLM для ускорения исполнения открытых больших языковых моделей (LLM). Компания отметила, что выпуск TensorRT LLM v1.0 стал значительным прорывом в повышении скорости инференса LLM благодаря распараллеливанию и оптимизации IO-операций. А у недавно вышедшей модели gpt-oss-120b-Eagle3-v2 используется спекулятивное декодирование — интеллектуальный метод, позволяющий предсказывать несколько токенов одновременно. Это уменьшает задержку и обеспечивает получение ещё более быстрых результатов — пропускная способность выросла втрое, до 100 токенов в секунду на пользователя (TPS/пользователь), а общая производительность на ускоритель выросла с 6 до 30 тыс. токенов. Для моделей с «плотной» архитектурой (Dense AI), таких как Llama 3.3 70b, которые требуют значительных вычислительных ресурсов из-за большого количества параметров и одновременного использования всех параметров в процессе инференса, NVIDIA Blackwell B200 достиг нового рубежа производительности в бенчмарке InferenceMAX v1, отметила NVIDIA. Суперускоритель показал более 10 тыс. токенов/с (TPS) на GPU при 50 TPS на пользователя, т.е. вчетверо более высокую пропускную способность на GPU по сравнению с NVIDIA H200. NVIDIA подчеркнула, что такие показатели, как количество токенов на Вт, стоимость на миллион токенов и TPS/пользователь не уступают по важности пропускной способности. Фактически, для ИИ-фабрик с ограниченной мощностью ускорители с архитектурой Blackwell обеспечивают до 10 раз лучшую производительность на МВт по сравнению с предыдущим поколением и позволяют получать более высокий доход от токенов. Компания отметила, что стоимость обработки одного токена (Cost per Token) имеет решающее значение для оценки эффективности ИИ-модели и напрямую влияет на эксплуатационные расходы. NVIDIA утверждает, что в целом архитектура NVIDIA Blackwell позволила снизить стоимость обработки миллиона токенов в 15 раз по сравнению с предыдущим поколением. В InferenceMAX используется метод оценки эффективности Pareto front, определяющий наилучшее (компромиссное) сочетание различных факторов для оценки производительности ускорителя. Это показывает, насколько Blackwell лучше конкурентов справляется с балансом стоимости, энергоэффективности, пропускной способности и скорости отклика. Системы, оптимизированные только для одной метрики, могут демонстрировать пиковую производительность «в вакууме», но такая «экономика» не масштабируется в производственных средах. Компания отметила, что ИИ переходит от экспериментальных пилотных проектов к ИИ-фабрикам — инфраструктуре, которая производит интеллектуальные решения, преобразуя данные в токены и решения в режиме реального времени. Фреймворк NVIDIA Think SMART помогает предприятиям ориентироваться в этом переходе, демонстрируя, как полнофункциональная платформа инференса обеспечивает измеримую окупаемость инвестиций. Обещая 15-кратную окупаемость инвестиций и непрерывный рост производительности за счёт ПО, NVIDIA не просто лидирует в текущей гонке ИИ-технологий, но и задаёт правила для следующего этапа, где экономика будет определять победителей рынка, пишет The Tech Buzz. Для предприятий, делающих ставку на конкурирующие платформы в своих стратегиях по развёртыванию ИИ, результаты таких бенчмарков должны побудить к пересмотру выбора ИИ-инфраструктуры.

10.10.2025 [10:11], Сергей Карасёв

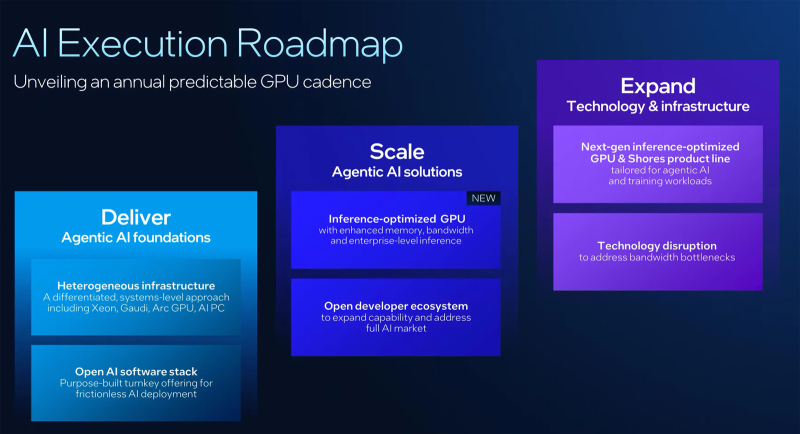

Intel готовит новый GPU-ускоритель, оптимизированный для инференсаКорпорация Intel в ходе мероприятия Intel Tech Tour Arizona сообщила о подготовке новых ИИ-ускорителей на базе GPU. Речь идёт об изделиях, специально оптимизированных для задач инференса. Кроме того, компания поделилась планами по развитию ИИ-продуктов в целом. Ранее предполагалось, что в 2025 году Intel выведет на рынок ускорители Falcon Shores. Изначально планировалось, что это будут гибридные решения, содержащие блоки CPU и GPU. Однако впоследствии Intel сделала выбор в пользу конфигурации исключительно на основе GPU. А затем корпорация и вовсе заявила, что на коммерческом рынке изделия Falcon Shores не появятся. Вместо этого Intel решила сфокусировать внимание на выпуске ускорителей Jaguar Shores. Войдёт ли готовящийся к выпуску GPU для инференса в семейство Jaguar Shores, пока не ясно. Подробности о новинке Intel обещает раскрыть в ходе предстоящего мероприятия 2025 OCP Global Summit, которое пройдёт с 13 по 16 октября в Сан-Хосе (Калифорния, США). На сегодняшний день известно, что устройство получит улучшенную память с высокой пропускной способностью. Изделие будет ориентировано на корпоративный сектор. «Мы активно работаем над оптимизированным для инференса GPU, о котором подробнее расскажем на конференции OCP», — сообщил технический директор Intel Сачин Катти (Sachin Katti). Кроме того, Intel объявила о намерении перейти на ежегодный график выпуска ИИ-продуктов следующего поколения. Предполагается, что это поможет укрепить позиции на глобальном рынке ИИ, на котором корпорация уступила позиции NVIDIA. При этом Intel подчёркивает, что на ближайшую перспективу Jaguar Shores является основным приоритетом в области развития высокопроизводительных решений для ИИ-инфраструктуры.

10.10.2025 [01:23], Владимир Мироненко

Ложная надежда: Synology смягчила требования к использованию сторонних HDD/SSD, но профессиональных систем это не коснулосьSynology объявила о выпуске системы DiskStation Manager (DSM) 7.3, которая, как указано в пресс-релизе, обеспечивает повышенную эффективность хранения, усиленную безопасность и надёжность, а также получила новые функции для повышения производительности. Вместе с тем компания под давлением пользователей ослабила политику ограничения использования сторонних накопителей в своих NAS. Однако поблажки сделаны только для SOHO-пользователей. Как отметил ресурс NAScompares.com, с выпуском DSM 7.3 компания официально представила самый подробный на сегодняшний день пакет политик совместимости с указанием, какие жёсткие диски и твердотельные накопители поддерживаются в её экосистеме. Ограничения DSM 7.2 на использование накопителей сторонних брендов, сделавшее жёсткие диски Seagate, Toshiba и WD, практически непригодными для использования в новых моделях серии DiskStation Plus вызвало серьёзную негативную реакцию со стороны пользователей, которые полагались на гибкий выбор дисков. Представленный в DSM 7.3 фреймворк HCL 5.0 частично смягчает введенные ранее ограничения для DiskStation Plus и серии J 2025 модельного года, возвращая возможность использования неперечисленных в списке совместимых HDD и SSD с интерфейсом SATA для создания пулов. Synology описала это как прагматичную эволюцию своей политики, которая соответствует ожиданиям клиентов. Компания продолжит сотрудничать с основными производителями накопителей для проверки дополнительных моделей. С точки зрения Synology есть три типа накопителей:

Источник изображения: Synology DSM 7.3 теперь отображает более понятные уведомления в диспетчере хранения, различая совместимые, несовместимые и прочие диски, что позволяет оценить влияние выбора оборудования на работу системы до создания томов и кешей. Кроме того, Synology пояснила, что для прохождения сертификации и попадания в список совместимых накопители должны пройти тесты на термические нагрузки, устойчивость к циклам вкл./выкл. и аварийное выключение. В DSM 7.3 Synology пересмотрела подход своих NAS к работе с SATA-дисками, которых нет в списке совместимых и нет в списке несовместимых. Для моделей DS+ Plus 2025 года, включая DS1525+, DS925+ и DS725+, эти диски теперь считаются полностью функциональными и в работе ничем не отличаются от официально совместимых накопителей, поддерживая установку, создание/расширение пулов/томов, работу со снимками и шифрование, использование HyperBackup и т.д., а DSM больше не «ругается» на них. DSM 7.2 блокировала создание пула, если установленный диск не входил в список совместимых. С M.2 NVMe SSD ситуация особая. Для создания новых кешей или пулов хранения требуются только накопители из списка совместимых, поскольку такие диски подвергаются более высоким постоянным нагрузкам записи и выделяют больше тепла при непрерывной работе NAS. Ранее сконфигурированные NVMe SSD по-прежнему можно использовать только при миграции со старых NAS на новые. Гарантия предоставляется в полном объёме, но техподдержка Synology может отказать в помощи с проблемами, которые, как доказано, вызваны оборудованием, не входящим в список совместимых. В то же время корпоративные серии СХД Synology FS, HD, SA, UC, XS+, XS, RS+, RS и DP продолжают работать в соответствии с более строгими правилами, согласно которым для полноценной работы требуются только диски SAS/SATA/NVMe из списка совместимых. SATA-накопители, не входящие в список совместимых, можно использовать только для миграции. Кеширующие накопители вне списка совместимых также запрещены к использованию. Synology объясняет это тем, что для корпоративных нагрузок требуются надёжные накопители с устойчивостью к различным сбоям, в том числе в многоузловых конфигурациях, способностью к корректному восстановлению после сбоев и с заданным уровнем производительности. Похожие аргументы приводятся и в пользу допустимости использования в СХД DVR/NVR SATA-накопителей вне списка совместимых только для миграции данных со старых систем. Совместимые накопители также должны пройти отдельные тесты на возможность непрерывной записи с малым временем отклика. Проблема в том, что Synology не спешит сертифицировать сторонние накопители. Так, Seagate IronWolf/SkyHawk и WD Purple в списках толком нет. Параллельно Synology подталкивает к использованию фирменных накопителей HAT/HAS/SAT. При покупке NAS/СХД вместе с ними можно получить расширенную гарантию сроком до пяти лет. Также Synology запустила программу экспресс-замены, позволяющую производить немедленную замену дисков в течение гарантийного срока, не дожидаясь отправки и проверки неисправного устройства. |

|