Материалы по тегу: s

|

25.10.2025 [22:25], Сергей Карасёв

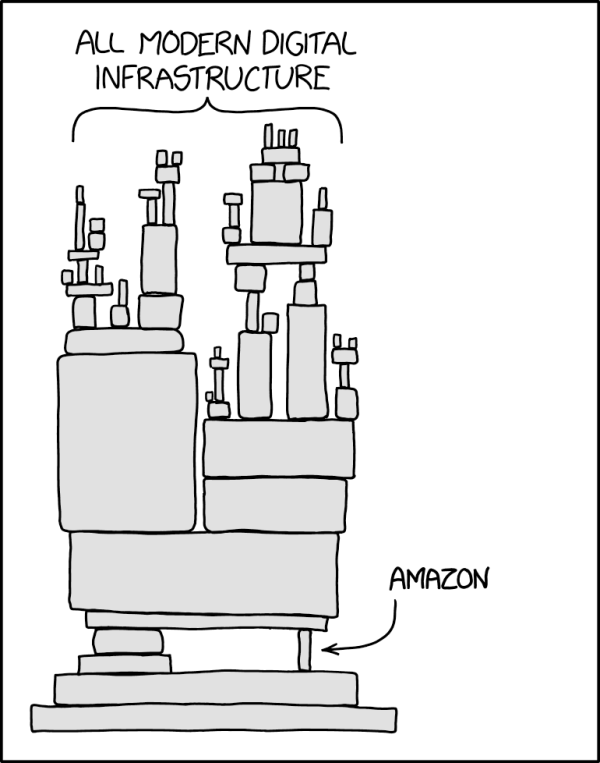

К масштабному сбою AWS привела ошибка в средствах автоматизации DNSКомпания Amazon опубликовала развёрнутый отчёт о причинах масштабного сбоя в работе облака Amazon Web Services (AWS). Проблемы, затронувшие многочисленные сервисы, возникли из-за ошибки в программном обеспечении для автоматизации. Сбой произошел в регионе us-east-1 в Северной Вирджинии. Утверждалось, что первопричиной проблем стала ошибка DNS. В общей сложности были затронуты более 110 собственных служб AWS. По данным сайта Downdetector, который отслеживает сбои в работе интернета, от пользователей по всему миру поступили более 8,1 млн сообщений о проблемах. Пострадали такие платформы, как Signal, Snapchat, Roblox, Duolingo, Apple Music, Apple TV, Lyft, Fortnite, Disney+, Venmo, Doordash, Hulu и многие другие. Как сообщает Amazon, сбой возник из-за неполадок в работе DynamoDB, с которой связаны сотни тысяч записей DNS, необходимых для работы огромного гетерогенного парка балансировщиков нагрузки в каждом регионе. При этом применяются средства автоматизации для обновления записей DNS и устранения любых проблем. Однако 20 октября система управления DNS для DynamoDB в ЦОД Amazon в Северной Вирджинии оказалась в состоянии гонки (race condition), в результате чего DNS-запись для региональной точки подключения к DynamoDB (dynamodb.us-east-1.amazonaws.com) оказалась пустой, хотя резервирование систем DNS как раз должно было предотвратить подобную ситуацию. Устранить неполадку самостоятельно система автоматизации не смогла, поэтому пришлось привлечь к решению проблемы специалистов. При этом DynamoDB оказалась недоступна для десятков собственных сервисов AWS и бесчисленного множества клиентских служб и приложений, которые используют её в своей работе, что привело к каскадным сбоям онлайн-сервисов. Amazon временно отключила систему автоматизации DNS для DynamoDB по всему миру, пообещав исправить в ней баги и добавив новые проверки. Также дополнительные механизмы контроля и новые системы проверки получат балансировщики NLB и службы EC2. Впрочем, эксперты отмечают, что данный инцидент наглядно показал, насколько мир может быть зависимым от единых точек отказа. Это касается не только AWS, но и других крупных облачных провайдеров, на инфраструктуру которых полагается огромное количество интернет-сервисов.

24.10.2025 [20:00], Сергей Карасёв

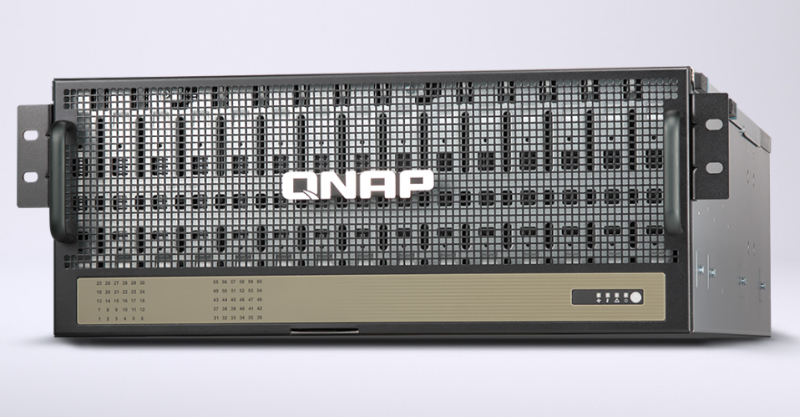

Модуль расширения QNAP TL-R6020Sep-RP рассчитан на 60 накопителей LFF суммарной ёмкостью 1 ПбайтКомпания QNAP Systems анонсировала модуль расширения TL-R6020Sep-RP, рассчитанный на подключение к сетевым хранилищам NAS. Устройство, предназначенное для монтажа в стойку, выполнено в форм-факторе 4U и оборудовано 60 посадочными местами для LFF-накопителей. Новинка позволяет использовать HDD с интерфейсом SATA-3 или SAS-3. Суммарная вместимость может превышать 1 Пбайт. Загрузка накопителей осуществляется через верхнюю часть корпуса. Реализованы четыре высокоскоростных порта Mini-SAS HD (SFF-8644). При этом технология Broadcom SAS DataBolt отвечает за оптимизацию процессов передачи данных и повышение общей производительности: в частности, два канала на 6 Гбит/с могут быть объединены для удвоения пропускной способности. В зависимости от конфигурации к одному NAS могут быть подключены до четырёх полок TL-R6020Sep-RP. В сумме это обеспечит возможность установки до 240 накопителей общей вместимостью свыше 4 Пбайт. В таких массивах QNAP рекомендует использовать четырёхпортовую SAS-карту расширения QXP-1630S-3816 с интерфейсом PCIe 4.0 х8. Кроме того, говорится о совместимости с двухпортовыми картами QXP-830S-3808 и QXP-820S-B3408. Устройство имеет размеры 176 × 482 × 750 мм и весит 25,2 кг без установленных накопителей. Диапазон рабочих температур простирается от 0 до +40 °C. Питание обеспечивают два блока мощностью 1300 Вт каждый. Применена система воздушного охлаждения с шестью вентиляторами диаметром 120 мм. Стандартная гарантия производителя составляет пять лет.

24.10.2025 [11:41], Руслан Авдеев

Vantage построит для OpenAI в Висконсине кампус Stargate Lighthouse стоимостью более $15 млрдОчередной кампус Stargate появится в США. Компании OpenAI, Oracle и Vantage Data Centers намерены построить площадку Lighthouse в штате Висконсин, на реализацию проекта уйдёт более $15 млрд, сообщает Silicon Angle. В кампусе разместятся четыре ЦОД с общей вычислительной мощностью почти 1 ГВт. Vantage, занимающаяся строительством ЦОД, основана в 2010 году инвестиционной компанией Silver Lake. В прошлом году Vantage привлекла $6,4 млрд на развитие своей инфраструктуры, по состоянию на январь 2024 года в её портфолио насчитывалось более 30 действующих и запланированных дата-центров. Lighthouse будет расположен в пригороде Милуоки (Milwaukee) на берегу озера Мичиган. В Vantage намерены создать «водно-положительный» кампус, который будет восстанавливать больше питьевой воды, чем потреблять. Для этого планируется использовать замкнутую систему жидкостного охлаждения для минимизации потерь воды. Также компания вложит средства в очистные сооружения, модернизацию водопровода и сопутствующие проекты. Новую инфраструктуру планируется построить в рамках программы объёмом в $175 млн. Также программа предусматривает реализации проектов в сфере производства электроэнергии. Vantage намерена поддержать развитие возобновляемой энергетики в Висконсине — солнечной и ветряной, а также создание аккумуляторных накопителей. Предполагается, что 70 % энергии будет выделяться проекту Lighthouse, а остальная часть будет доступна потребителям из Висконсина. Как заявил представитель OpenAI, проект позволит создать «хорошие» рабочие места, развивать энергетику с нулевыми выбросами и стимулировать местную экономику. При этом мощности будут расширяться без повышения тарифов для местных клиентов энергокомпаний. Vantage намерена начать строительство в ближайшее время, завершиться оно должно в 2028 году. В Vantage считают, что вклад в ВВП региона составит $2,7 млрд. Lighthouse — один из двух кампусов Stargate, строительство которых осуществляется при участии OpenAI и Oracle. В Техасе рядом с уже начавшим работу кампусом Stargate от Crusoe также строится кампус Frontier, рассчитанный на 10 дата-центров общей вычислительной мощностью более 1,4 ГВт. Vantage намерена инвестировать в проект более $25 млрд. На две площадки Vantage придётся около четверти мощностей ЦОД, которые OpenAI рассчитывает построить в США в рамках проекта Stargate. Общая стоимость проекта оценивается в $500 млрд до 2029 года. $300 млрд получить от партнёрства с OpenAI планирует Oracle.

23.10.2025 [15:49], Андрей Крупин

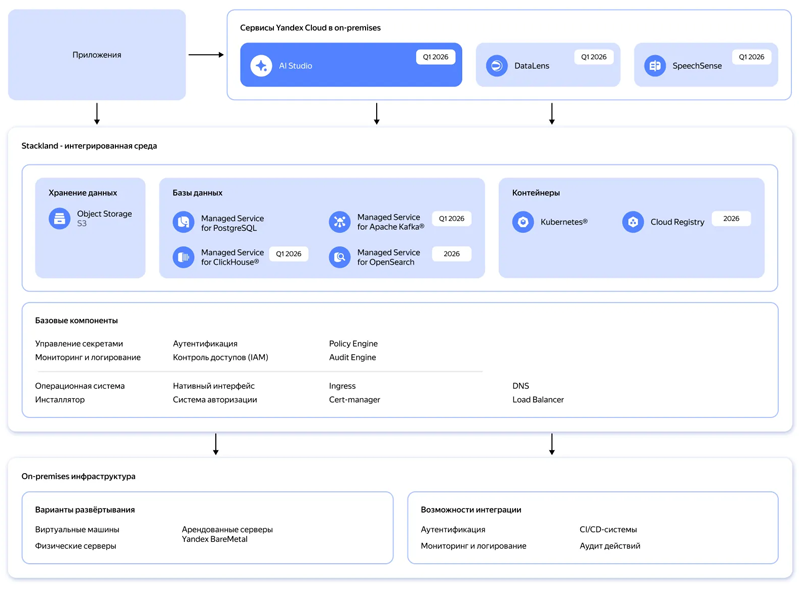

Yandex B2B Tech поможет компаниям быстро разворачивать инфраструктуру для ИИ-сервисов по модели On‑PremiseYandex B2B Tech (бизнес-группа «Яндекса», объединяющая технологии и инструменты компании для корпоративных пользователей, включая продукты Yandex Cloud и «Яндекс 360») сообщила о планах по запуску в первом квартале 2026 года нового инфраструктурного решения Yandex Cloud Stackland, с помощью которого организации смогут оперативно разворачивать инфраструктуру для управления ИИ‑нагрузками в закрытом контуре по модели on‑premise. Yandex Cloud Stackland предложит пользователям следующие компоненты для построения интегрированной ИИ-среды: платформу AI Studio для разработки ИИ-приложений и агентов, модуль речевой аналитики SpeechSense, BI-систему DataLens, контейнерный оркестратор, масштабируемое объектное S3-хранилище, управляемые СУБД PostgreSQL, ClickHouse, Kafka, а также векторные базы данных, которые распространены в RAG-решениях. В дополнение к этому будут представлены инструменты для обеспечения приложений доступом к графическим ускорителям и высокопроизводительным сетям, таким как InfiniBand, для задач распределённого инференса. Отдельное внимание будет уделено безопасности и защите обрабатываемых данных: Stackland получит встроенные средства IAM для гибкого разграничения доступов и инструменты для защищённого хранения паролей, токенов и сертификатов.

Архитектура Yandex Cloud Stackland (источник изображения: yandex.cloud/services/stackland) Stackland базируется на Kubernetes, что позволит компаниям применять привычные подходы и инструменты для управления микросервисными приложениями, а также управлять PaaS-сервисами Yandex Cloud через Kubernetes API. Ожидается, что интерес к Stackland проявят организации из сфер электронной коммерции, финтеха, ритейла и промышленного сектора, которые хотят использовать ИИ-решения на базе облачных технологий, но не могут сделать это из-за внутренних или регуляторных требований. Как передают «Ведомости», по оценке «Яндекса», в 2025 г. объём рынка контейнеризации составит 4–6 млрд руб., а к 2030 г. вырастет до 9–14 млрд руб. С новым решением компания планирует занять полоивину рынка инфраструктурного ПО для ИИ. Лицензирование Yandex Cloud Stackland будет производиться по количеству ядер CPU. Все инфраструктурные компоненты, в частности управляемые базы данных, будут включены в лицензию. Для отдельных сервисов, таких как AI Studio, DataLens и SpeechSense, нужно будет приобретать отдельные лицензии.

23.10.2025 [13:50], Руслан Авдеев

Неудобные вопросы: казначейство Великобритании выясняет, почему сбой AWS по ту сторону океана нарушил работу госведомств Соединённого Королевства

aws

lloyds banking

software

банк

великобритания

госуслуги

информационная безопасность

кии

конфиденциальность

облако

сбой

От правительства Великобритании потребовали ответить, почему многочасовой сбой в работе сервисов AWS (Amazon) на другом берегу Атлантики нарушил функциональность информационных систем британских структур, включая налоговую службу HMRC и Lloyds Banking Group, сообщает Computer Weekly. Многочасовой сбой 20 октября во флагманском регионе AWS US-East-1 в Северной Вирджинии (США) нарушил работу компаний и организаций по всему миру, в том числе и в Соединённом Королевстве. Поэтому в Великобритании и других странах растёт обеспокоенность тем, что частный и государственный сектора зависят от заокеанских служб — вновь появились призывы сохранить услуги национального значения под локальным контролем. Так, Казначейству Великобритании уже предложено отчитаться о том, почему предоставленные в январе этого года полномочия не помогли гарантировать надёжность сервисов в секторе финансовых услуг. В частности, почему платформа AWS (и не только она), которая является облачным провайдером большого числа финансовых учреждений Великобритании, до сих пор не включена в список критически важных третьих сторон (Critical Third Parties, CTP), который позволяет требовать от сторонних компаний соблюдения тех же высоких стандартов, что и от финансовых учреждений. Также чиновников попросили уточнить, не беспокоит ли их тот факт, что ключевые фрагменты британской IT-инфраструктуры размещены за рубежом, с учётом последствий недавнего сбоя. Также предлагается объяснить, какую работу проводят совместно с HMRC, чтобы предотвратить аналогичные сбои в будущем. В Министерстве финансов Великобритании заявили журналистам, что работают с регуляторами над внедрением режима CTP. В AWS же предложили спросить у самой HMRC, почему сбой в США так повлиял на неё. У AWS с 2016 года есть собственный облачный регион в Великобритании, причём платформа позволяет британским структурам получать доступ к локальным версиям публичных облачных сервисов. В AWS придерживаются «модели общей ответственности», при которой клиенты должны сами внимательно выбирать сервисы для размещения в облаке. Утверждается, что такой подход обеспечивает гибкость и контроль со стороны клиента. По мнению некоторых экспертов, сбой свидетельствует о том, что часть инфраструктуры HMRC и Lloyds зависела от американских мощностей, и это мог быть осознанный выбор британских структур, а не вина AWS. С другой стороны, инцидент показал, как сложна и взаимосвязана современная облачная инфраструктура. Заказчики могли не знать какие сервисы размещены в рамках их пакетов услуг в Великобритании и насколько они устойчивы. Например, Microsoft в своё сообщила, что не может гарантировать суверенитет данных полиции Великобритании, хранящихся и обрабатываемых на её платформе. Позже выяснилось, что данные британской полиции могут обрабатываться более чем в 100 странах, причём пользователи об этом не знали. В Forrester сообщают, что AWS осознаёт проблему и намерена запустить в Европе «идеальную копию» своих сервисов в рамках предложения суверенного облака. Первый изолированный регион предусмотрен в Германии. Фактически, единственный надёжный способ избавиться от иностранной зависимости — физическая и логическая изоляция облачных регионов, используемых клиентами. По словам экспертов, чем более «концентрированной» становится инфраструктура, тем более хрупкой и зависимой от внешнего управления она становится. Если Европа настроена на обретение цифрового суверенитета, ей необходимо скорее принять необходимые для этого меры. В частности, следует переосмыслить систему закупок, финансировать суверенные альтернативы и сделать обеспечение надёжности базовым требованием. Ранее эксперты пришли к выводу, что сбой в работе AWS наглядно продемонстрировал опасную зависимость всего мира от нескольких облачных гигантов из США. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. При этом к AWS есть вопросы и у других британских регуляторов.

23.10.2025 [09:43], Руслан Авдеев

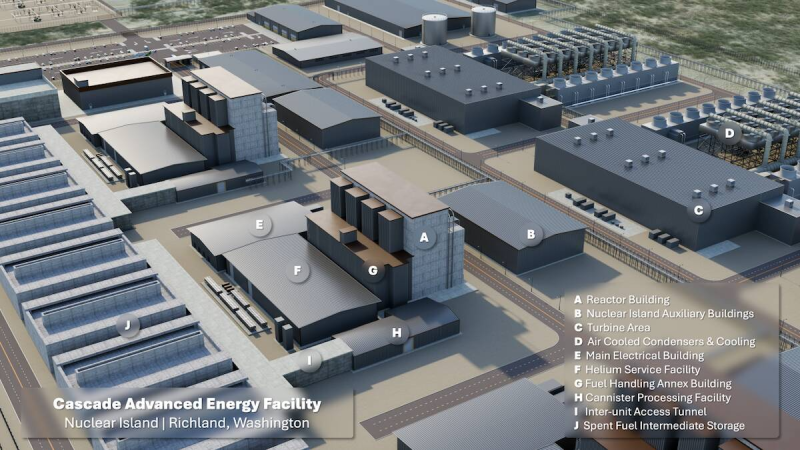

Amazon намерена построить в Вашингтоне мини-реакторы X-Energy на 960 МВт, но пока предлагает полюбоваться на рендеры будущих АЭСНесмотря на технические и нормативные препятствия, Amazon всё ещё считает, что малые модульные реакторы (SMR) являются оптимальным ответом на дефицит электричества для её дата-центров. Осенью 2024 года компания объявила об инвестициях $500 млн в «атомный» стартап X-Energy, а на днях появилась информация, что его реакторы Xe-100 обеспечат штату Вашингтон поставки до 960 МВт «чистой» электроэнергии, сообщает The Register. Правда, строительство начнётся не раньше конца текущего десятилетия, а сами SMR заработают уже 2030-х годов. В частности, 80-МВт реакторы планируется развернуть на объекте Cascade Nuclear Energy Center близ Ричленда (Richland). Реализация проекта предусмотрена в три этапа, каждый из которых обеспечит 320 МВт. В Amazon утверждают, что SMR компании X-Energy будут меньше, быстрее в установке и дешевле в эксплуатации, чем традиционные реакторы. Компания настолько уверена в технологии, что намерена развернуть к 2039 году SMR общей мощностью 5 ГВт. В этом ей помогут Doosan Enerbility и Korea Hydro and Nuclear Power. Правда, сама технология не опробована в реальных условиях, а один из ранних проектов SMR закрылся из-за высоких эксплуатационных расходов. Кроме того, реакторы компании ещё даже не получили одобрения Комиссии по ядерному регулированию (Nuclear Regulatory Commission, NRC) США, которое необходимо для начала строительства. Разрешение на начало строительства планируется получить лишь к концу 2026 года. Впрочем, Amazon активно делится 3D-рендермаи будущих электростанций.

Источник изображения: Amazon Ставку на SMR делают и другие операторы ЦОД. Например, Oracle намерена установить не менее трёх реакторов мощностью около гигаватта, но деталей о них пока немного. Поддерживаемый Google стартап Kairos Power намерен разместить 50-МВт реактор возле Ок-Риджской национальной лаборатории (ORNL). Демонстрационный образец Kairos Hermes 2 должен заработать не раньше 2030 года. Правда, одобрение NRC в этом случае уже получено, так что у Kairos больше шансов раньше представить рабочую модель. Впрочем, для запуска реактора всё равно потребуется дополнительное разрешение. Но и от традиционных АЭС гиперскейлеры не отказываются. В прошлом году AWS приобрела «атомный» кампус Cumulus Data за $650 млн при АЭС Susquehanna, которая может предоставить дата-центрам до 960 МВт. Microsoft вкладывает средства в возвращение к жизни энергоблока Unit-1 атомной электростанции Three Mile Island. Ожидается, что он снова заработает в 2027 году. Google тоже не прочь перезапустить АЭС DAEC, а Meta✴ попросту выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд.

22.10.2025 [17:09], Владимир Мироненко

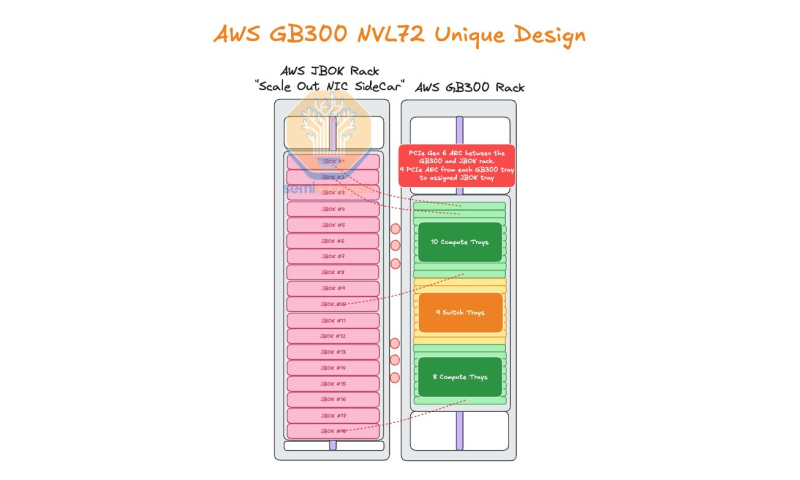

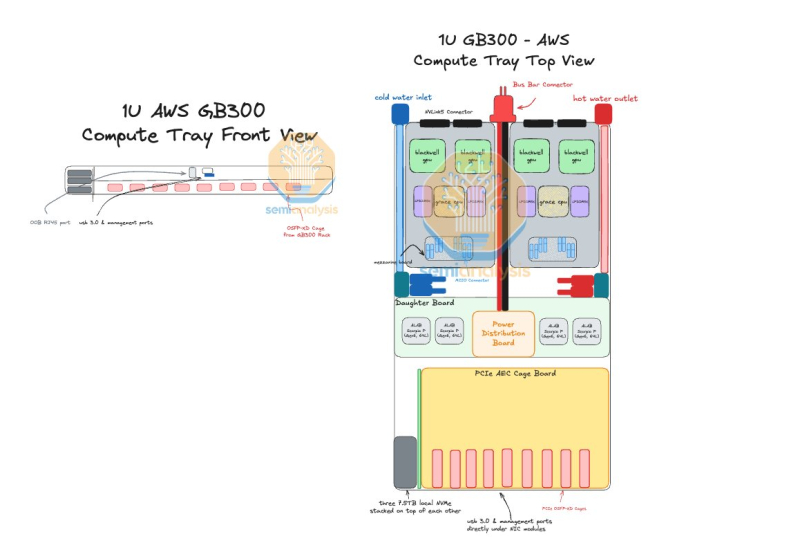

AWS пожертвовала компактностью GB300 NVL72, лишь бы снизить зависимость от NVIDIAAmazon Web Services (AWS) нашла выход, как использовать собственные Nitro DPU K2v5/6 (EFA) в новейших стоечных системах NVIDIA GB300 NVL72, которые, как считает гиперскейлер, превосходит адаптеры NVIDIA ConnectX-7/8 по производительности. В связи с тем, что в стойках NVIDIA Oberon используются укороченные лотки высотой 1U, AWS размещает NIC в отдельной стойке JBOK, предназначенной только для сетевых карт, пишет SemiAnalysis. Причина кроется в невозможности установить в 1U сразу девять фирменных адаптеров (8 × EFA + 1 × ENA/EBS). Для серверных систем GB200 NVL предыдущего поколения AWS выбрала вариант NVL36×2, поскольку только в этом случае использовались 2U-узлы, где достаточно места для всех NIC. Однако сдвоенная конфигурация менее эффективна, чем нативная конструкция NVL72. NVIDIA сама была не очень довольна вариантами NVL36. Meta✴, например, и вовсе «растянула» NVL36×2 на шесть стоек, чтобы обойтись воздушным охлаждением. AWS в случае Blackwell Ultra предпочла остановиться на NVL72-варианте, а DPU вынести в отдельную стойку — всего 18 узлов высотой 2U, по 9 NIC в каждом. С узлами NVIDIA они соединены активными электрическими кабелями (AEC) и портами OSFP-XD для передачи сигналов PCIe 6.0. По словам AWS, её адаптеры лучше справляются с нагрузками, чем ConnectX-8 (RoCEv2), что отчасти спорно. В любом случае таким образом компания снижается зависимость от NVIDIA. С точки зрения SemiAnalysis, доработка GB300 в AWS помогает устранить единую точку отказа в референсной архитектуре NVIDIA, где каждый ускоритель взаимодействует только с одним сетевым адаптером ConnectX-8, тогда как в конфигурации AWS каждый ускоритель общается с двумя NIC. У AWS накоплен богатый опыт разработки собственного оборудования для ЦОД. Ранее компания в партнёрстве с Broadcom разрабатывала специализированные сетевые коммутаторы. Также недавно представленные ею EC2-инстансы P6-B200 и P6e-GB200 оснащены собственным сетевым стеком Elastic Fabric Adapter (EFAv4) на базе собственных контроллеров Nitro, который оптимизирует обработку сетевых пакетов и снижает задержки для высокопроизводительных приложений.

22.10.2025 [12:35], Руслан Авдеев

Сбой в работе AWS показал опасную зависимость мира от нескольких облачных гигантов из СШАМасштабный сбой в работе облака AWS в понедельник коснулся множества сервисов по всему миру во многих секторах экономики и общественной деятельности. Инцидент вызвал разговоры о зависимости пользователей от крупных облачных провайдеров из США, необходимости повышения цифрового суверенитета и диверсификации рисков, сообщает Datacenter Knowledge. В компании объявили, что причина — в «эксплуатационном инциденте» в регионе us-east-1, именно там расположен крупнейший кластер ЦОД провайдера. Облачный регион находится в т.н. «Аллее ЦОД» в Северной Вирджинии и состоит из 158 объектов общей мощностью 2,544 ГВт. По оценкам Amazon, более 90 % компаний из рейтинга Fortune 100 используют именно облачные сервисы AWS. Сбой стал крупнейшим инцидентом в работе интернета с тех пор, как в 2024 году из-за ошибки обновления Crowdstrike из строя по всему миру вышли миллионы систем Microsoft. По словам IDC, последний инцидент демонстрирует, как масштабные вычисления могут привести к масштабным проблемам. Хотя предприятия в целом приняли идею отказа от собственной инфраструктуры ЦОД, происшествие привлекает внимание к необходимости диверсификации рисков. Это может привести к созданию распределённых архитектур, охватывающих несколько облачных регионов в рамках пакетного предложения одного провайдера, и более широкому использованию нескольких облаков разных провайдеров одновременно. Эксперты обеспокоены зависимостью предприятий всего мира от американских гиперскейлеров — последствия инцидента носят трансграничный характер и касаются не только клиентов одного поставщика облачных сервисов. Многие уже задаются вопросом — стоит ли сохранять зависимость государственных учреждений, от налоговых служб государство до крупных банков службам, расположенным на другом побережье Атлантического океана. Европа так и не смогла избавиться от бремени американских гиперскейлеров, которые открыто признают, что даже не могут гарантировать суверенитет данных. Как заявляют в британской Asanti Data Centres, многие организации активно приняли концепцию публичных облаков, но сбой показал, что может случиться, когда всё построено на одном фундаменте. Проблема затронула не только структуры, напрямую использующие сервисы AWS, но и всех остальных в цепочке поставок услуг. Большинство организаций ведут дела с клиентами AWS, в результате чего речь идёт о каскадном, общесистемном ущербе.

Источник изображения: Oğuzhan Akdoğan/unspalsh.com В IDC подчёркивают, что роль в купировании негативных эффектов от будущих инцидентов может сыграть ИИ. Хотя у AWS в целом довольно хорошая репутация среди пользователей, на устранение последствий инцидента потребовалось слишком много времени, поэтому возникают сомнения, сможет ли AWS поддерживать репутацию по мере роста бизнеса и усложнения технологий. ИИ может помочь, создавая агентов, способных заранее выявлять и устранять проблемы до того, как они негативно скажутся на клиентах. Стоит отметить, что концентрация облачных ресурсов в одном месте может действительно крайне негативно сказаться на деятельности целых государств. Недавний пожар в южнокорейском ЦОД показывает, к каким катастрофическим последствиям для государственных услуг может привести консолидация облачных мощностей в одном месте. Более того, даже концентрация крупных ЦОД разных операторов в одном месте грозит тем, что сбой одного из них приведёт к проблемам у соседних. Особенно в случае ИИ ЦОД.

21.10.2025 [21:50], Владимир Мироненко

Nebius запустила первый в Израиле ИИ ЦОД с NVIDIA HGX B200Компания Nebius объявила о доступности платформы Nebius AI Cloud в своем новом ЦОД в Израиле, запущенном на площадке в Модиине (Modiin). Сообщается, что это один из крупнейших в стране ИИ-кластеров и первый на архитектуре NVIDIA Blackwell. Кластер включает 4 тыс. ускорителей в составе HGX B200, объединённых интерконнектом NVIDIA Quantum InfiniBand, и предоставляет доступ к стеку NVIDIA AI Enterprise, в том числе к микросервисам NVIDIA NIM и инструментам управления ИИ-агентами NeMo. Запуск в Израиле последовал за аналогичными развёртываниями Nebius в Европе и США. Новая площадка объединяет передовую аппаратную и программную инфраструктуру, включая усовершенствованные системы охлаждения, системы управления энергопотреблением и механизмы управления данными, разработанные для интенсивных рабочих ИИ-нагрузок. Nebius — партнёр NVIDIA по облачным технологиям (NCP). «Запуск Nebius крупнейшего в Израиле облака ИИ на базе Blackwell знаменует собой начало развития инфраструктуры ИИ в стране», — сообщил директор представительства NVIDIA в Израиле, отметив, что благодаря суверенному доступу к передовым вычислительным, сетевым технологиям и ПО, израильские компании и разработчики смогут внедрять инновации, развёртывать и масштабировать следующее поколение агентного и физического ИИ. Nebius входит в число первых партнёров NCP, получивших сертификат Exemplar Cloud для учебных рабочих нагрузок на базе NVIDIA H100, продемонстрировав производительность в пределах 95 % от референсной архитектуры NVIDIA. Платформа Nebius AI Cloud получила сертификацию SOC2 Type II, включая HIPAA, и обеспечивает сквозное шифрование, а также полное соответствие стандартам защиты данных GDPR и CCPA.

21.10.2025 [14:25], Андрей Крупин

ТЦИ переведёт инфраструктуру доменных зон Рунета на российские серверыТехнический центр Интернета (ТЦИ), оператор национальных доменных зон .RU, .РФ и .SU, сообщил о проведении плановой замены ключевых элементов инфраструктуры на оборудование отечественного производства. Инициатива является частью системной работы по повышению технологической независимости и устойчивости российского сегмента интернета. Отмечается, что приоритетами ТЦИ остаются обеспечение бесперебойной работы доменной системы, её защищённость от внешних факторов и полный контроль над технологической цепочкой. Для достижения этих целей оператор использует серверные решения российского разработчика телекоммуникационного и IT-оборудования «Булат» (входит в группу компаний «Ростелеком»). Серверы «Булат» включены в единый реестр российской радиоэлектронной продукции, соответствуют требованиям ТЦИ и, по заверениям оператора доменных имён, прошли процедуру детального длительного тестирования перед вводом в эксплуатацию. «Переход технологической инфраструктуры IT- и телеком-отрасли на отечественное оборудование свидетельствуют о зрелости российского рынка IT-решений. Таким образом формируется замкнутая экосистема для критической инфраструктуры, что знаменует собой новый этап в развитии Рунета», — говорится в заявлении «Ростелекома». |

|