Материалы по тегу: s

|

30.10.2025 [17:24], Руслан Авдеев

МТС вложит 10 млрд руб. в развитие облачного направления MWS CloudМТС запустила публичное, импортонезависимое облако MWS Cloud Platform собственной разработки, которое соответствует требованиям регуляторов РФ. По словам компании, платформа позволит заказчикам размещать и обрабатывать в облаке данные любого объёма и формата с неограниченным масштабированием. На развитие своего облачного направления компания МТС намерена потратить более 10 млрд руб. в 2025 году, сообщает Forbes со ссылкой на главу МТС Web Services. По его словам, инвестиции в MWS Cloud предназначены для развития облачной платформы, инфраструктуры для облака и дата-центров. Разработанная компанией платформа с июня работала в режиме закрытого тестирования с ограниченным количеством сервисов, а сейчас полноценно выходит на рынок. Уже доступны сервисы Compute, VPC, CDN, Object Storage и IAM. В режиме превью запущены Artifact Registry (Docker), Certificate Manager (SSL/TLS), а также Managed PostgreSQL, Managed Kafka, Managed Kubernetes, KMS (управление криптографическими ключами), Secret Manager и сервис для использования LLM MWS GPT в облачной платформе. В 2026 году будет продолжено развитие IaaS/PaaS. Также со времением возможно появление направления периферийных вычислений. По оценкам iKS-Consulting, российский рынок облачных инфраструктурных сервисов растёт хорошими темпами, в текущем году он должен вырасти на 36 % до 229 млрд руб. MWS работает в сегментах IaaS и PaaS много лет, и в I полугодии она занимала пятое место среди крупнейших облачных провайдеров страны (доля 5 %). Предполагается, что соответствующий рынок до 2030 года будет расти в среднем на 27 % в год, а отдельные сегменты, особенно связанные с ИИ, растут особенно активно и потенциал рынка ещё не исчерпан. Особенно отмечен сегмент PaaS, именно в нём MWS намерена предлагать широкий спектр услуг, передаёт Forbes. В январе сообщалось, что почти все крупные компании России используют облачные сервисы, а в июне появилась новость, что инфраструктура в публичном облаке России ежегодно увеличивается почти на треть. В сентябре MWS Cloud заявила, что направит на развитие дата-центров 6,5 млрд руб.

30.10.2025 [16:56], Руслан Авдеев

AWS инвестирует не менее $5 млрд в ЦОД Южной КореиПо данным администрации президента Южной Кореи, Amazon Web Services (AWS) инвестирует в страну как минимум $5 млрд. Средства будут потрачены на новые ИИ ЦОД — Сеул намерен стать одним из ключевых ИИ-хабов в Азии, сообщает Reuters. Объявление было сделано в ходе встречи генерального директора AWS Мэтта Гармана (Matt Garman) с президентом Южной Кореи Ли Чжэ Мёном (Lee Jae Myung) на полях саммита Азиатско-Тихоокеанского экономического сотрудничества (АТЭС). Amazon является одной из семи компаний глобального уровня, чьи лидеры посетили групповую встречу с Ли и пообещали инвестировать в страну $9 млрд в следующие пять лет. Как заявил президент, инвестиции Amazon ускорят рост экосистемы для ИИ-индустрии в Южной Корее, поскольку страна намерена войти в тройку лидеров в сфере ИИ. Гарман в ответ подчеркнул, что что его компания уже инвестировала и намерена инвестировать дополнительные $40 млрд в 14 страны Азиатско-Тихоокеанского региона (АТР) до 2028 года. При этом такие инвестиции обеспечат экономике США $45 млрд. В июне AWS представила план инвестиций $4 млрд в Южную Корею в рамках проекта SK Group по строительству крупнейшего в стране дата-центра в Ульсане (Ulsan). Также анонсированы инвестиции в другие страны региона, включая Японию, Австралию и Сингапур. Ранее в этом месяце сообщалось, что OpenAI намеревалась открыть в Южной Корее совместные предприятия с Samsung и SK для строительства двух ЦОД, корейского вариант Stargate с изначальной мощностью 20 МВт. OpenAI заявила, что Южная Корея — один из рекордсменов по числу подписчиков GhatGPT, в этом отношении она уступает только США. Также OpenAI заключила сделки для приобретения чипов памяти для своих дата-центров у Samsung Electronics и SK Hynix.

30.10.2025 [16:18], Руслан Авдеев

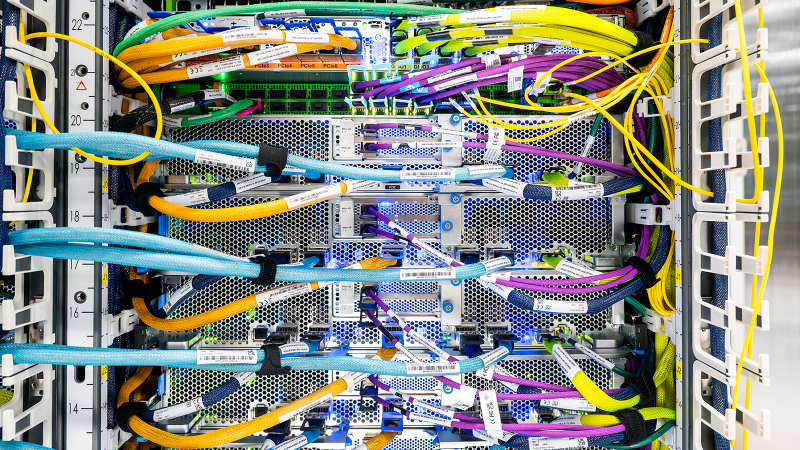

Полмиллиона ускорителей Trainium2: AWS развернула для Anthropic один из крупнейших в мире ИИ-кластеров Project RainierAWS объявила о запуске одного из крупнейших в мире ИИ-кластеров Project Rainier. Фактически амбициозный проект представляет собой распределённый между несколькими ЦОД ИИ-суперкомпьютер — это важная веха в стремлении AWS к развитию ИИ-инфраструктуры, сообщает пресс-служба Amazon. Платформа создавалась под нужды Anthropic, которая буквально на днях подписала многомиллиардный контракт на использование Google TPU. В рамках Project Rainier компания AWS сотрудничала со стартапом Anthropic. В проекте задействовано около 500 тыс. чипов Trainium2, а вычислительная мощность в пять раз выше той, что Anthropic использовала для обучения предыдущих ИИ-моделей. Project Rainier применяется Anthropic для создания и внедрения моделей семейства Claude. К концу 2025 года предполагается использование более миллиона чипов Trainium2 для обучения и инференса. В рамках Project Rainier в AWS уже создали инфраструктуру на основе Tranium2, на 70 % превосходящую любую другую вычислительную ИИ-платформу в истории AWS. Проект охватывает несколько дата-центров в США и не имеет аналогов среди инициатив AWS. Он задуман как гигантский кластер EC2 UltraCluster из серверов Trainium2 UltraServer. UltraServer объединяет четыре физических сервера, каждый из которых имеет 16 чипов Trainium2. Они взаимодействуют через фирменный интерконнект NeuronLink, обеспечивающий быстрые соединения внутри системы, что значительно ускоряет вычисления на всех 64 чипах. Десятки тысяч UltraServer объединяются в UltraCluster посредством фабрики EFA. Эксплуатация такого ЦОД требует повышенной надёжности. В отличие от большинства облачных провайдеров, AWS создаёт собственное оборудование и может контролировать каждый компонент, от чипов до систем охлаждения и архитектуру дата-центров в целом. Управляющие ЦОД команды уделяют повышенное внимание энергоэффективности, от компоновки стоек до распределения энергии и выбора методов охлаждения. Кроме того, в 2023 году вся энергия, потребляемая Amazon, полностью компенсировалась электричеством из возобновляемых источников. В Amazon утверждают, что в последние пять лет компания является крупнейшим покупателем возобновляемой энергии и стремится к достижению нулевых выбросов к 2040 году.

Источник изображения: AWS Миллиарды долларов инвестируются в ядерную энергетику и АКБ, а также крупные проекты в области возобновляемой энергетики для ЦОД. В 2024 году компания объявила о внедрении новых компонентов для ЦОД, сочетающих технологии электропитания, охлаждения и аппаратного обеспечения, причём не только для строящихся, но и уже для имеющихся объектов. Новые компоненты, предположительно, позволят снизить энергопотребление некоторых компонентов до -46 % и сократить углеродный след используемого бетона на 35 %.

Источник изображения: AWS Для новых объектов, строящихся в рамках Project Rainier и за его пределами, предусмотрено использование целого ряда новых технологий для повышения энергоэффективности и экоустойчивости. Некоторые технологии связаны с рациональным использованием водных ресурсов. AWS проектирует объекты так, чтобы использовать минимум воды, или вовсе не использовать её. Один из способов — отказ от её применения в системах охлаждения на многих объектах большую часть года, с переходом на охлаждение наружным воздухом.

Источник изображения: AWS Так, один из объектов Project Rainier в Индиане будет максимально использовать именно уличный воздух, а с октября по март дата-центры вовсе не станут использовать воду для охлаждения, с апреля по сентябрь в среднем вода будет применяться по несколько часов в день. Согласно отчёту Национальной лаборатории им. Лоуренса в Беркли (LBNL), стандартный показатель WUE для ЦОД 0,375 л/кВт·ч. В AWS этот показатель равен 0,15 л/кВт·ч, что на 40 % лучше, чем в 2021 году.

30.10.2025 [12:20], Сергей Карасёв

ASUS представила ИИ-сервер XA NB3I-E12 на базе NVIDIA HGX B300Компания ASUS анонсировала сервер XA NB3I-E12 на аппаратной платформе NVIDIA HGX B300, предназначенный для интенсивных нагрузок ИИ. В качестве потенциальных заказчиков системы названы предприятия, которые работают с большими языковыми моделями (LLM) и НРС-приложениями: это могут быть научно-исследовательские структуры и финансовые организации, компании автомобильного сектора и пр. Сервер выполнен в форм-факторе 9U. Возможна установка двух процессоров Intel Xeon 6700P поколения Granite Rapids с показателем TDP до 350 Вт. Доступны 32 слота для модулей оперативной памяти DDR5-6400 RDIMM / 3DS RDIMM. Во фронтальной части расположены 10 посадочных мест на SFF-накопителей (NVMe). Предусмотрены четыре слота расширения PCIe 5.0 х16 и один слот PCIe 5.0 х8. Система имеет архитектуру 8-GPU (NVIDIA HGX B300 288GB 8-GPU). Задействованы сетевые адаптеры NVIDIA ConnectX-8 и DPU NVIDIA BlueField-3. Реализованы два сетевых порта 10GbE с разъёмами RJ45 на основе контроллера Intel X710-AT2 и выделенный сетевой порт управления (RJ45). Питание обеспечивают 10 блоков мощностью 3200 Вт с сертификатом 80 PLUS Titanium. Применяется воздушное охлаждение; диапазон рабочих температур — от +10 до +35 °C. ASUS отмечает, что сервер имеет модульную конструкцию, благодаря чему минимизируется использование кабелей, упрощается обслуживание и повышается ремонтопригодность. Габариты устройства составляют 945 × 447 × 394,5 мм, масса — примерно 120 кг без установленных накопителей.

30.10.2025 [11:55], Сергей Карасёв

Компактное хранилище QNAP NASbook TBS-h574TX рассчитано на накопители E1.S SSDКомпания QNAP Systems анонсировала сетевое хранилище NASbook TBS-h574TX в компактном «настольном» форм-факторе, ориентированное на профессиональных пользователей, которые занимаются видеомонтажом, созданием визуальных эффектов и анимации. Устройство выполнено на аппаратной платформе Intel Alder Lake. Применён процессор Core i5-1235U с десятью ядрами (2P+8E), функционирующими на тактовой частоте до 4,4 ГГц. В состав чипа входит графический ускоритель Intel Iris Xe. Объём оперативной памяти составляет 16 Гбайт (без возможности расширения), интегрированной флеш-памяти — 5 Гбайт. Кроме того, доступны модификации с 12-ядерным чипом Core i5-1340PE (4P+8E) с тактовой частотой до 4,5 ГГц и 8-ядерным процессором Core i3-1320PE (4P+4E) с такой же максимальной частотой. Объём ОЗУ у этих версий составляет соответственно 16 и 12 Гбайт. Новинка располагает пятью отсеками для накопителей. Могут устанавливаться SSD типоразмера E1.S толщиной до 15 мм с интерфейсом PCIe 3.0 x2 или M.2 2280 (NVMe) с радиатором охлаждения толщиной до 4,5 мм. Покупателям, в частности, предлагаются варианты с пятью предустановленными SSD стандарта E1.S вместимостью 1,92 или 3,84 Тбайт каждый с суммарной ёмкостью соответственно 9,6 и 19,2 Тбайт. Хранилище оснащено сетевыми портами 2.5GbE и 10GbE, интерфейсом HDMI 1.4b, разъёмом USB 2.0, двумя портами USB 3.2 Gen2, а также двумя портами Thunderbolt 4, которые можно использовать для прямого подключения к рабочим станциям под управлением Windows и macOS. Для охлаждения применяются два вентилятора диаметром 40 мм. Диапазон рабочих температур — от 0 до +40 °C. Габариты составляют 60 × 215 × 199 мм, масса — 2,24 кг (без установленных накопителей). Питание устройство получает от сетевого адаптера мощностью 120 Вт; заявленное типовое энергопотребление — 46 Вт. Производитель предоставляет трёхлетнюю гарантию.

30.10.2025 [11:45], Руслан Авдеев

Снова DNS: доступ к сервисам Microsoft Azure восстановили после глобального сбояВ конце минувшей среды Microsoft объявила об успешном решении проблем с конфигурацией DNS, вызвавших сбои на платформе Azure. Инцидент повлиял на работу сервисов компании и затронул множество отраслей по всему миру, сообщает Reuters. Как сообщили представители Azure, хотя уровень ошибок и задержек вернулись к уровню, предшествовавшему инциденту, небольшое число клиентов всё ещё могут сталкиваться с проблемами, и компания всё ещё работает над устранением последствий. В Microsoft заявляют, что инцидент продолжался в течение восьми часов. Ранее в среду авиакомпания Alaska Airlines заявила, что столкнулась с проблемами в работе ключевых систем, включая сайт, из-за проблем с Azure и восстанавливает работу систем после того, как Microsoft решила проблему. Сайт лондонского аэропорта Хитроу тоже вернулся к работе после перерыва в среду, от сбоя пострадал и телеком-оператор Vodafone. Приблизительно в 12:00 по восточному времени США (19:00 по Москве) в среду 29 октября в Azure сообщили, что у их клиентов и сервисов Microsoft, использующих Azure Front Door (глобальную облачную сеть доставки контента и приложений), возникли проблемы, которые привели к таймаутам и ошибкам. По данным Downdetector на 19:49 ET (02:49 по Москве, 30 октября), число пользователей, сообщавших о проблемах с Azure, упало до 230. Для сравнения, на пике ранее в тот же день речь шла о более 18 тыс. жалоб. К 22:44 ET статистика Downdetector свидетельствовала о 77 сбоях Microsoft 365, на пике речь шла об около 20 тыс. жалобах. Поскольку речь идёт только о случаях обращений на сайт сервиса, настоящее число пострадавших может быть намного больше. Недавний масштабный сбой AWS, который, как в итоге выяснилось, тоже был вызван проблемами с DNS, стал крупнейшим с прошлогоднего инцидента с ПО CrowdStrike, нарушившего работу оборудования в больницах, банках и аэропортах — это продемонстрировало чрезвычайную уязвимость связанных глобальных технологий, находящихся под контролем всего нескольких компаний.

29.10.2025 [23:10], Владимир Мироненко

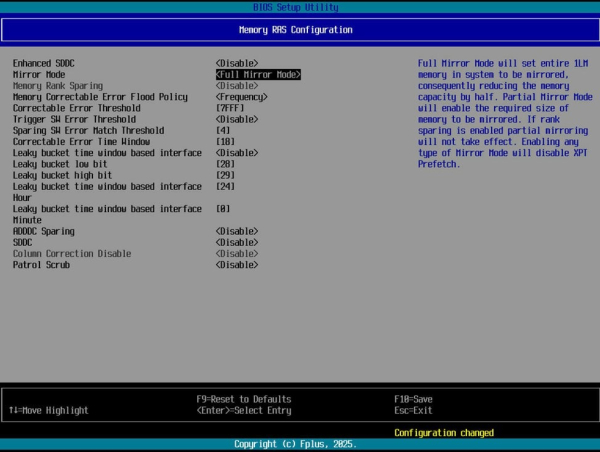

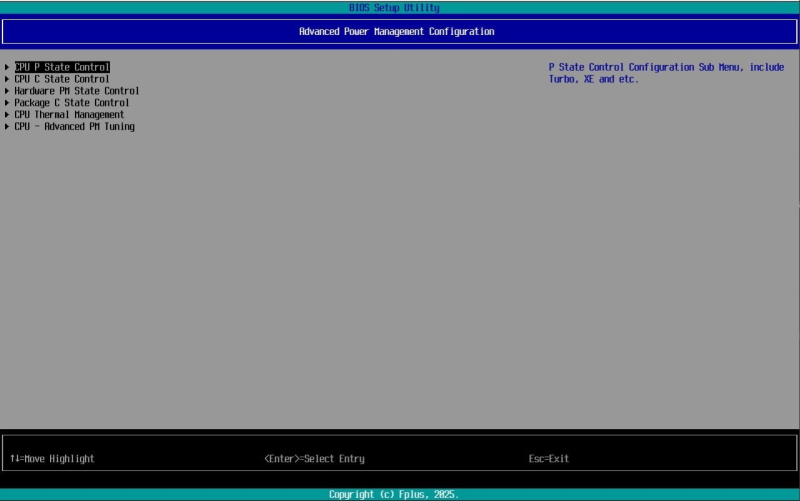

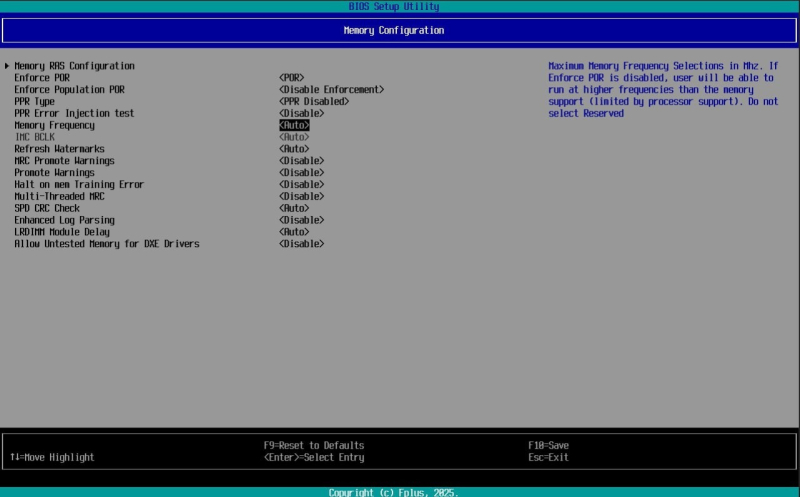

Fplus расширила возможности управление серверами в BIOS v1.0.5Fplus объявила о выходе BIOS v1.0.5, которое обеспечивает больше возможностей для управления серверами, в том числе для контроля производительности, энергоэффективности и отказоустойчивости. В частности, в новой версии добавлена функция настройки состояний процессора: P-state, C-state, PM-state и T-state, что помогает снизить энергопотребление в периоды низкой нагрузки без ущерба для пиковой производительности. Кроме того, добавлена функция управления состоянием сервера после сбоя электропитания — сервер может автоматически возвращаться в рабочее состояние сразу после возобновления питания. В обновлении также добавилось несколько функций для управления памятью. Появление возможности ручной настройки частоты оперативной памяти повышает стабильность работы платформы, говорит производитель. Кроме того, была добавлена поддержка технологий SDDC (исправление ошибок в пределах одной микросхемы) и ADDDC (исправление ошибок в двух устройствах памяти одновременно). Для критически важных систем, где недопустима потеря информации, предусмотрен режим полного зеркалирования памяти, при котором доступный объём RAM уменьшается вдвое, зато повышается сохранность данных в памяти. В предыдущем релизе Fplus BIOS v1.0.3 была добавлена поддержка Intel VT-d, фильтрация источников загрузки и фильтрация USB-устройств, а также переработаны Boot Manager и механизм предоставления в интерфейсе BIOS подробной информаций об установленных устройствах. Отметим, что все эти функции по умолчанию доступны в BIOS большинства зарубежных серверных платформ. Ранее Fplus объявила о разработке собственных BIOS и BMC.

29.10.2025 [18:08], Руслан Авдеев

NVIDIA и General Atomics создали виртуальный терморядерный реактор с помощью ИИ

general atomics

hardware

omniverse

ии

разработка

сша

термоядерная энергия

цифровой двойник

энергетика

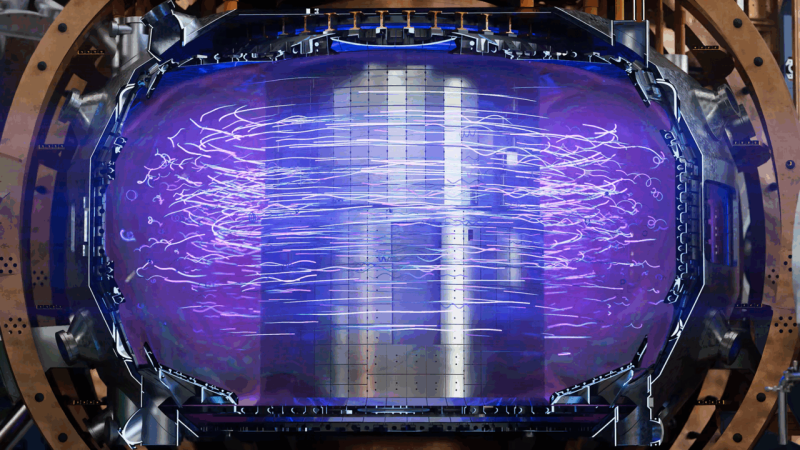

NVIDIA совместно с General Atomics и группой других партнёров создали цифровой двойник термоядерного реактора с использованием ИИ-технологий. В проекте приняли участие Суперкомпьютерный центр Сан-Диего (SDSC), вычислительный центр ALCF при Аргоннской национальной лаборатории (ANL) и вычислительный центр при Национальной лаборатории им. Лоуренса в Беркли (LBNL), сообщает пресс-служба NVIDIA. Проект построен на платформе NVIDIA Omniverse с использованием CUDA-X. Суперкомпьютеры Polaris в ALCF и Perlmutter в NERSC использовались для обучения трёх «суррогатных» ИИ-моделей, призванных имитировать работу более сложных систем. Проект призван помочь учёным создать работающие в земных условиях коммерческие термоядерные технологии. В General Atomics уверены, что возможность виртуальных исследований с помощью цифровых двойников — настоящий прорыв в термоядерной энергетике, а взаимодействие с NVIDIA позволяет тестировать, совершенствовать и проверять идеи на порядок быстрее, чем обычно. Это ускорит путь к коммерческой термоядерной энергетике. В термоядерных реакторах используется плазма, разогретая до миллионов градусов, поэтому прогнозирование её поведения достаточно быстро для поддержания работы реакторов — сложнейшая задача. ИИ позволяет радикально сократить время моделирования процессов внутри реактора, что даёт возможность виртуально «взаимодействовать», изучая различные сценарии работы без риска повреждения самого реактора. Если в норме на моделирование поведения плазмы уходят недели даже на быстрейших суперкомпьютерах, то суррогатные ИИ-модели, обученные на десятилетиях реальных данных, считают всё за секунды и продолжают совершенствоваться. Модели, включая EFIT (для равновесия плазмы), CAKE (для границы плазмы) и ION ORB (для плотности теплового потока от испускаемых ионов), способны помочь операторам поддерживать стабильность плазмы в реальном времени, снижая риск повреждения и ускоряя исследования. Сейчас NVIDIA и General Atomics создают полностью интерактивного цифрового двойника токамака DIII-D в среде Omniverse на базе серверов RTX PRO и DGX Spark. Виртуальный реактор объединяет данные датчиков, данные физического моделирования, инженерные модели и «суррогатные» ИИ-модели, создавая единую интерактивную среду в реальном времени, которая позволяет быстро принимать решения. Двойник синхронизирован с физическим реактором DIII-D, что позволяет международной команде из 700 ученых, представляющих 100 организаций, проверять идеи и запускать различные сценарии без применения реального оборудования. Ключевые элементы управления можно изучить с помощью цифрового двойника. Это позволяет лучше подготовиться к реальным экспериментам. Термоядерные технологии чрезвычайно востребованы на рынке. В январе разработчик термоядерных реакторов Helion, имеющий долгосрочный договор с Microsoft, привлёк $425 млн. В мае сообщалось, что Microsoft надеется, что ИИ ускорит создание термоядерных реакторов, которые смогут запитать ещё больше ИИ ЦОД. В июне появилась информация, что Google вложилась в разработчика термоядерных реакторов TAE Technologies.

28.10.2025 [15:02], Руслан Авдеев

SambaNova может быть выставлена на продажу — компании не удалось привлечь достаточно средствРазработчик ИИ-ускорителей SambaNova Systems изучает возможность продажи бизнеса. Компании не удалось вовремя завершить очередной рануд финансирования. По данным источников, знакомых с вопросом, она уже наняла инвестиционную компанию для контроля продажи, но переговоры продолжаются, т.ч. SambaNova всё ещё может передумать, сообщает The Information. Исполнительным председателем компании является Лип-Бу Тан (Lip-Bu Tan), нынешний глава Intel. В 2021 году капитализация компании оценивалась в $5 млрд. С момента основания SambaNova привлекла более $1,1 млрд, инвесторами выступили GV, Intel Capital, BlackRock и SoftBank Vision Fund. Издание говорит об отчёте Caplight, в котором указано, что BlackRock снизила оценочную стоимость своих акций в компании на 17 %, в результате чего общая оценка капитализации SambaNova упала до $2,4 млрд. SambaNova не прокомментировала возможную продажу, а её представитель заявил, что компания всегда оценивает стратегические возможности, поддерживающие её миссию, а также интересы владельцев. Основанная в 2017 году калифорнийская компания специализировалась на ИИ-ускорителях для обучения LLM, но в 2025 году сменила профиль на предоставление облачных ИИ-сервисов и инференс, повторив подход Groq. Последней, правда, повезло больше — она активно заключает сделки, получает инвестиции и создаёт ИИ ЦОД. У Cerebras дела идут ещё лучше, хотя и не идеально. Cerebras, Groq и SambaNova стали чуть ли не единственными компаниями, которые относительно успешно смогли конкурировать с NVIDIA и AMD на рынке «больших» ИИ-ускорителей. Последний продукт SambaNova — готовый ПАК SambaManaged на базе представленного два года назад ускорителям SN40L — популярности пока не снискал. Если SambaNova решится на продажу, она пополнит растущие ряды стартапов по выпуску ИИ-чипов, купленных за последние 12 месяцев. Так, Meta✴ объявила о покупке за неназванную сумму стартапа Rivos, занимающегося разработкой чипов на архитектуре RISC-V. Хотя сумма сделки неизвестна, ранее сообщалось, что стартап рассчитывал привлечь $500 млн с капитализацией $2 млрд. За полгода до этого южнокорейская FuriosaAI, тоже разрабатывающая ИИ-чипы, отклонила предложение Meta✴ о покупке за $800 млн. В этом году 2025 года SoftBank заявила о приобретении Ampere Computing за $6,5 млрд, а в прошлом году она приобрела разработчика ИИ-ускорителей Graphcore, у которого тоже были проблемы с финансами. Впрочем, бывают ситуации и похуже. Например, летом AMD купила команду разработчика ИИ-чипов Untether AI, но не саму компанию, которая тут же закрылась, оставив за бортом текущих клиентов стартапа. У Esperanto, создателя уникального тысячеядерного RISC-V-ускорителя, всех инженеров переманили крупные компании. Одним из возможных покупателей SambaNova называют Oracle, которая, по слухам, заинтересована именно в команде разработчиков, а не самих чипах.

26.10.2025 [23:55], Владимир Мироненко

Amazon проморгала рынок и теперь её клиенты бегут за ИИ в облака конкурентовAmazon, стоящая у истоков облачного бизнеса, уже не первый год отстаёт от конкурентов по темпам его роста. И на ИИ-рынке, по общему мнению, она оказалась в роли догоняющей на фоне стремительного роста конкурентов, пишет агентство Bloomberg. На прошлой неделе стало известно, что Google Cloud предоставит Anthropic до 1 млн своих ИИ-чипов TPU, что свидетельствует об углублении партнёрства Google с быстрорастущим ИИ-стартапом и наносит удар по Amazon, инвестировавшей в Anthropic миллиарды долларов. AWS по-прежнему лидирует на облачном рынке, но Microsoft наращивает объём корпоративных продаж быстрее, чем Amazon. В прошлом году, по оценке Gartner, облачное AWS заняла 38 % корпоративных расходов на услуги облачной инфраструктуры, тогда как ещё в 2018 году, по данным компании, у «дочки» Amazon было почти 50 % этого рынка. Чтобы выяснить причины сложившейся ситуации, агентство Bloomberg провело опрос аналитиков в области облачных вычислений и финансов, а также у компаний, которые используют или перепродают облачные решения Amazon, и среди 23 нынешних и бывших сотрудника AWS, работающих в сфере разработки, управления продуктами, маркетинга, продаж и поддержки. Одной из главных причин, тормозящих работу AWS, а также влияющих на гибкость, они назвали внутреннюю бюрократию. Респонденты отметили слабый старт компании в области ИИ, а также то, что она стала менее привлекательной для стартапов. Вместе с тем AWS верна своей давней стратегии на фоне быстро меняющегося рынка. Участники опроса признают, что AWS сохраняет значительные преимущества и лояльность клиентов, но опасаются, что компания теряет свои позиции в погоне за конкурентами, которых когда-то опережала. На следующей неделе Amazon объявит квартальные финансовые результаты, которые, как ожидается, покажут рост облачного бизнеса на 18 % до $32 млрд, что уступает показателю роста годом ранее (19 %). Сказался и серьёзный рост конкуренции на облачном рынке в последние пару лет. Oracle, которую когда-то считали аутсайдером в облачной индустрии, теперь заключает многомиллиардные контракты в области ИИ, хотя и не все верят в её успех. Также наращивают мощности Google и неооблака. Дэйв Маккарти (Dave McCarthy), консультант IDC, отметил, что выбор облачных предложений, ранее ограничивавшийся сервисами Amazon и Microsoft, стал гораздо больше, и это не сулит ничего хорошего Amazon. «Это создаёт новое конкурентное давление, которого раньше не было», — подчеркнул он. Стремясь вернуть себе инициативу, AWS реорганизовала команды по инжинирингу и продажам, провела кадровые перестановки в руководстве, а также отказалась от некоторых собственных правил разработки ради ускорения вывода продуктов на рынок и попыталась сократить бюрократию, возникшую после масштабного набора сотрудников во время пандемии. Кроме того, в этом месяце AWS выпустила Quick Suite, призванный заменить её предыдущий основной ИИ-инструмент для корпоративных клиентов, и в декабре ожидается запуск ряда новых и обновлённых ИИ-сервисов. Представитель Amazon Селена Шен (Selena Shen) сообщила в электронном письме Bloomberg, что AWS по-прежнему лидирует на рынке облачных технологиях с большим отрывом, а её ИИ-сервисы, такие как Amazon Bedrock, SageMaker и Kiro, пользуются спросом у клиентов, в том числе из-за выгодного соотношении цены и производительности фирменных ИИ-ускорителей Trainium2. Amazon заключила за последнее время крупные сделки с широким кругом клиентов, включая Delta Air Lines, Volkswagen, Управление общих служб США (GSA) и State Farm, отметила Шен. «Если вы посмотрите на любой список самых инновационных или быстрорастущих стартапов мира, вы обнаружите, что подавляющее большинство из них в значительной степени разворачивают рабочие нагрузки в AWS», — добавила она, ссылаясь, среди прочего, на списки Forbes и CNBC. Тем не менее, по общему мнению, оставаясь лидером в области облачной инфраструктуры, AWS отстаёт от своих конкурентов в плане привлечения бизнеса, создающего или использующего ИИ-модели. В частности, AWS не поверила в то, что Anthropic сможет монетизировать свои разработки, поэтому стартап в поисках необходимых вычислительных мощностей обратился к Google Cloud. Когда стартап привлёк инвестиции в начале 2023 года, среди инвесторов была и Google. Лишь в сентябре Amazon спохватилась и инвестировала в Anthropic первый из двух запланированных траншей в размере $4 млрд, обязав Anthropic использовать AWS и собственные чипы Amazon, а также предлагать клиентам Amazon модели Claude. Объём инвестиций шокировал ветеранов Amazon, знавших, что компания крайне не любит платить за что-либо по рыночным ценам. Некоторые посчитали это отчаянием, пишет Bloomberg. Amazon долгое время гордилась тем, что работает в режиме стартапа, предоставляя свободу независимым командам. Но этот принцип оказался неэффективным при разработке ИИ-моделей, поскольку научные и инженерные подразделения AWS, розничный отдел Amazon и группы Alexa и устройств занимались схожей, иногда дублирующей работой по обучению собственных ИИ-моделей. На конференции AWS re:Invent в ноябре 2023 года компания сделала упор на ИИ, а чуть позже развернула собственного ИИ-ассистента Amazon Q, который, по словам аналитиков, не принёс ничего революционного рынку, уже переполненному чат-ботами. Amazon провела реорганизацию и централизовала большинство работ по разработке передовых моделей, однако развитие AWS замедлилось. В том числе из-за усложнения иерархии после всплеска найма в результате пандемии. В условиях растущей бюрократии принятие решений происходило не так быстро, как раньше. Кроме того, поскольку ПО AWS стало критически важным для крупных корпоративных и государственных клиентов, в компании установили процедуры, призванные снизить риск того, что невнимательный или недовольный сотрудник может сломать что-то важное — это тоже замедляет работу. В некоторых случах часть сотрудников даже заставили получать разрешения на отправку писем высшему руководству. Шен сообщила, что с 2024 года AWS наняла множество новых руководителей и продвигает по службе тех, кто «демонстрирует производительность и готовность к следующему уровню», и что культура AWS остаётся сильной. Сменивший Адама Селипски (Adam Selipsky) на посту гендиректора AWS Мэтт Гарман (Matt Garman), пользующийся большим доверием разработчиков, частично вернул культуру прошлого. От руководителей продуктов требуется открытое признание ошибок и извлечённых уроков, идеи сотрудников принимаются в виде коротких питчей, а сами разработчики ПО работают посменно, обрабатывая запросы поддержки и инциденты по своим продуктам, чтобы понять потребности клиентов. Кроме того, Гарман завершил или прекратила разработку около трёх десятков устаревших и непопулярных продуктов, перенаправив силы на разработку ИИ-инструментов. Тем не менее, сотрудники выражают обеспокоенность тем, что Amazon теряет привлекательность для стартапов. AWS, как известно, помогла зарождению Netflix, но в последние годы порой отдавала приоритет корпорациям с большими расходами, не желая тратить силы на стартапы, которые могут и не стать долгосрочными богатыми клиентами. По словам аналитиков и стартап-консультантов, Google, используя свою известность, инженеров и навыки в передовых ИИ-инструментах, смогла привлечь многих ведущих стартапов в этой сфере. «Если вы сегодня не привлекаете местные стартапы в сфере ИИ, которые в ближайшие пару лет вырастут в пять-десять раз, это может стать реальной проблемой для бизнеса», — сказал Джош Бек (Josh Beck), аналитик Raymond James. Шен же назвала AWS «лучшим выбором для стартапов», приведя в пример Perplexity и Cursor. Но, к примеру, Пит Шваб (Pete Schwab), основатель стартапа Stronghold Labs в области ИИ-анализа видео, выбрал для своего детища площадку Google из-за её ориентации на небольших разработчиков и качества внутренних ИИ-моделей, хотя сам до этого 10 лет проработал в Amazon. AWS «раньше гораздо лучше привлекала таких людей, как мы», — сказал Шваб. Существующие клиенты AWS сейчас также обращаются к услугам её конкурентов, особенно в ИИ-сфере. Например, Grammarly, пользуется AWS, но для ИИ-решений использует модели OpenAI, в том числе в Microsoft Azure, а также Meta✴ Llama, поскольку AWS Bedrock не отвечает ценовым и другим потребностям компании, заявил технический директор стартапа. В начале этого месяца компания представила Quick Suite — чат-бот и набор ИИ-агентов, предназначенных для анализа данных, создания отчётов или резюмирования веб-контента, которые ориентированы на офисных сотрудников. В этой области компания не добилась особого успеха. Руководители в частном порядке признают, что, в отличие от Google и Microsoft, которые могут демонстрировать свои ИИ-инструменты миллиардам клиентов поисковой системы или пользователей ПК, естественный охват AWS ограничен гораздо более узким сообществом разработчиков. Для этой аудитории AWS продолжает расширять возможности Bedrock. Bedrock считается самым успешным ИИ-продуктом компании, число пользователей которого исчисляется десятками тысяч. По словам клиентов и партнёров, отделы продаж сделали увеличение их количества приоритетом. Однако Amazon может преуспеть в эпоху ИИ, просто выступая в качестве поставщика инфраструктуры для других компаний и управляя ею экономически эффективно. По мнению аналитиков, большая часть корпоративных проектов в области ИИ носит экспериментальный характер. Если проект получит более широкую поддержку, экономия средств и надёжная инфраструктура (если не учитывать недавний сбой) — два основных преимущества AWS — станут ещё важнее, утверждают руководители компании. |

|