Лента новостей

|

15.01.2026 [18:19], Сергей Карасёв

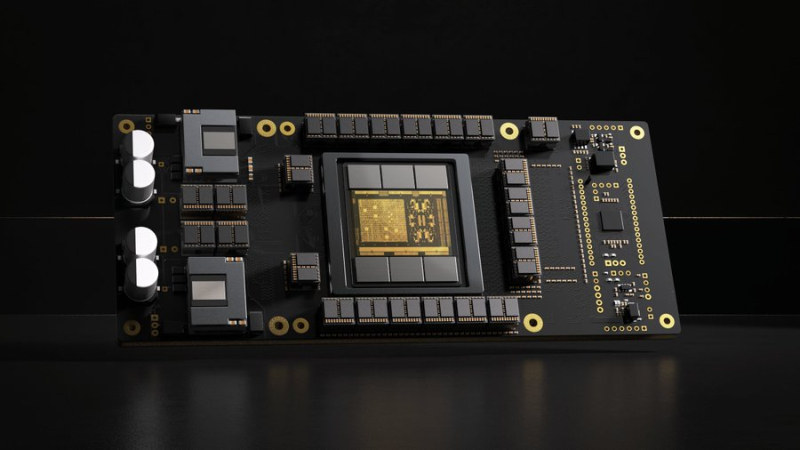

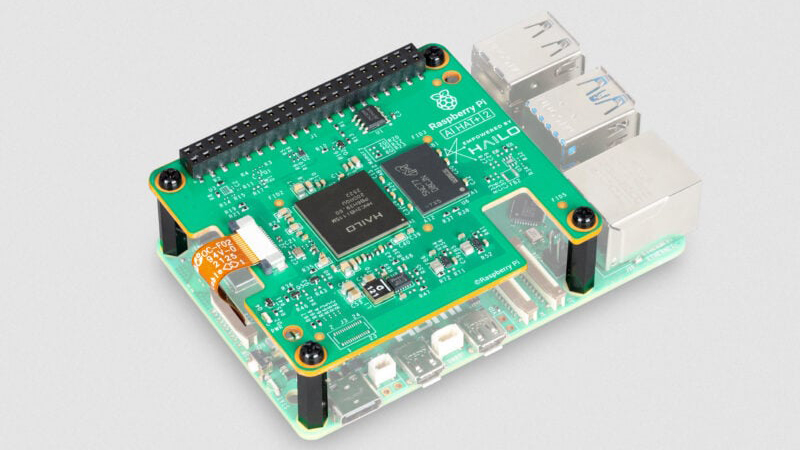

Модуль AI HAT+ 2 добавляет к Raspberry Pi 5 ИИ-ускоритель Hailo-10HКомпания Raspberry Pi анонсировала специализированный модуль расширения AI HAT+ 2, позволяющий использовать одноплатный компьютер Raspberry Pi 5 для ИИ-инференса. Новинка уже доступна для заказа по ориентировочной цене $130. Ранее Raspberry Pi выпустила ИИ-модуль AI HAT+, который в зависимости от модификации оснащается ускорителем Hailo-8 (26 TOPS) или Hailo-8L (13 TOPS). Такие изделия предназначены прежде всего для инференса. Решение Raspberry Pi AI HAT+ 2, в свою очередь, спроектировано под генеративный ИИ. В основу новинки положен ускоритель Hailo-10H, который позволяет использовать большие языковые модели (LLM), визуально-языковые модели (VLM) и другие модели генеративного ИИ локально. Чип функционирует в тандеме с 8 Гбайт LPDDR4/4X. Заявленная ИИ-производительность достигает 40 TOPS на операциях INT4. Для задач, основанных на машинном зрении, таких как распознавание объектов, оценка позы и сегментация сцены, производительность AI HAT+ 2 приблизительно эквивалентна быстродействию ранее выпущенного ИИ-модуля на базе Hailo-8.

Источник изображения: Raspberry Pi При подключении модуля операционная система Raspberry Pi OS автоматически обнаруживает ускоритель и переносит на него поддерживаемые задачи ИИ. Поначалу для изделия будут доступны следующие LLM: DeepSeek-R1-Distill, Qwen2.5-Coder, Qwen2.5-Instruct и Qwen2 (все с 1,5 млрд параметров), а также Llama3.2 (с 1 млрд параметров). В дальнейшем будут предложены более крупные модели.

15.01.2026 [16:15], Руслан Авдеев

Jefferies: как бы Трамп ни противился, солнечная энергия всё ещё остаётся привлекательной для ЦОДХотя нынешняя администрация США весьма скептически относятся к возобновляемым источникам энергии, солнечная энергетика, похоже, останется важным элементом снабжения ЦОД, сообщает The Register. По данным инвестиционного банка Jefferies, компании, занимающиеся «чистой» энергетикой, вынуждены адаптироваться к меняющимся временам. В частности, прошлым летом значительно уменьшены бюджетные ассигнования на многие налоговые льготы, выделявшиеся «чистым» энергетическим проектам с момента принятия Закона о снижении инфляции (Inflation Reduction Act) в США в 2022 году. Этому предшествовал более ранний указ, заморозивший одобрение проектов ветряной энергетики на федеральном уровне, что уже привело к искам к правительству. Впрочем, Jefferies отмечает, что бюджетный закон, несмотря на сокращение помощи, способствовал появлению определённости на рынке. Теперь компании, занятые «чистой» энергетикой, ориентируются на соглашения о выкупе энергии (PPA) с ИИ ЦОД. Атомная, газовая и геотермальная энергетика лучше подходят для такого спроса, но относительно недорогая солнечная энергия тоже играет свою роль. В качестве основных партнёров обычно рассматриваются поставщики энергии газовых турбин, что сдерживает рост PPA для солнечной и ветряной энергии. Тем не менее, эксперты предполагают, что компании в этих сферах в 2026 году всё равно расширят сферу своего действия.

Источник изображения: Markus Spiske/unspalsh.com В частности, речь идёт о рынке энергохранилищ. Согласно предыдущему прогнозу Jefferies, аккумуляторные хранилища (BESS) могут стать для ЦОД стандартным решением, поскольку в них нуждаются гиперскейлеры для развития ИИ-отрасли. В 2025 году исследование Centre for Net Zero продемонстрировало, что «микросети», включающие прибрежные ветряные и солнечные электростанции вкупе с аккумуляторными хранилищами и газовыми генераторами при ЦОД, обойдутся операторам дата-центров значительно дешевле, чем получение электроэнергии от малых модульных реакторов (SMR), несмотря на популярность последних в энергетической отрасли. Тем временем опубликованный Советом по международным отношениям (Council on Foreign Relations, CFR) доклад свидетельствует, что Конгресс США отклонил огромные сокращения бюджетных ассигнований на федеральные проекты исследований и развития энергетики, предложенные администрацией США. В CFR утверждают, что пересмотренный бюджет не позволит уступить Китаю и другим странам в деле внедрения передовых энергетических технологий. Новые технологии, более дешёвые и «чистые», чем доминирующие сегодня, сформируют триллионные рынки, причём Китай уже активно пользуется возможностью занять лидирующие позиции на рынках солнечных панелей и литий-ионных аккумуляторов. Значительную роль, по мнению Jefferies, может сыграть и мнение потребителей энергии. Доступность энергии является одной из ключевых проблем, что создаёт «положительные предпосылки» для ввода новых солнечных мощностей для частичной компенсации роста стоимости электроэнергии, хотя позиция администрация США относительно «зелёной» энергетики пока неизменна. В Jefferies предлагают следить, как будет развиваться ситуация с возобновляемыми источниками энергии на фоне роста розничных цен на электричество. Хотя Вашингтон, вероятно, будет и далее продвигать новые проекты АЭС и даже угольные инициативы, время запуска атомных станций слишком велико, чтобы позитивно повлиять на размер счетов за электричество.

15.01.2026 [15:20], Руслан Авдеев

Microsoft прекратила расширенную поддержку Windows Server 2008 — даже за деньгиMicrosoft без лишнего шума закончила поддержку операционной системы, выпущенной 18 лет назад — Windows Server 2008 на платформе Windows Vista теперь официально заброшена, сообщает The Register. 14 января 2020 года прекратилась расширенная поддержка для всех пользователей (Extended Support) системы под кодовым названием Longhorn Server. С 2020 по 2023 гг. действовала программа Extended Security Updates (ESU) — платные обновления безопасности для всех желающих. При переносе сервера в облако Azure бесплатные обновления предоставлялись ещё год, до 9 января 2024 года. Наконец, 13 января 2026 года полностью прекратилась поддержка даже для тех клиентов, кто оплатил действующий контракт Premium Assurance (PA). Стоит отметить, что Extended Security Updates (ESU) предлагалась для того, чтобы заменить Premium Assurance (PA), если та была куплена до 2018 года и была платным дополнением плана Software Assurance со сроком действия шесть лет. В своё время Microsoft пообещала выполнять обязательства, связанные с предоставление обновлений покупателям PA.

Источник изображения: Annie Spratt/unsplash.com Теперь продукты на платформе Windows Vista, анонсированной в 2006 году и ставшей общедоступной в 2007-м, более не поддерживается. Сама Windows Server 2008 увидела свет в 2008 году. Отдельно отмечается общая длительность сопровождения — фактически поддержка для платформы Vista осуществлялась дольше, чем для XP.

15.01.2026 [14:42], Руслан Авдеев

Бирмингем снова отложил перезапуск печально известной ERP-системы Oracle FusionГородской совет Бирмингема отложил повторный запуск печально известной ERP-системы Oracle Fusion, ставшей причиной многомиллионных расходов. В совете заявили, что сотрудникам нужно больше времени, чтобы адаптироваться к стандартным процессам вендора, сообщает The Register. Очередные манипуляции с ПО в крупнейшем муниципалитете Евросоюза последовали за крайне неудачной попыткой внедрить в 2022 году в Бирмингеме Oracle Fusion для управления миллионными поступлениями налогоплательщиков и многомиллионными же расходами, фактически превратившей местные власти в банкротов. Общая стоимость перехода с SAP на Oracle увеличилась с заложенных изначально £19 млн до около £131 млн, а позже до £170 млн. С учётом потерь в результате неудачного внедрения речь идёт уже о £216,5 млн, хотя эксперты в самом начале предрекали крупные проблемы, ведущие к задержке платежей и накоплению долгов В 2020 году муниципалитет запланировал заменить устаревшую систему SAP на стандартный вариант ПО Oracle. Тем не менее, проект подвергся усиленной кастомизации, включая внедрение системы сверки банковских счетов (Bank Reconciliation System), работу которой должным образом так и не смогли наладить. Когда изменения ПО практически парализовали работу системы, власти Бирмингема попытались заново внедрить решение Oracle «из коробки», а для банковских процедур было решено использовать стороннее ПО Income Management.

Источник изображения: Francisco Gomes/unsplash.com Замена должна была состояться в апреле, но недавно двое представителей муниципалитета заявили о переносе процедуры как минимум до лета. По результатам тестирования и оценки готовности ПО совет учёл мнение сотрудников и решил перенести дату ввода системы в эксплуатацию для снижения рисков и для того, чтобы гарантировать точность выплаты зарплат. Подчёркивается, что речь идёт лишь о переносе сроков, а не очередном «перезапуске». Хотя в мае 2024 года обслуживание школ исключили из обновлённого проекта, его стоимость продолжала расти. По данным муниципальных властей, управленческие решения должны быть приняты позже в январе, а независимая экспертиза должна установить, готова ли программа к запуску. Местные политики уже предрекают, что муниципалитет придёт к местным выборам в мае без функционирующей финансовой системы. Сами представители совета утверждают, что необходимо убедиться в успешности повторного внедрения ПО, не стремясь обеспечить его к заданным датам в ущерб стабильности. Влияния на работу действующей системы новая не окажет, а сервисы продолжат функционировать так, как функционируют сейчас. Бюджет на повторное внедрение системы включал резервные средства на случай изменений, поэтому роста расходов не ожидается. Внедрение будет проходить поэтапно, с независимой проверкой на согласованных заранее контрольных точках.

15.01.2026 [14:35], Владимир Мироненко

Акции «Базиса» включили в сектор рынка инноваций и инвестиций, что предоставит льготы при их покупкеС сегодняшнего дня акции «Базиса», российского разработчика ПО управления, включены в сектор рынка инноваций и инвестиций (РИИ) Московской биржи, сообщается на сайте торговой площадки. В настоящее время перечень сектора РИИ Московской биржи насчитывает акции 27 компаний. Сектор РИИ призван содействовать привлечению инвестиций в компании инновационного сегмента российской экономики. Включение в сектор РИИ означает, что обыкновенные акции «Базиса» будут добавлены в перечень ценных бумаг высокотехнологичного сектора экономики. Это представит право физическим лицам, владеющим такими акциями не менее одного года, на освобождение от уплаты налога на доходы от их продажи. Льготы по налогообложению распространяются на доходы в размере до 50 млн руб.

Источник изображения: «Базис» После проведения IPO акции «Базис» были включены во второй уровень котировального списка Московской Биржи. Торги ими начались 10 декабря под тикером BAZA (ISIN RU000A10CTQ0). Также акции компании были включены в индекс IPO Московской Биржи (MIPO), который служит инструментом для отслеживания динамики компаний, недавно вышедших на рынок капитала. Он включает акции эмитентов, которые провели первичное размещение или листинг на бирже не ранее чем за два года до даты формирования базы расчета. В результате IPO компания привлекла 3 млрд руб. при оценке рыночной капитализации в размере 18 млрд руб. «Базис» осуществляет продажи через более 230 дистрибьюторов и партнёров, включая 5 дистрибьюторов, более 200 системных интеграторов и более 30 технологических партнёров. Все её решения включены в Единый реестр российского ПО. Кроме того, ряд продуктов имеет сертификаты ФСТЭК IV уровня доверия.

15.01.2026 [13:06], Владимир Мироненко

Большая часть российских компаний не спешит с переходом на отечественный корпоративный софтБолее 70 % российских компаний продолжают использовать иностранный корпоративный софт, несмотря на объявленный правительством курс на импортозамещение, сообщили «Ведомости» со ссылкой на исследование компании Naumen, проведённое в конце 2025 года на основе опроса более 80 менеджеров из финансового сектора, промышленности, ритейла, IT, телекома, госуправления, энергетики, транспорта и логистики. В Naumen уточнили, что корпоративный софт включает CRM-системы, системы управления проектами, управления IT-службой, документооборот, голосовых и текстовых роботов для автоматизации клиентских обращений, ПО для внутренних коммуникаций, HRTech и т. д. При этом в исследовании не учитывались операционные системы. Согласно опросу, около трети (32 %) респондентов используют зарубежные IT-решения, поскольку нет подходящего решения на российском рынке, а ещё 16 % — из-за того, что отечественные аналоги чересчур дорогие. Ещё 12 % респондентов не начали импортозамещение, столько же ждут возвращения иностранных вендоров. Более четверти (27 %) опрошенных использует не менее пяти иностранных продуктов в разных категориях ПО. В исследовании приняли участие компаниях, на которых не распространяются регуляторные ограничения и требования по обязательному импортозамещению. Они продолжают использовать зарубежный софт и надеются, что он вскоре вновь будет доступен. Что касается регулируемого сегмента, что согласно данным Ассоциации разработчиков программных продуктов (АРПП), к концу 2025 года на отечественное ПО перешли лишь 40–45 % субъектов КИИ. Эксперты подтверждают тот факт, что удельный вес компаний, продолжающих использовать зарубежный софт, достигает 70 %, несмотря на связанные с этим риски, включая зависимость от внешней поддержки, угрозу отключений и технических проблем. К тому же переход на отечественное ПО тормозится его сложностью, поскольку это не только замена одного решения на другое, но ещё и обучение сотрудников или даже перестройка бизнес-процессов. Сказывается и привычка к устоявшимся подходам, приёмам, стандартам и форматам зарубежных вендоров, говорят эксперты. Вместе с тем в некоторых сегментах ситуация совсем другая. Например, в сфере информационной безопасности прошло практически полное импортозамещение, говорят эксперты. По их мнению, импортозамещение осуществляется там, где оно становится неизбежным. Если же использование иностранного ПО будет по-прежнему допустимым, многие компании не будут спешить с переходом на отечественный софт.

15.01.2026 [12:40], Сергей Карасёв

Infineon представила чипы Airoc ACW741x с поддержкой Wi-Fi 7, Bluetooth LE 6.0 и Thread для IoT-оборудованияКомпания Infineon Technologies AG анонсировала чипы беспроводной связи серии Airoc ACW741x, предназначенные для применения в оборудовании интернета вещей (IoT). Изделия могут использоваться в технике для умного дома, IP-камерах, маршрутизаторах, концентраторах и пр. Чипы Airoc ACW741x объединяют в одном решении контроллер Bluetooth LE 6.0 и радиомодуль с поддержкой Wi-Fi 7 с возможностью работы в полосах 2,4/5/6 ГГц. Реализована технология Wi-Fi 7 Multi-Link (MLO), которая позволяет одновременно использовать несколько частотных диапазонов для повышения надёжности и пропускной способности, а также снижения задержек. Новинки используют архитектуру с каналами 20 МГц. Изделия поддерживают стандарт 802.15.4/Thread для беспроводных сетей с низким энергопотреблением и ячеистой топологией. Благодаря совместимости со стандартом Matter в единую сеть могут объединяться IoT-устройства разных производителей. Утверждается, что новые чипы обеспечивают до 15 раз меньшее энергопотребление в режиме ожидания по сравнению с конкурирующими решениями, что особенно важно в случае устройств, получающих питание от батареи. Упомянута функция канального зондирования Bluetooth 6.0 Channel Sounding: она обеспечивает возможность определения расстояния и местоположения устройств с точностью до сантиметра. Технология Wi-Fi Sensing на базе стандарта 802.11bf позволяет оборудованию Wi-Fi работать в качестве датчиков, способных определять присутствие и количество людей, их перемещения и даже жесты. Достигается это путём анализа отражений и искажений сигналов беспроводной связи. Чипы ACW741x выполнены в корпусе QFN. Диапазон рабочих температур в зависимости от модификации простирается от -40 до +85 °C или от -40 до +105 °C. Поставки образцов изделий уже начались.

15.01.2026 [10:10], Руслан Авдеев

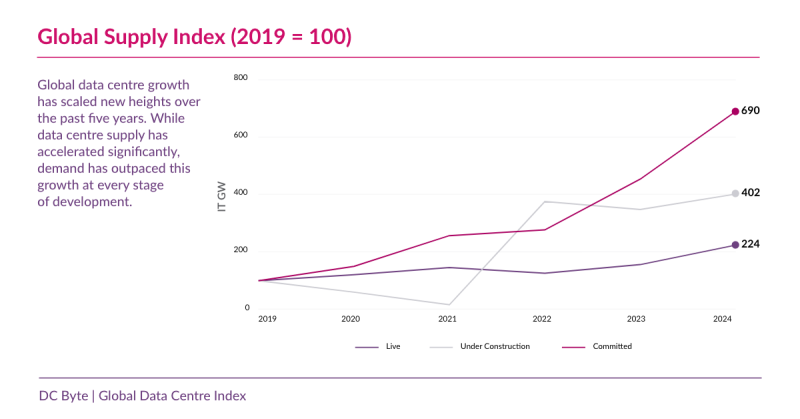

Планировать — не строить: пять трендов мирового рынка ЦОД в 2026 году по версии DC ByteВ 2026 году облака гиперскейлеров и ИИ-нагрузки требуют новых мощностей ЦОД, но возможность превратить запланированные мощности в действующие становится всё менее очевидной. Проблемы с доступностью энергии, ограничения регуляторов и задержки с вводом в эксплуатацию теперь оказывают существенное влияние, заявляется в докладе DC Byte. Аналитики назвали пять трендов, влияющих на планирование, финансирование и строительство новых мощностей ЦОД в 2026 году:

По данным DC Byte 2025 Global Data Centre Index, с 2019 года количество запланированных проектов ЦОД выросло более чем в шесть раз, но их вводимая в строй мощность растёт гораздо медленнее. В результате масштаб и спрос не меняются, но реализовать проекты становится сложнее, сроки реализации всё менее предсказуемы, а риски всё ощутимее. Дефицит электроэнергии, бюрократические барьеры и непредсказуемые сроки строительства будут ключевыми факторами для принятия решений о реализации инфраструктурных проектов для инвесторов и операторов, если ситуация останется неизменной в течение 2026 года.

Источник изображения: DC Byte Согласно докладу, разрыв между объектами «на бумаге» и реально строящимися дата-центрами только растёт. На некоторых ключевых рынках анонсированные мощности более чем вдвое больше действительно возводимых. Дело не в спросе — он велик в сфере облаков, соцсетей и ИИ, как и готовность инвесторов выделять средства. Реализация проектов нередко останавливается на полпути из-за проблем с присоединением к электросетям, задержек с получением разрешений от регуляторов, необходимости модернизации энергосетей и больших сроков поставок критически важного оборудования. В «зрелых» хабах уровень доступных мощностей упал ниже 1 %, но новые дата-центры по-прежнему часто так и не продвигаются дальше стадии планирования. Политические и бюрократические решения стали кардинально влиять на время реализации проектов. Исследование показало, что на некоторых зрелых рынках время присоединения к электросетям ожидается не раньше конца 2020-х гг., например, в Северной Вирджинии на подключение проектов мощнее 100 МВт может и вовсе уйти не менее семи лет. Если ранее разрешения на строительство получали за считанные месяцы, то теперь на это уходят годы, даже для хорошо финансируемых инициатив. На задержки влияют экологические законы, реформы зонирования, учёт энергоэффективности и др. Впрочем, на некоторых рынках происходит обратное — власти пытаются привлечь инвестиции, упрощая процесс получения всевозможных разрешений. Однако теперь инвесторы вынуждены вкладывать деньги в ЦОД как можно раньше, что связано с большими рисками — за 24–36 мес. до ожидаемого ввода в эксплуатацию, нередко на этапах покупки земли, переговорах о поставках энергии или получения разрешений. Ранее инвестиции поступали после подписания договоров с арендаторами или в ходе завершения основных этапов строительства. Ранние инвестиции обеспечивают доступ к энергии и земле, но существуют риски изменения законодательства, задержек с присоединением к сетям и проблем в цепочках поставок. Если тенденция сохранится, в 2026 году успешность инвестиций, вероятно, будет в большей степени зависеть от надёжности реализации проектов, чем просто от прогнозирования спроса.

Источник изображения: Benjamin White/unsplash.com Вместе с тем в ключевых мировых хабах ограничения только растут, так что рост смещается в направлении вторичных и совсем уж небольших рынков. Растущая доля новых проектов гиперскейл-уровня реализуется за пределами традиционных крупных, в местах с более доступной энергией. В Европе акцент смещается с рынка FLAPD (Франкфурт, Лондон, Амстердам, Париж и Дублин) в Южную и Центральную Европу. Такая децентрализация отражает ограничения в доступности энергии, земли и проблемах с регуляторами и заставляет пересматривать долгосрочные стратегии. Так, в АТР общая мощность ЦОД гиперскейлеров с 2020 по 2025 гг. росла в среднем на 32,9 % в год (CAGR), причём в основном рост отмечен за пределами старейших хабов региона. Если ограничения на ключевых рынках сохранятся, это скажется и на проектах в 2026 году. Рынки с более стабильным энергоснабжением и прозрачными правилами строительства растут более последовательно. Анализ показывает, что на таких рынках ввод мощностей идёт более стабильно, демонстрируя меньший разрыв между анонсированными, утверждёнными и введёнными в эксплуатацию ЦОД. Так, в Норвегии CAGR рынка в течение пяти лет с 2019 года составлил 43 % в год, а в Финляндии только в 2023–2024 гг. было введено более 1,4 ГВт IT-мощностей. Хотя в таких регионах нет крупных ежегодных анонсов новых проектов, в целом они обеспечивают более эффективную реализацию проектов, от стадии планирования до появления действующей инфраструктуры, с меньшими задержками, сроками реализации и рисками. С учётом пяти названных факторов, можно предполагать, что в 2026 году выигрывать будут проекты, которые легче реализовать — от стадии планирования до завершения строительства. По словам представителя DC Byte, значение теперь будет иметь не то, какие мощности ЦОД анонсированы, а то, сколько именно мощностей можно будет предоставить в срок. Недавно в докладе JLL сообщалось, что огромные затраты на ИИ ЦОД свидетельствуют не о «пузыре», а о «суперцикле» — к 2030 году на ЦОД будет потрачено $3 трлн. Правда, в сентябре 2025 года Bain Global Technology Report прогнозировала, что расходы ИИ-отрасли к 2030 году могут оказаться на $800 млрд больше её доходов.

15.01.2026 [09:09], Владимир Мироненко

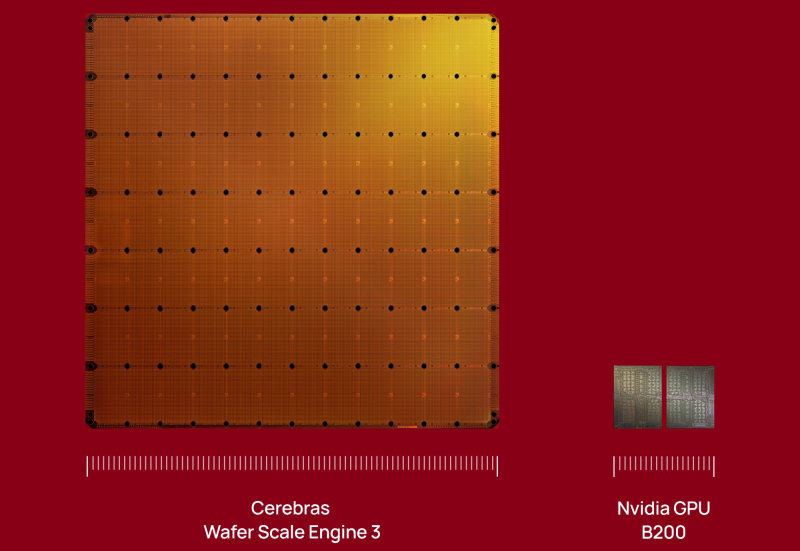

Инвесторы вкладывают сотни миллионов долларов в Etched и Cerebras в надежде, что они потеснят NVIDIA на рынке ИИЛидирующие позиции NVIDIA на рынке ИИ-ускорителей кажутся незыблемыми на долгие годы, но, как полагает ресурс SiliconANGLE, ей следует присмотреться к ближайшим конкурентам, которые пока не «дышат в спину», но стремительно наращивают свои возможности, получая солидную финансовую поддержку для роста. Согласно данным источников Bloomberg (официального сообщения пока не поступало), стартап Etched, занимающийся разработкой ИИ-чипов, привлёк около $500 млн в новом раунде финансирования, благодаря чему оценка его рыночной стоимости составила $5 млрд. Ещё более крупный конкурент NVIDIA, компания Cerebras Systems, по данным The Information, ведёт переговоры о привлечении $1 млрд инвестиций в рамках очередного раунда финансирования при оценке капитализации в $22 млрд. Всего лишь три месяца назад она уже получила $1,1 млрд при оценке в $8,1 млрд, в очередной раз перенеся IPO. По данным источников The Information, компания всё же выйдет на биржу в ближайшие месяцы. Сделка с OpenAI снизит её зависимость от базирующейся в ОАЭ компании G42. Как сообщают источники, нынешний раунд финансирования Etched возглавила компания Stripes при участии миллиардера Питера Тиля (Peter Thiel), а также компаний Positive Sum и Ribbit Capital. Ранее в инвестировании стартапа принимали участие Primary Venture Partners и известные бизнес-ангелы, такие как генеральный директор GitHub Томас Домке (Thomas Dohmke) и бывший руководитель Coinbase Баладжи Сринивасан (Balaji Srinivasan). По словам источников, с учётом этого раунда общая сумма привлечённых средств Etched приблизилась к $1 млрд. Это довольно внушительный финансовый резерв для стартапа, существующего всего два года. Etched создал Sohu — узкоспециализированный ASIC разработанный специально для инференса ИИ-моделями на архитектуре трансформеров. При разработке чипа Etched сотрудничала с группой Emerging Businesses компании TSMC, что свидетельствует как о технических амбициях, так и о производственной надёжности. Также к участию в проекте привлекли специалистов, ранее работавших в таких компаниях, как Cypress Semiconductor и Broadcom. В свою очередь, Cerebras Systems получила известность благодаря своим царь-чипам WSE, которые, по словам компании, значительно быстрее и энергоэффективнее решений NVDIA в ИИ-задачах. В отличие от Etched, Cerebras активно наращивает клиентскую базу, не только развёртывая оборудование, но и предоставляя услуги облачных ИИ-вычислений. Среди её клиентов — Meta✴, IBM и Mistral AI.

15.01.2026 [01:05], Игорь Осколков

$10 млрд за 750 МВт ИИ-мощностей: OpenAI подписала сделку с CerebrasOpenAI подписала многолетнее соглашение с разработчиком царь-ускорителей Cerebras, который до 2028 поставит 750 МВт вычислительных мощностей. По данным CNBC, сумма сделки превышает $10 млрд. Идёт ли речь о продаже ИИ-ускорителей или предоставлении сервисов инференса, пока не уточняется. «Вычислительная стратегия OpenAI заключается в создании отказоустойчивого портфеля, в рамках которого для различных рабочих нагрузок подбираются подходящие системы», — сообщила OpenAI, отметив высокую скорость инференса решений Cerebras, что ускорит генерацию ответов, обеспечит более естественное взаимодействие и позволит масштабировать использование ИИ в реальном времени для гораздо большего числа людей. OpenAI использует комбинацию ускорителей AMD и NVIDIA, а также строит гигантские ЦОД на базе решений последней в рамках проекта Stargate. Кроме того, OpenAI сотрудничает с Google, у которой есть ускорители TPU, а также разрабатывает собственные ИИ-чипы в партнёрстве с Broadcom. Наконец, компания может повлиять на разработку нового поколения фирменных ускорителей Microsoft Maia. AWS тоже не прочь дать OpenAI свои ИИ-ускорители Trainium, но пока компании договорились лишь о масштабной аренде чипов NVIDIA. Примечательно, что OpenAI ещё в 2017 году раздумывала, не купить ли Cerebras при участии Tesla, глава которой Илон Маск (Elon Musk) тогда всё ещё работал в OpenAI. На тот момент Cerebras было всего два года, а свой первый ускоритель WSE она представила только в 2019 году. Серьёзную поддержку компании оказала G42 из ОАЭ, но в итоге Cerebras оказалась от неё слишком зависима, так что сделка с OpenAI сыграет компании на руку в преддверии всё откладывающегося выхода на биржу. |

|