Материалы по тегу: ии

|

24.11.2025 [18:08], Андрей Крупин

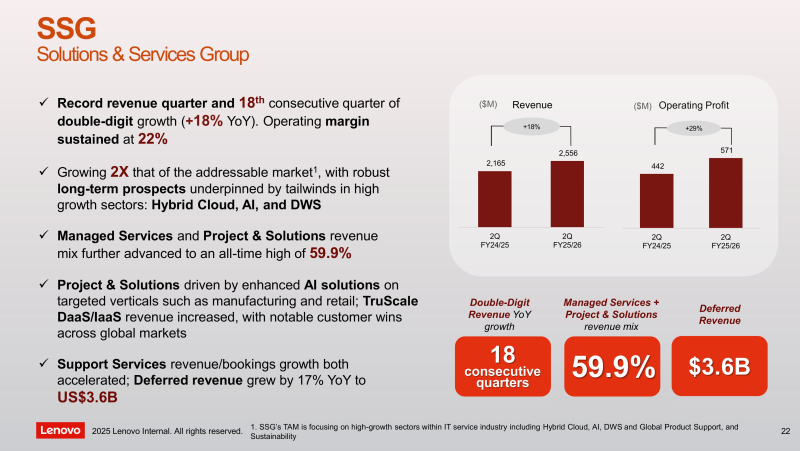

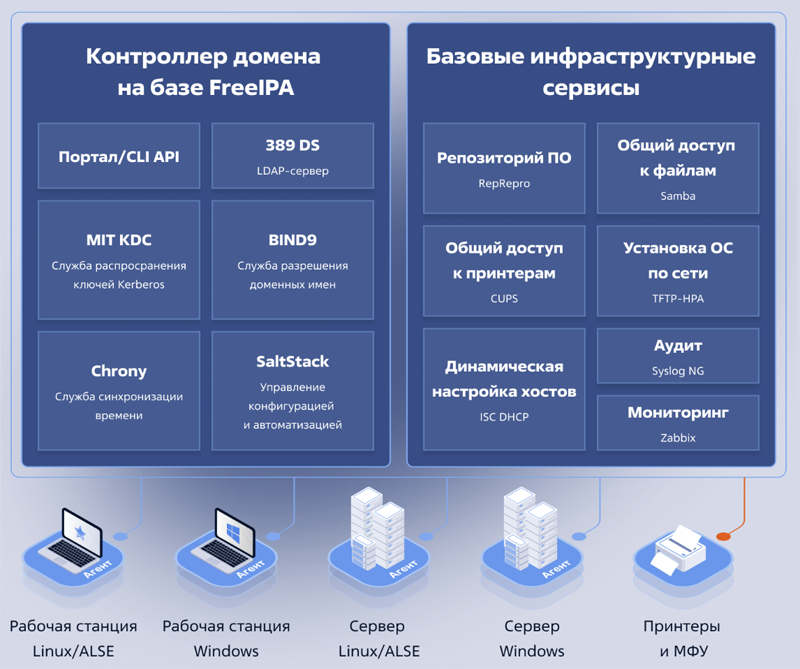

Российская служба каталогов ALD Pro дополнилась ИИ-помощником для системных администраторов«Группа Астра» представила новую разработку — ИИ-ассистент для службы каталогов ALD Pro. Программный комплекс ALD Pro предназначен для автоматизации и централизованного управления рабочими станциями, иерархией подразделений и групповыми политиками, а также прикладными сервисами для IT-инфраструктур организаций различного масштаба. Продукт может использоваться в качестве замены Microsoft Active Directory и учитывает интересы администраторов и пользователей компаний, переходящих на отечественный софт. ALD Pro включён в дорожную карту «Новое общесистемное программное обеспечение»; решению присвоен статус «особо важного продукта» в рамках программы Минцифры России. Система соответствует требованиям ФСТЭК по 2-му уровню доверия и может использоваться в организациях, предъявляющих высокие требования к безопасности корпоративного ПО.

Архитектура платформы ALD Pro (источник изображений: astra.ru) Встроенный в ALD Pro интеллектуальный ассистент избавляет системных администраторов от необходимости вручную искать информацию: теперь точный ответ на любой вопрос по работе со службой каталогов можно получить буквально за несколько секунд. Для формулировки запроса не требуется знание специальных команд или терминов. ИИ-помощник обеспечивает мгновенный доступ к знаниям, минимизируя простои в работе, и автоматизирует рутинный поиск, высвобождая время сотрудников для более важных задач. Кроме того, ассистент значительно ускоряет адаптацию новых сотрудников, предоставляя им встроенную экспертную поддержку и сокращая время на обучение. «На кейсе ALD Pro мы доказали, что локально размещённые большие языковые модели, настроенные под конкретные задачи, демонстрируют свыше 70 % качественных ответов и значительно снижают нагрузку на техническую поддержку. ИИ-помощник — незаменимый инструмент для компаний на этапе импортозамещения, позволяющий им быстро адаптироваться к изменениям. Внедрение таких решений позволяет ускорить онбординг сотрудников и повысить общую продуктивность команд на 30–40 %», — отмечает «Группа Астра».

24.11.2025 [17:46], Владимир Мироненко

Nokia инвестирует $4 млрд в производство и исследования в СШАКомпания Nokia в сотрудничестве с администрацией президента США объявила о планах инвестировать в течение нескольких лет $4 млрд в программы по расширению своих научно-исследовательских и производственных мощностей в США, чтобы ускорить разработки в области технологий мобильного и фиксированного доступа, IP, оптических сетей и сетей для ИИ ЦОД. Компания отметила, что этот шаг дополняет её инвестиции в производство, исследования и разработки в США в размере $2,3 млрд в рамках покупки Infinera. Кроме того, ранее Infinera объявила об инвестициях в размере $456 млн в строительство производственных мощностей в Сан-Хосе (San Jose, Калифорния) и предприятия по тестированию и упаковке в Бетлехеме (Bethlehem, Пенсильвания). $3,5 млрд из объявленной суммы инвестиций Nokia направит на поддержку исследований и разработок в США в области передовых сетевых технологий, включая автоматизацию, квантово-безопасные сети, производство полупроводников, тестирование и упаковку, а также современные материаловедческие разработки. Оставшаяся часть в размере $500 млн будет инвестирована в производство, исследования и разработки в США, в том числе в Техасе, Нью-Джерси и Пенсильвании. Nokia отметила, что эта инициатива укрепляет её внутренние производственные возможности в области мобильных, фиксированных, IP-, оптических и оборонных систем. В минувшую пятницу президент и исполнительный директор Nokia Джастин Хотард (Justin Hotard) заявил, что новые вложения позволят укрепить сетевую инфраструктуру на фоне роста инвестиций в ИИ, сообщил ресурс The Wall Street Journal. На прошлой неделе компания объявила на мероприятии 2025 Capital Markets Day для акционеров и инвесторов о масштабной «перезагрузке», в рамках которой оптимизирует свою деятельность, произведёт перестановки в руководящей команде и будет стремиться к расширению совместных партнёрских отношений в области инноваций в рамках курса на развитие ИИ и облачных вычислений. Добавим, что в конце октября NVIDIA сообщила о намерении приобрести пакет акций финской компании стоимостью $1 млрд.

24.11.2025 [16:21], Руслан Авдеев

PLDT оснастит базовые станции роборуками и ИИ, чтобы оптимизировать покрытие сети в реальном времениSmart Communications, дочерняя структура филиппинской телеком-компании PLDT, проводит пилотные испытания дистанционно управляемых роботизированных рук для базовых станций сотовой связи. Они помогут оптимизировать зону покрытия и повысить производительность сетевых подключений, сообщает Datacenter Dynamics. Особенно это актуально для удалённых районов, куда отправить живого техника сложно и дорого. Компания использует систему Optical Compass and Robot Arm (OCRA) от Humax Networks при поддержке интегратора Telkha. Отмечается, что благодаря этой системе операторы способны удалённо менять положение антенны в пространстве, благодаря чему корректировать настройки можно в режиме реального времени, в том числе во время пиковых дневных нагрузок.

Источник изображения: Humax Networks PLDT и Smart совместно с производителем OCRA — Humax Networks и системным интегратором Telkha запустили пилотную версию системы. Первую роборуку OCRA установили на действующей базовой станции, обслуживающей два объекта — больницу и близлежащий многоэтажный жилой комплекс. Испытания продемонстрировали улучшение уровня сигнала, качества и скорости в обоих локациях. Благодаря использованию OCRA компания сможет точно настраивать положение антенн и оптимизировать покрытие в режиме реального времени. Этот сократит время простоев и поднимет качество обслуживания клиентов. Особенно подчёркивается, что технология позволит инвестировать сэкономленные за счёт её внедрения средства в расширение и совершенствование сети, в конечном счёте это должно принести пользу конечным потребителям. В будущем планируется совместить возможность удалённого управления антеннами с ИИ-системой, что позволит отслеживать и корректировать состояние сети в реальном времени.

24.11.2025 [15:14], Сергей Карасёв

Технологии тысячеядерного RISC-V-ускорителя Esperanto будут переданы в open sourceСтартап Ainekko, специализирующийся на разработке аппаратных и программных решений в сфере ИИ, по сообщению EE Times, приобрёл интеллектуальную собственность и некоторые активы компании Esperanto Technologies. Речь идёт о дизайне чипов, программных инструментах и фреймворке. Фирма Esperanto, основанная в 2014 году, специализировалась на создании высокопроизводительных ускорителей с архитектурой RISC-V для задач НРС и ИИ. В частности, было представлено изделие ET-SoC-1, объединившее 1088 энергоэффективных ядер ET-Minion и четыре высокопроизводительных ядра ET-Maxion. Основной сферой применения чипа был заявлен инференс для рекомендательных систем, в том числе на периферии. Однако в июле нынешнего года стало известно, что Esperanto сворачивает деятельность и ищет покупателя на свои разработки — ключевых инженеров переманили крупные компании. А продать чипы Meta✴, в чём, по-видимому, и заключался изначальный план, не удалось. Как рассказала соучредитель Ainekko Таня Дадашева (Tanya Dadasheva), её компания работает с чипами Esperanto в течение примерно полугода. Изначально компания планировала использовать чипы Esperanto для запуска своего софтверного стека. В частности, удалось перенести llama.cpp up и tinygrad. Когда стало понятно, что Esperanto вряд ли выживет, было принято решение выкупить разработки стартапа. Во всяком случае, это лучше, чем просто закрыть компанию, оставив её заказчиков ни с чем, как поступила AMD с Untether AI.

Источник изображения: Esperanto Ainekko планирует передать сообществу open source технологии Esperanto, связанные с многоядерной архитектурой RISC-V, включая RTL, референсные проекты и инструменты разработки. Предполагается, что решения Esperanto будут востребованы прежде всего в области периферийных устройств, где большое значение имеет энергоэффективность. Архитектура Esperanto, как утверждается, подходит для таких задач, как робототехника и дроны, системы безопасности, встраиваемое оборудование с ИИ-функциями и пр. Второй соучредитель Ainekko Роман Шапошник (Roman Shaposhnik) добавляет, что многоядерная архитектура Esperanto подходит не только для разработки ИИ-чипов, но и для создания «универсальной вычислительной платформы». Сама Ainekko намерена выпустить чип с восемью ядрами Esperanto и 16 Мбайт памяти MRAM, разработанной стартапом Veevx. Отмечается, что соучредитель и генеральный директор Veevx, ветеран Broadcom Даг Смит (Doug Smith), является ещё одним сооснователем Ainekko. В дальнейшие планы входит разработка процессора с 256 ядрами: по производительности он будет сопоставим с чипом Broadcom BCM2712 (4 × 64-бит Arm Cortex-A76), лежащим в основе Raspberry Pi 5, но оптимизирован для инференса.

24.11.2025 [12:23], Руслан Авдеев

США рассматривают продажу в Китай ИИ-ускорителей NVIDIA H200Администрация США рассматривает возможность дать «зелёный свет» продажам ИИ-чипов NVIDIA H200 в КНР — по данным источников, некоторая двухсторонняя «разрядка» способствует обсуждению продаж передовых американских технологий в Китай, сообщает Reuters. Впрочем, H200 вряд ли можно назвать «новейшими» — в ходу уже совсем другие решения. В Белом Доме отказались комментировать ситуацию, но заявили, что американская администрация стремится «обеспечению американского технологического лидерства и защите национальной безопасности». Ранее глава NVIDIA Дженсен Хуанг (Jensen Huang) предупреждал, что именно запреты на продажу передовых решений могут угрожать технологическому лидерству США в мире. Теперь в NVIDIA не прокомментировали ситуацию прямо, но заявили, что текущие правила не позволяют продавать в Китае конкурентоспособные чипы, оставляя этот рынок на откуп быстро развивающимся иностранным конкурентам. Данные источников косвенно свидетельствуют о смягчении подхода США к отношениям с Китаем после того, как китайский Лидер Си Цзиньпин (Xi Jinping) в прошлом месяце заключил «перемирие» в технологической и торговой войнах. Антикитайские политики в Вашингтоне обеспокоены тем, что поставки более передовых чипов в Китай могут помочь Пекину «перезагрузить» военную машину, именно поэтому прошлая администрация в своё время ужесточила экспортный контроль в отношении Поднебесной.

Источник изображения: NVIDIA Столкнувшись с ограничениями Пекина на экспорт редкоземельных металлов, критически важных для производства многих высокотехнологичных продуктов, в этом году США пригрозили ввести новые технологические ограничения, но в итоге отказались от них в большинстве случаев. Чипы H200 представили два года назад, они получили более быструю и ёмкую память в сравнении с оригинальными H100, что позволяет быстрее обрабатывать данные ИИ-серверами. По имеющимся оценкам, модели H200 вдвое производительнее, чем варианты H20, разрешённые для экспорта в Китай Трампом после короткого тотального запрета. В отношении ближневосточных стран, которым тоже долго не разрешали закупать ускоритли из-за опасений, что они в итоге достанутся Китаю, послабления были объявлены на днях. В частности, Министерство торговли США уже одобрило поставку в страну эквивалент до 70 тыс. чипов NVIDIA Blackwell компаниям Humain и G42 из Саудовской Аравии и ОАЭ соответственно.

24.11.2025 [10:17], Руслан Авдеев

Перекрыть потоки: NVIDIA усиливает контроль над цепочкой поставок СЖО для Vera Rubin

cooler master

delta electronics

foxconn

hardware

nvidia

odm

qct

vr200

wistron

водоблок

ии

производство

сжо

NVIDIA намерена серьёзно изменить управление цепочкой поставок для серверной платформы новейшего поколения Vera Rubin. Она ужесточает контроль над сборкой и поставкой ключевых компонентов систем охлаждения, что связано с ростом энергопотребления и обязательным применением СЖО, сообщает DigiTimes. Это ещё один шаг в процессе усиления контроля над выпуском ИИ-платформ. NVIDIA уже давно внимательно следит за цепочками поставок для ускорителей и плат, но теперь намерена перейти на новый уровень. Источники сообщают, что компания намерена отобрать четырёх поставщиков водоблоков, перейти к координации производства и централизованным закупкам. Предполагается, что это будут Cooler Master, Asia Vital Components (AVC), Auras Technology и Delta Electronics. Ранее СЖО для NVIDIA занимались, в основном, Cooler Master, AVC и некоторые другие поставщики. Ожидается, что для Vera Rubin вместо поставки лишь отдельных компонентов (L6), NVIDIA будет участвовать в процессе и на более позднем этапе (L10), взяв ответственность за интеграцию и сборку готовых серверных шкафов. В целом окончательную сборку поручат Foxconn, Wistron и Quanta. Из-за необходимости быстрого выпуска продукции на поставщиков легла дополнительная нагрузка. Некоторые из них в частном порядке жалуются, что NVIDIA настаивает на запуске массового производства ещё до утверждения окончательного дизайна платформ, а новое поколение платформ часто появляется до того, как предыдущее достигло стабильного уровня производства и качества. Централизованные закупки помогут NVIDIA оптимизировать поставки и контролировать качество, но рентабельность работы поставщиков может пострадать, поскольку NVIDIA сама будет управлять спросом и торговаться по поводу цен. При этом отказ от подобных условий практически невозможен, учитывая доминирующее положение компании на рынке ИИ-инфраструктуры. В результате снижается самостоятельность как ODM, так и облачных провайдеров. Из-за этого же, как считается, во многом замедлено и развитие погружных СЖО — NVIDIA попросту не готова сертифицировать такие системы. Эксперты всё чаще говорят о росте напряжённости, которая со временем приведёт к открытому конфликту. Новый подход NVIDIA, вероятно, повлияет на цепочку поставок двумя путями. Во-первых, контракты на сборку консолидируются вокруг небольшого пула производителей, а выпуск водоблоков сконцентрируется в руках трёх-четырёх компаний. Облачным провайдерам, вероятно, тоже придётся идти на поводу NVIDIA при размещении крупных оптовых заказов, хотя они как раз предпочитают создавать собственные СЖО, что в целом тоже негативно влияет на некоторых игроков. Во-вторых, рост объёмов поставок не гарантирует роста рентабельности. Поставщики предполагают, что цена за единицу продукции в рамках попыток NVIDIA сконцентрировать производителей уменьшится, а более жёсткий контроль над проектированием снизит и стратегическую ценность индивидуальных разработок. Компании уже шутят, что статус крупнейшего поставщика NVIDIA может буквально навредить, поскольку по мере роста объёмов обычно растут и дисконты. Ожидается, что стойки поколения Vera Rubin обеспечат значительно более высокую плотность вычислений, чем уже доступные платформы GB200 и GB300, а для традиционного воздушного охлаждения места уже не останется. В отрасли ожидают, что Vera Rubin представят во II половине 2026 года. Платформа представляет собой важный шаг к созданию ИИ-инфраструктуры с полностью жидкостным охлаждением. Новейшая стратегия NVIDIA, касающаяся цепочек поставок, свидетельствует о решимости компании усилить прямой контроль качества, поставок и их стоимости по мере роста плотности мощности. В JPMorgan утверждают, что NVIDIA станет напрямую поставлять системы L10. Компания унифицирует конструкцию и заставит подрядчиков строго придерживаться предлагаемых чертежей и дизайна без использования проприетарных архитектур, созданных самими подрядчиками. Для NVIDIA это выгодно, поскольку позволяет значительно ускорить отгрузки и кратно сократить сроки развёртывания ИИ-инфраструктур (до 3 мес. вместо 9 мес.), опираясь на единые стандарты — от одного узла до целой ИИ-фабрики. При этом AWS, вероятно, придётся тяжелее всех, поскольку она пытается снизить зависимость от NVIDIA и в то же время не является активным сторонником OCP.

23.11.2025 [17:01], Руслан Авдеев

OpenAI и Foxconn оптимизируют стоечные решения для ИИ ЦОД, которые будут выпускаться в СШАКомпании OpenAI и Foxconn займутся совместной оптимизацией проектирования дата-центров. ИИ-гигант объявил, что партнёрство с Foxconn (Hon Hai Technology) сосредоточится на совместной разработке и подготовке производства в США нового поколения аппаратного обеспечения для ИИ-инфраструктур. Компании займутся проектированием и подготовке к реализации проектов «многочисленных поколений ИИ-стоек для дата-центров», чтобы обеспечить их соответствие потребностям новых моделей ускорителей. Упор сделан на расширение выпуска на всей территории США, увеличение доли местных поставщиков, локализацию тестирования и сборки. Foxconn намерена выпускать в Соединённых Штатах ключевые компоненты, включая кабели, сетевое оборудование, системы электропитания и охлаждения. Хотя конкретные обязательства по финансам и закупкам в соглашении отсутствуют, оговорено, что OpenAI будет иметь ранний доступ для оценки новых систем и заключения контрактов на их закупки. Компании уже довольно давно совместно работают над проектом Stargate. Ранее Foxconn подтвердила, что станет выпускать для проекта оборудование на бывшем производстве General Motors в Лордстауне (Lordstown, Огайо). Это последний в серии шагов, предпринятых тайваньским производителем электроники для расширения бизнеса на территории США за последний год. В июле 2025 года Foxconn заключила контракт с американским филиалом тайваньской Teco, занимающейся производством электродвигателей. Они договорились о выпуске модульных ЦОД в США. Американское правительство и бизнес призывают ключевые тайваньские полупроводниковые компании переносить производство в США на фоне опасений, что напряжённость в отношениях с материковым Китаем может поставить под угрозу глобальную цепочку поставок. А по словам главы OpenAI Сэма Альтмана (Sam Altman), востребованная ИИ-инфраструктура — редчайшая возможность реиндустриализации Америки. Некоторые из общих усилий уже начинают приносить плоды. Так, на фабрике TSMC в Финиксе (Phoenix, Аризона) изготовили первую в США пластину с чипами NVIDIA Blackwell и первую же пластину с CCD AMD EPYC Venice. Многие связанные с производством оборудования и компонентов для ЦОД компании также принимают решение о локализации производства в США. Так, в начале апреля об инвестициях в производство на территории Соединённых Штатов заявила Wistron. Schneider Electric инвестирует $140 млн на выпуск в стране электрооборудования, а Hitachi Energy — $1 млрд.

23.11.2025 [12:50], Владимир Мироненко

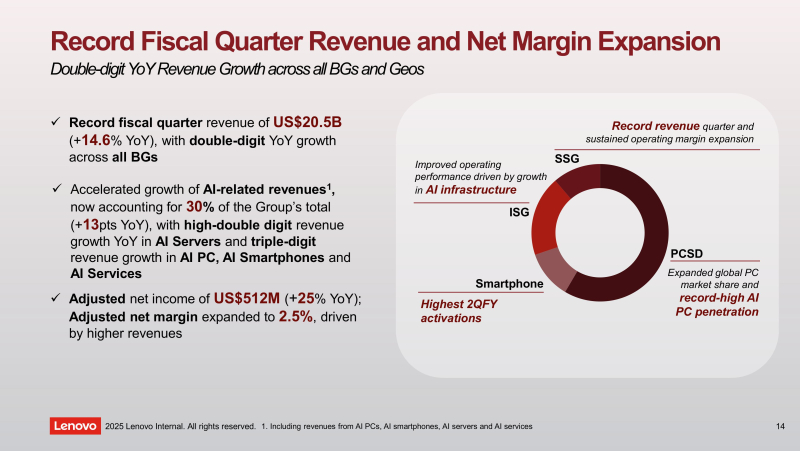

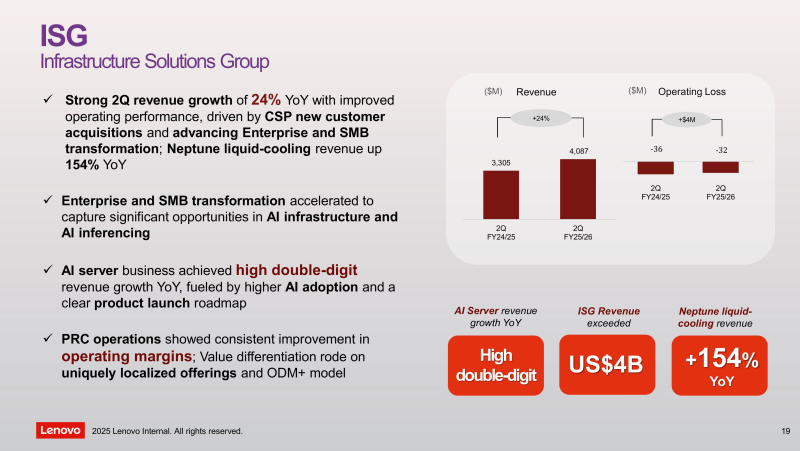

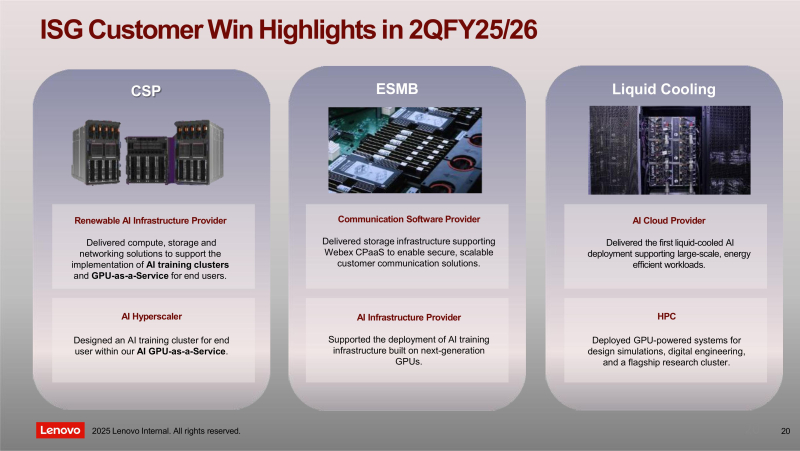

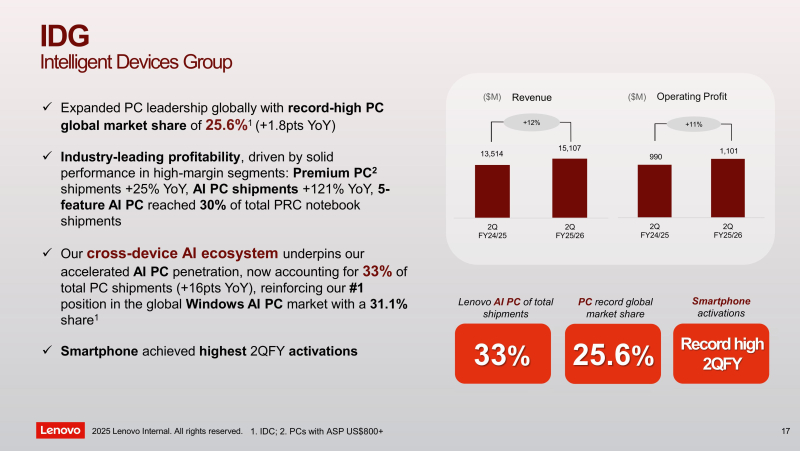

Спустя 11 лет после приобретения бизнеса IBM по выпуску x86-серверов Lenovo так и не добилась его прибыльностиLenovo Group опубликовала рекордные финансовые результаты за II квартал 2025/26 финансового года (III квартал 2025 календарного года): выручка увеличилась на 9 % по сравнению с предыдущим кварталом и на 15 % в годовом исчислении, достигнув $20,45 млрд, что немного выше консенсус-прогноза аналитиков, опрошенных LSEG, в размере $20,3 млрд (по данным Reuters). Lenovo продемонстрировала двузначный рост выручки в процентах в годовом исчислении во всех основных бизнес-группах и регионах продаж. Структура выручки, связанной с ИИ, увеличилась на 13 п.п. в годовом исчислении, составив 30 % от общей выручки компании. По словам руководства Lenovo, рост был обусловлен двузначным ростом выручки в процентах от поставок ИИ-серверов и трёхзначным ростом выручки в процентах от продаж от AI PC, смартфонов с поддержкой ИИ и ИИ-сервисов. Этот квартал знаменует собой восьмой квартал подряд роста выручки Lenovo в годовом исчислении после пяти кварталов спада, что является продолжением восстановления компании, начавшегося в конце 2024 года. Чистая прибыль (HKFRS) достигла $380 млн, снизившись на 25 % в квартальном исчислении и на 1% в годовом исчислении, что отражает рост операционных расходов, связанных с инвестициями в ИИ и сезонностью. Чистая прибыль, причитающаяся акционерам, упала на 5 % год к году до $340 млн. Скорректированная чистая прибыль (Non-HKFRS) увеличилась на 25 % до $512 млн. Подразделение инфраструктурных решений (Infrastructure Solutions Group, ISG), которое специализируется на поставках оборудования для ЦОД, периферийных систем и облачных вычислениях, увеличило выручку год к году на 24 % до $4,1 млрд (последовательное снижение на 5 %), вместе с тем снова зафиксировав убыток в размере $32 млн. Впервые после покупки в 2014 году у IBM бизнеса по выпуску x86-серверов подразделение ISG получило квартальную прибыль только в конце 2021 года, но затем снова сработало с убытком. С тех пор ISG демонстрировало то небольшую прибыль, то умеренные убытки, отметил The Register. Компания сообщила, что на рынке поставщиков облачных услуг (CSP) была получена рекордная выручка, а доход от услуг ИИ-инфраструктуры достиг высоких двузначных показателей роста в процентах в годовом исчислении благодаря большому количеству заказов. Рост выручки от решений жидкостного охлаждения Neptune составил 154 % в годовом исчислении. По данным The Register, руководство компании считает, что наконец-то сможет привести ISG к росту прибыльности, «оптимизировав бизнес-модели для лучшего удовлетворения различных потребностей предприятий и SMB», и полагает, что растущий спрос на вычислительные мощности для инференса будет способствовать росту спроса на её продукцию. Председатель совета директоров и генеральный директор Юаньцин Ян (Yuanqing Yang) поддержал мнение гендиректора NVIDIA Дженсена Хуанга (Jensen Huang), считающего безосновательными опасения по поводу формирования пузыря в ИИ-секторе. «Значительные инвестиции в инфраструктуру ИИ закладывают основу для следующей крупной технологической волны, подобной ранней эпохе интернета», — сказал он, отметив, как эта волна привела к «взрывному росту рынка ПК» и началу развития индустрии смартфонов. «Сейчас происходит следующая волна демократизации ИИ, охватывающая как персональное, так и корпоративное использование, что идеально соответствует стратегии Lenovo», — считает Ян. Подразделение решений и услуг Lenovo (Solutions and Services Group, SSG) увеличило выручку год к году на 18 % до $2,6 млрд, что стало 18 кварталом подряд роста выручки в годовом исчислении. Бизнес-подразделение SSG, созданное во II квартале 2021 года, ориентировано на разработку ПО и проектов для четырёх масштабируемых вертикалей: «Умный город», «Умное образование», «Умная розничная торговля» и «Умное производство» (Smart City, Smart Education, Smart Retail, Smart Manufacturing). Выручка подразделения Intelligent Devices Group (IDG) составила $15,1 млрд, что на 12 % больше, чем в предыдущем квартале, и на 12 % больше в годичном исчислении. Во время телефонной конференции, посвящённой финансовым результатам, Lenovo подтвердила рост цен на компоненты, особенно на память и СХД, выразив уверенность в возможности использования масштабов своей цепочки поставок и ресурсов закупок для снижения давления издержек. Компания предупредила о возможном дефиците поставок по мере роста спроса, хотя ожидается, что дисциплинированное управление запасами поможет поддерживать стабильную маржу. Сообщается, что в III квартале 2026 финансового года (IV квартал 2025 календарного года) Lenovo продолжит развивать свою платформу «Гибридный ИИ для всех», объединяя интеллект на уровне устройств, оркестрацию периферийных устройств и ИИ корпоративного масштаба в единую архитектуру. Компания отмечает, что приоритеты пользователей смещаются в сторону персонализации, безопасности, конфиденциальности, устойчивого развития и эффективности — всё это ускоряет внедрение ИИ в её портфолио оборудования, ПО и сервисов. Lenovo отметила, что продолжит развитие свою стратегии корпоративного ИИ, чтобы помочь клиентам превратить данные и знания в практическую аналитику и ценные идеи, подчеркнув, что имеет все возможности для стимулирования трансформации корпоративного ИИ и разработки ИИ-двойников для клиентов. Ожидается, что переход от облачного обучения ИИ-моделей к периферийному инференсу будет способствовать более активному росту рынка устройств и приложений ИИ, что ещё больше расширит общий целевой рынок компании. Также Lenovo реализует свою концепцию «Один персональный ИИ, несколько устройств», чтобы обеспечить персонализированный опыт использования ИИ для всех форм-факторов. На корпоративном уровне компания углубляет внедрение гибридного ИИ, повышает эффективность использования данных и расширяет сервисы на базе ИИ, используя цифровое рабочее место, гибридное облако и решения для устойчивого развития.

22.11.2025 [12:26], Сергей Карасёв

ASUS представила модульную ИИ-систему PE3000N на платформе NVIDIA Jetson Thor T5000Компания ASUS IoT, подразделение ASUS по выпуску умных устройств для интернета вещей, анонсировала компьютер PE3000N — модульную систему для периферийных ИИ-задач. Устройство выполнено в корпусе повышенной прочности в соответствии со стандартом MIL-STD-810H, а диапазон рабочих температур простирается от -20 до +60 °C. В основу новинки положен модуль NVIDIA Jetson Thor T5000. Изделие содержит CPU с 14 ядрами Arm Neoverse-V3AE (до 2,6 ГГц) и 2560-ядерный GPU на архитектуре Blackwell (до 1,57 ГГц). Имеется 128 Гбайт памяти LPDDR5X с пропускной способностью 273 Гбайт/с. ИИ-производительность достигает 2070 Тфлопс (FP4 Sparse). Встроенный VPU-блок способен осуществлять многопоточное декодирование видеоматериалов: 4 × 8Kp30 (H.265), 10 × 4Kp60 (H.265), 22 × 4Kp30 (H.265), 46 × 1080p60 (H.265), 92 × 1080p30 (H.265), 82 × 1080p30 (H.264) и 4 × 4Kp60 (H.264). Кодирование возможно в режимах 6 × 4Kp60 (H.265), 12 × 4Kp30 (H.265), 24 × 1080p60 (H.265), 50 × 1080p30 (H.265), 48 × 1080p30 (H.264) и 6 × 4Kp60 (H.264). Компьютер располагает коннектором M.2 M-key 2242/2260/2280 для SSD, разъёмом M.2 E-key 2230 для адаптера Wi-Fi/Bluetooth, коннектором M.2 B-key 3042/3052 для сотового модема 4G/5G (плюс слот для карты nano-SIM), а также разъёмом PCIe x4/x8. Есть сетевые порты 1GbE RJ45 и 10GbE RJ45, интерфейс HDMI 2.0, четыре порта USB 3.1 Type-A, по одному порту USB 3.1 Type-C и USB 3.1 Type-C OTG (OS Flash), два порт USB 2.0, аудиогнёзда на 3,5 мм. Могут быть также задействованы два последовательных порта RS-232/422/485 и четыре порта 25GbE. Реализован интерфейс MIPI CSI (16 линий; через коннектор AGX CSI) с возможностью подключения до 16 камер GMSL. Дополнительные интерфейсные модули закрепляются в нижней части компьютера. Один из таких блоков содержит шесть портов 1GbE с поддержкой PoE, другой — четыре разъёма 10GbE M12 и два коннектора Fakra для GSML-камер. Габариты системы составляют 165 × 165 × 68 мм (165 × 165 × 97 мм с модулем расширения). Возможна подача питания в диапазоне 12–60 В. В качестве программной платформы применяется Ubuntu.

21.11.2025 [17:48], Андрей Крупин

«МойОфис» анонсировал более десятка новых технологий и продуктов для бизнеса«МойОфис», российский разработчик программного обеспечения для совместной работы с документами и коммуникаций, представил ряд новых продуктов и технологических решений для корпоративного сегмента. Анонс новинок был сделан в рамках проходившей в Москве IT-конференции «МойОфис: призма изменений». Все они сфокусированы на расширение функциональности программных продуктов экосистемы «МойОфис» — настольных и веб-редакторов, а также корпоративного мессенджера Squadus, и призваны повысить офисную продуктивность благодаря применению новейших технологий искусственного интеллекта в корпоративном контуре.

Источник изображения: myoffice.ru/events/conference-prizma-2025 Компанией были презентованы шесть новых продуктов. «МойОфис Платформа AI». Решение для оркестрации больших языковых моделей (LLM). Позволяет разворачивать и масштабировать любые LLM на защищённом оборудовании заказчика и запускать на их основе кастомизированные ИИ-сервисы в корпоративном контуре. Интеллектуальное управление обеспечивает динамическое распределение ресурсов и автоматически оптимизирует нагрузку. «МойОфис Чат AI». Универсальный ИИ-ассистент для сотрудников. Позволяет решать деловые задачи, готовить презентации, писать код, анализировать большие объёмы данных, выявлять в них тренды и аномалии, строить прогнозы на их основе. Продукт можно развернуть как в облаке, так и в IT-инфраструктуре организации. «МойОфис Презентация AI». Сервис для автоматизированного создания профессиональных презентаций на основе искусственного интеллекта. Преобразует текстовые идеи и данные в слайды с продуманной структурой, адаптивным дизайном и релевантным визуальным контентом. «МойОфис Голосовые Заметки AI». Инструмент, трансформирующий устную речь в готовые структурированные письма, списки дел и документы различного формата. «МойОфис Документы Мобильные». Универсальное и безопасное корпоративное мобильное приложение для полноценной работы с текстовыми документами, таблицами, презентациями, включая просмотр и редактирование PDF-документов. Помогает сотрудникам оставаться продуктивными вне офиса: просматривать, редактировать и комментировать документы, работать совместно с коллегами с файлами из корпоративного хранилища «МойОфис Документы Онлайн», а также получать доступ к файлам из «Яндекс.Диск» и «Облако Mail». «МойОфис Портал». No-code-платформа для создания веб-приложений. Обеспечивает совместную работу, хранение файлов, управление документами и автоматизацию бизнес-процессов с возможностями настройки маршрутов согласования и прав доступа, управления задачами в одном пространстве, создания баз знаний и интранет-порталов для эффективной работы команд.  В дополнение к этому были представлены новые технологические решения для экосистемы «МойОфис». Интерпретатор VBA (входит в состав «МойОфис Документы Настольные»). Преобразует VBA-код в Lua — внутренний язык автоматизации «МойОфис» — и позволяет запускать макросы непосредственно в редакторе «МояТаблица». Исходный VBA-код при этом остаётся неизменным; интерпретированный в Lua код можно доработать под конкретные задачи. «Диаграмма Pro» (входит в пакет «МойОфис Документы Настольные»). Плагин, предоставляющий доступ более чем к 40 типам визуализации данных, таким как диаграммы Ганта и Мекко, каскадные и пузырьковые, линейные и комбинированные. Python в надстройках (доступен в составе «МойОфис Документы Настольные»). Позволяет использовать модули и библиотеки Python для расширения возможностей Lua-кода в надстройках табличного и текстового редакторов. ИИ в настольных редакторах пакета «МойОфис Документы Настольные». Интеллектуальный помощник, анализирующий запросы пользователя на естественном языке и автоматически выполняющий соответствующие операции — от простого форматирования текста до сложного анализа данных с генерацией скриптов на Python. Работа с облачными документами на доске (функция доступны в пакете «Документы Онлайн»). Расширяет возможности интерактивного онлайн-инструмента «МояДоска» для работы в командах, визуализации и организации идей и данных. Позволяет собрать всю информацию о проекте или задаче в едином виртуальном пространстве и взаимодействовать с облачными документами прямо на доске без перехода в другие приложения. Приложение «МоиЗаметки» (входит в «Документы Онлайн»). Предназначено для быстрого создания, редактирования и систематизации заметок. Средства транскрибации и суммаризации в Squadus. Расширяют возможности коммуникационной платформы и позволяют оперативно преобразовывать аудио- и видеозаписи встреч в текстовый формат и подводить ключевые итоги делового общения.

Источник изображения: myoffice.ru/events/conference-prizma-2025 Мультипродуктовая платформа «МойОфис» включает в себя набор необходимых настольных, мобильных и веб-приложений для общения и совместной работы с документами в любой точке мира. Решения разработчика обеспечивают полный контроль над данными, неприкосновенность личной и коммерческой информации, соответствуют отраслевым стандартам безопасности и требованиям российского законодательства. Продукты компании зарегистрированы в реестре отечественного ПО и подходят для использования в организациях любого размера. |

|